1 Vektoralgebra - ipc.uni-jena.de - Friedrich-Schiller

Werbung

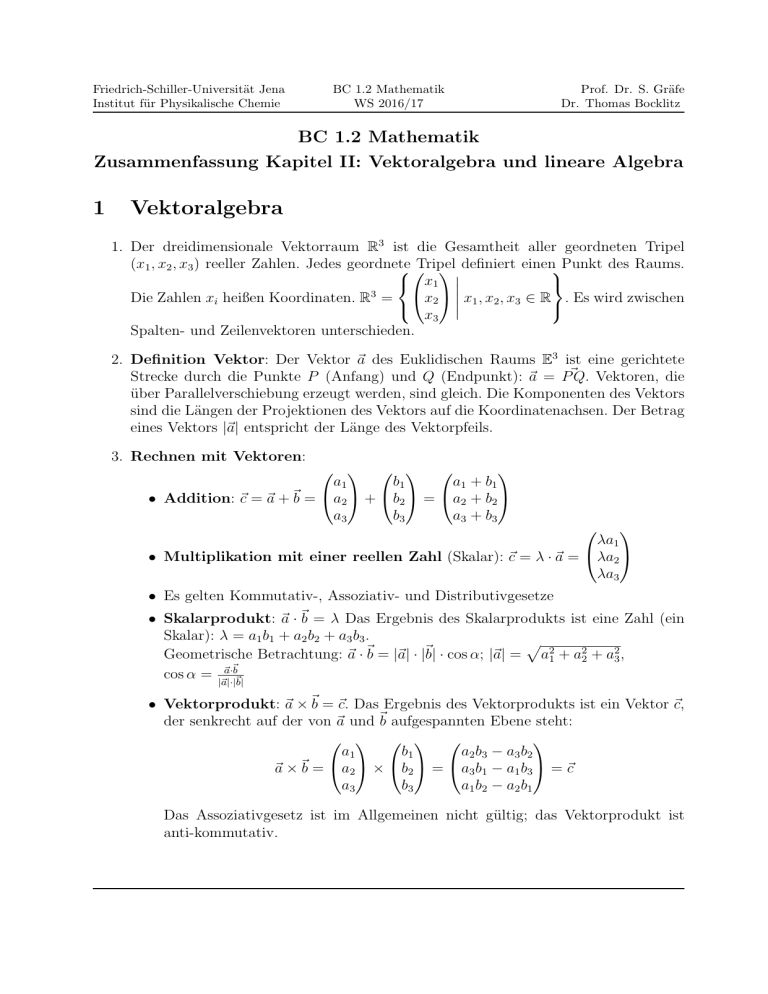

Friedrich-Schiller-Universität Jena Institut für Physikalische Chemie BC 1.2 Mathematik WS 2016/17 Prof. Dr. S. Gräfe Dr. Thomas Bocklitz BC 1.2 Mathematik Zusammenfassung Kapitel II: Vektoralgebra und lineare Algebra 1 Vektoralgebra 1. Der dreidimensionale Vektorraum R3 ist die Gesamtheit aller geordneten Tripel (x1 , x2 , x3 ) reeller Zahlen. Jedes geordnete Tripel definiert einenPunkt des Raums. x1 3 x Die Zahlen xi heißen Koordinaten. R = x1 , x2 , x3 ∈ R . Es wird zwischen 2 x3 Spalten- und Zeilenvektoren unterschieden. 2. Definition Vektor: Der Vektor ~a des Euklidischen Raums E3 ist eine gerichtete Strecke durch die Punkte P (Anfang) und Q (Endpunkt): ~a = P~Q. Vektoren, die über Parallelverschiebung erzeugt werden, sind gleich. Die Komponenten des Vektors sind die Längen der Projektionen des Vektors auf die Koordinatenachsen. Der Betrag eines Vektors |~a| entspricht der Länge des Vektorpfeils. 3. Rechnen mit Vektoren: a1 b1 a1 + b 1 • Addition: ~c = ~a + ~b = a2 + b2 = a2 + b2 a3 b3 a3 + b 3 λa1 • Multiplikation mit einer reellen Zahl (Skalar): ~c = λ · ~a = λa2 λa3 • Es gelten Kommutativ-, Assoziativ- und Distributivgesetze • Skalarprodukt: ~a · ~b = λ Das Ergebnis des Skalarprodukts ist eine Zahl (ein Skalar): λ = a1 b1 + a2 b2 + a3 b3 . p Geometrische Betrachtung: ~a · ~b = |~a| · |~b| · cos α; |~a| = a21 + a22 + a23 , ~ cos α = |~a~a|·|·b~b| • Vektorprodukt: ~a × ~b = ~c. Das Ergebnis des Vektorprodukts ist ein Vektor ~c, der senkrecht auf der von ~a und ~b aufgespannten Ebene steht: a1 b1 a2 b 3 − a3 b 2 ~a × ~b = a2 × b2 = a3 b1 − a1 b3 = ~c a3 b3 a1 b 2 − a2 b 1 Das Assoziativgesetz ist im Allgemeinen nicht gültig; das Vektorprodukt ist anti-kommutativ. Friedrich-Schiller-Universität Jena Institut für Physikalische Chemie BC 1.2 Mathematik WS 2016/17 Prof. Dr. S. Gräfe Dr. Thomas Bocklitz 4. Definition: Lineare Unabhängigkeit: Es seien k Vektoren a~1 , a~2 , ...a~k des ndimensionalen Raums Rn vorgegeben. Die k Vektoren heißen linear unabhängig, wenn die lineare Vektorgleichung λ1~a1 + λ2~a2 + . . . λk~ak = 0 nur für λ1 = λ2 = . . . λk = 0 erfüllt werden kann. Gibt es mindestens einen λi 6= 0, so heißen die k Vektoren linear abhängig. k Vektoren a~1 , a~2 , ...a~k in Rn sind dann und nur dann linear abhängig, wenn mindestens P einer der k Vektoren als Linearkombination der übrigen darstellbar ist: ai . ~aj = k−1 i=1 λ̃k ~ In einem n-dimensionalen Vektorraums hat eine Menge linear unabhängiger Vektoren höchstens n Elemente. 5. Definition Vektorraum: Eine nicht leere Menge V heißt Vektorraum, wenn gilt: • Es gibt für jeden Vektor ~a eine Multiplikation mit Skalaren λ ∈ R, wobei das Produkt λ~a ein Vektor ist, der auch zu V gehört: ~a ∈ V ⇒ (λ~a) ∈ V . • Der Summenvektor zweier beliebiger Vektoren gehört auch zu V : ~a ∈ V, ~b ∈ V ⇒ ~a + ~b = ~c ∈ V . Hierbei sollen die üblichen Rechenregeln gelten. Es gibt k linear unabhängige Vektoren; mehr als k Vektoren sind immer linear abhängig. Die Menge V heißt linearer Vektorraum der Dimension k, dim V = k oder Vk . Der lineare Vektorraum Vk besteht aus der Gesamtheit der Linearkombinationen der linear unabhängigen Vektoren ~q1 , ~q2 , ...~qk ; diese bilden eine sogenannte Basis des linearen Vektorraums. (Dies gilt für endlich-dimensionale Vektorräume.) 6. Im euklidischen Raum (kartesische Metrik) ist die Länge eines Vektors |~a| = P~Q als der Abstand zweier Punkte P = (p1 , p2 , ...pn ) und Q = (q1 , q2 , ...qn ) wie folgt definiert: v u n q uX |~a| = d(P, Q) = t (qi − pi )2 = a21 + a22 + ... + a2n i=1 Vektoren der Länge 1 heißen normiert. 7. Zwei Vektoren heißen orthogonal, wenn ihr Skalarprodukt gleich Null ist, ~a · ~b = 0 8. Die Vektoren, die eine orthonormale Basis aufspannen, erfüllen die folgende Relation: ( 1 für i = j q~i · q~j = δij = 0 für i 6= j δij heißt das Kronecker-Symbol. Friedrich-Schiller-Universität Jena Institut für Physikalische Chemie BC 1.2 Mathematik WS 2016/17 Prof. Dr. S. Gräfe Dr. Thomas Bocklitz 9. Über das Schmidtsche Orthogonalisierungsverfahren kann jede Basis aus n linear unabhängigen Vektoren q~1 , ...q~n in Rn in eine orthogonale bzw. orthonormale Basis e~1 , ...e~n überführt werden: r~i = q~i − i−1 X (~ qi · e~j ) e~j ; e~j = j=1 r~i |~ ri | 10. Im komplexen Vektorraum Cn ist das Skalarprodukt zweier komplexer Vektoren wie folgt definiert: a1 b1 n X .. ~ .. ~ ~a = . ; b = . ; ha|bi = ~a · b = a∗i bi = a∗1 b1 + a∗2 b2 + ... + a∗n bn = λ i=1 an bn λ ist eine (komplexe) Zahl. Es gilt: ha|bi = hb|ai∗ ; 2 ha|λbi = λha|bi; hλa|bi = λ∗ ha|bi; ha|b+ci = ha|bi+ha|ci; ha|ai ≥ 0 Matrizen und Determinanten 1. Definition: Matrix: Unter einer Matrix A vom Schema (m, n) mit m, n ∈ N verstehen wir die m · n Zahlen aik (Matrixelemente) (i = 1, ...m, k = 1, ..n), die in dem rechteckigen Schema a11 a12 . . . a1n a21 a22 . . . a2n A = .. .. .. . . . . . . am1 am2 . . . amn zusammengefasst werden. 2. Eine Matrix heißt quadratisch, wenn Zeilenzahl = Spaltenzahl. Quadratische Matrizen, deren Nichtdiagonalelemente verschwinden, heißen Diagonalmatrizen. Diagonalmatrizen, deren Diagonalelemente aii = 1, heißen Einheitsmatrix. 3. Rechnen mit Matrizen • Addition: Elementweise; A + B = C, mit cik = aik + bik a11 + b11 a12 + b12 . . . a1n + b1n a21 + b21 a22 + b22 . . . a2n + b2n C= .. .. .. .. . . . . am1 + bm1 am2 + bm2 . . . amn + bmn Friedrich-Schiller-Universität Jena Institut für Physikalische Chemie BC 1.2 Mathematik WS 2016/17 Prof. Dr. S. Gräfe Dr. Thomas Bocklitz • Multiplikation mit einem Skalar λ: elementweise Multiplikation: λ · a11 λ · a12 . . . λ · a1n λ · a21 λ · a22 . . . λ · a2n λ · A = .. .. .. . . . . . . λ · am1 λ · am2 . . . λ · amn • Multiplikation Matrix A(m, n) mit Vektor (der gleichen Länge n) ergibt wieder ein Vektor: a11 · v1 + a12 · v2 + · · · + a1n · vn a21 · v1 + a22 · v2 + · · · + a2n · vn A · ~v = .. . am1 · v1 + am2 · v2 + · · · + amn · vn P • Matrixmultiplikation A(m, n) · B(n, p) = C(m, p) mit cik = nj=1 aij + bjk . Matrixmultiplikation ist nicht kommutativ; es gelten Assoziativ- und Distributivgesetze • Eine Matrix A heißt regulär (nicht-singulär), wenn es eine Matrix B gibt, die zugleich links- und rechts-invers von A ist: A·B =B·A=E B heißt dann Inverse von A und wird im Allgemeinen mit A−1 bezeichnet: A · A−1 = A−1 · A = E 4. Der Rang Rg(A) einer Matrix A(m, n) gibt die Maximalzahl r (mit r < n) linear unabhängiger Zeilen- bzw. Spaltenvektoren an. Eine n-reihige quadratische Matrix A(n, n) is dann und nur dann regulär, wenn r = n. 5. Transponierte Matrix AT : aTik = aki . Symmetrische Matrix: AT = A. Orthogonale Matrix: AT = A−1 . Hermitesche Matrix: AT = A∗ . 6. Jeder n−reihigen quadratischen Matrix A wird a11 a12 a21 a22 det(A) = .. .. . . am1 am2 eine Zahl D zugeordnet: . . . a1n . . . a2n .. ... . . . . amn Die Determinante kann über die Regel von Sarrus (nur für 3×3P Matrizen) oder den Laplaceschen Entwicklungssatz berechnet werden: D = det(A) = nj=1 (−1)i+j aij Dij , wobei die Summe über die j−te Zeile oder Spalte geht, aij das Matrixelement an der Stelle aij darstellt und Dij die Unterdeterminante ist, welche entsteht, wenn der ursprünglichen die i−te Zeile und j−te Spalte gestrichen wurde. Friedrich-Schiller-Universität Jena Institut für Physikalische Chemie BC 1.2 Mathematik WS 2016/17 Prof. Dr. S. Gräfe Dr. Thomas Bocklitz 7. Eigenschaften von Determinanten: • Vertauschen zweier Zeilen (Spalten) einer Determinante führt zu einem Vorzeichenwechsel der Determinanten. • Enthält die Determinante zwei gleiche Zeilen (Spalten), ist der Wert der Determinante gleich Null. • Multiplikation einer Determinante mit einer Zahl λ: die Elemente einer Zeile werden mit λ multipliziert (nicht wie bei einer Matrix!). • Enthält eine Zeile (Spalte) nur Nullen, ist der Wert der Determinante gleich Null. • Addiert man zu einem beliebigen Zeilenvektor (Spaltenvektor) ~ai das λ-fache eines anderen Zeilenvektors (Spaltenvektors) ~ak (k 6= i), so behält die Determinante ihren Wert unverändert bei. • Addiert man zu einem beliebigen Zeilenvektor (Spaltenvektor) ~ai eine beliebige Linearkombination der übrigen Zeilenvektoren (Spaltenvektoren), so behält die Determinante ihren Wert unverändert bei. • Vertauscht man Zeilen und Spalten einer Determinante, so behält die Determinante ihren Wert unverändert bei. det(A) = det(AT ). • Für zwei quadratische Matrizen A und B des gleichen Typs gilt: det(C) = det(A · B) = det(A) · det(B) 8. Anwendungen der Determinantentheorie: • Lineare Unabhängigkeit von Vektoren: Da det(A) = 0, wenn die Matrix zwei gleiche Zeilen bzw. Spalten (oder den Nullvektor) aufweist: n Vektoren ~a1 , . . . ~an des n−dimensionalen Vektorraums Rn sind dann und nur dann linear unabhängig, wenn ihre Determinante nicht verschwindet. Der Rang r einer Matrix gibt demnach die größtmögliche Anzahl von Null verschiedener r-reihiger Unterdeterminanten an. • Lineare Gleichungssysteme A~x = ~b: Sei A eine (m,n) Matrix, b ∈ Rm und Rg(A) = Rg(Ã) = r. Homogone lineare Gleichungssysteme der Form A~x = ~0 haben immer eine Lösung (triviale Lösung), ~x = ~0. Diese ist die einzige Lösung, wenn Rg(A) = n. Für Rg(A) < n existiert nicht nur die triviale Lösung. Der Lösungsvektorraum hat dabei die Dimension n − r. Inhomogene lineare Gleichungssysteme haben nur dann eine Lösung, wenn Rg(A) = Rg(Ã). Für r = n existiert genau eine einzige Lösung; für r < n hat der Lösungsvektorraum die Dimension n − r. Der Lösungsvektor kann beispielsweise über die Cramersche Regel gefunden werden; alternativ bietet sich das Verfahren von Gauß an, um die Matrix in Zeilenstufenform zu überführen. • Berechnung inverser Matrizen: Friedrich-Schiller-Universität Jena Institut für Physikalische Chemie BC 1.2 Mathematik WS 2016/17 Prof. Dr. S. Gräfe Dr. Thomas Bocklitz 9. Eine lineare Transformation σ̂ ist eine eindeutige Abbildung des (komplexen) n−dimensionalen Vektorraums Vn (R) in sich, die jeden Vektor ~x ∈ Vn (R) einem Vektor ~y = σ̂(~x) ∈ Vn (R) so zuordnet, dass gilt: σ̂(λ · ~x) = λσ̂(~x) σ̂(x~1 + x~2 ) = σ̂(~x1 ) + σ̂(~x2 ) Die Summe zweier linearer Transformationen ist ebenfalls eine lineare Tranformation. Jeder lineare Transformation σ̂ kann durch eine Matrix A bezüglich einer festen Basis ~q1 , . . . ~qn dargestellt werden. Ein Beispiel für eine lineare Transformation ist die Koordinatentransformation. Der Übergang einer Matrix P in eine neue Basis Q wird wie folgt ausgedrückt: Q = T · P · T −1 , wobei T die Transformationsmatrix ist. 10. Matrixeigenwertprobleme: Spezielle linear Abbildung σ̂ eines Vektors ~x, so dass gilt: σ̂(~x) = λ~x, bzw. in Matrixdarstellung bzgl. einer festen Basis A~x = λ~x oder (A−λE)~x = 0. Es heißt λ Eigenwert und ~x Eigenvektor der Gleichung. Die Lösungen werden z.B. über die Determinante gefunden: a11 − λ a . . . a 12 1n a21 a22 − λ . . . a2n det(A − λE) = .. .. .. = 0 .. . . . . an1 an2 . . . ann − λ Die Nullstellen des Polynoms sind die Eigenwerte. Aufgrund des Fundamentalsatzes der Algebra gibt es n Lösungen (Eigenwerte) λ1 , . . . λn und n dazugehörende Lösungsvektoren (Eigenvektoren) ~x1 , . . . ~xn . Tritt mehrmals der gleiche Eigenwert auf, so nennt man diesen Eigenwert m-fach entartet. Das spezielle Eigenwertproblem (A − λE)~x = 0 mit A = AT besitzt die folgenden Eigenschaften: (i) alle n Eigenwerte sind reell; (ii) es gibt genau n linear unabhängige Eigenvektoren; (iii) Eigenvektoren, die zu verschiedenen Eigenvektoren gehören, sind orthogonal; (iv) zu jedem Eigenwert λi der Vielfachheit m existieren genau m linear (1) (2) (m) unabhängige Eigenvektoren ~xi , ~xi , . . . , ~xi , die sich orthonormieren lassen. Die Eigenwerte reeller symmetrischer Matrizen in Diagonal- oder Dreiecksform sind die Elemente der Hauptdiagonalen λi = aii (i = 1, ...n). Zu jeder reellen symmetrischen Matrix A findet sich eine reelle orthogonale Matrix T , so dass B = T −1 AT in Diagonalform ist. Die Spalten von T sind die Eigenvektoren ~xi , die Diagonalelemente sind die Eigenwerte bii = λi (Hauptachsentransformation).,