Vorlesungsfolien

Werbung

WARTESCHLANGENTHEORIE

HSU Hamburg, Frühjahrstrimester 2014

Andreas Löpker

1. Einführung

1.1. Einfaches Warteschlangenmodell

Der Ankunftsprozess beschreibt die zufällige Ankunft von Kunden.

Ist die Bedienstation besetzt, so müssen die Kunden in der

Warteschlange warten.

An der Bedienstation ergibt sich für jeden Kunden, der bedient wird,

eine zufällige Bediendauer.

Nach der Bedienung verlassen die Kunden das System und bilden den

Abgangsprozess.

–1–

Kendall-Notation

Warteschlangen werden häufig durch vier Parameter A, B, c und K klassifiziert. Man verwendet die Kendall-Notation:

A/B/c/K

A beschreibt den Ankunftsprozess:

M=Exponentiell, G=Allgemein,

D=Deterministisch.

B beschreibt die Bedienungszeit:

M=Exponentiell, G=Allgemein,

D=Deterministisch.

c gibt Auskunft über die Anzahl der Bedienstationen (Server),

K entspricht der Warteschlangenkapazität.

–2–

In dieser Vorlesung:

M/M/1 - Exponentielle Ankünfte und Bedienzeiten, ein Server.

M/M/1/K - Exponentielle Ankünfte und Bedienzeiten, ein Server,

aber nur maximal K freie Plätze in der Warteschlange. Es bedarf einer

Vereinbarung, was mit abgewiesenen Kunden passiert.

M/M/∞ - Exponentielle Ankünfte und Bedienzeiten. Es ist immer ein

Server frei.

M/M/m - Exponentielle Ankünfte und Bedienzeiten, m Server.

M/M/m/m - Exponentielle Ankünfte und Bedienzeiten, m Server,

Kapazität m.

M/G/1 - Exponentielle Ankünfte und beliebige Bedienzeiten, ein

Server.

Netzwerke von Warteschlangen.

–3–

Meistens werden folgende Eigenschaften des Modells angenommen:

die Zwischenankunftszeiten besitzen dieselbe Verteilung und sind

voneinander unabhängig (kurz: i.i.d. engl. ”independent and identically

distributed”),

die Bedienzeiten sind ebenfalls i.i.d.,

die Zwischenankunftszeiten und die Bedienzeiten sind unabhängig

voneinander,

Kunden, die zuerst ankommen, werden auch zuerst bedient (FIFOoder FCFS-Disziplin).

–4–

1.2. Beispiele

Bankschalter

Kunden kommen zu zufälligen Zeitpunkten in die Bank und werden dort

an einem Schalter bedient. Vor dem Schalter bildet sich eine Warteschlange.

Befahren eines Streckenabschnitts durch Züge

Die Züge sind die Kunden, der Streckenabschnitt ist der Server. Die

Warteschlange wird durch die vorgelagerten Streckenabschnitte gebildet.

Produktionsanlagen

Die Kunden sind Produkte, die in einer Maschine bearbeitet werden

müssen.

–5–

1.3. Erweiterte Modelle

Andere Warteschlangendisziplinen

Es gibt verschiedene weitere Abfertigungsmechanismen:

LIFO (LCFS): Ein ankommender Kunde wird sofort bedient, die Bedienung des aktuellen Kunden wird unterbrochen.

SIRO: Sobald der Server ohne Arbeit ist wird zufällig ein Kunde aus

der Schlange ausgewählt.

Prioritäten: Kunden haben verschiedene Prioritäten und werden je

nach Priorität ausgewählt.

–6–

Mehrere Server

Parallel:

In Serie (Tandem-Warteschlange):

–7–

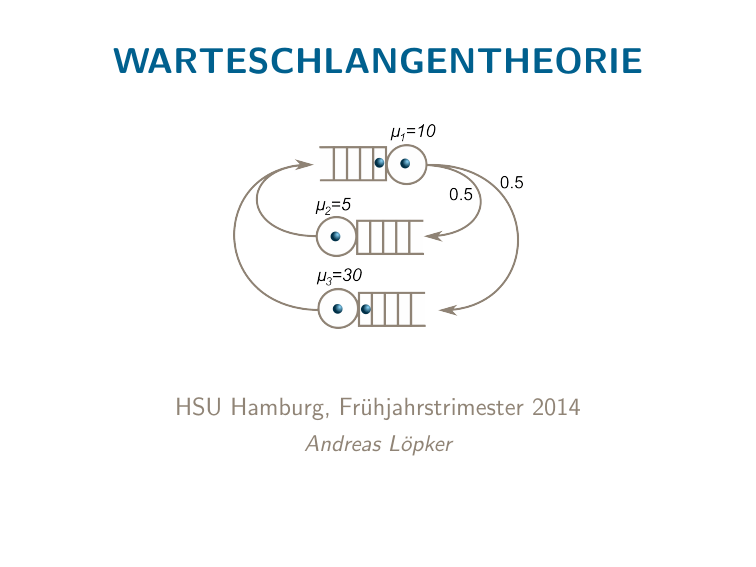

Netzwerke

In Warteschlangennetzen muss es Regeln für die Verteilung auf die verschiedenen Server geben (Routing).

–8–

1.4. Interessante Größen

Uns interessieren u.a. folgende Größen:

Verteilung (oder Erwartungswert) der Wartezeiten,

Verteilung (oder Erwartungswert) der Aufenthaltsdauer im System,

Verteilung (oder Erwartungswert) der Anzahl von Kunden in der

Warteschlange,

Verteilung (oder Erwartungswert) der Zeiten, in denen der Server

arbeitet (bzw. nicht arbeitet),

Auslastung des Systems,

Verhalten des Systems, wenn die Zeit gegen unendlich strebt.

–9–

2. Stochastik

2.1. Zufallsvariablen und ihre Verteilung

Zufallsvariablen

Zufallsvariablen sind mathematische Größen, die einen zufälligen

Zahlenwert annehmen.

Es gibt diskrete Zufallsvariablen, die nur abzählbar viele Werte

x1 , x2 , . . . annehmen und stetige Zufallsvariablen mit Werten z.B. in

einem Intervall [a, b].

– 10 –

Beispiel: Diskrete Zufallsvariable

Die Augenzahl beim Würfeln ist eine diskrete Zufallsvariable, denn sie

nimmt nur die Werte 1 bis 6 an.

Beispiel: Diskrete Zufallsvariable

Die Anzahl von Kunden in der Wartschlange ist eine weitere diskrete

Zufallsvariable mit Werten in der Menge N ∪ {0} = {0, 1, 2, . . .}.

Beispiel: Stetige Zufallsvariable

Die Ankunftszeit eines Kunden kann durch eine stetige Zufallsvariable

beschrieben werden.

– 11 –

Verteilung

Zufallsvariablen werden durch ihre Verteilung beschrieben. Das geschieht meistens, indem man ihre Verteilungsfunktion angibt:

F (x) = P(X ≤ x).

Die Funktion F ist nicht-fallend, rechtsseitig stetig, hat Werte im

Intervall [0, 1] und es gilt

lim F (x) = 0,

x→−∞

– 12 –

lim F (x) = 1.

x→∞

Wahrscheinlichkeitsfunktion

Bei diskreten Zufallsvariablen kann man die Verteilung am besten

durch Angabe der Wahrscheinlichkeitsfunktion

f (xk ) = P(X = xk )

angeben.

Beispiel

Beim Würfeln ist die Augenzahl eine Zufallsvariable X mit

1

1

1

f (1) = , f (2) = , f (3) = ,

6

6

6

1

1

1

f (4) = , f (5) = , f (6) = .

6

6

6

– 13 –

Verteilungsfunktion und Wahrscheinlichkeit

Die Verteilungsfunktion F (x) einer diskreten Zufallsvariable X besitzt

Sprünge der Höhe f (xi ) an den Stellen xi :

Es gilt

P(X ∈ (a, b]) = F (b) − F (a) =

X

xi ∈[a,b]

– 14 –

f (xi ).

Dichtefunktion

Bei stetigen Zufallsvariablen beschreibt man die Verteilung durch die

Angabe der Verteilungsfunktion F (x) oder ihrer Ableitung, der Dichtefunktion:

d

F (x).

f (x) =

dx

Für stetige Zufallsvariablen gilt

P X ∈ (a, b] = F (b) − F (a) =

Z

f (u) du.

a

– 15 –

b

2.2. Erwartungswerte

Erwartungswert

Als Erwartungswert E (X ) bezeichnet man eine theoretische Größe,

die eine Art Mittelwert der Zufallsvariablen angibt.

Für eine diskrete Zufallsvariable ist

X

E (X ) =

xi · f (xi ).

xi

Für eine stetige Zufallsvariable ist

Z ∞

E (X ) =

x · f (x) dx

−∞

– 16 –

Allgemeine Erwartungswerte

Ist g (x) eine Funktion, so kann man den Erwartungswert von E (g (X ))

wie folgt berechnen:

Für eine diskrete Zufallsvariable ist

X

E (g (X )) =

g (xi ) · f (xi ).

xi

Für eine diskrete Zufallsvariable ist

Z ∞

g (x) · f (x) dx

E (g (X )) =

−∞

– 17 –

Varianz

Die Varianz ist ein Maß für die Streuung einer Zufallsvariablen. Sie

ergibt sich als Erwartungswert des quadratischen Abstands vom Erwartungswert:

Var(X ) = E ((X − E (X ))2 ).

Alternative Berechnungsmethode:

Var(X ) = E (X 2 ) − E (X )2 .

Beispiel: Augenzahl

Es ist

E (X 2 ) =

1 2 1 2

1

91

1 + 2 + . . . + 62 =

.

6

6

6

6

Also ist

Var(X ) = E (X 2 ) − E (X )2 =

– 18 –

35

91 49

−

=

.

6

4

12

2.3. Das Gesetz der großen Zahlen

(

LLN.cdf)

Ein Würfel wird 10 mal geworfen. Die jeweilige Augenzahl Xk und der

aktuellen Mittelwert Mk = (X1 + X2 + . . . + Xk )/k werden notiert:

i

1

2

3

4

5

6

7

8

9

10

Xi

5

2

5

2

4

4

3

2

6

4

Mi

5

7/2

4

7/2

18/5

11/3

25/7

27/8

11/3

37/10

– 19 –

Bei 100 Würfen ergibt sich:

(Starkes) Gesetz der großen Zahlen

Sind die Zufallsvariablen X1 , X2 , . . . unabhängig und identisch verteilt

mit E (|X1 |) < ∞, so gilt

X1 + X2 + . . . + Xn

P lim

= E (X1 ) = 1.

n→∞

n

– 20 –

2.4. Wichtige Verteilungen

Bernoulli-Verteilung

X nimmt nur die zwei Werte 0 und 1 an (x1 = 0, x2 = 1).

P(X = 1) = p, P(X = 0) = 1 − p, p ∈ [0, 1], d.h. für die

Wahrscheinlichkeitsfunktion gilt f (x1 ) = 1 − p und f (x2 ) = p.

E (X ) = 1 · p + 0 · (1 − p) = p, k = 0, 1, . . . , n.

Var(X ) = p − p 2 = p(1 − p).

Ein Bernoulli-Experiment ist ein Zufallsexperiment, das nur zwei

Ausgänge (Erfolg und Misserfolg) kennt.

– 21 –

Binomialverteilung

X beschreibt die Anzahl von Versuchen bei n Bernoulli-Experimenten

bei denen Erfolg eintritt.

P(X = k) = kn p k (1 − p)n−k , k = 0, 1, . . . , n

E (X ) = np.

Var(X ) = np(1 − p).

– 22 –

Beispiel

Ein Würfel wird 5 mal geworfen. Es sei X die Anzahl der Würfe mit

einer Augenzahl > 4. Es ist p = 1/3 und 1 − p = 2/3 und damit

5 0

P(X = 0) =

p (1 − p)5 = (2/3)5 ,

0

5 1

P(X = 1) =

p (1 − p)4 = 5(1/3)(2/3)4 ,

1

5 2

P(X = 2) =

p (1 − p)3 = 10(1/3)2 (2/3)3 ,

2

5 3

P(X = 3) =

p (1 − p)2 = 10(1/3)3 (2/3)2 ,

3

5 4

P(X = 4) =

p (1 − p)1 = 5(1/3)4 (2/3)1 ,

4

5 5

P(X = 5) =

p (1 − p)0 = (1/3)5 .

5

– 23 –

Geometrische Verteilung vom Typ I

X beschreibt, nach wie vielen Bernoulli-Experimenten zum ersten mal

Erfolg auftritt.

P(X = k) = (1 − p)k−1 p, k = 1, 2, 3, . . .

E (X ) = p1 .

Var(X ) =

1−p

p2 .

Geometrische Verteilung vom Typ II

X beschreibt die Fehlversuche bis zum ersten Erfolg bei BernoulliExperimenten.

P(X = k) = (1 − p)k p, k = 0, 1, 2, 3, . . .

E (X ) =

1−p

p .

Var(X ) =

1−p

p2 .

– 24 –

Beispiel

Wie lange muss man im Durchschnitt würfeln, bis man eine 6 würfelt?

Es sei X die Anzahl der Würfe, bis eine Augenzahl 6 gewürfelt wird.

Es ist p =

1

6

und daher

E (X ) =

1

= 6.

p

– 25 –

Gleichverteilung

X nimmt Werte in einem Intervall [a, b] an. Dabei ist die Wahrscheinlichkeit in einem Teilintervall I zu liegen, proportional zur Intervalllänge.

F (x) = P(X ≤ x) =

f (x) =

1

b−a ,

E (X ) =

x−a

b−a ,

x ∈ [a, b],

x ∈ [a, b],

a+b

2 ,

Var(X ) =

(b−a)2

12 .

– 26 –

2.5. Die Exponential- und Poisson-Verteilung

Die Exponentialverteilung

(

Exp.cdf)

Eine Zufallsvariable X ist exponentiell verteilt mit Parameter λ > 0,

wenn F die Exponentialverteilung ist:

(

0

;x < 0

F (x) = P(X ≤ x) =

−λx

1−e

;x ≥ 0

Dichtefunktion:

d

f (x) =

F (x) =

dx

(

– 27 –

0

λe

;x < 0

−λx

;x ≥ 0

Für den Erwartungswert ergibt sich

Z ∞

Z ∞

E (X ) =

xf (x) dx =

xλe −λx dx

0

0

Z ∞

−e −λx ∞

1

−λx

−λx ∞

+

e

dx

=

− xe

=

]0 = .

0

λ

λ

0

Für die Varianz erhält man durch eine ähnliche Rechnung

Var(X ) = 1/λ2 .

Als nächstes wollen wir die Ws. berechnen, dass X größer ist als x + y ,

gegeben, dass X größer ist als y . Wir benötigen dazu die Formel für die

bedingte Wahrscheinlichkeit:

Bedingte Wahrscheinlichkeit

Für zwei Ereignisse A und B mit P(B) > 0 gilt:

P(A|B) =

P(A und B)

.

P(B)

– 28 –

Dann gilt:

P(X > x + y |X > y )

=

=

P(X > x + y , X > y )

P(X > y )

P(X > x + y )

P(X > y )

=

1 − (1 − e −λ(x+y ) )

1 − (1 − e −λy )

=

e −λ(x+y )

e −λx e −λy

=

= e −λx .

−λy

e

e −λy

Gedächtnislosigkeit der Exponentialverteilung

Besitzt X eine exponentielle Verteilung mit Parameter λ, so ist für jedes

y > 0 die Verteilung von X gegeben X > y erneut eine Exponentialverteilung mit demselben Parameter λ.

– 29 –

Beispiel

Die Ankunftszeit T eines Kunden sei exponentiell verteilt mit Erwartungswert 10 Minuten (λ = 1/10). Angenommen es kam in den ersten

15 Minuten kein Kunde an.

Die Wahrscheinlichkeit, auf den ersten Kunden noch mindestens weitere

8 Minuten warten zu müssen ist

P(T > 23|T > 15) = P(T > 8)

1

= e − 10 ·8

= e −0.8

≈ 0.45,

unabhängig von den bereits vergangenen 15 Minuten.

– 30 –

Poisson-Verteilung

Interpretation: Siehe Abschnitt ”Der Ankunftsprozess und die Bedienzeiten”.

k

P(X = k) = e −c ck! , k = 0, 1, 2, . . .

E (X ) = c.

Var(X ) = c.

Beispiel

Ist X Poisson-verteilt mit Parameter c = 3, dann gilt

0

P(X = 0) = e −3 30! ≈ 0.05,

1

P(X = 1) = e −3 31! ≈ 0.15,

2

P(X = 2) = e −3 32!

..

..

.

.

– 31 –

≈ 0.22,

..

.

Zusammenfassung – Abschnitt 2

Diskrete und stetige Zufallsvariablen und ihre Verteilungsfunktionen.

Erwartungswerte, bedingte Wahrscheinlichkeit.

Gesetz der großen Zahlen.

Verteilungen: Bernoulli-Verteilung, Binomialverteilung, Geometrische

Verteilung, Gleichverteilung

Wichtig: Exponentialverteilung und Poisson-Verteilung.

– 32 –

3. Der Ankunftsprozess und die Bedienzeiten

3.1. Die Ankunfts- und Zwischenankunftszeiten

Der Ankunftsprozess beschreibt die zufälligen Ankünfte der Kunden.

Die Kunden erreichen das System zu den Ankunftszeitpunkten

T1 , T2 , T3 , . . .. Der k-te Kunde betritt das System zum Zeitpunkt Tk .

Wir setzen T0 = 0.

– 33 –

Die Zwischenankunftszeiten

A1 = T1 − T0

A2 = T2 − T1

..

..

.

.

sind positive unabhängige Zufallsvariablen mit identischer Verteilung.

Der Wert λ =

1

E (Ai )

heißt Ankunftsrate.

– 34 –

Beispiel (Amt)

In einem Bürgeramt werden Wartenummern für die Besucher ausgegeben. Die Ankunftszeiten der ersten zehn Besucher registiert:

Kunde Nr. k:

Ankunftszeit Tk :

1

26

2

67

3

76

4

83

5

125

– 35 –

6

129

7

203

8

211

9

244

10

248

Beispiel (Amt)

Es ergeben sich folgende Zwischenankunftszeiten:

Kunde Nr. k:

Zwischenankunftszeit Ak :

1

26

2

41

3

9

4

7

5

42

6

4

Geschätzte Ankunftsrate:

λ̃ = 1/24.8

≈ 0.04 Bürger pro Minute

≈ 2.42 Bürger pro Stunde.

– 36 –

7

74

8

8

9

33

10

4

Beispiel (Amt)

Kunde Nr. k:

Zwischenankunftszeit Ak :

1

26

2

41

3

9

4

7

5

42

6

4

7

74

8

8

9

33

10

4

Empirische Verteilungsfunktion der Zwischenankunftszeiten und exponentielle Verteilungsfunktion mit λ = 0.04.

– 37 –

3.2. Der Erneuerungsprozess der Ankünfte

Der Zählprozess N(t), der die Ankünfte bis zum Zeitpunkt t zählt,

heißt Erneuerungsprozess.

Den Erwartungswert

U(t) = E (N(t))

nennt man Erneuerungsfunktion.

Die Erneuerungsfunktion ist in den meisten Fällen nur schwer explizit

anzugeben. Es ist im allgemeinen U(t) 6= λ · t.

– 38 –

Beispiel (Amt)

k:

Tk :

Ak :

1

26

26

2

67

41

3

76

9

4

83

7

5

125

42

6

129

4

– 39 –

7

203

74

8

211

8

9

244

33

10

248

4

Beispiel (Amt)

Es werden jetzt weitere zehn Besucherankünfte registiert.

– 40 –

Beispiel (Amt)

100 Ankünfte:

Vermutung: N(t) ≈ λt.

– 41 –

Erneuerungssatz

Es gilt

P

N(t)

= λ = 1.

t→∞

t

lim

und

U(t)

1

=

= λ.

t→∞

t

E (Ai )

lim

Es gilt also annähernd

U(t) ≈ λt

Erwartete Kundenzahl ≈ Ankunftsrate × Zeit.

– 42 –

3.3. Markovsche Ankünfte / Poisson-Prozess

(

PoissonEvents.cdf)

Besitzen die Zwischenankunftszeiten eine exponentielle Verteilung, so

heißt die Warteschlange Markovsch (Kendall-Notation M/ · /·).

Es gilt also

P(Ai ≤ t) = 1 − e −λt ,

t≥0

und E (Ai ) = λ1 .

In diesem Fall besitzt der Zählprozess N(t) eine Poissonverteilung mit

Parameter λt, d.h.

P(N(t) = k) = e −λt

(λt)k

,

k!

k = 0, 1, 2, . . . .

N(t) heißt dann Poisson-Prozess mit Intensität λ.

Die Erneuerungsfunktion hat dann eine besonders einfache Form:

U(t) = E (N(t)) = λt.

– 43 –

Beobachtung:

Der erste Kunde kommt erst nach dem Zeitpunkt t an, genau dann,

wenn N(t) < 1 ist.

Der zweite Kunde kommt erst nach dem Zeitpunkt t an, genau dann,

wenn N(t) < 2 ist.

Der nte Kunde kommt erst nach dem Zeitpunkt t an, genau dann,

wenn N(t) < n ist.

Es ergibt sich:

Duale Beziehung zwischen Tk und N(t)

Tn < t

⇔

N(t) > n

Es folgt also

P(Tn > t) = P(N(t) < n) = e −λx

n−1

X

(λt)k

k=0

– 44 –

k!

.

Verteilung der Ankunftszeiten beim Poisson-Prozess

Die Ankunftszeiten T1 , T2 , . . . besitzen eine Erlang-Verteilung, d.h.

P(Tn ≤ t) = 1 − e −λx

n−1

X

(λt)k

k=0

k!

Die zugehörige Dichtefunktion ist

f (t) =

(λt)n−1 −λt

λe

,

(n − 1)!

Es gilt

E (Tk ) =

– 45 –

k

.

λ

t ≥ 0.

.

Simulation: Poisson-Prozess

(

Poisson.cdf)

λ = 3, t ∈ (0, 2):

λ = 3, t ∈ (0, 5):

– 46 –

Simulation: Poisson-Prozess

λ = 3, t ∈ (0, 20):

λ = 3, t ∈ (0, 100):

– 47 –

3.4. Bedienzeiten

Der Zeitraum, für den sich ein Kunde in Bedienung befindet heißt

Bedienzeit. Sie hängt, bei konstanter Bearbeitungsgeschwindigkeit,

von der Arbeitsmenge, die der Kunde verlangt.

Wir nehmen wieder an, dass die Bedienzeiten B1 , B2 , . . . i.i.d. und

unabhängig von den Ankunftszeiten sind.

Die Bedienrate

Die Bedienrate ist µ = 1/E (B1 ).

Angenommen die Warteschlange wäre immer besetzt, dann bilden

die Abgänge der Kunden einen Erneuerungsprozess. Wenn M(t) die

abgehenden Kunden zählt, dann gilt nach dem Erneuerungssatz

E (M(t))

1

lim

=

= µ.

t→∞

t

E (B1 )

Die Bedienrate gibt also (langfristig) die mittlere Zahl von bedienten

Kunden pro Zeiteinheit in einem voll ausgelasteten System an.

– 48 –

Beispiel

Die Bedienzeiten an einem Schalter besitzen die Verteilungsfunktion

(

0

;x < 1

F (x) = P(B1 ≤ x) =

.

2

1 − 1/x

;x ≥ 1

Dann ist die Dichtefunktion gegeben durch

(

0

;x < 1

f (x) =

.

2/x 3 ; x ≥ 1

Daraus ergibt sich der Erwartungswert

∞

Z ∞

2

1

x 3 dx = 2

E (B1 ) =

= 2.

x

x

1

1

Die Bedienrate ist dann

µ = 1/E (B1 ) = 1/2.

Langfristig werden etwa 0.5 Kunden pro Zeiteinheit bedient, vorausgesetzt die Warteschlange ist immer voll.

– 49 –

3.5. Exponentielle Bedienzeiten

Häufig geht man davon aus, dass die Bedienzeiten eine Exponentielle

Verteilung besitzen, d.h.

P(Bi ≤ x) = 1 − e −µx ,

x ≥ 0.

Die Bedienrate ist dann offenbar

1

= µ,

E (B1 )

d.h. langfristig werden etwa µ Kunden pro Zeiteinheit bedient,

vorausgesetzt es kommen immer genug Kunden an.

Wegen der Gedächtnislosigkeit der Exponentialverteilung ist bei

besetztem Server die Restbedienzeit zum Zeitpunkt t wieder

exponentiell verteilt mit Parameter µ:

P(B1 ≤ t + s|B1 > t) = P(B1 ≤ s) = 1 − e −µs .

– 50 –

Zusammenfassung – Abschnitt 3

Ankunftzeitpunkte und Zwischenankunftszeiten, Ankunftsrate.

Speziell: Poisson-Prozess.

Bedienzeiten und Bedienrate.

Speziell: Exponentielle Bedienzeiten.

– 51 –

4. Die M/M/1-Warteschlange

4.1. Definition

Wir betrachten ein Warteschlangenmodell mit einem Server und einer

Warteschlange mit unbegrenzter Kapazität.

Ankunftsprozess: Poisson-Prozess mit Rate λ.

Bedienzeiten: Exponentiell mit Bedienrate µ.

– 52 –

4.2. Die Anzahl der Kunden im System(

MM.cdf)

Es sei Xt die Anzahl der Kunden, die sich zum Zeitpunkt t im System

befinden. Xt umfasst alle Kunden in der Warteschlange und ggf. den

Kunden, der gerade in Bedienung ist.

(Xt )t≥0 ist ein sog. stochastischer Prozess.

Da Xt zu jedem Zeitpunkt t eine Zufallsvariable ist, macht es Sinn zu

fragen,

wie die Verteilung von Xt aussieht oder

wie viele Kunden im Mittel in der Warteschlange sind.

Es ist im allgemeinen sehr schwer diese zeitabhängigen Größen zu

bestimmen.

– 53 –

Beispiel

An einer Bedienstation kommen Kunden zu folgenden Zeiten mit entsprechenden Bedienzeiten an:

1

2

3

4

5

6

Ankunftszeit

15:03

15:08

15:11

15:13

15:21

15:23

Bedienzeit (min)

6

6

1

2

5

2

– 54 –

Beispiel (Forts.)

Es bezeichne Dk die Abgangszeit des kten Kunden.

k

1

2

3

4

5

6

Tk

3

8

11

13

21

23

Ak

3

5

3

2

8

2

Anzahl Xt der Kunden im System:

– 55 –

Bk

6

6

1

2

5

2

Dk

9

15

16

18

26

28

Die Zeiten, in denen der Server ruht, heissen Leerzeiten (idle periods).

Die Zeiten, in denen der Server mit einem Kunden besetzt ist, heissen

Belegtzeiten (busy periods).

Beispiel

– 56 –

Wir wollen die Verteilung

πk (t) = P(Xt = k)

der Kundenzahl bestimmen.

Die Zwischenankunftszeiten sind exponentiell mit Parameter λ.

Die Anzahl N(t) der bis zum Zeitpunkt t bereits angekommenen

Kunden besitzt eine Poisson-Verteilung, d.h. für ein sehr kleines h > 0

gilt

P(keine Ankunft im Intervall [t, t + h]) = P(N(h) = 0) = e −λh ≈ 1 − λh.

Außer dem gilt

P(eine Ankunft im Intervall [t, t + h]) = e −λh λh ≈ λh,

P(mehr als eine Ankunft im Intervall [t, t + h]) ≈ 0

– 57 –

Die Restbedienzeit eines Kunden in der Bedienstation ist exponentiell

verteilt mit Parameter µ.

Daher gilt

P(kein Abgang im Intervall [t, t + h]) = e −µh ≈ 1 − µh

P(ein Abgang im Intervall [t, t + h]) = e −µh µh ≈ µh,

P(mehr als ein Abgang im Intervall [t, t + h]) ≈ 0

Außerdem gilt

P(weder Abgänge noch Ankünfte im Intervall [t, t + h])

≈ (1 − µh)(1 − λh) ≈ 1 − (λ + µ)h.

– 58 –

Dann ergibt sich

πk (t + h) ≈ (1 − (λ + µ)h)πk (t)

+λhπk+1 (t) + µhπk−1 (t)

⇔

⇔

πk (t + h) − πk (t) ≈ −(λ + µ)hπk (t) + λhπk+1 (t) + µhπk−1 (t)

πk (t + h) − πk (t)

≈ −(λ + µ)πk (t) + λπk+1 (t) + µπk−1 (t)

h

⇒ πk0 (t) = −(λ + µ)πk (t) + λπk+1 (t) + µπk−1 (t).

Mit dem gleichen Argument folgt

π00 (t) = −λπ0 (t) + µπ1 (t)

P∞

Zusätzlich gilt auch noch k=0 πk = 1.

Dieses System von Differentialgleichungen ist sehr schwer zu lösen.

Daher betrachten wir den Prozess Xt für t → ∞ und untersuchen die

Grenzverteilung

πk = lim πk (t),

t→∞

vorausgesetzt der Grenzwert existiert.

– 59 –

4.3. Grenzverteilung / Stationärer Zustand

Die Verteilung πk (t) des Prozesses Xt konvergiert nicht in jedem Fall

gegen eine Grenzverteilung πk .

Es können drei Fälle auftreten:

Transienter Fall: Für jedes K > 0 gilt Xt ∈ [0, K ] nur für einen

endlichen Zeitraum. Es gilt P(Xt → ∞) = 1.

Null-rekurrenter Fall: Der Prozess kehrt in jedes Intervall [0, K ]

unendlich oft wieder zurück, die Rückkehrzeiten haben aber einen

unendlichen Erwartungswert.

Positiv-rekurrenter Fall: Der Prozess kehrt in jedes Intervall [0, K ]

unendlich oft wieder zurück, die Rückkehrzeiten besitzen einen

endlichen Erwartungswert.

– 60 –

Grenzverteilung / Stationärer Zustand

Im positiv rekurrenten Fall konvergiert die Verteilung der Kundenzahl

πk (t) für t → ∞ gegen eine Grenzverteilung πk .

Es sei X eine Zufallsvariable mit der Verteilung π, d.h.

P(X = k) = πk .

Starten wir die Warteschlange nicht leer, sondern so, dass πk (0) = πk

ist, dann bleibt die Verteilung von t unabhängig, d.h.

P(Xt = k) = πk ,

für jedes t.

Wir sagen dann, dass sich die Warteschlange im stationären Zustand

oder im Gleichgewichtszustand (auch Steady State) befindet.

– 61 –

Wann ist die Warteschlange positiv rekurrent?

Wir verwenden zur Klassifizierung die Verkehrsintensität (”rho”)

λ

%= .

µ

Rekurrenz und Transienz

Für % > 1 (λ < µ) ist Xt transient.

Für % = 1 (λ = µ) ist Xt null-rekurrent.

Für % < 1 (λ > µ) ist Xt positiv rekurrent. In diesem Fall besitzt das

System eine eindeutige Grenzverteilung

lim πk (t) = πk .

t→∞

– 62 –

(

rekurrenz)

Transienter Fall: λ = 3, µ = 2

Null-Rekurrenter Fall: λ = 2, µ = 2

– 63 –

Positiv-rekurrenter Fall: λ = 1, µ = 2

– 64 –

Wir haben schon gezeigt:

πk0 (t) = −(λ + µ)πk (t) + λπk−1 (t) + µπk+1 (t)

π00 (t) = −λπ0 (t) + µπ1 (t)

Wir können annehmen, dass im positiv rekurrenten Fall πk0 (t) → 0 für

t → ∞ gilt. Daher ergibt sich

0 = −(λ + µ)πk + λπk−1 + µπk+1 ,

0 = −λπ0 + µπ1 .

Gleichgewichtsgleichungen

Es gilt

µπ1 = λπ0 ,

(λ + µ)πk = λπk−1 + µπk+1 .

und zusätzlich

∞

X

πk = 1.

k=0

– 65 –

Wie löst man die Gleichgewichtsgleichungen?

λπ0 = µπ1 ,

(λ + µ)πk = λπk−1 + µπk+1 .

Es gilt

π1

=

π2

=

λ

π0 = %π0

µ

(% + 1)π1 − %π0 = (% + 1)%π0 − %π0 = %2 π0

π3 = %3 π0

..

..

.

.

Vermutung: πk = %k π0 . Einsetzen bestätigt die Vermutung.

– 66 –

Da

P∞

k=0

πk = 1 gelten muss, ist

1=

∞

X

%k π0 = π0

k=0

1

1−%

Es folgt: π0 = 1 − %.

Grenzverteilung M/M/1

(

MM1)

Die Anzahl der Kunden hat im stationären Zustand folgende (geometrische) Grenzverteilung:

πk = P(X = k) = 1 − % %k , k ≥ 0

Die erwartete Anzahl von Kunden ist dann:

%

.

E (X ) =

1−%

Die Wahrscheinlichkeit, dass der Server besetzt ist (sog. Auslastung),

beträgt

1 − π0 = %.

– 67 –

Beispiel

In einer M/M/1-Warteschlange betrage die mittlere Zwischenankunftszeit 10 Minuten. Jeder Kunde verlangt eine Bearbeitungszeit von durchschnittlich 9 Minuten.

Die Auslastung beträgt also

λ

1/10

%= =

= 0.9 = 90%.

µ

1/9

Die erwartete Anzahl von Kunden im System ist

0.9

E (X ) =

= 9.

1 − 0.9

Die Wahrscheinlichkeit 10 Kunden im System vorzufinden, ist

P(X = 10) = (1 − %)%10 = 0.1 · 0.95 ≈ 0.035 = 3.5%.

– 68 –

4.4. PASTA

Zur Erinnerung: Wenn die Warteschlange mit der Startverteilung π

gestartet wird (P(X0 = k) = πK ) dann gilt

P(Xt = k) = πk ,

d.h. das System ist stationär und befindet sich im

Gleichgewichtszustand.

Angenommen T ist ein zufälliger Zeitpunkt. Gilt dann auch

P(XT = k) = πk ?

Gegenbeispiel I

Es sei T der erste Zeitpunkt, an dem Xt = 6 ist.

Dann ist trivialerweise

P(XT = 6) = 1 6= π6 .

– 69 –

Bei M/ · /1-Warteschlangen gilt aber das

PASTA-Prinzip

Eine Warteschlange besitze exponentiellen Zwischenankunftszeiten und

befinde sich im stationären Zustand.

Ist Tn die Ankunftszeit des nten Kunden, so gilt

P(XTn − = k) = πk .

Ein ankommender Kunde das System im Gleichgewicht, d.h. die Verteilung der Anzahl der Kunden zum Ankunftszeitpunkt hat dieselbe Verteilung wie X (der gerade ankommende Kunde wird nicht mitgezählt).

– 70 –

4.5. Die Warte- und Aufenthaltszeit im System

Wir nehmen an, das System befinde sich im Gleichgewicht und

definieren:

die Wartezeit Wn des n-ten Kunden in der Warteschlange,

die totale Aufenthaltszeit Sn des n-ten Kunden im System.

Es gilt offenbar

Sn = Wn + Bn .

– 71 –

Es seien Xn und Rn die Anzahl der Kunden im System und die

Restbedienzeit des Kunden in der Bedienstation zum Zeitpunkt der

Ankunft des n-Ten Kunden.

Es gilt:

Wn

=

(

0

Rn +

; Xn = 0

Pn−1

k=n−Xn +1

Bk

; Xn > 0

Die Wartezeit W hat dieselbe Verteilung, wie eine zufällige Summe von

Xn unabhängigen exponentiellen Zufallsvariablen, wobei Xn unabhängig

von diesen Zufallsvariablen ist.

– 72 –

Es seien C1 , C2 , . . . , Cn unabhängige Zufallsvariablen mit exponentieller

Verteilung mit Erwartungswert 1/µ, unabhängig von Xn .

Dann gilt

(

d

Wn ∼

0

PXn

k=1 Ck

;X = 0

;X > 0

Damit folgt

P(Wn ≤ x)

=

P(Xn = 0)

+P(Xn = 1 und C1 ≤ x)

+P(Xn = 2 und C1 + C2 ≤ x)

+...

=

P(Xn = 0)

+P(Xn = 1)P(C1 ≤ x)

+P(Xn = 2)P(C1 + C2 ≤ x)

+...

– 73 –

P(Wn ≤ x) = P(Xn = 0) +

∞

X

k

X

P(Xn = k)P(

Cj ≤ x)

j=1

k=1

Einsetzen der bekannten Formeln und Verwendung von PASTA ergibt:

∞

k−1

X

X

(µx)j P(Wn ≤ x) = 1 − % +

(1 − %)%k 1 − e −µx

j!

j=0

k=1

|

{z

}

Erlang-Verteilung

Also gilt

P(Wn ≤ x)

=

1−

∞

k−1

X

X

(µx)j

(1 − %)%k e −µx

j!

j=0

k=1

= 1 − (1 − %)e −µx

∞

X

j=1

= 1 − %e −µx

∞

X

(λx)j

j=1

– 74 –

j!

∞

(µx)j X k

%

j!

k=j+1

= 1 − %e −x(µ−λ) ,

x ≥ 0.

Für Sn = Wn + Bn erhalten wir genauso:

P(Sn ≤ x)

= P(C1 ≤ x)

+P(Xn = 1 und C1 + C2 ≤ x)

+P(Xn = 2 und C1 + C2 + C3 ≤ x)

+...

∞

k+1

X

X

=

P(Xn = k)P(

Cj ≤ x)

j=1

k=0

=

∞

X

(1 − %)%k 1 − e −µx

j=0

k=0

|

=

...

k

X

(µx)j {z

j!

Erlang-Verteilung

}

= 1 − e −(µ+λ)x .

Die Aufenthaltszeit Sn besitzt also eine exponentielle Verteilung mit

Erwartungswert 1/(µ − λ).

– 75 –

Verteilung der Warte- und Aufenthaltszeit

In der M/M/1 Warteschlange gilt im stationären Zustand

P(Wn ≤ x) = 1 − %e −x(µ−λ) ,

x ≥ 0.

und

P(Sn ≤ x) = 1 − e −x(µ−λ) ,

Für die Erwartungswerte gilt

E (Wn ) =

%

µ−λ

E (Sn ) =

1

.

µ−λ

und

– 76 –

x ≥ 0.

Mittelwertmethode

Mit PASTA gilt:

E (Sn ) = E (Xn ) E (B) + E (Bn )

| {z } | {z } | {z }

Kunden

im

System

Bearbeitungszeit

Eigene

Bearbeitungszeit

Dementsprechend erhalten wir

E (Sn )

1

1

1

+

E (Xn ) + 1

=

µ µ

µ

1

%

+1

µ 1−%

1

µ(1 − %)

1

.

µ−λ

= E (Xn )

=

=

=

– 77 –

4.6. Littles Gesetz

Wir haben gesehen, dass

E (Xn ) =

%

,

1−%

E (Sn ) =

1

µ−λ

gilt.

Es ist also

E (Xn ) =

%

λ

=

= λE (Sn ).

1−%

µ−λ

Littles Gesetz

Für G /G /n-Warteschlangen gilt im Gleichgewichtszustand

E (Xn ) = λE (Sn ),

d.h. die mittlere Kundenzahl ergibt sich aus dem Produkt der Ankunftsrate mit der mittleren Aufenthaltsdauer.

– 78 –

Zusammenfassung – Abschnitt 4

Definition der M/M/1-Warteschlange.

Stochastischer Prozess Xt =Anzahl der Kunden im System.

Verhalten für t → ∞: Rekurrenz, Transienz.

Grenzverteilung, falls positiv rekurrent (Verkehrsintensität % < 1):

geometrisch.

PASTA: Ein ankommender Kunde sieht die Grenzverteilung.

Wartezeit Wn besitzt beinahe exponentielle Verteilung.

Aufenthaltszeit Sn besitzt exponentielle Verteilung.

Littles Gesetz: E (Xn ) = λE (Sn ).

– 79 –

5. Markovketten in stetiger Zeit

5.1. Markovketten in diskreter Zeit

Eine Markovkette ist ein stochastischer Prozess (Xn )n=1,2,... mit

Werten in einer Menge {x1 , x2 , . . . , xN } (N = ∞ ist hier zugelassen),

für den die Verteilung von Xn nur von Xn−1 , nicht aber von der weiter

zurückliegenden Vergangenheit abhängt.

Genauer gesagt gilt für jedes n und beliebige j, k0 , k1 , . . . , kn

P(Xn = xj |X0 = xk0 , X1 = xk1 , . . . , Xn−1 = xkn−1 )

= P(Xn = xk |Xn−1 = xkn−1 ).

Eine Markovkette heißt homogen, wenn die

Übergangswahrscheinlichkeiten

P(Xn = xj |Xn−1 = xi )

nicht von n abhängen (sondern nur von i und j).

– 80 –

Wir gehen im folgenden immer von homogenen Markovketten aus und

schreiben kurz

pij = P(Xn = xj |Xn−1 = xi )

für die Übergangswahrscheinlichkeiten.

Dann können wir die Werte pij in

zusammenfassen:

p11

p21

P= .

..

pN1

einer quadratischen Matrix P = (pij )

p12

p22

..

.

...

...

..

.

p1N

p2N

.. .

.

pN2

...

pNN

Für N = ∞ ist diese Matrix unendlich.

Die Matrix P ist eine sog. stochastische Matrix, da die Zeilensummen

PN

j=1 pij für jede Zeile i gleich 1 sind.

– 81 –

Beispiel

(

MC.cdf)

In einer Fabrik arbeitet eine Maschine, deren Zustand jede Stunde

protokolliert wird. Es sei Xn der Zustand der Maschine nach n Stunden.

Mögliche Zustände:

A

B

C

voll funktionstüchtig

fehlerhaft

in Reparatur

Die Maschine geht mit folgenden Wahrscheinlichkeiten von einem Zustand in andere Zustände:

A

B

C

A

0.9

0.2

0.3

B

0.1

0

0

– 82 –

C

0

0.8

0.7

Beispiel (Forts.)

Die Übergangsmatrix ist

0.9

P = 0.2

0.3

0.1

0

0

0

0.8

0.7

Es gilt

P2

0.9 0.1 0

0.9 0.1 0

= 0.2 0 0.8 · 0.2 0 0.8

0.3 0 0.7

0.3 0 0.7

9 1 0

9 1 0

83

1

1

42

=

2 0 8 · 2 0 8 =

100

100

3 0 7

3 0 7

48

Zum Beispiel gilt

2

P(X2 = C |X0 = B) = p23

= 56%.

– 83 –

9

2

3

8

56 .

49

5.2. Übergangsdiagramm

Die Übergangswahrscheinlichkeiten stellt man gerne im sog.

Übergangsdiagramm dar.

Dabei werden die Zustände der Markovkette als Knoten, die möglichen

Übergänge als Pfeile gezeichnet.

Beispiel

Xn ist eine Markovkette mit 4 Zuständen {I , II , III , IV }:

– 84 –

Fabrikbeispiel (Forts.)

Die Übergangsmatrix für das Fabrikbeispiel war

0.9 0.1 0

P = 0.2 0 0.8

0.3

0

Übergangsdiagramm:

– 85 –

0.7

5.3. Markovketten in stetiger Zeit

Beispiel: Fabrik

In einer Fabrik arbeitet eine Maschine, deren Zustand nun

kontinuierlich beobachtet wird. Ein stochastischer Prozess Xt beschreibe den Zustand der Maschine zum Zeitpunkt t.

In jedem Zustand befinde sich der Prozess jeweils für eine exponentielle Zeitdauer:

A

B

C

Zustand

voll funktionstüchtig

fehlerhaft

in Reparatur

– 86 –

Mittl. Dauer

1 Tag

1 Stunde

3 Stunden

Beispiel (Forts.)

Die Übergangswahrscheinlichkeiten seien:

A

B

C

A

0

1/6

1

B

1

0

0

C

0

5/6

0

Beispiel: Befindet sich der Prozess zu Beginn im Zustand B, dann

bleibt er dort für eine exponentielle Zeitdauer mit Mittelwert 1h.

Danach springt er in den Zustand A mit Wahrscheinlichkeit 1/6 und

in den Zustand C mit Wahrscheinlichkeit 5/6.

– 87 –

Allgemein ist ein Markovkette in stetiger Zeit ein stochastischer

Prozess (Xt )t≥0 mit Zustandsraum S = {x1 , x2 , . . .} (u.U. unendlich),

der wie folgt verläuft:

Der Prozess befindet im Zustand xi jeweils für eine exponentiell

verteilte Zeit mit Parameter λi .

Danach springt der Prozess Xt in den Zustand xj mit

Wahrscheinlichkeit pij .

Die Markovkette (Yn )n=1,2,... , die die Folge der besuchten Zustände

angibt, besitzt die Übergangsmatrix P = (pij ).

– 88 –

5.4. Die Intensitätsmatrix

Xt sei eine zeitstetige Markovkette mit Zustandsraum S = {1, 2, 3, . . .}

und λ = (λ1 , λ2 , λ3 , . . .).

Die Intensitätsmatrix ist gegeben durch die Matrix

Q = (qij )i,j∈{1,2,...,N} mit

−λ1 λ1 p12 λ1 p13

λ2 p21 −λ2 λ2 p23

Q = λ · (P − I ) = λ p

−λ3

3 31 −λ3

..

..

..

.

.

.

...

. . .

.

. . .

..

.

Die Zeilensummen von Q sind null.

Die Elemente qij der Matrix Q haben keine unmittelbare probabilistische

Bedeutung. Man kann aus ihnen aber λ und P rekonstruieren:

λi = −qii

und pij = −qij /qii .

– 89 –

Beispiel: Fabrik (Forts.)

Es ist N = 3, λ = (1, 24, 8) und

0

P = 1/6

1

1

0

0 5/6

0

0

Die Intensitätsmatrix ist gegeben durch

−1

1

0

Q = λ(P − I ) = (1, 24, 8) 1/6 −1 5/6

1

0 −1

−1

1

0

= 4 −24 20 .

8

0

−8

– 90 –

5.5. Geburts- und Todesprozesse

Ein Geburts- und Todesprozess (GTP) ist eine Markovkette (Xt )t≥0

in stetiger Zeit mit unendlich vielen Zuständen {0, 1, 2, 3, . . .}, für die

lediglich Übergänge vom Zustand i in die Zustände i − 1 und i + 1

möglich sind.

(

GTP.cdf)

– 91 –

Um die Markov-Kette stochastisch zu beschreiben benötigen wir

die mittleren Aufenthaltsdauern 1/λi im Zustand i und

die Übergangsmatrix

0

p

10

0

P=

0

..

.

p01

0

p21

0

..

.

0

p12

0

p32

..

.

0

0

p23

0

..

.

...

. . .

. . .

. . .

..

.

für die Übergänge zwischen den Zuständen.

Wir schreiben

δi = λi pi,i−1 ,

(Sterberate)

βi = λi pi,i+1 .

(Geburtsrate)

Dann gilt δi + βi = λi .

– 92 –

Für die Intensitätsmatrix ergibt sich dann also

−λ0 λ0 p0,1

0

0

...

λ1 p1,0 −λ1 λ1 p1,2

0

. . .

Q= 0

λ2 p2,1 −λ2 λ2 p2,3 . . .

..

..

..

..

..

.

.

.

.

.

−β0

β0

0

0 ...

δ1 −(β1 + δ1 )

β1

0 . . .

= 0

.

δ2

−(β2 + δ2 ) β2 . . .

..

..

..

.. . .

.

.

.

.

.

Übergangsdiagramm:

– 93 –

Wir wollen den GTP für t → ∞ betrachten. Eine Grenzverteilung

existiert nur dann, wenn der Prozess positiv rekurrent ist.

Dazu müssen die Geburtsraten βk für große k klein sein im Verhältnis

zu den Todesraten δk .

Rekurrenz und Transienz

Ein GTP ist genau dann rekurrent, wenn

∞

X

δ1 δ2 · · · δk

=∞

β1 β2 · · · βk

(A)

k=1

ist. Endliche Systeme (mit βK = 0) sind immer rekurrent.

Hinreichend für positive Rekurrenz ist

βn

lim

< 1.

n→∞ δn

Gilt

βn

lim

> 1,

n→∞ δn

so ist der GTP transient.

– 94 –

(B)

Beispiel: Rekurrenter GTP

Es sei

βk = k + 1,

δk = k + 2.

Wir überprüfen Bedingung (A):

∞

∞

X

X

δ1 δ2 · · · δk

3 · 4 · · · (k + 1) · (k + 2)

=

β1 β2 · · · βk

2 · 3 · · · k · (k + 1)

k=1

k=1

=

∞

X

k +2

= ∞.

2

k=1

Der Geburts- und Todesprozess ist rekurrent.

Die Bedingung (B) ist nicht allerdings nicht erfüllt:

βn

n+1

= 1.

lim

= lim

n→∞ δn

n→∞ n + 2

– 95 –

Für einen rekurrenten GTP Xt muss noch keine Grenzverteilung

πk = lim P(Xt = k),

t→∞

k = 0, 1, 2, . . .

existieren.

Existenz einer Grenzverteilung

Für einen rekurrenten GTP Xt existiert eine Grenzverteilung genau dann,

wenn

∞

X

β0 β1 · · · βk−1

S=

<∞

(C)

δ1 δ2 · · · δk

k=1

ist.

In diesem Fall sagt man, der Prozess sei ergodisch.

– 96 –

Beispiel: Rekurrenter GTP (Fortsetzung)

Es sei wieder

βk = k + 1,

δk = k + 2.

Bedingung (C):

S

=

∞

X

β0 β1 · · · βk−1

k=1

=

∞

X

k=1

δ1 δ2 · · · δk

=

∞

X

k=1

1 · 2···k

3 · 4 · · · (k + 2)

2

<∞

(k + 1)(k + 2)

Die Bedingung ist erfüllt, eine Grenzverteilung existiert.

– 97 –

Ähnlich wie im Fall der M/M/1-Warteschlange erhalten wir für die

Grenzverteilung, falls sie existiert, die Gleichgewichtsgleichungen

β 0 π0 = δ 1 π1

(βk + δk )πk = βk−1 πk−1 + δk+1 πk+1 ,

und

P∞

k=0

Es ist

k ≥ 1.

πk = 1.

π1

=

β0

π0

δ1

π2

=

β0 β1

(β1 + δ1 )π1 − β0 π0

=

π0

δ1 δ2

δ2

Wir raten:

πk =

β0 β1 · · · βk−1

π0 .

δ1 δ2 · · · δk

Die Lösung ist in der Tat richtig (einsetzen!).

Die fehlende Wahrscheinlichkeit π0 = P(X = 0) erhält man aus der

P∞

Gleichung k=0 πk = 1.

– 98 –

Grenzverteilung

Für einen ergodischen GTP ist die Grenzverteilung gegeben durch

β0 β1 · · · βk−1

πk =

π0 .

δ1 δ2 · · · δk

Dabei ist

1

π0 =

.

1+S

Der unendliche Vektor π = (π0 , π1 , . . .) erfüllt die Gleichungen

1

1

π · Q = 0,

π · = 1.

..

.

– 99 –

Grenzverteilung (endlicher Fall)

Ein endlicher GTP Xt ist immer rekurrent. Gilt

β0 > 0, β1 > 0, . . . , βK = 0,

δ1 > 0, δ2 > 0, . . . , δK > 0.

(C’)

dann ist der Prozess auch ergodisch.

Für einen endlichen ergodischen GTP ist die Grenzverteilung gegeben

durch

β0 β1 · · · βk−1

π0 , k = 0, 1, . . . , K

πk =

δ1 δ2 · · · δk

und

1

π0 =

1+S

mit

K

X

β0 β1 · · · βk−1

S=

.

δ1 δ2 · · · δk

k=1

– 100 –

Zusammenfassung – Abschnitt 5

Markov-Ketten in diskreter Zeit.

Übergangsmatrix.

Übergangsdiagramm.

Markov-Ketten in stetiger Zeit: Intensitätsmatrix Q.

Geburts- und Todesprozesse: Bedingungen (A) und (B) für Rekurrenz.

Bedingung (C) für Ergodizität.

Grenzverteilung π.

– 101 –

6. M/M-Warteschlangensysteme

6.1. M/M/1

Wir betrachten erneut die einfache M/M/1-Warteschlange.

Der stochastische Prozess Xt (Kundenzahl zum Zeitpunkt t) ist ein

GTP mit Übergangsdiagramm:

Die Intensitätsmatrix ist dann

−λ

λ

0

0

µ −(µ + λ)

µ

0

Q= 0

µ

−(µ

+

λ)

λ

..

..

..

..

.

.

.

.

...

. . .

.

. . .

..

.

Also ist

βk = λ,

k = 0, 1, 2, . . .

– 102 –

δk = µ,

k = 1, 2, 3, . . .

Bedingung (A): Die Summe

∞

X

δ1 δ2 · · · δk

k=1

β1 β2 · · · βk

=

∞

X

µk

k=1

λk

∞

X

=

(1/%)k

k=1

ist unendlich, genau dann, wenn % ≤ 1 ist. Dann ist Xt rekurrent.

Bedingung (C): Die Summe

∞

∞

∞

X

X

X

β0 β1 · · · βk−1

λk

S=

=

=

%k

δ1 δ2 · · · δk

µk

k=1

k=1

k=1

ist endlich genau dann, wenn % < 1 ist. Dann existiert eine

%

Grenzverteilung und es ist S = 1−%

.

Grenzverteilung:

πk =

β0 β1 · · · βk−1

π0 = %k π0 .

δ1 δ2 · · · δk

Dabei ist

π0 =

1

= 1 − %.

1+S

– 103 –

Wir betrachten als nächstes allgemeinere Warteschlangenmodelle mit

exponentiellen Zwischenankunftszeiten und exponentiellen Bedienzeiten.

– 104 –

6.2. M/M/1/K - Warteschlange mit beschränkter

Kapazität

Wir gehen jetzt davon aus, dass das Warteschlangensystem nur eine

begrenzte Kapazität von K Plätzen besitzt.

Kunden, die das System besuchen und K Kunden im System (d.h.

K − 1 Kunden in der Warteschlange) vorfinden, verlassen das System

sofort und kommen nicht wieder.

Die Zwischenankunftszeiten und Bedienzeiten seien weiterhin

exponentiell verteilt mit Parametern λ und µ.

– 105 –

Übergangsdiagramm für Xt :

Xt ist ein Geburts- und Todesprozess mit

(

λ ;k ≤ K − 1

βk =

0 ;k ≥ K

und

δk =

(

µ ;k ≤ K

0

;k ≥ K + 1

.

Als endlicher GTP ist der Prozess automatisch rekurrent.

– 106 –

Der Prozess ist ergodisch, da (C’) erfüllt ist.

Es ist

S

=

K

X

β0 β1 · · · βk−1

δ1 δ2 · · · δk

k=1

=

K

X

(λ/µ)k

k=1

=

K

X

%k

k=1

(

=

K

% 1−%

1−%

; % 6= 1

K

;% = 1

Die Reihe konvergiert stets, also existiert eine Grenzverteilung.

– 107 –

Die Grenzverteilung ergibt sich dann aus den Formeln

β0 β1 · · · βk−1

πk =

π0

δ1 δ2 · · · δk

1

.

π0 =

1+S

In diesem Fall ist also

(

πk =

%k

;k ≤ K

0

;k > K

,

mit

1−%

1

= 1 − %K +1

π0 =

1

1+S

K +1

– 108 –

; % 6= 1

;% = 1

.

M/M/1/K-Grenzverteilung

In einer M/M/1/K-Warteschlange mit endlicher Kapazität ist die Grenzverteilung der Kundenzahl gegeben durch

1−% k

% ; % 6= 1

K +1

πk = P(X = k) = 1 −1 %

, k = 0, 1, 2, . . . , K .

;% = 1

K +1

Die Wahrscheinlichkeit als Kunde zurückgewiesen zu werden ist dann:

(

1−%

K

; % 6= 1,

K +1 %

P(X = K ) = 1−%

1

; % = 1.

K +1

Die Auslastung beträgt

(

P(X > 0) =

%−%K +1

1−%K +1

K

K +1

– 109 –

; % 6= 1

;% = 1

.

Auslastung P(X > 0) in Abhängigkeit von ρ ∈ (0, 1) und

K ∈ {1, 2, . . . , 10} (abnehmender Kontrast).

– 110 –

Wahrscheinlichkeit der Zurückweisung in Abhängigkeit von ρ ∈ (0, 1)

und K ∈ {1, 2, . . . , 10} (abnehmender Kontrast).

– 111 –

Für K → ∞ und % < 1 ergibt sich wie zu erwarten die Verteilung der

M/M/1-Warteschlange:

1−% k

% = (1 − %)%k .

lim πk = lim

K →∞

K →∞ 1 − %K +1

Die Wahrscheinlichkeit einer Zurückweisung strebt für K → ∞

monoton fallend gegen Null (Annäherung an die

M/M/1-Warteschlange).

Für % > 1 strebt die Wahrscheinlichkeit einer Zurückweisung monoton

fallend gegen den Grenzwert

1−% K

lim P(X = K ) = lim

%

K →∞

K →∞ 1 − %K +1

1

1

= (1 − %) lim −K

=1− .

K →∞ %

−%

%

Diese Wahrscheinlichkeit kann auch bei noch so großem Warteraum

nicht unterboten werden.

– 112 –

6.3. Spezialfall: M/M/1/1

Grenzverteilung:

1

,

1+%

%

π1 = P(X = 1) =

.

1+%

π0 = P(X = 0) =

Die Wahrscheinlichkeit als Kunde zurückgewiesen zu werden ist dann

gleich der Auslastung:

P(X = 1) =

– 113 –

%

.

1+%

Beispiel

Pralinen erreichen eine Verpackungsmaschine als Poisson-Prozess mit

Intensität µ. Erreicht eine Praline die Maschine, ohne dass dort bereits eine Verpackung vorhanden ist, wird sie zur nächsten Maschine

weitergereicht. Die entsprechenden Verpackungen kommen mit konstanter Rate λ an der Verpackungsstation an und warten dort auf

jeweils eine Praline. Ist die Maschine mit einer wartenden Packung

besetzt, so wird die Verpackung ebenfalls weitergereicht.

Ist eine Verpackung vorhanden, so wird eine ankommende Praline

unmittelbar verpackt und verlässt die Verpackungsmaschine sofort.

– 114 –

Beispiel (Forts.)

Es handelt sich um ein M/M/1/1-System, weil die Restwartezeit der

Verpackungen auf die nächste Praline exponentiell ist. Diese Restwartezeit entspricht der Bedienzeit im M/M/1/1-System.

Die Wahrscheinlichkeit einer ”Zurückweisung” beträgt für die Pralinen

1/(1 + %), für die Verpackungen %/(1 + %).

– 115 –

6.4. M/M/∞ - Beliebig viele Server

Es seien jetzt beliebig viele Server vorhanden:

In der Praxis ist die Zahl der Bedienstationen meist endlich, aber u.U.

genügend groß, um eine M/M/∞-Modell anzunehmen (siehe auch den

Abschnitt über die M/M/m-Warteschlange).

Die ankommenden Kunden wählen jeweils einen freien Server aus und

können sofort bedient werden, d.h. es ist keine Warteschlange nötig.

– 116 –

Minimum exponentiell verteilter Zufallsvariablen

Es seien X und Y exponentiell verteilt mit Parameter µ.

Dann gilt für die Verteilungsfunktion des Minimums von X und Y

P(min X , Y ≤ x)

= 1 − P(min{X , Y } > x)

= 1 − P(X > x, Y > x)

= 1 − P(X > x)P(Y > x)

= 1 − e −µx e −µx

= 1 − e −2µx .

Allgemeiner gilt: Das Minimum von k exponentiell verteilten Zufallsvariablen mit Parameter µ besitzt eine exponentielle Verteilung mit

Parameter kµ.

– 117 –

Sind k Server besetzt, so besitzt die Wartezeit bis zum nächsten

Abgang eine exponentielle Verteilung mit Parameter kµ.

Daher ergibt sich für das Übergangsdiagramm:

GTP mit βk = λ und δk = k · µ.

Bedingung (A): Es ist

∞

X

δ1 δ2 · · · δk

k=1

β1 β2 · · · βk

∞

X

1 · 2 · · · k · µk

λk

=

k=1

=

∞

X

k=1

Also ist der Prozess Xt immer rekurrent.

– 118 –

k!(1/%)k = ∞

Bedingung (C):

∞

X

β0 β2 · · · βk−1

S=

δ1 δ2 · · · δk

=

∞

X

%k

k=1

k=1

k!

= e % − 1 < ∞,

daher existiert in jedem Fall eine Grenzverteilung.

Es gilt

πk =

β0 β2 · · · βk−1

%k

π0 =

π0 .

δ1 δ2 · · · δk

k!

und

π0 =

1

= e −ρ .

1+S

– 119 –

M/M/∞-Grenzverteilung

Die Grenzverteilung der Kundenzahl eines M/M/∞-Systems ist

%k −%

e ,

k!

d.h. im stationären Zustand besitzt die Kundenzahl eine PoissonVerteilung mit Rate %.

πk = P(X = k) =

Die Auslastung beträgt

P(X > 0) = 1 − e −ρ .

Die erwartete Anzahl von Kunden ist

E (X ) = %,

Var(X ) = %.

Für großes % ist X etwa normalverteilt mit Erwartungswert % und

Varianz % (Zentraler Grenzwertsatz):

(k−%)2

1

P(X = k) ≈ √

e − 2% .

2π%

– 120 –

Beispiel

In Hamburg leben etwa 1.7 Millionen Menschen (≈ ∞). Angenommen jeden Tag infizieren sich durchschnittlich 5 Einwohner mit einer

bestimmten Krankheit, die dann im Mittel eine Woche andauere. Wir

nehmen eine exponentielle Krankheitsdauer an. Wie viele Einwohner sind

zu einem beliebigen Zeitpunkt infiziert, wenn man von einer konstanten

Ansteckungsrate ausgeht?

Mit λ = 5 d −1 und µ = 1/7 d −1 erhalten wir πk =

Wahrscheinlichkeiten πk

%k −%

k! e

=

35−k

k!

e −35 .

Normalverteilung mit µ = % und σ = % (blau)

– 121 –

6.5. M/M/m - System mit m Bedienstationen

Wir betrachten ein System mit m Bedienstationen mit Bedienrate µ,

Ankunftsrate λ und unbegrenzter Kapazität

Als Verkehrsintensität setzen wir hier

λ

%

ξ=

= .

mµ

m

– 122 –

Die Sterberate ist von der Anzahl der in der Bedienstation befindlichen

Kunden abhängig.

GTP mit Übergangsdiagramm:

Dann sind die Geburts- und Sterberaten gegeben durch

βk = λ,

(

kµ ; k < m

δk =

.

mµ ; k ≥ m

– 123 –

Bedingung (A):

∞

X

δ1 δ2 · · · δk

=∞

β1 β2 · · · βk

k=1

Es ist für k ≥ m

µk · 1 · 2 · · · m · m · · · m

λk

µk m!mk−m

=

λk

m k

.

= m!m−m

%

Die obige Reihe divergiert also, wenn m ≥ % also

δ1 δ2 · · · δk

β1 β 2 · · · β k

=

ξ = %/m ≤ 1

ist. Genau dann ist der Prozess rekurrent.

– 124 –

Bedingung (C) für Ergodizität:

∞

X

β0 β1 · · · βk−1

S =

δ1 δ2 · · · δk

k=1

=

m−1

X

k=1

=

m−1

X

k=1

∞

β0 β1 · · · βk−1 X β0 β1 · · · βk−1

+

δ1 δ2 · · · δk

δ1 δ2 · · · δk

k=m

k

%

+

k!

∞

X

k=m

m−1

∞

X %k

%

mm X

=

+

(%/m)k

m!mk−m

k!

m!

k

k=1

k=m

Die Reihe konvergiert für % < m, also ξ = %/m < 1.

Es ist

1+S

=

1+

m−1

X

k=1

=

m−1

X

k=0

%k

1

mm

+

(%/m)m

k!

m!

1 − %/m

%k

%m 1

+

.

k!

m! 1 − ξ

– 125 –

M/M/m-Grenzverteilung

Für ξ = %/m < 1 ist die Kundenzahl einer M/M/m-Warteschlange

rekurrent und ergodisch. Die Grenzverteilung ist gegeben durch

k

% π0

;k ≤ m

,

πk = P(X = k) = k!m

m ξ k π0 ; k > m

m!

m−1

−1

X %k

%m

π0 =

+

.

k!

m!(1 − ξ)

k=0

Der Fall m = 1 entspricht der M/M/1-Warteschlange (geometrische

Grenzverteilung).

Für m → ∞ erhalten wir, wie zu erwarten, die Grenzverteilung der

M/M/∞-Warteschlange (Poisson-Verteilung).

– 126 –

Beispiel: Postfiliale

In einer Postfiliale dauert eine Bedienung am Schalter im Mittel eine

Minute. Die Kunden erreichen die Filiale mit einer konstanten Rate

von 5 Kunden pro Minute. Die Filiale hat eine Warteschlange für 6

Schalter eingerichtet.

m = 6, λ = 5 min−1 , µ = 1 min−1 , % = 5, ξ = 5/6.

Das System ist rekurrent und ergodisch, da ξ < 1 ist.

Wahrscheinlichkeit eines leeren Systems:

!−1

!−1

5

5

X

X

5k

56

5k

55

π0 =

+

=

+

≈ 0.45%.

k!

6!(1 − 5/6)

k!

4!

k=1

Grenzverteilung:

k=1

k

(5/6)

8 k!

πk =

k

1765

(5/6)

6k−6 6!

– 127 –

;k ≤ 6

.

;k > 6

Grenzwahrschienlichkeit πk , k = 0, 1, 2, . . . 30 für ξ = 5/6 und

m = 1 (rot),

m = 6 (grün) und

m = 20 (blau).

– 128 –

Die Wahrscheinlichkeit, dass ein ankommender Kunde warten muss, die

Wartewahrscheinlichkeit, ist dann (wir verwenden wieder PASTA):

∞

X

P(W > 0) = P(X ≥ m) =

πk

k=m

=

∞

∞

X

mm X k

mm k

ξ

ξ π0 = π0

m!

m!

k=m

k=m

m

=

π0

m m

ξ

m!

∞

X

ξ k = π0

k=0

%m

.

m!(1 − ξ)

Erlang-C-Formel

Die Wahrscheinlichkeit, dass ein ankommender Kunde in einem

M/M/m-Wartesystem warten muss ist

−1

m−1

X %k

%m

%m

P(W > 0) = π0

, π0 =

+

.

m!(1 − ξ)

k!

m!(1 − ξ)

k=1

– 129 –

Für die mittlere Warteschlangenlänge ergibt sich

∞

X

E (L) =

(k − m)πk

k=m+1

=

=

=

∞

π0 m m X

(k − m)ξ k

m!

k=m+1

∞

m m X

π0 m ξ

m!

∞

m X

π0 %

m!

kξ k

k=1

kξ k

k=0

∞

X

k=0

π0 %m

ξ

=

m! (1 − ξ)2

ξ

= P(W > 0)

.

1−ξ

– 130 –

kq k =

q

2

(1 − q)

Es gilt dann für die mittlere Wartezeit:

1

1 E (W ) = P(W > 0)

+ E (L|W > 0)

mµ

mµ

P(W > 0) + E (L|W > 0)P(W > 0)

P(W > 0) + E (L)

=

=

mµ

mµ

=

ξ

P(W > 0) + P(W > 0) 1−ξ

mµ

=

P(W > 0)

1

= E (L).

mµ(1 − ξ)

λ

M/M/m - Warteschlangenlänge und Wartezeit

Die mittlere Warteschlangenlänge beträgt

E (L) = P(W > 0)

ξ

.

1−ξ

Für die mittlere Wartezeit gilt

P(W > 0)

1

E (W ) =

= E (L).

mµ(1 − ξ)

λ

(Zweite Version von Littles Gesetz).

– 131 –

Drei Varianten des Littleschen Gesetzes

Allgemein gelten für G /G /n-Warteschlangen im Gleichgewichtszustand

folgende Beziehungen für die zu erwartenden Kundenzahlen und die zu

erwartenden Aufenthaltsdauern:

(1)

E (Kunden System) = λE (Aufenthalt im System)

E (X ) = λE (S).

(2)

E (Kunden Schlange) = λE (Aufenthalt in der Schlange)

E (L) = λE (W )

(3)

E (Kunden Bedienstation) = λE (Aufenthalt in der Bedienstation)

E (Q) = λE (B)

– 132 –

Beispiel: Postfiliale (Forts.)

Wartewahrscheinlichkeit:

P(W > 0) = π0

%m

8 56

=

≈ 0.5902 = 59.02%.

m!(1 − ξ)

1765 5!

Mittlere Warteschlangenlänge:

5/6

ξ

= 0.5902

= 5 · 0.59 ≈ 2.951

E (L) = P(W > 0)

1−ξ

1/6

Mittlere Wartezeit in der Schlange:

P(W > 0)

0.5902

=

= 0.5902.

E (W ) =

mµ(1 − ξ)

6 · 1 · (1 − 5/6)

– 133 –

P(W > 0) und E (L) für ξ ∈ (0, 1) und

m = 1 (rot),

m = 6 (grün) und

m = 100 (blau).

– 134 –

6.6. Erlangsches Verlustmodell (M/M/m/m)

Wir betrachten ein System mit m Bedienstationen aber ohne

Warteschlange (Kapazität m):

Historisch: Call-Center mit m Kanälen, Anrufe mit Rate λ,

Gesprächsdauer im Mittel 1/µ. Wenn alle Kanäle besetzt sind, gehen

die Anrufe verloren (Agner Krarup Erlang).

– 135 –

Übergangsdiagramm:

GTP mit βk = λ und δk = kµ.

Das System ist rekurrent und die Grenzverteilung existiert immer.

Grenzverteilung: ”abgeschnittene” Poisson-Verteilung

πk =

β0 β2 · · · βk−1

%k

π0 =

π0 ,

δ1 δ2 · · · δk

k!

mit

1

π0 = Pm

%j

j=0 j!

– 136 –

.

k ≤m

M/M/m/m - Erlang-B-Formel

Im Erlangschen Verlustmodell ist die Grenzverteilung gegeben durch

πk =

k!

%k

Pm

%j

j=0 j!

,

k = 0, 1, 2, . . . , m.

Die Wahrscheinlichkeit, dass Kunden zurückgewiesen werden, ist durch

die Erlang-B-Formel (Erlangsche Verlustformel) gegeben:

%m

πm =

Pm %j .

m! j=0 j!

Der Fall m = 1 enstpricht der M/M/1/1-Warteschlange.

Für m → ∞ ergibt sich die Poisson-Verteilung des M/M/∞ Systems:

πk = e −%

%k

,

k!

k = 0, 1, 2, . . .

– 137 –

Beispiel

Ein Autobahnparkplatz wird entworfen. Es stehen nach der Fertigstellung

5 Parkplätze zur Verfügung. Man geht von einer Aufenthaltsdauer der

Gäste von durchschnittlich 15 Minuten aus (exponentielle Verteilung).

Autofahrer, die einen komplett besetzten Parkplatz vorfinden fahren weiter zur nächsten Parkgelegenheit. Es fahren im Mittel stündlich 10 Autos

den Parkplatz an.

Es ist m = 5, λ = 10, µ = 4, % = 5/2, also ergibt sich für die Wahrscheinlichkeit einen vollen Parkplatz vorzufinden

π5 =

5!

(5/2)5

P5 (5/2)j

j=0

j!

= 0.0697 ≈ 7%.

– 138 –

Wir berechnen die mittlere Kundenzahl:

∞

∞

X

X

kπk =

kπk

E (X ) =

k=0

k=1

m

X

%k

= π0

k

k!

k=1

m

X

= %π0

k=1

= %π0

m−1

X

k=0

%k−1

(k − 1)!

%k

k!

1

%m −

π0

m!

1

πm = %π0

−

π0

π

0

= % 1 − πm .

= %π0

– 139 –

Grenzwahrscheinlichkeiten πk und E (X ) (vertikale Linien) für ein

M/M/10/10-System,

% = 1/2 (rot),

% = 5 (grün) und

% = 20 (blau).

– 140 –

6.7. Engset-Modell für endliche Population

Wir nehmen jetzt an, es gäbe insgesamt N Kunden und K ≤ N

Bedienstationen.

Beispiel: N = 6 und K = 5:

Jeder Kunde außerhalb der Bedienstation erzeuge einen Eingangsstrom

mit Rate λ (Aktivierung nach einer exponentiellen Zeitperiode).

– 141 –

Alternative Darstellung:

– 142 –

Es beschreibe X die Anzahl der Kunden, die in der eigentlichen

Bedienstation bedient werden.

Dann ist X ein GTP mit βk = λ(N − k) und δk = kµ für k ≤ K :

Der Prozess ist rekurrent, eine Grenzverteilung existiert stets.

Grenzverteilung für 0 ≤ k ≤ K

πk

β0 β2 · · · βk−1

λk N(N − 1) · · · (N − k + 1)

π0 =

π0

δ1 δ2 · · · δk

µk k!

N k

=

% π0

k

=

mit

π0 =

K −1

X

N j

%

.

j

j=0

– 143 –

Engset-Modell

Im Engset-Modell mit endlicher Population N und K ≤ N Bedienstationen ist die Grenzverteilung der Kundenzahl gegeben durch die EngsetVerteilung:

N k

k %

πk = PK N , k = 0, 1, . . . , K .

j

j=0 j %

– 144 –

Beispiel

Bei einem kleinen Online-Buchversand gibt es 250 registrierte Kunden, die, insofern sie nicht auf laufenden Bestellungen warten, durchschnittlich einmal in 50 Tagen ein Buch bestellen.

Es gibt 3 Mitarbeiter, die durchschnittlich 2 Aufträge pro Tag abwickeln.

Wie groß ist die Wahrscheinlichkeit, dass alle drei Mitarbeiter

beschäftigt sind?

Es ist λ = 1/50, µ = 2, % = 1/100, N = 250, K = 3, also gilt

250

3

3 (1/100)

π3 =

250

2

1 + 250(1/100) + 2 (1/100)2 + 250

3 (1/100)

≈ 0.28 = 28%.

– 145 –

6.8. Sonderfall: Engset-Modell mit K = N

Für die Grenzverteilung gilt dann

N k

k %

πk = P N N ,

j

j=0 j %

k = 0, 1, . . . , N.

Es ist (binomische Formel)

N X

N j

% = (1 + %)N .

j

j=0

– 146 –

Dann gilt

πk

=

N

k

%k

(1 + %)N

% k

N

k

1+%

(1 + %)k

(1 + %)N

N

% k

1 N−k

=

.

k

1+%

1+%

=

Engset-Modell – Spezialfall

Im Engset-Modell mit N Kunden und N Bedienstationen ist die Grenzverteilung der Kundenzahl gegeben durch eine Binomialverteilung mit

Parameter %/(1 + %):

N

% k

1 N−k

πk =

, k = 0, 1, . . . , N.

k

1+%

1+%

– 147 –

7. Offene Netzwerke

7.1. Der Satz von Burke

Wir betrachten zunächst eine M/M/1-Warteschlange und nehmen

wieder % < 1 an, so dass X eine Grenzverteilung besitzt. Das System

befinde sich im stationären Zustand.

Es bezeichne Mt die Anzahl der Kunden, die nach erfolgter Bedienung

das System bis zum Zeitpunkt t verlassen haben (Abgangsprozess).

– 148 –

Ankunftsprozess Nt

(hellblau)

Kundenzahl Xt

(rot)

Abgangsprozess Mt

(dunkelblau)

Es gilt offenbar:

M0 = 0,

Mt ist stückweise konstant und macht Sprünge der Höhe eins.

Ist Mt ein Poisson-Prozess? Wenn ja, wie groß ist seine Intensität?

– 149 –

Die Wahrscheinlichkeit, dass im Zeitintervall [t, t + ∆] ein Kunde das

System verlässt, ist

≈ (1 − %) ·0 + % ·µ · ∆ = λ · ∆.

|{z}

| {z }

P(X =0)

P(X 6=0)

Die Wahrscheinlichkeit, dass in dem Zeitraum mehr als ein Kunde das

System verlässt, ist verschwindend klein.

Mit etwas mehr Mühe kann man zeigen:

Abgangsprozess der M/M/1-Warteschlange

Der Abgangsprozess Mt einer M/M/1-Warteschlange im Gleichgewichtszustand ist erneut ein Poisson-Prozess mit Rate λ.

– 150 –

Allgemein gilt für einen Geburts- und Todesprozess Xt mit Geburtsraten

βk = λ für die Wahrscheinlichkeit, dass im Zeitintervall [t, t + ∆] ein

Sprung Xt 7→ Xt − 1 nach unten erfolgt,

∞

X

≈

πk δ k · ∆

k=1

=

∞

X

k=1

=

∞

X

λk

π0 δ k · ∆

δ1 δ2 · · · δk

λk

π0 · ∆

δ1 δ2 · · · δk−1

k=1

∞

X

= λ

k=0

= λ

∞

X

λk

π0 · ∆

δ1 δ2 · · · δk

πk · t = λ · ∆.

k=0

– 151 –

Satz von Burke

Es sei Xt ein rekurrenter und ergodischer Geburts- und Todesprozess mit Geburtsraten βk = λ.

Dann gilt:

(1) Der stochastische Prozess

Mt , der die Sprünge nach

unten (Tode) zählt, ist ein

Poisson-Prozess mit Rate λ.

(2) {Ms |s ≤ t} ist unabhängig

von Xt .

{Ms |s < t} ist natürlich keinesfalls

unabhängig von {Xs |s ≤ t}.

Der Satz gilt selbstverständlich nur

im stationären Zustand, also wenn

das System bereits mit der stationären Verteilung startet.

– 152 –

7.2. M/M/1-Tandem-Warteschlange

Eine M/M/1-Tandem-Warteschlange besteht aus einem System von

zwei hintereinander geschalteten M/M/1-Warteschlangen und

Bedienstationen.

Der Abgangsprozess an der ersten Station ist wieder Poisson mit

Intensität λ.

Demnach verhält sich die zweite Warteschlange genau wie eine

M/M/1-Warteschlange. Der Poisson-Ankünftsprozess besitzt die

Intensität Λ = λ.

Es sei %i = λ/µi die Verkehrsintensität der i-ten Station.

– 153 –

Der Kundenzahlprozess im gesamten System ist offenbar dann

rekurrent und ergodisch, wenn max{%1 , %2 } < 1 ist.

Wir gehen davon aus, dass sich das System im stationären Zustand

befindet.

Es seien X1 und X2 die Kundenzahlen in den beiden Systemen 1 und 2.

Die Zufallsvariablen X1 und X2 besitzen jeweils eine geometrische

Verteilung

P(X1 = k) = (1 − %1 )%k1 ,

P(X2 = m) = (1 − %2 )%m

2 .

Darüber hinaus sind X1 und X2 sind unabhängig (Burke), so dass für die

gemeinsame stationäre Verteilung gilt eine Produktform vorliegt:

P(X1 = k, X2 = m) = P(X1 = k)P(X2 = m)

= (1 − %1 )(1 − %2 )%k1 %m

2 .

– 154 –

Für die Gesamtzahl X an Kunden im System gilt dann

P(X = n)

=

P(X1 + X2 = n)

∞

X

=

P(X1 + X2 = n und X1 = k)

k=0

=

=

n

X

k=0

∞

X

P(X1 + X2 = n|X1 = k)P(X1 = k)

P(X2 = n − k|X1 = k)(1 − %1 )%k1

k=0

=

(1 − %1 )

n

X

P(X2 = n − k)%k1

k=0

=

(1 − %1 )(1 − %2 )

n

X

%n−k

%k1

2

k=0

=

(1 − %1 )(1 − %2 )%n2

– 155 –

1 − (%1 /%2 )n+1

.

1 − %1 /%2

M/M/1-Tandem

In einer M/M/1-Tandem-Warteschlange mit max{%1 , %2 } < 1 gilt für

die stationäre Verteilung der Gesamtzahl der Kunden

%n+1

− %1n+1

2

.

%2 − %1

Die gemeinsame Verteilung von X1 und X2 ist

P(X = n) = (1 − %1 )(1 − %2 )

P(X1 = k, X2 = m) = (1 − %1 )(1 − %2 )%k1 %m

2 .

Speziell gilt für die Marginalverteilungen

P(X1 = k) = (1 − %1 )%k1 ,

P(X2 = m) = (1 − %2 )%m

2 .

Die M/M/1-Tandem-Warteschlange ist ein Spezialfall eines offenen

Netzwerks von Warteschlangen.

– 156 –

7.3. Offene Netzwerke

In offenen Netzwerken erreichen Kunden von außen ein System von N

Warteschlangen/Servern und verlassen das System auch wieder.

Ankünfte am Server i von außerhalb des Systems bilden einen

Poisson-Prozess mit Rate λi .

Markov-Routing: Kunden, die die Bedienstation i verlassen, laufen den

Server j mit Wahrscheinlichkeit pij an.

– 157 –

Wie üblich fassen wir die Wahrscheinlichkeiten pij zu einer Matrix

zusammen:

p11 p12 . . . p1N

p21 p22 . . . p2N

P= .

..

..

..

..

.

.

.

pN1

pN2

...

pNN

Die Wahrscheinlichkeit, nach dem Server i keine weitere Bedienstation

anzulaufen, sondern das System zu verlassen, sei pi0 .

Achtung: P ist keine stochastische Matrix, da die Zeilensummen nicht

eins, sondern 1 − pi0 sind.

– 158 –

7.4. Durchsatz

Der Durchsatz Λi beschreibt die effektive Ankunftsrate am Server i.

Erhaltungsprinzip:

In diesem Beispiel gilt: Λ3 = λ3 + Λ1 · p13 + Λ2 · p23 .

– 159 –

Allgemein ergibt sich

Λi = λi +

N

X

Λj pji

j=1

bzw. in Matrizenschreibweise

Λ = λ + Λ · P,

t

wobei λ = (λ1 , . . . , λN ) ist.

Der Durchsatzvektor Λ = (Λ1 , . . . , ΛN ) ist also eine Lösung des linearen

Gleichungssystems

(I − P)T Λ = λ.

Dann ist γi =

Λi

die (effektive) Verkehrsintensität an der i-ten

µi

Bedienstation.

– 160 –

7.5. Satz von Jackson

Satz von Jackson

Eine Grenzverteilung für die Verteilung von X1 , . . . , Xn existiert, wenn

γi < 1 für jeden Server i = 1, 2, . . . , N gilt.

Es sei Xi die Anzahl von Kunden am Server i im Gleichgewicht. Dann

sind die Zufallsvariablen X1 , X2 , . . . , XN unabhängig.

Es gilt P(Xi = k) = (1 − γi )γi k , also (wg. der Unabhängigkeit)

N

Y

P(X1 = k1 , X2 = k2 , . . . , XN = kN ) =

(1 − γi )γi ki .

i=1

Jede einzelne Warteschlange verhält sich also wie ein unabhängiges

M/M/1-Wartesystem.

– 161 –

Beispiel: M/M/1-Tandem-Warteschlange

Gegeben Seien zwei

min{µ1 , µ2 } > λ.

M/M/1-Warteschlangen

in

Serie

mit

Dann ist

λ1 = λ,

λ2 = 0,

P=

0

0

1

,

0

p20 = 1.

(I − P)T Λ = λ:

1

−1

0

1

λ

0

1 0

0 1

λ

⇒ Λ1 = λ,

λ

Λ2 = λ.

Die zweite Warteschlange verhält sich wie M/M/1:

λ λ k

λ λ k

P(X1 = k) = 1 −

, P(X2 = k) = 1 −

µ1 µ1

µ2 µ2

– 162 –

Beispiel: Tandem-Warteschlange mit Rücklauf

Kunden verlassen mit Wahrscheinlichkeit p den Server 1 in Richtung

Server 2. Mit Wahrscheinlichkeit 1 − p müssen Sie ein weiteres mal

die Bedienstation 1 passieren. Es sei min{pµ1 , µ2 } > λ.

λ1 = λ,

λ2 = 0,

P=

1−p

0

p

,

0

p20 = 1.

(I − P)T Λ = λ:

p

−p

0

1

λ

0

1 0

0 1

λ/p

⇒ Λ1 = λ/p,

λ

λ λ k

P(X1 = k) = 1 −

,

pµ1 pµ1

– 163 –

Λ2 = λ.

λ λ k

P(X2 = k) = 1 −

.

µ2 µ2

Beispiel

Gegeben sei folgendes System:

Es ist

0

P = 1

1

1/3 1/3

1

0

0 , (I − P)T = −1/3

0

0

−1/3

– 164 –

−1

1

0

−1

λ

0 , λ = 0

1

0

...

1

−1/3

−1/3

−1

1

0

−1

0

1

λ

0

0

1

0

0

−1

2/3

−1/3

−1

−1/3

2/3

λ

λ/3

λ/3

1 −1 0

0 2/3 0

0

0 1

1

0

0

2λ

2/3λ

λ

Damit ist

Λ = (3λ, λ, λ),

γ = (3%, %, %).

Das System ist ergodisch, wenn % < 1/3 ist.

– 165 –

−1

2/3

0

1

0

0

−1

−1/3

1/2

0

1

0

0

0

1

λ

λ/3

λ/2

3λ

λ

λ

Beispiel

Eine Maschine A produziert Flugzeugbauteile (µ = 1 h−1 ). Diese werden

anschließend an einer Station B geprüft (mittlere Dauer 12 Minuten).

Im Mittel sind 60 Prozent der Bauteile ohne Beanstandung, 30 Prozent

werden in einer zweiten Maschine C bearbeitet (im Mittel 30 Minuten

lang) und verlassen danach das System, 10 Prozent müssen ein weiteres

Mal die Maschine A passieren.

Wie groß darf der Eingangsstrom von Teilen maximal sein, wenn man

ein ergodisches System erhalten möchte?

Wie groß ist die Wahrscheinlichkeit im System A 7 Kunden und im

System B 4 Kunden vorzufinden, wenn λ = 0.5 ist?

– 166 –

...

Es ist

0

λ

λ = 0 , P = 0.1

0

0

1 0

1

0 0.3 , (I − P)T = −1

0 0

0

– 167 –

−0.1

1

−0.3

0

0

1

...

1

−1

0

1

0

0

−0.1 0 λ

1 0 0

−0.3 1 0

−0.1 0

λ

0.9 0

λ

0 1 λ/3

1

0

0

−0.1 0

0.9 0

−0.3 1

λ

λ

0

1 0 0 10/9λ

0 1 0 10/9λ

0 0 1 1/3λ

Wir erhalten also

Λ = (10/9λ, 10/9λ, 1/3λ),

γ = (10/9λ, 2/9λ, 1/6λ).

Bedingung für Ergodizität: 10/9λ < 1, also λ < 0.9. Mit λ = 0.5 ergibt

sich γ = (5/9, 1/9, 1/12):

4 5 7 8 1 4

32 · 57

P(X1 = 7, X2 = 4) =

=

= 9.8 · 10−7 ≈ 10−6 .

9 9 9 9

913

– 168 –

8. Geschlossene Netzwerke

8.1. Grenzverteilung

In geschlossenen Netzwerken (Gordon-Newell-Netzwerke) gibt es eine

feste Anzahl K von Kunden, die sich im System bewegen.

Wir nehmen an, dass sich K Kunden im System befinden.

– 169 –

Grenzverteilung geschlossener Netzwerke

(1)

Eine Grenzverteilung existiert stets.

(2)

Die Zufallsvariablen X1 , X2 , . . . , XN sind im allgemeinen nicht

unabhängig.

(3)

Es sei Λ = (Λ1 , . . . , ΛN ) eine (nicht eindeutige) Lösung des

linearen Gleichungssystems

(I − P)t Λ = 0

und γi = Λi /µi .

Dann gilt für die gemeinsame Verteilung der Kundenzahlen

P(X1 = k1 , X2 = k2 , . . . , XN = kN ) =

N

1 Y ki

γi .

C

i=1

Dabei ist die Konstante C gegeben durch

C=

X

N

Y

k1 +...+kN =K i=1

– 170 –

γi ki .

Wie berechnet man die Summe

X

C=

N

Y

γi ki

?

k1 +...+kN =K i=1

Beispiel: N = 3, K = 4.

k1

0

0

0

0

0

k2

0

1

2

3

4

k3

4

3

2

1

0

Insgesamt gibt es

k1

1

1

1

1

k2

0

1

2

3

k3

3

2

1

0

6

2

K +N−1

N−1

=

k1

2

2

2

3

3

4

k2

0

1

2

0

1

0

k3

2

1

0

1

0

0

= 15 Fälle.

Dann ergibt sich

C = γ34 + γ21 γ33 + γ22 γ33 + γ23 γ31 + γ24

+ γ1 γ33 + γ1 γ21 γ32 + γ1 γ22 γ31 + γ1 γ23

+ γ12 γ2 γ32 + γ12 γ2 γ21 γ31 + γ12 γ2 γ22 + γ13 γ3 + γ13 γ2 + γ14 .

– 171 –

Beispiel