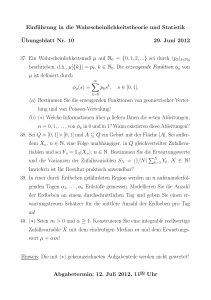

Probeklausur zur Einführung in die Wahrscheinlichkeitstheorie und

Werbung

Probeklausur zur Einführung in die

Wahrscheinlichkeitstheorie und Statistik

Prof. Dr. C. Löh/M. Blank

19. Juli 2012

Name:

Vorname:

Matrikelnummer:

Übungsleiter:

– Diese Klausur besteht aus 8 Seiten. Bitte überprüfen Sie, ob Sie alle

Seiten erhalten haben.

– Bitte versehen Sie alle Seiten mit Ihrem Namen und Ihrer Matrikelnummer.

– Bitte schreiben Sie nicht Lösungen zu verschiedenen Aufgaben auf dasselbe Blatt.

– Sie haben zwei Stunden (= 120 Minuten) Zeit, um die Klausur zu bearbeiten; bitte legen Sie Ihren Studentenausweis und einen Lichtbildausweis zu Beginn der Klausur vor sich auf den Tisch und halten Sie die

Ausweise bei der Abgabe bereit. Um Unruhe in den letzten Minuten zu

vermeiden, geben Sie bitte entweder um 11:00 Uhr oder vor 10:40 Uhr

ab.

– Die Klausur besteht aus 7 Aufgaben. Es können im Total 72 Punkte

erreicht werden. Zum Bestehen genügen voraussichtlich 50% der Punkte.

– Es sind keinerlei Hilfsmittel wie Taschenrechner, Computer, Bücher, Vorlesungsmitschriften, Mobiltelephone etc. gestattet; Papier wird zur Verfügung gestellt. Alle Täuschungsversuche führen zum Ausschluss von der

Klausur; die Klausur wird dann als nicht bestanden gewertet!

Viel Erfolg!

Aufgabe

Punkte maximal

erreichte Punkte

Note:

1

12

2

12

3

12

4

10

5

10

6

10

Unterschrift:

7

6

Summe

72

Name:

Matrikelnr.:

Seite 2/8

Aufgabe 1 (3+3+3+3 = 12 Punkte). Beantworten Sie die folgenden Fragen;

begründen Sie jeweils kurz Ihre Antwort (ca. ein bis drei Sätze).

1. Sei S eine σ-Algebra auf einer Menge Ω. Ist dann {A ⊂ Ω | A 6∈ S}

bereits eine σ-Algebra auf Ω ?

2. Sei (Ω, S, P ) ein Wahrscheinlichkeitsraum und seien A, B ∈ S. Gilt dann

bereits P (A ∪ B) + P (A ∩ B) = P (A) + P (B) ?

3. Gibt es eine reellwertige Zufallsvariable, die N (0, 2012) als induzierte

Verteilung besitzt?

4. Sei X eine reellwertige Zufallsvariable. Gibt es dann eine reellwertige

Zufallsvariable Y mit FY = 1 − FX ?

Lösung:

1. Nein, denn: Jede σ-Algebra auf Ω enthält Ω; daher kann {A ⊂ Ω | A 6∈ S}

keine σ-Algebra sein.

2. Ja, denn: Es gilt

P (A ∪ B) + P (A ∩ B) = P ((A ∩ (Ω \ B)) ∪ B) + P (A ∩ B)

= P (A ∩ (Ω \ B)) + P (A ∩ B) + P (B)

= P ((A ∩ (Ω \ B)) ∪ (A ∩ B)) + P (B)

= P (A) + P (B).

[Alternativ: Nach dem Inklusions/Exklusions-Prinzip (Blatt 3).]

3. Ja, etwa

idR : (R, B(R), N (0, 2012)) −→ (R, B(R)).

4. Nein, denn: Gäbe es ein solches Y , so würde gelten

1 = lim FY (x) = 1 − lim FX (x) = 1 − 1 = 0,

x→∞

was nicht möglich ist.

x→∞

Name:

Matrikelnr.:

Seite 3/8

Aufgabe 2 (3+3+3+3 = 12 Punkte). Beantworten Sie die folgenden Fragen;

begründen Sie jeweils kurz Ihre Antwort (ca. ein bis drei Sätze).

1. Sei (Ω, S, P ) ein Wahrscheinlichkeitsraum und sei (A, B, C) eine stochastisch unabhängige Familie in S. Sind dann auch A und B∩C stochastisch

unabhängig?

2. Seien (Ω1 , S1 , P1 ) und (Ω2 , S2 , P2 ) Wahrscheinlichkeitsräume und seien

X1 und X2 reellwertige Zufallsvariablen auf (Ω1 × Ω2 , S1 ⊗ S2 , P1 ⊗ P2 ).

Sind dann X1 und X2 bezüglich P1 ⊗ P2 stochastisch unabhängig?

3. Sei (Ω, S, P ) ein Wahrscheinlichkeitsraum, seien A, B ∈ S mit P (B) > 0.

Gilt dann bereits P (A | B) > P (A) · P (B) ?

4. Seien X, Y, Z quadratintegrierbare reellwertige Zufallsvariablen auf einem gemeinsamen Wahrscheinlichkeitsraum. Gilt dann bereits

Cov(X + Y, Z) = Cov(X, Z) + Cov(Y, Z) ?

Lösung:

1. Ja, denn: Es gilt

P (A ∩ (B ∩ C)) = P (A ∩ B ∩ C) = P (A) · P (B) · P (C) = P (A) · P (B ∩ C),

wobei wir zweimal die Unabhängigkeit von (A, B, C) benutzt haben.

2. Nein, im Allgemeinen nicht, denn: Man betrachte etwa den Produktraum

d

({0, 1}, Pot({0, 1}), U{0,1}

)⊗2 und die Zufallsvariablen

X1 = X2 : ({0, 1}, Pot({0, 1})) −→ (R, B(R))

ω 7−→ ω1 .

Dann gilt

P ({X1 = 1} ∩ {X2 = 1}) =

1

1

6= = P (X1 = 1) · P (X2 = 1).

2

4

d

d

Also sind X1 und X2 nicht unabhängig bzgl. U{0,1}

⊗ U{0,1}

.

Name:

Matrikelnr.:

Seite 3/8

3. Nein, denn: Es gilt etwa

P (Ω | Ω) =

P (Ω ∩ Ω)

= 1 = P (Ω) · P (Ω).

P (Ω)

4. Ja, denn: Dies folgt aus der Linearität des Erwartungswertes: Es gilt

Cov(X + Y, Z) = E (X + Y − E(X + Y )) · (Z − E(Z))

= E (X − E(X)) · (Z − E(Z)) + (Y − E(Y )) · (Z − E(Z))

= E (X − E(X)) · (Z − E(Z)) + E (Y − E(Y )) · (Z − E(Z))

= Cov(X, Z) + Cov(Y, Z).

(Und alle diese Erwartungswerte existieren.)

Name:

Matrikelnr.:

Seite 4/8

Aufgabe 3 (3+3+3+3 = 12 Punkte). Beantworten Sie die folgenden Fragen;

begründen Sie jeweils kurz Ihre Antwort (ca. ein bis drei Sätze).

1. Sei (Ω, S, P ) ein Wahrscheinlichkeitsraum, sei (Xn )n∈N eine Folge reellwertiger Zufallsvariablen auf (Ω, S, P ) und seien X, Y reellwertige ZuP -f.s.

P -f.s.

fallsvariablen auf (Ω, S, P ) mit Xn −→ X und Xn −→ Y . Stimmen X

n→∞

n→∞

und Y dann bereits P -fast sicher überein?

2. Sei (Ω, S, P ) ein Wahrscheinlichkeitsraum, sei (Xn )n∈N>0 eine stochastisch unabhängige Folge identisch verteilter reellwertiger quadratintegrierbarer Zufallsvariablen auf (Ω, S, P ) und sei X eine N (0, 1)-verteilte

reellwertige Zufallsvariable auf (Ω, S, P ). Gilt dann bereits

n

P -f.s.

1 X

·

Xk − E(Xk ) −→ X ?

n→∞

n k=1

3. Sei (Ω, S, (Pϑ )ϑ∈Θ ) ein statistisches Modell und sei T ein erwartungstreuer Schätzer für eine Abbildung τ : Θ −→ R. Gilt dann EPϑ (T ) = EPϑ0 (T )

für alle ϑ, ϑ0 ∈ Θ ?

4. Besitzt jedes statistische Standardmodell einen Maximum-LikelihoodSchätzer für die Identitätsabbildung auf der Parametermenge?

Lösung:

1. Ja, denn: Dies folgt direkt aus der Eindeutigkeit des Grenzwertes in R. Der

Schnitt zweier fast sicherer Ereignisse ist ein fast sicheres Ereignis (etwa nach

Aufgabe 1.2); daher gilt

1 ≥ P ({X = Y }) ≥ P ({ω | lim Xn (ω) = X(ω), lim Xn (ω) = Y (ω)}) = 1.

n→∞

n→∞

Also stimmen X und Y bereits P -fast sicher überein.

P

2. Nein, denn: Die Folge ( n1 · nk=1 Xk − E(Xk ) )n∈N>0 konvergiert nach dem

starken Gesetz der großen Zahlen P -fast sicher gegen 0 und kann daher nach

Teil 1 nicht P -fast sicher gegen eine N (0, 1)-verteilte Zufallsvariable konvergieren.

Name:

Matrikelnr.:

Seite 4/8

3. Nein, denn: Man betrachte das statistische Modell

d

)ϑ∈{0,1} ),

(N, Pot(N), (U{ϑ}

die kanonische Inklusion τ : {0, 1} −→ R und den erwartungstreuen Schätzer

T := (N ,→ R). Dann gilt

EP1 (T ) = 1 6= 0 = EP0 (T ).

4. Nein, denn: Man vergleiche Blatt 13, Aufgabe 3.

Alternativ: Man betrachte das statistische Standardmodell

({0, 1}, Pot({0, 1}), (B(1, p))p∈(0,1) ).

Die zugehörige Likelihoodfunktion hat die Form

L : {0, 1} × (0, 1) −→ R≥0

(ω, p) 7−→ pω · (1 − p)1−ω

Für ω = 0 sieht man, dass

L(0, ·) : (0, 1) −→ R≥0

p 7−→ p.

kein Maximum in (0, 1) annimmt. Insbesondere kann es keinen MaximumLikelihood-Schätzer für die Identitätsabbildung geben.

Name:

Matrikelnr.:

Seite 5/8

Aufgabe 4 (5 + 4 + 1 = 10 Punkte).

1. Formulieren Sie den zentralen Grenzwertsatz!

2. Definieren Sie die im zentralen Grenzwertsatz auftretende Konvergenzart!

3. Auf welcher Charakterisierung dieser Konvergenzart beruht der Beweis

(aus der Vorlesung) des zentralen Grenzwertsatzes?

Lösung:

1. Sei (Xn )n∈N>0 eine stochastisch unabhängige Folge von identisch verteilten,

quadratintegrierbaren reellwertigen Zufallsvariablen auf einem gemeinsamen

Wahrscheinlichkeitsraum und es gelte Var(X1 ) > 0. Dann gilt

n

1 X

1

d

√ ·

p

· (Xk − E(Xk )) −→ N (0, 1).

n→∞

n

Var(Xk )

k=1

2. Im zentralen Grenzwertsatz tritt Verteilungskonvergenz auf. Sei (Xn )n∈N eine

Folge reellwertiger Zufallsvariablen und sei X eine reellwertige Zufallsvariable.

– Es konvergiert (Xn )n∈N in Verteilung gegen X, wenn für alle x ∈ R, in

denen FX stetig ist, gilt, dass

lim FXn (x) = FX (x).

n→∞

– Alternativ: Es konvergiert (Xn )n∈N in Verteilung gegen X, falls für alle

stetigen und beschränkten Funktionen f : R −→ R gilt

lim E(f ◦ Xn ) = E(f ◦ X).

n→∞

– Alternativ: Es konvergiert (Xn )n∈N in Verteilung gegen X, falls für alle

e 2 (R, R) gilt

f ∈C

lim E(f ◦ Xn ) = E(f ◦ X).

n→∞

3. Auf der dritten Charakterisierung von Verteilungskonvergenz über die Konvergenz von Erwartungswerten (bezüglich der Komposition mit Testfunktionen,

s. oben).

Name:

Matrikelnr.:

Seite 6/8

Aufgabe 5 (2+4+4 = 10 Punkte). Zwei Busse B1 und B2 treffen unabhängig

und gleichverteilt zwischen 00:00 und 01:00 an einer Bushaltestelle ein.

1. Modellieren Sie diese Situation geeignet. Erklären Sie Ihr Modell und

Ihre Modellannahmen.

2. Bestimmen Sie die Wahrscheinlichkeit dafür, dass Bus B1 vor Bus B2

eintrifft.

3. Bestimmen Sie die Wahrscheinlichkeit dafür, dass einer der Busse mindestens 6 Minuten vor dem anderen eintrifft.

Lösung:

1. Seien B1 und B2 zwei stochastisch unabhängige, auf [0, 1] gleichverteilte Zufallsvariablen auf einem gemeinsamen Wahrscheinlichkeitsraum (Ω, S, P ). Dabei beschreibe B1 den ersten, B2 den zweiten Bus und [0, 1] das Zeitinterval

zwischen 00:00 und 01:00.

Alternativ: Man kann insbesondere für B1 und B2 die kanonischen Projektionen

π1 , π2 : [0, 1]2 , B([0, 1]2 ), λ2 |[0,1]2 −→ [0, 1], B([0, 1])

betrachten. Das gesuchte Ereignis lässt sich in diesem Modell beschreiben

durch {π1 < π2 }.

Name:

Matrikelnr.:

Seite 6/8

2. Wir erhalten damit für die gesuchte Wahrscheinlichkeit

Z

P ({B1 < B2 }) = χ{B1 <B2 } dP

Z

= χ{π1 <π2 } ◦ (B1 , B2 ) dP

Z

= χ{π1 <π2 } dP(B1 ,B2 )

Z

(B1 und B2 unabhängig)

= χ{π1 <π2 } d(PB1 ⊗ PB2 )

Z

= χ{π1 <π2 } λ1 |[0,1] ⊗ λ1 |[0,1]

(B1 , B2 gleichverteilt auf [0, 1])

Z

Z

=

[0,1]

Z

=

1 dλ1 (x) dλ1 (y)

(Fubini)

[0,y]

y dλ1 (y)

[0,1]

1

= .

2

Alternativ in der konkreten Beschreibung des Modells:

Z

λ2 ({π1 < π2 }) =

χ{π1 <π2 } dλ2

2

[0,1]

Z

Z

=

1 dλ1 (x) dλ1 (y)

[0,1] [0,y]

Z

=

y dλ1 (y)

(Fubini)

[0,1]

1

= .

2

3. Das gesuchte Ereignis ist {|π2 − π1 | > 0.1}. Wir erhalten für die gesuchte

Name:

Matrikelnr.:

Seite 6/8

Wahrscheinlichkeit somit

2

Z

λ ({|π2 − π1 | > 0.1}) =

[0,1]2

χ{|π2 −π1 |>0.1} dλ2

Z

=2·

[0,1]2

Z

=2·

χ{π2 −π1 >0.1} dλ2

(Symmetrie)

Z

1 dλ1 (x) dλ1 (y)

(Fubini)

[0.1,1]

Z

[0,y−0.1]

y − 0.1 dλ1 (y)

=2·

[0.1,1]

=2·

h1

2

81

.

=

100

y 2 − 0.1 · y

iy=1

y=0.1

Name:

Matrikelnr.:

Seite 7/8

Aufgabe 6 (5 + 2 + 3 = 10 Punkte). Die Lebensdauer (in Jahren) eines

Toasters sei exponentialverteilt zum Parameter λ ∈ R>0 .

1. Bestimmen Sie (in Abhängigkeit von λ) die Wahrscheinlichkeit dafür,

dass der Toaster eine Gesamtlebensdauer von mehr als zwei Jahren hat,

wenn er bereits mehr als ein Jahr alt ist. Erklären Sie dabei Ihr Modell

und Ihre Modellannahmen.

2. Der Parameter λ ∈ R>0 sei nun unbekannt und soll durch die Beobachtung eines Toasters geschätzt werden. Modellieren Sie diese Situation

durch ein geeignetes statistisches Modell und erklären Sie Ihr Modell.

3. Geben Sie einen erwartungstreuen Schätzer für die zu erwartende Lebensdauer an (und begründen Sie Ihre Antwort).

Lösung:

1. Sei λ ∈ R>0 . Wir betrachten den Modellraum (R, B(R), Exp(λ)). D.h. wir

beschreiben die Lebensdauer des Toasters durch eine reelle Zahl und nehmen

an, dass diese exponentialverteilt zum Parameter λ ist.

Alternativ: Sei T : (Ω, S, P ) −→ (R, B(R)) eine Exp(λ)-verteilte Zufallsvariable auf einem Wahrscheinlichkeitsraum (Ω, S, P ), welche die Lebensdauer

unseres Toasters modelliere.

Dann lässt sich die gesuchte Wahrscheinlichkeit beschreiben durch

P (T > 2 | T > 1) = P (T > 1) = e−λ .

Wobei wir die Gedächtnislosigkeit der Exponentialverteilung benutzt haben.

Alternativ: Für alle a ∈ R>0 erhalten wir

Z

λ · e−λ·x dλ1 (x)

Exp(λ)((a, ∞)) =

(a,∞)

h

ix=t

= lim −e−λ·x

t→∞

= lim −e

t→∞

−λ·a

=e

−λ·t

x=a

−λ·a

+e

.

Insbesondere gilt Exp(λ)((1, ∞)) > 0 und wir können die Wahrscheinlichkeit

des gesuchten Ereignisses wie folgt ausdrücken und berechnen

P ((2, ∞) | (1, ∞)) =

e−2·λ

= e−λ .

e−λ

Name:

Matrikelnr.:

Seite 7/8

2. Wir betrachten das statistische Modell

(R, B(R), (Exp(λ)λ∈R>0 )).

Das heißt, wir beschreiben die Lebensdauer eines einzelnen Toasters durch die

Exp(λ)-Verteilung, für einen a priori unbekannten Parameter λ ∈ R>0 .

3. Der Schätzer T := idR ist erwartungstreu bzgl. der zu erwartenden Lebensdauer, denn für alle λ ∈ R>0 ist T bzgl. Exp(λ) integrierbar (vergleiche Vorlesung)

und

EExp(λ) (T ) =

E(Exp(λ))

.

| {z }

erwartete Lebensdauer

Name:

Matrikelnr.:

Seite 8/8

Aufgabe 7 (6 Punkte). Sei P ein Wahrscheinlichkeitsmaß auf (R, B(R)) und

sei F die Verteilungsfunktion zu P . Sei

X : (0, 1) −→ R

x 7−→ inf c ∈ R F (c) ≥ x

Zeigen Sie, dass X eine Zufallsvariable auf (0, 1), B((0, 1)), λ1 |(0,1) ist, und

zeigen Sie, dass die von X induzierte Verteilung mit P übereinstimmt.

Lösung: Für alle x ∈ (0, 1) und alle a ∈ R gilt:

– Ist x ≤ F (a) so gilt nach Definition von X bereits X(x) ≤ a.

– Sei umgekehrt X(x) ≤ a. Dann existiert nach der Definition von X(x) als

Infimum für jedes ε ∈ R>0 ein c ∈ R mit F (c) ≥ x und a + ε ≥ X(x) + ε ≥ c.

Wegen der Monotonie von F gilt

x ≤ F (c) ≤ F (a + ε).

Mit der Rechtsstetigkeit von F folgt daher

x≤

lim

R>0 3ε→0

F (a + ε) = F (a).

Wie gerade gesehen gilt für alle a ∈ R

X −1 ((−∞, a]) = (−∞, F (a)] ∩ (0, 1) ∈ B((0, 1)).

insbesondere ist X eine Zufallsvariable (die halboffenen uneigentlichen Intervalle

erzeugen die Borel-σ-Algebra auf R) und es gilt für alle a ∈ R, dass

FX (a) = λ1 |[0,1] ({X ≤ a}) = λ1 |[0,1] ((−∞, F (a)] ∩ (0, 1)) = F (a) − 0 = F (a).

Also ist X nach dem Korrespondenzsatz für Verteilungsfunktionen P -verteilt.