Musterlösungen für Blatt 10 zur Vorlesung Statistik II, SoSe 2010

Werbung

Musterlösungen für Blatt 10 zur Vorlesung Statistik II, SoSe 2010

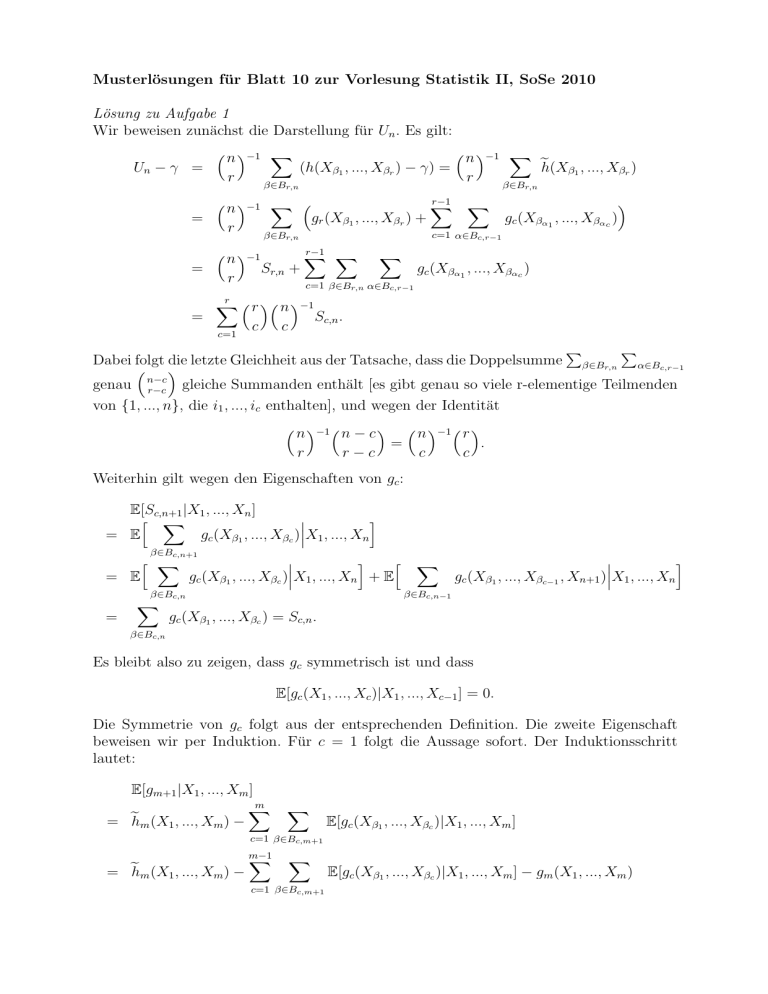

Lösung zu Aufgabe 1

Wir beweisen zunächst die Darstellung für Un . Es gilt:

n −1 X

n −1 X

e

Un − γ =

(h(Xβ1 , ..., Xβr ) − γ) =

h(Xβ1 , ..., Xβr )

r

r

β∈B

β∈B

r,n

=

=

=

r,n

n −1 X r

r

Sr,n +

X

gc (Xβα1 , ..., Xβαc )

c=1 α∈Bc,r−1

β∈Br,n

n −1

r−1 X

X

X

gc (Xβα1 , ..., Xβαc )

c=1 β∈Br,n α∈Bc,r−1

r X

c=1

gr (Xβ1 , ..., Xβr ) +

r−1

X

r n −1

c

c

Sc,n .

P

P

Dabei folgt die letzte Gleichheit aus der Tatsache, dass die Doppelsumme β∈Br,n α∈Bc,r−1

genau n−c

gleiche Summanden enthält [es gibt genau so viele r-elementige Teilmenden

r−c

von {1, ..., n}, die i1 , ..., ic enthalten], und wegen der Identität

n −1 n − c r

r−c

=

n −1 r c

c

.

Weiterhin gilt wegen den Eigenschaften von gc :

E[Sc,n+1 |X1 , ..., Xn ]

h X

i

= E

gc (Xβ1 , ..., Xβc )X1 , ..., Xn

β∈Bc,n+1

i

h

h X

= E

gc (Xβ1 , ..., Xβc )X1 , ..., Xn + E

=

i

gc (Xβ1 , ..., Xβc−1 , Xn+1 )X1 , ..., Xn

β∈Bc,n−1

β∈Bc,n

X

X

gc (Xβ1 , ..., Xβc ) = Sc,n .

β∈Bc,n

Es bleibt also zu zeigen, dass gc symmetrisch ist und dass

E[gc (X1 , ..., Xc )|X1 , ..., Xc−1 ] = 0.

Die Symmetrie von gc folgt aus der entsprechenden Definition. Die zweite Eigenschaft

beweisen wir per Induktion. Für c = 1 folgt die Aussage sofort. Der Induktionsschritt

lautet:

E[gm+1 |X1 , ..., Xm ]

m

X

= e

hm (X1 , ..., Xm ) −

X

E[gc (Xβ1 , ..., Xβc )|X1 , ..., Xm ]

c=1 β∈Bc,m+1

= e

hm (X1 , ..., Xm ) −

m−1

X

X

c=1 β∈Bc,m+1

E[gc (Xβ1 , ..., Xβc )|X1 , ..., Xm ] − gm (X1 , ..., Xm )

= e

hm (X1 , ..., Xm ) −

m−1

X

c=1

= e

hm (X1 , ..., Xm ) −

X

m−1

X

c=1

E[gc (Xβ1 , ..., Xβc )|X1 , ..., Xm ] − gm (X1 , ..., Xm )

β∈Bc,m+1

{β1 ,...,βc }⊂{1,...,m}

X

E[gc (Xβ1 , ..., Xβc )|X1 , ..., Xm ] − gm (X1 , ..., Xm )

β∈Bc,m

{β1 ,...,βc }⊂{1,...,m}

= gm (X1 , ..., Xm ) − gm (X1 , ..., Xm ) = 0

nach der Definition von gm wobei wir verwendet haben, dass nach Induktionsvoraussetzung gilt [Xi mit i ∈

/ {β1 , ..., βc } können im bedingten Erwartungswert weggelassen werden

da sie unabhängig von den anderen sind]:

gc (Xβ1 , ..., Xβc ) , {β1 , .., βc } ⊂ {1, .., m}

E[gc (Xβ1 , ..., Xβc )|X1 , ..., Xm ] =

0

,

sonst

Damit ist die Aussage nachgewiesen.

Lösung zu Aufgabe 2

Definiere

∗

Um,n

:= γ +

n

X

m

X

(E[Um,n |Xi ] − γ) +

(E[Um,n |Yj ] − γ)

i=1

r

= γ+

n

j=1

n

X

m

s X

(h1,0 (Xi ) − γ) +

(h0,1 (Yj ) − γ),

m

i=1

j=1

wobei die letzte Gleichheit aus der Tatsache folgt, dass

m −1 n −1 X

E[Um,n |Xi ] − γ =

(E[h(Xβ1 , ..., Xβr , Yα1 , ..., Yαs )|Xi ] − γ)

r

s

β∈Br,m

α∈Bs,n

=

=

m −1 n −1

r

s

X

m −1 m − 1 r

r−1

(h1,0 (Xi ) − γ)

β∈Br,m :i∈β

α∈Bs,n

(h1,0 (Xi ) − γ) =

r

(h1,0 (Xi ) − γ)

m

wobei wir die Symmetrie des Kerns h verwendet haben und die Identität

E[Um,n |Yi ] − γ =

s

(h0,1 (Yi ) − γ)

n

mit analogen Argumenten hergeleitet werden kann. Weiterhin gilt:

∗

∗

∗

∗

E[(Um,n − γ)2 ] = E[(Um,n − Um,n

)2 ] + E[(Um,n

− γ)2 ] − 2E[(Um,n − Um,n

)(Um,n

− γ)]

und somit ist

∗

∗

∗

∗

E[(Um,n − Um,n

)2 ] = E[(Um,n − γ)2 ] − E[(Um,n

− γ)2 ] − 2E[(Um,n − Um,n

)(Um,n

− γ)]

∗

∗

∗

= Var(Um,n ) − Var(Um,n ) − 2E[(Um,n − Um,n )(Um,n − γ)].

Nu gilt zusätzlich:

X

∗

∗

− γ)] =

)(Um,n

E[(Um,n − Um,n

∗

)|Xi ](E[Um,n |Xi ] − γ)]

E[E[(Um,n − Um,n

i

+

X

∗

E[E[(Um,n − Um,n

)|Yj ](E[Um,n |Yj ] − γ)]

j

= 0,

denn

∗

E[(Um,n − Um,n

)|Xi ] = E[Um,n |Xi ] − γ −

X

(E[E[Um,n |Xj ]|Xi ] − γ) −

j

X

(E[E[Um,n |Yk ]|Xi ])

k

= 0 f.s.

∗

und E[(Um,n − Um,n

)|Yj ] = 0 mit analogen Argumenten, also insbesondere

∗

∗

E[(Um,n − Um,n

)2 ] = Var(Um,n ) − Var(Um,n

).

Da die Stichproben X1 , ..., Xn und Y1 , ..., Ym unabhängig sind, gilt:

∗

Var(Um,n

)=

r2

s2

ξ1,0 + ξ0,1 .

n

m

Weiterhin ist nach den Präsenzübungen

Var(Um,n ) =

1

r2

s2

1

ξ1,0 + ξ0,1 + o

+

.

n

m

m n

Also folgt:

E[(Um,n −

∗

Um,n

)2 ]

1

+

,

=o

m n

1

was insbesondere impliziert

√

P

∗

m + n(Um,n − Um,n

) −→ 0.

Schliesslich folgt aus dem zentralen Grenzwertsatz:

n

1 X

D

√

(h1,0 (Xi ) − γ) −→ N (0, r2 ξ1,0 ),

n i=1

m

1 X

D

√

(h0,1 (Yi ) − γ) −→, N (0, s2 ξ0,1 )

m i=1

und wegen der Unabhängigkeit von X1 , ..., Xn und Y1 , ..., Ym gilt diese Konvergenz auch

gemeinsam. Daraus erhalten wir nach dem Lemma von Slutzky:

√

m + n(Um,n − γ)

√

∗

=

m + n(Um,n

− γ) + oP (1)

√

√

n

m

m+n r X

m+n s X

√

√

√

=

(h1,0 (Xi ) − γ) + √

(h0,1 (Yj ) − γ) + oP (1)

n

n i=1

m

m j=1

r2

r

s

s2

D

D

√

√

−→

Z1 +

Z2 = N 0, ξ1,0 +

ξ0,1 ,

λ

1−λ

1−λ

λ

wobei Z1 ∼ N (0, ξ1,0 ), Z2 ∼ N (0, ξ0,1 ) unabhängige Zufallsvariablen sind. Damit ist die

Aussage bewiesen.

Lösung zu Aufgabe 3

Korrelationskoeffizient ρ:

- Die Cauchy-Schwarz Ungleichung besagt, dass für quandratintegrierbare Zufallsvariablen A, B gilt: E[|AB|] ≤ (E[A2 ]E[B 2 ])1/2 mit Gleichheit genau dann, wenn

A = αB + β fastpsicher für reellwertige Konstanten α, β. Insbesondere ist also |Cov(Y, Z)| =

Var(Y )Var(Z) ⇔ Y = aZ + b fast sicher. Damit und wegen Cov(Y, Z) = −Cov(−Y, Z) ist klar, dass (i) und (ii) genau dann gilt, wenn

Y = aZ + b fast sicher und Y mit positiver Wahrscheinlichkeit Werte ausserhalb

von {0, 1} annimmt.

- Eigenschaft (iii) folgt aus der Cauchy-Schwarz Ungleichung.

- Eigenschaft (iv) folgt da für Y, Z unabhängig gilt: Cov(Y, Z) = 0.

- Eigenschaften (v) und (vi) gelten da Cov(Y, Z) = −Cov(−Y, Z) = Cov(−Y, −Z)

und weil die Varianz unter Vorzeichenwechsel invariant ist.

- Eigenschaft (vii) für lineare Trafos: folgt wegen Var(aY + b) = a2 Y , und

Cov(aY + b, αZ + β) = aαCov(Y, Z).

Gegenbeispiel für nichtlineare Trafos: sei Y = Z, beide seien positive Zufallsvariablen die mit positiver Wahrscheinlichkeit Werte ausser {0, 1} annehmen σ1 (Y ) :=

Y 2 , σ2 (Z) := Z. Dann ist mit den Argumenten aus dem Beweis von (i) ρ(Y, Z) = 1

und ρ(Y 2 , Z) 6= 1.

Kendalls τ [für stetige Verteilungen von Y, Z, das muss angenommen werden]:

- Eigenschaft (i)+(ii) ist aus der Definition von τ klar [im Fall (i) ist πc = 1, πd = 0,

im Fall (ii) ist πd = 1, πc = 0].

- Eigenschaft (iii) folgt, da πc und πd Wahrscheinlichkeiten sind

- Sind Y, Z unabhängig mit stetigen Verteilungen, so ist

πc = P((Z1 − Z2 )(Y1 − Y2 ) > 0) = P(Y1 > Y2 , Z1 > Z2 ) + P(Y1 < Y2 , Z1 < Z2 )

= P(Y1 > Y2 )P(Z1 > Z2 ) + P(Y1 < Y2 )P(Z1 < Z2 )

1

1 1

+ = .

=

4 4

2

Damit ist Eigenschaft (iv) nachgewiesen.

- Eigenschaft (v) und (vi) ergeben sich direkt aus der Definition

- Sind σ1 , σ2 streng monoton steigend, so folgt insbesondere:

Y1 > Y2 ⇔ σ1 (Y1 ) > σ1 (Y2 ),

Z1 > Z2 ⇔ σ2 (Z1 ) > σ2 (Z2 ),

und damit ist τ (σ1 (Y ), σ2 (Z)) = τ (Y, Z).

Lösung zu Aufgabe 4

Betrachte die Zufallsvariablen U :=

U V

Y1 −Y

√ 2,V

σ1 2

Z1 −Z

√ 2.

σ2 2

:=

Dann gilt:

0 1 ρ S

D

p

∼N

,

=

0

ρ 1

ρS + 1 − ρ2 T

mit S, T i.i.d. ∼ N (0, 1). Wegen der Eigenschaften von Kendalls τ (z.B. Invarianz unter

monotonen wachsenden Transformationen) gilt:

τ (Y, Z) = τ

Y

Z √ , √ = 2P(U V > 0) − 1.

σ1 2 σ2 2

Weiterhin ist mit α := √ ρ

1−ρ2

p

P(U V > 0) = P(S(ρS + 1 − ρ2 T ) > 0)

= P(S > 0, T > −αS) + P(S < 0, T < −αS)

= 2P(S > 0, T > −αS),

D

denn (S, T ) = (−S, −T ). Mit der Substitution (s, t) = (r cos θ, r sin θ) erhalten wir:

Z ∞Z

2

2

2πP(S > 0, T > −αS) =

I{t > −αs}e−(t +s )/2 dtds

0

R

Z π/2 Z ∞

2

=

I{tan θ > −α}re−r /2 drdθ

−π/2

Z

0

π/2

=

dθ =

− arctan α

π

− arctan α.

2

Die Behauptung folgt nun wegen

arctan α = arctan p

da für θ ∈ [−π/2, π/2] gilt: tan θ = sin θ/

ρ

1 − ρ2

= arcsin ρ

p

1 − sin2 θ.