Lehrplan - Userpage - Freie Universität Berlin

Werbung

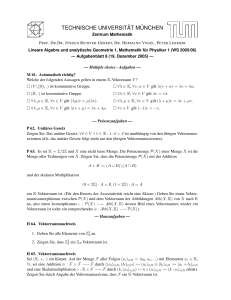

LINEARE ALGEBRA II: LEHRPLAN

VICTORIA HOSKINS

Webseite: http://userpage.fu-berlin.de/hoskins/LAII.html

Inhaltsverzeichnis

1. Jordan-Normalform

2. Bilinearformen und quadratische Formen

3. Euklidische und unitäre Vektorräume

4. Ringe und Moduln

Literatur

1

11

19

31

38

1. Jordan-Normalform

Mit der Jordan-Normalform werden wir alle komplexen Matrizen bis auf Ähnlichkeit klassifizieren. Wir werden eine Normalform, die Jordan-Normalform finden, so dass es in jeder

Ähnlichkeitsklasse genau eine1 komplexe Matrix in Normalform gibt. Wir werden Invarianten

für die Ähnlichkeitsklassen (d.h. etwas, dass das Gleiche für zwei ähnliche Matrizen ist) entdecken: alte Invarianten (das charakteristische Polynom, Eigenwerte) und neue Invariante (das

Minimalpolynom, geometrische und algebraische Vielfachheit der Eigenwerte).

[19.04.17]

1.1. Erinnerung an Eigenwerte und Diagonalisierung. Sei K ein Körper.

Definition.

(1) Für einen linearen Endomorphismus f ∈ EndK (V ) eines K-Vektorraumes V sagen wir,

dass v ∈ V mit v 6= 0V ein Eigenvektor zum Eigenwert λ ∈ K ist, falls

f (v) = λ · v.

Für λ ∈ K definieren wir den λ-Eigenraum von f

Eig(f, λ) := {v ∈ V : f (v) = λ · v}.

Die geometrische Vielfachheit von λ ist µg (f, λ) := dimK (Eig(f, λ)).

(2) Für eine Matrix A ∈ Matn×n (K) sagen wir, dass x ∈ K n mit x 6= 0 ein Eigenvektor

zum Eigenwert λ ∈ K ist, falls

Ax = λx.

Der λ-Eigenraum von A ist Eig(A, λ) = {x ∈ K n : Ax = λx} und die geometrische

Vielfachheit von λ ist µg (A, λ) := dimK (Eig(A, λ)).

Bemerkung. Nach [LAI, Satz 5.10] gelten:

(1) Wenn V endlichdimensional ist (so dass det(f ) für f ∈ EndK (V ) definiert ist), gilt: λ

ist ein Eigenwert von f ⇐⇒ det(λ · IdV − f ) = 0.

(2) λ ist genau dann ein Eigenwert von A ∈ Matn×n (K), wenn det(λIn − A) = 0.

Definition.

1(bis auf die Reihenfolge der Jordanblöcke)

1

2

VICTORIA HOSKINS

(1) Für A ∈ Matn×n (K) ist das charakteristische Polynom von A

χA (t) = det(tIn − A) ∈ K[t].

Die algebraische Vielfachheit von λ ist µa (f, λ) := µ(χf , λ) := max{n : (t − λ)n |χf (t)}.

(2) Für einen linearen Endomorphismus f : V → V eines endlichdimensionalen K-Vektorraumes

V ist das charakteristische Polynom von f

χf (t) = det(tIdV − f ) ∈ K[t].

Die algebraische Vielfachheit von λ ist µa (A, λ) := µ(χA , λ).

Bemerkung. Wenn dimK (V ) = n (bzw. A ∈ Matn×n (K)), ist χf (t) (bzw. χA (t)) ein normiertes2 Polynom vom Grad n und die Nullstellen des charakteristischen Polynoms sind die

Eigenwerte von f (bzw. A) [LAI, Satz 5.13].

Lemma.[LAI] Die algebraische Vielfachheit ist größer oder gleich die geometrische Vielfachheit für jeden Eigenvektor eines linearen Endomorphismus von einem endlichdimensionalen

K-Vektorraum.

Definition.

(1) Ein linearer Endomorphismus f : V → V eines endlichdimensionalen K-Vektorraumes

V heißt diagonalisierbar, wenn es eine geordnete Basis B von V gibt, so dass MBB (f )

eine Diagonalmatrix ist.

(2) Eine Matrix A ∈ Matn×n (K) heißt diagonalisierbar, wenn der Endomorphismus FA ∈

EndK (K n ) mit FA (x) = Ax diagonaliserbar ist.

(3) Zwei Matrizen A, B ∈ Matn×n (K) heißen ähnlich (schreibweise: A ∼ B), wenn es

S ∈ GLn (K) gibt mit A = SBS −1 .

Übung.

(1) Ähnlichkeit auf Matn×n (K) ist eine Äquivalenzrelation.

(2) Eine Matrix A ∈ Matn×n (K) ist genau dann diagonalisierbar, wenn A ähnlich zu einer

Diagonalmatrix ist.

(3) Wenn f : V → V ein linearer Endomorphismus eines K-Vektorraumes der Dimension

n ist, sind alle zugehörigen Matrizen von f ähnlich (d.h. für geordnete Basen A und B

A (f ) ∼ M B (f )).

von V gilt MA

B

(4) Für zwei ählinche Matrizen A ∼ B gilt χA (f ) = χB (f ).

Bermerkung. Sei V ein endlichdimensionaler K-Vektorraum und f ∈ EndK (V ).

(1) Nach [LAI, Satz 5.11] ist f genau dann diagonalisierbar, wenn V eine Basis aus Eigenvektoren von f besitzt.

(2) Nach [LAI, Satz 5.12] ist f diagonalisierbar, wenn f genau n = dim(V ) paarweise

verschiedene Eigenwerte λ1 , . . . , λn hat.

(3) Nach [LAI, Satz 5,14] ist äquivalent:

(a) f ist diagonalisierbar.

(b) Das charakteristische Polynom χf (t) zerfällt in Linearfaktoren und die geometrische

und algebraische Vielfachheiten aller Eigenwerte λ ∈ K übereinstimmen:

µg (f, λ) = µa (f, λ).

(c) Wenn λ1 , · · · , λk die paarweise verschiedene Eigenwerte von f sind, dann gilt

V =

k

M

Eig(f, λi ) := Eig(f, λ1 ) ⊕ · · · ⊕ Eig(f, λk ).

i=1

2P (t) = a tn + · · · a ist normiert, falls a = 1

n

0

n

LINEARE ALGEBRA II: LEHRPLAN

3

1.2. Nullstellen von Polynomen. Für einen Körper K kann man fragen, wann zerfällt jedes

Polynom P (t) ∈ K[t] in Linearfaktoren? Oder wann hat jedes nicht-konstante Polynom mit

Koeffizienten in K eine Nullstelle?

Definition. Ein Körper K heißt algebraisch abgeschlossen, wenn jedes nicht-konstante Polynom

mit Koeffizienten in K eine Nullstelle in K hat.

Beispiel. Für K = R hat das Polynom P (t) = t2 + 1 keine Nullstelle in R und deshalb ist R

nicht algebraisch abgeschlossen.

Lemma. Wenn K algebraisch abgeschlossen ist, zerfällt jedes Polynom P (t) ∈ K[t] in Linearfaktoren.

Satz 1.1 (Fundamentalsatz der Algebra3). Die komplexen Zahlen C sind algebraisch abgeschlossen, d.h. jedes nicht-konstante Polynom mit C-Koeffizienten besitzt mindestens eine Nullstelle

in C.

Bemerkung. Es gibt einen Körper-Homomorphismus R → C mit x 7→ x + i0 . Deshalb gibt es

einen Ring-Homomorphismus R[t] → C[t], der auch injektiv ist. Da C algebraisch abgeschlossen

ist, hat jedes nicht-konstante Polynom P (t) ∈ R[t] mindestens eine Nullstelle in C. Ferner gilt

für P (t) ∈ R[t] und eine Nullstelle α ∈ C von P (t)

(1) Die konjugiert komplexe Zahl α ist auch eine Nullstelle von P . Ferner haben α und α

die gleiche Vielfachheit: µ(P, α) = µ(P, α).

(2) Q(t) := (t − α)(t − α) ∈ R[t] und es gibt eine Zerlegung P (t) = Q(t)R(t) in R[t].

(3) Wenn Grad(P ) ungerade ist, hat P mindestens eine Nullstelle in R.

Lemma. Für P (t) ∈ K[t] gibt es einen injektiven Körper-Homomorphismus K → L (was wir

eine Körpererweiterung nennen), so dass P (t) in Linearfaktoren aus L[t] zerfällt.4

Beispiel. Für K = R oder K = C können wir L = C wählen, weil C algebraisch abgeschlossen

ist. Dann zerfällt jedes Polynom P (t) ∈ K[t] in Linearfaktoren in L[t].

1.3. Trigonalisierung. Sei V ein endlichdimensionaler K-Vektorraum und f ∈ EndK (V ). Was

A (f ) folgern, wenn nur χ (t) in Linearfaktoren

können wir über f und die zugehörige Matrizen MA

f

zerfällt (aber die geometrische und algebraische Vielfachheiten der Eigenwerte nicht übereinstimmen)?

Definition. Sei f : V → V ein linearer Endomorphismus.

(1) Ein Untervektorraum U ⊂ V heißt f -invariant, falls f (U ) ⊂ U .

(2) Eine Fahne in einem n-dimensionalen K-Vektorraum V ist eine Kette von Untervektorräume

{0V } = V0 ( V1 ( · · · ( Vn−1 ( Vn = V

mit dimK (Vr ) = r. Diese Fahne heißt f -invariant, wenn jeder Unterraum Vr in der Fahne

f -invariant ist.

Beispiel.

(1) Für alle f ∈ EndK (V ) sind {0V } und V offensichtlich f -invariant.

(2) Die Eigenräume Eig(f, λ) sind f -invariant.

(3) Für V = K n gibt es die Standard-Fahne mit Vr := Span(e1 , . . . , er ).

(4) Jede Fahne von V ist IdV -invariant.

3Für den Beweis, siehe Analysis (oder den Kurs ‘Funktionentheorie’).

4Diese Lemma wird in der Algebra und Zahlentheorie bewiesen.

[24.04.17]

4

VICTORIA HOSKINS

(5) Sei A ∈ Matn×n (K) eine obere Dreiecksmatrix, d.h. aij = 0 für i > j. Für die zugehörige

lineare Abbildung FA : K n → K n ist die Standard-Fahne FA -invariant.

Lemma. Für einen linearen Endomorphismus f : V → V eines n-dimensionalen K-Vektorraumes

ist äquivalent:

(1) Es gibt eine f -invariante Fahne von V ,

A (f ) eine obere Dreiecksmatrix ist.

(2) Es gibt eine geordnete Basis A von V , so dass MA

Definition.

(1) Ein linearer Endomorphismus f : V → V eines n-dimensionalen K-Vektorraumes heißt

trigonalisierbar, wenn es eine f -invariante Fahne von V gibt.

(2) Eine Matrix A ∈ Matn×n (K) heißt trigonalisierbar, wenn A ähnlich zu einer oberen

Dreiecksmatrix ist.

Bemerkung.

(1) A ∈ Matn×n (K) ist genau dann trigonalisierbar, wenn es FA : K n → K n ist.

A (f ) (für eine geordnete

(2) f ∈ EndK (V ) ist genau dann triangonalisierbar, wenn es MA

Basis A von V ) ist.

(3) Jeder diagonalisierbare Endomorphismus ist auch trigonalisierbar, aber die Umkehrung

ist falsch: zum Beispiel ist

1 1

A=

0 1

trigonalisierbar aber nicht diagonalisierbar, weil 1 = µg (A, 1) < 2 = µa (A, 1) [LAII, Satz

5.14].

Satz 1.2. Für einen linearen Endomorphismus f : V → V eines n-dimensionalen K-Vektorraumes

ist äquivalent:

(1) f ist trigonalisierbar,

(2) χf (t) zerfällt in Linearfaktoren.

Korollar.

(1) Jede komplexe Matrix A ∈ Matn×n (C) ist trigonalisierbar.

(2) Jeder Endomorphismus eines endlichdimensionalen C-Vektorraumes ist trigonalisierbar.

Beispiel. Sind die folgende reelle Matrizen diagonalisierbar (bzw. trigonalisierbar)?

2 −3

3 −2

1 1

A=

B=

0 1

0 3

−1 1

Wir berechnen die charakteristische Polynome und Vielfachheiten jeder Matrix:

• A ist trigonaliserbar, weil χA (t) = (t − 2)(t − 1) in Linearfaktoren zerfällt. Ferner ist A

diagonalisierbar, weil

3

1

Eig(A, 1) = Span

Eig(A, 2) =

,

1

0

so dass µg (A, λ) = 1 = µa (A, λ) für λ = 1, 2.

• B ist trigonalisierbar, weil χB (t) = (t − 3)2 , aber B ist nicht diagonalisierbar, weil

1

µg (B, 3) = dimK Eig(B, 3) = dimK Span

= 1 < 2 = µa (B, 3).

0

• C ist nicht trigonalisierbar (und deshalb auch nicht diagonalisierbar), weil

χC (t) = (t − 1)(t − 1) + 1 = t2 − 2t + 2

keine Nullstellen in R hat (die Diskriminante von χC ist negativ: (−2)2 −4×2 = −4 < 0).

LINEARE ALGEBRA II: LEHRPLAN

5

1.4. Der Satz von Cayley-Hamilton. Für einen K-Vektorraum V ist EndK (V ) ein KVektorraum und ein Ring: man kann Polynome miteinander punktweise addieren und die Komposition von Abbildung liefert eine Multiplikation auf EndK (V ). Deshalb können wir die Potenzen eine Abbildung f ∈ EndK (V ) betrachten: f 0 := IdV , f 1 := f , f 2 := f ◦ f , u.s.w. Für ein

Polynom P (t) = an tn + an−1 tn−1 + · · · + a0 ∈ K[t] definieren wir

P (f ) := an f n + an−1 f n−1 + · · · + a0 IdV ∈ EndK (V )

und wir schreiben P (f ) = 0, wenn dieser Endomorphismus die Nullabbildung ist.

Lemma. Sei V ein n-dimensionaler K-Vektorraum und f ∈ EndK (V ). Dann gibt es ein nichtNull Polynom P (t) ∈ K[t] mit P (f ) = 0.

Definition. Sei V ein endlichdimensionaler K-Vektorraum und f ∈ EndK (V ). Ein normiertes

nicht-Null Polynom mf (t) ∈ K[t] heißt Minimalpolynom von f wenn

i) mf (f ) = 0.

ii) Für alle andere nicht-Null Polynome P (t) ∈ K[t] mit P (f ) = 0 gilt Grad(mf ) ≤

Grad(P ).

Ebenso definieren wir das Minimialpolynom von A ∈ Matn×n (K), so dass mA (t) = mFA (t) für

FA : K n → K n , x 7→ Ax.

Bemerkung.

(1) Sei V ein endlichdimensionaler K-Vektorraum und f ∈ EndK (V ) mit dem Minimalpolynom mf (t) ∈ K[t]. Für alle P (t) ∈ K[t] mit P (f ) = 0 gilt mf (t)|P (t): nach der

Division mit Rest für Polynome gilt

P (t) = Q(t)mf (t) + r(t)

und Grad(r) < Grad(mf )

und falls r 6= 0, gilt r(f ) = 0, was ein Widerspruch zu der Minimalität von mf gibt.

(2) Das Minimalpolynom existiert nach dem Lemma oben und es ist eindeutig (weil es

normiert ist).

(3) Zwei ähnlich Matrizen A ∼ B haben das gleiche Minimalpolnom: mA (t) = mB (t).

Satz 1.3 (Satz von Cayley-Hamilton). Sei V ein endlichdimensionaler K-Vektorraum und f ∈

EndK (V ) mit dem charakteristischen Polynom χf (t) ∈ K[t]. Dann gilt χf (f ) = 0. Insbesondere

gilt mf (t)|χf (t).

Korollar. Sei V ein n-dimensionaler K-Vektorraum und f ∈ EndK (V ). Dann gilt χf |mnf .

Beispiel. Die Matrix

A=

1 1

0 1

hat das charakteristische Polynom χA (t) = (t − 1)2 = t2 − 2t + 1. Das Minimalpolynom von

A ist entweder t − 1 oder (t − 1)2 , da mA (t)|χA (t) nach dem Satz von Cayley–Hamilton. Da

A − I2 6= 0, ist t − 1 nicht das Minimalpolynom von A. Deshalb ist mA (t) = χA (t) = (t − 2)2 .

Nach dem Satz von Cayley–Hamilton gilt

A2 − 2A + I2 = 0.

Es folgt, dass A(A − 2I2 ) = −I2 , so dass A(2I2 − A) = I2 . Insbesonder ist A−1 = 2I2 − A.

Bemerkung. Mit dem Satz von Cayley-Hamilton können wir für jede invertierbare Matrix A ∈

Matn×n (K) die inverse Matrix A−1 finden. Wir erinnern uns, dass A genau dann invertierbar

ist, wenn det(A) 6= 0. Für das charakteristiche Polynom

χA (t) := det(tIn − A) = tn + cn−1 tn−1 + · · · + c1 t + c0

[26.04.17]

6

VICTORIA HOSKINS

gilt χA (0) = det(−A) = (−1)n det(A) = c0 . Insbesondere c0 6= 0 ⇐⇒ det(A) 6= 0. Nach dem

Satz von Cayley-Hamilton gilt

An + cn−1 An−1 + · · · + c1 A + c0 In = 0.

Diese Gleichung ist äquivalent zu

A(An−1 + cn−1 An−2 + · · · c1 In ) = −c0 In

und wenn c0 6= 0 ist die inverse Matrix A−1 =

−1

n−1

c0 (A

+ cn−1 An−2 + · · · c1 In ).

1.5. Nilpotente Endomorphismen und Haupträume. Haupträume sind verallgemeinerte

Eigenräume5 und wir werden Haupträume benutzen, um die Jordan-Zerlegung zu beschreiben.

Definition.

(1) Ein linearer Endomorphismus f : V → V eines K-Vektorraumes heißt nilpotent, falls es

gibt r ∈ N mit f r = 0 (die Nullabbildung).

(2) Eine Matrix A ∈ Matn×n (K) heißt nilpotent, falls es gibt r ∈ N mit Ar = 0 (die Nullmatrix).

[03.05.17]

Lemma. Sei f : V → V ein linearer Endomorphismus eines n-dimensionalen K-Vektorraumes.

Dann ist äquivalent:

(1) f ist nilpotent,

(2) Es gibt 1 ≤ r ≤ n mit f r = 0,

(3) χf (t) = tn ,

(4) Es gibt eine geordnete Basis A von V mit

0 ∗ ∗

A

MA

(f ) = ... . . . ∗ .

0 ··· 0

Bemerkung. Sei V ein endlichdimensionaler K-Vektorraum. Für h ∈ EndK (V ) und die Potenzen von h gilt

{0V } = ker(h0 ) ⊂ ker(h) ⊂ ker(h2 ) ⊂ · · ·

und

V = Bild(h0 ) ⊃ Bild(h) ⊃ Bild(h2 ) ⊃ · · ·

und dimK (V ) = dimK (ker(hr )) + dimK (Bild(hr )) nach der Dimensionsformel für hr , aber im

allgemeinen ist diese Summe nicht direkt: ker(hr ) ∩ Bild(hr ) 6= {0V }. Da V endlichdimensional

ist, können beide Ketten nicht endlos aufsteigen (bzw. absteigen).

Lemma (von Fitting). Sei V ein endlichdimensionaler K-Vektorraum. Für h ∈ EndK (V ) sei

d = min{r ∈ N : ker(hr ) = ker(hr+1 )}.

Dann gilt

(i) d = min{r ∈ N : Bild(hr ) = Bild(hr+1 )},

(ii) U := ker(hd ) und W := Bild(hd ) sind h-invariante Untervektorräume von V ,

(iii) h|W : W → W ist ein Isomorphismus,

(iv) h|U : U → U ist nilpotent mit dem Minimalpolynom mh|U (t) = td ,

(v) ker(hd ) = ker(hd+i ) und Bild(hd ) = Bild(hd+i ) für alle i ∈ N,

(vi) V = U ⊕ W ,

(vii) d ≤ dimK (U ) = µa (h, 0).

5Ein Hauptaum eines Eigenwertes λ (eines Endomorphismuses) ist größer als der λ-Eigenraum und die Dimension eines Hauptraumes ist die algebraische Vielfachheit von λ. Wir erinnern uns, dass die Dimension eines

Eigenraumes (d.h. die geometrische Vielfachheit) ist kleiner oder gleich die algebraische Vielfachheit.

LINEARE ALGEBRA II: LEHRPLAN

7

Insbesondere gibt es eine geordnete Basis A von V , so dass

N 0

A

MA (h) =

mit N d = 0 (nilpotent) und B invertierbar.

0 B

Definition. Sei f : V → V ein linearer Endomorphismus eines endlichdimensionalen KVektorraumes. Für einen Eigenwert λ von f definieren wir den Hauptraum von f zum Eigenwert

λ durch

Hau(f, λ) := ker((λIdV − f )µa (f,λ) ).

Bemerkung. Es gilt

Eig(f, λ) := ker(λIdV − f ) ⊂ ker((λIdV − f )µa (f,λ) ) =: Hau(f, λ).

Satz 1.4 (Jordan-Zerlegung). Sei f : V → V ein linearer Endomorphismus eines endlichdimensionalen K-Vektorraumes, so dass

χf (t) =

k

Y

(t − λi )ri

i=1

in Linearfaktoren in K[t] zerfällt, wobei λ1 , . . . , λk die paarweise verschiedene Eigenwerte sind

und ri = µa (f, λi ). Dann gelten:

(1) Jeder Hauptraum Hau(f, λi ) ist f -invariant mit Dimension ri ,

(2) V ist die direkte Summe der Haupträume von f :

V =

k

M

Hau(f, λi ),

i=1

(3) Es gibt eine Jordan-Zerlegung f = fN + fD mit fN nilpotent, fD diagonalisierbar und

fN ◦ fD = fD ◦ fN .

Korollar. Jeder lineare Endomorphismus f eines endlichdimensionalen C-Vektorraumes V hat

eine Jordan-Zerlegung f = fD +fN (und die entsprechende Aussage für komplexe Matrizen gilt).

Beispiel. Sei

A=

2 −3

3 −4

∈ Mat2×2 (K).

Dann χA (t) = (t + 1)2 , also λ := −1 ist ein Eigenwert von A mit µa (A, −1) = 2. Da das charakteristische Polynom von A in Linearfaktoren zerfällt, hat A (und die entsprechende Abbildung

FA : K 2 → K 2 ) eine Jordan-Zerlegung. Es gilt

1

0 0

Eig(A, −1) = Span

( Hau(A, −1) := ker((−I2 − A)2 ) = ker

= K 2.

1

0 0

Deshalb haben wir die Jordan-Zerlegung K 2 = Hau(A, −1). Ferner gibt es eine nilpotente

Matrix N und eine diagonale Matrix D mit N D = DN , so dass A ∼ D + N (nach Teil (3) des

Satzes 1.4). Die Matrix

3 −3

B := A − (−1I2 ) =

3 −3

ist nilpotent (B ist analog zu die Abbildung gi = f − λi IdV in dem Beweis des Satzes 1.4) und

deshalb gibt es eine geordnete Basis

1

1

0 6

A

A=

,

mit MA (FB ) =

=: N

1

−1

0 0

Dann gilt

A

A

A

(FA ) = MA

(−1IdK 2 ) + MA

(B) = D + N

A ∼ MA

mit D = −I2 .

[08.05.17]

8

VICTORIA HOSKINS

1.6. Jordan-Normalform. Für d ∈ N definieren wir den (nilpotenten) Jordanblock

0 1

0

.. ..

.

.

Jd :=

∈ Matd×d (K)

..

. 1

0

0

und für λ ∈ K definieren wir den Jordan-Block Jd (λ) = λId + Jd ∈ Matd×d (K).

Definition. Wir sagen eine Matrix A in Jordan-Normalform (JNF) ist, falls A eine blockdiagonale Form hat, die aus Jordan-Blöcke entsteht, d.h.

Jd1 (µ1 )

0

..

A=

,

.

0

Jds (µs )

wobei µi = µj und di = dj möglich ist. Wir sagen, dass A eine Jordan-Normalform hat,

wenn A ähnlich zu einer Matrix in JNF ist. Für einen Endomorphismus f ∈ EndK (V ) eines

endlichdimensionalen K-Vektorraumes V sagen wir, dass f eine Jordan-Normalform hat, wenn

A (f ) eine JNF hat.

für eine geordnete Basis A von V die Matrix MA

Satz 1.5 (Jordan-Normalform für nilpotente Endomorphismen). Sei g : V → V ein nilpotenter

Endomorphismus eines n-dimensionalen K-Vektorraumes V und d := min{r ∈ N : g r = 0}.

Dann gibt es eindeutig bestimmte Zahlen s1 , . . . , sd ∈ N mit

d

X

ksk = n

k=1

A (g) in JNF ist:

und eine geordnete Basis A von V , so dass MA

Jd

..

.

Jd

..

.

A

MA (g) =

..

.

J1

..

.

J1

mit sk Kopien von Jk .

Bemerkung. Nach dem Beweis des Satzes 1.5 folgt, dass sd > 0.

[10.05.17]

Beispiel. Für die folgende nilpotente Matrix

0 1 1

0 0 1

A = 0 0 1 mit A2 = 0 0 0

0 0 0

0 0 0

A3 = 0

finden wir eine JNF von A wie folgt. Sei d := min{r ∈ N : Ar = 0} = 3 und für 0 ≤ i ≤ d = 3

sei Ui := ker(Ai ) = {x ∈ K 3 : Ai x = 0}, dann

{0} = U0 ( U1 = Span(e1 ) ( U2 = Span(e1 , e2 ) ( U3 = K 3 .

Wir finden eine Zerlegung K 3 = U2 ⊕ W3 mit W3 = Span(e3 ). Es gilt A(W3 ) = A(Span(e3 )) =

Span(Ae3 ) = Span(e1 + e2 ) ⊂ U2 . Wir müssen eine Zerlegung K 3 = U1 ⊕ W2 ⊕ W3 finden mit

LINEARE ALGEBRA II: LEHRPLAN

9

A(W3 ) ⊂ W2 . Aus dim(U1 ) = dim(W3 ) = 1 folgt dim(W2 ) = 1, also W2 = Span(e1 + e2 ). Dann

ist W1 = U1 = Span(e1 ) und

K 3 = W1 ⊕ W2 ⊕ W3 = Span(e1 ) ⊕ Span(e1 + e2 ) ⊕ Span(e3 ).

Es gilt s3 = dim(W3 ) = 1 und s2 = dim(W2 ) − dim(W3 ) = 0 und s1 = dim(W1 ) − dim(W2 ) = 0.

(3)

Wir wählen eine Basis von K 3 wie folgt: sei v1 := e3 eine Basis von W3 und wir erweitern

(3)

A(v1 ) = Ae3 = e1 + e2 zu einer Basis von W2 (da s2 = 0 haben wir die triviale Erweiterung

mit 0 zusätzlichen Vektoren) und wir erweitern A(e1 + e2 ) = A2 (e3 ) = e1 zu einer Basis von W1

(wegen s1 = 0 ist diese Erweiterung trivial).

Basis von W3 :

Basis von W2 :

Basis von W1 :

(3)

(3)

(3)

v1 = e3

(3)

A(v1 ) = e1 + e2

(3)

A2 (v1 ) = e1

(3)

Für A = (A2 (v1 ), A(v1 ), v1 ) = (e1 , e1 + e2 , e3 ) ist

0 1 0

A

MA

(FA ) = 0 0 1

0 0 0

in Jordan-Normalform. Für die standard Basis B = (e1 , e2 , e3 ) ist

Basiswechselsformel gilt

1

A

B

MA

(FA ) = SAS −1 mit S := MA

(IdK 3 ) = 0

0

MBB (FA ) = A und nach dem

−1 0

1 0 .

0 1

Satz 1.6. Sei f : V → V ein linearer Endomorphismus eines endlichdimensionalen K-Vektorraumes

V , so dass das charakteristische Polynom von f

χf (t) =

k

Y

(t − λi )ri

i=1

in Linearfaktoren zerfällt mit λ1 , . . . , λk die paarweise verschiedenen Eigenwerte von f . Dann

gibt es eine Basis A von V , so dass

λ1 Ir1 + N1

0

···

0

..

.

0

λ2 Ir2 + N2 . .

.

A

MA (f ) =

..

..

.

.

0

0

...

0 λk Irk + Nk

A (f ) in

mit Ni ∈ Matri ×ri (K) nilpotente Matrizen in Jordan-Normalform. Insbesondere ist MA

JNF, also hat f eine JNF.

Lemma.

(1) Zwei Jordan-Blöcke Jr (λ) und Js (µ) sind genau dann ähnlich, wenn r = s und λ = µ.

(2) Zwei Matrizen in JNF A und B sind genau dann ähnlich, wenn sie die gleiche Anzahl

von jedem Jordan-Block Jr (λ) haben.

Satz 1.7. Die Jordan-Normalform eines Endomorphismus f eines endlichdimensionalen KVektorraumes mit einem charakteristischen Polynom, das in Linearfaktoren zerfällt, ist bis auf

die Reihenfolge der Jordan-Blöcke eindeutig durch f bestimmt, d.h. unabhängig von der Wahl

der Basis.

Korollar. Jede komplexe Matrix hat eine JNF, d.h. in der Ähnlichkeitsklasse der komplexen

Matrix gibt es eine Matrix in JNF. Ferner klassifiziert die Jordan-Normalform (bis auf die

Reihenfolge der Jordan-Blöcke) alle komplexen Matrizen bis auf Ähnlichkeit, d.h. in jeder Ähnlichkeitsklasse einer komplexen Matrix gibt es genau eine Matrix in JNF (bis auf die Reihenfolge

[15.05.17]

10

VICTORIA HOSKINS

der Jordan-Blöcke).

Beispiel. Sei A eine Matrix mit dem charakteristischen Polynom χA (t) = (t − 5)(t − 3)2 . Mit

nur diesen Informationen können wir die mögliche JNF wie folgt bestimmen. Die Eigenwerte

sind λ1 = 5 und λ2 = 3 und es gilt für jeder Eigenwert λi von A:

dimK (Hau(A, λi )) = µa (A, λi ) ≥ µg (A, λi ) ≥ 1.

Wegen µa (A, 5) = 1, folgt µg (A, 5) = 1 und wegen µa (A, 3) = 2, folgt µg (A, 3) = 1 oder

µg (A, 3) = 2. Um die JNF zu berechnen, betrachen wir die nilpotente Abbildungen

gi := (FA − λi Id)|Hau(A,λi ) : Hau(A, λi ) → Hau(A, λi )

(i)

(i)

und wenn di := min{r ∈ N : gir ≡ 0}, gibt es Zahlen s1 , . . . , sdi ∈ N, die eindeutig durch gi

definiert wird, mit

di

X

(1)

(i)

jsj = µa (A, λi )

j=1

(Satz 1.5). Ferner gilt

0 < di ≤ dimK (Hau(A, λi )) = µa (A, λi ).

(2)

(i)

Dann hat die JNF von A den Jordan-Block Jj (λi ) mit der Vielfalt sj .

(1)

Für λ1 = 5 folgt es, dass d1 = 1 nach (2) und s1 = 1 nach (1). Dann die JNF von g1 hat

(1)

(1)

1 = s1 Jordan-Block J1 und die JNF von A hat 1 = s1 Jordan-Block J1 (5).

(2)

Für λ2 = 3 folgt es, dass d2 = 1 oder d2 = 2 nach (2). Wenn d2 = 1, dann ist s1 = 2 nach

(2)

(2)

(1) und g2 hat 2 = s1 Jordan-Blöcke J1 und A hat 2 = s1 Jordan-Blöcke J1 (3). Wenn d2 = 2

(2) (2)

(2)

(2)

(i)

gibt es Zahlen s1 , s2 ∈ N mit 1s1 + 2s2 = µa (A, λ2 ) = 2 und wegen sdi > 0 (siehe die

(2)

(2)

Bemerkung nach dem Satz 1.5) haben wir s1 = 0 und s2 = 1. In diesem Fall hat g2 einen (da

(2)

(2)

s2 = 1) Jordan-Block J2 und A hat 1 = s2 Jordan-Block J2 (3).

Abschließend gibt es zwei Möglichkeiten:

(1)

(2)

a) Wenn (d1 = 1, s1 = 1) und (d2 = 1, s1

5

0

0

= 2), ist die JNF von A

0 0

3 0

0 3

und das Minimalpolynom von A ist mA (t) = (t − 5)(t − 3).

(1)

(2)

(2)

b) Wenn (d1 = 1, s1 = 1) und (d2 = 2, s1 = 0, s2 = 2), ist die JNF von A

5 0 0

0 3 1

0 0 3

und das Minimalpolynom von A ist mA (t) = (t − 5)(t − 3)2 .

Definition. Eine Funktion j : Matn×n (K) → X (für eine Menge X) heißt Invariant für Matrizen (bis auf Ähnlichkeit), falls j konstant auf jeder Ähnlichkeitsklasse ist, so dass, es eine

induziierte Abbildung gibt

j̄ : Matn×n (K)/ ∼ → X.

Beispiel. Die folgenden Funktionen sind Invarianten für Matrizen (bis auf Ähnlichkeit):

(1) das charakteristische Polynom χ : Matn×n (K) → K[t],

(2) das Minimalpolynom m : Matn×n (K) → K[t],

(3) die Determinante det : Matn×n (K) → K,

(4) die Spurabbildung Spur : Matn×n (K) → K,

(5) der Rang einer Matrix Rang : Matn×n (K) → N,

LINEARE ALGEBRA II: LEHRPLAN

11

(6) die Menge der Eigenwerte Eig : Matn×n (K) → {endliche Teilmenge von K},

(7) die algebraische (bzw. geometrische) Vielfachheiten von λ ∈ K:

µa (−, λ) : Matn×n (K) → N

(bzw. µg (−, λ) : Matn×n (K) → N).

(8) (falls K algebraisch abgeschlossen ist, so dass jede Matrix eine JNF hat) die Anzahl

sk (λ) von jedem Jordan-Block Jk (λ) in einer JNF einer Matrix.

2. Bilinearformen und quadratische Formen

2.1. Bilinearformen. Seien V , W und U Vektorräume über einen Körper K. Zur Erinnerung:

eine Abbildung f : V → W heißt K-linear (oder linear), wenn für alle v, v 0 ∈ V und λ ∈ K gilt

f (v + v 0 ) = f (v) + f (v 0 )

und f (λ · v) = λ · f (v),

oder, äquivalent, für alle v, v 0 ∈ V und µ, λ ∈ K gilt

f (µv + λv 0 ) = µf (v) + λf (v 0 ).

Definition.

(1) Eine Abbildung f : V × W → U heißt bilinear 6, wenn für alle Vektoren v, v 0 ∈ V und

w, w0 ∈ W und Elemente µ, λ ∈ K gilt

i) f (µv + λv 0 , w) = µf (v, w) + λf (v 0 , w),

ii) f (v, µw + λw0 ) = µf (v, w) + λf (v, w0 ).

(2) Eine bilineare Paarung zwischen V und W ist eine bilineare Abbildung f : V × W → K.

(3) Eine Bilinearform (BLF) auf V ist eine bilinear Abbildung b : V × V → K. Wenn

dimK V = n ∈ N und A = (v1 , · · · , vn ) eine geordnete Basis von V ist, dann nennen

wir die Matrix B := (b(vi , vj ))1≤i,j≤n ∈ Matn×n (K) die Matrix zu der Bilinearform b

bezüglich der Basis A und wir schreiben B = b(A, A). Die Menge der Bilinearformen

auf V wird mit BilK (V ) bezeichnet.

Beispiel.

(1) Die Abbildung b : K 2 × K 2 → K, die durch

x1

y1

b

,

:= x1 y2 − x2 y1

x2

y2

definiert wird, ist bilinear. Für die geordnete Basis (e1 , e2 ) von K 2 ist die zugehörige

Matrix

0 1

B=

.

−1 0

(2) Die kanonische Bilinearform auf K n ist die Abbildung b : K n × K n → K

n

X

b(x, y) =

x i yi

i=1

und die zugehörige Matrix für die geordnete Standardbasis A = (e1 , . . . , en ) von K n ist

die Einheitsmatrix: In = b(A, A).

(3) Für jeder K-Vektorraum V mit dem Dualraum V ∗ := HomK (V, K) ist die Abbildung

b:V∗×V →K

b(ϕ, v) := ϕ(v)

eine bilineare Paarung zwischen V ∗ und V .

Bemerkung. Sei V ein K-Vektorraum der endlichen Dimension n und A = (v1 , · · · , vn ) eine

geordnete Basis von V . Dann gibt es genau einen linearen Isomorphismus ΦA : V → K n mit

ΦA (vi ) = ei für 1 ≤ i ≤ n [LAI, Satz 4.4].

6Man kann diese Definition erweitern: wenn V , · · · , V und W K-Vektorräume sind, heißt eine Abbildung

1

n

f : V1 × V2 × · · · × Vn → W multilinear, wenn f in jeder Komponente linear ist, d.h. für alle 1 ≤ i ≤ n und für

alle vj ∈ Vj für j 6= i ist die Abbildung Vi → W , die durch vi 7→ f (v1 , · · · , vn ) definiert wird, linear.

12

VICTORIA HOSKINS

(1) Wenn b : V × V → K eine Bilinearform ist und B die Matrix zu b bzgl. der Basis A ist,

dann gilt für alle v, v 0 ∈ V

b(v, v 0 ) = ΦA (v)t B ΦA (v 0 ).

(2) Umgekehrt definiert B ∈ Matn×n (K) eine Bilinearform bA

B auf V durch

0

t

0

bA

B (v, v ) := ΦA (v) B ΦA (v )

und die zugehörige Matrix dieser Bilinearform bA

B bzgl. der Basis A ist wieder B.

Bemerkung. Man kann Bilinearformen auf V punktweise addieren: für Bilinearformen b1 , b2 :

V × V → K definieren wir b1 + b2 : V × V → K durch

(b1 + b2 )(v, v 0 ) := b1 (v, v 0 ) + b2 (v, v 0 ),

und b1 + b2 ist auch bilinear. Man kann auch eine Bilinearform b : V × V → K mit einem Skalar

λ ∈ K multiplizieren, um eine neue Bilinearform λ · b : V × V → K zu definieren

(λ · b)(v, v 0 ) := λ · b(v, v 0 ).

[17.05.17]

Deshalb ist die Menge der Bilinearformen auf V ein Untervektorraum des K-Vektorraumes

Abb(V × V, K) der Abbildungen von V × V nach K.

Satz 2.1. Sei V ein K-Vektorraum der endlichen Dimension n und A = (v1 , · · · , vn ) eine

geordnete Basis von V . Die Abbildung

ΨA : BilK (V ) → Matn×n (K),

die zu jeder Bilinearform b die zugehörige Matrix B = b(A, A) bzgl. der Basis A zuordnet, ist

ein linearer Isomorphismus.

Satz 2.2 (Basiswechsel). Seien A, B geordnete Basen eines endlichdimensionalen K-Vektorraumes

V . Dann gilt für eine Bilinearform b auf V

B

B

b(B, B) = MA

(IdV )t b(A, A) MA

(IdV )

B (Id ) die Basiswechselmatrix für die Identität auf V ist.

wobei MA

V

Definition. Zwei Matrizen A, B ∈ Matn×n (K) heißen kongruent, wenn es eine Matrix S ∈

GLn (K) gibt mit A = S t BS. Schreibweise: A ≈ B.

Übung. Die Relation der Kongruenz auf Matn×n (K) ist eine Äquivalenzrelation. Für eine

Bilinearform b auf einem K-Vektorraum der Dimension n sind alle die Matrizen b(A, A) für

verschiedene geordnete Basen A von V kongruent (nach der Basiswechsel-Formel).

Bemerkung. Wenn b : V × V → K eine Bilinearform auf V ist, können wir eine Abbildung

fb : V → V ∗ durch

fb (v) := b(−, v) : V → K

definieren. Wegen der Linearität von b im ersten Argument ist fb wohldefiniert. Wegen der

Linearität von b im zweiten Argument ist fb linear.

Wenn dimK (V ) = n und A = (v1 , . . . , vn ) eine geordnete Basis von V ist, können wir die

A (f ) ∈ Mat

∗

zugehörige Matrix C := MA

∗

n×n (K) betrachten (wobei A die duale Basis ist). Es

b

gilt

n

X

fb (vj ) =

cij vi∗

i=1

und deshalb folgt es, dass

b(vk , vj ) =: fb (vj )(vk ) =

n

X

i=1

d.h.

A (f )

MA

∗

b

ist die Matrix b(A, A) zu b bzgl. A.

cij vi∗ (vk ) = ckj

LINEARE ALGEBRA II: LEHRPLAN

13

Satz 2.3. Sei V ein endlichdimensionalen K-Vektorraum. Dann ist die Abbildung

BilK (V ) → HomK (V, V ∗ )

b

7→ fb : V → V ∗

ein linearer Isomorphismus.

2.2. Symmetrische Formen. Zur Erinnerung: eine Matrix A ∈ Matn×n (K) heißt symmetrisch, wenn At = A. Sei MatSym

n×n (K) die Teilmenge von Matn×n (K), die symmetrische Matrizen

enthält.

Definition. Eine Bilinearform b auf einem K-Vektorraum V heißt

(1) symmetrisch, wenn b(v, v 0 ) = b(v 0 , v) für alle v, v 0 ∈ V . Die Menge aller symmetrischen

Bilinearformen auf V bildet ein Untervektorraum Bilsym (V ) von Bil(V ).

(2) antisymmetrisch, wenn b(v, v 0 ) = −b(v 0 , v) für alle v, v 0 ∈ V .

Eine Matrix A ∈ Matn×n (K) heißt antisymmetrisch, wenn At = −A.

Bemerkung.

(1) Die Menge Bilsym (V ) (bzw. Bila-sym (V )) aller symmetrischen (bzw. antisymmetrischen)

Bilinearformen ist ein Untervektorraum von Bil(V ). Ebenso ist die Menge Matsym

n×n (K)

(bzw. Mata-sym

(K))

aller

symmetrischen

(bzw.

antisymmetrischen)

ein

Untervektorraum

n×n

von Matn×n (K).

(2) Wenn 2 := 1 + 1 = 0 in K stimmen die Begriffe symmetrische und antisymmetrisch

überein.

(3) Wenn 2 6= 0 in K (so dass 2 ∈ K invertierbar ist), dann gilt

a-sym

Matn×n (K) = Matsym

n×n (K) ⊕ Matn×n (K),

weil eine n × n-Matrix A die Form A = 21 (A + At ) + 21 (A − At ) hat.

Lemma. Sei b eine Bilinearform auf einem K-Vektorraum V der Dimension n. Die zugehörige

Matrix B = b(A, A) bzgl. einer geordneten Basis A von V ist genau dann symmetrisch (bzw.

antisymmetrisch), wenn b symmetrisch (bzw. antisymmetrisch) ist. Ferner gibt es einen linearen

Isomorphismus

Bilsym (V ) → Matsym

n×n (K) .

b

7→

b(A, A)

Beispiel. Die kanonische Bilinearform b : K n × K n → K

b(x, y) =

n

X

x i yi

i=1

ist symmetrisch.

Definition. Eine Bilinearform b auf einem K-Vektorraum V heißt alternierend, wenn b(v, v) = 0

für alle v ∈ V .

Lemma. Sei b : V × V → K eine Bilinearform.

(1) Wenn b alternierend ist, dann ist b antisymmetrsich.

(2) Wenn 2 6= 0 ∈ K und b antisymmetrisch ist, dann ist b alternierend.

[22.05.17]

2.3. Orthogonalität und nicht ausgeartete Formen.

Definition. Sei b : V × V → K eine Bilinearform auf einem K-Vektorraum V . Wir sagen, dass

v ∈ V orthogonal zu w ∈ V ist (bzgl. b), wenn b(v, w) = 0 und wir schreiben v ⊥ w. Für eine

Teilmenge M ⊂ V definieren wir die Menge M ⊥ aller Vektoren, die rechtsorthogonal auf M

bzgl. b sind

M ⊥ := {v ∈ V : b(m, v) = 0 ∀m ∈ M }

14

VICTORIA HOSKINS

und die Menge ⊥ M aller Vektoren, die linksorthogonal auf M bzgl. b sind

⊥

M := {v ∈ V : b(v, m) = 0 ∀m ∈ M }.

Die Menge M ⊥ (bzw. ⊥ M ) heißt Rechtsorthogonalraum (bzw. Linksorthogonalraum) von M in

V.

Bemerkung. Wenn b symmetrisch oder alternierend ist, dann gilt v ⊥ w ⇐⇒ w ⊥ v. Insbesondere ist M ⊥ = ⊥ M für alle M ⊂ V .

Beispiel. Für die kanonische Bilinearform auf K 3 und M = {e1 , e2 } gilt

x1

⊥

x2

: b(e1 , x) = b(e2 , x) = 0 = Span(e3 ) =⊥ M.

M := x =

x3

Lemma. Sei b : V × V → K eine Bilinearform auf einem K-Vektorraum V und M ⊂ V eine

Teilmenge. Dann sind M ⊥ und ⊥ M Untervektorräume von V .

Definition. Eine Bilinearform b auf einem K-Vektorraum V heißt nicht ausgeartet, wenn für

alle v ∈ V gelten die folgende Aussagen:

(1) b(v 0 , v) = 0 für alle v 0 ∈ V =⇒ v = 0 (d.h. V ⊥ = {0V }),

(2) b(v, v 0 ) = 0 für alle v 0 ∈ V =⇒ v = 0 (d.h. ⊥ V = {0V }).

Sonst sagen wir, dass b ausgeartet ist.

Beispiel.

(1) Die kanonische Bilinearform auf K n

b(x, y) =

n

X

x i yi

i=1

ist nicht ausgeartet: aus b(x, y) = 0 für alle y ∈ K n folgt x = 0, da b(x, ei ) = xi , und

aus b(x, y) = 0 für alle x ∈ K n folgt y = 0.

(2) Sei b : K 2 × K 2 → K die Bilinearform

x1

y1

b

,

:= x1 y1 + x2 y1

x2

y2

mit zugehörigen Matrix

b(A, A) =

1 0

1 0

bzgl. der Standardbasis A = (e1 , e2 ). Diese Bilinearform ist nicht symmetrisch und für

M = {e2 } gilt M ⊥ 6= ⊥ M :

0

y1

y1

b

,

= y1 so dass M ⊥ =

∈ K 2 : y1 = 0

1

y2

y2

und

b

x1

x2

0

,

=0

1

so dass

⊥

M = K 2.

Diese Bilinearform b ist ausgeartet, weil

y1

2

2 ⊥

∈ K : y1 = 0 6= {0V }.

(K ) =

y2

LINEARE ALGEBRA II: LEHRPLAN

15

Zur Erinnerung: für einen K-Vektorraum V und eine Bilinearform b : V × V → K gibt es

eine lineare Abbildung fb : V → V ∗ mit

fb (v) := b(−, v) : V → K

A (f ) = b(A, A).

und wenn A = (v1 , . . . , vn ) eine geordnete Basis von V ist, gilt MA

∗

b

Satz 2.4. Sei b : V ×V → K eine Bilinearform auf einem endlichdimensionalen K-Vektorraum

V mit einer geordneten Basis A. Dann sind die folgenden Bedingungen äquivalent:

(1) b ist nicht ausgeartet,

(2) V ⊥ = {0V },

(3) ⊥ V = {0V },

(4) die zugehörige Matrix B = b(A, A) ist invertierbar,

(5) die lineare Abbildung fb : V → V ∗ , die durch v 7→ b(−, v) definiert wird, ist ein Isomorphismus.

Beispiel. Die Einschränkung einer nicht ausgearteten Bilinearform kann ausgeartet sein: für

V = K 2 und die Bilinearform

b(x, y) := x1 y2 + x2 y1 ,

ist b|U ×U ≡ 0 für U := Span(e1 ) ⊂ V . Insbesondere ist b nicht ausgeartet, aber b|U ×U ist ausgeartet.

Definition. Sei U ein Untervektorraum eines K-Vektorraumes V . Dann definieren wir den

Annullator von U

Ann(U, V ∗ ) := {ϕ ∈ V ∗ : ϕ(u) = 0V ∀ u ∈ U } ⊂ V ∗ .

Für W ⊂ V ∗ , definieren wir Ann(W, (V ∗ )∗ ) ⊂ (V ∗ )∗ wie oben und

Ann(W, V ) := {v ∈ V : ϕ(v) = 0V ∀ ϕ ∈ W } ⊂ V.

Bemerkung. Sei V ein K-Vektorraum und U ⊂ V und W ⊂ V ∗ Untervektorräume.

(1) Der Annullator Ann(U, V ∗ ) ist ein Untervektorraum von V ∗ .

(2) Wenn V endlichdimensional ist, wir behaupten dass

dimK (Ann(U, V ∗ )) = dimK (V ) − dimK (U ).

Seien {u1 , · · · , ur } eine Basis von U und B = {u1 , · · · , ur , v1 , · · · , vs } eine Basis von V ,

dann sind die Linearformen vi∗ ∈ Ann(U, V ∗ ) ⊂ V ∗ für 1 ≤ i ≤ s linear unabhängig. Es

gilt

Span(v1∗ , . . . , vs∗ ) = Ann(U, V ∗ ),

da ‘⊂’ klar ist, und jede Abbildung ϕ ∈ Ann(U, V ∗ ) ⊂ V ∗ als eine Linearkombination

der Basisvektoren B ∗ geschrieben werden kann:

ϕ = λ1 u∗1 + · · · + λr u∗r + µ1 v1∗ + · · · + µs vs∗

mit λi = ϕ(ui ) = 0K für 1 ≤ i ≤ r. Daher ist {v1∗ , . . . , vs∗ } eine Basis von Ann(U, V ∗ ).

(3) Wenn V endlichdimensional ist, haben wir einen linearen Isomorphismus

Φ: V

v

→

(V ∗ )∗

7→ Φv : V ∗ → K,

wobei Φv (ϕ) := ϕ(v). Dann gilt Φ(Ann(W, V )) = Ann(W, (V ∗ )∗ ).

Satz 2.5. Sei b : V ×V → K eine Bilinearform auf einem endlichdimensionalen K-Vektorraum

V und U ein Untervektorraum von V . Dann gilt

dim(U ) + dim(⊥ U ) = dim(V ) + dim(U ∩ V ⊥ ).

und

dim(U ) + dim(U ⊥ ) = dim(V ) + dim(U ∩

⊥

V ).

16

VICTORIA HOSKINS

Korollar. Sei b : V × V → K eine nicht ausgeartete Bilinearform auf einem endlichdimensionalen K-Vektorraum V . Für einen Untervektorraum U ⊂ V gilt

dim(V ) = dim(U ) + dim(⊥ U ) = dim(U ) + dim(U ⊥ ).

Ferner haben wir U =

⊥ (U ⊥ )

= (⊥ U )⊥ .

Korollar. Sei b : V × V → K eine Bilinearform auf einem endlichdimensionalen K-Vektorraum

V . Für einen Untervektorraum U ⊂ V ist äquivalent:

(1) b|U ×U ist nicht ausgeartet,

(2) V = U ⊕ U ⊥ .

Übung. Sei K ein Korper mit 1 + 1 6= 0 und V ein endlichdimensionaler K-Vektorraum. Für

jede antisymmetrische Bilinearform b : V ×V → K beweisen Sie (durch Induktion nach dim(V )),

dass es eine Basis A von V gibt mit

0 0

...

0

.

.

0 .. ..

..

..

..

. 0

.

.

0 1

b(A, A) = .

.

für S =

..

..

−1 0

..

.

.

S

.. ..

.

. 0

0

[24.05.17]

...

0

S

Was ist eine notwendige Bedingung für V eine nicht ausgeartete antisymmetrische Bilinearform

zu haben?

2.4. Quadratische Formen.

Definition. Ein Polynom in n Variablen t1 , · · · , tn über K ist ein formaler Ausdruck P der

Form

X

P (t1 , . . . , tn ) =

aI ti11 ti22 · · · tinn

I=(i1 ,...,in )∈Nn

mit Koeffizienten aI ∈ K, so dass nur endliche viele Koeffizienten aI ungleich Null sind. Der

Grad eines nicht-Null Polynoms P ist

grad(P ) := max{i1 + · · · + in : aI 6= 0}.

Ein Polynom P heißt homogen vom Grad d, wenn für alle I = (i1 , . . . , in ) ∈ Nn gilt

aI 6= 0 =⇒ i1 + · · · + in = d.

Insbesondere ist das Nullpolynom homogen von jedem Grad d. Die Menge aller Polynome in n

Variablen t1 , . . . , tn über K wird mit K[t1 , . . . , tn ] bezeichnet; diese Menge ist eine Teilmenge der

Menge Abb(K n , K). Die Menge K[t1 , . . . , tn ] mit der Addition und Multiplikation von Polynome

bildet einen Ring und ist auch ein K-Vektorraum. Die Teilmenge K[t1 , . . . , tn ]d ⊂ k[t1 , . . . , tn ]

von allen homogenen Polynome des Grads d ist ein endlichdimensionalen Untervektorraum.

Übung. Ein Polynom P (t1 , · · · , tn ) in n Variablen über K ist homogen vom Grad d genau

dann, wenn für alle λ ∈ K gilt

P (λ · t1 , . . . , λ · tn ) = λd P (t1 , . . . , tn ).

Definition. Eine quadratische Form auf V ist eine Abbildung q : V → K mit den folgenden

Eigenschaften:

(1) q(λ · v) = λ2 · q(v) für alle λ ∈ K und v ∈ V ,

(2) Die Abbildung βq : V × V → K

βq (v, v 0 ) := q(v + v 0 ) − q(v) − q(v 0 )

ist eine Bilinearform auf V . (Wir nennen βq die zu q assoziierte Bilinearform).

LINEARE ALGEBRA II: LEHRPLAN

17

Die quadratische Form q heißt nicht ausgeartet, falls βq nicht ausgeartet ist. Die Menge aller

quadratischen Formen auf V wird mit QFK (V ) bezeichnet.

Bemerkung. Insbesondere, wenn q 6≡ 0 ist q nicht linear nach (1). Die assoziierte Bilinearform

βq ist symmetrisch. Ferner ist die Teilmenge QFK (V ) ⊂ Abb(V, K) ein Untervektorraum.

Satz 2.6. Sei A = (v1 , · · · , vn ) eine geordnete Basis eines K-Vektorraumes V . Für eine Abbildung q : V → K definieren wir eine Abbildung fqA : K n → K durch

fqA (x1 , . . . , xn ) := q(x1 · v1 + · · · + xn · vn ).

Die Abbildung q ist genau dann eine quadratische Form, wenn fqA ein homogenes Polynom vom

Grad 2 ist.

Bemerkung. Sei V ein K-Vektorraum.

(1) Wenn b eine Bilinearform auf V ist, dann ist qb (v) := b(v, v) eine quadratische Form von

V mit βqb (v, v 0 ) = b(v, v 0 ) + b(v 0 , v). Wenn A eine geordnete Basis von V ist, gilt

βqb (A, A) = b(A, A) + b(A, A)t .

(2) Wenn b ist eine symmetrische Bilinearform auf V , gilt

2b(v, v 0 ) = b(v + v 0 , v + v 0 ) − b(v, v) − b(v 0 , v 0 ).

Die folgende ‘Polarisierungs-Identität’ folgt für die quadratische Form qb (v) := b(v, v)

2b(v, v 0 ) = qb (v + v 0 ) − qb (v) − qb (v 0 )

Insbesondere gilt für die zugehörige Bilinearform βqb zu qb die Gleichung 2b = βqb .

(3) Falls 2 := 1 + 1 6= 0 ∈ K und b eine symmetrische Bilinearform auf V ist, dann können

wir b aus der quadratischen Form qb (v) := b(v, v) zurückgewinnen durch die Formel

b = 21 βqb .

Beispiel. Für die kanonische symmetrische Bilinearform b auf K n ist qb (x1 , . . . , xn ) =

Pn

2

i=1 xi .

Definition. Die Charakteristik eines Körpers K ist

0

falls n := 1 + · · · + 1 6= 0 ∈ K ∀n ∈ N∗ ,

Char(K) :=

min{n ∈ N∗ : n = 0 ∈ K} sonst.

Übung. Die Charakteristik eines Körpers ist entweder Null oder eine Primzahl.

Beispiel.

(1) Char(Q) = Char(R) = Char(C) = 0.

(2) Char(Fp ) = p für eine Primzahl p.

Satz 2.7. Sei K ein Körper mit Char(K) 6= 2 und V ein K-Vektorraum. Dann gibt es einen

linearen Isomorphismus

Bilsym

K (V ) → QFK (V )

b

7→

qb

mit qb (v) := b(v, v).

Bemerkung. Wenn dimK (V ) = n ∈ N und Char(K) 6= 2, dann gibt es Bijektionen

sym

∼

∼

Matsym

n×n (K) = BilK (V ) = QFK (V ).

P

n

Wenn q(x) =

1≤i≤j≤n aij xi xj eine quadratische Form auf K ist, dann ist die zugehörige

symmetrische Matrix C = (cij ) mit

aij /2 i < j

aii

i=j

cij =

aji /2 i > j,

[29.05.17]

18

VICTORIA HOSKINS

da 12 βq (ei , ej ) = cij , so dass 12 βq (B, B) = C für B = (e1 , . . . , en ).

Definition. Sei b eine symmetrische Bilinearform auf einem K-Vektorraum V . Eine Orthogonalbasis von V bzgl. b ist eine Basis A von V mit b(vi , vj ) = 0 für alle vi 6= vj ∈ A (d.h. vi ⊥ vj ).

Bemerkung. Sei V ein endlichdimensionaler K-Vektorraum und A eine geordnete Basis von

V . Die Basis A ist genau dann orthogonal bzgl. einer Bilinearform b auf V , wenn die zugehörige

Matrix b(A, A) diagonal ist.

Beispiel. Für die kanonische Bilinearform auf K n

b(x, y) :=

n

X

xi yi

i=1

ist die Standardbasis eine Orthogonalbasis.

Satz 2.8. Sei K ein Körper mit Char(K) 6= 2 und b eine symmetrische Bilinearform auf einem

endlichdimensionalen K-Vektorraum V . Dann gibt es eine Orthogonalbasis von V bzgl. b.

Korollar. Wenn Char(K) 6= 2, ist jede symmetrische Matrix A ∈ MatSym

n×n (K) kongruent zu

t

einer Diagonalmatrix, d.h. es gibt S ∈ GLn (K) mit SAS = D, eine Diagonalmatrix.

Korollar. Wenn K = C und b eine symmetrische Bilinearform auf einem C-Vektorraum V der

Dimension n ∈ N ist, dann gibt es 0 ≤ r ≤ n und eine geordnete Basis A von V so dass die

Matrix B = b(A, A) zu b die folgende Form hat

Ir 0

B=

.

0 0

[31.05.17]

Korollar. (Trägheitssatz von Sylvester - Version I). Sei K = R und b eine symmetrische Bilinearform auf einem R-Vektorraum V der Dimension n. Dann gibt es r, s ∈ N mit r + s ≤ n und

eine geordnete Basis A von V so, dass die zu b gehörige Matrix B = b(A, A) die folgende Form

hat

Ir

0 0

B = 0 −Is 0 .

0

0 0

Korollar.

Sei K ein Körper mit Char(K) 6= 2. Jedes homogene quadratische Polynom q(x1 , . . . , xn ) =

P

a

1≤i≤j≤n ij xi xj in n Variablen x1 , . . . , xn lässt sich schreiben in der Form

X

q(x) =

di · (bi1 x1 + · · · + bin xn )2

1≤i,j≤n

mit bij und di ∈ K.

q(x) = xt Cx = xt B t DBx = (Bx)t D(Bx) =

n

X

di (Bx)2i .

i=1

Bemerkung. Aus diesem Korollar folgt:

(1) Für jede quadratische Form q auf einem C-Vektorraum der Dimension n gibt es 0 ≤

r ≤ n und eine geeignete Basis A von V , so dass das zugehörige homogene quadratische

Polynom fqA (siehe Satz 2.6) die folgende Form hat

fqA (t1 , . . . , tn ) = t21 + · · · + t2r .

LINEARE ALGEBRA II: LEHRPLAN

19

(2) Für jede quadratische Form q auf einem R-Vektorraum der Dimension n gibt es r, s ∈ N

mit r + s ≤ n und eine geeignete Basis A von V , so dass das zugehörige homogene

quadratische Polynom fqA die folgende Form hat

fqA (t1 , . . . , tn ) = t21 + · · · + t2r − t2r+1 − · · · − t2r+s .

3. Euklidische und unitäre Vektorräume

3.1. Euklidische Vektorräume. In diesem Abschnitt sei K = R. Der Körper R ist angeordnet, d.h. es gibt eine Ordnung ≤ auf R. Ferner gibt es einen Betrag auf R, der eine Abbildung

| − | : R → R≥0 := {x ∈ R : x ≥ 0} ist.

Definition. Sei V ein R-Vektorraum.

(1) Eine symmetrische Bilinearform b : V × V → R heißt positiv semi-definit (bzw. positiv

definit), falls b(v, v) ≥ 0 (bzw. b(v, v) > 0) für alle v ∈ V \{0V }.

(2) Eine symmetrische Bilinearform b auf V heißt negativ (semi-)definit, wenn −b positiv

(semi-)definit ist.

t

(3) Eine symmetrische Matrix A ∈ MatSym

n×n (R) heißt positiv semi-definit, wenn x Ax ≥ 0 für

n

alle x ∈ R \{0} ist. Ebenso kann man die Definitionen für positiv semi-definit, negativ

definit, und negativ semi-definit formulieren.

(4) Ein Skalarprodukt auf V ist eine positiv definite symmetrische Bilinearform h−, −i :

V × V → R auf V .

(5) Ein euklidischer Vektorraum (V, h−, −i) ist ein endlichdimensionaler R-Vektorraum V

mit einem Skalarprodukt h−, −i : V × V → R.

Bemerkung.

(1) Wenn V ein endlichdimensionaler R-Vektorraum ist und A eine geordnete Basis von V

ist, dann gilt für eine symmetrische Bilinearform b auf V :

b ist positiv definit ⇐⇒ b(A, A) ist positiv definit.

(2) Nach dem Trägheitssatz von Sylvester (Version I) gibt es zu jeder symmetrische Bilinearform b auf einem R-Vektorraum V der Dimension n natürliche Zahlen r, s mit r+s ≤ n

und eine geordnete Basis A von V so, dass

Ir

0 0

B = b(A, A) = 0 −Is 0 .

0

0 0

Die Bilinearform b ist genau dann positiv semi-definit, wenn s = 0. Die symmetrische

Bilinearform b ist ein Skalarprodukt (d.h. positiv definit), wenn s = 0 und r = n. Insbesondere ist ein Skalarprodukt h−, −i auf V nicht ausgeartet nach dem Satz 2.4. Die

Bilinearform ist negativ definit, wenn r = 0 und s = n.

Beispiel. Das Standardskalarprodukt auf Rn ist

h−, −i : Rn × Rn → R

P

(x, y)

7→ hx, yi := ni=1 xi yi .

Dann ist En := (Rn , h−, −i) der standard euklidische Vektorraum (der Dimension n).

Lemma. Eine symmetrische Matrix A ∈ MatSym

n×n (R) ist genau dann positiv definit, wenn A

kongruent zu der Einheitsmatrix In ist.

Satz 3.1 (Trägheitssatz von Sylvester). Sei h−, −i eine symmetrische Bilinearform auf einem

endlichdimensionalen R-Vektorraum V . Dann gibt es eine Zerlegung V = V+ ⊕ V− ⊕ V0 mit den

folgenden Eigenschaften.

(1) V0 , V+ und V− sind paarweise orthogonal bezüglich < −, − > ,

20

VICTORIA HOSKINS

(2) b|V0 ×V0 ≡ 0,

(3) b|V+ ×V+ ist positiv definit,

(4) b|V− ×V− ist negativ definit.

Ferner sind V0 , dimR (V+ ) und dimR (V− ) eindeutig bestimmt.

Definition.

(1) Die Signatur einer symmetrische Bilinearform b auf einem endlichdimensionalen RVektorraum V ist

sign(b) := dim(V+ ) − dim(V− ),

wobei V = V+ ⊕ V− ⊕ V0 eine Zerlegung wie in dem Trägheitssatz von Sylvester ist.

(2) Die Signatur einer symmetrische Matrix A ∈ Matn×n (R) ist die Signatur der zugehörigen symmetrische Bilinearform bA .

Bemerkung. Für zwei symmetrische Matrizen A, B ∈ Matn×n (R) gilt

A und B sind kongruent ⇐⇒ Rang(A) = Rang(B) und sign(A) = sign(B).

[07.06.17]

Definition. Sei (V, h−, −i) ein euklidischer Vektorraum.

(1) f ∈ EndR (V ) heißt orthogonal (bzgl. h−, −i), wenn für alle v, w ∈ V gilt

hf (v), f (w)i = hv, wi.

Wir schreiben O(V ) := {f ∈ EndK (V ) : f ist orthogonal}.

(2) Eine Matrix A ∈ Matn×n (R) mit At A = In heißt orthogonal 7. Wir schreiben O(n) für

die Menge aller orthogonalen n × n-Matrizen.

Bemerkung.

(1) Jede Matrix A ∈ O(n) ist invertierbar mit A−1 = At , also gilt O(n) ⊂ GLn . Tatsächlich

ist diese Teilmenge eine Untergruppe: es gilt In ∈ O(n) und aus A ∈ O(n) folgt A−1 ∈

O(n). Wir nennen O(n) die orthogonale Gruppe.

(2) Für A ∈ Matn×n (R) definieren wir eine lineare Abbildung FA : Rn → Rn durch FA (x) =

Ax für einen Spaltenvektor x ∈ Rn . Dann gilt für das Standardskalarprodukt h−, −i auf

Rn

hFA (x), FA (y)i = hAx, Ayi = (Ax)t Ay = xt At Ay.

Insbesondere ist A genau dann orthogonal, wenn FA orthogonal bzgl. des Standardskalarprodukt h−, −i auf Rn ist.

Beispiel.

(1) Sei λ ∈ R und V ein euklidischer Vektorraum. Dann ist f = λ · IdV genau dann orthogonal, wenn λ = ±1.

(2) Eine Drehung Dθ : R2 → R2 um 0 ∈ R2 mit Winkel θ ist orthogonal bzgl. des Standardskalarprodukt h−, −i auf Rn , weil

cos θ sin θ

Aθ = MBB (Dθ ) =

− sin θ cos θ

mit B = (e1 , e2 ) orthogonal ist:

cos θ − sin θ

cos θ sin θ

1 0

t

Aθ Aθ =

=

.

sin θ cos θ

− sin θ cos θ

0 1

7In diesem Fall ist A invertierbar mit A−1 = At

LINEARE ALGEBRA II: LEHRPLAN

21

(3) Eine Spieglung Sx : R2 → R2 in der x-Achse ist orthogonal, weil

1 0

A = MBB (Sx ) =

0 −1

orthogonal ist. Tatsächlich ist die Spieglung durch jede Gerade L durch 0 ∈ R2 orthogonal.

Bemerkung. Für einen euklidischen Vektorraum V und orthogonale Endomorphismen f, g ∈

EndR (V ) gilt

(1) f ◦ g ist orthogonal,

(2) ker(f ) = {0V }. Wegen dimR (V ) < ∞, ist f bijektiv und ferner ist f −1 orthogonal.

(3) Die Menge O(V ) ist eine Untergruppe von AutR (V ) ⊂ EndR (V ).

(4) Für einen Eigenwert λ ∈ R von f gilt λ = ±1.

Beispiel.

(1) O(1) = {±1}.

(2) Für n = 2: wenn eine Matrix

A=

a b

c d

orthogonal ist, gilt a2 + c2 = b2 + d2 = 1 und ab + cd = 0. Seien α := a + ic und

β := b + id ∈ C, dann gilt |α| = |β| = 1 und Re(αβ) = 0. Es folgt, dass |αβ| = 1 und,

wegen Re(αβ) = 0, dass αβ = ±i, d.h. β = ±iα. Jede komplexe Zahl α ∈ C mit |α| = 1

hat die Form α = cos θ + i sin θ für θ ∈ [0, 2π). Deshalb gibt es zwei Fälle:

cos θ − sin θ

Fall 1 : β = iα.

A=

sin θ cos θ

eine Drehung um 0 ∈ R2 mit Winkel θ, oder

cos θ sin θ

Fall 2 : β = −iα.

A=

sin θ − cos θ

√

eine Spieglung an der Geraden durch den 0 und α.

(3) Für A ∈ O(n) ist det(A) = ±1. Ferner ist der Homomorphismus det : O(n) → O(1) =

{±1} surjektiv.

3.2. Unitäre Vektorräume. In diesem Abschnitt sei K = C := {x + iy : (x, y) ∈ R2p

}, wobei i

eine Wurzel von −1 ist. Der Betrag ist eine Abbildung | − | : C → R≥0 mit |x + iy| = x2 + y 2 .

Die Komplexe Konjugation ist ein Körperautomorphisms C → C, der durch z := x + iy 7→ z̄ =

x − iy definiert wird. Es gilt z̄z = |z|2 .

Es gibt keine Ordnung auf C, deshalb hat der Begriff ‘positive Definitheit’ keinen Sinn. Ferner

haben wir für die kanonische symmetrische Bilinearform b auf Cn

b(z, w) :=

n

X

z k wk

k=1

für z = w = (i, . . . , i)t , dass b(z, z) < 0. Deshalb werden wir ein Skalarprodukt auf einem komplexen Vektorraum als eine ‘positiv definite hermitesche’ Form definieren.

Definition. Sei V ein C-Vektorraum.

(1) Eine Abbildung h : V × V → C heißt Sesquilinearform auf V , wenn

(a) h ist C-linear im zweiten Argument, d.h. für vi ∈ V und λ, µ ∈ C gilt

h(v1 , µv2 + λv3 ) = µh(v1 , v2 ) + λh(v1 , v3 ).

22

VICTORIA HOSKINS

(b) h ist C-antilinear im ersten Argument , d.h. für vi ∈ V und λ, µ ∈ C gilt

h(µv1 + λv2 , v3 ) = µ̄h(v1 , v3 ) + λ̄h(v2 , v3 ).

Die Menge aller Sesquilinearformen auf V wird mit SLF(V ) bezeichnet.

(2) Eine Sesquilinearform h auf V heißt Hermitesch (bzw. schief-Hermitesch), wenn ∀vi ∈

V:

h(v1 , v2 ) = h(v2 , v1 ) (bzw. h(v1 , v2 ) = −h(v2 , v1 )).

(3) Wenn A = (v1 , . . . , vn ) eine Basis von V ist und h eine Sesquilinearform auf V ist, dann

heißt h(A, A) := (h(vi , vj ))ij ∈ Matn×n (C) die Matrix von h bezüglich A.

(4) Für B = (bij ) ∈ Matm×n (C), definieren wir B † := B̄ t = (bji ) ∈ Matn×m (C).8

(5) Eine Matrix B ∈ Matn×n (C) heißt Hermitesch (bzw. schief-Hermitesch), wenn B = B †

(bzw. B = −B † ).

Beispiel. Die kanonische Hermitesche Form auf Cn ist h : Cn × Cn → C mit

n

X

z k wk

h(z, w) =

k=1

und die Matrix von h bzgl. zu der geordneten Standardbasis (e1 , . . . , en ) ist die Einheitsmatrix

In .

Bemerkung. Sei V ein C-Vektorraum der Dimension n und A = (v1 , . . . , vn ) eine geordnete

Basis von V . Dann gibt es genau einen linearen Isomorphismus ΦA : V → Cn mit ΦA (vk ) = ek

für 1 ≤ k ≤ n [LAI, Satz 4.4].

(1) Wenn h : V × V → C eine Sesquilinearform ist und B die Matrix von h bzgl. der Basis

A ist, dann gilt für alle v, v 0 ∈ V

h(v, v 0 ) = ΦA (v)† B ΦA (v 0 ).

Ferner ist h genau dann eine (schief-)Hermitesche Form, wenn B eine (schief-)Hermitesche

Matrix ist.

(2) Umgekehrt definiert B ∈ Matn×n (C) eine Sesquilinearform auf V durch

0

†

0

hA

B (v, v ) := ΦA (v) B ΦA (v )

und die zugehörige Matrix dieser Sesquilinearform h bzgl. der Basis A ist wieder B.

(3) Die Abbildung

ΨA : SLF(V ) → Matn×n (C),

die zu jeder Sesquilinearform h die zugehörige Matrix B = h(A, A) von h bzgl. der Basis

A zuordnet, ist ein linearer Isomorphismus.

(4) Es gibt eine Formel für einen Basiswechsel: seien A, B geordneten Basen von V . Dann

gilt für eine Sesquilinearform h auf V

B

B

h(B, B) = MA

(IdV )† h(A, A)MA

(IdV )

B (Id ) die Basiswechselmatrix für die Identität auf V ist.

wobei MA

V

Bemerkung. Sei V ein C-Vektorraum.

(1) Wenn h eine Hermitesche Form auf V ist, gilt h(v, v) ∈ R für alle v ∈ V , weil h(v, v) =

h(v, v).

(2) Wenn h eine schief-Hermitesche Form auf V ist, gilt h(v, v) ∈ iR für alle v ∈ V .

8Es gilt B † := (B t ) = (B̄)t .

LINEARE ALGEBRA II: LEHRPLAN

23

Definition. Sei V ein C-Vektorraum.

(1) Eine Hermitesche Form h auf einem C-Vektorraum V heißt positiv definit, wenn für alle

v ∈ V mit v 6= 0V gilt h(v, v) > 0. Die Definitionen für positiv semi-definit, negativ

definit und negativ semi-definit sind analog.

(2) Ein Skalarprodukt auf V ist eine positiv definite Hermitesche Form auf V .

(3) Ein unitärer Vektorraum (V, h) ist ein endlichdimensionaler C-Vektorraum V mit einer

Skalarprodukt h auf V .

Beispiel. Die kanonische Hermitesche Form auf Cn

n

X

z k wk

hz, wi :=

k=1

Pn

Pn

ist positiv definit, weil hz, zi := k=1 z k zk = k=1 |zk |2 . Wir nennen h−, −i das Standardskalarprodukt auf Cn . Dann heißt (Cn , h−, −i) der standard unitäre Vektorraum

Definition. Sei (V, h−, −i) ein unitärer Vektorraum.

(1) f ∈ EndC (V ) heißt unitär (bzgl. h−, −i), wenn für alle v, w ∈ V gilt

hf (v), f (w)i = hv, wi.

Wir schreiben U(V ) := {f ∈ EndC (V ) : f ist unitär}.

(2) Eine Matrix A ∈ Matn×n (C) mit A† A = In heißt unitär 9. Wir schreiben U(n) für die

Menge aller unitären n × n-Matrizen.

Bemerkung. Für A ∈ Matn×n (Cn ) definieren wir eine lineare Abbildung FA : Cn → Cn durch

FA (x) = Ax für einen Spaltenvektor x ∈ Cn . Dann gilt für das Standardskalarprodukt h−, −i

auf Cn

hFA (x), FA (y)i = hAx, Ayi = (Ax)† Ay = x† A† Ay.

Insbesondere ist A genau dann unitär, wenn FA unitär bzgl. zu dem Standardskalarprodukt

h−, −i auf Cn ist.

Beispiel. Sei λ ∈ C und V ein unitärer Vektorraum. Dann ist f = λ · IdV genau dann unitär,

wenn |λ| = 1.

Bemerkung. Für einen unitären Vektorraum V und unitäre Endomorphismen f, g ∈ U(V ) gilt

(1) f ◦ g ist unitär.

(2) ker(f ) = {0V } und wegen dimC (V ) < ∞, ist f bijektiv und ferner ist f −1 unitär.

(3) Die Menge U(V ) ist eine Untergruppe von AutC (V ) ⊂ EndC (V ).

(4) Für einen Eigenwert λ ∈ C von f gilt |λ| = 1.

Definition. Die Menge aller unitäre n × n-Matrizen U(n) < GLn (C) heißt die unitäre Gruppe.

Beispiel.

(1) U(1) = {z ∈ C : |z| = 1}.

(2) Für A ∈ U(n) ist | det(A)| = 1. Ferner ist der Homomorphismus det : U(n) → U(1)

surjektiv.

3.3. Normen und Orthogonalität. In dieser Sektion sei K = R oder K = C. Dann gibt es

einen Betrag | − | : K → R≥0 .

Definition. Sei V ein K-Vektorraum. Eine Abbildung || − || : V → R≥0 heißt Norm, wenn die

folgenden Eigenschaften (N1-N3) gelten:

9In diesem Fall ist A invertierbar mit A−1 = A†

[12.06.17]

24

VICTORIA HOSKINS

(N1). Für v ∈ V gilt ||v|| = 0 =⇒ v = 0V ,

(N2). Für v ∈ V und λ ∈ K gilt ||λ · v|| = |λ| ||v||,

(N3.) Für v, v 0 ∈ V gilt die Dreiecksungleichung: ||v + v 0 || ≤ ||v|| + ||v 0 ||.

Bemerkung. Für eine Norm || − || : V → R gilt:

(1) ||0V || = 0 nach dem Axiom (N2).

(2) || − v|| = ||v|| nach dem Axiom (N2).

Satz 3.2. Sei V ein K-Vektorraum

und h−, −i : V × V → R ein Skalarprodukt (mit K = R

p

oder C). Dann ist ||v|| := hv, vi eine Norm auf V . Ferner gelten für v, w ∈ V und λ ∈ K

(a) ||v + w||2 = ||v||2 + ||w||2 + 2Re < v, w >.

(b) (Parallelogrammidentität)

||v + w||2 + ||v − w||2 = 2||v||2 + 2||w||2 .

(c) (Schwarz’sche Ungleichung)

|hv, wi| ≤ ||v|| ||w||

mit Gleichheit genau dann, wenn v und w linear abhängig sind.

(d) | ||v|| − ||w|| | ≤ ||v − w||.

Beispiel. Das Standardskalarprodukt auf Rn

h−, −i : R × Rn → R

P

(x, y) 7→ hx, yi := ni=1 xi yi

liefert die euklidische Standardnorm || − || : Rn → R≥0

v

u n

uX

||x|| = t

x2i .

i=1

Ebenso liefert das Standardskalarprodukt auf

Cn

h−, −i : C × Cn → C

P

(z, w) 7→ hz, wi := nk=1 z¯k wk

die unitäre Standardnorm || − || : Cn → R≥0

v

v

u n

u n

uX

uX

||z|| = t

z¯k zk = t

|zk |2 .

k=1

k=1

Definition. Sei V ein K-Vektorraum. Eine Abbildung d : V × V → R≥0 heißt Metrik (oder

Abstand), wenn die folgenden Eigenschaften (M1-M3) gelten:

(M1). Für v, w ∈ V gilt d(v, w) = 0 ⇐⇒ v = w.

(M2). Symmetrie: Für v, w ∈ V gilt d(v, w) = d(w, v).

(M3.) Dreiecksungleichung: Für u, v, w ∈ V gilt d(u, v) ≤ d(u, w) + d(w, v).

Lemma. Sei || − || eine Norm auf einem K-Vektorraum V . Dann ist d(v, w) := ||v − w|| eine

Metrik auf V .

Definition. Sei h−, −i : V × V → K ein Skalarprodukt auf einem K-Vektorraum V .

(1) Zwei Vektoren v, w ∈ V heißt orthogonal, falls hv, wi = 0. In diesem fall schreiben wir

v ⊥ w.

(2) Zwei Teilmengen A und B heißt orthogonal (schreibweise A ⊥ B), falls a ⊥ b für alle

a ∈ A und b ∈ B.

(3) Eine direkte Summe ⊕nj=1 Ui von Untervektorräume Uj von V ist orthogonal, falls Uj ⊥

Uk für alle j 6= k.

LINEARE ALGEBRA II: LEHRPLAN

(4)

(5)

(6)

(7)

25

Eine Familie (vj )j∈J von Vektoren heißt orthogonal, falls für alle j 6= k gilt vj ⊥ vk .

Eine Familie (vj )j∈J von Vektoren heißt normiert, falls für alle j ∈ J gilt ||vj || = 1.

Eine Familie (vj )j∈J von Vektoren heißt orthonormal, falls hvj , vk i = δjk für alle j, k ∈ J.

Eine Orthonormal-Basis (ON-Basis) von V ist eine Basis von V , deren Vektoren orthonormal zueinander sind.

Bemerkung. Für ein Skalarprodukt h−, −i : V × V → K auf einem K-Vektorraum V gelten

die folgenden Aussagen.

(1) v ⊥ w ⇐⇒ w ⊥ v für v, w ∈ V , weil hv, wi = hw, vi.

(2) Eine Familie ist genau dann orthonormal, wenn sie orthogonal und normiert ist.

(3) Für v 6= 0V ist v/||v|| normiert.

(4) Jede orthogonale Familie

P (vj )j∈I mit vj 6= 0V für alle j ∈ J ist linear unabhängig: aus

einer Gleichung 0V = nk=1 λk vjk mit λk ∈ K folgt für 1 ≤ l ≤ n

0 = hvil , 0V i = hvil ,

n

X

λk vjk i =

k=1

n

X

λk hvil , vjk i = λl ||vjl ||2

k=1

und wegen vjl 6= 0V , folgt λl = 0.

(5) Wenn (vj )j∈J eine orthogonale Familie mit vj 6= 0V für alle j ∈ J ist, dann ist die

Familie (wj )j∈J mit wj := vj /||vj || orthonormal.

Beispiel. Die Standardbasis e1 , . . . , en von K n ist eine ON-Basis (bzgl zum Standardskalarprodukt).

Satz 3.3. Sei h−, −i : V × V → K ein Skalarprodukt auf einem K-Vektorraum V (mit K = R

oder C) und sei v1 , . . . , vn eine ON-Basis von V .

(1) Für alle v ∈ V gilt

n

X

v=

hvk , vi · vk .

k=1

(2) Parseval-Gleichung: für alle v, w ∈ V gilt

hv, wi =

n

X

hvk , vihvk , wi.

k=1

(3) Bessel-Gleichung: für alle v ∈ V gilt

||v||2 =

n

X

|hvk , vi|2 .

k=1

Satz 3.4. Sei f : V → W eine lineare Abbildung zwischen endlichdimensionalen K-Vektorräumen mit Skalarprodukten h−, −iV : V × V → K und h−, −iW : W × W → K. Wenn A =

(v1 , . . . , vn ) und B = (w1 , . . . , wn ) geordnete ON-Basen von V und W sind und A = MBA (f ),

dann gilt

aij = hwi , f (vj )i.

3.4. Gram-Schmidtsche-Orthogonalisierungsverfahren (GSOV). Durch diese Verfahren werden wir zeigen, wie man aus einer gegebenen linear unabhängigen Familie v1 , . . . , vn von

Vektoren aus einem K-Vektorraum mit Skalarprodukt (V, h−, −i) eine ON-Familie w1 , . . . , wn

erhält mit Span(v1 , . . . , vn ) = Span(w1 , . . . , wn ). Das Verfahren an den Beweis von Satz 2.8

anlehnt.

Satz 3.5 (Gram-Schmidt OV). Sei (V, h−, −i) ein K-Vektorraum mit Skalarprodukt. Wenn

v1 , . . . , vn eine lineare unabhängige Familie von Vektoren aus V ist, gibt es eine ON-Familie

w1 , . . . , wn von Vektoren mit

Span(v1 , . . . , vr ) = Span(w1 , . . . , wr )

für 1 ≤ r ≤ n

[14.06.17]

26

VICTORIA HOSKINS

Korollar. Jeder endlichdimensionale K-Vektorraum V mit Skalarprodukt hat eine ON-Basis.

Bemerkung. Sei (V, h−, −i) ein K-Vektorraum mit Skalarprodukt. Wenn (vj )j∈N eine lineare

unabhängige Familie von Vektoren aus V ist, nach dem GSOV und Induktion gibt es eine

ON-Familie (wj )j∈N von Vektoren, so dass für alle n ∈ N gilt

Span(v0 , . . . , vn ) = Span(w0 , . . . , wn ).

Korollar. Sei V ein unitärer Vektorraum und f ∈ EndC (V ). Dann gibt es eine ON Basis A

A (f ) eine obere Dreiecksmatrix ist.

von V so dass MA

Korollar.(Satz von Schur) Sei A ∈ Matn×n (C). Dann gibt es U ∈ U(n) so dass U † AU eine

obere Dreiecksmatrix ist.

3.5. Spektralsätze.

Satz 3.6 (Spektralsatz für Hermitesche Matrizen). Sei A ∈ Matn×n (C) eine Hermitesche Matrix. Dann gilt

(1) Alle Eigenwerte von A sind reelle.

(2) Cn hat eine ON-Basis von Eigenvektoren von A.

(3) Es gibt eine unitäre Matrix U so dass U † AU ist diagonal mit reellen Einträge.

[19.06.17]

Korollar. (Spektralsatz für symmetrische Matrizen) Sei A ∈ Matn×n (R) eine symmetrische

Matrix. Dann gilt

(1) A hat n reelle Eigenwerte (wenn man mit Vielfach rechnen).

(2) Rn hat eine ON-Basis von Eigenvektoren von A.

(3) Es gibt eine orthogonale Matrix P so dass P t AP ist diagonal.

Satz 3.7 (Spektralsatz für unitäre Matrizen). Sei A ∈ Matn×n (C) eine unitäre Matrix. Dann

gilt

(1) Alle Eigenwerte von A haben Betrag 1.

(2) Cn hat eine ON-Basis von Eigenvektoren von A.

(3) Es gibt eine unitäre Matrix U so dass U † AU ist diagonal mit Einträge vom Betrag 1.

3.6. Orthogonale Projektion.

Satz 3.8. Sei (V, h−, −i) ein K-Vektorraum mit Skalarprodukt, v ∈ V und U ⊂ V ein Untervektorraum (mit K = R oder K = C). Für u ∈ U ist äquivalent:

(1) v − u ∈ U ⊥

(2) d(v, U ) := min{d(v, u0 ) : u0 ∈ U } = d(v, u).

Ferner gibt es ein u ∈ U mit (1) und (2) genau dann, wenn v ∈ U + U ⊥ . In diesem Fall ist u

eindeutig.

Definition. Sei (V, h−, −i) ein K-Vektorraum mit Skalarprodukt, v ∈ V und U ⊂ V ein Untervektorraum. Die lineare Abbilung πU : U ⊕ U ⊥ → U mit πU (u + u0 ) := u heißt die orthogonale

Projektion.

Korollar. Sei (V, h−, −i) ein K-Vektorraum mit Skalarprodukt und U ⊂ V ein Untervektorraum. Die orthogonale Projektion πU : U ⊕ U ⊥ → U erfüllt für alle v ∈ U ⊕ U ⊥

(1) πU (v) ist gleich dem Element u ∈ U mit minimalem Abstand zu v, d.h.

d(v, u) ≤ d(v, u0 )

für alle u0 ∈ U.

(2) ||πU (v)|| ≤ ||v|| mit Gleichheit genau dann, wenn v ∈ U (d.h. πU (v) = v).

Bemerkung. Sei (V, h−, −i) ein endlichdimensionaler K-Vektorraum mit Skalarprodukt und

U ⊂ V ein Untervektorraum.

(1) Es gilt V = U + U ⊥ = U ⊕ U ⊥ . Daher ist die orthogonale Projektion auf U eine

Abbildung πU : V → U .

LINEARE ALGEBRA II: LEHRPLAN

27

(2) Es gilt U = (U ⊥ )⊥ .

P

(3) Wenn u1 , . . . , un eine ON-Basis von U ist, gilt πU (v) = nj=1 huj , vi · uj für alle v ∈ V .

3.7. Adjungierte Abbildungen. In diesem Abschnitt sei K = R oder C und wir betrachen

endlichdimensionale K-Vektorräume mit Skalarprodukten.

Lemma (von Riesz). Sei V ein endlichdimensionaler K-Vektorraum mit Skalarprodukt h−, −i.

Für f ∈ V ∗ := HomK (V, K) gibt es einen eindeutig bestimmten Vektor v ∈ V mit f (−) = h−, vi

als Elemente von V ∗ .

Satz 3.9. Seien (V, h−, −iV ) und (W, h−, −iW ) endlichdimensionale K-Vektorräume mit Skalarprodukten. Für f ∈ HomK (V, W ) gibt es eine eindeutige lineare Abbildung f ad ∈ HomK (W, V )

mit

hf (v), wiW = hv, f ad (w)iV

für alle v ∈ V, w ∈ W.

ad

Wir nennen f die zu f adjungierte Abbildung. Wenn A = (v1 , . . . , vn ) eine ON-Basis von V

ist, dann gilt für alle w ∈ W

n

X

ad

(3)

f (w) =

hf (vj ), wiW · vj .

j=1

Wenn zusätzlich B = (w1 , . . . , wm ) eine ON-Basis von W ist, dann gilt

B ad

MA

(f ) = MBA (f )† .

Korollar. Für f : V → W eine lineare Abbildung zwischen endlichdimensionalen K-Vektorräum- [21.06.17]

en und die adjungierte Abbildung f ad : W → V gilt auch

hw, f (v)iW = hf ad (w), viV

für alle v ∈ V, w ∈ W

Korollar. Sei V ein endlichdimensionaler K-Vektorraum mit Skalarprodukt h−, −i. Für f ∈

EndK (V ) ist äquivalent

(1) f ist orthogonal falls K = R (bzw. f ist unitär falls K = C),

(2) f ist invertierbar mit f −1 = f ad .

Bemerkung. Seien (U, h−, −iU ), (V, h−, −iV ) und (W, h−, −iW ) drei endlichdimensionale KVektorräume mit Skalarprodukten. Für f, fi ∈ HomK (U, V ) und g ∈ HomK (V, W ) und λi ∈ K

gelten:

(1) (λ1 · f1 + λ2 · f2 )ad = λ1 f1ad + λ2 f2ad ,

(2) (g ◦ f )ad = f ad ◦ g ad ,

(3) (IdV )ad = IdV ,

(4) (f ad )ad = f .

Satz 3.10. Seien (V, h−, −iV ) und (W, h−, −iW ) endlichdimensionale K-Vektorräume mit Skalarprodukten. Für f ∈ HomK (V, W ) gilt

(1) ker(f ) = Bild(f ad )⊥

(2) ker(f ad ) = Bild(f )⊥

Korollar. Seien (V, h−, −iV ) und (W, h−, −iW ) endlichdimensionale K-Vektorräume mit Skalarprodukten. Für f ∈ HomK (V, W ) gilt

(1) f ist genau dann injektiv, wenn f ad surjektiv ist.

(2) f ist genau dann surjektiv, wenn f ad injektiv ist.

(3) f ist genau dann bijektiv, wenn f ad bijektiv ist.

28

VICTORIA HOSKINS

Definition. Sei V ein endlichdimensionaler K-Vektorraum mit Skalarprodukt und f ∈ EndK (V ).

(1) f heißt selbstadjungiert, falls f = f ad .

(2) f heißt antiselbstadjungiert, falls f = −f ad .

(3) f heißt normal, falls f ◦ f ad = f ad ◦ f .

A (f ) gilt

Bemerkung. Wenn A eine ON-Basis von V ist und A = MA

(1) f ist selbstadjungiert ⇐⇒ A† = A

(2) f ist antiselbstadjungiert ⇐⇒ A† = −A.

(3) f ist normal ⇐⇒ AA† = A† A.

Beispiel. Für einen Untervektorraum U eines endlichdimensionalen K-Vektorraumes V (mit

Skalarprodukt) ist die orthogonale Projektion πU : V → U selbstadjungiert: Sei (v1 , . . . , vr ) eine

ON-Basis von U , dann können wir diese ON-Basis auf einer ON-Basis A = (v1 , . . . , vn ) von V

erweitern, so dass

Ir 0

A

MA (πU ) =

.

0 0

Satz 3.11. Sei V ein endlichdimensionaler K-Vektorraum mit Skalarprodukt h−, −i und f ∈

EndK (V ) normal. Dann gilt für jede λ ∈ K

Eig(f, λ) = Eig(f ad , λ))

und Eigenvektoren zu verschiedenen Eigenwerten sind orthogonal aufeinander. Insbesondere gilt

ker(f ) = Eig(f, 0) = ker(f ad ) = Bild(f ad )⊥ = Bild(f )⊥ .

Satz 3.12 (Spektralsatz für normale Abbildungen). Sei V ein endlichdimensionaler K-Vektorraum

mit Skalarprodukt h−, −i und f ∈ EndK (V ). Dann ist äquivalent

(1) f ist normal und das charakteristische Polynom χf (t) zerfällt vollständig in Linearfaktoren,

(2) V ist die orthogonale Summe der Eigenräume von f ,

(3) Es existiert eine ON-Basis von V aus Eigenvektoren von f .

[26.06.17]

Korollar. Eine Matrix A ∈ Matn×n (C) ist genau dann normal (d.h. A† A = AA† ), wenn es gibt

eine unitäre Matrix U ∈ U(n) mit U † AU diagonal.

3.8. Anwendung in der Geometrie: Affine reelle Quadriken. Sei K ein Körper mit

Char(K) 6= 2. Bald werden wir annehmen, dass K = R.

Definition. Ein quadratisches Polynom in n Unbestimmten x = (x1 , · · · , xn ) über K ist ein

Ausdruck der Form

n

X

X

bj xj + c

Q(x1 , . . . , xn ) =

ajk xj xk +

j=1

j≤k

mit ajk , bj und c ∈ K. Die affine Quadrik Z(Q) ⊂

K n,

die durch Q definiert wird, ist die Menge

Z(Q) = {x ∈ K n : Q(x) = 0} ⊂ K n .

Im Fall n = 2 nennt man eine affine Quadrik Z(Q) ⊂ K 2 auch einen Kegelschnitt.

Beispiel. Sei K = R und n = 2. Dann sind die folgende Beispiele Kugelschnitte (d.h. die

entsprechende affine Quadriken kann als Durchschnitt eines Kugels in R3 mit einer (affinen)

Ebene E ∼

= R2 beschreiben werden):

(1) Q(x, y) = x2 + y 2 − 1 mit Z(Q) ⊂ R2 ein Kreis.

(2) Q(x, y) = x2 + 2y 2 − 1 mit Z(Q) ⊂ R2 eine Ellipse.

(3) Q(x, y) = x2 − y mit Z(Q) ⊂ R2 eine Parabel.

(4) Q(x, y) = xy − 1 mit Z(Q) ⊂ R2 eine Hyperbel.

LINEARE ALGEBRA II: LEHRPLAN

29

(5) Q(x, y) = x2 + y 2 + 1 mit Z(Q) = ∅ ⊂ R2 die leere Menge.

Bemerkung. Wir können ein quadratisches Polynom

n

X

X

Q(x1 , . . . , xn ) =

ajk xj xk +

bj xj + c

j=1

j≤k

xt Ax

schreiben als Q(x) =

a11 a212 · · ·

.

a12

2 a22 . .

A := .

..

..

..

.

.

an1

·

·

·

·

·

·

2

+

bt x

a1n

2

..

.

..

.

ann

+ c mit

Sym

∈ Matn×n (K),

b=

b1

b2

..

.

, x =

bn

x1

x2

..

.

∈ Matn×1 (K).

xn

Man kann Q durch eine einzige Matrix à drücken: Q(x1 , . . . , xn ) = x̃t Ãx̃ mit

1

x1

c bt /2

à :=

∈ MatSym

(K)

und

x̃

:=

.. ∈ Mat(n+1)×1 (K).

(n+1)×(n+1)

b/2 A

.

xn

Definition. Seien Q und Q0 zwei quadratische Polynome in n Unbestimmten x1 , · · · , xn über

K = R. Dann heißen Q und Q0

(1) affin (algebraisch) äquivalent, wenn es S ∈ GLn (R) und v ∈ Rn gibt mit Q0 (x) =

Q(Sx + v).

(2) kartesisch (algebraisch) äquivalent, wenn es S ∈ O(n) und v ∈ Rn gibt mit Q0 (x) =

Q(Sx + v).

Beispiel. Für n = 2 betrachten wir Q(x1 , x2 ) = x21 + 4x22 + 2x1 − 8x2 + 1. Wir können diese

Polynom schreiben als

Q(x1 , x2 ) = (x1 + 1)2 + 4(x2 − 1)2 − 4.

Durch die Translation

x1

y1

x1 + 1

1

7→

:=

= I2 x +

x2

y2

x2 − 1

−1

wird Z(Q) zur Ellipse Z(Q0 ) = {y ∈ R2 : y12 + 4y22 = 4}. Deshalb sind Q(x) und Q0 (x) :=

x21 + 4x22 − 4 zueinander kartesisch äquivalent.

Satz 3.13 (Normalformen für reelle Quadriken). Sei Q(x) = xt Ax + bt x + c ein quadratisches

Polynom in x = (x1 , . . . , xn )t mit A ∈ MatSym

n×n (R), b ∈ Matn×1 (R) und c ∈ R. Dann ist Q zu

einer der folgenden Normalformen kartesisch äquivalent:

Typ 1. P (x) = d1 x21 + · · · dr x2r ,

Typ 2. P (x) = d1 x21 + · · · dr x2r + e mit e 6= 0,

Typ 3. P (x) = d1 x21 + · · · dr x2r + exr+1 mit e > 0.

Jeweils mit 0 ≤ r ≤ n und di 6= 0. Dabei ist r = Rang(A) und d1 , . . . , dr sind die nicht-Null

Eigenwerte von A (mit Vielfach). Ferner gilt

(1) Zwei Normalformen sind genau dann äquivalent, wenn sie zum selben Typ (d.h. Typ

1,2,3) gehören, die Zahlen d1 , . . . , dr bis auf Permutation die-selben sind und die Zahlen

e übereinstimmen.

(2) Wenn man Q als Q(x) = x̃t Ãx̃ schreiben mit x̃t = (1, x1 , . . . , xn ), dann gilt

Q hat Typ j ⇐⇒ Rang(Ã) − Rang(A) = j − 1.

30

VICTORIA HOSKINS

Bemerkung.

a) Eine orthogonale Matrix S ∈ O(n) definiert eine Abbildung FS : Rn → Rn mit FS (x) =

Sx, so dass hFS (x), FS (y)i = hx, yi für alle x, y ∈ Rn . Insbesdondere erhält FS Distanzen:

p

d(FS (x), FS (y)) = ||FS (x) − FS (y)|| = ||FS (x − y)|| = hFS (x − y), FS (x − y)i

p

= hx − y, x − yi = d(x, y).

Eine Translation T : Rn → Rn (d.h. eine Abbildung der Form x 7→ x + v für einen

festen Vektor v ∈ Rn ) erhält Distanzen auch. Eine Koordinatentransformation der Form

x 7→ Sx + v mit S ∈ O(n) und v ∈ Rn erhält Distanzen. Wenn Q und Q0 kartesische

äquivalent quadratische Polynome sind, dann gibt es eine Koordinatentransformation der

Form x 7→ Sx + v mit S ∈ O(n) und v ∈ Rn , die die Quadrik Z(Q) zu der Quadrik Z(Q0 )

nimmt. Eine Abbildung Rn → Rn , die Distanzen erhält, heißt Isometrie.10

b) Es gibt 4 Schritte, um ein quadratisches Polynom in Normalform zu schreiben:

Schritt 1: orthogonale Diagonalisierung.

Schritt 2: quadratische Ergäzung.

Schritt 3: lineare Terme kombinieren.

Schritt 4: Translation.

Die Koordinatentransformationen in den Schritte 1 und 3 sind orthogonale Transformationen und die Koordinatentransformationen in den Schritte 2 und 4 sind Translationen.

Beispiel. Für

Q(x1 , x2 ) = 5x21 + 5x22 + 8x1 x2 − 1.

wollen wir eine Normalform finden. Der erste Schritt ist die orthogonale Diagonalisierung der

symmetrischen Matrix

5 4

A :=

,

4 5

d.h. wir müssen eine orthonormale Basis von R2 von Eigenvektoren von A finden (eine solche

Basis existiert nach dem Spektralsatz für symmetrische Matrizen). Es gilt χA (t) = t2 −10t+9 =

(t − 1)(t − 9) und deshalb sind 1 und 9 die Eigenwerte von A mit Eigenräume

1

1

Eig(A, 1) = Span

und Eig(A, 9) = Span

.

−1

1

Deshalb ist

(

A :=

v1 :=

√1

2

−1

√

2