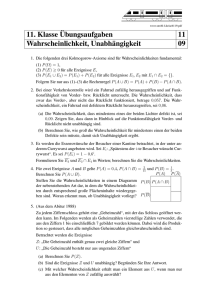

Höchstens 10% defekt Es wird

Werbung

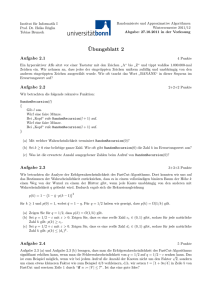

Lösungsvorschläge zu Blatt 3

20) Die gelieferte Packung enthalte 100 Stück.

Lieferbedingungen: Höchstens 10% defekt

Es wird zufällige Stichprobe o.Z. von 10 Stück gezogen.

Bevor die Stichprobe gezogen und ausgewertet wird, ist

X:= Anzahl der defekten Stücke in der Stichprobe

eine hypergeometrisch verteilte Zufallsvariable mit den Parametern

N = Anzahl der Stücke in der Packung = 100,

M = Anzahl der defekten Stücke in der Packung,

n = Anzahl der Ziehungen (o.Z.) = 10.

Damit gilt:

P (X = m) =

M

m

N −M

n−m

N

n

=

M

m

100−M

10−m

100

10

Die Packung wird zurückgewiesen, wenn mindestens ein Stück in der Stichprobe

defekt ist. Die Wahrscheinlichkeit dafür ist:

P (X > 1) = 1 − P (X = 0)

a) Für M = 10 erhalten wir für die Wahrscheinlichkeit für die irrtümliche Zurückweisung einer Packung:

10 90

10

0

P (X > 1) = 1 − 100

10

1 · 90 · 89 · . . . · 81 · 10!

90 · 89 · . . . · 81

= 1−

= 0.670

10! · 100 · 99 · . . . · 91

100 · 99 · . . . · 91

b) M ist jetzt nicht mehr bekannt, aber wir wissen, dass M 6 10 (statt M = 10)

gilt, da die Lieferbedingungen erfüllt sind. Eine Zurückweisung bei weniger als 10

defekten Stücken in der Packung ist höchstens genauso wahrscheinlich wie eine

Zurückweisung bei genau 10 defekten Stücken. Da aber M 6 10 u.a. den Fall

M = 10 einschließt, müssen wir von einer Wahrscheinlichkeit von 0.670 für eine

irrtümliche Ablehnung der Packung ausgehen.

= 1−

Die Aufgabe 20 b) ist damit gelöst. Wir wollen aber trotzdem die Wahrscheinlichkeit für eine irrtümliche Ablehnung der Packung direkt abschätzen. Dazu

verwenden wir die Abschätzung

n2

n1

für m ≤ n1 ≤ n2 ,

≤

m

m

1

die sich aus der Ungleichungskette

n1 · (n1 − 1) · · · (n1 − m + 1)

n1

n2 · (n1 − 1) · · · (n1 − m + 1)

=

≤

m

m!

m!

n2 · (n2 − 1) · (n1 − 2) · · · (n1 − m + 1)

≤

≤ ...

m!

n2 · (n2 − 1) · (n2 − 2) · · · (n2 − m + 1) · (n1 − m + 1)

≤

m!

n2 · (n2 − 1) · · · (n2 − m + 1)

n2

≤

=

m

m!

ergibt, wobei die Positivität aller Faktoren in den Zählern zu beachten ist. Da

nun 100 − M ≥ 100 − 10 ≥ 10 ist erhalten wir daraus:

100 − M M

100 − M 1·

10

0

10

P (X > 1)|M ≤10 = 1 −

= 1−

100

100

10

10

M ≤10

M ≤10

100 − M 1·

a)

10

= P (X > 1)|M =10 = 0.670.

≤ 1−

100

10

M =10

21)

N, n vergl. Aufgabe 20)

Wir haben jetzt 11 defekte Stücke in der Packung, die Lieferbedingungen sind

also verletzt.

Die Wahrscheinlichkeit für die irrtünliche Annahme der Packung

11 89

89 · 88 · . . . · 80

10!

10

0

P (X = 0) = =

·

= 0.294

100

10!

100 · 99 · . . . · 91

10

ist also ziemlich groß.

Da also sowohl eine irrtümliche Ablehnung als auch eine irrtümliche Annahme

der Packung noch sehr wahrscheinlich sind, ist die Stichprobe zu klein.

22) Die gelieferte Packung enthalte 10000 Stück, 100 davon sind defekt

Zufällige Stichprobe von 250 (o.Z.)

Bevor die Stichprobe gezogen und ausgewertet wird, ist

X:= Anzahl der defekten Stücke in der Stichprobe

eine hypergeometrisch verteilte Zufallsvariable mit den Parametern

2

N = Anzahl der Stücke in der Lieferung = 10000,

M = Anzahl der defekten Stücke in der Lieferung = 100,

n = Anzahl der Ziehungen (o.Z.) = 250.

Damit gilt:

9900

100

250 − m

m

P (X = m) =

10000

250

Die Näherung durch die Binomialverteilung ist gut genug, da N = 10000 > 1000

und n/N = 0.025 6 0.1.

Damit gilt also

M

n m

p (1 − p)n−m

n = 250, p =

P (X = m) ≈

= 0.01

m

N

Die Näherung durch die Poisson-Verteilung gut genug, da n = 250 > 50 und

λ := n · p = 2.5 6 5.

Damit gilt also

2.5m

P (X = m) ≈ e−2.5

m!

a)

2.5 2.52

2.5 2.52

−2.5

−2.5

1+

=e

= 0.544

+

+

1+

P (X 6 2) ≈ e

1!

2!

1

2

p

b) Wir suchen die Wahrscheinlichkeit P |X − E(X)| 6 V (X) .

Dazu müssen wir zunächst den Erwartungswert und die Varianz berechnen. Wir

könnten auch dazu die Näherung durch die Poisson–Verteilung verwenden, aber

die Berechnung über die hypergeometrische Verteilung selbst ist kaum aufwändiger und bei diskreten Verteilungen wirken sich kleine Ungenauigkeiten in Intervallgrenzen stärker aus als bei stetigen Verteilungen. Aus den Formeln in Satz

7.6.9 erhalten wir sofort:

E(X) = 250 ·

100

= 2.5(= λ),

10000

V (X) = 2.5 ·

9900 9750

·

= 2.413(≈ λ),

10000 9999

√

σ = 2.413 = 1.554.

Für die gesuchte Wahrscheinlichkeit erhalten wir also:

P (|X − 2.5| 6 1.554) = P (2.5 − 1.554 6 X 6 2.5 + 1.554)

= P (0.946 6 X 6 4.054) = P (X = 1) + . . . + P (X = 4)

1

2.52 2.53 2.54

2.5

−2.5

+

+

+

≈ e

1!

2!

3!

4!

1

2

3

2.5

2.5

2.54

2.5

−2.5

= 0.809

+

+

+

= e

1

2

6

24

3

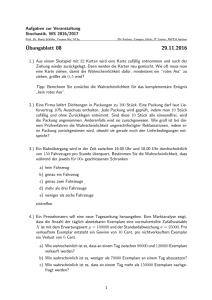

23) Randverteilungen

↓ X| Y → −1

−1

0

1

0

2

0.5

0.5

1

5

0 0.1

0.4 0

0

0

0.4 0.1

0.1

0.4

0.5

1.0

Beispiele:

P (X = 1 ∧ Y = 1) = 0.4

P (X = 1) = 0.4

P (Y = 5) = 0.1

Erwartungswerte und Varianzen:

E(X) = (−1) · 0.1 + 1 · 0.4 + 2 · 0.5 = 1.3

E(X 2 ) = (−1)2 · 0.1 + 12 · 0.4 + 22 · 0.5 = 2.5

V (X) = 2.5 − 1.32 = 0.81

E(Y ) = (−1) · 0.5 + 1 · 0.4 + 5 · 0.1 = 0.4

E(Y 2 ) = (−1)2 · 0.5 + 12 · 0.4 + 52 · 0.1 = 3.4

V (Y ) = 3.4 − 0.42 = 3.24

Die Lösung dieser Aufgabe ist damit abgeschlossen. Zur Vorbereitung der Lösung

von Aufgabe 28 sind noch einige Berechnungen durchzuführen. Zunächst bestimmen wir E(X · Y ). Dies ist die Summe aller Produkte aus den möglichen Werten

von X und Y und den zugehörigen Wahrscheinlichkeiten. Die Produkte, bei denen

mindestens ein Faktor = 0 ist, sind gleich weggelassen worden:

E(X · Y ) = 2 · (−1) · 0.5 + 1 · 1 · 0.4 + (−1) · 5 · 0.1 = −1.1

Cov(X, Y ) := E(X · Y ) − E(X) · E(Y ) = −1.1 − 1.3 · 0.4 = −1.62

σ(X) = 0.9,

σ(Y ) = 1.8

24) a)

Sind X und Y aus 23) unabhängig? Da X und Y diskrete ZV sind, ist dies

gleichbedeutend mit pi,j = pi,∗ · p∗,j für alle i, j. Da schon

P (X = −1 ∧ Y = −1) = 0 6= P (X = −1) · P (Y = −1) = 0.1 · 0.5 ist, sind X

und Y nicht unabhängig.

b)

↓ X| Y →

0

1

2

0

0.18 0.30 0.12

1

0.12 0.20 0.08

0.30 0.50 0.20

4

0.60

0.40

1.00

Wir prüfen, ob jedes Produkt von Randverteilungswahrscheinlichkeiten gleich der

zugehörigen Wahrscheinlichkeit der gemeinsamen Verteilung ist:

0.30 · 0.60 = 0.18, 0.50 · 0.60 = 0.30, 0.20 · 0.60 = 0.12, 0.30 · 0.40 = 0.12,

0.50 · 0.40 = 0.20, 0.20 · 0.40 = 0.08.

Es gilt also tatsächlich pi,j = pi,∗ ·p∗,j für alle i, j. Damit sind X und Y unabhängig.

25) Bei dieser Aufgabe sind die Wahrscheinlichkeiten P (X = xi ), P (Y = yj )

vorgegeben, also die Wahrscheinlichkeiten der Randverteilung. Wegen der Unabhängigkeit der ZV kann man daraus leicht die Wahrscheinlichkeiten der gemeinsamen Verteilung ermitteln:

pi,j := P (X = xi ∧ Y = yj ) = P (X = xi ) · P (Y = yj ) für alle i, j.

Ausrechnungsbeispiel: P (X = 1.5 ∧ Y = 2.5) = 0.5 · 0.1 = 0.05

↓ X| Y →

0

1.5

2

3

1

0.03

0.15

0.06

0.06

0.3

2

0.04

0.20

0.08

0.08

0.4

2.5

0.01

0.05

0.02

0.02

0.1

4

0.01

0.05

0.02

0.02

0.1

5

0.01

0.05

0.02

0.02

0.1

0.1

0.5

0.2

0.2

1.0

26)

Es sei Xi =

1 mit Wahrscheinlichkeit p,

(Erfolg)

0 mit Wahrscheinlichkeit q := 1 − p,

(Fehlschlag)

Sn := X1 + X2 + . . . + Xn

a) Nach Satz 7.8.4 a) gilt:

E(Sn ) = E(X1 ) + E(X2) + . . . + E(Xn ) = np.

| {z } | {z }

| {z }

=p

=p

=p

Aus der Unabhängigkeit der ZV X1 , X2 , . . . , Xn folgt nach Satz 7.8.4 b)

V (Sn ) = V (X1 ) + V (X2 ) + . . . + V (Xn ) = npq

| {z }

| {z } | {z }

=pq

=pq

=pq

b) Bei der Bestimmung der Verteilung von Sn verwenden wir, dass

Xi einem Zufallsexperiment mit 2 Ausgängen (Erfolg oder Fehlschlag) entspricht.

Sn := X1 + X2 + . . . + Xn ist also die Anzahl der Erfolge bei n Versuchen.

Erläuterung:

3 Beispiele für Realisierungen von X1 , . . . , Xn :

1. Beispiel: x1 = . . . = xn = 1 : sn = n · 1 = n

2. Beispiel: x1 = . . . = xn = 0 : sn = n · 0 = 0

3. Beispiel: x1 = x3 = 1, übrige xi = 0 : sn = 1 + 0 + 1 + 0 + . . . + 0 = 2

5

Nach den Erläuterungen bei der Einführung der Binomialverteilung ist Sn damit

binomialverteilt mit der Parametern p und n.

Die Aufgabe ist damit gelöst. Um aber insbesondere die (bisher nur erläuterte

aber nicht bewiesene) Formel für den Binomialkoeffizienten herzuleiten, beweisen wir für die Darstellung der Wahrscheinlichkeitsverteilung mit vollständiger

Induktion:

Behauptung:

n k n−k

p q

für alle k = 0, 1, . . . , n

P (Sn = k) =

k

(1)

gilt für alle n ∈ N

Beweis durch Induktion:

Induktionsanfang: (1) gilt für n = 1:

P (S1 = k) = P (X1 = k) =

Induktionsschluss:

Fall 1: 1 6 k 6 n

q=

p=

1

0

1

1

· p0 q 1−0

· p1 q 1−1

für k = 0

für k = 1

n l n−l

pq

für alle l = 0, 1, . . . , n

P (Sn = l) =

l

⇒ P (Sn+1 = k)

=

Unahängigkeit

=

(2)

=

=

=

Fall 2: k = 0

(2)

P (Sn = k ∧ Xn+1 = 0) ∨ (Sn = k − 1 ∧ Xn+1 = 1)

P (Sn = k) · P (Xn+1 = 0) + P (Sn = k − 1) · P (Xn+1 = 1)

n

n k n−k

pk−1 q n−k+1 · p

p q

·q+

k−1

k

n

n k n−k+1

pk q n−k+1

p q

+

k−1

k

n + 1 k n+1−k

n

n

k n+1−k

p q

p q

=

+

k

k−1

k

n 0 n−0

pq

P (Sn = 0) =

0

(3)

Unahängigkeit

⇒ P (Sn+1 = 0) = P Sn = 0 ∧ Xn+1 = 0

=

P (Sn = 0) · P (Xn+1 = 0)

n + 1 0 n+1−0

n 0 n−0

(3)

pq

pq

·q =

=

0

0

6

Fall 3: k = n + 1

n n n−n

p q

P (Sn = n) =

n

(4)

Unahängigkeit

⇒ P (Sn+1 = n + 1) = P Sn = n ∧ Xn+1 = 1

=

P (Sn = n) · P (Xn+1 = 1)

n + 1 n+1 (n+1)−(n+1)

n n n−n

(4)

p q

p q

·p=

=

n+1

n

27) Wir nutzen, dass die Summe der Wahrscheinlichkeiten der gemeinsamen Verteilung gleich der passenden Wahrscheinlichkeit der Randverteilungen ist und

dass die Summe der Randverteilungen zu Y gleich 1 ist.

1. Rechengang:

↓ X| Y →

−1

0

2

3

4

6

0 1/8 2/8

∗

0

∗

∗

0 1/8

2/8 1/8 5/8

3/8

∗

∗

1

↓ X| Y →

−1

0

2

3

4

6

0 1/8 2/8

∗

0 2/8

∗

0 1/8

2/8 1/8 5/8

3/8

∗

∗

1

2. Rechengang:

Jetzt brauchen wir die zusätzliche Angabe über den Erwartungswert:

3

6

3

3 !

= E(X) = (−1) · + 2 · P (X = 2) ⇒ 2 · P (X = 2) = ⇒ P (X = 2) =

8

8

8

8

4. Rechengang:

↓ X| Y → 3

4

6

−1

0 1/8 2/8

0

∗

0 2/8

2

2/8 0 1/8

2/8 1/8 5/8

3/8

∗

3/8

1

↓ X| Y → 3

4

6

−1

0 1/8 2/8

0

0

0 2/8

2

2/8 0 1/8

2/8 1/8 5/8

3/8

2/8

3/8

1

5. Rechengang:

7

28)

a)

Cov(X, Y ) = 0

Jede der ZV X, Y nimmt mehr als einen Wert mit

Wahrscheinlichkeit > 0 an ⇒ V (X), V (Y ) > 0

Die ZVX,Yin Aufg. 25 sind unabhängig

⇒

Satz 7.8.3

⇒

ρ(X, Y ) = 0, d.h. X und Y sind unkorreliert.

In Aufg. 23 wurden bereits folgende Werte ermittelt: Cov(X, Y ) = −1.62,

σ(X) = 0.9, σ(Y ) = 1.8. Damit erhalten wir:

−1.62

Cov(X, Y )

=

= −1

σ(X) · σ(Y )

0.9 · 1.8

Es besteht also ein extremer linearer Zusammenhang zwischen X un Y und

damit gilt Y = a + bX für geeignete Zahlen a ∈ R, b < 0 (f.s.). Um die

Werte für a und b zu bestimmen, setzen wir mögliche Werte für die ZV X

und Y ein und betrachten dabei nur Kombinationen mit Wahrscheinlichkeit

> 0 nach der in Aufgabe 23 vorgegebenen Tabelle:

↓ X Y → −1 1

5

ρ(X, Y ) :=

−1

1

2

0

0 0.1

0 0.4 0

0.5 0

0

Die möglichen Wertekombinationen notieren wir in Tabellenform:

Y = a + bX

X Y

-1 5 5 = a + (−1) · b

1 1

1=a+1·b

Die Addition der beiden Gleichungen liefert 2a = 6, d.h. a = 3.

b = a − 5 = 3 − 5 = −2

Kontrolle (die aber nicht durchgeführt zu werden braucht): X = 2, Y = −1:

−1 = 3 + (−2) · 2

Bem.: Wenn hier (−2) statt (−1) ein möglicher Wert für Y wäre, so würde

man keinen extremen linearen Zusammenhang erhalten; denn für X = 2,

Y = −1 müsste −2 = 3+(−2)·2 gelten, was aber offensichtlich nicht richtig

ist. Es würde dann aber auch |ρ(X, Y )| < 1 herauskommen.

b) (i )

↓ X Y →

0

1

2

0

0.08

0.07

0.20

0.35

8

1

0.08

0.10

0.15

0.33

2

0.09

0.08

0.15

0.32

0.25

0.25

0.50

1.00

E(X) = 1 · 0.25 + 2 · 0.50 = 1.25

E(Y ) = 1 · 0.33 + 2 · 0.32 = 0.97

2

2

2

E(X ) = 1 · 0.25 + 2 · 0.50 = 2.25 E(Y 2 ) = 12 · 0.33 + 22 · 0.32 = 1.61

V (X) = 2.25 − 1.252 = 0.6875

V (Y ) = 1.61 − 0.972 = 0.6691

Cov(X, Y ) := E(X · Y ) − E(X) · E(Y )

= (1 · 1 · 0.10 + 1 · 2 · 0.08 · +2 · 1 · 0.15 + 2 · 2 · 0.15) − 1.25 · 0.97

= −0.0525,

ρ(X, Y ) = √

−0.0525

= −0.0774.

0.6875 · 0.6691

X und Y sind also schwach negativ korreliert.

(ii )

↓ X Y →

0

1

2

0

1

2

0.01 0 0.39

0 0.30 0

0.28 0.02 0

0.29 0.32 0.39

0.40

0.30

0.30

1.00

E(X) = 1 · 0.30 + 2 · 0.30 = 0.90

E(Y ) = 1 · 0.32 + 2 · 0.39 = 1.10

E(X 2 ) = 12 · 0.30 + 22 · 0.30 = 1.50 E(Y 2 ) = 12 · 0.32 + 22 · 0.39 = 1.88

V (X) = 1.50 − 0.902 = 0.6900

V (Y ) = 1.88 − 1.102 = 0.6700

Cov(X, Y ) = (1 · 1 · 0.30 + 2 · 1 · 0.02) − 0.90 · 1.10 = −0.6500,

ρ(X, Y ) = √

−0.6500

= −0.9560.

0.6900 · 0.6700

X und Y sind also stark negativ korreliert.

29) Aus der Verteilung für X und aus der Beziehung Y = X 2 erhalten wir sofort

folgende Einträge für die gemeinsame Verteilung und die Randverteilungen:

↓ X| Y → 1 4

−2

0 *

−1

* 0

1

* 0

2

0 *

* *

1/4

1/4

1/4

1/4

Daraus ergeben sich nach Satz 7.7.1 b) (Summe der Einträge der gemeinsamen

Verteilung in einer Zeile = Eintrag der Randverteilung in dieser Zeile, Summe

9

der Einträge der gemeinsamen Verteilung in einer Spalte = Eintrag der Randverteilung in dieser Spalte) sofort die übrigen Einträge der gemeinsamen Verteilung

und der Randverteilungen:

↓ X| Y → 1

4

−2

0 1/4

−1

1/4 0

1

1/4 0

2

0 1/4

1/2 1/2

1/4

1/4

1/4

1/4

X, Y sind nicht unabhängig aus zwei Gründen:

1.) Y ist sogar Funktion von X und V (X), V (Y ) > 0.

2.) P (X = −2 ∧ Y = 1) = 0 6= 18 = P (X = −2) · P (Y = 1) (zum Beispiel)

1

E(X) = · (−2 − 1 + 1 + 2) = 0

4

⇒ Cov(X, Y ) = E(X·Y )−E(X)E(Y ) = 0

1

E(X · Y ) = E(X 3 ) = · (−8 − 1 + 1 + 8) = 0

4

Ergebnis: X und Y sind unkorreliert, aber nicht unabhängig.

10