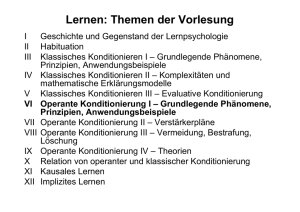

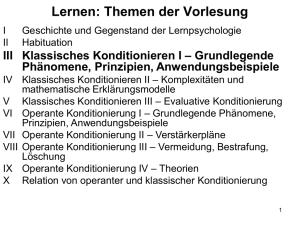

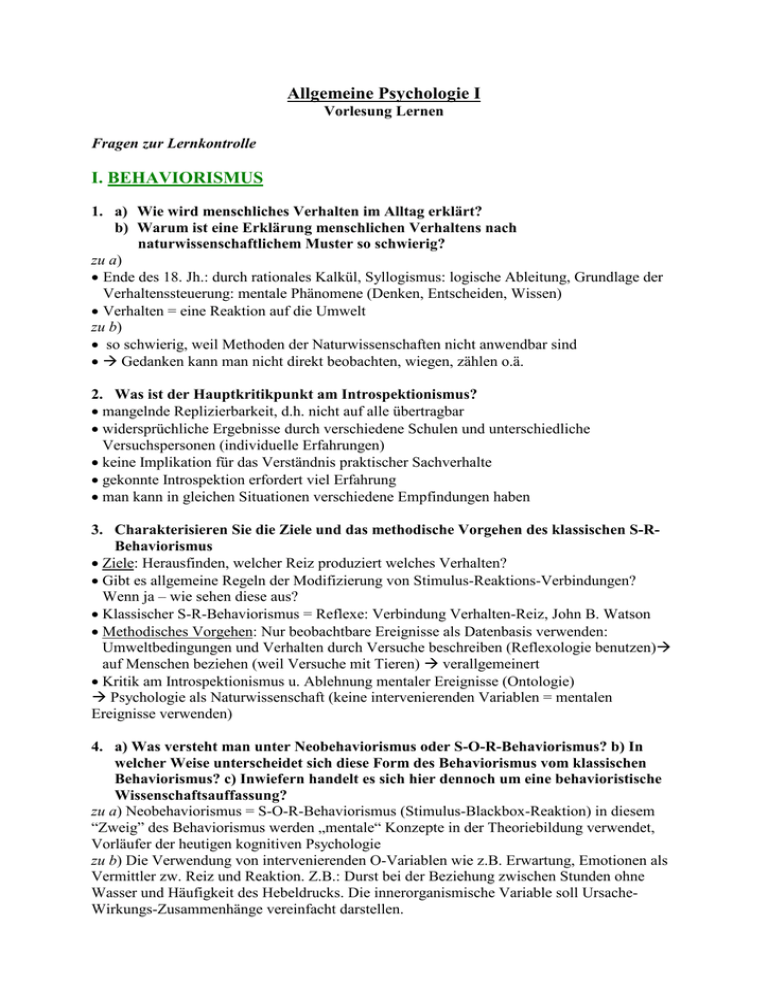

Allgemeine Psychologie I I. BEHAVIORISMUS

Werbung