Integration von Entscheidungsverfahren in den

Werbung

Integration von Entscheidungsverfahren in den

induktiven Theorembeweiser QuodLibet

René Rondot

Oktober 2004

Diplomarbeit

Technische Universität Kaiserslautern

Betreuer:

Prof. Dr. Jürgen Avenhaus

Dipl.-Inform. Tobias Schmidt-Samoa

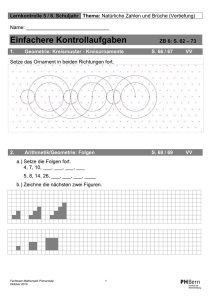

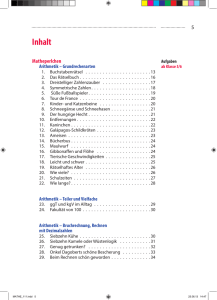

Inhaltsverzeichnis

0. Motivation und Zielsetzung

1

1. Grundlagen

1.1. Theoretische Grundlagen und Schreibweisen . . . . . . . . .

1.1.1. Syntax von Spezifikationen mit Konstruktoren . . .

1.1.2. Semantik von Spezifikationen mit Konstruktoren . .

1.2. Der Theorembeweiser QuodLibet . . . . . . . . . . . . . .

1.2.1. Anwendbarkeitsbereich und generelle Funktionsweise

1.2.2. Inferenzsystem . . . . . . . . . . . . . . . . . . . . .

1.2.3. Beweiszustandsgraphen . . . . . . . . . . . . . . . .

1.2.4. Taktiken . . . . . . . . . . . . . . . . . . . . . . . . .

1.3. Entscheidungsverfahren . . . . . . . . . . . . . . . . . . . .

1.4. Lineare Arithmetik . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

3

4

6

6

7

10

12

12

13

2. Integration der linearen Arithmetik in QuodLibet

2.1. Die Darstellung natürlicher Zahlen . . . . . . . . .

2.2. Operatoren und Prädikate der linearen Arithmetik

2.3. Terme in Polynomdarstellung . . . . . . . . . . . .

2.4. Literale in Polynomdarstellung . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

17

17

18

21

28

3. Integration eines Entscheidungsverfahrens für lineare Arithmetik

3.1. Das Entscheidungsverfahren . . . . . . . . . . . . . . . . . . .

3.2. Inferenzregeln für das Entscheidungsverfahren . . . . . . . . .

3.2.1. Vorbemerkungen . . . . . . . . . . . . . . . . . . . . .

3.2.2. Normalisierung . . . . . . . . . . . . . . . . . . . . . .

3.2.3. Tautologien . . . . . . . . . . . . . . . . . . . . . . . .

3.2.4. Redundanz-Elimination . . . . . . . . . . . . . . . . .

3.2.5. Variablen-Elimination . . . . . . . . . . . . . . . . . .

3.2.6. Benutzen negativer Literale . . . . . . . . . . . . . . .

3.3. Taktiken für das Entscheidungsverfahren . . . . . . . . . . . .

3.3.1. Erweiterung des Moduls Simplification . . . . . . . . .

3.3.2. Möglichkeiten zur Verbesserung der Taktiken . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

35

35

38

38

43

46

48

51

59

61

61

64

4. Auswertung

4.1. Auswirkung der Integration des

spezifikationen . . . . . . . . .

4.1.1. Das Beispiel √

ggT . . . .

4.1.2. Das Beispiel 2 . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

67

Entscheidungsverfahrens

. . . . . . . . . . . . . .

. . . . . . . . . . . . . .

. . . . . . . . . . . . . .

i

in Beispiel. . . . . . .

. . . . . . .

. . . . . . .

67

68

69

Inhaltsverzeichnis

4.1.3. Das Beispiel 91er-Funktion . . . . . . . . . . . . . . . . . . .

4.2. Grundtendenzen in den Auswertungen der Beispiele . . . . . . . . .

70

71

5. Zusammenfassung und Ausblick

73

A. Beweise der verwendeten Lemmata

75

B. Beispielspezifikationen

B.1. Das Beispiel √

ggT . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

B.2. Das Beispiel 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

B.3. Das Beispiel 91er-Funktion . . . . . . . . . . . . . . . . . . . . . . .

93

93

94

94

Literaturverzeichnis

97

ii

0. Motivation und Zielsetzung

Theorembeweiser für die induktive Theorie haben bei der Beweisfindung einen sehr

großen Suchraum zu untersuchen. Dies liegt daran, dass im Vergleich zu deduktiven

Systemen Induktionsordnungen bestimmt und Lemmata spekuliert werden müssen.

Zudem ist das Problem, ob eine Aussage induktiv gültig ist, nicht rekursiv aufzählbar. Derzeit existierende Systeme sind daher in der Regel nur interaktiv einsetzbar

und benötigen einen sehr hohen Rechenaufwand. Dies führt dazu, dass ihre Bedienung kompliziert und zeitaufwändig ist.

Für viele spezielle Anwendungsgebiete existieren jedoch Verfahren, die es ermöglichen, deutlich schneller und vollkommen automatisch zu entscheiden, ob eine Aussage gültig ist oder nicht. Solche sogenannten Entscheidungsverfahren existieren beispielsweise für Teile der Arithmetik der natürlichen Zahlen und die Theorie der

Listen. Es scheint daher sinnvoll, solche Entscheidungsverfahren für häufig auftretende Theorien mit einem induktiven Theorembeweiser zu kombinieren. Das Entscheidungsverfahren kann immer dann genutzt werden, wenn während eines Beweises

Probleme der entsprechenden Theorie auftreten. Dadurch sollte es möglich sein, die

Komplexität eines allgemeinen induktiven Theorembeweisers für diese Probleme zu

vermeiden und durch die Verwendung eines spezialisierten Verfahrens schneller zum

Ziel zu kommen.

Ziel dieser Arbeit ist es, die Integration von Entscheidungsverfahren in einen induktiven Theorembeweiser am Beispiel der linearen Arithmetik über den natürlichen Zahlen zu untersuchen. Für diese Theorie sind bereits seit längerer Zeit einige

Entscheidungsverfahren bekannt. Ein solches Entscheidungsverfahren soll in den induktiven Theorembeweiser QuodLibet integriert werden, der an der Universität

Kaiserslautern entwickelt wurde [Küh00]. Dabei wird untersucht, wie diese Integration möglich ist und welche Vorteile und Nachteile sie bringt. Der erhoffte positive

Effekt sollte vor allem eine deutliche Reduzierung der Beweiskomplexität sowie der

notwendigen manuellen Eingriffe in den Beweisvorgang sein. Dabei ist insbesondere

zu erwarten, dass die Zahl der Lemmata, die für einen Beweis zu einer Spezifikation

mit natürlichen Zahlen benötigt werden, stark verringert werden kann. Als Nachteil

ist ein relativ hoher Aufwand für die Zusammenarbeit des Entscheidungsverfahrens

mit dem restlichen System zu erwarten. Diese Zusammenarbeit ist notwendig, da

das Entscheidungsverfahren auch für eine erweiterte Theorie mit definierten Operatoren verwendet werden soll. Zudem wird das Gesamtsystem durch die Integration

des Entscheidungsverfahrens größer und somit für den Benutzer unübersichtlicher.

Kann der Beweisvorgang wie erhofft durch die Integration des Entscheidungsverfahrens jedoch stärker automatisiert werden, fällt dieser Nachteil weniger ins Gewicht.

Im ersten Kapitel dieser Arbeit werden zunächst die Grundlagen erläutert. Dazu

gehören die theoretischen Grundlagen über die Syntax und Semantik der verwen-

1

Kapitel 0. Motivation und Zielsetzung

deten Spezifikationen. Außerdem wird der induktive Theorembeweiser QuodLibet

in seiner bisherigen Form beschrieben. In diesen Theorembeweiser soll ein Entscheidungsverfahren für lineare Arithmetik integriert werden, weshalb die beiden letzten

Abschnitte des ersten Kapitels allgemeine Grundlagen zu Entscheidungsverfahren

und eine Beschreibung der linearen Arithmetik enthalten.

Wie die lineare Arithmetik in den Theorembeweiser QuodLibet integriert werden kann, ist Thema des zweiten Kapitels. Da QuodLibet bisher keine Strukturen

für natürliche Zahlen enthielt, wird zunächst beschrieben, wie diese in das System

integriert werden können. Anschließend wird erläutert, wie die Operatoren und Prädikate definiert sind und wie diese in das System integriert werden. Die beiden

letzten Abschnitte des zweiten Kapitels sind der Polynomdarstellung von Termen

und Literalen gewidmet. Hier wird beschrieben, wie Terme und Literale der linearen

Arithmetik in eine Polynom-Normalform überführt werden können, mit der dann

effizient ein Entscheidungsverfahren ausgeführt werden kann.

Die Integration des Entscheidungsverfahrens selbst wird dann im dritten Kapitel

behandelt. Hier wird zunächst eine Menge neuer Inferenzregeln vorgestellt, mit deren

Hilfe die einzelnen Schritte des Entscheidungsverfahrens realisiert werden. Um diese

Inferenzregeln so in den formalen Rahmen des Systems QuodLibet integrieren zu

können, dass zentrale Ergebnisse über Eigenschaften des Systems gültig bleiben, wird

die Korrektheit und Sicherheit dieser Inferenzregeln bewiesen. Im Anschluss wird

beschrieben, wie diese neuen Inferenzregeln in die Taktiken des Theorembeweisers

eingearbeitet werden können.

Das vierte Kapitel ist schließlich der Auswertung der Ergebnisse der in den beiden vorhergehenden Kapitel beschriebenen Änderungen gewidmet. Hier wird aufgrund von empirisch erhobenen Daten ausgewertet, wie sich die Integration des Entscheidungsverfahrens bemerkbar macht und wie stark die erhofften positiven Effekte

durch die negativen Effekte beeinträchtigt werden.

Zuletzt werden im fünften Kapitel die Ergebnisse der Arbeit zusammengefasst

und ein Ausblick auf weitere Entwicklungsmöglichkeiten gegeben, die sich basierend

auf den erreichten Ergebnissen aufzeigen.

2

1. Grundlagen

1.1. Theoretische Grundlagen und Schreibweisen

Die dieser Arbeit zugrunde liegenden theoretischen Konzepte und Schreibweisen basieren auf [Küh00] und [Ave95]. Hier wird nur eine kurze Übersicht über die für diese

Arbeit wichtigen Konzepte gegeben, weitere Details und Beweise einiger Aussagen

können in den beiden angegebenen Werken nachgelesen werden.

1.1.1. Syntax von Spezifikationen mit Konstruktoren

Eine Signatur sig = (S, F, α) besteht aus einer Menge von Sortensymbolen S, einer

Menge von Funktionssymbolen F und einer Stelligkeitsfunktion α, die F auf S +

abbildet. Zu jeder Signatur sig = (S, F, α) wird für jede Sorte s ∈ S eine Menge von

Variablensymbolen Vs definiert. Diese Mengen sind paarweise disjunkt und zudem

disjunkt zu F . Die Menge aller Variablensymbole ist V = (Vs )s∈S . Zusammen mit

diesen Variablenmengen beschreibt die Signatur wie üblich die Menge der korrekten

Terme T (sig, V )s einer Sorte s sowie die Menge aller korrekten Terme T (sig, V ) =

(T (sig, V )s )s∈S . Die Menge aller variablenfreien Grundterme wird mit GT (sig) =

(GT (sig)s )s∈S bezeichnet.

Eine Position p in einem Term t ist eine Folge von natürlichen Zahlen. Mit t/p

wird der Teilterm von t an der Position p bezeichnet und t[u]p bezeichnet den Term,

der aus t durch Ersetzen des Teilterms t/p durch u entsteht. Mit P os(t) wird die

Menge aller Positionen in t bezeichnet.

Ein Gewicht über einer Signatur sig und einer Variablenmenge V ist eine Folge

von Termen (t1 , . . . , tk ), so dass 0 ≤ k ≤ k0 für einen festen Wert k0 und t1 , . . . , tk ∈

T (sig, V ).

Eine Gleichung ist ein Term-Paar t1 = t2 , so dass t1 , t2 ∈ T (sig, V )s für eine

Sorte s ∈ S. Ein Ordungsatom ist ein Ausdruck der Form w1 < w2 , wobei w1

und w2 Gewichte sind. Ein Definiertheitsatom ist ein Ausdruck der Form def (t),

wobei t ein Term ist. Ein Atom ist eine Gleichung, ein Ordnungsatom oder ein

Definiertheitsatom. Ein positives Literal ist ein Atom und ein negatives Literal ein

negiertes Atom in der Form ¬A, wobei A ein Atom ist. Ein Literal λ ist ein positives

oder negatives Literal. Das Komplement λ eines positiven Literals λ ist ¬λ und das

.

Komplement ¬λ eines negativen Literals ¬λ ist λ. Die Schreibweise t1 = t2 steht für

˙ t2 für t1 6= t2 oder t2 6= t1 .

t1 = t2 oder t2 = t1 und analog steht t1 6=

Eine Klausel ist eine (möglicherweise leere) Folge von Literalen λ1 . . . λn , zur besseren Lesbarkeit und um den disjunktiven Charakter der Klauseln hervorzuheben

3

Kapitel 1. Grundlagen

meist geschrieben als λ1 ∨ . . . ∨ λn . Die leere Klausel wird als geschrieben. Eine

bedingte Gleichung ist ein Ausdruck der Form l = r ← ∆ wobei ∆ eine (möglicherweise leere) Folge von Literalen, den sogenannten Bedingungsliteralen, ist. Die

Klauseldarstellung der bedingten Gleichung l = r ← λ1 . . . λn ist (l = r)λ1 . . . λn .

Für Ausdrücke (das heißt Terme, Literale, Klauseln oder bedingte Gleichungen)

e1 , . . . , en bezeichnet Var(e1 , . . . , en ) die Vereinigung der Mengen der Variablen, die

in den Ausdrücken e1 , . . . , en vorkommen. Die Definition von Positionen wird auf

Literale fortgesetzt, indem bei Definiertheitsliteralen die Positionen des Terms verwendet werden und bei Literalen der Form l op r die erste Stelle der Position

bezeichnet, ob die restliche Position auf den linken Term (1) oder auf den rechten

Term (2) bezogen ist. Dementsprechend werden für ein Literal analog zu Termen die

Bezeichnungen λ/p, λ[u]p und Pos(λ) verwendet.

Eine Spezifikation mit Konstruktoren spec = (sig, C, E) besteht aus einer Signatur

sig, einer Menge der aus den Funktionssymbolen F ausgezeichneten Konstruktorsymbole C und einer Menge von bedingten Gleichungen E, den sogenannten definierenden Gleichungen. Die Konstruktoren C heißen frei, wenn jede definierende Gleichung mindestens ein Nicht-Konstruktorsymbol außerhalb der Bedingungsliterale enthält. Entsprechend der Unterteilung der Funktionssymbole in die Konstruktorsymbole C und die Symbole für definierte Operatoren D = F \ C wird

auch die Menge der Variablensymbole V disjunkt in sogenannte Konstruktorvariablen V C = (VsC )s∈S und generelle Variablen V G = (VsG )s∈S unterteilt, so dass gilt

V = V C ∪ V G und V C ∩ V G = ∅.

Eine Substitution σ : V −→ T (sig, V ) wird Konstruktorsubstitution genannt, falls

σ(V C ) ⊆ T (sig C , V C ) und σ wird induktive Substitution genannt, falls σ(V C ) ⊆

GT (sig C , V C ) und σ(V G ) ⊆ T (sig, V G ).

Die Intention dieser Definitionen ist es, durch eine Spezifikation mit Konstruktoren

einen Datentyp zu spezifizieren, dessen Daten die Konstruktorgrundterme sind und

auf dem durch die Gleichungen E Operatoren definiert werden. Dies wird durch die

folgende Semantik formalisiert.

1.1.2. Semantik von Spezifikationen mit Konstruktoren

Eine sig-Algebra A ist ein Tupel (A, F A ), wobei A = (As )s∈S eine (nicht-leere) Trägermenge für die Sorten der Signatur und F A = (f A )f ∈F eine Menge von Funktionen

passender Stelligkeit ist, die die Funktionssymbole der Signatur interpretieren.

Ein sig-Homomorphismus h : A −→ B zwischen zwei sig-Algebren A und B ist

eine Familie h = (hs )s∈S von Funktionen hs : As −→ Bs , so dass für alle ai ∈ Asi

gilt:

hs (f A (a1 , . . . , an )) = f B (hs1 (a1 ), . . . , hsn (an ))

Mit evalA wird der eindeutige sig-Homomorphismus von GT (sig) auf eine sigAlgebra A bezeichnet, der durch

evalA (f (t1 , . . . , tn )) = f A (evalA (t1 ), . . . , evalA (tn ))

4

1.1. Theoretische Grundlagen und Schreibweisen

für alle f ∈ F und ti ∈ GT (sig)si definiert ist. Statt evalA (t) wird üblicherweise tA

geschrieben.

Definition 1.1 Das Datenredukt einer sig-Algebra A = (A, F A ) ist die sig C -AlC

gebra A = (AC , C A ), die folgende Bedigungen erfüllt:

A

C

• Für jedes s ∈ S ist AC

s = {t ∈ As | t ∈ GT (sig )s }.

C

A (a , . . . , a ) = cA (a , . . . , a ), wobei

• Für jedes c ∈ C und jedes ai ∈ AC

1

n

1

n

si gilt c

α(c) = s1 . . . sn s.

Zur Auswertung von Ordnungsliteralen wird die Ordnung <lex

A verwendet, die die

strikte Komponente der lexikographischen Erweiterung ≤lex

der

wie folgt definierten

A

Ordnung ist:

Definition 1.2 Sei sig = (S, F, α) eine Signatur, so dass C ⊆ F eine Konstruktormenge für sig ist und sei A = (A, F A ) eine sig-Algebra. Die mit A assoziierte

Relation ≤A ist definiert auf A durch a1 ≤A a2 genau dann, wenn

• a1 = a2 oder

• es gibt t1 , t2 ∈ GT (sig C ), so dass tA

i = ai für i = 1, 2 und |t1 | < |t2 |.

Die Modellsemantik einer Spezifikation mit Konstruktoren kann dann wie folgt

definiert werden:

Definition 1.3 Sei sig eine Signatur und A = (A, F A ) eine sig-Algebra.

• Sei X ⊆ V . Ein Belegung von X in A ist eine Funktion ϕ : X −→ A, so

C

G

dass ϕ(x) ∈ AC

s für jedes x ∈ X ∩ Vs und ϕ(x) ∈ As für jedes x ∈ X ∩ Vs .

Mit evalϕA wird der eindeutige sig-Homomorphismus von T (sig, X) nach A

bezeichnet, der ϕ erweitert. Weiterhin wird evalϕA so erweitert, dass für ein

Gewicht w = (t1 , . . . , tk ) gilt: evalϕA (w) = (evalϕA (t1 ), . . . , evalϕA (tk )).

• Sei ϕ eine Belegung von V in A. Dann erfüllt A

– eine Gleichung t1 = t2 mit ϕ, falls evalϕA (t1 ) = evalϕA (t2 ),

A

– ein Ordnungsatom w1 < w2 mit ϕ, falls evalϕA (w1 ) <lex

A evalϕ (w2 ) und

– ein Definiertheitsatom def (t) mit ϕ, falls evalϕA (t) ∈ AC

s.

A erfüllt ein negatives Literal ¬λ mit ϕ falls A nicht λ mit ϕ erfüllt. Weiterhin

erfüllt A eine Klausel Γ mit ϕ falls ein Literal in Γ existiert, das A mit ϕ

erfüllt.

• Eine Klausel Γ ist gültig in A, falls A die Klausel Γ mit jeder Belegung von V

in A erfüllt (Schreibweise: A |= Γ). Sei K eine Klasse von sig-Algebren und

E eine Klauselmenge. Man schreibt K |= E genau dann, wenn A |= Γ für jede

sig-Algebra A ∈ K und jede Klausel Γ ∈ E.

5

Kapitel 1. Grundlagen

Definition 1.4 Sei spec = (sig, C, E) eine Spezifikation mit Konstruktoren. Eine

sig-Algebra A heißt (sig-)Modell von spec falls die Klauseldarstellung jeder bedingten Gleichung E in A gültig ist. Die Klasse aller sig-Modelle von spec wird mit

Mod(spec) bezeichnet.

Definition 1.5 Sei spec = (sig, C, E) eine Spezifikation mit Konstruktoren. Ein

sig-Modell A von spec wird ein Datenmodell genannt, falls für alle KonstruktorA

Grundterme t1 , t2 ∈ GT (sig C ), tA

1 = t2 impliziert, dass Mod(spec) |= t1 = t2 . Die

Klasse aller Datenmodelle von spec wird mit DMod(spec) bezeichnet.

Definition 1.6 Ein Spezifikation spec heißt zulässig, falls DMod(spec) 6= ∅.

Eine Klausel Γ heißt induktiv gültig oder induktives Theorem bezüglich einer

zulässigen Spezifikation mit Konstruktoren spec, falls DMod(spec) |= Γ.

Ein induktiver Theorembeweiser hat nun zur Aufgabe, die induktive Gültigkeit

einer gegebenen Klausel nachzuweisen. Das folgende Lemma bietet hierfür ein nützliches Kriterium für die Gültigkeit einer Klausel in einer sig-Algebra.

Lemma 1.1 (nach [Küh00, S. 34]) Wenn A eine sig-Algebra und Γ eine Klausel

ist, dann gilt A 6|= Γ genau dann, wenn es eine induktive Substitution σ und eine

Belegung ϕ von V G in A gibt, so dass A nicht Γσ mit ϕ erfüllt. Das Tupel (Γ, σ, ϕ)

wird dann ein A-Gegenbeispiel genannt.

Basierend auf diesem Lemma ist es möglich, eine Klausel als induktiv gültig nachzuweisen, indem systematisch die Existenz eines Gegenbeispiels ausgeschlossen wird.

Dieses Verfahren ist die Grundlage des induktiven Theorembeweisers QuodLibet.

1.2. Der Theorembeweiser QuodLibet

In den folgenden Abschnitten werden einige grundlegende Eigenschaften des Theorembeweisers QuodLibet beschrieben, die für die folgenden Kapitel wichtig sind. Eine detaillierte Darstellung des gesamten Systems findet sich in [Küh00] und [Kai02].

1.2.1. Anwendbarkeitsbereich und generelle Funktionsweise

QuodLibet ist ein Beweissystem zum Nachweis von induktiven Theoremen zu positiv/negativ bedingten Spezifikationen mit freien Konstruktoren. Dabei sind auch

partiell spezifizierte Funktionen zugelassen. Die Zulässigkeit der Spezifikation, das

heißt, die Tatsache, dass die Klasse der Datenmodelle der Spezifikation nicht leer

ist, wird von QuodLibet automatisch anhand eines hinreichenden, syntaktischen

Kriteriums überprüft.

Um ein induktives Theorem nachzuweisen, arbeitet QuodLibet nach dem Prinzip

der Verkleinerung von Gegenbeispielen entsprechend einer wohlfundierten Ordnung.

Diese wird solange durchgeführt, bis die Existenz oder Nicht-Existenz eines Gegenbeispiels evident wird. Dieses Verfahren ist sehr stark an der mathematischen

6

1.2. Der Theorembeweiser QuodLibet

Vorgehensweise beim Finden von Induktionsbeweisen orientiert, die Fermat bereits

1659 unter dem Namen descente infinie beschrieb [Wir04].

Der Vorgang wird durch ein festes Inferenzsystem beschrieben, das gültige Schritte zur Verkleinerung von Gegenbeispielen und für die Erkennung der Nicht-Existenz eines Gegenbeispiels beschreibt. Jede Inferenzregel überführt ein Ziel in eine

(möglicherweise leere) Menge von Teilzielen. Das Inferenzsystem enthält auch Inferenzregeln zum induktiven Anwenden von Zielen. Hierbei werden automatisch neue

Teilziele erzeugt, die sogenannten induktiven Beweisverpflichtungen, die den Nachweis fordern, dass die Instanz, für die die Induktionsannahme angewandt wurde, in

einer wohlfundierten Induktionsordnung kleiner als das ursprüngliche Beweisziel ist.

Die in QuodLibet verwendete semantische Induktionsordnung -A basiert darauf,

jedem Beweisziel Γ ein Gewicht w zuzuordnen, das gewissermaßen die Größe“ des

”

Beweisziels angibt. Daher werden Beweisziele in der Form hΓ ; wi angegeben, das

heißt als Tupel einer Klausel Γ mit dem zugehörigen Gewicht w.

1.2.2. Inferenzsystem

Das Inferenzsystem ist der Kern von QuodLibet. Bisher enthielt QuodLibet 25

Inferenzregeln [Küh00]. Allgemein hat eine Inferenzregel des Kalküls von QuodLibet folgende Form:

hΓ ; wi

hΓ1 ; w1 i . . . hΓn ; wn i

mit hΠ1 ; wˆ1 iU1 , . . . , hΠk ; wˆk iUk

falls Anwendbarkeitsbedingung

wobei n, k ∈ und Uj ∈ {I, L} für j = 1, . . . , k. Eine solche Inferenzregel kann verwendet werden, um ein Ziel hΓ ; wi zu den neuen (Teil-)Zielen hΓ1 ; w1 i . . . hΓn ; wn i

abzuleiten, vorausgesetzt die Anwendbarkeitsbedingung ist erfüllt. Die Inferenzregel

kann dazu weitere Ziele hΠ1 ; wˆ1 iU1 , . . . , hΠk ; wˆk iUk nutzen, die auf hΓ; wi entweder

als Induktionsannahme (Ui = I) oder als Axiom oder Lemma (Ui = L) angewandt

werden. Eine Inferenzregel heißt applikativ, falls k > 0 und nicht-applikativ, falls

k = 0. Applikative Inferenzregeln beinhalten die Anwendung einer definierenden

Gleichung, eines Lemmas oder einer Induktionsvoraussetzung auf ein Ziel. Nicht-applikative Inferenzregeln sind z. B. das Reinigen einer Klausel oder die Aufspaltung

nach Fällen.

N

Im folgenden Abschnitt werden zunächst zwei wichtige Eigenschaften der Inferenzregeln von QuodLibet vorgestellt. Im Anschluss daran werden drei Beispiele

für Inferenzregeln beschrieben.

Eigenschaften von Inferenzregeln

Für das Gesamtsystem sind folgende Eigenschaften gefordert:

• Korrektheit: Wenn mit Hilfe des Systems ein abgeschlossener Beweisbaum gefunden wird, so ist das Ziel ein induktives Theorem.

7

Kapitel 1. Grundlagen

• Widerspruchskorrektheit: Wenn ein Ziel mit dem System zu einem Widerspruch (in der Regel in Gestalt der leeren Klausel) abgeleitet werden kann, so

ist das Ziel kein induktives Theorem.

Da Veränderungen am Zustand der Inferenzmaschine generell nur durch Anwendung

einer der Inferenzregeln durchgeführt werden können, kann der Nachweis dieser beiden Eigenschaften auf lokale Eigenschaften der Inferenzregeln zurückgeführt werden.

Wie in [Küh00] gezeigt wird, genügt für den Nachweis der Korrektheit des gesamten Kalküls der Nachweis der Korrektheit der einzelnen Inferenzregeln und für den

Nachweis der Widerspruchskorrektheit der Nachweis der Sicherheit der Inferenzregeln.

Definition 1.7 Eine Inferenzregel heißt korrekt, falls für jede zulässige Spezifikation spec und jede Instanz

hΓ ; wi

hΓ1 ; w1 i . . . hΓn ; wn i

mit hΠ1 ; wˆ1 iU1 , . . . , hΠk ; wˆk iUk

der Inferenzregel sowie für jedes Datenmodell A ∈ DMod(spec) und jedes A-Gegenbeispiel der Form (hΓ ; wi, σ, ϕ) eine der folgenden Aussagen gilt:

1. Es gibt ein i ∈ {1, . . . , n} und ein A-Gegenbeispiel der Form (hΓi ; wi i, τ, ψ),

so dass (hΓi ; wi i, τ, ψ) -A (hΓ ; wi, σ, ϕ).

2. Es gibt ein j ∈ {1, . . . , k}, so dass Uj = L und Πj nicht induktiv gültig in spec

ist.

3. Es gibt ein j ∈ {1, . . . , k} und ein A-Gegenbeispiel der Form (hΠj ; ŵj i, τ, ψ),

so dass Uj = I und (hΠj ; ŵj i, τ, ψ) ≺A (hΓ ; wi, σ, ϕ).

Sicherheit bedeutet, dass durch die Anwendung einer Inferenzregel keine neuen

Gegenbeispiele eingeführt werden:

Definition 1.8 Eine Inferenzregel heißt sicher, falls für jede zulässige Spezifikation

spec und jede Instanz

hΓ ; wi

hΓ1 ; w1 i . . . hΓn ; wn i

mit hΠ1 ; wˆ1 iU1 , . . . , hΠk ; wˆk iUk

der Inferenzregel gilt, dass aus der induktiven Gültigkeit von jeder der Klauseln

{Γ, Π1 , . . . , Πk } bezüglich spec die induktive Gültigkeit jeder der Klauseln {Γ1 , . . . , Γn }

bezüglich spec folgt.

Nachdem nun diese Eigenschaften von Inferenzregeln definiert wurden, werden

in den folgenden Abschnitten drei Beispiele für Inferenzregeln von QuodLibet beschrieben, die diese Eigenschaften haben. Eine Beschreibung der weiteren Inferenzregeln kann in [Küh00] und [Kai02] nachgelesen werden.

8

1.2. Der Theorembeweiser QuodLibet

Beispiel: Literal Hinzufügen

Ein Beispiel für eine nicht-applikative Inferenzregel ist die Regel Literal Hinzufügen.

Um diese zu beschreiben, wird die folgende Definition benötigt:

N

Definition 1.9 Sei Γ = λ1 , . . . , λn eine Klausel mit n ∈ . Dann besteht die aus

der Klausel Γ resultierende Fallunterscheidung aus den Klauseln Λ1 , . . . , λn und Λ,

so dass

1. Λi = λi , λi−1 , λi−2 , . . . , λ1 für i = 1, . . . , n

2. Λ = λn , . . . , λ1

Die Inferenzregel Literal Hinzufügen realisiert genau diese Fallunterscheidung und

kann wie folgt formal beschrieben werden:

Literal Hinzufügen

falls Λ1 , . . . , Λn , Λ die Fallunterscheidung ist, die aus den Literalen

λ1 , . . . , λn für n > 0 resultiert

hΓ ; wi

hΛ1 , Γ ; wi . . . hΛn , Γ ; wi hΛ, Γ ; wi

Wendet man diese Inferenzregel mit den Literalen ¬def (f (x)) , ¬def (g(y)) an, so

kann beispielsweise das Ziel hf (x) + g(y) = g(y) + f (x) ; wi zu den Zielen

hdef (f (x)) , f (x) + g(y) = g(y) + f (x) ; (f (x), g(y))i

hdef (g(y)) , ¬def (f (x)) , f (x) + g(y) = g(y) + f (x) ; wi

h¬def (g(y)) , ¬def (f (x)) , f (x) + g(y) = g(y) + f (x) ; wi

abgeleitet werden.

Beispiel: Konstant Umschreiben

Eine weitere nicht-applikative Inferenzregel ist die Regel Konstant Umschreiben. Diese

˙ t2 aus, um in einem andeInferenzregel nutzt ein negatives Literal der Form t1 6=

ren Literal den Term t1 durch t2 zu ersetzen. Sie kann folgendermaßen beschrieben

werden:

Konstant Umschreiben

falls

hΓ, λ[t1 ]p , ∆ ; wi

hΓ, λ[t2 ]p , ∆ ; wi

• p ∈ Pos(λ) und λ/p = t1 und

˙ t2 in Γ, ∆ gibt.

• es ein Literal t1 6=

Mit der Inferenzregel Konstant Umschreiben kann demnach beispielsweise das Ziel

hx 6= y ∨ y 6= z ∨ x = z ; wi in das Ziel hx 6= y ∨ x 6= z ∨ x = z ; wi abgeleitet

werden.

9

Kapitel 1. Grundlagen

Beispiel: Nicht-induktive Termersetzung

Eine applikative Inferenzregel ist zum Beispiel die Regel Nicht-induktive Termersetzung. Um diese beschreiben zu können, wird zunächst folgende Definition benötigt:

Definition 1.10 Die Menge von Definiertheitsbedingungen einer Substitution µ und

einer Klausel Γ ist definiert als

DefCond(µ, Γ) = {¬def (xµ) | x ∈ Var(Γ) ∩ V C und xµ 6∈ T (sig C , V C )}

Damit kann nun die Inferenzregel Nicht-induktive Termersetzung wie folgt formuliert werden:

Nicht-induktive Termersetzung

hΓ, λ, ∆ ; wi

.

mit hΠ, l = r, Σ ; ŵiL

hΛ1 , Γ, λ, ∆ ; wi . . . hΛn , Γ, λ, ∆ ; wi hΛ, Γ, λ[rµ]p , ∆ ; wi

falls es eine Position p ∈ Pos(λ), eine Substitution µ und eine Klausel Θ gibt, so

dass

• λ/p = lµ

.

• Γ, ∆, lµ = rµ, Θ enthält DefCond(µ, (Π, l = r, Σ)), Πµ, Σµ

• Λ1 , . . . , Λn , Λ ist die aus Θ resultierende Fallunterscheidung

Mit Hilfe dieser Inferenzregel kann beispielsweise unter Anwendung des Lemmas

hx + y = y + x ; wi mit der Substitution µ = {x ← f(u), y ← v} auf die Position

p = 1 das Ziel hf(u) + v = v + f(u) ; wi zu den Zielen

hdef (f(u)) ∨ f(u) + v = v + f(u) ; wi

h¬def (f(u)) ∨ v + f(u) = v + f(u) ; wi

abgeleitet werden.

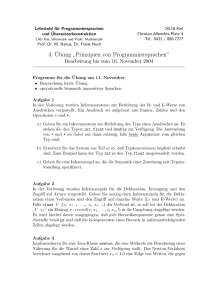

1.2.3. Beweiszustandsgraphen

Beweise und Beweisversuche der Lemmata werden in sogenannten Beweiszustandsgraphen dargestellt. Diese Beweiszustandsgraphen sind und-oder-Graphen, die Zielknoten und Inferenzknoten als und- bzw. oder-Knoten enthalten. Für jedes zu beweisende Lemma wird ein neuer Zielknoten erzeugt. Eine Veränderung an einem Beweiszustandsgraphen ist nur möglich, indem auf einen Zielknoten eine Inferenzregel

angewendet wird. Dadurch erhält dieser Zielknoten als Kind einen Inferenzknoten,

dessen Kinder Zielknoten sind. Diese enthalten die Teilziele der Inferenzregel. Bei

applikativen Inferenzregeln wird zusätzlich eine Kante zu einem Axiom-Knoten oder

einem anderen Zielknoten eingefügt. Dadurch werden Zusammenhänge zwischen einzelnen Lemmata festgehalten. Es ist daher nicht unbedingt notwendig, dass diese

10

1.2. Der Theorembeweiser QuodLibet

{ +(0, y) = y }

y

subst-add

{ +(0, 0) = 0 }

0

{ +(0, s(y)) = s(y) }

s(y)

axiom-rewrite

axiom-rewrite

{0=0}

0

{ s(+(0, y)) = s(y) }

s(y)

=-decomp

ind-rewrite

{ s(y) = s(y) }

s(y)

{ y < s(y),

y = +(0, y),

s(+(0, y)) = s(y) }

s(y)

=-decomp

<-decomp

Abbildung 1.1.: Ein abgeschlossener Beweisbaum für das Ziel +(0, y) = y.

Lemmata bereits bewiesen sind, da die Abhängigkeiten später überprüft werden

können. Lässt man diese Kanten jedoch weg, so zerfällt der Beweiszustandsgraph in

den sogenannten Beweiszustandswald, dessen Komponenten Beweiszustandsbäume

genannt werden. Die Wurzeln der Beweiszustandsbäume sind die zu beweisenden

Ziele.

Es ist möglich, auf einen Zielknoten mehrere Inferenzregeln anzuwenden. Dadurch

entstehen mehrere Inferenzknoten als Nachfolger des Zielknotens. Ein solcher Punkt

wird Entscheidungspunkt genannt und ermöglicht es, mehrere Beweisversuche für

einen Zielknoten parallel auszuführen.

Wenn eine Inferenzregel keine neuen Teilziele erzeugt, so ist dieser Inferenzknoten des Beweiszustandsbaumes abgeschlossen. Ein Inferenzknoten mit Teilzielen ist

abgeschlossen, wenn jedes Teilziel abgeschlossen ist (daher werden die Inferenzknoten als und-Knoten angesehen). Ein Zielknoten ist abgeschlossen, wenn mindestens

ein nachfolgender Inferenzknoten abgeschlossen ist (daher sind die Zielknoten oderKnoten). Reduziert man einen Beweiszustandsbaum auf jeweils einen Inferenzknoten als Nachfolger eines Zielknotens, so erhält man einen partiellen Beweisversuch.

Ist die Wurzel des partiellen Beweisversuches ein abgeschlossener Zielknoten und ist

die induktive Gültigkeit aller angewandten Lemmata bewiesen, so wird der partielle Beweisversuch als Beweisbaum bezeichnet. Wie in [Küh00] gezeigt wird, ist ein

Ziel induktiv gültig, wenn für das Ziel ein Beweisbaum existiert. Der Beweis eines

induktiven Theorems läuft in QuodLibet daher so ab, dass zunächst ein neuer

Zielknoten erzeugt wird, der das zu beweisende Theorem enthält. Anschließend wird

11

Kapitel 1. Grundlagen

durch Anwendung von Inferenzregeln ausgehend von diesem Zielknoten versucht,

einen Beweisbaum für das Ziel zu erzeugen.

Ein Beispiel für einen abgeschlossenen Beweisbaum ist in Abbildung 1.1 dargestellt. Zielknoten werden dabei als Rechtecke dargestellt, in denen das Ziel in Form

einer Klausel in geschweiften Klammern und eines Gewichtes steht. Inferenzknoten

werden als Rechtecke mit abgerundeten Ecken dargestellt, in denen der Name der

angewendeten Inferenz steht. Der Beweisbaum beinhaltet einen Beweis für das Ziel

+(0, y) = y in einer Spezifikation, die die Sorte Nat mit den Konstruktoren 0 und

s und ein definiertes zweistelliges Funktionssymbol + mit den definierenden Regeln

+(x, 0) = x und +(x, s(y)) = s(+(x, y)) enthält.

1.2.4. Taktiken

Weil die Inferenzregeln korrekt und sicher sind und die einzige Möglichkeit darstellen,

Änderungen an Beweiszustandsgraphen vorzunehmen, ist QuodLibet bereits dafür

geeignet, einen manuell erarbeiteten Beweis zu überprüfen. Allerdings ist es auch

wünschenswert, noch unbekannte Beweise automatisch zu finden. Dies ist möglich,

indem die Anwendung der Inferenzregeln durch sogenannte Taktiken automatisiert

wird. In QuodLibet werden diese Taktiken in der eigens entwickelten Programmiersprache QML (QuodLibet-Meta-Language) beschrieben. Hierbei handelt es sich um

eine imperative Programmiersprache, ähnlich der Sprache Pascal, die neben Befehlen

für die Ausführung von Inferenzregeln die notwendigen Kontrollstrukturen bereitstellt, um Taktiken für die Beweisfindung zu beschreiben. Diese Taktiken können

vom Benutzer selbst programmiert und in das System geladen werden. Es steht

jedoch auch eine Menge von Standard-Taktiken bereit, mit denen zumindest eine

Teilautomatisierung des Beweisprozesses bereits realisierbar ist – dennoch ist eine

Interaktion mit dem Benutzer in den meisten Fällen notwendig, um komplexere Beweise zu führen. Eine Beschreibung der bisher verwendeten Standard-Taktiken findet

sich in [Sch04].

1.3. Entscheidungsverfahren

Mit einem induktiven Theorembeweiser wie QuodLibet ist es möglich, Theoreme

aus verschiedenen Theorien zu beweisen. Dazu müssen nur in der Spezifikation die

entsprechenden Axiome der Theorie enthalten sein. Diese Flexibilität ist der große

Vorteil eines solchen allgemeinen Theorembeweisers. Allerdings tauchen viele Theorien sehr häufig auf, insbesondere in bestimmten Problemdomänen. Eine der häufigsten Theorien ist die Theorie der Arithmetik der natürlichen Zahlen. Hierbei zeigt sich

eine Schwäche des allgemeinen Ansatzes, da es für einige dieser Theorien deutlich

effizientere Verfahren gibt, die das Wissen über die Struktur der Axiome und damit

der Theorie besser ausnutzen. Besonders interessant sind dabei diejenigen Theorien,

für die es ein sogenanntes Entscheidungsverfahren gibt. Ein Entscheidungsverfahren liefert für jeden syntaktisch korrekten Ausdruck eine Entscheidung, ob dieser in

einer gegebenen Theorie gültig ist oder nicht. Für die Arithmetik der natürlichen

Zahlen zeigte Gödel bereits 1930 in [Göd31] mit seinem bekannten Unvollständig-

12

1.4. Lineare Arithmetik

keitssatz, dass diese unvollständig ist; das heißt auch, dass für diese Theorie kein

Entscheidungsverfahren existiert. Allerdings hatte Presburger bereits 1929 in [Pre29]

gezeigt, dass eine Teiltheorie der Arithmetik der ganzen Zahlen, die lineare Arithmetik oder sogenannte Presburger-Arithmetik, vollständig ist und somit auch ein

Entscheidungsverfahren existiert. Presburgers Argumentation lässt sich analog zur

linearen Arithmetik der ganzen Zahlen auch für die der natürlichen Zahlen führen

[JBG99].

Die Kombination spezieller Entscheidungsverfahren mit einem allgemeinen Theorembeweiser ist daher sehr viel versprechend. Man hat nach wie vor ein Verfahren,

das allgemein für alle Theorien funktioniert, kann jedoch Aussagen, die aus einer der

Theorien stammen, für die ein Entscheidungsverfahren zur Verfügung steht, wesentlich effizienter behandeln. Es ist zudem möglich, auch Aussagen, die nur teilweise

in den Bereich eines Entscheidungsverfahrens fallen, mit dem Entscheidungsverfahren zu behandeln. Dazu werden Terme mit definierten Operatoren, die nicht zu

der jeweiligen Theorie gehören, zu Variablen abstrahiert. Dann ist es auch möglich,

auf die Axiome und Lemmata dieser Theorien zu verzichten, so dass das allgemeine Verfahren bei der Beweissuche einen deutlich kleineren Suchraum durchsuchen

muss. Zudem wird auch der Benutzer entlastet, da die Axiome und Lemmata, die in

den Bereich der Entscheidungsverfahren fallen, nicht mehr explizit formuliert werden müssen. Kritisch ist jedoch die Zusammenarbeit zwischen Theorembeweiser und

Entscheidungsverfahren zu sehen. Hierbei kann der Effizienzgewinn durch das Entscheidungsverfahren möglicherweise wieder verloren gehen. Dabei ist es in der Regel nicht realisierbar, das Entscheidungsverfahren als Black-Box“ zu integrieren,

”

da zu viele Informationen zwischen den Komponenten ausgetauscht werden müssen

[BM88].

1.4. Lineare Arithmetik

Lineare Arithmetik ist eine Theorie erster Stufe der natürlichen, ganzen bzw. rationalen Zahlen ohne Multiplikation. Diese Theorie ist im Gegensatz zur allgemeinen

Arithmetik der natürlichen, ganzen bzw. rationalen Zahlen entscheidbar. Bereits

1929 bewies Mojzesz Presburger in [Pre29] diese Entscheidbarkeit für die lineare

Arithmetik der ganzen Zahlen und dieser Beweis kann leicht auf die natürlichen

Zahlen übertragen werden. Allerdings ist auch bewiesen, dass die Komplexität eines

solchen Entscheidungsverfahrens für die natürlichen und die ganzen Zahlen bestenn

falls in O(22 ) liegen kann, wobei n die Länge der Aussage ist [FR74]. In der Praxis

können viele Beispiele jedoch deutlich schneller entschieden werden.

Im Folgenden wird ausschließlich die lineare Arithmetik der natürlichen Zahlen

behandelt, die daher auch kurz als lineare Arithmetik bezeichnet wird. Die lineare

Arithmetik der natürlichen Zahlen umfasst die Prädikatenlogik erster Stufe mit den

. sowie dem Prädikat

natürlichen Zahlen als Universum und den Operatoren + und −

≤. Zusätzlich wird der Operator ∗ zur Multiplikation mit Konstanten als Abkürzung

für eine entsprechend häufige Addition definiert: n ∗ x := x + x + . . . + x für n ∈ .

Dieser Operator muss als erstes Argument stets eine natürliche Zahl haben.

N

13

Kapitel 1. Grundlagen

In dieser Arbeit werden nur Aussagen betrachtet, die keine Quantoren enthalten.

Aufgrund der in Abschnitt 1.1.2 beschriebenen Semantik sind die Aussagen implizit

allquantifiziert, da für die Gültigkeit einer Klausel, gefordert wird, dass diese von

allen Belegungen erfüllt wird. Die so entstehende Arithmetik wird quantorenfreie

lineare Arithmetik genannt. Im Folgenden wird unter dem Begriff lineare Arithmetik

stets die quantorenfreie lineare Arithmetik verstanden.

Für die Informatik ist die quantorenfreie lineare Arithmetik besonders interessant,

da viele Beweisziele, die typischerweise bei Hardware- und Software-Verifikation entstehen, mit den Mitteln dieser Arithmetik formuliert werden können. Daher ist es

wünschenswert, solche Aufgaben effizient lösen zu können. Die Integration eines Entscheidungsverfahrens für lineare Arithmetik in einen induktiven Theorembeweiser ist

hierfür sehr viel versprechend.

Es kommt jedoch sehr häufig vor, dass Beweisziele nicht in der reinen linearen

Arithmetik liegen, sondern zusätzlich definierte Funktionssymbole enthalten. Auch

diese Ziele können mit Hilfe des Entscheidungsverfahrens bearbeitet werden, indem

man die Teilterme, die außerhalb der lineare Arithmetik liegen, zu Variablen abstrahiert. Natürlich ist das Entscheidungsverfahren dann kein Entscheidungsverfahren

für die ursprüngliche, nicht in der linearen Arithmetik liegende, Klausel. Gelingt es

jedoch, die Klausel mit den neuen Variablen mittels des Entscheidungsverfahrens zu

beweisen, das heißt die Nicht-Existenz eines Gegenbeispiels nachzuweisen, so kann

auch in der ursprünglichen Klausel kein Gegenbeispiel enthalten sein; somit ist auch

diese bewiesen.

Beispiel: (nach [BM88, S. 92]) Zusätzlich zu der Sorte Nat und den beschriebenen

Operatoren und Prädikaten sei die Sorte List definiert, die wie üblich Listen über

natürlichen Zahlen beschreibt. Dazu seien die beiden folgenden Funktionen definiert,

die das maximale bzw. minimale Element einer Liste bezeichnen sollen:

max : List −→ Nat

min : List −→ Nat

Seien weiter l und k Variablen der Sorte Natund a eine Variable der Sorte List. Dann

ist die Klausel

min(a) < l ∨ k ≤ 0 ∨ l < max(a) + k

nicht in der linearen Arithmetik, kann aber durch Abstraktion der Terme min(a) und

max(a) zu neuen Variablen min und max der Sorte Nat in eine solche umgewandelt

werden:

min < l ∨ k ≤ 0 ∨ l < max + k

Diese neue Klausel kann jedoch nicht mehr bewiesen werden, da die Information

fehlt, dass min(a) ≤ max(a) ist. Möglicherweise steht diese Information als Lemma

zur Verfügung, kann jedoch nicht mehr angewendet werden, weil die Terme min(a)

und max(a) abstrahiert wurden. Daher ist es notwendig, diese Abstraktion rückgängig zu machen, wenn das Entscheidungsverfahren nicht das gewünschte Ergebnis

bringt. Um dies zu vereinfachen, muss man in der Praxis die Abstraktion nicht

durchführen, sondern kann lediglich während des Entscheidungsverfahrens alle Teilterme, die außerhalb der linearen Arithmetik liegen, wie Variablen behandeln. Dies

geschieht hier im Rahmen der in Abschnitt 2.3 beschriebenen Polynomdarstellung.

14

1.4. Lineare Arithmetik

Eine derartige Integration des Entscheidungsverfahrens in den Theorembeweiser

ermöglicht es daher, dieses nicht nur für die Entscheidung von Aussagen der reinen

linearen Arithmetik zu verwenden, sondern auch Aussagen, die definierte Funktionssymbole enthalten, zu verarbeiten. Diese Möglichkeit ist essentiell für den Nutzen

des Entscheidungsverfahrens, da in der Praxis sehr selten Aussagen aus der reinen

linearen Arithmetik bewiesen werden müssen.

15

16

2. Integration der linearen Arithmetik in

QuodLibet

Ein wichtiger Schritt für die Integration eines Entscheidungsverfahrens ist zunächst,

die notwendigen Basisstrukturen bereitzustellen. Bisher sind in QuodLibet keinerlei

vordefinierte Sorten und Operatoren vorhanden. Um jedoch ein spezielles Entscheidungsverfahren für eine auf den natürlichen Zahlen basierende Arithmetik implementieren zu können, müssen sowohl die natürlichen Zahlen selbst als auch die zu

behandelnden Operatoren dem System als solche bekannt sein.

2.1. Die Darstellung natürlicher Zahlen

Zunächst wird für die natürlichen Zahlen eine Sorte definiert, die mit Nat bezeichnet

wird. Das heißt, dass zukünftig jede Spezifikation eine Signatur enthält, für die Nat ∈

S gilt. In QuodLibet wird dies so realisiert, dass beim Programmstart automatisch

die Sorte Nat in die Liste der bekannten Sorten eingetragen wird.

Bisher wurden die natürlichen Zahlen in der Regel mittels der Konstruktoren

0 : → Nat für die natürliche Zahl Null und s : Nat → Nat für die Nachfolgerfunktion dargestellt. Diese Darstellung wird sehr unhandlich, wenn mit Konstanten

gearbeitet wird, die größere natürliche Zahlen repräsentieren, da die natürliche Zahl

n durch den Konstruktorgrundterm s(s(s(. . . (s(0)) . . .))) (im Folgenden kurz sn (0))

dargestellt werden muss. Um effizienter mit natürlichen Zahlen arbeiten zu können,

werden daher abkürzende Schreibweisen für sämtliche Konstruktorgrundterme der

bisherigen Darstellung eingeführt. Dazu wird das Zahlsymbol der natürlichen Zahl

n als Abkürzung für sn (0) verwendet. Das heißt, dass beispielsweise das Symbol

3 als Abkürzung für den Term s(s(s(0))) eingeführt wird. Die Menge aller dieser

Symbole für alle natürlichen Zahlen wird zukünftig mit N bzw. als die Konstanten

der natürlichen Zahlen bezeichnet. Um weiterhin eine Darstellung der natürlichen

Zahlen mit freien Konstruktoren zu ermöglichen, wird dabei die Definition mit 0

und s beibehalten und fest in das System integriert. Das heißt, es werden fortan

nur noch Spezifikationen verwendet, deren Signatur das Funktionssymbol s sowie

die Konstante 0 als Konstruktorsymbole der Sorte Nat enthält. Für die Konstanten

der natürlichen Zahlen wird ein neuer Symboltyp eingeführt, der überall im System

an Stelle eines Konstruktorterms verwendet werden kann. Der Parser wird entsprechend angepasst, so dass automatisch solche Symbole erzeugt werden, wenn eine

natürliche Zahl eingelesen wird.

Aus dieser Darstellung ergibt sich jedoch das Problem, dass es für jede natürliche

Zahl (außer der Null) mehrere syntaktisch verschiedene, jedoch semantisch gleich-

17

Kapitel 2. Integration der linearen Arithmetik

wertige Darstellungen gibt. Da es aufgrund der unendlichen Anzahl nicht möglich

ist, für jede der neuen Konstanten eine definierende Regel im System zu speichern,

die deren Äquivalenz zur Darstellung in sn (0) beschreibt, ist es notwendig, diese

Information fest in das System zu integrieren und die beiden Darstellungen gleichwertig zu behandeln. Dies betrifft Matching, Unifikation und Termgleichheit. Hierbei muss sichergestellt werden, dass die Terme n, sn (0), sn−1 (1), usw. für n ∈ N

als gleich angesehen werden. Eine relativ einfache Lösung für dieses Problem ist die

automatische Konvertierung der verkürzten Darstellung in die s-Darstellung. Diese

Konvertierung kann schrittweise und nur bei den Operationen, die diese benötigen,

durchgeführt werden. Will man beispielsweise die beiden Terme 2 und s(s(0)) auf

Gleichheit überprüfen, so geschieht dies rekursiv durch Vergleich der Topsymbole

und der Argumente. Es wäre an dieser Stelle also möglich, den Term 2 zunächst in

s(1) zu konvertieren. Dann stimmt das Topsymbol von s(1) und s(s(0)) überein. Als

nächsten Schritt werden die Argumente verglichen, das heißt 1 mit s(0). Auch hier

kann man zunächst 1 in s(0) konvertieren, was dann sowohl im Topsymbol s als auch

im Argument 0 mit dem zweiten Term übereinstimmt.

Analog kann man auch bei den Operationen Unifikation und Matching vorgehen.

Diese erweiterte Form der Termgleichheit ist in vielen Fällen jedoch sehr aufwändig

zu überprüfen, so dass bei der Implementierung noch einige Optimierungen notwendig sind. Beispielsweise muss vermieden werden, dass beim Vergleich zweier vordefinierter Nat-Konstanten wie beispielsweise 5 und 7 beide Terme in ihre s-Darstellung

expandiert werden.

2.2. Operatoren und Prädikate der linearen Arithmetik

Wie in Abschnitt 1.4 beschrieben, enthält die lineare Arithmetik die Operatoren +,

. und ∗ sowie das Prädikat ≤. Die drei Operatoren +, −

. und ∗ arbeiten rein auf

−

der Sorte Nat, für die Definition des Prädikates ≤ wird zusätzlich die Sorte Bool mit

den Konstruktorsymbolen true und false benötigt.

Daraus ergibt sich folgende Definition für eine Signatur, die die Sorten und Funktionssymbole der linearen Arithmetik enthält:

Definition 2.1 Eine Signatur mit linearer Arithmetik ist eine Signatur sig = (S, F, α),

für die gilt:

• {Nat, Bool} ⊆ S

. ∗, s, ≤} ⊆ F , N ⊆ F

• {+, −,

• α(+)

.

α(−)

α(∗)

α(s)

α(≤)

=

=

=

=

=

Nat

Nat

Nat

Nat

Nat

Nat

Nat

Nat

Nat

Nat

Nat

Nat

Nat

Bool

18

2.2. Operatoren und Prädikate der linearen Arithmetik

. und ∗ mit Infix-Notation verwenIm Folgenden werden die Funktionssymbole +, −

det, um die Lesbarkeit zu erhöhen. Alle anderen Funktionssymbole werden jedoch

nach wie vor mit der bei QuodLibet üblichen Präfix-Notation verwendet.

Die Bedeutung der Funktionssymbole wird nun durch eine Menge von Axiomen

festgelegt, die im Rahmen der linearen Arithmetik vorgegeben sind:

x+0 = x

x + s(y) = s(x + y)

x∗0 = 0

x ∗ s(y) = (x ∗ y) + x

. 0 = x

x−

. x = 0

0−

. s(y) = x −

. y

s(x) −

(A1 )

(A2 )

(A3 )

(A4 )

(A5 )

(A6 )

(A7 )

≤(0, y) = true

(A8 )

≤(s(x), 0) = false

(A9 )

≤(s(x), s(y)) = ≤(x, y)

(A10 )

Die Menge aller dieser Axiome wird mit AX LA bezeichnet. Daraus ergibt sich

dann folgende Definition für eine Spezifikation mit Konstruktoren, die die Axiome

der linearen Arithmetik enthält:

Definition 2.2 Eine Spezifikation mit Konstruktoren und linearer Arithmetik ist

eine Spezifikation mit Konstruktoren spec = (sig, C, E), für die gilt:

• sig ist eine Signatur mit linearer Arithmetik

• CNat = {0, s}

CBool = {true, false}

• AX LA ⊆ E

Enthält die Spezifikation keine weiteren Sorten, Operatoren und Axiome, so spricht

man von der Spezifikation der reinen linearen Arithmetik.

Durch diese Definitionen wird die Spezifizierbarkeit nicht eingeschränkt. Alle Spezifikationen ohne lineare Arithmetik lassen sich problemlos zu Spezifikationen mit

linearer Arithmetik erweitern, indem die Sorten- und Funktionssymbole sowie die

Axiome der linearer Arithmetik zur Spezifikation hinzugenommen werden. Sofern in

der ursprünglichen Spezifikation bereits Sorten- oder Funktionssymbole der linearen

Arithmetik enthalten waren, können diese umbenannt werden, um Konflikte zu vermeiden. Da es unendlich viele Möglichkeiten für Sorten- und Funktionssymbole gibt,

entsteht dadurch keine Einschränkung. Die Menge der induktiv gültigen Theoreme

wird durch diese Erweiterung nicht eingeschränkt, sondern wird ebenfalls erweitert.

Das heißt, dass alle vorher induktiv gültigen Theoreme auch anschließend induktiv

19

Kapitel 2. Integration der linearen Arithmetik

gültige Theoreme sind. Zusätzlich sind alle in der linearen Arithmetik induktiv gültigen Theoreme hinzugekommen. Dadurch ist es gerechtfertigt, im Folgenden nur

noch mit Spezifikationen mit linearer Arithmetik zu arbeiten.

Intention der Spezifikationen mit linearer Arithmetik ist es, die lineare Arithmetik auf den natürlichen Zahlen zu beschreiben. Da die natürlichen Zahlen mit

den üblichen Operationen Datenmodell einer Spezifikation spec mit reiner linearer

Arithmetik sind, gelten alle in spec induktiv gültigen Theoreme auch in den natürlichen Zahlen. Für die Bestimmung induktiv gültiger Theoreme sind jedoch alle

Datenmodelle zu betrachten, nicht nur die natürlichen Zahlen. Um diese Semantik

beizubehalten, werden daher die folgenden Beweise nicht nur für die natürlichen

Zahlen, sondern für alle Datenmodelle geführt.

Bei der Integration der linearen Arithmetik in QuodLibet wird statt des Operators ≤ mit Ergebnistyp Bool ein vordefiniertes Prädikat in Form eines neuen

Literaltyps eingeführt, das sogenannte ≤-Atom. Dies dient dazu, im Rahmen des

Entscheidungsverfahrens einfacher mit diesem Prädikat arbeiten zu können. Zudem

kann dadurch auf die Einführung der Sorte Bool verzichtet werden. Ein ≤-Atom ist

ein Termpaar der Form t1 ≤ t2 mit t1 , t2 ∈ T (sig, V )Nat . Ein Atom ist dann eine Gleichung, ein Ordnungsatom, ein Definiertheitsatom oder ein ≤-Atom. Um die

Semantik von ≤-Atomen festzulegen, wird der zweite Punkt der Definition 1.3 wie

folgt erweitert: A erfüllt ein ≤-Atom t1 ≤ t2 , falls gilt evalϕA (≤(t1 , t2 )) = true. Somit

kann ein ≤-Atom t1 ≤ t2 als abkürzende Schreibweise für ≤(t1 , t2 ) = true angesehen

werden. Dadurch ist es möglich, bei der Integration in QuodLibet die Sorte Bool

nicht mehr explizit zu integrieren, da diese in der Syntax nicht mehr auftaucht.

Um nun das Entscheidungsverfahren für lineare Arithmetik in QuodLibet zu

integrieren, ist es zunächst notwendig, QuodLibet auf Spezifikationen mit linearer Arithmetik umzustellen. Dazu werden die Sorten- und Funktionssymbole sowie

die Axiome der linearen Arithmetik fest in das System integriert. Dies geschieht,

. ∗ und s sowie die Konstante

indem beim Systemstart die Funktionssymbole +, −,

0 automatisch in die Liste der Funktionssymbole eingetragen werden. Die Axiome

werden ebenfalls automatisch für jede Spezifikation in das System aufgenommen.

Dies dient vor allem dazu, die Analyse der Operatoren zu ermöglichen, beispielsweise um zu einem späteren Zeitpunkt eine geeignete Induktionsvariable zu finden.

. nicht angewendet werden. Stattdessen

Allerdings sollten die Axiome für + und −

wird die in den folgenden Abschnitten beschriebene Normalisierung angewendet, die

die Anwendung dieser Axiome beinhaltet. Die Axiome für ∗ werden jedoch weiterhin

angewendet, da im Rahmen der linearen Arithmetik nur Multiplikationen mit Konstanten behandelt werden können. Für nichtlineare Multiplikationen müssen daher

nach wie vor die Axiome für den Beweisprozess zur Verfügung stehen.

Alle Grundterme der linearen Arithmetik können, da sämtliche Operatoren total definiert sind, unter Anwendung der Axiome zu Konstruktorgrundtermen ausgewertet werden. Daher kann jeder Grundterm t der linearen Arithmetik zu einer

Konstante aus N ausgewertet werden, für die im Folgenden die Schreibweise (t)↓

verwendet wird. Beispielsweise gilt (3 + 4)↓ = (s3 (0) + s4 (0))↓ = s7 (0) = 7 und

. 5)↓ = (s12 (0) −

. s5 (0))↓ = s7 (0) = 7. Außerdem kann jeder Konstruktorgrund(12 −

n

term s (0) der Sorte Nat auf eine äquivalente Konstante n ∈

abgebildet werden

N

20

2.3. Terme in Polynomdarstellung

und umgekehrt. Das heißt, die Auswertung eines Grundterms zu einer Konstanten

entspricht inhaltlich dem Rechnen“ auf natürlichen Zahlen.

”

Somit ist es auch möglich, gewisse Konzepte, die auf den natürlichen Zahlen

verwendet werden, auf die hier verwendeten Konstanten der natürlichen Zahlen N

zu übertragen. Ein solches Konzept, das für die folgenden Abschnitte benötigt wird,

ist das eines gemeinsamen Teilers natürlicher Zahlen. Ein gemeinsamer Teiler g

zweier natürlicher Zahlen a und b ist eine Zahl, die beide Zahlen ohne Rest teilt.

Das heißt es existieren a0 , b0 ∈ , so dass a = g ∗ a0 und b = g ∗ b0 . Dieses Konzept

wird nun folgendermaßen auf die hier verwendeten Konstanten und Operationen

übertragen: Seien x und y Konstanten aus N . Dann können die Konstanten x und y

auf natürliche Zahlen x

e und ye in abgebildet werden. Ist nun ge ∈ ein gemeinsamer

Teiler von x

e und ye, so wird die ge entsprechende Konstante g in N gemeinsamer Teiler

von x und y genannt. Dann existieren auch x0 , y 0 ∈ N , so dass x = (g ∗ x0 )↓ und

y = (g ∗ y 0 )↓. Analog kann auch ein gemeinsamer Teiler mehrerer natürlicher Zahlen

bzw. Konstanten definiert werden.

N

N

N

N

Der größte gemeinsame Teiler (ggT) zweier oder mehrerer Zahlen ist dann der bezüglich der Ordnung der natürlichen Zahlen größte der gemeinsamen Teiler der Zahlen. Auf den natürlichen Zahlen ist der ggT eindeutig bestimmt. Auch das Konzept

des größten gemeinsamen Teilers lässt sich analog zum Vorgehen beim gemeinsamen

Teiler auf die hier definierten Konstanten für die natürlichen Zahlen übertragen.

2.3. Terme in Polynomdarstellung

Um effizient mit Termen der linearen Arithmetik arbeiten zu können, bietet es sich

an, diese als Polynome darzustellen. Dies ermöglicht es, die Operationen des Entscheidungsverfahrens effizient auszuführen.

Definition 2.3 Ein Term-Polynom ist eine Summe der Form

a1 t1 + a2 tn + . . . + an tn + a

mit ai , a ∈ N , ai 6= 0, n ∈

N, ti ∈ T (F, V )Nat.

Als abkürzenden Schreibweise wird im Folgenden meist die Form

n

X

ai ti + a

i=1

verwendet.

Man nennt die ti die Summanden, die ai die Koeffizienten, die ai ti die Monome

und a die Konstante des Term-Polynoms.

Hierbei ist es sinnvoll, zusätzliche Eigenschaften zu fordern, die eine Normalform

für Term-Polynome beschreiben. Durch Anwendung der Axiome der linearen Arithmetik und einfacher, daraus ableitbarer, Lemmata ist es möglich, jeden Term in

eine solche Normalform zu überführen. Dies erleichtert die Vergleichbarkeit von Polynomen und erhöht nochmals die Effizienz bei der Behandlung der Polynome im

21

Kapitel 2. Integration der linearen Arithmetik

Rahmen des Entscheidungsverfahrens. Zudem ist es möglich, auf die explizite Anwendung der Axiome der linearen Arithmetik zu verzichten, wenn die Umwandlung

eines Terms in ein Term-Polynom in Normalform in das System integriert wird.

Für die Normalform wird gefordert, dass die Monome minimal sind, das heißt nicht

selbst wieder eine Addition oder eine Multiplikation mit einer Konstanten sind. Falls

ein Monom eine Subtraktion beschreibt, so wird diese unter Einsatz der Axiome

möglichst stark vereinfacht. Weiterhin ist es möglich, alle Monome zu sortieren,

da die Kommuntativität und Assoziativität von + bewiesen werden können. Hierbei

kann auch zusätzlich sichergestellt werden, dass kein Summand mehrfach vorkommt.

Daraus ergibt sich die folgende Definition:

Definition 2.4 Sei ≺ eine strikte und totale Ordnung auf Termen. Ein Term-Polynom t der Form

t=

n

X

ai ti + a

mit ai , a ∈ N , ai 6= 0, n ∈

N, ti ∈ T (F, V )Nat

i=1

ist in Polynom-Normalform (PNF) bezüglich ≺, falls für alle ti

• ti ist eine Variable oder

. s} oder

• top(ti ) ∈

/ {+, ∗, −,

• ti = l ∗ r und l, r ∈

/ N , l, r Term-Polynome in PNF oder

. r und

• ti = l −

– l ist ein Term-Polynom in PNF der Form

–

–

–

–

–

Pn0

0 0

j=1 aj tj

+ a0

Pn00

r ist ein Term-Polynom in PNF der Form k=1 a00k t00k + a00

alle t0j , t00k sind paarweise disjunkt

a0 = 0 oder a00 = 0

alle a0j , a00k , a0 , a00 haben keinen gemeinsamen Teiler außer 1

r 6= 0, l 6= 0

und t1 ≺ t2 ≺ . . . ≺ tn gilt. Damit sind auch alle ti paarweise verschieden, da die

Ordnung ≺ strikt ist.

Term-Polynome werden im Folgenden auch anstelle von Termen verwendet, obwohl sie syntaktisch keine Terme darstellen. Dazu wird die folgende Termrepräsentation eines Term-Polynoms verwendet, wenn notwendig:

Definition 2.5 Die Termrepräsentation [ai ti ]T eines Monoms ai ti ist

ti

falls ai = 1

[ai ti ]T :=

(ai ∗ ti ) sonst

P

Die Termrepräsentation [t]T eines Term-Polynoms t = ni=1 ai ti + a ist

a + ([a1 t1 ]T + ([a2 t2 ]T + . . . + [an tn ]T ) . . .)) falls a 6= 0

[p]T :=

[a1 t1 ]T + ([a2 t2 ]T + . . . + [an tn ]T ) . . .)

sonst

22

2.3. Terme in Polynomdarstellung

Im Folgenden wird diese Umwandlung eines Term-Polynoms in seine Termdarstellung nicht immer explizit angegeben, sondern immer dann, wenn ein Term-Polynom

als Term behandelt wird, angenommen. Auch für Termpolynome selbst werden oft

zur besseren Lesbarkeit eine Konstante, die 0 ist, und Faktoren, die 1 sind, weggelassen.

Da die Ordnung ≺ in der Definition beliebig, aber fest ist, wird sie fortan nicht

mehr explizit aufgeführt. Der Ausdruck ein Term-Polynom t ist in PNF bedeutet

dann, dass das Term-Polynom t bezüglich einer beliebigen, aber festen Ordnung ≺

in PNF ist.

Um zu zeigen, dass es mit den bisherigen Inferenzregeln von QuodLibet möglich

ist, einen Term in ein Term-Polynom in PNF zu überführen, wird eine vereinfachte

Ableitbarkeit definiert, die sich insbesondere dadurch auszeichnet, dass keine induktiven Inferenzregeln zugelassen sind.

Definition 2.6 Sei spec eine Spezifikation. Ein Term t heißt in spec mit einer

Klausel Θ zu einem Term s nicht-induktiv ableitbar, wenn jedes Ziel hΓ ; wi, für

das Γ/p = t gilt, durch einmalige Anwendung der QuodLibet-Inferenzregel Literal

Hinzufügen mit Θ und anschließende Anwendung von nicht-induktiven Inferenzregeln (wobei nur in spec gültige Lemmata und Axiome für applikative Inferenzregeln

verwendet werden) in die Ziele

hΛ1 , Γ ; wi . . . hΛn , Γ ; wi hΛ, Γ[s]p ; wi

überführt werden kann. Dabei ist Λ1 , . . . , Λn , Λ die aus Θ resultierende Fallunterscheidung ist.

Man sagt dann auch umgekehrt, dass der Term s in spec mit Θ aus t nichtinduktiv ableitbar ist. Ein Term t ist in jeder Spezifikation spec mit ∅ zu sich selbst

nicht-induktiv ableitbar.

Die folgenden zwei Lemmata beschreiben Eigenschaften der nicht-induktiven Ableitbarkeit von Termen, die in den folgenden Beweisen benötigt werden.

Lemma 2.1 Sei spec eine Spezifikation mit Konstruktoren. Ist in spec der Term t

mit Θ1 zum Term t1 nicht-induktiv ableitbar und der Term t1 mit Θ2 zum Term t2

nicht-induktiv ableitbar, so ist in spec auch t mit Θ = Θ1 ∪ Θ2 zu t2 nicht-induktiv

ableitbar.

Beweis: Ist in spec der Term t mit Θ1 zum Term t1 nicht-induktiv ableitbar und

der Term t1 mit Θ2 zu t2 nicht-induktiv ableitbar, so kann ein Ziel hΓ ; wi, für

das Γ/p = t gilt, durch einmalige Anwendung der QuodLibet-Inferenzregel Literal

Hinzufügen mit Θ in die Ziele

hΛ1 , Γ ; wi . . . hΛn , Γ ; wi hΛ, Γ ; wi

überführt werden, wobei Λ1 , . . . , Λn , Λ die aus Θ resultierende Fallunterscheidung

ist.

Anschließend kann das Ziel hΛ, Γ ; wi in spec durch aufeinander folgende Ausführung der Instanzen der nicht-induktiven, applikativen Inferenzregeln, die für die

23

Kapitel 2. Integration der linearen Arithmetik

Ableitung von t nach t1 und von t1 nach t2 verwendet wurden, zu hΛ, Γ[t2 ]p ; wi

abgeleitet werden.

t

u

Lemma 2.2 Sei spec eine Spezifikation und t ein Term für den t/p = t0 gilt. Ist in

spec der Term t0 mit Θ zum Term s nicht-induktiv ableitbar, so ist in spec auch t

mit Θ zu t[s]p nicht-induktiv ableitbar.

Beweis: Folgt unmittelbar aus der Definition von nicht-induktiv ableitbar.

t

u

In den folgenden Beweisen wird stets angegeben, welche Instanzen von Inferenzregeln für die nicht-induktive Ableitbarkeit angewendet werden. Sind lediglich Axiome

und induktiv gültige Lemmata angegeben, so bedeutet dies, dass diese mit der Inferenzregel Nicht-induktive Termersetzung angewendet werden, sofern es sich um eine

bedingte Gleichung handelt. Handelt es sich um ein Lemma der Form l ↔ r, so wird

das Lemma zunächst in einer Richtung mit der Inferenzregel Nicht-induktive Termersetzung und anschließend, um das ursprüngliche Lemma zu entfernen, in die andere

Richtung mit der Inferenzregel Applikative Literal-Beseitigung angewendet. Da Gültigkeit der Bedingungsliterale meist aus dem Kontext klar ist, wird deren Nachweis

dann nicht explizit aufgeführt.

Einige Axiome und einfache Lemmata werden hierbei zur Verbesserung der Übersichtlichkeit oft nicht explizit aufgeführt, sofern sie für den Nachweis der nicht-induktiven Ableitbarkeit nicht wesentlich sind. Dazu gehören beispielsweise die Assoziativität und Kommutativität von +, die häufig zunächst angewandt werden, um

Summanden so umzusortieren, dass andere Lemmata anwendbar sind. Das folgende

Lemma enthält eine Liste der benötigten, in jeder Spezifikation mit linearer Arithmetik induktiv gültigen Lemmata.

Lemma 2.3 Die in Abbildung 2.1 aufgeführten Lemmata sind in jeder Spezifikation

mit linearer Arithmetik spec induktiv gültig (u, v, w, x, y und z sind Konstruktorvariablen der Sorte Nat).

Die Schreibweise Γ ← ∆ steht hierbei (als Erweiterung des Konzeptes des bedingten Gleichung) für eine bedingte Klausel, deren Klauselrepräsentation Γ, δ1 . . . δn ist,

falls ∆ = δ1 . . . δn ist. Weiter steht Γ ↔ ∆ (Γ und ∆ sind Klauseln) als Abkürzung

für zwei Lemmata Γ ← ∆ und ∆ ← Γ.

t

u

Beweis: Siehe Anhang A.

Mit Hilfe dieser Lemmata kann nun folgender Satz bewiesen werden:

Satz 2.1 Sei spec eine Spezifikation mit Konstruktoren und linearer Arithmetik. Zu

jedem Term t der Sorte Nat gibt es ein Term-Polynom tp in PNF, dessen Termdarstellung [tp ]T in spec mit einer Klausel PNFDefCond(t) aus t nicht-induktiv ableitbar

ist.

24

2.3. Terme in Polynomdarstellung

def (x + y)

(L1 )

def (x ∗ y)

(L2 )

1∗x

=

x

(L3 )

x+y

=

y+x

(L4 )

(x + y) + z

=

x + (y + z)

(L5 )

(x ∗ z) + (y ∗ z)

=

(x + y) ∗ z

(L6 )

(x + 1) ∗ y

=

(x ∗ y) + y

(L7 )

s(x)

.

(x ∗ y) − (x ∗ z)

. (x + z)

(x + y) −

=

x+1

(L8 )

=

. z)

x ∗ (y −

. z

y−

(L9 )

=

. z) = w + (z −

. y)

x + y = w + z ↔ x + (y −

. z) ∗ u) = w + ((z −

. y) ∗ u)

x + (y ∗ u) = w + (z ∗ u) ↔ x + ((y −

(L10 )

(L11 )

(L12 )

≤(x ∗ y, x ∗ z)

=

≤(y, z) ← x 6= 0

(L13 )

≤(u ∗ v, (u ∗ w) + y)

=

≤(v, w) ← ≤(u, y) = false

(L14 )

≤((u ∗ x) + v, u ∗ y)

=

≤(x + 1, y) ← ≤(u, v) = false, v 6= 0

(L15 )

x∗y

6=

(x ∗ z) + u ← u 6= 0, ≤(x, u) = false

(L16 )

(x ∗ y = x ∗ z ↔ y = z) ← x 6= 0

(L17 )

≤(x, y) = false ↔ ≤(y + 1, x) = true

(L18 )

x < y ↔ ≤(x + 1, y) = true

(L19 )

x 6< y ↔ ≤(y, x) = true

. y = 0 ← ≤(y, x) = false

x−

(L20 )

(L21 )

.

(x + (y − z) = u ↔ x + y = u + z) ← ≤(z, y) = true

(L22 )

.

(≤(x + (y − z), u) = true ↔ ≤(x + y, u + z) = true) ← ≤(z, y) = true (L23 )

x

=

y ← ≤(x, y) = true, ≤(y, x) = true

(L24 )

≤(x, y)

=

true ← x = y

(L25 )

≤(x, y)

=

true ← ≤(y, x) 6= true

(L26 )

Abbildung 2.1.: In jeder Spezifikation mit linearer Arithmetik induktiv gültige Lemmata.

25

Kapitel 2. Integration der linearen Arithmetik

Beweis: Induktion über den Termaufbau.

Induktionsanfang:

1. t ∈ V : tp = 1t ist ein Polynom-Term in PNF und t ist in spec mit

(

∅

falls t ∈ V C

PNFDefCond(t) =

{¬def (t)} sonst

zu [tp ]T nicht-induktiv ableitbar, denn es gilt [tp ]T = [1t]T = t. Auch wenn

t keine Konstruktorvariable ist, reicht PNFDefCond(t) = ∅ für die Ableitbarkeit aus, für den weiteren Beweis ist es jedoch nützlich, hier bereits ¬def (t)

aufzunehmen.

2. t ∈ N : tp = t ist ein Polynom-Term in PNF, der in spec mit PNFDefCond(t) =

∅ zu [tp ]T nicht-induktiv ableitbar ist, denn es gilt [tp ]T = [t]T = t.

Induktionsschritt: Fallunterscheidung nach dem Topsymbol des Terms:

1. t = l + r: Seien lp und rp Term-Polynome in PNF, deren Termdarstellungen

in spec mit PNFDefCond(l) bzw. PNFDefCond(r) aus l bzw. r nicht-induktiv

ableitbar sind.

und haben die

PmInduktionsvoraussetzung

Pn Diese existieren nach

0

Form lp = i=1 ai ti + a und rp = j=1 bj sj + b. Dann ist t := lp + rp in spec

mit PNFDefCond(t) = PNFDefCond(l) ∪ PNFDefCond(r) aus t nicht-induktiv

ableitbar (nach Lemma 2.1 und 2.2). Sei cj := (bj + ai )↓ für alle i, j mit sj = ti

(für jedes sj existiert maximal ein solches ti , da lp und rp in PNF sind) und sei

c := (a + b)↓. Dann ist auch die Termdarstellung des Polynoms

X

X

X

t00 :=

ai ti +

bi sj +

cj sj + c

{i|1≤i≤n,∀j:sj 6=ti }

{j|1≤j≤m,∀i:ti 6=sj }

{j|1≤j≤m,∃i:ti =sj }

mit PNFDefCond(t) in spec aus t nicht-induktiv ableitbar (Anwendung von

A1 , L3 , L4 , L5 und L6 ). Sortiert man die Summanden von t00 entsprechend

einer totalen Ordnung ≺ auf Termen, so erhält man ein Term-Polynom tp in

PNF, dessen Termdarstellung ebenfalls in spec mit PNFDefCond(t) aus t nichtinduktiv ableitbar ist (Lemma 2.1 und Anwendung von L4 und L5 ).

2. t = l ∗ r: Seien lp und rp Term-Polynome in PNF, deren Termdarstellung in

spec mit PNFDefCond(l) bzw. PNFDefCond(r) aus l bzw. r nicht-induktiv

ableitbar ist.

und haben die

PnDiese existieren nach

PInduktionsvoraussetzung

m

0

:=

Form lp = i=1 ai ti + a und rp = j=1 bj sj + b. Dann ist t

lp ∗ rp in spec

mit PNFDefCond(t) = PNFDefCond(l) ∪ PNFDefCond(r) aus t nicht-induktiv

ableitbar (nach Lemma 2.1 und Lemma 2.2). Daraus können dann folgende

vereinfachte Term-Polynome abgeleitet werden, die in PNF sind:

a) n = 0, m = 0: tp := (a ∗ b)↓ ist ein Term-Polynom in PNF, dessen Termdarstellung in spec mit ∅ aus t0 und damit mit PNFDefCond(t) aus t nichtinduktiv ableitbar ist (Lemma 2.1).

26

2.3. Terme in Polynomdarstellung

Pn

b) n > 0, m = 0: tp :=

i=1 (b ∗ ai )↓ ti + (b ∗ a)↓ ist ein Term-Polynom

in PNF, dessen Termdarstellung in spec mit PNFDefCond(t1 ) aus t0 und

damit mit PNFDefCond(t) aus t nicht-induktiv ableitbar ist (Lemma 2.1,

Anwendung von L6 ).

P

c) n = 0, m > 0: tp := m

j=1 (a ∗ bj )↓ sj + (a ∗ b)↓ ist ein Term-Polynom

in PNF, dessen Termdarstellung in spec mit PNFDefCond(t2 ) aus t0 und

damit mit PNFDefCond(t) aus t nicht-induktiv ableitbar ist (Lemma 2.1,

Anwendung von L6 ).

d) n > 0, m > 0: tp := 1(t1p ∗ t2p ) ist ein Term-Polynom in PNF, dessen

Termdarstellung [tp ]T in spec mit PNFDefCond(t) aus t nicht-induktiv

ableitbar ist, da [tp ]T = lp ∗ rp = t0 .

3. t = s(l): Sei lp ein Term-Polynom in PNF, dessen Termdarstellung in spec

mit PNFDefCond(l) aus l nicht-induktiv ableitbar

Pn ist. Dieser existiert nach

Induktionsvoraussetzung

und

hat

die

Form

l

=

p

i=1 ai ti + a. Dann ist tp :=

Pn

i=1 ai ti + (a + 1)↓ ein Term-Polynom in PNF, dessen Termdarstellung mit

PNFDefCond(t) = PNFDefCond(l) aus t nicht-induktiv ableitbar ist (Lemma 2.1 und Lemma 2.2, Anwendung von L8 ).

. r: Seien l und r Term-Polynome in PNF, deren Termdarstellung

4. t = l −

p

p

in spec mit PNFDefCond(l) bzw. PNFDefCond(r) aus l bzw. r nicht-induktiv

ableitbar ist.

PInduktionsvoraussetzung und haben die

P Diese existieren nach

Form lp = ni=1 ai ti + a und rp = m

j=1 bj sj + b. Seien

ci :=

ai

falls sj 6= ti für alle j

. b )↓ falls s = t

(ai −

j

j

i

bj

falls sj 6= ti für alle i

. a )↓ falls s = t

(bj −

i

j

i

.

c := (a − b)↓

. a)↓

d := (b −

dj

:=

Sei weiterhin k der größte gemeinsame Teiler aller ci und dj sowie c und d, das

heißt es existieren c0i , d0j , c0 und d0 , so dass ci = (k ∗ c0i )↓ für alle i ∈ {1, . . . , n}

0

und dj = (k ∗ d0j )↓ P

für alle j ∈ {1, . . . , m} sowie c = (k

∗ d0 )↓.

P∗ c )↓ und d = (k

0

0

0

0

0

Seien dann t1 p := {i|1≤i≤n,ci 6=0} ci ti + c und t2 p = {j|1≤j≤m,dj 6=0} dj sj + d0 .

Weiterhin sei

falls ci = 0 für alle i ∈ {1, . . . , n}, c = 0

0P

c

t

+

c

falls dj = 0 für alle j ∈ {1, . . . , m}, d = 0

tp :=

{i|1≤i≤n,ci6=0} i i

.

0

0

k t1 p − t2 p

sonst

Dann ist tp ein Term-Polynom in PNF, dessen Termdarstellung in spec mit

PNFDefCond(tp ) aus t nicht-induktiv ableitbar ist (Anwendung von A5 , A6 ,

L6 , L9 und L10 ).

. Das Polynom t := 1(f (t , . . . , t )) ist in

5. t = f (t1 , . . . , tn ) mit f 6∈ {+, ∗, s, −}:

p

1

n

PNF und seine Termdarstellung in spec mit PNFDefCond(t) = {f (t1 , . . . , tn )}

aus t nicht-induktiv ableitbar, da [tp ]T = t gilt.

t

u

27

Kapitel 2. Integration der linearen Arithmetik

Der Beweis von Satz 2.1 ist konstruktiv und lässt daher die unmittelbare Ableitung eines Konstruktionsverfahrens für die Bestimmung eines aus einem Term nichtinduktiv ableitbaren Term-Polynoms in PNF zu.

Beispiele: Sei eine Ordnung auf den Termen gegeben, die diese im Wesentlichen

nach der Multimenge der Variablen, der Termlänge, dem Topsymbol und schließlich

lexikographisch nach den Teiltermen ordnet.

Der Term ((x + (3 ∗ y)) + 5) + (x + (x ∗ y)) ist entsprechend dem Verfahren aus

Satz 2.1 mit ∅ nicht-induktiv ableitbar zu dem Polynom 2x + 3y + xy + 5, das in

PNF ist.

. x)) ist entsprechend dem Verfahren aus

Der Term ((3 ∗ x) + (f (z) ∗ 2)) + (3 + (y −

.

Satz 2.1 mit {¬def (f (z))} nicht-induktiv ableitbar zu dem Polynom 3x+2f (z)+(y −

x) + 3, das in PNF ist.

2.4. Literale in Polynomdarstellung

Auch für Literale der Form l op r, wobei op ∈ {6=, =, ≤} ist und l und r Terme der

Sorte Nat sind, kann eine Polynomdarstellung definiert werden. Diese beinhaltet,

dass die beiden Terme l und r Term-Polynome sind.

Definition 2.7 Ein Polynom-Literal

ist ein Literal λPder Form l op r, bei dem l

P

und r Polynome der Form l = ni=1 ai ti + a bzw. r = m

j=1 bj sj + b sind

Analog zu Term-Polynomen kann auch für Polynom-Literale eine Normalform definiert werden. Diese besteht zunächst daraus, dass die beiden Polynome l und r

in PNF sind. Darüber hinaus können hier jedoch noch weitere Forderungen gestellt

werden. Die Summanden können über beiden Seiten paarweise disjunkt gemacht

werden, indem bei gleichen Summanden auf der Seite mit dem größeren Koeffizienten der kleinere Koeffizient abgezogen wird. Dasselbe kann auch mit den Konstanten

gemacht werden, so dass nur noch eine der Konstanten ungleich 0 ist. Zuletzt können

mittels der Distributivität gemeinsame Koeffizienten ausgeklammert und anschließend eliminiert werden. Hierbei müssen jedoch die Konstanten gesondert behandelt

werden, falls sie den gemeinsamen Teiler der Summanden nicht enthalten. Die Behandlung ist abhängig von der Literalart. Daraus ergibt sich folgende Definition für

die Polynom-Normalform erster Stufe für Literale:

Pn

Pm

Definition 2.8 Ein Polynom-Literal λ =

i=1 ai ti + a op

j=1 bj sj + b ist in

Polynom-Normalform erster Stufe (PNF1), falls gilt:

1. op ∈ {6=, =, ≤}

2. die beiden Polynome

Pn

i=1 ai ti

+ a und

Pm

j=1 bj sj

+ b sind in PNF

3. alle ti , sj sind paarweise verschieden

4. a = 0 oder b = 0

5. alle ai , bj haben keinen gemeinsamen Teiler außer 1

28

2.4. Literale in Polynomdarstellung

Definition 2.9 Sei spec eine Spezifikation mit Konstruktoren. Ein Literal λ heißt

in spec mit einer Klausel Θ zu einer Klauselmenge K = {Γ1 , . . . , Γn } mit Γi =

λi,1 . . . λi,ki für alle i ∈ {1, . . . , n} nicht-induktiv ableitbar, wenn das Ziel hλ ; wi sich

durch einmalige Anwendung der QuodLibet-Inferenzregel Literal Hinzufügen mit Θ

und anschließende Anwendung von nicht-induktiven Inferenzregeln (wobei nur in

spec gültige Lemmata und Axiome für applikative Inferenzregeln verwendet werden)

in die Ziele

hΛ1 , λ ; wi , . . . , hΛn , λ ; wi , hΛ, λ1,1 , . . . , λ1,k1 ; wi , . . . , Λ, λj,1 , . . . , λj,kj ; w

überführen lässt. Dabei ist Λ1 , . . . , Λn , Λ die aus Θ resultierende Fallunterscheidung.

Besteht dabei die Klauselmenge K nur aus einer Klausel mit einem Literal, das

heißt K = {λ1,1 }, so sagt man auch, dass λ in spec mit Θ zu λ1,1 nicht-induktiv

ableitbar ist.

Bemerkung: Ist ein Literal λ in spec mit Θ zur Klauselmenge K = ∅ ableitbar, so

bedeutet dies, dass für den Beweis des Ziels hλ ; wi nur noch die aus der Fallunterscheidung resultierenden Ziele hΛ1 , λ ; wi , . . . , hΛn , λ ; wi bewiesen werden müssen.

Ist ein Literal λ in spec mit Θ zur Klauselmenge K = {} ableitbar, so bedeutet

dies, dass das Literal λ aus jedem Ziel entfernt werden kann, sofern zuvor eine

Fallunterscheidung nach Θ gemacht wird.

Auch hier lässt sich, analog zu Lemma 2.1, die nicht-induktive Ableitbarkeit verketten.

Lemma 2.4 Sei spec eine Spezifikation mit Konstruktoren und das Literal λ in spec

mit Θ1 zur Klauselmenge K = {Λ1 , . . . , Λn } mit Λi = λi,1 . . . λi,ki für i ∈ {1, . . . , n}

nicht-induktiv ableitbar. Sei weiterhin das Literal λj,k mit j ∈ {1, . . . , n} und k ∈

{1, . . . , kj } in spec mit Θ2 zu einer Klauselmenge K2 = {∆1 , . . . , ∆m } nicht-induktiv

ableitbar und Γl := λj,1 . . . λj,k−1 , ∆l , λj,k . . . λj,ki für l ∈ {1, . . . , m}. Dann ist λ in

spec mit Θ = Θ1 ∪ Θ2 zur Klauselmenge {Λ1 , . . . , Λj−1 , Γ1 , . . . , Γm , Λj+1 , . . . , Λn }

nicht-induktiv ableitbar.

t

u

Beweis: Analog Lemma 2.1.

Lemma 2.5 Sei spec eine Spezifikation mit Konstruktoren und linearer Arithmetik.

Jedes Literal λ der Form λ = l op r, wobei op ∈ {6=, =, ≤} ist und l und r

Terme der Sorte Nat sind, ist in spec mit einer Klausel PNFDefCond(λ) zu einer

Klauselmenge Kp nicht-induktiv ableitbar, in der alle Literale in PNF1 sind.

P

P