Document

Werbung

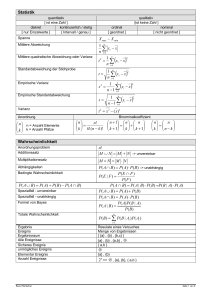

STATISTIK

Inhaltsangabe

Themen

Seite

1.

2.

3.

1.

2.

3.

1.

1.

2.

3.

4.

1.

2.

3.

4.

1.

2.

1.

2.

1.

2.

3.

1.

2.

1.

2.

1.

2.

3.

4.

1.

2.

3.

1.

2.

3.

1.

2.

3.

4.

1.

2.

3.

4.

5.

Häufigkeitsverteilung

Rendite

Lageparameter

Streuungsmaße

Konzentrationsmaße

Preisindizes

Korrelationskoeffinzienten

Wahrscheinlichkeitsrechnung

Zufallsvariable

Verteilungsparameter

Ausgewählte

Verteilungen

Schätzfunktion und

Konfidenzintervalle

Statistische Tests

Statistik - Ferit Demir

Nominalskala

Ordinalskala

metrische Skala

absolute Häufigkeit

relative Häufigkeit

Histogramm

Rendite & Wachstumsraten

Modalwert und Median

arithmetisches Mittel

gewogenes arithmetisches Mittel

geometrisches Mittel

mittlere absolute Abweichung

mittlerer absolute Differenz

mittlere quadratische Abweichung (Varianz)

empirische Standardabweichung

Gini-Koeffizient

Lorenzkurve

Preisindex nach Laspeyres

Preisindex nach Paasche

Kovarianz

Bravais-Pearson-Korrelationskoeffizient

Spearman’sche Rangkorrelationskoeffizient

Begriffe, Ereignisse, Mengenalgebra

Kolmogroff’sche Axiome und Folgerungen

Berechnung, Laplace Experiment= W’keit

Unabhängigkeit und bedingte Wahrscheinlichkeit

Begriffe

diskrete Zufallsvariable

stetige Zufallsvariable

mehrdimensionale Zufallsvariable

Erwartungswert

(Eigenschaften und Unabhängigkeit)

Varianz

(Eigenschaften und Unabhängigkeit)

Kovarianz

(Unabhängigkeit, Korrelationskoeffizient)

Binominalverteilung und Bernoulliverteilung

stetige Gleichverteilung und Normalverteilung

Standardisierung und zentraler Grenzwertsatz

Punktschätzung und Konfidenzintervallkonstruktion

bei normalverteilter GG und unbekannter Varianz

bei normalverteilter GG und bekannter Varianz

approximatives K-Intervall für unbekannte Anteile

bei bekannter Varianz

bei unbekannter Varianz

approximative Test für unbekannte Anteile

X2 – Anpassungstest

X2 – Unabhängigkeitstest

Seite

0

1

.

.

1

.

.

1

2

.

.

.

2

.

.

.

3

.

3

.

4

.

.

5

.

6

.

7

.

.

.

8

.

.

9

10

11

12

13

.

.

14

.

15

.

16

wiso.ferit.info

Ø

induktive

Statistik

Skalen

1

Wahrscheinlichkeits

-rechnung

1. deskriptive Statistik Ù induktive Statistik

deskriptive Statistik

Einführung

Deskriptive Statistik

Induktive Statistik

-beschreibendeDatenaufbereitung oder Veranschaulichung

-schließendeTeildaten ermöglichen Schlüsse für die

unbekannte Gesamtmenge

S K A L E N

Nominalskala

keine quantitative oder qualitative Ordnung

Ordinalskala oder Rangskala

eine qualitative Ordnung oder eine Rangfolge

Kardinalskala oder

metrische Skala

quantitative Ordnung

oder zwei

Zuordnungen

Stab- oder

Kreisdiagramm

diskret = speziell

Histogramm

stetig = beliebig

H Ä U F I G K E I T S V E R T E I L U N G

k

h(aj )

absolute Häufigkeit

∑ h(aj ) = n

j =1

k

1

f (aj ) = h(aj )

n

relative Häufigkeit

Histogramm

( Höhe der Balken)

Höhe =

R E N D I T E

&

∑ f (aj ) = 1

j =1

relative Häufigkeit

Intervallbreite

W A C H S T U M S R A T E N

neu Kurs − alt Kurs

alt Kurs

neu Kurs

−1 = r

alt Kurs

Rendite

r =

Wachstumsrate in Prozent

neu Kurs

rw =

− 1 ⋅ 100 oder

alt Kurs

durchschnittliche

Wachstumsrate

r =

Statistik - Ferit Demir

n

oder

(1 + r1 )(1 + r2 ) L (1 + rn )

Seite

1

rw = r ⋅ 100

−1

wiso.ferit.info

L A G E P A R A M E T E R

Die am häufigsten auftretende Merkmalsausprägung.

Modalwert

n + 1

x

; falls n ungerade

2

n

n

x 2 + x 2 + 1 ; falls n gerade

Median

1

2

arithmetisches Mittel

xa =

gewogenes

arithmetisches Mittel

xa =

∑g

geometrisches Mittel

xg =

n

g

1

n

∑ xi

i

Transformation

→

g i ≥ 0,

xi

∑g

i

y a = a ⋅ xa + b

=1

∏ xi

S T R E U U N G S M A ß E

mittlere absolute

Abweichung

dx =

mittlere absolute Differenz

∆x =

mittlere quadratische

Abweichung (Varianz)

S 2x =

Standardabweichung

Sx =

Transformation von Varianz und

Standardabweichung

Statistik - Ferit Demir

1

∑ xi − xm

n

1

n2

∑∑

xi − x j

(

1

∑ xi − xa

n

oder

1

xi 2 − xa 2

∑

n

S2x

S 2 y = a2 ⋅ S 2x

Sy =

)2

und

S 2x

Seite

oder

2

a2 ⋅ S 2 x =

a ⋅ Sx

wiso.ferit.info

K O N Z E N T R A T I O N S M A ß E

Gini-Koeffizient

Mögliche 3 Formen um den Gini-Koeffizienten zu berechnen.

∆x

2 xa

2

Gx =

n∑ xi

Gx =

Gx =

Konzentration

Wie verändert sich der GiniKoeffizient?

Intervall /Klassen ändern

Lorenzkurve

( ∑ i xi ) − 1 − 1

n

siehe unten

Lorenzkurve

(Tabelle erstellen)

m

∑ (K i + K i −1 )(Li − Li −1 ) − 1

i =1

0 < Gx < 1

; gegen 1 Konzentration größer

; gegen 0 Konzentration kleiner

Zu betrachten ist dann die Differenz von Gx – Gy

Bei gröberer Einteilung der Intervalle/Klassen nimmt der

Gini-Koefizient ab

LK = 1 ist die WH , wobei dann G x = 0 ist.

i − te Zeile

n

− Spalte

Tabelle

j

i

n

i + i− 1

Zähler wird

n

kummuliert

i + i − 1 + ... + i − n

= 1

n

P R E I S I N D I Z E S

Preisindex nach Laspeyres

P01 L =

∑ pt q0 = pt

∑p

∑ p0 q0

0

g0 ; g0 =

Preisindex nach Paasche

P01 P =

∑ pt qt = pt

∑p

∑ p0 qt

0

gt ; gt =

p0 q0

∑ p0 q0

p0 qt

∑ p0 qt

Immer Tabelle in dieser Form erstellen:

Berechnungshilfe Æ

Statistik - Ferit Demir

p0

M

Seite

q

0

M

3

pt

M

qt

M

wiso.ferit.info

K O R R E L A T I O N S K O E F F I Z I E N T E N

empirische Kovarianz

S xy =

Kovarianz ist nicht normiert, daher schlechte Vergleichbarkeit

1

n

∑ (xi − x a )(y i − y a )

Transformation von Kovarianz

1

n

oder

∑

xi y i − x a y a

S ~x~y = a ⋅ c ⋅ S xy wenn

~

x = a ⋅ xa + b und ~

y = c ⋅ ya + d

Æ Bravais-Pearson benötigt metrisch Skalierte Merkmalsausprägungen und

misst nur den linearen Zusammenhang

s xy

rxy =

Bravais-PearsonKorrelationskoeffizient

sx s y

M

∑ (xi − xa )(yi − ya )

2

2

∑ (xi − xa ) ∑ (yi − ya )

Ð eine Tabelle mit 7 Spalten erstellen Ð

Berechnungshilfe Æ

xi

=

(xi − xa ) (xi − xa )2

M

M

(yi − ya ) (yi − ya )2 (xi − xa )(yi − ya )

yi

M

M

M

M

BPK ist invariant gegenüber linearer Transformation.

Transformation von BPK

positiver, linearer Zusammenhang = rxy nahe bei 1

negativer,linearer Zusammenhang = rxy nahe bei –1

Zusammenhang

− 1 ≤ rxy ≤ 1

Im Gegensatz zu Kovarianz normiert, aber Korrelation sagt nichts über Kausalität aus.

Æ Spearman benötigt mindestens ordinal skalierte Merkmalsausprägungen und

die Ausprägungen werden durch Ränge ersetzt

rS =

Spearman’sche

Rangkorrelationskoeffizient

∑ (R( x ) − Rx ) (R( y ) − Ry )

2

2

∑ (R( x ) − Rx ) ∑ (R( y ) − Ry )

i

i

i

i

Falls bei x und y alle Ränge verschieden sind, lässt sich rS auch

berechnen durch: Ð

Berechnungshilfe IÆ

(

6 ∑ R( xi ) − R( y i )

rS = 1 −

n (n − 1)(n + 1)

Berechnungshilfe IIÆ

)2

Ð ansonsten eine Tabelle mit 5 Spalten erstellen Ð

(R(x ) − Rx ) (R(x ) − Rx )2 (R( y ) − R y ) (R( y ) − R y )2 (R(x ) − Rx ) (R( y ) − R y )

i

i

M

i

M

Statistik - Ferit Demir

i

M

i

M

Seite

4

i

M

wiso.ferit.info

W A H R S C H E I N L I C H K E I T S R E C H N U N G

Begriffe

Zufallsexperiment (ZE)Æ

Ergebnismenge Ω Æ

Elementereignis ω Æ

Umfang von |Ω|Æ

Ereignis A Æ

SchnittmengeÆ

VereiningungmengeÆ

Ereignisse

Bedeutungen:

Ein Experiment dessen Ausgang unbekannt ist.

Ω ={1,2,3,4,5,6} Menge aller möglichen Ausgänge

ω1={1,3,5}; ω2={2,4,6}; eindeutige Teilmenge von Ω

|Ω|= 6 Æ Anzahl der ein elementigen Teilmengen von Ω

Teilmenge von Ω

A∩ B

A∪ B

Schreibweisen:

A ist sicheres Ereignis

A=Ω

A ist unmögliches Ereignis

A=∅

A ist Teilereignis von B

A⊂ B

A und B sind äquivalente M

Mengenalgebra

Assoziativgesetz

A= B

Distributivgesetz

Gesetz vom

komplementären

Element

Gesetze von de Morgan

Umformungen:

A∪ A = Ω

A ∪ (B ∩ C ) = ( A ∪ B ) ∩ ( A ∪ C ) bzw.

A ∩ (B ∪ C ) = ( A ∩ B ) ∪ ( A ∩ C )

disjunkt

komplementär

A ∩A=∅

A∪ A =Ω

(A ∩ B) = A ∪ B

(A ∪ B) = A ∩ B

bzw.

Wahrscheinlichkeitsmaß:

P ( A) ≥ 0

Kolmogroff’sche Axiome

P(Ω ) = 1

P ( A ∪ B ) = P ( A) + P (B )

; wenn A, B disjunkt

P(0/ ) = 0

Folgerungen aus den

Kolmogroff’schen Axiomen

Statistik - Ferit Demir

P ( A ) = 1 − P ( A)

P ( A ∪ B ) = P ( A) + P (B ) − P ( A ∩ B )

Seite

5

wiso.ferit.info

W A H R S C H E I N L I C H K E I T S R E C H N U N G

mathematische Berechnung

der Wahrscheinlichkeit

Laplace-Experiment

Ω < ∞ dann

P ( A) =

A

Ω

=

P({ω }) =

1

Ω

Anzahl der günstigen Fälle

;A⊂ Ω

Anzahl der möglichen Fälle

P ( A ∩ B ) = P ( A) ⋅ P ( B )

Unabhängigkeit

wenn 2 Ereignisse unabhängig sind

P( A ∩ B )

P(B )

P ( A | B ) ≠ P ( B | A)

P( A | B ) =

wenn A, B ⊂ Ω mit P(B ) > 0

nicht beliebig austauschbar!

kurz ↑ = P von A unter B ; hier wird Ω auf das Ereignis B reduziert!

bedingte

Wahrscheinlichkeit

falls unabhängig :

P( A | B ) =

Statistik - Ferit Demir

P ( A ∩ B ) P ( A) ⋅ P (B )

=

= P ( A)

P(B )

P(B )

Seite

6

wiso.ferit.info

Z U F A L L S V A R I A B L E

Begriffe

Bedeutungen:

Zufallsvariable XÆ

Wertebereich X(Ω)Æ

Realisation x=X(ω)Æ

diskrete Zufallsvariable

Wahrscheinlichkeitsfunktion:

Verteilungsfunktion:

Wertebereich von W’keit-fkt

und Vtlgs-fkt:

stetige Zufallsvariable

Dichtefunktion:

X: ΩÆIR, deren mögliche Werte vom Ausgang des ZE abhängen

Menge aller möglichen Realisationen

Wert einer Zufallsvariable

Wertebereich hat nur abzählbar viele Werte

f ( x ) = P( X = x ) heißt Wahrscheinlichkeitsfunktion

F ( x ) = P( X ≤ x ) heißt Verteilungsfunktion

0 ≤ f (x ) ≤ 1

∑ f (xi ) = 1

und

0 ≤ F (x ) ≤ 1

F ( x ) = monoton steigend , rechtsseitig stetig

Wertebereich kann (od. in Grenzen) alle reellen Werte umfassen

x

P( X = x ) = 0 ≠

f ( x ) = F ′( x ) =

∫ f (t ) ⋅ dt

−∞

b

Verteilungsfunktion:

P(a < X ≤ b ) = F (b ) − F (a ) = ∫ f ( x ) dx

⇔ [F ( x ) ⋅ dx ]ba

a

Wertebereich von Dichte-fkt

und Vtlg-fkt:

f (x ) ≥ 0

∞

∫ f (x ) ⋅ dx = 1

und

0 ≤ F (x ) ≤ 1

−∞

F ( x ) = monoton steigend , stetig in x

mehrdimensionale

Zufallsvariable

Unabhängigkeit

Statistik - Ferit Demir

Fx1 x 2 ( x1 , x2 ) = P( X 1 ≤ x1 , X 2 ≤ x2 ) " , " = ∩

P( X1 ≤ x1, X 2 ≤ x2 ) = P( X1 ≤ x1 ) ⋅ P( X 2 ≤ x2 )

14243 14243

F ( x1 )

Seite

7

F ( x2 )

wiso.ferit.info

V E R T E I L U N G S P A R A M E T E R

Erwartungswert

x diskrete Zufallsvariable mit Realisation x1,x2,…xn ,dann gilt:

E ( X ) = ∑ xi ⋅ f ( xi )

bei diskreter Verteilung

x stetige Zufallsvariable mit Dichtefunktion f(x) ,dann gilt:

E(X ) =

∞

∫ x ⋅ f (x ) ⋅ dx

bei stetiger Verteilung

−∞

E (a ⋅ X + b ) = a ⋅ E ( X ) + b

Eigenschaften

E (∑ x i ) =

∑ E (X i )

E (∑ a i ⋅ x i ) =

od .

∑ g ( x i ) ⋅ f ( x i )

E (g ( x ) ) =

∫ x ⋅ f ( x ) ⋅ dx

E( XY ) = E( X ) ⋅ E(Y )

Unabhängigkeit

Var

Varianz

einfacher:

Eigenschaften

Unabhängigkeit

Statistik - Ferit Demir

(X ) = E

für diskrete

∑ ai

⋅ E (X i )

ZV

für stetige ZV

wenn X , Y unabhängig

(

X − E ( X )

)

2

( X ) = E (X 2 ) − [E ( X )] 2

Var ( x ) ≥ 0

Var (a ⋅ x + b) = a 2 Var( x ) "+b hat keine Auswirkung"

Var(a ⋅ x + b ⋅ y ) = a 2 Var( x ) + b 2 Var( y ) + 2ab Cov( x, y )

Var

x 1 ,..., x n unabhängig

Var

(∑ x i ) = ∑

Seite

8

Var

dann

(x i )

wiso.ferit.info

Kovarianz

Cov ( X , Y ) = E [( X − E ( X ) ) ⋅ (Y − E (Y ) )] = E ( XY ) − E ( X ) ⋅ E (Y )

Unabhängigkeit

Korrelationskoeffizient

x, y unabhängig dann

Cov( x, y ) = 0

Pxy =

Cov ( X , Y )

σ X ⋅σY

wenn X eine beliebige ZV mit unabhängigen

Gesetz der großen Zahl

Realisation x1 L xn , dann

lim

n→∞

1

∑ xi = E ( X )

n

A U S G E W Ä H L T E

eine diskrete ZV heißt,

Binominalverteilung

Zahl der möglichen

Anordnungen

Wahrscheinlichkeitsfunktion:

Verteilungsfunktion:

Erwartungswert

Varianz

V E R T E I L U N G E N

X~B(n, p)Æ wenn x die Erfolge bei n unabhängigen

Versuchen mit Erfolgswahrscheinlichkeit p zählt.

x = Zahl der Erfolge mit Wahrscheinlichkeit px,

wobei (n – x) die Anzahl der Misserfolge misst

n

n!

=

x! (n − x )!

x

n

f X ( x ) = p

x

F X (x ) =

x

∑

k =0

wenn x ≤ n

x

(1 −

p )n− x

n k

p (1 − p ) n − k

k

E(X ) = n ⋅ p

Var ( X ) = n ⋅ p (1 − p )

n = 1 ⇒ X ~ Bin (1, p )

SpezialfallÆ Bernoulli-Vtlg

Statistik - Ferit Demir

X i ~ Bin (1, p ) ⇒ ∑ xi ~ Bin (n, p )

Seite

9

wiso.ferit.info

A U S G E W Ä H L T E

stetige Gleichverteilung

X ~ R [a, b] , heißt gleichverteilt

(rechteckverteilt ) im Intervall [a, b]

1

f X (x ) = b − a

0

Dichtefunktion:

Verteilungsfunktion:

Erwartungswert

Varianz

Normalverteilung

Dichtefunktion:

Verteilungsfunktion:

Erwartungswert

Varianz

Eigenschaften

V E R T E I L U N G E N

x ∈ [a , b]

sonst

x<a

0

x − a

FX ( x ) =

x ∈ [a , b]

−

b

a

x>b

1

(a + b )

1

E ( X ) = (a + b ) oder

2

2

(

1

b − a )2

2

(b − a ) oder

Var ( X ) =

12

12

X ~ N (µ , σ 2 ) , dann ist eine stetige ZV normalvert eilt

f

F

X

X

1

(x ) =

( x − µ )2

2σ 2

2 πσ

x

1

−∞

2 πσ

(x ) =

E(X ) = µ

−

∫

−

( x − µ )2

2σ 2

Var ( X ) = σ 2

f (µ − x ) = f (µ + x ) , d .h. Dichte ist symmetrisch

Median → ( X ) = µ

arg max f ( x ) = µ

Modalwert → ( X ) = µ

Wendestellen von f → x1 = (µ − σ ) ∧ x2 = (µ + σ )

Statistik - Ferit Demir

Seite

10

wiso.ferit.info

Z ~ N (0 , 1) , d.h. Z ist standardnormalverteilt

Standardisierung

(

X ~ µ ,σ 2

)

dann ist die Standardis ierung von x

Dichtefunktion:

Verteilungsfunktion:

Eigenschaften

1

(

σ

− x

1

ϕ 2

2πσ

ϕ (x ) =

Φ (x ) =

x−µ

Z=

gegeben durch :

x

∫ ϕ (t ) dt

−∞

2

→ tabelliert

)

dann

→ F ( x ) = P( X ≤ x )

X ~ µ , σ 2

X −µ x−µ

x−µ

x−µ

⇔ P Z ≤

⇔ P

≤

⇔ Φ

σ3

σ

σ

12

σ

Z ~ N (0,1)

Φ(− x ) = 1 − Φ( x )

(

X 1 ~ N µ1 , σ 1

2

)

→ tabelliert

;

(

X 2 ~ N µ2 , σ 2

2

)

X 1 , X 2 sind unabhängig, dann gilt :

Unabhängigkeit

2

2

X 1 + X 2 ~ N µ1 − µ 2 , σ 1 + σ 2

424

3

1424

3

1

Erwartungs

wert

Varianz

∑

∑

zentraler Grenzwertsatz

X 1 , X 2 ,...Folge unabhängig, identisch

verteilter ZV mit gl . Erw. µ mit gl . Var. σ

X ~ Bin(n, p ) dann gilt : ↓

2

1

xi − µ

∑

Fo lg erung

lim P n

→

≤ x = Φ( x )

2

n→∞

↓

σ

↓

n

Diese Approximation ist

akzeptabel, wenn folgende

Faustregeln gelten:

Statistik - Ferit Demir

x − n⋅ p

lim P

≤ x = Φ( x )

n→∞

n ⋅ p(1 − p )

n ≥ 30

wenn das gilt dann kann man

Binominalverteilung zu

n ⋅ p ≥ 10

n (1 − p ) ≥ 10 Standardnormalverteiltung approximieren

Seite

11

wiso.ferit.info

K O N F I D E N Z I N T E R V A L L E

Punktschätzung

Schätzfunktion

θ̂ = g ( x1 ,K, xn ) für den unbekannten Parameter

x1,…xn StiPro aus GG mit unbekanntem Erwartungswert µ . Dann gilt:

Eigenschaften

→ Eine Schätzfunktion θˆ heißt erwartungstreu

()

(unverzerrt) für θ , wenn gilt: E θˆ = θ

Erwartungstreue Æ

→ Die Verzerrung (Bias) einer Schätzfunktion θˆ

() ()

ist definiert durch Bias θˆ = E θˆ − θ

→ Eine erwartungstreue Schätzung hat Bias 0 (null).

Eine erwartungstreue Schätzfunktion trifft im Mittel den

unbekannten Parameter Æ jedes gewogene arithmetische

Mittel ist eine erwartungstreue Schätzung

θˆ1 ,θˆ2 erwartungstreue Schätzfunktion für θ .

Effizienz Æ

θˆ1 heißt

( 1 ) < Var (θˆ2 )

effizienter (wirksamer) als θˆ2 wenn : Var θˆ

→ µˆ = x : effizienteste Schätzfunktion : x ist BLUE für µ

θˆ Schätzfunktion für θ . θˆ heißt Konsistent , wenn

Konsistenz Æ

(

)

lim P θˆ − θ > E = 0

n→∞

()

lim E θˆ = θ

n→∞

( x ist Konsistent für µ )

()

lim Var θˆ = 0

und

→

n→∞

x1,…xn StiPro aus GG mit unbekanntem Erwartungswert µ und unbekannter Varianz σ2 . Dann gilt:

Vorsicht:

1

2

Schätzfunktion σˆ 2 = S 2 =

empirische Varianz

xi − x

ist nicht

n−1

erwartungstreu!

1

einfacher: σˆ 2 = S 2 =

xi 2 − n ⋅ x 2

σ2 aber schon !

n−1

∑(

)

(∑

)

Konfidenzintervalle

1. Konfidenzniveau festlegen (Irrtums - W' keit) → α

2. Fraktil aus zugehöriger Verteilung ausrechnen → c

Konstruktionsprinzip für alle

behandelten Konfidenzintervalle

Æ in 5 Schritten

3. Schätzer berechnen → x

4.

c ⋅σ

berechnen

n

[

5. Konfindenzintervall aufstellen → KI = V ;V

Statistik - Ferit Demir

Seite

12

u

o

]

wiso.ferit.info

Konfidenzintervall für µ bei normalverteilter GG und bekannter Varianz

KI mit unbekanntem

Erwartungswert und

bekannter Varianz

mit Erwartungswert µ und Varianz σ

σ 2 dann

→ n ⋅ x − µ ~ N (0,1)

X ~ N µ ,

n

σ

c ⋅σ

PX −

n

≤µ≤

X+

c ⋅σ

KI (µ ) = X −

n

Fraktil

2

c =U

α

1−

2

c ⋅σ

n

= 1−α

≤µ≤

X+

c ⋅σ

n

α

= 1 − - Fraktil der N (0,1) − Verteilung

2

Konfidenzintervall für µ bei normalverteilter GG und unbekannter Varianz

KI mit unbekanntem

Erwartungswert und

unbekannter Varianz

n⋅

x−µ

entsprechende

~ t (n−1) → t − Verteilung

S

Verteilung

σ 2 = kann erwartungstreu geschätzt werden → S

c⋅S

KI (µ ) = X −

n

Standardabweichung

≤µ≤

X+

c⋅S

n

1

(xi − x )2

∑

n−1

α

= 1 − - Fraktil der t

c=t

(n − 1) 2

(n − 1) − Verteilung

S = S2 =

Fraktil

approximatives Konfidenzintervall für unbekannte Anteile Æ StiPro aus dichotomer GG

KI mit unbekanntem Anteil

c ⋅ σˆ

KI ( p ) = X −

n

KI für den unbekannten Anteil p p =

Für jede

Stichprobenvariable

aus GG gilt:

Eigenschaften

c ⋅ σˆ

n

Grundgesamtheit

1 , Element hat Eigenschaft A

Xi =

0 , sonst

X i ~ Bin (1, p ) → E ( X ) = p

Schätzer

c =U

α

1−

2

Var ( X i ) = p ⋅ (1 − p )

σˆ = X ⋅ (1 − X )

1442443

Standardab weichung

der N (0,1) − Verteilung

α

= 1 − - Fraktil

2

standardisiert, approximiert

Länge und Größe

L = Vo − Vu

Statistik - Ferit Demir

X+

Element hat Eigenschaft A

pˆ = x ,

123

Fraktil

≤µ≤

c ⋅σ

= 2⋅

n

Seite

13

c ⋅σ

⇔ n = 2⋅

L

2

wiso.ferit.info

S T A T I S T I S C H E

T E S T S

Begriffe

Statistischer Test

Prüfgröße (V)

Vermutungen

Ablehnbereich

Verwerfungsbereich

folgende Situationen möglich:

Irrtümlich Ablehnung der NH

Irrtümlich Annahme der NH

Entscheidung für oder gegen die Nullhypothese anhand der StiPro

ZV zur Überprüfung der Nullhypothese H0 bei einem statist. Test

H0=Nullhypothese H1=Alternative

B ⊂ R = Menge mit der Eigenschaft

{V ∈ B ⇒ H

0

verwerfen

}

ablehnen | H0 wahr )

P(Fehler 1. Art)=P(H0

P(Fehler 2. Art)=P(H0 nicht ablehnen | H0 falsch)

1. Testproblem formulieren a H vs. H

0

Konstruktionsprinzip für alle

behandelten statistischen Tests

Æ in 5 Schritten

1

2. Signifikanzniveau bestimmen → α

3. Teststatistik berechnen → V = ?

4. Verwerfungsbereich bestimmen → Ablehnregel

5. Testentscheidung treffen → V ∈ B od. V ∉ B

Test auf µ bei bekannter Varianz (Gauß-Test)

Test mit unbekanntem

Erwartungswert und

bekannter Varianz

Entscheidungsregeln

für das Testproblem

mit Verwerfungsbereich

Punkte (1+2)

einseitiger Test

Punkt (3)

zweiseitiger Test

→ Erwartungswert µ und → Varianz σ

V = n⋅

X −µ

σ

2

H0

~ N (0,1)

1. H 0 : µ ≥ µ 0

vs. H 1 : µ < µ 0

2. H 0 : µ ≤ µ 0

vs. H 1 : µ > µ 0

3. H 0 : µ = µ 0

vs. H 1 : µ ≠ µ 0

H 0 ablehnen falls a V ∈ (− ∞ ; − U 1−α )

H 0 ablehnen falls a V ∈ (U 1−α ; ∞ )

H 0 ablehnen falls a V ∈ (− ∞ ;−U 1−α / 2 ) ∪ (U 1−α / 2 ; ∞ )

Test auf µ bei unbekannter Varianz (t-Test)

Test mit unbekanntem

Erwartungswert und

bekannter Varianz

Standardabweichung

Entscheidungsregeln

für das Testproblem

mit Verwerfungsbereich

Ho verwerfen fallsÆ

(Rest siehe oben)

Statistik - Ferit Demir

→ Erwartungswert µ und → Varianz σ

V = n⋅

2

X − µ H0

~ t (n−1)

S

S = S2 =

1

(xi − x )2

∑

n−1

(

)

2. a V ∈ (t (n−1) ; 1 − α ; ∞ )

1. a V ∈ − ∞ ; − t (n−1) ; 1 − α

α

α

3. a V ∈ − ∞ ;−t (n−1) ; 1 − ∪ t (n−1) ;1 − ; ∞

2

2

Seite

14

wiso.ferit.info

Tests auf unbekannte Anteile

unter Verwendung des zentralen Grenzwertsatzes

Faustregeln beachten

(Seite 11 unten)

Stichprobenvariable aus

dichotomer GG mit

unbekanntem Anteil p

Eigenschaften

V = n⋅

H0

X−p

~ approx. N (0,1)

p ⋅ (1 − p )

1 , Element hat Eigenschaft

Xi =

0 , sonst

X i ~ Bin (1, p ) → E( X i ) = p

Var( X i ) = p ⋅ (1 − p )

E( X i ) = p

⇒ pˆ = x ,

123

Var( X i ) =

Schätzer

Entscheidungsregeln

für das Testproblem

mit Verwerfungsbereich

identisch wie bei Test auf µ bei

bekannter Varianz

1. H 0 : p ≥ p0

vs. H 1 : p < p0

2. H 0 : p ≤ p0

vs. H 1 : p > p0

3. H 0 : p = p0

vs. H 1 : p ≠ p0

p ⋅ (1 − p )

n

H 0 ablehnen falls a V ∈ (− ∞ ; − U 1−α )

H 0 ablehnen falls a V ∈ (U 1−α ; ∞ )

H 0 ablehnen falls a V ∈ (− ∞ ;−U 1−α / 2 ) ∪ (U 1−α / 2 ; ∞ )

X2 – Anpassungstest (Chi-Quadrat)

Anpassungstest

X 1 ,K, X n StiPro aus GG mit K möglichen Realisation

(

i

K

(hi − n ⋅ pi )2

i =1

n ⋅ pi

V =∑

Begriffe

)

x1 ,.., xn und P X = x = p i = 1,K , K. Dann gilt für V :

i

i

~ approx.χ 2 (K −1)

H0

K = mögliche Realisatio n

hi = beobachtet e Anzahl → Datenreihe

Entscheidungsregeln

für das Testproblem

mit Verwerfungsbereich

Anmerkung

n ⋅ p i = erwartete Anzahl → p i = W ' keit

H 0 : pi = P (X j = xi ) , i = 1,K, K vs. H 1 : ¬ H 0

H 0 ablehnen falls a V ∈ ( χ 2 (K −1) ; 1 − α ; ∞

)

V ist approximativ χ 2 − Verteilt

Die Anpassung ist umso besser , je größer n ⋅ p ist.

i

Statistik - Ferit Demir

Seite

15

wiso.ferit.info

X2 – Unabhängigkeitstest (Chi-Quadrat)

- S K R I P T E N D E Dies ist kein offizielles Skript und erhebt somit keinen

Anspruch auf Vollständigkeit und Richtigkeit.

http://www.wiso.ferit.info

Mit freundlichen Grüßen

Ferit Demir

Statistik - Ferit Demir

Seite

16

wiso.ferit.info