Neuropsychologische Bedeutungstheorie - Ruhr

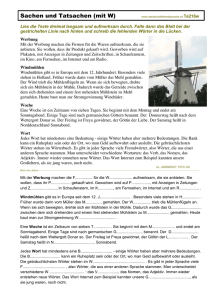

Werbung