Kapitel 2: Digitale Signale

Werbung

ZHAW, WCOM1, 7.2-1

Kapitel 7: Informationstheorie

2. Entropie

Inhaltsverzeichnis

2.1. INFORMATIONSQUELLEN ........................................................................................... 2

2.2. INFORMATIONSGEHALT .............................................................................................. 3

2.3. MINIMALE ANZAHL BINÄRE FRAGEN ......................................................................... 5

2.4. ENTROPIE VON DEUTSCHEM TEXT ........................................................................... 7

2.5. REDUNDANZ ................................................................................................................. 7

Literatur- bzw. Quellenverzeichnis

[1]

T. M. Cover, J. A. Thomas. Elements of Information Theory. John Wiley & Sons, 1991.

[2]

J. G. Proakis, M. Salehi. Grundlagen der Kommunikationstechnik. Pearson Studium,

2004.

ZHAW, WCOM1, 7.2-2

2.1. Diskrete Informationsquellen

Informations- oder Nachrichtenquellen generieren Signale, die Information tragen. Solche

Signale sind Zufallssignale und enthalten eine gewisse Ungewissheit, sonst wäre die Nachricht ja belanglos.

In Abbildung 2-1 ist eine diskrete Nachrichtenquelle dargestellt, die zu den diskreten Zeitpunkten t = nT die Symbole X[n] erzeugt. Dabei bezeichnet T die Symboldauer und R=1/T

die Symbolrate [Symbole/s] bzw. [baud] der Quelle. Die Quellensymbole X[n] können als

diskretes Zufallssignal (Zufallsprozess) oder als Folge von Zufallsvariablen aufgefasst werden.

diskrete

Quelle

..., X[-1], X[0], X[1], X[2], ...

Quellensymbole

Abbildung 2-1: Modell einer zeitdiskreten Informations- bzw. Nachrichtenquelle.

In diesem Kurs betrachten wir oft digitale Informationsquellen, deren Symbole X[n] M diskrete Werte im Alphabet A = {x1, x2, ..., xM} annehmen können und zwar mit der Wahrscheinlichkeit P(X=xm) = PX(xm), m=1,...,M.

Wir bezeichnen Zufallsvariablen mit Grossbuchstaben (z.B. X) und deren mögliche Werte

oder Ereignisse (z.B. xm) mit Kleinbuchstaben. Für die Wahrscheinlichkeitsverteilung von X

gilt:

M

P

X

(x m ) = 1

(2.1)

m=1

Im Folgenden betrachten wir ausschliesslich Quellen mit identischer Wahrscheinlichkeitsverteilung für alle Ausgangssymbole.

Eine Quelle, deren Symbole X[n] statistisch abhängig sind, hat ein Gedächtnis.

Beispiel

Eine Quelle für deutschen Text hat ein Gedächtnis, denn nach einem „q“ folgt höchstwahrscheinlich ein „u“. Nacheinander folgende Buchstaben, Wörter oder sogar Sätze

sind statistisch abhängig.

Gedächtnislose Quellen hingegen generieren statistisch unabhängige Symbole X[n].

Zur Erinnerung: Für zwei diskrete, statistisch unabhängige Zufallsvariablen X und Y gilt:

PXY(xi,yk) = PX(xi)·PY(yk)

(2.2)

Wir betrachten der Einfachheit wegen oft gedächtnislose Quellen und definieren die

folgenden drei Typen:

DMS (Discrete Memoryless Source)

Die Symbole X[n] sind unabhängig und haben identische Wahrscheinlichkeitsverteilung.

ZHAW, WCOM1, 7.2-3

BMS (Binary Memoryless Source)

Die unabhängigen Symbole X[n] sind 2-wertig, d.h. PX(x1) = p und PX(x2) = 1-p.

BSS (Binary Symmetric Source)

Die unabhängigen Symbole X[n] sind 2-wertig und es gilt: PX(x1) = 0.5 und PX(x2) = 0.5.

2.2. Informationsgehalt

Der Informationsgehalt eines Ereignisses X=xm ist wie folgt definiert:

1

IX (x m ) log 2

[bit]

PX (x m )

(2.3)

Für Ereignisse von 2 (oder mehreren) Zufallsvariablen X und Y gilt sinngemäss:

1

[bit]

I XY ( x i , y k ) log2

PXY ( x i , y k )

(2.4)

Die Definition des Informationsgehalts hat die folgenden, intuitiv einleuchtenden, Eigenschaften:

Seltene bzw. unwahrscheinliche Ereignisse tragen viel Information.

Beispiel

Jede Ziehung im CH-Zahlenlotto kann als zweiwertiges Symbol X einer BMS dargestellt

werden, wenn man sich nur für die Ereignisse „6er!“ und „wieder kein 6er“ interessiert.

Die Wahrscheinlichkeit für das Ereignis „6er!“ beträgt

PX(„6er!“) = (6/45)·(5/44)·(4/43)·(3/42)·(2/41)·(1/40) = 1 / 8145060,

denn im ersten Durchgang muss eine der 6 Zahlen auf dem Lottoschein aus den 45

Zahlen gezogen werden, im zweiten Durchgang eine der verbleibenden 5 Zahlen auf

dem Lottoschein aus den verbleibenden 44 Zahlen usw.

Das sehr seltene Ereignis „6er!“ hat einen Informationsgehalt von IX(„6er!“) = 22.96 bit,

während das sehr häufige Ereignis „wieder kein 6er“ nur einen Informationsgehalt von

IX(„wieder kein 6er“) = 1.77·10-7 bit aufweist.

Ein Symbol X trägt nur Information, wenn es mehrere Werte annehmen kann.

Für 2 unabhängige Symbole X und Y gilt: IXY(xi,yk) = IX(xi) + IY(yk) ,

wie man durch Einsetzen von Gleichung (2.2) in Definition (2.4) zeigen kann.

Beispiel

Eine „6“ beim Werfen des Würfels X hat den Informationsgehalt IX(„6“) =log2(6) =2.58 bit.

Eine Doppel-„6“ beim Werfen der beiden Würfel X und Y hat den Informationsgehalt

IXY(“6“,“6“) = log2(1/(1/36)) = 2·log2(6) = 2·2.58 = 5.16 bit .

ZHAW, WCOM1, 7.2-4

Die Entropie H(X) einer diskreten Zufallsvariablen X mit der Wahrscheinlichkeitsverteilung

PX(xm) ist wie folgt definiert:

M

1

H(X) PX (x m ) log 2

[bit],

m 1

PX (x m )

(2.5)

wobei 0·log2(0) = 0. Die Entropie H(X) ist ein Mass für die Ungewissheit der Zufallsvariablen

X oder, mit anderen Worten, H(X) ist ein Mass für die Information von X. Die Definition (2.5)

ist verwandt mit der Definition der Entropie in der Thermodynamik.

Beispiel „Zahlenlotto“ (Fortsetzung)

Die Entropie bzw. die Information von X beträgt H(X) = 3·10-6 und ist sehr klein, weil das

Ereignis „wieder kein 6er“ sehr, sehr häufig auftritt.

Beispiel von Abbildung 1-3 (Fortsetzung)

Die Symbole X[n] der ternären Quelle in Abbildung 1-3 tragen die Information

H(X) = 1/2·log2(2) + 1/4·log2(4) + 1/4·log2(4) = 1.5 bit / Symbol.

Der angegebene Quellencode erreicht eine durchschnittliche Kompression von 1.5 bit /

Symbol. Dieser Quellencode ist für die betrachtete Quelle also optimal, weil man deren

Symbole X[n] nicht mehr stärker komprimieren kann, ohne Information zu verlieren.

Die Entropie H(X) der Zufallsvariablen X ist keine Funktion von X, wie die Schreibweise nahe

legt, sondern eine Funktion der Wahrscheinlichkeitsverteilung PX(xm) von X.

Die Entropie H(X) entspricht dem mittleren Informationsgehalt E[IX(X)] aller möglichen Ereignisse xm einer Zufallsvariablen X, d.h.

H(X) = E[IX(X)].

(2.6)

Zur Erinnerung:

Der Mittelwert E[X] der diskreten Zufallsvariablen X entspricht dem gewichteten Durchschnitt von X und ist gegeben durch

M

E[X] PX (x m ) x m .

(2.7)

m 1

Der Mittelwert E[f(X)] einer Funktion der diskreten Zufallsvariablen X ist gegeben durch

M

E[f(X)] PX (x m ) f(x m ) .

(2.8)

m 1

Wenn man in Gleichung (2.8) nun f(X) = IX(X) setzt und für den Informationsgehalt die

Definition (2.3) verwendet, so sieht man mit der Definition (2.5), dass H(X) = E[IX(X)].

Man kann zeigen, dass

H(X) ≤ log2(M),

(2.9)

und dass dann und nur dann Gleichheit gilt bzw. H(X) maximal ist, wenn alle Ereignisse der

Zufallsvariablen X gleich wahrscheinlich sind, d.h. wenn gilt: PX(xm) =1/M für m=1,...M.

ZHAW, WCOM1, 7.2-5

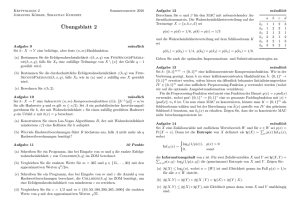

Beispiel

Die Symbole der binären, gedächtnisfreien Quelle (BMS) mit PX(0) = p und PX(1) = 1-p

tragen die Information

H(X) = h(p) = - p·log2(p) - (1-p)·log2(1-p) [bits].

(2.10)

wobei die Definition (2.5) und die Umformung log2(1/p) = -log2(p) benutzt worden sind.

In Gleichung (2.10) bezeichnet h(p) die binäre Entropiefunktion. Sie ist in Abbildung 2-2

grafisch dargestellt.

h(p)=0.811

h(p)=0.5

p=0.11

p=0.25

p=0.75

p=0.89

Abbildung 2.2: Binäre Entropiefunktion h(p).

Die binäre Entropiefunktion ist maximal, d.h. h(p) = 1 bit, wenn die beiden Ereignisse

„0“ und „1“ gleich wahrscheinlich sind, d.h. wenn p=0.5.

Die binäre Entropiefunktion h(p)=0 und damit minimal, wenn p=0 oder p=1 ist. Das macht

Sinn, weil in diesem Fall die Quellensymbole nicht zufällig sind und es keine Ungewissheit gibt, d.h. die Symbole entweder sicher „0“ oder „1“ sind.

Die binäre Entropiefunktion h(p) ist konkav und grösser gleich Null im interessierenden

Bereich 0 ≤ p ≤ 1. Man kann zeigen, dass das für jede Entropiefunktion H(X) gilt.

Für die Verbund-Entropie H(X,Y) von 2 (oder mehreren) Zufallsvariablen X und Y gilt sinngemäss:

1

[bit]

H ( X ,Y ) PXY ( x i , y k ) log2

i, j

PXY ( x i , y k )

(2.11)

ZHAW, WCOM1, 7.2-6

Die Verbund-Entropie H(X,Y) ist maximal, wenn

X und Y unabhängige Zufallsvariablen sind und

die möglichen Ereignisse von X und Y gleich wahrscheinlich sind.

2.3. Minimale Anzahl binäre Fragen

Bis jetzt ist die Definition der Entropie H(X) nicht weiter gerechtfertigt worden. Es gibt aber

tatsächlich einen Zusammenhang zwischen der Entropie und Antworten auf ganz natürliche

Fragen zur Information, wie wir in diesem Abschnitt an einem Beispiel sehen werden.

In Abbildung 2-3 ist eine diskrete, gedächtnislose Quelle (DMS) dargestellt, die 8-wertige

Symbole bzw. Ziffern X[n] im Alphabet A={1,2,3,4,5,6,7,8} generiert, wobei alle Ereignisse

gleich wahrscheinlich sind, d.h. PX(1) =...= PX(8) = 1/8. Aus Gleichung (2.5) oder (2.9) folgt,

dass jedes Quellensymbol X die Information H(X) = 3 bit trägt.

Die Information, die einem Beobachter durch das Erzeugen einer der 8 Ziffern geliefert wird,

könnte man mit verschiedenen Fragestrategien herausfinden. Im optimalen Fall müssten im

Mittel gerade 3 binäre Fragen zum Ziel führen.

X wobei A = {1,2,3,4,5,6,7,8} und PX(1) =…= PX(8) = 1/8

DMS

Abbildung 2-3: DMS mit 8-wertigen Symbolen.

Bei der ersten Strategie fragt man der Reihe nach, ob es sich um die Ziffer 1, 2, 3, usw.

handelt. Die „1“ tritt mit Wahrscheinlichkeit 1/8 auf und es braucht nur 1 Frage, um die Ziffer

zu erraten. Die „7“ tritt mit Wahrscheinlichkeit 1/8 auf und es braucht 7 Fragen, um die Ziffer

zu erraten. Die „8“ tritt mit Wahrscheinlichkeit 1/8 auf und es braucht auch 7 Fragen, um die

Ziffer zu erraten. Im Mittel sind also (1+2+3+4+5+6+7+7)/8 = 4.375 Fragen erforderlich, um

eine beliebige Ziffer zu erraten.

Optimal ist die folgende Strategie: Man bildet einen Entscheidungsbaum, indem man die

Menge der möglichen Ereignisse mit einer geschickten Frage sukzessive halbiert, siehe

Abbildung 2-4. Nach genau 3 Fragen ist man am Ziel.

ja

nein

x<5?

x<3?

x<2?

x=1

x<7?

x<4?

x=2

x=3

x<6?

x=4 x=5

x<8?

x=6

x=7

Abbildung 2-4: Fragestrategie mit binärem Entscheidungsbaum.

x=8

ZHAW, WCOM1, 7.2-7

2.4. Entropie von deutschem Text

Ein wichtiges Beispiel einer Informationsquelle ist deutscher Text. Im Folgenden betrachten

wir nur das Alphabet, das aus allen Grossbuchstaben und dem Zwischenschlag (30 Zeichen)

besteht.

Die Häufigkeit der Buchstaben ist alles andere als uniform. Am häufigsten ist neben dem

Zwischenschlag der Buchstabe „E“ (14.7%) und am seltensten sind die Buchstaben Q, X und

Y (~ 0.015%), siehe Tabelle 2-1.

A

B

C

D

E

F

G

H

I

J

0.04331 0.01597 0.02673 0.04385 0.14700 0.01360 0.02667 0.04355 0.06377 0.00165

K

L

M

N

O

P

Q

R

S

T

0.00956 0.02931 0.02134 0.08835 0.01772 0.00499 0.00015 0.06858 0.05388 0.04731

U

V

W

X

Y

Z

Ä

Ö

Ü

""

0.03188 0.00735 0.01420 0.00013 0.00017 0.01423 0.00491 0.00255 0.00580 0.15149

Tabelle 2-1: Relative Häufigkeit der Buchstaben im deutschen Text.

Die Entropie bzw. der mittlere Informationsgehalt beträgt H(X) = 4.1 bit / Zeichen.

Nutzt man die häufigen Buchstabenkombinationen und Silben aus, so ergibt sich sogar nur

ein mittlerer Informationsgehalt von 2.8 bit / Zeichen.

Codiert man über ganze Wörter, so trägt ein einzelnes Zeichen nur noch 2.0 bit Information.

Codiert man über ganze Sätze, so trägt ein einzelnes Zeichen nur noch 1.6 bit Information.

2.5. Redundanz

Die maximale Entropie bzw. die maximale Information einer Nachricht ist dann gegeben,

wenn die einzelnen Symbole der Nachricht gleichverteilt und statistisch unabhängig sind.

Jede Abweichung von der Gleichverteilung bzw. von der statistischen Unabhängigkeit

bewirkt eine Reduktion der Information der Nachricht.

Diese Verringerung der Entropie nennt man Redundanz R. Die Redundanz R einer diskreten

Zufallsvariablen X mit M Werten ist die Differenz zwischen der maximalen und der tatsächlichen Entropie, d.h.

R = log2(M) – H(X)

Beispiel

Die ternäre Quelle in Abbildung 1-3 weist die Redundanz

R = log2(3) - H(X) = 1.58 – 1.5 = 0.08 bit / Symbol

auf. Sie kann also noch komprimiert werden.

(2.12)