11. Grundlagen der Informationstheorie 11.1. Entropie

Werbung

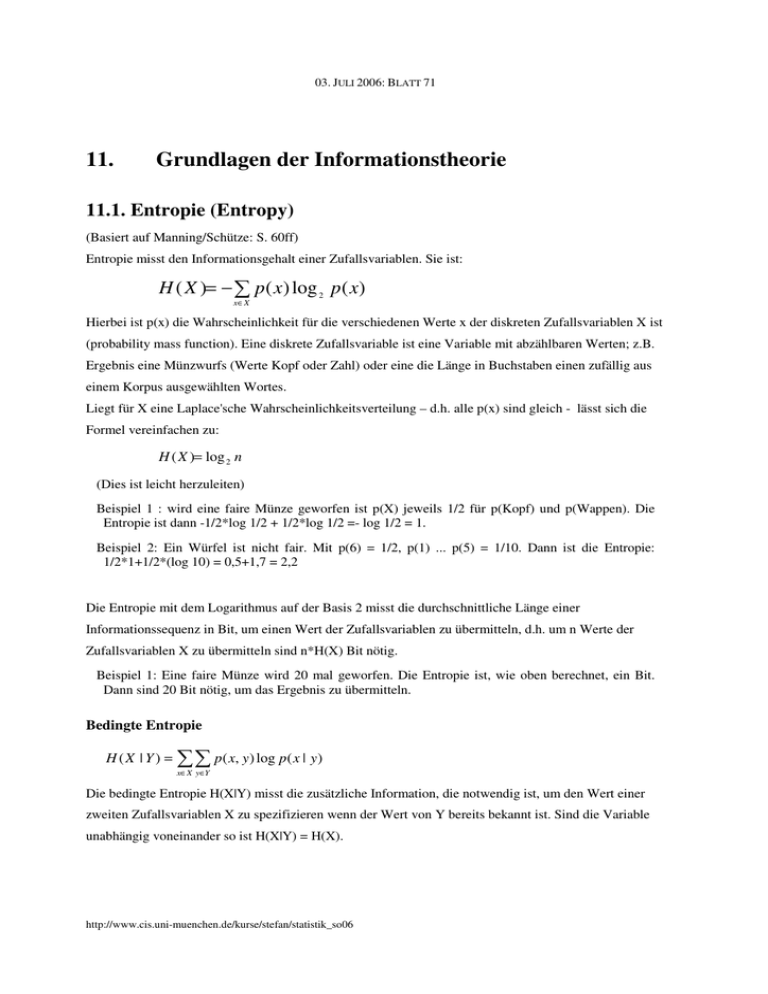

03. JULI 2006: BLATT 71 11. Grundlagen der Informationstheorie 11.1. Entropie (Entropy) (Basiert auf Manning/Schütze: S. 60ff) Entropie misst den Informationsgehalt einer Zufallsvariablen. Sie ist: H ( X )= − ¦ p ( x) log 2 p ( x) x∈ X Hierbei ist p(x) die Wahrscheinlichkeit für die verschiedenen Werte x der diskreten Zufallsvariablen X ist (probability mass function). Eine diskrete Zufallsvariable ist eine Variable mit abzählbaren Werten; z.B. Ergebnis eine Münzwurfs (Werte Kopf oder Zahl) oder eine die Länge in Buchstaben einen zufällig aus einem Korpus ausgewählten Wortes. Liegt für X eine Laplace'sche Wahrscheinlichkeitsverteilung – d.h. alle p(x) sind gleich - lässt sich die Formel vereinfachen zu: H ( X )= log 2 n (Dies ist leicht herzuleiten) Beispiel 1 : wird eine faire Münze geworfen ist p(X) jeweils 1/2 für p(Kopf) und p(Wappen). Die Entropie ist dann -1/2*log 1/2 + 1/2*log 1/2 =- log 1/2 = 1. Beispiel 2: Ein Würfel ist nicht fair. Mit p(6) = 1/2, p(1) ... p(5) = 1/10. Dann ist die Entropie: 1/2*1+1/2*(log 10) = 0,5+1,7 = 2,2 Die Entropie mit dem Logarithmus auf der Basis 2 misst die durchschnittliche Länge einer Informationssequenz in Bit, um einen Wert der Zufallsvariablen zu übermitteln, d.h. um n Werte der Zufallsvariablen X zu übermitteln sind n*H(X) Bit nötig. Beispiel 1: Eine faire Münze wird 20 mal geworfen. Die Entropie ist, wie oben berechnet, ein Bit. Dann sind 20 Bit nötig, um das Ergebnis zu übermitteln. Bedingte Entropie H(X | Y) = ¦¦ p( x, y) log p( x | y) x∈ X y∈Y Die bedingte Entropie H(X|Y) misst die zusätzliche Information, die notwendig ist, um den Wert einer zweiten Zufallsvariablen X zu spezifizieren wenn der Wert von Y bereits bekannt ist. Sind die Variable unabhängig voneinander so ist H(X|Y) = H(X). http://www.cis.uni-muenchen.de/kurse/stefan/statistik_so06 03. Juli 2006: Blatt 72 11.2. Die Mutual Information (Transinformation) Die Mutual Information I(X;Y) zweier Zufallsvariablen X und Y ergibt sich aus dem Differenz aus Entropie einer Variable H(X) und der bedingten Entropie H(X|Y). Also: I(X;Y) = H(X)-H(X|Y). Sind beide Variablen unabhängig, so ist sie 0; bei maximaler Abhängigkeit ist sie =H(X). Durch Umformung der obigen Formel ergibt sich: I ( X ;Y ) = p ( x, y ) ¦¦ p( x, y ) log p( x) p( y ) x∈ X y∈Y Als Mutual Information zweier Werte einer Zufallsvariablen (pointwise mutual information) wird folgender Wert bezeichnet: I ( x; y ) = log p ( x, y ) p( x) p( y ) Dieser Wert ist in der Computerlinguistik sehr beliebt, um die Korrelation eines Assoziationspaares von Wörtern zu messen (s.o.) Sprechstunde nach Vereinbarung