Visuelle Argumente

Werbung

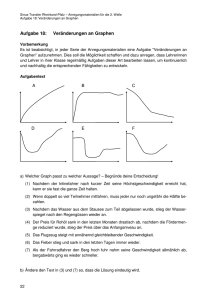

Dieter Mersch / Visuelle Argumente – Zur Rolle der Bilder in den Naturwissenschaften (Buch: Bilder als Diskurse – Bilddiskurse / Hg. S. Maasen u.a.) Dank auch an: Boris Nieslony / Kommentare (eingerückt) von G. Dirmoser (S.96) … Denn Visualisierungen behaupten, wie >visuelle Argumente< überhaupt, ihre außerordentliche Bedeutung im Diskursiven, ja sogar ihre prinzipielle Gleichwertigkeit im Prozess der Wissensgenerierung, wie auch Ludwig Wittgenstein, der wie kaum ein anderer Philosoph seine Überlegungen auf Skizzen, Modelle und Figuren stützte, in seinen Nachlassnotizen nahe legte: „Gibt es eine bevorzugte, etwa besonders unmittelbare Art der Abbildung? Ich glaube nein! Jede Art der Abbildung ist gleichberechtigt.“ (S.96) Beide – Visualität und Diskursivität – teilen sich dann das wissenschaftliche Feld mit Verfahren der Abtastung, Akustik, Numerik oder Statistik und dergleichen, wobei die diskursiven Verfahrensweisen an der Hervorbringung und Überprüfung von Wahrheitsansprüchen arbeiten, während den Bildprozessen die Produktion von Evidenz zufällt. Beide gehorchen somit unterschiedlichen Geltungsverfahren. (S.97) Allerdings sind die visuellen Strategien selber höchst disparat. Sie lassen sich heuristisch – wenn auch nicht scharf voneinander abgrenzbar – in zwei grundlegende Klassen einteilen, wozu freilich noch als weitere Klasse die ganz anders gearteten Präparate, die von Hans-Jörg Rheinberger so genannten >epistemischen Dinge<, hinzuzurechnen wären: Erstens solche Darstellungsweisen, deren wesentliche Funktion die Zeugenschaft ist und die das Visuelle als Beleg verwendet, sowie zweitens solche, die das Wissen auf abstrakten Tableaus anordnet oder es in Bezug auf eine zugrunde liegende Datenmenge in berechenbare Figuren verwandelt. Erstere verfahren referenziell; sie führen einen Existenbeweis, markieren eine Spur oder einen Abdruck, während letztere diagrammatisch oder >graphematisch< argumentieren, wobei das Format eine Skriptur oder >Zeichnung< ist, die einen konstruktiven Status einnimmt. (DG) Der ersten Gruppe wäre diverse mimetische Ansätze zuzuordnen, die in der Lage sind Spuren oder Abdrücke festzuhalten. Manche Spuren werden erst sichtbar, wenn zuvor Markierungstechniken angewendet wurden. Auch nachträgliche Markierungen können für die Lesbarkeit zentral sein. Bei selbstschreibenden Einrichtungen führt der Begriff der Spur auch zu graphematischen Ansätzen (vergl. selbstschreibende Messgeräte bei J. Watt). (S.97) Wir haben es folglich mit mindestens zwei disparaten Arten der Sichtbarmachung zu tun, die jeweils andere Zwecke erfüllen und damit auch anderen >Logiken< gehorchen. Man könnte einerseits von Repräsentationsverfahren im weitesten Sinne sprechen, sowie andererseits von >konstruktiven< oder >modellhaften< Visualisierungen, die zugleich >Schrift< und >Zahl< als basale Kulturtechniken aufrufen und damit als Hybride zwischen Notationalität und Ikonizität funktionieren. (S.98) Die Transformation berührte nicht nur die Wissenschaft selber, sondern auch die Bilder, die fortan dem Kriterium einer >mechanischen Aufzeichnung< zu genügen hatten: >Nichtintervention – und nicht Ähnlichkeit – war das Herzstück der mechanischen Objektivität.< Entsprechend traten die Apparate in den Vordergrund und entthronten das Herrschaftswissen der Künstler, die die Präzision ihres Auges an optische und andere Instrumente automatischer Registratur abtraten, um fortan das Sehen der Messung durch eine Maschine überlassen. Das bedeutet aber, dass das Bild tendenziell zur graphischen Inskription, zur Schrift gerät, die das Wirkliche so authentisch abzeichnen und wiederholen sollte und sogar den Fehler noch als Beglaubigungsmerkmal beibehielt. (S.98) …. Folglich war das Ideal der von ihnen erzeugten Bilder eine Entästhetisierung …. Diese Formulierung scheint mir sehr wichtig zu sein, weil der „Gestaltungswille“ auf ein Minimum reduziert wird. Die Farbwahl bei verwendeten Schreibern hat entweder gar keine Bedeutung, oder es werden unterschiedliche Datenquellen differenziert, oder ein Code definiert Maximalwerte und Minimalwerte, etc. Der Linienverlauf ist nicht eine Ausdrucksgeste, und auch die Linienstärke ist keine Duktusfrage (einer menschlichen Hand). Ähnlich wie bei technischen Zeichnungen, wird ein „neutraler“ Stil angestrebt. Vergl. Gespräch mit Katja Mayer zu Konzepten von Lothar Krempel (S.98) Gelangte so mit der Mechanisierung eine >graphematische< Struktur ins Bild, die sich ihm mittels aller möglichen technischen Instrumente wie Fotografie, Polygraphie, Phonographie, Tachistoskopie oder Phenakistiskopie und vieler anderer einschrieb, deren Namen und Funktion fast vergessen ist, bildete ihr Korrelat die Ausschaltung jeder Subjektivität, die tendenziell das Semantische auf das Syntaktische reduzierte. Die Semantikfrage ist weder in der Diagrammatik noch in der Graphematik geklärt. Mit der Semantisierung dinglicher Verhältnisse (Gamm zu Latour) könnte das Konzept der Semantik erweitert werden – zumindest so weit, wie es bei den Wissensbegriffen der Fall ist, die ja bereits weit über die Verbalsprachlichkeit hinaus reichen. An Ansätzen legen das auch Formulierungen wie „Sprache der Phänomene selbst“ nahe: (S.99) Wir haben es folglich mit einer grundlegenden Transformation, einem Platztausch zu tun, der das Ästhetische zugunsten von Technik und das Visuelle zugunsten exakter optischer und mathematischer Verfahren austrieb, deren Aufgabe zuletzt in der Dokumentation einer Spur oder eines Abdrucks bestand, worin sich, wie es hieß, der Pinelstrich der Natur oder die >Sprache der Phänomene selbst< bekundete . (siehe im Detail: Lorraine Daston, Peter Galison) Sie korrespondierte mit dem Beobachtungssatz im Experiment, jenem >Protokoll< als einfachem Datum, das seit Rudolf Carnap zur Grundlage der empirischen Wissenschaften überhaupt avancierte und dessen allgemeine Form >An der Stelle k befindet sich zum Zeitpunkt t ein x< Der einfachen Aufzeichnung eines Vorkommnisses im Bild aufs Genaueste entsprach. Kurz, das Schema der Visualisierung war die repräsentationale Schreibung auf der Basis aller erdenklichen Schreibgeräte und selbstregistrierenden Automaten, die Signale, Bewegungen, Reize und dergleichen in eine graphische Repräsentation übersetzten. Bezüglich dieser „Stelle k“ vergleiche auch die Überlegungen zur „Marke“ als Übersetzungsbegriff, zwischen Graphematik und Diagrammatik. (S.100) Abschnitt: Visuelle Epistemik Allerdings wurde die Debatte um Visualisierung und Bildlichkeit in den Wissenschaften bislang ohne Spezifik des Bildes geführt. Gehört dazu zum einen dessen besondere Ästhetik, zweitens seine >Logik< des Zeigens, die für die fehlende Syntax, insbesondere aber für die mangelnde Negation und die Nichthypothetizität des Visuellen verantwortlich ist, drittens seine saptiale Organisation, die im Bild die Form oder topologische Struktur auszeichnet, steht gleichzeitig das auf dem Prüfstand, was durch Bilder und deren Sichtbarmachung in den Wissenschaften überhaupt gewusst werden kann. Bzgl. der fehlenden Syntax sollte zu denken geben, dass sich lt. einer Theorie die Syntax aus Gebärden, also aus gestischen Konstellationen entwickelt hat. Wenn auch die Übertragung der verbalsprachlichen Syntax auf eine binnenkontextuelle Bildlogik nicht gelingen konnte, heißt das noch nicht, dass nicht auch die Objekt-Relationen eine gute Basis für eine Art Syntax abgeben könnten. (S.100/101) (… weiter) Klar ist, dass ein solches Wissen nicht ohne die Beziehung unterschiedlicher Visualisierungsstrategien zueinander diskutiert werden kann, wie denn auch Bruno Latour zu Recht bemerkt hat, das es >das Bild< in den Naturwissenschaften nicht gibt, sondern immer nur synchrone und diachrone Bildserien, die sich untereinander austauschen und allererst in Beziehung zueinander lesbar werden. Visualisierungen verweisen dann auf andere Visualisierungen, sowie – quer zu ihnen – auf diskursive Prozesse der Kontextuierung und Interpretation, worin Bild, Schrift und Zahl unablässig miteinander interagieren. Vergleiche dazu die Ansätze von Aby Warburg und meine Versuche 4000 Diagramme als Bildnetz aufzuschlüsseln. Vergleiche auch die Überlegungen von Ludwik Fleck. (S.101) (… weiter) Wir bekommen es dabei insbesondere mit verschiedenen Bildtypen zu tun, die einerseits durch die optischen Apparate oder andere Aufzeichnungsinstrumente generiert werden und deren semiotisches Format die >Spur< oder >Index< ist, andererseits mit den >abstrakten< Bildformen wie Graphen, Pläne, Modelle oder Diagramme, die weit eher Theorien ähneln als Abbildungen. Spannend, dass (über die Graphematik) neben der Reihe Pläne-Karten-Diagramme (Seite 97) nun auch Modelle und Graphen ins Spiel kommen. Vergleiche auch die Reihe bei N. Goodman: Karten-Diagramme-Modelle oder die Reihe bei meinen „Grundtypen“: Karte-Diagramm-Plan(Modell) (S.101) Weil unterschiedliche Datensätze derselben Codierung unterliegen und dieselben Datensätze mehrfach adressierbar erscheinen, zeigen sie sich auf der Ebene der Algorithmen als universell manipulierbar, so dass Visualisierungseffekte als Oberflächeneffekte entstehen. Die Sichtbarmachung gerät dann zum Gestaltungsprodukt von >Design<. Es lässt disparate Erscheinungen zu, insofern sich die gleichen Daten auch jeweils anders darstellen lassen und kein Kriterium existiert, das eine Darstellungsweise gegenüber der anderen privilegiert. Informationsdesign / Die Gestalt der Daten Vergleiche dazu C. Darwin und Zeitgenossen, die alle wichtigen Diagrammtypen durchprobierten, um die beste Visualisierung ihrer Fragestellungen zu erarbeiten. Je nach Denkkollektiv werden Methoden und Repräsentationstechniken tradiert, die dann über lange Zeitspannen beibehalten und gepflegt werden. (S.102) Wir haben es folglich mit keiner eindeutigen Sichtbarmachung mehr zu tun, keiner Stabilität im Bild, das etwas Bestimmtes darstellt, sondern lediglich mit Möglichkeiten, die ebenso unvereinbar nebeneinander bestehen können wie sie unterschiedliche epistemische Formen aufrufen, deren gemeinsamer Nenner ebenfalls ihre Berechenbarkeit ist. Im Denkkolletiv bekommt man im Laufe der Zeit einen „Blick“ für verwandte „epistemische“ Formen. Unüberschaubare Datenmengen werden so gewissermaßen „anschaulich“. Die verwendeten symbolisch/mathematischen Ausdrücke sind (zB. in der Atomphysik) oft so komplex, dass Effekte bestimmter Glieder u.a. in ihrer Wirkung als graphische Ausformung studiert werden (Vergl. Vortrag von Bernd Thaller im ZKM zum Elektron). (S.102) (…weiter) Weil außerdem am Anfang diskrete Daten stehen, die auf Messungen beruhen, die nicht notwendig optischer Natur sind, vielmehr nicht selten bereits auf theoretischen Abstraktionen und Rechnungen fußen, verwandelt sich ihr Bildliches- unter Abzug von dessen ästhetischer Qualität – dem Text an und nähert sich einer diskursiven Matrix. Ihr Material besteht aus Signalen, Impulsen oder Frequenzen, wobei es keine Rolle spielt, wie diese gewonnen werden, sondern bestenfalls, wie sie in elektromagnetische Wellen und von dort aus in Digitalcodes übersetzt worden sind, wobei ihre notationale Schreibung nicht vorgibt, ob sie anschließend visuell, akustisch oder in einem anderen Wahrnehmungsmodus modelliert und aufbereitet werden. (S.102) (…weiter) Im Unterschied zu klassischen Visualisierungsverfahren bildet darum kein genuin Sichtbares den Ausgangspunkt, um zum Bild zu werden, vielmehr >Informationen< im kybernetischen Sinne, welche erst am Ende der Kette in visuelle Parameter verwandelt werden. Als diskrete Entscheidungsmaße haben sie deshalb auch, selbst wenn sie optisch generiert wurden, einen anderen Status als visuelle Objekte. Zu ihrer Erzeugung kommen digitale Scanner und Sensoren zum Einsatz, die, wie im Falle der Enzephalographie, elektrische Ströme, oder im Falle der Rastertunnelmikroskopie, Orte gleichen Tunnelstroms messen, um sie in Graphen zu überführen, die zu >Scharen< aufsummiert eine dreidimensionale Struktur imitieren, die euklidischen Raumbildern zum verwechseln ähnlich sehen. Dann handelt es sich überhaupt um Graphen oder diagrammartige Strukturen, die anders betrachtet werden müssen als Bilder oder sichtbare Dinge. Zuweilen kommen kartographische Methoden ins Spiel, um ihnen eine Färbung zu geben, die freilich kein Sichtbares zeigen, sondern bestenfalls Richtungen, Verteilungen, räumliche Anordnungen oder Muster usw. zu erkennen geben. An anderer Stelle wurde schon angesprochen, dass die Graphematik den Blick der Diagrammatik auch in Richtung Materialität schärft. Für die komplexen materialen Oberflächen oder Binnenstrukturen (die zB. durch Schnitte, Brüche und Schliffe greifbar werden), kommen Begriffe Muster, Textur, Struktur, Anordnung, Körnung, Rauhtiefe, Gleichmäßigkeit, Gitter, Zellen, Inseln, Anhäufung, Häufung, Kapselung, Einschluß, Einfaltung, Verteilung, Verlauf, Dichte, Verdichtung, Ballung, Ansammlung, Nebel, Maserung, Streuung, Verbreitung, Ausdünnung, Sinterung, Klumpung, Sediment …. ins Spiel. Wenn die Materialität mit ins Spiel kommt, schein sich eine dritte Sicht (neben Diagrammatik und Graphematik) abzuzeichnen. Einerseits könnte man von einer Mikrophysiognomie sprechen und andererseits kommen geomorphologische Begriffe ins Spiel, so wie sie Deleuze (mit Cache) & Serres in ihren geophilosophischen Annäherungen verwenden. Auch die Beiträge von Sloterdijk haben da einiges zu bieten. Auf jeden Fall hat also die Materialität einen eigenen Formenschatz zu bieten. (S.102) (…weiter) Worauf sie auch immer referieren mögen, oder wovon sie >Spur< und >Abdruck< sind – sie enthüllen nichts Wirkliches, sondern bestenfalls Topologien und Relationen, die entsprechend auch nicht als Probe oder Beleg für >Etwas< fungieren, sondern unabhängig von ihrer Ästhetik als Abstrakta gelesen werden müssen, an denen Eigenschaften wie Symmetrie oder Strukturähnlichkeit usw. zählen. Folglich nehmen sie keinen repräsentationalen oder denotativen Status ein, sondern einen diagrammatischen oder >graphematischen<. Weit eher als dass sie als >Spuren< oder >Abdrücke< von etwas gelesen werden dürfen, handelt es sich um geordnete Syntaxen. Ihre epistemische Funktion beruht darum nicht im Existenzbeweis, der stets noch an Materialität haftet, sondern in der Modellierung einer geometrischen oder figuralen Struktur, die gänzlich immateriell bleibt. Aus dieser Sicht wären die Diagramme/Graphen also nicht nur a-semantisch, sondern auch a-material aufzufassen. Die Sicht der Ordnung zeigt sich dabei als „geordnete Syntax“, die je Methode und Aufgabenstellung sehr speziell ausfallen kann. Es ist also nicht von einer allgemeinen Graphensyntax oder Diagrammsyntax die Rede, sondern von problemspezifischen Ausformungen. (S.103) Abschnitt: Diagrammatik und spatiale Ordnung (S.103) Abzustecken wäre dann allerdings im einzelnen, was unter diagrammatischen bzw. >graphematischen< Visualisierungen zu verstehen ist. Gefaßt seien darunter zunächst sämtlichen syntaktischen Bildtypen, die auf diskreten Ordnungen basieren, also auch computergenerierte Visualisierungen, soweit sie der Strukturoder Mustererkennung dienen. Obwohl dieser Text von D. Mersch seinen Schwerpunkt in der Graphematik hat, wird dieser Begriff noch unter > < gesetzt. Wir gewöhnlich zwischen Karte, Plan, Diagramm und Modell und Graph unterschieden, differieren allerdings die Termini in verschiedenen Kontexten und Disziplinen und wechseln nicht selten die Seiten, sodaß einmal Graphen als >Kurvendiagramme<, ein andermal als logische oder mathematische Notationen als diagrammatische Formen, schließlich Netzpläne – wie in der Informatik – wiederum als Graphen bezeichnet werden. Vergl. dazu File „Begriffe.htm“ in der Diagrammatik-Studie (S.103/104) Zwar existiert noch keine allgemeine Theorie des Diagrammatischen – sie wäre erst zu schreiben – doch ist klar, dass in ihr skripturale wie ikonische Elemente aufeinander verweisen, und zwar so, dass logische oder relationale Beziehungen durch ein System visueller Parameter sichtbar gemacht werden können. Diagrammatiken bedeuten in diesem Sinne die Sichtbarkeit eines Denkens. Karten, Graphen, Netze und dergleichen bilden Hybride, an denen ihre >Schriftbildlichkit< auffällig ist, die Bedingung dafür ist, dass Diskursives als Ikonisches lesbar und Ikonisches als Diskursives sichtbar wird. Der Ausdruck >Hybridität< meint hier die beiderseitige Verschränkung von Skripturalität und Pikturalität, an der ihre Indifferenz eigentümlich ist, so dass Skripturales und Piktorales nicht als getrennte Parameter erscheinen, sondern eines im anderen und umgekehrt. Mit meiner Diagrammstudie möchte ich mit Hilfe der gewählten Matrix (Typ /vs/ Aspekt) zeigen, dass über 90% der Exemplare auch diagrammatische Hybride sind, also in der Regel Mischformen von Ordnungsfiguren zu Anwendung kommen. (S.104) (… weiter) Distinkte Zeichen oder logische Beziehungen zeigen sich dann entsprechend als Figuren oder räumliche Verteilungen, wie auf der anderen Seite – was freilich nur analytisch unterschieden werden kann – die Bildelemente als differenzierbare >Marken< funktionieren, die, wie die seit Platon währende Debatte über geometrische Formen bezeugt, >Idealisierungen< darstellen, die als solche >wiederholbar< sind und an denen vor allem Orte, Winkel und Proportionen relevant sind, nicht ihre je konkrete Gestalt. Vergleiche Überlegungen zum Begriffe der Marke (mit Derrida) - Link Bei Ludwik Fleck findet sich (im Buch: Entstehung und Entwicklung einer wissenschaftlichen Tatsache) ein spannender Ansatz zum Gestaltbegriff, der auch graphematisch fruchtbar gemacht werden könnte: (S.121) „Das unmittelbare Gestaltsehen verlangt ein Erfahrensein in dem bestimmten Denkgebiete: erst nach vielen Erlebnissen, eventuell nach einer Vorbildung erwirbt man die Fähigkeit, Sinn, Gestalt, geschlossene Einheit unmittelbar wahrzunehmen. … Solche Bereitschaft für gerichtetes Wahrnehmen macht aber den Hauptbestandteil des Denkstils aus. Hiermit ist Gestaltsehen ausgesprochene Denkstilangelegenheit.“ Jedes Denkkollektiv verständigt sich also gerade auch bei sehr abstrakten biologischen und physikalischen Erscheinungen über „relevante“ wiedererkennbare Gestalten. Der Begriff der Gestalt sollte also im Rahmen der Graphematik nicht zur Seite gestellt werden, so wie auch der Begriff der (wörtlich zu nehmenden) Denk-Figur in der Diagrammatik gute Dienste leistet. Siehe auch Plakat zu den Denkfiguren – Link Siehe auch Gestalt-findungen der Elektron-Forscher (ZKM-Vortrag) (S.104) Der Übergang von Bild zu >Schriftbildlichkeit< bedingt dabei eine Transformation von Figuralität zu Operationalität, wie der Übergang von Schrift zu >Schriftbildlichkeit< die Register der klassischen Linguistik verlässt, indem Skripturalität weniger der Aufzeichnung einer Sprache dient, sondern vielmehr einen eigenen, freien Strukturraum konfiguriert. Er fußt auf einer >spatialen Logik< aus einer Streuung von Punkten und ihren Relationen zueinander, Anordnungen, Häufungen, Richtungen oder metrischen Verhältnissen und dergleichen, die Zusammenfassungen zu Mustern, Stellungswechsel und andere räumliche Aktionen erlauben und dabei neue Ordnungen sichtbar machen, ohne auf rhetorische Tropen wie Metapher, Metonymie, Synekdoche oder Katachrese zurückzugreifen. Es stellt sich die Frage, ob nicht auch in den „fluidalen Strukturen“ quasi Figuren gesehen werden können. Die absolut gleichmäßige Verteilung, wäre immerhin noch als „Nebel“ begrifflich fassbar. „Häufungen“ heben sich im Nebel der gleichmäßigen Verteilung ab. Im Rahmen der Atmosphären-Bildstudie (mit 1600 Exemplaren) wird also den Ausformungen dieser diffusen und fluidalen Verhältnisse nachgegangen. Auch sollte zu denken geben, dass es im Rahmen der menschlichen Wahrnehmungsmöglichkeiten wenig sinnvoll scheint, zwei unvereinbare Ordnungsmuster-Komplexe zu unterscheiden. Jede Visualisierung komplexer Abläufe muß einige Schritte in Richtung fluider Repräsentationstechniken gehen. Der Diagrammgrundtyp „Faltungen“ scheint dabei eine wichtige Rolle als „formale Übersetzungshilfe“ zu spielen (zumindest als Einstiegshilfe für das Erfassen fluider Gebilde und Situationen). Weiters gilt es zu bedenken, dass mit diversen Strategien der Glättung, Formen ins Spiel kommen, die als komplexe Übergänge, komplexe Krümmungen, etc. angesprochen werden, also Physiognomien, die auch den Hintergrund für Deleuze und Cache bilden wenn sie von gekerbten und glatten Phänomenen sprechen. (S.105) (… weiter) Der Diagrammatik inhäriert damit eine eigenständige Form von Performanz. Es handelt sich um eine operative Performanz, die den Kern einer visuellen Argumentation ausmacht, soweit sie im >Schrift-Bild-Raum< Handlungen vollzieht, die Abhängigkeiten, Extremwerte, Isomorphien oder Ähnliches evident machen. Beruhen Schriften zudem, wie Nelson Goodman zu Recht betont hat, auf diskreten Notationen, verschiebt die >Schriftbildlichkeit< zugleich die Aspekte von den Zeichen und >Buchstaben< zu ihrer spatialen Lokalisierung und Ausbreitung. Interspatialität - Zwischenräumlichkeit (S.105) (… weiter) Ihr Kriterium ist folglich >Interspatialität<. Diagrammatische Strukturen visualisieren aufgrund solcher >Zwischenräumlichkeit<. Sie gestatten gleichzeitig, Beziehungen im Raum ebenso zu setzen wie auszulöschen und ihrer Matrix einen piktoralen >Sinn< abzugewinnen, der wiederum über die Diskretheit der Schrift hinausweist. Das bedeutet, Spatialität überhaupt als leitendes Prinzip des Diagrammatischen auszuweisen: Sie ermöglicht nicht nur, >Marken< zu unterscheiden, sondern durch Zuweisung verschiedener Stellen oder Plätze im Raum ebenso logische wie deiktische Funktionen abzubilden, die als topologische Strukturen sichtbar gemacht werden können. Siehe auch Kapitel: Diagramme als Zwischenschreibung Siehe auch Schema zur Rolle der Marke/Markierung (S.105) (… weiter) Aus ihnen lassen sich einige Grundlinien des Diagrammatischen ableiten. Zunächst bedarf es der Formatierung des Raumes, um Orte festzulegen sowie Metriken und Skalierungen vorzunehmen, die die Inskriptionen ein festes Bezugssystem einbinden, so dass als Grundbedingung jeder Diagrammatik der formatierte Raum fungiert. Er beruht sowohl auf der Einteilung relevanter Felder, Zonen oder Teilräume, worin die graphischen Elemente ihren Platz finden, als auch auf der Diskretierung des Raumes, der als eine Zuordnung der Daten und ihre Figurierung erlaubt. So bilden Kurven diskrete Anordnungen von Punkten im n-dimensionalen Raum, die durch Interpolation und andere Glättungsmethoden, d.h. durch Algorithmen, in Figuren überführt werden können. An der Figuralisierung lässt sich ablesen, was die zugrunde liegenden Rechnungen im Modus der >Zahl< nicht darzustellen vermögen. Figuralität und mithin Räumlichkeit fallen auf diese Weise eine unmittelbare epistemische Rolle zu. Zum Begriff der (Denk)Figuren und der Gestalt s.o. Die Methoden der „Glättung“ passen auch sehr gut zum Konzept der „Glätte“ (also zu komplex gekrümmten glatten Erscheinungen) bei Deleuze (S.106) (… weiter) Dabei werden die Unterschiede nicht als Differenzen zwischen >Marken< modelliert, so dass wir es nicht mit einem genuin diskursiven Schema zu tun haben, sondern als Unterschiede räumlicher Strukturen, so dass es sich um >spatiale Differentialitäten< handelt, die mittels Kontrasten, Lücken, Abständen oder nichtbesetzten Plätzen usw. arbeiten. Ihre Textur konstituiert jenen >visuellen Operationsraum<, der die Struktur visueller Argumentationen im wesentlichen als eine topologische ausweist. Allerdings kommen solche Argumentationen ohne Abschneidung ästhetischer Funktionen nicht aus. Es handelt sich also gleichsam um graphische Abbreviaturen oder Schemata, deren Basis >notationale Ikonizitäten< darstellen, die die Repräsentation >sytaktischer Strukturbildlichkeit< ermöglichen, wobei bemerkenswert ist, dass der Verbildlichung auf diese Weise logische Verhältnisse eingeschrieben werden können, die dem Bild sonst fehlen. (S.106) (… weiter) Man kann deshalb sagen, dass die diagrammatischen Hybride ein neues Genre bilden, das in einem strikten Sinne weder dem Bildlichen noch dem Schriftlichen angehört, auch nicht >zwischen< ihnen liegt, sondern Logik und Ikonik bzw. Visualität und Diskursivität miteinander verschränkt. Damit erfolgt eine klare Abgrenzung von (mimetischer) Bildlichkeit. Die Verknüpfung mit der Logik erfolgte ja bereits von Peirce vor hundert Jahren. Auf jeden Fall Verortung der Diagramme bei S. Krämer nun relativiert; sie hat ja die Hybridität in Bezug auf Text und Bild thematisiert. (S.106) (… weiter) Wissenschaftliche Visualisierungen, wie sie vor allem auf der Basis graphematischer Verfahren wie MRT, Röntgenspektrogramm, Sonden- und Tunnelrastermikroskopie usw. entstehen und digital aufbereitet werden, sind von dieser Art, weil sie ebenso Aussagen treffen, die richtig oder falsch sein können, wie sie deiktisch operieren. Sie übernehmen dabei unterschiedliche Funktionen wie Klassifikation, Sortierung, Typologie oder Rasterung, die gleichermaßen der Verdichtung und Bündelung von Daten und deren Dynamisierung dienen, wie sie gleichsam mit >Kartographien< konfrontieren, die auf paradoxe Weise etwas sichtbar machen ohne optisches Korrelat. (S.106) Abschnitt: Graphen und Bildlosigkeit der Mathematik Bestimmen demnach spatiale Ordnungen die Medialität des Diagrammatischen, konstituieren sie sowohl ein visuelles als auch diskursives Feld des Wissens. Vergl. das Buch: D. Mersch / Medientheorien – zur Einführung Das Kapitel zu N. Luhmann wirft die Frage auf, wie die Sichten zur Diagrammatik zum Begriff der Medialität stehen. „…. Sie denkt in Kombinationen, Ordnungen, Baukästen oder Strukturen, nicht in Materialitäten, woran sich ihr Ästhetisches erst manifestierte.“ Hier wird nun die spatiale Ordnung als zentrales Moment benannt. Medien stellen Repräsentationstechniken zur Verfügung, die idealerweise semantisch „neutral“ sein sollten. In der Diagrammatik sind es die spatialen Ordnungen, die als Trägermedien fungieren. Gerade auch in der Diagrammatik kann von a-semantischen (medialen) Dienstleistungen gesprochen werden. Diagramme sind also Medien, deren Medialität in spatialen Ordnungen fundiert ist. Wenn man bei komplexen Abläufen den zeitlichen Verlauf mit herein nimmt, dann scheinen Bezugnahmen auf Computersimulation und Film-Medien relevant zu sein. (S.106/107) Die dabei entstehenden Diagrammatiken erweisen sich jedoch als prinzipiell mehrdeutig, weil ihre Raumstrukturen unterschiedliche >Abzeichnungen< desselben Datenmaterials zulassen. Vergleiche die Nebelkammer als Medium – „.... es zeichnet sich etwas ab ....“ (S.107) Generell kann als diagrammatische Grundregel angenommen werden, dass die Eindeutigkeit des Wissens sich zum Grad der Ikonizität umgekehrt proportional verhält: Je mehr ikonische Elemente in die Darstellung eingehen, desto uneindeutiger wird sie, weil sie unterschiedliche Alternativen zulässt. Mit dem Grad der Ikonizität wird die „mimetische Bildlichkeit“ angesprochen. Nicht gemeint sind damit „Glättungen“ die zu physiognomisch lesbaren aber völlig abstrakten Figurationen führen. Es sind also Physiognomien mit organischem Hintergrund von den völlig abstrakten, komplex gekrümmten Figurationen zu unterscheiden. Formal gesehen sind aber Übergangsformen, also ähnliche Gestalten sehr wahrscheinlich. (S.107) (… weiter) Umgekehrt schneidet der Graphismus die Ambivalenz des Bildes ab. Das gilt im eigentlichen Sinne vor allem für Graphen als Untermengen von diagrammatischen Visualisierungen. Sie lassen (sich) gemäß der Graphentheorie als >mathematische Modelle für netzartige Strukturen< verstehen, die im wesentlichen durch zwei Arten von Objekten bestimmt sind, nämlich Orte (>Knoten<) und Verbindungen (>Kanten<). Siehe: Dialektik der Knoten und Kanten (S.107) (… weiter) Die Definition ist hinreichend allgemein, so dass alle Netzstrukturen aus Kombinationen beider Objekte hervorgehen; doch zeigen sie sich gegenüber ihrer visuellen Darstellung insofern als resistent, als allein ihre Strukturalität entscheidet, nicht ihre Ikonizität. Graphen zeichnen sich damit durch ihre weitestgehende Abstraktion von piktoralen Elementen aus, wobei die Tilgung der ästhetischen Mittel eine notwendige, nicht hinreichende Bedingung darstellt. Dies ergibt sich schon daraus, dass sie strukturell äquivalent sein können, auch wenn ihre piktoralen Darstellungen im einzelnen differieren. Isomorphie ist folglich eine Eigenschaft ihrer Syntax, nicht ihrer Bildlichkeit. Es ist also unerheblich, ob die Kante als Rohr, Stange, Ast, Rebe oder Kette dargestellt wird. Nur syntaktisch ausdefinierte Eigenschaften für die Gerichtetheit der Kante, der Beziehungsstärke und der Beziehungstype sind der Kern des Graphen. Der Rest ist eine Frage der Ausschmückung oder deutlicheren Lesbarkeit und auch der ästhetischen „Verspieltheit“. (S.107) (… weiter) Entsprechend erscheint ihre jeweilige Visualität mit Blick auf die dargestellten Netzstrukturen als irrelevant; vielmehr waren sie jenes Minimum an visueller Evidenz, wie es für die räumliche Anordnung der relationalen Schemata unerläßlich ist. Dabei folgt die Unabhängigkeit des Graphischen vom Ikonischen aus dem Vorrang der Mathematik, der Geltung der Bilder nicht Bedarf. Der Begriff der „Strukturalität“ im darüber liegenden Absatz gefällt mir besser, da er für Diagramme und Graphen funktioniert. Das mathematische Argument ist eher für die Graphen umfassender gültig; für bestimmte Diagramme geht mir die Formulierung zu weit, auch wenn die Graphentheorie jede Netzstruktur auch mathematisch erschließt. Auch mit der Begrifflichkeit der Logik kann man nicht jede Repräsentationstechnik umfassend abdecken (vergl. Expertensysteme und komplexe Datenbanken). (S.107) (… weiter) Zwar ist die Mathematik nicht bilderlos, wie der Streit zwischen Geometrie und Algebra belegt, doch fungieren die geometrischen Objekte selber nur als abstrakte Figuren, an denen nicht ihr >Aussehen< (eikon), sondern ihre formale Konstruktivität aus Zirkel und Lineal interessiert. Zudem hat die Algebraisierung der Mathematik seit Descartes und der Logik seit Bool den Einfluß des Geometrischen und damit auch Visuellen zurückgedrängt, so dass nicht das Piktorale das Graphische determiniert, sondern die jeweilige Vorschrift oder Regel. Dennoch sind auch Graphen, die seither die analytische Geometrie, Topologie oder Kombinatorik beherrschen, nicht ganz auf den Graphismus der Schrift rückführbar. (S.108) Zur Chaosmathematik .... (S.108) Ihre Strukturen treten figural hervor, so dass die vermeintlichen visuellen Erkenntnisse zuletzt auf figuralen fußen, die als Anzeigen fungieren, nicht schon als Beweise. Die Sichtbarkeit der Logik und die Visualität des Denkens finden daran ihre Grenzen. Sie beziehen sich auf Figuralität, nicht auf Bildlichkeit im eigentlichen Sinne. Der Begriff der Figuralität ist auch sehr gut geeignet eine Brücke zwischen der Diagrammatik und der Graphematik zu schlagen. Diese Begrifflichkeit fand auch für die Sammlung der 400 Denkfiguren (der Diagrammatik) ihre Anwendung. Ordnungsfiguren sind für unterschiedlichste Medien relevant und zeigen sich in Text, Bild und Zahl. Je nach Anwendungsbereich haben sich Figurationen unterschiedlichster Komplexität als brauchbar herausgestellt. Der Begriff der Figuralität ist für die „glatten“ und die „gekerbten“ Aspekte brauchbar. (S.108) (… weiter) Ersichtlich wird daraus, daß alle diagrammatischen Visualisierungen, insbesondere aber Graphen, um interpretiert werden zu können, der Konventionalität und Regelhaftigkeit bedürfen. Keine Wissenschaftsvisualisierung kommt ohne Legende oder diskursiven Kommentar aus. Nicht nur verweisen Schrift und Bild im Diagrammatischen aufeinander, sondern die Diagrammatik selber erfordert den Text, der sie deutbar macht. Welche Funktion das Ikonische innerhalb der Wissenschaften auch immer einnimmt – sei es al Skizze, Heuristik, Strukturdarstellung oder Wissensorganisation -, immer erfüllt es ein >Programm<, das durch den Diskurs noch beglaubigt werden muß. Modelle, Netze, Karten etc. gleichen daher Instrumenten, die, wie mechanischen, auf das gesamte szientifische Dispositiv bezogen bleiben. Insofern entmaterialisieren diagrammatische und graphematische Visualisierungen das Bildliche und beschränken es – anders als die Kunst, deren Darstellungen stets ins Materielle eingelassen bleiben – auf die Form. Diese Kette „Modelle, Netze, Karten“ paßt sehr gut in den dreischichtigen GrundtypenAnsatz >Karten, Diagramme, Modelle/Pläne<, wobei der Begriff Diagramm vermieden wird, der ja auch für das Ganze steht und durch jenen Typ ersetzt wird, der in größter Anwendungsstückzahl vorliegt. Außerdem wird der „stärkere“ Modell-Begriff dem Plan vorgezogen. Karten, Netze, Modelle Vergleiche auch die abgrenzende Diskussion von Diagramm und Dispositiv. Dieser Aspekt der Entmaterialisierung kann auch mit Hilfe des Medienschemas gut gezeigt werden. So sind es speziell 2 der 4 Eckpunkte im Schema, die für die Graphematik und die Diagrammatik wenig zu bieten haben (die Sicht der Zeichen und die Sicht der Materialiät). Die Sicht der Physiognomien ist ja zumindest für die Graphematik von Bedeutung. An anderer Stelle wurde besprochen, daß die Sicht der Materialität aber soweit relevant zu sein scheint, daß (mit Derrida) klassische >Zeichen< von >Marken< und Diagramme von Graphen unterscheiden werden könnten. Mit Kubler wurde (im Abschnitt: Verwendungssinn) bereits besprochen, daß man sich in einigen Bereichen auch analytisch wieder mehr auf die Form bzw. auf Form-Reihen konzentrieren sollte. Die Entwicklungen der Formen haben ihre eigene (außersprachliche) Logik, die es mit den Formen selbst zu zeigen gilt; umso mehr, als die Verbalbegrifflichkeit bei Formen kaum ausgestattet scheint. (S.108) (… weiter) >Aber was macht einen Plan zum Plan?<, fragt darum Wittgenstein, „d.h. was unterscheidet ihn von einem beliebigen Gekritzel? (...) Zu dem Plan gehört die Regel der Übersetzung (...). So ist der Plan offenbar ein nützliches Instrument. Und das rechtfertigt seine Untersuchung seiner Wirksamkeit/Funktion.“ Deswegen genügt es auch nicht, „um den Plan zu verstehen (...), dass ich diese Zeichnung sehe (...). Ich muß auch wissen, was es heißt, einem Plan zu folgen.“ In diesem Zusammenhang ist es spannend anzumerken, daß Astrit Schmidt-Burkhardt die Ebene des Planes (im Grundschema) als den „imperativen Zugang“ bezeichnet hat und die erste Grundzuordnung von Personen und Zeiträumen Wittgenstein (als zeichnenden Philosophen) als Idealbesetzung erscheinen läßt. (S.109) (… weiter) Doch ist damit zugleich ein grundlegendes Problem angezeigt. Denn Wittgenstein macht deutlich, dass diese Operation zuletzt bodenlos bleibt, weil sich kein Plan selbst erläutert. „Ich möchte sagen: einen Plan verstehen muß schon heißen, ihn anwenden“, wobei die Anwendung keiner weiteren Regel folgt, denn damit „würde wieder ein neuer Plan erzeugt, der der Erklärung so bedürftig wäre wie der erste.“ Das bedeutet: „Ich brauche keine weitere Abbildung, die mir zeigt, wie die Abbildung vor sich zu gehen hat, wie also die erste Vorlage zu benutzen ist, denn sonst brauche ich auch eine Vorlage, um mir die Verwendung/Anwendung der zweiten zu zeigen usf. ad infinitum. (...) Der Plan ist als Plan (...) nicht zu beschreiben.“ Im Abschnitt zum „Verwendungssinn“ bin ich auch an diese Grenze gestoßen, bzw. bei der Frage vom Anwendungswissen. Wir müssen bei relevanten Anwendungshandlungen dabei gewesen sein. Das können eigene Versuche sein, aber in der Regel sind diese Handlungen in die Kommunikation eines je relevanten Denkkollektives eingebettet. (S.109) (… weiter) Man müßte hinzusetzen: Graphen und diagrammatische Strukturen sind nicht selbsterklärend. Sie funktionieren eben nicht als Bilder, die etwas sehen lassen und sich im Zeigen erschöpfen, weshalb kein Hochtechnologiebild aus seiner Sichtbarkeit alleine entschlüsselbar wäre. Seine Lesbarkeit verlangt vielmehr noch der Theorie als Erklärungsrahmen, aus der es hervorgeht und ohne die es nicht existierte, so dass wir es mit einer Indiffrenz zwischen Argument und Instrument zu tun bekommen. (S.109) (… weiter) Abschnitt: Ontologisierung diagrammatischer Strukturen (S.109) (… weiter) Diese Indifferenz macht indessen den prekären Status der Wissenschaftsvisualisierung im Zeitalter des >errechneten Bildes< aus. An sie knüpfen sich zwei grundlegende Probleme, die die Frage, was sie darstellen oder worauf sie verweisen, prinzipiell unbeantwortbar machen. Der erste Instabilitätspunkt entsteht dadurch, daß das, was sie zu sehen geben, auf instrumentell erzeugten Datenmengen beruht, die erst vermöge graphischer Algorithmen in Bildpunkte übersetzt werden müssen. (S.110) Soweit jedoch das Sichtbare keinen Rekurs auf sein Ausgangsmaterial zuläßt, weil es nicht länger als dessen >Spur< oder >Abdruck< , sondern als >Information< fungiert, bleibt die visuelle Präsenz des Errechneten gegenüber seiner zugrunde liegenden technischen und algorithmischen Tiefenstruktur ein Oberflächliches, dessen Quellen verdeckt bleiben. Dazu finden sich im Buch >image & logic< von Peter Galison spannende Überlegungen zu zwei „Maschinen-Kulturen“ der Teilchenphysik. Für die eine Tradition ist der Begriff der Spur nach wie vor gültig (man will das physikalischen Ereignis als Spur festhalten). Mit Hilfe der Informatik sind nun beide Traditionen und auch Maschinentypen als Kombinationstechnik verfügbar, wobei die zweite Tradition (mit ihren logischen bzw. statistischen Ansätzen) in der Ergebnisvisualisierung bei der Anschaulichkeit der ersten Tradition profitiert. Siehe dazu Kap. 8 der Diagrammatikstudie (LINK). (S.110) (… weiter) Wir haben es hier zwar grundsätzlich mit jener Paradoxie zu tun, dass ein Medium sichtbar macht, ohne die Weise seiner Sichtbarmachung, d.h. auch seine Produktionsbedingungen und deren Dispositive, mit sichtbar zu machen, doch erzeugt diese Paradoxie in Bezug auf die technischen Bilder eine Opazität oder Intransparenz, die mit dem Grad der Programmierung wächst. (S.110) (… weiter) Die zweite Problematik ergibt sich aus den Verfahren des Computerdesigns und seiner digitalen Bildbearbeitung selbst. Denn durch spezifische Softwareangebote werden die diagrammatischen oder >graphematischen< Visualisierungen referenziellen Bildern zunehmend angeähnelt. ... (S.110) Hinzu kommen zahlreiche Interpolationsverfahren, die Datenlücken ausgleichen, sowie Methoden der Datenkompression, der Rauschunterdrückung, Glättung und Filterung, die die Bilder bereits auf der Programmstruktur modellieren. (S.110) Ihr wichtigster Punkt ist dabei die Einschreibung von Bildstilen und Wahrnehmungsgewohnheiten, die zwar den Visualisierungen seit je als imaginäre Verfahren implementiert wurden, die nunmehr aber zu den einschlägigen Tools der Softwarepakete selber gehören, so dass diese gar nicht mehr anders können als in die graphischen Bildproduktionen die perspektivischen Raster der Projektionsgeometrie, Fluchtpunktkonstruktionen, kohärente Licht- und Schattenwürfe, Objektumrisse, Farbgebungen, fließende Bildübergänge usw. einzutragen. ... (S.111) Mithin läßt sich eine Tendenz zur Einschreibung ästhetischer Regeln feststellen, die schon auf der Ebene des Algorithmus den abstrakten Bildern einen konventionellen Bildrealismus aufzuerlegen suchen. (S.111) (… weiter) Hier beginnt die >Ideologie< der Bildlichkeit, ihr impliziter Illusionismus. Er gemahnt an räumliche Objekte, deren Eindruck sich mimetischer Evidenzverfahren verdankt, die die Visualisierung nicht länger von der Diagrammatik her als Darstellung einer topologischen Ordnung oder eines Graphen versteht, sondern als Bild von Gegenständen mit eigener Identität und Kontur. Sie avancieren zu stabilen und damit erforschbaren Objekten in der Welt. Wir haben es also mit einer Transponierung von diskreten graphischen Strukturen zu ontologischen Entitäten zu tun, die mit dem Nimbus versehen sind, Eigenschaften zu besitzen und im Sichtbaren als verfügbare, veränderbare und bestimmbare Dinge aufzutreten. (S.111) Abschnitt: Unentscheidbarkeit der Referenz (S.111) Die digitale Bildbearbeitung impliziert damit eine Verdinglichung. Sie überführt kraft ihrer ästhetischen Vorentscheidungen diagrammatische Skripturen in mimetische. Der Haupteffekt gilt dabei der Verwischung der digitalen Zuordnung. Sie löscht die Schriftzüge der Graphen zugunsten eines analogen Scheins aus und verwandelt deren graphematische Ordnung in eine referenzielle. Dann erweist sich ihr epistemischer Status als prekär, weil keine eindeutige Trennungslinie mehr besteht. Eines der schlagensten Beispiele dafür sind die >Bilder< der Nanotechnologie. Diese zwei Sätze haben es in sich :) Wenn man sich das Medienschema in Erinnerung ruft, dann erfolgt hier eine Übersetzung von (quasi linearen) graphischen „Skripturen“ in komplex gekrümmte (mimetische) Physiognomien. Dies erinnert auch an die Unterscheidungen bei Deleuze: Linien die Punkte verbinden (Kerben) /vs/ Linien die komplexe Flächen zwischen Punkten aufspannen, also in ihren Bewegungen zwischen den Punkten Physiognomien abtasten bzw. ausformen (also die Punkte nicht nur einfach verbinden). Diese Übersetzung bringt die Ästhetik (lt. Mersch zwingend) mit ins Spiel, wobei ich es eher vorziehe die ästhetische Sicht als Parallel-Ebene darzustellen, da sie in allen medialen Hauptsichten (mehr oder weniger) eine Rolle spielen kann. Die digitale Bearbeitung/Verarbeitung bringt den analogen Schein ins Spiel. (Vergl. dazu die „digitalen Passagen“ von B. Siegert) Mit dem Begriff der Verwischung werden folgende Aspekte mit angesprochen: weg von diskreten Einheiten/Datenpunkten zu komplexen gekrümmten Oberflächen; weg von den digitalen Codes hin zu analogen Erscheinungen; weg von den coolen bits hin zu den atmosphärischen Verwischungen; weg von selbstbezüglichen Verwebungen hin zu referenziellen Ordnungen. Der Begriff der Verwischung erinnert auch an die „Diagrammatik“ (=Graphematik) bei F. Bacon (Siehe Text von Deleuze) Diese Verschiebung läßt auch die Konzepte von Saussure bzw. Frege bzgl. >Sinn und Bedeutung< wieder ins Spiel treten. Siehe dazu die Detailbetrachtungen (Link). Repräsentationstechnische Grundsatzentscheidungen und die Frage der „referenziellen Ordnung“ scheinen nun auch für die Diagrammfrage zentral zu werden. Kompliziert wird das nun hier noch dadurch, daß auch die Differenz zwischen mimetischen Bildern und Graphen entlang dieser Unterscheidung gedacht wird. Würde nun mit der Ästhetisierung der Diagramme/Graphen eine Referenzialität mit ins Spiel kommen? Aber welche „Informationen“ wird hier ästhetisch transportiert? Wenn einerseits die Materialität ausgeschaltet wurde, welche Aspekte bleiben nun fern ab von individuellen Ausdrucksgesten? Oder versucht man lediglich dem Wahrnehmungs- und Gedächtnisapparat ein paar erfassungs- und merktechnische Zugeständnisse zu machen? Genau genommen weiß ich noch nicht, ob es wirklich Sinn macht ästhetische Begrifflichkeit ins Spiel zu bringen. Streng codierte Farbentscheidungen führen zu jederzeit wiederholbaren Visualisierungen, die für ästhetisch gebildete RezipientInnen reizvoll oder gruselig sein können. Nur was heißt es wirklich, wenn nun Forscher (wie Lothar Krempel) beginnen die Farbskalen der jeweiligen Disziplin zu normieren? Was hat das mit (Kunst)Ästhetik zu tun, wenn sie mit Hilfe der bildenden Kunst Farbtafeln bzw. Sets definieren, die wahrnehmungstechnisch günstig sind und in unterschiedlichsten Kombinationen gut „harmonieren“ bzw. in der Wiedergabe von Datenmaterial optimal kontrastierend wirken. Auch wenn einzelne Softwareentwickler die Ästhetik nun für ihre graphematischen Visualisierungen bemühen, bin ich mir nicht sicher, der Ästhetik eine so wichtige Übersetzerrolle zugestehen zu können. Unser Wahrnehmungssystem kann gar nicht anders, als jede „ausdruckslose“ Diagrammgeste oder graphematische Geste auch ansatzweise „ausdruckshaft“ zu lesen (Vergl. dazu das Buch zur Anthropologie des Ausdrucks). So erscheinen bestimmte Graphen „energetisch expressiv“ zu sein, andere „minimalistisch“ etc. Zu den Visualisierungen in der Nanotechnologie (Pseudoschatten) würde ich sagen, daß es sehr schwierig ist feldhafte Erscheinungen zu visualisieren und man daher versucht ist, wahrnehmungstechnisch einfacher faßbare Entitäten auszuformen, auch wenn das der physikalischen Realität auf atomarer Ebene zuwiderläuft. Nur welche Visualisierungsansätze zeichnen ein besser faßbares Bild? Welcher Ansätze könnte aus anderen Bereichen übernommen werden? (S.112) Wie die Quantenmechanik jedoch zuletzt zu einer Undarstellbarkeit subatomarer Beziehungen gelangt, die sich nur mathematisch erschließen, bilden demgegenüber die nanotechnologischen Visualisierungen lediglich >Abbildungen< mathematischer Funktionen. Prinzipien der Identität, der Gestalt und Materialität, die einer >Sache< anhängen, werden hinfällig. (S.113) Wurden solche Unschärfen in frühen Veröffentlichungen bewußt beibehalten, so dass die Medialität der technischen Erzeugung als Spur reflexiv im >Bild< mitaufbewahrt wurde, setzte sich mit zunehmender technischer Perfektion und unter Rückgriff auf kommerzielle Softwarepakete ein Ideal der Glättung durch, das die Konstruiertheit der Sichtbarmachung zu überdecken suchte. Glättung und Unschärfe rücken als Begriffe immer mehr ins Blickfeld, wobei sie darstellungstechnisch nicht im Widerspruch stehen müssen. Fluidale, nebelige Ansätze können zu visuellen Glättungen führen, die nicht jede Unschärfe eliminieren. Coole metallische Anmutung /vs/ weiche nebelartig flüssige Übergänge (S.113) (… weiter) Entsprechend imitiert das Visualisierte eine kohärente Darstellung, die dem Sichtbaren eine Referenzialität auferlegt, so dass wir es mit einer grundlegenden Unentscheidbarkeit zwischen Denotat und Konstruktion zu tun bekommen. Unklar bleibt dann, worauf sich die Visualisierungen beziehen oder ob sie überhaupt >etwas< beschreiben, so dass zuletzt eine Instabilität zwischen diagrammatischen und referenziellen Bildverfahren entsteht. Die klare Kluft, die beide voneinander trennt, verliert entsprechend ihre Gültigkeit. Es ist diese Instabilität, die den Kern der epistemischen Problematik computergenerierter Wissenschaftsbilder ausmacht, gleichsam ihre immanente >Verblendung<, ihr denotativer Schein. Er impliziert einen Übergang vom Topologischen und Syntaktischen zur Indexikalität mit allen Attributen der >Spur<, des Belegs oder des Existenznachweises. Eigentlich ist hier der Übergang von einer Diagrammatik zur Graphematik bzw. zur fluidalen AnDiagrammatik beschrieben. Die Graphematik hatte ja zumindest seit J. Watt immer auch schon mit Spur (und der Sicht der Indexikalität) zu tun. D. Mersch beklagt hier aber sicher nicht diesen Übergang bzw. die Unterschiede zwischen Diagrammatik und Graphematik, sondern die mimetische Überzeichnung in der Graphematik. In Bereichen wie der Computertomographie wird die mimetische Verwandlung der Graphematik unproblematischer verlaufen, da ja die dargestellten Aspekte ja durchaus faßbare organische Realweltentitäten als Grundlage haben. Und die zerstörungsfrei Einsichtnahme ist der Vivisektion allemal vorzuziehen. (S.113) (… weiter) Nicht, dass solche >Bilder< auf nichts verweisen würden, doch ist der entscheidende Punkt, dass wir nicht mehr in der Lage sind zu entscheiden, was ein Index, ein Denotat ist und was Konstruktion oder Textur. Das sehe ich nicht so kritisch, denn zB. im Bereich der Medizintechnik wird die Software in der Praxis weiter entwickelt. Features und Darstellungsweisen, die im Rahmen der Diagnose unbrauchbar sind, werden kaum Chance auf Bestand haben. Umso mehr als die Softwarehersteller nur „Testprogramme“ und „Forschungssoftware“ liefern, um die Letztverantwortung nicht vom Mediziner auf die Maschine(inkl. Software) überantwortet bzw. übertragen zu bekommen. Vielen Dank an D. Mersch für diesen Text, der wieder einige wichtige Schritte in Richtung Graphematik und Diagrammatik setzen konnte.