Data Warehouse Referenz Architektur_Juni_2006

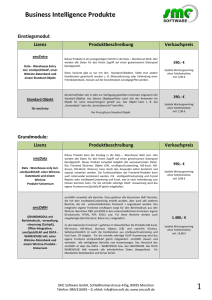

Werbung