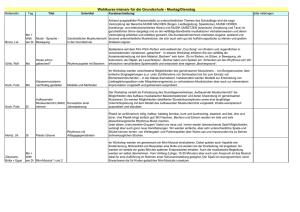

Spaltanlage - Messwiederholung

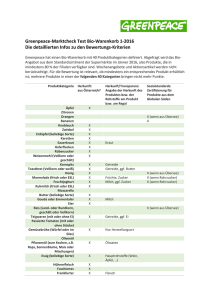

Werbung