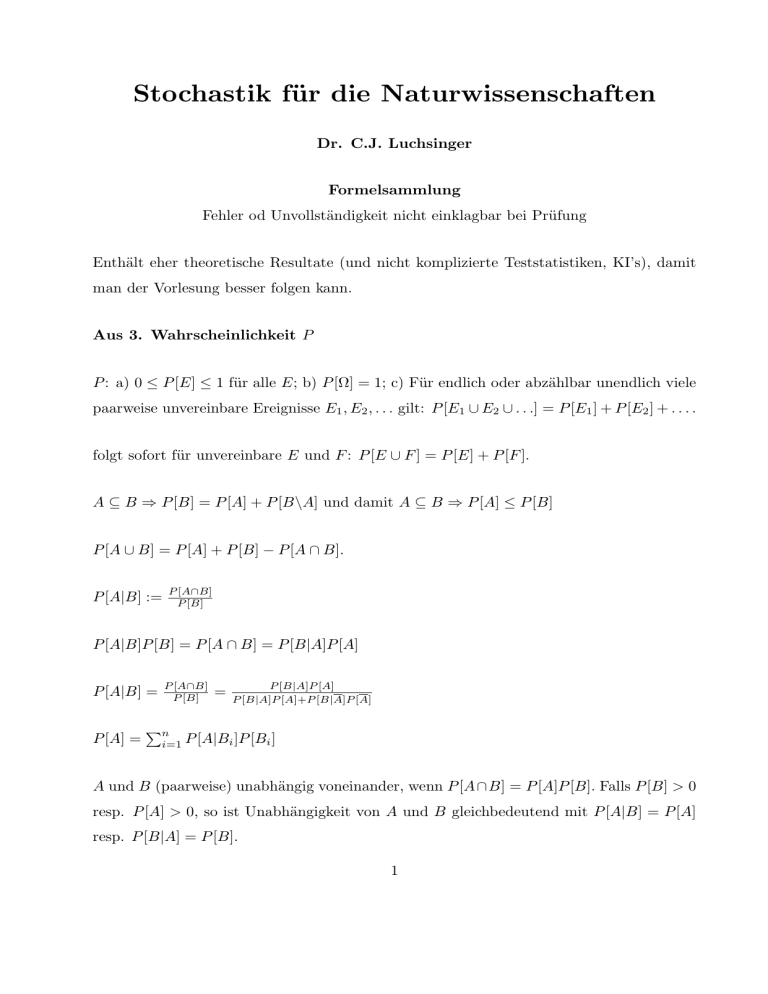

Formelsammlung

Werbung

Stochastik für die Naturwissenschaften

Dr. C.J. Luchsinger

Formelsammlung

Fehler od Unvollständigkeit nicht einklagbar bei Prüfung

Enthält eher theoretische Resultate (und nicht komplizierte Teststatistiken, KI’s), damit

man der Vorlesung besser folgen kann.

Aus 3. Wahrscheinlichkeit P

P : a) 0 ≤ P [E] ≤ 1 für alle E; b) P [Ω] = 1; c) Für endlich oder abzählbar unendlich viele

paarweise unvereinbare Ereignisse E1 , E2 , . . . gilt: P [E1 ∪ E2 ∪ . . .] = P [E1 ] + P [E2 ] + . . . .

folgt sofort für unvereinbare E und F : P [E ∪ F ] = P [E] + P [F ].

A ⊆ B ⇒ P [B] = P [A] + P [B\A] und damit A ⊆ B ⇒ P [A] ≤ P [B]

P [A ∪ B] = P [A] + P [B] − P [A ∩ B].

P [A|B] :=

P [A∩B]

P [B]

P [A|B]P [B] = P [A ∩ B] = P [B|A]P [A]

P [A|B] =

P [A] =

P [A∩B]

P [B]

∑n

i=1

=

P [B|A]P [A]

P [B|A]P [A]+P [B|A]P [A]

P [A|Bi ]P [Bi ]

A und B (paarweise) unabhängig voneinander, wenn P [A ∩ B] = P [A]P [B]. Falls P [B] > 0

resp. P [A] > 0, so ist Unabhängigkeit von A und B gleichbedeutend mit P [A|B] = P [A]

resp. P [B|A] = P [B].

1

Aus 4. Zufallsgrösse X

F (x) := P [X ≤ x] := P [{ω|X(ω) ≤ x}], wenn diskret noch F (x) = P [X ≤ x] =

∑

xi ≤x P [X = xi ]

Y stetig, wenn FY sich darstellen lässt als

∫

FY (a) := P [Y ≤ a] =

wo

∫∞

−∞

a

f (u)du

−∞

f (x)dx = 1

stetig: P [a < X ≤ b] = P [X ≤ b] − P [X ≤ a] = F (b) − F (a) =

stetig: P [X = x0 ] =

∫ x0

x0

∫b

a

f (x)dx

f (x)dx = 0

stetig: P [a ≤ X ≤ b] = P [a < X ≤ b] = P [a < X < b] = P [a ≤ X < b]

∫b

= P [X ≤ b] − P [X ≤ a] = F (b) − F (a) = a f (x)dx

stetig und F differenzierbar: F ′ (x) = f (x)

Jargon: unabhängig, identisch verteilt = independent and identically distributed (iid)

Aus 5. Erwartungswert E und Varianz V

Erwartungswert

Varianz

{∑

xi P [X = xi ]

E[X] := ∫ ∞xi

xf (x)dx

−∞

falls X diskret

falls X stetig

{∑

(xi − µX )2 P [X = xi ] X diskret

V [X] := ∫ ∞xi

(x − µX )2 f (x)dx

X stetig

−∞

Standardabweichung sd (Standard Deviation) ist die Wurzel aus der Varianz: sd[X] :=

√

V [X] ≥ 0

Linearität des Erwartungswertes

E[aX + bY ] = aE[X] + bE[Y ]; E[X + Y ] = E[X] + E[Y ], E[b] = b, E[0] = 0

2

V [aX + b] = a2 V [X] (”Konstante quadratisch raus”), zentral: V [aX] = a2 V [X]

V [X] = E[X 2 ] − (E[X])2

{∑

x2 P [X = xi ]

E[X ] = ∫ ∞xi i2

x f (x)dx

−∞

2

falls X diskret

falls X stetig

Varianz einer Summe bei Unabhängigkeit !

∑n

∑n

V [ i=1 Xi ] =

i=1 V [Xi ] (”Varianz der Summe ist die Summe der Varianzen”); insbesondere V [X + Y ] = V [X] + V [Y ]

Falls Xi iid, sodass E[Xi ] = µ und V [Xi ] = σ 2 , dann gelten die folgenden 3 Resulate:

I: E[X] := E

[ 1 ∑n

n

II: V [X] := V

III: sd[X] =

i=1

]

Xi = µ

[ 1 ∑n

n

i=1

]

Xi =

1 2

nσ

√1 σ

n

Beliebter Blödsinn: P [X], E[A], E[X = 3]

Aus 6. Ausgewählte Verteilungen

Diskrete Verteilungen

6.1.1 Bernoulli Be(p)

X kann 2 Werte annehmen: 0 und 1 (alternativ −1 und +1). P [X = 1] = p (Erfolg) und

P [X = 0] = 1 − p (Misserfolg). E[X] = p und V [X] = p(1 − p). Mit 0 ≤ k ≤ 1 haben wir

P [X = k] = pk (1 − p)1−k

3

6.1.2 Binomial Bin(n,p); Storrer Kapitel 38, 51.1

Xi , 1 ≤ i ≤ n, n iid Be(p). Y :=

∑n

i=1

Xi . Dann Y per Definitionem Binomialverteilung

mit Parametern n und p; Bin(n,p). E[Y ] = np und V [Y ] = np(1 − p). 0 ≤ k ≤ n:

( )

n k

P [Y = k] =

p (1 − p)n−k

k

Einsatz: Anzahl Erfolge (k) bei n unabhängigen Versuchen mit Erfolgswahrscheinlichkeit

p.

6.1.3 Geometrisch Ge(p); Storrer (37.12 b))

Xi , i ≥ 1, iid Be(p). Z := min{i|Xi = 1}. Z Zufallsgrösse auf den natürlichen Zahlen

ohne die Null. Z per Definitionem geometrische Verteilung Ge(p) mit Parameter p. Es

gilt: E[Z] = 1/p und V [Z] = (1 − p)/p2 .

P [Z = k] = p(1 − p)k−1

Einzige diskrete Zufallsgrösse, welche gedächtnislos: mit n > m > 0 gilt

P [Z > n|Z > m] = P [Z > (n − m)].

Geometrische Verteilung in gewissen Lehrbüchern so definiert, dass man Anzahl Misserfolge

bis zum ersten Erfolg zählt. Dann nimmt Ge(p) Werte auf den natürlichen Zahlen inklusive

0 an. Resultate analog aber leicht komplizierter.

6.1.4 Poisson Po(λ)

V poissonsch, wenn Sie Werte auf den natürlichen Zahlen inklusive 0 annimmt und zwar

mit folgenden Wahrscheinlichkeiten:

P [V = v] = e−λ

Es gilt: E[V ] = V [V ] = λ.

4

λv

.

v!

Stetige Verteilungen

6.2.1 Uniform U [a, b]

U per Definitionem auf [a, b] uniform verteilt, wenn U folgende Dichtefunktion hat:

f (u) = (b − a)−1 ,

wobei dann natürlich a ≤ u ≤ b zu gelten hat. Ausserhalb von [a, b] ist die Dichte gleich

null. Es gilt E[U ] = (a + b)/2 und V [U ] = (b − a)2 /12.

6.2.2 (Negativ-) Exponential Exp(λ)

Zufallsgrösse X mit Dichtefunktion

f (x) = λe−λx , x ≥ 0,

heisst exponentialverteilt mit Parameter λ; Exp(λ). E[X] = 1/λ, V [X] = 1/λ2 . Modell

für: radioaktiver Zerfall, ”wann geht Glühbirne kaputt?”, Zwischenzeit bei Ankunft von

KundInnen in einem Geschäft und vieles mehr.

Einzige stetige Zufallsgrösse, welche gedächtnislos:

t ≥ s, P [X > t|X > s] = P [X > (t − s)].

6.2.3 Normal N (µ, σ 2 )

Vorsicht: Storrer N (µ, σ), Luchsinger N (µ, σ 2 )

Dichtefunktion

(x−µ)2

1

f (x) = √

e− 2σ2 , x ∈ R,

2πσ

E[X] = µ und V [X] = σ 2 .

“Z-Transform”: X sei N (µ, σ 2 ), dann Z :=

X−µ

σ

5

ist N (0, 1)

6.2.4 χ2

(Xi )ni=1 iid N (0, 1), dann

n

∑

Xi2

i=1

χ2n -verteilt (sprich ”Chiquadrat mit n Freiheitsgraden” (degree of freedom, df)).

(Yi )ni=1 iid N (µ, σ 2 )-verteilt, dann

n

∑

(Yi − µ)2

σ2

i=1

χ2n -Verteilung. Ein wenig überraschend: Mit

n

∑

S :=

(Yi − Y )2 ,

2

i=1

wo Y :=

∑n

i=1

Yi /n, hat S 2 /σ 2 die χ2n−1 -Verteilung. E[χ2n ] = n; V [χ2n ] = 2n.

X sei χ2a , Y sei χ2b und X und Y unabhängig voneinander, dann W := X + Y χ2a+b .

6.2.5 F

U und V zwei unabhängige, χ2m -, bzw. χ2n -verteilte Zufallsgrössen. Dann

W :=

U/m

V /n

F -verteilt mit Parametern m, n: Fm,n .

E[W ] = n/(n − 2) (falls n > 2).

6.2.6 t

Y eine N (0, 1)-Zufallsgrösse und Z eine χ2n -Zufallsgrösse; Y unabhängig von Z.

Y

Tn := √

Z/n

6

Student-t-Verteilung mit n df. Es gilt E[tn ] = 0 (falls n > 1 und falls n = 1 existiert der

√

Erwartungswert nicht), V [tn ] = n/(n − 2), sobald n > 2.

F1,n = |tn |. X1 , X2 zwei iid

N (0, 1)-Zufallgrössen, so ist X1 /X2 ebenfalls t1 -verteilt. t∞ = N (0, 1).

Summen von Zufallsgrössen

n

∑

Be(p) = Bin(n, p)

1

n

∑

n

∑

Bin(ni , p) = Bin(

ni , p)

1

1

Summe Normal ist Normal (Summanden müssen nicht mal identisch verteilt sein)

n

∑

N (µi , σi2 )

n

n

∑

∑

= N(

µi ,

σi2 )

i=1

i=1

i=1

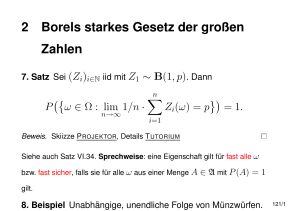

Aus 7. n → ∞ (Konvergenz, LLN, CLT)

[ ∑n

CLT: P

k=1

√

Xk −nµ

nσ

]

≤ a −→ P [N (0, 1) ≤ a]

Aus 8. Schätzen von Parametern und Konfidenzintervalle

2

X1 , . . . , Xn iid N (µ, σ 2 ), dann hat X eine N (µ, σn )-Verteilung

95 % KI f µ bei bekanntem σ 2 , Daten x1 , . . . , xn in Modell N (µ, σ 2 ) ist: [x −

1.96σ

√ ,x

n

+

1.96σ

√ ].

n

√ σ̂ , x +

95 % KI f µ bei unbekanntem σ 2 , Daten x1 , . . . , xn in Modell N (µ, σ 2 ) ist: [x − CV

n

√

∑n

CV

1

2

√ σ̂ ] wo σ̂ :=

i=1 (xi − x̄) .

n−1

n

Aus 10. ANOVA/Regression

Auf dem Weg zur Fundamentalgleichung der Varianzanalyse:

∑nj

µ̂j := Ȳ.j :=

i=1

Yij

nj

7

∑k

GM =

∑k

∑nj

i=1 (Yij

j=1

j=1

nj Ȳ.j

∑k

j=1

=

n

− GM )2 =

∑nj

∑k

i=1

i=1 (Ȳ.j

− GM )2 +

∑nj

∑k

Yij

nj

n

∑nj

j=1

nj

=

∑k

j=1

i=1

j=1

Yij

n

∑nj

i=1 (Yij

− Ȳ.j )2 .

∑k

nj (Ȳ.j −GM )2 /(k−1)

.

V := ∑k j=1∑nj

2

j=1

i=1

(Yij −Ȳ.j ) /(n−k)

Regression

Yi = β0 + β1 xi + ϵi

SSE :=

SSR :=

SSxx :=

SSyy :=

SSxy :=

∑n

2

i=1 (yi − ŷi ) :=

∑n

i=1 (ŷi

∑n

i=1 (xi

∑n

i=1 (yi

∑n

i=1 (xi

∑n

i=1 (yi

− (β̂0 + β̂1 xi ))2

− ȳ)2

− x̄)2 =

− ȳ)2 =

∑n

i=1

∑n

i=1

x2i − nx̄2

yi2 − nȳ 2

− x̄)(yi − ȳ) =

∑n

i=1

xi yi − nx̄ȳ

SSyy = SSR + SSE, also

∑n

i=1 (yi

β̂1 =

− ȳ)2 =

SSxy

SSxx

∑n

i=1 (ŷi

− ȳ)2 +

∑n

i=1 (yi

und β̂0 = ȳ − β̂1 x̄ sowie σ̂ 2 :=

− ŷi )2

1

n−2

8

∑n

2

i=1 ei

(10.2)