Mitschrift 2008/09 - Universität Konstanz

Werbung

Statistische Datenanalyse

Mitschrift W

S 2008/2009

Sitzung 1

Zur Klärung einer bestimmten Fragestellung werden in wissenschaftlichen Untersuchungen Daten

über den interessierenden Gegenstandsbereich gesammelt und zur weiteren Verarbeitung nach

bestimmten Regeln geordnet.

Die Daten können durch Fragebögen, Beobachtungen oder Experimente gewonnen werden.

Der Gegenstandsbereich sollte klar umgrenzt und bestimmt sein.

Die Objekte dieses Gegenstandbereiches, über die Aussagen formuliert werden sollen, werden als

Untersuchungseinheiten (UEen) bezeichnet.

Dies sind zum Beispiel Versuchspersonen, Gruppen, Länder, Firmen, Organisationen, etc.

Entsprechend der Fragestellung sollen bestimmte Eigenschaften oder Aspekte der UE untersucht

werden. Zum Beispiel Alter, Schulform, IQ, Ausgaben pro Jahr, Managergehälter,

Spendeneinnahmen, etc.

Diese Aspekte werden als Merkmale bzw. Variablen bezeichnet.

Die Menge aller möglichen Realisierungen eines Merkmales nennt man

Merkmalsausprägungen bzw. Werte der Variablen.

Die im Versuch realisierten Einzelergebnisse jeder UE werden systematisch beobachtet und

protokolliert. Zum Beispiel ist eine Realisierung des Merkmals 'Alter' eines Studenten in einer

Untersuchung das Alter 25, die Realisierung der Schulform Hochschule, etc.

Die Merkmale müssen so konzipiert sein, dass jede UE genau eine einzige Merkmalsausprägung pro

Merkmal hat.

Die gesammelten Daten können dann in Form einer Matrix angeordnet werden, wobei pro Zeile eine

UE und pro Spalte ein Merkmal aufgeführt wird.

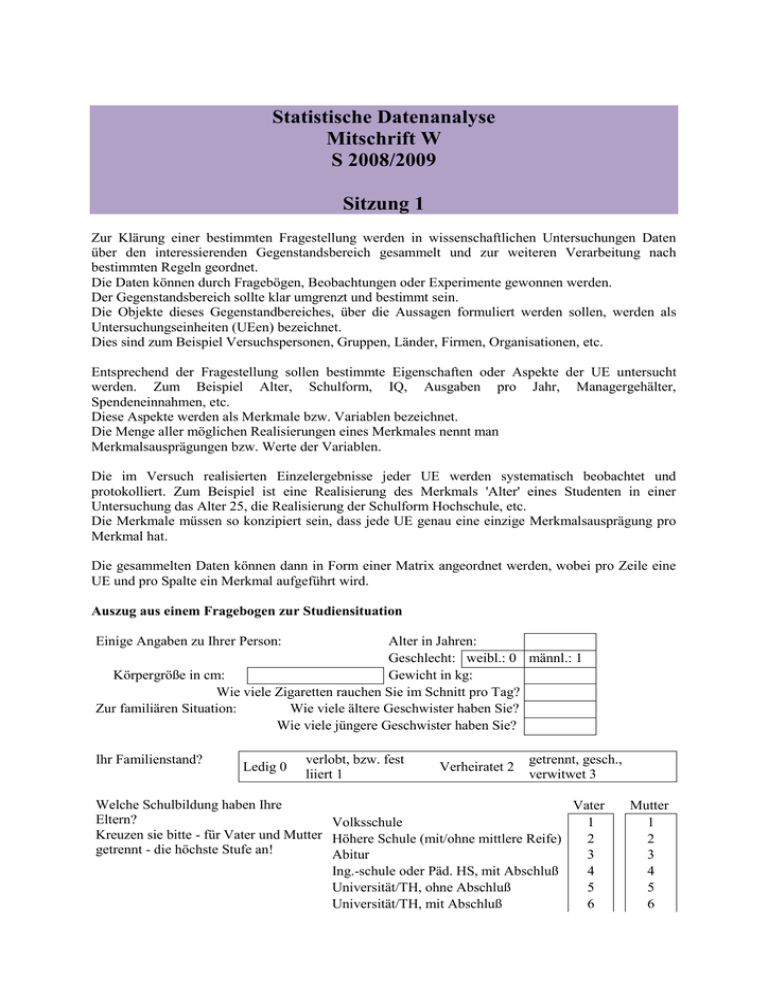

Auszug aus einem Fragebogen zur Studiensituation

Einige Angaben zu Ihrer Person:

Alter in Jahren:

Geschlecht: weibl.: 0 männl.: 1

Körpergröße in cm:

Gewicht in kg:

Wie viele Zigaretten rauchen Sie im Schnitt pro Tag?

Zur familiären Situation:

Wie viele ältere Geschwister haben Sie?

Wie viele jüngere Geschwister haben Sie?

Ihr Familienstand?

Ledig 0

verlobt, bzw. fest

liiert 1

Verheiratet 2

getrennt, gesch.,

verwitwet 3

Welche Schulbildung haben Ihre

Vater

Eltern?

Volksschule

1

Kreuzen sie bitte - für Vater und Mutter Höhere Schule (mit/ohne mittlere Reife)

2

getrennt - die höchste Stufe an!

Abitur

3

Ing.-schule oder Päd. HS, mit Abschluß

4

Universität/TH, ohne Abschluß

5

Universität/TH, mit Abschluß

6

Mutter

1

2

3

4

5

6

Sonstiges, weiß nicht

7

7

Bei einem exklusivem Antwortmuster (z.B.Geschlecht/Wohnform) kann eine Spalte angelegt werden,

in der die unterschiedlich kodierten Ausprägungen (z.B. 0/m für männlich, 1/w für weiblich) notiert

werden.

UE Alter Sex Größe

1

..

24

m

182

Gewicht Anz.

Anz.

Zigarett. jünger.

Geschwister

80

8

--

Anz.

älterer

Geschw.

2

Fam.

stand

Bildung Bildung

Vater

Mutter

Ledig

4

3

In einer Spalte darf nie mehr als eine Information verzeichnet werden.

Manchmal werden die UE auch kontrollierten Behandlungen (Treatments) ausgesetzt.

Ein Beispiel für dieses zentrale Element des Experimentierens findet sich im Alten Testament im

Buch Daniel (1. Kap.).

Daniel und seine Freunde (Ananias, Misael, und Azarias) sind als jüdische Jugendliche vornehmer Herkunft während der babylonischen

Gefangenschaft an den Hof Nebukadnezars verschleppt worden.

Sie erhalten dort eine babylonische Erziehung und bekommen das gleiche Essen wie der König. Daniel und seine Freunde würden allerdings

lieber streng jüdische Essensvorschriften einhalten; sie wollen auf das dargebotene Fleisch und den Wein verzichten. Sie wenden sich mit

dieser Bitte an den Oberkämmerer. Seine Bedenken bezüglich der Schönheit und Vollheit der Freunde kann Daniel durch ein Experiment zerstreuen.

Aufgrund des folgenden Berichtes sind zwar die Ergebnisse des Experimentes nicht exakt bekannt. Dem Bericht würden die folgenden Daten

zumindest nicht widersprechen (Schönheit und Vollheit seien auf einer Skala mit 5 Stufen gemessen worden).

Da sprach der Oberkämmerer zu Daniel: „Ich fürchte meinen Herrn, den König, der euch Speis und Trank bestimmte. Fänd er, dass euere

Gesichter schmächtiger als die der anderen Knaben eueres Alters wären, so brächtet ihr beim König mich um meinen Kopf“. Darauf sprach

Daniel zum Wächter, den der Oberkämmerer über Daniel, Ananias, Misael und Azarias gesetzt:

„Versuch es bitte doch 10 Tage lang mit deinen Knechten. Man gebe uns nur Gemüse zu essen und Wasser zu trinken. Besieh dir dann

unsere Gesichter und die der anderen Knaben, die von der königlichen Kost genießen. Und je nachdem, wie der Befund ausfällt, magst du

mit deinen Knechten verfahren“.

Nach Ablauf der 10 Tage aber waren ihre Gesichter sichtlich schöner wie auch voller als die aller anderen Knaben, die von königlicher

Speise zu genießen pflegten. So ließ fortan der Wächter ihre Speise wegnehmen mitsamt dem Wein, den sie genießen sollten; er brachte

ihnen dafür nur Gemüse. (AT Daniel, 1. Kap:, Vers 10-16)1

6

M

D

4

Az

An

Schön

schoen4

5

3

3

6

2

1

4

1

5

2

D

0

0

1

2

3

voll4

Voll

4

5

6

Datenmatrix

1. UE

2. UE

3. UE

4. UE

5. UE

6. UE

7. UE

8. UE

9. UE

10. UE

name

1

2

3

4

5

6

Daniel

ananias

azarias

misael

gruppe

control

control

control

control

control

control

exp

exp

exp

exp

Schoen

2

1

3

2

1

2

5

4

4

5

Voll

3

3

2

2

2

1

5

5

4

4

Die Datenpunkte können in die Form einer Datenmatrix übertragen werden mit den Merkmalen Schön

und Voll. Als weitre Merkmale werden noch der Name der Versuchsperson (=Vp) und die

Gruppenzugehörigkeit zur Experimental- bzw. Kontrollgruppe eingeführt.

Da eine zufällige Zuordnung der VP in diesem speziellen Falle nicht möglich war, interessiert die

Frage, ob der Unterschied zwischen den Gruppen in Vollheit und Schönheit schon vor der Behandlung

bestanden hat, bzw. wie die Behandlung über den untersuchten Zeitraum verlaufen ist.

Der gefundene Unterschied könnte also nicht durch das Treatment entstanden sein, sondern von einer

anderen Variable abhängig sein.

Zum Zwecke der Überprüfung dieser Möglichkeit können Messungen an Tag 1,4,7 und 10 der

Untersuchung bzgl. der Vollheit und Schönheit durchgeführt werden.

Die erhaltenen Daten können auf zwei Arten gruppiert werden – in der horizontalen Form, die auch als

Bei solch einem Vorgehen muss die Abhängigkeit der Messungen beachtet werden.

UE in Zeitreihenanalysen sind nicht unterschiedliche ‘Entitäten‘ (Versuchspersonen, Organisationen

etc.) sondern verschiedene Zeitpunkte.

Die Messungen einer Person zu verschiedenen Zeitpunkten sind voneinander nicht völlig unabhängig

(wie in unverbundenen Stichproben, in denen die UEen verschiedene Versuchspersonen sind).

Zur Behebung dieses Problems kann eine Personenvariable eingeführt werden, die interindividuelle

Unterschiede vergleichbar machen lässt. (z.B. Korrektur durch die Varianz).

Weitere Datenstrukturen, die Abhängigkeiten enthalten, sind

Mehrebenendatensätze (Land - Bundesland - Schule - Klasse - Lehrer)

und Netzwerke.(z.B. Interaktionen zwischen VP oder Gruppen)

Auch ein Buch kann als Datenstruktur mit mehreren Ebenen bezeichnet werden

(Kapitel - Unterkapitel - Paragraph - Absatz - etc. )

1.2 Zusammenfassung zur uni- und bivariaten Statistik

Variablen

1

2

Deskription

Verbal

Grafisch

Lagemaße

Histogramme

Streuungsmaße etc.

Boxplots

Kovarianz

Korrelation

2-Test

auf Unabhängigkeit

PRE-Maße

Regressionsanalyse

Streudiagramm

Mosaicplots

Induktion

, , ,...

- Anpassungstest,

Mittelwertstest etc.

,

Hat eine der Variablen distinkte Ausprägungen (z.B. Geschlecht), kann das 3dimensionale

Streudiagramm auf zwei Dimensionen abgebildet werden.

Meist wird die 3. Variable als Kontrollvariable eingeführt, um Scheinkorrelationen oder ScheinNichtkorrelationen ausschließen zu können.

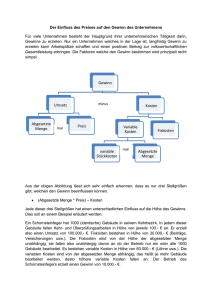

Würde man etwa den Zusammenhang zwischen

der Variable „Anzahl gegessener Äpfel am Tag“

und der Variable „Verbrachte Jahre mit den

Dritten“ in einer Männerstichprobe untersuchen,

könnte man aufgrund einer Scheinkorrelation die

Annahme machen, je mehr Äpfel man zu sich

nehme, desto schneller fielen einem die Zähne

aus.

Betrachtet man jedoch die dritte Variable

„Alter“(hier in zwei Kreisen als zwei Kohorten –

Männer zwischen 50-70 (A) und Männer

zwischen 20 -50 (B) - skizziert) entpuppt sich die

Annahme einer Korrelation zwischen x und y als

fehlerhaft.

Anzahl Jahre mit den

„Dritten“

A

B

Anzahl Äpfel am Tag

Fragen

1.

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

Was sind Untersuchungseinheiten und welchen Platz nehmen sie im Experiment ein?

Was sind Variablen? Geben Sie Beispiele.

Wandeln Sie den Studentenfragebogen in eine Datenmatrix um.

Wieviele Spalten würden Sie für ein Merkmal mit exklusivem Antwortmuster (z.B.

‘Geschlecht‘) angelegen? Begründen Sie Ihre Entscheidung.

Wieviele Informationen dürfen Sie maximal in einer Spalte angeben?

Was gilt als zentrales Element des Experimentes?

Was ist ein Quasi-Experiment? Geben Sie Beispiele.

Wandeln Sie das Streudiagramm der Daniel-Daten in eine Datenmatrix um.

Was ist eine Zeitreihenanalyse? Welche UE werden hier untersucht?

Geben Sie ein Beispiel für eine Zeitreihenanalyse mit mehreren Variablen.

Was ist eine Mehrebenenuntersuchung? Geben Sie ein Beispiel.

Welche Untersuchung würde zu einer Datenstruktur in Form eines Netzwerkes führen?

In wiefern sind Daten aus Mehrebenenuntersuchungen, Zeitreihenanalysen und Netzwerken

abhängig?

Geben Sie Beispiele für eine univariate und eine bivariate Fragestellung.

Wozu wird meist eine dritte Variable eingeführt?

Was ist eine Scheinkorrelation? Geben Sie Beispiele.

Was ist eine Schein-Nichtkorrelation? Geben Sie Beispiele.

18. Welche Maßzahlen verwendet man zur Beschreibung univariater Daten? Welche für

bivariate?

19. Wie können bivariate Daten grafisch dargestellt werden?

20. Was bedeutet Induktion? Nennen Sie Beispiele für die Induktion von Maßzahlen univariater

Datensätze.

Sitzung 2

Erste Schritte in R

- Commander laden

Taskleiste (TL) Pakete – Lade Paket – Rcmdr

- Datenmatrix bearbeiten

Die Datenmatrix kann verändert werden. Wird gerade eine Statistik gerechnet, lässt sich diese Option nicht

anwählen, stattdessen kann die Datenmatrix betrachtet werden.

- Ein Streudiagramm erstellen

TL Grafiken

- Daten importieren

TL Datenmanagment – Daten importieren

1. Nennen Sie eine mögliche Fragestellung zur ersten Analyse der Danieldaten.

2. Welche Fragestellungen könnten bei der Untersuchung eines intervallskalierten yMerkmals und eines nominalen x-Merkmals untersucht werden?

3. Mit welchem Test kann man Mittelwertsunterschiede der Gruppen untersuchen?

4. Was ist eine zweiseitige Fragestellung?

5. Wann wird ein Test signifikant?

6. Was bedeutet das Signifikanzniveau alpha?

7. Was ist der Fehler 2.Art?

8. Was ist die Macht des Testes (Power)? Wann erst kann die Macht eines Testes

berechnet werden?

9. Was ist der p-Wert?

10. Was meint die Bezeichnung „95% Konfidenzintervall“?

11. Warum kann man u.U. von einem Konfidenzintervall die Signifikanz eines Testes

ablesen?

12. Welcher Test kann zur Überprüfung der Gleichheit zweier Varianzen verwendet

werden?

13. Welche zwei Freiheitsgrade müssen bei einer Testung mit der F-Verteilung angegeben

werden?

14. Welche Voraussetzung muss gegeben sein, um einen parametrischen Test anwenden

zu können?

15. Welcher Teststatistiken kann man sich bedienen, wenn diese Voraussetzung nicht

erfüllt ist?

16. Nennen Sie einen nichtparametrischen Test zur Untersuchung von Lageunterschieden,

wenn

a. die Variablen ordinalskaliert sind

b. die Variablen intervallskaliert sind

17. Wofür steht die Bezeichnung „Location Shift“?

18. Wann können parametrische Tests trotz der Verletzung der

Normalverteilungsannahme angewendet werden?

19. Was ist der sog. Standardfehler?

Lösungsvorschläge

1. Zum Beispiel: Gibt es einen systematischen Unterschied zwischen Kontroll- und

Experimentalgruppe? Oder anders formuliert: Gibt es zwischen der Variable ‚Gruppe’ und

der Ausprägung der Variable ‚Vollheit’/ ‚Schönheit’ einen systematischen Zusammenhang?

2. Sind die Verteilungen unterschiedlich? Unterscheiden sich einzelne Parameter? (z.B.

Mittelwerte, Mediane, Streuungen, etc. )

3. In dem Falle der Danieldaten wähle man einen t-test für unabhängige Stichproben, unter

der Voraussetzung, dass die Varianzen verschieden sind.(s. auch Frage 12) -> Welch 2Sample t-test. Freiheitsgrade sind in dieser Lösung nicht ganzzahlig. Sie können aber

gerundet werden.

(In R: TL Statistik – Mittelwerte vergleichen – t-test für unabhängige SP)

4. Die Formulierung einer Alternativhypothese zur Nullhypothese „Es gibt keine

Unterschiede (zwischen den Gruppen, zwischen den Behandlungen etc.)“ bzw. μ1 = μ2 (μ1 μ2 = 0) kann entweder einseitig oder zweiseitig formuliert werden.

Die Testung einer einseitig formulierten Alternativhypothese etwa der Form μ1 - μ2 > 0 ist nur

gerechtfertigt, wenn Größenunterschiede in die entgegengesetzte Richtung ausgeschlossen

werden können – wenn man also sicher ist, dass eine zweiseitige Testung nicht notwendig ist.

Solch ein Trugschluss könnte etwa entstehen, wenn man zur Nullhypothese „Es lassen sich

keine Intelligenzunterschiede zwischen Schwarzen und Weißen feststellen“ die einseitige

Alternativhypothese „Weiße sind intelligenter als Schwarze“ testen würde, ohne ausschließen

zu können, dass Schwarze intelligenter sind als Weiße.

Eine zweiseitig formulierte Alternativhypothese führt also zu einem zweiseitigen kritischen

Bereich unter Geltung der Nullhypothese, die Richtung des Effektes ist nicht im Vorhinein

festgelegt.

5. Wenn der TW (Testwert) in den kritischen Bereich (KB) fällt. Bzw. der p-Wert kleiner als

das vorgegebene Signifikanzniveau ist.

6. Der alpha-Fehler (der Fehler 1.Art ) bezeichnet unter Geltung der Nullhypothese die

W´keit, den Fehler zu machen, die Nullhypothese abzulehnen, obwohl sie richtig ist. Je

kleiner alpha, desto höher ist das Signifikanzniveu. Ein Signifikanzniveau von 0.05 wird als

signifikant, eines von 0.01 als sehr signifikant und eines von 0.001 als hochsignifikant

bezeichnet.

7. Der Fehler 2.Art(oder β-Fehler) bezeichnet die W´keit die Alternativhypothese abzulehnen,

obwohl sie richtig ist. Er ist vom wahren Wert des Populationsparameters abhängig.

Da dieser bei der Formulierung der Alternativhypothese nicht bekannt ist, kann der Fehler

2.Art nicht berechnet werden.

Der Fehler 2.Art wird kleiner

je größer der Unterschied zwischen μ0 (angenommener Parameterwert) und μ1

(tatsächlicher Parameterwert) wird

je kleiner die Streuung ist

je größer die Stichprobe ist

je größer alpha ist.

Zu den Zusammenhängen zwischen Fehler 1.Art und 2.Art siehe:

http://www.uni-konstanz.de/FuF/wiwi/heiler/os/vt-normtest.html

Grafische Darstellung des Fehlers 1. und 2.Art.

Aus: http://page.mi.fu-berlin.de/mielke/eis/Weber-Fehlerquellen-Parametertest.pdf

8. Die Macht des Testes (1-β) bezeichnet die W´keit, die Alternativhypothese anzunehmen,

wenn sie richtig ist. Diese Teststärke ändert sich nach bestimmten Kriterien. (s.o.). Bei der

Formulierung einer exakten Alternativhypothese, kann die Macht des Tests und darüber auch

der beta-Fehler berechnet werden.

Wird ein Test nicht signifikant und die Power des Testes ist niedrig, kann sowohl Null- als

auch Alternativhypothese zutreffen. Ist die Power allerdings hoch und der Test nicht

signifikant, ist dies ein Hinweis auf die Geltung der Nullhypothese.

9. Der p-Wert bezeichnet unter Geltung der Nullhypothese die W´keit, einen Wert gleich oder

extremer dem Testwert im Sinne der Alternativhypothese zu erhalten.

10. Mit einer 95% - W´keit überdeckt das angegebene Intervall den wahren Parameterwert.

( Achtung: Es gibt nicht nur ein Intervall, sondern mehrere, die den wahren Parameterwert

überdecken, daher wird eine W´keit angegeben. )

11. Liegt der angenommene Parameterwert nicht im Konfidenzintervall, wird die

Nullhypothese abgelehnt.

12. Der Varianzen-Levene-Test.

13. Zähler: df1 = n( Stichprobe 1) - 1

Nenner: df2= n (Stichprobe 2) – 1

14. Die Werte in der Population müssen normalverteilt sein.

15. Man kann sich eines nichtparametrischen Tests bedienen.

16a. Vorzeichentest

16b. Wilcoxon-Rangsummen-Test

17. Location Shift bezeichnet die Annahme, zwei Verteilung könnten durch Verschieben zur

Deckung gebracht werden. Bei dem Wilcoxon-Rangsummen-Test bezeichnet der Location

Shift die Alternativhypothese.

18. Bei großer Stichprobengröße nähert sich die Verteilung der Mittelwerte einer NV. Je nach

Lageparametern der Stichprobe (Schiefe, Streuung, etc.) variiert die hierzu erforderliche

Größe der Stichprobe.

19. Die Standardabweichung der Verteilung einer bestimmten Maßzahl (z.B. des

Mittelwertes, der Standardabweichung, Regressionskoeffizienten, etc.)

Sitzung 3

R

-- Versehentliches Schließen des Rcmdr

Geben Sie in die Befehlszeile (ganz unten, beginnend mit ´>´) den Befehl ´Commander ( )´ ein.

-- Konvertieren der numerischen Variablen in Faktoren

Ist ein Faktor, zum Beispiel Gruppenzugehörigkeit der VPn, als numerische Variable kodiert ( etwa: 0 Experimentalgruppe, 1-Kontrollgruppe ),

werden von R nicht alle t-tests zur Ausführung angeboten, da zwischen Faktor und Variable in diesem Fall

nicht automatisch unterschieden werden kann.

Um dieses Problem zu beheben, gehen Sie zur TL Datenmanagment

- Variablen bearbeiten - Konvertiere

numerische Variablen in Faktor. Geben Sie nun die entsprechende Variable an, die konvertiert werden soll.

Wählen Sie die Option `Etikette´ wird ein neuer Stempel vergeben - es wird eine neue Spalte angelegt

(Name: Grf - Gruppenfaktor) und Sie werden dazu aufgefordert, die unterschiedlichen Ausprägungen

zu benennen.

1. Warum liegt ein Wert nicht mit einer bestimmten Wahrscheinlichkeit im

Konfidenzintervall?

2. Der Mittelwert verschiedener Stichproben streut weniger stark denn die Stichprobe selbst.

Um welchen Faktor? Wie nennt man den somit berechneten Faktor?

3. Was ist die Effektstärke und wie kann sie berechnet werden?

4. Wie verfährt man bei unterschiedlicher Stichprobenvarianz?

5. Warum benötigt man die Effektgröße neben der Berechnung eines statistisch signifikanten

Unterschiedes?

6. Wie hängt der t-Wert und d zusammen? Geben Sie eine Formel zu Berechnung an.

7. Wann kann bei verbundenen Stichproben, die den Einfluss einer Behandlung anhand

zweier Zeitpunkte untersuchen (e.g. Vorher-Nachher) auf die Analyse des ersten Zeitpunktes

verzichtet werden?

8. Welche Voraussetzungen müssen für die Durchführung eines parametrischen Tests

gegeben sein?

9. Welcher Test wird, wenn diese Voraussetzungen erfüllt sind, schneller signifikant:

Ein parametrischer oder ein nicht-parametrischer Test?

10. Was berechnet die sog. Power-Efficiency?

11. Welche Fragestellungen können mittels einer Regressionsanalyse untersucht werden?

Geben Sie ein Beispiel.

12. Welche Vorteile hat eine Regressionsanalyse gegenüber einem t-test?

13. Was ist der sog. Regressionskoeffizient?

14. Was ist die sog. Regressionskonstante?

15. Angenommen, Sie untersuchten den Zusammenhang zwischen der Anbaufläche (in

Hektar) auf die Menge an Ernte (in Kg).

Was bedeutet der Regressionskoeffizient(Anbaufläche)=2.5?

16. Angenommen, Sie verwendeten zusätzlich die Variable Frost (in Tagen) als Prädiktor für

Ernte - übersetzen Sie bitte folgende

Angabe eines Bauers in Zahlen: "Jeder Tag Frost kostet mich 2 Kilo meiner Ernte."

Lösungsvorschläge

1. Zum Einen ist der tatsächliche Parameter der Population keine Zufallsvariable. Es ist ein

fester Wert und besitzt daher

keine Auftretenswahrscheinlichkeit. Zum anderen ist das Konfidenzintervall kein stets

gleichbleibender Bereich. Mit jeder Stichprobenziehung ändern sich die Grenzen des KI. Die

Angabe eines 95%-konfidenzintervalls

kann beispielsweise folgendermaßen verbalisiert werden:

Zu 95% enthält der angegebene Bereich Konfidenzintervalle, die den wahren Wert

überdecken.

2. Die Verteilung des sog. Standardfehler des Mittelwerts (allg.: eines Parameters) streut

weniger stark denn die Verteilung der Stichprobenwerte um den Faktor 1/√n.

.

3. Mittelwertsunterschiede werden in der Einheit der Standardabweichungen angegeben und

sind daher von der Stichprobengröße unabhängig.

Ein beliebtes Maß ist Cohen´s d:

Nach Cohen´s Faustregel gilt eine Effektstärke unter 0.2 als sehr klein, unter 0.5 als klein,

unter 0.8 als mittel und 0.8 und größer als starker Effekt.

Bei einer kleinen Stichprobe ohne signifikantes Ergebnis sollte trotzdem die Effektstärke

angegeben werden. Je weniger zwei Verteilungen überlappen (je größer also der Unterschied

zwischen zwei Verteilungen ist) und/oder je geringer die Streuung ist, desto größer ist die

Effektstärke.

Siehe hierzu: http://www.bolderstats.com/jmsl/doc/CohenD.html

4. Es muss die mittlere Stichprobenvarianz berechnet werden: pooled = [(1²+ ²) / 2]

5. Die Berechnung der Effektstärke dient der Bestimmung praktischer Bedeutsamkeit eines

experimentellen Effektes.

Bei der Durchführung eines statistischen Testes kann durch eine Vergrößerung der Stichprobe

und durch eine Senkung der Streuung (etwa durch die Auswahl sehr homogener

Versuchsteilnehmer) eine Signifikanz erhöht oder erreicht werden.

Um nun herauszufinden, ob der Unterschied abgesehen von der Signifikanz tatsächlich und

aussagekräftig ist, zieht man die Effektsärke zu Rate.

6. d = 2t / √df

7. Wenn die VPn durch eine randomisierte Auswahl den Gruppen zugeordnet wurden.

Mithilfe dieses Verfahrens wird die Annahme verfolgt, durch Randomisierung eine

ausgewogenen Verteilung evtl. Unterschiede der VPn, die einen störenden oder verzerrenden

Einfluss auf die Versuchsergebnisse haben könnten, auf die beiden Gruppen erreicht zu

haben.

Die Gruppen seien demzufolge vor der Behandlung in allen relevanten Hinsichten gleich.

Ergo kann auf die Analyse des ersten Zeitpunktes verzichtet werden.

8. Intervallskalierte Variablen und normalverteilte Populationswerte.

9. Ein parametrischer Test.

10. Wenn alle Voraussetzungen für einen parametrischen Test erfüllt sind, berechnet die sog.

Power-Efficiency die Anzahl der Fälle, in denen ein nicht-parametrischer Test signifikant

wird, wenn auch der parametrische Test signifikant geworden ist. Die Power-Efficiency

beträgt beispielsweise für den Wilcoxontest .95 und für den Mediantest .65.

11. Mittels Regressionsanalyse soll eine abhängige Variable durch eine oder mehrere

unabhängige Variablen erklärt werden. Zum Beispiel kann

die Ernte eines Jahres (abhängige Variable) durch Wettereinflüsse (Regenmenge,

Sonnenstunden, Niedrigsttemperatur etc.), durch verwendete Dünger, die Anbaufläche,

etc. prognostiziert, bzw. erklärt werden. Zur Beschreibung des Zusammenhanges zwischen

abhängiger und unabhängiger/n Variablen können verschiedene Funktionen verwendet

werden. (z.B. lineare oder logistische Regression). Es soll immer die bestmögliche Anpassung

der erklärenden Gerade/Kurve an die Daten erreicht werden.

12. Der t-test eignet sich nicht zur Überprüfung der Einflüsse einer oder mehrerer

unabhängiger Variablen auf die abhängige/n Variable/n.

13. Der Regressionskoeffizient misst den Einfluss der unabhängigen Variable X auf die

abhängige Variable Y. Bei einer linearen Regression ist dieser Einfluss (" Wie verändert sich

Y, wenn sich X um eine Einheit ändert?") unabhängig von der Größe von X immer gleich und

entspricht der Steigung der Geraden.

14. Die Regressionskonstante entspricht dem Wert der abhängigen Variable Y, wenn der Wert

der unabhängigen Variablen X Null beträgt. (sog. „Intercept“). Die Interpretation ist nur dann

sinnvoll, wenn die unabhängige Variable X tatsächlich einen Wert von Null annehmen kann.

15. Etwa: Bei Vergrößerung der Anbaufläche um einen Hektar, steigt die erhaltene Ernte um

2.5 Einheiten.

16. y= a - 2x + ε

Sitzung 4

1. Welchen Vorteil hat eine Regressionsanalyse gegenüber einem t-test?

2. Was ist der Unterschied zwischen einer multivariaten und einer multiplen

Regressionsanalyse?

3. Wie bezeichnet man eine Regressionsanalyse, die den Einfluss mehrerer unabhängiger

Variablen auf eine abhängige Variable untersucht?

4. Führen Sie eine univariate Regressionsanalyse (UV=Gruppenzugehörigkeit i.e.

Experimentalgruppe =0, Kontrollgruppe = 1; AV= 'Change', i.e. Score_1 – Score_2)

der Magnetdaten (http://onlinestatbook.com/rvls.html) mithilfe von R durch und

interpretieren Sie die Ergebnisse.

a. Durch welche Punkte wird die Regressionsgerade gelegt?

b. Wie lässt sich der angegebene Intercept interpretieren?

c. Wie lässt sich der negative Regressionskoeffizient interpretieren?

d. Was würde ein positiver Regressionskoeffizient bedeuten?

e. Wie müsste der Regressionskoeffizient aussehen, wenn die Kontrollgruppe zum

zweiten Zeitpunkt einen höheren Wert als zum ersten Zeitpunkt aufweisen würde?

5. Wie unterscheidet sich dieses Ergebnis der univariaten Regression von einem t-test

auf Mittelwertsunterschiede unter der Annahme der Homoskedastizität?

6. Was ist eine Dummy-Variable?

7. Wie kann in R eine Variable in eine Dummy-Variable umgewandelt werden?

8. Führen Sie nun eine Regressionsanalyse mit den Prädiktorvariablen Gruppe und

Score_1 durch. Erläutern Sie, was man dabei unter Konstanthaltung versteht und wie

dieses Konzept in diesem Kontext zum Tragen kommt.

9. Zeigen Sie anhand einer Gleichung, warum bei einer Regressionsanalyse mit einer

Dummy-Variable als Prädiktor und einer Differenz zweier intervallskalierter

Variablen (z.B. Messzeitpunkte, i.e. y2-y1) als Kriterium der Intercept an der Stelle

x=0 problemlos interpretiert werden kann. / wann kann bei einer Dummy-Variable als

Prädiktor und einer blabla .. der durch die Regressionsanalyse herausgerechnete

Intercept problemlos interpretiert werden?

10. Die in Frage 11 vorgestellte Regression soll nun durch eine weitere Prädiktorvariable

Z erweitert werden. Zeigen Sie anhand einer Gleichung, wann in dieser Anordnung

der Intercept als Mittelwert der mit Null kodierten Ausprägung interpretiert werden

kann.

11. Was sind Odds?

12. Was ist eine Odds-Ratio?

13. Berechnen Sie die Odds das Gymnasium zu besuchen und das Abitur zu machen für

Kinder mit und ohne Migrationshintergrund. Berechnen Sie die Odds-Ratio.

Abitur

Kein Abitur

Kinder mit

Migrationshintergrund

Ohne Migrationshintergrund

24

82

76

18

14. Warum und wie rechnet man Odds in Logits um?

15. Was ist die logistische Regression?

16. Welche Unterschiede bestehen zwischen logistischer Regression und linearer

Regression?

17. Warum ist die lineare Regression nicht zur Analyse einer binären Variable geeignet?

18. Für die Chile-Daten erhält man folgende Häufigkeiten Odds und Logits:

N

Y

Odds(py)

Logit(pY)

w

m

363

526

480 1.32231405

388 0.73764259

0.27938327

-0.30429587

a) Wie groß ist der Unterschied zwischen männlich und weiblich bezüglich der YesLogits?

b) Wie groß ist der Yes-Logit für die Frauen?

19. Welches lineare Modell muss hier verwendet werden und warum?

20. Bei einer Berechnung mithilfe des generalisierten linearen Modells (Prädiktor: sex,

Prädikand: vote) werden folgende Ergebnisse ausgegeben:

Coefficients:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 0.27938 0.06956 4.017 5.90e-05 ***

sex[T.M] -0.58368 0.09652 -6.047 1.48e-09 ***

Interpretieren Sie den Intercept und den Einfluss von Sex.

Lösungsvorschläge

1. Es kann der Einfluss mehrerer unabhängiger Variablen auf eine oder mehrere

abhängige Variablen untersucht werden.

2. Eine multivariate Regressionsanalyse untersucht die Auswirkung auf mehrere

abhängige Variablen, wohingegen die multiple Regressionsanalyse den Einfluss

mehrerer unabhängiger Variablen beschreibt.

3. Univariate multiple Regression.

(s. weiterführend: http://www.uni-landau.de/schreiber/archiv/ws03_32/Multivariate1-korr_WHS.pdf )

4. a. Durch die Mittelwerte der beiden Gruppen.

b. Die Regressionskoeffizienten ändern sich stets, wenn eine neue erklärende Variable

oder eine neue zu erklärende Variable hinzukommt. Bei dieser einfachen, univariaten

Versuchsanordnung lässt sich der Intercept jedoch als Mittelwert der

Experimentalgruppe (Active 1) interpretieren.

c. Da Change über Score_1 – Score_2 definiert ist, bedeutet ein kleinerer Ergebnis

weniger Veränderung – die Experimentalgruppe zeigt also einen stärkeren Rückgang

der Schmerzen bzw. eine kleineren Score zum zweiten Zeitpunkt.

d. Die Veränderung der Kontrollgruppe wäre, im Vergleich zur Experimentalgruppe

noch kleiner, d.h. Change würde in der Kontrollgruppe einen höheren Wert aufweisen.

e. Wenn sich die Schmerzen in der Kontrollgruppe zum zweiten Zeitpunkt gesteigert

haben sollten, müsste der Regressionskoeffizient größer sein als der Mittelwert der

Experimentalgruppe, da der Mittelwert der Kontrollgruppe negativ wäre.

5. Betrachtet man die vom t-test angegebenen Mittelwerte, sollte der Mittelwert der

Experimentalgruppe gleich dem Intercept sein und der Mittelwert der Kontrollgruppe

gleich dem von der Regressionsanalyse prädizierten Wert bei X=1 sein (i.e. Y2=

5.24139– 4.1461)

6. Eine dichotome Variable (z.B. männlich, weiblich), die auf 0 und 1 kodiert ist.

7. 'Erzeuge neue Variable' (TL Datenmanagment – Variablen bearbeiten ), dann *Gruppe

== “exp“ '

Die neue Variable wird in der Datenmatrix angezeigt. Sollten die Ausprägungen noch

mit 'True' und 'False' angegeben sein, können Sie im Skriptfenster den Befehl:

'NamederDatenmatrix$exp <-- with(NamederDatenmatrix, (Gruppe==“exp“*1))'

eingeben bzw. abändern. Durch diese Multiplikation mit 1 wird die Ausprägung False

mit Null und die Ausprägung True mit 1 kodiert.

8. Durch die Konstanthaltung von Störgrößen soll der Effekt eines Treatments unverzerrt

sichtbar werden.

Im vorliegenden Falle könnte der Zustand der VPen zum ersten Zeitpunkt einen

Einfluss auf die AV haben. Die Konstanthaltung in diesem Fall gibt also Ausschluss

darüber, wie groß der Effekt der Behandlung ist, wenn alle VPen die gleiche

Schmerzintensität zum ersten Zeitpunkt berichten.

9. Bei Intervallskalen ist der Abschnitt (= Intercept) schon für einfachste Aussagen nicht

sinnvoll interpretierbar. Zulässig bei intervallskalierten Variablen sind

Lineartransformationen, so dass Y folgendermaßen ersetzt werden kann (X sei eine

Dummy-Variable: 0 bzw. 1) :

Y = a +bX;

Man betrachte folgende Behauptung: der Abschnitt ist 0 (hier a=0)

Y -> A +BY (zulässige Transformation bei Intervallskalenniveau)

d.h. Nach zulässiger Transformation gilt: A+BY = a +bX -> Y = (a-A)/B + b/B X

gilt für die Aussage (der Abschnitt ist 0: (a/B – A/B) = 0. Diese Aussage ist nur dann

zulässig, wenn A = 0 ist; d. h. diese Aussage wäre nur bei einer Verhältnisskala

sinnvoll.

Für Differenzen: Soll nun eine Differenz zweier solcher Variablen durch die

Regressionsanalyse prädiziert werden Y2-Y1 = a + bX, kürzt sich das in der linearen

Transformationen enthaltene A raus:

Nach zulässiger Transformation A+BY gilt:

A+BY2 - (A +BY1) = a + bX

-> BY2 – BY1 = a +bX

-> Y2 –Y1 = a /B + b/B X

Hier ist die Aussage (der Abschnitt ist 0) äquivalent in Vergleich der der

transformierten und untransformierten Regressionsgleichung, und daher zulässig.

Die abhängige Variable ist die Differenz. Die Regressionsgerade wurde anhand der

Regressionsgleichung geschätzt: Y2 –Y1 = a + b X + e.

(mit X=0 für Kontrollgruppe und X=1 für Experimentalgruppe).

Der Kleinst-Quadrateschätzer liefert

für die Kontrollgruppe (X=0) die Differenzenmittelwerte: y 2 (0) y1 (0) a und

für die Experimentalgruppe (X=1) die Differenzenmittelwerte: y 2 (1) y1 (1) a +b.

b ist daher gerade die Differenz der Differenzmittelwerte:

( y 2 (1) y1 (1)) ( y 2 (0) y1 (0)) .

10. Y2 – Y1 = a +bX +cZ An der Stelle, an der Z=0 ist.

11. Odds sind Verhältnisangaben von Anteilen oder Häufigkeiten. Zum Beispiel kann der

Anteil der Kinder unter 18 Jahren einer Horrorkinovorstellung zum Verhältnis der

Jungerwachsenen und Erwachsenen über 18 Jahren dargestellt werden – etwa 1:19.

Dies würde der Angabe entsprechen, dass sich unter 20 Kinobesuchern eine Person

unter 18 Jahren befindet oder dass der prozentuale Anteil an Minderjährigen bei 5%

liegt.

12. Odds finden oft in Wetteinsätzen Verwendung – hier geht es um einen Vergleich der

Gewinnchancen: in einem Würfelspiel etwa liegen die Odds, eine Sechs zu würfeln,

bei 1:5. Odds-Ratio – das Verhältnis von Odds – setzt Odds zweier Gruppen

zueinander in Beziehung und soll somit Aussagen über die Stärke von

Zusammenhängen geben. Beispiel: Es interessiert, wie hoch die Wahrscheinlichkeit

für Kinder mit Migrationshintergrund ist, eine weiterführende Schule zu besuchen, im

Vergleich zu Kindern ohne Migrationshintergrund.

13. Die Odds für Kinder mit Migrationshintergrund, eine weiterführende Schule zu

besuchen, betragen 12:41, für Kinder ohne 38:9. Die Odds-Ratio beträgt 14.42 für

Kinder ohne Migrationshintergrund und Abitur. D.h. die Chancen, dass ein Kind ohne

Migrationshintergrund ein Abitur macht, sind 14,42 mal so hoch, als dass ein Kind mit

Migrationshintergrund das Abitur macht. Liegt die Odds-Ratio über 1, sind die Odds

für die erste Gruppe höher, liegt sie unter 1 sind die Odds für die zweite Gruppe höher.

14. Odds haben einen beschränkten Wertebereich. Sie sind zwar nach oben hin offen,

nähern sich jedoch asymptotisch Null an. Indem man sie in Logits umwandelt, erreicht

man einen unbeschränkten Wertebereich. Der Logit ist der natürliche Logarithmus

eines Odds.

15. Die logistische Regression ist ein Verfahren zur Beurteilung des Zusammenhangs

zwischen einer dichotomen abhängigen Variable und mindestens einer unabhängigen ,

mindestens intervallskalierten Variable.

Typisch sind abhängige Variablen, die das Eintreten eines

Ereignisses erfassen und sich gegenseitig ausschließen – Ereignis tritt ein oder

Ereignis tritt nicht ein. Es interessiert der Einfluss der unabhängigen Variable/n und

die konkrete Wahrscheinlichkeit für das Eintreten des Ereignisses.

16. Im linearen Regressionsmodell ist die abhängige Variable metrisch skaliert und es

wird keine Wahrscheinlichkeit vorhergesagt, sondern die konkrete Ausprägung von Y.

Die logistische Regression unterstellt einen nicht-linearen Zusammenhang zur

Wahrscheinlichkeit des Auftretens des ‚abhängigen’ Ereignisses, das durch eine

Ausprägung der abhängigen Variablen charakterisierbar ist.

1. Die logistische Funktion lautet: p1 () :

exp( )

1 exp( )

2. Andererseits gilt dann: log it ( p1 ()) ln( Odds()) ln(

mit a bx

p1 ()

) : mit a bx

1 p1 ()

17. Die Voraussetzung der Homoskedastizität der Residualvarianzen ist nicht erfüllt. Die

Residuen sind nicht normalverteilt. Weiterhin ist ein linearer Zusammenhang

zwischen der/n unabhängigen Variable/n und der Eintrittswahrscheinlichkeit nicht

anzunehmen. Vielmehr geht man von einem „Sättigungseffekt“ aus – die

Wahrscheinlichkeiten nähern sich den Extremwerten asymptotisch an. Und es können

für bestimmte Ausprägungen von X Werte geschätzt werden, die unter 0 oder über 1

liegen.

18. a) -0.5837 b) 0.279

19. Es muss das generalisierte lineare Modell verwendet werden, da Prädikand (Yes/No)

und Prädiktor (Male/Female) qualitative Variablen sind.

20. Da eine Dummy-Variable automatisch von R kodiert wird – je nachdem, welche

Ausprägung die vordere Stelle im Alphabet einnimmt (in diesem Falle Female) wird

mit 0 kodiert. Daher ist der Intercept als Logit der Frauen zu interpretieren

( a bx . x= 0 ). Der Einfluss von Sex ist genau der Unterschied zwischen dem

Logit der Frauen und dem Logit der Männer. (-0.58368)

Sitzung 5

1. Beschreiben Sie den Zusammenhang zwischen den Differenzen der Logits und den

Odds-Ratios.

2. Welche Voraussetzungen sollten die Prädiktoren bei einer multiplen Regression

erfüllen?

3. Was ist der Unterschied zwischen dem linearen Modell und dem generalisierten

linearen Modell(GLM)?

4. Was ist die Poisson-Verteilung? Geben Sie ein Beispiel.

5. Wie können die Parameter im GLM geschätzt werden?

6. Geben Sie eine Formel zur Berechnung der Schätzer für die GLM –Parameter an.

7. Was ist die sog. Goodness-of-Fit? Welches Goodness-of-Fit-Maß kann bei GLM

berechnet werden?

8. Geben Sie ein Beispiel für einen Test, mit dem die Güte der Modellanpassung

überprüft werden kann. ( Bezüglich der Chile-Daten. Man verwende zur Prädiktion

von „Vote“ die Dummy- Variable „Sex“ in einem generalisierten linearen Modell. )

9. Welcher Hypothese entspricht die Relevanzbewertung der Gruppenunterschiede?

10. Wie kann die Null-Steigungshypothese β=0 geprüft werden?

11. Warum wird bei der logistischen Regression kein Störglied eingefügt?

12. Was ist der Standardfehler?

13. Was ist ein Konfidenzintervall?

14. Wie kann die Schätzung des Regressionskoeffizienten in einen z-Wert umgewandelt

werden?

Coefficients:

Estimate Std. Error z value Pr(>|z|)

sex[T.M] -0.58368 0.09652 -6.047 1.48e-09 ***

15. Welche Hypothese wurde hier überprüft und warum ist das Ergebnis signifikant?

16. Was ist der p-Wert?

17. Wie kann das Konfidenzintervall eines Regressionskoeffizienten berechnet werden?

18. Was versteht man unter AIC?

19. Was ist ein Bootstrapping-Verfahren?

20. Welche Fragestellungen könnten nach einem Bootstrap-Verfahren im Rahmen einer

Regressionsanalyse interessieren?

Interaktionen und Haupteffekte (Datensatz: Wohnen; Balanciert und Unbalanciert)

21. Woran kann man die Existenz eines Haupteffektes an einer graphischen Darstellung

überprüfen?

22. Wie kann ein Haupteffekt interpretiert werden?

23. Woran erkennt man an einer graphischen Darstellung einen Interaktionseffekt?

24. Welches Modell kann man wählen, wenn ausschließlich Haupteffekte vorliegen oder

die Daten ausschließlich anhand solcher dargestellt werden sollen?

25. Was ist der Unterschied zwischen symmetrischen und asymmetrischen Restriktionen?

26. Prädizieren Sie die Zellmittelwerte der Wohnen_Balanced- Daten mithilfe einer

asymmetrischen Restriktion, wobei α1 und β2 als Normalfall betrachtet werden sollen.

27. Was sind (mathematisch) die Interaktionseffekte?

28. Wie können die Effekte in der Stichprobe geschätzt werden?

29. Wie groß sind die Effekte der Wohnen_Balanced-Daten? Wie können die einzelnen

Zellenmittelwerte mittels linearem Modell prädiziert werden?

30. Wie kann der Fehler (ohne) berechnet werden?

31. Welche Hypothesen können bei der zweifaktoriellen Varianzanalyse gestellt werden?

32. Wie kann überprüft werden, ob bei vorhandener Interaktion zusätzlich noch ein

Haupteffekt vorliegt?

33. Was ist ein sog. Hybrideffekt?

34. Welche Teststatistik kann zur Überprüfung der Hypothesen herangezogen werden?

Welche Eigenschaften sollte sie haben?

35. Was sind die sog. ‘mean sum of squares’?

36. Was bildet in der F-Statistik den Zähler, was den Nenner?

37. Was ist ein unbalanciertes Design?

38. Welche Probleme bringt solch ein unbalanciertes Design bezüglich der Faktoren mit

sich?

39. Welches Problem gibt es bei unbalancierten Designs bezüglich der Interpretation der

Effekte?

40. Woran liegt das?

41. Welche Fehlerreduktion eines Faktors sollte dann zur Interpretation herangezogen

werden?

42. Was ist die sog. Kleinste-Quadrate Eigenschaft des Mittelwertes?

43. Warum ist eine Aussage der Art „Die Hypothese, der F-Wert sei Null soll überprüft

werden“ eher ungeschickt?

Lösungsvorschläge

1. Der Logarithmus eines Quotienten entspricht der Differenz des Logarithmus des

Nenners zum Logarithmus des Zählers :

log it ( p1 ( )) log it ( p 2( )) log it (

p1 ( )

) ln( Oddsratio ( ))

p2 ( )

p1 ( )

)

1 p1 ( )

Die Oddsratios können also ganz einfach erhalten werden, indem die e-Funktion

auf die Differenz der Logits angewendet wird.

mit log it ( p1 ( )) ln( Odds ( )) ln(

2. Sie sollten mind. Intervallskalenniveau haben und nicht linear voneinander abhängig

sein, auch nicht kollinear voneinander abhängig. (linear – ein Regressor wäre durch

die anderen mittels einer multiplen Regression exakt prädizierbar; kollinear – ein

Regressor wäre durch die anderen mittels einer multiplen Regression fast exakt

prädizierbar ). Sie dürfen allerdings miteinander korrelieren.

3. Im Gegensatz zu linearen Modellen, in denen man von normalverteilten abhängigen

Variablen ausgeht, nimmt man in generalisierten linearen Modellen (GLM) an, dass

die abhängige Variable eine Verteilung aus der Klasse der exponentiellen Familien

besitzt. Zu diesen Klassen gehören neben der Normalverteilung die Binomial-,

Poisson-, Gamma- und die inverse Gaußverteilung.

Achtung bei den in der Literatur verwendeten Abkürzungen: Manchmal wird das

generelle lineare Modell (aus dem Englischen von General linear Model) mit GLM

abgekürzt. In Anlehnung an die in R verwendete Bezeichung „Lineares Modell“ und

„Generalisiertes lineares Modell“ habe ich lieber GLM für das Generalisierte lineare

Modell verwendet.

4. Die Poissonverteilung entsteht bei der mehrmaligen Durchführung eines BernoulliExperimentes und ist eine diskrete Wahrscheinlichkeitsverteilung. Die Fragestellung

bezieht sich auf die Anzahl des Eintretens eines bestimmten Ereignisses in einer Zeit-,

Raum- oder sonstigen Einheit. Zum Beispiel könnte die Frage interessieren, wie oft

ein Blitz im November in einem bestimmten Stadtviertel einschlägt.

5. In generalisierten linearen Modellen erfolgt die Parameterschätzung mithilfe der

Maximum-Likelihood-Schätzung. In linearen Modellen minimiert man die Summe der

Fehlerquadrate.

6. Es kann keine allgemeine geschlossene Form zur Berechnung der Schätzer angegeben

werden. Sie werden jeweils über ein iterativ numerisches Verfahren gefunden

(Newton-Raphson-Verfahren).

7. Das Goodness-of-Fit -Maß misst die Güte der Anpassung. Dieses Maß soll minimiert

werden. Als Kriterium wird die Devianz – die Abweichung vom Idealwert betrachtet. -2LL (LL für LogLikelihood) wird als Devianz bezeichnet und ist

annähernd χ²-verteilt. Bei perfekter Modellanpassung ergäbe sich eine Devianz von 0.

Je kleiner die Devianz also ist, desto besser ist die Anpassung des Modells an die

Daten.

8. Es bietet sich zum Beispiel ein Likelihood-Ratio-Test ( ??oder Pearson -χ² Test) an,

der die Devianz des Modells mit dem Prδdiktor „Sex“ mit dem „Nullmodell“

vergleicht: Das Nullmodell erhδlt man, wenn alle Regressionskoeffizienten auf Null

gesetzt werden und nur noch die Regressionskonstante ins Modell einflieίt.

Coefficients:

Estimate Std. Error z value Pr(>|z|)

(Intercept) 0.27938 0.06956 4.017 5.90e-05 ***

sex[T.M] -0.58368 0.09652 -6.047 1.48e-09 ***

--Signif. codes: 0 '***' 0.001 '**' 0.01 '*' 0.05 '.' 0.1 ' ' 1

Null deviance: 2435.5 on 1756 degrees of freedom

Residual deviance: 2398.5 on 1755 degrees of freedom

9. Die Relevanzbewertung der Gruppenunterschiede (z.B. der Gruppe Männlich vs.

Weiblich == Prädiktor „Sex“) entspricht der Hypothese, der zugehörige

Regressionskoeffizient sei Null, bzw. dass die Anteile für alle x-Werte gleich sind.

10. Mit dem allgemeinen Likelihood-Ratio-Test.

11. Weil man annimmt, dass Y binomialverteilt ist.

12. Als Standardfehler bezeichnet man die Streuung der Stichprobenkennwerte um

den wahren Wert des gesuchten Parameters der Population. Der Standardfehler hängt

direkt mit der Breite des Konfidenzintervalles zusammen – je größer der

Standardfehler, desto größer ist das Konfidenzintervall.

13. Ein 95% Konfidenzintervall enthält zu 95% Intervalle, die den gesuchten

Populationsparameter enthalten. Wichtig: Das Konfidenzintervall enthält nicht mit

einer bestimmten Wahrscheinlichkeit den Populationsparameter, da dieser keine

Zufallsvariable ist und daher nicht mit einer bestimmten Wahrscheinlichkeit

aufzufinden ist. Das Konfidenzintervall ist auch kein festes Intervall, sondern

schwankt mit jeder Stichprobe, die aus einer Grundgesamtheit gezogen wird.

14. Indem die Schätzung des Regressionskoeffizienten ( -0.58368 ) durch den

Standardfehler geteilt wurde.

15. Es wurde die Hypothese überprüft, der Regressionskoeffizient des Prädiktors

„Sex“ ( ̂β1) sei Null. Die Hypothese wurde abgelehnt, da der z-Wert in den kritischen

Bereich fällt.

16. Der p-Wert bezeichnet unter Geltung der Nullhypothese die Wahrscheinlichkeit,

einen Wert gleich oder extremer dem Testwert im Sinne der Alternativhypothese zu

erhalten.

17. Angenommen, es werde das 95% - Intervall gesucht: KI = ̂β1 +- 1.96σβ

18. Das sogenannte Akaike Information Criterion ist ein Maß zur Beurteilung jener

multivariater Modelle, die auf Maximum-Likelihood-Schätzern basieren und soll den

Vergleich unterschiedlicher nicht-geschachtelter Modelle zum selben Datensatz

unterstützen. Jedes dieser Modelle enthält mindestens eine Variable, die in dem

jeweils anderen Modell nicht enthalten ist. Es geht also um die Frage, welches Modell

die beste Anpassung an die Daten liefert. Angestrebt wird ein möglichst einfaches

Modell mit wenigen Variablen. Dieses Vorgehen bezeichnet man auch als BackwardStrategie – ausgehend vom komplexen Modell wird die Zahl der Variablen reduziert.

19. Das Bootstrapping ist eine Methode, Konfidenzintervalle statistischer Kennwerte

zu bilden, indem aus einer Stichprobe wiederholt Stichproben „mit Zurücklegen“

gezogen werden.

20. Bei einer Stepwise- Regression interessiert unter anderem die Fragestellung, ob die

Regressionskoeffizienten immer dasselbe Vorzeichen haben. Bei der Stepwise-Regression

ist allerdings das Problem, dass nicht alle möglichen Kombinationen (2I, mit I = Faktoren)

untersucht werden, sondern jeweils ein Faktor additiv zum Modell hinzugefügt wird.

21. Bei einem Haupteffekt sind die die Daten zweier Gruppen

anzeigenden/verbindenden Linien parallel.

22. Man kann Aussagen über die Stufen eines Faktors treffen, ohne den anderen

Faktor zu berücksichtigen. Etwa: Männer haben, unabhängig von der Wohnform, ein

höheres Einkommen als Frauen.

23. Beide Linien sind nicht mehr parallel. Will heißen: Es kann keine Aussage über

die Stufen eines Faktors getroffen werden, ohne den anderen Faktor zu

berücksichtigen. Oder: Der Unterschied zwischen den Stufen des einen Faktors (z.B.

Unterschiede zwischen Männern und Frauen im Einkommen) ist auf mindestens einer

Stufe des anderen Faktors unterschiedlich.

24. Die Effekte bezüglich der Faktoren können durch additive Kombinationen dargestellt

werden. Gesucht ist die additive Darstellung der Zellenmittelwerte aus Summanden,

die den tatsächlichen Mittelwerten in der Population möglichst nahe kommt. Es muss

unterschieden werden zwischen asymmetrischen und symmetrischen Restriktionen.

Merke: α und β sind eigentlich Regressionskoeffizienten. Es hat sich aber

eingebürgert, sie als Effekte zu bezeichnen.

25. In der symmetrischen Restriktion beziehen sich die Effekte auf ein generelles Niveau

und ergeben in der Summe Null. In der assymetrischen Restriktion beziehen sich die

Effekte auf eine Vergleichsgruppe, deren Effekt auf Null gesetzt wird. Dies bietet sich

an, wenn eine Gruppe als der 'Normalfall' betrachtet werden kann.

26. Die mittels asymmetrischer Restriktion prädizierten Zellenmittelwerte entsprechen

den mittels symmetrischer Restriktion prädizierten.

27. Die Interaktionseffekte sind die Differenz der Zellmittelwerte zum rein additiven

Modell. Wie auch die Haupteffektgrößen sind sie als Parameter der Population

gedacht, die in der Stichprobe zu schätzen sind.

28. Mittels der Methode der kleinsten Quadrate.

29. Die Zellenmittelwerte können in einer Regressionsgleichung mithilfe von DummyVariablen prädiziert werden.

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 6.000e+01 5.774e+00 10.392 4.65e-05 ***

sex[T.w] 1.941e-14 8.165e+00 2.38e-15 1.0000

wohnen[T.Privat] 2.000e+01 8.165e+00 2.449 0.0498 *

wohnen[T.Wg] 1.000e+01 8.165e+00 1.225 0.2666

sex[T.w]:wohnen[T.Privat] 1.000e+01 1.155e+01 0.866 0.4198

sex[T.w]:wohnen[T.Wg] 2.000e+01 1.155e+01 1.732 0.1340

Im Falle der Wohnen_Balanced Daten zeigte die Regressionsgleichung dergestalt:

Einkommen = 60 + 0 Sex + 20 Privat + 10 WG + 10 weibl.Privat + 20 weibl.WG

Für die Wohnform werden zwei Dummys benötigt:

Daheim

WG

Privat

Privat

0

0

1

WG

0

1

0

Männlich und Weiblich werden mit 0 und 1 kodiert.

Die einzelnen Zellenmittelwerte (hier zur Veranschaulichung durchnummeriert)

1

2

3

1

11

12

13

2

21

22

23

können folgendermaßen prädiziert werden:

11

μ

12

μ+β2

13

μ+β3

21

μ+α2

22

μ+α2+ β2 + αβ22

23

μ+α2+ β3 + αβ23

30. Von Hand:

I1

I2

J

y

i1 1 i 2 1 j 1

2

i 1i 2 j

I 1 I 2 Jy 2

31. Zum Einen ist die Formulierung zweier Haupteffekthypothesen möglich:

a. Null-Hypothese zum Faktor x1: die Mittelwerte der x1-Gruppen sind gleich.

Beispiel: Der Einkommensmittelwert eines Studenten ist gleich dem Einkommensmittelwert einer Studentin.

Die Einkommenseffekte von Sex sind 0.

b. Null-Hypothese zum Faktor x2: die Mittelwerte der x2-Gruppen sind gleich.

Beispiel: Die Einkommensmittelwerte unterscheiden sich nicht nach Wohnform.

Zum anderen können drei Interaktionseffekthypothesen aufgestellt werden:

c. Null-Hypothese zur Interaktion zwischen den beiden Faktoren x1 und x2. D.h. das

rein additive Modell der Haupteffekte ist richtig.

Beispiel: Alle Interaktionseffektsparameter sind null. Auf Grund der Restriktionen sind allerdings nur zwei

Interaktionseffektsparameter zu betrachten; es genügt zu fordern, dass: 11= 12=0. Auf Grund der Restriktionen sind dann alle

Effektparameter 0.

d.

Die Mittelwertunterschiede zwischen den x1-Gruppen sind gleich in allen x2-Stufen.

Beispiel: Der Einkommensunterschied zwischen Studenten und Studentinnen ist in allen Wohnformen gleich groß.

e. Die Mittelwertunterschiede zwischen den x2-Gruppen sind gleich in allen x1Stufen.

Beispiel: Die Einkommensunterschiede zwischen daheim versus in WG zu wohnen ist gleich groß für Studenten wie für

Studentinnen.

32. Indem man einen Faktor nicht berücksichtigt (z.B. Wohnform) und die

Gesamtmittelwerte in den einzelnen Ausprägungen des anderen Faktors (hier: Sex )

bildet. In diesem Beispiel würde das bedeuten, dass man die Einkommensunterschiede

zwischen Männern und Frauen unabhängig von der Wohnform betrachtet. Diese

Vorgehensweise bezeichnet man auch als Konstanthaltung.

33. Obwohl eine Interaktion der Faktoren festgestellt werden konnte, lässt sich zudem

noch ein Haupteffekt erkennen. Solch eine Interaktion bezeichnet man als hybrid.

34. Unter Geltung der Nullhypothese sollte die Stichprobenmaßzahl klein, unter Geltung

der Alternativhypothese groß werden. Diese Eigenschaften erfüllen die

Fehlerreduktions-quadratsummen. Diese Quadratsummen werden zudem relativiert

auf die Variabilität innerhalb der Zellen einerseits, andererseits werden auch die

Freiheitsgrade berücksichtigt. Die resultierenden Teststatistiken sind F-Statistiken

35. Als mean sum of squares (msq) sind jeweils die sum of squares des Modells, die durch

die entsprechenden Freiheitsgrade geteilt wurden.

36. Den Zähler bilden die mean sum of squares des Modells, dessen Effekt in der

Nullhypothese überprüft werden soll. Den Nenner bilden die mean sum of squares des

Modells, das sowohl Interaktions- als auch Haupteffekte berücksichtigt.( Dies

entspricht der Variabilität innerhalb der Zellen. Durch kein anderes Modell kann

diese Variabilität noch weiter reduziert werden. ) Dies wird auch als msqe(within)

bezeichnet. Hier für den Faktor x1 :

Baumstruktur der Fehlerreduktion durch die einzelnen Modelle:

Studenten-Einkommens-Beispiel: für alle Faktoren-Modelle wurden die Fehler berechnet. Dargestellt wird jeweils das Fehlermaß der

Modelle (ssqe). Darauf aufbauend sind ebenfalls die Fehlerreduktionen eingetragen; hier zusätzlich mit rein additivem Modell.

-

-

ssqe(-) 1

23 1

a

b

I1

ssqe(a)

a

I2

ssqe(b)

FR(b . a)

14

3

FR(b)

FR(a)

b

9 3

20 2

FR(a . b)

3

14

a, b

a, b

I1+I2-1

ssqe(a,b)

Rein additives Modell

FR. durch Interaktion

6 4

2

FR(ab. (a,b) )

19

FR(ab)

ab

ssqe(ab) I1I2

ab

4

z

6

Anzahl linear unabhängiger Parameter

37. Versuche, bei denen ungleiche oder unproportionale Zellbesetzungen gegeben sind,

werden als unbalancierte Designs bezeichnet.

38. Bei nichtbalancierten Designs korrelieren im Allgemeinen die Faktoren, da die

Häufigkeiten nicht proportional zu den Randhäufigkeiten sind.

39. Bei den Modellen, die verschiedene Faktoren berücksichtigen, sind die geschätzten

Effekte je nach Modell unterschiedlich groß.

Die Fehlerreduktion durch einen bestimmten Faktor ohne Konstanthaltung ist nicht

gleich groß wie die Fehlerreduktion dieses Faktors bei Konstanthaltung eines anderen

Faktors.

Studenten-Einkommens-Beispiel: Prädiktionsfehlerberechnung für nicht balancierte Daten. Hier ist wiederum die Fehlerreduktion durch

einen Faktor unterschiedlich je nach Konstanthaltung (z.B. FR(b) =17.85 ungleich FR(b . a)=15.2).

-

-

ssqe(-)

26.85

a

b

a

ssqe(a)

ssqe(b)

21.5

FR(b . a)

Rein additives Modell

FR. durch Interaktion

17.85

5.35

FR(b)

FR(a)

FR(a . b)

b

9

2.7

15.2

a, b

a, b

ssqe(a,b)

6.3

2.3

FR(ab. (a,b) )

22.85

FR(a, b, ab)

a, b, ab

ssqe(ab)

a, b, ab

4

40. Die Gruppenmittelwerte der verschiedenen Stufen eines Faktors sind nicht gleich dem

ungewichteten Mittelwerte über die Zellmittelwerte. Diese Gleichheit besteht bei

balancierten Designs.

41. Wenn ein Faktor unterschiedliche Fehlerreduktionen je nach Konstanthaltung

aufweist, sollte zur Interpretation jene Fehlerreduktion herangezogen werden, die die

maximale Konstanthaltung aufweist.

42. Kleinste- Quadrate Eigenschaft des Mittelwerts: Wenn die Summe der quadrierten

Abweichungen als Fehlermaß betrachtet wird, soll der Mittelwert verwendet werden,

da er das besterklärendste Maß darstellt. Nähme man die Beträge als

Abweichungsmaß, wäre etwa der Median besser.

43. Vielleicht: Es soll die Hypothese überprüft werden, die Hinzunahme des Faktors x

führt zu keiner signifikanten Fehlerreduktion. Bzw. der Haupteffekt des Faktors x in

der Population ist Null.

Sitzung 7

1. Welcher Art sind die unabhängigen Variablen, die in der linearen Regression, dem

linearen Modell und dem generalisierten linearen Modell verwendet werden können?

2. Was ist die Kovarianzanalye? Was ist die Kovarianzanalye im engeren Sinn?

3. Welche unterschiedliche graphische Darstellung muss in der multiplen

Regressionsanalyse gewählt werden? Was ist der Intercept?

4. Was sind Störgrößen?

5. Geben Sie ein Beispiel.

6. Welche Voraussetzungen müssen die Störgrößen im linearen Modell erfüllen?

7. Wenn bei Testinstrumenten zwei Faktoren korrelieren, diese Korrelation aber

ausgeschaltet oder zumindest verringert werden soll: Welche Möglichkeiten hat man

hierzu in der Regressionsanalyse?

8. Welche Korrelationen der Prädiktoren sind in der multiplen Regression erlaubt?

Welche nicht?

9. Welche Verteilungsannahmen hat man in Bezug auf die Störgrößen?

10. Wie können sich die Regressionskoeffizienten in einer multiplen Regressionsanalyse

in verschiedenen Modellen unterscheiden? Bei welchem Fall unterscheiden sie sich

nicht?

11. Wieviele unabhängige Variablen darf man maximal in einer Regressionsanalyse

verwenden?

12. Nennen Sie die Eigenschaften der Residuen der multiplen Regression.

13. Was ist der multiple quadrierte Korrelationskoeffizient?

14. Wieviele verschiedene Modelle gibt es bei der multiplen Regressionsanalyse mit p

Prädiktoren?

15. Welche Aussage kann bezüglich der Korrelation der Prädiktoren getroffen werden,

wenn sich die Regressionskoeffizienten in verschiedenen Modellen unterscheiden?

16. Wann ist die prädiktive Relevanz eines Merkmales sequenzunabhängig?

17. Was sind semipartielle Determinationskoeffizienten?

18. Was sind partielle Determinationskoeffizienten?

19. Verbalisieren Sie:

r ya2 . gs

=

FR ( a. gs)

F(gs)

=

F( gs )-F (ags )

F(gs)

= 0.159.

Welcher Determinationskoeffizient wurde hier berechnet?

20. Verbalisieren Sie:

r y2( a. g s )

FR ( a. gs)

= F(-) =

berechnet?

F( gs )-F (ags )

F(-)

= 0.048. Welcher Determinationskoeffizient wurde hier

21. Warum ist der partielle Determinationskoeffizient größer oder gleich wie der

semipartielle Determinationskoeffizient?

22. Wie kann der multiple Determinationskoeffizient additiv oder multiplikativ durch

semipartielle oder partielle Determinationskoeffizienten dargestellt werden?

Lösungsvorschläge

1. In der linearen Regression müssen alle unabhängigen Variablen quantitativ sein. (Dummys

gelten als quantitativ). Im linearen Modell können die unabhängigen Variablen quantitativer

oder qualitativer Art sein, die abhängige Variable sollte, wie in der linearen Regression,

mindestens Intervallskalenniveau besitzen. Im generalisierten linearen Modell können sowohl

unabhängig als auch abhängige Variablen qualitativer oder quantitativer Art sein. Die

Varianzanalyse wird als lineares Modell ( mit qualitativen UV ) betrachtet. Faktoren

entsprechen den UV, man sollte sich daher nicht verwirren lassen, wenn bei der

Varianzanalyse von Faktoren gesprochen wird.

2. Als Kovarianzanalyse bezeichnet Scheffè (1959) jede Regressionsanalyse, die sowohl

quantitative Merkmale als Prädiktoren als auch qualitative Prädiktoren enthält. Etwas

eingeschränkter wird unter Kovarianzanalyse ein Verfahren verstanden, das erlaubt

Gruppenunterschiede (qualitativer Faktor) zu untersuchen, obwohl bekannt ist, dass die

Gruppen in einem (oder mehreren) quantitativen Merkmal (Kovariate genannt)

unterschiedlich sind, das seinerseits für den Prädikanden relevant ist. Durch ‚Konstanthaltung

der Kovariaten’ soll die Vergleichbarkeit hergestellt werden. Diese Form der Analyse sei als

„Kovarianzanalyse im engeren Sinne“ bezeichnet, die allgemeinere, von Scheffè (1959)

eingeführte, Bezeichnung als Kovarianzanalyse im weiteren Sinn.

3. Multiple Regression (mit mindestens zwei Faktoren) führt nicht mehr zu einer

zweidimensionalen Prädiktionsgeraden wie die einfache Regression, sondern zu einer Ebene

im dreidimensionalen Raum. Der Intercept ist hier dann jene Stelle, an der x1 und x2 Null sind.

In manchen Untersuchungssituationen ist es inhaltlich unsinnig, den Intercept an den

Nullstellen der beiden Prädiktoren gesetzt zu haben. (z.B. in einer Prädiktion von

Körpergröße und Alter auf den Prädikand Gewicht). Daher wird manchmal auf die

Mittelwerte zentriert, so dass der Intercept dann an der Stelle der Mittelwerte von x1 und x2

ist.

4. Als „Störgrößen“ werden die Abweichungen der wahren Werte von den durch die

Regressionsanalyse prädizierten Werten bezeichnet.

5. Wohnenbeispiel: Eigentlich müsste ein Mann 17.5 Euro pro Woche bekommen, wenn er

zuhause wohnt. Jetzt sind seine Eltern aber so reich, dass er zwanzig Euro bekommt. Diese

2.5 Euro bezeichnet man als Störgröße (man könnte sie vielleicht auch erklären, aber man

lässt diesen Faktor raus, um es nicht zu kompliziert werden zu lassen.)

Störgrößen sind auch die Summen jener Variablen, die man rauslässt, um das Modell nicht zu

kompliziert werden zu lassen. ABER! Bemerke, diese Einflüsse haben keinen systematischen

Effekt! (Es gibt zum Beispiel auch Eltern, die arm sind und der Sohn daher ein wenig weniger

als 17.5 Euro bekommt)

Wenn man die Parameter der Population hätte, könnte man die Störgrößen genau prädizieren.

6. Voraussetzung für das lineare Modell

Man unterstellt auch, dass die Störgrößen nicht mit den unabhängigen Variablen korrelieren.

Wenn die Störgrößen korrelieren, muss das lineare Modell verworfen werden. Auch die

Residuen werden so konstruiert, dass sie nicht mit den UV korrelieren.

7. Beispiel: Kreativitätsmessung.

In der Messung mithilfe von Instrumenten (also zum Beispiel in Kreativitätstests ) ist die

Kreativität meist nicht unkorreliert mit Intelligenz.

Wie kann man es schaffen, dass die beiden überhaupt nicht mehr korrelieren?

Man stelle sich eine einfache Regression vor, mit einem zweidimensionales Streudiagramm.

In die Daten kann die Regressionsgerade gelegt werden und die Residuen angegeben werden.

→ Residuen sind nun jene Werte, die von der Intelligenz nicht prognostiziert werden können.

Man kann also sagen, die Residuen stellten die Kreativität dar, bereinigt durch den Einfluss

von Intelligenz. Das Residuum korreliert dann nicht mehr mit IQ.

8. Unabhängige Variablen dürfen in der Regressionsanalyse miteinander korrelieren, aber auf

keinen, auf gar keinen Fall mit der Störgröße.

Achtung auch bei einer Korrelation eines Faktor Z, dessen Ausprägungen vielleicht nicht

erhoben worden sind, der eine Korrelation zwischen der Störgröße und einer oder mehreren

der UV herstellt.

Auch eine solche Korrelation ist strengstens verboten.

Sie dürfen korrelieren, aber nicht linear oder kolinear abhängig sein.

Es gibt keinen Prüfwert auf Kollinearität, R2 sollte aber nicht über .95 liegen.

9. Annahme: Bei der Datengenerierung werden die Störgrößen unabhängig aus einer NV

gezogen.

Das heißt die Störgrößen der Person haben die gleiche Variabilität (

Homoskedastizitätsannahme ).

10. Durch eine Einführung einer weiteren UV können sich die Regressionskoeffizienten der

anderen UVs ändern, u.U. auch von positive in negative Werte.

Es genügt nicht zu schauen, wie hoch die Korrelation zwischen AV und UV ist, da sich diese

Korrelation auch erst ergeben kann, wenn eine andere UV hinzugefügt wird.

Daraus resultiert der Irrtum, sich nur eine UV anzusehen. Denn man kann immer nur die

einzelnen UVs betrachten, wenn sie alle untereinander zu Null korrelieren. (das ist meist nicht

der Fall)

Wenn UV zu Null korrelieren, bleiben Regressionskoeffizienten in allen Modellen gleich.

Achtung: Es kann sein, dass bei Hinzufügen einer weiteren Variable mehr prognostiziert

werden kann (also Fehlerquadrate reduziert werden können), das muss aber nicht sein.

11. Daumenregel: Für jede Variable, die man hat, braucht man ca. 5-10 Fälle.

Es hängt auch von der Korrelation zwischen den UV ab. Wenn die Korrelation zwischen den

Prädiktoren 0 sind, braucht man weniger Versuchspersonen; dann verändern sich die

Regressionskoeffizienten nicht, wenn zusätzliche Prädiktoren hinzugefügt werden.

Die Anzahl der Beobachtungen wird beim Testen berücksichtigt (z.B. beim F-Test in den

Freiheitsgraden von ssqe(within) und ssqe(total))

12. Der arithmetische Mittelwert aller Residuen ist Null. Die Korrelation der Residuen mit

allen x Variablen ist Null.

13. Ein PRE- Maß, das das Mit-Fehlermaß (Summe der quadrierten Residuen; enthält alle p

Prädiktoren) und das Ohne-Fehlermaß (Summe der quadrierten Abweichungen vom

Mittelwert)

14. 2p Modelle.

15. Wenn sich die Regressionskoeffizienten in verschiedenen Modellen unterscheiden,

korrelieren sie miteinander.

16. Wenn die Prädiktoren nicht wechselseitig korrelieren.

17. Der semipartielle Determinationskoeffizient ist die globalanteilige Reduktion des Fehlers

durch ein Merkmal ‚unter Konstanthaltung’ anderer Merkmale. Basis der Anteilsbildung ist

der Fehler ohne jedes Merkmal.

18. Der partielle Determinationskoeffizient ist die anteilige Reduktion des Fehlers durch ein

Merkmal ‚unter Konstanthaltung’ anderer Merkmale. Basis der Anteilsbildung ist der Fehler

an der Stelle, an der das Merkmal hinzugefügt wurde.

19. Unter Konstanthaltung von g und s kann die Prädiktion von y durch a um 15.9%

verbessert werden. Dies ist ein partieller Determinationskoeffizient.

20. Unter Konstanthaltung von g und s kann die Prädiktion von y durch a um 4.8% global

verbessert werden. Dies ist ein semipartieller Determinationskoeffizient.

21. Weil der semipartielle Determinationskoeffizient durch einen größeren Fehler dividiert

wird als der partielle.

22. Der multiple Determinationskoeffizient kann additiv durch semipartielle, multiplikativ

durch partielle Determinationskoeffizienten dargestellt werden.

Sitzung 8

Semipartielle und partielle Determinationskoeffizienten

1. Der semipartielle Determinationskoeffizient

r y2( a. g s )

kann auch als quadrierte Korrelation zweier Variablen beschrieben werden.

Welche Variablen sind dies?

2. Der partielle Determinationskoeffizient

r ya2 . gs

kann auch als quadrierte Korrelation zweier Variablen beschrieben werden.

Welche Variablen sind dies?

3. Auch der multiple Determinationskoeffizient kann als Korrelation zweier

Variablen intepretiert werden. Welche?

Für die Formeln zur Berechnung der Korrelationen siehe Skript zur Einführung in die Statistik, Abschnitt 5.4.4.2

Semipartielle und partielle Korrelation.

Venn-Diagramme

y

E

A

C

B

D

x

z

4. Angenommen, die abhängige Variable Y werde durch die beiden Prädiktoren

X und Z erklärt. Welcher Teil der Grafik stellt den semipartiellen

Determinationskoeffizient r 2y(x.z) dar ?

5. Welcher Teil der Grafik stellt den einfachen Determinationskoeffizienten r2yx

dar?

6. Welcher Teil der Grafik stellt den multiplen Determinationskoeffizient dar?

Welcher Teil 1- R2?

7. Wie kann mithilfe einiger Teile der Grafik ein partieller

Determinationskoeffizient beschrieben werden? (am Beispiel: r2yx.z)

8. Was ist bei einer Darstellung mittels Venn-Diagramm zu beachten? Auf

wieviele Merkmale kann eine Darstellung erweitert werden?

Analyse zweier Merkmale – zusammenfassende Wiederholung

9. Nennen Sie die wichtigsten Verfahren, die zur Analyse einer quantitativen

abhängigen Variable (mind. intervallskaliertes y-Merkmal) durchgeführt

werden können.

10. Nennen Sie die wichtigsten Verfahren zur Analyse einer qualitativen

abhängigen Variable.

11. Welche Vorteile hat der t-Test gegenüber einer Regressionsanalyse? Welche

Nachteile gibt es?

Standardisierte Regressionskoeffizienten

12. In einer multiplen Regressionsanalyse kann die Frage interessieren, welche

Variable den stärksten Effekt hat. Wodurch wird der Effekt einer Variable

ersichtlich?

13. Wodurch kann die Vergleichbarkeit der Regressionskoeffizienten verhindert

werden?

14. Was kann getan werden, um die Regressionskoeffizienten vergleichbar zu

machen?

15. Verbalisieren Sie, welchen Einfluss ein standardisierter Regressionskoeffizient

angibt.

16. Warum ist es daher unsinnig, eine dichotome Variable zu standardisieren?

17. Welche Einschränkungen müssen bezüglich der standardisierten

Regressionskoeffizienten unterschiedlicher Datensätze beachtet werden?

18. Was ist der Unterschied zwischen der Normierung und der Standardisierung?

19. Welche Fehlermaße gibt es außer Cohens d?

20. Wann ist Cohens d äquivalent zum standardisierten Regressionskoeffizienten?

Faktorenanalyse

21. Welche Fragestellung soll mittels Faktorenanalyse untersucht werden?

22. In welcher Beziehung stehen manifeste und latente Variablen?

23. Es gibt verschiedene Vorgehensweisen, bzw. Annahmen über Koeffizienten.

Welche?

24. Was sind die sog. Ladungen?

25. Was ist das Modell der gemeinsamen Faktoren (common factors model)?

26. Beim Modell der gemeinsamen Faktoren wird zusätzlich zu den gemeinsamen

Faktoren noch eine andere Größe mit in die Linearkombination genommen.

Welche ist das und welche Voraussetzung muss sie erfüllen?

27. Unter welchen Voraussetzungen sind die Ladungen gleich den Korrelationen

zwischen den Faktoren und den manifesten Variablen?

28. Was ist das Hauptkomponentenmodell?

29. Was bedeutet Orthogonalität?

30. Warum können Korrelationen zwischen X-Variablen, die von demselben

Faktor erklärt werden, als Scheinkorrelationen enttarnt werden?

31. Was ist eine Kommunalität?

32. Geben Sie eine Formel zur Berechnung der Varianz eines Items bei Erklärung

durch einen Faktor an.

33. Geben Sie eine Formel zur Berechnung der Varianz eines Items bei Erklärung

durch zwei Faktoren an.

34. Wie können die Faktoren interpretiert werden?

35. Was ist eine Spezifität?

36. Wie hoch korrelieren die Spezifitäten mit den Faktoren?

37. Wie wird die Varianz, die ein Faktor in allen Variablen erklärt, berechnet?

Wofür ist diese Berechnung wichtig?

Lösungsvorschläge

1. Der semipartielle Determinationskoeffizient kann als quadrierte Korrelation

zwischen y und den Residuen von a unter der Konstanthaltung von gs

interpretiert werden.

2. Der partielle Determinationskoeffizient kann als quadrierte Korrelation

zwischen dem Residuum y.s und und dem Residuum a.gs interpretiert werden.

3. Die multiple Korrelation kann als einfache Korrelation der y-Werte mit den

Prädiktionswerten ŷ(x1 , x 2 ,...,x p ) interpretiert werden, kurz: Korr(y, ŷ ). Die

quadrierte Korrelation ist dann auch der Determinationskoeffizient, der angibt,

wie gut die y-Werte durch die p x-Variablen prognostizierbar sind.

4. A - die Schnittfläche zwischen x und y ohne C - stellt den semipartiellen

Determinationskoeffizient r 2y(x.z) dar.

5. A+C

6. A+B+C. Der Varianzanteil der Variablen y, der nicht durch die Prädiktoren x

und z erklärt werden kann ist mit E graphisch dargestellt. (und entspricht 1R2).

A

7. Der partielle Determinationskoeffizient r2yx.z kann durch

beschrieben

( A E)

werden.

8. Bei Darstellung von mehr als zwei Variablen sind auch negative Flächen

möglich. Je mehr Variablen hinzugenommen werden, desto größer wird die

Gefahr negativer Flächen. Grundsätzlich können mehr als drei Variablen

dargestellt werden, im Einzelfalle sollte aber zu Gunsten der Übersichtlichkeit

davon abgeraten werden.

Bei einer Darstellung mithilfe eines Venn-Diagramms ist zu beachten, dass

durch die Darstellung mit Kreisen keine flächengetreue Darstellung möglich

ist.

9. Bei qualitativen unabhängigen Variablen: Vergleiche zweier Mittelwerte,

Varianzanalyse, Vergleiche von Varianzen. Nichtparametrische Verfahren (bei

Verletzung von Verteilungs-Voraussetzungen)

Bei ordinalen unabhängigen Variablen: Mittelwerttests, Varianzanalyse

Bei quantitativen unabhängigen Variablen: Pearson- Korrelation,

Regressionsanalyse

Merke: Auch eine qualitative unabhängige Variable kann als Prädiktor in eine

Regressionsanalyse eingeführt werden und zwar dann, wenn sie als Dummy

kodiert wurde.

10. Bei qualitativen unabhängigen Variablen: Kreuztabellenanalysen, ChiQuadrat, Nominale Korrelation (Chi-Quadrat-Normierungen, GOODMANs ,

KRUSKALs , kappa), Analyse mit loglinearen und nominal-logistischen

Modellen.

Bei quantitativen unabhängigen Variablen: Analyse mit nominal-logistischen

Modellen (logistische Regression)

Auch bei qualitativen abhängigen Variablen gilt in der Regressionsanalyse die

Verwendung qualitativer unabhängiger Variablen als Dummy-Variablen

kodiert als zulässig.

11. Ein Vorteil des t-Test gegenüber der Regressionsanalyse liegt darin, dass im ttest unterschiedliche Varianzen berücksichtigt werden können (vgl. Welch 2sample test), wohingegen die Gleichheit der Varianz in der Regressionsanalyse

vorausgesetzt ist.

Ein Vorteil der Regressionsanalyse gegenüber dem t-Test ist, dass mehrere

unabhängige Variablen und deren Einfluss beachtet werden kann. Ein weiterer

liegt natürlich darin, dass verschiedene Funktionen herangezogen werden

können, um die Daten zu beschreiben (vgl. logistisches Modell,

Linearkombination, Poisson-Verteilung etc.)

12. Der jeweilige Regressionskoeffizient misst den Effekt der Variable.

13. Werden die Prädiktoren in unterschiedlichen Masseinheiten angegeben, ist die

Vergleichbarkeit zwischen ihnen erschwert, bzw. verhindert.

14. Die Regressionskoeffizienten werden vergleichbar, wenn sie standardisiert

wurden. Multipliziert man die unstandardisierten Regressionskoeffizienten mit

den Standardabweichungen der jeweiligen unabhängigen Variable und teilt

dies durch die Standardabweichung der abhängigen Variable, erhält man die

standardisierten Regressionskoeffizienten, die nunmehr vergleichbar sind.

Zum Beispiel: y a b1

s(x1)

x1

*

s(y) s ( x1)

Achtung: Die Koeffizienten sind nicht auf einen bestimmten Wertebereich

begrenzt, können also größer als 1 und kleiner als -1 werden.

15. Der standardisierte Regressionskoeffizient gibt an, um wieviele

Standardabweichungen sich die abhängige Variable ändert (senkt oder erhöht,

je nach Vorzeichen des Regressionskoeffizienten), wenn sich die unabhängige

Variable um eine Standardabweichung erhöht.

16. Es ist unmöglich, den Fall zu interpretieren, dass sich zum Beispiel

‚Geschlecht‘ um eine Standardabweichung ändert.

17. Wird dasselbe Regressionsmodell in unterschiedlichen Datensätzen berechnet,

ist die Vergleichbarkeit der Regressionskoeffizienten eingeschränkt bzw.

verhindert, da die Variablen unterschiedliche Streuungen aufweisen können.

18. Bei einer Normierung wird durch die Standardabweichung geteilt. Bei der

Standardisierung wird zusätzlich noch der Mittelwert abgezogen (vgl. zTransformation).

19.

- Determinations-Koeffizient 1. und 2. Art

- Prozentuale Fehlerreduktion

- Entropiereduktion