Statistische Datenanalyse

Werbung

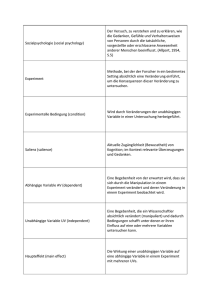

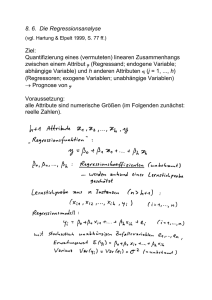

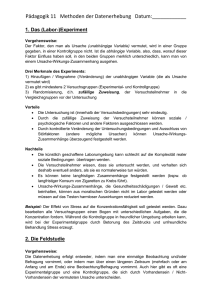

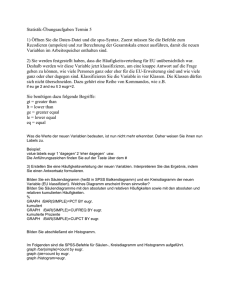

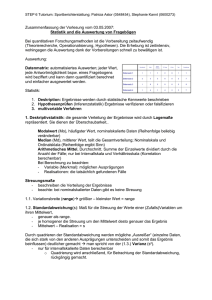

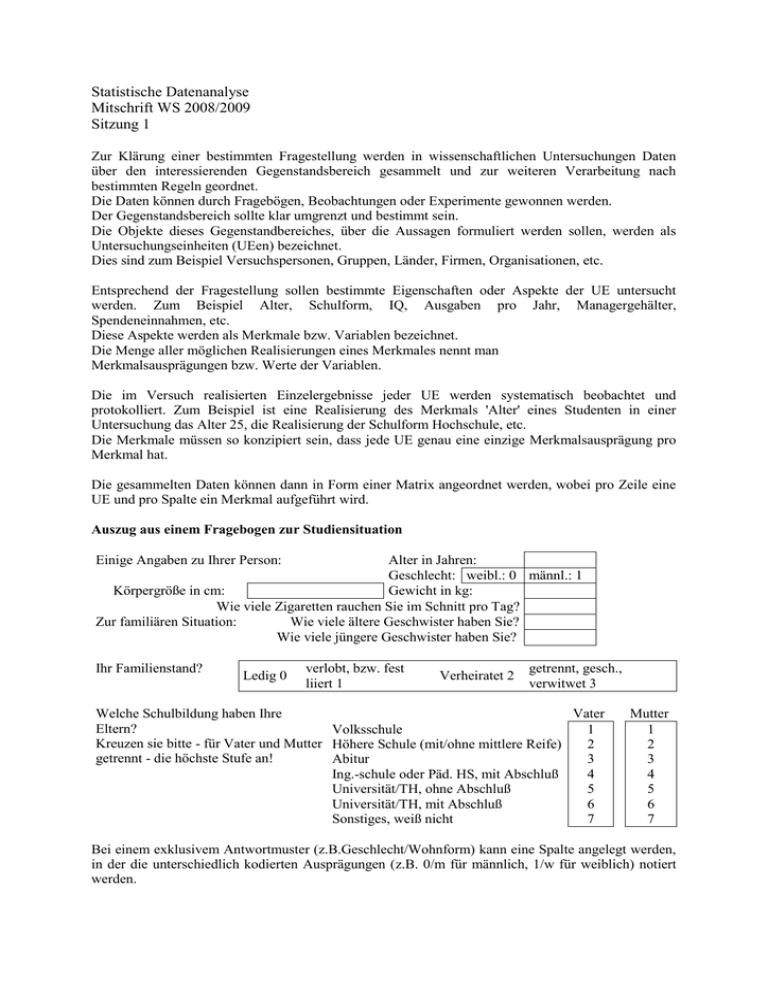

Statistische Datenanalyse Mitschrift WS 2008/2009 Sitzung 1 Zur Klärung einer bestimmten Fragestellung werden in wissenschaftlichen Untersuchungen Daten über den interessierenden Gegenstandsbereich gesammelt und zur weiteren Verarbeitung nach bestimmten Regeln geordnet. Die Daten können durch Fragebögen, Beobachtungen oder Experimente gewonnen werden. Der Gegenstandsbereich sollte klar umgrenzt und bestimmt sein. Die Objekte dieses Gegenstandbereiches, über die Aussagen formuliert werden sollen, werden als Untersuchungseinheiten (UEen) bezeichnet. Dies sind zum Beispiel Versuchspersonen, Gruppen, Länder, Firmen, Organisationen, etc. Entsprechend der Fragestellung sollen bestimmte Eigenschaften oder Aspekte der UE untersucht werden. Zum Beispiel Alter, Schulform, IQ, Ausgaben pro Jahr, Managergehälter, Spendeneinnahmen, etc. Diese Aspekte werden als Merkmale bzw. Variablen bezeichnet. Die Menge aller möglichen Realisierungen eines Merkmales nennt man Merkmalsausprägungen bzw. Werte der Variablen. Die im Versuch realisierten Einzelergebnisse jeder UE werden systematisch beobachtet und protokolliert. Zum Beispiel ist eine Realisierung des Merkmals 'Alter' eines Studenten in einer Untersuchung das Alter 25, die Realisierung der Schulform Hochschule, etc. Die Merkmale müssen so konzipiert sein, dass jede UE genau eine einzige Merkmalsausprägung pro Merkmal hat. Die gesammelten Daten können dann in Form einer Matrix angeordnet werden, wobei pro Zeile eine UE und pro Spalte ein Merkmal aufgeführt wird. Auszug aus einem Fragebogen zur Studiensituation Einige Angaben zu Ihrer Person: Alter in Jahren: Geschlecht: weibl.: 0 männl.: 1 Körpergröße in cm: Gewicht in kg: Wie viele Zigaretten rauchen Sie im Schnitt pro Tag? Zur familiären Situation: Wie viele ältere Geschwister haben Sie? Wie viele jüngere Geschwister haben Sie? Ihr Familienstand? Ledig 0 verlobt, bzw. fest liiert 1 Verheiratet 2 getrennt, gesch., verwitwet 3 Welche Schulbildung haben Ihre Vater Eltern? Volksschule 1 Kreuzen sie bitte - für Vater und Mutter Höhere Schule (mit/ohne mittlere Reife) 2 getrennt - die höchste Stufe an! Abitur 3 Ing.-schule oder Päd. HS, mit Abschluß 4 Universität/TH, ohne Abschluß 5 Universität/TH, mit Abschluß 6 Sonstiges, weiß nicht 7 Mutter 1 2 3 4 5 6 7 Bei einem exklusivem Antwortmuster (z.B.Geschlecht/Wohnform) kann eine Spalte angelegt werden, in der die unterschiedlich kodierten Ausprägungen (z.B. 0/m für männlich, 1/w für weiblich) notiert werden. UE Alter Sex Größe 1 .. 24 m 182 Gewicht Anz. Anz. Zigarett. jünger. Geschwister 80 8 -- Anz. älterer Geschw. 2 Fam. stand Bildung Bildung Vater Mutter Ledig 4 3 In einer Spalte darf nie mehr als eine Information verzeichnet werden. Manchmal werden die UE auch kontrollierten Behandlungen (Treatments) ausgesetzt. Ein Beispiel für dieses zentrale Element des Experimentierens findet sich im Alten Testament im Buch Daniel (1. Kap.). Daniel und seine Freunde (Ananias, Misael, und Azarias) sind als jüdische Jugendliche vornehmer Herkunft während der babylonischen Gefangenschaft an den Hof Nebukadnezars verschleppt worden. Sie erhalten dort eine babylonische Erziehung und bekommen das gleiche Essen wie der König. Daniel und seine Freunde würden allerdings lieber streng jüdische Essensvorschriften einhalten; sie wollen auf das dargebotene Fleisch und den Wein verzichten. Sie wenden sich mit dieser Bitte an den Oberkämmerer. Seine Bedenken bezüglich der Schönheit und Vollheit der Freunde kann Daniel durch ein Experiment zerstreuen. Aufgrund des folgenden Berichtes sind zwar die Ergebnisse des Experimentes nicht exakt bekannt. Dem Bericht würden die folgenden Daten zumindest nicht widersprechen (Schönheit und Vollheit seien auf einer Skala mit 5 Stufen gemessen worden). Da sprach der Oberkämmerer zu Daniel: „Ich fürchte meinen Herrn, den König, der euch Speis und Trank bestimmte. Fänd er, dass euere Gesichter schmächtiger als die der anderen Knaben eueres Alters wären, so brächtet ihr beim König mich um meinen Kopf“. Darauf sprach Daniel zum Wächter, den der Oberkämmerer über Daniel, Ananias, Misael und Azarias gesetzt: „Versuch es bitte doch 10 Tage lang mit deinen Knechten. Man gebe uns nur Gemüse zu essen und Wasser zu trinken. Besieh dir dann unsere Gesichter und die der anderen Knaben, die von der königlichen Kost genießen. Und je nachdem, wie der Befund ausfällt, magst du mit deinen Knechten verfahren“. Nach Ablauf der 10 Tage aber waren ihre Gesichter sichtlich schöner wie auch voller als die aller anderen Knaben, die von königlicher Speise zu genießen pflegten. So ließ fortan der Wächter ihre Speise wegnehmen mitsamt dem Wein, den sie genießen sollten; er brachte ihnen dafür nur Gemüse. (AT Daniel, 1. Kap:, Vers 1016)1 Schön schoen4 6 5 M D 4 Az An 3 3 2 6 1 4 1 5 2 D 0 0 1 2 3 voll4 Voll 4 5 6 Die Datenpunkte können in die Form einer Datenmatrix übertragen werden mit den Merkmalen Schön und Voll. Als weitre Merkmale werden noch der Name der Versuchsperson (=Vp) und die Gruppenzugehörigkeit zur Experimental- bzw. Kontrollgruppe eingeführt. Da eine zufällige Zuordnung der VP in diesem speziellen Falle nicht möglich war, interessiert die Frage, ob der Unterschied zwischen den Gruppen in Vollheit und Schönheit schon vor der Behandlung bestanden hat, bzw. wie die Behandlung über den untersuchten Zeitraum verlaufen ist. Der gefundene Unterschied könnte also nicht durch das Treatment entstanden sein, sondern von einer anderen Variable abhängig sein. Zum Zwecke der Überprüfung dieser Möglichkeit können Messungen an Tag 1,4,7 und 10 der Untersuchung bzgl. der Vollheit und Schönheit durchgeführt werden. Die erhaltenen Daten können auf zwei Arten gruppiert werden. Bei solch einem Vorgehen muss die Abhängigkeit der Messungen beachtet werden. UE in Zeitreihenanalysen sind nicht unterschiedliche ‘Entitäten‘ (Versuchspersonen, Organisationen etc.) sondern verschiedene Datenmatrix Zeitpunkte. Die Messungen einer Person zu verschiedenen name gruppe Schoen Voll Zeitpunkten sind voneinander nicht völlig 1. UE 1 control 2 3 unabhängig (wie in unverbundenen 2. UE 2 control 1 3 Stichproben, in denen die UEen verschiedene 3. UE 3 control 3 2 Versuchspersonen sind). 4. UE 4 control 2 2 Zur Behebung dieses Problems kann eine 5. UE 5 control 1 2 Personenvariable eingeführt werden, die 6. UE 6 control 2 1 interindividuelle Unterschiede 7. UE Daniel exp 5 5 vergleichbar machen lässt. (z.B. Korrektur 8. UE ananias exp 4 5 durch die Varianz). 9. UE azarias exp 4 4 Weitere Datenstrukturen, 10. UE misael exp 5 4 enthalten, sind Mehrebenendatensätze (Land - Bundesland - Schule - Klasse - Lehrer) und Netzwerke.(z.B. Interaktionen zwischen VP oder Gruppen) die Auch ein Buch kann als Datenstruktur mit mehreren Ebenen bezeichnet werden (Kapitel - Unterkapitel - Paragraph - Absatz - etc. ) Abhängigkeiten 1.2 Zusammenfassung zur uni- und bivariaten Statistik Deskription Variablen 1 Verbal Lagemaße Streuungsmaße etc. Grafisch Histogramme Boxplots 2 Kovarianz Korrelation 2-Test auf Unabhängigkeit PRE-Maße Regressionsanalyse Streudiagramm Mosaicplots Induktion , , ,... - Anpassungstest, Mittelwertstest etc. , Hat eine der Variablen distinkte Ausprägungen (z.B. Geschlecht), kann das 3dimensionale Streudiagramm auf zwei Dimensionen abgebildet werden. Meist wird die 3. Variable als Kontrollvariable eingeführt, um Scheinkorrelationen oder ScheinNichtkorrelationen ausschließen zu können. Anzahl Jahre mit den „Dritten“ A B Anzahl Äpfel am Tag Fragen (Sitzung 1) 1. 2. 3. 4. 5. 6. 7. 8. 9. 10. 11. 12. 13. 14. 15. 16. 17. Würde man etwa den Zusammenhang zwischen der Variable „Anzahl gegessener Äpfel am Tag“ und der Variable „Verbrachte Jahre mit den Dritten“ in einer Männerstichprobe untersuchen, könnte man aufgrund einer Scheinkorrelation die Annahme machen, je mehr Äpfel man zu sich nehme, desto schneller fielen einem die Zähne aus. Betrachtet man jedoch die dritte Variable „Alter“(hier in zwei Kreisen als zwei Kohorten – Männer zwischen 50-70 (A) und Männer zwischen 20 -50 (B) - skizziert) entpuppt sich die Annahme einer Korrelation zwischen x und y als fehlerhaft. Was sind Untersuchungseinheiten und welchen Platz nehmen sie im Experiment ein? Was sind Variablen? Geben Sie Beispiele. Wandeln Sie den Studentenfragebogen in eine Datenmatrix um. Wieviele Spalten würden Sie für ein Merkmal mit exklusivem Antwortmuster (z.B. ‘Geschlecht‘) angelegen? Begründen Sie Ihre Entscheidung. Wieviele Informationen dürfen Sie maximal in einer Spalte angeben? Was gilt als zentrales Element des Experimentes? Was ist ein Quasi-Experiment? Geben Sie Beispiele. Wandeln Sie das Streudiagramm der Daniel-Daten in eine Datenmatrix um. Was ist eine Zeitreihenanalyse? Welche UE werden hier untersucht? Geben Sie ein Beispiel für eine Zeitreihenanalyse mit mehreren Variablen. Was ist eine Mehrebenenuntersuchung? Geben Sie ein Beispiel. Welche Untersuchung würde zu einer Datenstruktur in Form eines Netzwerkes führen? In wiefern sind Daten aus Mehrebenenuntersuchungen, Zeitreihenanalysen und Netzwerken abhängig? Geben Sie Beispiele für eine univariate und eine bivariate Fragestellung. Wozu wird meist eine dritte Variable eingeführt? Was ist eine Scheinkorrelation? Geben Sie Beispiele. Was ist eine Schein-Nichtkorrelation? Geben Sie Beispiele. 18. Welche Maßzahlen verwendet man zur Beschreibung univariater Daten? Welche für bivariate? 19. Wie können bivariate Daten grafisch dargestellt werden? 20. Was bedeutet Induktion? Nennen Sie Beispiele für die Induktion von Maßzahlen univariater Datensätze. Statistische Datenanalyse Mitschrift WS 2008/09 Sitzung 2 Erste Schritte in R - Commander laden Taskleiste (TL) Pakete – Lade Paket – Rcmdr - Datenmatrix bearbeiten Die Datenmatrix kann verändert werden. Wird gerade eine Statistik gerechnet, lässt sich diese Option nicht anwählen, stattdessen kann die Datenmatrix betrachtet werden. - Ein Streudiagramm erstellen TL Grafiken - Daten importieren TL Datenmanagment – Daten importieren Übungsfragen (Sitzung 2) 1. Nennen Sie eine mögliche Fragestellung zur ersten Analyse der Danieldaten. 2. Welche Fragestellungen könnten bei der Untersuchung eines intervallskalierten yMerkmals und eines nominalen x-Merkmals untersucht werden? 3. Mit welchem Test kann man Mittelwertsunterschiede der Gruppen untersuchen? 4. Was ist eine zweiseitige Fragestellung? 5. Wann wird ein Test signifikant? 6. Was bedeutet das Signifikanzniveau alpha? 7. Was ist der Fehler 2.Art? 8. Was ist die Macht des Testes (Power)? Wann erst kann die Macht eines Testes berechnet werden? 9. Was ist der p-Wert? 10. Was meint die Bezeichnung „95% Konfidenzintervall“? 11. Warum kann man u.U. von einem Konfidenzintervall die Signifikanz eines Testes ablesen? 12. Welcher Test kann zur Überprüfung der Gleichheit zweier Varianzen verwendet werden? 13. Welche zwei Freiheitsgrade müssen bei einer Testung mit der F-Verteilung angegeben werden? 14. Welche Voraussetzung muss gegeben sein, um einen parametrischen Test anwenden zu können? 15. Welcher Teststatistiken kann man sich bedienen, wenn diese Voraussetzung nicht erfüllt ist? 16. Nennen Sie einen nichtparametrischen Test zur Untersuchung von Lageunterschieden, wenn a. die Variablen ordinalskaliert sind b. die Variablen intervallskaliert sind 17. Wofür steht die Bezeichnung „Location Shift“? 18. Wann können parametrische Tests trotz der Verletzung der Normalverteilungsannahme angewendet werden? 19. Was ist der sog. Standardfehler? 1. Zum Beispiel: Gibt es einen systematischen Unterschied zwischen Kontroll- und Experimentalgruppe? Oder anders formuliert: Gibt es zwischen der Variable ‚Gruppe’ und der Ausprägung der Variable ‚Vollheit’/ ‚Schönheit’ einen systematischen Zusammenhang? 2. Sind die Verteilungen unterschiedlich? Unterscheiden sich einzelne Parameter? (z.B. Mittelwerte, Mediane, Streuungen, etc. ) 3. In dem Falle der Danieldaten wähle man einen t-test für unabhängige Stichproben, unter der Voraussetzung, dass die Varianzen verschieden sind.(s. auch Frage 12) -> Welch 2Sample t-test. Freiheitsgrade sind in dieser Lösung nicht ganzzahlig. Sie können aber gerundet werden. (In R: TL Statistik – Mittelwerte vergleichen – t-test für unabhängige SP) 4. Die Formulierung einer Alternativhypothese zur Nullhypothese „Es gibt keine Unterschiede (zwischen den Gruppen, zwischen den Behandlungen etc.)“ bzw. μ1 = μ2 (μ1 μ2 = 0) kann entweder einseitig oder zweiseitig formuliert werden. Die Testung einer einseitig formulierten Alternativhypothese etwa der Form μ1 - μ2 > 0 ist nur gerechtfertigt, wenn Größenunterschiede in die entgegengesetzte Richtung ausgeschlossen werden können – wenn man also sicher ist, dass eine zweiseitige Testung nicht notwendig ist. Solch ein Trugschluss könnte etwa entstehen, wenn man zur Nullhypothese „Es lassen sich keine Intelligenzunterschiede zwischen Schwarzen und Weißen feststellen“ die einseitige Alternativhypothese „Weiße sind intelligenter als Schwarze“ testen würde, ohne ausschließen zu können, dass Schwarze intelligenter sind als Weiße. Eine zweiseitig formulierte Alternativhypothese führt also zu einem zweiseitigen kritischen Bereich unter Geltung der Nullhypothese, die Richtung des Effektes ist nicht im Vorhinein festgelegt. 5. Wenn der TW (Testwert) in den kritischen Bereich (KB) fällt. Bzw. der p-Wert kleiner als das vorgegebene Signifikanzniveau ist. 6. Der alpha-Fehler (der Fehler 1.Art ) bezeichnet unter Geltung der Nullhypothese die W´keit, den Fehler zu machen, die Nullhypothese abzulehnen, obwohl sie richtig ist. Je kleiner alpha, desto höher ist das Signifikanzniveu. Ein Signifikanzniveau von 0.05 wird als signifikant, eines von 0.01 als sehr signifikant und eines von 0.001 als hochsignifikant bezeichnet. 7. Der Fehler 2.Art(oder β-Fehler) bezeichnet die W´keit die Alternativhypothese abzulehnen, obwohl sie richtig ist. Er ist vom wahren Wert des Populationsparameters abhängig. Da dieser bei der Formulierung der Alternativhypothese nicht bekannt ist, kann der Fehler 2.Art nicht berechnet werden. Der Fehler 2.Art wird kleiner je größer der Unterschied zwischen μ0 (angenommener Parameterwert) und μ1 (tatsächlicher Parameterwert) wird je kleiner die Streuung ist je größer die Stichprobe ist je größer alpha ist. Zu den Zusammenhängen zwischen Fehler 1.Art und 2.Art siehe: http://www.uni-konstanz.de/FuF/wiwi/heiler/os/vt-normtest.html Grafische Darstellung des Fehlers 1. und 2.Art. Aus: http://page.mi.fu-berlin.de/mielke/eis/Weber-Fehlerquellen-Parametertest.pdf 8. Die Macht des Testes (1-β) bezeichnet die W´keit, die Alternativhypothese anzunehmen, wenn sie richtig ist. Diese Teststärke ändert sich nach bestimmten Kriterien. (s.o.). Bei der Formulierung einer exakten Alternativhypothese, kann die Macht des Tests und darüber auch der beta-Fehler berechnet werden. Wird ein Test nicht signifikant und die Power des Testes ist niedrig, kann sowohl Null- als auch Alternativhypothese zutreffen. Ist die Power allerdings hoch und der Test nicht signifikant, ist dies ein Hinweis auf die Geltung der Nullhypothese. 9. Der p-Wert bezeichnet unter Geltung der Nullhypothese die W´keit, einen Wert gleich oder extremer dem Testwert im Sinne der Alternativhypothese zu erhalten. 10. Mit einer 95% - W´keit überdeckt das angegebene Intervall den wahren Parameterwert. ( Achtung: Es gibt nicht nur ein Intervall, sondern mehrere, die den wahren Parameterwert überdecken, daher wird eine W´keit angegeben. ) 11. Liegt der angenommene Parameterwert nicht im Konfidenzintervall, wird die Nullhypothese abgelehnt. 12. Der Varianzen-Levene-Test. 13. Zähler: df1 = n( Stichprobe 1) - 1 Nenner: df2= n (Stichprobe 2) – 1 14. Die Werte in der Population müssen normalverteilt sein. 15. Man kann sich eines nichtparametrischen Tests bedienen. 16a. Vorzeichentest 16b. Wilcoxon-Rangsummen-Test 17. Location Shift bezeichnet die Annahme, zwei Verteilung könnten durch Verschieben zur Deckung gebracht werden. Bei dem Wilcoxon-Rangsummen-Test bezeichnet der Location Shift die Alternativhypothese. 18. Bei großer Stichprobengröße nähert sich die Verteilung der Mittelwerte einer NV. Je nach Lageparametern der Stichprobe (Schiefe, Streuung, etc.) variiert die hierzu erforderliche Größe der Stichprobe. 19. Die Standardabweichung der Verteilung einer bestimmten Maßzahl (z.B. des Mittelwertes, der Standardabweichung, Regressionskoeffizienten, etc.) Statistische Datenanalyse Mitschrift 2008/2009 Sitzung 3 R -- Versehentliches Schließen des Rcmdr Geben Sie in die Befehlszeile (ganz unten, beginnend mit ´>´) den Befehl ´Commander ( )´ ein. -- Konvertieren der numerischen Variablen in Faktoren Ist ein Faktor, zum Beispiel Gruppenzugehörigkeit der VPn, als numerische Variable kodiert ( etwa: 0 Experimentalgruppe, 1-Kontrollgruppe ), werden von R nicht alle t-tests zur Ausführung angeboten, da zwischen Faktor und Variable in diesem Fall nicht automatisch unterschieden werden kann. Um dieses Problem zu beheben, gehen Sie zur TL Datenmanagment - Variablen bearbeiten - Konvertiere numerische Variablen in Faktor. Geben Sie nun die entsprechende Variable an, die konvertiert werden soll. Wählen Sie die Option `Etikette´ wird ein neuer Stempel vergeben - es wird eine neue Spalte angelegt (Name: Grf - Gruppenfaktor) und Sie werden dazu aufgefordert, die unterschiedlichen Ausprägungen zu benennen. Sitzung 3 1. Warum liegt ein Wert nicht mit einer bestimmten Wahrscheinlichkeit im Konfidenzintervall? 2. Der Mittelwert verschiedener Stichproben streut weniger stark denn die Stichprobe selbst. Um welchen Faktor? Wie nennt man den somit berechneten Faktor? 3. Was ist die Effektstärke und wie kann sie berechnet werden? 4. Wie verfährt man bei unterschiedlicher Stichprobenvarianz? 5. Warum benötigt man die Effektgröße neben der Berechnung eines statistisch signifikanten Unterschiedes? 6. Wie hängt der t-Wert und d zusammen? Geben Sie eine Formel zu Berechnung an. 7. Wann kann bei verbundenen Stichproben, die den Einfluss einer Behandlung anhand zweier Zeitpunkte untersuchen (e.g. Vorher-Nachher) auf die Analyse des ersten Zeitpunktes verzichtet werden? 8. Welche Voraussetzungen müssen für die Durchführung eines parametrischen Tests gegeben sein? 9. Welcher Test wird, wenn diese Voraussetzungen erfüllt sind, schneller signifikant: Ein parametrischer oder ein nicht-parametrischer Test? 10. Was berechnet die sog. Power-Efficiency? 11. Welche Fragestellungen können mittels einer Regressionsanalyse untersucht werden? Geben Sie ein Beispiel. 12. Welche Vorteile hat eine Regressionsanalyse gegenüber einem t-test? 13. Was ist der sog. Regressionskoeffizient? 14. Was ist die sog. Regressionskonstante? 15. Angenommen, Sie untersuchten den Zusammenhang zwischen der Anbaufläche (in Hektar) auf die Menge an Ernte (in Kg). Was bedeutet der Regressionskoeffizient(Anbaufläche)=2.5? 16. Angenommen, Sie verwendeten die Variable Frost (in Tagen) als Prädiktor für Ernte übersetzen Sie bitte folgende Angabe eines Bauers in Zahlen: " Wenn es dieses Jahr auch nur einen Tag Frost hat, kann ich die Hälfte meiner Ernte wieder vergessen." Lösungen zu den Fragen 1. Zum Einen ist der tatsächliche Parameter der Population keine Zufallsvariable. Es ist ein fester Wert und besitzt daher keine Auftretenswahrscheinlichkeit. Zum anderen ist das Konfidenzintervall kein stets gleichbleibender Bereich. Mit jeder Stichprobenziehung ändern sich die Grenzen des KI. Die Angabe eines 95%-konfidenzintervalls kann beispielsweise folgendermaßen verbalisiert werden: Zu 95% enthält der angegebene Bereich Konfidenzintervalle, die den wahren Wert überdecken. 2. Die Verteilung des sog. Standardfehler des Mittelwerts (allg.: eines Parameters) streut weniger stark denn die Verteilung der Stichprobenwerte um den Faktor 1/√n. Der Standardfehler gilt als die Standardabweichung des Populationsparameters. 3. Mittelwertsunterschiede werden in der Einheit der Standardabweichungen angegeben und sind daher von der Stichprobengröße unabhängig. Ein beliebtes Maß ist Cohen´s d: Nach Cohen´s Faustregel gilt eine Effektstärke unter 0.2 als sehr klein, unter 0.5 als klein, unter 0.8 als mittel und 0.8 und größer als starker Effekt. Bei einer kleinen Stichprobe ohne signifikantes Ergebnis sollte trotzdem die Effektstärke angegeben werden. Je weniger zwei Verteilungen überlappen (je größer also der Unterschied zwischen zwei Verteilungen ist) und/oder je geringer die Streuung ist, desto größer ist die Effektstärke. Siehe hierzu: http://www.bolderstats.com/jmsl/doc/CohenD.html 4. Es muss die mittlere Stichprobenvarianz berechnet werden: pooled = [(1²+ ²) / 2] 5. Die Berechnung der Effektstärke dient der Bestimmung praktischer Bedeutsamkeit eines experimentellen Effektes. Bei der Durchführung eines statistischen Testes kann durch eine Vergrößerung der Stichprobe und durch eine Senkung der Streuung (etwa durch die Auswahl sehr homogener Versuchsteilnehmer) eine Signifikanz erhöht oder erreicht werden. Um nun herauszufinden, ob der Unterschied abgesehen von der Signifikanz tatsächlich und aussagekräftig ist, zieht man die Effektsärke zu Rate. 6. d = 2t / √df 7. Wenn die VPn durch eine randomisierte Auswahl den Gruppen zugeordnet wurden. Mithilfe dieses Verfahrens wird die Annahme verfolgt, durch Randomisierung eine ausgewogenen Verteilung evtl. Unterschiede der VPn, die einen störenden oder verzerrenden Einfluss auf die Versuchsergebnisse haben könnten, auf die beiden Gruppen erreicht zu haben. Die Gruppen seien demzufolge vor der Behandlung in allen relevanten Hinsichten gleich. Ergo kann auf die Analyse des ersten Zeitpunktes verzichtet werden. 8. Intervallskalierte Variablen und normalverteilte Populationswerte. 9. Ein parametrischer Test. 10. Wenn alle Voraussetzungen für einen parametrischen Test erfüllt sind, berechnet die sog. Power-Efficiency die Anzahl der Fälle, in denen ein nicht-parametrischer Test signifikant wird, wenn auch der parametrische Test signifikant geworden ist. Die Power-Efficiency beträgt beispielsweise für den Wilcoxontest .95 und für den Mediantest .65. 11. Mittels Regressionsanalyse soll eine abhängige Variable durch eine oder mehrere unabhängige Variablen erklärt werden. Zum Beispiel kann die Ernte eines Jahres (abhängige Variable) durch Wettereinflüsse (Regenmenge, Sonnenstunden, Niedrigsttemperatur etc.), durch verwendete Dünger, die Anbaufläche, etc. prognostiziert, bzw. erklärt werden. Zur Beschreibung des Zusammenhanges zwischen abhängiger und unabhängiger/n Variablen können verschiedene Funktionen verwendet werden. (z.B. lineare oder logistische Regression). Es soll immer die bestmögliche Anpassung der erklärenden Gerade/Kurve an die Daten erreicht werden. 12. Der Regressionskoeffizient misst den Einfluss der unabhängigen Variable X auf die abhängige Variable Y. Bei einer linearen Regression ist dieser Einfluss (" Wie verändert sich Y, wenn sich X um eine Einheit ändert?") unabhängig von der Größe von X immer gleich und entspricht der Steigung der Geraden. 13. Die Regressionskonstante entspricht dem Wert der abhängigen Variable Y, wenn der Wert der unabhängigen Variablen X Null beträgt. (sog. „Intercept“). Die Interpretation ist nur dann sinnvoll, wenn die unabhängige Variable X tatsächlich einen Wert von Null annehmen kann. 14. Etwa: Bei Vergrößerung der Anbaufläche um einen Hektar, steigt die erhaltene Ernte um 250% / wird aus einem Kilo Tomaten 2.5Kg. 15. y = a + 0.5b + ε Statistische Datenanalyse Mitschrift 2008/2009 Sitzung 4 1. Welchen Vorteil hat eine Regressionsanalyse gegenüber einem t-test? 2. Was ist der Unterschied zwischen einer multivariaten und einer multiplen Regressionsanalyse? 3. Wie bezeichnet man eine Regressionsanalyse, die den Einfluss mehrerer unabhängiger Variablen auf eine abhängige Variable untersucht? 4. Führen Sie eine univariate Regressionsanalyse (UV=Gruppenzugehörigkeit i.e. Experimentalgruppe =1, Kontrollgruppe = 2; AV= 'Change', i.e. Score_1 – Score_2) der Magnetdaten (http://onlinestatbook.com/rvls.html) mithilfe von R durch und interpretieren Sie die Ergebnisse. a. Durch welche Punkte wird die Regressionsgerade gelegt? b. Wie lässt sich der angegebene Intercept interpretieren? c. Wie lässt sich der negative Regressionskoeffizient interpretieren? d. Was würde ein positiver Regressionskoeffizient bedeuten? e. Wie müsste der Regressionskoeffizient aussehen, wenn die Kontrollgruppe zum zweiten Zeitpunkt einen höheren Wert als zum ersten Zeitpunkt aufweisen würde? 5. Wie unterscheidet sich dieses Ergebnis der univariaten Regression von einem t-test auf Mittelwertsunterschiede unter der Annahme der Homoskedastizität? 6. Was ist eine Dummy-Variable? 7. Wie kann in R eine Variable in eine Dummy-Variable umgewandelt werden? 8. Führen Sie nun eine Regressionsanalyse mit den Prädiktorvariablen Gruppe und Score_1 durch. Erläutern Sie, was man dabei unter Konstanthaltung versteht und wie dieses Konzept in diesem Kontext zum Tragen kommt. 9. Zeigen Sie anhand einer Gleichung, warum bei einer Regressionsanalyse mit einer Dummy-Variable als Prädiktor und einer Differenz zweier intervallskalierter Variablen (z.B. Messzeitpunkte, i.e. y2-y1) als Kriterium der Intercept an der Stelle x=0 problemlos interpretiert werden kann. / wann kann bei einer Dummy-Variable als Prädiktor und einer blabla .. der durch die Regressionsanalyse herausgerechnete Intercept problemlos interpretiert werden? 10. Die in Frage 11 vorgestellte Regression soll nun durch eine weitere Prädiktorvariable Z erweitert werden. Zeigen Sie anhand einer Gleichung, wann in dieser Anordnung der Intercept als Mittelwert der mit Null kodierten Ausprägung interpretiert werden kann. 11. Was sind Odds? 12. Was ist eine Odds-Ratio? 13. Berechnen Sie die Odds das Gymnasium zu besuchen und das Abitur zu machen für Kinder mit und ohne Migrationshintergrund. Berechnen Sie die Odds-Ratio. Abitur Kein Abitur Kinder mit Migrationshintergrund Ohne Migrationshintergrund 24 82 76 18 14. Warum und wie rechnet man Odds in Logits um? 15. Was ist die logistische Regression? 16. Welche Unterschiede bestehen zwischen logistischer Regression und linearer Regression? 17. Warum ist die lineare Regression nicht zur Analyse einer binären Variable geeignet? 18. Für die Chile-Daten erhält man folgende Häufigkeiten Odds und Logits: N w m 363 526 Y Odds(py) 480 1.32231405 388 0.73764259 Logit(pY) 0.27938327 -0.30429587 a) Wie groß ist der Unterschied zwischen männlich und weiblich bezüglich der YesLogits? b) Wie groß ist der Yes-Logit für die Frauen? Lösungen 1. Es kann der Einfluss mehrerer unabhängiger Variablen auf eine oder mehrere abhängige Variablen untersucht werden. 2. Eine multivariate Regressionsanalyse untersucht die Auswirkung auf mehrere abhängige Variablen, wohingegen die multiple Regressionsanalyse den Einfluss mehrerer unabhängiger Variablen beschreibt. 3. Univariate multiple Regression. (s. weiterführend: http://www.uni-landau.de/schreiber/archiv/ws03_32/Multivariate1-korr_WHS.pdf ) 4. a. Durch die Mittelwerte der beiden Gruppen. b. Die Regressionskoeffizienten ändern sich stets, wenn eine neue erklärende Variable oder eine neue zu erklärende Variable hinzukommt. Bei dieser einfachen, univariaten Versuchsanordnung lässt sich der Intercept jedoch als Mittelwert der Experimentalgruppe (Active 1) interpretieren. c. Da Change über Score_1 – Score_2 definiert ist, bedeutet ein kleinerer Ergebnis weniger Veränderung – die Experimentalgruppe zeigt also einen stärkeren Rückgang der Schmerzen bzw. eine kleineren Score zum zweiten Zeitpunkt. d. Die Veränderung der Kontrollgruppe wäre, im Vergleich zur Experimentalgruppe noch kleiner, d.h. Change würde in der Kontrollgruppe einen höheren Wert aufweisen. e. Wenn sich die Schmerzen in der Kontrollgruppe zum zweiten Zeitpunkt gesteigert haben sollten, müsste der Regressionskoeffizient größer sein als der Mittelwert der Experimentalgruppe, da der Mittelwert der Kontrollgruppe negativ wäre. 5. Betrachtet man die vom t-test angegebenen Mittelwerte, sollte der Mittelwert der Experimentalgruppe gleich dem Intercept sein und der Mittelwert der Kontrollgruppe gleich dem von der Regressionsanalyse prädizierten Wert bei X=1 sein (i.e. Y2= 5.24139– 4.1461) 6. Eine dichotome Variable (z.B. männlich, weiblich), die auf 0 und 1 kodiert ist. 7. 'Erzeuge neue Variable' (TL Datenmanagment – Variablen bearbeiten ), dann *Gruppe == “exp“ ' Die neue Variable wird in der Datenmatrix angezeigt. Sollten die Ausprägungen noch mit 'True' und 'False' angegeben sein, können Sie im Skriptfenster den Befehl: 'NamederDatenmatrix$exp <-- with(NamederDatenmatrix, (Gruppe==“exp“*1))' eingeben bzw. abändern. Durch diese Multiplikation mit 1 wird die Ausprägung False mit Null und die Ausprägung True mit 1 kodiert. 8. Durch die Konstanthaltung von Störgrößen soll der Effekt eines Treatments unverzerrt sichtbar werden. Im vorliegenden Falle könnte der Zustand der VPen zum ersten Zeitpunkt einen Einfluss auf die AV haben. Die Konstanthaltung in diesem Fall gibt also Ausschluss darüber, wie groß der Effekt der Behandlung ist, wenn alle VPen die gleiche Schmerzintensität zum ersten Zeitpunkt berichten. 9. Bei Intervallskalen ist der Abschnitt (= Intercept) schon für einfachste Aussagen nicht sinnvoll interpretierbar. Zulässig bei intervallskalierten Variablen sind Lineartransformationen, so dass Y folgendermaßen ersetzt werden kann (X sei eine Dummy-Variable: 0 bzw. 1) : Y = a +bX; Man betrachte folgende Behauptung: der Abschnitt ist 0 (hier a=0) Y -> A +BY (zulässige Transformation bei Intervallskalenniveau) d.h. Nach zulässiger Transformation gilt: A+BY = a +bX -> Y = (a-A)/B + b/B X gilt für die Aussage (der Abschnitt ist 0: (a/B – A/B) = 0. Diese Aussage ist nur dann zulässig, wenn A = 0 ist; d. h. diese Aussage wäre nur bei einer Verhältnisskala sinnvoll. Für Differenzen: Soll nun eine Differenz zweier solcher Variablen durch die Regressionsanalyse prädiziert werden Y2-Y1 = a + bX, kürzt sich das in der linearen Transformationen enthaltene A raus: Nach zulässiger Transformation A+BY gilt: A+BY2 - (A +BY1) = a + bX -> BY2 – BY1 = a +bX -> Y2 –Y1 = a /B + b/B X Hier ist die Aussage (der Abschnitt ist 0) äquivalent in Vergleich der der transformierten und untransformierten Regressionsgleichung, und daher zulässig. Die abhängige Variable ist die Differenz. Die Regressionsgerade wurde anhand der Regressionsgleichung geschätzt: Y2 –Y1 = a + b X + e. (mit X=0 für Kontrollgruppe und X=1 für Experimentalgruppe). Der Kleinst-Quadrateschätzer liefert für die Kontrollgruppe (X=0) die Differenzenmittelwerte: y 2 (0) y1 (0) a und für die Experimentalgruppe (X=1) die Differenzenmittelwerte: y 2 (1) y1 (1) a +b. b ist daher gerade die Differenz der Differenzmittelwerte: ( y 2 (1) y1 (1)) ( y 2 (0) y1 (0)) . 10. Y2 – Y1 = a +bX +cZ An der Stelle, an der Z=0 ist. 11. Odds sind Verhältnisangaben von Anteilen oder Häufigkeiten. Zum Beispiel kann der Anteil der Kinder unter 18 Jahren einer Horrorkinovorstellung zum Verhältnis der Jungerwachsenen und Erwachsenen über 18 Jahren dargestellt werden – etwa 1:19. Dies würde der Angabe entsprechen, dass sich unter 20 Kinobesuchern eine Person unter 18 Jahren befindet oder dass der prozentuale Anteil an Minderjährigen bei 5% liegt. 12. Odds finden oft in Wetteinsätzen Verwendung – hier geht es um einen Vergleich der Gewinnchancen: in einem Würfelspiel etwa liegen die Odds, eine Sechs zu würfeln, bei 1:5. Odds-Ratio – das Verhältnis von Odds – setzt Odds zweier Gruppen zueinander in Beziehung und soll somit Aussagen über die Stärke von Zusammenhängen geben. Beispiel: Es interessiert, wie hoch die Wahrscheinlichkeit für Kinder mit Migrationshintergrund ist, eine weiterführende Schule zu besuchen, im Vergleich zu Kindern ohne Migrationshintergrund. 13. Die Odds für Kinder mit Migrationshintergrund, eine weiterführende Schule zu besuchen, betragen 12:41, für Kinder ohne 38:9. Die Odds-Ratio beträgt 14.42 für Kinder ohne Migrationshintergrund und Abitur. D.h. die Chancen, dass ein Kind ohne Migrationshintergrund ein Abitur macht, sind 14,42 mal so hoch, als dass ein Kind mit Migrationshintergrund das Abitur macht. Liegt die Odds-Ratio über 1, sind die Odds für die erste Gruppe höher, liegt sie unter 1 sind die Odds für die zweite Gruppe höher. 14. Odds haben einen beschränkten Wertebereich. Sie sind zwar nach oben hin offen, nähern sich jedoch asymptotisch Null an. Indem man sie in Logits umwandelt, erreicht man einen unbeschränkten Wertebereich. Der Logit ist der natürliche Logarithmus eines Odds. 15. Die logistische Regression ist ein Verfahren zur Beurteilung des Zusammenhangs zwischen einer dichotomen abhängigen Variable und mindestens einer unabhängigen , mindestens intervallskalierten Variable. Typisch sind abhängige Variablen, die das Eintreten eines Ereignisses erfassen und sich gegenseitig ausschließen – Ereignis tritt ein oder Ereignis tritt nicht ein. Es interessiert der Einfluss der unabhängigen Variable/n und die konkrete Wahrscheinlichkeit für das Eintreten des Ereignisses. 16. Im linearen Regressionsmodell ist die abhängige Variable metrisch skaliert und es wird keine Wahrscheinlichkeit vorhergesagt, sondern die konkrete Ausprägung von Y. Die logistische Regression unterstellt einen nicht-linearen Zusammenhang zur Wahrscheinlichkeit des Auftretens des ‚abhängigen’ Ereignisses, das durch eine Ausprägung der abhängigen Variablen charakterisierbar ist. 1. Die logistische Funktion lautet: p1 () : exp( ) 1 exp( ) 2. Andererseits gilt dann: log it ( p1 ()) ln( Odds()) ln( mit a bx p1 () ) : mit a bx 1 p1 () 17. Die Voraussetzung der Homoskedastizität der Residualvarianzen ist nicht erfüllt. Die Residuen sind nicht normalverteilt. Weiterhin ist ein linearer Zusammenhang zwischen der/n unabhängigen Variable/n und der Eintrittswahrscheinlichkeit nicht anzunehmen. Vielmehr geht man von einem „Sättigungseffekt“ aus – die Wahrscheinlichkeiten nähern sich den Extremwerten asymptotisch an. Und es können für bestimmte Ausprägungen von X Werte geschätzt werden, die unter 0 oder über 1 liegen. 18. a) -0.5837 b) 0.279