Zusammenfassung

Werbung

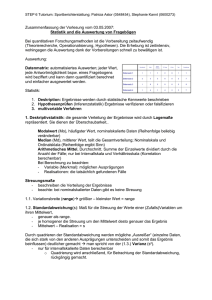

Zusammenfassung Marketingforschung 1. Vorlesung Agenda > Marketing und Marketingforschung > Marketingforschungsprozess > Hypothesenbildung und –test Ein einfaches Marketingsystem Der Austauschprozess ist das fundamentale Explanadum des Marketings! Marketing ist der Prozess der Planung und Ausführung der Konzeption, des „pricing“ und der Verkaufsförderung sowie dem Vertrieb von Ideen und Dienstleistungen, um einen Austausch zu erreichen, der Individuen wie Organisationen zufrieden stellt. Das Marketing Konzept ist auf KonsumentenZufriedenheit ausgelegt und nicht so sehr auf Profit- Maximierung! Marktforschung hilft dabei Management Entscheidungen zu verbessern, indem es relevante, akkurate und rechtzeitige Informationen liefert. Informationen dienen also dazu, Konsumenten, Kunden und die Öffentlichkeit an den Produzenten durch Informationen zu binden, welche Möglichkeiten und Probleme herausstellen und somit das Verständnis verbessern, Marketing als einen Prozess zu verstehen. Marktforschung liefert die dazu notwendigen Informationen. Das Marketing-Konzept Das Marketingkonzept besagt, dass der Schlüssel zur Erreichung unternehmerischer Ziele darin liegt, die Bedürfnisse und Wünsche des Zielmarktes zu ermitteln und diese dann wirksamer und wirtschaftlicher zufrieden zu stellen als die Wettbewerber. (Kotler/Bliemel 2001, S. 34) Einfluss auf die Marketingforschung: "Finde Wünsche und erfülle sie!" statt "Erfinde Produkte und verkaufe sie!" Terminologische Abgrenzung Make-or-Buy Entscheidung "make" • Vertrautheit mit dem Problem • Einfluss- und Kontrollmöglichkeiten • geringes Risiko von Indiskretionen • wenig Kommunikationsprobleme • spezifische Marktkenntnisse "buy" • Standarderhebungen "auf Vorrat" • keine Betriebsblindheit • Objektivität • Know-How, Methodenkenntnis, aktuelles Fachwissen, Spezialisten Die zehn führenden Marktforschungsinstitute (Jahresumsatz in Millionen Dollar, von unten nach oben der Größe nach) Westat Inc. (U.S.) (10) NOP World (U.K.) IPSOS Group SA (France) NFO World (U.S.) GfK Group (Germany) (6) Information Resources (U.S.) Taylor Nelson Sofres plc (U.K.) WPP plc (U.K.) IMS Health Inc. (U.S.) VNU NV (Netherlands) (1) Die GfK Gruppe aus Nürnberg belegt den sechsten Platz. Marketingforschung im Marketingplanungsprozess Aufgaben der Marketingforschung Der Marketingforschungprozess Wissenschaftstheoretische Grundlagen Induktion vs. Deduktion Beobachtungsaussagen → Induktion → Gesetze und Theorien → Deduktion → Erklärung und Vorhersage Theorie: System logisch widerspruchsfreier Aussagen und Gesetzmäßigkeiten über reale Phänomene, die empirisch überprüfbar sind. Hypothesen • Sätze (Behauptungen), die empirisch überprüfbar sind. • Aussagen, keine Fragen • Mindestens zwei relevante Begriffe • Begriffe operationalisierbar • "Wenn-dann-Verknüpfungen zwischen Begriffen • nicht tautologisch • widerspruchsfrei • Geltungsbedingung • Möglichkeit der Falsifizierung Hypothesen werden abgeleitet: • aus explorativen Studien • aus Theorien • aus Erfahrungswissen Forschungstypen 3 Forschungstypen • explorative Forschung • deskriptive Forschung • kausale Forschung Relationship among the Research Designs Explorative Forschung • Problemstrukturen entdecken • Hilfe zur präzisen Problemformulierung • Vorbereitung weiterer Studien • Erkennen der Durchführbarkeit • Sammeln von Argumenten und Fakten • Vorarbeit zur Hypothesenfindung • keine repräsentativen Ergebnisse • hochflexible, wenig strukturierte Ansätze Deskriptive Forschung • Erfassen und Beschreiben von Marktgegebenheiten (quantitativ) • Darstellung von Fakten (z.B. Charakteristika von Populationen) • keine Erklärungsansätze, aber hypothesenartiges Vorverständnis des Problemfeldes nötig • detaillierte Forschungsplanung • oft: Beantwortung von Fragen, die durch explorative Studien aufgeworfen wurden • Sekundärquellen und Felderhebungen Kausalforschung • Ursache - Wirkungszusammenhang ("Wenn - dann") • Untersuchung der Bestimmungsgründe des Verhaltens ("Warum?") • Untersuchung der Art von Beziehungen • häufig: Anwenden von Experimenten • gründliches Verständnis des Problems und exaktes Vorgehen erforderlich • typisch: Versuch der Falsifizierung von Hypothesen • aber: empirische Daten liefern keinen Beweis Probleme der Kausalforschung 1. zeitlicher Zusammenhang 2. Scheinkorrelationen 3. Kausalitäten nicht erkennbar Scheinkorrelation Verdeckte Korrelation Methodologische Grundsätze der Marketingforschung • Theoriegeleitete Forschung • Interdisziplinäre Ausrichtung • Pragmatismus 2. Vorlesung Agenda > Fragebogendesign > Stichprobenbildung > Datenerhebung Beispiele für Frageformen und Messniveaus Einfluss der Fragestellung auf die Antwort: Beispiel 1 In a study by Schwarz, Hippler, Deutsch, and Strack (1985), Germans were asked "How many hours a day do you spend watching TV?" Half were given the response alternatives in set 1, and the other half those in set 2. Einfluss der Fragestellung auf die Antwort: Beispiel 2 „Was ist Ihre persönliche Meinung? Finden Sie es alles in allem gerechtfertigt oder nicht gerechtfertigt, wenn die Altbaumieten erhöht werden?“ Typische Fehler • Suggestivfragen • “Double - barrel Questions“ - Wie beurteilen Sie Preis und Qualität von Produkt Z? gut oder schlecht? - „Glauben Sie nicht auch, ...?“ - „Sie sind doch sicher, ...?“ (Unterstellung) - Betonung der Alternativen - wertende Begriffe • “Unbalanced Questions“ - unterschiedlich ausformulierte Alternativen - Ungleichgewicht zwischen positiven und negativen Antwortmöglichkeiten: „Wie schmeckt Ihnen Schokoriegel Y?“ hervorragend, sehr gut, gut, ziemlich gut, nicht - optische Bevorzugung von Antwortmöglichkeiten Umgang mit heiklen Fragen • Verstecken in einer Gruppe von „unverdächtigen“ Fragen • Herausstellen der „Normalität“ • Kategorieneinteilung • „Münzenmodell“ (Wahrscheinlichkeitsmodell oder auch Randomized Response Technique) → 2 verdeckte Karten: Eine enthält eine heikle Frage, die andere eine harmlose (z.B. A: Marihuana geraucht in letzter Zeit? B: Und ist die letzte Zahl ihrer ID eine 6?) Dann ergibt sich eine Wahrscheinlichkeit von 0,5 x befragter Anzahl der Personen, dass jemand ja zu A sagt. Bei Ergebnis 100 ja und 900 nein bei einer Population von 1.000 ? 100:1000= 0,5 x 0,5 + 0,5 x X ? X = 2x (100:1000 – 0,25) = 0,3 ? Wahrscheinlichkeit, dass jemand ja zu Marihuana gesagt hat. Inhalt eines Fragebogens • Sachfragen • Fragen zur Person • psychologisch-funktionale Fragen: - Kontakt-, Eisbrecherfragen - Ablenkungs-, Puffer-, Löschfragen - Lehr-, Trainings-, Unterweisungsfragen - Motivationsfragen • Kontrollfragen • Ablaufordnungsfragen Fragebogen: Wichtige Kriterien • Klarer Ablaufplan • Formulierungen eindeutig, klar, neutral • Gestaltung übersichtlich und optisch ansprechend • Zielgruppenorientierung • Intervieweranweisungen • Anrede Grundregeln bei der Gestaltung von Fragen • Klarheit und Verständlichkeit im Ausdruck • Neutralität der Fragestellung, keine Vorgefassten Meinungen • Ausgewogene Alternativen (bei Mehrfach-Auswahl-Fragen) • Alle Antwort-Alternativen sollen auf einer logischen Ebene liegen • Die Antwort-Alternativen müssen ausformuliert sein • Ausgewogenheit der Fragen untereinander Grundprinzip der Stichprobenziehung Grundgesamtheit (z.B. 80 Mio. Bundesbürger) Stichprobe? (z.B. 2.000 Bundesbürger) Einfache oder Uneingeschränkte Zufallsauswahl: Urnenmodell(Lotterieauswahl) > Eine Urne enthält für jedes Element der Grundgesamtheit eine Kugel mit der Angabe des Merkmalwertes, das sie repräsentiert. Die Kugeln sind gut durchzumischen und dann eine Stichprobe vom Umfang n zu ziehen. Wahrscheinlichkeit eines jeden Elementes einmal gezogen zu werden ist also 1/n. Wichtig: Sicherstellen einer „guten Mischung“. Dies nur möglich durch Zufallsauswahl! (Beispiel Löffel: Suppenlöffel holt Auswahl heraus, muss aber nicht unbedingt repräsentativ sein für die gesamte Suppe! Also vorher gut durchmischen und Löffel rein, dann bekommt man von allem etwas:)) Grundformen von Auswahlverfahren Geschichtete Zufallsauswahl(stratified sampling) • bei heterogener Grundgesamtheit und relativ homogenen Teilgruppen • Aufteilung der Grundgesamtheit in Untergruppen (Segmente, Schichten) • Betrachtung der einzelnen Schichten als neue Grundgesamtheiten • Zufallsfehler bei diesem Verfahren i.d.R. kleiner als bei reiner Zufallsauswahl • große Bedeutung im der Praxis Klumpenauswahl(cluster sampling) • hier: zweistufiger Prozess (kann auch einstufig erfolgen) • Aufteilung der Grundgesamtheit in nummerierbare Erhebungseinheiten (Klumpen) • Beispiele: Unternehmen und Angestellte Stadtteile und Haushalte • regionale Aufteilung (Regionen, Flächen, Stadtbezirke, Straßenzüge) Vor- und Nachteile der Klumpenauswahl Vorteile: • kostengünstig durch Konzentration • Durchführbarkeit • Praxisbewährung • Grundgesamtheit muss nicht vollständig vorliegen • Es wird nur nach geografischen Gesetzmäßigkeiten unterschieden • Struktur der Grundgesamtheit muss nicht bekannt sein. Nachteile: • Klumpeneffekt: Ein- oder Ausschließen ganzer Klassen von Einheiten mit bestimmten Merkmalen (besonders reiche oder arme Regionen, bestimmte Wohnviertel, Altersheim, Studentenwohnheim,...) • größerer Stichprobenfehler Die mündliche (persönliche, direkte) Befragung - hohe Kosten + hohe Response-Rate - großer Personalaufwand + Kontrolle der Antwortsituation - schwer erreichbare Gruppen? + umfangreiche Fragebögen möglich - Interviewereinfluss !!! + Motivation durch Interviewer, hoher Einfluss bei Befragung durch Interviewer + Ausräumen von Missverständnissen + Arbeiten mit Vorlagen möglich + zusätzliche Beobachtungen können festgehalten werden + vielseitigste Methode Die schriftliche (postalische) Befragung + kein Interviewereinsatz (Kosten, Beeinflussung) + große Flächenabdeckung + Ansprechen schwer erreichbarer Personenkreise + Antwortehrlichkeit durch Anonymität (Problem: Rücklaufkontrolle) + keine unüberlegten Antworten + für persönliche Fragen geeignet - geringe Rücklaufquote - begrenzter Umfang - begrenzte Komplexität - keine Rückfragen - Beeinflussung durch Dritte - keine Kontrolle der Antwortsituation - Befragter sieht gesamten Fragebogen - keine spontanen Antworten Begleitschreiben ist wichtig (Ansprache, Kurzinformation, Interessenweckung) Begleitschreiben bei der schriftlichen Befragung - untersuchendes Institut - Zweck und Zielsetzung der Befragung - überzeugende Argumente für die Wichtigkeit der Befragung und die Notwendigkeit der Beantwortung - Ermunterung zu Rückfragen - Rücksendeschlusstermin (ca. 2 Wochen), Hinweis auf Freiumschlag - überzeugende Zusicherung der Vertraulichkeit und Anonymität - Dank für Mitarbeit Mittel der Interessenstimulierung - vorherige Ankündigung - optische Gestaltung - Freiumschlag - kurzer Fragebogen - Eilbotenzustellung - Produktbeigabe - Koppelung mit Garantiekarten - Nachfaßaktionen - "Droheffekt" - Geschenke, Prämien - Teilnahme an Verlosung - persönliche Adressierung der Briefe - interessanter Absender Die telefonische Befragung + Schnelligkeit + relativ preisgünstig + einfache Auswahl der Befragten + Rückfragen möglich + geringer Aufwand + Interviewer bestimmt Ablauf des Interviews + große regionale Streuung möglich - kurze Interviews - Gesprächssituation nicht durchschaubar - keine Visualisierungshilfen - keine komplexen oder persönlichen Fragen - keine eindeutige Legitimation des Interviewers - Aktualitätsverlust Telefonbuch - (Repräsentativität) - Interviewereinfluss - bei Ferngesprächen teuer Die computergestützte Befragung • Computergestützte Befragungssysteme • CATI (Computer Assisted Telephone Interviewing) • CAPI (Computer Assisted Personal Interviewing) • CSAQ (Computerized Self Administrated Questionaires) • Organisation einer computergestützten Befragung (CAPI) • simultane Mehrpersonenbefragung (Studiobefragung) • unabhängige Mehrpersonenbefragung • mobile Befragung Schriftliche, telefonische und mündliche Befragungen 3. Vorlesung Agenda > Stichprobentheorie > Qualitative Marketingforschung Lageparameter Streuparameter Zentrale Grenzwertsatz der Statistik „Die Verteilung von Stichprobenmittelwerten nähern sich bei einer Stichprobengröße von n=30 der Normalverteilung an“. Also: Je größer die Stichprobe, umso besser! Mit zunehmender Stichprobengröße lässt sich ein Trend hin zum Erwartungswert feststellen. Beispiel: Weiße und schwarze Kugeln! Stichprobengröße n=100, man nimmt davon 100 Stichproben. Dann könnte man meinen, es werden ca. 50x weiße Kugeln gezogen. Es können aber auch 70x schwarze gezogen werden. Also kann man nur mit einer gewissen Wahrscheinlichkeit voraussagen, dass es so kommt. Je mehr Stichproben gezogen werden, umso näher wird man an den Wert n=50 kommen! Man kann mit einer Wahrscheinlichkeit von 95% zufrieden sein. Normalverteilung Je größer die Stichprobe, umso höher die Annäherung an den Erwartungswert oder an einen bestimmten Wert, der dann als Erwartungswert genommen werden kann! Und: umso geringer die Standardabweichung! Zusammenhang zw. Sicherheitsfaktor z und Wahrscheinlichkeit der Aussage einer Stichprobe Methoden der qualitativen Marketingforschung • Individuelles Tiefeninterview • Fokusgruppe • Projektive Techniken: - Wortassoziationstest - Satzergänzungstest - Bildinterpretation - „Third-Person“ Technik - Rollenspiel - Fallstudie Vergleich der qualitativen und der quantitativen Marktforschung Idealtypischer Ablauf des Forschungsprozesses Praxisvortrag > Qualitative Methoden Dr. Katja Meier-Pesti, Universität Wien Fakultät für Psychologie, Institut für Wirtschaft, Bildung und Evaluation Agenda > Was sind qualitative Methoden? > Das qualitative Interview > Die Focusgruppe mit Beispielen > Die indirekte Befragung, projektive und assoziative Verfahren mit Beispielen > Die Beobachtung mit Beispielen > Qualitative Inhaltsanalyse > Zusammenfassung Forschungsansatz Einblicke/Grundverständnis, Verständnis vertiefen/erweitern explorativ‚ qualitativ Größenordnungen/ Signifikanz bestimmen deskriptiv, quantitativ Ursache/Wirkung- Zusammenhänge kausal, ‚experimentell‘ 1. Was heißt „qualitativ“? • scheinbare Dichotomie quantitativ vs. qualitativ • Ober-, Sammelbegriff • Stichwort „interpretativ“ • ideologisch geführte Diskussion • Methodenvielfalt als pragmatischer Zugang „Es gibt keine guten oder schlechten Methoden, sondern nur Methoden, die zur Befragung einer Fragestellung besser oder schlechter geeignet sind“ quantitativ vs. Harte Daten Objektiv Schwache Aussagen Messung Zahlen Generalisierbarkeit positivistisch Signifikanz Niveau geordnet repräsentativ Wertfrei qualitativ Weiche Daten Subjektiv Starke Aussagen Bedeutung Wörter Prozess beschreibend Interpretativ Verstehen dichtend gegenständlich Polit./soz. Aktivismus Aufgabenfelder • Strukturierung – wenn Forschungsthema unbekannt oder komplex – Suche nach Heterogenität • Qualitative Prognose • Ursachenforschung – besonders wenn Ursachen komplex, tabuisiert, wenig bekannt sind • Ideengenerierung • Screening von Stichprobenmerkmalen Stichwort: Auswertung • Deskription - Breite Beschreibung - Gegenüberstellungen anhand relevanter Kriterien - Grundannahmen explizieren - Theoriebezug herstellen • Interpretation (anhand der Annahmen & relev. Theorie) • Schlussfolgerungen(für Theorie & Praxis) – Beantwortung der Forschungsfragen – Formulierung bzw. Modifikation von Hypothesen – Aufzeigen neuer Forschungsfragen/Probleme 1. Qualitatives Interview vs. die Abfrage eines schriftlichen Fragebogens • exploratives Interview: – Experteninterview, – Ziel = umfassende Sammlung von Sachinformationen – Flexibilität bezüglich Reihenfolge • psychologisches Tiefeninterview – Ziel = Aufdeckung von unbewussten Motiven – Verständnis + Bedeutungszuweisung – psychologische Ausbildung + Gesprächstechnik erforderlich • Fokussiertes Interview – gelenkt und themenzentriert – kann auch zur Testung von Hypothesen verwendet werden – mögliche Verwendung von Hilfsmittel (Stimuli, z. B. Werbeplakate, Verpackung) 2. Gruppendiskussion - Focusgruppe • fokussiert vs. unfokussiert • moderiert vs. offen • welche Differenzierungskriterien gibt es bei den TeilnehmerInnen? • homogene vs. heterogene Gruppe (z. B. Experten) • Kumulative, kombinierte, kontradiktorische und kreative Gruppendiskussion 3. Ethisches Investment (eher nicht relevant) 4. Projektive Verfahren • Projektion ist die Neigung eigene, unangenehme Regungen auf andere Personen zu verlagern (auch psychoanalytischer Abwehrmechanismus). • Spiegel-Projektion: Selbstidentifikation („ist ebenso wie ich“, „so möchte ich gerne sein“) • kathartische Projektion: eigene Fehler werden anderen untergeschoben („ ich fahre Porsche wegen seiner Beschleunigung, der Nachbar weil er angeben will“) Beispiele für projektive Verfahren > Die einfache projektive Frage: Verlagerung auf eine anonyme dritte Person oder ein Kollektiv (Arbeitskollegen, Österreicher,...) > Der Ballontest: Vorgabe einer Sprechblase, in der die Auskunftspersonen ihre Antwort schreiben sollen > Der Bilder-Erzähl-Test: Bilder typischer Lebenssituationen werden vorgegeben; Auskunftspersonen sollen eine Geschichte dazu erzählen > Produkt-Personifizierung: Wie ist der typische Käufer/Verwender des Produktes zu beschreiben? > Lücken-Test: Sätze oder Geschichten ausfüllen bzw. weitererzählen > Expressive Verfahren (Collage, Psychodrawing,..) Beispiel: Ballontest Fire of desire – Objekte der Begierde? Was sind die Merkmale von leidenschaftlichen Konsumwünschen? Methode: - individuelle Tagebücher, Tiefeninterviews, projektive Tests (Collagen, sensorische Erfahrungen,..) - Studierende aus der Türkei, Dänemark, USA, insgesamt 109 Tagebücher, 265 Tiefeninterviews, 139 Ergebnisse Objekte der Begierde sind: • aufregend, körperlich spürbar (embodied passion) • versprechen eine Veränderung (desired otherness) • Sehnsucht nach sozialen Kontakten (desired sociality) • Gefahr und Unmoral • Distanz und Unerreichbarkeit Ergebnisse Assoziative Verfahren • Assoziative Verfahren – Assoziation ist das Verknüpfen von psychischen Inhalten – Gedächtnis speichert nach raumzeitlichem Zusammentreffen – Gesetz der Ähnlichkeit • Eingeschränkte Assoziationen – Wortassoziationen – Vielzahl von Reizwörtern werden vorgegeben; Vpn soll nur eine Assoziation nennen • Freie Assoziationen: – Vorgabe eines Schlüsselreizes • „Was fällt Ihnen zum Thema xx ein?“ – Assoziationsgeflecht (DeRosa, 1985) • Was fällt Ihnen spontan ein, wenn Sie an xx denken? Bitte nennen Sie Wörter oder Begriffe, die Ihnen durch den Kopf gehen. Bitte lesen Sie jetzt noch einmal Ihre aufgereihten Gedanken durch, und geben Sie bei jedem Wort an, ob es etwas Negatives, Neutrales oder Positives ausdrückt. Wenn Sie den Begriff positiv finden, schreiben Sie bitte ein “+” daneben, wenn Sie ihn neutral erleben ein “o” und negativ ein “–”. Bitte verbinden Sie die Begriffe und Worte, die für Sie zusammenhängen Beispiel: Soziale Repräsentationen vom Euro (Meier & Kirchler, 1998; Meier-Pesti, Kirchler & E-Sehity, 2003) Im Vergleich zwischen 1998 und 2002, haben sich Assoziationen zum Euro verändert, und wenn, wie? Methode: – Assoziationsgeflecht – 1997, n=244 (zumindest Abitur), 2001, n=196 Studenten, 2002, n=248 Studenten – Auswertung mit deduktivem Kategoriensystem, Korrespondenzanalyse Welche Assoziationen verbinden Personen mit dem Euro? > Assoziation ist das Verknüpfen von psychischen Inhalten > Gesetz der Ähnlichkeit > Gedächtnis speichert nach raumzeitlichen Zusammentreffen Assoziationsschema Beschreibung der Subgruppen Häufigkeiten von Kategorien/Jahr Zusammenfassung Stärken • explorativ • in der Sprache des Interviewten • verstehen > erklären • kann Ausweg aus Dschungel anbieten • teilweise „objektiver“ als quantitative Forschung Schwächen • Durchführungs-, Auswertungsobjektivität • hohe Ansprüche an InterviewerIn Auswertung • Validitäts- Reliabilitätsprüfung kaum möglich • kostspielig • kleine Stichproben, Aussagekraft ? 4. Vorlesung Agenda > Auswertungsverfahren > Kontingenzanalyse > Regressionsanalyse Nullhypothese vs. Gegenhypothese Die Nullhypothese ist also z.B. eine Hypothese, die besagt: Die Meinung von Wildwasser- Rafting ausübenden Leuten wird sich in Bezug auf eine Umfrage nicht von der Allgemeinheit unterscheiden. Die Gegenhypothese würden besagen: Sicher unterscheidet sich die Meinung von Wildwasser- Rafting ausübenden Leuten von der Allgemeinheit. Also: Beide Hypothesen müssen gegeneinander getestet werden, um das Testergebnis anschließend in Bezug auf die Hypothesen zu bewerten. Fehler 1. Ordnung: „Ich nehme die Hypothese an, obwohl sie falsch ist“. (wenn Stichprobenwerte zu weit außerhalb des Erwartungswertes) Gegenfehler: „ Ich lehne Hypothese ab, obwohl sie richtig ist“. (alpha- Fehler oder beta- Fehler) Datenniveau und Auswertungsverfahren Typische Fragestellungen der Kontingenzanalyse Der X²- Test Der Chi- Quadrat Test ist ein Maß für den Unterschied zwischen der aktuellen Anzahl der in Abschnitt i untersuchten Werte(Bij) und der erwarteten Werte(Eij), wenn die Nullhypothese richtig sein sollte. Beispiel Typische Fragestellungen der Regressionsanalyse Die Regressionsanalyse noch andere statistische Verfahren können Kausalitäten einwandfrei nachweisen! Vielmehr vermag die Regressionsanalyse nur Korrelationen zwischen Variablen nachweisen. Regression bedeutet: Tendenz einer Rückkehr (Regress) zu einer durchschnittlichen Größe/Menge, etc. Die Regressionsanalyse ist immer anwendbar, wenn sowohl die unabhängige als auch die abhängige Variable metrisches Skalenniveau besitzen, es sich also um quantitative Variable handelt. Es ist somit möglich, alle Problemstellungen der Varianzanalyse mit Hilfe der Regressionsanalyse zu behandeln. Anwendungsbereiche der Regressionsanalyse Ursachenanalysen Wie stark ist der Einfluss der unabhängigen Variablen auf die abhängige Variable? Wirkungsprognosen Wie verändert sich die abhängige Variable bei einer Änderung der unabhängigen Variablen? Zeitreihenanalysen Wie verändert sich die abhängige Variable im Zeitverlauf und somit ceteris paribus auch in der Zukunft? d. Multiple Regression: Für die meisten Untersuchungszwecke ist es erforderlich, mehr als eine unabhängige Variable in das Modell aufzunehmen, der Regressionsansatz ist dann folgender: Y = b0+b1X1+b2X2+…bjXj+…bJXJ e. Eine multiple Regression könnte so aussehen: Y = -6,9 + 11,085 Besuche + 9,927 Preis + 0,655 Ausgaben f. Ein Regressionskoeffizient b3= 0,655 für die Variable Ausgaben besagt, dass der Verkaufsleiter bspw. 65,5 Kartons mehr absetzen wird, wenn er die Verkaufsförderung um 100 erhöht. Bei einem Preis von 10 ergibt dies einen Mehrerlös von 655. Unter Berücksichtigung seiner sonstigen Kosten kann er damit feststellen, ob sich eine Erhöhung der Ausgaben lohnt. Eine andere Möglichkeit, die Regressionskoeffizienten, die ja alle verschieden und nicht gut vergleichbar sind, zu standardisieren. Die standardisierten Regressionskoeffizienten, die auch als Beta- Werte bezeichnet werden, errechnen sich wie folgt: bj= bj x Standardabweichung von Xj/Standardabweichung von Y g. Durch die Standardisierung werden die unterschiedlichen Messdimensionen der Variablen, die sich in den Regressionskoeffizienten niederschlagen, eliminiert. > Prüfung der Regressionskoeffizienten a. Nun ist die Güte des Modells zu prüfen, d.h. wie gut sie als Modell der Realität geeignet ist. Die Prüfung lässt sich in zwei Teile teilen: b. 1. Globale Prüfung der Regressionsfunktion ? Prüfung der Funktion als Ganzes, also wie gut die abhängige Variable Y durch das Modell erklärt wird. Globale Gütemaße sind: das Bestimmtheitsmaß, die FStatistik, der Standardfehler c. 2. Prüfung der Regressionskoeffizienten ? Prüfung wie gut einzelne Variablen des Regressionsmodells zur Erklärung von Y beitragen. Maße zur Prüfung der Regressionskoeffizienten sind: der t-Wert und der Beta-Wert. Sollte eine Variable keinen Beitrag leisten, kann sie aus dem Modell entfernt werden. Erweist sich das Modell nach der globalen Prüfung als unbrauchbar, erübrigt sich die Prüfung der Regressionskoeffizienten. d. Erklärung der einzelnen Methoden: 1. Bestimmtheitsmaß: misst die Güte der Anpassung der Regressionsfunktion an die empirischen Daten(„goodness of fit“). Die Basis hierfür bilden die Residualgrößen, d.h. die Abweichungen zwischen den Beobachtungswerten und den geschätzten Werten von Y. Gesamtabweichung = Erklärte Abweichung + Residuum (Yk – Y = Yk – Y + Yk – Yk). Die Schätzung von Yk ist offenbar umso besser, je größer der Anteil der durch die unabhängige Variable erklärten Abweichung an der Gesamtabweichung ist, bzw. je geringer der Anteil der Restabweichung an der Gesamtabweichung ist. Wenn z.B. die Restabweichung größer als die erklärte Abweichung ist(z.B. 66% der Gesamtabweichung), dann wäre dies ein schlechtes Ergebnis. In der jetzt folgenden Abbildung kann man nachvollziehen, dass das Prinzip der Abweichungszerlegung stets in gleicher Weise angewendet wird. Es kann dabei vorkommen, dass sich erklärte und nicht erklärte Abweichung zum Teil kompensieren. e. Im Unterschied zur Gesamtabweichung einer einzelnen Beobachtung Yk bezeichnen wir die Summe der quadrierten Gesamtabweichung aller Beobachtungen als Gesamtstreuung. Gesamtstreuung = erklärte Streuung + nicht erklärte Streuung. Erfassung der Restschwankung Maßzahlen für die Güte der Schätzung Auf Basis der Streuungszerlegung lässt sich das Bestimmtheitsmaß leicht berechnen. Es ergibt sich aus dem Verhältnis von erklärter Streuung und Gesamtstreuung. Das Bestimmtheitsmaß ist eine normierte Größe, dessen Wertebereich zwischen Null und Eins liegt. Es ist umso größer, je höher der Anteil der erklärten Streuung an der Gesamtstreuung ist. Im Extremfall, wenn die gesamte Streuung erklärt wird, ist R² = 1, im anderen Extremfall entsprechend R² = 0. R kann auch als multipler Korrelationskoeffizient bezeichnet werden. Das Bestimmtheitsmaß wird in seiner Höhe durch die Zahl der Regressoren bestimmt. Man kann das Bestimmtheitsmaß auch durch Subtraktion des Verhältnisses der nicht erklärten Streuung zur Gesamtstreuung vom Maximalwert 1 ermitteln, was auch rechnerisch von Vorteil ist: 1 – nicht erklärte Streuung/Gesamtstreuung. Aus der Formel des Bestimmtheitsmaßes ist zu erkennen, dass das Kleinste- Quadrate- Kriterium, das zur Schätzung der Regressionsbeziehung angewendet wird, gleichbedeutend mit der Maximierung des Bestimmtheitsmaßes ist. Bsp.: Ein Ergebnis von 34,55%( 0,3455) besagt, dass trotzdem noch 64,45% unerklärt bleiben. Die Schwankungen der Absatzmenge Y sind also zu einem großen Teil durch andere Einflüsse, die in der Regressionsgleichung nicht auftauchen, zurückzuführen. Der Wert des Bestimmtheitsmaßes kann also mit der Aufnahme von irrelevanten Regressoren zunehmen, aber nicht abnehmen. Insbesondere bei kleiner Zahl von Freiheitsgraden aber verschlechtern sich mit der Zahl der Regressoren die Schätzeigenschaften des Modells. Das korrigierte Bestimmtheitsmaß berücksichtigt diesen Sachverhalt! Es vermindert das einfache Bestimmtheitsmaß um eine Korrekturgröße, die umso größer ist, je größer die Zahl der Regressoren und je kleiner die Zahl der Freiheitsgrade ist. Das korrigierte Bestimmtheitsmaß kann daher im Gegensatz zum einfachen Bestimmtheitsmaß durch die Aufnahme weiterer Regressoren auch abnehmen. Formel: R²korr = R² - (J x (1-R²))/K-J-1 mit K = Zahl der Beobachtungswerte, J = Zahl der Regressoren und K-J-1 = Zahl der Freiheitsgrade > Prüfung der Modellprämissen Das Bestimmtheitsmaß drückt aus, wie gut sich die Regressionsfunktion an die beobachteten Daten anpasst. In empirischen Untersuchungen wird die Regressionsanalyse aber nicht nur deskriptiv zur Beschreibung vorliegender Daten eingesetzt. Vielmehr handelt es sich i.d.R. um Daten einer Stichprobe und es stellt sich die Frage, ob das geschätzte Modell auch über die Stichprobe hinaus für die Grundgesamtheit Gültigkeit besitzt. Die F-Statistik ist ein geeignetes Prüfkriterium, um neben der obigen Streuungszerlegung zusätzlich auch den Umfang der Stichprobe zu berücksichtigen. So bietet ein möglicherweise „phantastisches“ Bestimmtheitsmaß wenig Gewähr für die Gültigkeit eines Modells, wenn dieses auf Grund nur weniger Beobachtungswerte geschätzt wurde. Die geschätzte Regressionsfunktion wird nun auch um eine Zufallsgröße oder Störgröße erweitert (u), die als stochastische Komponente bezeichnet wird. Sie ist eine Zufallsvariable, die den systematischen Einfluss überlagert und damit verschleiert. Das Modell wird somit zum stochastischen Modell der Regressionsanalyse und lautet nun: Y = b0+b1X1+b2X2+…bjXj + u Zur Berechnung sind die erklärte und nicht erklärte Streuung jeweils durch die Zahl ihrer Freiheitsgrade zu dividieren und ins Verhältnis zu setzen. Die Zahl der Freiheitsgrade der erklärten Streuung ist gleich der Zahl der unabhängigen Variable J und die die Zahl der Freiheitsgrade der nicht erklärten Streuung ist gleich der Beobachtungen vermindert um die zu schätzenden Parameter in der Regressionsbeziehung: K-J-1. Die F-Statistik lässt sich auch als Funktion des Bestimmtheitsmaßes bestimmen(s. erste Formel unten) Ablauf des F- Test 1. Berechnung des empirischen F- Wertes > Formel s. oben! Man erhält nun einen prozentualen Wert(z.B. 0,3455 = 34,55%) 2. Vorgabe eines Signifikanzniveaus > Es ist, wie immer, eine Wahrscheinlichkeit vorzugeben, die das Vertrauen in die Verlässlichkeit des Testergebnisses ausdrückt. Üblicherweise wird hierfür die Vertrauenswahrscheinlichkeit 0,95 (oder auch 0,99) gewählt. Also: Mit einer Wahrscheinlichkeit von 95 % kann man sich darauf verlassen, dass der Test zu einer Annahme der Nullhypothese führen wird, wenn diese korrekt ist, d.h. wenn kein Zusammenhang besteht. > Die Irrtumswahrscheinlichkeit beträgt dann natürlich 1-0,95 = 5%, die auch als Signifikanzniveau bezeichnet wird. 3. Auffinden des theoretischen F- Wertes > Hier kommt, zur Prüfung der Nullhypothese um den theoretischen mit dem empirischen F- Wert zu vergleichen, eine F- Tabelle zum Einsatz. Durch die obige Formel lässt sich der Wert finden. Er ergibt sich durch die Zahl der Freiheitsgrade im Zähler und im Nenner der Formel. Die Zahl der Freiheitsgrade im Zähler bestimmt die Spalte und die der Freiheitsgrade im Nenner bestimmt die Zeile der Tabelle und man erhält so einen Wert(z.B. 5,32). 4. Vergleich der empirischen mit dem theoretischen F- Wert > Das Entscheidungskriterium für den F- Test lautet: Ist der empirische F- Wert(Femp) größer als der aus der Tabelle abgelesene F- Wert(Ftab), dann ist die Nullhypothese zu verwerfen. Es ist also zu folgern, dass nicht alle ßj Null sind. Der durch die Regressionsbeziehung als hypothetisch postulierte Zusammenhang wird damit als signifikant erachtet. Ist dagegen der empirische F-Wert klein und übersteigt nicht den theoretischen Wert, so kann die Nullhypothese nicht verworfen werden. Die Regressionsbeziehung ist damit nicht signifikant. Auf das Beispiel mit der Absatzmenge und der Vertreterbesuche bezogen, bedeutet das aber noch nicht, dass kein Zusammenhang zwischen beiden besteht. Möglicherweise ist dieser durch andere Einflüsse überlagert und wird damit infolge der geringen Stichprobengröße nicht deutlich. Oder er wird nicht deutlich, weil bestimmte Einflussgrößen(z.B. Preis oder die Ausgaben für Verkaufsförderung) nicht berücksichtigt wurden und deshalb die nicht erklärte Streuung groß ist. Man kann auch sagen, dass der Test an „Trennschärfe“ verliert. > Prinzipiell kann die Annahme der Nullhypothese nicht als Beweis für deren Richtigkeit angesehen werden. Sie ließe sich andernfalls immer beweisen, wenn man den Stichprobenumfang klein macht und/oder die Vertrauenswahrscheinlichkeit hinreichend groß wählt. Wenn die globale Prüfung der Regressionsfunktion durch den F- Test ergeben hat, dass nicht alle Regressionskoeffizienten ßj Null sind (und somit ein Zusammenhang in der Grundgesamtheit besteht), sind jetzt die Regressionskoeffizienten einzeln zu überprüfen. Üblicherweise wird hier wieder die Nullhypothese getestet: Ho: ßj = 0. Prinzipiell jedoch könnte auch jeder andere Wert getestet werden. Ein geeignetes Prüfkriterium ist hie die tStatistik! t- Statistik: temp = bj – ßj/sbj mit temp = empirischer t- Wert für den j- ten Regressor, ßj = wahrer Regressionskoeffizient, bj = Regressionskoeffizient des j- ten Regressors, sbj = Standradfehler von bj. Wird die Nullhypothese Ho: ßj = 0 getestet, so vereinfacht sich die Formel zu der obigen ersten Formel. Der t- Wert einer unabhängigen Variablen errechnet sich also sehr einfach, indem man ihren Regressionskoeffizienten durch dessen Standardfehler dividiert. Der t- Test verläuft analog zum F-Test, also nach dem gleichen Ablaufschema!!! F- Test und t- Test Bei nur einer unabhängigen Variablen ist der F- Test für das Modell(die Gesamtheit der Variablen) auch ein Test der Variablen, deren Einfluss hier durch den t- Test geprüft wurde. Im Fall der einfachen Regression reicht es daher aus, nur einen der beiden Test durchzuführen! Während der t- Test nur für die Prüfung einer einzelnen Variablen geeignet ist, kann der F- Test für die Prüfung einer Mehrzahl von Variablen dienen. Um mit dem F- Test eine einzelne Variable zu prüfen, sollte die F- Statistik nur einen Freiheitsgrad im Zähler haben und es gilt: F = t² Während also der F- Test für die Prüfung einer Mehrzahl von Variablen verwendet werden kann, ist für die Prüfung einer einzelnen Variablen die Anwendung des t- Tests einfacher! Heteroskedastizität und Autokorrelation Heteroskedastizität Wenn die Streuung der Residuen in einer Reihe von Werten der prognostizierten abhängigen Variable nicht konstant ist, dann liegt Heteroskedastizität vor! Damit ist eine Prämisse der des linearen Regressionsmodells verletzt, die verlangt, dass die Varianz der Fehlervariablen u für alle k homogen ist, mit anderen Worten die Störgröße darf nicht von den unabhängigen Variablen und von der Reihenfolge der Beobachtungen unabhängig sein. Ein Beispiel für das Auftreten von Heteroskedastizität wäre eine zunehmende Störgröße in einer Reihe von Beobachtungen etwas auf Grund von Messfehlern, die durch nachlassende Aufmerksamkeit der beobachtenden Personen entstehen. Heteroskedastizität für zur Ineffizienz der Schätzung und verfälscht den Standardfehler des Regressionskoeffizienten. Damit wird auch die Schätzung des Konfidenzintervalls ungenau. Der Standardfehler ist ein Gütemaß der Schätzung, der angibt, welcher mittlere Fehler bei Verwendung der Regressionsfunktion zur Schätzung der abhängigen Variablen Y gemacht wird. Zur Aufdeckung von Heteroskedastizität empfiehlt sich zunächst eine visuelle Inspektion der Residuen. Dabei ergibt sich meist ein Dreiecksmuster, wie in der obigen Abbildung. Der bekannteste Test zur Aufdeckung von Heteroskedastizität bildet der Goldfeld/Quandt- Test, bei dem die Stichprobenvarianzen der Residuen in zwei Unterstichproben, z.B. der ersten und zweiten Hälfte einer Zeitreihe, verglichen und ins Verhältnis gesetzt werden. Wenn Heteroskedastizität vorliegt, müssen die Varianzen identisch sein(s²1 = s²2). Das Verfahren von Glesjer impliziert eine nicht- lineare Transformation. Zur Begegnung von Heteroskedastizität kann versucht werden, durch Transformation der abhängigen Variablen oder der gesamten Regressionsbeziehung Homoskedastizität der Störgrößen herzustellen. Dies zeigt, dass Heteroskedastizität meist auch ein Problem von Nichtlinearität ist(s. obige Abb.) Autokorrelation Das lineare Regressionsmodell basiert auf der Annahme, dass die Residuen in der Grundgesamtheit unkorreliert sind. Wenn diese Bedingung nicht gegeben ist, sprechen wir von Autokorrelation. Autokorrelation tritt vor allem bei Zeitreihen auf. Autokorrelation führt zu Verzerrungen bei der Ermittlung des Standardfehlers der Regressionskoeffizienten. Zur Aufdeckung der Autokorrelation empfiehlt es sich, auch hier zunächst eine visuelle Inspektion durchzuführen. Bei positiver Autokorrelation liegen aufeinander folgende Werte der Residuen nahe beieinander, bei negativer Autokorrelation dagegen schwanken sie stark(s. obige Abb.) 5. Vorlesung Agenda > Logistische Regression > Varianzanalyse Die Varianzanalyse stellt das Spiegelbild der logistischen Regression dar. Bei der logistischen Regression ist die abhängige Variable nominal skaliert und die unabhängige, also zu erklärende Variable metrisch verteilt. Bei der Varianzanalyse ist es genau umgekehrt. Sie wird durch ein Set von Variablen erklärt, die nominal skaliert sind. Im Gegensatz zur linearen Einfachregression versucht die logistische Regression nicht Schätzungen für die Beobachtungen der binären abhängigen Variablen vorzunehmen, sondern die Eintrittswahrscheinlichkeiten dieser Beobachtungswerte abzuleiten. Dabei wird die Ausprägung y = 1 allgemein als „Ereignis y tritt ein“ und die Ausprägung y = 0 als „Ereignis y tritt nicht ein“ interpretiert. Typische Fragestellungen der logistischen Regression Problemstellung • mit herkömmlicher (linearer) Regression treten bei kategorialen abhängigen Variablen Probleme auf • dichotome Verteilung ist nicht metrisch • da Y dichotom, keine Varianzberechnung möglich • andere Interpretation der Regressionsgeraden: Betrachtung des Anteils → Ansatz über Wahrscheinlichkeiten Um die Wahrscheinlichkeit für das Eintreten von y = 1[allgemein bezeichnet als P(y=1)] bestimmen zu können, wird unterstellt, dass eine nicht empirisch beobachtete latente Variable „Z“ existiert, die die binäre Ausprägung der abhängigen Variablen (Y) in Abhängigkeit der Ausprägungen der unabhängigen Variablen Xj erzeugen kann. Dieser Zusammenhang lässt sich formal für einen Beobachtungsfall k wie folgt formulieren: zk = ß0 + ∑ ßj x xjk + uk Durch die latente Variable Z wird die Verbindung zwischen der binären abhängigen Variablen Xj hergestellt. Dabei kann die Variable Z als aggregierte Einflussstärke der verschiedenen unabhängigen Variablen interpretiert werden, die das Ereignis Kauf herbeiführen. Weiterhin wird unterstellt, dass die verschiedenen Einflussgrößen Xj durch eine Linearkombination die (latente) Variable Z erzeugen. Eine Wahrscheinlichkeitsaussage im eigentlichen Sinne ist damit allerdings noch nicht erreicht. Hierzu bedarf es einer Wahrscheinlichkeitsfunktion, die dann nach Maßgabe der aggregierten Einflussstärke Z das Ereignis y = 1 oder aber y = 0 erzeugt. Die logistische Regression greift zu diesem Zweck auf die sog. logistische Funktion zurück, die wie folgt definiert ist: p = 1/1+e-z e = 2,71828183 (Eulersche Zahl) Beispiel: Einfluss des Alters auf den Familienstand Der logistische Regressionsansatz berechnet nun die Wahrscheinlichkeit für das Eintreten des Ereignisses y = 1 unter Verwendung der logistischen Funktion. Dabei spiegeln der Parameter ß0 und die Regressionskoeffizienten ßj - letztere werden häufig auch als Logit- Koeffizienten bezeichnet – die Einflussstärke der jeweils betrachteten unabhängigen Variablen Xj auf die Höhe der Eintrittswahrscheinlichkeit P(y=1) wider. Die logistische Funktion stellt somit eine Wahrscheinlichkeitsbeziehung zwischen dem Ereignis y = 1 und den unabhängigen Variablen Xj her, weshalb sie auch als Linking- Function bezeichnet wird. Der logistische Regressionsansatz lässt sich unter Betrachtung der durch die obigen Gleichungen formulierten Zusammenhänge wie folgt definieren: Logistische Regressionsgleichung Pk(y=1) = 1/1+e-zk → die z-Werte werden hier als Logits bezeichnet. Die mit Hilfe der logistischen Funktion erzeugt Wahrscheinlichkeitsverteilung für das Ereignis y = 1 weist einen s- förmigen Verlauf auf und hat die Eigenschaft, dass sich selbst für unendlich kleine oder auch große Werte des Prädikators Z(x) die Wahrscheinlichkeit für das Ereignis y=1 immer innerhalb des Intervalls [0,1] bewegt. Weiterhin ist die logistische Funktion immer symmetrisch um den Wendepunkt P(y=1) = 0,5. Die untere Abbildung zeigt den Verlauf der logistischen Funktion für z-Werte im Intervall [0-90]. Die logistische Funktion unterstellt damit einen nicht- linearen Zusammenhang zwischen der Eintrittswahrscheinlichkeit der binären, abhängigen Variablen [P(y=1)] und den unabhängigen Variablen als Modellprämisse. Demgegenüber wird aber das Zustandekommen der aggregierten Einflussstärke Z im Exponenten der Linking- Function als linear unterstellt. Grundprinzip der logistischen Regression Ablaufschritte der logistischen Regression Ablauf > Im Unterschied zur linearen Einfachregression werden hier keine Je- desto- Hypothesen unmittelbar zwischen den unabhängigen Variablen und der abhängigen Variablen formuliert, sondern zwischen den unabhängigen Variablen und der Eintrittswahrscheinlichkeit für das Ereignis y=1. Für das Margarinebeispiel könnte z. B. postuliert werden: „Je besser die Streichfähigkeit der Margarine, desto höher ist auch die Kaufwahrscheinlichkeit“. > Wichtig ist noch zu beachte, dass die angenommenen Wirkungsbeziehungen von nicht- linearen Charakter sind, da durch die s-förmig verlaufende logistische Funktion Nichtlinearität angenommen wird. > Bei der Beurteilung des Modells eines logistischen Regressionsansatzes insgesamt(Gesamtfit), steht die Frage im Vordergrund, wie gut die unabhängigen Variablen in ihrer Gesamtheit zur Trennung der Ausprägungskategorien von Y beitragen. > Der Likelihood spiegelt die Wahrscheinlichkeit wider, unter den gegebenen Parameterschätzungen die empirischen erhobenen Beobachtungswerte zu erhalten. > Als Devianz wird die Abweichung vom Idealwert bezeichnet und kann inhaltlich mit der Fehlerquadratsumme der klassischen Regressionsanalyse verglichen werden. > Sie dient weiterhin als Gütemaß zur Überprüfung des Modellfits, wobei ein perfekter Modellfit einen Likelihood von 1 aufweist und die Devianz in diesem Fall 0 beträgt. > Mit Hilfe der Devianz kann folgende Hypothese getestet werden: a. H0: Das Modell besitzt eine perfekte Anpassung b. H1: Das Modell besitzt keine perfekte Anpassung > Die mit der Devianz verbundenen Probleme versucht der sog. Likelihood- Ratio- Test(auch „Modell ChiQuadrat- Test“ genannt) zu beheben, indem er den maximalen LL- Wert nicht mit Null, sondern mit demjenigen LL- Wert vergleicht, der sich ergibt, wenn alle Regressionskoeffizienten der unabhängigen Variable auf Null gesetzt werden(? „Null Modell“) > Mc Faddens-R² beruht ebenso wie der LR- Test auf der Gegenüberstellung der LL- Werte des vollständigen und des Null- Modells und ist wie folgt definiert: 1-LLv/LL0. Hierbei wird der LogLikelihood des Nullmodells durch der des vollständigen Modells dividiert. > Zur Beurteilung der Klassifikationsergebnisse werden die empirisch beobachteten Gruppenzuordnungen, gekennzeichnet durch die Ausprägungen 0 und 1 der unabhängigen Variablen, mit den durch die Regressionsgleichung erzeugten Wahrscheinlichkeiten verglichen. Typische Fragestellungen der Varianzanalyse > Gemeinsam ist allen Beispielen, dass ihnen eine Vermutung über die Wirkungsrichtung zugrunde liegt. > Wie in der Regressionsanalyse, die einen Erklärungszusammenhang über metrische Variablen herstellt, formuliert auch die Varianzanalyse einen solchen Zusammenhang, allein mit dem Unterschied, dass die Variablen nominal skaliert sein dürfen. Varianzanalyse Die einfaktorielle sowie die zweifaktorielle Varianzanalyse haben folgendes Ablaufschema: > Problemformulierung > Analyse der Abweichungsquadrate > Prüfung der statistischen Unabhängigkeit Bei der zweifaktoriellen Varianzanalyse wird zum Beispiel der Absatz nicht nur von der Warenplatzierung, sondern auch noch von der Verpackung der Waren beeinflusst, bzw. es wird vermutet, dass dem so sei. Allgemein ist die Varianz definiert als mittlere quadratische Abweichung („mean sum of squares“) Formel: Varianz = SS/Zahl der Beobachtungen - 1 Ausgehend von unseren bisher gesetzten vereinfachenden Annahmen über das Wirksamwerden von im Modell erfassten und von im Modell nicht erfassten Einflussgrößen können wir nun folgern, dass SSb von der im Beispiel angesprochenen Warenplatzierung und SSw von den nicht erfassbaren Einflüssen bestimmt wird. Graphische Analyse von Interaktionen Keine Interaktionen liegen vor, wenn die Verbindungslinien der Mittelwerte parallel verlaufen. Nichtparallele Verläufe sind ein klares Indiz für das Vorhandensein und die Stärke von Interaktionen. Im vorliegenden Fall bietet sich ein Anhaltspunkt für eine schwache Interaktion von Verpackung und Platzierung, weil der Wirkungsunterschied von Becher und Papier von den Kunden möglicherweise nicht wahrgenommen wird. Die Abbildung zeigt das Grundprinzip der Varianzanalyse: Die Definition von Faktor 1 und einem Faktor 2. Man kann jeden Wert für die Absatzmenge schätzen, indem man seinen Abstand vom Gesamtmittelwert schätzt, der durch die Faktoren 1 und 2 bestimmt wird. Dies geschieht durch die Interaktion der beiden Faktoren, sowie nicht kontrollierte Einflüsse. Prüfung der statistischen Unabhängigkeit Im zweifaktoriellen Fall erfolgt die statistische Prüfung auf unterschiedliche Wirkungen der beiden Faktoren durch einen Vergleich der Mittelwerte in allen Zellen. Wenn alle Mittelwerte gleich sind, kann angenommen werden, dass die jeweiligen Stufen beider Faktoren keinen unterschiedlichen Einfluss auf die anhängige Variable haben (Nullhypothese). Andernfalls kann angenommen werden, dass zumindest eine Faktorstufe einen anderen Einfluss besitzt als die andere (Alternativhypothese). 6. Vorlesung Agenda > Faktorenanalyse > Conjoint-Analyse Ablauf einer Faktorenanalyse > Variablenauswahl und Errechnung der Korrelationsmatrix > Extraktion der Faktoren > Bestimmung der Kommunalitäten > Zahl der Faktoren > Faktorinterpretation > Bestimmung der Faktorwerte Beispiel für den Grundgedanken der Faktorenanalyse Anwendung in der Forschungspraxis: Multi-Item Scales Faktorenanalyse • Verfahren zur Reduktion umfangreicher Variablenmengen auf wenige, voneinander unabhängige Faktoren • Aufdecken latenter Faktoren, die hinter den Variablen stehen: > Prinzip lässt sich geometrisch darstellen: Darstellung der Variablen durch Vektoren > Korrelationskoeffizient zwischen zwei Variablen = Kosinus des eingeschlossenen Winkels Korrelationsanalyse zur Aufdeckung der Variablenzusammenhänge Faktoren, die als „hinter den Variablen“ stehende Größen angesehen werden, repräsentieren den Zusammenhang zwischen verschiedenen Ausgangsvariablen. Bevor solche Faktoren ermittelt werden, ist es zunächst erforderlich, die Zusammenhänge zwischen den Ausgangsvariablen messbar zu machen. Als methodisches Hilfsmittel wird hierzu die Korrelationsrechnung herangezogen. Dazu benötigt man den Korrelationskoeffizienten: In vereinfachter Form: cov(x, y) / √v(x) ∙ √v(y) Tendiert der gesamte Term gegen 1, besteht ein großer Zusammenhang zwischen den Variablen, tendiert der Term eher gegen 0, besteht nur ein kleiner bis gar kein signifikanter Zusammenhang. Wie die obere Abbildung zeigt, ist der Cosinus eines 60° - Winkels gleich 0,5. Entsprechend lässt sich jeder beliebige Korrelationskoeffizient zwischen zwei Variablen auch durch zwei Vektoren mit einem genau definierten Winkel zueinander darstellen. Je mehr Variablen jedoch zu berücksichtigen sind, umso mehr Dimensionen werden benötigt, um die Vektoren in ihren entsprechenden Winkeln zueinander zu positionieren. Die Faktorenanalyse trachtet nun danach, das sich über die Korrelationskoeffizienten gemessene Verhältnis der Variablen zueinander in einem möglichst gering dimensionierten Raum zu reproduzieren. Die Zahl der Achsen gibt dann die entsprechende Zahl der Faktoren an. Frage: Wie werden die Achsen(Faktoren) in ihrer Lage zu den jeweiligen Vektoren(Variablen) bestimmt? Antwort: Die beiden Winkel von 30° des halboffenen Schirmes zwischen Vektor 1 bzw. Vektor 2 und Faktor- Vektor geben an, inwieweit der gefundene Vektor mit Vektor(Variable) 1 bzw. 2 zusammenhängt. Sie repräsentieren ebenfalls Korrelationskoeffizienten, und zwar die zwischen den jeweiligen Variablen und dem Faktor. Diese Korrelationskoeffizienten hatten wir als Faktorladungen bezeichnet. Die Faktorladungen des 1. Faktors betragen also in Bezug auf Variable 1 und Variable 2: cos 30° = 0,8660. Beispiel • Problem der Faktorenextraktion: Wie findet man einen Vektor, der stellvertretend für mehrere zusammenhängende Variablen fungieren kann? Auswahlkriterien für Zahl der Faktoren basierend auf dem Eigenwert der Faktoren(Eigenwert = Summe der quadrierten Ladungen eines Faktors über alle Variablen) > Scree-Test: Beim Scree-Test werden die Eigenwerte in einem Koordinatensystem nach abnehmender Wertefolge angeordnet. Sodann werden die Punkte im Koordinatensystem durch Geraden verbunden. Ausgehend von der sich asymptotisch der Abszisse annähernden Punkten entsteht an der Stelle, an der die Differenz der Eigenwerte zwischen zwei Faktoren am größten ist, ein Knick (auch „Elbow“ genannt). Der erste Punkt links von diesem Punkt bestimmt die Anzahl der zu extrahierenden Faktoren. Die Faktoren mit den kleinsten Eigenwerten für Erklärungszwecke werden als unbrauchbar(scree = Geröll) angesehen und werden deshalb nicht extrahiert. > Kaiser-Kriterium dient zur Extraktion von zwei Faktoren und kommt bei empirischen Untersuchungen am häufigsten zur Anwendung. Hier sind entgegen des Scree-Test 3 Faktoren zu extrahieren, und zwar die mit dem geringsten Eigenwert(s. Abb. unten) • Problem der Faktoreninterpretation: subjektive Ermessensspielräume, Interpretation anhand hoch ladender Variablen > Rotation des Koordinatensystems: Laden mehrere Variablen auf mehrere Faktoren gleich hoch(„hohe“ Ladungen (≤0,5), dann ist es häufig unmöglich, unmittelbar eine sinnvolle Faktorinterpretation zu erreichen. Es lässt sich mathematisch nachweisen, dass die Aussagekraft einer Hauptsachenanalyse durch eine Drehung(Rotation) des Koordinatenkreuzes in seinem Ursprung nicht verändert wird. Aus diesem Grund wird zur Interpretationserleichterung häufig eine Rotation durchgeführt. Dabei wird zwischen der orthogonalen(rechtwinkligen) Rotation und der obliquen(schiefwinkligen) Rotation unterschieden. • Problem der Faktorenwerte: summierte Produkte aus Merkmalsausprägung bei den Variablen und Faktorladung der Variablen → Einordnen von Objekten Die Zahl der Faktoren Unrotierte Faktorladungen Rotierte Faktorladungen Beispiel Conjoint-Measurement • Welchen Beitrag liefern verschiedene Komponenten zum Gesamtnutzen eines Objekts? • Nutzenbeitrag der Einzelkomponenten berechnet aus empirisch ermittelten Gesamtnutzenwerten • dekompositionelles Verfahren bedeutet: Gesamtnutzen setzt sich additiv aus Teilnutzenwerten zusammen • Ableiten der Teilnutzenwerte aus Rankingwerten fiktiver Objekte (Stimuli) • Conjoint- Analyse ist in ihrem Kern eine Analyse individueller Nutzenvorstellungen. Häufig interessiert darüber hinaus die Nutzenstruktur einer Mehrzahl von Personen. Ablaufschritte einer Conjoint-Analyse (1) Eigenschaften und Eigenschaftsausprägungen (2) Erhebungsdesign (3) Bewertung der Stimuli (4) Schätzung der Nutzenwerte (5) Aggregation der Nutzenwerte zu (2): a) Definition der Stimuli: Profilmethode versus Trade-Off-Analyse b) Zahl der Stimuli: Vollständiges versus reduziertes Design Faktorenanalyse Eigenschaften und Eigenschaftsausprägungen Beispiel Vollständiges faktorielles Design Lateinisches Quadrat (reduziertes Design) Die obigen zwei Abbildungen zeigen Designs mehrer Basispläne(basic plans), die von Addelman entwickelt wurden, um die Bildung reduzierter Designs zu erleichtern. In der oberen Abbildung lassen sich Designs mit maximal 3 Eigenschaften und maximal 3 Ausprägungen bilden, die untereinander kombiniert werden. Im unteren Beispiel werden für die beiden Eigenschaften A und B mit jeweils 3 Ausprägungen die Spalten 1 und 2 aus Block 1 und für die Eigenschaften C und D mit jeweils zwei Ausprägungen die Spalten 3 und 4 aus Block 2 ausgewählt. Präferenzrangreihen zweier Studenten Individuelle Nutzenprofile zweier Studenten Errechneter Nutzenbeitrag der einzelnen Produktmerkmale > Höchster Nutzenwert: Coca-Cola / Glasflasche / -,48 DM 14 + 44 + 10 = 68 nicht im Erhebungsdesign !!! Diese Auswahl ist nicht möglich, da alle drei bzw. das Letzte Kriterium miteinander korrelieren. 7. Vorlesung Agenda Ergänzung zur vorherigen Vorlesung: > Clusteranalyse Typische Fragestellungen der Clusteranalyse Beispiel: Cluster im zweidimensionalen Merkmalsraum Proximitätsmaße bei der Clusteranalyse: Nominales Datenniveau > Der Tanimoto- bzw. Jaccard- Koeffizient misst den relativen Anteil gemeinsamer Eigenschaften bezogen auf die Variablen, die mindestens eine 1 aufweisen. Zunächst wird festgestellt, wie viele Eigenschaften beide Produkte übereinstimmend aufweisen. In dem Margarinebeispiel sind das drei Merkmale: „Lagerzeit mehr als 1 Monat“, „Diätprodukt“ und „Becherverpackung“. > Auf eine andere Art wird die Ähnlichkeit der Objektpaare beim RR- Koeffizienten(Russel/Rao) gemessen. Der Unterschied zum Tanimoto- Koeffizienten besteht darin, dass nunmehr im Nenner auch die Fälle, bei denen beide Objekte das Merkmal nicht aufweisen, mit aufgenommen werden. > Beim M- Koeffizienten(„Simple Matching“) werden gegenüber den anderen beiden Koeffizienten hier im Zähler alle übereinstimmenden Koeffizienten erfasst. Proximitätsmaße bei der Clusteranalyse: Intervallskaliertes Datenniveau Zur Bestimmung der Beziehung zwischen den Objekten zieht man in der Regel ihre Distanz heran. Zwei Objekte bezeichnet man als sehr ähnlich, wenn ihre Distanz sehr klein ist. Eine große Distanz weist umgekehrt auf eine geringe Ähnlichkeit der Objekte hin. Sind zwei Objekte als vollkommen identisch anzusehen, so ergibt sich eine Distanz von Null. In der praktischen Anwendung stellen die sog. Minkowski- Metriken oder L- Normen weit verbreitete Distanzmaße dar, die sich wie folgt berechnen lassen: Dabei stellt r eine positive Konstante dar. Für r = 1 erhält man die City- Block- Metrik (L1- Norm) und für r = 2 die Euklidsche Distanz (L2- Norm). Die City- Block. Metrik(auch Manhattan oder Taxifahrer- Metrik genannt) spielt bei praktischen Anwendungen vor allem bei der Clusterung von Standorten eine bedeutende Rolle. Sie wird berechnet, indem man die Differenz bei jeder Eigenschaft für ein Objektpaar bildet und die sich ergebenen Differenzwerte addiert. Da ein Objekt zu sich selbst immer die Distanz von Null hat, besteht die Hauptdiagonale einer Distanzmatrix immer aus Nullen(Bsp. Distanzmatrix S.492 des Skripts). Verfahren der Clusteranalyse • Hierarchische Verfahren: - Agglomerative Verfahren • Single-Linkage (Nearest Neighbour) ? vereinigt die Objekte, die die geringste Distanz haben • Complete-Linkage (Furthest Neighbour) ? vereinigt die Objekte, die die größte Distanz haben • Average-Linkage (Group Average) -> Weighted Average Linkage • Median-Verfahren -> Gewichtetes Centroid-Verfahren • Ward-Verfahren ? Zusammenfassung zu „wahren Gruppen“? Fusionsalgorithmus, Zielmaxime: „Vereinige diejenigen Objekte(Gruppen), die die Fehlerquadratsumme am wenigsten erhöhen“. - Divisive Verfahren • Nicht-hierarchische Verfahren: Die k-means-Methode Beispiel zur Verdeutlichung der Fusionierungseigenschaften: Distanzmaße bei hierarchischen Verfahren Ablaufschritte der agglomerativen hierarchischen Clusterverfahren Bestimmmung der Clusterzahl nach dem „elbow“- Kriterium Es ist hilfreich, die in der Zuordnungsübersicht aufgezeigte Heterogenitätsentwicklung gegen die zugehörige Clusterzahl in einem Koordinatensystem abzutragen. Zeigt sich in dem Diagramm ein „Ellbogen“, in der Entwicklung des Heterogenitätsmaßes, so kann dieser als Entscheidungskriterium für die zu wählende Clusteranzahl verwendet werden. Wir sprechen in diesem Fall auch von dem so genannten EllbowKriterium als Entscheidungshilfe. 8. Vorlesung Agenda > Produkttest > Storetest > Produkttest > Storetest > Markttest > Minimarkttest Produkttest • ausgewählte Testpersonen erproben kostenlos zur Verfügung gestellte Produkte • anschließende Befragung • Testobjekte: eigene Produkte, Konkurrenzprodukte, Prototypen • Ziele: -Ermitteln von Produktalternativen - "verbrauchsoptimales" Produkt - Gebrauchstauglichkeit - Imagewirkung - Vergleich mit Konkurrenzprodukten - Reaktionen auf Modifikationen - optimale Gestaltung einzelner Produktkomponenten • Vorteile: - kostengünstig - flexibel - relativ hohe Geheimhaltung • Hauptprobleme: - Repräsentativität der Testpersonen - Aussagekraft der Ergebnisse (Beispiele: Grundgesamtheit der Nassrasierer, Grundgesamtheit der innovativen jungen Haushalte) • Lösung: Produkttest-Panel der Mafo-Institute (Beispiel: GfK Nürnberg Produkttest-Panel mit 20.000 Haushalten in der BRD) Storetest • Probeweiser Verkauf von Produkten unter kontrollierten Bedingungen in ausgewählten Geschäften zur Überprüfung der Absatztauglichkeit neuer oder modifizierter Produkte • experimentelle Versuchsordnung • i.d.R. nicht repräsentativ angelegt (ca. 10-25 Geschäfte) • Bestandteil des Service-Angebots der Mafo-Institute • Institut übernimmt Transport, Platzierung und Bevorratung der Testprodukte, Kontrolle der Testsituation, Abrechnung mit den Einzelhändlern Standard-Storetest Besonderer Vorzug: Zuverlässige Ergebnisse bei vergleichsweise niedrigen Kosten. In 20 Testgeschäften kaufen durchschnittlich 30.000 Haushalte ein. Ergänzungsdienste: Nielsen-Testmärkte, Nielsen-Handelsbefragungen Vorteile: • kostengünstig • schnell • marktnahe Ergebnisse Nachteile: • nicht feststellbar, wer gekauft hat • Effekte durch Werbung werden nicht berücksichtigt • Anfälligkeit gegen Störaktionen • Gewinnung von Einzelhandelsgeschäften schwierig Auswahl der Testmärkte Bedingungen: 1. Bevölkerungs-, Bedarfs-, Handels- und Wettbewerbsstruktur entspricht dem Gesamtmarkt 2. Vergleichbare Medienstruktur 3. Bereitschaft des Handels zur Mitarbeit 4. Isolation des Marktes Großstadt reicht nicht aus als Testmarkt (Pendler, Verbrauchermärkte in der Peripherie) → Agglomerationsräume Bundesländer • Traditionelle Testmärkte: (Berlin), Saarland, Hessen Testmärkte • Vorteile: - Realitätsnähe - Austesten ganzer Marketing-Konzeptionen möglich • Nachteile: - sehr kostenintensiv - frühzeitige Darlegung von Strategien - regionale Unterschiede Minimarkttest am Beispiel des GfK-Behavior-Scan in Haßloch Mögliche Testgruppenstruktur im Minimarkttest Vorteile des Minimarkttests • Realitätsnahe Einblicke in das Käuferverhalten • Experimentalcharakter (unter realistischen und kontrollierten Bedingungen) • Kausalinformationen (aus annähernd natürlicher Testsituation) • Single-Source-Daten Beispiel: Entwicklung der Erstkäuferrate sowie der Wiederkäuferrate bei unterschiedlichem Werbedruck 9. Vorlesung Agenda > Apparativ gestützte Marketingforschung > Panelforschung > Mikrogeografische Panelauswertung Apparativ gestützte Erhebungstechnik • Psychophysiologische Messverfahren • Messung der elektrodermalen Reaktion • Blickaufzeichnung • Tachistoskopverfahren • Schnellgreifbühne Anwendungsschwerpunkte: - Verpackungstests - Werbemittel-Pretests Panel Definition: Ein bestimmter, gleich bleibender Kreis von Untersuchungseinheiten, bei dem wiederholt in regelmäßigen Abständen Daten zu einem ganz bestimmten Untersuchungsgegenstand beschafft werden. Arten: - Herstellerpanel - Großhandelspanel - Einzelhandelspanel - Verbraucherpanel - Spezialpanel Methoden: - mündliche Befragung - telefonische Befragung - schriftliche Befragung - Beobachtung Zweck: • Sichtbarmachen von Veränderungen des Marktes im Zeitablauf • Erfassen von Bewegungen im Markt • Grundlagen für Prognosen ? höhere Markttransparenz • Panelerhebung ermöglicht relativ schnelle Informationsgewinnung über wechselnde Marktbedingungen • Steigende Dynamik der Märkte ? positive Auswirkung auf die Nachfrage nach Paneldaten • Kundenkarten ? negative Auswirkung auf die Nachfrage nach Paneldaten Beispiel eines Panel-Stichprobenplans Probleme beim Verbraucherpanel • Under-Reporting • Panelsterblichkeit • durchlaufende Masse nach 1a 70-80 %, nach 3a ca. 60 % • Paneleffekt • Over-Reporting → Gegenmaßnahme: Teilnehmer-Rotation • Erfassung von Prestigeprodukten und Artikeln der Intimsphäre • Repräsentativität: Auswahleffekt Leistungsspektrum beim Verbraucherpanel Leistungsspektrum beim Handelspanel Was bestimmt das Shopping Behaviour für ein bestimmtes Geschäft? > Erreichbarkeit > Attraktivität des jeweiligen Geschäfts > Alternative Einkaufsmöglichkeiten Optionsspektrum eines ausgewählten Haushalts in Köln Optionsspektrum bis 20 min Fahrzeit → Beispiel ALDI-Analyse: Gebietsabdeckung Potentials-Ausschöpfung ALDI im Einzugsgebiet Potentialsausschöpfung Discounter im Einzugsgebiet Aldi contra Lidl > Von allen Haushalten haben 52,6 % die gleiche Entfernung zu ALDI und LIDL > Insgesamt ist das Umsatzverhältnis ALDI zu Lidl 74 % zu 26 % > Bei Zeitgleichheit ist im Durchschnitt das Umsatzverhältnis ALDI zu Lidl 64 % zu 36 %. Optionsnormierte Umsatzanteile Attraktivität 10. Vorlesung > Gastvortrag smart GmbH 11. Vorlesung > Gastvortrag EUMARA AG 12. Vorlesung > Kursorischer Überblick Ende