Sprache und Sprachrezeption - Fachschaft Psychologie Freiburg

Werbung

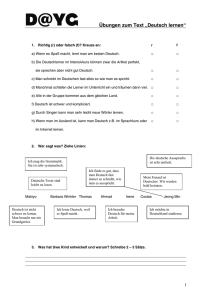

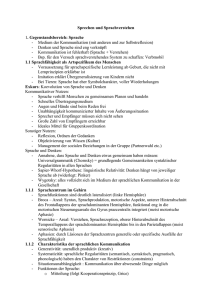

Sprache und Sprachrezeption Sprache - Sprache ist wichtigstes Medium zur Kommunikation und (Selbst-)Reflexion - Ist nicht notwendig zum Denken (Tiere denken auch), aber beim Erwachsenen Menschen sind Denken und Sprache aufs Engste verknüpft - Bisher gelang noch kein Computersystem, das Sprache annähernd so gut verarbeitet wie Menschen. Gleichzeitig reden Menschen jedoch eigentlich ziemlich fehlerhaft. Sprachfähigkeit ist Artspezifikum des Menschen Von Geburt an sind die Voraussetzungen zum Sprachelernen gegeben. Denn: - die Muttersprache wird ohne „Beschulung“ d.h. spontan erworben, - ist nicht durch reine Lernprinzipien erklärbar, insbesondere auch nicht durch Imitation (siehe Phase der Übergeneralisierungen: das Kind bildet Formen, die es noch nie gehört hat „gehte, gegangt“ Primaten können zwar Sprache im Ansatz lernen (nur durch „Beschulung“!), wie andere Tier“sprache“ hat sie aber immer noch vor allem - Signalcharakter - Bezieht sich auf das hier und jetzt - Ist voller Wiederholungen, - Dafür aber nahezu frei von Syntax, passenden Wortendungen, Nebensätzen etc. Zusammengefasst: menschliche Sprache ist komplex, flexibel, wird von Menschen spontan erworben tataa: artspezifische Fähigkeit! =) Die Idee der Universalgrammatik: Stammt von Chomsky und macht die Annahme, dass es grundlegende Gemeinsamkeiten aller Sprachen geben könnte und „nur“ einige Parameter die verschiedenen Sprachen der Menschen dann unterscheiden. Das ist insofern schlüssig, als sich Sprache und Denken in der Evolution gemeinsam entwickelt haben (Koevolution) und somit strukturell (in syntaktischen Regularitäten) die Sprachen sich vielleicht ähneln. Klingt gut, konnte bisher aber nicht belegt werden, obwohl Linguisten Grammatiken aller möglichen Sprachen erstellen und vergleichen. Sprachzentren im Gehirn: Fast immer lateralisiert bei Rechtshändern fast immer linkshemisphärisch, bei Linkshändern unterschiedlich macht insgesamt bei 90% d. Menschen linkshemisphärisch Zwei kortikale Sprachzentren, grob erklärt: Name Broca-Areal Wernicke-Areal Funktion Location i.d. sprachdominanten Hirnhälfte u. wichtige Verbindungen Syntax, Liegt unten hinten am motorische Frontallappen, etwa Aspekte der Schläfengegend Sprachproduktion Funktional in die motorischen Steuerungsareale des Gyrus präcentralis integriert (logisch – will ja den Sprachapparat motor. steuern) Verstehen, Liegt hinten oben am Sprachrezeption Temporallappen, also etwa oben hinterm Ohr, (dehnt sich genaugenommen aus bis auf Parietallappen) Ist eng mit der Hörrinde verbunden (logisch – will ja verstehen) Bei Läsionen (z.B. durch Schlaganfall) Ausnahmen i.d.R. motorische Aphasie: das Sprechen ist stark beeinträchtigt, mühsam, es werden sehr kurze Sätze (Telegrammstil) gebildet, Grammatikalität geht verloren, aber das Gesagte ist sinnvoll! Sprachverstehen ist weitestgehend intakt Kommen vor! Es kann trotz Läsion kaum bis keine Beeinträchtigung vorkommen, sowie auch Beeinträchtigung obwohl Läsion in völlig anderem Bereich Zusätzlich zu aphasischen Stör. Auch nonverbalkognitive Defizite möglich alles ist möglich i.d.R. sensorischer Aphasie: die Leute reden flüssig (also kein Problem der Sprachproduktion), oft unsinnig, das Verstehen ist stark beeinträchtigt, die Bedeutung des Gehörten wird nicht erkannt Wenn’s so einfach wär – hier sind die Einschränkungen: Sowohl an Sprachrezeption als auch an Sprachproduktion sind noch auf komplexe (und bei verschiedenen Menschen nicht auf die gleiche) Weise subkortikale Areale beteiligt, die miteinander auch verschaltet sind. (s. Ausnahmen bei Läsionen – mglw. damit im Zusammenhang) Fodor (1983) postuliert ein „Input-Output-Modul“ der Sprache und somit, dass Denken und Sprechen nicht so eng zusammenhängen, wie es die berühmte Sapir-Whorf-Hypothese (linguistische Relativität: Denken hängt von der jeweiligen Sprache ab) behauptet, diese sei damit widerlegt! Fodor gründet seine These auf die Existenz der oben beschriebenen beiden Sprachzentren, die unterschiedliche Funktionen besitzen. Charakteristika der sprachl. Kommunikation Generativität Systematizität Sprache ist unendlich produktiv (weiteres Argument gegen Imitationslernen!) Neuschöpfungen, Weiterentwicklung Grundlage je Sprache 25-40 untersch. Phoneme, werden zu wenige hundert Funktionswörter, viele tausend Inhaltswörter, unendlich viele Sätze sind möglich Sprachliche Regeln sind trotz der gestalterischen Freiheit von Sprache quasi harte Restriktionen (man darf nicht machen, was man will..) Semantische Restriktion (die Bedeutung muss/soll Sinn machen): Der Fels war bewusstlos ist kein sinnvoller Satz, entspricht somit nicht den Kommunikationsregeln Syntaktische Restriktion (Satzbau muss regelgerecht sein): Kurt hört die Vorlesung. Nicht: Vorlesung hört Kurt die. Weitere: pragmatische und phonologische Restriktionen (nicht näher ausgeführt) Situationsunabhängigkeit Arten der Kommunikation: Mitteilung Sprache kann von Dingen handeln, die nicht gegenwärtig oder gar real sein müssen (abwesende Personen, Mythen, Fantasiewelt, Zukunft, Abstraktes,....) Das wäre mit Gesten oder einfachen Signalen nicht möglich Anderen etwas erzählen Grice’s Regeln: Zweckorientiert (nur was dem Zweck der Unterhaltung dient, nicht mit Unwichtigkeiten nerven) Aufforderung Expression Handlungsvollzug Indirektes Handeln, indem andere (direkt oder indirekt) aufgefordert werden, etwas im Sinne unserer Ziele zu tun Befindlichkeit, Gefühle Das Gesprochene ist die Handlung, oft eine Formel oder Formalität, man sagt auch performativer Sprechakt Beachtung des Adressaten und seines Hintergrundwissens etc. (wem wir etwas sagen, bestimmt mit, was wir ihm sagen und wie wir es tun) wen wir auffordern und in welcher Situation, bestimmt mit, wie wir es tun Beeinflusst die emotionale Beziehung zwischen den Gesprächspartnern Taufe, Schwur, Sitzungseröffnung usw. Sprachspezifisches Wissen Sensitivität für Sprachlaute bei Säuglingen geht auf sprachl. Wahrnehmung schon vor der Geburt zurück. Der Mutterspracherwerb ist mit zwölf Jahren abgeschlossen, bis dahin hat das Kind auch die zahlreichen Regularitäten erworben, mit denen es aus dem riesigen Wortschatz komplexe Äußerungen produzieren kann. Sprachspezifisches Wissen aus dem Langzeitgedächtnis mit eher prozeduralem Charakter: lexikalisches Wissen = Wortschatz grammatikalisches Wissen (Flexion von Wörtern, Satzbau etc.) pragmatisches Wissen (Stil, situationsadäquate Verwendung von Sprache,....) daneben verwendet man noch Wissen, das eher deklarativ ist: begriffliches Wissen (die Bedeutung von Wörtern) Weltwissen = Hintergrundwissen (allgemein u. Bereichsspezifisch) Dass die beiden Arten von Wissen getrennt werden, ist deshalb sinnvoll, weil es möglich ist inhaltlich sinnlose Sätze zu bilden, die aber einen korrekten Satzbau haben (Chomsky: „green ideas sleep furiously“) Grammatik im linguistischen Sinn möchte wissenschaftlich beschreiben, wie Muttersprachler Äußerungen aufbauen und für richtig halten (im Gegensatz zu Schulgrammatik!). Das Wissen darüber (muttersprachlicher Gebrauch) ist grammatikalisches Wissen. Variabilität innerhalb von Sprachen beschreibt, dass es regionale Unterschiede in derselben Muttersprache gibt (Bayern sagen „das Cola“, jeder normale Mensch jedoch „die Cola“ =) z.B.) Kompetenz und Performanz Kompetenz: zuhören, verstehen, sprechen, unterhalten, erkennen was sprachlich richtig/falsch ist Performanz: empirische Realität des Sprachgebrauchs, voller Fehler (z.B. unvollständige Sätze etc. gleichzeitig werden die wichtigsten Regularitäten aber meist befolgt), da das Arbeitsgedächtnis beschränkt ist, richtet sich die Performanz auch daran aus (eher kurze, nicht sehr verschachtelte Sätze) Kompetenz: „idealer Sprecher-Hörer“ → Linguistik Performanz: reales Verhalten v. Personen → Sprachpsychologie Sprachrezeption Rezeption sprachlicher Äußerungen am Anfang: Sprachwahrnehmung →Worterkennung (← lexikalisches Wissen) syntaktische Analyse (← syntaktisches Wissen) semantische Interpretation (Inhalt erfassen) (← semantisches und Weltwissen) Inhalt überführen in ein mentales Modell und mit vorhandenem Wissen integrieren → inkrementeller Vorgang (Wort für Wort), kann aber auch rückwärts gerichtet werden, wenn Probleme auftauchen (semantischer oder syntaktischer Art) → Reanalyse Grundsätzlich: Tendenz zur Ökonomie! Sowohl syntaktisch als auch semantisch wird nur eine Lesart kognitiv repräsentiert (s. Ambiguität – es wird eine Art gewählt den Satz/die Konstruktion zu verstehen, wenn das nicht aufgeht, wird reanalysiert und dann erst die Alternative „ausprobiert“) Sprachrezeption erfolgt weitgehend mühelos und ist selbstverständlich (man muss nicht „besonders befähigt“ sein), ist der Introspektion nicht zugänglich und erst das Resultat wird bewusst (so wie bei visueller Wahrnehmung). Wissenschaftlich gesehen ist es jedoch ein höchst komplexer Prozess und eigentlich eine schwierige Aufgabe, die unser Gehirn da bewältigt. Ambiguität Fast jeder Satz ist stellenweise mehrdeutig (lokal ambig – das würde sich an einer bestimmten Stelle auflösen), manche auch global ambig (also auch am Ende des Satzes ist nicht eindeutig, welche Bedeutung gemeint ist) Bsp.: Dass der Doktorand der Professorin Urlaub genommen hat... Müllers sahen die Störche auf ihrem Flug nach Afrika Ursache sind häufig Wörter, die in mehreren Funktionen eingesetzt werden können (bspw. mit) Bsp.: mit dem Flugzeug nach New York fliegen (Art und Weise) mit der Freundin nach New York fliegen (...zusammen, nicht auf ihr) mit Lufthansa nach New York fliegen (mit denen macht man da aber nicht Urlaub) mit dem Flugsimulator nach New York fliegen (dann steigt man nicht in NY aus) ...... → sehr verschiedene Schlüsse können gezogen werden, sinngemäß wird aber meist die richtige Bedeutung von mit erkannt. =) Teilprozesse der Rezeption Sprachwahrnehmung: aus dem Schallsignal (in höchst verschiedenen Situationen) müssen Einheiten (v.a. Wörter) erkannt werden Lexikalischer Zugriff: erkannte Einheiten müssen mit bekannten Einheiten aus dem Gedächtnis (Wortrepräsentationen u. Begriffl. Repräsentationen) in Verbindung gebracht werden Syntaktische Analyse (=Parsing): im Gehörten identifiziert man eine syntakt. Struktur und erhält darüber Information über grammatische Funktionen (wer mit wem, worüber, etc.) semantische Interpretation, Verstehen: das mentale Modell wird konstruiert, und neue Information (z.B. das nächste Wort) in den Kontext des Schon-Gehörten integriert, dies alles unter Hinzuziehen von Weltwissen und Wissen über die Gesprächssituation etc. Dieses Modell soll es ermöglichen aus dem Gehörten (oder Gelesenen) Schlüsse zu ziehen. siehe hierzu als grafische Darstellung des Modells S. 288 (unklar ist mir, warum unten aus dem Modell „Schrift“ rauskommt...ich hätte eher „Verstehen“ oder „Repräsentation des Gehörten“ erwartet) [Forschungsfragen auf dem Gebiet befassen sich mit den einzelnen Schritten/Detailprozessen, der Ablaufmodalität (parallel? Nacheinander? Rückkoppelnd?...) sehr interdisziplinär: Psychologie, Linguistik, Informatik] Schallsignal und Sprachwahrnehmung Das physikalisch messbare Schallsignal ist eine sehr komplexe Schwingung. Versuche, durch phonetische Technik aus dem Schallsignal zu entschlüsseln, was gesagt wurde, gelingen nicht zufriedenstellend – sehr hohe Fehlerrate. (Wer etwas sagt, lässt sich allerdings mit solcher Technik feststellen, d.h. sie kann verschiedene Sprecher unterscheiden). Bemerkenswert also, dass unser Wahrnehmungsapparat aus kontinuierlichen Äußerungen Wörter segmentieren kann! Kategoriale Wahrnehmung Lautsignale kann man kontinuierlich verändern, bspw. Von /da/ nach /ta/ Der Phonem-Restaurationseffekt von Warren, 1970: schneidet man ein Phonem aus einer (Tonband-)Aufnahme von etwas Gesprochenem heraus und ersetzt es durch ein anderes Geräusch (bspw. Husten), dann glauben die VP dennoch, das Phonem gehört zu haben. Samuel (1982) zeigte, dass dies v.a. im Wortkontext geschieht, weniger bei isolierten Silben. „Bei der Sprachwahrnehmung greifen also bottom-up und top-down getriebene Prozesse ineinander.“ [Ich würde sagen, das „Überhören“ falscher Phoneme und automatische Ergänzen von Wörtern ist top-down – man hat eine bestimmte/unbewusste Erwartung, was man hören wird (Stichwort: Voraktivierung). Wenn etwas irritierendes eintritt UND bemerkt wird (wie bei Samuel einzelne verfälschte Silben – an die hat man keine besondere Erwartung, da sinnlos), das wird bottom-up verarbeitet. ...meine Interpretation] Eine Anwendung dessen findet sich in der Wiedererkennung eines Sprechers (Täter, wenn’s um Verbrechen geht) durch Ohrenzeugen. Spricht der Zeuge die gleiche Sprache wie der Täter, gelingt die Identifikation besser, da der Zeuge „geringfügige Idiosynkrasien“ also individuelle Besonderheiten in der Sprache des Täters nur beurteilen kann, wenn er gute Kenntnis des Bezugssystems (der Sprache samt Verwendung etc.) hat. [verwirrt? S. 290 links] Lesen Lernt man nicht spontan, sondern nur durch Unterricht. Es bedarf einiger Übung, bis man direkt von der visuellen Mustererkennung auf das mentale Lexikon zugreifen kann (der Zwischenschritt des Lautwerdenlassens, also Umsetzung von der Schrift in den Klang der Sprache, war bis ins Mittelalter noch üblich – man las laut, und auch kleine Kinder brauchen das ja zu Anfang noch) Die Blickbewegungen erfolgen sakkadisch (in Sprüngen), eine Fixation dauert 100 bis 250 ms, links vom Fixationspunkt werden 2-4 Buchstaben wahrgenommen, rechts vom Fixationspunkt 5-9 Buchstaben (wenn von links nach rechts gelesen wird! lernabhängig, nicht biologisch fundiert) Für sprachpsychologische Forschung ist lesen interessant, weil es die Verarbeitungsgeschwindigkeit abbildet – diese ist bei Höraufgaben nicht „ausgelastet“, wir sind kognitiv viel schneller als die normale Sprechgeschwindigkeit Lexikalischer Zugriff = zu einem wahrgenommenen Schall- oder visuellen Muster die passende mentale Repräsentation zu finden Mentales Lexikon = Gesamtheit des sprachspezifischen Wissens, soweit es auf Wörter bezogen ist (Wortstamm (=Lemma) + seine morphologischen Formen) Lemmata (Sg.: Lemma): Elemente des mentalen Lexikons, enthalten semantische und grammatische Information (Wortart, Genus) Morpheme: kleinste bedeutungstragende Sprachbausteine.... Lehrerin hat 3 Morpheme: lehr weist auf eine spezifische Tätigkeit hin, er weist auf den Akteur der Tätigkeit hin, in auf das weibl. Geschlecht des Akteurs; Wasserball hat zwei Morpheme Morpheme sind nicht Silben!! Ein Morphem kann mehrere Silben haben. Und auch Morphem- und Silbengrenzen unterscheiden sich ggf.: tanzen besteht aus den Morphemen tanz und en, aber Silbentrennung tan-zen Worterkennung Sicherheit und Schnelligkeit der Worterkennung lässt sich experimentell sehr gut mit der shadowing-Technik darstellen: VP hören etwas über Kopfhörer und sollen es direkt nachsprechen. Die beste VP hatte nur ca. eine Silbe Abstand zum Vorgesprochenen (250ms). Es werden sogar Fehler der „Vorlage“ beim Shadowing korrigiert offensichtlich ist die Sprachverarbeitung beteiligt! Marslen-Wilson (1985) nahm auf dieser Grundlage in seinem Kohortenmodell an, dass die Worterkennung wie ein Ausschlussverfahren funktioniert: Phonem für Phonem bleiben nur die Wörter des „Lexikons“ im Spiel, die noch möglich sind mit der Phonemkonstellation, solange bis es eindeutig ein bestimmtes Wort ist oder nur noch sein kann. Neuere Versionen des Modells gehen aber davon aus, dass nicht Phoneme sondern phonologische Merkmale auf unterspezifizierte Wortformen abgebildet werden. Segmentierung ist die Kunst Wortgrenzen in einem Redeschwall zu erkennen, die sind nämlich nur selten tatsächlich durch Pausen markiert. Kleine Kinder (2J) entwickeln meist die „Theorie“, dass Wörter prinzipiell maximal zweisilbig sind und auf der ersten Silbe betont (lade für Schokolade; mate für Tomate). Auch bei englischen Erwachsenen zeigte sich dass ambige Äußerungen bevorzugt als ein Wort wahrgenommen werden, wenn auf der ersten Silbe betont (lettuce / let us), im Vergleich zu solchen, die auf der zweiten Silbe betont werden (invests / in vests). Solche Strategien sind aber sehr sprachspezifisch, daher nicht ohne weiteres übertragbar! Prozessmodelle der Worterkennung Suchmodell (Forster 1985): aufgrund des Buchstabenmusters wird eine Teilmenge des Lexikons ausgewählt und seriell durchsucht, es wird überdies angenommen, dass das Lexikon nach Vorkommenshäufigkeit der Wörter sortiert ist (da vielbenutzte Wörter schneller zugänglich sind) -> neurobiol. nicht plausibel Weiteres Modell: aktivierende Verbindungen zwischen ähnlichen Wörter und Berücksichtigung ihrer Vorkommenshäufigkeit (neighbourhood activation model) Konnektionistische Modelle: bottom-up und top-down spielen zusammen, bottom-up aktiviert durch bestimmte Merkmale, top-down sind schon einige Wortknoten teilaktiviert, das wirkt zusammen und erklärt den Wortüberlegenheitseffekt (Buchstabe in einem sinnvollen Wort wird leichter erkannt als in einer sinnlosen Buchstabenkombination) gibt mittlerweile auch eine gute konnektionistische Modellierung des Kohortenmodells (s.o.) Rein datengetriebene Modelle: auch erstaunlich gut, im technischen Bereich der Spracherkennung dominierend: stochastische Modelle Der Geltungsbereich all dieser Modelle ist unklar, neben Wortlänge und Vorkommenshäufigkeit spielen auch semantische Faktoren (Konkreta schneller erkannt als Abstrakta) und kontextuelle Aspekte usw. eine Rolle. [Neuropsychologische Modelle: ...werden an alle möglichen auftretenden Ausfallerscheinungen, Krankheiten und Phänomene angepasst, sind deshalb zunehmend komplexer und lassen auch am Konzept eines einzigen mentalen Lexikons zweifeln. Für gesunde Erwachsene und unseren Zweck eines einführenden Kapitels kann man das aber einfach trotzdem annehmen.] Inhalte des mentalen Lexikons Lemmata (Stammwörter) jedes Lemma hat einen eigenen Eintrag Lexikalische Formen (meist Flexionsmorpheme, die aus Lemmata Wortformen bilden, z.B. sing-en, sing-t,.. ohne eigenen Eintrag) Derivationen (z.B. –ung, das aus das Lemma bild- modifizieren kann zum Lemma Bild-ung) eigenständige Einträge [Wikipedia sagt, Derivation ist eine Form der Wortbildung, ein Teil wird angehängt und ein „neues“, eigenes Wort entsteht. Faustregel: wenn das neue Wort im (echten) Lexikon einen eigenen Eintrag hätte (Bildung würde extra stehen, nicht unter bilden; oder auch singen und Sänger) ist es ein eigenes Lemma (und Lexem), bildest würde aber im Eintrag von bilden stehen] Semantische Information Verschiedene Annahmen: direkt schon im mentalen Lexikon könnte die Wortbedeutung durch semantische Merkmale repräsentiert sein, das ist aber eigentlich nicht so wahrscheinlich, deshalb geht man eher davon aus, dass die Bedeutung eines Wortes im semantischen Gedächtnis ist, und das mentale Lexikon auf die jeweilige Begriffsrepräsentation im semant. Gedächtnis verweist. Diese „Arbeitsteilung“ scheint insofern schlüssig, als das mentale Lexikon einzelsprachlichen Charakter hat, die begriffl. Repräsentation im semant. Gedächtnis wiederum für verschiedene Sprachen dienen kann. Morphologische Information Ein Eintrag im mentalen Lexikon kann verschiedene Varianten enthalten (Kasus-/Numerusformen, Konjugationsformen, je nach Wortart). Im Deutschen kann man sich vorstellen, dass die umfangreiche Flexionsmorphologie in Klassen organisiert ist, die eine Art „Wortsyntax“ vorgeben, so dass wenigstens z.B. die regelmäßigen Verben nicht alle einen eigenen Eintrag brauchen, sondern die sparsamere Form der Klassenzuordnung ausreicht. Unregelmäßige Verben bräuchten jedoch wohl einen eigenen Eintrag. Syntaktische Information Auch im mentalen Lexikon sind die syntaktischen Eigenschaften eines Wortes, an erster Stelle die Kategorie (Verb, Nomen, etc.), eventuell noch Subkategorisierung für ggf. notwendige Komplemente (ein Verb braucht eine Nominalphrase, kein Verb ohne Subjekt; falls es ein transitives Verb ist, muss auch noch ein Objekt her, z.B. man kennt immer jemanden; oder sogar ein ditransitives Verb, dass noch ein indirektes Objekt braucht) Auch Präpositionen brauchen immer noch ein Komplement in einem bestimmten Kasus. Gibt auch noch optionale Komplemente, die müssen nicht sein, sind aber erwartbar (z.B. eine Tochter ist immer die Tochter von jemandem, ein Entdecker der Entdecker von etwas) Kodierung für Rezeption und Produktion Es muss außerdem die phonologische Struktur (bzw. graphemische Struktur beim Lesen) im mentalen Lexikon verzeichnet sein, sodass bei der Sprachrezeption über diese phonol. Kodierung der Zugriff auf die lexikalische Information möglich ist. Andererseits muss für die Sprachproduktion vom begrifflichen Wissen aus ein Zugriff auf die lexikalische Information (und die phonologische) möglich sein. Es ist noch nicht geklärt, ob diese beiden Verwendungen unterschiedliche Zugriffsarten auf das gleiche mentale Lexikon sind (wäre naheliegend) oder ob sogar zwei verschiedene Lexika (eins für Rezeption und eins für Produktion) vorhanden sind (das legen einige neuropsychologische Befunde nahe). Überdies ist das mentale Lexikon über weite Teile der sprachdominanten Hemisphäre verteilt ergo: „Mentales Lexikon“ ist ein sehr nützliches theoretisches Konstrukt der Sprachpsychologie, aber es hat wohl keine einheitliche neuronale Struktur als Entsprechung. Wortsemantik und semantisches Gedächtnis Es ist sinnvoll mentales Lexikon und semantisches Gedächtnis anzunehmen, weil bei Zweitspracherwerb zwar zuerst die direkte Verknüpfung von z.B. dt. zu engl. Wort, bei fortschreitender Kompetenz sind die Wörter aber nur noch indirekt verknüpft, nämlich über die jeweilige semantische Bedeutung/Repräsentation. Dann existiert ein eigenes mentales Lexikon für die Zweitsprache, beide mentalen Lexika benutzen jedoch das gleiche semant. Gedächtnis Wortbedeutung Schon viele Versuche Semantik von Wörtern zu erfassen. Extensionale Bedeutung = Referenzsemantik: bezieht sich auf Objekte in der Welt (z.B. alle Tomaten die es so gibt) Intensionale Bedeutung: das, was wir folgern können, wenn jemand von einer Tomate spricht (meist rot, 2-10cm, essbares Gemüse...) Andere Unterscheidung: Denotation: wörtliche Bedeutung (intensional wie extensional) Konnotation: affektiv getönter Bedeutungs-„Hof“ Außerdem: ...ist ein Begriff möglicherweise durch die hierarchische Anordnung von semantischen Merkmalen charakterisiert allerdings nicht sehr überzeugend. Man kann per statistischer Analyse Ähnlichkeitsbeziehungen zwischen Wörtern „errechnen“, indem man untersucht, welche Wörter in vielen Textabschnitten oft zusammen vorkommen, hat aber eigentlich nicht richtig viel mit semantischem Gedächtnis zu tun. LSA=latente semantische Analyse: ist quasi das vorgenannte - semantische Ähnlichkeit, wird angenommen, wenn Wörter mit den gleichen anderen Wörtern oft vorkommen....komplizierte statistische Analyse=Bahnhof....ist im Endeffekt aber weniger die Bedeutung einzelner Wörter, die rauskommt, als vielmehr die Bestimmung von Ähnlichkeitsstrukturen in einer Menge von Wörtern. [nix verstanden? S.295] Phonologisches und semantisches Priming Neben dem Wortüberlegenheitseffekt gibt es auch den Effekt, dass Wörter im Kontext anderer Wörter besser erkannt werden: wenn vorher ein semantisch verwandtes Wort präsentiert wurde, wird das aktuelle Wort schneller erkannt Priming-Paradigma! Mögliche Versuchsaufbauten: naming – schnell das Wort aussprechen (visuelle Darbeitung), shadowing – schnell nachsprechen (akustische Darbietung), lexical decision – per Tastendruck entscheiden, ob es ein Wort der Muttersprache ist (visuell oder akustisch) Die Aufgabe bezieht sich immer auf das Zielwort, diesem geht ein Prime-Wort voraus, das entweder Wort oder Pseudo-Wort (aussprechbar, aber sinnlos) ist Priming natürlich wie immer sehr kurz davor (100-1200ms – SOA=Stimulus-Onset Asynchrony) KG (Kontrollgruppe): bekommt Priming-Wörter ohne Beziehung zum Zielwort (Apfel – Buch) EG (Experimentalgr.): bekommt Wörter, die semantisch ähnlich (Buch – Zeitung), phonetisch ähnlich (Burg - Buch) oder hoch assoziiert (lesen – Buch) sind verglichen wird die Reaktionszeit Priming-Effekt zeigt sich sogar bei polysemen Wörtern wie Bank, und zwar in beide Richtungen (keine Bevorzugung) – sogar im Satzkontext, wenn die eine Bedeutung manifestiert ist, funktioniert bei kurzer SOA das Priming auch für den anderen Bedeutungsbereich des Wortes (bei längerer SOA nicht, dann nur kontextangemessen) Erklärung des Effektes: Wahrnehmung des Prime-Wortes aktiviert die entsprechende Repräsentation im mentalen Lexikon (und schwach auch phonologische Wortknoten) und die seiner Bedeutung entsprechenden Konzeptknoten im semant. Gedächtnis - die Aktivierung klingt nur langsam ab und ist deshalb bei Erscheinen des Zielwortes noch teilaktiviert. Opake (nicht sinnvoll ersetzbare) Wörter wie Himmelsschlüssel (=eine Blume), primen zwar die Wortbestandteile (Himmel und Schlüssel), aber nicht damit verwandte Wörter (wie Sonne oder Tür). Anwendungen (mentales Gedächtnis) Wichtig für Neuropsychologie – fast bei jedem Hirntrauma ist irgendwie Sprachverarbeitung betroffen Zweitspracherwerb (s.o.: zu Beginn direkte Verknüpfung, später indirekt über semant. Gedächtnis – eigenes mentales Lexikon für Zweitsprache; insbesondere interessant: Dolmetschen/Übersetzen – oft Besonderheit eines Ausdrucks transportieren) Syntaktische Verarbeitung (= Parsing) Nach dem Auseinanderklamüsern einzelner Wörter aus dem Redefluss, müssen diese nun weiterverarbeitet werden. Dies beginnt quasi unmittelbar nach einer Worterkennung. 2 Hauptaufgaben: Rekonstruktion der Struktur einer Äußerung und Interpretation der Äußerung Syntaktische Verarbeitung geschieht mit jedem Wort, denn meistens ist die Möglichkeit der folgenden Sätze begrenzt (zumindest die Art des notwendigerweise folgenden Satzes ist oft klar), zu einem Verb gehört ein Agent, zu einer bestimmten Präposition muss vllt. eine Nominalphrase im Dativ,.... Man kann das als Phrasenstruktur darstellen in Form einer Formel oder eines Strukturbaumes (s. S. 297/298) Parsing geschieht automatisch, ist nicht unterdrückbar, und nachweisbar im Experiment, wie z.B. von Flores D’Arcais (1982), der zeigte, dass unbemerkte syntaktische Fehler in einem Lesetext dennoch zu einer Verzögerung der Verarbeitungszeit führten! Syntax+Lexikon=Grammatik Erinnerung: Grammatik bedeutet hier „wissenschaftlicher Versuch, die dem Sprachgefühl und Sprachgebrauch entsprechenden sprachlichen Regularitäten zu beschreiben, und zwar möglichst sparsam und systematisch (wie jede gute Theorie)“ Hier wird sich auf die Phrasenstrukturgrammatik beschränkt, diese ist als generative Grammatik formuliert, also mit einigen Erzeugungsregeln, wie Sätze gebildet werden können (z.B. dass ein Satz ein Verb (V) benötigt, dieses eine Nominalphrase (NP), auch eine Präpositionalphrase (PP) braucht zur Präposition (Prep) eine Nominalphrase (NP).......) Der Hund jagt die Katze (NP, VP (V, NP)) die wesentlichen syntaktischen Abhängigkeiten werden von diesen Regeln jedoch nicht erfasst. Das kann HPSG (head-driven phrase structure - andere Methode) Funktionale Rollen: Grammatisch gesehen (Subjekt, Objekt, diese als Verbkomplemente) Thematische Rollen: Inhaltlich/semantisch gesehen (Agent, Rezipient, Thema,...) Sprachtypologische Unterschiede: je nach Sprache verschiedene Restriktionen / verschieden strenge Regeln, verschiedener Umfang (bsp. Im Deutschen viel umfangreichere Kasusmorphologie als im Englischen) Um funktionale Rollen der Wörter im Satz festzulegen, kann man allgemein sagen, dass entweder die Wortstellungsregeln oder die Kasusmorphologie dazu verwendet werden. (Bsp. Türkisch: reiche Kasusmorphologie, Wortstellung aber sehr frei, Englisch: keine Kasusmorph., dafür strenge Wortstellungsregeln) Mentale Repräsentation syntaktischen Wissens: Grammatikalisches Wissen sehr implizit! Wissen höchstens nachträglich in der Schule erlernt. Grammatikalität von Äußerungen Man kann sehr schnell sagen, „ob man etwas so sagen kann“, dabei sprechen wir oft ziemlich ungrammatikalisch, aber an den entscheidenden Stellen stimmt’s dann doch meistens Ellipsen: (Satz-)verkürzungen meist nur im genauen Kontext verständlich, weil so viel Information ausgelassen wird, dass mindestens der Satz vorher bekannt sein muss, um den Sinn zu erfassen. Experimentelle Paradigmen zur Analyse der Satzverarbeitung: Offline-Verfahren: im nachhinein wird erhoben, z.B. über Ratingskala, Fragebogen oder auch Lückentechnik, für Textverstehensforschung wird auch Behaltensleistung gemessen Verschiedene Online-Verfahren sind: Erfassung der Lesezeit: über Tastendruck (VP kann selber weiterklicken, aber evtl. auch andere Prozesse, als reine Sprachverarbeitung (Varianten: stationary window – Text erscheint immer an selber Stelle, moving window – Text steht da, wo das nächste Wort stehen würde, wenn’s als ganzer Satz dastünde) Blickbewegungsregistrierung (eye-tracker), hier werden Fixationspunkte und –zeiten messbar, so auch Rücksprünge im Text beim Lesen) EEG-Technik: Hirnaktivität messen, hohe zeitliche/schlechte räumliche Auflösung, muss wegen hoher Hintergrundaktivität über die Methode der evozierten Potentiale erhoben werden (ca. 50 Messungen gemittelt, um dann den Effekt sichtbar zu machen). Messzeitpunkt muss sehr genau platziert und sonstige Bewegungen weitgehend ausgeschlossen werden Effekt heißen dann nach ihrem Scheitelpunkt: P600 ist der Zacke nach 600ms etc.. Mgl: fMRI als komplementäre Ergänzung (gute räuml. Auflösung) Materialkonstruktion: Muss sehr sorgfältig erfolgen. Testsätze in „Füllsätze“ einbetten, damit nicht zu offensichtlich. Wegen interindividueller Unterschiede der Lesegeschwindigkeit zw. VP wird die Lesezeit innerhalb einer VP gemessen (Bsp. S. 302) Hauptergebnisse der Parsing-Forschung: Inkrementalität: Sprachverarbeitung findet während des Hörens/lesens schon Wort für Wort inkrementell statt Anbindungs-Ambiguitäten: In Relativsätzen. Erst an der Disambiguierungsstelle erhöht sich die Lesezeit, beim Holzweg-Effekt (also einer heftigen Verletzung der Erwartung, die auch bewusst wird) ist diese sehr stark erhöht. Weitere Ambiguitäten: Häufig durch freiere Wortstellung im Deutschen und gleichzeitig häufige Ambig. durch Nominativ und Akkusativ Theoretische Modelle des menschlichen Parsers Parsing: inkrementell, eine erste syntaktische Analyse wird erstellt noch ohne von inhaltlichen Hinweisen Gebrauch zu machen, hier geht auch Frequenzinformation (wie häufig kommt ein Wort so vor/in der Lesart), wenn bei dieser ersten Analyse Unstimmigkeiten, dann Reanalyse der Satzstruktur modular, da vorläufig nur syntakt. Analyse; es wird nur eine Analyse (nicht mehrere parallel) durchgeführt Parsing-Modelle ohne Reanalyse: gehen entweder von multiplen Analysen aus oder von der wait-and-see-Analyse, bei der erst am Disambiguierungspunkt analysiert wird. Empirie zeigt: Parallele Analyse unwahrscheinlich: kein messbar höherer Aufwand während des Lesens ambiger Stellen Aufschub-Theorie: müsste immer zu längerer Zeit am Disambig.-punkt führen, da immer erst da analysiert wird, passiert aber nur, wenn erste Annahme falsch war! Reanalysemodelle entsprechen der Befundlage: manchmal am Disambig.-punkt längere Lesezeiten, wenn die eine erstellte Analyse falsch war interessante EEG-Effekte und ihre Bedeutung: P600 ist ein positiver Ausschlag nach 600ms, der bei Reanalysen am Disambiguierungspunkt auftritt; tritt auch bei syntaktisch inkorrekten Sätzen auf N400 (neg. Ausschlag bei 400ms) tritt bei semantisch inkorrekten Sätzen auf ELAN (early left anterior negativity) tritt ganz schnell (deshalb early) bei syntaktischen Inkorrektheiten auf (spricht für die erste rein syntaktische Analyse Reanalyse-Modelle – was zur Zeit diskutiert wird Late closure/right association: neues Wort wird, wenn’s passt, bevorzugt an die jüngst erstellte Struktur angehängt, also meist unterste Ebene/innerster Nebensatz Modularität des Parsens: besagt, dass wohl tatsächlich erst nur syntakt. Analysiert wird, ABER dass gewisse wortbezogene semantische Informationen auch schon mit der Syntax im mentalen Lexikon vorhanden ist Parsing: zunächst nur lexikalische Information (+mini Semantik-Brocken) Frequenzinformationen: die durchschnittliche Häufigkeit lexik. Einträge spielt eine Rolle bei der Wahl der Analyse Vorsicht: das sind keine Heuristiken! Rein frequenzbasierte Parsing-Theorien: Wörter, aber auch syntakt. Konstruktionen nach Vorkommenshäufigkeit (empirisch: spielt ne Rolle, aber nicht grundlegendes Prinzip) Constraint-satisfaction-Modell: syntaktische, semantische und andere Faktoren wirken gleichzeitig, aber unterschiedlich stark auf ein auf Ausgleich bedachtes konnektionistisches System solche Modelle zwar gut in der Vorhersage, aber so komplex, dass schon wieder nicht falsifizierbar Semantische Interpretation und Textverstehen Zwei Theorien besonders hoch im Kurs: Kintsch (1988,1998) sagt: nach dem Parsing wird eine textnahe Repräsentation erstellt, die propositionale Textbasis, aus dieser wird mit Vorwissen verbunden ein Situationsmodell erstellt, das den Inhalt repräsentiert: Theorie der mentalen Modelle (z.B. Johnson-Laird): nur eine Repräsentation (das mentale Modell), kann auch analog repräsentierte bildhafte Aspekte beinhalten (das hat Kintsch seinem Modell später aber auch hinzugefügt sind sich also alles in allem ziemlich ähnlich) Das Construction-Integration-Modell: Zweistufig: 1) Konstruktion der Textbasis: Text in Propositionen (= elementare Aussagen) zerlegen, diese sind durch inhaltliche Bezüge verknüpft propositionales Netzwerk 2) Integration: Textbasis hat nun gleiche Form wie Wissen im Langzeitgedächtnis, kann also mit Vorwissen integriert werden bei Ambiguitäten: Widersprüche als hemmende Verbindungen in 1), pendelt sich in dem Netz so ein während 2), dass die passendste Lesart übrig bleibt/“gewinnt“ Was für dieses Modell spricht: Versuche haben gezeigt, dass der Inhalt hängen bleibt, nicht aber die Formulierung (ist nach Teilsatz schon vergessen!) Diskursmodell/Partnermodell: beziehen die Gesprächssituation mit ein, da diese ggf. eine sehr große Rolle spielen kann Komponenten des Situationsmodells: Objekte (Referenzobjekte) Eigenschaften /Klassenzugehörigkeit, die Objekten zugeschrieben werden Ereignisse (in Formeln/Schemata = Propositionen) Das Kompositionalitätsprinzip: Die Bedeutung eines komplexen Satzes ergibt sich aus den in ihm enthaltenen einzelnen Aussagen, wobei zu beachten ist, wie diese miteinander verknüpft sind. Anaphorische Referenzen und Textkohäsion Anaphorische Referenzen sind Bezugnahme auf etwas vorher schon Erwähntes (mit Weltwissen ist das einfach zu lösen) Suche nach dem Antezedenten der Anapher (z.B. was ist mit er gemeint?) durch: - Diskurs-Information: „Liste“ von möglichen Referenzobjekten von der aktuellen Situation ausgehend, nach Salienz geordnet, wird durchgearbeitet, bis eins passt - Syntaktische Information: Restriktionen, wie z.B. dass Genus und Numerus passen müssen (gibt Ausnahmen!) Anaphern: - Die Art der Bezugnahme spielt keine Rolle (ob Eigenname, Pronomen oder indirekt) - Werden bevorzugt auf Hauptperson bezogen - Hauptmittel zur Textkohäsion (der innere Zusammenhang eines Textes); je mehr Bezugnahmen eine Proposition im Text enthält, desto zentraler ist ihre Rolle, je zentraler desto länger verweilt sie im KZG, je länger im KZG desto eher geht’s ins LZG Probleme semantischer Interpretation - Personen brauchen nicht länger um Metaphern zu erkennen, es wäre aber anzunehmen, dass man zuerst an der wörtl. Interpretation scheitert - Skopus (Geltungsbereich) von Quantoren und Verneinung – kann sich inhaltlich ziemlich ändern, je nach Anordnung des Satzes, oft auch nicht in Propositionen abbildbar (lest S. 312/13...was auch immer die Kernaussage ist) - Deindexierung deiktischer Ausdrücke: meint, dass alles deiktische (bspw. Zeitl./räuml. Bestimmungen) relativ zur Erzählsituation zu verstehen ist (gestern war heute noch morgen....) und eigentlich in eine explizite Bezugnahme übersetzt werden muss für die Repräsentation und um kompatibel mit anderem Wissen zu sein - Unterbestimmtheit und Standardannahmen: Was nicht klar ausgedrückt ist (Zwei Männer sahen drei Boote) wird entweder auch unbestimmt repräsentiert, oder wir bilden eine Repräsentation einer Situation, die wir unterstellen. Dies ist dann eine Standardannahme, plausibel, aber nicht unbedingt richtig. Zweiteres ist wahrscheinlich der Fall - wir wählen eine unaufwendige Lesart, diese verfestigt sich in den folgenden Sätzen sofern sie nicht korrigiert wird - Analoge Modelle von Raum und Zeit: Der Versuch mit dem Laborgrundriss und der Geschichte dazu, in dem dann nach einem Gegenstand gefragt wurde Antwortzeit in Abhängigkeit der Distanz des Gegenstands zur hauptfigur (mental durch die Räume laufen...) Inferenzen beim Textverstehen: - nur so viel wie nötig (fauler Leser), v.a. Brückeninferenzen und kausal verbinden, was nacheinander steht - je nach Aufgabenorientierung (bspw. Lernen) auch Umkehrung: starke Elaboration und elaborative Inferenzen - Ereignisschemata! Ganz wichtig beim/zum Textverstehen