Gedächtnispsychologie

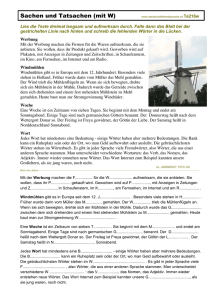

Werbung

1 Gedächtnispsychologie I. Experimentelle Methoden der Gedächtnispsychologie 1. Retrieval (= aufrufen, Info zurückholen usw.) 1. Das Konzept von Retrieval Wie in einer Bücherei muss das Gedächtnis Infos speichern und zwar so, dass sie für viele verschiedene Verwendungen verfügbar sind. z.B.: ich sehe jemanden in der Straßenbahn und weiß, dass ich ihn irgendwoher kenne Frage: wer ist es? Woher kenne ich ihn? usw. um das herauszufinden, sind 2 Prozesse aktiv: 1. aktiver Suchprozess, so ähnlich wie beim Problemlösen 2. automat. Prozess, wobei die Information aus dem nichts aufzutauchen scheint Es konnte durch mehrere Studien festgestellt werden, dass Sensor. Ged. recall recognition 2. free recall Alltagsbeispiel: man steht im Supermarkt und die Einkaufsliste liegt zuhause. Nun möchte man diese erinnern Prinzip im Labor: es gibt eine Lernphase (study phase) und nach einem gewissen Behaltensintervall (retention interval) eine Testphase (test phase). Die Versuchsperson wird instruiert, sich die nachfolgenden Wörter zu merken und zu reproduzieren; Wörter werden präsentiert und Vp soll so viele wie möglich reproduzieren Dabei verschiedene Arten des recall: a) die Testphase erfolgt sofort auf die Lernphase immediate free recall b) zwischen Lern- und Testphase vergeht eine gewisse Zeit delayed free recall Typische Effekte des recall: a) primacy effect: die ersten dargebotenen Items werden gut reproduziert, weil die proaktive Hemmung durch vorangehende Gedächtniselemente wegfällt b) recency effect: die zuletzt dargebotenen Items werden gut reproduziert, weil die retroaktive Hemmung wegfällt, da keine nachfolgenden Ged.elemente vorhanden sind diese beiden Effekte führen zu der typischerweise u-förmigen seriellen Positionskurve 3. recognition (= Wiedererkennen) Alltagsbeispiel: auf einer Party bekannte und unbekannte Personen auseinander halten 1 2 Prinzip im Labor: es gibt eine Lernphase (study phase) und nach einem gewissen Behaltensintervall (retention interval) eine Testphase (test phase) im Labor: Vpn werden instruiert, sich Wörter/Bilder/etc. zu merken; dann Präsentation, dann Test-Phase in Testphase: alte und neue Items präsentiert; bei jedem Item entscheiden, ob „alt“ oder „neu“ korrekte Auswertung: Antwort „alt“ Reiz „neu“ alt hits misses neu false Correct alarms Summe rejections Summe 4. recall vs. Recognition Frage: in welchem Zusammenhang stehen beide? typischerweise ist die Behaltensleistung bei recognition besser als bei recall (jedoch gibt es auch einige Bereiche, in denen man durch recall bessere Ergebnisse erzielt als durch recognition) manchmal gibt es bei recognition auch RT-Messung häufig ist recognition die einzige Möglichkeit z.B. Gedächtnis für Gerüche, wie sollte recall hier aussehen? Jedoch ist wichtig zu sagen, dass es einige Probleme beim Vergleichen von verschiedenen Recognition-Werten gibt: z.B. 1.Vp: erkannte große Anzahl an Items als alt, aber auch große Anzahl an Items als neu 2. Vp: war vorsichtiger und machte weniger hits aber auch weniger false alarms wer war jetzt besser? Methode, um mit false alarms umzugehen: - durch „guessing correction“: Annahme, dass eine Vp bei den Items, die sie nicht kennt, raten wird - in vielen Studien: gleiche Anzahl an alten Items und neuen Distraktoren -> Chance, ein unbekanntes Item zu erraten beträgt also 50% - für jedes neue Item, das als alt bezeichnet wurde, sollte es ein altes Item geben, das die Vp durch eine 50%- Chance richtig errät man kann also den wahren Wert (also „true detection rate“) so berechnen: wahrer Wert = correct rejection – false alarms 5. Vergessen als ein Retrieval-Fehler Die Idee, dass Retrieval eine wichtige Komponente im Erinnern und Lernen von Informationen ist, ist sehr neu. Es wurde erst in den 1960ern eingeführt, als einige Studien auf dessen Wichtigkeit hinwiesen. 2 3 Ein wichtiges Experiment wurde von Mandler, Pearlstone & Koopmans (1969) geliefert. Den Versuchspersonen wurden 100 Wörter in 5 aufeinander folgenden Durchgängen gezeigt. Dabei wurde das Merken der Wörter entweder durch a) recall (= reproduzieren, wiedergeben) oder b) recognition (= wieder erkennen) getestet. Die Wörter wurden gemischt dargeboten, d.h. also alte und neue Wörter in gleicher Anzahl präsentiert. Ergebnisse: Vpn reproduzierten in Durchschnitt 38%, aber erkannten rund 96% im recognition-Modus wieder, mit einer false alarm rate von 7%. Die Tatsache, dass 62 Wörter nicht reproduziert wurden, und nur 4 Items nicht wieder erkannt wurden, ist ein Indiz dafür, dass die Wörter nicht vergessen wurden nach Tulving waren diese Wörter zwar vorhanden, aber nicht verfügbar für die Vpn Tulving (1967): freies Reproduzieren und Lernen einer Wortliste - verschiedene Bedingungen: 1. Bedingung: normale Prozedur, d.h. Liste (P), dann Test (T), also: PT,PT, PT usw. 2. erst PTTT, also 3x hintereinander getestet, dann wieder PTTT usw. - Tulving stellte fest, dass in jedem aufeinander folgenden Durchgang die Vpn ca. dieselbe Anzahl an Wörtern reproduzieren konnten, aber nicht immer dieselben Wörter, also nur etwa 50% der Wörter wurden in allen Durchgängen wieder gegeben, die restlichen Wörter nicht immer die Wörter sind also vorhanden, aber nicht verfügbar, d.h. nicht alle Wörter, die gespeichert werden, sind auch immer reproduzierbar 6. Kontext-abhängiges Gedächtnis (context-dependent-memory) In manchen Situationen ist es schwieriger etwas zu reproduzieren, was man in anderen Situationen gelernt hat Goddon & Baddeley (1980): Taucher an Land und im Wasser, mussten Wörter lernen, dann entweder an Land oder im Wasser reproduzieren - es gab einen deutlichen Kontext-abhängigen Effekt: - wenn Lern- und Recall-Ort verschieden waren, konnten sich die Vpn an etwa 40% weniger Wörter erinnern als wenn Lern- und Recall-Ort derselbe waren auch andere Studien konnten feststellen, dass recall beeinträchtigt wird, falls die Umgebung geändert wird Frage: Ist physische Anwesenheit wichtig, damit kontext-abhängiger Effekt, oder ausreichend, wenn man nur gedanklich an diesen Ort zurückkehrt? Smith (1979) untersucht: - Vpn lernten 80 Wörter in einem Labor (1.Tag) - Reproduzieren am 2. Tag: 3 4 a) entweder im selben Raum oder b) in einem anderen Raum mit ganz anderer Möblierung c) in einem anderen Raum, aber den Lernraum genau vorstellen, bevor Wiedergabe - Ergebnisse: a) 18 Wörter erinnert b) 12 Wörter erinnert c) im Durchschnitt 17 Wörter reproduziert 6. Häufigkeitsparadox bezieht sich auf die Beziehung zwischen der Worthäufigkeit, recall und recognition sehr gebräuchliche Wörter können besser reproduziert werden als weniger gebräuchliche, können aber nur sehr schlecht wieder erkannt werden; Warum?: - kann man durch den 2. Aspekt v. recognition erklären (muss entscheiden, ob Wort alt oder neu); gebräuchliche Wörter tauchen in verschiedenen Kontexten auf, so dass diese einem nicht wirklich auffallen; weniger gebräuchliche hingegen trifft man nur gelegentlich an, weshalb sie einem eher ins Auge stechen, also bessere Diskriminierung Zusammenfassung: Vergessen tritt auf, weil das Material zu dem gewünschten Zeitpunkt nicht aufgerufen werden kann. Retrieval besteht aus 2 Prozessen: Prozess des bewussten Zusammenstellens der Info, welches offen steht für Introspektion Ein relativ automatischer und unfreiwilliger Aufruf/Suchprozess, der von unserem Erinnern abhängig ist Retrieval-Fehler repräsentieren Hauptaspekt für Vergessen konnte durch Vergleiche von recall und recognition festgestellt werden, d.h. also, dass die Fähigkeit des Erinnerns zeitlich schwankt. Weiterhin ist wichtig zu wissen, dass das Aufrufen von Erinnerungen durch retrieval cues angeregt werden kann. 2. Satzverifikation beliebte Methode in der Psychologie, wobei es untersch. Varianten davon gibt Bei diesem Paradigma wird normalerweise das semantische Gedächtnis untersucht, es gibt keine Lernphase. Es werden Sätze präsentiert und Vp muss entscheiden, ob Aussage des Satzes richtig oder falsch. - Ein Spatz ist ein Vogel. richtig - Ein Spatz ist ein Tier richtig - Cola ist blau falsch 4 5 Oder: - A ist über B. - kurze Zeit später Präsentation: A B Entscheidung: richtig; dies geht ganz einfach - B ist nichtunter A - kurze Zeit später Präsentation: B A Entscheidung: richtig; ist zwar auch einfach, aber man muss etwas um die Ecke denken, weshalb einige Fehler auftreten geht insgesamt problemlos, also mit ganz wenigen Fehlern deshalb betrachtet man auch nicht die Fehler, sondern die Zeit zur Verifikation (RT) (- typischerweise geht „ein Spatz ist ein Vogel“ schneller als „ein Spatz ist ein Tier“) 3. Spezielle Form des Priming = Wortstamm-Ergänzung Experimentalgruppe: - Wieder 2 Phasen, aber statt Lernphase eine Inspektionsphase und Testphase - Während Inspektionsphase liest Vp Wörter ohne die Instruktion, diese zu behalten (z.B. Wagen) - In Testphase: Wortanfänge präsentiert z.B. Wa--, und Vp soll mit Wort komplettieren, das ihr zuerst einfällt - Ergebnis: - bei Ergänzungen werden häufiger vorher gelesene Wörter verwendet – obwohl Vp das nicht bewusst ist Kontrollbedingung: - cued recall - Inspektionsphase wie bei EG; in Testphase aber die Instruktion, Wortanfänge mit Wörtern aus der Inspektionsphase ergänzen geht problemlos Aber: Amnesie-Patienten schlecht bei cued recall, besser bei Wortstammergänzung ohne Instruktion zum memorieren II. kurzer historischer Abriss Fragen zum Gedächtnis sind keine Erfindung der Psychologie: - Plato Wachstafel - Aristoteles Assoziationen - Descart, Kant einfache u. komplexe Ideen als Einheiten von Denken und Gedächtnis Aber: vorpsych. Überlegungen zum Gedächtnis nicht empirisch belegt 1. Ebbinghaus Bedeutung: - 1. Forscher, der experimentelle Untersuchungen zum Gedächtnis durchführte („Buch über das Gedächtnis“). 5 6 - es gab noch keine psychologischen Labore, keinen Vp-Pool, keine geeigneten statistischen Methoden und kein standardisiertes Stimulus-Material Methode: - war seine eigene Vp - „erfand“ sein Material, nämlich sog. sinnlose (heute: sinnarme) Silben, CVC (also KonsonantVokal-Konsonant) wie z.B. zeb, baf, lub… - erfand Lernkriterium: Liste von Sieben Items, 2x reproduzieren, dann galt das Material als hinreichend gelernt - für gewöhnlich Liste mit 13 Items - maß die Zeit bis zum Erreichen des Lernkriteriums, ließ dann ein Behaltensintervall verstreichen (19min. bis zu 31 Tagen) - danach lernte er die Liste erneut und maß ebenfalls die dazu notwendige Zeit fand heraus, dass recall in 1. Recall-Durchgang schlecht war, was auf Vergessensprozess hindeutet Ersparnis-Methode: - Liste erstes Mal lernen, notwendige Zeit: OL; Liste nach Behaltensintervall erneut Lernen, notwenige Zeit: NL er konnte die Anzahl der vergessenen Items dadurch abschätzen, indem er die Zeit fürs Neulernen der Items maß, bis er wieder den Level des Originallernens erreicht hatte, also: Ersparnis: (OL – NL) / OL - diese Methode liefert Werte zwischen 0% und 100%; je größer die Ersparnis ist, desto mehr im Gedächtnis enthalten ABBILDUNG 10.1 (skript) - man sieht hier, dass die Vergessensrate nicht linear ist und auch, dass auch nach einem Behaltensintervall von 31 Tagen die Ersparnis nicht 0% beträgt, was darauf hindeutet, dass immer noch etwas im Gedächtnis vorhanden ist. - die Ersparnismethode vermeidet sog. Bodeneffekte selbst dann, wenn 0 Items korrekt reproduziert werden können, kann mit der Ersparnismethode ein Rest von Gedächtnis nachgewiesen werden 6 7 2. Alfred Binet Methode: - interessiert sich für Schüler und deren Schulalltag; - keine sinnlosen Listen, sondern Material aus dem Schulalltag, also Wörter, Sätze, Texte - typ. Vorgehen: Material wurde vorgelesen, dann immediate o. delayed recall, schriftlich typ. Befunde: - Listenlängen-Effekt: wird die Liste länger, so wird zwar absolut mehr behalten, aber nicht relativ - serieller Positions-Effekt (Erinnerung: recall) - Bedeutsamkeits-Effekt: Bedeutende Textpassagen werden besser behalten als unbedeutende bedeutend sind solche Passagen, die man nicht ohne Sinnverfälschung weglassen kann außerdem: - qualitative Fehleranalysen, also nicht wie viele Fehler gemacht wurden, sondern welche - Ergebnisse: akustische Verwechslungen bei immediate recall und semantische Verwechslungen bei delayed recall 3. Richard Semon Entwickelte die Konzepte: - Enkodierung (encoding; seine Begrifflichkeit: Engraphie) - Speicherung (storage; Engram) - Abruf (recall; Ecphorie) Entwickelte Enkodier-Spezifität, die von Tulving (1974) neu entdeckt wurde; dies wurde von ihm nicht empirisch überprüft 4. Frederic Bartlett Ebbinghaus und Assoziationisten waren interessiert an der möglichst exakten Reproduktion individueller Items Bartlett aber hatte anderen Schwerpunkt rekonstruktive Gedächtnisinhalte, denn seiner Meinung nach reproduziert nicht einfach, er rekonstruiert die Ged.inhalte Typ. Material: Geschichten, wie z.B. „The War of the Ghosts“ (siehe Baddeley S.246, 13.3) Zentraler Begriff bei Bartlett: Schema Info wird aufgenommen u. in bereits vorhandene Schemata eingebettet, beim Abruf entsprechend den eigenen Schemata modifiziert Aber: Zweifel an diesem rekonstruktiven Prozess, z.B. von Zangwill (1937): Vp sollten Zeichnungen v. Gesichtern nach 1, 2,…,10 oder 18 Tagen nachzeichnen; später Wiedererkennungstest mit Original und eigenen Zeichnungen; Vp wählten am häufigsten Originalzeichnungen, waren also recht akkurat in ihren Erinnerungen; doch nach Bartlett sollte man wegen rekonstruktivem Ged. Eher eigene Zeichnungen erkennen III. Sensory Memory = ist das kurzlebigste Ged.system, kann Infos nur für wenige ms speichern wird auch: - sensorisches Gedächtnis, 7 8 - sensor. Register - Ultrakurzzeitgedächtnis - iconic/echoic memory genannt es gibt mehrere sensor. Gedächtnisse, die wesentliche Bestandteile des Wahrnehmungsprozesses sind nach dem Enkodierungsprozess gelangen die Infos in dieses Register das sensorische Gedächtnis ist modalitätsspezifisch, weshalb folgende Unterscheidung: Iconic memory = visuelles sensor. Ged. Echoic memory = auditives sensor. Ged. UKG für visuelle u. auditive Infos repräsentieren die früheren Stadien des sog. Sensorischen Gedächtnisses alle Infos gelangen dann später, wenn sie weiterverarbeitet werden, in einen etwas länger anhaltenden Speicher (short-term auditory and visual memory), mit einer Gedächtnisspur von wenigen Sekunden 1. visuelles Gedächtnis/ iconic memory Segner untersuchte 1740 die sog. Visuelle Persistenz, indem er glühende Kohle auf ein Rad montierte und dieses im dunklen Raum drehte; Geschwindigkeit des Rades wurde gesteigert bis durchgehende Spur ohne Lücke schätzte Persistenz-Dauer von 100ms Sperling (1960): war der erste, der sich für die Wahrnehmung komplexer Stimuli wie Buchstabenfolgen interessierte; er führte eine moderne Untersuchung des sensorischen Registers durch - experimentelles Paradigma: - Stimulus ist eine Buchstabenmatrix, die Vp. für kurze Zeit sieht, z.B. 3x4 Matrix whole report Bedingung - Präsentation mittels Tachistoskop; - Darbietungszeit etc.: - Buchstabenmatrix in verschiedenen Experimenten untersch. lange präsentiert, Zeiten lagen zwischen 15 und 500 ms - verschiedene Anordnungen, z.B. 3x4 oder 2x4 - untersch. Material, z.B. Buchstaben oder Ziffern - typische Ergebnisse: - wenn Sperling die Matrix für 50ms präsentierte, anschließend weißes Feld, konnten Vpn sich 4-5 der 12 Items merken Frage: Liegt Ergebnis daran, weil Vpn wirklich nur diese Items sahen oder weil Vpn alle sahen, aber diese ganz schnell wieder verblassen, wie einige Vpn nach dem Experiment behaupteten? wie kann man feststellen, ob mehr Info verfügbar ist als berichtet wird? Sperling: partial report - erneut kurze Darbietung einer Buchstabenmatrix 8 9 - nach Darbietung hoher, mittlerer oder niedriger Ton - Vp sollten nur die entsprechende Zeile wiedergeben, da sie aber nicht wissen, welche Zeile, müssen sie versuchen, sich so viele wie möglich zu merken - Ergebnisse: auch hier werden 3 von 4 Items berichtet - Interpretation: - direkt nach Darbietung ist die vollständige Info vorhanden - diese zerfällt aber sehr schnell, und zwar während die Vpn reproduzieren - Annahme, dass Vpn bei einer 3x4-Matrix mind. 3 Items aus jeder Zeile zur Verfügung hatten, da sie nämlich zuvor nicht wussten, welche Reihe abgefragt wird - wenn in partial report mit 3x4-Matrix 3-4 Items berichtet werden können, müssen 9-12 Items verfügbar gewesen sein Sperling meinte auch, dass eine schnell verfallende visuelle Gedächtnisspur die Buchstaben liest, diese aber nicht alle der Vp verfügbar sind Wie lange hält die Gedächtnisspur an? a) nach dem Sperling-Modell: - kriegt man durch partial report raus, aber Ton wird nicht direkt nach der Item-Matrix präsentiert, sondern mit einer gewissen Verzögerung ABBILDUNG SKRIPT SEITE 12; - auf X-Achse: Verzögerung des Tons in ms; auf Y-Achse: Anzahl der Buchstaben, die verfügbar sein müssen - Ergebnisse: nach ca. 1s ist in der partial report Bedingung die Leistung so gut wie in der whole report Bedingung es ergibt sich eine Persistenzschätzung von ca. 1s 9 10 b) nach Averbach & Coriell (1961): - untersuchten unabhängig von Sperling die Länge der Ged.spur - Methode: - Präsentation einer Matrix mit Reizen - Matrix verschwindet, in der Nähe eines Items erscheint eine Maskierung - Vp soll das Item bei der Maskierung berichten - Resultate: - auch bei ihnen gab es eine SOA-Verzögerung; - Signal erfolgt direkt nach display-offset: fast perfekte Wiedergabe - Signal mit zeitlicher Verzögerung: verschlechterte Wiedergabe - Persistenzschätzung hier bei ca. 300ms nennt man auch „bar-probe-task“ - übereinstimmende Interpretation: - es liegt eine visuelle Information vor, diese zerfällt jedoch sehr schnell c) Sperlings Modell: ABBILDUNG SEITE 12 1. Licht-Muster gelangt ins System, zuerst ins iconic memory (visual information storage, VIS) - im VIS ist die Info prä-kategoriell - innerhalb einer Sekunde zerfällt die Info 2. aber (da Vpn zumindest einige Items berichten können): ein sog. Scanning Prozess liest die Info aus dem VIS aus, und zwar sequentiell (also ein Item nach dem anderen), und platziert sie in einen sog. 3. recognition buffer; hier wird der Info ein Name zugewiesen (also kategoriell) (z.B. aus Lichtmuster wird ein Buchstabe) - die Kodierung im recognition buffer ist auditiv - aufgrund der auditiven Kodierung im recognition buffer entstehen Verwechslungsfehler anhand des Klanges 4. dann erfolgt der sog. rehearsal Prozess, damit die Infos aus recognition buffer nicht verloren gehen - dieser Prozess transportiert die Items in einen 5. auditiven Speicher (AIS): wenn Info berichtet werden muss, dann wird sie aus dem recognition buffer geholt und in motorische Kommandos übersetzt (tranlation, T) Frage: Erklärt das Modell die Befunde? - whole report 10 11 - Vpn bilden icon (also visuelles Abbild) des displays im VIS - dieses wird gescannt - die Items werden erkannt - sie werden „rehearsed“ - sie werden aufgeschrieben aber: - die Leistung ist limitiert und benötigt Zeit - also können nicht alle Items gescannt oder erkannt werden, bevor das icon zerfällt; somit hat der Scanning-Prozess keine Grundlage mehr - deshalb können nur ca. 4 Items berichtet werden und nicht alle - partial report - das Signal erlaubt, den scan-Bereich einzuschränken auf die relevante Lokation - also können in der vorhandenen Zeit (fast) alle relevanten Items gescannt und erkannt werden bessere Behaltensleistung Alternativen zur Untersuchung des iconic memory - bei den Verfahren von Sperling und von Averbach & Coriell handelte es sich um indirekte Methoden - es gibt auch Reihe direkter Methoden, d.h. die Vpn werden direkt befragt (sollen mit den Reizen bestimmte Aufgaben erfüllen) 1. Methode: wiederholte Darbietung - ein Reiz wird wiederholt dargeboten, in immer kürzerem Abstand, bis die Vp sagt, er erscheine kontinuierlich Film, Fernsehen, Computermonitor 2. Methode: Onset-Einstellung - Vpn müssen den Onset eines Reizes zeitlich so einstellen, dass er mit dem Offset eines vorherigen Reizes zusammenfällt, d.h. 2. Reiz fängt an, wenn 1. Reiz aufhört - 1. Reiz in der Regel visueller Reiz - Vpn stellen Onset etwas später ein als Offset des 1. Reizes haben also Eindruck, dass 1. Reiz länger andauert, weil der vis. Reiz zwar auf Bildschirm abgeschaltet wird, aber nicht im Gedächtnis, sondern länger anhält (also Ged.spur) 3. Eriksen & Collins (1967) ABBILDUNG IM SKRIPT SEITE 14 11 12 - 2 zufällig erscheinende Punktmuster werden kurz nacheinander präsentiert - wenn Punktmuster übereinander gelegt: wäre Silbe sichtbar - Erkennungsleistung hängt davon ab, wie weit beide Muster zeitlich entfernt dargeboten werden ABBILDUNG SEITE 14 - wichtig hierbei die durchgezogene Linie mit den großen Kreisen ^= MW - 0ms ISI: 90% korrekt - 50ms: ca. 70% - 100ms: ca. 50% Wo ist das iconic memory? 1. Idee: iconic memory ist Eigenschaft der Retina, beispielsweise der Stäbchen (Sakitt, 1976) - aber: Stäbchen-Fkt = Hell-Dunkel-Sehen; doch Farbe kann als partial-report-cue verwendet werden, also nicht Stäbchen (Banks & Barber, 1977) 2. Frage: Was passiert, wenn kurz nach Reiz ein weiterer Reiz präsentiert wird? - Maskierung = Reiz wird verdeckt, Leistung wird immer schlechter a) Helligkeitsmaskierung - kurz nach Reiz ein Lichtblitz - somit nimmt Reproduktionsleistung ab aber: nur dann, wenn Helligkeitsmaske aufs gleiche Auge wie der Reiz präsentiert wird ( stellt das wichtigste Merkmal der Helligkeitsmaskierung dar) - also: Buchstabenmatrix und Helligkeitsmaske aufs selbe Auge schlechte Reproduktionsleistung - Buchstabenmatrix aufs rechte und Maske aufs linke Auge unbeeinträchtigte Leistung iconic memory vor Sehbahnkreuzung, also peripher, möglicherweise so was wie ein Nachbild (d.h. also auf der Retina, aber nicht auf Zapfen oder Stäbchen, sondern auf anderen Zellen der Retina) b) Mustermaske = Beeinträchtigung der Leistung durch eine kurz nach dem Reiz präsentierte Mustermaske (pattern mask) wie in Abb. 2.2 zu sehen ist - hier ist das wichtigste Merkmal nicht die Intensität (wie bei Helligkeitsmaske) sondern das Intervall zwischen der Reizpräsentation und dem Onset der Maskierung - aber: auch dann, wenn die Helligkeitsmaske auf das andere Auge wie der Reiz dargeboten wird h - Buchstabenmatrix und Mustermaske aufs rechte Auge schlechte Reproduktionsleistung 12 13 - Buchstabenmatrix und Mustermaske auf das jeweils andere Auge auch schlechte Leistung iconic memory liegt hinter der Sehbahnkreuzung, ist also eher zentral vermutlich gibt´s nicht ein einziges iconic memory, sondern es sind verschiedene Systeme, die dazu beitragen; manche sind eher peripher, die anderen eher zentral 2. auditives sensorisches Gedächtnis Ton: beinhaltet eine Fluktuation des Schalldrucks in einer best. Zeitspanne, weshalb die Ged.spur auch länger dauert als im visuellen Ged. Viele Studien konnten bestätigen, dass das auditive sensor. Ged. in 3 Bereiche unterteilt werden kann: - echoic memory: hält einige ms an - auditiver STM: bis zu 5-10s - auditiver LTM Onset-Methode bei Efron (1970 a, b): - Vpn hören kurze Töne u. sollen am Offset des Tons den Onset eines Lichtreizes ansetzen (wie im vis. Ged.) unabhängig von der Länge der Töne schätzten sie die Länge auf durchschnittlich 130ms Goldburt (1961): - konnte nachweisen, dass scheinbare Dauer eines Tons verkürzt wurde, wenn es von einem 2. Ton gefolgt wurde all das deutet daraufhin, dass es einen sensor. auditiven Speicher gibt; auch konnte man nachweisen, dass dieses sensor. Ged. anfällig für Maskierung ist, wobei Reiz u. Maskierung aufs selbe Ohr präsentiert werden müssen in einigen Studien wurde versucht, das Modell des partial report von Sperling so zu modifizieren, dass es auf das auditive sensor. Ged. angewendet werden kann: a) Moray, Bates & Barnett (1965) - Vpn tragen Kopfhörer u. hören 4 verschiedene Mitteilungen, die scheinbar aus 4 versch. Richtungen kommen - direkt danach: visueller Hinweisreiz, der sagt, welche Mitteilungen reproduziert werden sollen - Leistung in dieser partial report Bedingung besser als in whole report, d.h. die geschätzte Anzahl des gespeicherten Materials war bei partial report größer als beim whole report b) Darwin, Turvey & Crowder (1972) - wie bei Moray et al., aber visueller Hinweisreiz wurde zeitlich verzögert - partial report: bei sehr kurzen Verzögerungen gut, nach 4s aber verschwindet es, weshalb es hier ab 5s eine Asymptote gibt, d.h. bei einigen Sekunden Verzögerung partial report nicht besser als whole report - aber: delay muss größer sein als im visuellen, also echoic memory im Taktilen? - Bliss, Crane, Mansfield & Townsend (1966): - die 8 Finger beider Hände (ohne Daumen) wurden in Oben, Mitte und Unten unterteilt, so dass 24 verschiedene Fingerregionen definiert waren 13 14 - Vpn lernten, jeder Fingerregion einen Buchstaben zuzuordnen - im Exp. wurde einer dieser 24 Regionen durch einen Luftstrom gereizt u. Vpn sollten die den gereizten Regionen zugehörigen Buchstaben nennen (whole report) - in partial report wurde nach dem Luftstrom visuell bestimmt, ob nur Oben, Mitte oder Unten zu reproduzieren ist - es gab einen kleinen, aber bedeutsamen Vorteil für partial report auch im Taktilen kurzlebiger Speicher vorhanden, der Infos kurz bereithält Probleme mit Sperlings Modell - methodologisch: a) normalerweise: - wenn wir 2 experimentelle Bedingungen miteinander vergleichen wollen, dann sollten sich diese nur in der Stufe der unabhängigen Variablen unterscheiden, in allem anderen aber identisch sein - das bedeutet auch, dass diese beiden Bedingungen in zufälliger Abfolge erscheinen müssen, wenn immer es experimentell machbar ist (also mal partial report, mal whole report) b) bei Sperling und folgenden Untersuchungen: - whole report u. partial report geblockt dargeboten nicht gut c) was passiert, wenn whole u. partial report gemischt dargeboten? - Befundlage weniger deutlich klar als bei geblockter Darbietung, spricht aber nicht völlig gegen iconic bzw. echoic memory - möglicherweise ist Vorteil von whole vs. Partial report ein Strategieeffekt und keine Eigenschaft des iconic memory - prä-kategoriell: - nach Sperling ist Info im VIS prä-kategoriell kann aufgrund physikalischer Dimensionen (z.B. Lokation) selegiert werden, aber nicht aufgrund von kategoriellen Dimensionen - aber schon Sperling testet Buchstaben vs. Ziffern (partial cue: Buchstaben o Ziffern reproduzieren) und fand kleinen, aber unbedeutenden Vorteil für partial report - Merikle (1980): - whole und partial report gemischt, nicht geblockt - ebenfalls Buchstaben vs. Ziffern bei partial report - statistisch bedeutsamer Vorteil für partial report (d.h. doch kategoriell, denn die Vpn nehmen eine Unterscheidung zwischen Buchstaben und Ziffern vor) - gleicher Zeitverlauf wie bei Sperling Info ist nicht prä-kategoriell Frage: Weshalb sinkt eigentlich die Leistung bei partial report mit steigendem cue delay? - modellkonforme Antwort: das icon zerfällt im Laufe der Zeit und kann nicht mehr vollständig ausgelesen werden - was macht Vp, wenn sie dennoch etwas berichten will? sie rät Fehleranalysen: - Annahme: icon zerfällt u. Vpn rät 14 15 - z.B.: die Averbach & Coriell bar probe task, 9 von 26 verschiedenen Buchstaben wurden gezeigt - wenn Vp rät, kann sie mit: - p = 1/26 richtig raten, wir entdecken gar keinen Fehler - p = 8/26 begeht sie einen location error, nennt also einen Buchstaben aus dem display, aber nicht den gewünschten - p = 17/26 begeht sie einen intrusion error, nennt also einen Buchstaben, der gar nicht auf dem display war - tatsächlicher Befund: - mit dem cue-delay nehmen die location errors zu, nicht aber die intrusion errors - das bedeutet: - nicht das iconic memory zerfällt, sondern die Lokationsinformation geht verloren Alternative Modelle: z.B. dual-buffer model von Mewhort, Marchetti, Gurnsey und Campbell (1984) - grundsätzliche Idee: - visuelle Info wird verarbeitet, features (gerade Linien, Kurven, Kreise, etc.) werden extrahiert und in einem prä-kategoriellen feature buffer gespeichert - ein recognition Mechanismus erzeugt aus dem feature-buffer abstrakte Repräsentationen und speichert diese in einem kategoriellen Speicher: character buffer - character buffer beinhaltet abstrakte Repräsentationen der Reize und Lokationsinfo - nicht die abstrakten Repräsentationen, sondern die Lokationsinfos zerfallen dann erzielen wir bessere Ergebnisse im whole report Fazit: doch prä-kategoriell IV. Wie viele Gedächtnisarten gibt es? 1. Die Kapazität des STM auditive Präsentation kann besser reproduziert werden als visuelle (z.B. Telefonnummer) wie lässt sich die Gedächtnisspanne verbessern, so dass man sich solche Infos besser merken kann? (I) - man kann die Zahlenkombination in Buchstaben umwandeln; (muss aber vorher natürlich eine Kodierung finden und diese dann auswendig lernen) - z.B.: 265070193 BAFDILTUN wieso aber lässt sich eine Buchstabenkombination einfacher merken als eine Zahlenkombination? - weil diese 9 Zahlen z.B. zu drei sinnvollen Einheiten (hier: CVCs) reduzieren lassen können: BAF DIL TUN George Miller (1956) führte Untersuchungen zur Gedächtnisspanne durch und stellte fest, dass die sofortige Gedächtnisspanne durch die Anzahl der chunks bestimmt wird statt durch die Anzahl der Items chunks: sinnvolle Einheiten, z.B. einzelne Buchstaben, CVCs oder Wörter (aber keine Sätze); erinnert man sich an einen Teil des chunks, so fällt es einem leichter auch den Rest zu reproduzieren wie wird die Gedächtnisspanne gemessen? 15 16 - typisches Vorgehen: - immediate serial recall - Vpn müssen best. Infos in richtiger Reihenfolge korrekt wiedergeben z.B. 1 Zahl – Wiedergabe 2 Zahlen – Wiedergabe 3 Zahlen – Wiedergabe usw. - es wird also immer eine Zahl mehr gezeigt; wenn die Vp nach mehreren Durchgängen schließlich immer 50% korrekt reproduzieren kann, dann entspricht dies der Gedächtnisspanne - nach Miller beträgt die Gedächtnisspanne 7 ± 2 chunks (eher 7 – 2 chunks) wie kann ich meine Gedächtnisspanne erhöhen? (II) - indem ich die Anzahl der Items in den chunks erhöhe: - Gedächtnisspanne für einzelne Buchstaben beträgt: ≤6 Items - Gedächtnisspanne für CVCs: ≤9 Items - Gedächtnisspanne für Wörter, die in ein sinnvolles Satzgefüge gebracht werden: ≥50 ABER: Anzahl der chunks bleibt dennoch 7 ± 2 2. Vergessen im STM John Brown in England und die Petersons in den USA (1950er) entwickelten experimentelle Prozeduren, die das schnelle Vergessen von kleinen Infos untersuchen Brown-Peterson-Paradigma Das Prinzip: - Konsonanten-Trigramm wird dargeboten (z.B. HLM) gefolgt von einer Zahl (z.B. 492) - Vp soll von dieser Zahl in 3er Schritten zurückzählen bis ein Signal ertönt - dann soll Vp das Trigramm erinnern - die Zeit zum Rückwärtszählen wird variiert; je länger diese Zeit, desto schlechter die Leistung ABBILDUNG 3.1 16 17 - hier sind auch die Ergebnisse von Murdock (1961) dargestellt: - entweder Wort mit 3 Buchstaben (HAT), oder 3 unabhängige Wörter (HAT;DOG;PEN) oder CVCs - bei den Petersons: - 3s Behaltensintervall 80% korrekt - 15s Behaltensintervall ca. 10% korrekt - Ergebnisse: 1. schnelles Vergessen im STM 2. relevante Einheit ist nicht Anzahl der Buchstaben, sondern der chunks; 3 Wörter ähnlich gut behaltbar wie 3 Konsonanten (die aber keine Bedeutung haben dürfen) Wieso überhaupt Vergessen? - 2 gegensätzliche Theorien: a) Spurenzerfall: wenn wir uns etwas merken, dann haben wir für diese Info eine Gedächtnisspur (d.h. Info ist irgendwie im Gedächtnis repräsentiert); doch im Laufe der Zeit zerfällt diese einfach; b) Interferenz: neue Info oder bereits vorhandene Info beeinträchtigt das, was ich gerade abrufen wollte; sie ist zwar faktisch noch vorhanden, wird aber von anderen Spuren überlagert; aber nur bei ähnlichem Material - Brown-Peterson favorisierten Spurenzerfall; denn wenn Interferenz die Erklärung wäre, müssten die Infos, die miteinander interferieren, irgendwie ähnlich sein; Zahlen aber sind von Buchstaben so verschieden, dass man Interferenz ausschließen kann b) Interferenz: - proaktive Interferenz (PI): alte Lerninhalte stören das Behalten neuer Inhalte - retroaktive Interferenz (RI): neue Lerninhalte stören das Behalten alter Inhalte - wenn ich ständig etwas Neues lerne, sind beide Mechanismen aktiv - Keppel & Underwood (1962) präferierten Interferenz - Beleg: release from PI: das erste Trigramm zeigt quasi kein Vergessen, die weiteren Trigramme schon; das erste Trigramm bleibt also verschont, weil es keine PI erfährt dies kann man mit Spurenzerfall nicht erklären - Wickens, Born & Allen (1963): - Idee: Interferenz gilt nur bei ähnlichem Material; deshalb sollte es kein PI geben, wenn nach den ersten paar Trials die Items verändert werden - wurde von ihnen untersucht mit folgendem Ergebnis: - für ein paar Trials gibt es Konsonanten, danach Zahlen; direkt nach dem Wechsel gibt es fast kein Vergessen, denn die Konsonanten interferieren nicht mit den Zahlen (Interferenz nur bei ähnlichem Material) dieses Phänomen nennt man „release from PI“, welches sehr robust ist, was die Studie von - Loess (1968) zeigt: - Wort-Triplets aus gemeinsamer Kategorie, z.B. Tiere, dann rückwärts zählen, dann erinnern - nach 6 Triplets wird die Kategorie gewechselt, z.B. auf Pflanzen; - das Ergebnis: das erste Triplet nach dem Wechsel zeigt fast kein Vergessen Interferenz 17 18 - Gunter, Berry & Clifford (1981): - nahmen an, dass Behalten von Infos am besten ist, wenn ähnliche Items getrennt statt geblockt dargeboten werden - Vpn schauten sich eine Reihe von 4 TV-Nachrichten an - sollten diese dann recallen: sofort oder mit Verzögerung - Kontrollbedingung: immer die gleiche Kategorie, also entweder nur Inlands- oder Auslandsnachrichten - Experimentalgruppe: nach 3 Spots einer Kategorie Wechsel zur nächsten Kategorie ABBILDUNG 3.2 - wenn nach 3. Spot ein Wechsel erfolgt, dann sind die Vpn wieder besser sowohl bei immediate als auch delayed recall auf Interferenz zurückzuführen - Also: viele Befunde sprechen für, dass das Vergessen im STM auf proaktive Interferenz zurückzuführen ist - aber: Loess & Waugh (1967): macht man zwischen den Durchgängen eine Pause von 2min, dann ist jeder Durchgang quasi der erste und es gibt fast kein Vergessen; das widerspricht aber der Interferenzerklärung, denn Interferenz sollte im Laufe der Zeit größer werden Was denn nun? - Turvey, Brick & Osborn (1970): - Brown-Peterson-Paradigma, aber Behaltensintervalle geblockt, nicht gemischt (normalerweise im Paradigma: Mix zwischen langen und kurzen Intervallen; hier: Vp weiß nicht, wie lange Intervall dauern wird) - 1. Gruppe: 5s Behaltensintervall - 2. Gruppe: 10s - 3. Gruppe: 20s Behaltensleistung in allen Gruppen gleich groß - im letzten Durchgang: für alle Gruppen 15s Behaltensintervall - nun: Vergessen bei kurzen vorherigen Intervallen viel größer als bei langen vorherigenIntervallen - WIESO?: - liefert die Spuren-Diskriminations-Hypothese 18 19 - das Problem bei dem Brown-Peterson-Paradigma liegt darin, dass das letzte Item von dem vorletzten und vorvorletzten etc. unterschieden werden muss - diese Schwierigkeit der Diskrimination hängt von dem Verhältnis der Verzögerungen untereinander ab: - z.B.: geblockt 5s: 5s vs. 10s (1:2), also das letzte Item liegt 5s und das vorvorletzte 10s zurück unter geblockten Bedingungen ist das Verhältnis immer 1:2, dadurch ist recall in allen Bedingungen gleich schwierig - bei 15s Behaltensintervall: - 15s vs. 20s (1:1.33) - 15s vs. 25s (1:1.66) - 15s vs. 35s (1:2.33) Verhältnis in allen Gruppen verschieden; Idee: je näher es zu 1:1 kommt, desto schlechter ist die Diskrimination zwischen dem letzten und vorletzten Item deshalb war 5s-Gruppe so schlecht, denn je schlechter die Diskrimination zu zurückliegenden Items, desto schlechter die Behaltensleistung - Diskriminationshypothese macht 2 Annahmen: - 1. Es gibt einen spontanen Spurenzerfall - 2. Abruf (retrieval) erfordert eine gewisse Form der Diskrimination - zur genaueren Untersuchung: a) Spurenzerfall: - Baddeley & Scott (1971) - Brown-Peterson-Task mit nur einem Item es gibt vergessen (also Spurenzerfall), doch dieser Effekt hat eine Asymptote bei ca. 5s Behaltensintervall - Gardiner, Craik & Birtwisle (1972) - Brown-Peterson-Task, Items waren diesmal Blumennamen; dabei 2 verschiedene Kategorien: Kategorienwechsel zwischen Wildpflanzen und kultivierten Pflanzen - 3 Vpn-Gruppen: a) uninformiert b) informiert c) nachträglich informiert, d.h. nach dem Wechsel, aber vor der Wiedergabe - Frage: Können Vpn diese Information über den Kategorienwechsel benutzen, um zwischen target und den zuvor interferierenden Items zu diskriminieren? - Ergebnisse: a) kein release from PI b) Release from PI c) Release from PI diese Ergebnisse unterstützen die Annahme der Diskriminations-Hypothese bzgl. der PI-Rolle im STMVergessen: die Vpn können die release cues (hier die Info über den Kategoriewechsel) nutzen Siehe auch Kapitel XII Vergessenstheorien 19 20 3. Evidenz gegen einheitliches Gedächtnis 1. Zwei-Komponenten-Aufgabe (Standardevidenz) - Postman & Phillips (1965): - untersuchten primacy und recency Effekt anhand von immediate und delayed free recall ABBILDUNG 3.4 - wenn immediate recall, werden die letzten Items am besten reproduziert recency Effekt - wenn die Vpn aber in der delay-Phase noch eine andere Aufgabe erfüllen sollten, verschwindet der recency Effekt, d.h. alles im STM geht verloren, wobei die Items, die am Anfang der Liste standen, davon nicht beeinflusst werden - Interpretation: die recency Items werden in einem vorübergehenden und sehr zerbrechlichen STM gehalten, wobei die Items am Anfang der Liste jedoch aus dem LTM recalled werden 2. Speicher-Kapazität - Miller (1956) hatte ja festgestellt, dass die Gedächtnisspanne 7 ± 2 chunks beträgt - dies deutet daraufhin, dass: - das STM eine geringe Speicherkapazität, aber dafür einen schnellen input/output besitzt - das LTM hingegen eine vermutlich unbegrenzte Speicherkapazität hat, dafür aber einen langsamen input und output 20 21 - Waugh (1970): - recency Items sind konsistent schneller abzurufen als die anderen Items - deshalb die Annahme, dass retrieval aus STM einfacher sei als aus LTM 3. Art der Kodierung - Annahme: Info im STM ist phonologisch kodiert, im LTM jedoch semantisch - bei Sperling (1960) fanden sich Verwechslungen hinsichtlich ähnlich klingender Buchstaben - Conrad & Hull (1964): - P,D,V,C,T vs. K,Y,Z,W,R - wenn man diese in korrekter Reihenfolge wiedergeben soll, mehr Fehler bei gleich klingenden Buchstaben als bei den anderen, denn man kann diese nur schwer auseinander halten kann ableiten, dass phonologischer Code wichtig ist, aber ist er auch alleine entscheidend? - Baddeley (1966a, 1966b): untersuchte Klangähnlichkeit vs. Semantische Ähnlichkeit - Baddeley (1966a): - Sequenz von 5 Wörtern, immediate serial recall - man, mad, etc (klangähnlich) - pen, rig, etc. (klangunähnlich) - big, huge, etc. (sem. ähnlich) - old, late, etc. (sem. unähnlich) ABBILDUNG 3.5 - zeigt, dass phonolog. ähnliches Material schwieriger ist als die unähnlichen Listen, wobei die semantische Ähnlichkeit nur geringen Effekt zeigt Vpn versuchen sich an den Klang der Items zu erinnern, nicht an Bedeutung - Baddeley (1966b): - untersuchte in diesem Experiment das Langzeitlernen - Sequenz von 10 Wörtern, 4x präsentieren und jeweils wiedergeben 21 22 - Behaltenstest erfolgt nach 20min, also weit weg von der Gedächtnisspanne; in diesen 20 Minuten müssen sie eine andere Aufgabe erfüllen, damit man ST-Lernen ausschließen kan ABBILDUNG 3.6 - phonolog. Ähnlichkeit ist nicht mehr so wichtig, sondern die semant. Ähnlichkeit wird zum entscheidenden Lernmerkmal 4. Neuropsychologische Evidenz - Patient H.M.: - wurde im Alter von 9 Jahren von einem Fahrrad umgehauen, erlitt eine Kopfverletzung und litt von da an unter Epilepsie - dies wurde immer schlimmer, bis zu 10 Anfälle pro Woche mit Blackout, pro Woche ein großer Krampfanfall - im Alter von 27 Jahren schwer behindert - Therapie: neurochirurgische Entfernung der Innenseite des Temporallappens incl. des Hippocampus - dies führte zu gewünschten Linderung der Epilepsie, aber dramatischer Gedächtnisverlust - aber normales STM und normale Erinnerung an alte Gedächtnisinhalte - Milner (1966): - untersuchte H.M. - ihre Folgerungen: - Übertrag ins LTM ist Funktion, die im Schläfenlappen angesiedelt ist (denn diese Region wurde entfernt und bei H.M. funktionierte dies nicht mehr) - mediale Temporallappen nicht für STM zuständig (denn STM funktioniert weiterhin) - Temporallappen nicht der Ort des LTM (denn obwohl Temp. entfernt, kann er sich noch an alte Gedächtnisinhalte erinnern) - es gibt noch eine andere Form des LTM, die nicht von der Funktion der Temporallappen abhängt 22 23 dazu: ABBILDUNG IM SKRIPT SEITE 23 - Aufgabe: Nachzeichnen der Linie zwischen den beiden Linien (aber: die Vpn sieht ihre eigene Hand nicht und den Stern nur im Spiegel) - H.M. unbeeinträchtigt bei dieser Lernaufgabe, er ist so gut/schlecht wie normale Vpn, obwohl er sich jeden Tag aufs Neue nicht erinnern kann, diese Aufgabe schon einmal bearbeitet zu haben - das besondere ist, dass H.M. im Laufe der Zeit besser wurde, obwohl er neue Dinge nicht mehr im LTM speichern kann da er aber besser wurde, muss es ein weiteres Gedächtnis geben, das so genannte prozedurale Gedächtnis (zuständig für motor. Handlungen und Fertigkeiten; bleibt ein Leben lang bestehen) - Baddeley & Warrington (1970): - untersuchten Amnesiepatienten mit intaktem STM und beeinträchtigtem LTM durch immediate und delayed free recall ABBILDUNG 3.7 - Ergebnis: exzellenter recency Effekt, aber Beeinträchtigung der Leistung bei den vorherigen - Items 23 24 - einfache Dissoziation: - die Dissoziation von H.M. ist ein Hinweis auf eine Trennung zwischen STM und LTM, aber noch nicht überzeugend - denn es könnte ja sein, dass STM-Aufgaben einfacher sind als LTM-Aufgaben; dann können die Patienten noch die einfachere Aufgabe, die schwierigere aber nicht mehr - braucht also einen Patienten, der ein umgekehrtes Störungsmuster aufweist - Shallice & Warrington (1970): -Patient K.F.: Läsion in linker Hemisphäre in der Nähe der sylvischen Furche, wo das Zentrum für die Sprachkontrolle liegt - Gedächtnisspanne bei K.F. 2-3 Items, also beeinträchtigtes STM - LTM aber unbeeinträchtigt - Brown-Peterson-Task sehr schlecht - serielle Positionskurve umgekehrt zu H.M.: - normaler primacy Effekt - kein recency Effekt Doppelte Dissoziation: - bei H.M. ist STM unbeeinträchtigt, es kann aber keine neue Info ins LTM übertragen werden - bei K.F. ist das LTM unbeeinträchtigt, das STM jedoch stark beeinträchtigt - also: Trennung von STM und LTM 24