Instrumentelles Lernen – Operantes Konditionieren

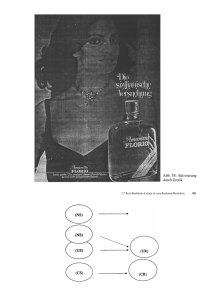

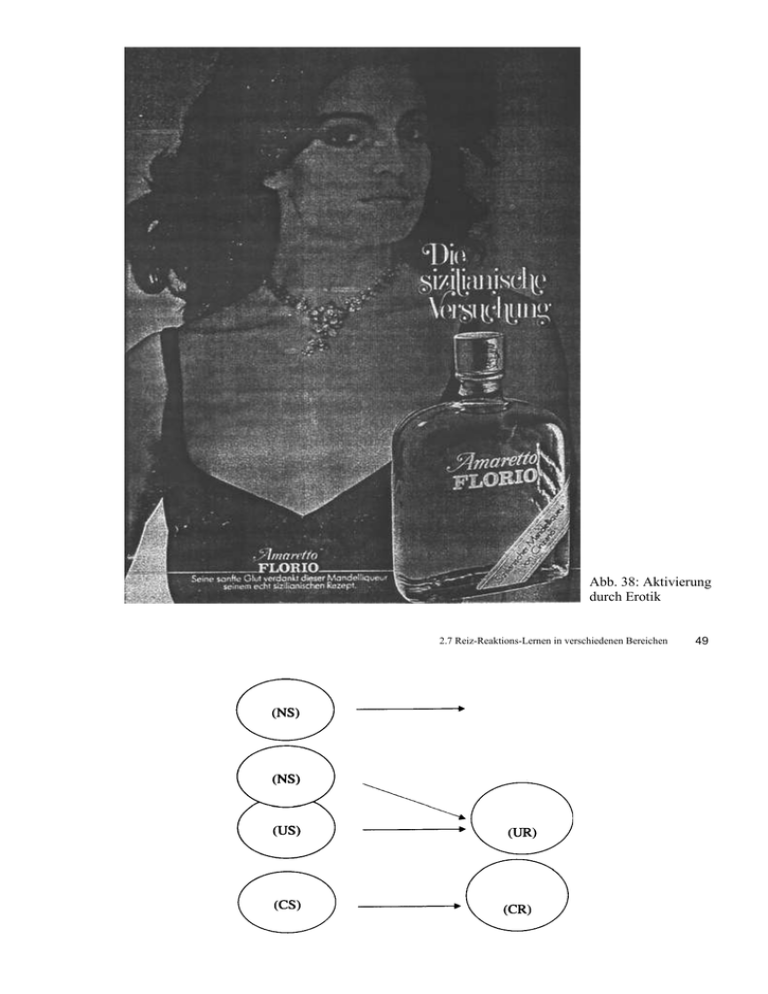

Werbung

Abb. 38: Aktivierung durch Erotik 2.7 Reiz-Reaktions-Lernen in verschiedenen Bereichen 49 ad 3. NS: neutraler Reiz US: unkonditionierter Reiz CS: konditionierter Reiz UR: unkonditionierte Reaktion CR: konditionierte Reaktion Instrumentelles Lernen – Operantes Konditionieren Übersicht Einführung: Die „Skinner-Box“ Unterschied zwischen klassischem und operantem K. Arten von Verhaltenskonsequenzen („Verstärkung“) Verstärkung und Verstärkerpläne Zeitpunkt der Verstärkung Diskriminative Reize und Generalisation von Verhalten Shaping Negative Verstärkung vs. Bestrafung Fremd- vs. Selbstverstärkung Techniken der Verhaltensmodifikation Operantes Konditionieren (aus LeFrancois, 1986) Burrhus F. Skinnner (1904-1990) Skinner-Box: erlaubt, Erwerb und Löschung von Verhalten systematisch als Funktion von Verstärkungsart und Verstärkungsplan zu studieren. Unterschied zwischen klassischer und operanter Konditionierung Mit dem Begriff instrumentelles Lernen bezeichnet man solche Lernsituationen, in denen Ereignisse von der Ausführung einer Reaktion abhängen. Klassisches Konditionieren: Der US tritt als bedeutsames Ereignis unabhängig von der Reaktion (CR) auf ( respondentes oder Antwortverhalten) Instrumentellen Lernen: Kontingenz zwischen Reaktion und ihrer Konsequenz ( operantes oder Wirkverhalten) Verhalten = Instrument / Mittel, das die Konsequenz hervorruft Edward L. Thorndike (1911): Trial and error learning Gesetzes der Wirkung („law of effect“): erfolgreiches Verhalten tendiert dazu, häufiger aufzutreten. Was ist „Verstärkung“? Da es schwer ist, einen Verstärker inhaltlich zu definieren, hat Skinner (1938) eine rein operationale Definition gegeben. Definition Verstärker: Ein Verstärker ist ein Reiz, der die Auftretenswahrscheinlichkeit einer Reaktion erhöht. Für Lernen muss eine Kontingenz zwischen Verhalten und Konsequenz (d.h. dem Verhaltenseffekt) bestehen Kontingenz = Zusammenhang, Regelmäßigkeit, hoher Grad an Wahrscheinlichkeit. Arten von Verstärkung Tabelle. Verstärkung und Bestrafung beim operantem Konditionieren Reiz (Verhaltenskonsequenz) _____________________________________ angenehm Einer Situation nach einer Reaktion hinzugefügt Positive Verstärkung (Aufbau) Aus einer Situation nach Bestrafung einer Reaktion (Abbau) entfernt (Entzug) Keine Konsequenz Löschung unangenehm Bestrafung (Abbau) Negative Verstärkung (Aufbau) Motivation des Lerners bestimmt den Aufforderungscharakter (= emotionaler Wert) des Verstärkers - Verhaltensaufbau / -abbau findet nur statt, wenn der Lerner über ein Bedürfnis verfügt, die Konsequenz herbeizuführen / zu meiden - z.B. wirkt eine Futterpille nur bei hungrigen, nicht bei satten Ratten - z.B. kann ein Verweis aus dem Klassenzimmer durchaus belohnende Komponenten haben Positive Verstärkung IV Tisch decken K V+ Lob der Eltern Negative Verstärkung IV Hausaufgaben Erledigen K -av Drohung wird nicht wahrgemacht Drohung: auch vorgestellte oder erwartete Konsequenzen sind unangenehme Reize Bestrafung - entweder Darbietung negativer Reize oder Entzug positiver Reize IV Schlagen K av Schimpfen Kein Fernsehen Löschung 7 IV Fluch K0 Nichtbeachtung Primäre vs. sekundäre Verstärker Primäre Verstärker Nahrung oder Schmerzreize sind Beispiele für primäre Verstärker, die ohne vorherige Lernvorgänge verstärkend wirken. Sekundäre (generalisierte) Verstärker Werden ursprünglich neutrale Reize (z.B. bunte Papierscheine) mit primären Verstärkern gepaart, können auch solche neutralen Reize zu Verstärkern werden (z.B. wird aus bunten Papierscheinen Geld), die man dann sekundäre oder generalisierte Verstärker nennt. Sekundäre Verstärker vs. konditionierte Reize höherer Ordnung Die Unterscheidung zwischen unbedingten Verstärkern und gelernten (bedingten) sekundären Verstärkern lässt sich auf das klassische Konditionieren höherer Ordnung übertragen, wo ursprünglich neutrale Reize (CS) durch Lernprozesse Qualitäten von unbedingten Reizen annehmen können. Verstärkerpläne Verstärkerpläne unterscheiden sich vor allem darin, ob jede gewünschte Reaktion verstärkt wird (kontinuierliche Verstärkung) oder nicht (intermittierende Verstärkung). Intermittierende Verstärkung: Quotenverstärkung: basiert auf der Reaktionshäufigkeit, Intervallverstärkung: basiert auf Zeitintervallen Beide können entweder fest oder variabel sein. z.B. fester Quotenplan: genau jede fünfte Reaktion wird verstärkt z.B. variabler Intervallplan: im Durchschnitt wird alle fünf Minuten ein Verstärker gegeben Kontinuierlich (jede Reaktion wird verstärkt) Quote (Verstärkung basiert auf Reaktionshäufigkeit) Fest (V nach jeder 5. korrekten R) Variabel (durchschnittlich V bei 1 von 5 korrekten R) Intermittierend (nicht alle Reaktionen werden verstärkt) Intervall (Verstärkung basiert auf Zeitintervallen) Fest (V nach der 1. korrekten R nach einem 5Min-Intervall) Variabel (durchschnittlich 1 V pro 5Min-Intervall) Auswirkung auf Erwerb und Löschung Neue Verhaltensweisen werden am schnellsten erworben, wenn zunächst jede Reaktion verstärkt wird. Unter diesen Bedingungen wird das gelernte Verhalten allerdings auch sehr schnell wieder eingestellt, wenn keine Verstärkung mehr gegeben wird, d.h. das gelernte Verhalten ist nicht sehr löschungsresistent. Die Löschung von Verhalten vollzieht sich langsamer, wenn die gewünschten Reaktionen vorher nur intermittierend verstärkt wurde. Zeitpunkt der Verstärkung Eine wichtige Variable für das operante Konditionieren ist das zeitliche Intervall, das zwischen Reaktion und Verstärkung liegt. Ähnlich wie beim klassischen Konditionieren hat sich hier gezeigt, dass am besten gelernt wird, wenn dieses Intervall kurz ist. Intervalle in der Größenordnung von 500 ms haben sich als optimal herausgestellt, während deutlich längere Intervalle das Lernen beeinträchtigen. Dieser Zusammenhang zwischen Kontiguität und Lernerfolg wurde auch von Shanks und Dickinson (1991) gefunden, die menschliche Kausalurteile in operanten Lernsituation untersuchten. Diskriminative (situative) Reize D S IV K Keine Beleuchtung Einbruch Erfolg Beleuchtung Einbruch Kein Erfolg SD = Hinweisreiz, - signalisiert, welcher Art die nachfolgenden Konsequenzen sein werden Führt zu Situationsabhängigkeit des Verhaltens (Diskriminationslernen) - Verhalten wird unter bestimmten situativen Bedingungen gelernt und wird später nur in ähnlichen Situationen gezeigt. Transfer ist beim instrumentellen Lernen nur begrenzt möglich - Gelerntes wird nur schwer auf neue Situationen übertragen - Instrumentelles Verhalten ist meist relativ starr und gewohnheitsmäßig. Generalisation von Verhalten und situative Diskrimination Stufenweise Annäherung („Shaping“) Dies ist eine von Skinner entwickelte Methode, um Versuchstieren neue Verhaltensweisen beizubringen, die die Tiere normalerweise nicht (oder nur ganz selten) ausführen würden (z.B. sich im Kreis zu drehen). 1. Dazu wartet man, bis das Tier eine leichte Bewegung in die vom Experimentator gewünschte Richtung, z.B. nach links, ausführt und verstärkt dies durch die Gabe von etwas Futter. 2. Dies sollte nach dem Gesetz der Wirkung dazu führen, dass diese Bewegung häufiger auftritt. 3. Als nächstes wird allerdings nur eine Bewegung verstärkt, die noch etwas weiter nach links geht, und schließlich wird nur noch eine volle Drehung verstärkt. Auf diese Art kann man Tieren relative komplexe Verhaltensfolgen beibringen. Tiertrainer benutzen für die Dressur ähnliche Methoden. Negative Verstärkung Entzug einer aversiven Konsequenz führt zu Intensivierung eines Verhaltens Fluchtlernen: Person wird direkt mit dem aversiven Ereignis konfrontiert und ergreift Maßnahmen, diesem zu entkommen Vermeidungslernen: Person wird durch Signalreiz gewarnt und ergreift Maßnahmen, das aversive Ereignis vorbeugend zu vermeiden (wichtig: aktives Vermeiden: Person tut etwas! Alternative: passives Vermeiden = Unterlassen einer Verhaltensweise, tritt nach Bestrafung auf) Bestrafung Darbietung einer aversiven Konsequenz oder Entzug einer angenehmen Konsequenz führt zu Abbau/ Unterdrückung eines Verhaltens Strafe oder Strafandrohung kann Verhalten nur unterdrücken, nicht aufbauen Abb. 55: Permissives Verhalten führt zu wechselseitigen Lernprozessen (aus: Bretecher, 1978) 3.5 Bestrafung Abbildung 2.4 Eine weiße Ratte und ein Hund lösen keine Furchtreaktion aus `(aus Watson, 1928, S. 24, 25) Abbildung 2.6 Eine Nikolausmaske löst eine Furchtreaktion aus (aus Watson, 1928, S. 28) Zweifaktoren Theorie der Angstvermeidung (Mowrer, 1947) 1. Klassisches Konditionieren Schule (NS) Hänseln (US) Angst (UR) Angst (CR) Schule (CS) 2. Instrumentelles Lernen (Vermeidungslernen) Angstmotivation IV Schwänzen K-av Angstminderung Vermeidungsverhalten ist sehr löschungsresistent, weil es verhindert, dass der Lerner erfährt, dass CS und US nicht mehr gekoppelt sind. Therapie: Konfrontation: Person muss sich dem CS stellen, um erfahren zu können, dass der US nicht mehr auftritt. Wirksamkeit von Bestrafung Bestrafung ist wenig wirksam bei stabilem Verhalten. hoher Motivation für Verhalten. Wirksame Bestrafung ist unmittelbar. intensiv. zunächst kontinuierlich. Ergänzend sollte ein alternatives, inkompatibles Verhalten aufgebaut werden. Nebenwirkungen von Bestrafung Generalisierung des aversiven Reizes (auf Bestrafenden) Angstvermeidung Lernen von aggressiven Verhaltensweisen (Modelllernen) Ambiguität von Strafreizen (Zuwendung von Aufmerksamkeit kann als belohnend erlebt werden) Löschung als Ausweg? IV Fluch K0 Nichtbeachtung Löschung vs. Bestrafung: Bestrafung: dem Entzug positiver Konsequenzen gehen Hinweisreize (Verbot, Strafandrohung) voraus Löschung: Ausbleiben positiver Verstärkung ohne Hinweisreiz Probleme bei der Löschung: konsequente Nicht-Verstärkung ist schwierig gelegentliche / intermittierende Verstärkung führt zu löschungsresistentem Verhalten Selbstverstärkung Verhalten wird häufig zunächst intensiviert, um die erwarteten positiven Konsequenzen doch noch herbeizuführen Wirksamkeit der Löschung wird erhöht, wenn gleichzeitig ein mit dem unerwünschten Verhalten unvereinbares (inkompatibles) Verhalten aufgebaut wird. Fremd- vs. Selbstverstärkung (bzw. Kontrolle des Verhaltens) Selbstverstärkung als Komponente von Selbstregulation (F. Kanfer) Selbstbeobachtung Selbstbewertung Selbstverstärkung Bei Vorhandensein eines Konflikts: Selbstkontrolle Techniken der Verhaltensmodifikation Verhaltenstherapie: Grundannahme: „pathologisches“ und „normales“ Verhalten werden auf die gleiche Art gelernt Therapie = „therapeutisches Lernen“, Verlernen oder Umlernen des „pathologischen“ Verhaltens Aufbauend auf Konzepten der klassischen Konditionierung - vor allem bei emotionellen Problemen (z.B. Angst) Gegenkonditionierung: (1) Eine als angenehm erlebte Reiz-Reaktions-Verbindung wird durch die Darbietung eines aversiven Reizes abgebaut (z.B. Medikamente, die bei Alkohol Übelkeit hervorrufen) (2) Eine als aversiv erlebte Reiz-Reaktions-Verbindung wird durch die Verwendung eines Sicherheitsreizes unterbrochen (z.B. Vorstellen einer angstauslösenden Situation plus Entspannung) Systematische Desensibilisierung: - Patient soll schrittweise an immer angstauslösendere Situationen denken, aber sich dabei vollständig entspannen - Voraussetzung: Hierarchie von Angst-Stuationen erstellen Aufbauend auf Konzepten des instrumentellen Lernens - vor allem Veränderung von Verhaltensweisen (z.B. Abbau von zwanghaftem Verhalten, Aufbau von Selbstbewusstsein) Therapie-Verträge: - Patient verpflichtet sich zur Erprobung bestimmter Verhaltensweisen; Belohnung bei Erreichen des vereinbarten Ziels Token-Systeme: - Gewünschtes Verhalten wird mittels „Münzen“ (tokens) verstärkt, die dann gegen etwas anderes eingetauscht werden können Stimuluskontrolle: - Kontrolle der Situationen (= Hinweisreize), in denen ein unerwünschtes Verhalten verstärkt wird - z.B. Verhindern von Fressanfällen dadurch, dass keine kalorienreichen Lebensmittel gekauft werden Biofeedback: - Rückmeldung körperlicher Zustände, um „autonome“ Reaktionen (z.B. EEG-Wellen, Herzfrequenz, Muskelspannung) kontrollierbar zu machen