Evaluierung von Information Retrieval Systemen: Minimal Test

Werbung

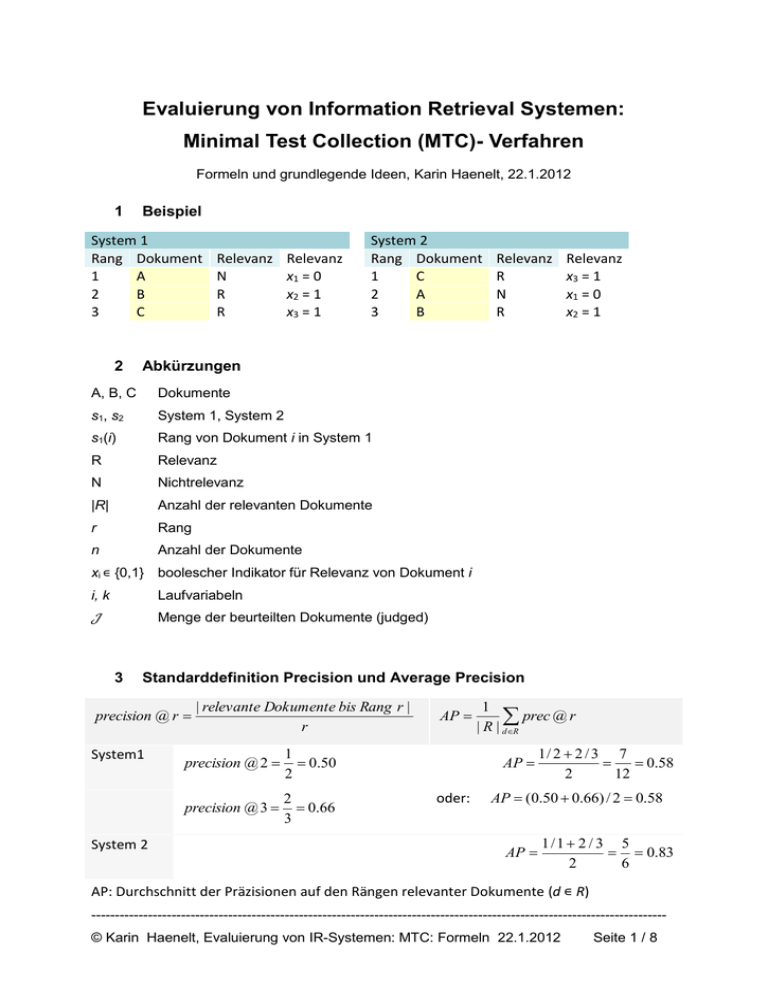

Evaluierung von Information Retrieval Systemen:

Minimal Test Collection (MTC)- Verfahren

Formeln und grundlegende Ideen, Karin Haenelt, 22.1.2012

1

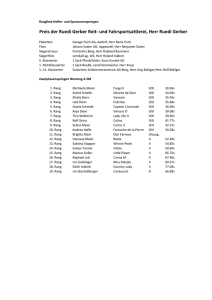

Beispiel

System 1

Rang Dokument

1

A

2

B

3

C

2

Relevanz

N

R

R

Relevanz

x1 = 0

x2 = 1

x3 = 1

System 2

Rang Dokument

1

C

2

A

3

B

Relevanz

R

N

R

Relevanz

x3 = 1

x1 = 0

x2 = 1

Abkürzungen

A, B, C

Dokumente

s1, s2

System 1, System 2

s1(i)

Rang von Dokument i in System 1

R

Relevanz

N

Nichtrelevanz

|R|

Anzahl der relevanten Dokumente

r

Rang

n

Anzahl der Dokumente

xi ∊ {0,1} boolescher Indikator für Relevanz von Dokument i

i, k

Laufvariabeln

𝒥

Menge der beurteilten Dokumente (judged)

3

Standarddefinition Precision und Average Precision

precision @ r

System1

System 2

| relevante Dokumente bis Rang r |

r

precision @ 2

1

0.50

2

precision @ 3

2

0.66

3

AP

1

prec @ r

| R | dR

AP

oder:

1/ 2 2 / 3 7

0.58

2

12

AP (0.50 0.66) / 2 0.58

AP

1/1 2 / 3 5

0.83

2

6

AP: Durchschnitt der Präzisionen auf den Rängen relevanter Dokumente (d ∊ R)

-------------------------------------------------------------------------------------------------------------------------© Karin Haenelt, Evaluierung von IR-Systemen: MTC: Formeln 22.1.2012

Seite 1 / 8

4

Darstellung von Precision und Average Precision als Zufallsexperiment

Rang

1

2

3

Relevanz

N

R

R

prec @ r

1 r

xi

r i 1

Wert der Zufallsvariablen Xi

x1=0

x2=1

x3=1

r

1 n

1 n r 1

x

i

AP

| R | r 1 xr i 1 r | R | r 1 i 1 r xr xi

1

0

0 1

0 1 1

7

(0 ∙ + 1 ( + ) + 1 ( + + )) =

2

1

2 2

3 3 3

12

1

prec @ 1 (0) 0

1

prec @ 2

oder

1

1

(0 1)

2

2

1 1

1

1

1

1

1

7

( ∙ 0 + ∙ 0 + ∙ 1 + ∙ 0 + ∙ 1 + ∙ 1) =

2 1

2

2

3

3

3

12

1

2

prec @ 3 (0 1 1)

3

3

5

AP

Durchschnittliche Precision: Formel für beliebige Dokumentreihenfolge

1

R

n

a x x

ij i

i 1

aij

j

j i

1

max{ rank (i ), rank ( j )}

i=

1

2

3

j=

1

2

3

2

3

3

Rang (xi)

1

1

1

2

2

3

Rang(xj)

1

2

3

2

3

3

1 ( 1 2 + 1

+ 1

+ 1 2 + 1

+ 1 2 )

𝑥1

𝑥1 𝑥2

𝑥1 𝑥3

𝑥2

𝑥2 𝑥3

𝑥

2 1

2

3

2

3

3 3

System 1

Rang (xi)

1

1

1

2

2

3

Rang(xj)

1

2

3

2

3

3

1 ( 1

+ 1

+ 1

+ 1

+ 1

+ 1

) = 7

∙0

∙0

∙0

∙1

∙1

∙1

12

2 1

2

3

2

3

3

System 2

Rang (xi)

2

2

2

3

3

1

Rang(xj)

2

3

1

3

1

1

1 ( 1

+ 1

+ 1

+ 1

+ 1

+ 1

) = 5

∙0

∙0

∙0

∙1

∙1

∙1

2 2

3

2

3

3

1

6

-------------------------------------------------------------------------------------------------------------------------© Karin Haenelt, Evaluierung von IR-Systemen: MTC: Formeln 22.1.2012

Seite 2 / 8

6

Differenz der durchschnittlichen Präzision zweier Systeme

AP AP1 AP2

1

R

n

c x x

ij i

cij aij bij

j

i 1 j i

Differenz positiv: System 1 hat bessere AP, Differenz negativ: System 2 hat bessere AP

7

-

Zusammenwirken von Relevanzbeurteilungen

Relevanzbeurteilung jedes einzelnen Dokuments wirkt sich auf das Gesamtergebnis

der AP aus.

-

Dies ermöglicht eine inkrementelle Beurteilung und den inkrementellen Aufbau der

Testkollektion

7.1

Beitrag eines Dokuments zur Präzisionssumme

System 1

Rang

1

2

3

System 1

Xi Dokument

x1 A

x2 B

x3 C

Dokument

A

B

C

System 2

Dokument

C

A

B

-

Sei SP (sum precision) = AP ∙ |R|

-

Wenn Dokument A relevant ist, ist sein Gesamtbeitrag zu SP1 höchstens:

Xi

x3

x1

x2

1 + 1/2 + 1/3

(abhängig davon ob die nachfolgenden Dokumente relevant sind, da für AP nur die

Werte auf den Rängen relevanter Dokumente gezählt werden)

-

Wenn Dokument A nicht relevant ist, kann SP1 nicht größer sein als

|R| - 1 -1/2 - 1/3

7.2

Beurteilungen als „nicht relevant“ sind also informativ für AP

Einfluss einer positiven Dokumentbeurteilung auf die inkrementelle

Berechnung von 𝚫SP - Beispiel

-

Angenommen, alle Dokumente gelten als nicht relevant

-

wenn ein Dokument als relevant beurteilt wird, ergibt sich folgende Veränderung (je

nachdem, welches Dokument beurteilt wird):

x1: SP1 = 1/1, SP2 = 1/2 𝚫SP =

0.50

x2: SP1 = 1/2, SP2 = 1/3 𝚫SP =

0.16

x3: SP1 = 1/3,SP2 = 1/1

𝚫SP = -0.66

-------------------------------------------------------------------------------------------------------------------------© Karin Haenelt, Evaluierung von IR-Systemen: MTC: Formeln 22.1.2012

Seite 3 / 8

7.3

Einfluss einer negativen Dokumentbeurteilung auf die inkrementelle

Berechnung von 𝚫SP – Beispiel

-

Angenommen, alle Dokumente gelten als relevant

-

wenn ein Dokument als nicht relevant beurteilt wird, ergibt sich folgende

Veränderung:

𝚫SP = -0.50

x1: SP1 = 1/2 + 2/3

-

SP2 = 1 + 2/3

𝚫SP = -0.33

x2: SP1 = 1 + 2/3

SP2 = 1 + 1

𝚫SP =

x3: SP1 = 1 + 1

0.83

SP2 = 1/2 + 2/3

8

8.1

Dokument-Selektions-Algorithmus zum Nachweis von ΔSP

Algorithmus

𝒥⟵ø

𝒘𝒉𝒊𝒍𝒆 ⌊𝛥𝑆𝑃⌋ < 0 <⌈𝛥𝑆𝑃⌉

𝒇𝒐𝒓 𝒆𝒂𝒄𝒉 𝑢𝑛𝑗𝑢𝑑𝑔𝑒𝑑 𝑑𝑜𝑐𝑢𝑚𝑒𝑛𝑡 𝑖 𝒅𝒐

𝑤𝑖𝑅

⟵

𝑐𝑖𝑖

+

∑

𝑘∈ 𝒥

𝑤𝑖𝑁

⟵

𝑐𝑖𝑖

+

∑

𝑘∈ 𝒥

𝑤𝑖

8.2

+ ∑

𝑐𝑖𝑘 𝑥𝑘

𝑘∉ 𝒥

𝑐𝑖𝑘

max{|𝑤𝑖𝑅 |, |𝑤𝑖𝑁 |}

⟵

𝑖∗

⟵

arg 𝑚𝑎𝑥𝑖 𝑤𝑖

𝑥𝑖 ∗

⟵

𝑗𝑢𝑑𝑔𝑒𝑚𝑒𝑛𝑡 𝑜𝑛 𝑑𝑜𝑐𝑢𝑚𝑒𝑛𝑡 𝑖 ∗

⟵

𝒥 ∪ 𝑖∗

𝒥

𝑐𝑖𝑘 𝑥𝑘

Erläuterung der Formel zur Berechnung der Dokumentgewichte

𝑤𝑖𝑅

⟵

𝑐𝑖𝑖

+

∑

𝑘∈ 𝒥

𝑤𝑖𝑁

⟵

𝑐𝑖𝑖

+

∑

𝑘∈ 𝒥

Basiseffekt

𝑐𝑖𝑘 𝑥𝑘

𝑐𝑖𝑘 𝑥𝑘

+ ∑

𝑘∉ 𝒥

𝑐𝑖𝑘

Zusammenwirken

Zswirken

mit beurteilten

mit nicht-

-------------------------------------------------------------------------------------------------------------------------© Karin Haenelt, Evaluierung von IR-Systemen: MTC: Formeln 22.1.2012

Seite 4 / 8

Dokumenten

1)

zusätzliche Basis für rel-Gewichte:

b. Doks 1)

unbeurteilte Dokumente sind nicht-relevant: xk=0

zusätzliche Basis für nonrel-Gewichte: unbeurteilte Dokumente sind relevant: xk=1

9

Tracing des Dokumentselektionsalgorithmus

9.1

Startgewichte

9.2

Tracing des Algorithmus

9.2.1

Start

-------------------------------------------------------------------------------------------------------------------------© Karin Haenelt, Evaluierung von IR-Systemen: MTC: Formeln 22.1.2012

Seite 5 / 8

9.2.2

1. Iteration

-------------------------------------------------------------------------------------------------------------------------© Karin Haenelt, Evaluierung von IR-Systemen: MTC: Formeln 22.1.2012

Seite 6 / 8

9.2.3

2. Iteration

10 MTC – Zwei Teile

1. Algorithmus zur Selektion des nächsten zu beurteilenden Dokuments (s.o.)

2. Evaluierungsverfahren für den Fall fehlender Beurteilungen

a. Beobachtung: Δ AP konvergiert mit zunehmender Anzahl beurteilter

Dokumente zu einer Normalverteilung

b. Konfidenzintervalle

11 Literatur

11.1 MTC-Entwicklung

James Allan, Ben Carterette, Javed A. Aslam, Virgil Pavlu, Blagovest Dachev,

Evangelos Kanoulas (2007). Million Query Track 2007 Overview. Proceedings of

TREC 2007. http://maroo.cs.umass.edu/pub/web/getpdf.php?id=800

Ben Carterette (2008). Low-Cost and Robust Evaluation of Information Retrieval

Systems. PhD thesis, University of Massachusetts Amherst

Ben Carterette (2007). Robust Test Collections for Retrieval Evaluation. IN:

Proceedings of SIGIR’07, July 23–27, 2007

Ben Carterette, Evangelos Kanoulas, Emine Yilmaz (2010). Low-Cost Evaluation in

information Retrieval. Tutorial of the 33rd Annual International ACM SIGIR Conference

on Research and Development in Information Retrieval.

http://ir.cis.udel.edu/SIGIR10tutorial/slides.pdf

Ben Carterette, James Allan, and Ramesh K. Sitaraman. Minimal test collections for

retrieval evaluation. In: Proceedings of SIGIR’06, pages 268-275, 2006.

http://ir.cis.udel.edu/~carteret/papers/sigir06.pdf

-------------------------------------------------------------------------------------------------------------------------© Karin Haenelt, Evaluierung von IR-Systemen: MTC: Formeln 22.1.2012

Seite 7 / 8

11.2 Darstellungen

Karin Haenelt (2011). Evaluierung von Information Retrieval Systemen. Minimal Test

Collection (MTC)- Verfahren. Kursfolien 5.12.2011. 57 S.

http://kontext.fraunhofer.de/haenelt/kurs/folien/Haenelt_MTC.pdf

Eliah Ninyo, Keren Kenzi (o.J.). Minimal Test Collections for Retrieval Evaluation. B.

Carterette et al. http://cs.haifa.ac.il/courses/infor/students/Minimal Test Collections for

Retrieval Evaluation-Eli+Keren.ppt

-------------------------------------------------------------------------------------------------------------------------© Karin Haenelt, Evaluierung von IR-Systemen: MTC: Formeln 22.1.2012

Seite 8 / 8