Datenqualitätsanalysen mit Oracle

Werbung

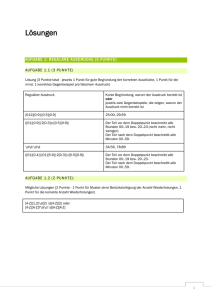

<Insert Picture Here> Datenqualitätsanalysen mit Oracle Alfred Schlaucher, Data Warehouse Architect, Oracle <Insert Picture Here> Data Quality Data Profiling Standardisierung Match/Merge Rules „Es ist leichter, Datenqualitätsprobleme zu lösen, als mit Ihnen zu leben.“ (Albert Einstein) Ein Dashboard mit vielen Charts Warum ist ein Tooleinsatz bei Datenqualitätsanalysen sinnvoll? • Das meiste geht auch ohne Tool, allerdings mühsam Functional Dependencies Der Fehler steckt im Detail Fehler stecken im Detail Umsatz pro Sparte? Umsatz pro Gruppe? Umsatz pro Produkt? Werden korrekte Rechnungen gestellt? Umsatz pro Kunde? Sparten Gruppen Produkte Fehlerhafte Spartenkennzeichnung von Gruppen Orphans ohne Parents Falsche Statuskennzeichnung von Finanzprodukten Fehlerhafte Verschlüsselung von Artikel- und Produkten Bestellung Position Doppelte Produktnummern KundenStamm Fehlerhafte , nicht rechenbare Einzelpreiswerte Doppelte Wertebelegung von Statuskennzeichnung für Privat- und Firmenkunden. Aspekte der Datenqualität Korrekt Stimmig Vollständig Brauchbarkeit der Daten! Dokumentiert Redundanzfrei Aktuell Verfügbar (Access) Nützlich (TCO) Handhabbar Die Kosten der schlechten Daten Data Profiling • Software – gestütztes Erkennen von Anomalien in Datenbeständen (The use of analytical techniques about data for the purpose of developing a thorough knowledge of its content, structure and quality) • Interaktiver Analyse-Vorgang • Bestandteil von Oracle Warehouse Builder seit 2006 Methoden und Hilfsmittel bei Datenqualitätsanalysen • Methoden • Attribut-Klassifizierung (Namen) • Kategorisierung von Qualitätsregeln • Datenmodellierung • Vorgehensmodell Brain-Ware • Tools • • • • • • Data Profiling Tool Data Rules Mechanismus Deduplizierungs-Feature Standardisierung ETL-Tool Datenbank OWB Oracle Data Quality / Data Profiling • Standardanalysen • • • • • • • • Unique Keys Functional Dependencies Relationships Domains Redundant Columns Patterns, Types Statistiken Six Sigma • Rules (Business-/ IT-Rules) • Generierung von Korrekturen • Auditing • Eingebettet in ein ETL-Tool • hohe Flexibilität beim Bereitstellen von Daten • Direktes Anwenden erkannter Regeln für eine spätere Datenaufbereitung und Minitoring • Ablaufumgebung ist die Datenbank • Datennähe Starten eines GenerierungProfiling-Laufs Rule Starten einer CorrectionMapping-Generierung Auswahl und Ergebnisansicht Methoden Die Tabellen, die zu dem Analysefukus gehören Tabellen-Darstellung Chart-Darstellung Feintuning zu den Analysemethoden Drill-Werte Operative Datensätze AnalyseJobProtokolle Aktivierbare Business Rules Wertebereichsanalysen (Domain) Beispiel: Marketingkampagnen • 5 Millionen Privatkunden-Kontaktdaten • Davon 372112 unterschiedliche Berufe Wie wertvoll ist diese Art der Information? Kann damit eine Segmentierung für eine Marketingkampagne gesteuert werden? • Datenmaterial lässt Rückschlüsse auf die Geschäftsprozesse zu! Beziehungen (Relational) Beziehungen (Orphans / Childless) Formate (Data Type) ? ? ? Wertmustererkennung (Pattern) Definieren von Regelwerken (Logical / Business Data Rules) Korrekt: Zusammen 100% (Alle Fälle erfasst) Korrekt, muß 0 sein Korrekt: Es kann nur ein Wert gepflegt sein. Korrekt, muß 0 sein Korrekt, muß 0 sein Korrekt, das sind die richtigen Werte Korrekt, das sind richtige Werte Problem: kein Schlüsselfeld ist gepflegt Korrekt, muß 0 sein Korrekt: Zusammen 100%. (Alle Fälle erfasst) Korrekt, muß 0 sein Problem Korrekt Stammdatenbetrachtung In einigen Fällen fehlen die Einkaufpreise ? Nicht normiertes Datenmaterial Mit solchen Daten kann man nicht rechnen Hilfsmittel: Pattern-Analyse Prüfung der aufgestellten Geschäftsregeln Stammdatenregel: Artikelnummer und Produktnummer sind alternativ zu füllen. Ein Statusfeld steuert mit Korrekt: Zusammen 100% (Alle Fälle erfasst) Korrekt, muß 0 sein Korrekt: Es kann nur ein Wert gepflegt sein. Korrekt, muß 0 sein Korrekt, muß 0 sein Korrekt, das sind die richtigen Werte Korrekt, das sind richtige Werte Problem: kein Schlüsselfeld ist gepflegt Korrekt, muß 0 sein Korrekt: Zusammen 100%. (Alle Fälle erfasst) Korrekt, muß 0 sein Problem Korrekt Analyseumgebung LDAP DBMS_LDAP non Oracle DB2, SQL Server Informix, Teradata Meta Daten Repository Gateway / ODBC / FTP Oracle 9i / 10g / 11g SAP Integrator SAP R/3 Source Stage Siebel CRM Oracle eBusiness Text / XML Profiling Stage Analyse Datenbank Direct Path DBLink Transportable Modules Data Quality Monitoring im DWH Data Quality Dashboards Data Profiling im Data Warehouse hat zwei Hauptaufgaben 1. Garantieren von korrekten Berichten 2. Minimieren von Projektkosten Wo stecken die Aufwende? Traditionelle Projektaufwand bei Neuentwicklung Datenanalyse 50% Front End 20% 5 % Arbeit mit ETL Tool 10 % Entwurf Transformationen 15 %Daten Modellierung + Systemdesign Korrektur Phase 1 ?? Korrektur Phase 2 ?? Wartung ??