PPT

Werbung

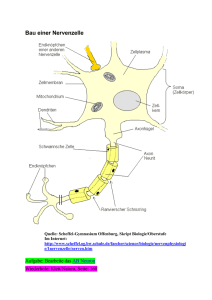

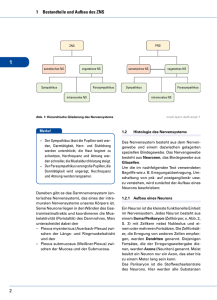

Neuronale Netze und Fuzzy Sets Das Gehirn von Carl Friedrich Gauß (1777-1855) Robert Fludd (1574-1637) Robert Fludd (1574-1637) George Combe (1788-1858) George Combe (1788-1858) A System of Phrenology, Boston: Marsh Capen 1831. Nervenzelle (Neuron) Nervenzelle (Neuron) Neuronenwachstum Neuronenwachstum Synaptische Verbindungen bei einem Neugeborenen Synaptische Verbindungen bei einem drei Monate alten Kind Synaptische Verbindungen bei einem zwei Jahre alten Kind Siegmund Exner (1852 -1934) Entwurf zu einer physiologischen Erklärung der psychischen Erscheinungen, Leipzig und Wien:1894 Makroskopische Gliederung der Großhirnrinde Neuronentypen - Schematische Darstellung eines Neurons Santiago Ramón y Cajal (1852 -1934) Santiago Ramón y Cajal (1852 -1934) Santiago Ramón y Cajal (1852 -1934) Natürliche Neuronale Netze • Eingänge des Nervensystems: Einige Nervenzellen (z.B. Sinneszellen) können durch Umweltreize erregt werden. • Ausgänge des Nervensystems: Einige Ausgänge von Nervenzellen wirken (über Muskelzellen) auf die Umwelt ein. • Erregungsbedingung: • Eine Nervenzelle geht in den Erregungszustand über, wenn genügend viele ihrer Eingänge mit erregten Nervenzellen verbunden sind. • Unabhängigkeit der Nervenzellen: Der Zustand einer Nervenzelle ist allein durch die Verhältnisse an ihren Eingängen bestimmt. Die einzelnen Zellen arbeiten also unabhängig voneinander. Natürliche Neuronale Netze • Aufbau einer Nervenzelle: Eine Nervenzelle besitzt viele Eingänge, nämlich die synaptischen Verbindungen, und einen Ausgang, nämlich das Axon. • Zustände einer Nervenzelle: Eine Nervenzelle kann zwei Zustände annehmen: den Ruhezustand und den Erregungszustand. • Verbindungen der Nervenzellen untereinander: der Ausgang einer Nervenzelle führt zu den Eingängen anderer Nervenzellen. Nicolas Rashevsky (1899-1972) • begründete 1939 das Bulletin of Mathematical Biophysics (heute: Bulletin of Mathematical Biology, offizielles Journal der Society of Mathematical Biology) • Erste Studenten: Alvin Weinberg, Anatol Rapoport. • Erstes PhD program in Mathematical Biology, 1947. • Arbeitsgebiete:, Neurowissenschaften, Zellbiology Embryologie, Ökologie, Psychologie, Soziologie. • Weitere Studenten: George Karreman, Herbert Landahl (Mitbegründer der Society of Mathematical Biology), Robert Rosen, Robert S. Cohen. Pioniere der mathematischen Biologie bzw. Neurowissenschaften Alston Householder Herbert Landahl Rashevskys Forschungen in den 1930er Jahren Nicolas Rashevsky: Mathematical Biophysics. Nature, April 6, 1935, p. 528-530: 530. Cornelius Ubbo Ariëns Kappers (1877-1946) Of all cells, the neurones have most completely lost their property of dividing; we should expect forces of attraction between them. Indeed the existence of such forces has been inferred by a number of neurologists, notably Ariens Kappers and Ramon y Cajal from various observations. Santiago Ramón y Cajal (1852 -1934) David P. C. Lloyd (1911 -1985) Charles Sherrington (1857 -1952) Rashevskys Forschungen in den 1930er Jahren Nicolas Rashevsky: Mathematical Biophysics. Nature, April 6, 1935, p. 528-530: 530. Ivan Petrowitsch Pawlow (1849-1936) It has been suggested that a formation of new anatomical connexions between neurones may be the cause of conditioned reflexes and learning. Calculation shows that the above forces may account for it. Under certain conditions they will produce an actual new connexion in a very small fraction of a second. This leads us towards a mathematical theory of nervous functions. We find that, under very general conditions, aggregates of cells such as are studied above will possess many properties characteristic of the brain. Rashevsky: Mathematical Biophysics And Psychology,1936 Psychometrika, Vol. 1, No. 1, September 1936, pp. 1-26. e = Erregungssubstanz i = Hemmungssubstanz Erregung: e-i >0 Hemmung: e-i <0 Rashevsky: Mathematical Biophysics And Psychology,1936 Psychometrika, Vol. 2, No. 3, September 1937, pp. 199-209. Neuron I: Schwelle h1 Neuron II: Schwelle h2 Erregungsfaktorenen : e1 , e2 Erregungen: E1 , E2 e1 > h1 e2 > h2 E1 in Neuron I, E2 in Neuron II. Wenn e1 - h1 genügend klein, dann ist E1 genügend klein, dann ist e2 < h2, dann wird Neuron II nicht erregt. Wenn e1 - h1 so groß ist, dass E1 und damit e2 so groß sind, dass e2 >h2, dann wird Neuron II erregt mit E2. Vernetzte Nervenzellen – Die Arbeiten von McCulloch und Pitts in den 1940er Jahren Jack D. Cowan Jerome Y. Lettvin Warren Sturgis McCulloch (1899-1972) • Studium: ab 1917 Mathematik (Haverford College), ab 1918 Philosophie und Psychologie (Offiziersschule in Yale), Magister in Psychologie (Columbia University, New York), dann Medizin (Columbia, New York), • 1928: Neurologe am Bellvue Hospital, New York, • 1930: Rockland State Hospital für Geisteskranke, New York (Forschung zu Kopfverletzungen und Epilepsie) • Labor für Neurophysiologie (Yale) • Prof. für Psychiatrie in Illinois, Leiter des Labors für Grundlagenforschung in der Abteilung für Psychiatrie, (Erforschung von Fragen der Physiologie aus Sicht der Anatomie, Physik und Chemie). • 1952: Research Laboratory of Electronics, MIT, Boston, • 1972 gestorben. Walter Pitts (1924-196?) • geb. in Detroit, Michigan, • keine Abschlüsse in High School oder College, • kam 1937 nach Chicago, traf dort Russell, Carnap, Rashevsky und McCulloch, •1943: Research Assistant bei Wiener am MIT, • um 1951 Nervenzusammenbruch, • 1950er Jahre: Pitts zerstörte Zeugnisse seines Vorlebens, „verschwunden“, • starb in den 1960er Jahren. Warren McCulloch, Walter Pitts A Logical Calculus of the ideas immanent in nervous activity. Bulletin of Mathematical Biophysics, Vol. 5, S. 115133. Künstliche Neuronen • Ein Neuron ist ein entweder aktives oder inaktives binäres Schaltelement. • Jedem Neuron ist ein fester Schwellenwert eigen. • Neuronen empfangen Eingaben (inputs) von erregenden Synapsen, die ihre Aktivierung mit gleichem Gewicht weitergeben. • Neuronen empfangen auch Eingaben (inputs) von hemmenden Synapsen, wodurch ihre Aktivierung gerade verhindert wird. • Innerhalb eines kleinen Zeitabschnittes werden die erregenden Eingaben im Neuron addiert; überschreitet diese Summe den Schwellenwert des Neurons, so wird es aktiv. McCulloch, Leiter der Macy-Treffen der Cybernetic Group“, 1944-1953 McCulloch: Finality and Form American Lecture Series (Springfield I11, Charles C. Thomas, 1952). „Alles-oder-nichts-Impuls“ Wenn ein Klotz angestoßen wird, fällt er ganz um oder gar nicht. Das ist sein Alles-oder-nichts-Impuls. Refraktärzeit Es braucht Zeit, ihn wieder aufzustellen. Das ist die Erholungs- oder Refraktärzeit. Schwelle - latente Summation Damit er fällt, muss er hinreichend stark angestoßen werden. Das ist seine Schwelle. Ein Stoß, der ihn nicht umfallen lässt, bringt ihn nur zum Kippen, von wo er in seine alte Lage zurückkehrt; aber während er noch kippt, kann er durch einen zweiten gleichen Schlag umgeworfen werden. Das ist latente Summation. Synaptische Verzögerung Nachdem ein Klotz angestoßen wurde, dauert es eine Weile, bis er umfällt. Das ist die synaptische Verzögerung. Zeitliche Summation Der Impuls und die latente Summation sind so viel kürzer als die Refraktärzeit und die synaptische Verzögerung, dass ein Klotz nie einen anderen umwerfen kann, indem er ihn zweimal anstößt. Das ist das Fehlen der zeitlichen Summation. Unumkehrbarkeit der Leitungsrichtung Ein Klotz, der zwei andere umstößt, wirft sie möglicherweise nicht um, während die beiden Klötze zusammen den ersten umwerfen können. Das ist die Unumkehrbarkeit der Leitungsrichtung. Hemmung - Räumliche Summation Ein Klotz, der gegen die Kante eines anderen fällt, kann einen dritten daran hindern, ihn umzuwerfen. Das ist die Hemmung an einer Synapse. Zwei Klötze, die gemeinsam einen dritten anstoßen, können ihn umwerfen, obwohl jeder allein es nicht geschafft hätte. Das ist räumliche Summation. Irritabilität Nicht zuletzt stammt fast alle zum Umwerfen eines Bausteins nötige Energie aus der Lageenergie, die beim Aufstellen im Baustein gespeichert wurde. Diese Energie braucht nicht von dem Stoß zu kommen, der den Klotz umwirft. Das ist die Erregbarkeit oder Irritabilität. Signifikante gleichzeitige Funktionen Wenn C fällt, folgt daraus, dass entweder A oder B oder beide eine synaptische Verzögerung zuvor gefallen sind: logisches „oder“ (und/oder). Die logische Relation des Falls von A und/oder B zu einer bestimmten Zeit, etwa t =1, wird ihre Disjunktion genannt. Das Umfallen von C zur Zeit t =2 impliziert nicht das eine oder andere Ereignis, sondern ihre Disjunktion zur Zeit t =1. Signifikante gleichzeitige Funktionen Wenn G umfallen soll müssen sowohl E als auch F innerhalb der Periode der zeitlichen Summation G angestoßen haben. Wenn G also zur Zeit t =2 fällt, setzt das die Konjunktion des Fallens von E und F zur Zeit t =1 voraus: logisches „und“. Signifikante gleichzeitige Funktionen H kann J zum Umfallen bringen, wenn nicht I gegen den Rand von J fällt und damit sein Umfallen verhindert. Konjunktion einer Behauptung mit einer Negation. Das Umfallen von J zur Zeit t =2 setzt voraus, dass zur Zeit t =1 zwar H umfiel, aber nicht I. Gedächtnis Werden Bauklötze nebeneinander im Kreis aufgestellt und fällt einer um, so setzt ich das Umfallen im Kreis fort, bis der letzte Stein auf den ersten fällt. Wenn die Klötze so rasch wieder aufgestellt werden könnten, wie sie umfallen, würde das Fallen immer weitergehen. Das ist eine Art Gedächtnis. „Wachstum durch Gebrauch“ Wie wird die Aufstellung der Klötze (bzw. das Neuronennetz) durch die Impulse verändert? Regel: Ein Klotz C, der gleichzeitig mit einem Klotz R umfällt, der aber nicht durch C umgestoßen wurde, wird so wieder aufgestellt, dass er beim nächsten Mal R umwerfen kann. Bikonditionale Funktion: „dann und nur dann“ Wenn die Orte und Stoßrichtungen so festgelegt wurden, dass B beim Umfallen immer C zu Fall bringt, haben wir Implikation in beiden Richtungen. Die Fall von C zur Zeit t = 2 bedingt das Umfallen von B zur Zeit t = 1. Jetzt bedingt aber auch das Umfallen von B zur Zeit t = 1 das Umfallen von C zur Zeit t = 2. „Reflexe“ McCulloch, Pitts: A Logical Calculus of the Ideas Immanent in Nervous Activity Bulletin of Mathematical Biophysics, Vol. 5, S. 115-133. Struktur eines typischen künstlichen Neuronalen Netzes Interpretation des neuronalen Netzes als Funktion Struktur eines typischen künstlichen Neuronalen Netzes Interpretation des neuronalen Netzes als Black Box Struktur eines typischen künstlichen Neuronalen Netzes Auswertung einer Funktion mit n Argumenten Struktur eines typischen künstlichen Neuronalen Netzes Generisches Neuron mit Integrationsteil und Ausgabeteil Integrationsteil: g Zusammenfassung der Eingabe Ausgabeteil: f Berechnung der Ausgabe McCulloch-Pitts-Neuron McCulloch-Pitts-Neuronen zum Aufbau logischer Funktionen McCulloch-Pitts-Neuronen zum Aufbau logischer Funktionen Logische Funktionen Frank Rosenblatt, 1957: Perzeptron Frank Rosenblatt, 1957: Perzeptron Frank Rosenblatt, 1957: Perzeptron McCulloch-Pitts-Zellen: geometrische Interpretation McCulloch-Pitts-Zellen: geometrische Interpretation Perzeptron; geometrische Interpretation Logische Funktionen XOR-Problem x1 x2 x1 XOR x2 0 0 0 1 0 1 0 1 1 1 1 0 McCulloch und Pitts: Logik der Neuronen Donald Olding Hebb (1904-1985) Unser Gedächtnis beruht wahrscheinlich darauf, dass synaptische Verbindungen zwischen gleichzeitig aktiven Nervenzellen gestärkt werden. Eine solche Veränderung der synaptischen Stärke wird als Hebb'sches Lernen bezeichnet. Donald Olding Hebb (1904-1985) Tatsächlich kann nach wiederholter gleichzeitiger Stimulation eine Zunahme der synaptischen Verbindungsstärke festgestellt werden: Nach dem Hebb‘schen Modell entsteht in Gruppen von Nervenzellen, die untereinander durch positive Rückkopplung verbunden sind, kreisende Erregung. Diese Erregungszustände betrachtete Hebb als Grundlage von psychischen Komponenten wie Ideen und Vorstellungen. Gruppen von Nervenzellen, von Hebb als "Zellgesellschaften" bezeichnet, bilden sich durch Verstärkung von synaptischen Verbindungen zwischen gleichzeitig aktiven Nervenzellen. Hebb hat sein Modell vorgeschlagen, ohne über experimentelle Hinweise darauf zu verfügen. Mittlerweile hat man aber in verschiedenen Regionen des Gehirns Synapsen mit genau diesen Eigenschaften gefunden. Man bezeichnet sie heute als Hebb'sche Synapsen. Modell-Neuron Body Axon Nerveneigenschaften Nerveneigenschaften Logische Operationen “Wenn A dann B” Neuron A Neuron B Logische Operationen “Wenn A oder B dann C” Neuron A Neuron B Neuron C Logische Operationen Neuron A “Wenn A oder B dann C” Neuron C Neuron B Logische Operationen Neuron A “Wenn A und nicht B dann C” Neuron C Neuron B XOR-Problem = w1 x1 + w2 x2, woraus folgt: x2 = - (w1 / w2) x1 + ( / w2) Auf der einen Seite der Geraden gilt: w1 x1 + w2 x2 > , d. h. Neuron ist aktiv. Auf der anderen Seite der Geraden: w1 x1 + w2 x2 < , d. h. Neuron ist nicht aktiv. XOR-Problem x1 = 0 und x2 = 1: y soll 1 sein. x1 = 1 und x2 = 0: y soll 1 sein. x1 = 0 und x2 = 0: y soll 0 sein. x1 = 1 und x2 = 1: y soll 0 sein. D. h.: w1 0 + D. h.: w1 1 + D. h.: w1 0 + D. h.: w1 1 + w2 1 , w2 0 , w2 0 < , w2 1 < , Addieren der beiden ersten Ungleichungen ergibt: Aus den letzten beiden Ungleichungen folgt: > w1 + w2 2, Das gilt aber nur für < 0. Dies steht im Widerspruch zu w1 0 + w2 0 < . d. h. aktiv! d. h. aktiv! d. h. inaktiv! d. h. inaktiv! w1 + w2 2 , also >2. Zwei nicht linear trennbare Muster in einem 2-dim. Merkmalsraum in einem 3-dim. Merkmalsraum Marvin Minsky und Seymour Papert 1969 L. A. Zadeh, 1963: Optimality and Non-Scalar-Valued Performance Criteria Eine Teilmenge (constraint set) C von sei durch Einschränkungen an das System S definiert. Auf sei eine partielle Ordnung „“ definiert, wodurch jedem System S in die folgenden drei disjunkten Teilmengen von zugeordnet werden können: >(S): (S): ~(S): Teilmenge aller Systeme, die besser als S sind (superior). Teilmenge aller Systeme, die schlechter oder gleich S sind (inferior). Teilmenge aller Systeme, die mit S nicht vergleichbar sind. >(S) (S) ~(S) = . Definition 1: Ein System S0 ist in C nichtinferior, wenn gilt: C >(S0) = Ø. (Es gibt somit kein System in C, das besser als S0 ist.) Definition 2: Ein System S0 ist in C optimal, wenn gilt: C (S0). (Jedes System in C ist somit schlechter (inferior) als S0 oder gleich S0.) L. A. Zadeh, 1963: Optimality and Non-Scalar-Valued Performance Criteria Ist die Menge aller betrachteten Systeme durch ein skalares Kriterium vollständig geordnet, dann gilt: ~(S0)= und >(S0) und (S0) sind komplementäre Mengen. Wenn C >(S0) = , dann gilt sicher: (S0) C. Nichtinferiorität und Optimalität sind äquivalent; Unterschied der Begriffe ist nicht erkennbar. Vorschlag: Partielle Ordnung von durch vektorwertiges Leistungskriterium berücksichtigen: System S sei durch x = (x1, ..., xn) charakterisiert, dessen reellwertige Komponenten z. B. die Werte von n veränderlichen Parametern des Systems S sind. C sei Teilmenge des n-dimensionalen Euklidischen Raumes. Die Leistung des Systems S werde durch einen m-dimensionalen-Vektor p(x) = [p1(x), ..., pm(x)] gemessen, wobei pi(x), i = 1, ..., m, reellwertige Funktion von x ist. Es gilt nun S ≥ S´ p(x) ≥ p(x‘). Das heißt also: pi(x) ≥ pi (x‘), i = 1, ..., m. L. A. Zadeh, 1963: Optimality and Non-Scalar-Valued Performance Criteria L. A. Zadeh, 1963: Optimality and Non-Scalar-Valued Performance Criteria Separation Theorem for Fuzzy Sets