Vorl-6-Schwellwertoperatoren&Texturen

Werbung

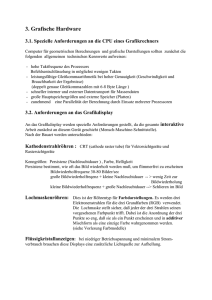

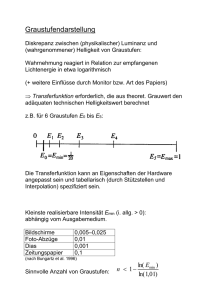

Schwellwertverfahren

Sollen Bilder in kleinere Farbräume konvertiert werden,

ergibt sich das Problem der Bestimmung adäquater

Schwellwerte. Eine klassische Aufgabe ist die

Binarisierung eines Grauwertbildes.

Typische Schwellwerte können aus dem

Grauwerthistogramm eines Bildes gewonnen werden:

Mittelmäßiger Grauwert

Grauwertmedian

Hauptsenken (zentralste relative Extremstellen des

Grauwerthistogramms)

Maximum-Entropie-Schwellwert

Ziel einer Filterung ist im Allgemeinen eine

Verbesserung eines Musters.

Im Einzelnen kann dies eine Reduktion

störender Anteile, oder eine Hervorhebung

informativer Anteile bzw. die Restaurierung eines

idealen Musters sein.

Die Abbildung welche ein gegebenes Bild auf ein

Ausgabebild abbildet, heißt Transformation.

Ein wichtiges Unterscheidungsmerkmal von

Transformationen ist ihre mathematische Beschaffenheit.

Eine Transformation

heißt Lineares System wenn für

alle Funktionen

und alle Skalare

gilt:

1-dimensional:

2-dimensional:

Die bilaterale Z-Transformation eines Signals x[n] ist die formale Reihe X(z):

wobei n alle ganzen Zahlen durchläuft und z, im Allgemeinen, eine komplexe Zahl

der Form

ist. A ist der Betrag von z und φ der Winkel der komplexen Zahl in Polarkoordinaten.

Alternativ kann z auch als Realteil σ und Imaginärteil ω beschrieben werden.

In der digitalen Bildverarbeitung bezeichnet eine

Nachbarschaft eine kleine, definierte Bildregion um ein

Pixel. Viele Bildverarbeitungsoperationen betrachten die Pixel

innerhalb einer Nachbarschaft, um für ihren Mittelpunkt einen

neuen Farb- oder Grauwert zu berechnen.

Mit der Vierer-Nachbarschaft (auch D-Nachbarschaft) und

der Achter-Nachbarschaft existieren zwei grundlegende

Nachbarschaftskonzepte.

Jedes Pixel P eines Bildes hat vier horizontale und vertikale

Nachbarn D. Diese direkten Nachbarn zeichnen sind

dadurch aus, dass sie mit P jeweils eine Pixelkante

gemeinsam haben. Sie werden als D-Nachbarn oder 4Nachbarn bezeichnet.

Nimmt man die Koordinaten von P mit (x,y) an, so sind die

Koordinaten der vier D-Nachbarn durch

◦ (x − 1, y),(x, y − 1),(x, y + 1),(x + 1, y)

gegeben. Jeder D-Nachbar ist von P genau eine Einheit

entfernt.

Die Menge, die den Punkt P und seine Nachbarn D enthält,

heißt Vierer-Nachbarschaft. Eine Vierer-Nachbarschaft besteht

also aus fünf Punkten . Sie wird üblicherweise mit N4(P)

bezeichnet.

Die

Menge, die den Punkt P und seine

Nachbarn D und N enthält, heißt AchterNachbarschaft.

Eine Achter-Nachbarschaft besteht also aus

neun Punkten (siehe nextstehende Abbildung).

Sie wird mit N8(P) oder oft auch ganz einfach

mit NP bezeichnet.

Wenn in der Bildverarbeitung von einer Nachbarschaft

die Rede ist und im konkreten Anwendungsfall nicht

explizit auf die Verwendung einer Vierer- oder anderen

Nachbarschaft hingewiesen wird, so findet in der Regel

eine Achter-Nachbarschaft Anwendung.

Die Größe und Form einer Nachbarschaft hängt immer vom

Anwendungsfall ab. Für viele Operatoren ist eine

quadratische Form nxn mit n = 3,5,7… üblich.

Abweichend davon kann eine Nachbarschaft beispielsweise

auch nach der Manhattan-Metrik mit maximalem

Abstand 2 zum Mittelpunkt P definiert werden (siehe

nebenstehende Abbildung). Auch runde oder sogar völlig

unsymmetrische Nachbarschaften sind denkbar.

Der Pixel in der Mitte einer Nachbarschaft muss nicht

zwangsweise der Mittelpunkt P der Nachbarschaft sein.

Bei der praktischen Anwendung von

Nachbarschaftsoperatoren tritt

unweigerlich das Randproblem auf:

Wie wird der Fall behandelt, wenn ein

Pixel so nah am Rand eines Bildes

liegt, dass die Nachbarschaft über

das Bild „hinausragt”

Vier verschiedene Lösungsansätze

sind denkbar:

Die Randpixel werden nicht

betrachtet.

Der Nachteil hierbei ist, dass das

Ergebnisbild dann etwas kleiner wird

(bei einer -Nachbarschaft mit

ungeradem n um

(n − 1) / 2 Pixel auf jeder Seite).

Die benötigten Pixel außerhalb des Bildes werden

entsprechend der naheliegendsten Bildpunkte

extrapoliert.

Der Nachteil hierbei ist, dass sich

Extrapolationsfehler bei aufeinanderfolgender

Anwendung mehrerer Nachbarschaftsoperatoren ins

Innere des Bildes fortsetzen können.

Das Bild wird periodisch fortgesetzt.

Um in der Praxis die Filter anwenden zu können nutzt man

in der Regel eine m x n Filtermatrix.

Jeder Eintrag dieser Matrix entspricht einem Gewicht,

mit welchem die Nachbarpunkte des zu

transfomrierenden Punktes multipliziert werden.

Ein Punkt g(x,y) im Ergebnisbild erhält also den Wert, der

sich dadurch ergibt, dass man die Punkte seiner

Nachbarschaft mit den Werten der Filtermatrix gewichtet

aufaddiert und anschließend durch die Gesamtsumme des

Betrags der Gewichte teilt.

Beispiel: 3x 3 Filtermatrix mit dem Ableitungsoperator

und jeder Pixelwert noch

durch 6 geteilt. Man sieht,

dass der Rand mit Nullen

aufgefüllt wurde, es wäre

auch möglich, den Rand

ins Unendliche zu

erweitern. In der Praxis

würde in der Regel noch

eine Betragsbildung

durchgeführt.

Filter

nach Anwendungsgebieten

Glättung

Durch Glättung kann das Bildrauschen

vermindert werden, grobere Strukturen bleiben dagegen

erhalten. Hier ein für ein (künstlich) verrauschtes Bild. Auf

das Frequenzspektrum eines Bildes bezogen kommt eine

Glättung einem Tiefpassfilter gleich. Typische FIRGlättungsfilter sind

Gaußfilter: Gaußfilter der Größe

und einer

Varianz σ2 werden durch eine Impulsantwortmatrix

beschrieben.

Die Nachbarpunkte des Ausgangsbildes werden

entsprechend einer zweidimensionalen Gaußglocke

gewichtet. Sie werden als reales optisches Bauteil als

Gauß-Filterung der Fourier-Transformierten eingesetzt.

verrauschtes Bild

Gaußfilter

Medianfilter

Medianfilter

Beim Einsatz in der Bildverarbeitung werden die Grauwerte

der Pixel innerhalb einer definierten Umgebung eines Pixels

im Zentrum dieser Umgebung nach ihrer Größe

sortiert.

Der mittlere Wert der sortierten Liste wird zurückgegeben

und der Wert des zentralen Pixels wird durch ihn ersetzt.

Hier ein Beispiel für den Unterschied zwischen Medianfilter

und Mittelwertberechnung

Median von {1,3,5,8,13} = 5 hingegen der Mittelwert von

{1,3,5,8,13} = 6

oder

Median {(120 118 110)(125 221 105)( 90 101 114)} =

90,101,105,110,114,118,120,125,221 = 114

Das linke Bild des oberen Fotopaars ist von statistisch verteilten

weißen Pixeln überlagert.

Eine Median-Filterung führt zum Ergebnis rechts. Der

Informationsgehalt beider Bilder ist gleich, dennoch ist das rechte

Bild leichter zu erkennen. Werden sie durch Farbwerte aus ihrer

Umgebung ersetzt, entsteht ein leicht unscharfes Bild ohne bildfremde

Kanten. Die Ausreißerpixel (hier weiß (Salt)) werden auch Salt and

Pepper genannt.

Das rechte Photopaar zeigt das Ergebnis einer Medianfilterung

(Blockgröße: 5 Pixel) an einer Marsaufnahme aus dem Jahr 1976, die

von dunklen Pixeln durchsetzt ist.

Leider hat nicht alles nur Vorteile - z.B. bei Schrift zeigt der

Medianfilter eindeutige Schwächen.

Ein 3x3 Medianfilter lässt alle "Striche" weg die kleiner 2

Pixel breit sind. Ein 9x9 Medianfilter lässt sogar alle "Striche"

weg die eine Breite von weniger als 5 Pixel haben.

So würde schwarze Schrift auf weißen Untergrund nicht mehr

angezeigt werden da der Großteil der umgebenden Pixel weiß

ist.

Die Kantendetektion ist Teil einer Segmentierung in der

Bildverarbeitung, bei der versucht wird, flächige Bereiche

in einem digitalen Bild von einander zu trennen.

Kantenoperatoren erkennen die Übergänge zwischen diesen

Bereichen. Diese Übergänge werden als Kanten

markiert.

Ein Kantendetektor berechnet aus einem Bild sein

entsprechendes Kantenbild in dem alle Kanten entsprechend

zu sehen sind. Um dieses zu erreichen, wird jeder Bildpunkt

durch eine Berechnung mittels einer Matrix neu gesetzt.

Originalbild

Kantenbild

Häufig finden folgende FIR-Filter Anwendung:

Ableitungsfilter

Laplacefilter , Gaußfilter

Nichtlineare Kantendetektoren:

Varianzfilter

Extremalspannenfilter

Roberts-Kreuz

Kirsch-Filter

Gradientenfilter

◦ Prewitt-Filter

◦ Sobel-Filter

◦ Canny-Filter

Die Bereiche der größten Intensität sind dort, wo die

Helligkeit des Originalbildes sich am stärksten ändert

und somit die größten Kanten darstellt.

Daher wird zumeist nach der Faltung mit dem

Sobeloperator eine Schwellwert Funktion angewandt.

Wenn wir das Originalbild als Matrix A definieren, dann können wir

folgende Faltung berechnen:

Eine richtungsunabhängige Information kann man durch die

Kombination bei der Ergebnisse erhalten:

Folgendermaßen erhält man die Richtung eines Gradienten:

Sobel contour Beispiel:

23

34

18

50 200 226

148 234 180

-1

0

1

-1

-2

-1

-2

-1

0

0

2

1

0

1

0

2

0

1

Sobel mask Mx

Sobel mask My

Bildfunction V

3

3

3

3

Tx M ijxVij ; Ty M ijyVij ; T Tx2 Ty2

i 1 j 1

i 1 j 1

Tx 23 2.50 148 18 2.226 180 379

Ty 23 2.34 18 148 2.234 180 687

?

T 379 687 784.6 Tpredefined

2

2

32

Der Laplacefilter ist ein Filter zur Kantendetektion, der die Summe

der beiden reinen zweiten Ableitungen approximiert:

Bestimmt werden dabei Stellen der Grauwertkurve, an denen

die Krümmung verschwindet (sogenannte Nulldurchgänge).

Zu beachten ist, dass homogene Flächen ebenfalls in der 2.

Ableitung gleich null sind.

Er ist richtungsunabhängig und kann für ein Bild A wie folgt

beschrieben werden:

Der Prewitt-Operator ist ein Kantendetektor ähnlich dem

Sobel-Operator, nur werden bei diesem die Grauwerte in

der aktuellen Gradientenrichtung nicht zusätzlich

gewichtet.

Analog zum Sobel-Operator erhält man als Ausgabe des

Kantendetektor ein Gradientenbild in X und eines in Y

Richtung.

Der Roberts-Operator ist ein einfacher KantendetektionsAlgorithmus der Bildverarbeitung.

Hier wird die Differenz über Kreuz liegender Pixel berechnet.

Der Operator nutzt als Faltungsmatrix eine 2×2- Matrix.

Das Gradientenstärkebild ergibt sich zu

hn,m = max ( | fn,m − fn + 1,m + 1 | , | fn + 1, m − fn, m + 1 | )

RA = Sqrt [(A-C)2 + (B-D)2]

Der Kirsch-Operator ist ein nichtlinearer Kantendetektor, der als

Kantenstärke eines Bildpunktes die am stärksten ausgeprägte

Gradientenrichtung liefert.

Eine analytische Beschreibung ist wie folgt möglich:

mit den Richtungsschablonen

Der Begriff Textur beschreibt im Kontext der

digitalen Bildverarbeitung eine Bildregion,

die sich durch bestimmte Eigenschaften

auszeichnet. Diese Eigenschaften betreffen

z.B. die Verteilung von Farb- resp.

Grauwerten, sich wiederholende geometrische

Strukturen

und deren räumliche Anordnung.

In den Standardwerken der digitalen Bildverarbeitung

findet man stattdessen qualitative Beschreibungen von

Texturen:

Pratt beschreibt Textur qualitativ über die

Grobkörnigkeit.

Dabei bezieht sich die Ausprägung der

Grobkörnigkeit auf die Periode der räumlichen

Wiederholung einer lokalen Struktur.

Der IEEE-Standard 610.4-1990 beschreibt

Grauwerttexturen mit dem Satz:

"Texture is an attribute representing the spatial

arrangement of the gray levels of the pixels in

a region”.

Gonzales und Woods beschreiben Texturen

intuitiv als Maß für Eigenschaften, wie

Glattheit, Grobheit und Gleichmäßigkeit.

Hauptkategorien

natürliche und künstliche Texturen.

Künstliche Texturen sind aus Anordnungen von

Symbolen, oder besser Texeln (engl.: texture

elements), aufgebaut.

Die Texel bestehen aus einfachen geometrischen

Primitiven, wie z.B. Linien, Kreise usw., und sind vor

einem homogenen Hintergrund positioniert.

Natürliche Texturen sind generell stochastischer

Natur und lassen sich nicht einfach über Repetitionen

von Texeln beschreiben.

Neben den beiden Hauptkategorien gibt es noch die

Unterkategorien: periodisch, stochastisch, hierarchisch

und additiv.

Periodische Texturen enthalten die strukturellen

Texturen als Untermenge. Strukturelle Texturen sind

einfache, künstliche Texturen, die aus einem

homogenen Hintergrund und einfachen, periodisch

angeordneten geometrischen Objekten bestehen.

Stochastische Texturen enthalten Strukturen, die in der

Erscheinung und der Lokalisierung stochastischen

Prozessen und keiner Periodizität genügen.

Texturarten, die über Mikro- und Makrotexturen

verfügen, werden hierarchische Texturen genannt.

Additive Texturen ergeben sich aus der Überlagerung

mehrerer Texturen.

Neben der Kategorisierung lassen sich

Texturen mit den Attributen

grob, fein, glatt, körnig, wellig, gleichmßig,

ungleichmßig oder geradlinig beschreiben.

Das allgemeine Schema der Mustererkennung ist in

Abbildung 3.1 wiedergegeben. Aufgabe

der Mustererkennung ist es, ein Objekt, welches durch

ein Muster reprasentiert wird, zu erkennen und einer

Aquivalenzklasse zuzuordnen. Aquivalenzklassen werden

uber die in ihr enthaltenen Objekte resp. Muster und die

auf die Objekte resp. Muster wirkenden Transformationen

beschrieben.

Zu den auftretenden Transformationen gehören z.B.

Rotation und Translation im dreidimensionalen Raum.

Abbildung 3.3 abstrahiert den beschriebenen Vorgang

der Merkmalkonstruktion. Wird das Muster aufgrund

äußerer Einflüsse gestört, beispielsweise durch

additives Rauschen, so stellt sich die Frage, in welcher

Weise sich die Störungen des Musters auf das zu

konstruierende Merkmal auswirkt.

Eine Methode zur Konstruktion von Merkmalen ist

demnach dann robust, wenn eine Störung des Musters

innerhalb der Umgebung M nur eine Störung der

Musters in der Umgebung F zur Folge hat, und diese

möglichst gering ist.

Daraus ergibt sich mathematisch eine gewisse

Anforderung an die Stetigkeit der Berechnungsmethode

des Merkmals.

Die Größe der Störung des Musters ist in Abbildung 3.3 als Umgebung M im

Musterraum M angegeben. Alle Punkte innerhalb der Umgebung M werden

uber die Methode zur Merkmalkonstruktion auf eine Umgebung F im

Merkmalraum F abgebildet.

Es gibt eine Vielzahl von Methoden zur

Konstruktion von invarianten Merkmalen, die

sich im zugrunde liegenden theoretischen Ansatz,

der Robustheit gegenüber Störungen

und den Invarianzeigenschaften magßgeblich

unterscheiden.

An dieser Stelle seien nur zwei Methoden für

die Invariantenkonstruktion erwähnt:

Basierend auf Fourier-Deskriptoren, ist es

möglich, invariante Grauwertmerkmale zu

konstruieren .

Ein alternativer Ansatz für die Konstruktion

von 3D-Invarianten für eine Abbildungen

stellen die Zernike-Momente dar.

Nach 1000 Stunden

45000 Stunden

135000 Stunden

Nero Africa Impala

Nero Markuina

Grigio Sardu

Gris Mondaris

Erwartung

E{( xi mi )( x j m j )}

2

ij

0

11 0

Г Г , Г 0 22

0

nn

1

rij

2

ij

r 1

rij

ij

r

1

ii . jj

ij

Kovarianz Matrix

Recognition of 10 representatives of class1- GS Original

1 Color with 9Pix Motion Blur

1

10

GS Original Colour

2

0.5

GS+20% brighten

GS+40% brighten

0

9

3

-0.5

GS+60% brighten

GS+80% brighten

-1

GM Original Colour

8

4

GM+20% brighten

GM+40% brighten

7

5

6

GM+60% brighten

GM+80% brighten

Recognition of 10 representatives of class4 - GS +60%

1 brighten with 15Pix Motion Blur

1

10

2

0.5

GM Original Colour

GS+20% brighten

0

9

3

-0.5

GS+40% brighten

GS+60% brighten

-1

GS+80% brighten

8

4

GM Original Colour

GM+20%brighten

GM+40% brighten

7

5

6

GM+60% brighten

GM+80% brighten

Recognition of 10 representatives of class8 - GM + 40%

1 brighten with 25Pix Motion Blur

1

10

2

0.5

GS Original Colour

0

9

GS+20% brighten

3

-0.5

GS+40% brighten

GS+60% brighten

-1

GS+80% brighten

8

4

GM Original Colour

GM+20% brighten

GM+40% brighten

7

5

6

GM+60% brighten

GM+80% brighten