Informationstheorie und Codierung

Werbung

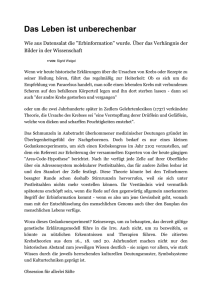

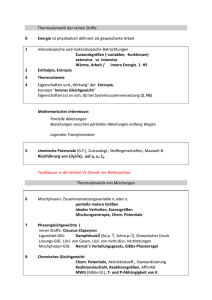

Informationstheorie und Codierung Prof. Dr.-Ing. Lilia Lajmi [email protected] Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 2 Aspekte der Quellencodierung Bei der Quellcodierung sind zwei Aspekte wichtig: 1. Oft treten Daten in einer Form auf, die sich nicht zur Übermittlung eignet. Diese Quelldaten müssen codiert werden, damit sie überhaupt übertragen werden können. Beispiele: o Digitalisierung von Sprache, Bildern, ... o Morse-Code: a = • –, b = – • • •, ... o ASCII-Code: a = 10000010, b = 10000100, ... 2. Die Daten sollen möglichst ökonomisch übertragen werden. Dazu sollen sie so gut wie möglich (möglichst ohne Informationsverlust) komprimiert werden. Man unterscheidet hier o Verlustlose Kompressionsverfahren: Originaldaten rekonstruierbar o Verlustbehaftete Kompressionsverfahren: Originaldaten nicht mehr rekonstruierbar. Verlust kann aber je nach Kompressionsrate unbemerkt bleiben 3 Motivation für die Datenkompression • • Nicht komprimierte Datenmengen sind zu groß Speicherkapazität erhöhen o Datenaufbewahrung o Z.B. CD / DVD 700 MB / 4-7 GB • Datentransport / Bandbreite von Übertragungsmedien besser nutzen o Gleichzeitige Übertragung großer Datenmengen (z.B. mehrere Sat-Kanäle über einen Transponder in DVB-S) o Schnelles Laden einzelner Dateneinheiten (VOD) o Übertragung über Kanäle: - DSL: 1-16 MBits/s - DVB: 2-8 MBit/s - GSM /UMTS/ 3G 32 kBit – 42 MBit/s 4 Datenmenge Video von SD zu HD SDTV: • 3840 x 2160 8 Mio. Pixel 576 Zeilen / 720 Spalten / 25 Vollbilder (50 Halbbilder pro sec) / 3 Byte pro Pixel (RGB) 2 Mio Pixel 576x720x25x3 MB/s Ca. 30 MB/s SDTV Digital TV Signal: 30 MB/s (ca. 240 MBit/s) über einen 3..8 MBit/s Kanal Kompression 30 .. 80 UHDTV • 2160 Zeilen / 3840 Spalten / 120 Vollbilder / 3 Byte pro Pixel (RGB) Ca. 20 GB/s *1: *2: Progressive Scan. Ist ein Videoaufnahmeverfahren, bei dem der Sensor alle Linien eines Bildes nacheinander erfasst Interleased (interpoliert). Es werden erst alle ungeraden dann alle geraden Zeilen eines Bildes erfasst, d.h. die Aufnahme erfolgt durch zwei getrennte Halbbilder (nacheinander). Ein richtiges Vollbild ergibt sich erst nach zwei Durchgängen 5 Bild aus Wikipedia Farbtiefe 8 Bit Prinzipien der Kompression Nachrichten-Ebene Nachrichten-Ebene Prädiktive codierung Redundanz-Reduktion Irrelevanz-Reduktion • Verzicht auf mehrfach vorhandene Info (Redundanz) • • Nutzt Ähnlichkeit im Signal aus Verzicht auf nicht erkennbare Signalanteile (Irrelevanz) • Alle Infos müssen eindeutig wiederherstellbar sein Nutzt psychovisuelle oder psychoakustische Maskierungseffekte aus • Qualität der Info ist umgekehrt proportional zur Größe der Zieldatei • Verlustbehaftet irreversible • Kompressionsgewinn: 16 • Quantisierung (angepasst an Wahrnehmungsvermögen) Redundant • Interessant Irrelevant Stärkere Quantisierung • Verlustfrei reversible (Bspl. JPEG) • Kompressionsgewinn: 2 • Prädiktion, DPCM Bitrate (PCM) Kompressionsgewinn = Bitrate nach Kompression 6 Datenkompression Datenkompression Verlustlose Kompression HuffmanCodierung LauflängenCodierung (RLE) ShannonCodierung Arithmetische Codierung Informationsgehalt, Entropie, Redundanz Verlustbehaftete Kompression AudioKompression MP3 BildKompression JPEG VideoKompression MPEG Psychoakustische und Psychovisuelle Irrelevanz 7 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie 2.2.1 Diskrete Quelle ohne Gedächtnis 2.2.2 Nachricht / Information 2.2.3 Nachrichtengehalt / Informationsgehalt 2.2.4 Entropie 2.2.5 Redundanz der Quelle 2.2.6 Mittlere Codewortlänge 2.2.7 Codierung nach Fano Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 8 2.2 Shannon´sche Informationstheorie 2.2.1 Diskrete Quelle ohne Gedächtnis Eine diskrete Informationsquelle ist charakterisiert durch: • Alphabet , ,…, , sind die möglichen Symbole der Quelle • Wahrscheinlichkeitsverteilung , ,…, der einzelnen Symbole: ∈ 0,1 1 0 , • • Für die Quelle wird folgende Darstellung verwendet: Eine Nachricht der Quelle ist ein Wort … • Diesem Wort ist folgende Wahrscheinlichkeit zuzuordnen, falls die Quelle kein Gedächtnis* hat: … mit ∈ . Bemerkung: In der Realität haben Quellen meist ein Gedächtnis, z.B. Textübertragung. Zur Vereinfachung wird Gedächtnis oft weggelassen. *Eine Quelle hat kein Gedächtnis falls die Einzelsymbole dieser Quelle statistisch unabhängig voneinander 9sind Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie 2.2.1 Diskrete Quelle ohne Gedächtnis 2.2.2 Nachricht / Information 2.2.3 Nachrichtengehalt / Informationsgehalt 2.2.4 Entropie 2.2.5 Redundanz der Quelle 2.2.6 Mittlere Codewortlänge 2.2.7 Codierung nach Fano Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 10 2.2 Shannon´sche Informationstheorie 2.2.2 Nachricht, Information Definition der beiden Begriffe und deren Bedeutung für die Informationstheorie Einfaches Nachrichtenübertragungssystem Quelle Quelle und Senke bestehen über den gleichen Symbolvorrat Nachricht Kanal Senke Senke wertet Symbole aus und interpretiert die Nachricht Information • Ist eine Symbolfolge aus dem Symbolvorrat der Quelle mit beliebiger Darstellung: Sprache, Bild, Symbol, Text … • Die Interpretation der Nachricht ist rein subjektiv. Nachricht kann bei verschiedenen Empfängern zu unterschiedlichen Informationen Führen • Entsteht auf der Seite der Quelle • Information: Entsteht also auf der Seite der Senke, wenn der Nachrichtengehalt der Senke bis dahin nicht bereits vollständig bekannt war Kenntnis der Senke wird 11 vergrößert. 2.2 Shannon´sche Informationstheorie 2.2.2 Nachricht, Information • Es entsteht auf der Senke-Seite keine Information (die Kenntnis der Senke nicht vergrößert), wenn z.B. o Die Darstellung der Nachricht der Senke völlig unbekannt ist: z.B. keine Übereinstimmung der verwendeten Symbolvorräte hier Spricht man von Irrelevanz o Nachricht aus den vorangegangenen Symbolen vorhersehbar ist hier spricht man von Redundanz Nachricht redundant nicht redundant irrelevant Verwendete Symbole sind bei Quelle und Senke verschieden relevant Vorhersage möglich Information Die Bedeutung (oder der Informationsgehalt) einer Nachricht für den Empfänger ist umso größer, je weniger die gesendete Nachricht vorhersehbar ist 12 2.2 Shannon´sche Informationstheorie • Die Informationstheorie ist älter als die Codierungstheorie o Begonnen 1928 mit Arbeiten von Hartley o Begründet 1948 von Shannon Die Informationstheorie • beantwortet Fragen zu den theoretischen Grenzen von technischen Nachrichtensystemen • ist wichtig für Quellencodierung (minimale mittlere Codewortlänge) und Kanalcodierung (Kanalkapazität) 13 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie 2.2.1 Diskrete Quelle ohne Gedächtnis 2.2.2 Nachricht / Information 2.2.3 Nachrichtengehalt / Informationsgehalt 2.2.4 Entropie 2.2.5 Redundanz der Quelle 2.2.6 Mittlere Codewortlänge 2.2.7 Codierung nach Fano Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 14 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt • • Der Informationsgehalt beschreibt die Bedeutung einer Nachricht Schwerpunkt der Shannon‘schen Informationstheorie Wie kann man den Informationsgehalt einer Nachricht mathematisch erfassen? Quelle ,.., Symbolfolge Quelle sendet Symbolfolgen durch Auswahl von Elementarsymbolen Quelle hat insgesamt Darstellung binär mit (hier ) z.B. Senke Bits Entscheidet, welches Symbol vermutlich übertragen wurde. Symbole z.B. 4 Symbole und • • = Nachrichtenmenge pro Symbol (hier 2 Mit Bits pro Symbol kann man insgesamt / ) Symbole darstellen Entscheidungsgehalt beschreibt die Nachrichtenmenge (Nachrichtengehalt) pro Symbol 15 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt Beispiel Eine Quelle verfügt über 40 alphanumerische Symbole d.h.: • 26 Buchstaben A, B, C, …, Z • 3 Umlaute Ä, Ö und Ü • Zahlen 0, 1, …, 9 • 1 Leerzeichen 1. Wie groß ist der Nachrichtengehalt der Quelle? , / 2. Wie viele Bits werden für eine binäre Darstellung (Codierung) benötigt? Für die binäre Darstellung sind somit jeweils 6 Bits pro Symbol notwendig. 16 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt Aufgabe 2-1 Quelle verfügt über sämtliche möglichen Symbole, die aus zweidimensionalen Bildern mit der räumlichen Auflösung von 1000x1000 Bildpunkten mit jeweils 8 Helligkeitsstufen gebildet werden. 1. Wie groß ist der Nachrichtengehalt 0 ( )? 2. Wie viele Symbole hat die Quelle ( ?)? Lösung 1. Ein Symbol ist ein Bild mit 1000 x 1000 Pixelpunkte. 1 Pixelpunkt wird mit 3 Bits repräsentiert (da 8 Stufen) Nachrichtengehalt 0 : Nachrichtenmenge in Bits pro Symbol (Bild) 1000 1000 3 3 / 2. = Anzahl der möglichen Symbole mit jeweils Bits 2 2 · mögliche Symbole 18 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt • • Der Nachrichtengehalt oder Entscheidungsgehalt beschreibt die Nachrichtenmenge eines Symbols und berücksichtigt aber noch nicht die Tatsache, dass die Quelle Symbole mit unterschiedlicher Wahrscheinlichkeiten auswählt. Der Informationsgehalt eines Symbols ist aber abhängig von der Auftrittswahrscheinlichkeit dieses Symbols in der Quelle. Je unwahrscheinlicher ein Symbol auftritt, desto höher ist die darin enthaltene Information (antiproportional). Beispiel: Eine Quelle enthält 4 Symbole : 1, 2, 3und 4 mit folgenden Wahrscheinlichkeiten: 1; 0 Es gibt empfängerseitig keine Information, da man vorher weiß, dass übertragen werden wird. 1 19 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt sei eine Quelle mit den Symbolen , 1⋯ ist die Auftrittswahrscheinlichkeit des Symbols Annahme: ∀ , • Tritt ein Symbol mit geringer Wahrscheinlichkeit auf, dann gibt es mehr Information (mehr Überraschung) als bei einem Symbol mit höherer Auftrittswahrscheinlichkeit Definition nach Shannon: Bei einer diskreten Quelle ohne Gedächtnis (Symbole unabhängig voneinander) ist der Informationsgehalt , der durch das mit der Wahrscheinlichkeit 0 eingetretene Symbol geliefert wird, definiert durch: 20 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt Schlussfolgerungen • Ein Symbol, das immer auftritt (Wahrscheinlichkeit 1 100%) liefert keine Information • Ein Symbol, das auftritt, obwohl es die Wahrscheinlichkeit 0 hat, liefert unendliche Information (ist eine Sensation) Bei zwei unabhängigen aufeinanderfolgenden Ereignissen , , · , und gilt 21 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt Ansätze für a. reelles nicht negatives Maß b. ist eine stetige, monoton fallende Funktion der Auftretenswahrscheinlichkeit c. Bei zwei unabhängigen aufeinanderfolgenden Ereignissen und ergibt sich der Informationsgehalt aus der Summe der Informationen der beiden Ereignissen , 22 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt Beispiel Sei eine diskrete Quelle ohne Gedächtnis mit 2 Symbolen identischer Wahrscheinlichkeiten . beschreibt die Anzahl der Bits pro Symbol = der Nachrichtengehalt Wie groß ist der Informationsgehalt eines Symbols 23 2.2 Shannon´sche Informationstheorie 2.2.3 Nachrichtengehalt / Informationsgehalt Beispiel Sei eine diskrete Quelle ohne Gedächtnis mit 2 Symbolen identischer Wahrscheinlichkeiten . beschreibt die Anzahl der Bits pro Symbol = der Nachrichtengehalt Wie groß ist der Informationsgehalt eines Symbols Lösung Es gilt immer: ∑ 1⟹ 2 Fazit: · 1 ⟹ ⟹ Für Symbole gleicher Wahrscheinlichkeit gilt: Informationsmenge = Nachrichtenmenge Allgemein gilt aber: 24 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie 2.2.1 Diskrete Quelle ohne Gedächtnis 2.2.2 Nachricht / Information 2.2.3 Nachrichtengehalt / Informationsgehalt 2.2.4 Entropie 2.2.5 Redundanz der Quelle 2.2.6 Mittlere Codewortlänge 2.2.7 Codierung nach Fano Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 25 2.2 Shannon´sche Informationstheorie 2.2.4 Die Entropie • Im allgemeinen interessiert man sich in der Informationstheorie weniger für den Informationsgehalt eines einzelnen Quellensymbols, sondern für die im Mittel pro Symbol gelieferte Information (den Erwartungswert). Definition: Gegeben sei eine diskrete Quelle mit den Symbolen 1, ⋯ und der dazugehörigen Wahrscheinlichkeiten 1, ⋯ Die Entropie von ist der mittlere Informationsgehalt von (in bit/Symbol) ist definiert durch: · · Bemerkung: Die Entropie ist allein von der Wahrscheinlichkeitsverteilung der Quelle abhängig und nicht vom Alphabet selbst 26 2.2 Shannon´sche Informationstheorie 2.2.4 Die Entropie Beispiel: 0,4 0,1 0,2 xi pi 0,3 Wie groß ist die Entropie der Quelle? Antwort: Für die Entropie gilt: , · , · , , · , , · , , · , / 27 2.2 Shannon´sche Informationstheorie 2.2.4 Die Entropie Beispiel einer binären Quelle Eine binäre Quelle verfügt über zwei Symbole wahrscheinlichkeiten und Für die Entropie gilt: · · • max 1 2 / • 1und 2 mit den Auftritts- 1 · Diese Funktion nennt man die ShannonFunktion Maximum bei 0,5: Gleiche Verteilung der Symbole. In diesem Fall gilt 28 2.2 Shannon´sche Informationstheorie 2.2.4 Die Entropie Beispiel: Quelle mit gleichverteilten Symbolen sei eine Quelle mit verschiedenen gleichverteilten Symbolen den Auftrittswahrscheinlichkeiten 1 , 1⋯ Für die Entropie 1… mit gilt: · · · Für die Quelle ergibt sich für das Nachrichtengehalt: Somit gilt: Bei gleichverteilten Symbolen ist der Entscheidungsgehalt identisch mit dem mittleren Informationsgehalt (Entropie ). Damit wird gleichzeitig die maximale Entropie für alle Quellen mit verschiedenen Symbolen erreicht 29 2.2 Shannon´sche Informationstheorie 2.2.4 Die Entropie Maximale Entropie Gegeben sei eine diskrete Quelle mit den Symbolen , … , binären Alphabet und den zugehörigen Wahrscheinlichkeiten , über einem …, • Unter allen Möglichkeiten zur Variation von , 1… ist die Entropie von maximal, wenn alle identisch sind, d.h. alle Symbole die gleiche Auftrittswahrscheinlichkeit haben. • Diese maximale Entropie (bei festem Alphabet und insbesondere festem N) bezeichnet und heißt Entscheidungsgehalt. wird mit 30 2.2 Shannon´sche Informationstheorie 2.2.4 Die Entropie Minimale Entropie Gegeben sei eine diskrete Quelle mit den Symbolen , … , binären Alphabet und den zugehörigen Wahrscheinlichkeiten , über einem …, • Unter allen Möglichkeiten zur Variation von , 1… ist die Entropie von minimal, wenn ein Extremfall mit 1 und ⋯ 0 auftritt, d.h. es wird immer das selbe Symbol gesendet. • Es gilt in diesem Fall 31 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie 2.2.1 Diskrete Quelle ohne Gedächtnis 2.2.2 Nachricht / Information 2.2.3 Nachrichtengehalt / Informationsgehalt 2.2.4 Entropie 2.2.5 Redundanz der Quelle 2.2.6 Mittlere Codewortlänge 2.2.7 Codierung nach Fano Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 32 2.2 Shannon´sche Informationstheorie 2.2.5 Redundanz der Quelle Die Redundanz einer Quelle stellt einen Informationsgehalt dar mit der Dimension Bit/Symbol, der von einer gegebenen Quelle aufgrund der speziellen Auftrittswahrscheinlichkeiten der Symbole nicht vollständig ausgenutzt wird : Redundanz der Quelle : Entscheidungsgehalt Entropie der Quelle : • Wenn alle Symbole gleich wahrscheinlich auftreten gilt: 0 33 2.2 Shannon´sche Informationstheorie 2.2.5 Die Redundanz der Quelle Beispiel: 0,4 0,1 0,2 0,3 ? Wie groß ist die Redundanz der Quelle Antwort : Für die Entropie gilt: , 4 2 Für die Redundanz der Quelle gilt also: , Redundanz Information 34 Beispiel für die Redundanz Redundanz in Texten Die folgenden Beispiele zeigen, dass die deutsche Sprache erhebliche Redundanz enthält, denn trotz der erheblichen Buchstabenvertauschungen innerhalb der Wörter bzw. Verstümmelungen kann man die Texte rekonstruieren. Gmäeß eneir Sutide eneir elgnihcesn Uvinisterät ist es nchit witihcg, in wlecehr Rneflogheie die Bstachuebn in eneim Wrot snid; das ezniige was wcthiig ist, ist dsas der estre und der leztte Bstabchue an der ritihcegn Pstoiion snid. Der Rset knan ein ttoaelr Bsinöldn sien, tedztorm knan man ihn onhe Pemoblre lseen. Das ist so, wiel wir nciht jeedn Bstachuebn enzelin leesn, snderon das Wrot als gseatems. Das ghet wicklirh! 35 2. Quellencodierung 2.1 2.2 2.3 2.4 Motivation Shannon´sche Informationstheorie 2.2.1 Diskrete Quelle ohne Gedächtnis 2.2.2 Nachricht / Information 2.2.3 Nachrichtengehalt / Informationsgehalt 2.2.4 Entropie 2.2.5 Redundanz der Quelle und des Codes 2.2.6 Mittlere Codewortlänge 2.2.7 Codierung nach Fano Binärcodierung nach Shannon Huffman-Codierung 36 2.2 Shannon´sche Informationstheorie 2.2.6 Mittlere Codewortlänge Eine erste Zielsetzung der Informationstheorie besteht im Entwurf von günstige Codierungen für eine gegebene Quelle. Eine Quelle wird als günstig bezeichnet, wenn die resultierende mittlere Codewortlänge möglichst kurz bzw. minimal ist. • • • • Eine Quelle enthält verschiedene Symbole Jedem Quellzeichnen wird ein Binärcode zugeordnet. sei die Codewortlänge des Binärcodes für ist die Mittlere Codewortlänge der Quelle in Bit/Symbol (mathematischer erwartungswert). Es gilt: · ist die entscheidende Größe zur Charakterisierung der Effektivität einer Codierung Beispiel: Der ASCII-Code ist ein Blockcode der Länge 8 37 2.2 Shannon´sche Informationstheorie 2.2.6 Mittlere Codewortlänge Redundanz eines Codes Die Redundanz eines Codes ist ein Maß dafür wie viele Daten über die eigentliche Information (bzw. Entropie) hinaus zu übertragen sind Die Redundanz eines Codes ( ) ergibt sich aus der Differenz zwischen mittlere Codewortlänge und Entropie der Quelle. 38 Aufgabe 2-2 Eine Quelle enthält 4 Symbole 1. Berechnen Sie: Den Entscheidungsgehalt Die Entropie Die Redundanz der Quelle 2. Die Quelle wird mit einer optimalen Codewortlänge codiert (die Codewortlänge soll an den Informationsgehalt angepasst werden Berechnen Sie Die Codewortlänge pro Symbol (Wie lauten die Codewörter ? ) Die mittlere Codewortlänge Die Redundanz des Codes 39 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie 2.2.1 Diskrete Quelle ohne Gedächtnis 2.2.2 Nachricht / Information 2.2.3 Nachrichtengehalt / Informationsgehalt 2.2.4 Entropie 2.2.5 Redundanz der Quelle 2.2.6 Mittlere Codewortlänge 2.2.7 Codierung nach Fano Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 40 2.2 Shannon´sche Informationstheorie 2.2.7 Codierung nach Fano • Binäre Codierungen lassen sich durch Binärbäume darstellen. Jedes Codierte Symbol entspricht einem Blatt dieses Binärbaumes. • Problem: Wie erstellt man einen möglichst guten Code bzw. Binärbaum? Dazu gibt es unterschiedliche Algorithmen zur Konstruktion dieser Bäume Die Fano-Codierung ist eine Möglichkeit: Relativ einfacher Ansatz für eine effektive binäre Codierung einer Quelle. 41 2.2 Shannon´sche Informationstheorie 2.2.7 Codierung nach Fano Zu codieren: Quelle mit Symbolen mit den Wahrscheinlichkeiten 1. Schritt • Zu Codierende Symbole der Quelle werden so geordnet, dass für die Wahrscheinlichkeiten gilt: ⋯ 2. Schritt • Symbole werden – unter Beibehaltung der Ordnung – in 2 Teilmengen aufgeteilt, dass beide Teilmengen möglichst gleiche Wahrscheinlichkeit besitzen (beim ersten Durchlauf jeweils möglichst 0,5) 3. Schritt • Die beiden Teilmengen werden (für jedes in der Teilmenge enthaltene Symbol) codiert mit: 0 (für die obere Hälfte) und 1 (für untere Hälfte). 4. Schritt • Sind alle Teilmengen einelementig Codierung fertig. • Falls nicht: Fortsetzung mit 2. Schritt für jede andere Teilmenge. 42 2.2 Shannon´sche Informationstheorie 2.2.7 Codierung nach Fano Beispiel: 0,4 0,1 0,2 0,3 Sortierung: A 0,4 0 0 D 0,3 0 10 D C 0,2 0 110 C 1 111 B 1 1 B 0,1 A 43 2.2 Shannon´sche Informationstheorie 2.2.7 Codierung nach Fano Beispiel: 0,4 0,1 0,2 0 0,3 Zugehöriger Baum 0 1 A 10 D 110 C 111 B A 0 1 D 0 C 1 B 44 Aufgabe 2-4 Erstellen Sie jeweils den Codebaum und Code-Tabelle. Geben Sie für jedes Symbol die Codierung an und berechnen Sie die mittlere Codewortlänge 1. 2. Zeigen Sie, dass es hier nach dem Fano drei unterschiedliche mögliche Codierungen gibt und dass die Fano-Codierung nicht immer optimal ist 46 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie Binärcodierung nach Shannon 2.3.1 Das shannon´sche Codierungstheorem 2.3.2 Codierung nach Shannon 2.3.3 Beispiel Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 47 2.3 Binärcodierung nach Shannon 2.3.1 Das Shannon´sche Codierungstheorem Shannon fand einen Zusammenhang zur Abschätzung der mittleren Codewortlänge eines Codes für eine diskrete Quelle Satz 1: Für Jede Quelle und jede beliebige zugehörige Binärcodierung mit Präfix-Eigenschaft ist die zugehörige mittlere Codewortlänge nicht kleiner als die Entropie Es gilt also: Die Entropie gibt also nicht nur den mittleren Informationsgehalt der Quelle, sondern gleichzeitig auch den minimalen Codieraufwand für eine gegebene Quelle. Beweis des Theorems: s. Buch Rohling 48 2.3 Binärcodierung nach Shannon 2.3.1 Das Shannon´sche Codierungstheorem Satz 2: Für eine beliebige Quelle ohne Gedächtnis kann eine Codierung gefunden werden, so dass die mittlere Codewortlänge kleiner ist als Es gilt also: Insgesamt kann also - laut Shannon - eine binäre Codierung gefunden werden mit einer mittleren Codewortlänge , für die gilt: Beweis des Theorems: s. Buch Rohling 49 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon´sche Informationstheorie Binärcodierung nach Shannon 2.3.1 Das Shannon´sche Codierungstheorem 2.3.2 Codierung nach Shannon 2.3.3 Beispiel Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 50 2.3 Binärcodierung nach Shannon 2.3.2 Codierung nach Shannon Grundlagen: Binäre Darstellung von Brüchen Brüche werden durch binäre Nachkommastellen dargestellt, die den negativen Potenzen von 2 entsprechen Binär 1 0,1 0,01 0,001 Dezimal … Bruch Beispiel: … , , 0,0000 ⋯ ⟹ 0 , ä ⟹ 1 · 2 ⟹ ⟹ 0 , , 0·2 1·2 . 51 2.3 Binärcodierung nach Shannon 2.3.2 Codierung nach Shannon Beweis des Codierungstheorems durch Konstruktion des Codes. Zu Codieren ist eine Quelle mit Symbolen und zugehörigen Wahrscheinlichkeiten 1. Schritt Die Symbole der Quelle werden nach ihren Wahrscheinlichkeiten sortiert (Kleinste nach unten) ⋯ 2. Schritt Die mittlere Codewortlänge wird abgeschätzt: Jedem Symbol mit Auftrittswahrscheinlichkeit wird eine Codewortlänge zugeordnet, so dass es gilt: : Informationsgehalt des Symbols Beispiel: 0,19 ⟹ 2,395 ⟹ 3 52 2.3 Binärcodierung nach Shannon 2.3.2 Codierung nach Shannon 3. Schritt Für jeden Index wird die akkumulierte Auftrittswahrscheinlichkeit Also gilt: 0; ; ; berechnet. … Es gilt nach wie vor die Sortierung aus Schritt 1. (Aufsummieren von der Liste von oben nach unten) 54 2.3 Binärcodierung nach Shannon 2.3.2 Codierung nach Shannon 4. Schritt Berechnung des Codewortes für jeden Index Durch Binärdarstellung von und weglassen aller Nachkommastellen nach Beispiel: Zu codieren ist 0,22; 0,22 0,19 ⟹ 0 0 3 (Beispiel aus Schritt 2) 0,125 0,0625 0,03125 ⋯ Binärdarstellung: 0,00111 Binärcode 001 Diese Binärcodierung erfüllt die Präfix-Eigenschaft und kann somit als Binärbaum dargestellt werden 55 2. Quellencodierung 2.1 2.2 2.3 2.4 Motivation Shannon´sche Informationstheorie Binärcodierung nach Shannon 2.3.1 Das Shannon´sche Codierungstheorem 2.3.2 Codierung nach Shannon 2.3.3 Beispiel Huffman-Codierung 56 2.3 Binärcodierung nach Shannon 2.3.3 Beispiel i Binärcode 1 0,22 2,184 3 0,00 0,000… 000 2 0,19 2,395 3 0,22 0,00111 001 3 0,15 2,736 3 0,41 0,01101 011 4 0,12 3,058 4 0,56 0,10001… 1000 5 0,08 3,643 4 0,68 … 1010 6 0,07 3,836 4 0,76 1100 7 0,07 3,836 4 0,83 1101 8 0,06 4,058 5 0,90 11100 9 0,04 4,643 5 0,96 11110 Wahrscheinlichkeit höher Code kürzer 0,41 Binärzahl 0,56 0,25 0,5 0,125 0 0 0,03125 0 0,03125 ⋯ ⟹ 0,01101 ⋯ & Präfix-Code · , / ⋯ ⟹ 0,10001 ⋯ 57 2.3 Binärcodierung nach Shannon 2.3.3 Beispiel Binärbaum Mit der Shannon-Codierung werden nicht sämtliche Endknoten innerhalb des Baumes durch gültige Codewörter belegt Die Shannon-Codierung ist offenbar nicht optimal: Möglichkeit zur Reduzierung der Codewortlänge ist unmittelbar gegeben. Für das Beispiel gilt: 3,54 9 3,17 ; H 2,703 Es gilt also 58 2.3 Binärcodierung nach Shannon Besonderheiten der Shannon-Codierung Die Codewortlängen können direkt aus bzw. berechnet werden Umsortieren nicht erforderlich (es wird nur am Anfang sortiert) Mittlere Codewortlänge zwar meist kleiner als bei Fano-Codierung aber keineswegs minimal Es gibt noch Verkürzungsmöglichkeit. Beispiel aus dem Kapitel Fano Codierung 0,4 0,1 0,2 0,3 : Die Fano-Codierung ergibt: Daraus ergibt sich eine mittlere Codewortlänge von Für die Entropie gilt: H 1,8463 / Die Redundanz des Codes ist 0,0537 0 10 110 111 1,9 / 59 2.3 Binärcodierung nach Shannon 2.3.3 Beispiel Beispiel aus dem Kapitel Fano Codierung 0,4 0,1 0,2 0,3 Aufgabe 2-5 Codieren Sie die Quelle mit Shannon und ermitteln Sie 1. Die mittlere Codewortlänge 2. Die Redundanz des Codes Vergleichen Sie das das Ergebnis mit dem Fano-Code 60 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon‘sche Informationstheorie Binärcodierung nach Shannon Huffman-Codierung 2.4.1 Prinzip 2.4.2 Algorithmus 2.4.3 Anwendung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 61 2.4 Huffman-Codierung 2.4.1 Prinzip • Das letzte Beispiel der Shannon-Codierung zeigte, dass es Codes mit kürzeren mittleren Codewortlängen gibt. • Huffman (1952, Schüler von Shannon) löst die Frage nach der Konstruktion eines optimalen Codes mit minimaler Codewortlänge zur Codierung einer Quelle mi Symbolen. Grundidee • Alle Endknoten werden besetzt, sonst stets Verkürzungsmöglichkeiten • Kurze (lange) Codeworte für häufige (seltene) Symbole • Code rekursiv der Binärbaum wird von den Endknoten aus entwickelt. Problem • Erkennung der Codewortgrenzen: Kein Codewort darf Anfang eines anderen Codewortes sein (Präfix freier Code) Lösung: • Realisierung mit Binärbaum: Bedingung wird automatisch erfüllt, wenn Bitfolgen der Codeworte durch binären Baum gewonnen werden. 62 2.4 Huffman-Codierung 2.4.1 Prinzip Beispiel: Code {00, 01, 100, 101, 11} • Präfix-freier Code: kein Codewort ist Anfang eines anderen Codewortes • Codebaum wird von Unten nach Oben aufgebaut • Liefert bei statistisch unabhängigen Symbolen den (nachweisbar) kürzesten Code! Codebaum 1 1 0 0 0 11 01 1 101 00 0 100 63 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon‘sche Informationstheorie Binärcodierung nach Shannon Huffman-Codierung 2.4.1 Prinzip 2.4.2 Algorithmus 2.4.3 Anwendung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 64 2.4 Huffman-Codierung 2.4.2 Algorithmus A7 A2 A1 A1 A5 A4 A7 A8 A1 A4 A1 A6 ..... Wort aus dem Alphabet der Quelle Nein Häufigkeitsverteilung Nach Häufigkeit sortieren Symbole der Quelle nach ihren Wahrscheinlichkeiten sortieren, kleinste nach unten A1 A2 A3 A4 A5 A6 A7 A8 0.510 0.015 0.010 0.182 0.104 0.131 0.047 0.001 A1 A4 A6 A5 A7 A2 A3 A8 0.510 0.182 0.131 0.104 0.047 0.015 0.010 0.001 Nur noch 2 Symbole Reduktionsschritt Zwei Symbole mit den kleinsten Wahrscheinlichkeiten zu einem neuen Symbol (Knoten) zusammenfassen. (Neue Wahrscheinlichkeit = Summe) A1 0.510 A4 0.182 A6 0.131 A5 0.104 A7 0.047 A2 0.015 An1 0.011 CodeZuteilung Ggf. die Liste neu sortieren 65 2.4 Huffman-Codierung 2.4.2 Algorithmus Code-Zuteilung nach Häufigkeit S 1 0 A1 A1 0.510 A4 0.182 A6 0.131 A5 0.104 A7 0.047 A2 0.015 A3 0.010 A8 0.001 0.510 0.182 0.131 0.104 0.047 0.015 0.011 0.510 0.182 0.131 0.104 0.047 0.026 0.510 0.182 0.131 0.104 0.073 0.510 0.182 0.177 0.131 0.510 0.308 0.182 0.510 0.490 0.490 0.510 0 1 0.308 A4 1 0 A6 0.177 1 0.104 1 00 010 0111 01101 011001 0110001 0110000 0.073 A5 0.047 0.131 0 0 1 A1 0.510 A4 0.182 A6 0.131 A5 0.104 A7 0.047 A2 0.015 A3 0.010 A8 0.001 0.182 0.026 A7 0 1 A2 0.015 0.011 1 0 A3 A8 0.010 0.001 66 2.4 Huffman-Codierung 2.4.2 Algorithmus Decodierer S 0 1 A1 0.510 A4 0.182 A6 0.131 A5 0.104 A7 0.047 A2 0.015 A3 0.010 A8 0.001 1 00 010 0111 01101 011001 0110001 0110000 0.510 Zu decodieren: A1 0 0.308 A4 1 0.104 A6 Ein Symbol ist gefunden, wenn ein Blatt erreicht wurde 0.073 0 1 0.047 0.131 0 A5 Baumrepräsentation 0.182 0 0.177 1 000111010101001010001 A4 A5 ..... 0.490 1 0.026 A7 1 0 A2 0.015 0.011 1 0 A3 A8 0.010 0.001 67 Beispiel ohne Huffman-Codierung • A1 A2 A3 A4 A5 A6 A7 A8 0.510 0.015 0.010 0.182 0.104 0.131 0.047 0.001 Entropie der Nachrichtenquelle: px i 0.51000.01500.01000.18200.10400.13100.04700.0010 I x i 0.97146.05896.64392.45803.26532.93244.41129.9658 px i I x i 0.49540.09090.06640.44740.33960.38410.20730.0100 px I x 2.0411bit i i Entropie • Binäre Codierung mit 3 Bit / Symbol: H0 ld 8 3 Bit R H0 H 3 2.0411 0.9589Bit 68 2.4 Huffman-Codierung • Codewortlänge eines Symbols: Lx i 1234567 7 8 • Mittlere Codewortlänge: L px i Lx i 2.94Bit i 1 besser als binär RC L H 2 ,94 2,0411 0,8989bit aber trotzdem nicht optimal! • Redundanz des Codes: • Huffman-Codierung ist nur dann optimal (Redundanz=0), wenn die Codewortlänge eines Symbols gleich dem Informationsgehalt des A1 0.510 1 Symbols ist. 1 ld px i Lx i I x i ld p x i A4 0.182 A6 0.131 A5 0.104 A7 0.047 A2 0.015 A3 0.010 A8 0.001 00 010 0111 01101 011001 0110001 0110000 69 2.4 Huffman-Codierung 2.3.3 Beispiel Beispiel aus den Kapiteln Fano/Shannon Codierung 0,4 Entropie • 0,1 0,2 0,3 1,8463 / Fano-Codierung ergibt: → 0; o Mittlere Codewortlänge 1,9 0,0537 o Redundanz des Codes ist • o Redundanz des Codes ist • → 00; Shannon-Codierung ergibt: o Mittlere Codewortlänge → 10; → 110; → 111 / → 01; → 101; → 1110 2,4 0,5537 / Huffman-Codierung ergibt ??? 70 2.4 Huffman-Codierung Anwendungen • Huffman-Code ist das Standard-Verfahren zur Kompression von Datenquellen mit Einzelsymbolen bekannter Wahrscheinlichkeit. • Das Verfahren ist z.B. eine Basis für Datenkompression bei o o o o o • ZIP GZIP PDF JPEG (MPEG) MP3 Die Huffman-Codierung wird typischerweise in Verbindung mit anderen Verfahren eingesetzt. 71 2.4 Huffman-Codierung 2.4.3 Eigenschaften Die Huffman-Codierung ist in mehrfacher Hinsicht nicht eindeutig: • Die Zuordnung der Symbole 0 und 1 zu den beiden Quellsymbolen ist für jeden Schritt willkürlich. Dies hat aber keinen Einfluss auf die mittlere Codewortlänge. • Sind zwei Wahrscheinlichkeiten gleich (u.U auch nach Zusammenfassungen), ist die Auswahl willkürlich andere Reihenfolge • Es kann also zu anderen Codewortlängen kommen, die mittlere Codewortlänge bleibt aber unverändert. • Bei der Huffman-Codierung wird jedem Einzelsymbolen einer Quelle ein Binärcode zugeordnet. Die Quelle wird anhand der Auftrittswahrscheinlichkeiten der Einzelsymbole betrachtet. In der praktischen Anwendung werden von der Quelle Einzelsymbole nacheinander aus dem Symbolvorrat ausgewählt und zu Symbolketten (Wörtern) zusammengesetzt. 72 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon‘sche Informationstheorie Binärcodierung nach Shannon Huffman-Codierung 2.4.1 Prinzip 2.4.2 Algorithmus 2.4.3 Anwendung Codierung von Wörtern anstelle von Einzelsymbolen 2.5.1 Verbundwahrscheinlichkeit und Verbundentropie einer Quelle ohne Gedächtnis 2.5.2 Erweiterung des Shannon´she Codierungstheorem Diskrete Quelle mit Gedächtnis 73 2.5 Codierung von Wörtern anstelle von Einzelsymbolen • Das Shannon´sche Codierungstheorem liefert eine Abschätzung für die mittlere Codewortlänge eines Codes für eine binäre Quelle ohne Gedächtnis bei der Codierung der Einzelsymbolen. Frage: Ist eine Verringerung der mittleren Codewortlänge möglich durch eine Codierung von Wörtern anstelle von Einzelsymbolen? • • • Betrachten wir eine Quelle . Die Symbole der Quelle sind statistisch unabhängig voneinander. Codiert werden Wörter und keine Einzelsymbole. Ein Wort ist eine … … mit ∈ . Symbolkette aus der Quelle. Diesem Wort ist folgende Wahrscheinlichkeit zuzuordnen: 74 2.5 Codierung von Wörtern 2.5.1 Verbundwahrscheinlichkeit Definition: Gegeben seien zwei diskrete Quellen , ,…, und , ,…, Die Wahrscheinlichkeit für das Auftreten des kombinierten Ereignisses (Ereignispaares) von und , heißt Verbundwahrscheinlichkeit , Wenn die Symbole unabhängig voneinander ausgewählt werden, so gilt für die Verbundwahrscheinlichkeit: , · Wie groß ist dann die Verbundentropie , aus und unabhängig voneinander sind? *, wenn die Elemente der Paare Gelegentlich wird statt , auch geschrieben setzt sich aus Paaren von Elementen aus den beiden Quellen Eine Quelle und zusammen. 75 2.5 Codierung von Wörtern 2.5.1 Die Verbundentropie Sei , die Verbundentropie für eine Quelle, die sich aus Paaren von zusammensetzt. Die Elemente der Paare aus und sind unabhängig voneinander. Es gilt: , , · · · und , · · · , · 76 2.5 Codierung von Wörtern 2.5.1 Die Verbundentropie Beispiel für unabhängige Quellen: ; : Mann und : Frau ∝ ;∝: Evangelisch und : Katholisch 2 1 3 8 ∝ 3 8 8 3 4 ∝ 3 8 3 8 1 8 8 3 1 8 1 8 8 1 8 8 0,811 1,811 1,811 / 1,811 / Solange die Quellen unabhängig sind, kann man die Entropien addieren 77 2.5 Codierung von Wörtern 2.5.1 Verbundentropie Spezialfall: • Wort besteht aus M statistisch unabhängigen Einzelsymbolen einer Quelle • Die Verteilung der Einzelsymbole ist identisch , d.h. In diesem Fall gilt: , ,⋯, · Dieser Zusammenhang wird ausgenutzt, um den Codierungsaufwand gegenüber dem Shannon´schen Codierungstheorem weiter zu reduzieren, in dem nicht Einzelsymbole sondern Symbolketten codiert werden 78 2.5 Codierung von Wörtern 2.5.2 Erweiterung des Codierungstheorems • • • • Wir betrachten Symbolketten bestehend aus jeweils statistisch unabhängigen Einzelsymbolen (gleichverteilt) Symbolkette wird mit Huffman codiert , ,⋯, ist die mittlere Codewortlänge pro Symbolfolge : Codierungsaufwand pro Symbol , ,⋯, Es gilt: Die mittlere Codewortlänge der Symbolkette kann nach Shannon wie folgt abgeschätzt werden: , ,⋯, , ,⋯, , ,⋯, 1 ⟹ · · · 1 1 nähert sich der Entropie der Quelle bis auf einen beliebig kleinen Summanden / an : Symbolkette länger näher an die Entropie 79 2.5 Codierung von Wörtern 2.5.2 Erweiterung des Codierungstheorems Erweiterung des Shannon´schen Codierungstheorem für Quellen ohne Gedächtnis: 1 Codierung von Einzelsymbolen Codierung von Symbolketten Aufgabe 2-7 (A16 aus Übung) 0,7 0,2 0,1 1. Codieren Sie die Symbole von mit Huffman und berechnen Sie die mittlere Codewortlänge 2. Codieren Sie Symbolpaare von und bestimmen Sie die mittlere Codewortlänge pro Symbol. Vergleichen Sie beide Ergebnisse mit der Entropie der Quelle 80 Aufgabe 2-8 (A17 aus Übung) Gegeben ist folgende Binärsequenz: 0001 0000 1010 0000 1000 0011 0010 0010 1. Berechnen Sie für die obige Nachricht: a. b. c. Den Entscheidungsgehalt Die Entropie Die Redundanz pro Symbol und die gesamte Redundanz der Nachricht 2. Es sind jeweils zwei benachbarte Bits zu einem Symbol zusammenzufassen. Beantworten Sie für die sich daraus ergebende Symbolfolge alle Fragen gemäß 1a-c. 3. Codieren Sie die Symbolfolge mit Shannon. Welche Redundanz ergibt sich? 4. Codieren Sie die Symbolfolge mit Huffman. Welche Redundanz ergibt sich jetzt? 81 Aufgabe 2-9 (A18 aus Übung) Gegeben ist folgende Nachricht: AACDABCAAADBACAC 1. Wie groß sind a. der Entscheidungsgehalt der Nachrichtenquelle, b. der Informationsgehalt der einzelnen Symbole, c. die Entropie und Redundanz der Nachricht. 2. Die Symbole sollen binär codiert und dann übertragen werden. Der Code lautet: A = 00 B = 01 C = 10 D = 11 a. b. c. Geben Sie den Informationsgehalt der binären Symbole 0 und 1 an Welche Redundanz ergibt sich jetzt? Machen Sie einen Vorschlag, wie die Redundanz durch eine optimierte Codierung verringert werden kann. 82 Aufgabe 2-10 (A19 aus Übung) Eine farbige Grafik besteht aus 1 Million Bildpunkten, die ROT, GRÜN, BLAU, WEISS und SCHWARZ aussehen können. Das gesamte Bild wird in 1 Sekunde übertragen. Alle genannten Farben/Helligkeiten treten in der Grafik gleich häufig auf. 1. Berechnen Sie den Entscheidungsgehalt der Quelle „farbige Grafik“ und geben Sie den Informationsgehalt für jedes der möglichen Symbole (Farben bzw. Helligkeitswerte) an. 2. Die Zustände der Bildpunkte sollen binär codiert werden (gleiche Blockcodierung). Welcher Datenfluss ergibt sich hierbei? Welche Redundanz liegt jetzt vor? 3. Stellen Sie die Symbole mit dem Huffman-Code dar. Welche mittlere Codewortlänge ergibt sich? Welche Redundanz resultiert? 83 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon‘sche Informationstheorie Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 2.6.1 Verbundwahrscheinlichkeit 2.6.2 Entropie 2.6.3 Markow Prozesse 2.6.4 Markow Prozesse höherer Ordnung 84 2.6 Diskrete Quelle mit Gedächtnis 2.6.1 Verbundwahrscheinlichkeit • • • Bisher wurde von einer Quelle ohne Gedächtnis ausgegangen Annahme der statistischen Unabhängigkeit der Einzelsymbole einer Quelle trifft bei vielen Anwendungen nicht zu. Z.B. Text: Bei geschriebenem Text besteht eine hohe Korrelation der Einzelsymbole Diese Abhängigkeit wird in der Informationstheorie durch eine bedingte Wahrscheinlichkeit beschrieben. Definition: Gegeben sind zwei diskrete Quellen und . Die Wahrscheinlichkeit für das Auftreten des Ereignisses unter der Voraussetzung, dass bereits eingetroffen ist, wird als bedingte Wahrscheinlichkeit | bezeichnet • Die Bedingte Wahrscheinlichkeit erfasst die Korrelation zwischen den Ereignissen bzw. Symbolen und . 85 Der Satz von Bayes einer der wichtigsten Sätze der Wahrscheinlichkeitsrechnung • Der Satz von Bayes besagt, dass ein Verhältnis zwischen der bedingten | und der umgekehrten Form Wahrscheinlichkeiten zweier Ereignisse | besteht. 0, lautet der Satz von Bayes: Definition: Für zwei Ereignisse und , für | · | | ist die bedingte Wahrscheinlichkeit des Ereignisses A unter der Bedingung, dass B eingetreten ist. | ist die bedingte Wahrscheinlichkeit des Ereignisses B unter der Bedingung, dass A eingetreten ist. ist die Wahrscheinlichkeit (Anfangswahrscheinlichkeit) für das Eintreten des Ereignisses A. ist die Wahrscheinlichkeit (Anfangswahrscheinlichkeit) für das Eintreten des Ereignisses B. Anfangswahrscheinlichkeit meint, dass ein Ereignis unabhängig von einem anderen betrachtet wird. 86 2.6 Diskrete Quelle mit Gedächtnis 2.6.1 Verbundwahrscheinlichkeit • Für die bedingten Wahrscheinlichkeiten gilt allgemein: | | und Bemerkungen: • Wenn und identisch sind, ist die bedingte Wahrscheinlichkeit i.a. nicht symmetrisch: | | • Die Verbundwahrscheinlichkeit kann in diesem Fall durch das Produkt der Auftrittswahrscheinlichkeit eines Einzelsymbols und der bedingten Wahrscheinlichkeit wie folgt beschrieben werden: , · | · | 87 2.6 Diskrete Quelle mit Gedächtnis 2.6.1 Verbundwahrscheinlichkeit Eine Quelle ohne Gedächtnis ist ein Spezialfall dieser Situation. Für diese gilt: • (und insbesondere ) • | unabhängig von • | unabhängig von • , · 88 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon‘sche Informationstheorie Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 2.6.1 Verbundwahrscheinlichkeit 2.6.2 Entropie 2.6.3 Markow Prozesse 89 2.6 Diskrete Quelle mit Gedächtnis 2.6.2 Verbundentropie Gegeben seien wieder zwei diskrete Quellen mit Gedächtnis , ,…, und , ,…, . Für die Quelle kann eine Entropie berechnet werden, wenn aus der Quelle das Symbol ausgewählt worden ist. Diese Entropie wird mit bedingte Entropie der Quelle bezüglich des Einzelsymbols bezeichnet: | | · | / Für jedes aus der Quelle ausgewählte Symbol ergibt sich eine derartige bedingte Entropie der Quelle Durch Mittelung über diese bedingten Entropien (Gewichtung mit ) erhält man die bedingte Entropie | der Quelle bezüglich der Quelle . | · | 90 2.6 Diskrete Quelle mit Gedächtnis 2.6.1 Verbundentropie | : Bedingte Entropie der Quelle | · bezüglich der Quelle | · | , | · · | | Für die Verbundentropie für eine diskrete Quelle mit Gedächtnis gilt: , , · , Zur Erinnerung gilt für Quellen mit Gedächtnis: , · | · | 91 2.6 Diskrete Quelle mit Gedächtnis 2.6.2 Entropie Für die Verbundentropie gilt also: , , , · · , | · | , | · · , · | | | , | 92 2.6 Diskrete Quelle mit Gedächtnis 2.6.2 Entropie Behauptung*: Die Entropie einer Quelle ist größer oder gleich der bedingten Entropie ⟹ • • , | | Die Korrelation der Symbole untereinander verringert den mittleren Informationsgehalt der Quelle. In der Quellencodierung sollten deshalb nicht Einzelsymbole, sondern Symbolketten codiert werden, um dadurch den Codieraufwand zu minimieren *Beweis s. Rohling 93 Zusammenfassung Optimierung der (binären) Codierung einer Quelle mit verschiedenen Symbolen unterschiedlicher Wahrscheinlichkeiten und mit Gedächtnis. 1. Schritt: Codierung aller Einzelsymbole ohne Berücksichtigung der Einzelwahrscheinlichkeiten oder des Gedächtnisses 2. Schritt: Huffman-Codierung aller Einzelsymbole mit Berücksichtigung der Einzelwahrscheinlichkeiten (N Codewörter) 94 Zusammenfassung 3. Schritt: Huffman-Codierung von Symbolketten der Länge , Berücksichtigung der Wahrscheinlichkeiten dieser Ketten durch Produkte der Einzelwahrscheinlichkeiten (d.h. noch Vernachlässigung des Gedächtnisses) , ,⋯, · · ⋯· sehr komplizierter Code mit Codewörtern (statt ) 4. Schritt: Huffman-Codierung jedes Einzelsymbols mit einem Code, der vom vorherigen Symbol 1 abhängt und so das Gedächtnis berücksichtigt und damit den richtigen Wert für berücksichtigt | ´ | ´ , u.U deutlich kleiner als Nachteil: komplizierter Code mit · Codewörtern (statt ) 95 Anwendung auf Texte mit deutscher Sprache 96 Anwendung auf Texte mit deutscher Sprache • • Wichtiges Beispiel für eine Quelle mit Gedächtnis: Texte 30 Symbole: 26 Buchstaben + Zwischenraum + 3 Interpunktion Entropien: 30 4,907 Bit/Symbol 4,087 Bit/Symbol , , , 3,26 Bit/Symbol 2,883 Bit/Symbol Ohne Berücksichtigung der Wahrscheinlichkeiten der Symbole Mit Wahrscheinlichkeit der Einzelsymbole (Markov-Quelle 0. Ordnung) Korrelation von Symbolpaaren (MarkovQuelle 1. Ordnung) Korrelation von Symboltripeln (MarkovQuelle 2.Ordnung) 97 Anwendung auf ein extremes Beispiel 98 Anwendung auf ein extremes Beispiel 99 Anwendung auf ein extremes Beispiel 100 Inhaltsverzeichnis 2. Quellencodierung 2.1 2.2 2.3 2.4 2.5 2.6 Motivation Shannon‘sche Informationstheorie Binärcodierung nach Shannon Huffman-Codierung Codierung von Wörtern anstelle von Einzelsymbolen Diskrete Quelle mit Gedächtnis 2.6.1 Verbundwahrscheinlichkeit 2.6.2 Entropie 2.6.3 Markov Prozesse 101 2.6 Diskrete Quelle mit Gedächtnis 2.6.3 Markov-Prozesse 102 2.6 Diskrete Quelle mit Gedächtnis 2.6.3 Markov-Prozesse • Die Situation einer Quelle mit Gedächtnis wird anschaulich häufig durch das Markov-Diagramm 1.Ordnung dargestellt. Beispiel: 3 Symbole A, B und C mit Auftrittswahrscheinlichkeiten und bedingten Wahrscheinlichkeiten. | A 4/5 1/2 1/5 1/2 A 0 ⟶∑ 1 B 0 ⟶ ∑ 1 C ⟶∑ 1 , B C 2/5 · | · | , 1/10 1/2 Aufgabe: Bestimmen Sie p(A), p(B) und p(C) aus dem Markov-Diagramm 0 0 103 2.6 Diskrete Quelle mit Gedächtnis 2.6.3 Markov-Prozesse , | A 0 B C 0 0 3 Entropie: 1,253 0 / Bedingte Entropie: | , · | 0,931 / Verbundentropie: , · , , 1,092 · , 2,184 / / 104 2.6 Diskrete Quelle mit Gedächtnis 2.6.3 Markov-Prozesse (höherer Ordnung) • • Bei Markov-Prozessen der Ordnung hängt der Informationsgehalt eines Symbols von den vorhergehenden Zuständen ,…, , die im Folgenden abgekürzt durch den Vektor dargestellt werden. Der bedingte Informationsgehalt für das i-te Symbol ist definiert durch: | • | | ist die bedingte Entropie der Quelle mit Gedächtnis unter Berücksichtigung eines die Vergangenheit beschreibenden definierten Zustandsvektors | • | · | | , die bedingte Entropie der Quelle ergibt sich durch Mittelung über alle möglichen Zustandsvektoren . Die Entropie der Quelle wird also durch die bedingte Entropie beschrieben | · | 105 Aufgabe 2-10 A 24 Dr. Jäger , , mit Gedächtnis. Für die Gegeben Sei eine Quelle Quellensymbole gelten die folgenden bedingten Wahrscheinlichkeiten: | 1 3 1 4 1 4 1 3 1 2 1 4 1 3 1 4 1 2 a. Stellen Sie die Quelle anschaulich mit Hilfe eines Markov-Diagramms 1. Ordnung dar. b. Bestimmen Sie die Symbolwahrscheinlichkeiten , und c. Berechnen Sie die Verbundwahrscheinlichkeiten , d. Berechnen Sie die Entropie der Quelle, die bedingte Entropie und die Verbundentropie 106 Aufgabe Eine diskrete Quelle folgenden Abbildung. , mit Gedächtnis habe den Zustandsgraf aus der 3/4 ? B A ? 1. Geben sie die Übergangswahrscheinlichkeiten an. 2. Berechnen Sie die Auftrittswahrscheinlichkeiten der einzelnen Zustände. 3. Geben Sie die Entropie der Quelle an unter Berücksichtigung der Übergangswahrscheinlichkeiten. 4. Fassen Sie jeweils drei Zeichen zu einem Symbol zusammen. Berechnen Sie die Wahrscheinlichkeiten der möglichen Symbole. 5. Führen Sie eine Huffman-Codierung durch und geben Sie die mittlere Codewortlänge des Codes. 107