Skript - Informatik

Werbung

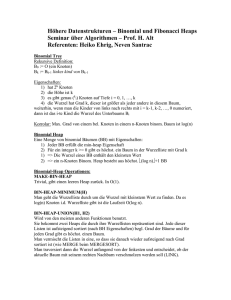

Informatik III

Prof. Dr. W. Vogler

1

INHALTSVERZEICHNIS

INHALTSVERZEICHNIS

Inhaltsverzeichnis

1 Grundlagen

1.1 Literatur . . . . . . . . . . . . . .

1.2 Prinzipien des Korrektheitsbeweis

1.3 Effizienz und Größenordnungen .

1.4 Bäume . . . . . . . . . . . . . . .

1.5 Schichtnumerierung . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

1

4

8

11

2 Listen, Keller und Warteschlangen

13

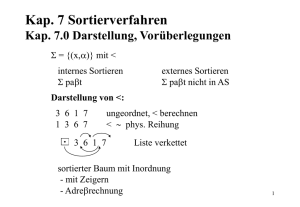

3 Sortieren

3.1 Einfache Sortierverfahren . . . . . . . . . . . . .

3.2 Quicksort . . . . . . . . . . . . . . . . . . . . . .

3.3 Untere Schranke für vergleichsbasierte Verfahren

3.4 Heapsort . . . . . . . . . . . . . . . . . . . . . . .

3.4.1 Halden . . . . . . . . . . . . . . . . . . . .

3.4.2 Heapsort . . . . . . . . . . . . . . . . . . .

3.4.3 Vorrangswarteschlangen . . . . . . . . . .

3.5 Bucket Sort, Radix Sort . . . . . . . . . . . . . .

3.6 Externes Sortieren . . . . . . . . . . . . . . . . .

3.6.1 Direktes Mischen . . . . . . . . . . . . . .

3.6.2 Verbesserungen . . . . . . . . . . . . . . .

3.6.3 Natürliches Mischen . . . . . . . . . . . .

3.6.4 Verbesserungen des natürlichen Mischens

3.6.5 Mehrphasenmischen . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

17

17

17

20

21

21

24

25

26

26

27

29

29

30

30

.

.

.

.

.

.

.

32

32

33

34

39

39

40

43

5 Verwaltung disjunkter Mengen

5.1 Schnelles Find . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2 Schnelles Union . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.3 Pfadverkürzung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

45

45

47

48

6 Graphenalgorithmen

6.1 Darstellung von Graphen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2 Zusammenhangskomponenten, Tiefen- und Breitensuche . . . . . . . . . . . .

6.3 Gerichtete Graphen: starke Zusammenhangskomponenten . . . . . . . . . . .

52

53

54

59

4 Mengenverwaltung

4.1 Baumdurchläufe . . . . . . . . .

4.2 Binäre Suchbäume . . . . . . . .

4.3 2-3-Bäume . . . . . . . . . . . . .

4.4 Hashing (Streuspeicherverfahren)

4.4.1 Hash-Funktionen . . . . .

4.4.2 Offenes Hashing . . . . .

4.4.3 Geschlossenes Hashing . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

i

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

INHALTSVERZEICHNIS

6.4

INHALTSVERZEICHNIS

Kürzeste Wege . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

63

7 Turingmaschinen (Wiederholung)

67

8 NP-vollständige Probleme

8.1 P . . . . . . . . . . . . .

8.2 NP . . . . . . . . . . . .

8.3 SAT . . . . . . . . . . .

8.4 VC . . . . . . . . . . . .

8.5 Tripartites Matching . .

.

.

.

.

.

71

71

72

73

74

76

.

.

.

.

.

.

.

.

.

.

.

.

.

.

79

79

79

82

82

85

89

90

91

92

94

94

95

97

99

.

.

.

.

.

100

100

100

100

101

101

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

9 Entwurfstechniken für Algorithmen

9.1 Greedy Algorithmen . . . . . . . . . . . .

9.1.1 Minimale Spannbäume . . . . . . .

9.1.2 Ein einfaches Scheduling-Problem .

9.1.3 Huffman Codes . . . . . . . . . . .

9.1.4 Bin-Packing . . . . . . . . . . . . .

9.2 Divide and Conquer . . . . . . . . . . . .

9.2.1 Multiplikation ganzer Zahlen . . .

9.2.2 Matrixmultiplikation nach Strassen

9.2.3 Selektion in linearer Zeit . . . . . .

9.3 Dynamische Programmierung . . . . . . .

9.3.1 Alle kürzesten Wege . . . . . . . .

9.3.2 Multiplikation mehrerer Matrizen .

9.4 Backtracking . . . . . . . . . . . . . . . .

9.5 Probabilistische Algorithmen . . . . . . .

10 Fibonacci-Heaps und amortisierte

10.1 Motivation . . . . . . . . . . . . .

10.2 Amortisierte Zeit und Potentiale

10.3 Fibonacci-Heap . . . . . . . . . .

10.3.1 Operationen . . . . . . . .

10.3.2 Zeitanalyse . . . . . . . .

Zeit

. . .

. . .

. . .

. . .

. . .

.

.

.

.

.

ii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. . . .

. . . .

. . . .

. . . .

. . . .

. . . .

. . . .

(1968)

. . . .

. . . .

. . . .

. . . .

. . . .

. . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

Grundlagen

Abstrakte Datentypen fassen Typen (die für Mengen von Werten stehen) und getypte Operationen mit “vorgeschriebenen Effekten” zusammen. Z.B. haben Sie in Informatik I zur Darstellung von Mengen natürlicher Zahlen den Typ set mit den Operationen set emptyset(),

bool iselem (nat, set), set insert (nat, set) etc. kennengelernt. Wir erwarten z.B.

iselem (n, insert( n, M)) = true für jede Menge M.

Eine Datenstruktur für einen solchen Datentyp legt genau fest, wie die Werte und die

Operationen realisiert werden. Dabei kann z.B. set in unterschiedlicher Weise implementiert

werden, z.B. als sortierte wiederholungsfreie Listen oder als Bitvektoren.

Wird die Implementierung ausgetauscht, bleibt die Korrektheit von Programmen, welche

den Datentyp verwenden, unberührt (Modularität, OOP); die Laufzeit oder der (Speicher-)

Platzbedarf hingegen können sich ändern. In dieser Vorlesung sollen Sie effiziente Datenstrukturen kennenlernen, in denen die Daten möglichst geschickt und platzsparend organisiert

werden, so dass die Operationen durch intelligente Algorithmen realisiert werden können, die

in erster Linie möglichst wenig Zeit, in zweiter Linie aber auch möglichst wenig Platz benötigen. Dabei ist ein Algorithmus ein präzis formuliertes Verfahren, das in endlicher Zeit sein

Ergebnis abliefert.

Die Algorithmen in dieser Vorlesung sind oft Grundverfahren; sie bearbeiten Probleme, die

stark von der Realität abstrahieren und demgemäß stark vereinfacht sind. Mit den Kenntnissen

aus dieser Vorlesung sollten Sie aber in der Lage sein, auch realistischere Probleme effizient

zu lösen.

1.1

Literatur

M. A. Weiss: Data Structures and Algorithm Analysis in Java, z.B. 3. Aufl. 2012

Aho, Hopcroft, Ullman: Data Structures and Algorithms

A. Gibbons: Algorithmic Graph Theory, 1985

T. Ottmann, R. Widmayer: Algorithmen und Datenstrukturen, 3. Auflage, 1996

R. Sedgewick, Wayne: Algorithmen. 2014

1.2

Prinzipien des Korrektheitsbeweis

Wird ein Verfahren zur Lösung eines Problems vorgestellt, muss man das Verfahren als erstes

verstehen und seine Korrektheit einsehen; für beide Fragen sind Schleifeninvarianten wichtig.

Ein Verfahren, Programm oder Programmstück ist partiell korrekt, wenn gilt: Falls das

Verfahren (ohne Fehlerabbruch) terminiert, liefert es das richtige Ergebnis. Es ist total korrekt,

wenn es partiell korrekt ist und terminiert. Korrektheit ist vor allem ein Problem, wenn das

Programm eine Schleife enthält oder rekursiv ist. Betrachten wir eine While-Schleife while

(B) {S} – für For-Schleifen gilt entsprechendes.

Um Terminierung zu zeigen, definiert man eine Terminierungsfunktion t, die die Werte der

oder einiger Programmvariablen in der Regel nach N0 abbildet; dabei muss der Funktionswert zu Beginn eines Schleifendurchlaufs immer kleiner sein als zu Beginn des vorhergenden

Schleifendurchlaufs – und es muss sichergestellt sein, dass S terminiert. Da die Werte nicht

immer kleiner werden können, wird es irgendwann keinen nächsten Schleifendurchlauf geben.

1.2 Prinzipien des Korrektheitsbeweis

1 GRUNDLAGEN

Statt N0 mit dem üblichen < kann man auch andere fundierte (well-founded) bzw. Noethersche Mengen nehmen, d.h. in denen es keine unendlichen absteigenden Ketten gibt; z.B.

N0 × N0 mit der lexikographischen Ordnung oder mit komponentenweisem <.

Um partielle Korrektheit zu zeigen, verwendet man Schleifeninvarianten – Aussagen, die

bei jedem Beginn eines Schleifendurchlaufs wahr sind. Um sich überzeugen zu können, dass

die Aussage P dies erfüllt, verlangt man im Prinzip: P wird durch S erhalten („invariant“),

d.h. gilt P und wir führen S aus, so gilt P danach wieder. Gilt P zu Beginn, so gilt es

nach Induktion zu Beginn jedes Schleifendurchlaufs, und insbesondere nach Beendigung der

Schleife.

Es fällt natürlich leichter zu beweisen, dass P am Ende gilt, wenn wir mehr voraussetzen

dürfen; und tatsächlich wird der Schleifenrumpf S ja nur ausgeführt, wenn die Schleifenbedingung B gilt. Eine gleichermaßen ausreichende Anforderung ist demnach: Sind B und P wahr

und wir führen S aus, so gilt P am Ende wieder.

Auch aus dieser Anforderung folgt: Gilt P zu Beginn, so gilt es nach Induktion zu Beginn

jedes Schleifendurchlaufs, und insbesondere nach Beendigung der Schleife. Weil die Anforderung schwächer ist („leichter zu beweisen“), wird sie von mehr Aussagen P erfüllt, und das ist

praktisch wichtig.

Ist die Schleife Teil eines Programms, so erreichen wir unser Ziel natürlich nur, wenn P

auch tatsächlich beim Erreichen der Schleife wahr ist. Dies müssen wir nachweisen durch Betrachtung des vorhergehenden Programmtextes – und evtl. unter Verwendung von Annahmen

an die Eingabewerte des Programms.

Zusammengefasst: Ist die Schleife Teil eines Programms, so ist eine Aussage P eine Schleifeninvariante, wenn P

• wahr ist, wenn die Schleife erreicht wird,

• und nach Ausführung von S wahr sein, vorausgesetzt daß zuvor B und P wahr sind.

Ob eine gegebene Aussage P eine Schleifeninvariante ist, läst sich oft vergleichsweise leicht

prüfen. Konvention: Wenn man über den Wert von i beim Erreichen und dem am Ende

der Schleife reden will, schreibt man für letzteren oft i′ .Die wirklich schwierige und kreative Aufgabe ist es, P zu finden. Hier liegt auch das wesentliche Problem für automatische

Verifikationsverfahren.

Ein wichtige Aufgabe in der Software-Entwicklung ist die Anpassung vorhandener Programme; dazu muss man zunächst ein solches Programm verstehen. Was das Programm tun

soll, ist oft bekannt; das sagt einem aber nicht, was eine Schleife in dem Programm genau tut.

Letzteres wird gerade durch eine Schleifeninvariante beschrieben. Ihre Angabe ist also eine

unerlässliche Dokumentation!!

Eine noch so schöne Schleifeninvariante bringt natürlich nichts, wenn sie nicht den Nachweis der partiellen Korrektheit unterstützt. Aufgrund der Definition gilt P nach Abschluss der

Schleife (wenn sie denn je abgeschlossen wird); daraus müssen wir folgern, dass das Endergebnis des Programms richtig ist. Tatsächlich wissen wir wieder mehr als nur P : Am Schleifenende

gilt zudem

• Eine Schleifeninvariante P ist nützlich, wenn folgendes zutrifft: Gelten P und ¬B und

wir führen das Restprogramm nach der Schleife aus, so ist das Ergebnis korrekt.

2

1.2 Prinzipien des Korrektheitsbeweis

1 GRUNDLAGEN

Wenn wir eine nützliche Schleifeninvariante P finden (d.h. die obigen drei Punkte überprüft

haben), so folgt die partielle Korrektheit.

Beispiel: Ein Algorithmus ist z.B. ein Sortierverfahren wie Sortieren durch Einfügen (Insertion Sort), das Sie vermutlich schon kennen. Beim Sortierproblem soll eine Folge von

Objekten/Datensätzen „aufsteigend “ sortiert werden. Oft ist diese Folge in Form eines Felds

a gegeben, und im Allgemeinen sind die Komponenten von a Verbunde mit einer Komponente

key, nach der sortiert werden soll. Für den Typ von key muss also < und > definiert, damit

wir wissen, wie wir die Objekte sortieren sollen.

Vereinfachend nehmen wir an, dass key eine ganze Zahl ist, und dass in a nur key gespeichert

ist; gegeben ist uns also int a[n]. (Die Notation in diesem Skript orientiert sich an Java.)

(1)

(2)

(3)

(4)

(5)

int x,j;

for (int i=1; i<n; i++)

{ x = a[i]; j = i;

while ((j>0) && (a[j-1]>x))

{ a[j] = a[j-1]; j--;

}

a[j] = x;

}

Zum Verständnis macht man sich klar, was ein typischer Schritt von Insertion Sort ist:

Anfangsstück (zunächst a[0]) ist sortiert, das nächste Element a[i] wird durch Vergleichen

(und ggf. Verschieben) von rechts in diesen Anfang einsortiert.

Formal: Für die For-Schleife – d.h. immer wenn i < n in (1) überprüft wird – gilt die

Schleifeninvariante „a[0] ≤ . . . ≤ a[i-1]“. Begründung: Dies gilt trivialerweise für i = 1 beim

ersten Erreichen der Schleife; gilt es zu Beginn eines Schleifendurchlaufs, so wird a[i] einsortiert, am Ende gilt also a[0] ≤ . . . ≤ a[i], und da i′ = i + 1 (s. Konvention oben), gilt die

Aussage am Ende der Schleife für i′ wieder – d.h. beim nächsten Erreichen von i < n in (1).

(Man muss daran denken, dass die neue Zuweisung an i noch vor dem Erreichen von i < n in

(1) und damit innerhalb der Schleife geschieht; die Situation wird evtl. klarer, wenn man die

For-Schleife in eine While-Schleife übersetzt.)

Weiter muss man die Aussage i ≤ n in die Schleifeninvariante aufnehmen; dies gilt zu

Beginn und wegen der Abfrage i < n auch am Ende jeder Schleife (i′ ≤ n). Damit gilt am

Ende i ≤ n und ¬(i < n) (d.h. B ist falsch); mit i = n ergibt die Schleifeninvariante, dass

das Feld am Ende sortiert ist. Genaugenommen will man natürlich auch, dass es immer noch

dieselben Elemente wie am Anfang enthält (es ist eine Permutation der Eingabe); formal

müsste man dazu die Schleifeninvariante abändern, was wir uns hier aber ersparen. Eine

formalere Behandlung von Korrektheitsbeweisen macht man im Hoare-Kalkül, s. Logik für

Informatiker.

Terminierungsfunktion für (3):

Die While-Schleife terminiert also und damit der Rumpf der For-Schleife.

Terminierungsfunktion für (1):

Bemerkung: Verschiedene Verbunde können den gleichen key haben; erhält ein Sortierverfahren immer die Reihenfolge der “gleichwertigen” Komponenten, so heißt es stabil. (Sind die

3

1.3 Effizienz und Größenordnungen

1 GRUNDLAGEN

Feldelemente wirklich nur ganze Zahlen, ist das natürlich egal.) Wie man sieht, ist Insertion

Sort stabil.

Hier noch ein kurzes Beispiel für einen Korrektheitsbeweis bei Rekursion:

int f(int n,m) /* n,m > 0 */

{ if (n == m) return n;

else { if (n < m) return f(n,m-n);

else return f(n-m,m);

}

}

Diesmal bildet eine Terminierungsfunktion t die Parameterwerte z.B. nach N0 ab, wobei

der t-Wert eines rekursiven Aufrufs immer kleiner ist als der t-Wert des Ursprungsaufrufs.

Existenz einer Terminierungsfunktion garantiert offenbar die Terminierung. Im Beispiel:

Rekursive Funktionen sind Fallunterscheidungen (s.o.): Enthält ein Zweig keinen rekursiven

Aufruf (Terminierungszweig, Gesamtzahl von Aufrufen = 1), zeigt man partielle Korrektheit

des Ergebnisses direkt; wird die Funktion insgesamt nur einmal aufgerufen, gilt also partielle

Korrektheit. Weiter zeigt man, daß die anderen Zweige partiell korrekt sind, wenn man partielle Korrektheit der rekursiven Aufrufe annimmt (Gesamtzahl ist kleiner). Damit gilt nach

Induktion über k: Wird die Funktion insgesamt k-mal aufgerufen, gilt Korrektheit. (Führt

ein Aufruf zu rekursiven Aufrufen, so ist die Gesamtzahl der vom ersten Aufruf ausglösten

Aufrufe gerade die Summe der Gesamtzahlen der rekursiven Aufrufe plus 1.) Dies zeigt gerade

die partielle Korrektheit.

Wir wollen mit diesem Prinzip zeigen, dass f unter der Annahme n, m > 0 den ggT berechnet. Im Terminierungszweig ist dies offenbar zutreffend. Betrachten wir nun den zweiten

Zweig (der dritte ist analog): Da n < m, gilt n, m − n > 0 und wir können annehmen, dass

f (n, m − n) = ggT (n, m − n). Ein Teiler von n und m − n teilt aber auch n + (m − n) = m, ein

Teiler von n und m teilt auch m − n. (n, m) und (n, m − n) haben also dieselben gemeinsamen

Teiler, damit auch denselben ggT und das Ergebnis ist korrekt. Dies zeigt partielle Korrektheit: Wenn die Rekursion bei Eingabe positiver natürlicher Zahlen terminiert, berechnet sie

den ggT.

Zusammen mit t haben wir totale Korrektheit.

1.3

Effizienz und Größenordnungen

Wenn man ein Verfahren verstanden, d.h. insbesondere seine Korrektheit eingesehen hat, muss

man sich Gedanken über die Effizienz machen, also über den benötigten Speicherplatz und

die Laufzeit.

Den Speicherplatz für die Eingabe, beim Sortieren also für das Feld a, zählt man oft nicht

mit. Beim Sortieren soll oft darüberhinaus nur konstant viel weiterer Speicherplatz verwendet

werden, er soll also vor allem unabhängig von der Länge von a sein. (Sortieren “am Platz”, “in

situ”; Mergesort z. B. sortiert nicht am Platz.)

Dabei nimmt man an, dass man jede ganze Zahl mit konstant Speicherplatz speichern kann;

das ist natürlich nicht allgemein der Fall – aber zumindest für die Zahlen, die wir verwenden,

soll es gelten.

4

1.3 Effizienz und Größenordnungen

1 GRUNDLAGEN

Bei Insertion Sort ist der zusätzliche Speicherplatz in der Tat konstant: Wir brauchen nur

drei int-Variablen.

Wieviel Zeit dieses Programm benötigt, hängt natürlich einerseits von n und der WerteVerteilung in a ab, andererseits aber auch stark vom verwendeten Rechner; um die Effizienz zu bestimmen, nehmen wir daher einfach nur an, dass eine Addition, Subtraktion, Multiplikation und Division, aber auch ein Vergleich, eine Zuweisung und ein Zugriff

auf ein Feldelement jeweils eine konstante (rechnerabhängige) Zeit brauchen. Demnach wird

in jeder der numerierten Zeilen jeweils eine gewisse feste Zeit verbraucht; die Werte seien

c1 , . . . , c5 . Zeile (1) wird n-mal, Zeilen (2) und (5) (n − 1)-mal durchgeführt, was zusammen

nc1 + (n − 1)(c2 + c5 ) = n(c1 + c2 + c5 ) − (c2 + c5 ) dauert.

Da wir die genauen Konstanten sowieso nicht kennen, kommt es uns bei diesem Wert nur

auf das Wachstum mit wachsendem n an; wir interessieren uns für die asymptotische Laufzeit.

Bei großem n spielt die Subtraktion von c2 + c5 sicher keine Rolle, der Aufwand für diese

Zeilen ist also im wesentlichen cn für ein c, er ist also linear in n.

Wie oft die Zeilen (3) und (4) ausgeführt werden, hängt nun aber auch von der WerteVerteilung ab: Ist a aufsteigend sortiert, bricht die Schleife jedesmal sofort ab (insgesamt Zeit

(n − 1)c3 ); ist a absteigend sortiert, wird die Schleife 1 + 2 + . . . + (n − 1) = n(n − 1)/2 Mal

ausgeführt (insgesamt Zeit (n − 1)( n2 (c3 + c4 ) + c3 )).

Dies sind der beste und der schlechteste Fall. Man kann sich nun für den besten Fall (best

case) interessieren; dann ist die Laufzeit linear. Das erscheint übertrieben optimistisch. Allerdings könnten in einer bestimmten Anwendung die Felder im Prinzip sortiert und nur leicht

durcheinander gekommen sein; für solche weitgehend sortierten Felder ist Insertion Sort ein

sehr schnelles Verfahren.

Man könnte auch für jedes n die Laufzeiten für alle möglichen Werte-Verteilungen betrachten und den Durchschnitt berechnen. Wie kann das bei unendlich vielen int-Werten gehen??

Die konkreten a[i] sind hier nicht wichtig, nur ihre relativen Größen! Es gibt also . . . . . . viele

Werte-Verteilungen, wenn alle Werte verschieden sind.

Diese mittlere Laufzeit (average case) ist praktisch sehr relevant. Allerdings gibt es auch

sicherheitskritische Anwendungen, bei denen man die Laufzeit in jedem Fall begrenzen will.

Zudem ist die Bestimmung der mittleren Laufzeit oft sehr schwierig.

Wir werden daher im wesentlichen die Laufzeit im schlechtesten Fall (worst case) betrachten. Diese sieht aber auch sehr unübersichtlich aus; grob hat sie aber die Form cn2 + c′ n + c′′

für Konstanten c, c′ , c′′ . Ähnlich wie oben können wir nun sagen, dass bei größeren n nur

wichtig ist, dass sie quadratisch ist; wir sagen, dass sie in Θ(n2 ) („Theta von n-Quadrat“) ist,

s.u.

Mit dieser Sichtweise erhält man das Ergebnis leichter wie folgt: Die for-Schleife wird (n−1)mal durchlaufen. Neben der while-Schleife fallen die sonstigen konstanten Aufwendungen (1),

(2) und (5) nicht ins Gewicht; diese wird beim i-ten Mal im schlechtesten Fall i-mal durchlaufen

mit jeweils konstantem Aufwand. Wegen 1 + 2 + . . . + (n − 1) = n(n − 1)/2 ist der Aufwand

also quadratisch.

Noch leichter wird die Sache, wenn wir nur eine obere Schranke angeben wollen: Bei jedem

der ≤ n Durchläufe der for-Schleife wird die while-Schleife ≤ n Mal durchlaufen mit jeweils

konstantem Aufwand. Also ist der Aufwand höchstens quadratisch, O(n2 ) (Groß-Oh).

5

1.3 Effizienz und Größenordnungen

1 GRUNDLAGEN

Es sei noch angemerkt: Für wirklich große Zahlen ist Multiplikation aufwendiger als Addition; tatsächlich werden wir uns noch mit der Multiplikation langer Zahlen befassen. Unsere

Annahme, dass jede Multiplikation konstante Zeit kostet, gilt also nur, wenn wir darauf achten, dass die Zahlen nicht zu groß werden.

Wir wollen noch kurz als zweites Beispiel binäre Suche betrachten. Man kann eine Menge

auch verwalten, indem man ihre Elemente in ein Feld einträgt. Um zu entscheiden, ob ein

Wert x enthalten ist, muss man dann wie bei einer Liste die (besetzten) Zellen des Felds der

Reihe nach durchsuchen, der Aufwand ist also O(. . . . . .), wobei

Um dies zu verbessern, kann man das Feld sortiert halten. Um nun nach x zu suchen, teilt

man das (benutzte) Feld in der Mitte, stellt durch Vergleich mit einem Element an der Grenze

fest, in welcher Hälfte x liegen würde, und wiederholt dies. Da der Aufwand bei jeder Teilung

konstant ist, dauert das Suchen jetzt O(. . . . . .).

Wie fügen wir ein neues Element ein?

Wir wollen nun die Schreibweisen Θ(n2 ) und O(n2 ) genauer einführen. Grundsätzlich gilt:

je größer die Eingabe (z.B. je mehr Zahlen wir sortieren sollen), desto größer die Laufzeit,

die wir jetzt in Schritten (Addition,. . . , Zuweisung . . . ) messen wollen. Üblicherweise wird die

Größe der Eingabe mit n bezeichnet.

Die Effizienz eines Algorithmus A ist eine Funktion f : N0 → N, n → maximale Laufzeit

von A bei Eingabegröße n. Dies ist die Effizienz im schlechtesten Fall (worst case complexity).

Statt f : n → n2 schreiben wir n2 ,

statt f : n → n log n schreiben wir n log n, was genauer f : n → n ⌈log n⌉ bedeutet, wobei

immer ⌈log n⌉ ≥ 1 sein soll, u.ä. Damit vermeiden wir, dass eine Laufzeit n log n für n = 1 0

ist – was sie natürlich nicht ist – und n log log n für n = 1 sogar undefiniert.

Definition 1.1. O(g) = {f : N0 → N | ∃c, d ∈ N ∀n : f (n) ≤ cg(n) + d}

f ∈ O(g) bedeutet, daß f größenordnungsmäßig – d.h. asymptotisch (vgl. 1.3 i)) bis auf

einen konstanten Faktor/Summanden (vgl. 1.3 iii)) – ≤ g.

Beispiel 1.2. i) Für l ≤ k ist nl ∈ O(nk ), denn nl ≤ nk .

ii) O(1) = {f : N0 → N | ∃c, d ∀n : f (n) ≤ c · 1 + d} ist die Menge aller konstant nach oben

beschränkten Funktionen.

iii) ∀a, b > 1 O(loga n) = O(logb n), denn loga n = (loga b) logb n. Wir schreiben einfach

log n und meinen im Zweifel log2 n.

iv) log n ∈ O(n)

Man schreibt oft f = O(g) statt f ∈ O(g); n = O(n) und n = O(n2 ) (s. Bsp. i)) suggerieren

O(n) = O(n2 ) — falsch!

Proposition 1.3. i) Ist f ∈ O(g) und sind f und f ′ nur an endlich vielen Stellen verschieden,

so ist f ′ ∈ O(g).

ii) Sei a > 0. f ∈ O(g) ⇒ af + b ∈ O(g).

iii) Sei a > 0. f ∈ O(g) ⇔ af + b ∈ O(g) ⇔ f ∈ O(ag + b).

6

1.3 Effizienz und Größenordnungen

1 GRUNDLAGEN

Beweis. i) Sei f ≤ cg + d und d′ der maximale f ′ -Wert der “Stellen”, so ist f ′ ≤ cg + d + d′ .

ii) f ≤ cg + d ⇒ af ≤ acg + ad ⇒ af + b ≤ acg + ad + b.

iii) ähnlich

✷

Proposition 1.4. i) f ∈ O(f )

ii) f ∈ O(g), g ∈ O(h) ⇒ f ∈ O(h) – partielle Ordnung

iii) f ∈ O(g) ⇔ O(f ) ⊆ O(g)

iv) f ∈ O(g), f ′ ∈ O(g ′ ) ⇒ f + f ′ ∈ O(g + g ′ )

v) f, f ′ ∈ O(g) ⇒ f + f ′ ∈ O(g)

vi) f + g ∈ O(max(f, g))

Beweis. Übung

✷

Korollar 1.5. Sei p ein Polynom vom Grad k; dann ist p ∈ O(nk )

P

Beweis. Sei p(n) = ki=0 ai ni . Dann ist ai ni ∈ O(nk ) nach Bsp. 1.2 i) und Proposition 1.3

ii); Behauptung folgt aus 1.4 v).

✷

Insertion Sort hat Laufzeit f (n) ≤ cn2 + c′ n + c′′ , also O(n2 ). Wir werden sehen: Auch

Quicksort sortiert in O(n2 ), d.h. n Daten werden auf jeden Fall größenordnungsmäßig in ≤ n2

Schritten sortiert. Sortiert A in O(n log n), so ist A “besser” als Q.; aber:

• evtl. nur für große n (z.B. n ≥ 21000 )

• average case Effizienz von Quicksort ist O(n log n)

• konstanten Faktor kann man zwar durch schnelleren Rechner ausgleichen, ist aber doch

relevant

Beispiel: Man habe die Wahl zwischen einem O(2n )-, einem O n2 - und einem O (n log n)Verfahren.

Annahme: 106 Operationen sind zeitlich akzeptabel, und die Verfahren brauchen 2n , n2 bzw.

100n log n Operationen:

Max. Eingabe

2n

n2

100n log n

alt

neu(4.8)

neu(48)

≈ 20

1000

≈ 1000

≈ 22

≈ 2200

≈ 4000

≈ 25

≈ 7000

≈ 32000

Wird der Rechner schneller, z. B. 4.8 oder 48mal so schnell, dann wachsen auch die Anforderungen. Die Tabelle zeigt: je schneller der Rechner, um so mehr lohnt sich ein asymptotisch

besseres Verfahren.

f ∈ O(g) ⇐⇒: g ∈ Ω(f ) (untere Schranke)

f ∈ O(g) ∧ g ∈ O(f ) ⇐⇒: f ∈ Θ(g) (gleiche Größenordnung)

f ∈ O(g) ∧ g ∈

/ O(f ) ⇐⇒: f ∈ o(g) (echt kleinere Größenordnung)

Beispiel: logk n ∈ o(n)

7

1.4 Bäume

1.4

1 GRUNDLAGEN

Bäume

Ein Baum T besteht aus einem Knoten, der Wurzel, und einer Folge von Bäumen, den

unmittelbaren Teilbäumen oder Ästen.

Wurzel

w

w

1

w

w

2

n

Kinder

Ast

Bemerkung rekursive Definition; Terminierungsfall?

Die Wurzeln der Äste heißen Söhne oder Kinder der Wurzel, diese ist ihr Vater (parent); sie

sind Brüder voneinander; für i < j ist wi jünger als wj . Kinder und Kindeskinder etc. heißen

Nachkommen.

Ein Baum T ′ ist Teilbaum von T , wenn T = T ′ oder T ′ Teilbaum eines Astes von T ist.

• Grad eines Knotens:

Anzahl der Kinder

• Blatt = Knoten vom Grad 0; sonst: innerer Knoten

• Grad von t: maximaler Knotengrad in t

• Höhe eines Baumes:

Länge des längsten Weges (Anzahl der Kanten) von der Wurzel zu einem Blatt

• Höhe eines Knotens v:

Höhe des Teilbaumes mit Wurzel v

3

✔❆

✔✔ ❆❆

1

2

✁▲

✁✁ ▲▲

✆

✆

✆

0 1

0

❇

❇

❇

0

• Tiefe eines Knotens v:

Weglänge von der Wurzel zu v

0

✔❆

✔✔ ❆❆

1

✁▲

✁✁ ▲▲

2

1

✆

✆✆

2 2

❇

❇

❇

3

8

1.4 Bäume

1 GRUNDLAGEN

• Tiefe eines Baumes:

Die maximale Tiefe eines Baumes entspricht der maximalen Tiefe eines Blattes, also der

Höhe.

• Durchschnittliche Tiefe eines Baumes:

Die durchschnittliche Tiefe eines Baumes T ist als die durchschnittliche Tiefe seiner

= 2, 3

Blätter definiert, im Beispiel: 2+2+3

3

• Binärbaum:

Baum vom Grad ≤ 2; oft unterscheidet man linken und rechten Sohn, so dass ein Knoten

mit einem Sohn entweder einen linken oder einen rechten Sohn hat

• voller Binärbaum:

Jeder Knoten hat genau zwei Söhne (“innerer Knoten”) oder keinen Sohn (“Blatt”).

• vollständiger Binärbaum:

voller Binärbaum, bei dem alle Blätter dieselbe Tiefe haben

• vollständig ausgeglichener Binärbaum:

entsteht aus einem vollständigen Binärbaum, indem man Blätter von rechts entfernt

Zu jeder Knotenzahl n gibt es genau einen vollständig ausgeglichenen Binärbaum.

9

1.4 Bäume

1 GRUNDLAGEN

Lemma 1.6. Ein Baum vom Grad ≤ c mit c > 1 und der Tiefe ≤ d hat höchstens cd Blätter

und (cd+1 − 1)/(c − 1) Knoten.

Beweis: Induktion über d:

d = 0: Der Baum besteht nur aus der Wurzel und hat somit genau ein (= c0 ) Blatt und

einen (= c−1

c−1 ) Knoten.

d > 0: Der Baum besteht aus der Wurzel und bis zu c Teilbäumen, jeweils mit Tiefe ≤ d − 1

und Grad ≤ c, d. h. mit jeweils ≤ cd−1 Blättern und ≤ (cd − 1)/(c − 1) Knoten. Zusammen

sind dies ≤ ccd−1 = cd Blätter und ≤ 1 + c(cd − 1)/(c − 1) = (cd+1 − c + c − 1)/(c − 1) =

(cd+1 − 1)/(c − 1) Knoten.

✷

Lemma 1.7. Ein binärer Baum mit l Blättern hat mindestens Tiefe log(l).

Beweis: Folgt direkt aus Lemma 1.6.

Lemma 1.8.

Knoten.

✷

i) Ein vollständiger Binärbaum der Tiefe d hat 2d Blätter und 2d+1 − 1

ii) Für einen vollständig ausgeglichenen Binärbaum T der Tiefe d mit n Knoten und b

Blättern gilt:

d = ⌈log(n + 1)⌉ − 1 und b = (n + 1) div 2, d.h. n − b = n div 2.

Beweis: i) wie 1.6.

ii) d = 0 ok.

Sei d > 0. T besteht aus einem vollständigen Binärbaum T1 der Tiefe d− 1 und b′ zusätzlichen

Blättern. Nach i) ist 2d − 1 < n ≤ 2d+1 − 1, d.h. d + 1 = ⌈log(n + 1)⌉. Ferner ist n = 2d − 1 + b′ ,

und damit (n + 1) div 2 = 2d−1 + b′ div 2.

Von den 2d−1 Blättern von T1 werden b′ div 2 in T ‘verdoppelt’, d.h. b = 2d−1 + b′ div 2.

Damit ist (s.o.) (n + 1) div 2 = 2d−1 + b′ div 2 = b.

✷

d-1

T1

b'

10

1.5 Schichtnumerierung

1 GRUNDLAGEN

Lemma 1.9. Ein binärer Baum mit l Blättern hat mindestens die durchschnittliche Tiefe

log(l).

1.5

Schichtnumerierung

1

2

3

4

8

6

5

9

10

11

7

12

Bei vollständig ausgeglichenem Binärbaum hat der Knoten mit der Nr. i (ggf.) Kinder mit

Nr. 2i und 2i + 1. Denn: Knoten i habe Tiefe d ≥ 1 und mind. ein Kind. Oberhalb von i

ist ein vollständiger Binärbaum der Tiefe d − 1 mit 2d − 1 Knoten. In derselben Tiefe wie

i = 2d − 1 + r + 1 liegen 2d Knoten. Also ist s = 2d+1 − 1 + 2r + 1 = 2i.

d-1

d

2 -1

r

2r

i

s s'

11

1.5 Schichtnumerierung

1 GRUNDLAGEN

Markierte / beschriftete Bäume (z.B. Suchbäume)

1

9

2

20

5

3

6

10

4

5

6

3

Linearisierung: Abspeichern in einem Feld

Index: Nr. der Schichtnumerierung

Inhalt: Beschriftung

0

9

5 20 3

6 10

1

2

5

3

4

6

Bei vollständig ausgeglichenen Binärbäumen läßt sich der markierte Baum rekonstruieren:

Wurzel hat Index 1, Knoten mit Index i hat Kinder mit Index 2i und 2i + 1 soweit vorhanden.

12

2 LISTEN, KELLER UND WARTESCHLANGEN

2

Listen, Keller und Warteschlangen

Zu Beginn der Vorlesung wurde schon kurz der abstrakte Datentyp set (mit emptyset, isempty, iselem etc.) erwähnt, den man als Bitvektor (bei endlicher, nicht zu großer Grundmenge)

oder als aufsteigend sortierte Liste implementieren kann. Andere einfache Datentypen sind

Keller (bekannt aus Info II und TI) und Warteschlangen.

Keller (stack):

- Stack(): erzeugt einen leeren Keller

- push(x): legt x „oben auf“ den Keller

- pop(): liefert das „oberste“ Kellerelement und entfernt dies

- isempty()

Abb. 1 zeigt, wie ein Keller sich bei der Folge push(i), push(t), pop (liefert t), push(n),

push(u) entwickelt. Wiederholtes pop liefert jetzt den Kellerinhalt in umgekehrter Eingabefolge

– ein Keller folgt dem LIFO-Prinzip (last in, first out).

u

t

i

i

i

n

n

i

i

Abbildung 1

Wie Sie schon in Informatik II gehört haben, kann man einen Keller bei bekannter maximaler Elementzahl mit einem Feld realisieren; next gibt jeweils den Index der nächsten freien

Zelle von A an.

public class Stack

{ private int[] A ;

private int next ;

public Stack (int n)

{ A = new int[n] ; next = 0 ;

}

public void push (int x) /* not isfull */

{ A[next++] = x ;

}

public int pop () /* not isempty */

{ return A[--next] ;

}

public boolean isempty ()

13

2 LISTEN, KELLER UND WARTESCHLANGEN

{ return (next == 0) ;

}

}

Offenbar kann jede der Operationen in O(1), d.h. in konstanter Zeit unabhängig von der

Anzahl der gespeicherten Elemente ausgeführt werden.

Kennt man keine obere Schranke für die Anzahl der zu speichernden Elemente, benötigt

man eine dynamische Datenstruktur. Wir beschäftigen uns daher zunächst mit Listen und

kommen später auf den Keller zurück. Es gibt verschiedene Varianten von Listen; hier werden

wir doppelt verkettete Listen betrachten.

public class L2Elem

{ public int value ;

public L2Elem left, right ;

}

14

42

17

101

Abbildung 2

Die Liste selbst ist ein Kopfverbund (header) mit zwei Zeigern auf das erste und das letzte

Element, ggf. beide null (Konstruktor List2() ).

14

2 LISTEN, KELLER UND WARTESCHLANGEN

public class List2

{ private L2Elem fst, lst ;

public boolean isempty ()

{ return (fst == null) ;

}

public void prefix (int v)

{ L2Elem l = new L2Elem() ;

l.value = v ; l.right = fst ;

if (isempty())

fst = lst = l ;

else { fst.left = l ; fst = l ; }

}

public void postfix (int v)

{ L2Elem l = new L2Elem() ;

l.value = v ; l.left = lst ;

if (isempty())

fst = lst = l ;

else {

}

public int pop() /* not isempty */

{ int x = fst.value ;

fst = fst.right ;

if (isempty())

lst = null ;

else { fst.left = null ; }

return x ;

}

public boolean iselem(int x)

{ L2Elem l = fst ;

while (l != null)

if ( l.value = x) return true ;

else l = l.right ;

return false ;

}

}

15

2 LISTEN, KELLER UND WARTESCHLANGEN

Der Aufwand der ersten vier Operationen ist O(. . .), der von iselem ist O(. . .)

Mit List2 können wir einen Keller implementieren, wobei push durch prefix realisiert wird.

Warteschlange (queue):

- Queue(): erzeugt eine leere Warteschlange

- enq(x): hängt x hinten an die Warteschlange an (enqueue)

- deq(): liefert das erste Element der Warteschlange und entfernt dies (dequeue)

- isempty()

Eine Warteschlange folgt dem FIFO-Prinzip (first in, first out). Sie kann mit List2 implementiert werden: enq wird durch postfix, deq durch pop realisiert.

Dynamische Datenstrukturen erfordern im Vergleich zu einer Implementierung mit einem

Feld immer einen gewissen Extra-Aufwand: Speicherplatz organisieren und wieder freigeben,

Speichern und korrekte Verwaltung der Verweise. (Allerdings muss man beim Feld immer den

maximal benötigten Speicherplatz bereithalten.)

Warteschlange als Feld: Bei enq wird eine Zelle nach der anderen gefüllt, bei deq wird

unabhängig davon eine Zelle nach der anderen geleert. Man braucht also einen Zeiger, der

auf das erste Element zeigt, und eine Variable length, aus denen man die nächste freie Zelle

berechnen kann; an length kann man ablesen, ob die Warteschlange leer oder ganz voll ist.

Die Position der Warteschlange wandert also im Feld langsam nach rechts. Wenn man am

Ende ankommt,

16

3 SORTIEREN

3

Sortieren

3.1

Einfache Sortierverfahren

Neben dem Sortieren durch Einfügen (Insertion Sort), s.o., beschreiben wir kurz:

Sortieren durch Minimumssuche (Selection Sort)

• typischer Schritt:

Anfangsstück (zunächst leer) ist sortiert und enthält die kleinsten Elemente. (Dies ist

wieder eine (Schleifen-)Invariante.)

Suche minimales Element im Rest und füge es an das Anfangsstück an – um die Zahl

der Vertauschungen klein zu halten, mit 1 Vertauschung.

• immer (n − 1) + (n − 2) + . . . + 1 Vergleiche, also ist selbst der beste Fall Θ n2

• stabil?

3.2

Quicksort

1. wähle sog. Pivot(-Element) x in a

2. partitioniere a in zwei Teile mit Elementen ≤ x im linken und ≥ x im rechten Teil

3. sortiere die Teile genauso

Bemerkung: Beispiel für das Prinzip „divide and conquer“ (teile und herrsche, divide et

impera), nach dem man eine Aufgabe aufteilt, die Teile rekursiv löst und aus diesen Lösungen

die Gesamtlösung ermittelt. (Der letzte Schritt ist bei Quicksort trivial.)

Zu 2.: Zwei Zähler (Zeiger) i und j durchlaufen das Feld von links bzw. von rechts (bis sie

sich treffen); jedesmal wenn dabei a[i] > x und a[j] < x, werden a[i] und a[j] vertauscht. Der

Aufwand ist also linear: c · n

Ist x immer das kleinste Element, spaltet man jedes Mal einfach nur 1 Element ab; der

Gesamtaufwand ist also c · n + c · (n − 1) + . . . + c · 2, d. h. O n2 .

Dieser Fall tritt auch ein, wenn alle Elemente gleich sind – “i hält alle Elemente für klein”.

Besser: auch tauschen, wenn a[i] = x bzw. a[j] = x, um gleichmäßig zu teilen.

Zu 1.: essentiell!

Zufällige Wahl von x ist aufwendig, evtl. auch nicht wirklich zufällig. x := a[0] ist praktisch

ungünstig, da die Eingabe oft ein wenig vorsortiert ist; dann ist die Aufteilung jedesmal sehr

ungleichmäßig. Optimal wäre der Median (der Größe nach n2 -tes Element), dessen Bestimmung

aber aufwendig ist.

Median-of-3 sortiert das erste, letzte und mittlere Element in a; der mittlere Wert dient als

x. Dabei soll swap(a,l,r) die Elemente a[l] und a[r] vertauschen.

17

3.2 Quicksort

3 SORTIEREN

int median3(int[] a, int l, int r)

{

int m = (l+r)/2;

if (a[l] > a[m])

swap(a,l,m);

if (a[l] > a[r])

swap(a,l,r); /* kleinstes links */

if (a[m] > a[r])

swap(a,m,r);

swap(a,m,r-1); /* Pivot verstecken */

return a[r-1]; }

Damit steht links ein kleines und rechts ein großes Element als Wächter (sentinel); damit

laufen j und i nicht über den Rand des Feldes, ohne dass wir dies jedesmal durch einen

Vergleich mit l bzw. r prüfen müssen (s.u. Bsp.). Als Ausgleich für den Aufwand in Medianof-3 beginnen die Vergleiche mit x bei a[l + 1] bzw. a[r − 2]; das Pivot kommt zum Schluss in

die Mitte und muss in keiner Hälfte berücksichtigt werden.

Für kleine Felder (die gegen “Ende” der Rekursion zahlreich auftreten), ist Quicksort zu

aufwendig ( – außerdem: was ist Median-of-3 bei zwei Elementen?); besser: Sortieren durch

Einfügen. Als cutoff wird ungefähr 10 empfohlen. Organisatorisch gut: kleine Teilfelder unsortiert lassen und zum Schluß einmal Sortieren durch Einfügen.

void quicksort (int[] a, int n)

{ qsort (a,0,n-1);

insertsort (a,n);

}

void qsort (int[] a, int l, int r)

{ int i,j;

int x; /* Element-Typ */

if (l+cutoff <= r)

{ x= median3(a,l,r);

i=l; j=r-1;

for ( ; ; )

{ while (a[++i] < x) {}

while (a[--j] > x) {}

if (i<j)

swap(a,i,j);

else

break;

}

18

3.2 Quicksort

3 SORTIEREN

swap(a,i,r-1); /* restore pivot */

qsort (a,l,i-1);

qsort (a,i+1,r);

}

}

Tip: Code von swap explizit einfügen.

Bsp. 8 7 4 9 0 3 5 2 1 6

↑

↑

↑

median-of-3 → 6

0749135268

↑

↑

i

j

↑

↑

i

j

// Wächter

0249135768

↑

↑

i

j

0245139768

↑↑

j i

restore pivot

9 8}

0| 2 4{z5 1 3} 6 7| {z

beachte: Jetzt lässt Insertion Sort automatisch die gefundene Teilung unberührt; es führt

z.B. auf den Zwischenzustand 0 1 2 3 4 5 | 6 7 9 8

Aufwand: Im schlechtesten Fall werden jeweils mit linearem Aufwand zwei Elemente abgespalten. (median-of-3: z.B. das kleinste und das zweitkleinste) Also: O(n2 )

Warum linearer Aufwand? Die Zuweisungen an x, i und j, das letzte swap und die rekursiven

Aufrufe (ohne Durchführung) erfordern nur konstante Zeit. In der for-Schleife durchlaufen i

und j maximal den Bereich von l bis r, wobei für jeden i- bzw. j-Wert höchstens einmal

inkrementiert/dekrementiert, eine while- und eine if-Bedingung geprüft sowie einmal geswappt

wird; dieser Aufwand ist proportional zur Bereichslänge, d.h. linear.

Der beste Fall

Das Feld wird immer in der Mitte geteilt (ohne Beweis), für die Laufzeit BT gilt im Prinzip:

BT (n) = 2 · BT n2 + c · n

19

3.3 Untere Schranke für vergleichsbasierte Verfahren

3 SORTIEREN

Also: (für n = 2k )

BT (n)

n

BT n2

n

2

BT (2)

2

=

=

BT

n

2

BT

n

4

..

.

=

n

2

n

4

+c

+c

BT (1)

+c

1

Insgesamt gibt es log n Gleichungen dieser Art. Einsetzen ergibt: BTn(n) = BT1(1) + c · log n,

d.h. BT (n) ∈ O (n log n). Für allgemeines n kann man die Laufzeit wegen Monotonie durch

die Laufzeit der nächsten 2er-Potenz abschätzen:

Ist n ≤ 2k < 2n, so ist BT (n) ≤ BT (2k ) ∈ O(2k log 2k ) ⊆ O(2n log(2n). Wegen 2n log(2n) =

2n log n + 2n ∈ Θ(n log n) erfordert der beste Fall also für jedes n O (n log(n)); dies gilt auch

im Durchschnittsfall mit recht kleinen Konstanten. Trotz Aufwands O(n2 ) im schlechtesten

Fall ist Quicksort das praktisch beste Sortierverfahren!

Quickselect

Zur Bestimmung des k-größten Elementes von a verwendet man Quicksort, sortiert aber

jeweils nur den passenden Teil soweit nötig.

worst case: O n2 (es werden mit linearem Aufwand 2 Elemente abgespalten)

im Schnitt: O(n), auch bei der Medianbestimmung

3.3

Untere Schranke für vergleichsbasierte Verfahren

Es soll jetzt eine untere Zeitschranke für Sortierverfahren angegeben werden, welche die zu

sortierenden Elemente nur untereinander vergleichen und vertauschen. Man nimmt an, daß

alle Elemente verschieden sind. Dazu definiert man den Entscheidungsbaum eines Verfahrens

(für ein n), einen Binärbaum, dessen

• Knoten jeweils einen Zwischenzustand durch die Menge aller Anordnungen beschreiben,

die mit den bisherigen Vergleichen konsistent sind

• Kanten aus Knoten v mit den Ergebnissen des nächsten Vergleiches nach v beschriftet

sind

Ein Ablauf des jeweiligen Verfahrens entspricht einem Pfad von der Wurzel zu einem Blatt;

das Blatt darf nur eine Anordnung enthalten, denn keine zwei Anordnungen lassen sich durch

dieselben Vertauschungen sortieren. Der Entscheidungsbaum hat also ≥ n! Blätter.

Beispiel: median3 sortiert 3 Elemente folgendermaßen:

{ if (a[1] > a[2])

swap(a,1,2);

if (a[1] > a[3])

swap(a,1,3); /* kleinstes links */

20

3.4 Heapsort

3 SORTIEREN

if (a[2] > a[3])

swap(a,2,3);

}

Ausschnitt des zugehörigen Entscheidungsbaums in Abb. 3:

b1 b2 b3

b1<b2<b3, b1<b3<b2, ..., b3<b2<b1

b1< b2

b1 > b2

b2 b1 b3

b2<b1<b3, b2<b3<b1, b3<b2<b1

b2< b3

b2 b1 b3

b3< b2

b2<b1<b3, b2<b3<b1

b3<b2<b1

b3 b1 b2

Abbildung 3

Satz 3.1. Ein Sortierverfahren, das Elemente nur vergleicht und vertauscht, benötigt

i) ≥ log(n!) Vergleiche im schlimmsten Fall und im Durchschnitt

ii) Ω(n log n) Zeit im schlimmsten Fall und im Durchschnitt

Beweis: i) folgt aus Lemmata 1.7 und 1.9

ii) folgt aus i), denn:

n

n

P

P

log(n!) =

log i ≥ n2 log n2 =

log i ≥

i=1

i=n/2

n

2

log n −

Bem.:

n

P

•

log(i) ≤ n log(n) – die Abschätzung ist optimal

n

2

∈ Ω(n log n)

✷

i=1

• Quicksort hat unter vergleichsbasierten Sortierverfahren optimale Durchschnittseffizienz.

3.4

Heapsort

3.4.1

Halden

bilden eine nicht nur für Heapsort, sondern oft nützliche Datenstruktur.

Eine (Max-)Halde (heap) ist ein markierter vollständig ausgeglichener Binärbaum, so daß:

die Markierung eines Knotens ist immer ≥ den Markierungen seiner Kinder (ggf.), wobei

≥ eine totale Ordnung auf der Menge der Markierungen

Min-Halden sind analog definiert. Für Max-Halden gilt:

– jeder Knoten trägt das Maximum seines Teilbaums;

21

3.4 Heapsort

3 SORTIEREN

– jeder Teilbaum ist auch eine Halde;

– jeder Baum mit nur einem Knoten ist eine Halde.

Ein Feld heißt Halde, wenn es Linearisierung einer Halde ist (vgl. Schichtnumerierung);

äquivalent: int a[n+1] ist Halde, gdw. grbed(a, i, n) für i = 1, . . . , n gilt, wobei

grbed(a, i, j) ≡ (2i + 1 > j || a[i] ≥ a[2i + 1]) && (2i > j || a[i] ≥ a[2i])

Intuitiv: Die Haldenbedingung gilt für den Knoten i, wenn die Halde in a[1] bis a[j] abgelegt

ist; wäre ein oder beide Kinder > j, so hat i nur ein oder kein Kind, das die Haldenbedingung

verletzen könnte. Man beachte, daß a[0] ungenutzt bleibt und insbesondere || das sequentielle

Oder ist.

1.Ziel: Feld a durch Vertauschungen in Halde umwandeln; dazu:

Einbettung (in ein allgemeineres Problem): Haldenbedingung für Teilbereiche definieren

und solche Teilbereiche ausweiten

Definition: heap(a, i, j) bedeutet grbed (a, k, j) für k = i, . . . , j.

Teilbäume sind Halden

w i

j

Abbildung 4

Also ist a Halde, gdw. heap(a, 1, n).

Zunächst: Alle Blätter sind Halden; es gilt also heap(a, ⌊n/2⌋ + 1, n), vgl. Lemma 1.8; die

hintere Feld-Hälfte ist also ok. (Wie sieht man das anhand der Definition?)

Gesucht: „Vertauschung“ sift(a, i, j), die aus heap(a, i, j) heap(a, i − 1, j) macht; dann ist

buildmaxheap:

for(i= n/2 + 1; i>1; i--) /* heap(a,i,n) */

sift(a,i,n);

// heap(a,1,n)

Bem.: Zu Beginn und nach jedem Schleifendurchlauf gilt die Schleifeninvariante heap(a, i, n);

am Ende gilt daher heap(a, 1, n).

sift(a, i, j) muß Teilbaum mit Wurzel w = i−1 (Abb. 4) in Halde umwandeln. Dazu muß bei

w das Maximum des Teilbaums stehen; die Kinder tragen schon die Maxima ihrer Teilbäume;

also: w hat größeren Wert als 2w und 2w + 1 oder w tauscht mit maximalem Kind, d.h. der

Wert von w rieselt nacht unten.

Es gilt die Invariante P: heap(a, i − 1, j) außer dass die Haldenbedingung beim jeweiligen

Wert von w verletzt sein kann. Damit ist sift(a, i, j):

22

3.4 Heapsort

3 SORTIEREN

/* heap(a,i,j) && i>1*/

for (w= i-1, s= 2*w /* P */; s<=j; w=s, s= 2*w /* P */)

{

if (s<j && a[s] < a[s+1])

s++; // s ist größtes Kind

if (a[w] < a[s])

swap(a,w,s);

else

break; /* heap(a,i-1,j) */

}

/* heap(a,i-1,j) oder (P && s>j), also heap(a,i-1,j) */;

Beispiel:

2

5/2 +1 = 3

2

4 8

7

1

4

8

7

sift(a,3,5)

2

7 8

4

1

1

8

7

sift(a,2,5)

8

7

2

4

1

4

2

1

Aufwand für sift(a,i,j)

je Schicht zwischen w = i − 1 und j in Abb. 4 ein „Schritt“

i − 1 ist in Schicht ⌈log i⌉ − 1 nach Lemma 1.8

j ist in Schicht ⌈log(j + 1)⌉ − 1

also: ungefähr log j − log i + 1 = log(j/i) + 1

Aufwand für buildmaxheap

Z.B. braucht sift(a, 2, n) O(log n) Zeit, also zusammen O((n/2) log n); besser:

P n

P∞

i

i

Zusammen: log

i=1 (n/2 )i ≤ n

i=1 (i/2 ) = 2n; demnach arbeitet buildmaxheap in O(n).

23

3.4 Heapsort

3 SORTIEREN

Maximale Schrittzahl

bei sift

1 Element mit

log n

2 Elemente mit log (n/2)

n/8 Elemente mit

3

n/4 Elemente mit

2

n/2 Elemente mit 1

3.4.2

Heapsort

Wir gehen hier von einem Feld int a[n+1] aus, bei dem a[0] irrelevant ist und a[1] bis a[n]

sortiert werden sollen.

buildmaxheap;

for (j= n; j>1; )

deletemax;

Dabei ist deletemax:

/* heap(a,1,j) && j>1*/

swap(a,1,j]); // heap(a,2,j-1)

j--; // heap(a,2,j)

sift(a,2,j); // heap(a,1,j)

maximale Elemente

sortiert

Halde

1

j

Aufwand: deletemax: O(log j) (für sift)

P

P

Heapsort: O(n + nj=1 log j) ⊆ O(n + nj=1 log n) = O(n log n)

Heapsort sortiert also optimal.

Bemerkung: Quicksort und Heapsort brauchen im Schnitt O(n log n); dabei hat Quicksort

einen besseren konstanten Faktor als Heapsort; es gibt aber auch Verbesserungen von Heapsort.

Heapsort ist nicht stabil und macht sich bei weitgehend sortierten Feldern sehr viel Arbeit

(da es große Elemente zunächst nach vorn bringt).

24

3.4 Heapsort

3.4.3

3 SORTIEREN

Vorrangswarteschlangen

(priority queue)

Speicherung von beschränkt vielen Elementen, die je nach Priorität zu bedienen sind; Operationen:

i) makeemptyprio, isemptyprio

ii) Finden und Entfernen des Maximums

iii) Einfügen eines neuen Elements

Implementierung durch Halden (wobei evtl. auch buildmaxheap zum Aufbau herangezogen

werden kann):

i) ok (langes Feld und ?

)

ii) wie deletemax

iii) Idee: analog zu sift, neues Element hinten anfügen und aufsteigen lassen; Übung!

Priorityqueues mit bis zu n Elementen unterstützen:

i) makeemptyprio, isemptyprio in O(1)

ii) deletemax und insert in O(log n)

iii) Aufbau aus einem Feld in O(n)

Anwendung z.B. bei Halten von Bestenlisten bei fortlaufend anfallenden Ergebnissen; s.a.u.

25

3.5 Bucket Sort, Radix Sort

3.5

3 SORTIEREN

Bucket Sort, Radix Sort

Satz 3.1 ist nicht immer anwendbar. Will man z.B. kleine natürliche Zahlen ai ∈ {0, . . . , m}

sortieren, so verwendet man Bucket Sort, das für int bucket[m+1]

• bucket mit Nullen initialisieren

O(m)

• ai ’s durchlaufen und jeweils bucket[ai ] um 1 erhöhen

O(n)

• bucket durchlaufen und jeweils bucket[i]-mal i ausgeben

O(m + n)

Satz 3.2. Bucket Sort sortiert in O(m + n); bei n ∈ Ω(m) also in linearer Zeit.

Sind die ai Verbunde, so

Erweiterung: ai ∈ {0, . . . , m}2 , (ai1 , ai2 ) < (aj1 , aj2 ) ⇐⇒ ai1 < aj1 ∨(ai1 = aj1 ∧ai2 < aj2 )

(lexikographische Ordnung)

• Bucket Sort zunächst nach ... Komponente sortieren lassen,

• dann nach ... Komponente

Beispiel: m = 2

a: (0,2) (2,2) (2,1) (1,2)

Zeit: O(2(m + n))

Allgemein können ai ∈ {0, . . . , m}k in O(k(m+n)) sortiert werden. Im Rechner darstellbare

natürliche Zahlen können (oft) als Elemente von {0, 1}31 oder von {0, . . . , 15}8 gesehen werden;

das allgemeine Bucket Sort heißt in diesem Fall Radix Sort.

3.6

Externes Sortieren

Bisher lagen bei Sortierverfahren wie z.B. Quicksort und Heapsort die Daten in einem array

vor; größere Datenmengen benötigen u.U. viel mehr Speicherplatz; also externe Speichermedien mit sequentiellem und vergleichsweise langsamem Zugriff (ursprüngich Magnetbänder,

externe Festplatten); somit andere Sortierverfahren.

Grundidee dabei ist das Mischsortieren ( Mergesort), das wie Quicksort dem Paradigma

divide and conquer folgt. Hier teilt man (ohne Aufwand) die Eingabe in zwei Hälften; diese

sortiert man nach demselben Verfahren und mischt (mit Aufwand) die Ergebnisse zusammen.

Bsp.:

71954281❀7195|4281❀71|95|42|81❀7|1|9|5|4|2|8|1

❀ 1 7 | 5 9 | 2 4 | 1 8 ❀ 1 5 7 9| 1 2 4 8 ❀ 1 1 2 4 5 7 8 9

Beim Mischen durchläuft man die beiden Ergebnisse (z.B. die letzten beiden Teilergebnisse)

gleichzeitig und übernimmt das jeweils kleinere Element ins Endergebnis. (Z.B. die beiden 1en,

dann 2 (<5) und 4 (<5), 5 (<8) etc.) Um dies wirklich mit sequentiellem Zugriff zu realisieren,

müssen die Teilergebnisse in verschiedenen Dateien liegen, man braucht also zusätzlichen

linearen Platz.

26

3.6 Externes Sortieren

3.6.1

3 SORTIEREN

Direktes Mischen

Idee: Wiederholtes Aufteilen der Eingabedaten auf Hilfsdateien und Mischen dieser Dateien:

3-Band-Mischen

7948

17 24

1579

71954281❀

❀ 17 59 24 18 ❀

❀ 1579 1248 ❀

❀ 11245789

1521

59 18

1248

Ein Lauf (run) ist ein aufgrund des Verfahrens sortiertes Teilstück von Daten in einer der

Dateien. (Statt Datei sagt man oft Band.)

Bei jedem Aufteilen und Mischen verwendet man auf jede Zahl konstante Zeit, also zusammen jeweils O(n) Zeit. Da sich jedesmal die Länge des Laufs verdoppelt, bis n erreicht ist,

wird ⌈log n⌉-mal aufgeteilt und gemischt; es ergibt sich also O(n log n) Zeit.

In Java muss man auf die Dateien abwechselnd als Input- und Output-Streams zugreifen; um

von den entsprechenden Java-Details zu abstrahieren, erfinden wir Mstreams: Für Mstream

a liefert a.read jeweils die nächste Zahl von a, bzw. a.write(x) hängt die Zahl x an a an;

zwischen Lese- und Schreibphasen muss man a.reset ausführen (Geschriebenes von vorn lesen

bzw. löschen und neu beschreiben); ob beim Lesen das Ende der relevanten Daten erreicht

ist, prüfen wir mit a.eof etc. (end of file).

Wir nehmen an, dass uns Mstreams a (für die Eingabe), b und c gegeben sind.

27

3.6 Externes Sortieren

3 SORTIEREN

Top-down-Entwurf des Verfahrens:

void directmergesort()

/* Sortiert a mit Hilfe von b und c */

{ int k; /* Größe der Runs */

k=1;

while (k<n)

{ distribute(k);

a.reset; b.reset; c.reset;

directmerge(k);

a.reset; b.reset; c.reset;

k*=2;

}

}

void distribute(int k)

/* Verteilt Teilstücke der Länge k von a abwechselnd auf b und c */

{ while (!a.eof)

{ copyrun(k,a,b); /* zuerst auf b schreiben */

copyrun(k,a,c); /* dann auf c */

}

}

void copyrun(int k, Mstream a, Mstream b)

/* Kopiert k Elemente von a nach b (soweit vorhanden) */

{ while (k >0 && !a.eof)

b.write(a.read); k--; }

void directmerge(int k)

/* Mische Sequenzen der Länge k > 0 aus b und c mit |b|, |c| ≥ 1 nach a */

{ while(!b.eof && !c.eof)

{ mergerun(k);

}

copyrest(b,a);

copyrest(c,a);

}

void mergerun (int k)

/* Mische je k > 0 Elemente von b und c mit |b|, |c| ≥ 1 nach a */

{ int x,y;

int i,j;

i=j=k; /* Wieviele Elemente aus b bzw. c sind noch zu übertragen? */

x = b.read; y = c.read;

28

3.6 Externes Sortieren

3 SORTIEREN

do

{ if (x<=y)

{ a.write(x); i--;

if(i>0 && !b.eof)

x = b.read;

else i=0; /* Schleifenterminierung */

}

else . . .

}

while (i>0 && j>0);

if(i==0)

{ a.write(y);

copyrun(j-1,c,a); /* Rest kopieren*/

}

if(j==0) . . .

}

3.6.2

Verbesserungen

• Man halbiert die Anzahl der Durchgänge durch die Daten (langsamer Zugriff auf externes Medium!), indem man die unproduktive Verteilungsphase (a nach b und c) einspart;

stattdessen werden die zusammengemischten Läufe gleich wieder auf zwei andere Dateien verteilt: Direktes 4-Band-Mischen (benötigt 4 Dateien)

• Sind 2m Dateien vorhanden, kann man auf jeweils m Dateien verteilen. Beim direkten m-Weg-Mischen verlängern sich die Läufe auf das jeweils m-fache. Die Anzahl der

log2 n

Durchläufe verringert sich dadurch auf logm (n) = log

m.

2

• Idee: Verlängerung der 1-Läufe zu Beginn des Verfahrens auf m-Läufe. Dazu liest man

beim ersten Verteilen m Elemente in den Hauptspeicher (m geeignet) und sortiert sie

mit Quicksort/Heapsort o. ä.

3.6.3

Natürliches Mischen

Ausnutzen bereits vorsortierter Teilfolgen; hier ist ein Lauf eine maximale vorsortierte Teilfolge.

Beispiel:

Aufteilen:

Mischen:

a

b

c

a

2

2

3

2

8 | 3 23 | 10 12 27 | 16 | 5 9

8 | 10 12 27 | 5 9

23 | 16

3 8 10 12 23 27 | 5 9 16

u. s. w.

Statt viermal Teilen/Mischen ist nur noch zweimal Teilen/Mischen notwendig. Dieses Verfahren heißt natürliches 3-Band-Mischen. Beim natürlichen Mischen kann sich die Zahl der

Durchgänge vermindern, besonders, wenn die Daten schon etwas vorsortiert sind. Dafür fällt

ein erhöhter Verwaltungsaufwand zur Erkennung der Läufe an, der aber im Vergleich zum

Dateizugriff eher eine geringe Rolle spielt.

29

3.6 Externes Sortieren

3.6.4

3 SORTIEREN

Verbesserungen des natürlichen Mischens

Wie in 3.6.2 kann man

• sich die Verteilungsphasen sparen, indem man die gemischten Läufe sofort verteilt: natürliches 4-Band-Mischen

• die Anzahl der Durchgänge durch Verwendung von zusätzlichen Bändern vermindern:

natürliches m-Weg-Mischen

Die Verlängerung der anfänglichen Läufe läßt sich wie folgt verfeinern:

Einlesen von m Elementen in ein Feld; buildminheap;

do { deletemin liefert nächstes Element e für den augenblicklichen Lauf;

Einlesen des nächsten Elements e′ ;

if (e′ ≥ e) insert(e′ );

else e′ im freiwerdenden Teil des Feldes ablegen; */ vgl. Heapsort */

}

while (Halde nicht-leer)

Jetzt stehen im Feld m Elemente; zur Erstellung des nächsten Laufes beginnt man also

direkt mit buildheap.

12 3 24 6 5 38 20 33 ...

Beispiel:

m=3 Elemente einlesen und buildheap:

3.6.5

Mehrphasenmischen

Jetzt will man den Vorteil des 4-Band-Mischens mit nur 3 Bändern erzielen. Dazu mischt man

die Läufe zweier Bänder auf das dritte Band; ist eines der beiden Bänder erschöpft, mischt

man die restlichen Läufe des anderen Bandes mit denen des dritten. Die ursprünglichen Läufe

müssen also ungleichmäßig verteilt werden:

Beispiel: 21 Läufe; gleichmäßige Teilung ergibt (jeweils Anzahl Läufe mit Länge indiziert):

D1

D2

D3

0

101

111

102

0

11

92

13

0

82

0

15

72

17

0

...

Jedesmal wird ein immer länger werdender Lauf durchgearbeitet, aber wenig gewonnen.

Teilung 41 zu 43 :

D1

D2

D3

0

5

16

5

0

11

0

5

6

1:3

1:2

1:1

5

0

1

4

1

0

...

30

3.6 Externes Sortieren

3 SORTIEREN

Damit das Verhältnis stabil bleibt und die ursprünglichen Läufe spätestens in der zweiten

2

Phase gemischt werden, sollte dd23 = d3d−d

sein (❀ goldener Schnitt; Fibonacci-Zahlen).

2

(f ib(1) = f ib(2) = 1; f ib(n) = f ib(n − 1) + f ib(n − 2) für n > 2)

D1

D2

D3

0

81

131

82

0

51

32

53

0

0

23

35

28

0

15

18

113

0

0

0

121

21 = f ib(8)

Ist die Anzahl der Läufe keine Fibonacci-Zahl, so füllt man bis zur nächsten FibonacciZahl mit Dummy-Läufen auf. Bei mehr als drei Bändern kann man Fibonacci-Zahlen höherer

Ordnung zur Aufteilung verwenden:

f ib2 = f ib;

f ib3 (n) = f ib3 (n − 1) + f ib3 (n − 2) + f ib3 (n − 3); . . .

31

4 MENGENVERWALTUNG

4

Mengenverwaltung

Wir wollen mittels der Operationen insert, delete und iselem eine Menge von Daten mit

Schlüsseln verwalten; vgl. Datenbanken. In Kapitel 1 haben wir schon kurz über binäre Suche

gesprochen; ähnlich wollen wir im ersten Teil dieses Kapitels die Menge in „die Kleineren“ und

„die Größeren“ aufteilen. Abweichend suchen wir nach einer dynamischen Datenstruktur, und

auch insert soll schneller gehen. Binäre Bäume liefern (immer wieder) eine Aufteilung in den

linken und den rechten Ast.

4.1

Baumdurchläufe

Man kann die Knoten eines Baums in verschiedener Weise systematisch durchlaufen (und

dabei bearbeiten). In der Präfixordnung läuft man zuerst die Wurzel an und durchläuft danach die Äste von links nach rechts in gleicher Weise; Postfixordnung analog, Wurzel zuletzt.

Infixordnung bei Binärbäumen: linker Ast, Wurzel, rechter Ast.

Die 3 Durchläufe für die beiden linken Bäume in Abb. 5 sind:

• 9 17 3 20 10 6, 3 17 10 6 20 9, 3 17 9 10 20 6

• 9 5 3 6 20 10,

Ein Baum ist (aufsteigend) sortiert wenn seine Infixordnung aufsteigend sortiert ist, d.h.

wenn für jeden Knoten im linken Ast kein größerer und rechten Ast kein kleinerer Wert steht.

17

3

*

9

9

10

20

5

20

6

3

6

10

-

+

3

6

10

Abbildung 5

Der rechte Baum ist der Strukturbaum eines Terms, der aufgrund der Baumstruktur ein

Produkt einer Summe und einer negativen Zahl ist. Infixordnung 3 + 6 ∗ - 10 ist fast der

Term, aber

Aus der Präfixordnung ∗ + 3 6 - 10 (polnische Notation) kann man den Term . . . . . . . . .

rekonstruieren, zumindest wenn man die Stelligkeit der Operationen kennt (Problem mit -):

Der Term ist ein Produkt, der erste Operand ist eine Summe, d.h. bei - beginnt der zweite

Operand.

Bem.: Bei (-10) ∗ (3+6) erhält man ∗ - 10 + 3 6 und könnte denken, man soll 10 - (3+6)

berechnen.

Postfixordnung: 3 6 + 10 - ∗ (umgekehrt polnische Notation); so arbeitet der Rechner:

beschaffe Dir zwei Operanden (z.B. Werte aus dem Speicher), berechne Summe (die man für

spätere Zwecke aufbewahrt), beschaffe Dir Operanden und wechsle das Vorzeichen, wende *

auf die beiden Ergebnisse an.

32

4.2 Binäre Suchbäume

4.2

4 MENGENVERWALTUNG

Binäre Suchbäume

Ein (beschrifteter) binärer Baum ist ein Suchbaum, wenn für jeden Knoten im linken Ast

nur kleinere und im rechten Ast keine kleineren Werte stehen; vgl. Baum oben mitte. Für

wiederholungsfreie Binärbäume (d.h. injektive Beschriftung) ist dies dasselbe wie sortiert; wir

betrachten in diesem Abschnitt 4.2 nur solche.

public class BinNode

{ public int value ;

public BinNode leftson, rightson ;

public BinNode (int v, BinNode l, BinNode r)

{ value = v ; leftson = l ; rightson = r ;

} }

public class SBinTree

{ private BinNode root ;

public boolean isempty ()

{ return (root == null) ; }

public boolean iselem(int x)

{ BinNode b = root ;

while ( b != null)

{ if ( b.value == x ) return true ;

if ( x < b.value ) b = b.leftson ;

else b = b.rightson ;

}

return false ; }

private void insertsub(BinNode b, int x)

{ if ( x < b.value )

{ if (b.leftson == null ) b.leftson = new BinNode (x, null, null) ;

else insertsub(b.leftson,x) ;

}

else { if ( x > b.value ) ... insertsub(b.rightson,x) ; }

}

public void insert(int x)

{ if ( root == null)

root = new BinNode (x, null, null) ;

else insertsub(root,x) ;

} }

33

4.3 2-3-Bäume

4 MENGENVERWALTUNG

Was geschieht in insertsub, wenn x = b.value?

Partielle Korrektheit von insertsub verlangt, dass im Terminierungsfall x in den Suchbaum

b eingefügt wird, falls es neu ist. Je nach If-Abfrage wird es links oder rechts eingefügt. Im

ersten Fall ist der Then-Zweig ein Terminierungszweig; hier wird die Spezifikation erfüllt (

wegen x < b.value). Im Else-Zweig können wir annehmen, dass insertsub(b.leftson,x) das

gewünschte leistet; da die alten Werte im Baum b.leftson und wegen der Abfrage auch das

neue x kleiner als b.value sind, ist der umgebaute Baum b wieder ein Suchbaum, der zusätzlich

x enthält.

Warum ist dieses Vorgehen beim Korrektheitsbeweis selbst korrekt?

Wiederholung: Bei nur einem Aufruf, landen wir im Terminierungszweig, und der ist korrekt.

Angenommen, bei ≤ n Aufrufen ist das Ergebnis korrekt. Erfordert der Aufruf insertsub(b,x) n + 1 Aufrufe, so führt dieser erste Aufruf o.E. auf den Aufruf insertsub(b.leftson,x).

Da dieser also n Aufrufe erfordert, ist das Ergebnis nach Ind.ann. korrekt; wir haben oben

gezeigt, dass dann auch der Aufruf insertsub(b,x) das Gewünschte leistet.

Der obige Suchbaum (Abb. 5 mitte) entsteht z.B. aus

SBinTree() insert(9) insert(5) insert(3) insert(20) insert(6) insert(10) . Dauert iselem nun immer O(log n)?

Betrachten Sie SBinTree().insert(20).insert(10).insert(9).insert(5).insert(3) .

Tatsächlich ist der schlechteste Fall

Ist der Baum aber (einigermaßen) ausgeglichen, so hat er Tiefe O(log n), vgl. Abschnitt 1.5;

b steigt jeweils mit konstantem Aufwand zur nächsttieferen Schicht ab. Zudem gibt es Methoden, einen Suchbaum durch Umbauten „balanciert“ zu halten (s. AVL-Bäume). Eine andere

Möglichkeit besteht darin, den Baum sehr ausgeglichen zu halten, aber dabei auch mehr als

2 Kinder zuzulassen:

4.3

2-3-Bäume

In einem 2-3-Baum hat jeder innere Knoten 2 oder 3 Kinder, alle Bätter sind in derselben

Tiefe. Die inneren Knoten enthalten nur Schlüsselwerte als Trenninformation, in einem Blatt

liegt dann ein ganzer Datensatz; da bei einer Operation nur auf ein Blatt zugegriffen wird,

kann man den Datensatz auch auf einen externen Speicher legen – das Blatt hält dann dessen

Adresse.

Bem.: Es gibt auch allgemeinere B-Bäume, bei denen die inneren Knoten ⌈M/2⌉ bis M

Kinder (die Wurzel 2 bis M Kinder) haben.

Die Trenninformation besteht jeweils aus 1 oder 2 Werten, dem kleinsten Wert im 2. Ast

und ggf. dem kleinsten Wert im 3. Ast.

Suche nach 18 im 2-3-Baum in Abb. 6: 18 ≥ 7, also nicht im 1. Ast; 18 ≥ 16, also nicht im

2. Ast – gehe in den 3.; 18 ≥ 18, also nicht im 1. Ast; 18 < 19, also im 2. Ast.

Sei n die Mächtigkeit der Menge, also die Anzahl der Blätter; sei ferner h die Höhe des

Baums. Dann hat der Baum zwischen 2h und 3h Blätter, also h ≤ log n ≤ h log 3. Demnach

hat der Baum immer logarithmische Höhe und wir werden auf eine Suchzeit von O(log n)

kommen.

34

4.3 2-3-Bäume

4 MENGENVERWALTUNG

7 16

5

2

18 19

8 12

5

7

8

12

16

18

19

Abbildung 6

public class Node23

{ public int value ;

public boolean isleaf ;

public Node23 son1, son2, son3 ;

public int lowof2, lowof3 ;

public Node23 (int v)

{ value = v ; isleaf = true ;

}

public Node23 (Node23 s1, Node23 s2, int lo2)

{ isleaf = false ; son1 = s1 ; son2 = s2 ; lowof2 = lo2 ;

}

public boolean twosons () /* innerer Knoten */

{ return (son3 == null) ;

}

}

Besser: Node23 hat zwei Unterklassen für Blätter (nur mit value) und innere Knoten (ohne

value), um Speicherplatz zu sparen ; isleaf kann ersetzt werden durch

public class Tree23

{ private Node23 root ;

public boolean isempty ()

{ return (root == null) ;

}

public boolean iselem(int x)

{ Node23 b = root ;

if ( b == null) return false ;

while ( ! b.isleaf )

{ if ( x < b.lowof2 ) b = b.son1 ;

else if ( b.twosons() || x < b.lowof3 ) /* sequentielles oder */

b = b.son2 ;

35

4.3 2-3-Bäume

4 MENGENVERWALTUNG

else b = b.son3 ;

}

return ( b.value == x ) ;

}

}

Je Schicht konstanter Aufwand, also insgesamt O(log n) wie gewünscht. Ähnlich kann man

für nicht-leere 2-3-Bäume findmin() und findmax() programmieren.

Vor-Bem.: Ist x nicht in b und liegt z.B. „zwischen“ son2 und son3, so suchen wir in son2,

also links. Daher ist x nie kleiner als der kleinste Wert des Teilbaums, in dem wir suchen –

es sei denn, x ist kleiner als jeder Wert in b. Analog geht man beim Einfügen vor: x wird

in einem Teilbaum eingefügt, so dass sich dessen kleinster Wert (Trenninfo!) nicht ändert –

es sei denn, x wird neuer kleinster Wert und liegt immer in son1; dessen kleinster Wert wird

nicht als Trenninfo benötigt. (Außer: neuer Baum, s.u.)

Einfügen: Suche nach dem neuen Element und füge ungefähr bei dem entsprechenden Blatt

ein.

kleinster Wert zu neu

8

8 12

12

7

7

12

8

12

neu

Abbildung 7

Hatte der neue Vater schon 3 Kinder: aufteilen! Der Großvater braucht den kleinsten Wert

des neuen Teilbaums.

10

kleinster Wert zu

7 10

7

neuer Teilbaum

5

2

5

8 12

5

7

8

10 12

2

8

5

7

12

8

10

12

4 Kinder - Vater spalten

Abbildung 8

Evtl. wiederholtes Spalten; im Extremfall muss man eine neue Wurzel einfügen, s. Abb. 9.

Im Prinzip durchlaufen wir einen Suchpfad von der Wurzel zum neuen Blatt und (teilweise)