Quantitative Methoden ( PDF , 351 KB )

Werbung

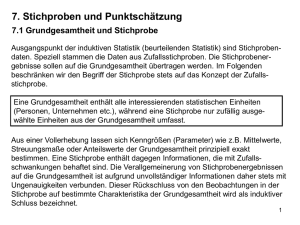

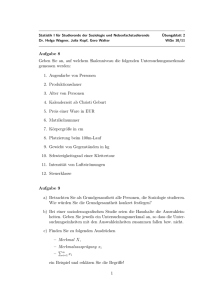

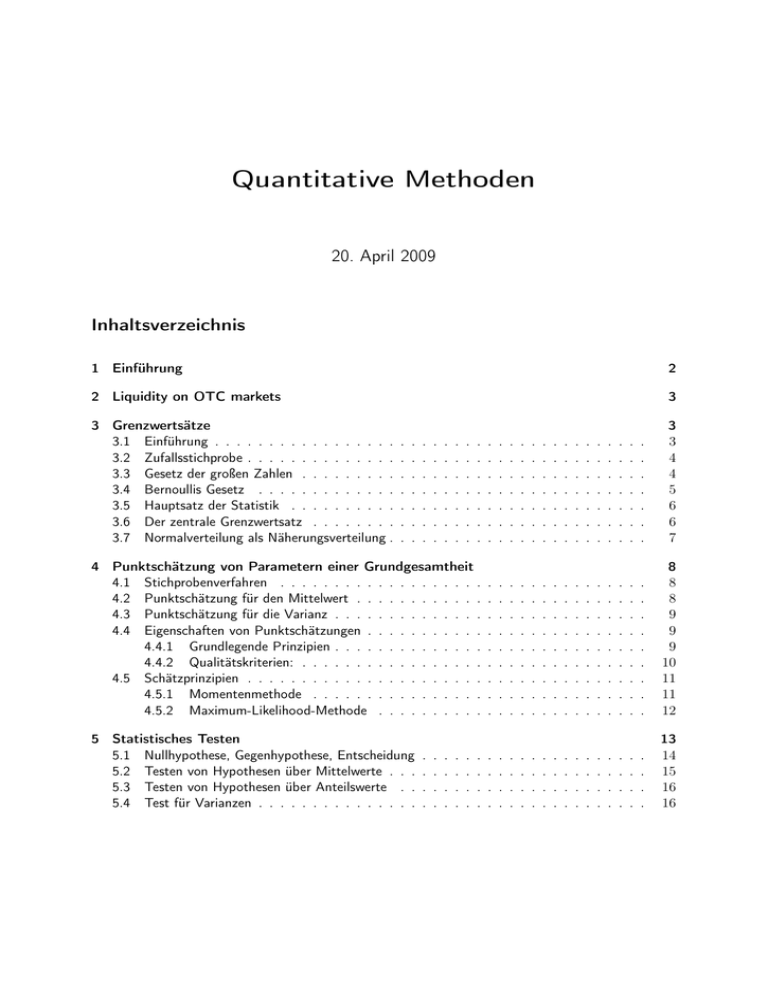

Quantitative Methoden 20. April 2009 Inhaltsverzeichnis 1 Einführung 2 2 Liquidity on OTC markets 3 3 Grenzwertsätze 3.1 Einführung . . . . . . . . . . . . . . . . . 3.2 Zufallsstichprobe . . . . . . . . . . . . . . 3.3 Gesetz der großen Zahlen . . . . . . . . . 3.4 Bernoullis Gesetz . . . . . . . . . . . . . 3.5 Hauptsatz der Statistik . . . . . . . . . . 3.6 Der zentrale Grenzwertsatz . . . . . . . . 3.7 Normalverteilung als Näherungsverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3 3 4 4 5 6 6 7 4 Punktschätzung von Parametern einer Grundgesamtheit 4.1 Stichprobenverfahren . . . . . . . . . . . . . . . . . . . 4.2 Punktschätzung für den Mittelwert . . . . . . . . . . . . 4.3 Punktschätzung für die Varianz . . . . . . . . . . . . . . 4.4 Eigenschaften von Punktschätzungen . . . . . . . . . . . 4.4.1 Grundlegende Prinzipien . . . . . . . . . . . . . . 4.4.2 Qualitätskriterien: . . . . . . . . . . . . . . . . . 4.5 Schätzprinzipien . . . . . . . . . . . . . . . . . . . . . . 4.5.1 Momentenmethode . . . . . . . . . . . . . . . . 4.5.2 Maximum-Likelihood-Methode . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8 8 8 9 9 9 10 11 11 12 5 Statistisches Testen 5.1 Nullhypothese, Gegenhypothese, Entscheidung 5.2 Testen von Hypothesen über Mittelwerte . . . 5.3 Testen von Hypothesen über Anteilswerte . . 5.4 Test für Varianzen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13 14 15 16 16 . . . . . . . . . . . . . . . . . . . . . . . . Quantitative Methoden – Inhaltsverzeichnis 5.5 5.6 5.7 Macht eines Tests . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Teststatistiken/Testverteilungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . t-Testen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16 17 18 6 Das lineare einfache Regressionsmodell 6.1 Kleinst-Quadrate-Algebra . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6.2 Annahmen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 6.2.1 Welche Annahme liefert was . . . . . . . . . . . . . . . . . . . . . . . . . . 19 19 20 22 7 Zeitreihenanalyse 7.1 Der stochastische Prozess . . . . . . . . . . . . . . . . . 7.1.1 Beispiele für stochastische Prozesse . . . . . . . . 7.1.2 „Werkzeuge“ . . . . . . . . . . . . . . . . . . . . 7.1.3 Restriktion . . . . . . . . . . . . . . . . . . . . . 7.1.4 2 nützliche Operatoren . . . . . . . . . . . . . . 7.1.5 Einige wichtige univariate stochastische Prozesse 7.1.6 Unit-Root-Prozess (URP) . . . . . . . . . . . . . 23 23 23 24 25 26 27 31 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2 Quantitative Methoden – 1 Einführung 1 Einführung Agenda • Methodische Basis: – Zufallsstichprobe – Gesetz der großen Zahlen/Zentraler Grenzwertsatz – Methoden zur Parameterschätzung • Testen von Hypothesen • Parameterschätzung und Hypothesentests im linearen Regressionsmodell • Grundzüge der Zeitreihenanalyse – Stochastischer Prozess – (Nicht)Stationarität – Autoregressive/Moving Average – Vektor-Autoregression – Kointegration • Kausalität MBO: Die Ziele dieser Veranstaltung sind... • Entwicklung der methodischen Bausteine für das Verständnis der modernen wirtschaftswissenschaftlichen Literatur (Werkzeugkasten) • Erarbeiten eines qualitativ guten methodischen Fundaments für Vertiefungsstudium und Masterstudium • Sowohl formales als auch intuitives Verständnis für quantitative Ansätze in der Wirtschaftswissenschaft Aufbau der Veranstaltung Die Erkenntnis muss der Anwendung vorangehen Die Hürden sind nicht mahtematische Ziele werden erreicht durch: • vorbereitete Tutoren • vorbereitete Studenten in Vorlesung und Tutorien • vorbereitete Dozenten mit geordneter Vorlesung 3 Quantitative Methoden – 2 Liquidity on OTC markets • Mitschriften und Selbststudium Literatur: KOOP, Gary: „Analysis of Economic Data“ 2nd Edition, Whiley Folienskript auf der Kurspage verfügbar → Ilias: Koop2008 2 Liquidity on OTC markets OTC= over the counter= über das Telefon Pj,t = beobachteter Transaktionspreis j zu einer Zeit t yt = Bond-Preis am Tagesende t v u Nt T X u 1 X t (Pj,t − yt )2 N xT (1) t=1 j=1 Diese Formel ist das Maß für Liquidität in diesem Markt: umso größer es ist, umso größer die Illiquidität Frage: welche Bonds müssen besonders geschützt werden, da besonders illiquide? Problem: Selektionsproblem: auf OTC-Märkten kann man bei dieser Formel nur etwas erklären wenn wirklich gehandelt wird, die Bonds mit der größten Illiquidität werden jedoch gar nicht gehandelt, so dass die diese Formel die Liquidität extremst unterschätzt. 3 Grenzwertsätze 3.1 Einführung Vorgehen bei wissenschaftlicher Auswertung: Ich gebe keine Spezifikationen vor, sondern lasse den Datensatz einfach wachsen, so dass damit obige Gesetze greifen und viele Schlüsse zulassen Konzept Zufallsstichprobe am Beispiel: IQ Ich ziehe ein X aus der Grundgesamtheit „Menschheit“, mess den IQ und lege jeweils zurück. Dies mache ich n-mal. Der IQ wird jeweils als Zufallsvariable X1 aufgefasst X1 hat die gleiche Verteilung wie die Grundgesamtheit (ist ZV) bis zur Realisation x1 (reelle Zahl) Ich kann jedoch nicht nur eine Stichprobe ziehen, sondern theoretisch unendlich viele. Für X1 gibt es damit gesehen unendlich viele Ausprägungen, weshalb sie auch eine Zufallsvariable ist. 4 Quantitative Methoden – 3 Grenzwertsätze 3.2 Zufallsstichprobe Die Auswahl der Leute in einer Zufallsstichprobe muss zufällig sein (keine Selbstselektion, Marktforschung als Bsp.: keine Arbeit mit Quoten, da nicht nichtrepräsentativ für Zufallsstichprobe) 1. Zug aus GG → X1 Zufallsvariable ... nter Zug aus GG → Xn Zufallsvariable → alle X mit gleicher Wahrscheinlichkeitsverteilung wie X selbst Warum Zufallsstichprobe: • aus Daten Aussage über Wahrscheinlichkeitsverteilung von X (in GG) • Parameterschätzung • Hypothesentests • Prognosen Und warum nicht GG? • Kosten • GG kann fiktiv/hypotetisch sein („Menschheit“, „Würfelwurf“) X1 ...Xn nennt man Stichprobenvariablen: unabhängig, identisch verteilte ZVen (u.i.v., i.i.d (independent identically distributed)), auf diese ZVen sind unten genannte Theoreme anwendbar Es handelt sich um ZVen, da Wert vor Ziehung unbekannt, aber es sind unabhängige ZVen. Nach Realisation: x1 ...xn = reelle Zahlen Wegen Zufälligkeit der Auswahl: fX1 ...Xn (x1 ...xn ) (gem. Wahrscheinlichkeits-/dichtefunktion) → fX1 (x1 ) = ... = fXn (xn ) = identische Randverteilungen (gleiche GG, unabhängig) 3.3 Gesetz der großen Zahlen Seien X1 ...Xn unabhängig und identisch verteilte Zufallsvariablen, deren Erwartungswerte und Varianzen existieren und sei Xn das arithmetische Mittel aus ihnen. Dann gilt für jedes noch so kleine > 0: P (Xn − µ ≥ ) → 0f rn → ∞ (2) d.h. Stichprobenmittelwerte werden bei sehr vielen Stichproben zum Erwartungswert hin konvergieren (auch bei etwas aufgeweichtem DGP) Beweis über tschbyschevsche Ungleichung (Substitution k ∗ σ = ) 5 Quantitative Methoden – 3 Grenzwertsätze Verschiedene Arten von Konvergenz: Schwaches Gesetz der großen Zahlen: „Wahrscheinlichkeitslimes“, „ stochastische Konvergenz“ plimXn = µ Starkes Gesetz der großen Zahlen: „Konvergenz mit Wahrscheinlichkeit 1“, „fast sichere Konvergenz“ P (limXn = µ) = 1 Es gilt auch: E(Xn ) = µ 2 V ar(Xn ) = σn Mächtigkeit des SGGZ Z ∞ n 1X x ∗ fx dx) xn = xv → E(x)( n −∞ (3) v=1 Für y=x2 (E(y) = E(x2 ) < ∞) y ist u.i.v. wenn X u.i.v. yn = n n v=1 v=1 1X 2 1X yv = xv n n (4) n 1X 2 yn →p E(Y ) = E(x )oder xv →p E(X 2 ) n 2 (5) v=1 d.h. für empirische Varianz aus Zufallsstichprobe: n 1X 1X 2 1X (xv − xn )2 = xv − ( xv )2 n n n (6) s2x →p E(x2 ) − (E(x))2 = V ar(x) = E(x − E(X)2 ) (7) v=1 Gilt auch für g(x) z.b. x3 , ln(x) 1X g(xv ) →p E(g(x)) n (8) 3.4 Bernoullis Gesetz Ein Bernoulli-Experiment mit der Erfolgswahrscheinlichkeit p werde n-mal unabhängig voneinander wiederholt und sei dabei Hn die relative Häufigkeit der Erfolge. Dann gilt für jedes noch so kleine >0 P (|Hn − p| ≥ ) = 0 (9) oder: limn→∞ P (|Hn − p| ≥ ) = 0 (10) 6 Quantitative Methoden – 3 Grenzwertsätze plimHn = p (11) Anmerkungen: Bernoullis Gesetz datiert lange vor dem Gesetz der großen Zahlen. Es ist ein Spezialfall des allgemeinen Gesetzes, wir brauchen es daher nicht extra zu beweisen. Praktische Bedeutung 1. Statistische Wahrscheinlichkeit: Bestimmung von Wahrscheinlichkeit auf experimentellem Wege: hn ist guter Näherungswert bzw. brauchbare Schätzung für p wenn n hinreichend groß 2. Stichprobenverfahren: bei qualitativen Merkamlen: p=Anteil der statistischen Einheiten in der GG, bei denen das Merkmal in einer bestimmten Ausprägung vorliegt hn =Stichprobenanteilswert. Er wird mit zunehmendem Stichprobenumfang immer näher bei dem Wert p zu liegen kommen 3.5 Hauptsatz der Statistik Frage: Kann auch die Wahrscheinlickeitsverteilung F(x) experimentell bestimmt werden? Dazu berechnet man aus den n Stichprobenwerten die empirische Verteilungsfunktion Hn (x) → P (limn→∞ Hn (x) = F (x)) = 1 (12) 3.6 Der zentrale Grenzwertsatz Betrachtet man den Mittelwert einer Zufallsstichprobe als ’Realisation einer Zufallsvariablen wobei E(Xn ) = µ 2 V ar(Xn ) = σn stellt sich die Frage wie die Verteilungsfunktion lautet. Seien X1 ...Xn u.i.v. ZVen mit Erwartungswert und Varianz und sei Xn ihr arithmetisches Mittel. Dann strebt die Verteilungfunktion Fn der standardisierten Größe Zn = Xn − µ σ sqrtn (13) mit wachsendem n gegen die Standardnormalverteilung Fst (Zn ) 7 Quantitative Methoden – 3 Grenzwertsätze Die Binomialverteilung konvergiert auch gegen die Normalverteilung mit Hn − p Zn = q (14) pq n Beweisskizze Standardisierung: xn − E(xn ) zn = p V ar(xn ) (15) ≈ N(0,1) Man setzt: xn = sn : sn − E(sn ) zn = p V ar(sn ) (16) Man zeigt, dass die MEF für zn : −t2 limn→∞ M EFzn (f ) = e 2 =MEF von X≈ N(0,1) Da wenn zwei MEF gleich sind die Funktion gleich ist: bewiesen Bedeutung 1. Entscheidender Vorteil: der ZGWS stellt keinerlei Anforderungen an die Ausgangsverteilung. Wie auch imner die identisch und unabhängige- Verteilung der Xi beschaffen sein mag, die Verteilungsfunktion der Summe beziehungsweise des arithmetischen Mittels konvergiert stets gegen die Normalverteilung 2. Diesem Umstand verdankt die Normalverteilung ihre universale theoretische und praktische Bedeutung 3. Empirische Verteilungen: der ZGWS eklärt auch weshalb so viele empirische Verteilungen der Normalverteilung nahekommen und durch sie recht gut näherungsweise beschrieben werden können 3.7 Normalverteilung als Näherungsverteilung Ist n hinreichend groß, kann die Verteilung einer Summe bzw. eines arithmetischen Mittels durch die Normalverteilung approximiert werden: Summe: P (Sn ≤ sn ) ≈ FSt ( sn − nµ √ ) σ n (17) 8 Quantitative Methoden – 4 Punktschätzung von Parametern einer Grundgesamtheit Intervall: P (a < Sn ≤ b) ≈ FSt ( b − nµ a − nµ √ − FSt ( √ ) σ n σ n (18) Mittelwert: P (Xn ≤ xn ) ≈ FSt ( xn − µ √σ n ) (19) 4 Punktschätzung von Parametern einer Grundgesamtheit 4.1 Stichprobenverfahren Die repräsentative Stichprobe: Man stellt sicher, dass die Stichprobe bezüglich anderer Merkmale eine gleiche oder ähnliche Struktur aufweist wie die Grundgesamtheit. Reine Zufallsauswahl: Jedes Element der Grundgesamtheit hat die gleiche Chance, in die Stichprobe zu gelangen. Urnenmodell: Ziehen ohne oder mit Zurücklegen 1. Der Merkmalswert Xi jedes einzelnen Stichprobenelements ist eine Zufallsvariable 2. Die Wahrscheinlichkeitsverteilung dieser Zufallsvariablen Xi ist durch die Häufigkeitsverteilung des Merkmals X in der Grundgesamtheit bestimmt. 3. Mit den in der Stichprobe beobachteten Merkmalswerten xi wird un versucht, diese Verteilung oder doch wenigstens ihren Mittelwert und ihre Varianz zu schätzen 4.2 Punktschätzung für den Mittelwert Mittelwert µ des metrischen Merkmals X einer Grundgesamtheit sei unbekannt. Er soll mit Hilfe einer Zufallsstichprobe vom Umfang n geschätzt werden. Beobachtete Merkmalswerte xi : P realisierte Zufallsstichprobe (x1 , x2 , ∧, xn ) → n1 xj = x als Stichprobenmittelwert Schätzformel: µ b = x mit µ b ist Schätzwert für µ Frage: Ist dies eine gute Schätzformel? Meistens gibt es einen Schätzfehler : e = µ − µ b Wir untersuchen die stochastischen Eigenschaften: µ b ist eine Zufallsvariable. Verteilung? Momente? E(b µ) = µ: Erwartungstreue bias= E(e): Verzerrung, Bias 2 V ar(b µ) = σn → plimb µ = µ: Konsistenz 9 Quantitative Methoden – 4 Punktschätzung von Parametern einer Grundgesamtheit 4.3 Punktschätzung für die Varianz Varianz σ 2 eines metrischen Merkmals in einer Grundgesamtheit sei unbekannt. Sie soll mit der empirischen Varianz der Zufallsstichprobe geschätzt werden: s2 = 1X (xj − x)2 n (20) 2 \ = s2 ist nicht erwartungstreu. Bereinigt Die auf den ersten Blick naheliegende Schätzformel sigma um die Zahl der Freiheitsgrade: σ b2 = n 2 s n−1 (21) Es ist nun E(b σ2 = σ2 4.4 Eigenschaften von Punktschätzungen 4.4.1 Grundlegende Prinzipien 1. Annahme Verteilung für ZV X z.B. X≈ Po(λ) oder ≈ N(µ, σ 2 ) ... 2. Ziehen der Zufallsstichprobe → Stichprobevariable x1 ...xn (u.i.v.) 3. Schätzfunktionen (SF) „schätzen“ Parameter der Verteilung von X (λ, µ, σ 2 ) Die SF ist eine Stichprobenfunktion mit Stichprobenvariablen: g(X1 , X2 ...Xn ) und damit selbst eine Zufallsvariable (messbare Funktion), deren Wert g(x1 , x2 ...xn ) eine reelle Zahl ist: Schätzwert für Verteilungsparameter von X Allgemeine Schreibweise: θ : wahrer Wert (konstant, unbekannt) θb : Schätzwert (Zufallsvariable) für Parameter von Verteilungen z.B. Mittelwert µ, Varianz σ 2 b 1 , ∧, Xn ) ist eine Schätzformel oder ein Schätzer oder eine Schätzfunktion. Sie hat eine θb = θ(X Wahrscheinlichkeitsverteilung. Rechenbeispiel: X≈ Po(λ) in GG → Schätzung von λ : 2 Schätzfunktionen: b1 = X1 λ b2 = P Xv λ 10 Quantitative Methoden – 4 Punktschätzung von Parametern einer Grundgesamtheit 4.4.2 Qualitätskriterien: 1. Kriterium: Erwartungstreue: Ein Schätzer θb ist erwartungstreu oder unverzerrt („ohne Bias“), wenn sein Erwartungswert seinem zu schätzenden wahren Wert entspricht, also: b = θd.h.E(θ) b −θ =0 E(θ) Es erscheint unmittelbar vernünftig zu fragen, ob eine Schätzformel im Mittel, das heißt im Durchschnitt ihrer Anwendungen auf lange Sicht, den gesuchten Wert trifft. Eine systematische Überschätzung etwa ist sicher nicht wünschenswert. Im Beispiel: beide Vorschläge sind erwartungstreu: b1 ) = E(X1 ) = E(X) = λ E(λ b2 ) = E( 1 P Xv ) = 1 P E(xv ) = 1 ∗ n ∗ E(x) = E(x) = λ E(λ n n n 2. Kriterium: Effizienz Man sagt, ein unverzerrter Schätzer sei effizienter als ein anderer unverzerrter Schätzer, wenn er eine kleinere Varianz hat. Der effizienteste unverzerrte Schätzer θ∗wäre derjenige, der verglichen mit allen anderen unverzerrten Schätzern die kleinste Varianz hätte, also: b V ar(θ∗) < V ar(θ) Im Beispiel: Vorschlag 2 ist effizienter als Vorschlag 1: b1 ) = V ar(X1 ) = V ar(X) = λ V ar(λ b2 ) = V ar( 1 P xv ) = V ar(X = λ V ar(λ n n n b1 ) > V ar(λ b2 ) → V ar(λ 3. Kriterium: Mittlerer quadratischer Fehler DEr mittlere quadratische Fehler (mean squared error MSE) eines Schätzers ist der Erwartungswert seiner quadrierten Abweichung vom wahren Parameterwert, also: b = E((θb − θ)2 ) (sollte möglichst klein werden) M SE(θ) Der MSE berücksichtigt sowohl Varianz und Bias: b = V ar(θ) b + bias2 = E(θb − E(θ)) b 2 + E(θb − θ) M SE(θ) Es kann vorteilhaft sein, einem leicht verzerrten Schätzer den Vorzug zu geben vorausgesetzt, dass dadurch eine wirksame Verkleinerung der Varianz erreicht wird, was oft der Fall ist. Beispiel siehe eigene Anlage 1 4. Kriterium: Konsistenz Der Schätzfehler sollte möglichst klein sein und -vor allem- umso kleiner, je größer der zur Verfügung stehende Stichprobenumfang n ist. Man wünscht sich die Eigenschaft der Konsistenz, was bedeutet, dass die Wahrscheinlichkeit, mit der ein noch so kleiner Schätzfehler >0 auftritt, mit zunehmendem n gegen 0 strebt, also: limn→∞ P (θbn − θ| > ) = 0(f rn → ∞) (22) oder: plimn→∞ θb = θ (23) 11 Quantitative Methoden – 4 Punktschätzung von Parametern einer Grundgesamtheit Man kann zeigen: limM SE(θbn ) = 0 wenn limE(θb − θ) = 0 und limV ar(θbn = 0 Ein Schätzer ist also konsistent, wenn er erwartungstreu ist und wenn außerdem seine Varianz bei zunehmendem Stichprobenumfang gegen 0 geht Beispiel siehe eigene Anlage 2 4.5 Schätzprinzipien Ziel: X≈ Verteilung(θ1 ,θ2 ) mit θ als unbekannter Parameter (Vektor: θ = (θ1 ...θk )0 Aus der Zufallsstichprobe schätzt man θ1 ...θk mittels der Stichprobenvariablen X1 ...Xn (u.i.v.) Zum Schätzen verwendet man Schätzfunktionen und bewertet die Ergebnisse mittels Bias, Effizienz, MSE und Konsistenz 4.5.1 Momentenmethode „Schätze die Momente der Verteilung der Grundgesamtheit mit den entsprechenden Momenten der Stichprobe“ Daraus lassen sich z.B. die Schätzformeln für Mittelwert und Varianz herleiten Beobachtung: es besteht ein funktionaler Zusammenhang zwischen θ1 ...θk und den Momenten: Am Beispiel: X≈ P o(λ) E(x)=λ Da Var(x)=E(x2 ) − (E(x))2 gilt: E(x2 ) = V ar(x) + µ2 E(x2 ) =P λ2 + λ 1 Xn = n xv →p E(x) = µ → xn ist ein konsistenter Schätzer für λ Am Beispiel: X ≈ N (µ, σ 2 ) Nach den Ergebnissen vonP vorher gilt: 1 P 1 P 2 2 = 1 x − ( x ) (xv − xn )2 →p σ 2 v v n n n Momentenschätzer basieren auf u.i.v. Zufallsstichproben, die konsistent sind (GGZ) Asymptotisch (approx.) normalverteilt (ZGS) Für Poissonverteilung gilt: c1 = 1 P xv →p E(x) = λ λ n c2 = 1 P x2 − [ 1 P xv ]2 →p V ar(x) = λ λ v n n Beide sind konsistent → Wahl des Effizientesten Schätzers über den Zusammenhang der einzelnen Kriterien 12 Quantitative Methoden – 4 Punktschätzung von Parametern einer Grundgesamtheit 4.5.2 Maximum-Likelihood-Methode „Wähle den Wert θbM L als Schätzwert für einen unbekannten Parameter θ, welcher angesichts des Stichprobenergebnisses die größte Likelihood oder Mutmaßlichkeit besitzt!“ Gemeint ist damit derjenige Wert, welcher, wenn er der wahre Parameter der Verteilung wäre, verglichen mit allen anderen Werten das Stichprobenergebnis mit der größten Wahrscheinlichkeit hervorgebracht hätte. Ausgangspunkt: f (X1 ...Xn , θ)=gem. Wkeitsfunktion bzw Dichtefunktion (P (X1 = x1 ...Xn = xn ) mit θ=Vektor. Sie ist proportional zu einer Wkeit, aber nicht Wkeit selbst Man berechnet die Wkeit für die Abfolge bestimmter X, d.h. X ändert sich während θ gleich bleibt: → Πfx (xv , θ) Gegebenes θ und mit konkreten x1 ...xn → reelle Zahl Gegebenes θ und mit Zufallsvariablen X1 ...Xn → messbare Funktion, Zufallsvariable Unbekanntes θ: Die Likelihood-Funktion gibt an: L(θ) = Πfx (xv , θ) Maximum-Likelihood-Idee: Wähle θb so dass L(θ) maximal wird Ich bestimme eine Abfolge für X und teste sie für jeweils verschiedene λ und nehme den Wert mit der höchsten Wahrscheinlichkeit P Max. v. L(θ) = Max. v. ln L(θ) = lnf (xv , θ) → log-Funktion wegen: numerischer Stabilität, leichtere Ableitung und Wissen wohin Summen in Wahrscheinlichkeit konvergieren P Max ln L(θ) = Max n1 lnf (xv , θ) → wieder ein Mittelwert Obige Methode beschreibt Grid search: möglich für kleine Parameter und für grobe Annäherung Andere Methode: Bedingung erster Ordnung: b 1 X ∂lnf (xv , θ) =0 n ∂ θb1 (24) Dies für alle θ des Vektors, umformen und nach den θ auflösen ergibt ML-Schätzer → „Königin der Schätzmethoden in ihrem Reich“: das beste für große n, aber alle Ergebnisse nur bei korrekt speziem DGP (=großer Anspruch an Wissen für Schätzer) = „kein robuster Schätzer“ Beispiel: ML-Schätzung, Parameter NV X≈ N (µ, σ 2 ) in GG als Annahme 13 Quantitative Methoden – 5 Statistisches Testen Likelihood-Funktion: L(µ, σ 2 ) = Π √ −1 xv −µ 1 ∗e 2 ( σ ) 2π ∗ σ (25) als Dichtefunktion der NV √ P lnL(µ, σ 2 ) = −n ∗ ln( 2π) − n ∗ lnσ − 2σ1 2 ∗ (xv − µ)2 Wähle Werte für µ und σ so dass die Likelihood-Funktion max. wird: ∂lnL 1 X 2(xv − µ)(−1) = 0(1) = ∂µ −2σ 2 X 1 ∂lnL 1 (xv − µ)2 = 0(2) = −n ∗ 2 − 3 (−2) ∂σ σ 2σ aus (1): X (xv − µ) = 0 ↔ n ∗ µ = X xv ↔ µ = 1X xv = xn n (26) (27) (28) aus (2): σ2 = 1X (xv − x)2 n (29) 5 Statistisches Testen Schätzverfahren und Testverfahren sind Anwendungen der Stichprobentheorie Ziel: Entscheidung über eine Hypothese zu treffen Hypothesen sind Annahmen z.B. über eine Verteilung oder über einzelne Parameter der Verteilung eines Merkmals in einer Grundgesamtheit. Signifikanzniveau: „wie unwahrscheinlich muss ein Ereignis (Testergebnis) mindestens sein, dass man die Null-Hypothese (=Ausgangshypothese) verwirft.“ z.B 0,01; 0,05; 0,1 Dazu Anlage „Partnerwahl“ Woher stammen die Hypothesen? • frühere Beobachtungen • theoretische Überlegungen • Prinzip des unzureichenden Grundes • begründete Mutmaßungen 14 Quantitative Methoden – 5 Statistisches Testen Beachte: Ob eine gefaßte Hypothese richtig oder falsch ist, kann mit einer Stichprobe nicht festgestellt werden. Die Testentscheidung beinhaltet „Hypothese beibehalten“ oder „verwerfen“. Kernsätze • statistische Signifikanz 6= ökonomische Bedeutung • Signifikant: keine Aussage ob H0 wahr oder falsch • Signifikant: keine Aussage wie (un)wahrscheinlich H0 ist, sondern nur Aussage über Verwerfung • Kontrolle über Wkeit für Fehler 1.Art, aber nicht für Fehler 2.Art (Wunsch: bei gegebenem α sollte β möglichst klein, bzw α + β möglichst klein) • 1-β ist Macht des Tests als die Wkeit eine falsche H0 abzulehnen 5.1 Nullhypothese, Gegenhypothese, Entscheidung Hypothese über den Zahlenwert θ0 eines Parameters θ • z.B. einer Verteilung eines Merkmals in einer GG • Wahrscheinlichkeitsverteilung einer Zufallsvariablen Nullhypothese H0 : θ = θ0 H0 kann falsch oder richtig sein. Sie wird beibehalten wenn genügend Hinweise für das Gegenteil erbracht sind: Stichprobe Gegenhypothese/Alternativhypothese HA : θ 6= θ0 Vier Möglichkeiten Tabelle 1: Testentscheidung-Realität H0 beibehalten H0 verwerfen H0 ist richtig ok Fehler 1.Art (α) H0 ist falsch Fehler 2.Art (β) ok Fehler 1.Art: Man verwirft die Null-Hypothese obwohl sie richtig ist Fehler 2.Art: Man verwirft die Null-Hypothese nicht obwohl sie falsch ist Nach dem Neymann/Pearson Paradigma gilt: Max W.keit für α-Fehler fixiert = kontrolliert 15 Quantitative Methoden – 5 Statistisches Testen W.keit für β-Fehler ergibt sich = nicht kontrolliert → P (H0 verwerfen | H0 richtig)=α sollte möglichst klein sein 5.2 Testen von Hypothesen über Mittelwerte Sei µ der Mittelwert des metrischen Merkmals X in einer GG. Nullhypothese: H0 : µ = µ0 mit µ0 als hypotetischem Zahlenwert. Wir ziehen eine Zufallstichprobe und finden eine Abweichung |x − µ0 | > 0 Problem: Nullhypothese verwerfen? Eine richtige Nullhypothese soll nur mit sehr geringen Wahrscheinlichkeit α verworfen werden. Übliche Signifikanzniveaus sind α=0,05; 0,01; 0,1 (=konventionell) 1. Festlegen der Nullhypothese Fomuliere dazu die Alternativ-Hypothese HA , damit alle Möglichkeiten abgedeckt Konstruktion Prüfgröße/Teststatistik T Beim zweiseitigen Bereich ist der Verwerfungsbereich symmetrisch zu beiden Seiten des Annahmebereichs angeordnet. Standardisierte Testvariable: X − µ0 (30) σx Für große Stichproben gilt: X − µ0 P( > z(1 − α/2)|µ = µ0 ) = α (31) σx Dabei ist der erste Teil die Prüfgröße und der zweite der kritische Wert. Gilt die größer-Beziehung ist H0 zu verwerfen Beim einseitigen Test ist der Verwertungsbereich nicht symmetrisch zu beiden Seiten des Annahmebereichs angeordnet: Oberseitiger Test H0 : µ ≤ µ0 gegen H1 : µ > µ0 Testentscheidung: x − µ0 > z(1 − α) → H0 verwerf en σx Unterseitiger Test H0 : µ ≥ µ0 gegen H1 : µ < µ0 Testentscheidung: x − µ0 < z(α) → H0 verwerf en σx (32) (33) 3. Ableitung Wkeitsverteilung von T bei Gültigkeit von H0 (oft das Aufwändigste) Es existiert eine bestimmte Dichtefunktion wenn Nullhypothese wahr, die Verteilung der Gegenhypothese sollte eine andere sein Siehe Anlage 16 Quantitative Methoden – 5 Statistisches Testen 4. Max. tolerierte Wkeit für Fehler 1.Art festlegen = α 5. Verwerfungsbereich (Nichtverwerfungsbereich=Annahme) festlegen Der kritische Wert tkrit wird von α bestimmt und wird an die Verteilung aus 3. abgetragen Siehe Anlage 6. Berechnen konkreter Wert Teststatistik/Prüfgröße t* Liegt t* im Nichtverwerfungsbereih kann die Nullhypothese auf Signifikanzniveau α nicht verworfen werden Liegt t* im Verwerfungsbereich wird die Nullhypothese auf Signifikanzniveau α verworfen. Siehe Anlage 5.3 Testen von Hypothesen über Anteilswerte Bei den Schritten 5+6 gibt es eine Alternative: p-Wert (p-value) „empirisches Signifikanzniveau“ ES liegt eine bestimmte Verteilung von T unter Gültigkeit von H0 vor. Der p-Wert bei einseitiger Fragestellung fragt: würde t* als tkrit angenommen und welches Signifikanzniveau impliziert dies? P(T<t*)=p-Wert Bsp. p-Wert von 0,31 und damit P(T>t*)=0,31 Bei α=0,01 kann H0 nicht verworfen werden Siehe Anlage Der p-Wert ist hilfreich, da keine strikte Vorgabe von α und mehr Information Bei zweiseitiger Fragestellung gilt P (T > t∗) = p−W2 ert und P (T < −t∗) = bei symmetrischer Verteilung geht → p-Wert=P(T>t*)*2 Siehe Anlage p−W ert , 2 wobei dies nur 5.4 Test für Varianzen 5.5 Macht eines Tests Es gibt Tests bei denen die Verteilung von H0 und HA gleich aussehen. Bei einem Signifikanzniveau von α=0,05 gilt: α-Fehler ist 0,05. Wegen der gleichen Verteilung ist damit der β-Fehler=1-α=0,95 Die Wkeit der Fehlersumme ist damit 1, was schlecht ist, da diese Summe möglichst klein sein sollte. Die Macht des Tests P(H0 verworfen|H0 falsch)=1-β=0,05 Bei besseren Tests sind die Verteilungen stark unterschiedlich. Beispiel siehe Anlage 17 Quantitative Methoden – 5 Statistisches Testen 5.6 Teststatistiken/Testverteilungen Konstrutkionsbedingt haben Teststatistiken unter H0 keine Standardnormalverteilung, sondern: χ2 -Verteilung T≈ χ2 (n) mit n als Parameter der Freiheitsgrade P Wenn Z≈ N(0,1), dann nv=1 Z 2 ≈ χ2 (n) mit Z 2 ist messbare Funktion. Die Dichtefunktion folgt aus der Anwendung des Dichtetransformationstheorems: n x ( x2 ) 2 −1 ∗ e− 2 fχ2 (x, n) = 2Γ( n2 ) (34) mit Γ(a)= Z ∞ y a−1 ∗ e−y dy (35) a Fχ2 (x,n)=tabelliert Schira Verteilung siehe Anlage student-t-Verteilung T≈ t(n) mit n als Parameter der Freiheitsgrade Wenn Z≈ N(0,1) und U≈ χ2 (n) und U,Z unabhängig, dann √Z U/n ≈ t(n) mit t ist messbare Funktion. Die Dichtefunktion folgt aus der Anwendung des Dichtetransformationstheorems: fT (x, n) = k ∗ [1 + x2 /n]−0,5(n+1) (36) mit k= 1 Γ(n + 0.5) √ ∗ n Γ ∗ (n/2) ∗ Γ ∗ (0.5) (37) FT (x,n)=tabelliert Schira Verteilung siehe Anlage F-Verteilung T≈ F(m,n) mit m,n zwei Parameter U Wenn U≈ χ2 (m) und V≈ χ2 (n) und U,V unabhängig, dann F= m V mit F ist messbare Funktion. n Die Dichtefunktion folgt aus der Anwendung des Dichtetransformationstheorems: FF = tabelliert Schira 18 Quantitative Methoden – 5 Statistisches Testen 5.7 t-Testen Benutzt zum Test des Signifikanzniveaus von Parameter(schätzern) Einfaches Beispiel: X in GG mit X≈ N(µ, σ 2 ) H0 : µ = µ e (wobei θ oft =0) HA : µ 6= µ e Dies sollte den Parameterraum komplett abdecken Zufallstichprobe mit u.i.v.; es gilt: θbn : Schätzer für Verteilung den ich herausbekomme (ist konsistent und approx. normalverteilt) θ=wahrer Parameter e θ=angenommener Wert bei Hypothese Bei Gültigkeit der H0 : E(X) = E(xv ) = µ e V ar(X) = V ar(xv ) = σ 2 Konstruktion der Teststatistik X n −e µ Z= √ ≈ N (0, 1) unter H0 mit 2 σ /n X n ≈ N (µ, σ 2 /n) √ Z = x−µ ≈ N (0, 1) (für n-k>30) 2 σ E(X n ) = µ = µ e V ar(X n ) = σ 2 /n α=0,05, damit ist tkrit ungefähr± 2 1 Ist σ 2 nicht bekannt, dann wird sie durch n−1 s2 , also die empirische Varianz (xv − x)2 , ersetzt, die aus den Daten berechnet werden können. Durch das Ersetzen jedoch wird die Verteilung nun t-verteilt. Bsp. für diese Verteilung mit t(n-1), also n-1 Freiheitsgrade. Schaubild siehe Anlage Die allgemeine Prüfgröße lautet: θbn − θe t= q V ar(θbn ) (38) Der Standardfehler ist normalerweise nicht bekannt, muss über empirische Varianz geschätzt werden Faustregel: θbn signifikant von θe verschieden (oft=0) wenn Wert der t-Statistik t<-2 oder t>2 (bei zweiseitigem Test) Konfidenzintervall Für alle Werte in diesem Intervall verwerfen sie auf einem gegebenen Signifikanzniveau nicht: → 95% Konfidenzintervall= 5% Signifikanzniveau 19 Quantitative Methoden – 6 Das lineare einfache Regressionsmodell 6 Das lineare einfache Regressionsmodell yi = α + β ∗ xi + i mit y als abhängige Variable (Regressant) x als erklärende/beobachtete Variable (Regressor) α, β als wahre Parameter als „Fehler“ (unbeobachtete erklärende Variable) Konzeptionelles: Alles Bestandteile können als reelle Zahlen uafgefasst werden, da aus Grundgesamtheit gezogen (z.T. messbare Funktionen) Aber: α, β als reelle Zahlen Oft konditioniert auf x (bedingte Verteilung) E(yi |xi ) = α + E(β ∗ xi |xi ) + E(i |xi ) (39) wobei E(β ∗ xi |xi ) = β ∗ xi und E(i |xi ) = 0 (per Annahme) Indizes: i=Individuen (Querschnittsanalyse) it=Paneldaten (t)=Zeitpunkte (Zeitreihenanalysen) Ökonomische Modelle Y X Einkommen Schulausbildung Konsum Jahr t verfügbares Einkommens Verkäufe Jahr t Werbeausgaben des Unternehmens in t e unbekannte Fähigkeit (Soziales, IQ) Risikoneigung Mode, Zeitgeist Zentrale Ziele Schätzung des Parameters β (=Key Parameter): „Bildungsrendite“, „marginale Konsumquote“, „Marketingeffizienz“ Hypothesentests Man nutzt einen Test und nimmt β=0 bzw. β 6=0, testet also die Hypothese z.B. Bildung bringt nichts. 6.1 Kleinst-Quadrate-Algebra Schätzung der wahren Parameter mit der Zielfunktion: n X (yi − α b − βb ∗ xi )2 (40) i=1 Es werden α, β so gewählt dass die Summe der Residuen (ei = yi − α − β ∗ xi ) möglichst klein macht 20 Quantitative Methoden – 6 Das lineare einfache Regressionsmodell Intuition Die Daten aus der Zufallsstichprobe: da für jede Variable mehrere Möglichkeiten existieren entstehen Zufallsvektoren Parameterschätzung: aus KQ-Zielfunktion: α b = y − βb ∗ x c βb = sxy 2 x Alle diese Parameter, Variablen und Mittelwerte sind Zufallsvariablen 6.2 Annahmen • R1: Linearität (wichtig ist, dass α und β linear eingehen) • R2: striktre Exogenität (der Störfehler ist 0 und und x sind unabhängig) • R3: konstante Varianz (für alle i)=homoskedastisch • R4: Kovarianz von 0 (zwischen zwei Störtermen, also keine Autokorrelation) • → BLUE: Best Linear Unbiased Estimator (Gauss-Markov-Theorem • R5: Normalverteilung Annahme 1 Linearität in Parametern, d.h. α und β müssen linear verbunden sein. Anmerkung: evl. Tranformation der Daten notwendig: Unilog-Modelle: yei = exp(α + β ∗ xi + i ) → lnyei = α + β ∗ xi + i → yi = α + β ∗ xi Loglog-Modelle: yei = α + xei β ∗ i → lnyei = α + β ∗ lnxei + lne i → yi = α + β ∗ xi + i Nichtlineare Regression: auch KQ-Schätzung möglich, aber erfüllt damit die erste Annahme nicht; kein BLUE Annahme 2 strikte Exogenität: E(i |x1 , x2 ...xn ) = 0 Anmerkung Bei ZS (=unabhängige Ziehung) gilt für strikte Exogenität: E(i |x) = 0 → E(i ) = 0 → cov(i ; xi ) = 0; E(i ∗ xi ) = 0 (prädeterminierte Regressoren) Dies wird durch Simultanität oder vernachlässigte Regressoren gebrochen. Annahme 3 a. V ar(i |x1 ...xn ) = (berA2) = E(2i |x1 ...xn ) = σ 2 d.h. die bedingte Varianz des Störterms ist unabhängig davon auf welches x ich bedinge. 21 Quantitative Methoden – 6 Das lineare einfache Regressionsmodell Anmerkung bei u.i.v ZV gilt wegen Unabhängigkeit der Ziehungen: E(2i |x1 ...xn ) = E(2i |xi ) = E(2i = σ 2 b. cov(i ; j |x1 ...xn ) = E(i ∗ j |x1 ...xn ) = 0 für i 6= j Anmerkung bei u.i.v. ZV ohnehin gegeben Anmerkung zu A2 und A3 Sie restringieren die Verteilung der Störterme: A2 macht Aussagen über 1. Momente; A3 macht Aussagen über die 2. Momente Über die Verteilung von x wird keine Aussage gemacht! Annahme 4 (i |x1 ...xn ) ≈ N (0, σ 2 ) (0 wegen A2; σ 2 wegen A3) Anmerkung bei u.i.v. reicht Konditionierung auf xi benötigt für Hypothesentests: t-Tests; F-Tests; Kondifenzintervalle Schlechte Einflüsse: 1. omitted variable bias=Schätzer sind nicht erwartungstreu (konsistent) weil zusätzliche Variablen vergessen wurden Lösung: Aufnahmen (kontrollieren) relevanter erklärender Variablen: multiples Regressionsmodell: argmin : X (yi − βb1 xi1 − ...βbk xik )2 (41) 2. Beziehung zwischen X und (cov(x, ) 6= 0)=Schätzer sind inkonsisten,verzerrt weil endogene Regressoren Lösung: Schätzung mit Instrumentvariablen (I): cov(X, I) 6= 0; cov(, I) = 0 Ersetzen von X durch I, da I Anforderungen des Modells erfüllt (Bsp. Vietnam) 3. simultaneous equation bias=indirekte wirkung von Y auf X (via Z), d.h. Schätzer inkosistent, verzerrt Lösung: Systemschätzverfahren oder Instrumentvariable 4. Diese drei „Plagen“ verhindern konsistente Schätzer! 22 Quantitative Methoden – 6 Das lineare einfache Regressionsmodell 6.2.1 Welche Annahme liefert was Mit A1+A2 α b; βb sind erwartungstreu Mit A1+A2+A3 α b; βb sind BLUE: V ar(b α) ≤ V ar(e α) b ≤ V ar(β) e V ar(β) →α e; βe sind unverzerrte lineare Schätzer; d.h. man wählt bei einem BLUE-Schätzer immer den mit der kleinsten Varianz unter allen erwartungstreuen linearen Schätzern. α b V ar = b β = ! b V ar(b α) cov(b α, β) b b cov(b α, β) V ar(β) = σ2( n X xi ∗ x0i )−1 (42) (43) (44) i=1 Anmerkung: Die Wurzel dieser Varianzen benötigt man für t-Tests Mit A1+A2+A3+A4 Ausnutzen obiger Berechnung der Varianz: α b |x1 ...xn βb | (45) b ≈ BVN (bivariatnormalverteilt) [(α/β); V ar(b α/β)] Beim t-Testen gilt: e hypoth.W ert) βb − β(= q ≈ N (0, 1) ≈ t(n − 1)unterH0 \b V ar(β) (46) b =β Gilt H0 : βe = E(β) 23 Quantitative Methoden – 7 Zeitreihenanalyse So wie auch hier kann die Varianz oben oft nur geschätzt werden: P \b V ar(b α/β) wird geschätzt als s2 ∗ [ xi ∗ x0i ]−1 mit s2 = 1 X 2 ei n−1 (47) Da geschätzt wird gilt aber immer: 1 P 2 2 2 E(s ) = σ , aber E( n ei ) 6= σ 2 , weshalb man den Korrekturfaktor verwendet. 7 Zeitreihenanalyse In Wiwi meistens Beobachtung von Zeitreihen (=geordnete Realisationen von ZVen): Y1 , Y2 , ...YT mit T=Zeitreihenindex Ökonomische Beispiele: • 3 Monats-Zinssatz (LIBOR (London Inter Bank O. Rate)= täglich verfügbar • BIP Wachstum = vierteljährlich • ALQ = monatlich • → geordnet nach Zeit • → Beobachtungen=Realisationen einer Folge zeitlich geordneter ZVen = stochastischer Prozess =“langer natürlich geordneter Zufallsvektor“ Notation: (Yt ) = Y1 , Y2 ...Yt ... (Yt )t=∞ t=−∞ = ...Y−1 , Y0 , Y1 ...Yt ...YT ... (aber nur die Werte von 1-T werden als Realisationen betrachtet) 7.1 Der stochastische Prozess 7.1.1 Beispiele für stochastische Prozesse „Lego-Blocks“ = Bausteine für andere stochastische Prozesse „Ensembles“(=wiederholte Welten); ist keine Realität, aber wir tun als ob wir es könnten Für einige stochastische Prozesse reicht eine Realisation für die Aussage über die Verteilung, E, Var..., bei einigen reicht es nicht (Gausscher) White Noise: Yt = t mit t u.i.v. und N(0,1) 24 Quantitative Methoden – 7 Zeitreihenanalyse Random Walk: P Yt = Yt−1 + t = ti=1 i (Aufsummierung der vergangenen Zufallsrestriktionen) Random Walks drücken keine Trends aus und damit sind keine Aussagen über die Realität möglich (keine Zukunftsaussagen) Die aufsteigende Varianz zeigt, dass die Ziehungen nicht aus der gleichen Verteilung kommen (nicht u.i.v.) Hier kann man also nur aufgrund einer Realisation keine Aussage über Eigenschaften machen. Random Walk with drift: Yt = c + Yt−1 + t Langfristig dominiert der Drift (bei pos. c langfristig Aufwärtstrend) Auch hier aufsteigende Varianz was Prognostizierbarkeit erschwert. Trendstationärer Prozess: Yt = c ∗ t + t Konstante Varianz, d.h. alle mit ähnlicher Aufwärtsbewegung. Geringe Unsicherheit Unterscheidung: bei 2,3 wirken alle noch ohne schwächer zu werden (Einheitswurzelprozess) bei 4 wirkt nur das aktuelle Mischungen sind möglich; entschieden wird sich im Hypothesentest für eines. 7.1.2 „Werkzeuge“ Z ∞ Yt ∗ fYt dYt = µt (Schira : µ(t)) E(yt ) = (48) −∞ V ar(yt ) = E[(yt − y)2 ] = σt2 (sigma2 (t)) (49) Cov(yt , yt−j ) = E[(yt − µt )] = γj,t (γj (t)) = Autokovarianz (50) Cov(yt , yt−j ) γj,t = = ρj,t (ρj (t)) = Autokorrelation; −1 ≤ ρj,t ≤ 1 σt ∗ σt−j σt ∗ σt−j (51) FYt (yt ) = P (Yt ≤ Yt ) = V erteilungsf unktion(marginaleV erteilungsf unktion) (52) fYt (yt ) = dFYt (yt ) = Dichtef unktion(marginaleDichtef unktion) dYt (53) Fy1 ...yT (y1 ...yt ) = gemeinsameV erteilungsf unktion (54) fy1 ...yT (y1 ...yT ) = gemeinsameDichtef unktion (55) fyt |yt−1 ...y1 = bedingteDichtef unktion (56) E(yt |yt−1 ...y1 ) = bedingterErwartungswert (57) V ar(yt |yt−1 ...y1 ) = bedingteV arianz (58) 25 Quantitative Methoden – 7 Zeitreihenanalyse bedingte Momente 6= unbedingte Momente (wenn ich Abhängigkeiten im stochastischen Prozess drin habe) =Prognostizierbarkeit 7.1.3 Restriktion auf Heterogenität (Stationarität) und Gedächtnis (Ergodezität) des stochastischen Prozesses Entscheidende Frage: reicht eine Realisation des stochastischen Prozess aus um die Parameter(Momente)/Verteilung des stochastischen Prozesses konsistent zu schätzen. → nur wenn bestimmte Bedingungen bezüglich Stationarität und Ergodezität gelten: Man hat drei Realisationen in einer Simulation (S=3). Dies sind unabhängige Experimente. Die einzelnen Zeitziehungen müssen jedoch nicht unabhängig sein. Wichtig ist: sind fy10 und fy100 gleich, d.h. ziehe ich aus der gleichen Verteilung (siehe Abbildung) Zur Berechnung P s eines Durchschnitts bräuchte man das „Ensemble-Mittel“: y10 = 1s y10 (wegen SGGZ: lim P[|y10 − E(y10 )| > ] = 0; d.h. y10 → E(y10 ) = µ10 Wir haben jedoch nur eine Realisation. . Deshalb berechnet man das „Zeitreihen-Mittel“: 1 P yt → E(y10 ) T Notwendige Bedingung ist dafür: (yt ) muss stationär sein. (6= u.i.v., denn u ist abgeschwächt, da Abhängigkeit über Zeit hinweg erlaubt) Stationarität: (identische Verteilung beibehalten; Unabhängigkeit aufgeweicht) schwache Stationarität (auch Kovarianz-Stationarität) E(Yt ) = µt = µ (mittelwert-stationär) V ar(Yt ) = σt2 = σ 2 = γ0 (varianz-stationär) Cov(yt , yt−j ) = γj,t = γj (kovarianz-stationär) γ γ ρj = σj2 = γ0j für schwach stationären Prozess Anmerkungen: Bei gemeinsamer Normalverteilung (=Gausscher Prozess: fyt , fyt+j1 ...fyt+jn gem. normalverteilt) impliziert schwache Stationarität gleichzeitig auch strenge Stationarität. strenge Stationarität F (y1 , y2 ...ym ) = F (y1+k , y2+k ...ym+k ) Es gibt nur einen Fall in dem es strenge Stationarität gibt ohne schwache: eine Verteilung in der bestimmte Momente nicht existieren. Regression und Mittelwerte machen bei Zeitreihen nur Sinn wenn man stationären Prozess als Grundlage hat. Bei zwei nichtstationären Reihen bekommt man nur sinnvolle Ergenisse bei Kointegration. Ergodezität: (gilt nur im stationären Prozess) Stationärer Prozess ist (mittelwert) ergodisch: P yt und y ist konsistenter Schätzer für µ (keine u.i.v. limt→∞ P [|y − µ| > ] = 0 mit y = 1/T Stichprobe mehr benötigt) Anmerkungen: Ergodezität kann oft nur angenommen werden, schwer zu testen 26 Quantitative Methoden – 7 Zeitreihenanalyse Notwendige Bedingung für Mittelwertergodezität ∞ X |γj | < ∞ (59) j=0 d.h. die Kovarianzen müssen geringer werden; das Gedächtnis muss abnehmen Kovarianz-ergodischer Prozess KEP T X 1 (yt − µ) ∗ (yt−j − µ) →p γj = Cov(yt − yt−j ) T −j (60) t=j+1 → Kovariant und Varianz können aus einer Realisation geschätzt werden Die notwendige Bedingung für KEP ist im allgemeinen schwieriger zu beweisen, aber einfach für Gausscher Prozess: ∞ X |γj | < ∞ (61) j=0 → Prozess ergodisch für alle Momente Übersicht zu Stationarität Anlage 7.1.4 2 nützliche Operatoren Lag-Operator L (z.B. B) Lyt = yt−1 Lyt−1 = yt−2 = L(Lyt ) = L2 yt L wird behandelt wie Multiplikation mit reeller Zahl: L(a ∗ yt ) = a ∗ Lyt = a ∗ yt−1 Lag-Polynome: ϕ(L) = 1 − φ1 L − φ2 L2 − ... − φp Lp = (1 − φ1 L − φ2 L2 − ... − φp Lp )yt = yt − φ1 yt−1 − φ2 yt−2 − ... − φp yt−p Faktorisierung: (1 − λ1 L)(1 − λ2 L) = 1 − λ1 L − λ2 L + λ1 λ2 L2 = 1 − (λ1 λ2 )L + λ1 λ2 L2 → Polynom Differenzen-Operator ∆ ∆yt = yt − yt−1 = (1 − L)yt → ∆ = 1 − L ∆2 yt = (1 − L)(1 − L)yt = (1 − 2L + L2 )yt = yt − 2yt−1 + yt−2 = (yt − yt−1 ) − (yt−1 − yt−2 ) = ∆yt − ∆yt−1 27 Quantitative Methoden – 7 Zeitreihenanalyse 7.1.5 Einige wichtige univariate stochastische Prozesse • White Noise • Martingal • Moving Average Prozes (MA) • Autoregressiver Prozess (AR) (mit Random Walk) • Unit-Root Prozesse • ARMA Prozesse Methodologie: • Ein Stochastischer Prozes als DGP für ökonomische Zeitreihe annehmen • Spezifikation des SP (z.B. Lag Länge q) • Schätzung Parameter mit ML, KQ, MM... • analyse und Prognose White Noise (WN) (yt ) E(yt ) = 0; V ar(yt ) = σ 2 ; Cov(yt , yt−j ) = 0mitj = 1, 2, ... Prozess ohne Gedächtnis = am nächsten von allen an u.i.v. yt ≈ N (0, σ 2 ) = Gausscher WN Anmerkung: WN (schwach) stationär und (mittelwert) ergodisch Martingal (m) E(yt |yt−1 ...) = yt−1 Martingal-Differenz-Prozess (m.d.) E(yt |yt−1 ...) = 0 Anmerkung • m und m.d wichtig in Finance • wie Random Walk • Unter bestimmten Voraussetzungen ist E(yt |yt−1 ...) = yt−1 die beste Prognose für yt : Prognosenutzer will MQF der Prognose zu minimieren: M QF = E((yt |yt−1 ... − yt )2 ) Wenn (yt Martingal, dann yt−1 die beste Prognose 28 Quantitative Methoden – 7 Zeitreihenanalyse • wenn (yt ) Martingal dann (∆yt ) Martingal-Differenz, da: E(yt − yt−1 |yt−1 ...) = E(yt |yt−1 ...) − yt−1 = yt−1 − yt−1 = 0 • (yt ) ist m.d → (AT S)cov(yt , yt−j ) = 0 für alle t,j als „unbedingter Erwartungswert“ (=kein Gedächtnis) • Die cov(yt , yt−j ) = 0 ist zu unterscheiden von der empirischen Kovarianzen (Korrelationen), die als Tests benutzt werden können um obige These zu testen Moving Average Prozess (MA) MA(1) yt = µ + θ ∗ t−1 + t Dabei sind µ und θ Parameter. t bezeichnet „Innovationen“, „etwas neues“, „Schocks“. Aufgebaut ist der Prozess wie die Einfachregression, nur das t−1 unbeobachtet MA(q) yt = µ + θ1 ∗ t−1 + θ2 ∗ t−2 + ... + θq ∗ t−q + t "‘Repräsentationen“= gleicher Prozess wird umgeschrieben dargestellt: yt − µ = (1 + θ1 L + ... + θq Lq )t Anmerkungen/Resultate: • jeder MA(q) mit q<∞ ist stationär und mittelwertergodisch • schwankt um den Mittelwert, wie White Noise • Einfache Berechnung von Momenten von (yt ) z.B. E(yt ) = E(µ)+θ1 E(t−1 )+...+θq E(t−q )+ E(t ) = µ (da E(t ) = 0 wegen White Noise) • „Gedächtnis“ MA(q): exakt q Perioden, d.h. γj 6= 0 für j=0...q; γj = 0 für j>q (äquivalent Pj ) • Ökonomische Prozesse als MA(q): Geldmenge Beispiele für MA(2) siehe Anlage Grenzfälle MA: MA(0) = White Noise mit µ=E()6= 0 (kein Gedächtnis) M A(∞) = yt = c0 + ψ0 ∗ t + ψ1 ∗ t−1 ... (ist immer ein anderer Prozess, der umgeschrieben wurde und der eine bestimmte Folge der ψ impliziert → macht ihn wieder schätzbar, z.B. Random Walk ψ immer 1) ∞ → Stationarität MA(∞) hängt ab von j )j=0 ab. P(ψ ∞ → Ergebnis: MA(∞) stationär wenn j=0 |ψj | < ∞ = Koeffizientenfolge absolut summierbar, dann E(yt ) = E(c) + (ψ0 + ψ1 + ...)E(t ) = c(= µ) Beispiele für MA siehe Anlage Autoregressive Prozesse AR(1) 29 Quantitative Methoden – 7 Zeitreihenanalyse yt = c + φ ∗ yt−1 + t mit (t ) White Noise mit Rekursion: yt = c + φ(c + φ ∗ yt−2 + t−1 ) + t =c + φ ∗ c + φ2 ∗ yt−2 + φ ∗ t−1 + t ... =[1 + φ + φ2 + ...] ∗ c + t + φ ∗ t−1 + φ2 ∗ t−2 ... =Konvergente Reihe (<∞)*c+MA(∞) Stationarität von AR: 1 hängt ab von φ: wenn |φ| < 1 dann lim[1 + φ + φ2 + ... + φj ] = 1−φ <∞ P∞ P∞ j 1 2 und j=0 |ψj | = j=0 |φ| = 1 + |φ| + φ + ... = 1−φ < ∞ =Stationaritätsbedingung für MA(∞) erfüllt und damit ist AR(1) stationär. c c + “ < ∞“ ∗ 0 = 1−φ → E(yt ) = [1 + φ + φ2 + ...] ∗ c + [1 + φ + φ2 + ...]E(t = 1−φ Ebenso wird auch für höhere Momente und Autokovarianzen/Autokorrelationen vorgegangen. Beispiel: Zinszeitreihen Beispiele (ρj ) für stationäre AR(1) siehe Anlage Besondere Prozesse: „mean-reverting“: Prozess kehrt immer wieder zum Erwartungswert zurück; trotzdem kann er länger drüber oder drunter liegen = Gedächtnis, „kleben“; Bsp. c=0,5, φ = 0,9 Bei -0,9 nicht gegeben, da erwartet man wenn einmal überm Erwartungswert, dann nächstes Mal drunter Schwer zu unterschieden vom Random Walk, denn wenn φ=1 ist AR(1)=Random Walk (Stationarität geht verloren) Alternative Repräsentation: ∆yt = yt − yt−1 = ρ(yt−1 − µ) + t mit ρ = φ − 1 und µ = Dabei ist ρ(yt−1 − µ) der Fehlerkorrekturterm c 1−φ für |φ| < 1 Andere Fälle: φ>1 „Werte explodieren“ exponentiell Diese Fälle sind wirtschaftswissenschaftlich nicht relevant siehe Anlage Fall φ=1 yt = c + yt−1 + t ↔ (1 − L)yt = c + t ↔ ∆yt = c + t AR(1) Rekursion: =[1+1+...]*c+t + t−1 ...ψj = 1, d.h. die Summe geht gegen unendlich und ist nicht konvergent; damit nicht stationär) Anmerkungen: 30 Quantitative Methoden – 7 Zeitreihenanalyse • E(yt ) existiert nicht, da [1+1+...]*c+[1+1+...]E(t und damit ist der letzte Ausdruck mit ∞∗0 nicht definiert • V ar(yt ) und andere höhere Momente existieren nicht • GGZ und ZGS funktionieren nicht wegen fehlenden Momenten • AR(1) nicht stationär • Permanenter Effekt vergangener Schocks auf yt (Charakteristikum für URP) • Erste Differenz ist stationär; er ist also differenzenstationär AR(p) in MA(∞) - Berechnung (ψj ): yt = c + φ1 ∗ yt−1 + ... + φp yt−p + t mit (t ) w.n. =[1 − φ1 L − ... − φp Lp ]yt = c + t → Intelligente Rekursion mit AR(p)=MA(∞) (1 − φ1 L − ... − φp Lp )yt = c + t 1 − φ1 z − ... − φp z p = 0 (z − z1 ) ∗ (z − z2 )...(z − zp ) = 0; λj = 1/zj mit zj ist Nullstelle (1 − λ1 z)(1 − λ2 z)...(1 − λp z)) = 0; z → L; äquivalente Darstellung des Lag-Polynoms (1 − λ1 L)(1 − λ2 L)...(1 − λp L)yt = c + t yet = (1 − λ2 L)...(1 − λp L) (1 − λ1 L)yet = c + t yet = c + λ1 ∗ yg t−1 + t (AR(1)f r yet ) →AR(1) Rekursion wenn |λ1 < 1| oder |z1 | > 1 gilt: c yet = 1−λ + t + λ1 t−1 + λ21 t−2 ... 1 yet = e c + uet yet = (1 − λ3 L)...(1 − λp L)yt c + uet (1 − λ2 L)yet = e y für |λ2 < 1| oder |z2 | > 1: AR(1) Rekursion auf e e c 2 e y = 1−λ + u e + λ u g t 2 t−1 + λ2 ug t−2 + ... 2 2 mit uet = t + λ1 t−1 + λ1 t−2 2 λ2 ug t−1 = λ2 t−1 + λ1 λ2 t−2 + λ1 λ2 t−3 + ... 2 2 2 2 λ22 ug t−2 = λ2 t−2 + λ1 λ t−3 + λ1 λ2 t−4 + ... 3 3 2 λ2 ug t−3 = λ2 t−3 + λ1 λ t−4 + ... Für p=2, d.h. yet = yt c yt = (1−λ1 )(1−λ + t + (λ1 + λ2 )t−1 + (λ21 + λ1 λ2 + λ22 )t−2 + (λ31 + λ21 λ2 + λ1 λ22 + λ32 )t−3 + ... 2) c yt = (1−λ1 )(1−λ2 ) + t + ψ1 t−1 + ψ2 t−2 + ... allgemein: ψj = c1 λj1 + c2 λj2 mitc1 = λ1 λ1 −λ2 ; c2 = −λ2 λ1 −λ2 31 Quantitative Methoden – 7 Zeitreihenanalyse → c1 + c2 = 1 P Wenn |λ1 | < 1 und |λ2 | dann |ψ| < ∞ und AR(2) ist stationär Für AR(2): c E(yt = (1−λ1 )(1−λ + (1 + ψ1 + ψ2 + ...)E(t ) = 2) 2 Da (1 − φ1 z − φ2 z ) = (1 − λ1 z)(1 − λ2 z) Für alle z gilt, daher auch für z=1 (1 − φ1 − φ2 ) = (1 − λ1 )(1 − λ2 ) E(yt ) = 1−φ1c−φ2 c (1−λ1 )(1−λ2 ) Für p>2 Weiter mit AR(1) Rekursion mit |λj | < 1 yt = (1−λ1 )(1−λc 2 )...(1−λp ) + t + ψ1 t−1 + ψ2 t−2 + ... P ψj = c1 λj1 + c2 λj2 + ... +Pcp λjp mit cj = 1 Wenn |λj | < 1∇j dann |ψj | < ∞ → AR(p) stationär c E(yt ) = 1−φ1 −φ 2 ...φp 7.1.6 Unit-Root-Prozess (URP) Hier gelten andere Regeln der Statistik (andere Welt)= Standard-Statistik funktioniert nicht Unit Root= eine Nullstelle des Polynoms (1 − φ ∗ z − ... − φp ∗ z p ) ist 1 • AR(1) mit φ=1 ist ein spezieller URP • Permanenter Effekt vergangener Schocks • Regression von xt auf yt wenn beide URP ist problematisch • KQ-Eigenschaften (BLUE) gelten nicht mehr • E(yt ) und höhere Momente existieren nicht • ZGS, GGZ gelten nicht • Differenzenstationär: ∆yt = e c + wt (= M A(∞)) • Tests haben keine Standardverteilung • Ausnahmen wenn x un y kointegriert sind Kointegration: (xt ) und (yt ) sind kointegriert wenn URP, aber z = a1 ∗ xt + a2 ∗ yt mit z stationär Unit Root im AR(p) - was wenn λp = 1(zp = 1) Fall zp = 1 : zp ist die betragsmäßig kleinste Nullstelle von (1 − φ1 z − ... − φp z p ) 32 Quantitative Methoden – 7 Zeitreihenanalyse Was bedeutet das für den AR(p)? f1 t−1 + ψ f2 t−2 + ... mit: (1 − λL)yt = e c + t + ψ c e c = (1−λ1 )...(1−λ p−1 ) fj = c1 λj + ... + cp λj ψ 1 p−1 → (1 − L)yt = e c + wt mit: f1 t−1 + ψ f2 t−2 + ... wt = t + ψ P e Da ψ < ∞wenn |λ1 | ... |λp−1 | < 1 ist wt eine stationärer MA(∞) mit E(wt =0 Man muss aber beachten dass obiges vereinfacht, richtig wenn man oben ausmultipliziert: yt = e c + yt−1 + wt =Random Walk mit stationären Innovationen (nicht notwendigerweise unkorreliert) Letzte AR(1) Rekursion: yt = (1 + 1 + ...)e c + wt + wt−1 + wt−2 ..., d.h. der erste Teil geht gegen unendlich und E(yt ) existiert nicht. Problem der Scheinregression: (yt ) und (xt ) URP (z.B. unabhängige Random Walks): Regression yt = λ + β ∗ xt + t liefert unsinnige Ergebnisse (β sollte 0 sein, kann aber oft im t-Test nicht verworfen werden) → Test auf URP wichtig! Dicky-Fuller-Test: H0 : (yt ist URP HA : (yt ) nicht URP DF-Testidee: H0 : yt = yt−1 + t (wahrer Prozess ist URP), d.h. φ=1; AR(1)=Random Walk ohne Drift (Anmerkung: auch RW mit Drift möglich) Konstruktion einer Teststatistik im Regressionsmodell: yt = c + φ ∗ yt−1 + t ∆y = c + ρ ∗ yt−1 + t mitρ = φ − 1 b ρb → Schätzung der Parameter oben mit der KQ-Methode: φ; T-Test der Hypothese, dass φ=1 bzw. ρ=0 b φ−1 ρe τ = se(φ) , bzw. τ = se(ρ) Test ist einseitig: verwirft für kleine negative Werte Problem: wenn H0 korrekt, dann ist τ -Statistik keine bekannte Verteilung → Lösung: simulation der Verteilung von τ unter der H0 ; Tabulierung und Verwendung der simulierten Quantile Beispiele: 1) t-Verteilung: t0,05 =-1,645 im Vergleich mit DF-Verteilung: τ0,05 =-8,1, wobei τ in verschiedenen Varianten existiert = Fallweise Entscheidung notwendig 33 Quantitative Methoden – 7 Zeitreihenanalyse 2) SP500 H0 : SP500 ist ein URP 0,05 τ =-1,411; p-value=0,850; τkrit =-3,412 Die Nullhypothese, dass SP500 ein URP ist, kann auf dem 5% Signifikanzniveau nicht abgelehnt werden 3) Log Rendite der SP500 H0 : Log Rendite der SP500 ist ein URP 0,05 =-2,862 τ =-49,87; p-value=0,000; τkrit Die Nullhypothese kann auf jedem konventionellen Signifikanzniveau abgelehnt werden. 34