mit big data bessere entscheidungen treffen - T

Werbung

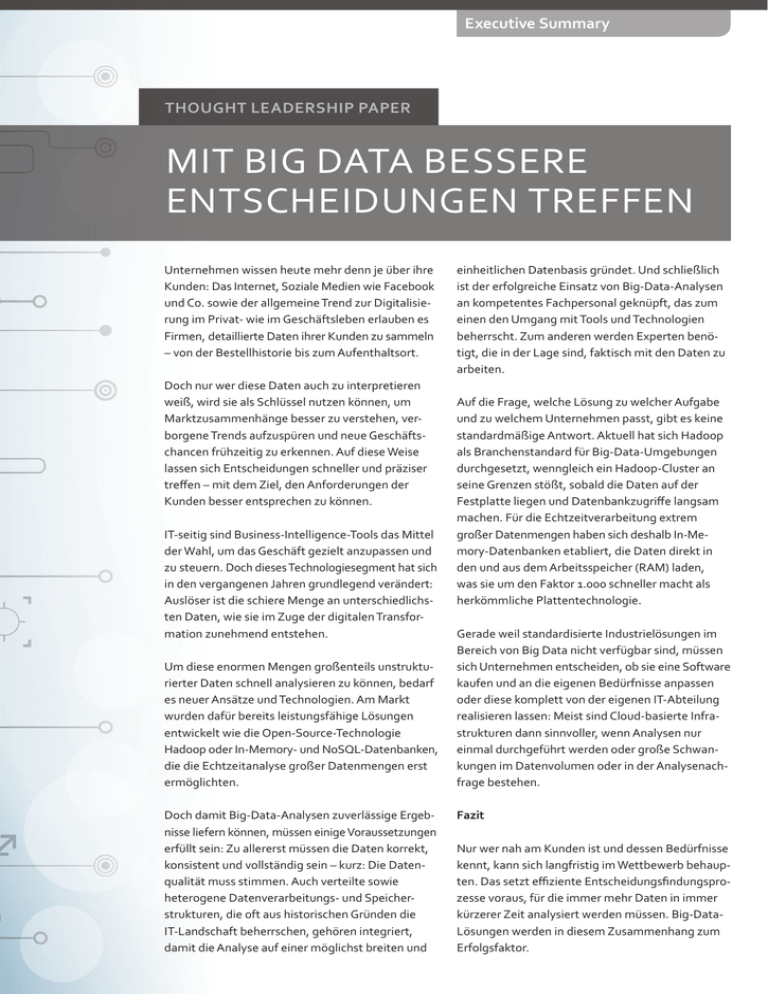

Executive Summary THOUGHT LEADERSHIP PAPER MIT BIG DATA BESSERE ENTSCHEIDUNGEN TREFFEN Unternehmen wissen heute mehr denn je über ihre Kunden: Das Internet, Soziale Medien wie Facebook und Co. sowie der allgemeine Trend zur Digitalisierung im Privat- wie im Geschäftsleben erlauben es Firmen, detaillierte Daten ihrer Kunden zu sammeln – von der Bestellhistorie bis zum Aufenthaltsort. Doch nur wer diese Daten auch zu interpretieren weiß, wird sie als Schlüssel nutzen können, um Marktzusammenhänge besser zu verstehen, verborgene Trends aufzuspüren und neue Geschäftschancen frühzeitig zu erkennen. Auf diese Weise lassen sich Entscheidungen schneller und präziser treffen – mit dem Ziel, den Anforderungen der Kunden besser entsprechen zu können. IT-seitig sind Business-Intelligence-Tools das Mittel der Wahl, um das Geschäft gezielt anzupassen und zu steuern. Doch dieses Technologiesegment hat sich in den vergangenen Jahren grundlegend verändert: Auslöser ist die schiere Menge an unterschiedlichsten Daten, wie sie im Zuge der digitalen Transformation zunehmend entstehen. Um diese enormen Mengen großenteils unstrukturierter Daten schnell analysieren zu können, bedarf es neuer Ansätze und Technologien. Am Markt wurden dafür bereits leistungsfähige Lösungen entwickelt wie die Open-Source-Technologie Hadoop oder In-Memory- und NoSQL-Datenbanken, die die Echtzeitanalyse großer Datenmengen erst ermöglichten. Doch damit Big-Data-Analysen zuverlässige Ergebnisse liefern können, müssen einige Voraussetzungen erfüllt sein: Zu allererst müssen die Daten korrekt, konsistent und vollständig sein – kurz: Die Datenqualität muss stimmen. Auch verteilte sowie heterogene Datenverarbeitungs- und Speicherstrukturen, die oft aus historischen Gründen die IT-Landschaft beherrschen, gehören integriert, damit die Analyse auf einer möglichst breiten und einheitlichen Datenbasis gründet. Und schließlich ist der erfolgreiche Einsatz von Big-Data-Analysen an kompetentes Fachpersonal geknüpft, das zum einen den Umgang mit Tools und Technologien beherrscht. Zum anderen werden Experten benötigt, die in der Lage sind, faktisch mit den Daten zu arbeiten. Auf die Frage, welche Lösung zu welcher Aufgabe und zu welchem Unternehmen passt, gibt es keine standardmäßige Antwort. Aktuell hat sich Hadoop als Branchenstandard für Big-Data-Umgebungen durchgesetzt, wenngleich ein Hadoop-Cluster an seine Grenzen stößt, sobald die Daten auf der Festplatte liegen und Datenbankzugriffe langsam machen. Für die Echtzeitverarbeitung extrem großer Datenmengen haben sich deshalb In-Memory-Datenbanken etabliert, die Daten direkt in den und aus dem Arbeitsspeicher (RAM) laden, was sie um den Faktor 1.000 schneller macht als herkömmliche Plattentechnologie. Gerade weil standardisierte Industrielösungen im Bereich von Big Data nicht verfügbar sind, müssen sich Unternehmen entscheiden, ob sie eine Software kaufen und an die eigenen Bedürfnisse anpassen oder diese komplett von der eigenen IT-Abteilung realisieren lassen: Meist sind Cloud-basierte Infrastrukturen dann sinnvoller, wenn Analysen nur einmal durchgeführt werden oder große Schwankungen im Datenvolumen oder in der Analysenachfrage bestehen. Fazit Nur wer nah am Kunden ist und dessen Bedürfnisse kennt, kann sich langfristig im Wettbewerb behaupten. Das setzt effiziente Entscheidungsfindungsprozesse voraus, für die immer mehr Daten in immer kürzerer Zeit analysiert werden müssen. Big-DataLösungen werden in diesem Zusammenhang zum Erfolgsfaktor. Executive Briefing MIT BIG DATA BESSERE ENTSCHEIDUNGEN TREFFEN Um Business-Entscheidungen frühzeitig, schnell und präzise zu treffen, müssen heute große Mengen von strukturierten und unstrukturierten Daten ausgewertet werden. Analysen mit Big-Data-Technologien helfen, hierfür die richtigen Antworten zu finden. Früher galt ein Händler als kundenfreundlich, wenn er Grillkohle neben Bier und Ketchup ins Regal stellte. Ganz nebenbei profitierte er von Mitnahmeeffekten. Heute muss er sich schon mehr einfallen lassen, wenn er im Kampf um die Gunst des Kunden bestehen will. Im E-Business ist es heute gang und gäbe, dass der Händler die Präferenzen seiner Kunden kennt, seine Bestellhistorie, die Rabattvorlieben und möglichst noch den Aufenthaltsort. Doch nur wer solche Daten auch zu interpretieren weiß beziehungsweise intelligent miteinander verknüpft, ist in der Lage, auf den Kunden zugeschnittene Angebote zu präsentieren und ihn dort abzuholen, wo er gerade ist – online, zu Hause auf der Couch oder in der Fußgängerzone. Dazu braucht er die richtigen Analyseinstrumente – und für seine Zwecke bestimmte oder notwendige Daten. Sie sind in Zeiten von globalem Wettbewerb und volatilen Märkten unverzichtbar und unterstützen Entscheidungsträger bei der Optimierung ihres Geschäfts. Händlern etwa geben Daten dezidiert Auskunft über das Kaufverhalten ihrer Klientel. Für Unternehmen sind sie der Schlüssel dazu, Markt­ zusammenhänge besser zu verstehen, verborgene Trends aufzuspüren und neue Geschäftschancen frühzeitig zu erkennen. Entscheidungen lassen sich so schneller und präziser treffen – das alles mit dem Ziel, näher am Kunden zu sein und seinen Anforderungen besser entsprechen zu können. So versetzt die Analyse von Daten zum Beispiel Marketingabteilungen in die Lage, feinkörnige ­ evölkerungs- und Kundensegmente zu erstelB len sowie Waren und Dienstleistungen auf deren Bedarfe zuzuschneiden. Eine detaillierte Seg­ mentierung von Zielgruppen erleichtert deren ­Ansprache, v­ ermindert die Streuverluste und ­somit auch die Kosten für Marketingkampagnen. Ein ­Telekommunikationsanbieter etwa kann mittels Datenanalyse herausfinden, warum Kunden ­abwandern, und so mit gezielten Maßnahmen ­gegensteuern. Die Rolle von Daten Viele Entscheidungsträger und Manager haben mittlerweile den strategischen Wert von Daten ­erkannt, nutzen relevante Datenquellen mit Informationen über ihre Produkte und Kunden und analysieren mit Business-Intelligence-Tools beispielsweise die Kaufhäufigkeit von Produkten oder die Veränderung von Lagerbeständen. Einer Studie des Softwareanbieters Artegic zufolge gehen 75 Prozent der befragten Unternehmen davon aus, dass der Unternehmenserfolg durch die Nutzung per­ sonenbezogener Daten aus dem Online-Marketing ­signifikant gesteigert werden kann. Mithilfe von Business-Intelligence-Tools lässt sich das Geschäft gezielt anpassen und steuern. Das Management profitiert deutlich von den daraus ­gewonnenen Informationen und kann sie als stra­ tegischen Kompass nutzen, um Veränderungen im Markt und im Kundenverhalten rechtzeitig zu erkennen und proaktiv tätig zu werden. 1 Aus Daten wird Big Data Entspannt zurücklehnen können sich Manager heute allerdings trotz Dashboards, Grafiken und Tabellen nicht. Denn in den vergangenen Jahren ist die Welt der Business Intelligence gehörig durcheinandergewirbelt worden. Auslöser ist die schiere Menge an Daten. Waren die für geschäftliche Entscheidungen relevanten Informationen noch bis vor Kurzem relativ überschaubar, sind sie in den zurückliegenden Jahren förmlich explodiert. Mittlerweile wird faktisch alles digita­lisiert, und es entstehen neue Arten von Transaktions- und Echtzeitdaten. Und auch Maschinen und Rechner produzieren enorme Datenmengen, die heute auf immer preiswerter und dynamischer w ­ erdender Hardware nutzbar werden: Allein ein modernes Flugzeug generiert innerhalb von 30 Minuten Flugzeit bis zu 10 Terabyte an Daten. Bei 25.000 Flügen pro Tag entstehen damit Petabytes an Daten. Die Transformation hin zu digitalen Geschäfts­ modellen und neuen Anwendungen steigert das Datenwachstum ebenfalls. Technologien wie Cloud Computing, RFID, transaktionale Systeme, Data Warehouses sowie Dokumenten-Managementund Enterprise-Content-Management-Systeme sind wichtige Entwicklungen im Kontext von Big Data. Viele dieser Systeme erzeugen fortwährend neue Datenströme. Den entscheidenden Anteil an der Datenexplosion aber haben das Internet, der zunehmende Anteil mobiler Geräte und vor allem die sozialen Medien wie Facebook, Twitter, YouTube und Co. Allein Facebook produziert beispielsweise täglich 2,7 Milliarden „Likes“, 300 Millionen Fotos und scannt jede halbe Stunde 105 TB Daten. Hinzu kommt, dass Datenmengen heutzutage nicht nur groß, sondern auch deutlich weniger strukturiert sind als die früheren typischen Geschäftsdaten in ERP-Systemen. Social-Media-Informationen wie Texte, Bilder, Audiodateien oder Videos lassen sich nicht mehr in ordentliche Zeilen und Spalten zwängen, wie es das relationale Datenbankmodell verlangt: Sie sind unstrukturiert. Laut der IDC-Studie „Storage in Deutschland 2013“ gehören inzwischen bereits 90 Prozent der Daten zu diesem unstrukturierten Typus und müssen mit ganz neuen Techniken erfasst und ausgewertet werden. (Quelle: IDC Storage*) Im Ergebnis bedeutet dies, dass Unternehmen es mittlerweile mit einem ungeordneten Aufkommen großer Mengen an strukturierten, semistrukturierten und unstrukturierten Daten aus einer Vielzahl verschiedenster Quellen zu tun haben. Gerade unstrukturierte Daten aus sozialen Netzwerken können Unternehmen heute nicht mehr ­ignorieren. Aus E-Mails, Feedback-Formularen, Kommentaren und Bewertungen in sozialen ­Netzen und Diskussionen in Foren lässt sich eine Menge lernen. Die massive Anzahl an täglich generierten Tweets – zurzeit etwa 12 Terabyte – ist eine profunde Basis etwa für die Trendforschung oder für die Produktentwicklung. Welche Branchen profitieren von Big Data? Unternehmen haben, je nach technischer Ausstattung, relativ einfachen Zugang zu großen Mengen nützlicher Markt- und Kundendaten – und wollen den Wert dieser Daten auch ausschöpfen. Laut ­einer von T-Systems in Auftrag gegebenen interna- Typische Datenarten heute Strukturierte DatenDaten, die in Tabellen und Strukturen von relationalen Datenbanken ­abgebildet werden Semi-strukturierte DatenDaten, die oft durch die Anwendung von Datenaustauschprogrammen zwischen Unternehmen erzeugt werden und daher häufig auf XML ­basieren Unstrukturierte DatenDaten aus Textdateien, Speech-to-Text-Anwendungen, PDFs, gescannte Post, ­Präsentationen, Bildern, Videos, Audiodateien 2 tionalen IDC-Studie hat bereits jedes zweite Unternehmen Big-Data-Projekte implementiert oder plant dies konkret. Drei von vier Unternehmen, die Big-Data-Projekte eingeführt haben, bezeichnen Business Analytics dabei in einer SAS-Umfrage als wirksam bei der Entscheidungsfindung (Quelle: SAS Decision Making*). Am meisten profitieren sie der Untersuchung zufolge von einer erhöhten Rentabilität, reduzierten Kosten, gezielterem ­Risikomanagement, Prozessoptimierung, schneller Entscheidungsfindung und Performance-­ Verbesserungen. Der mit Big Data verbundene Aufwand zahlt sich laut McKinsey auch in barer Münze aus. Werden Big Data richtig und zeitnah analysiert, können beispielsweise Handelsunternehmen ihre Marge um bis zu 60 Prozent verbessern, und europäische Behörden können durch effizientere Prozesse 250 Millionen Euro pro Jahr einsparen, so die Consultants. Wenn Unternehmen mehr über die Standorte ihrer Kunden wüssten, könnten sie sogar zusätzlich Produkte im Wert von 600 Millionen Dollar absetzen. (Quelle: McKinsey Big Data*) Während sich bis vor Kurzem nur Banken, Finanzdienstleister und ausgewählte Großkonzerne – ­typische Anwender von Data Warehousing und Business Intelligence – mit automatisierten Entscheidungsprozessen beschäftigt haben, erkennen nun laut Experton Group zunehmend auch Han­ delskonzerne, Versorgungsunternehmen sowie ­Anbieter in den Branchen Life Sciences und Medizin sowie aus vielen anderen Märkten, dass Daten zum Grundkapital gehören – also ein wichtiges Wirtschaftsgut sind. (Quelle: Experton Big Data*) Aufgefächert auf Unternehmensabteilungen pro­ fitieren von Big Data besonders Forschung und ­Entwicklung, Marketing und Vertrieb, Produktion, Distribution und Logistik sowie Finanz-Controlling und Risk-Management. In diesen fünf Funktions­ bereichen lässt sich der wirtschaftliche Nutzen von Big Data besonders eindrucksvoll belegen. Big Data analysieren Trotz des unumstrittenen Nutzens stellt es für viele Firmen eine Herausforderung dar, die gesammelten Daten in verwertbare Informationen zu verwandeln. Laut Marktforscher Gartner werden bis 2015 mehr als 85 Prozent der Fortune-500-Unternehmen nicht in der Lage sein, Big Data effektiv zu nutzen, um sich einen Wettbewerbsvorteil zu verschaffen. „Die meisten Unternehmen sind schlecht auf die Herausforderungen für Technik und Verwaltung vorbereitet, die mit Big Data einhergehen“, sagen die Analysten von Gartner. „Daher werden nur ­wenige in der Lage sein, diesen Trend effektiv zu nutzen und sich einen Wettbewerbsvorteil zu verschaffen.“ (Quelle: Gartner PI*) Alle drei Faktoren – Datenmenge, Datenvielfalt und Verarbeitungsgeschwindigkeit – sind eine große Herausforderung mit Blick auf die herkömmliche Datenverarbeitung und -analyse. Relationale ­Datenbanken sind ihrem Ursprung und ihrer Architektur nach dann effizient nutzbar, wenn sie für häufige Transaktionen auf Datensatzebene oder für Szenarien mit kleinen bis mittleren Datenvolumina eingesetzt werden. Zur Verarbeitung und Analyse von Datenmengen im Peta- oder gar Exabyte-Bereich sind sie nicht ausgerichtet. Vor allem lassen sich unstrukturierte Daten nicht oder nur schwer in tabellenorientierten, relationalen Datenbanksystemen speichern. „Da immer mehr Daten für Auswertungen zur ­Verfügung stehen, brauchen Unternehmen neue Ansätze und Technologien“, heißt es in der GartnerStudie „Big Data Opportunities, New Answers and New Questions“ (Quelle: Gartner Big Data*). Neue „Big-Data-Systeme“ müssen nicht nur die ­Datenmassen bewältigen, sondern auch unstruk­ turierte Daten zuverlässig analysieren – und das möglichst schnell. Diese Echtzeitanalysen erfordern Systeme mit extrem schnellen Datenbankzugriffen und einer effizienten Parallelisierung, um Aufgaben auf viele Rechner zu verteilen – ein Ansatz, der aus der Vergangenheit unter dem Begriff Grid Computing bekannt ist. Wegbereiter solcher Big-Data-Werkzeuge zur Analyse unstrukturierter Daten war Google. Mit dem Programmiermodell MapReduce hat der Konzern die Verarbeitung der Datenmassen so aufgeteilt, dass die Infrastruktur flexibel an die Datengröße angepasst werden kann. Daraus entstand das populäre Open-Source-Projekt Hadoop, heute neben In-Memory und NoSQL-Datenbanken für unstrukturierte Daten der Standard für die Big-Data-Technologie. Im Bereich der Unternehmensanwendungen setzte SAP mit der auf In-Memory-Technologie basierenden SAP-HANA-Datenbank (High Performance Analytic Appliance) die Entwicklung in Gang. Das Herzstück der Big-Data-Analyse bilden Modelle und Algorithmen, die darauf ausgerichtet sind, 3 ­ usammenhänge in den Datenbergen ausfindig zu Z machen und Muster und Ähnlichkeiten zu erkennen. Diese Predictive- oder Business-Analytics-­ Lösungen helfen nicht nur, schnell und akkurat ein Bild der Gegenwart zu zeichnen, sondern auch, ­Vorhersagen zu treffen und damit Prognosen über künftige Entwicklungen abzugeben. Dies geschieht auf Basis von statistischen und stochastischen ­Methoden, Datenmodellen und Simulationen mit Best-Case- und Worst-Case-Szenarien, die die ­Entwicklung ganz neuer Berufsbilder, wie das des „Data Scientist“, nach sich ziehen. Business goals related to decision-making capabilities and agility/speed are significantly connected to a majority of respondents’ big data strategies and initiatives. (5) To a significant extent (4) (3) To a moderate extent (2) Increasing speed of decision-making Increasing business agility New customer acquisition/retention Using immediate market feedback to improve customer satisfaction Building new business partnerships Improving internal communication Developing new products/services and revenue streams Quelle: How ­Organisations are ­approaching Big Data, IDG, September 2013 (200 Entscheider aus Unternehmen mit mehr als 100 Mitar­ beitern in den USA, Brasilien, Niederlande, Österreich, Südafrika und der Schweiz) Strengthening existing business partnerships Improving finance/accounting and procurement processes Reducing CAPEX Reducing OPEX 34 23 53 35 32 26 53 37 31 Improving the speed of response to IT security issues Meeting regulatory/compliance requirements 35 31 Improving the quality of decision-making Improving planning and forecasting capabilities (1) To a significant extent 28 31 29 22 29 35 6 3 28 26 33 30 26 33 27 4 3 8 3 8 5 26 32 32 6 4 25 34 32 6 4 25 32 35 5 3 25 32 34 6 3 25 29 23 30 19 23 18 28 35 33 41 41 6 4 9 5 12 5 8 5 To what extent is your organization’s big data strategy/big data initiatives connected to each of the following business goals? Base: 155 qualified respondents who have implemented or have plans to implement big data projects (figures in per cent) About half of all respondents have either already deployed or are in the process of implementing big data projects at their organizations. Already deployed/implemented big data initiatives In the process of implementing big data projects 23 25 Planning to implement big data projects over the next 12 months Planning to implement big data projects within the next 13 – 24 months We have no immediate plans to implement big data projects Quelle: How ­Organisations are ­approaching Big Data, IDG, September 2013 10 23 21 At what stage is your organization currently with the planning and rollout of big data projects? Base: 200 qualified respondents (figures in per cent) 4 Data to Decisions: die sechs Schritte Wie entstehen aus den großen Mengen un­ strukturierter Twitter- und Facebook-Text-, ­Video- und Verbrauchsdaten aussagekräftige ­Informationen? Zwischen den Daten, die den Weg in das Unternehmen finden, und den ­aufbereiteten Informationen, die Führungs­ kräften als Entscheidungsgrundlage dienen, liegt ein technisch aufwendiger Weg. Es finden unzählige Auswahl-, Verarbeitungs- und Analyseprozesse statt. Der Analytics-Experte Ken McLaughlin schlägt – basierend auf der Auswertung mehrerer Fall­ studien – in seinem Blog „Data to Decisions“ sechs konkrete Schritte vor, wie sich mit Business Analytics datenbasierte Entscheidungen generieren lassen. Schritt 1: Ein Ziel definieren Ein klar definiertes Ziel muss zwei Voraussetzungen erfüllen: Es muss sowohl erreichbar als auch messbar sein. „Senke die Produktversandkosten um 15 Prozent“ wäre zum Beispiel ein klar formuliertes Ziel. Schritt 2: Alternativen modellieren Das Ziel bestimmt die Richtung, gibt die Alternativen und den Weg zur Erreichung des Ziels vor. Beispiel: „Kosten für einen preiswerten ­Versender“ versus „Kosten für einen automa­ tisierten Abwicklungsprozess“ wären mögliche Alternativen. Schritt 3: Erforderliche Daten bestimmen Festlegung der Daten und Metriken, die für die ­jeweilige Alternativen gebraucht werden. Im Beispiel: frühere Versandkosten sowie Software- und Hardwarekosten für automatisierte Prozesse. Schritt 4: Daten sammeln und organisieren Um die Modelle bewerten zu können, müssen zuvor Daten gesammelt und organisiert werden. Schritt 5: Daten analysieren Für die eigentliche Bewertung müssen die geeignete Analysetechnik und im Anschluss die beste Modellalternative ausgewählt werden. Schritt 6: Entscheiden und ausführen Schließlich sollten die Aktion, die die besten ­Ergebnisse brachte, ausgeführt und die realen Resultate beobachtet werden. Welche Risiken gibt es? Eine zentrale Frage im Zusammenhang mit Big Data ist die nach der Datenqualität: Kommen ­Daten mehrfach vor, sind sie fehlerhaft oder in­ konsistent, fehlen ganze Datensätze? Den Nutzern ist die Bedeutung dieser Frage in der Regel bewusst, wie eine Studie von Omikron Data Quality zeigt. Danach gehen 39 Prozent der Befragten ­davon aus, dass Big-Data-Ansätze zum Scheitern verurteilt sind, wenn die Daten von schlechter ­Qualität sind. „Es leuchtet ein, dass mit einer größeren Datenmenge die statistische Signifikanz steigt und man sich also auf die BI-Analyseergebnisse besser verlassen kann“, heißt es in der Studie. „Sind aber schon die Ausgangsdaten unrichtig, doppelt oder inkonsistent, wird diese Signifikanz trüge- risch: Im schlimmsten Fall hat man dann zwar ­mathematisch folgerichtige und scheinbar klare Ergebnisse – die aber sind faktisch falsch. Wenn dann aus den Analyseergebnissen auch noch Handlungen abgeleitet werden – was ja das Ziel von BI ist –, sind negative Folgen programmiert.“ (Quelle: Omikron Data Quality*) Sollen die Analysen und Prognosen also korrekt sein, muss die Grundlage, die Daten, stimmen. In der klassischen BI existieren dazu im Rahmen des sogenannten ETL-Prozesses (Extract, Transform, Load) erprobte Verfahren und Methoden, unsau­ bere Daten zu bereinigen, bevor die Informationen im Data Warehouse landen. Dazu gehören etwa Profiling, Cleansing sowie Anreichern und Abgleichen mit Referenzdaten. 5 Herausforderung Datensilos Eine weitere grundlegende Herausforderung (oder weitere Kernfrage) im Umgang mit Big Data ist die Verteilung der Daten auf parallele Systeme. Zum ­einen beherrschen aus historischen Gründen noch immer Datensilos – etwa aus CRM-, ERP- und anderen Systemen – die Architektur der Datenhaltung, die zunehmend auch die Altdatenarchivierung übernehmen müssen. Mit steigendem Datenvolumen weisen zum nderen viele Unternehmen die ­anfallende Datenflut nur noch verschiedenen ­Speicherorten zu – ohne sie vorher zu verarbeiten und zu transformieren. Diese verteilten und heterogenen Datenverar­ beitungs- und Speicherstrukturen sind weder ­wirtschaftlich noch zielführend für potenzielle ­Datenanalysen. Sie verhindern den Austausch und die Integration von Daten und erschweren insbeson­dere den ganzheitlichen Blick auf das ­Datenmanagement. Abhilfe können hier moderne Integrationstech­ nologien schaffen, die die strukturierten, unstruk­ turierten und semistrukturierten Daten aus den ­verschiedenen Quellen zu einem integralen Bestandteil der unternehmensweiten Datenmanagementstrategie machen. Dazu zapfen Softwarelösungen die Datenquellen im gesamten Unternehmen an, lesen und extra­ hieren sie und laden sie in das dafür vorgesehene Speichersystem. Im nächsten Schritt werden diese Daten in Datenmodelle eingespielt und mit weiteren Daten aus anderen Quellen angereichert und anschließend ausgewertet. Cloud-basierte Systeme helfen hier, Speicherkapazitäten für große Datenmengen zu schaffen. Kein Big Data ohne Fachkräfte Für den erfolgreichen Einsatz von Big-Data-Analysen sind nicht nur geeignete Technologien erforderlich, sondern auch kompetentes Fachpersonal. Big Data Analytics lässt sich nur mithilfe hoch qualifizierter Spezialisten umsetzen, die den Umgang mit Tools und Technologien beherrschen und zugleich in der Lage sind, Fachbereichsanforderungen zu verstehen und IT-seitig umzusetzen. ­ mwandlung in konkreten betrieblichen Wert. Im U Jahr 2003 hat Capital One den branchenweit ersten CDO ernannt. Seitdem erscheint die CDO-Position allmählich auf Führungskräftelisten, vor allem in großen öffent­lichen Institutionen, die mit Daten überflutet werden. Laut Gartner ist der CDO weltweit bei 2 Prozent der Unternehmen etabliert, in großen Betrieben sind es 6 Prozent, 2017 sollen es – so die Prognose – 20 Prozent sein. In Europa ist der CDO noch relativ unbekannt. Ob es wirklich notwendig ist, einen CDO zu etablieren, ist umstritten, zumal dessen Rolle nicht genau umrissen ist. Dringend benötigt werden indes Big-Data-Experten, die faktisch mit den Daten arbeiten. Diese ­IT-Experten müssen andere Fähigkeiten besitzen als die Fachkräfte für konventionelle IT-Systeme. Neben den technischen Voraussetzungen müssen diese Spezialisten den Umgang mit statistischen und stochastischen Methoden sowie analytischen Modellen beherrschen und über ein fundiertes Branchen-Know-how verfügen. Die Experton Group fordert deshalb neue Berufs­ bilder wie den Data Scientist und den Data Artist. Der Data Scientist ist der Datenexperte, der die Analyseverfahren festlegt und die Daten analysiert. Er benötigt eine Querschnittsausbildung mit Kenntnissen in Mathematik und Stochastik, Grundlagen der Programmierung, SQL und Datenbanken, Informationstechnik und Netzwerken. Die Aufbereitung und Visualisierung übernimmt dann ergänzend der Data Artist. Dessen Ausbildung umfasst Grafikdesign, Psychologie, ein wenig ­Mathematik, IT und Kommunikation. Diese Jobs bilden sozusagen den Kern des Big-Data-Personals. Zu dieser Kerngruppe gesellen sich noch weitere neue Berufe, alle zusammen zeigt die Tabelle (auf der nächsten Seite). In den USA wurde vor einiger Zeit begonnen, auf C-Level-Ebene den Chief Data Officer (CDO) ein­zuführen. Dessen Schwerpunkt liegt bei der ­Ver­waltung der Daten als Aktivposten und bei der 6 Big-Data-Berufsbilder Tätigkeit Inhalt Erforderliches Know-how Data Scientist Legt fest, welche Analyseformen sich am besten eignen und welche Rohdaten benötigt werden, und wertet diese aus Mathematik, Stochastik, Programmierung, SQL und Datenbanken, Informationstechnik und Netz­ werke Data Artist Verständliche Präsentation der Auswertungen in Form von Diagrammen und Grafiken Grafikdesign, Psychologie, Mathematik, IT und Kommunikation Data Architect Erstellt Datenmodelle und legt fest, wann welche Analyse-Tools Verwendung finden Datenbanken, Datenanalyse, BI Dateningenieur Betreut die Hardware und ­Software, insbesondere die ­Analysesysteme und die Netzkomponenten Hardware, Softwarekenntnisse, Programmierung Information Broker Beschafft Informationen und stellt sie zur Verfügung, z.B. indem er Kundendaten oder Inhouse-­ Datenbestände unterschiedlicher Quellen bereitstellt Datenbanken, Kommunikation, Psychologie Wer Big-Data-Spezialisten ausbildet Bis dato können Unternehmen allerdings kaum auf diese personellen Ressourcen zurückgreifen. „Data Scientist und Data Artist sind Berufsbilder, die im Rahmen einer zwei- bis dreijährigen Berufsausbildung vermittelbar sind, aber aufgrund ihres Querschnittscharakters heute noch nicht existieren“, sagt Holm Landrock, Senior Advisor der Experton Group. In der Tat gibt es nur wenige Unternehmen und ­Organisationen, die sich für Ansätze einer Aus­ bildung von Data Scientists und Data Artists ­enga­gieren – von einer fundierten Ausbildung kann keine Rede sein. IT-Unternehmen wie SAS, EMC oder Oracle bieten zumindest Schulungen und Fortbildungen in dieser Richtung an. Auch die Fraunhofer-Gesellschaft ist mit einem Trainings­ angebot Data Scientist aktiv. Doch diese Schnellkurse sind nur ein Tropfen auf den heißen Stein. Die Experton Group empfiehlt deshalb der ICT-Branche, gemeinsam mit Bildungseinrichtungen – etwa den Berufsakademien, Fachschulen, den Branchenverbänden und auch den IHKs – schnellstmöglich neue Berufsbilder zu schaffen. ­Solche Ausbildungen von Mitarbeitern für die Rolle der Data Scientists und weiterer neuer Berufsbilder sind keine Samariter-Projekte, sondern ein guter Grundstein für künftige Big-Data-Projekte und sich daraus ergebende nachhaltige Geschäftserfolge. 7 Welche Big-Data-Lösungen gibt es? Eine Standardlösung gibt es nicht, doch haben sich in den vergangenen Jahren Verarbeitungstechniken herauskristallisiert, die heute und die nächsten Jahre als Basis für Big-Data-Analysen dienen. Der Königsweg, die Datenmassen in den Griff zu bekommen, ist das uralte Prinzip „Teile und herrsche“. Rechenaufgaben werden dazu in viele kleine Teilaufgaben zerlegt und auf mehrere Server ­verteilt. Als De-facto-Standard beim verteilten Rechnen hat sich der von Google entwickelte ­MapReduce-Algorithmus durchgesetzt. Eine ­typische MapReduce-Anwendung berechnet ­dabei einige Terabyte an Daten auf Tausenden von Maschinen. Praktisch realisiert wird MapReduce mit der Softwarebibliothek Apache Hadoop. Mit der Aufteilung der Daten in kleinere Portionen und deren paralleler Bearbeitung auf Standardrechnern hat sich Hadoop als aktueller Branchenstandard für Big-Data-Umgebungen durchgesetzt. Mit Hadoop konnte beispielsweise der chinesische Mobilfunk-Provider China Mobile das Nutzungsverhalten und die Abwanderungswahrscheinlichkeit ­aller seiner Kunden analysieren. Die zuvor eingesetzte „scale up“-Lösung ermöglichte es dem Unternehmen, die Daten von nur etwa zehn Prozent der Kunden auszuwerten. Nun konnten alle Kundendaten berücksichtigt werden, sodass gezielte Marketingmaßnahmen die Abwanderungen reduzierten. About two-thirds of respondents are extremely/very likely to consider using or to continue to use in-memory databases. (5) Extremely likely (4) Very likely (3) Somewhat likely (2) Not very likely (1) Not at all likely Not familiar with this type of solution In-memory databases (e.g., SAP HANA, Oracle Exadata) Log file analysis software NoSQL databases Columnar databases Hadoop/MapReduce 28 38 15 9 3 6 20 32 26 10 3 20 31 26 9 7 17 15 28 25 28 26 12 12 4 6 9 6 11 15 Quelle: How ­Organisations are ­approaching Big Data, IDG, September 2013 How likely are you to consider using or to continue to use each of the following big data solutions? Base: 155 qualified respondents who have implemented or have plans to implement big data projects (figures in per cent) In-Memory erlaubt Echtzeitanalysen Ein Hadoop-Cluster löst allerdings nicht alle BigData-Aufgaben. Liegen die Daten auf der Festplatte, kannibalisieren langsame Datenbankzugriffe das, was beim Parallelisieren gewonnen wurde. Für die beschleunigte Verarbeitung extrem großer Datenmengen haben sich deshalb In-Memory-­ Datenbanken etabliert. Diese Datenbanken speichern die Daten direkt im Arbeitsspeicher (RAM) und rufen sie von dort ab. Das macht sie etwa um den Faktor 1.000 schneller als mit herkömmlicher Plattentechnologie. Um das Performance-Maximum herauszuholen, ­laden In-Memory-Datenbanken deshalb möglichst das gesamte Datenvolumen – zusammen mit den Datenbankanwendungen – in den Hauptspeicher, der dann entsprechend groß dimensioniert sein muss. Damit lässt sich die Analyse von Geschäfts8 daten nahezu in Echtzeit ausführen und nimmt nicht Tage oder Wochen in Anspruch. sen dabei auf gute und sehr gute Erfahrungen. (Quelle: T-Systems New Study*) Mit dem inzwischen recht populären HANA (High Performance Analytic Appliance) bietet SAP beispielsweise eine eigene, auf In-Memory-Technik ­basierende Datenbanktechnologie, die Mitte 2010 von ihren geistigen Vätern Hasso Plattner und ­SAP-Technik-Chef Vishal Sikka als Hochleistungsplattform für die analytische Bearbeitung großer Datenmengen entwickelt wurde. Auch der Datenbankspezialist Oracle bietet mit Exadata inzwischen ein auf In-Memory-Technologie basierendes Datenbanksystem an. Die Mehrheit der deutschen Unternehmen betrachtet In-Memory-Verfahren allerdings zunächst als ­Ergänzungsbaustein für zeitkritische Analysen. Immerhin bereits knapp 20 Prozent der Unternehmen sehen in ihnen aber eine wichtige Antwort auf die Herausforderungen durch Big Data. Sie erwarten, dass In-Memory-Systeme zentraler Bestandteil von Datenanalyseumgebungen werden. In-Memory-Datenbanken sind inzwischen kein ­Nischenthema mehr. Laut einer von TNS-Infratest im Auftrag von T-Systems durchgeführten Studie haben 43 Prozent der deutschen Unter­ nehmen ­In-Memory-Technologien zur Datenauswertung b ­ ereits im Einsatz oder planen dies für die nahe ­Zukunft. 90 Prozent der Nutzer verwei- Für unstrukturierte Daten gibt es darüber hinaus Techniken wie NoSQL-Datenbanken. Dabei ist NoSQL der Sammelbegriff für „nicht-relationale“ Datenbanksysteme und zugleich der Name einer Bewegung weg von den relationalen Datenbanken hin zu neuen beziehungsweise vergessenen Datenbankmodellen. NoSQL Datenbanksysteme können unstrukturierte Daten wie Texte, Audiodateien, ­Videos und Bildmaterial effizient speichern und ­verarbeiten. Overall, respondents believe that in-memory databases best address big data’s challenges, but there are significant differences by region. Respondents in EMEA are significantly more likely to favor in-memory databases (60%), compared to only 22% in the US and 14% in Brazil. In-memory databases (e.g., SAP, HANA, Oracle Exadata) 30 NoSQL databases 19 Log file analysis software Columnar databases Hadoop/MapReduce Not sure Quelle: How ­Organisations are ­approaching Big Data, IDG, September 2013 15 12 11 14 Which of the following solutions do you believe would best address the challenges associated with big data? Base: 147 qualified respondents who are familiar with two or more big data solutions shown in Q.3 (figures in per cent) Make or Buy? Eine letzte Herausforderung auf dem Weg zum ­Big-Data-Erfolg stellt die aktuelle Marktlage für Big-Data-Lösungen dar. Mehrere Dienstleister ­bieten Softwarewerkzeuge auf Hadoop-Basis. Dazu gehören Cloudera, Hortonworks, Datameer und HStreaming und auch große Namen wie IBM, Intel und EMC. Doch die Anbieter stoßen alle an dieselbe Grenze: Keiner besitzt standardisierte Industrielösungen, die sich schnell an die Kundenbedürfnisse anpassen lassen. Oft müssen diese Systeme erst in gemeinsamen Kundenprojekten fachlich entwickelt werden. 9 Für Unternehmen, die die Technologie anwenden möchten, ist dies eine klassische „Make or Buy“Entscheidung. Wenn Analysen nur einmalig erfolgen beziehungsweise große Schwankungen im ­Datenvolumen oder in der Analysenachfrage be­ stehen, dann lohnt es sich eher, auf Cloud-basierte Infrastrukturen zurückzugreifen, als in eine eigene Hardware zu investieren. Der in Deutschland größte Hadoop-Cluster befindet sich derzeit im Münchner Rechenzentrum von T-Systems. Unternehmen bekommen hier Big Data oder Analytics-as-a-Service – zugeschnitten auf den jeweiligen Zeitpunkt und Bedarf. Big-Data-Lösungen werden dabei zum Erfolgsfaktor, doch sie erfordern auch eine gezielte Transformation etwa in Richtung Cloud, um die benötigten Big-Data-Technologien nahtlos in die bestehende Infrastruktur integrieren zu können. Unternehmen müssen zudem die Bereitschaft aufbringen, am Ball zu bleiben und neue Entwicklungen zu integrieren. Ein einziges Datenreservoir, das die Big-Data-Herausforderungen zentral und unkompliziert löst, wird es auch in Zukunft nicht geben. Nach Ansicht von Experton-Group-Analyst Andreas Zilch werden immer nur Teillösungen möglich sein: „Es wird nicht ’die’ Big-Data-Superlösung geben.“ Mittel- bis langfristig sollten Unternehmen aber das Datenmanagement selbst betreiben, da andernfalls ein Großteil der wertvollen Informationen verloren geht. Nur bei kontinuierlicher Arbeit mit den Daten, dem Testen von Hypothesen und der Beobachtung von Veränderungen kann das ganze Potenzial von Big Data ausgeschöpft werden. Erwartet werden in nächster Zeit massiv-parallele Systeme, die durch paralleles Data Crunching noch umfangreichere Daten in noch kürzerer Zeit analysieren können, als dies mit den jetzigen Methoden möglich ist. Fazit Um in hart umkämpften Märkten bei immer kürzer werdenden Produktionszyklen bestehen oder gar wachsen zu können, müssen sich Unternehmen Marktanteile und Absatzerfolge sichern. Dabei unterscheidet der richtige Einsatz von IT Gewinner von Verlierern. Nur wer nah an seinem Kunden ist, dessen Bedarf exakt kennt, Business und IT eng verzahnt und entsprechend ausrichtet, kann sich langfristig im Wettbewerb behaupten. Dabei müssen Unternehmen heute mitunter in der Lage sein, schnell gut vorbereitete Entscheidungen zu treffen und proaktiv zu handeln. So stehen sie heute vor der Herausforderung, ein extrem wachsendes ­Datenvolumen aus zunehmend unterschiedlichen Datenquellen in immer kürzeren Zeitabständen verarbeiten zu müssen. Diese Daten müssen anschließend analysiert werden, um die unternehmerische Entscheidungsfindung mit besseren Zahlen, Daten und Fakten zu untermauern. *Quellen: – Artegic „Marketing in the Digital Age“, 2013 – Experton „Die Entwicklung von Big Data im Jahr 2012“ (Experton Big Data) – Gartner „Big Data Opportunities, New Answers and New Questions“, April 2013 (Gartner Big Data) – Gartner PI „Gartner Reveals Top Predictions for IT-Organizations and Users for 2012 and Beyond“ (Gartner PI) – IDC „Storage in Deutschland 2013“ (IDC Storage) – McKinsey: „Big data: The next frontier for innovation, ­competition, and productivity“ (McKinsey Big Data) – OMIKRON „Datenqualität wird zur Herausforderungen von Big-Data-Strategien“ (Omikron Data Quality) – SAS Study „Most firms say business analytics boosts ­decision-making process“ (SAS Decision Making) – T-Systems-Studie „Quo vadis Big Data“ (T-Systems Big Data) – T-Systems-PI „Neue Studie: Big Data im Fokus der ICT-Entscheider“ (T-Systems New Study) ©IDG Business Media GmbH, Germany 1/2014 10 Case Study HAMBURGER HAFEN WIE KANN BIG DATA EINEM HAFENBETREIBER HELFEN, BESSERE ENTSCHEIDUNGEN ZU TREFFEN? Am Hamburger Hafen bewegen sich täglich bis zu 40.000 mit Containern beladene Lastkraftwagen. Auf dem Gelände interagieren tausende Mitarbeiter von Speditionen, Transporteuren, Parkflächen- und Terminal-Betreibern sowie der Hamburger Hafenbehörde (Hamburg Port Authority, kurz: HPA). Sie alle treffen ohne Unterlass Entscheidungen zum Beispiel über Ankunft- und Verladezeiten oder die Nutzung von Routen und Zwischenstationen, Lagerplätzen, Parkplätzen und Leercontainern. Je besser sich die Akteure dabei abstimmen, desto schneller lassen sich Güter aller Art verschiffen oder wieder auf die Straße bringen. Um dies zu ermöglichen, ist es Aufgabe der Hafenbehörde, die richtigen Informationen den richtigen Beteiligten zur richtigen Zeit zur Verfügung zu stellen. Doch bislang waren die einzelnen Dienstleister lediglich hinsichtlich ihrer eigenen Informationsbedürfnisse optimiert: Durch diese Informationsinseln aufgrund proprietärer Systeme, inhomogener Datenstrukturen und fehlender Schnittstellen gab es am Ende kein übergreifendes Lagebild der Verkehrs- und Infrastruktursituation, das zur Entscheidungsfindung hätte dienen können. Dies und die Menge an Daten und Informationen, die nicht ohne Big Data zur Analyse herangezogen werden konnte, führten in der Folge zu vielen und langen Stehzeiten der Fahrzeuge oder auch zu Leerfahrten über das Hafengelände. De facto waren nur 30 % der Zeit, die Fahrzeuge im Hafen verbringen, effektive Fahrzeit. Auch das Kontakthalten zwischen den Akteuren war aufgrund von Medienbrüchen in der Kommunikation schwierig. So führte zum Beispiel die Nutzung von CB-Funk bei der Auftragsübermittlung an den Fahrer häufig zu Fehlern – etwa bei der Durchgabe von komplexen Auftragsnummern. Bis 2025 erwartet der Hamburger Hafen eine Verdoppelung seines Containerumschlags gegenüber heute. Eine Erweiterung des Hafengeländes ist dabei ausgeschlossen: Der Hamburger Hafen nimmt 10 Prozent des Stadtgebietes ein und kann räumlich nicht wachsen. Umso wichtiger ist es, die bestehende Fläche optimal auszunutzen und den Umschlag besser zu takten. Um diesen zukunftsentscheidenden Anforderungen gerecht zu werden, entwickelte die HPA „Smart Port Logistics“. Die Lösung bindet alle an der Hafenlogistikkette Beteiligten ein und optimiert so den Prozess entlang des Containertransportprozesses. Smart Port Logistics integriert zum einen die Telematiksysteme diverser Fahrzeug- und Trailer-Hersteller und deren Schnittstellen via TelematicOne, was auch über eine Nachrüstlösung (Bring Your Own Device, BYOD) möglich ist. Zum anderen nutzt die Logistiklösung das sogenannte Geofencing für die Kommunikation und für Location Based Services. Erfassung und Verarbeitung der enormen Datenmengen, die dabei entstehen, erfolgen über SAP HANA aus einer Private Cloud. TelematicOne und SAP HANA bilden die Grundlage der verschiedenen Anwendungen (Services), die in einem Servicemarktplatz für den Hamburger Hafen bereitgestellt werden. Die Mitarbeiter des Straßenund Wegemanagements, Disponenten der Speditionen sowie Parkplatzanbieter können damit leicht auf das auf allen Daten basierende, übergreifende Lagebild zugreifen und mittels fundierter Entscheidungen etwa über Routen- und Stellflächennutzung oder An- und Abfahrtzeiten ihre Fahrer gezielt steuern – auch zum Vorteil ihrer Kunden. Dabei erfolgt der Abruf von Informationen dediziert und rollenspezifisch – Datenschutz und Vertraulichkeit sind somit sichergestellt. Rollen heute Lkws auf das Hafengelände, erhalten die Fahrer Aufträge und Ziel von der Speditionszentrale direkt auf ihr Smart Device übermittelt. Das System errechnet außerdem aus Verknüpfungen von Verkehrsfluss und Containertransportkette die geschätzte Ankunftszeit am Terminal (ETA) und zeigt diese ebenso an wie ortsrelevante Infos auf Basis von Geofencing, zum Beispiel wichtige Zufahrtstraßen oder bestimmte Hafenzonen. Pro Tour können Spediteure so fünf bis zehn Minuten Zeit sparen und somit eine Fuhre pro Tag mehr schaffen. Bei 40.000 Lkws pro Tag würden 300.000 Minuten eingespart. 11