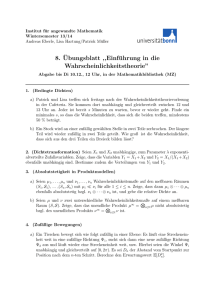

Poisson-Punkt Prozesse

Werbung

Poisson-Punkt Prozesse

Markus Kakac

Wintersemester 2013/14

1

Inhaltsverzeichnis

1 Wiederholung und wichtige Begriffe

2

2 Der Poisson’sche Punktprozess

2.1 Definition und Konstruktion . . . . . . . . . . . . . . . . . . . . . . . . .

2.2 Eigenschaften und weitere Charakterisierungen des PPP . . . . . . . . .

5

5

9

3 Die Poisson-Dirichlet Verteilung

3.1 Der China-Restaurant Prozess . . . . . . . . . . . . . . . . . . . . . . . .

13

15

4 Anwendung in der Finanz- und Versicherungsmathematik

16

5 Simulation im R2

23

1

1

Wiederholung und wichtige Begriffe

Im Folgenden wird häufig der Begriff des polnischen Raumes verwendet und daher wollen

wir zuerst wiederholen was es bedeutet, dass ein topologischer Raum (vollständig) metrisierbar, separabel, lokalkompakt, oder polnisch ist. Dazu sei im Folgenden (E, τ ) ein

topologischer Raum.

Definition 1.1 (E, τ ) heißt metrisierbar, wenn es eine Metrik d gibt, sodass die Topologie τ durch die offenen Kugeln Bε = {y ∈ E : d(x, y) < ε} erzeugt wird. In weiterer

Folge heißt der Raum (E, τ ) vollständig metrisierbar, wenn die Metrik, die τ erzeugt,

vollständig ist.

Definition 1.2 Ist (E, τ ) metrisierbar, so heißt er separabel, wenn es eine abzählbare

Dichte Teilmenge von E gibt.

Definition 1.3 Der topologische Raum (E, τ ) wird polnischer Raum genannt, wenn

er vollständig metrisierbar und separabel ist.

Man erkennt hier schnell, dass polnische Räume in ihrer Größe eingeschränkt sind

Definition 1.4 Eine Menge A ⊆ E heißt relativ kompakt, falls ihr Abschluss A kompakt ist.

Man beachte, dass in der letzten Definition nicht davon ausgegangen werden muss, dass

die Menge A selbst schon kompakt sein muss.

Definition 1.5 Der topologische Raum (E, τ ) heißt lokalkompakt, wenn es für jeden

Punkt x ∈ E eine offene Umgebung Uε (x) gibt, deren Abschluss kompakt ist.

In der folgenden Arbeit wird (E, τ ), oder kurz einfach E, immer ein lokalkompakter

polnischer Raum sein. Zum besseren Verständnis kann man sich vorstellen, dass E = Rd

oder E = Zd .

Definition 1.6 Es sei E ein lokalkompakter polnischer Raum mit Borel’scher σ-Algebra

B(E). Dann wird

Bb (E) = {B ∈ B(E) : B ist relativ kompakt}

als das System der beschränkten Borel’schen Mengen bezeichnet.

Da es sich bei den Poisson’schen Punktprozessen vor allem um Wahrscheinlichkeitsprozesse handelt, wollen wir ein paar Begriffe aus der Maßtheorie wiederholen. Dazu sei im

Folgenden (E, A) ein Messraum und µ ein σ-endliches Maß darauf.

Definition 1.7 µ heißt Borel-Maß wenn es für jeden Punkt x ∈ E eine offene Menge

gibt deren Maß endlich ist. Also:

∀x ∈ E ∃U 3 x mit µ(U ) < ∞

Aufgrund der Eigenschaft von Borel-Maßen, spricht man in der Regel auch von lokal

endlichen Maßen.

2

Definition 1.8 µ heißt von innen regulär, wenn für jedes A aus A gilt:

µ(A) = sup{µ(K) : K ⊂ A ist kompakt}

Definition 1.9 µ heißt Radon-Maß, wenn es ein von innen reguläres Borel-Maß ist.

Bei uns bezeichne M (E) im Folgenden den Raum der Radon-Maße auf E und M =

σ(1A : A ∈ Bb (E)) die kleinste σ-Algebra, bezüglich der alle Abbildungen

1A : µ 7→ µ(A),

A ∈ Bb (E)

messbar sind.

Wir werden zufällige Maße definieren, und damit fast sicher wohldefinierte Operationen

wieder zufällige Maße ergeben, müssen wir unseren Raum M (E) vergrößern. Dazu sei

M̃ (E) der Raum aller Maße auf E und M̃ die zugehörige σ-Algebra. Da E ein polnischer

und damit separabler ist, können wir eine abzählbare, dichte Menge F ⊆ E wählen, in

der es für jedes x ∈ F eine kompakte Umgebung Kx gibt und erhalten somit schnell:

\

M (E) =

{µ ∈ M̃ (E) : µ(Kx ) < ∞}

x∈F

Daher können wir sehen, dass M (E) ∈ M̃ (E) und somit M die Spur-σ-Algebra von M̃

auf M (E) ist.

Wir kommen nun zu dem etwas komplizierten Begriff des zufälligen Maßes.

Definition 1.10 Ein zufälliges Maß auf dem Raum E ist eine Zufallsvariable X mit

folgenden Eigenschaften:

X : (Ω, A, P) → (M̃ (E), M̃)

P[X ∈ M (E)] = 1

Ein zufälliges Maß bildet also aus einem Wahrscheinlichkeitsraum in den Raum aller

Maße ab, mit der Eigenschaft, dass es sich fast sicher um ein Radon-Maß handelt. Erst

wenn man nun dieses zufällige Maß auf eine Borel-Menge anwendet, erhält man eine

Zufallsvariable, so wie man sie spätestens aus Vorlesungen wie Maß- und Wahrscheinlichkeitstheorie seit dem dritten Semester des Mathematikstudiums kennt. In diesem Sinne

kann man ein zufälliges Maß auch in folgender Weise betrachten:

X : Ω × B(E) → E

In diesem Fall bezeichnet X(ω, ·) für alle ω ein Maß auf B(E). Andererseits ist X(·, A)

für alle Mengen A ∈ B(E) eine Zufallsvariable, oder im Fall von E = R eine Zufallszahl.

Ein wichtiger Begriff im Zusammenhang mit zufälligen Maßen ist der des Intensitätsmaßes.

Da der Begriff Maß im Vorhinein nicht klar ist, wollen wir den Umstand, dass es sich bei

der folgenden Definition des Intensitätsmaßes tatsächlich um ein Maß handelt, als Satz

festhalten.

3

Satz 1.1 Es sei X ein zufälliges Maß. Die Mengenfunktion:

B(E) → [0, ∞]

E[X] :

A

7→ E[X(A)]

wird als Intenstiätsmaß von X bezeichnet und es handelt sich in der Tat um ein Maß.

Beweis:

Aufgrund der Linearitätseigenschaft des Erwartungswerts für Zufallsvariablen ist es klar,

dass E[X] endlich additiv ist. Wir wollen nun zeigen, dass die Mengenfunktion auch stetig

von unten ist und damit auch σ-additiv, was die spezielle Eigenschaft eines Maßes ist.

Dazu wählen wir:

A, A1 , A2 , . . . ∈ B(E) mit An ↑ A

Wir betrachten die Zufallsvariablen Yn := X(An ) und Y := X(A). Klarerweise gilt in

diesem Fall: Yn ↑ Y . Mithilfe des Satzes über die monotone Konvergenz folgt:

lim E[Yn ] = E[Y ] und daher

n→∞

lim E[X](An ) = E[X](A)

n→∞

Dies gibt uns die Stetigkeit von unten und damit die σ-Additivität.

Wir wollen noch ganz allgemein die Definition der Laplace-Transformierten sowie der

charakteristischen Funktion eines zufälligen Maßes angeben. Dabei ist zu beachten, dass

es sich bei einem zufälligen Maß nicht um eine Zufallsvariable im eigentlichen Sinne

handelt, sondern wie der Name schon sagt um ein Maß. Daher ist es naheliegend, dass

wir für die Definition integrierbare Funktionen brauchen.

Definition 1.11 Sei X ein zufälliges Maß auf E. Die Laplace-Transformierte von

X ist definiert durch:

Z

LX (f ) = E exp − f dX

, f ∈ B + (E)

Die charakteristische Funktion von X ist definiert durch:

Z

φX (f ) = E exp i f dX

, f ∈ BbR (E)

Hierbei sei noch angemerkt, dass B + (E) für die Menge der messbaren Abbildungen E →

[0, ∞] und BbR für die Menge der beschränkten, messbaren Abbildungen E → R mit

kompaktem Träger steht.

Bemerkung 1.1 Die Verteilung eines zufälligen Maßes ist sowohl durch die Verteilungen

von

((1A1 , . . . , 1An ) : n ∈ N; A1 , . . . , An ∈ Bb (E) paarweise disjunkt)

als auch durch seine Laplace-Transformierte eindeutig bestimmt.

4

Als letzten Teil in diesem Abschnitt möchte ich den Begriff der unabhängigen Zuwächse

eines zufälligen Maßes einführen. Obgleich er sehr einfach und leicht verständlich ist,

spielt er dennoch eine sehr wichtige Rolle in der weiteren Theorie der Poisson’schen

Punktprozesse, nicht zuletzt aus dem Grund, weil man mit unabhängigen Zufallsvariablen

in jeder Situation besser rechnen kann und die meisten Theorien auf dem Begriff der

Unabhängigkeit aufbauen.

Definition 1.12 Ein zufälliges Maß X besitzt unabhängige Zuwächse auf E wenn für

jeweils endliche und paarweise disjunkte Mengen A1 , . . . , An gilt, dass die Zufallsvariablen

X(A1 ), . . . , X(An ) unabhängig sind.

Man beachte, dass in der letzten Definition wieder von Zufallsvariablen im einfachen

Sinne des dritten Semesters die Rede ist.

2

Der Poisson’sche Punktprozess

2.1

Definition und Konstruktion

Definition 2.1 Sei µ ein Radon-Maß. Ein zufälliges Maß X heißt Poisson’scher Punktprozess mit Intensitätsmaß µ, falls es folgende zwei Bedingungen erfüllt:

1. X hat unabhängige Zuwächse

2. Für alle A ∈ Bb (E) gilt X(A) ∼ P oiµ(A)

Wir schreiben im Folgenden X ∼ P P Pµ .

Vorerst steht noch nicht einmal fest ob es solche Prozesse überhaupt geben kann. Bevor wir dies jedoch beweisen werden, will ich noch ein kurzes Resultat bringen, das

hauptsächlich Anwendung in der Risiko und Ruintheorie findet. Konkret geht es um

die Berechnung der Momenterzeugenden Funktion (MEF) einer Zufallssumme. Dazu definieren wir zuerst den Begriff der Zufallssumme.

Definition 2.2 Es seien (Xk )k≥0 iid Zufallsvariablen und dazu unabhängig N eine weitere (ganzzahlige) Zufallsvariable. Die Zufallsvariable

S :=

N

X

Xk

k=0

wird als Zufallssumme bezeichnet.

Lemma 2.1 Hat N die Zähldichte (pn )n≥0 und Xi ∼ FX iid und ist t ∈ C so, dass

MX (Re(t)) und MN (lnMX (Re(t))) existieren, so existiert auch die MEF von S und es

gilt:

MS (t) = MN (lnMX (t))

5

(1)

Beweis:

Wir wollen das Lemma mittels Ereignispartition für Erwartungswerte beweisen:

MS (t) =E[etS ]

X

[Ereignispartiton für EW] =

E[et(X1 +...+Xn ) 1{N =n} ]

n≥0

[(Xk )k≥0 und N unabhängig]

=

X

=

X

=

X

E[et(X1 +...+Xn ) ]E[1{N =n} ]

n≥0

[Xk iid]

MX (t)n P[N = n]

n≥0

en·lnMX (t) P[N = n]

n≥0

[Def der MEF einer diskreten ZV]

=MN (lnMX (t))

Bemerkung 2.1 Sind Xk ≥ 0 fast sicher, dann existiert MS (t) zumindest für Re(t) ≤ 0

Bemerkung 2.2 Mit der hier und im Folgenden verwendeten Konvention lnMX (t) =

−∞ wenn MX (t) = 0 und MN (−∞) = p0 , gilt Lemma 2.1 auch für MX (t) = 0

Bevor wir die Konstruktion und Existenz von Poisson’schen Punktprozessen beweisen

werden, wollen wir uns noch die Berechnung der MEF von Poisson- und Bernoulli verteilten Zufallsvariablen ansehen.

Lemma 2.2 Es sei N ∼ P oiµ und X ∼ Berν . Dann gilt:

1. MN (t) = exp(µ(et − 1))

2. MX (t) = 1 + ν(et − 1)

Beweis:

Wir verwenden die naive Berechnung der MEF mithilfe der Formel MX (t) = E[etX ], die

für alle beliebigen Zufallsvariablen gilt und nützen die Eigenschaft aus, dass eine Poissonverteilte Zufallsvariable nur auf den nicht-negativen ganzen Zahlen und eine Bernoulli

Zufallsvariable nur auf der Menge {0, 1} definiert ist.

ad 1:

∞

∞

∞

∞

k

X

X

X

X

µk ekt

(µet )k

−µ

−µ

tN

kt

kt µ −µ

e =e

=e

=

E[e ] =

e P[N = k] =

e

k!

k!

k!

k=0

k=0

k=0

k=0

t

= e−µ eµe = exp(µ(et − 1))

ad 2

E[etX ] = νet·1 + (1 − ν)et·0 = νet + (1 − ν) = 1 + ν(et − 1)

Nun sei der Vorbereitung genüge getan und wir wollen endlich zur Konstruktion von

Poisson’schen Punktprozessen schreiten.

6

Satz 2.1 Zu jedem µ ∈ M (E) existiert ein Poisson’scher Punktprozess X mit Intensitätsmaß µ.

Beweis:

Da wir wissen, dass µ ein Radon-Maß ist, ist es sicher σ-endlich. Wir wählen uns nun

eine wachsende Folge von Mengen, die unseren Grundraum E als Grenzwert hat. Also:

En ↑ E

Für jede dieser Mengen gilt, dass µ(En ) < ∞. Wir wollen nun Maße definieren die genau

den Zwischenraum zwischen En−1 und En messen:

µ1 (·) = µ(E1 ∩ ·) und µn (·) = µ((En \En−1 ) ∩ ·)

Wie man sich durch eine kleine Skizze schnell überzeugen kann, gilt die folgende Formel

für alle A ⊆ E, da die Maße µi auf disjunkten Mengen definiert sind:

µ1 (A) + µ2 (A) + . . . = µ(A)

(2)

Wir wählen uns nun unabhängige Poisson’sche Punktprozesse Xi ∼ P P Pµi . Dass es solche

gibt wird im zweiten Teil des Beweises klar werden, da die Maße µi ∈ (0, ∞). Wir wollen

nun von der Summe dieser Poisson’schen Punktprozesse zeigen, dass es sich wieder um

einen Poisson’schen Punktprozess handelt. Dazu sei:

X=

∞

X

Xn

n=0

Wir wollen nun die drei definierenden Eigenschaften eines Poisson’schen Punktprozesses

nachweisen:

1. unabhängige Zuwächse

2. E[X] = µ

3. PX(A) = P oiµ(A)

Die unabhängigen Zuwächse sind klar, weil die einzelnen Xi laut Voraussetzung P P Pµi

sind und damit unabhängige Zuwächse besitzen und untereinander sind sie auch unabhängig.

Um den zweiten Punkt nachzuweisen, müssen wir nur überprüfen ob E[X(A)] = µ(A)

für alle A ∈ E erfüllt ist:

"∞

#

∞

∞

X

X

X

E[X(A)] = E

Xn (A) =

E[Xn (A)] =

µn (A) = µ(A)

n=1

n=1

n=1

Dabei gilt das erste Gleichheitszeichen wegen der Definition des Prozesses X, das zweite

wegen der Linearität des Erwartungswerts, das dritte aufgrund der Eigenschaft, dass die

Xn als P P Pµn vorausgesetzt sind, und das letzte aufgrund von Formel 2.

Der dritte Punkt der Eigenschaften ist, wie die beiden anderen auch, einfach auf die

Eigenschaften der Xi zurückzuführen. Da die Xi unabhängig sind, ist die Verteilung der

7

Summe einfach mithilfe der Faltung zu bestimmen. Die Verteilung der Xi ist laut Voraussetzung eine Poissonverteilung und seit dem dritten Semester des Mathematikstudiums

weiß man, dass die Faltung von Poissonverteilungen wieder eine Poissonverteilung mit

Parameter der Summe der Einzelparameter ist. Als Gleichungskette:

PX(A) = PX1 (A) ∗ PX2 (A) ∗ . . . = P oiµ1 (A) ∗ P oiµ2 (A) ∗ . . . = P oiµ1 (A)+µ2 (A)+... = P oiµ(A)

Wir wollen nun zeigen, dass es die im ersten Teil des Beweises verwendeten PPP tatsächlich

gibt. Daher betrachten wir im Folgenden, dass µ(E) ∈ (0, ∞). In diesem Fall können wir

uns nun ein neues Maß definieren:

ν(·) =

µ(·)

µ(E)

Durch die Normierung ist mit ν ein Wahrscheinlichkeitsmaß gegeben. Weiters brauchen

wir eine Zufallsvariable N ∼ P oiµ(E) und dazu unabhängig eine Familie von Zufallsvariablen Yi ∼ ν. Damit gilt für alle A ⊆ E, dass 1A (Yi ) ∼ Berν(A) . Wir betrachten nun die

Zufallssumme

X(A) =

N

X

1A (Yn ).

n=1

Wenn wir nun die folgenden zwei Punkte zeigen können, handelt es sich mit X um einen

P P Pµ , was den Beweis vervollständigt.

1. X(A) ∼ P oiµ(A)

2. X(A1 ), . . . , X(An ) sind unabhängig für paarweise disjunkte A1 , . . . , An ∈ B(E)

ad 1:

Mithilfe von Lemma 2.1 und Lemma 2.2 sowie der Definition von ν(·) erhalten wir schnell

folgende Gleichungskette:

MX(A) (t) = exp(µ(E) · (1 + ν(A)(et − 1) − 1))

= exp(µ(E) · (ν(A)(et − 1)))

µ(A) t

(e − 1))

= exp(µ(E) ·

µ(E)

= exp(µ(A) · (et − 1))

Wie man leicht erkennt, ist die Form der MEF von X(A) wie in Lemma 2.2 Punkt 1 und

daher gilt, da die MEF die Verteilung eindeutig charakterisiert, X(A) ∼ P oiµ(A) .

ad 2:

Wir wollen den Umstand der Unabhängigkeit mit einem weiteren Ergebnis aus der Maßund Wahrscheinlichkeitstheorie beweisen. Wir verwenden hierbei die Tatsache, dass sich

bei unabhängigen Zufallsvariablen die gemeinsame MEF durch multiplizieren der einzelnen MEF berechnen lässt. Nach einem Satz aus der Wahrscheinlichkeitstheorie gilt auch

die Umkehrung, die wir im Folgenden benützen. Dazu seien A1 , . . . , An ∈ B(E) paarweise

disjunkt.

8

Wir betrachten zunächst die gemeinsame MEF der Zufallsvariablen 1A1 (Yi ), . . . , 1An (Yi ).

Man beachte dabei, dass Yi eine Zufallszahl ist und daher nur in einer der Mengen An

liegen kann, oder in keiner. Daher ergibt sich die MEF wie folgt:

"

!#

n

X

M1A1 (Yi ),...,1An (Yi ) (t1 , . . . , tn ) = E exp

t` 1A` (Yi )

`=1

= ν(A1 )e + . . . + ν(An )etn + (1 − ν(A1 ) − . . . − ν(An ))

n

X

=1+

ν(A` )(et` − 1)

t1

`=1

Wie man leicht durch nachrechnen und vertauschen der Summationsreihenfolge überprüfen

kann, gilt dieselbe Formel für die gemeinsame MEF von Zufallssummen, (wenn sie bis

zur selben Zufallsvariable aufsummieren) wie für eine einzelne:

MX(A1 ),...,X(An ) (t1 , . . . , tn ) = MN (ln(M1A1 (Yi ),...,1An (Yi ) (t1 , . . . , tn )))

Daher erhalten wir:

"

MX(A1 ),...,X(An ) (t1 , . . . , tn ) = exp µ(E) · 1 +

n

X

#!

ν(A` )(et` − 1) − 1

`=1

= exp µ(E) ·

n

X

`=1

= exp

n

X

!

µ(A` ) t`

(e − 1)

µ(E)

!

µ(A` )(et` − 1)

`=1

=

n

Y

exp(µ(A` )(et` − 1))

`=1

=

n

Y

MX(A` )

`=1

Damit haben wir die Unabhängigkeit bewiesen, und den Beweis vollendet.

2.2

Eigenschaften und weitere Charakterisierungen des PPP

In diesem Abschnitt wollen wir zunächst eine weitere Charakterisierung und einige Eigenschaften des PPP angeben. Jedoch werden wir diese Ergebnisse aufgrund der Aufwendigkeit der Beweise nur vereinzelt beweisen, da sonst der Rahmen dieser Arbeit gesprengt

werden würde. Der interessierte Leser sei an diesen Stellen auf das ausgezeichnete Nachschlagewerk [1] verwiesen.

Zunächst wollen wir die mit Abstand wichtigste Eigenschaft und Charakterisierung angeben:

Satz 2.2 Sei µ ∈ M (E) atomlos, also µ({x}) = 0 ∀x ∈ E. Sei weiters X ein zufälliges

Maß auf E mit der Eigenschaft P[X(A) ∈ N0 ] = 1 ∀A ∈ B(E). Dann sind äquivalent:

9

1. X ∼ P P Pµ

2. X ist fast sicher doppelpunktfrei, also:

P[X({x}) ≥ 2 für ein x ∈ E] = 0

und

P[X(A) = 0] = e−µ(A)

Beweis:

Die Implikation 1 ⇒ 2 ist aufgrund der Eigenschaft der Poissonverteilung klar. Für die

Implikation 2 ⇒ 1 sei der Leser wie am Anfang des Kapitels erwähnt, auf [1] verwiesen. Bemerkung 2.3 Die Notation N0 in Satz 2.2 ist eine Kurzschreibweise für N0 ∪ ∞.

Wir wollen nun die Laplace-Transformierte und die charakteristische Funktion eines

zufälligen Maßes speziell für den Fall des PPP angeben.

Satz 2.3 Sei µ ∈ M (E) und X ∼ P P Pµ . Dann hat X die Laplace-Transformierte

Z

−f (x)

(e

− 1)µ(dx) , f ∈ B + (E)

LX (f ) = exp

und die charakteristische Funktion

Z

if (x)

(e

− 1)µ(dx) ,

φX (f ) = exp

f ∈ BbR (E)

Beweis:

Aufgrund der üblichen Approximationsargumente für Integrale und Funktionen, reicht

es, den Satz für elementare Treppenfunktionen der Art

f=

n

X

α i 1A i

i=1

mit komplexen Zahlen α1 , . . . ,Rαn und paarweise disjunkten Mengen A1 , . . . , An zu zeigen.

So erhalten wir mit If (X) = f dX:

"

!#

" n

#

n

X

Y

E[exp(−If (X))] = E exp −

αi X(Ai )

=E

e−αi X(Ai )

i=1

i=1

Da es sich mit X um einen PPP handelt, sind die Zufallsvariablen X(A1 ), . . . X(An )

unabhängig daher geht die Gleichungskette weiter:

=

n

Y

E e−αi X(Ai )

i=1

10

Da die Zufallsvariablen X(Ai ) ∼ P oiµ (A), können wir Lemma 2.2 anwenden:

!

Z

n

n

Y

X

−α1

−αi

−f (x)

=

exp µ(Ai )(e

− 1) = exp

µ(Ai )(e

− 1) = exp

(e

− 1)µ(dx)

i=1

i=1

Wir wollen nun im Anschluss an die charakteristische Funktion auch noch kurz die beiden

wichtigsten Momente des PPP besprechen. Dabei steht L1 (µ) für die µ-integrierbaren

und L2 (µ) für die µ-quadrat-integrierbaren Funktionen. Dabei ist zu beachten, dass die

Inklusion L2 (µ) ⊂ L1 (µ) nur für endliches µ gilt.

Satz 2.4 Sei µ ∈ M (E) und X ∼ P P Pµ .

Z

Z

E

f dX = f dµ, f ∈ L1 (µ)

Z

Z

V

f dX = f 2 dµ, f ∈ L2 (µ) ∩ L1 (µ)

Beweis:

Wir wollen den Beweis mithilfe der charakteristischen Funktion führen, da für Zufallsmaße

dieselbe Regel wie für normale Zufallsvariablen gilt, nämlich:

d

φ

(t)

d2

2

dt X

und E[X ] = − 2 φX (t)

E[X] =

i

dt

t=0

t=0

Übersetzt in den Fall für zufällige Maße erhalten wir:

d

φ

(tf

)

d2

X

2

dt

und E[If (X) ] = − 2 φX (tf )

E[If (X)] =

i

dt

t=0

t=0

Wir betrachten für den Erwartungswert die Zerlegung der Funktion f in Positiv- und

Negativteil f = f + − f − ∈ L1 (µ). In diesem Fall können wir Integral und Differentiation

für dtd φX (tf + ) vertauschen und erhalten mit naiver Ableitung der Exponentialfunktion

und der Tatsache, dass φX (0) = 1:

Z

d

+

+

+

φX (tf ) = iφX (tf ) f + (x)eitf (x) µ(dx)

dt

Damit erhalten wir:

Z

E[If + (X)] =

f + dµ

Mit dem gleichen Argument wie für f + können wir für f − vorgehen und erhalten durch

aufsummieren die im Satz angegebene Formel für den Erwartungswert.

Wenn f ∈ L2 (µ)∩L1 (µ), so können wir die Produktregel für die Differentiation anwenden

und erhalten für die zweite Ableitung:

"Z

Z

2 #

d2

φX (tf ) = −φX (tf )

f 2 (x)eitf (x) µ(dx) +

f (x)eitf (x) µ(dx)

dt2

11

Daher erhalten wir

2

Z

E[If (X) ] =

Z

2

f dµ +

2

f dµ

Mithilfe der allgemeinen Formel zur Berechnung der Varianz durch den Verschiebungssatz

von Steiner erhalten wir nun die im Satz angegebene Formel zur Berechnung der Varianz:

"Z

Z

#

Z

Z

2

V

f dX = E

2

−E

f dX

f dX

=

f 2 dµ

Die wohl wichtigste Eigenschaft eines PPP ist der Abbildungssatz.

Satz 2.5 Seien:

• E und F lokalkompakte, polnische Räume,

• ψ : E → F eine messbare Abbildung,

• µ ∈ M (E), sodass µ ◦ ψ −1 ∈ M (F ) und

• X ∼ P P Pµ auf E.

Dann ist X ◦ ψ −1 ∼ P P Pµ◦ψ−1 auf F.

Beweis:

Wir werden den Beweis mithilfe der Laplace-Transformierten führen und uns auf die eindeutige Charakterisierung der Verteilung eines zufälligen Maßes durch eben diese berufen

um den Beweis abzuschließen.

Sei dazu f ∈ B + (F ). Dann gilt mithilfe der Substitutionsregel für Integrale mit y = ψ(x):

Z

−f (ψ(x))

LX◦ψ−1 (f ) = LX (f ◦ ψ) = exp

(e

− 1)µ(dx)

Z

−f (y)

−1

= exp

(e

− 1)(µ ◦ ψ )(dy)

Hierbei handelt es sich wieder um die Form der Laplace-Transformierten eines PPP mit

Intensitätsmaß (µ ◦ ψ −1 ), was den Beweis, wie schon im Vorfeld angekündigt, beweist. Am Ende dieses Abschnitts möchte ich noch einen weiteren stochastischen Prozess über

den PPP konstruieren um einerseits zu zeigen, dass der PPP tatsächlich als Grundbaustein für komplexere stochastische Prozesse eine sehr wichtige Rolle in der Theorie der

stochastischen Prozesse spielt. Andererseits brauchen wir den im folgenden eingeführten

Begriff des Subordinators später in der Arbeit noch einmal.

12

Definition 2.3 Sei X ∼ P P Pν⊗λ auf (0, ∞) × [0, ∞). Hier bezeichnet λ das LebesgueMaß. Wir setzen:

Z

Y0 = 0 und Yt :=

xX(d(x, s))

(0,∞)×(0,t]

Der so konstruierte Prozess (Yt )t≥0 heißt Subordinator mit Lévy-Maß ν

Bemerkung 2.4 Wie man leicht einsieht ist X(· × (s, t]) ∼ P P P(t−s)ν . Damit erhält

man schnell dass Y unabhängige Zuwächse hat und aufgrund der Definition rechtsstetige,

monoton wachsende Pfade besitzt.

3

Die Poisson-Dirichlet Verteilung

In diesem Abschnitt möchte ich kurz den Bogen von den Poisson’schen Punktprozessen

hin zu mehr unbekannten Verteilungen, wie der Poisson-Dirichlet Verteilung oder der

GEM-Verteilung schlagen. Im Anschluss wollen wir noch einen weiteren stochastischen

Prozess, den China-Restaurant Prozess betrachten.

Um einen sinnvollen Zugang zu den Begriffen zu bekommen, wollen wir folgendes Problem im Hinterkopf behalten und am Ende des Abschnitts beantworten: Gegeben sei ein

Stock der Länge 1. Dieser wird an einer zufälligen (uniform verteilten) Stelle gebrochen

und das linke Stück der Länge W1 beiseite gelegt. Mit dem rechten Teil des Stockes

macht man weiter und erhält ein weiteres Stück der Länge W2 . Die Frage, die sich uns

nun auftut, ist, welche gemeinsame Verteilung einerseits die zeitlich geordnete Folge der

Längen der Bruchstücke (W1 , W2 , . . .) und andererseits die nach Größe geordnete Folge

der Bruchstücke (W(1) , W(2) , . . .) haben.

Dazu definieren wir zuerst die n-dimensionale Dirichlet-Verteilung:

Definition 3.1 Sei n ∈ {2, 3, . . .} und θ1 , . . . , θn > 0 die Parameter. Die DirichletVerteilung ist die Verteilung die für eine messbare Teilmenge A eines (n-1)-dimensionalem

Simplex

∆n := {(x1 , . . . , xn ) ∈ [0, 1]n : x1 + . . . + xn = 1}

definiert ist durch

Z

Dirθ1 ,...,θn (A) =

1A (x1 , . . . , xn )fθ1 ,...,θn (x1 , . . . , xn )dx1 . . . dxn−1

mit Dichtefunktion

fθ1 ,...,θn (x1 , . . . , xn ) =

Γ(θ1 + . . . + θn ) θ1 −1

x1 · · · xθnn −1

Γ(θ1 ) · · · Γ(θn )

Bemerkung 3.1 Um die Notation einfacher verständlich zu halten schreiben wir Dirθ;n

für Dirθ,...,θ

13

Wie man schnell anhand der Dichtefunktion erkennt, ist die Dirichletverteilung die multivariate Verallgemeinerung der Betaverteilung. Genauer ausführen möchte ich das hier

allerdings nicht, da es zu weit vom eigentlichen Thema wegführen würde.

Vereinfacht kann man sich diese Verteilung folgendermaßen vorstellen: Die Parameter

der multinomiale Verteilung geben zum Beispiel die Wahrscheinlichkeiten an, mit denen

bei einem Würfel die einzelnen Zahlen geworfen werden. Die Dirichletverteilung hingegen

gibt die Wahrscheinlichkeit für das Auftreten einer solchen Verteilung an.

Um den Begriff der Poisson-Dirichlet Verteilung einführen zu können, brauchen wir zuerst

noch einen weiteren stochastischen Prozess:

Definition 3.2 Ein stochastischer Prozess (Mt )t≥0 heißt Moran-Gamma-Subordinator,

falls er

• rechtstetige, monoton wachsende Pfade t 7→ Mt

• unabhängige, stationäre, Γ-verteilte Inkremente: Mt − Ms ∼ Γ1,t−s für t > s ≥ 0

besitzt.

Nun können wir anhand unserer Vorarbeit endlich die Poisson-Dirichlet Verteilung definieren.

Definition 3.3 Sei θ > 0 und (Mt )t∈[0,θ] ein Moran-Gamma Subordinator. Wir bezeichnen die der Größe nach sortierten Sprunghöhen von M mit m1 ≥ m2 ≥ . . . ≥ 0. Wir

betrachten die Verteilung der Zufallsvariablen (m̃1 , m̃2 , . . .) auf der Menge S := {(x1 ≥

x2 ≥ . . . ≥ 0); x1 + x2 + . . . = 1}, wobei

m̃i =

mi

Mθ

Die betrachtete Verteilung heißt Poisson-Dirichlet Verteilung (P Dθ ) mit Parameter θ > 0.

P

An dieser Stelle ist noch zu zeigen, dass ∞

i=1 m̃i = 1, damit die Definition auf dem Raum

S tatsächlich Sinn macht. Dazu sei X ∼ P P Pν⊗λ auf (0, ∞) × (0, θ]. Hier bezeichnet λ

das Lebesgue-Maß und ν das Lévy-Maß der Γ1,1 -Verteilung. Nach Definition 2.3 können

wir den Prozess nun folgendermaßen definieren:

X

Mt :=

x

(x,s):X({x,s})=1

s≤t

Weiters erkennt man leicht, dass sich die sortierten Sprunghöhen auf folgende Art berechnen lassen:

m1 = sup{x ∈ (0, ∞) : X({x} × (0, θ]) = 1}

mn = sup{x < mn−1 : X({x} × (0, θ]) = 1} für n ≥ 2

Also erhalten wir durch Vertauschung der Summationsreihenfolge Mθ =

daher:

∞

∞

X

X

mi

1=

=

m̃i

Mθ

i=1

i=1

14

P∞

i=1

mi , und

Das folgende Ergebnis möchte ich wieder ohne Beweis angeben, weil auch das zu weit vom

eigentlichen Thema abweichen würde. Der interessierte Leser sei wieder auf [1] verwiesen.

Da es sich aber doch um einen interessanten Zusammenhang zwischen der Dirichletverteilung und der Poisson-Dirichlet Verteilung handelt, wird es hier aufgezeigt:

Satz 3.1 Sei (X1 , . . . , Xn ) ∼ Dir θ ;n für n ∈ N. Dann gilt:

n

n→∞

P(X(1) ,X(2) ,...) → P Dθ

Hier bezeichnet (X(1) , X(2) , . . .) wieder die der Größe nach sortierten Zufallsvariablen.

Man kann aber auch die Verteilung der zufällig angeordneten Zufallsvariablen betrachten.

So zeigt sich (ohne Beweis), dass diese Folge gegen eine Zufallsvariable konvergiert die

GEMθ (für Griffiths-Engen-McCloskey) verteilt ist.

Definition 3.4 Sei θ > 0 und seien V1 , V2 , . . . unabhängig und identisch β1,θ -verteilt.

Wir setzten:

!

k−1

Y

Z1 = V1 und Zk =

(1 − Vi ) Vk für k ≥ 2

i=1

Die Verteilung von Z = (Z1 , Z2 , . . .) heißt GEMθ -Verteilung

Damit haben wir unsere am Beginn des Abschnitts gestellte Frage über die Verteilung

der Bruchstücke auch schon beantwortet: Der Vektor (W(1) , W(2) , . . .) ist P D1 -verteilt,

und (W1 , W2 , . . .) ist GEM1 -verteilt.

3.1

Der China-Restaurant Prozess

Bevor wir den China-Restaurant Prozess besprechen, werden wir sowohl die PoissonDirichlet als auch die GEM-Verteilung um jeweils einen Parameter erweitern, um einen

sinnvollen Grenzwertbegriff für den Prozess zu erhalten.

Definition 3.5 Sei α ∈ [0, 1) und θ > −α. Weiters seien V1 , V2 , . . . unabhängig und

identisch β1−α,θ+iα -verteilt. Wir setzen:

!

k−1

Y

Z1 = V1 und Zk =

(1 − Vi ) Vk für k ≥ 2

i=1

Die Verteilung von Z = (Z1 , Z2 , . . .) heißt GEMα;θ -Verteilung. Die Verteilung des nach

der Größe sortierten Vektors Z = (Z(1) , Z(2) , . . .) heißt P Dα;θ -Verteilung.

Bemerkung 3.2 Man beachte, dass sich Definition 3.5 nur in Form des α in der Ausgangsverteilung von den Definitionen 3.3 und 3.4 unterscheidet. Daher ist es leicht einzusehen, dass man aus den zweiparametrigen Verteilungen durch α = 0 die bereits bekannten

einparametrigen Verteilungen zurückgewinnen kann.

15

Wir wollen nun den China-Restaurant Prozess heuristisch herleiten und im Anschluss

noch eine Grenzwertaussage ohne Beweis liefern.

Wie der Name schon vermuten lässt, geht man bei dieser Art von Prozessen von einem China-Restaurant aus. Darin gäbe es abzählbar viele nummerierte Tische, an denen

jeweils beliebig viele Gäste Platz finden können. Nun lassen wir abzählbar viele Gäste

kommen. Der erste Gast setzt sich naturgemäß an den noch freien Tisch mit der Nummer

Eins. Wir nehmen nun an, dass bereits n Gäste an k Tischen Platz genommen haben.

Der (n + 1)-te Gast hat nun zwei Möglichkeiten der Sitzplatzwahl. Wir geben sie mit der

entsprechenden Wahrscheinlichkeit an:

• Er kann sich an den `-ten bereits besetzten Tisch, an dem mittlerweile N`n Personen

sitzen, setzen. Wir nehmen an, dies geschieht mit Wahrscheinlichkeit

N`n − α

n+θ

• Er kann aber auch am ersten freien Tisch Platz nehmen. Dies geschehe mit Wahrscheinlichkeit

θ + kα

n+θ

Hier seien α ∈ [0, 1) und θ > −α frei zu wählende Parameter. Wir nennen (N n )n∈N =

(N1n , N2n , . . .)n∈N den China-Restaurant Prozess mit Parametern α, θ. Dabei bezeichnet N`n die Anzahl der Personen am `-ten Tisch, nachdem n Personen insgesamt gekommen sind.

Mithilfe der Definition 3.5, können wir nun das asymptotische Verhalten

des ChinaN1n N2n

Nn

Restaurant Prozesses betrachten. Dabei sei im folgenden Satz n = ( n , n , . . .).

Satz 3.2 Seien α ∈ [0, 1), θ > −α, und (N n )n∈N der China-Restaurant Prozess mit

Parametern α und θ. Dann gilt:

n→∞

P N n → P Dα;θ

n

4

Anwendung in der Finanz- und Versicherungsmathematik

Anwendung findet der Poisson’sche Punktprozess in der Finanz- und Versicherungsmathematik hauptsächlich in Form des zusammengesetzten Poisson-Prozesses dem ein einfacher

(meist homogener) Poisson-Prozess zu Grunde liegt. Diese Prozesse sind dann Hauptbestandteil des Cramér-Lundberg Modells nach Filip Lundberg und Harald Cramér zur

Modellierung eines Risikoreserveprozesses, oder kurz der freien Reserve.

Wir wollen diesen Abschnitt mit dem einfachen Poisson-Prozess beginnen. Dabei handelt

es sich um einen Zählprozess. Als Anwendung sei die Modellierung der Schadenanzahl

eines Versicherungsportfolios genannt.

Definition 4.1 Ein Zählprozess (Nt )t≥0 ist ein stochastischer Prozess in stetiger Zeit,

der folgende Eigenschaften besitzt:

16

• N0 = 0

• Nt ∈ Z+ fast sicher ∀t ≥ 0

• Ns ≤ Nt fast sicher ∀0 ≤ s ≤ t

Bemerkung 4.1 Ein Zählprozess hat stückweise konstante Trajektorien, wobei die Höhe

der Sprünge 1 ist.

In der folgenden Definition wollen wir die wichtigsten Begriffe im Zusammenhang mit

Zählprozessen kurz aufzählen:

Definition 4.2 Gegeben sei ein einfacher Zählprozess (Nt )t≥0 . Die Zufallsvariablen (Tn )n≥0 ,

definiert durch

T0 = 0

und

Tn := inf{t ∈ R+ : Nt = n}

nennen wir die Ankunftszeiten. Wir definieren die Wartezeiten (od. Zwischenankunftszeiten) durch

Wn := Tn − Tn−1

Die Zufallsvariable

ζ := inf{t ≥ 0 : Nt = +∞}

nennen wir die Explosionszeit. Dabei heißt das Ereignis {ζ < ∞} Explosion.

Bemerkung 4.2 Wie man aufgrund der letzten Definition leicht einsieht, kann man

die Definition auch rückwärts durchführen und aus einer beliebigen Folge R+ -wertiger

Zufallsvariablen (Wartezeiten) (Wn )n≥1 leicht einen Zählprozess generieren, indem man

zuerst die Ankunftszeiten definiert:

T0 = 0

und

Tn :=

n

X

Wi für n ≥ 1

i=1

Mithilfe dieser Ankunftszeiten kann man dann den Zählprozess (Nt )t≥0 definieren durch:

X

N0 = 0 und Nt =

1{Tk ≤t} für t ≥ 0

i≥1

Wir wollen nun vom allgemeinen Zählprozess auf den Poisson-Prozess kommen. Dabei

entsteht die Schwierigkeit der Auswahl der Definition. Verschiedene Quellen verwenden

andere Definitionen und geben die jeweils anderen als Charakterisierung in Form eines

Satzes an. Ich werde mich in diesem Abschnitt jedoch nicht so wie bisher auf [1], sondern

auf meine zweite Quelle, [2] beziehen.

Definition 4.3 Ein wie in Bemerkung 4.2 konstruierter Zählprozess heißt PoissonProzess, wenn die zugrunde liegenden Wartezeiten (Wn )n≥1 unabhängig und identisch

Expλ verteilt sind.

17

Die erste wichtige Erkenntnis über Poisson-Prozesse ist das folgende Lemma, auf das wir

uns an späterer Stelle noch einmal beziehen werden:

Lemma 4.1 Ist (Nt )t≥0 ein Poisson-Prozess, so gilt:

Nt ∼ P oiλt

für alle t ∈ R+

Beweis:

Dazu sei angemerkt, dass die Summe n unabhängiger Expλ -verteilter Zufallsvariablen

Γn;λ -verteilt ist. Daher erhalten wir nach Konstruktion der Ankunftszeiten:

P[Tn ≤ t] = 1 −

n−1

X

e−λt

i=0

(λt)i

k!

Wie man nach Konstruktion des Prozesses schnell einsieht gilt für das Ereignis {Nt = n}:

{Nt = n} = {Tn ≤ t}\{Tn+1 ≤ t}

Daher erhalten wir schnell für die Wahrscheinlichkeit des Eintretens dieses Ereignisses:

P[Nt = n] = P[Tn ≤ t] − P[Tn+1 ≤ t] = e

n

−λt (λt)

n!

was den Beweis vervollständigt, da es sich um die Dichte der P oiλt -Verteilung handelt. Eine weitere interessante und in der Versicherungsmathematik wichtige Tatsache ist der

folgende Satz.

Satz 4.1 Ein Poisson-Prozess hat keine Explosion.

Beweis:

Nach dem Gesetz der großen Zahlen gilt

n

1X

Wi = E[Wi ].

n→∞ n

i=1

lim

Bei der Expλ -Verteilung haben wir E[Wi ] =

zeiten erhalten wir:

1

λ

und mithilfe der Definition der Ankunftsn

1X

1

1

Tn = lim

Wi =

n→∞ n

n→∞ n

λ

i=1

lim

Daher erhalten wir lim Tn = +∞ fast sicher. Das wiederum widerspricht der in Definin→∞

tion 4.2 erwähnten Explosion, was den Beweis vollendet.

Wir wollen nun zwei Eigenschaften der Ankunftszeiten besprechen, um das in der Theorie

sehr wichtige Multinomialkriterium beweisen zu können.

18

Lemma 4.2 Sei (Nt )t≥0 ein Poisson-Prozess mit Intensität λ, (Tn )n≥0 die zugehörigen

Ankunftszeiten und (Wn )n≥1 die entsprechenden Wartezeiten. Dann gilt für die bedingte

Verteilung Tn+1 |T1 , . . . , Tn :

P[Tn+1 > t|T1 , . . . , Tn ] = e−λ(t−Tn ) 1{t>Tn }

Beweis:

Wir werden uns in diesem Beweis auf die in Definition 4.3 angesprochenen unabhängigen

Wartezeiten berufen. Dazu sei

P[Tn+1 > t|T1 , . . . , Tn ] = P[Tn+1 − Tn > t − Tn |T1 , . . . , Tn ]

= P[Wn+1 > t − Tn |T1 , . . . , Tn ]

Nun sind die Wi unabhängig, damit ist aber auch Wn+1 von (T1 , . . . , Tn ) unabhängig und

Tn ist bezüglich der Bedingung messbar. Daher erhalten wir gemeinsam mit Wi ∼ Expλ :

= P[Wn+1 > t − Tn ] = 1 − P[Wn+1 > t − Tn ] = [1 − (1 − e−λ(t−Tn ) )]1{t>Tn }

= e−λ(t−Tn ) 1{t>Tn }

Die Indikatorfunktion wird aufgrund der Exp-Verteilung benötigt, da diese nur für positive Werte definiert ist.

Wir wollen nun einen Zusammenhang zwischen den Ankunftszeiten und iid U(0,t)-verteilten Zufallsvariablen angeben. Dazu sei zuerst das folgende Lemma, ohne Beweis angegeben:

Lemma 4.3 Seien (U1 , . . . , Un ) unabhängig und identisch U(0,t)-verteilt. Dann haben

die Ordnungsstatistiken (U(1) < . . . < U(n) ) die folgende Dichte:

f(U(1) ,...,U(n) ) (t1 , . . . , tn ) =

n!

1{0<t1 <...<tn }

tn

Damit können wir nun den Zusammenhang angeben und beweisen:

Lemma 4.4 Sei (Nt )t≥0 ein Poisson-Prozess mit Intensität λ und (Tn )n≥0 die zugehörigen

Ankunftszeiten. Seien weiter (Un )n≥1 unabhängig und identisch U(0,t)-verteilt. Dann gilt:

D

(T1 , . . . , Tn |Nt = n) = (U(1) , . . . , U(n) )

Beweis:

Wir wollen diesen Sachverhalt mithilfe des bedingten Erwartungswertes beweisen und

in diesem dann die Dichte ablesen. Dazu sei h : Rn → R eine beliebige Borel-messbare

Funktion. Damit erhalten wir mit den bekannten Rechenregeln für Erwartungswerte:

1

E[h(T1 , . . . , Tn )1{Nt =n} ]

P[Nt = n]

1

=

E[h(T1 , . . . , Tn )1{Tn ≤t≤Tn+1 } ]

P[Nt = n]

1

=

E E[h(T1 , . . . , Tn )1{Tn ≤t} 1{t≤Tn+1 } |T1 , . . . , Tn ]

P[Nt = n]

E[h(T1 , . . . , Tn )|Nt = n] =

19

Die letzte Gleichheit gilt aufgrund der Regel Erwartungswert des bedingten Erwartungs”

werts“. Da h(T1 , . . . , Tn )1{Tn ≤t} messbar bezüglich der Bedingung ist, können wir es aus

dem inneren (bedingten) EW herausziehen und erhalten:

1

E h(T1 , . . . , Tn )1{Tn ≤t} E[1{t≤Tn+1 } |T1 , . . . , Tn ]

P[Nt = n]

1

=

E h(T1 , . . . , Tn )1{Tn ≤t} P[Tn+1 ≥ t|T1 , . . . , Tn ]

P[Nt = n]

1

=

E h(T1 , . . . , Tn )1{Tn ≤t} e−λ(t−Tn ) 1{t>Tn }

P[Nt = n]

1

=

E h(T1 , . . . , Tn )1{Tn <t} e−λ(t−Tn )

P[Nt = n]

=

Mithilfe der gemeinsamen Dichte: f(T1 ,...,Tn ) (t1 , . . . , tn ) = λn e−λtn 1{0<t1 <...<tn } und Lemma

n

4.1 nach dem P[Nt = n] = e−λt (λt)

erhalten wir:

n!

Z

=

h(t1 , . . . tn )

1{tn <t} e−λ(t−tn ) · λn e−λtn 1{0<t1 <...<tn }

n

e−λt (λt)

n!

Rn

d(t1 , . . . , tn )

Daraus könne wir nun die gesuchte Dichte ablesen und erhalten:

fT1 ,...,Tn |Nt =n (t1 , . . . , tn ) =

=

=

1{tn <t} e−λ(t−tn ) · λn e−λtn 1{0<t1 <...<tn }

n

e−λt (λt)

n!

λn e−λt 1{0<t1 <...<tn <t}

n

e−λt (λt)

n!

n!

1{0<t1 <...<tn <t}

tn

Das ist aber nach Lemma 4.3 genau die Dichte der Ordnungsstatistiken U(0,1)-verteilter

Zufallsvariablen, was den Beweis vollendet.

Bevor wir zu dem für den Poisson-Prozess so wichtigen Multinomialkriterium kommen, wollen wir kurz die Multinomialverteilung wiederholen und eine Formel für die

Wahrscheinlichkeitserzeugende Funktion dieser Verteilung, hier und im Folgenden kurz

WEF genannt, einführen.

Definition 4.4 Die Multinomialverteilung mit Parametern n, m, p1 , . . . , pm ist die multivariate Verteilung des Vektors (N1 , . . . , Nm ), definiert durch die Zähldichte

n

P[N1 = n1 , . . . , Nm = nm ] =

pn1 · · · pnmm

n1 , . . . , n m 1

P

Pm

wobei m

i=1 pi = 1 und

i=1 ni = n. Wir schreiben Mm (n, p1 , . . . , pm )

Satz 4.2 Die WEF der Multinomialverteilug ist gegeben durch:

F (z1 , . . . , zm ) = (p1 z1 + . . . + pm zm )n

20

Beweis:

Der Beweis verläuft einfach mithilfe des Multinomischen Lehrsatzes:

Nm

]

F (z1 , . . . , zm ) : = E[z1N1 · · · zm

X

n

(p1 z1 )k1 · · · (pm zm )km

=

k

,

.

.

.

,

k

1

m

k ≥0,...,km ≥0

1

k1 +...+km =n

= (p1 z1 + . . . + pm zm )n

Satz 4.3 (Multinomialkriterium) Es sei (Nt )t≥0 ein Poisson-Prozess mit Intensität

λ. Weiters sei 0 = t0 < t1 < . . . < tm für m ≥ 1. Setzt man

K1 := Nt1 − Nt0 , . . . , Km := Ntm − Ntm−1

und

p1 =

t1 − t0

tm − tm−1

, . . . , pm =

tm

tm

so folgt die bedingte Verteilung von (K1 , . . . , Km |Ntm = n) einer Mm (n, p1 , . . . , pm ).

Beweis:

Wir wollen uns in diesem Beweis auf das Ergebnis von Lemma 4.4 stützen. Wenn wir

annehmen, dass Ntm = n können wir die Ki mithilfe der Ankunftszeiten beschreiben:

Kj =

n

X

1(tj−1 ,tj ] (Tk ),

j = 1, . . . , m

k=1

Wählen wir nun (U1 , . . . , Un ) unabhängig und identisch U (0, tm )-verteilt so erhalten wir,

durch Anwendung des Lemmas 4.4:

!

n

n

X

X

D

1(tm−1 ,tm ] (U(k) )

(K1 , . . . , Km |Ntm = n) =

1(t0 ,t1 ] (U(k) ), . . . ,

k=1

k=1

Da die Sortierung für die hier gebrauchte Anzahl keine Rolle spielt, können wir auch den

unsortierten Vektor U nehmen und erhalten:

!

n

n

X

X

D

=

1(t0 ,t1 ] (Uk ), . . . ,

1(tm−1 ,tm ] (Uk )

k=1

D

=

n

X

k=1

1(t0 ,t1 ] (Uk ), . . . , 1(tm−1 ,tm ] (Uk )

k=1

21

(3)

Nun gilt aufgrund der Geichverteilung auf (0, tm ) der Uk , dass

P[Uk ∈ (tj−1 , tj ]] =

t − j − tj−1

= pj

tm

Daher erhalten wir die WEF

1

E[z1 (t0 ,t1 ]

(Uk )

1(tm−1 ,tm ] (Uk )

, . . . , zm

] = p1 z1 + . . . + pm zm .

Aufgrund der Tatsache dass es sich bei (3) um die Summe iid Vektoren handelt potenziert

sich damit die WEF und wir erhalten:

Pn

h Pn 1

i

(Uk )

k=1 1(tm−1 ,tm ] (Uk )

E z1 k=1 (t0 ,t1 ] , . . . , zm

= (p1 z1 + . . . + pm zm )n

Dies ist wiederum die WEF von Mm (n, p1 , . . . , pm ), die die Verteilung eindeutig charakterisiert und den Beweis damit vollendet.

Nun wollen wir noch eine weitere Charakterisierung des Poisson-Prozesses kennenlernen.

Wie eingangs erwähnt, wird in mancher Literatur häufig dieses Ergebnis als Definition

genommen und unsere Definition als Satz bewiesen:

Satz 4.4 Sei (Nt )t≥0 ein Poisson-Prozess mit Intensität λ. Dann hat er stationäre und

unabhängige Inkremente und es gilt:

1. Nt ∼ P oiλt für alle t > 0

2. Nt − Ns ∼ P oiλ(t−s) für alle 0 ≤ s < t

Beweis:

Punkt 1 wurde schon in Lemma 4.1 bewiesen. Zum Beweis von Punkt 2 verwenden wir

die Notation aus Satz 4.3. Wir wollen die Unabhängigkeit der Kj zeigen. Mithilfe des

Satzes von Bayes über die bedingte Wahrscheinlichkeit erhalten wir:

P[K1 = k1 , . . . , Km = km ] = P[K1 = k1 , . . . , Km = km |Ntm = n]P[Ntm = n]

Nun können wir das Multinomialkriterium anwenden und erhalten:

k

k

tm−1 − tm m −λtm (λtm )n

n

t1 − t0 1

···

·e

=

k1 , . . . , km

tm

tm

n!

Da k1 + . . . + km = n, können wir das λn aus dem letzten Bruch auf die anderen mittels

λk1 · · · λkm aufteilen. Weiters können wir aufgrund von t0 = 0 e−λtm als e−λ(t1 −t0 ) · · · e−λ(tm −tm−1 )

schreiben und erhalten somit:

=

n

n!

((t1 − t0 )λ)k1 · · · ((tm − tm−1 )λ)km −λ(t1 −t0 )

−λ(tm −tm−1 ) (tm )

·

·

·

e

·

·

·

e

k1 ! · · · km !

(tm )k1 +...+km

n!

Durch diverses kürzen und umsortieren erhalten wir nun :

= e−λ(t1 −t0 )

(λ(t1 − t0 ))k1

(λ(tm − tm−1 ))km

· · · e−λ(tm −tm−1 )

k1 !

km !

22

Da dies der Wahrscheinlichkeit für P oiλ(t1 −t0 ) ⊗ . . . ⊗ P oiλ(tm −tm−1 ) entspricht haben wir

sowohl Punkt 2 als auch die Unabhängigkeit der Inkremente gezeigt. Die Stationärität

ergibt sich somit aus dem Zusammenhang.

Am Ende dieses Abschnitts möchte ich noch kurz an den Anfang erinnern, wo wir von

homogenen und inhomogenen Poisson-Prozessen gesprochen haben. Dabei ist zu sagen,

dass wir in dieser Arbeit und insbesondere in diesem Abschnitt nur homogene PoissonProzesse besprochen haben.

Definition 4.5 Sei (Nt )t≥0 ein Poisson-Prozess mit Intensität λ. Ist λ eine konstante, deterministische Funktion, so spricht man von einem homogenen Poisson-Prozess.

Lässt man jedoch zu, dass es sich mit λ(t) um eine zeitabhängige, deterministische, nicht

negative Funktion handelt, so spricht man von einem inhomogenen Poisson-Prozess.

Zuletzt möchte ich noch den für das Risikomodell nach Cramér-Lundberg wichtigen zusammengesetzten Poisson-Prozess, definieren, jedoch keine Eigenschaften mehr darüber

aufzählen. Der interessierte Leser sei an [2] verwiesen.

Definition 4.6 Sei (Nt )t≥0 ein Poisson-Prozess mit Intensität λ. (Xn )n≥1 sei eine dazu unabhängige Folge unabhängiger, identisch verteilter Zufallsvariablen. Dann ist der

zusammengesetzte Poisson-Prozess (St )t≥0 definiert durch:

St =

Nt

X

Xk

k=1

Der Vollständigkeit wegen wollen wir noch den Risikoprozess nach Cramér-Lundberg

angeben:

Definition 4.7 Es sei x ≥ 0 das Anfangskapital, c > 0 die Prämienrate, (Nt )t≥0 ein

Poisson-Prozess mit Intensität λ, (Xk )k≥1 eine dazu unabhängige Folge unabhängiger,

identisch verteilter Zufallsvariablen und (St )t≥0 der zugehörige zusammengesetzte PoissonProzess. Dann wird der Risikoprozess (Rt )t≥0 definiert durch:

Rt = x + ct − St

Bemerkung 4.3 Im allgemeinen Risikoprozess kann man sich die Folge der Xk als Einzelschäden, den Prozess Nt als Schadenanzahlprozess, und den Prozess St als Gesamtschadenprozess vorstellen.

5

Simulation im R2

In diesem letzten Abschnitt wollen wir als Abrundung der Arbeit einen Poisson’schen

Punktprozess anschaulich im R2 simulieren. Dazu wählen wir uns zuerst ein Fenster, in

dem der PPP zu sehen sein soll. Der Einfachheit wegen, werden wir in unserem Programm

nur die Länge der Quadratseiten L wählen. Damit erhalten wir unser Fenster [0, L]2 . Weiters müssen wir noch einen Parameter α > 0 wählen, der später den Intensitätsparameter

darstellen wird. Als nächsten Punkt werden wir einen eindimensionalen Poisson Prozess

23

simulieren der als Grundstock fungieren wird. Dazu benützen wir Definition 4.3 nach der

die Wartezeiten exponential verteilt sind und die in Bemerkung 4.2 angegeben Konstruktion eines Zählprozesses. Dafür benützen wir die bekannte Methode, um ExpαL -verteilte

Zufallszahlen zu generieren:

Xi =

− ln(Ui )

,

αL

wobei Ui ∼ U (0, 1)

Da mit Xi nur die Wartezeiten, nicht aber die Ereigniszeiten, an denen wir eigentlich

interessiert sind, gegeben sind, müssen wir diese noch mit Hilfe der folgenden Formel

bestimmen:

Ti =

i

X

Xk

k=1

Im nächsten Schritt müssen wir nur noch ebenso viele Zi ∼ U (0, L) erzeugen wie wir Ti

haben, diese als Paare in ein Gitter zeichnen und erhalten den Poisson’schen Punktprozess

ξ = {(Ti , Zi ) : 1 ≤ i ≤ NL }

wobei NL für die gesamte Anzahl an Ereignissen im Intervall [0,L] steht. Zur Vollständigkeit

möchte ich an dieser Stelle noch einen funktionierenden Matlab-Code angeben, der genau

die eben besprochenen Schritte bearbeitet und als Ergebnis das folgende Bild hat.

a lp h a =5;

L=5;

t=−log ( rand ) / ( alpha ∗L ) ; n=0;

while t<L

n=n+1;

T( n)= t ;

t=t−log ( rand ) / ( alpha ∗L ) ;

end

Z=u n i f r n d ( 0 , L , 1 , length (T ) ) ;

figure (1)

clf

plot (T, Z , ’ . ’ )

24

Literatur

[1] Achim Klenke Wahrscheinlichkeitstheorie Springer Verlag Berlin Heidelberg 2013,

3.Auflage

[2] Friedrich Hubalek Vorlesung Risiko- und Ruintheorie TU Wien Wintersemester

2013/2014

25