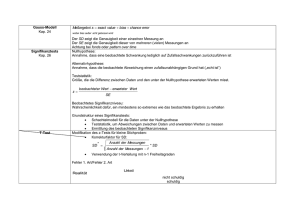

Kapitel 4: Testtheorie

Werbung

15

Kapitel 4. Testtheorie

4.1 Modell

Es gelten die Modellvoraussetzungen 1.2, gegeben ist also ein statistischer Raum (Q,G, WZ)

mit WZ = {wh: h01}und einer Parametermenge 1, wobei wir die Familie WZ als mögliche

Verteilungen einer Zufallsgröße Z interpretieren, d.h. PZ = wh für ein bestimmtes, aber

unbekanntes h01.

Gegeben sei weiter eine Zerlegung 1 = 10 c 11 der Parametermenge in zwei disjunkte

nichtleere Mengen 10 und 11 und damit eine Zerlegung WZ = W 0 c W1 der Familie WZ, wobei

Wi = {wh | h01i} für i=0,1.

Nullhypothese H0 : Die "wahre" Verteilung liegt in W0 : wh 0 W0 oder: der "wahre" Parameter

liegt in 10: h010.

Gegenhypothese (Alternative) H1: Die "wahre" Verteilung liegt in W1 : wh 0 W1 oder: der

"wahre" Parameter liegt in 11: h011.

4.2 Definition: nichtrandomisierte und randomisierte Tests

Ein (nichtrandomisierter) Test (von H0 gegen H1) ist eine (meßbare) Entscheidungsregel

*: Q 6 {0,1} mit der Bedeutung:

*=1: H0 verwerfen, also H1 akzeptieren,

*=0: H0 nicht verwerfen, d.h. H0 beibehalten.

Die Menge {*=1}={z0Q| *(z)=1} heißt Verwerfungsbereich oder kritischer Bereich des

Tests *.

Ein randomisierter Test (von H0 gegen H1) ist eine (meßbare) Entscheidungsregel

*: Q 6 [0,1] mit der Bedeutung:

*(z) = p: führe ein B(1,p)-Experiment durch; beim Ergebnis "1" wird H0 verworfen, beim

Ergebnis "0" beibehalten.

4.3 Definition: Gütefunktion

Sei *: Q 6 [0,1] ein Test von H0 gegen H1.

Die Funktion g* = g: 1 6 [0,1] gemäß g(h) = Eh(*); h01, heißt Gütefunktion des Tests *

(power function).

Für jedes h01 ist g(h) die Wahrscheinlichkeit, daß H0 verworfen wird, falls h der wahre

Parameter ist.

Ist speziell * nichtrandomisiert, so ist g(h) = wh{*=1} für alle h01.

4.4 Definition: Fehler und Irrtumsniveau

Sei *: Q 6 [0,1] ein Test von H0 gegen H1.

Bei Anwendung des Tests * sind zwei Arten von Fehlern möglich:

a) Fehler 1.Art: Die Nullhypothese H0 wird verworfen, obwohl sie wahr ist (d.h. h010).

b) Fehler 2.Art: Die Nullhypothese H0 wird beibehalten, obwohl sie falsch ist (d.h. h011).

"(*) := sup {g*(h)| h010} ist die größtmögliche Wahrscheinlichkeit eines Fehlers 1.Art.

"(*) heißt effektives (Signifikanz- oder Irrtums-) Niveau des Tests *.

1-"(*) heißt auch Sicherheitsniveau von *.

Für h011 ist 1 - Eh(*) = 1 - g(h) ist die Wahrscheinlichkeit eines Fehlers 2.Art, also

$(*) := sup{1 - g(h)| h011} = 1 - inf{g(h)| h011} die größtmögliche Wahrscheinlichkeit

eines Fehlers 2.Art.

16

4.5 Definition: Niveau-"-Tests

Seien *: Q 6 [0,1] ein Test von H0 gegen H1, " 0 [0, 1]. Falls "(*) # ", so heißt *

(Signifikanz-)Test zum (Irrtums-)Niveau " oder kurz Niveau-"-Test (von H0 gegen H1).

Erwünscht sind Niveau-"-Tests * mit möglichst großen g*(h) für h011. Dabei sollte das

Irrtumsniveau " nach Möglichkeit ausgeschöpft werden, also "(*) = " sein.

Beispiel: siehe Vorlesung

4.6 Definition: Unverfälschte Tests

Seien " 0 [0, 1], * ein Test mit der Gütefunktion g wie in 4.3. * heißt unverfälschter

(unbiased) Niveau-"-Test, wenn "(*) # " # g(h) für alle h 0 11.

4.7 Definition: Gleichmäßig beste Tests (UMP und UMPU)

Seien " 0 [0,1], )(") bzw. )u(") die Menge aller Niveau-"-Tests bzw. aller unverfälschten

Niveau-"-Tests von H0 gegen H1.

1) Ein Test **0)(") heißt gleichmäßig bester Test (UMP = uniformly most powerful) von H0

gegen H1 zum Niveau ", falls für alle *0)(") und für alle h011 gilt: Eh(*) # Eh(**), d.h. der

Test ** minimiert für jedes h011 die Wahrscheinlichkeit eines Fehlers 2.Art unter allen

Niveau-"-Tests.

2) Ein Test **0)u(") heißt gleichmäßig bester unverfälschter Test (UMPU = uniformly most

powerful unbiased) von H0 gegen H1 zum Niveau ", falls für alle *0)u(") und für alle

h011 gilt: Eh(*) # Eh(**), d.h. der Test ** minimiert für jedes h011 die Wahrscheinlichkeit

eines Fehlers 2.Art unter allen unverfälschten Niveau-"-Tests.

4.8 Definition: Der p-Wert

Es liege Modell 4.1 vor, also ein statistischer Raum (Q,G, WZ) mit WZ = {wh: h01},

1 = 10 c 11 , H0 : h010, H1: h011.

Es sei T: Q 6 ú eine meßbare Abbildung (eine "Statistik"); für alle "0+0,1, sei B(")dú mit

sup{wh(T0B(")) | h010}#" und *(") sei der nichtrandomisierte Test mit dem

Verwerfungsbereich {T0B(")}. Für alle " ist dann *(") ein Niveau-"-Test für H0 gegen H1.

Sei p: Q 6 [0,1] definiert gemäß p(x) := inf{"0+0,1, | T(x)0B(")}; x0Q.

p(x) heißt p-Wert (zur Beobachtung x); für alle x0Q ist p(x) das kleinste Irrtumsniveau "

derart, daß der Test *(") bei Beobachtung von x zur Verwerfung der Nullhypothese führt,

also p(x) = inf{"0+0,1, | *(")(x)=1}. Je kleiner der p-Wert, umso stärker spricht das

Testergebnis gegen die Nullhypothese.

4.9 Definition: Likelihoodquotienten und Neyman-Pearson-Tests

Sei (Q,G, WZ) ein Standardraum (vgl. 1.3.4) mit 1 = {0, 1}, also WZ = {w0, w1} mit

Likelihoods f0 bzw. f1. H0: h = 0, H1: h = 1.

(Nullhypothese und Gegenhypothese sind hier einfach, d.h. einpunktig).

Definiere q: Q 6 [0, 4] gemäß q(z) = f1(z)/f0(z), falls f0(z)>0, bzw. q(z) = 4 sonst. q heißt

Likelihood-Quotient (LQ).

Ein Test n: Q 6 [0,1] heißt Neyman-Pearson-Test (NP-Test) oder vom Neyman-PearsonTyp, falls ein c0ú+ existiert derart, daß n(z) = 1, falls q(z) > c , und n(z) = 0, falls q(z) < c.

c heißt Schwellenwert oder kritischer Wert des NP-Tests n.

4.10 Neyman-Pearson-Lemma (Jerzy Neyman und Egon Pearson, 1932/33)

17

Mit den Voraussetzungen und Bezeichnungen von 4.9 gilt:

1) Ist n ein NP-Test, ":= E0(n), so ist n UMP-Test in )("), d.h. E1(n) $E1(n') für alle

Niveau-"-Tests n' von H0 gegen H1.

2) Zu beliebigem " 0 +0,1, existiert ein NP-Test ** mit " = E0(**). Setze dazu

(1) c := inf{t0ú+ | w0(q>t) # "},

(2) ( := (" - w0(q>c))/w0(q=c), falls w0(q=c) > 0, bzw. (=1 sonst,

und definiere **: Q 6 [0,1] gemäß

(3) **(z) = 1, falls q(z)>c, **(z) = 0, falls q(z)<c, und **(z) = (, falls q(z)=c.

4.11 Bemerkung

Mit den Voraussetzungen und Bezeichnungen von 4.9 sei T: Q 6 ú eine Statistik,

q': ú 6 [0, 4, monoton wachsend derart, daß q = q' B T.

1) Sei c0ú und sei n ein Test mit {T>c} d {n=1} und {T<c} d {n=0}. Dann ist n ein NPTest (mit Schwellenwert c' = q'(c)).

2) Zu " 0 +0, 1, setze

(1) d := inf{t0ú | w0(T>t) # "},

(2) ( := (" - w0(T>d))/w0(T=d), falls w0(T=d) > 0, bzw. (=1 sonst

(3) **: Q 6 [0,1] gemäß **(z) = 1, falls T(z)>d, **(z) = 0, falls T(z)<d, und **(z) = (, falls

T(z)=d, ist ein NP-Test mit E0(**) = ".

Beispiel: siehe Vorlesung

4.12 Modell

Sei (Q,G, WZ) ein Standardraum, WZ = {wh: h 0 1}, wobei 1 offenes Intervall in ú mit

Likelihood L. L sei eine Exponentialfamilie wie in 2.14 bezüglich einer Statistik T: Q 6 ú,

also L(z,h) = h(z) exp{a(h)T(z) - b(h)}für alle z0Q und alle h01

wobei h: Q 6 +0,4,, a: 1 6 ú stetig differenzierbar mit a' > 0 stets, b: 1 6 ú.

4.13 Gleichmäßig beste Tests bei einseitigen Testproblemen

Es gelten die Voraussetzungen und Bezeichnungen von 4.12.

1) Sei c 0 ú und n: Q 6 [0,1] mit der Eigenschaft {T>c} d {n=1}und {T<c} d {n=0}.

Dann ist die Funktion 1hh 6 Eh(n) monoton wachsend.

2) Sei h(0)0 1 fest. H0: h# h(0) H1: h> h(0) (linksseitiges Testproblem) und seien c und n

wie in 1). Dann ist n gleichmäßig bester Test von H0 gegen H1 zum Niveau " = Eh(0)(n).

3) Seien H0 und H1 wie in 2) und sei " 0 +0,1, vorgegeben. Definiere hierzu c gemäß

(1) c: = inf{t0ú | wh(0)(T>t) # "},

sowie ( 0 [0,1] als Lösung der Gleichung

(2) wh(0)(T>c) + ( wh(0)(T=c) = ",

und setze

(3) n(z) = 1, falls T(z) > c, n(z) = 0, falls T(z) < c, und n(z) = (, falls T(z) = c.

Dann ist n gleichmäßig bester Test von H0 gegen H1 zum Niveau ".

Bemerkung

Zu 4.13 analoge Aussagen gelten für rechtsseitige Testprobleme, nämlich für H0: h$ h(0)

gegen H1: h< h(0). (siehe Literatur, bzw. Übungen)

4.14 Einseitige Binomialtests

18

Gegeben ist eine Bernoulli-Stichprobe Z = (X1, ..., Xn) (siehe Beispiel 1 zu 1.4),

also 1 = +0, 1,, Q = {0, 1}n, wp = B(1, p)qn für alle p01,

Likelihood L(z, p) = ps(1-p)n-s für z = (x1, ..., xn) 0 Q, s = x1 + ... + xn, p01.

Nach 2.17.1 liegt eine Exponentialfamilie vor bezüglich S = X1 + ... + Xn, wobei

a(p) = n (ln(p) - ln(1-p)) streng monoton wachsend auf 1.

Seien p(0) 0 +0, 1, , " 0 +0, 1, fest vorgegeben.

Der in 4.13.3 (1),(2),(3) beschriebene Test n ist gleichmäßig bester Test in der Klasse aller

Tests zum Signifikanzniveau " für H0: p # p(0) gegen H1: p > p(0).

Da bezüglich wp(0) S ~ B(n,p(0)), sind c und ( zu wählen gemäß

(1) c = min{d 0{0,...,n}| B(n,p(0))({k | k>d}) # "},

(2) ( = (" - B(n,p(0))({k | k>c}))/B(n,p(0))({c});

Es ist also n: {0,1}n 6 [0,1] gemäß n(x1,...,xn) = 1, falls x1 + ... + xn > c, n(x1,...,xn) = (, falls

x1 + ... + xn = c, n(x1,...,xn) = 0, falls x1 + ... + xn < c.

In der Praxis verwendet man meist den nichtrandomisierten Test mit dem

Verwerfungsbereich {S > c}, wobei c zu " wie in (1) bestimmt wird. Er ist allerdings nur

näherungsweise gleichmäßig bester Test.

Diese Tests heißen linksseitige Binomialtests oder Tests auf eine unbekannte

Wahrscheinlichkeit.

Beispiele: siehe Vorlesung

4.15 Einseitige Gaußtests

Wir betrachten das Normalverteilungsmodell mit unbekanntem Erwartungswert m und

bekannter Varianz v = v0, also 1 = ú, Q = ún, für alle m0ú hat wm die Likelihood

(Lebesguedichte) L(z,m) = (2Bv0)-n/2 exp{-(1/2v0)[(x1-m)²+...+(xn-m)²]}; z=(x1, ..., xn)0ún.

Gemäß 2.17.2 ist dies eine Exponentialfamilie bezüglich M = (1/n)(X1 + ... + Xn), wobei

a(m) = nm/v0 streng monoton wachsend ist. Die Voraussetzungen von 4.13 sind also mit

T = M erfüllt. Seien m(0)0ú, "0+0, 1, vorgegeben.

Sei H0: m # m(0), H1: m > m(0). Der in 4.15.3 (1),(2),(3) beschriebene Test n ist gleichmäßig

bester Test in der Klasse aller Tests zum Signifikanzniveau " für H0 gegen H1.

Da bezüglich wm(0) M ~ N(m(0),v0/n) ist n nichtrandomisiert ((=1) und c ist das (1-")Quantil von N(m(0),v0/n), d.h. M((c-m(0))(v0/n)-1/2) = 1-", also c = m(0) + (v0/n)1/2u1-", wobei

u1-" das (1-")-Quantil von N(0,1) ist.

Der nichtrandomisierte Test n mit dem Verwerfungsbereich{M$m(0) + (v0/n)1/2u1-"}

ist gleichmäßig bester Test in der Klasse aller Niveau-"-Tests für H0 gegen H1.

Dieser Test heißt einseitiger (linksseitiger) Gauß-Test.

4.16 Konfidenzintervalle und Tests

Es liege das Modell 1.1 vor; zusätzlich sei 8: 1 6 ú und 80 0 ú fest.

Sei 10 = {h01| 8(h)=80} (…i), 11 = 1 (10 , H0 : 8(h) = 80 , H1: 8(h) … 80 , " 0 +0,1,.

Sei Q hz 6 C(z) ein (1-")-Konfidenzintervall für 8(h). Dann ist der (nichtrandomisierte)

Test * mit dem Verwerfungsbereich {*=1} = {z0 Q| 80 ó C(z)} ein Niveau-"-Test von H0

gegen H1. Dabei ist "(*) = ", falls für wenigstens ein h010 wh{z0Q| 8(h) 0 C(z)} = 1-".

4.17 Der zweiseitige Binomialtest für eine unbekannte Wahrscheinlichkeit

Es liegt das Binomialmodell wie in 4.14 vor: n0ù, 1 = +0, 1,, Q = {0, 1}n,

WZ = {B(1,p)qn| p01}; Z=(X1, ..., Xn) Bernoullistichprobe vom Umfang n mit unbekannter

19

Erfolgswahrscheinlichkeit p; wie in 4.16 sei S = X1 + ... + Xn = Anzahl der Erfolge; bezüglich

wp ist S B(n,p)-verteilt.

Seien p* 0 +0, 1, fest, H0: p = p*, H1: p … p*; " 0 +0, 1, fest. Definiere

c1:= max{x0{0,...,n}| B(n,p*)({k | k<x})#"/2} (= n - qbinom(1 - "/2, n,1-p*))

c2:= min{x0{0,...,n}| B(n,p*)({k | k>x})#"/2} (= qbinom(1 - "/2, n, p*)).

Dann ist wp*(S<c1) # "/2 und wp*(S>c2) # "/2. Der nicht-randomisierte Test * mit dem

Verwerfungsbereich {*=1} = {S < c1} c {S > c2} ist also ein Niveau-"-Test für H0 gegen H1.

* heißt zweiseitiger Binomialtest.

Beispiele: siehe Vorlesung

4.18 Normalapproximationen der Binomialtests

Gegeben sei wieder das Binomialmodell wie in 4.14 und 4.17; ferner seien "0+0, 1, und

p*0+0, 1, vorgegeben; für jedes t0+0,1, bezeichne ut das t-Quantil von N(0,1).

Nach dem Satz von deMoivre-Laplace (V 2.5) ist B(n,p*) . N(np*,np*(1-p*)) für große n.

1) Beim einseitigen Binomialtest 4.14 ist der Schwellenwert c ein (1-")-Quantil von B(n,p*),

welches man für große n durch das (1-")-Quantil von N(np*,np*(1-p*)), also durch

np* + u1-"(np*(1-p*))1/2 approximieren kann.

Der nichtrandomisierte Test * mit dem Verwerfungsbereich

{*=1} = {S > np* + u1-"(np*(1-p*))1/2}

ist dann für große n näherungsweise ein Niveau-"-Test für H0: p # p* gegen H1: p > p*.

2) Beim zweiseitigen Binomialtest 4.17 ist die untere Schranke c1 ein ("/2)-Quantil von

B(n,p*) und die obere Schranke c2 ein (1-"/2)-Quantil von B(n,p*). Da u"/2 = - u1-"/2, ist

c1 .np* - u1-"/2(np*(1-p*))1/2 und c2 .np* + u1-"/2(np*(1-p*))1/2.

Der nichtrandomisierte Test * mit dem Verwerfungsbereich

{*=1} = {S < np* - u1-"/2(np*(1-p*))1/2} c {S > np* + u1-"/2(np*(1-p*))1/2}

ist dann für große n näherungsweise ein Niveau-"-Test für H0: p=p* gegen H1: p…p*.

Diese Tests heißen Normalapproximationen der Binomialtests 4.14 bzw. 4.17.

Beispiele: siehe Vorlesung

4.19 Zweiseitige Gauß-Tests

Gegeben ist das Normalverteilungsmodell mit bekannter Varianz v = v0 wie in 4.15, also

1 = ú, Q = ún, und für alle m0ú ist wm = N(m,v0)qn.

Seien m(0)0ú, " 0+0,1, vorgegeben, und seien H0: m = m(0), H1: m … m(0).

U = (M-m(0))(v0/n)-1/2 sei die sogenannte Gauß-Statistik (vgl. 3.9.2). Bezüglich wm(0) ist U

standardnormalverteilt. Der nichtrandomisierte Test * mit dem Verwerfungsbereich

{*=1} = {|U| $ u1-"/2}, wobei u1-"/2 das (1-"/2)-Quantil von N(0,1) ist, ist ein Niveau-"-Test

von H0 gegen H1. * heißt zweiseitiger Gaußtest.

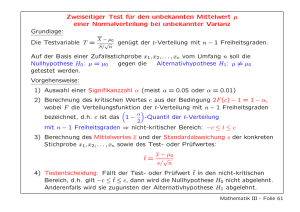

4.20 Zweiseitige t-Tests

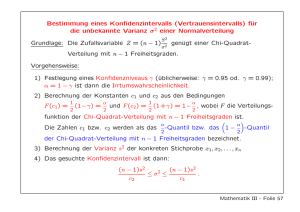

Zugrunde liegt das allgemeine Normalverteilungsmodell 1.4.2, d.h. Z = (X1,...,Xn) ist eine

N(m,v)-verteilte Stichprobe vom Umfang n mit unbekannten Parametern m und v, also

1 = ú×+0, 4,, Q = ún, WZ = {wh | h01}, wobei für h=(m,v)01 wh = N(m,v)qn.

Wie üblich bezeichne M das Stichprobenmittel, S² die Stichprobenvarianz.

Seien " 0 +0, 1,, m(0)0ú fest vorgegeben, und seien H0: m = m(0), H1: m … m(0), also

10 = {(m,v)01 | m=m(0)}, 11 = {(m,v)01 | m…m(0)}.

20

T = (M-m(0))(S²/n)-1/2 sei die sogenannte t-Statistik (vgl. 3.9.1). Für jedes h010 ist bezüglich

wh T t-verteilt mit n-1 Freiheitsgraden (siehe 3.9.1).

Der nichtrandomisierte Test * mit dem Verwerfungsbereich {|T| > tn-1,1-"/2}, wobei tn-1,1-"/2 das

(1-"/2)-Quantil der t-Verteilung mit n-1 Freiheitsgraden ist, ist ein Niveau-"-Test für H0

gegen H1. * heißt zweiseitiger t-Test.

Beispiel: siehe Vorlesung

4.21 Chi-Quadrat-Tests für die Varianz

Modellvoraussetzungen und Bezeichnungen wie in 4.20; vorgegeben seien "0+0, 1, und ein

festes v0>0. Seien H0: v = v0, H1: v … v0, also 10 = {(m,v)01 | v=v0}, 11 = {(m,v)01 | v…v0}.

Für jedes h=(m,v0)010 ist bezüglich wh (n-1)S²/v0 P²n-1-verteilt (siehe 3.9.3).

Der nichtrandomisierte Test * mit dem Verwerfungsbereich

{S² < (v0/(n-1))P²n-1,"/2}c{S² > (v0/(n-1))P²n-1,1-"/2}

ist ein Niveau-"-Test für H0 gegen H1.

(Für m0ù, $0+0,1, bezeichne P²m,$ das $-Quantil der Chiquadrat-Verteilung mit m

Freiheitsgraden.)

* heißt zweiseitiger Chiquadrat-Test (für die Varianz).

Beispiel: siehe Vorlesung

Wir betrachten weitere Tests in Normalverteilungsmodellen.

4.22 Zwei-Stichproben-t-Test: Vergleich zweier Erwartungswerte

Wir erweitern das Normalverteilungsmodell wie folgt:

seien k,n0ù, die Zufallsgröße Z sei eine Folge X1,...,Xk, Y1,...,Yn von unabhängigen

Zufallsvariablen, wobei X1,...,Xk identisch normalverteilt sind mit (unbekanntem)

Erwartungswert m(1) und (unbekannter) Varianz v>0, Y1,...,Yn identisch normalverteilt mit

(unkanntem) Erwartungswert m(2) und derselben Varianz v.

Als Parameterbereich liegt also vor 1 = ú×ú×+0,4,, der Stichprobenraum ist Q = úk+n,

und für alle h = (m(1),m(2),v) 0 1 hat wh die Likelihood (W-Dichte)

L(z,h) = (2Bv)-(k+n)/2exp{-(1/2v)[(x1-m(1))²+...+(xk-m(1))²+(y1-m(2))²+...(yn-m(2))²]};

z = (x1,...,xk,y1,...,yn) 0 úk+n . Seien

M(1,k) = (1/k)(X1+...+Xk) das X-Stichprobenmittel,

M(2,n) = (1/n)(Y1+...+Yn) das Y-Stichprobenmittel,

S²(k,n) := (k+n-2)-1[(X1-M(1,k))²+...(Xk-M(1,k))²+(Y1-M(2,n))²+...+(Yn-M(2,n))²] die ZweiStichprobenvarianz, S(m,n) := (S²(m,n))1/2 die Zwei-Stichprobenstandardabweichung. Sei

T = T(Z) = (kn/(k+n))1/2(M(1,k) -M(2,n))/S(m,n) = [(1/k)+(1/n)]-1/2(M(1,k) -M(2,n))/S(m,n).

Es gilt: (*) Für alle h=(m(1),m(2),v)01 mit m(1)=m(2) ist die "Teststatistik" T bezüglich wh

t-verteilt ist mit k+n-2 Freiheitsgraden.

Sei " 0+0,1, vorgegeben; H0: m(1) = m(2), H1: m(1) … m(2), also

10 = {h = (m(1),m(2),v)01 | m(1)=m(2)}, 11 = 1(10.

Aus (*) folgt, daß der nichtrandomisierte Test * mit dem kritischen Bereich

{*=1} = {| T | > tk+n-2,1-"/2} ein Niveau-"-Test für H0 gegen H1 ist.

(Dabei ist tk+n-2,1-"/2 das (1-"/2)-Quantil der t-Verteilung mit k+n-2 Freiheitsgraden.

* heißt Zwei-Stichproben-t-Test.

4.23 F-Tests: Vergleich zweier Varianzen

21

Ähnlich wie in 4.22 betrachten wir ein Normalverteilungsmodell wie folgt:

seien k,n0ù, die Zufallsgröße Z sei eine Folge X1,...,Xk, Y1,...,Yn von unabhängigen

Zufallsvariablen, wobei X1,...,Xk identisch normalverteilt sind mit (unbekanntem)

Erwartungswert m(1) und (unbekannter) Varianz v(1)>0, Y1,...,Yn identisch normalverteilt

mit (unkanntem) Erwartungswert m(2) und (unbekannter) Varianz v(2)>0.

Als Parameterbereich liegt also vor 1 = ú×ú×+0,4,×+0,4,, der Stichprobenraum ist Q = úk+n

und für alle h=(m(1),m(2),v(1),v(2))01 ist wh = N(m(1),v(1))qkqN(m(2),v(2))qn.

Wie in 4.22 sei M(1,k) (bzw. M(2,n)) das X- (bzw. Y-)Stichprobenmittel, ferner

S²(1,k) := (k-1)-1((X1-M(1,k))²+...+(Xk-M(1,k))²) die X-Stichprobenvarianz,

S²(2,n) := (n-1)-1((Y1-M(2,n))²+...+(Yn-M(2.n))²) die Y-Stichprobenvarianz.

H0: v(1) = v(2), H1: v(1) … v(2),

also 10 = {h = (m(1),m(2),v(1),v(2))01 | v(1)=v(2)}, 11 = 1(10.

Für h = (m(1),m(2),v,v)010 ist bezüglich wh Z1 := (k-1)S²(1,k)/v Chiquadrat-verteilt mit

k-1 Freiheitsgraden, und Z2 := (n-1)S²(2,n)/v Chiquadrat-verteilt mit n-1 Freiheitsgraden

(siehe 3.9.3); ferner sind Z1 und Z2 unabhängig. Gemäß V11 ist dann

F := (Z1/(k-1)) : (Z2/(n-1)) = S²(1,k)/S²(1,n) Fk-1,n-1-verteilt.

Zu vorgegebenem "0+0,1, sei u1 das ("/2)-, u2 das (1-"/2)-Quantil der Fk-1,n-1-Verteilung.

Dann ist der nichtrandomisierte Test * mit dem Verwerfungsbereich

{*=1} = {F < u1}c{F > u2}

ein Niveau-"-Test für H0 gegen H1 ("F-Test").

Beispiel: siehe Vorlesung

Zuletzt wollen wir Chi-Quadrat-Anpassungs- und Unabhängigkeitstests behandeln.

4.24 Beispiel

Bei der Kreuzung zweier Erbsensorten sind vier Ergebnisse möglich:

Typ 1 (AB): rund und gelb; Typ 2 (aB): gerunzelt und gelb; Typ 3 (Ab): rund und grün;

Typ 4 (ab): gerunzelt und grün.

Sei W = {1,2,3,4} und sei X die Zufallsvariable "Typ" mit dem Wertebereich W.

Ihre Verteilung ist unbekannt; sie wird durch einen vierdimensionalen W-Vektor

p =(p1,p2,p3,p4) beschrieben, wobei pi = P(X=i) für i=1,2,3,4.

Die Mendelsche Theorie behauptet: p = (9/16,3/16,3/16,1/16).

Diese Behauptung soll durch einen sogenannten Anpassungstest überprüft werden.

4.25 Modellvoraussetzungen für den Chi-Quadrat-Anpassungstest

Sei r0ù, r$2, A = {a1, a2, ..., ar} eine r-elementige Menge und sei X eine Zufallsvariable mit

Wertebereich A. Die Verteilung von X wird beschrieben durch einen r-dimensionalen WVektor p = (p1, ..., pr): pD = P(X=aD}, D=1,...,r. p ist unbekannt, also

1 = Pr = {p = (p1, ..., pr) | pD > 0 für D=1,...,r, p1 + ... + pr = 1} Parameterbereich.

Sei n0ù. Das durch X beschriebene Zufallsexperiment wird n-mal unabhängig wiederholt,

dies ergibt eine Stichprobe Z(n) = (X1, ..., Xn).

Es liegt also das statistische Modell (Qn,G n, WZ(n)) vor, wobei

Qn = An, G n = -(Qn), WZ(n) = {wp | p01} mit wp = pqn für alle p01. (Wir identifizieren dabei

endlich-diskrete Verteilungen mit ihren W-Vektoren.)

Für D=1,...,r sei hD(n)= Anzahl der j0{1,...,n} mit Xj = aD, also die Besetzungszahl der D-ten

Klasse, h(n) = (h1(n), ..., hr(n)) der Besetzungsvektor.

22

Für jedes p01 ist bezüglich wp h(n) ~ Mult(n,r,p) (siehe V3.3).

4.26 Die Chi-Quadrat-Statistik für den Anpassungstest

Qn: Qn×Pr 6 ú+ gemäß Qn(Z(n), p) = (h1(n)-np1)²/(np1) + ... + (hr(n)-npr)²/(npr), wobei

p = (p1, ..., pr), heißt Chi-Quadrat-Statistik.

Für p=(p1, ..., pr)0Pr ist bezüglich wp für D = 1, ... , r hD(n)~ B(n,pD), insbesondere ist also npD

die erwartete Besetzungszahl der D-ten Klasse. Bei der Berechnung von Qn wird also

summiert über das Quadrat der Differenz aus tatsächlicher und erwarteter Besetzungszahl

geteilt durch die erwartete Besetzungszahl.

Es gilt: Qn(Z(n), p) = (1/n)(h1²(n)/p1 + ... + hr²(n)/pr) - n.

4.27 Satz (Karl Pearson, 1900)

Für beliebige p0Pr und große n ist die Zufallsvariable Qn(Z(n), p) bezüglich wp

näherungsweise P2-verteilt mit r-1 Freiheitsgraden, d.h. bezüglich wp konvergiert Qn(Z(n), p)

für n64 schwach gegen P²r-1.

4.28 Der Chi-Quadrat-Anpassungstest

Gegeben r,n0ù, wobei r $2, (Qn,G n, WZ(n)) mit WZ(n) = {wp | p01}, 1 = Pr wie in 4.25.

Seien weiter p(0)0Pr und "0+0,1, vorgegeben.

H0: p = p(0) (also 10 = {p(0)}); H1: p … p(0).

Sei P²r-1,1-" das (1-")-Quantil der P²r-1-Verteilung, Q* := Qn(Z(n),p(0)) gemäß 4.26.

Der nichtrandomisierte Test * mit dem Verwerfungsbereich {*=1} = {Q* > P²r-1,1-"} heißt

Chi-Quadrat-Anpassungstest. Wegen 4.27 ist * ein Test von H0 gegen H1 mit dem

asymptotischen Signifikanzniveau ".

4.29 Beispiele

1) Fortsetzung von 4.24: r=4, p(0) = (9/16,3/16,3/16,1/16), n=556, " = 0.1, P²3,0.9 = 6.25.

556 Kreuzungen liefern den Zählvektor h = (315,101,108,32). Q* = Q(Z(n), p(0)) = 0.470 <

6.25. Also *=0, das Ergebnis spricht nicht gegen die Mendelsche Theorie.

2) und 3) siehe Vorlesung

4.30 Der Chiquadrat-Anpassungstest bei stetigen Verteilungen

Der Chiquadrat-Anpassungstest gemäß 4.28 prüft die Nullhypothese, ob eine bestimmte

endlich-diskrete Verteilung p(0) vorliegt oder nicht. Will man diesen Test auch für stetige

Verteilungen anwenden, muß man vorher diskretisieren.

Sei dazu X eine stetige reelle Zufallsvariable und sei < eine bestimmte stetige W-Verteilung

auf (ú,B). Es soll die Nullhypothese PX = < untersucht werden. Sei "0+0,1, gegeben.

Man unterteilt die Zahlengerade in r Teilintervalle I1, ..., Ir und setzt pD(0) := <(ID) für

D=1,...,r, p(0) := (p1(0), ..., pr(0)). H0: p = p(0); H1: p … p(0).

Man erzeugt eine einfache Stichprobe Z=(X1, ..., Xn) und setzt für D=1,...,r

hD = Anzahl der i0{1,...,n}mit Xi 0 ID; h:= (h1, ..., hr).

Teste nun H0 gegen H1 mit dem kritischen Bereich {Q* > P²r-1,1-"}, wobei Q* = Qn(Z, p(0)).

Beachte: Ist PX = <, so ist h ~ Mult(n,r,p(0)), d.h. es liegt die Nullhypothese vor. Liegt daher

die Testgröße im kritischen Bereich, kann die Hypothese PX = < zum Signifikanzniveau "

verworfen werden. Die Wahrscheinlichkeiten für Fehler zweiter Art sind allerdings i.a. höher

als im diskreten Fall, da verschiedene stetige Verteilungen zur gleichen Diskretisierung p(0)

führen können.

23

Mit dem im folgenden beschriebenen Unabhängigkeitstest soll untersucht werden, ob zwei

Merkmale (Zufallsvariablen) XA und XB mit jeweils endlich vielen Ausprägungen A =

{1,...,a} und B = {1,...,b} unabhängig sind.

Dabei seien a,b0ù({1}.

4.31 Modellvoraussetzungen für den Chi-Quadrat-Unabhängigkeitstest

Seien E = A×B = {(i,j) | i0A, j0B}, 1 = 1E = {h=(h(i,j))(i,j)0E 0 +0,1,E | 3(i,j) h(i,j) = 1} die

Menge aller E-Wahrscheinlichkeitsmatrizen, 1A = {"=("(i))i0A 0 +0,1,A | 3i "(i) = 1},

1B = {$=($(j))j0B 0 +0,1,B | 3j $(j) = 1} die Menge aller A- bzw. B-Wahrscheinlichkeitsvektoren. Im folgenden werden W-Matrizen und W-Vektoren mit den durch sie in

kanonischer Weise induzierten W-Maßen auf E bzw. A bzw. B identifiziert.

Für jedes h01 setze hA = (hA(i))i0A 0 1A, wobei für i0A hA(i) = 3 j0B h(i,j), und

hB = (hB(j))j0B 0 1B, wobei für j0B hB(j) = 3 i0A h(i,j). hA und hB sind also die zu h gehörigen

Randverteilungen auf A bzw. B (also die Verteilungen von XA resp.XB bezüglich h).

Nullhypothese: XA und XB sind unabhängig, also H0: h = hAqhB oder H0: h010, wobei

10 = {"q$ = ("(i)$(j))(i,j)0E | "01A, $01B}.

Gegenhypothese: H1: h011 = 1(10.

Im Gegensatz zu 4.28 (einfache, nämlich einelementige Nullhypothese) liegt hier eine

zusammengesetzte (mehrelementige) Nullhypothese vor.

Sei n0ù. Analog 4.25 beschaffen wir uns n unabhängige Wiederholungen des Zufallsvektors

X = (XA,XB): Z(n) = (X1,...,Xn) = ((X1A,X1B),...,(XnA,XnB)) .

Es liegt also das statistische Modell (Qn,G n, WZ(n)) vor, wobei

Qn = En, G n = -(Qn), WZ(n) = {wh | h01} mit wh = hqn für alle h01.

Für (i,j)0E definieren wir die Besetzungsvariablen

hn(i,j) := Anzahl der k0{1,...,n} mit Xk = (i,j), Ln(i,j) = hn(i,j)/n,

hn = (h n(i,j))(i,j)0E die sogenannte Kontingenztafel nach n Beobachtungen,

Ln = (Ln(i,j))(i,j)0E die empirische gemeinsame Verteilung der beiden Merkmale nach n

Beobachtungen.

Für n0ù, i0A sei hnA(i) = 3j0B hn(i,j) = Anzahl der k0{1,...,n} mit XkA = i, LnA(i) = hnA(i)/n,

LnA = (LnA(i))i0A die empirische Verteilung des Merkmals XA nach n Beobachtungen;

für n0ù, j0B sei hnB(j) = 3i0A hn(i,j) = Anzahl der k0{1,...,n} mit XkB = j, LnB(j) = hnB(j)/n,

LnB = (LnB(i))j0B die empirische Verteilung des Merkmals XB nach n Beobachtungen

hn

1

...

b

hnA

1

hn(1,1)

...

hn(1,b)

hnA(1)

.

.

.

.

.

.

...

...

...

.

.

.

.

.

.

a

hn(a,1)

...

...

hn(a,b)

hnA(a)

hnB

hnB(1)

...

hnB(b)

n

24

In der letzten Zeile der Kontingenztafel stehen also die Spaltensummen, in der letzten Spalte

die Zeilensummen.

Für jedes h= (h(i,j))0 1 ist bezüglich wh die (zufällige) Kontingenztafel hn

multinomialverteilt mit den Parametern n, a@b und h, also hn ~ Mult(n, a@b, h)

4.32 Die Chi-Quadrat-Statistik für den Unabhängigkeitstest

Dn := Dn(X(n)) := 3 (i,j)0E[hn(i,j)-n LnA(i)LnB(j)]²/(n LnA(i)LnB(j)).

Im Vergleich zur Q-Statistik aus 4.26 wurden hier die unbekannten Wahrscheinlichkeiten

h(i,j) (= hA(i)hB(j) im Fall der Nullhypothese) jeweils durch ihre ML-Schätzwerte

LnA(i)LnB(j) ersetzt.

Eine einfache Umformung ergibt: Dn = n {3 (i,j)0E hn(i,j)²/(hnA(i)hnB(j)) - 1}.

4.33 Der verallgemeinerte Satz von Pearson

Für jedes D="q$010 gilt bezüglich wD: Dn ist asymptotisch (n64) Chi-Quadrat-verteilt mit

(a-1)(b-1) Freiheitsgraden.

4.34 Der Chi-Quadrat-Unabhängigkeitstest

Es gelte das Modell 4.31 und es sei Dn wie in 4.32..

Sei ferner " 0 +0,1, vorgegeben und sei P²(a-1)(b-1),1-" das (1-")- Quantil der Chi-QuadratVerteilung mit (a-1)(b-1) Freiheitsgraden.

Der nichtrandomisierte Test *: Qn 6{0,1} mit dem Verwerfungsbereich {Dn > P²(a-1)(b-1),1-"} ist

ein Test von H0 gegen H1 mit dem asymptotischen Signifikanzniveau " (wegen 4.33).

* heißt Chi-Quadrat-Unabhängigkeitstest.

4.35 Beispiele: siehe Vorlesung