Analysis, Design and Development of Information Systems

Werbung

Prof. Dr. rer.nat.habil. Bernhard Thalheim

Information Systems Engineering

Institute of Computer Science

Christian-Albrechts-University Kiel

Olshausenstr. 40

D - 24098 Kiel

Skript zur Vorlesung

Analysis, Design and Development of Information Systems

& Modellierung von Informationssystemen

& Web-Informationssysteme

2. Strukturierung von IS

ab SS 2012

Sonderfarben der Seiten im Skript für zusätzliches Material.

Forschung

Hintergrundinformation (auch Inhalte der Grundvorlesungen)

Zusatzliteratur und Lesestoff

1 Einführung

In den Vorlesungen werden vier zentrale Spezifikationssprachen zur Spezifikation von Informationssystemen im

Co-Design-Zugang vorgestellt: die Strukturierung und die Funktionalität auf der Grundlage des erweiterten EntityRelationship-Modellen HERM, die Verteilung auf der Grundlage der Verteilungsspezifikationsprache DistrLang und

die Spezifikation durch die Web-Informationssystem-Spezifikationssprache SiteLang.

Übungen: jeweils eine Übung zur Spezifikation der Strukturierung, zur Spezifikation der Funktionalität, zur Spezifikation der Medientypen und zur Spezifikation der Interaktivität.

Es werden die Systeme ERWin und Silverrun, sowie DBMain zur Modellierung der Strukturierung bzw. Funktionalität eingesetzt.

2 Strukturierung von Informationssystemen

Strukturierung = Struktur + statische Integritätsbedingungen (+ Modellinhärentes !!!)

HERM : higher-order entity-relationship model

EER : extended ER model (meist auch nur für die Definition der Struktur(ierung) genutzt!!!)

Bemerkung: Modell meint hier eigentlich Sprache.

Brief Survey: The Higher-Order Entity-Relationship Model (HERM).

The entity-relationship model has been extended by more than three-score proposals in the past. Some of the extensions contradict other

extensions. Within this chapter we use the higher-order (or hierarchical) entity relationship model (HERM). It is a special case of an extended

entity-relationship model (EER) e.g. [EWH85, Gog94, Hoh93, Tha00].

The higher-order ER model used in this chapter has the following basic and extended modeling constructs:

Simple attributes: For a given set of domains there are defined attributes and their corresponding domains.

Complex attributes: Using basic types, complex attributes can be defined by means of the tuple and the set constructors The tuple

constructor is used to define complex attributes by Cartesian aggregation. The set constructor allow construction of a new complex

attribute by set aggregation. Additionally, the bag, the list, and the variant constructors can be used.

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

152

Entities:

Entity types are characterized by their attributes. Entity types have a set of attributes which serve to identify the elements of the

class of the type. This concept is similar to the concept of key known for relational databases.

·

Clusters:

A disjoint union ∪ of types whose identification type is domain compatible is called a cluster. Cluster types (or variant types) are

well known in programming languages, but are often overlooked in database models, where this absence creates needless fragmentation

of the databases, confusing mixing of generalization and specialization and confusion over null values.

First-order relationships:

First-order relationship types are defined as associations between single entity types or clusters of entity

types. They can also be characterized by attributes.

Higher-order relationships:

The relationship type of order i is defined as an association of relationship types of order less than i or of

entity types and can also be characterized by attributes.

Integrity constraints:

A corresponding logical operator can be defined for each type. A set of logical formulas using this operator can

define the integrity constraints which are valid for each instance of the type.

Operations:

Operations can be defined for each type.

• The generic operations insert, delete, and update are defined for each type.

• The algebra consists of classical set operations, such as union, intersection, difference and restricted complement, and general

type operations, such as selection, map (particular examples of this operation are (tagged) nest, unnest, projection, renaming),

and pump (particular examples of this operation are the classical aggregation functions). The fixpoint operator is not used.

• Each type can have a set of (conditional) operations.

• Based on the algebra, query forms and transactions can be specified.

The extensions of the ER model should be safe in the sense that appropriate semantics exist. There is a large variety of proposals which are

not safe. Some reasons for this include higher-order or function types, such as those used for the definition of derived attributes, or the loss of

identification.

It can be observed that higher-order functions can be attached to the type system. However, in this case types do not specify sets, although

their semantics can be defined by topoi [Sch94, Gol06]. This possibility limits simplicity for the introduction of constraints and operations.

Furthermore, these semantics are far too complex to be a candidate for semantics. The ER model is simpler than OO models.

Es taucht oft die Frage auf, ob dies adäquat ist. In [HL07] wurde dazu ein Vergleich von englischen Sprachäußerungen und dem HERM vorgenommen. Eine der Tabellen dazu ist die folgende

English sentence concept HERM feature

transitive verb

relationship type

common noun

component of relationship type

adjective

attribute of component

adverb

attribute of relationship type

numerical expression

attribute of object type

preposition

role name of component

gerund

relationship type that is component of another relationship type

clause

relationship type with components

complex sentence

relationship type of order higher than 1

alternative phrase

cluster type

plural collection

type/nested attribute

“IsA” sentence

specialisation

Comparison to Chen’s original correspondences by [HL07]

Peter P.-S. Chen: English Sentence Structure and ER Diagrams, Inf. Sci. 29(2-3): 127-149, 1983

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

English

sentence

concept

transitive verb

common noun

adjective

adverb

numerical expression

gerund

clause

complex sentence

2. Strukturierung von IS

ab SS 2012

153

ER feature

relationship type

entity type

attribute of entity type

attribute of relationship type

attribute of entity or relationship type

relationship-converted entity type

high-level entity type abstracted from group of interconnected low-level entity and

relationship types

one or more entity types connected by relationship type in which each entity type can

be decomposed recursively into low-level entity types interconnected by relationship

types

Conclusions:

à EER reflects (English) sentence structures more soundly and naturally

à higher-order object types reflect dependence between sentences

à this provides justification for introduction of new ER features

à ER model does not just provide safe constructs that result in good database design, but also features that enable

good communication between designer and user

à essential to best approximate requirements

à additional EER features justified in the sense that modelling becomes more natural

à provides also a justification why the EER features exist

à higher-order object types reminiscent of nested sentence structure in natural language text

2.1 Spezifikation der Struktur von Datenbanken

eine Vorlesung (da bereits in der Vorlesung Informationssystem in Grundzügen in abweichender Form behandelt)

2.1.1 Modellierungsannahmen

• Konstruktiver Aufbau mit kompositioneller Semantik

damit dann auch induktive Sprache

(inkrementelle Modellierung als resultierende Variante des Modellierens)

Vorteil: die Semantik wird kompositional

• Abstraktionsresistenz, Verfeinerungsstrategie (scaling depending on its modes (visibility (zoom), hierarchy

(fold), manifestation (express, suppress)))

Modularisierbarkeit als Option

• Äquivalenzbegriff für Sprachkonstrukte

• rigide Trennung von Klassen und Typen, aber 1-1-Bindung von Klassen an Typen

• Abbildungseigenschaften

• Wohlfundiertheit

• Einschränkung auf Mengensemantik, keine Kollektionssemantik

• Visualisierung

• Skalierbarkeit/Modularisierbarkeit der Sprachäußerungen je nach Auffassungsmöglichkeiten

Modularisierbarkeit als Option

Modular modelling supports information abstraction and hiding by encouraging and facilitating the decomposition of systems [BM97] into components

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

154

and their modular development based on a precise definition of interfaces and the collaboration of components through which the systems are put

together. Implicit modularisation can be achieved by introduction of name spaces on signatures. Explicit modularisation offers a better understanding

of structure and architecture of systems and thus supports consideration of evolution of systems and of collaboration of systems.

Modularisation offers a number of advantages: separation of concerns, discovery of basic concepts, validation and verification of development, efficiency

of tool support, and - last but not least - scoped changes. The last advantage of modularisation is based on an explicit framing of development to a number

of elements while preserving all other elements in its current form. We model this impact by introducing name spaces on signatures.

Typically, small submachines capture smaller models that are easier to understand and to refine. Small models can better be ascertained as to whether

we need to apply refinements.

Modularization is a specification technique of structuring large specifications into modules. It is classically based on structural and functional decomposition [BS00]. We additionally consider control decomposition. Modules form a lattice of associated submachines having their own states and their

own control.

Modularisation is based on implementation abstraction and on localization abstraction. Implementation abstraction selectively hides information about

structures, semantics and the behavior of ASM concepts. Implementation abstraction is a generalization of encapsulation and scoping. It provides data

independence through the implementation, allowing the private portion of a concept to be changed without affecting other concepts using that concept.

Localization abstraction “factors out” repeating or shared patterns of concepts and functionality from individual concepts into a shared application

environment. Naming is the basic mechanism for achieving localization. Parametrisation can be used for abstraction over partial object descriptions.

We use the name space for handling localisation abstraction.

• Agentorientierte Darstellung und damit Separation für verteilte Anwendungen

A submachine consists of a vocabulary and a set of rules. In this case, any clustering of rules and of elements from the vocabulary may define a

submachine. Turbo machines [BS03] capture our notion of a submachine by encapsulating elements of the vocabulary and rules into a machine. They

hide the internals of subcomputations within a separate machine. The submachine has its own local state and its own interface.

The set of functions of each submachine can be separated into basic and derived functions. Basic functions may be static functions or dynamic functions.

Classically [BS03] dynamic functions can be classified as in(put) functions, out(put) functions, controlled or local functions that are hidden from the

environment, and shared functions that are visible to the environment. A similar classification can also be applied to basic static functions. They are

either functions only used by a its own machine or read by several environments. We thus extend the notion of shared and controlled functions to static

functions as well. We do not use derived static functions since they can be considered as syntactic sugar. We differentiate these functions according to

their role in Figure 1 which displays the functions internal for an agent machine. A similar classification can be developed for functions external to an

agent. An agent machine consists of all functions that assigned to the agent and of rules that are assigned to the agent and that use only those functions

assigned to the agent.

function/relation/location

basic

static

non-updatable

by any agent

derived

dynamic

indirectly indirectly indirectly

monitored controlled shared

out

in (monitored) controlled shared (interaction)

updatable

updatable

non-updatable updatable

by agent

by agent

by agent

by agent

controlled shared

Abbildung 1: The Kinds of Internal Functions for Agent Machines

Static functions may also be local functions. They are not updated by any submachine. [BM97] distinguish derived function to whether these functions

are monitored functions, controlled functions, or shared functions. Typically, derived functions are functions that do not exist on their own right, but

may be dynamically computed from one or more base functions. They provide a powerful and flexible information hiding mechanism. Updates made

in the base functions that affect the derived function are immediately reflected in derived functions.

We may additionally assume that derived functions are allowed to update dynamic functions. In this case, dynamic functions may be used as a security

mechanism, as an access mechanism, and as a simplification mechanism that allows to use complex derived functions in rules instead of complex

computations in rules.

• Perspektiven und Stile der Modellierung sind explizit wählbar

Different modelling perspectives can be distinguished:

1. The structure-oriented perspective focuses on structural description of the machine. Sometimes, the structure-oriented perspective is unified

with the semantic perspective. In this case, design of the structure is combined with design of invariants.

2. The behavior-oriented perspective is concerned with the behavior of the machine during its lifetime. It can be based on event approaches or on

Petri-net approaches and predicate transition systems.

3. The process-oriented perspective is concerned with the operation of the system.

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

155

The structure-oriented perspective is often used for data-intensive applications. Almost all recognized database design approaches are based on the

structure-oriented perspective. The process-oriented perspective uses approaches considered in software engineering. The behavior-oriented perspective

is a high-level descriptive approach to an integrated specification of the vocabulary and rules.

Modelling styles provide a very abstract description of a particular set of general characteristics of a model. Different constructional notations may be

useful for describing a machine. We use the Turbo machine approach for component or submachine description. Typically, the role of the components

of the system follow the rules specified by the style. The modelling style explains the structure, the abstraction and grouping of the elements. Parts of

the system may follow different modelling styles.

The style of modelling is a specification of the high level structure and organisation of system modelling. The structure describes the handling of

elements of the vocabulary, the topology or relationships between elements, the semantical limitations for their usage, and the interaction mechanism

between the elements such as blackboard, submodule calls,etc. The organisational style describes relevant local and global structures, the decomposition

strategy, and control mechanisms between parts of the machine. The organisational style is based on the architectural style. It is our aim to maintain and

to preserve the strategy over the life cycle of the system.

The perspective and the style result in strategies that are use for step-wise development of specifications. The different strategies [Tha00] based on the

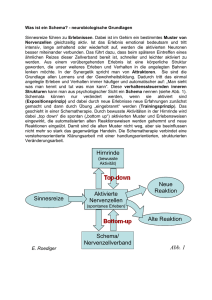

structure-oriented perspective are sketched in Figure 2.

structure-oriented strategies

¼

s

flat

(first-order)

(uncontrolled)

(one-dimensional)

ª

ª

R

q

second-order

mixed

(skeleton-based flat)

controlled

R

ª

modular

(design by modules)

R

inside-out

(by neighborhood)

1. design central type

1. design general

1. design basic modules 2. (recursion step)

module schema

with interface

(bottom-up or top-down)

design next level

1. design all

2. (iteration step)

1. design

(skeleton)

(bottom-up or

basic concepts

connect modules

top-down)

2. build more all main concepts 2. refine each module

or

design

(bottom-up or

complex concepts 2. refine concepts

design or attach

combined modules

top-down)

concept

from them

bottom-up

top-down

Abbildung 2: Structure-Oriented Specification Strategies

• Integritätsbedingungen werden anhand von Mustern definiert und eingesetzt

Invariants, e.g. integrity constraints in database applications, are used to define semantics of applications. We know different pattern for their specification:

• Operational representation of invariants incorporates invariants into the programs or rules. The invariant enforcement mechanism may be hidden

because of control conditions or to the specification of actions.

• Descriptive representation uses explicit specification and refinement obligations. These descriptions are combined with the specification of

invariant enforcement:

• Eager enforcement maintains invariants based on a scheduling mechanism for maintenance of invariants. Transactional systems are typical

scheduling mechanisms. They bind invariant enforcement to programs.

• Lazy enforcement maintains invariants in a delayed mode. Inconsistency is temporarily tolerated. This tolerance reduces some of the cost

of enforcing invariants within large structures.

• Refusal enforcement maintains invariants by rollback of all activities since the last consistent state and by executing a subset of activities.

Partially ordered runs are based on refusal enforcement.

Depending on the pattern chosen invariant handling is varies. If we choose an implicit invariant handling then any change applied to the current ASM

must explicitly consider all invariants and must be entirely aware of the effects of these. Therefore this pattern is the most inefficient for early design

phases. This pattern is however applicable during implementation if later revision is going to be based on a more general ASM.

The completeness of invariant specification is a dream that is never satisfied. Sets of invariants are inherently open since we cannot know all invariants

valid in the current application, we cannot envision all possible changes in invariant sets, and we cannot choose the most appropriate selection of

invariants from which all other invariants follow. Therefore, we use a separation into

• hard (or iron) invariants that must be preserved and which are valid over a long time in the application and

• soft invariants that can be preserved or are causing later corrections or which are not valid for a longer time in the application.

• Modellierung im Local-As-View-Ansatz

• Konzeptuelles Modell ist dann zugleich die globale Sicht

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

156

• Lokale Sichten werden mit der Schema-Algebra über dem konzeptuellen Schema als abgeleitetes Konzept

verwendet

Damit (S, V1 , ...., Vk ) als Modell, das den Anspruch erfüllen könnte, kognitiv vollständig zu sein.

Siehe Arbeit von B. Thalheim zur kognitiven Vollständigkeit der Modellierung mit einem erweiterten

ER-Modell.

• als klassischer Zugang

Alternativ könnte auch der Global-As-View-Ansatz verwendet werden.

• Damit wird eine natürlichere Form der Repräsentation gewählt.

• Damit kann auch unterschiedliche Abstraktion und Granularität verwendet werden.

• Kompromiß ist der sichtenzentrierte Entwurf.

• ((V1 , ..., Vk ), Association Constraints) als Modell-Suite (siehe B. Thalheim, A. Dahanayake)

• Man könnte hier den Komponenten-Zugang nach Thalheim/Hegner verwenden.

Unterschiedliche HERM-Annahmen je nach Abstraktionsschicht

• mit Identifikation

• mit partiellen Constraintmengen (z.B. nur ein Schlüssel)

• Schemavollständigkeitskriterium

Pragmatische strikte Unterscheidung

Wir unterscheiden in modernen Sprachen zwischen

Einführung von Variablen, Daten, die damit auch Rechte an der Modifikation und am Auslöschen mit einschließt,

Mitnutzung von Variablen, Daten, die immer eine entsprechende Koordination mit einschließt und

Mitbenutzung von Variablen, Daten etc., die keine Rechte an Modifikation und Auslöschen einschließt!

siehe auch Handbook, HERM-Kapitel

Implicit Assumptions and Inherent Constraints of DB Specification Languages.

Each language used should be based on a clear definition of structure, semantics, operations, behavior and environment. At the same time,

languages presuppose implicit assumptions and constraints. The enhanced or extended ER (EER) model might, for instance, use the following

assumptions:

Set semantics:

The default semantics of entity and relationship types are set semantics. If extended type constructors are used then their

semantics are explicitly defined.

Identifiability:

Each entity type is identifiable. Each component type needs to be labelled whenever it cannot be distinguished from

other components. In relationship types components are ordered. Their labels can be omitted whenever there is an identification. Set

semantics implies identifiability of any element in the database.

Partial Unique Name Assumption:

Attribute names are unique for each entity and relationship type. Entity type names and relationship type names are unique for the ER-schema.

Referential Integrity:

If a type is based on component types then each value for this type can only use such values in components which

exist as values in the component instance.

Monotonicity of Semantics:

If integrity constraints Φ are added to a given set of integrity constraints Σ, then the set of possible

instances which satisfy the extended set of constraints Σ ∪ Φ is a subset of the set of instances which satisfy Σ.

Resulting coincidence theorems

Mod IS

as a matter of convenience.

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

157

Storage and Representation Alternatives.

The classical approach to objects is to store an object based on strong typing. Each real-life thing is thus represented by a number of

objects which are either coupled by the object identifier or by specific maintenance procedures. This approach has led to the variety of types.

Thus, we might consider two different approaches:

Class-wise, strongly identification-based representation and storage:

Things of reality may be represented by several

objects. Such choice increases maintenance costs. For this reason, we couple things under consideration and objects in the database

by an injective association. Since we may be not able to identify things by their value in the database due to the complexity of the

identification mechanism in real life we introduce the notion of the object identifier (OID) in order to cope with identification without

representing the complex real-life identification. Objects can be elements of several classes. In the early days of object-orientation it

was assumed that objects belonged to one and only one class. This assumption has led to a number of migration problems which have

not got any satisfying solution. The association among facets of the same thing that are represented by several objects is maintained by

the object identifier.

Object-wise representation and storage:

Graph-based models which have been developed in order to simplify the object-oriented

approaches [BT99] display objects by their sub-graphs, i.e. by the set of nodes associated to a certain object and the corresponding

edges. This representation corresponds to the representation used in standardization.

Object-wise storage has a high redundancy which must be maintained by the system thus decreasing performance to a significant extent. Beside

the performance problems such systems also suffer from low scalability and poor utilization of resources. The operating of such systems leads

to lock avalanches. Any modification of data requires a recursive lock of related objects.

Therefore, objects-wise storage is applicable only under a number of restrictions:

• The application is stable and the data structures and the supporting basic functions necessary for the application do not change during

the lifespan of the system.

• The data set is almost free of updates. Updates, insertions and deletions of data are only allowed in well-defined restricted ‘zones’ of

the database.

A typical application area for object-wise storage is archiving or information presentation systems. Both systems have an update system

underneath. We call such systems play-out system. The data are stored in the way in which they are transferred to the user. The data

modification system has a play-out generator that materializes all views necessary for the play-out system.

Two implementation alternatives are already in use albeit more on an intuitive basis:

Object-oriented approaches:

Objects are decomposed into a set of related objects. Their association is maintained on the basis of

OID’s or other explicit referencing mechanisms. The decomposed objects are stored in corresponding classes.

XML-based approaches:

The XML description allows to use null values without notification. If a value for an object does not exist,

is not known, is not applicable or cannot be obtained etc. the XML schema does not use the tag corresponding to the attribute or the

component. Classes are hidden. Thus, we have two storage alternatives for XML approaches which might be used at the same time or

might be used separately:

Class-separated snowflake representation:

An object is stored in several classes. Each class has a partial view on the

entire object. This view is associated with the structure of the class.

Full-object representation:

All data associated with the object are compiled into one object. The associations among the

components of objects with other objects are based on pointers or references.

We may use the first representation for our storage engine and the second representation for out input engine and our output engine

in data warehouse approaches. The input of an object leads to a generation of a new OID and to a bulk insert into several classes. The

output is based on views.

The first representation leads to an object-relational storage approach which is based on the ER schema. Thus, we may apply translation

techniques developed for ER schemata[Tha00].

The second representation is very useful if we want to represent an object with all its facets. For instance, an Address object may be

presented with all its data, e.g., the geographical information, the contact information, the acquisition information etc. Another Address

object is only instantiated by the geographical information. A third one has only contact information. We could represent these three

object by XML files on the same DTD or XSchema.

Grundlegende Strukturbeziehungen

Modellierung muß ist auch eine Ingenieursdisziplin. Deshalb werden auch die Engineering-Annahmen des Einführungskapitels betrachtet.

The four fundamental structural relations used for construction abstraction are:

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

158

Aggregation/participation characterizing which object consists of which object or resp. which object is part of

which object.

Aggregation is based on constructors such as sets, lists, multisets, trees, graphs, products etc. It may include

naming.

Generalization/specialization characterizing which object generalizes which object or resp. which object specializes which object.

Hierarchies may be defined through different classifications and taxonomies. So, we may have a different

hierarchy for each point of view.

Hierarchies are built based on inheritance assumptions. So, we may differentiate between generalization and

specialization in dependence on whether characterization are not or are inherited and on whether transformation

are or are not applicable. Qualifications may form their orthogonal hierarchy (e.g., Bachelorette for Female and

Single and Bachelor for Male and sl Single).

Exhibition/characterization specifying which object exhibits which object or resp. which object is characterized

by which object.

Exhibitions may be multi-valued depending of the data type used. They may be qualitative or quantitative.

Classification/instantiation characterizing which object classifies which object or resp. which object is an instance

of which object.

Define/use separates definition of structures/types/objects from deployment of those.

Modes of States.

• Initial

• Ultimate

• Default

Generalisation und Spezialisierung sind besser zu unterscheiden

Aus der Enzyklopädie der Datenbanksysteme: Langfassung hier (in Enzyklopädie: Kurzfassung

Specialisation and Generalisation.

Definition 1 The generalisation and specialisation principles are main principles of database modelling. Generalisation maps or groups

types or classes to more abstract or combined ones. It is used to combine common features, attributes, or methods. Specialisation is based on

a refinement of types or classes to more specific ones. It allows to avoid null values and to hide details from non-authorised users. Typically,

generalisations and specialisations form a hierarchy of types and classes. The more general types or classes may be bound by a mapping or by

inheritance of attributes and methods from the more general one to the more special ones. Clusters of types to a type that represents common

properties and abstractions from a type are the main kinds of generalisations. Is-A associations that specialise a type to a more specific one

and Is-A-Role-Of associations that considers a specific behaviour of objects are the main kind of specialisations used in database modelling

and implementation.

Specialisation introduces a new entity type by adding specific properties belonging to that type which are different from the general

properties of its generic type. Thus, generalisation introduces the Role-Of relationship or the Is-A relationship between a subtype and its

generic type. Therefore, the constructs are different. For generalisation the generic type must be the union of its subtypes. Thus, the subtypes

can be virtually clustered by the generic type. This tends not to be the case for specialisation. Specialisation is a refinement or restriction of

a type to more special ones. Typical specialisations are Is-A and Has-Role associations. Exceptions can be modelled by specialisations. We

distinguish different kinds of specialisation:

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

159

Structural specialisation T 0 ¹St T : The structure S 0 is a substructure of S. An embedding function η exists which relates each object in

T 0 to one object in T . For instance, the tuple structure (A, B, C) is a substructure of (A, B). In addition, structural specialisation requires that

according to η the class T 0C of the type T 0 is a subclass of T C , i.e., we require that for each o0 ∈ T 0C an o ∈ T C exists such that o = η(o0 ).

The relationship among objects can be supported by identifiers or keys. In this case the subtype uses the identifier and keys and provides

additional attributes and methods.

Semantic specialisation T 0 ¹Se T : The logical language of T 0 can be mapped onto the logical language of T in such a way that the

constraints on T 0 are stronger than the constraints on T , i.e., a mapping θ from LT 0 to LT exists such that θ(Σ0s ) |= Σs . The constraints used

in T 0 are stronger than those used in T .

The constraint sets of types are partitioned into static constraints Σs (applicable to elements of the type sets) and dynamic constraints Σd

(applicable to operations of the types).

The strong semantic specialisation T 0 ¹St,Se T is defined on the basis of both mappings η and θ whereas θ is created using η as the

mapping primitive.

Pragmatical specialisation T 0 ¹P r T : Objects may be used in different contexts. Pragmatical specialisation allows to separate the

different usage of objects in contexts. The identification of objects is not changed. Therefore pragmatical specialisation can be based on

structural specialisation. We require that the additional properties of objects in T 0C represent the additional properties that context requires.

Operational specialisation T 0 ¹Op T : The operations defined for T can also be applied to T 0 objects.

The strong operational specialisation T 0 ¹St,Op T requires that mappings η : Struc0 → Struc, θ : LT 0 → LT and ζ : Ops0 → Ops

exist which commute, i.e., for any n-ary operation o0 from Ops and arbitrary objects o01 , ..., o0n from T 0 t the equality η(o0 (o01 , ..., o0n )) =

ζ(o0 )(η(o01 ), ..., η(o0n )) and ζ(θ(Σ0d )) |= Σd .

Type specialisation T 0 ¹T ype T requires strong operational and strong semantic specialisation.

Is-A specialisation T 0 Is − A T requires structural and strong semantic specialisation. Is-A relationship (types) are typical semantical

specialisations. We require that the properties of objects in T 0C specialise those in T C or are not applicable to T .

Is-A-Role-Of specialisation T 0 Is − A − Role − Of T requires structural, pragmatical and strong semantic specialisation. We require that

the additional properties of objects in T 0C represent the additional properties that context requires.

Generalisation can be treated in a similar manner and is based either on abstraction or on grouping. The cluster construct of the

extended ER model is used to represent generalisations. Generalisation tends to be an abstraction in which a more general (generic) type is

defined by extracting common properties of one or more types while suppressing the differences between them. These types are subtypes

of the generic type. New types are created by generalizing classes that already exist. Typical such feature abstractions are the separation or

extraction of constructors, destructors, and identification from the rest of the type. Similarity of attributes or methods may be used for the

development of more abstract ones. Grouping allows to combine types that partially share properties or methods into a new type that represents

the commonalities.

We thus consider structural combination, semantical combination, and pragmatical combinations of types into a more general one.

Structural combination typically assumes the existence of a unifiable identification of all types. Typically unambiguity is assumed, i.e. the

combination is based on a disjoint union of the types. Semantical combination allows the disjunction of types through the linear sum of

semantics. Pragmatical generalisation is based on building collections whenever applications require a consideration of commonalties.

Abstraction is the opposite of refinement. In this case, generalisation can been seen as the inverse of specialisation. The main difference is

however which of the types has a practical relevance or importance. Kernel types can be generalised to more general types by abstraction from

some attributes or methods, by consideration of generic methods with parameters that are mapped to the kernel type methods by instantiating

parameters or by introduction of more general attributes.

Generalisation and specialisation are supported by inheritance of properties and methods. It helps to factor out shared specifications and implementations. Type inheritance is defined on the basis of the definition of types and can be further partitioned into aggregation/decomposition inheritance, classification/instantiation inheritance and generalisation/specialisation inheritance. Localisation inheritance is

based on localisation abstraction. Naming, parametrisation and binding are basic mechanisms to extract repeating or shared patterns. Implementation inheritance is concerned with the encapsulation and hiding of types. A typical kind of implementation inheritance is that of the

operational environment of a type. Interface inheritance or view inheritance can cause some confusion since these can reverse other inheritance

approaches, e.g. inclusion inheritance. Object-oriented databases allow four different kinds of inheritance: Substitution inheritance, inclusion

inheritance, constraint inheritance, and specialisation inheritance,

Specialisation and generalisation are based on the concept of refinement. We may use refinement steps such as refinement through instantiation replacing types by partially instantiated, refinement through separation using decomposition operators enabling in vertical or horizontal

decomposition, refinement through specialisation specializing types to structurally, behaviorally or semantically more specific subtypes, and

refinement through structural extension extending types by other components, additional semantical constraints or functions.

B. Thalheim. Entity-relationship modeling – Foundations of database technology. Springer, Berlin, 2000.

J. H. Ter Bekke. Semantic data modelling. Prentice-Hall, London, 1992.

J. C. Mitchell. Type systems for programming languages. In J. Van Leeuwen, editor, Handbook of Theoretical Computer Science,

Vol. B - Formal Models and Semantics, pages 365–458. Elsevier, Amsterdam, 1990.

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

160

Modellierungsstil im HERM

Aus den Annahmen heraus können wir uns einen spezifischen Modellierungsstil leisten:

Mengensemantik als präferierte Semantik obwohl auch eine Listensemantik oder eine Referenzsemantik nicht ausgeschlossen ist

Modularisierung innerhalb der Spezifikation als eine strukturelle Separation von Aspekten

Bevorzugung der struktur-orientierten Spezifikation gegenüber der prozeß-orientierten Spezifikation

Inhärente Unvollständigkeit der Spezifikation wird toleriert.

Agenten-orientierte Spezifikation für verteilte Anwendungen mit expliziter Separation der Einheiten des gesamten Namensraumes der Modelle in

• Input-Einheiten

• Sharing-Einheiten

• Control-Einheiten und

• Output-Einheiten

IS als Transaktionssysteme mit resultierender Steuerung und Ableitbarkeit von Informationen aus Daten

anstatt eines prozeduralen Systemes

Resultierende Annahmen.

• Grunddatentypen werden als unstrukturiert vorausgesetzt

in OLAP-Anwendungen ist dies nicht mehr aufrecht zu erhalten!!!!!!

• Pragmatik der Typeneindeutigkeit für jede Einheit

z.B. Typen sind entweder Attribut- oder ... Cluster-Typen

• Eine linguistische Semantik der Namen für Einheiten kann verwendet werden.

Es wird dazu ein Stil der Benennung im Vornherein vereinbart und dann eingehalten.

Wir verwenden damit für alle Namen eine Minisemantik.

• Es wird eine Pragmatik für die Repräsentation zugelassen und vorher vereinbart.

• Wir unterscheiden explizit zwischen Rolle und Objektexistenz.

Kern-Objekte sind in der Existenz unabhängig und werden durch Entity-Typen dargestellt.

An object is a thing that has the potential of stable, unconditional physical or mental existence.

Existence is derived from ‘be’, ‘have being’, ‘continue to be’. Existence means to stand out, to show

itself, and have a identifiable, distinct uniqueness with the physical or mental realm.(D.Dori, Websters

dictionary)

2.2 HERM-Strukturen

Abstrakter Datentyp mit allen Eigenschaften der Grunddatentypen

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

Finiteness

Finite

Infinite

2. Strukturierung von IS

Granularity

Discrete

Continuous

Discrete

Continuous

Textual

Text-enumerated

-

ab SS 2012

Expression

Symbolic

Symbol-enumerated

Symbol-floating-enumerated

-

161

Numeric

Integer-enumerated

Floating-enumerated

Integer

Floating-point

Eine Sprache zur Beschreibung der Strukturierung von Datenbank-Anwendungen verfügt über Konstrukte zur

Darstellung der Struktur einer Anwendung. Falls diese Sprache nicht-zyklisch und induktiv aufgebaut ist, ist damit

auch eine Einbettung in die Sprache der Prädikatenlogik (der ersten Stufe) gegeben. Deshalb lassen sich dann statische Integritätsbedingungen als Formeln der Prädikatenlogik mit einer Standardinterpretation angeben. Mit der

Sprachkonstruktion und mit Annahmen aus dem Umfeld werden implizite Integritätsbedingungen aufgenommen. Die

Sprache zur Beschreibung der Strukturierung von Datenbanksystemen wird genutzt, um diese mit einem sogenannten

Datenbank-Schema zu beschreiben. Inhalte eines statischen Modelles sind daher:

Strukturen einer Anwendung,

Statische Integritätsbedingungen einer Anwendung (meist für die zusätzliche Beschränkung evt. in einer Anwendung vorkommender Daten) und

Common-sense-Annahmen (über das Modell, die Modellierungsart, über die Interpretation der Daten etc.).

Damit wird das Wissen über die statischen Gesichtspunkte einer Anwendung modelliert durch:

Die Spezifikation der Struktur in Abhängigkeit vom Typensystem mit der Spezifikation des Seienden (entity), der

Beziehungen (relationship) und der Eigenschaften (Attribute).

Dinge stehen in Beziehung bzw. besitzen Eigenschaften, die klassifiziert werden durch eine Rolle oder durch

Klassenbildung.

Die Gesamtheit der Dinge wird unter Berücksichtigung der Beziehungen untereinander modelliert:

• Aussonderung (Separation/Spezialisierung),

• Verallgemeinerung (Generalisierung von Gemeinsamkeiten) und

• Aggregation (zur Darstellung komplexerer Daten mit entsprechenden Operationen).

Die Spezifikation der statischen Semantik, d.h. durch einschränkende Bedingungen für wirklichkeitsgetreue Nachbildung der Anwendung wie

• die eindeutige Bestimmung aller Objekte durch Schlüsselbedingungen,

• die Hierarchie der Objekte (Aussonderungsbedingungen (specialization, IsA), Verallgemeinerungsbedingungen (partition constraints, uniqueness constraints))

• und Bedingungen für Beziehungsklassen wie die folgenden:

• Darstellung eines funktionalen Zusammenhangs (viele-eins-Bedingung),

• Bedingungen zur Assoziation mit Komponentenobjekten (Seinsbedingung (existence constraint))

und

• Verweisbedingungen auf Objekte der Komponentenklassen,

sowie

• allgemeine Bedingungen (inhärente Bedingungen des Modells) wie die folgenden:

• Gesamtheitsregel (universe of discourse)

• Verneinungsregel

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

162

Sichten und abgeleitete Begriffe sind erschließbare Objekte und werden durch Anwendung von Spezifikationen aus

den Objekten der Datenbank erzeugt.

Das allgemeine Vorgehen der statischen Datenbankmodellierungssprachen läßt sich somit wie folgt charakterisieren:

• Typen sind über ihre Typausdrücke definiert. Den (freien) Variablen werden wiederum Typen zugeordnet.

• Die Zuordnungsvorschrift für Typausdrücke kann sowohl hierarchisch als auch zyklisch sein. Wählt man

eine zyklische Struktur, dann sind meist nur Topoi-Semantiken geeignet. Wählt man hierarchische

Strukturen, dann kann meist eine Mengensemantik noch garantiert werden.

• Typen haben eine assoziierte statische Semantik.

• Typen haben Operationen zu ihrer Manipulation und Veränderung. Man kann diese Operationen generisch

definieren, wenn die Typenstruktur hierarchisch aufgebaut ist. Einige Operationen können auch Prädikate

sein.

A type constructor is a function from types to a new type. The constructor can be supplemented

• with a selector for retrieval (like Select ) with a retrieval expression and update functions (like Insert,

Delete , and Update ) for value mapping from the new type to the component types or to the new type,

• with correctness criteria and rules for validation,

• with default rules,

• with one or several user representations , and

• with a physical representation or properties of the physical representation.

• Klassen sind Typen zugeordnet.

• Sie stellen “Container” für die Objekte des jeweiligen Typs dar.

• Die assoziierte statische Semantik der Typen muß zu jedem Zeitpunkt für eine Klasse erfüllt sein.

• Die Operationen der Typen werden auf Klassen ausgeführt.

Wir bezeichnen Typen mit ihrem Namen, z.B. T und die zugehörigen Klassen mit einer Annotation zum Typennamen, z.B. T C (C steht für Klasse).

Es sind verschiedene Modelle möglich. Jedes Modell ist durch eine Menge von inhärenten Bedingungen gekennzeichnet. Jeder benutzte Typ hat neben Konstruktor, Selektoren (für Retrieval) und Updatefunktionen, Korrektheitskriterien, default-Regeln auch eine Benutzerrepräsentation und eine physische Repräsentation.

Günstig ist eine graphische Repräsentation.

Eines der populärsten Modelle ist das Entity-Relationship-Modell. Wir erweitern dieses Modell zu einem

Higher-Order Entity-Relationship-Modell (HERM).

2.2.1 Attribut-Typen

können einfache oder auf der Grundlage von Konstruktoren wie Mengenkonstruktor, Tupelkonstruktor, Listenkonstruktor, Multimengenkonstruktor induktiv konstruierte komplexe Attribut-Typen sein. Sie werden induktiv definiert:

Basis-Datentypen sind parametrisierte Typen T = (dom(T ), ops(T ), pred(T )) des DBMS. Sie sind gegeben

durch eine Bezeichnung T (evt. auch mit Abkürzung), einen Wertebereich dom(T ), eine Menge von Funktionen ops(T ) und eine Menge pred(T ) von Prädikaten.

Oft wird auch der Basis-Datentyp mit einem Informationstyp assoziiert.

Ein Beispiel ist der Typ der ganzen Zahlen in der 4-Byte-Repräsentation

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

163

integer := (IntegerSet4Byte , {0, s, +, -, *, ÷, }, { =, ≤ }) mit der Nachfolgefunktion s .

Basis-Datentypen verfügen neben dem Wertebereich auch über Funktionen und Prädikate. Sie sind außerdem

durch eine Reihe von Eigenschaften eingeschränkt, die im Datenbanksystem zu beachten sind und oft im Entwurf übersehen werden:

• Die Präzision und Genauigkeit sind ggf. für Typen wie REAL eingeschränkt.

• Die Granularität von Daten kann sehr unterschiedlich sein. Die Skalierung von Datentypen kann sich

ggf. auch auf die Funktionalität auswirken.

• Datentypen verfügen nur ggf. über eine eigene Ordnungsbeziehung.

• Datentypen verfügen ggf. über eine Klassifikation innerhalb der Daten des Wertebereiches. Diese Klassifikation kann einfach oder mehrfach hierarchisch, analytisch oder synthetisch, monothetisch oder polythetisch und ein- oder mehrdimensional sein.

• Datentypen können über unterschiedliche Präsentationsformen verfügen. Das Format umfaßt Länge und

Größe.

• Datentypen können auf unterschiedliche Art abgespeichert werden.

• Datentypen verfügen über eigenständige Default- und Nullwerte.

• Datentypen können durch Casting-Funktionen aufeinander abgebildet werden.

• Datentypen sind bestimmten Anwendungen und Arbeitsgebieten zugeordnet.

• Die Funktionen und Prädikate lassen unterschiedliche Berechnungen zu, die sich auf die Erfassung, Berechnung, Algorithmen etc. auswirken.

• Bestimmte Funktionen, wie z.B. der Durchschnitt, sind evt. anders oder gar nicht definiert.

• Datentypen sind oft mit Maßeinheiten ausgewiesen, womit auch Berechnungen unterlegt werden müssen.

Basis-Datentypen sind meist auch in einem Typenverband geordnet.

Neben den Basis-Datentypen des DBMS kann auch eine Anwendung über eigene Basis-Datentypen verfügen.

Wir können z.B. den Typ varnumbersequence20 zur Darstellung von Telefonnummern mit einer angepaßten

Ordnungsbeziehung und ohne Unterdrückung führender Nullen einführen. Analog kann ein Typ EmailTyp oder

URL eingeführt werden.

Kind of data type

extension based

absolute

ratio

intension based

nominal

ordinal

rang

interval

Natural order

Natural zero

Predefined functions

+

+

+/+/-

+/+(type dependent)

+

+

+

+

-

(-) (except concatenation)

(+)(e.g., concatenation)

Example

number of boxes

length, weight

names of cities

preferences

competitions

time, space

Tabelle 1: Data types and their main canonical assumptions

Attribut-Typen werden über einem Basis-Datentypen-System und einem Markierungssystem L für Attributnamen

induktiv ausschließlich durch die folgenden beiden Regeln definiert:

• Ein Attribut-Typ ist für eine Markierung A und einen Basis-Datentyp durch einen Ausdruck A :: T

gegeben. Der Wertebereich dom(A) des Attribut-Typs ist der Wertebereich des Basis-Datentyps. Der

Wertebereich des leeren Datentyps λ besteht aus ⊥.

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

164

• Sind X1 , ..., Xn , Y Attribut-Typen und A, B, C, D Markierungen, dann sind A(X1 , ..., Xn ) (Tupel- oder

Produkt-Konstruktor), A{Y } (Mengen-Konstruktor), A < Y > (Listenkonstruktur), A[Y ] (Konstruktor

für optionale Elemente), A{| Y |} (Konstruktor für Multimengen).

Die entsprechenden Wertebereiche sind durch Anwendung der Konstruktion gegeben, z.B.

dom(A(X1 , ..., Xn )) = dom(X1 ) × ... × dom(Xn ) und dom(A{Y }) = 2dom(Y ) .

Markierungen können auch weggelassen werden.

Beispiele von komplexeren Attributen sind

Name (Vornamen<(Vorname :: varstring15 , Benutzung :: string1)>,

Familienname :: varstring30, [Geburtsname :: varstring30,]

·

[Titel:{AkademischeTitel :: varstring10 } ∪ FamilienTitel :: varstring10])

Kontakt (Tel({dienstl :: varnumbersequence20 }, privat :: varnumbersequence20),

email :: emailType, ...)

Geburtsdatum :: date .

Attribute können in einer verkürzten Notation verwendet werden, wenn dies eindeutig im Schema bleibt. Das Attribut

Kontakt ist z.B. dann auch ohne seine Bestandteile verwendbar.

Attribute sind hierarchisch strukturiert wie - im Falle des Namens einer Person - der Baum in Bild 3 zeigt. Diese

Name

?

( ... )

z

9

Vornamen

?

< ... >

?

( ... )

)

Vorname

ª

Familienname

?

varstring30

q

Benutzung

?

string1

[

... ]

?

Geburtsname

?

varstring30

z

9

... }

?

AkademischeTitel

?

varstring10

{

?

varstring15

[ ... ]

?

Titel

·?

∪

z

Familientitel

?

varstring10

Abbildung 3: Semi-strukturiertes Attribut Name

hierarchische Struktur ermöglicht auch Elemente auszuzeichnen, z.B. mit der Eigenschaft Element eines Schlüssels

zu sein. So kann z.B. zum Schlüssel das Teilattribut

Name (Vornamen, Familienname, [Geburtsname ])

hinzugenommen werden, wobei wir als Abkürzungsregel benutzen, daß mit dem Nennen eines Bezeichners auch der

damit verbundene Teilbaum mit übernommen wird, z.B. für Vornamen auch die gesamte Teilstruktur Vornamen<(Vorname

:: varstring15 , Benutzung :: string1)> .

Kontrollfrage: Ist richtig Plz:String oder Plz:Number ?

2.2.2 HERM-Typen

werden induktiv aufeinander basierend definiert.

Grundlagen aus der Theorie der Informationssysteme

Wir unterscheiden zwischen der formalen Definition und der graphischen Repräsentation. Die graphische Darstellung kann unterschiedlichen

Paradigmen folgen.

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

165

Begründung: Da die Werkzeuge zum Datenbank-Entwurf meist einschränkend sind bei der graphischen Darstellung, sollte man sich hier die unterschiedlichen

Darstellungsformen erschließen und parallel benutzen.

Allgemeiner Definitionsrahmen für Typen: für korrekte Separation wird verwendet

• T $ (componT ; identifT ; integrityT )

Die drei Elemente eines Typen (componT ; identifT ; integrityT ) können als Folge definiert werden,

wenn man die Separation durch das Semikolon benutzt.

• Wird eine Folge verwendet, dann kann auch die Reihenfolge der Elemente für die Annotation verwendet

werden.

• Oft wird anstatt $ auch einfach das Gleichheitszeichen verwendet. Dies ist eine Form der Bezeichnungsökonomie, hat aber nichts mit der mathematischen Gleichhet zu tun.

• alternativ aber weniger korrekt T $ (componT , identifT , integrityT )

Verwendung von Marken ist für alle Typen zugelassen.

I.a. wird dazu die Form Marke:Bezeichner gewählt. Dies erlaubt dann auch die Marke als Abkürzung

oder alias zu verwenden.

Unique-Name-Assumption für alle Bezeichner des Schemas, d.h. alle Entity-, Relationship- und Cluster-Typen,

sowie für Komponenten der Typen selbst. Ansonsten wird eine Marke notwendig.

Alternativen in der Darstellung

Wir verwenden - wo immer es möglich ist - das Kartesische Produkt als Typenkonstruktoren.

Begründung: Die Darstellung im Stile der funktionalen Programmierung mit Funktionen hat sich nicht bewährt und wurde in den 1980ern verworfen.

Entity-Typ: Eine Seiendenklasse (Objektklasse) (Entity-Klasse im weiteren) wird durch einen Entity-Typ dargestellt.

Ein Entity-Typ besteht aus einer nichtleeren Folge von Attributen und einer Menge von statischen Integritätsbedingungen. Der Primärschlüssel wird direkt durch Unterstreichen der Attribute angegeben. Ist die Menge der

statischen Integritätsbedingungen leer, dann kann sie auch weggelassen werden. Eine Klasse von der Struktur

des Entity-Typs ist gültig, falls alle Integritätsbedingungen gelten. Wir folgen der klassischen Notation, bei

der ein Entity-Typ mit einer Definitionsgleichung dargestellt wird. Zum Beispiel ist ein Person-Typ spezifiziert

durch

·

Person $ (Name, Adresse, Kontakt, GebDatum, PersNr : StudNr ∪ MitarNr, ..., ∅)

mit einer Folge von Attributen. Markierungen sind als solche ausgewiesen.

Ein Entity-Typ wird durch ein Rechteck graphisch repräsentiert.

Eine Entity-Klasse besteht aus einer Menge von Objekten vom Entity-Typ, die die statischen Integritätsbedingungen des Entity-Typen erfüllt.

Hier verwendete Annahmen:

Wir definieren die Klasse als eine

Menge. Multimengen-Semantik wird z.B. im relationalen Modell für Anfragen verwendet. Dort ist die

Multimenge relativ einfach beherrschbar. Wird dagegen ein paralleler Zugriff für unterschiedliche Benutzer erlaubt, dann muß ein explizites

Konzept des sharing eingeführt werden.

Begründung: Kollaboration kann über das 3C-Modell (siehe meine Publikationen) definiert werden. Der sehr komplexe und zugleich sehr schwer zu

realiserende Teil des 3C-Modelles ist die Koordination. Man kann hier Verträge von Benutzern verwenden. Eine Spezifikation von Anwendungen wird

dabei allerdings viel zu komplex.

Zum Beispiel ist das folgende Objekt mit dem Identifikator β

β : ((<(Karl,z),(Bernhard,r)>, Thalheim, {Prof., Dr.rer.nat.habil., Dipl.-Math.}),

BTU Cottbus, (({ +49 355 692700, +49 355 692397}, +49 355 824054),

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

166

[email protected]), 10.3.52, 637861)

vom Entity-Typ Person, wobei mit ‘z’ der Zusatzname und mit ‘r’ der Rufname bezeichnet wird.

Darstellung im Diagramm durch ein Rechteck mit dem Namen des Typen als Bezeichner und ggf. den Attributen als Annotationen am Rechteck.

Alternativ kann man auch die UML-artige Notation verwenden mit einer Liste der Attribute innerhalb

eines Rechteckes.

Unterschied zur Vorlesung Informationssysteme (4. Semester)

Im Diagramm nutzen wir einen Typen mit annotierten Attributen. Man könnte auch noch Kreise um die Attribute ziehen.

Begründung: Dies ist aber unnötigt. Die Diagramme werden unübersichtlicher.

Hier verwendete Annahmen:

Ein Entity-Typ hat mindestens eine Komponente, die Sinn in der Anwendung macht.

Begründung: Künstliche, vom System erzeugte Identifikation macht für einen Anwender weder Sinn für das Retrieval noch für die Modifikation. Sie

ist ein bequemes und zugleich sehr mächtiges Instrument der Implementation.

Unterschied zur Vorlesung Informationssysteme (4. Semester)

Wir verwenden nur eine interne Identifikation über Komponenten des Entity-Typs. Schwache Entity-Typen sind nicht zugelassen.

Begründung: Im Buch [Tha00] wird ausführlich begründet, warum schwache Typen zu schlechten Schemata führen, in eigenartiger Se-

mantik resultieren und auch mit dem higher-order Relationship-Typ vollständig überflüssig sind.

Unterschied zur Vorlesung Informationssysteme (4. Semester)

Wir vermeiden eine ständige Einführung eines Identifiers. Diese Attribut sollte bei der konzeptionellen Modellierung nur dann

eingeführt werden, wenn dies erforderlich ist.

Begründung: Der Identifier ist ein logisches Konzept. Ansonsten erfordert er eine Extra-Verwaltung, die ein Schema verschlimmbessert.

Hinzu kommt der Albtraum, den wir für objekt-orientierte Schemata in aller Problematik kennenlernen mußten.

Grundlagen aus der Theorie der Informationssysteme

Konzeptionelle Modellierung orientiert sich an echten, in der Anwendungswelt sinnvollen Konzepten. Künstliche, der Implementation geschuldete

Konstrukte sind strikt zu vermeiden, wenn man den Benutzer nicht verwirren oder von der Anwendung fernhalten möchte.

Begründung: Die Theorie der relationalen Datenbanken hat sich stark an den ersten Systemrealisierungen orientiert und dabei die dort erfolgten Annahmen einfach als ‘gottgegeben’ akzeptiert. Solche Annahmen sind meist nicht mehr hinnterfragt worden. Sie bedürfen jedoch einer Revision unter

modernen Gegebenheiten.

Grundlagen aus der Theorie der Informationssysteme

Die Identifikation kann über minimale Schlüssel definiert werden. Es ist hier nicht nur der Primärschlüssel von Interesse, sondern auch weitere

Schlüssel, die in einer Anwendung Sinn machen.

Begründung: Man betrachte einmal den Typ Lehrstuhl, der sowohl über den Namen (mit ggf. Zusätzen) als auch die Kostenstelle als auch den Raum

oder andere Kantaktformen identifizierbar ist, wobei die spezifische Identifikation für unterschiedliche Assoziationen dann auch benötigt wird.

Einfacher Relationship-Typ: Ein Relationship-Typ (erster Ordnung) besteht aus einer nicht-leeren Folge von EntityTypen, einer Menge von Attributen und einer Menge von statischen Integritätsbedingungen. Eine Menge von

der Struktur des Relationship-Typen ist eine gültige Menge, wenn sie den statischen Integritätsbedingungen

genügt. Elemente können markiert sein.

Ein Beispiel sind die Relationship-Typen

InGruppe = (Person, Gruppe, { Zeit(Von [,Bis]), Funktion }, ∅ )

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

167

DirektVoraussetz = (setztVoraus: Kurs, vorausges : Kurs, ∅, ∅ )

Professor = (Person, { Berufungsgebiet }, ∅ ) .

Ein Relationship-Typ wird mit einer Raute graphisch repräsentiert. Wir erlauben auch optionale Komponenten

von Relationship-Typen, solange eine Identifikation über die obligatorischen Elemente definiert ist.

Alternativen in der Darstellung

Eine alternative Form ist die IDEF-Notation, bei der Relationship-Typen mit Rechtecken, die abgerundete Ecken haben, verwendet werden. Diese

Form erlaubt auch eine einfache Umformung von Entity-Typen zu Relationship-Typen oder auch die Objektifizierung von Relationship-Typen.

Begründung: Es wird oft argumentiert, daß die IDEF-Darstellung die natürlichere Form sei. Sie wird auch von fast allen Werkzeugen unterstützt. In

der Forschungsliteratur hat sich jedoch die ursprüngliche Form durchgesetzt. Dem folgt auch die Lehrbuchliteratur. Ein survey der DAMA zeigt jedoch,

daß diese Form in der Praxis weit verbreitet ist. Die Verbreitung hat sich nicht mit UML geändert, die auch sowohl die Raute als auch das abgerundete

Rechteck erlaubt.

Ein Objekt eines Relationship-Typs ist ein Tupel, das zu den jeweiligen Elementen auf die entsprechenden Objekte der Klasse der Elemente durch Angabe von identifizierenden Werten (Identifikator bzw. Primärschlüssel

bzw. anderer Schlüssel) verweist und Werte für die Attribute des Relationship-Typs besitzt.

Eine Relationship-Klasse besteht aus Objekten des Relationship-Typs, die den statischen Integritätsbedingungen

genügen.

z.B. sind Objekte der Typen Professor, InGruppe und DirektVoraussetz

Profβ : ( 637861, Datenbank- und Informationssysteme )

Senator3β : ( 637861, Senat, (1995,1998), Dekan)

Senator5β : ( 637861, Senat, (2000), Vorsitzender)

VorausDBIVHaupt: (DBIV, DBI) .

Cluster-Typ Eine disjunkte

LVereinigung von bereits konstruierten Typen wird als Cluster-Typ bezeichnet. Ein ClusterTyp wird mit einem -Zeichen graphisch repräsentiert.

Beispiele sind durch folgende Typen gegeben:

·

·

JuristischePerson = Person ∪ Betrieb ∪ Vereinigung

·

·

Gruppe = Senat ∪ Arbeitsgruppe ∪ Vereinigung,

die den Typ JuristischePerson bzw. Gruppe als disjunkte Vereinigung von anderen Typen einführen.

Cluster-Typen können weitere Attribute besitzen. In diesem Fall wird der Cluster-Typ durch eine Raute mit den

Attributen repräsentiert.

Objekte von Cluster-Typen sind analog zu den Objekten anderer Typen durch entsprechende Zuordnung zu den

Element-Typen eingeführt. So können z.B. die Objekte β , LIM, CottbusNet e.V. juristische Personen sein.

Alternativen in der Darstellung

Cluster-Typen werden oft nicht zugelassen, so daß dann für alle Typen eine Mixvererbung geführt werden muß.

Begründung: Die Generalisierung ist i.a. nicht die Umkehrung der Spezialisierung. Neben der Mixvererbung sind auch die virtuelle und partielle Vererbung von Interesse und deshalb nicht von vornherein auszuschließen.

¨

Uber

die Nutzung der disjunkten Vereinigung hinaus kann auch der Cluster-Konstrukt für alle algebraischen Operationen genutzt werden.

Ein Beispiel aus dem Titelbild der 7. Auflage des Buches von A. Kemper/ A. Eickler dazu:

The following three schemata are equivalent to each other and are tightly associated with each other by transformation mappings. A typical example of these two schemata is given in

Figure 4. Students enrolled in a course may be examined by docents that give the course.

The optimised conceptual schema can be easily mapped to a structure that supports smooth operating of the database. The sophisticated HERM schema uses the

Θ-join for the correct

building of the relationship type that records downloads. The optimised conceptual schema is equivalent to this schema due to the equivalence of the join decomposition and the inclusion

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

Θ := Enrolls.Course 1P rovides.Course

Examines.Enrolls.Course

= Examines.GivenBy.Course

Course

¾

Enrolls

-

GivenBy

6

Docent

6

¾

168

Course

¾

GivenBy

6

Examines

Enrolls

?

?

Student

Student

The simple HERM schema

-

Docent

6

¾

Θ

Examines

The sophisticated HERM schema

The representational conceptual schema

-

Enrolls

⊇

Course

¾

6

GivenBy

⊆

Student = ({ StudId, ... }, ...),

Course = ({ CourseID,... }, ...),

Docent = ({ DocentID,... }, ...),

Enrolls = ({ StudId, CourseID,... }, ...),

Provides = ({ CourseID, DocentID,... }, ...),

Examines = ({ StudId, DocentID, CourseID,... }, ...)

Examines[StudId, CourseID]

⊆ Enrolls[StudId, CourseID]

- Docent

Student ¾

Examines

Examines[CourseID, DocentID]

⊆ Provides[CourseID, DocentID]

The “optimized” conceptual schema

The logical relational schema

The association between the “optimised” schema and the relational schema

?

?

Abbildung 4: The ‘Janus’ schema cluster for conceptual modelling

constraints [Tha00].

Unterschied zur Vorlesung Informationssysteme (4. Semester)

Relationship-Typen werden im Stile der funktionalen Programmierung als Funktion des Namen auf die Rollen der Komponenten

eingeführt. Ggf. sind auch Attribute erlaubt.

Begründung: Es ist damit eine Defintion der Rollen unbedingt erforderlich. Rollen sind jedoch eine spezifische Form der Spezialisie-

rung für die Komponenten und sollten nur dort verwendet werden, wo dies erforderlich ist.

Relationship-Typ höherer Ordnung: Ein Relationship-Typ i-ter Ordnung besteht aus einer nicht-leeren Folge von

Entity- und Relationship-Typen einer Ordnung von maximal (i-1), wobei ein Typ (i-1)-ter Ordnung sein muß,

einer Menge von Attributen und einer Menge von statischen Integritätsbedingungen. Eine Menge von der

Struktur des Relationship-Typen ist eine gültige Menge, wenn sie den statischen Integritätsbedingungen genügt.

Eine Identifikation kann sowohl aus den Elementen bestehen als auch aus den Attributen.

Unterschied zur Vorlesung Informationssysteme (4. Semester)

Es wird oft für Relationship-Typen höherer Ordnung der Zugang der Objektifizierung genutzt. Dieser Zugang ist äquivalent zu

dem hier genutzten. Er führt jedoch ein weiteres Element im Diagramm ein. Es wird um die Raute ein Rechteck gezogen, so daß

ein weiteres Element entsteht.

Begründung: Man sollte im Diagramm Konstrukte so sparsam wie möglich verwenden. Alles andere verwirrt nur. Hinzu kommt als

Fehler- und Verwirrungsproblem das genaue Anbringen der Attribute an den Typen. Attribute gehören dann wohl eher zum ursprünglichen Typ und nicht zum objektifiziertem Typ.

Dieser Zugang erlaubt keine Einführung von Clustern.

Alternativen in der Darstellung

Besonders unübersichtlich wird die Objektifizierung über Teilschemata z.B. für einen Relationship-Typen mit seinen Komponenten.

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

169

Begründung: Man verliert sich sehr schnell in solchen Diagrammen.

Mit der expliziten Einführung von Typen höherer Ordnung werden objektifizierte Typen überflüssig!

Es ist mitunter vorteilhaft, über Relationship-Typen höherer Ordnung zu verfügen, wie Bild 5 zeigt. Im oberen

Student’

1

*

6

eingeschr.

in

®9

Vorlesung

+

q

?

Raum

Semester

Professor’

¾

Kurs

¾

Student’

Professor’

*

6

eingeschr.

in

9

Semester

DirektVoraussetz

- Vorlesung

+

?

Raum

¾

Kurs

¾

DirektVoraussetz

Abbildung 5: HERM Diagramme mit und ohne Relationship-Typen höherer Ordnung

Diagramm muß eine zusätzliche Integritätsbedingung zwischen den Typen eingeschriebenIn und Vorlesung

gelten, weil man sich nur dann einschreiben kann, wenn diese Vorlesung existiert.

Ein etwas komplexeres Beispiel ist das Beispiel in Bild 6. Eine Lehrveranstaltung, z.B. eine Vorlesung, wird

durch einen Lehrstuhl angeboten. Dieses Angebot kann angenommen werden. Dann wird die Lehrveranstaltung

geplant. Wird sie auch gehalten, dann werden die aktuellen Daten in der Klasse zum Typ GehalteneLehrveranst

gespeichert. Der Typus und die Raumzuordnung können sich vom Vorschlag zum Plan und für den Raum

vom Plan zu den gehaltenen Lehrveranstaltungen ändern. Ein Vorschlag für eine Lehrveranstaltung wird durch

Berechtigte eingetragen. Eine Person ist für die Lehrveranstaltung verantwortlich. Eine Lehrveranstaltung kann

für mehrere Studiengänge angeboten werden.

Wir wollen hier nicht die vollständige Entfaltung von Objekten zu Typen höherer Ordnung fordern. Deshalb

erbt ein Relationship-Typ höherer Ordnung nur die Identifikation seiner Elemente oder - wenn wir an einer

vollständigen Wertedarstellung interessiert sind - nur die identifizierenden Werte der Objekte seiner Komponenten. So können z.B. Objekte vom Typ geplanteLehrveranstaltung in Bild 6 auch nur auf Objekte verweisen,

die Kurs, Semester, Professor bezeichnen, wenn wir voraussetzen, daß ein Schlüssel des Typs angeboteneVorlesung aus Kurs, Semester, Professor besteht.

Mod IS

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

Kurs

ab SS 2012

Semester

k

Studiengang

{}

Person

1

eingetragen

Verantwortlicher4LV

µ

Dozent

Wunsch

angebotene

Vorlesung

Vorschlag

*

Professor

6

¾

170

Zeit(Vorschlag,

6 Nebenbeding)

-

Raum

*6

+

Typus

¾

geplante

Lehrveranst

¾

gehaltene

Lehrveranst

Zeitrahmen

Abbildung 6: HERM Diagramm zu unserem Hauptbeispiel

Ein Objekt vom Typ

angeboteneVorlesung = (Kurs, Semester, Studiengänge,

Professor, eingetragen, Verantwortlicher4LV, Raumwunsch, Typus, { Zeit }, ∅) ist z.B.

VorlesungDBIVSS02: (DBIV, SS2002, { Informatik, IMT },

637861, KK, 637861, SR1, Vorlesung/Übung/Praktikum 2+2+2, Mo. 1.DS) .

Generalisierung versus Spezialisierung: Ein Cluster-Typ erlaubt die explizite Darstellung einer Generalisierung.

Ein unärer Relationship-Typ stellt dagegen eine Spezialisierung dar, wenn der Relationship-Typ bzw. EntityTyp als sein Element diesen identifiziert. Rollen werden oft durch einen generischen Typ mit der Bezeichnung

IsA dargestellt. Da die relationalen Schemata auch ohne diesen Typ auskommen, bevorzugen wir die Darstellung als Rolle mit unären Relationship-Typen oder ggf. auch mehrstelligen Relationship-Typen, falls die Rolle

durch eine Beziehung zu anderen Typen ausgezeichnet ist. Damit sind wir in der Lage, zwischen Generalisierung und Spezialisierung zu unterscheiden.

Rollen, die exklusiv bzw. hierarchisch sind, lassen sich auch anstelle einer HERM-Rautenstruktur durch hierarchische Strukturen abbilden, wie in Bild 7 dargestellt. Welche Darstellungsform gewählt wird, hängt vom erforderlichen Detaillierungsgrad ab. Sollen Attribute mit dargestellt werden, wird das hierarchische ER-Modell

sehr schnell zu unübersichtlich. In den ersten Abstraktionsschichten stellt es aber eine gute Alternative zum

HERM-Diagramm zum.

Person

Student

Diplomand

Diplomand

-

Student

Universitätsmitarbeiter

-

Person

6

Professor

Projektmitarbeiter

Projektmitarbeiter

- Universitäts- ¾

mitarbeiter

Abbildung 7: Hierarchisches ER-Diagramm versus HERM Diagramm

Mod IS

IS ADD

Web IS

Professor

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

171

Aggregation: Wir können die Konstruktion von Relationship-Typen zu einer allgemeinen Aggregationskonstruktion

erweitern, indem wir weitere Konstruktoren zulassen:

• Vereinigung,

• Mengenbildung,

• Aggregation durch Beziehungsklasse und

• Abstraktion durch Komponentenbildung.

Klassen werden mit der hochgestellten Annotation ‘C’ und dem Typnamen bezeichnet. Z.B. sind PersonC und

InGruppeC Klassen entsprechenden Typs.

IsA-Beziehungen können auf sehr unterschiedliche Art repräsentiert werden, ebenso wie unterschiedliche Schemata letztendlich das gleiche

darstellen können.

Three different styles are depicted in Figure 8. We prefer the compact style in the left diagram.

Person

Person

6

Professor

6

Professor

Person

6

IsA

Professor

Abbildung 8: Variants for Representation of Unary Relationship Types

IsA-Typen:

hier wurde partielle, nicht disjunkte Darstellung über Teiltypen bevorzugt, denkbar sind jedoch verschiedene Typen:

1. partiell, nicht disjunkt;

dieser Fall wird als der typische Fall angenommen (keine weiteren semantischen Informationen)

Im HERM darstellbar über unäre Teiltypen.

Person ⊇ Professor ∪ Mitarbeiter ∪ Student

E ⊇ E1 ∪ ... ∪ En

2. partiell, disjunkt

die Teiltypen erfüllen eine Exklusionsbeschränkung

Person ⊇ Professor ∪ Student

E = E1 ∪ ... ∪ En

3. total, nicht disjunkt

E = E1 ∪ ... ∪ En

Projektmitarbeiter = Professor ∪ Mitarbeiter ∪ Student

4. total, disjunkt

E = E1 ∪ ... ∪ En

Studenten = StudImVordiplom ∪ StudImHauptstudium ∪ Diplomand

Weiterhin kann auch für die Spezialisierung mit Partitionsbedingung eine analoge Strukturierung betrachtet werden (wird auch in den

meisten Büchern ‘vergessen’):

1. partiell, nicht disjunkt

E ⊆ E1 ∪ ... ∪ En

Teilnehmer ⊆ Vortragender ∪ Organisator ∪ NormalerTeilnehmer

2. partiell, disjunkt

E ⊆ E1 ∪ ... ∪ En

Literatur ⊆ Buch ∪ Preprint ∪ Zeitschrift

3. total

E =

Mod IS

siehe oben

Generalisierung 6= (Spezialisierung)−1

E1 ∪ ... ∪ En

IS ADD

Web IS

CAU zu Kiel, IfI, ISE, β

2. Strukturierung von IS

ab SS 2012

172

Gewöhnlich wird in der Literatur nur versimplifizierend die IsA-Beziehung als strukturelle Beziehung betrachtet. Richtig ist aber die IsABeziehung im vollen Typeninhalt zu betrachten:

Typ = Struktur + Operationen + Semantik

In diesem Fall wird die Richtung der Vererbung bekanntgegeben.

Damit dann besser modellierbar:

• Vererbung von Eigenschaften von Teiltyp nach Supertyp

• Vererbung von Eigenschaften von Supertyp nach Teiltyp (als Weiterbenutzung, Wiederverwendung)

• Operationen des Teiltyps sind operationale Spezialisierung der Operationen des Supertyps (wenn im supertyp definiert)

• Semantik des Teiltyps (eingeschränkt auf im Supertyp darstellbares) folgt aus Semantik des Supertyps

Unterschied zur Vorlesung Informationssysteme (4. Semester)

Oft wird mit dem IsA-Typen eine Mixvererbung verbunden. Das Liskov-Substitutions-Prinzip (Methoden, die Zeiger oder Referenzen auf Basisklassen benutzen, müssen in der Lage sein, Objekte von abgeleiteten Klassen zu benutzen, ohne es zu bemerken!

Es ist eine andere Formulierung von totalem Polymorphismus. Wenn es für jedes Objekt O1 vom Typ S ein Objekt O2 vom Typ T

gibt, so daß sich für alle Programme definiert in T das Verhalten nicht ändert, wenn O2 durch O1 ersetzt wird: Dann ist S eine

Subtyp von T .) bei der Vererbung ist nur dann erforderlich, wenn die Objekte wie in Java oder UML zugleich um alle Attribute

des Supertypen im Subtypen angereichert werden.

Begründung: Die Vererbung von Beziehungen des Supertypen erfolgt im Schema ohnehin aufgrund der Integritätsbedingungen. Die automa-

tische Anreicherung um alle Attribute des Supertypen bringt eine erhöhte Redundanz an Werten, die zudem noch gepflegt werden müssen.

Alternativen in der Darstellung

Abstraktionskonzepte, die in der Informatik entwickelt worden sind:

•