Wissensbasierte Diagnosesysteme

Werbung

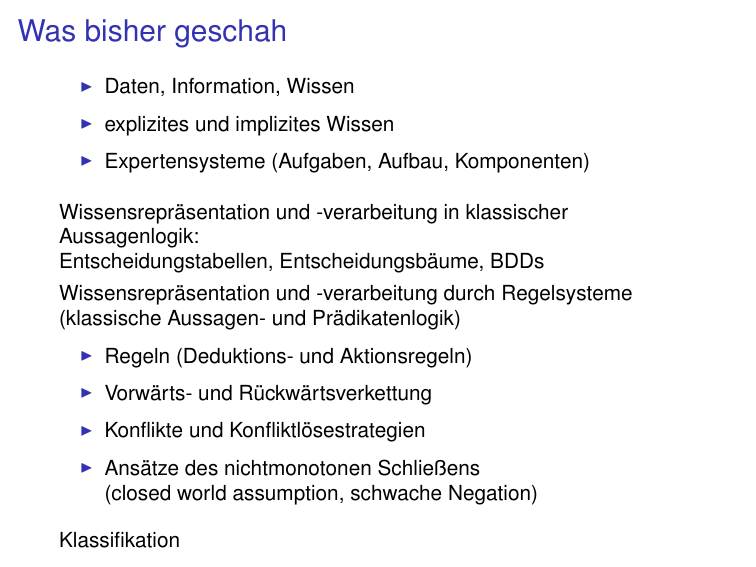

Was bisher geschah

I

Daten, Information, Wissen

I

explizites und implizites Wissen

I

Expertensysteme (Aufgaben, Aufbau, Komponenten)

Wissensrepräsentation und -verarbeitung in klassischer

Aussagenlogik:

Entscheidungstabellen, Entscheidungsbäume, BDDs

Wissensrepräsentation und -verarbeitung durch Regelsysteme

(klassische Aussagen- und Prädikatenlogik)

I

Regeln (Deduktions- und Aktionsregeln)

I

Vorwärts- und Rückwärtsverkettung

I

Konflikte und Konfliktlösestrategien

I

Ansätze des nichtmonotonen Schließens

(closed world assumption, schwache Negation)

Klassifikation

Unsicheres Wissen

Problem bei Bestimmung von Merkmalswerten

(Antworten auf Fragen), falls Wert

I

unbekannt

I

ungenau

I

unsicher, unzuverlässig

I

genauere Untersuchung unmöglich, zeitaufwendig, teuer

Abhilfe durch:

I

Wahrscheinlichkeiten

I

Vermutungen, Annahmen

I

Heuristiken: Erfahrungswerte, Schätzungen

Methoden zur heuristischen / unsicheren Klassifikation

Häufig angewendete Wissensverarbeitungsverfahren zur

heuristischen / unsicheren Klassifikation:

I

Klassifikation bei unsicherem Wissen

(nichtmonotone Logiken)

I

Klassifikation bei unscharfem Wissen

(Fuzzy Logic)

I

statistische Klassifikation

(Verwendung statistischer Werte, probabilistische Logiken)

I

künstliche neuronale Netze

Klassische (crisp) Mengen

Klassische Mengenlehre: M ⊆ U

M = {x | P(x)} für bestimmte Eigenschaft P

charakteristische Funktion χM : U → {0, 1} von M ⊆ U

1 falls x ∈ M

∀x ∈ U : χM (u) =

0 sonst

I

Zu jeder Menge M ⊆ U gehört genau eine

charakteristische Funktion χM : U → {0, 1}.

I

Jede Funktion f : U → {0, 1} ist die charakteristische

Funktion genau einer Menge M ⊆ U, nämlich M = f −1 (1).

Repräsentation von Mengen durch Eigenschaften und

Funktionen sind gleichwertig, also austauschbar.

Unscharfe (fuzzy) Mengen

W

Menge

möglicher Zugehörigkeitsgrade eines Elementes zu

einer unscharfen Menge M

(oft

= [0, 1] ⊆ odr Teilmengen davon)

unscharfe Menge M:

repräsentiert durch ihre charakteristische Funktion

W

R

χM : U →

W

Jedem Element aus U wird ein Grad der Zugehörigkeiten zur

Menge M zugeordnet.

verschieden Fuzzy-Logiken unterscheiden sich in W und der

Interpretation der Junktoren als Wahrheitswertfunktionen.

Beispiel:

= [0, 1],

Operationen auf unscharfen Mengen A, B : U → [0, 1]:

Vereinigung: (A ∪ B)(x) = max(A(x), B(x))

Schnitt: (A ∩ B)(x) = min(A(x), B(x))

Komplement: A(x) = 1 − A(x)

Produkt: (A × B)(x, y ) = min(A(x), B(y ))

W

Unscharfe (fuzzy) Relationen

Klassische n-stellige Relation:

R ⊆ A1 × · · · × An

Menge von n-Tupeln

charakteristische Funktion der Relation R

χR : A1 × · · · × An → {0, 1}

unscharfe n-stellige Relation:

R : A1 × · · · × An →

W

Jedem n-Tupel aus A1 × · · · × An wird ein Grad der

Zugehörigkeiten zur Relation R zugeordnet.

Klassifikation nach unscharfen Merkmalen

gegeben:

Menge

von Wahrheitswerten

unscharfe Zuordnung Objekt – Merkmal

W

I

I

M Menge aller Merkmale

S

m∈M Vm Merkmalsraum,

Menge aller Merkmalswerte (Symptome, Attribute)

I

O Menge aller Objekte,

S charakterisiert durch

Merkmalsverktor o ∈ m∈M Vm

I

C Menge aller Klassen (Diagnosen, Lösungen)

I

Funktion fm : (O × Vm ) →

(unscharfe Relation zwischen Objekten und

Merkmalswerten)

W

Ziel:

unscharfe Klassifikation: unscharfe Zuordnung Objekt – Klasse

f : (O × C) →

W

Klassifikation bei unsicherem Wissen

Zuordnung Merkmal – Klasse mit

Zugehörigkeitsgraden aus .

W

häufige Bedeutung von Gewichten als Zugehörigkeitsgrade:

positiv , falls das Merkmal die Zugehörigkeit zur Klasse

(Lösung, Diagnose) erfordert

negativ , falls das Merkmal die Zugehörigkeit zur Klasse

ausschließt

Je höher der Betrag des Gewichtes, desto stärker der

(positive bzw. negative) Zusammenhang

Unsichere Regelsysteme

Zuordnung von Gewichten zu jeder Regel

Beispiel:

I

Merkmale: M = {p1 , p2 , p3 , q1 , q2 , r }

I

Klassen : K = {h}

I

Gewichte: G =

I

Regeln:

R

p1 ∧ p2 ∧ p3 → h

(0.7)

q1 ∨ q2 → h

(0.4)

r

→ h

(−0.8)

Unsicheres Schließen

Ziele:

I

Bewertung, Vergleich verschiedener Lösungen

I

Auswahl der besten Lösung

Idee:

Schrittweise Berechnung der Werte der Lösungen (Diagnosen)

über Zwischenlösungen (Grobdiagnosen)

Wert der Lösung im Regelkopf wird berechnet aus:

I

Werte der Voraussetzungen,

I

Wert der Regel

Beispiel

I

Merkmale: M = {p1 , p2 , p3 , q1 , q2 , r }

I

Klassen: K = {h}

I

Gewichte: G =

I

Regeln:

R

p1 ∧ p2 ∧ p3

→ h

q1 ∨ q2

→ h,

(0.4)

r

→ h,

(−0.8)

(0.7)

Werte der Merkmale:

w(p1 ) = w(p2 ) = w(q2 ) = 1, w(p3 ) = 0.6, w(q1 ) = w(r ) = 0.5

Berechnung der Werte der Regelrümpfe mit ∧ 7→ min, ∨ 7→ max

Anwendung der Regeln: Multiplikation mit Regelgewicht

Berechnung des Wertes von h (oft Maximum oder Summe)

Unsicherheit in MYCIN

I

Regelbasiertes System

einfache Regeln der Form: Merkmalswerte → Klasse

(vermeidet zyklische Auswertung)

I

Regeln r (und Fakten) mit Gewissheitsfaktor γr ∈ [−1, 1]

I

logischen Junktoren zugeordnete Berechnung der

Gewissheitsfaktoren:

γϕ∨ψ = max(γϕ , γψ ) γϕ∧ψ = min(γϕ , γψ ) γ(h|B) = γ(B→h) max(0, γB )

I

Regel für Kombination der Werte bei mehreren anwendbaren

Regeln B1 → h, . . . , Bn → h:

γ(h|B1 ,...,Bn ) = γ(h|B1 ,...,Bn−1 ) ⊕ γ(h|Bn )

mit

falls γ1 ≥ 0, γ2 ≥ 0 dann γ1 ⊕ γ2

= γ1 + γ2 − γ1 γ2

falls γ1 < 0, γ2 < 0 dann γ1 ⊕ γ2

= γ1 + γ2 + γ1 γ2

γ1 + γ2

=

1 − min(|γ1 |, |γ2 |)

falls γ1 γ2 < 0 dann γ1 ⊕ γ2

(Nachbildung wahrscheinlichkeitstheoretischer Regeln)

Grundprinzipien regelbasierten Schließens

Wahrheitsfunktionalität Wahrheitswert einer Regel (Formel)

lässt sich aus Wahrheitswerten der Teilformeln

berechnen

Lokalität (Zugehörigkeitsgrad einer) Folgerung aus einer

Regel wird durch das Vorhandensein anderer

Regeln nicht beeinflusst

Abtrennbarkeit (Zugehörigkeitsgrad einer) Folgerung ist

unabhängig von der Herleitung

Probabilistische Anzätze:

Interpretation der Gewichte in γϕ ∈ [0, 1] ⊆

Wahrscheinlichkeiten

zusätzliche Forderung: ∀ϕ : γϕ + γ¬ϕ = 1

R als

Reine probabilistische Ansätze erfüllen diese nicht, sind also

für regelbasiertes Schließen oft nicht sinnvoll.

Gewichte in d3Web

Gewichte:

G = {N7, N6, N5+, N5, . . . , N1, P1, . . . , P5, P5+, P6, P7}

Gewichte repräsentieren Punktzahlen

(diese lassen sich addieren und vergleichen)

Berechnung des Wertes w(l) einer Klasse (Lösung) l ∈ K :

X

w(l) =

gw(ϕ)

(ϕ→l,g)∈R

I

Gewichte mit entgegengesetztem Vorzeichen heben

einander auf

I

Gewichte mit demselben Vorzeichen verstärken einander

Beste Lösung ist diejenige mit dem höchsten Wert.

Pseudowahrscheinlichkeiten in d3Web

Score

P7

P6

P5+

P5

P4

P3

P2

P1

Bedeutung

immer dafür

fast immer dafür

etwa fast immer dafür

meistens dafür

mehrheitlich dafür

häufig dafür

manchmal dafür

selten dafür

Score

N7

N6

N5+

N5

N4

N3

N2

N1

Bedeutung

immer dagegen

fast immer dagegen

etwa fast immer dagegen

meistens dagegen

mehrheitlich dagegen

häufig dagegen

manchmal dagegen

selten dagegen

Heuristische Entscheidungsbäume

Entscheidungsbaum mit Kantengewichten:

Baum (gerichteter azyklischer Graph) mit den folgenden

Eigenschaften:

I

Jeder Knoten hat höchstens eine eingehende Kante.

I

Genau ein Knoten (Wurzel) hat keine eingehende Kante.

I

Jeder Knoten ist mit einem Merkmal (Frage) markiert.

I

Jeder innere Knoten hat so viele ausgehende wie mögliche

Werte für das Merkmal

Knotenmarkierung: Merkmal

ausgehende Kanten markiert mit möglichen Werten (Antworten)

dieses Merkmals und Gewichten

Kantengewichte repräsentieren die Stärke des Zusammenhangs

zwischen Merkmalswert und Folgerung

Wert einer Lösung auf einem Pfad in einem Entscheidungsbaum:

Summe (Produkt o.Ä.) der Gewichte aller Kanten dieses Pfades von

der Wurzel zur Lösung (Klasse)

Wert einer Lösung in einem Entscheidungsbaum:

Maximum (Summe, o.Ä.) der Gewichte aller Pfade von der Wurzel zu

dieser Lösung (Klasse)