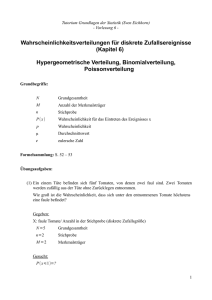

Statistik verstehen - von-der

Werbung