Formelsammlung

Werbung

Formelsammlung 2005 Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Formelsammlung

II. Wahrscheinlichkeitsrechnung

Zufällige Ereignisse

Zufälliger Versuch

V

Beliebig oft unter den gleichen Bedingungen wiederholbares

Experiment, bei dem die (Beobachtungs-) Ergebnisse zufällig, also

nicht eindeutig vorhersagbar sind.

Zufällige Ereignisse

A,B,C,...

Beobachtungsergebnisse in einem zufälligen Versuch V.

Werden durch Mengen beschrieben!

Elementarereignisse

{ω}

Zusammengesetzte

Ereignisse

Unmittelbar im Versuch V beobachtete (kleinste bzw. atomare)

Ereignisse

Entstehen aus den Elementarereignissen durch Anwendung von

Mengenoperationen ∩, ∪, ¬ (Komplement), \ .

Ereignisfeld

Menge aller zu V definierbaren Ereignisse.

– Elementarereignis,

- Menge aller zu einem zufälligen Versuch V

definierbaren Elementarereignisse,

- beliebiges Ereignis zu V,

A⊆ Ω

A := Ω\A

– Komplementärereignis zu A ( A := ‘nicht A‘ bzw. ‘¬A‘ ),

℘(Ω)={A | A⊆ Ω} - Ereignisfeld (Menge aller zu V definierbaren

Ereignisse.

Bezeichnungen: {ω}

Ω

Sicheres Ereignis:

Ein Ereignis, was bei jeder Durchführung von V (also immer)

eintritt. (Beispiel: Ω)

Unmögliches Ereignis: Ein Ereignis, was bei jeder Durchführung von V niemals eintritt

(Beispiel: Ω := Ω \Ω = Φ)

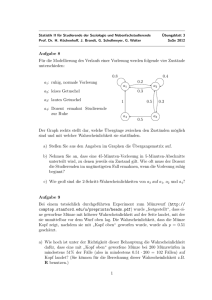

Beispiel: Versuch V = ‘2 maliger Münzwurf‘

Struktur eines Elementarereignis:

{ω} mit ω=(W1, W2)

Wi∈{K(opf), Z(ahl)} für i=1,2

Menge aller Elementarereignisse zu V:

Ω = {(K,K), (K,Z), (Z,K), (Z,Z)}

Menge aller möglichen zu V definierbaren Ereignisse:

℘(Ω) ={φ, {(K,K)},{(K,Z)}, {(Z,K)},{(Z,Z)}, {(K,K),(K,Z)}, {(K,K),(Z,K)},

{(K,K),(Z,Z)},{(K,Z),(Z,K)}, {(K,Z),(Z,Z)}, {(Z,K),(Z,Z)},

{(K,K), (K,Z), (Z,K)}, {(K,K), (K,Z), (Z,Z)}, {(K,K), (Z,K), (Z,Z)},

{(K,Z), (Z,K), (Z,Z)}, Ω}

Ein spezielles Ereignis:

A= {(K,K),(Z,Z)} – ‘bei beiden Würfen das gleiche Ergebnis‘

A = {(K,Z),(Z,K)} – ‘beide Würfe haben unterschiedliche Ergebnisse‘

1

Formelsammlung 2005 Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Axiomatische Definition der Wahrscheinlichkeit (Kolmogorow)

Def: Sei V ein zufälliger Versuch und Ω die Menge der Elementarereignisse zu V.

Dann heißt eine Abbildung P : A⊆ Ω → P(A)∈[0,1], die jedem Ereignis von V

eine reelle Zahl im abgeschlossenen Intervall zwischen 0 und 1 zuordnet,

Wahrscheinlichkeitsmaß auf dem Ereignisfeld von V, falls P folgende 3 Axiome

erfüllt:

A1: ∀A ⊆ Ω : 0 ≤ P( A) ≤ 1 und

P(Φ ) = 0,

P ( Ω) = 1

A2: ∀A ⊆ Ω∀B ⊆ Ω : A ⊆ B ⇒ P( A) ≤ P( B)

A3: ∀A ⊆ Ω∀B ⊆ Ω : P( A ∪ B) = P( A) + P( B) − P( A ∩ B)

∞

∞

A4: P(∪ Ai ) = ∑ P( Ai ) , falls alle Ai gegenseitig disjunkt.

i =1

(Normiertheit) (N)

(Monotonie) (M)

(Additivität) (A)

(σ-Additivität) (σ-A)

i =1

Bemerkungen:

1) P(A) ist ein Vorhersagemaß für die Wahrscheinlichkeit (Chance) des Eintretens von A bei einmaliger

Durchführung des Versuchs V.

2) (N), (M), (A) sind auch Eigenschaften der relativen Häufigkeit hn(A). Damit bildet das axiomatische

Modell für die Wahrscheinlichkeit P(A) die Eigenschaften der beobachteten relativen Häufigkeit hn(A) in

der Praxis ab.

3) Man kann experimentell nachweisen, daß die relative Häufigkeit hn(A) eines Ereignisse A

gegen die Wahrscheinlichkeit P(A) konvergiert, wenn man die Anzahl n der Versuchswiederholungen

unendlich groß werden läßt (n →∞).

Damit kann die Wahrscheinlichkeit P als relative Häufigkeit bei unendlich vielen Versuchen aufgefaßt

werden: P(A):= h∞(A).

(oder: die Zahl P(A) ist die erwartete relative Häufigkeit des Eintretens von A bei einer

genügend großen Anzahl n von Versuchswiederholungen)

P(A) = 0.2 wird so interpretiert:

bei 100 maliger Veruchsdurchführung sollte das

Ereignis A ca. 20 mal eintreten.

bzw. A tritt in genau 20 % aller Versuche ein.

4) Auf den 4 Axiomen beruht die gesamte Theorie der Wahrscheinlichkeitsrechnung, d.h.

weitere Axiome sind nicht erforderlich.

Bedingte Wahrscheinlichkeit:

P(A / B): =

P( A ∩ B)

- Wahrscheinlichkeit des Eintretens von A unter der Bedingung

P( B)

(Voraussetzung), daß B eingetreten ist.

Die bedingte Wahrscheinlichkeit P( ⋅ /B) ist bei fester Bedingung B ein

Wahrscheinlichkeitsmaß auf ℘(Ω) !

Es gilt insbesondere :

P( A /B) = 1-P(A/B)

2

Formelsammlung 2005 Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Unabhängigkeit von Ereignissen:

Zwei Ereignisse A und B heißen stochastisch unabhängig, falls gilt: P(A ∩ B) = P(A)P(B)

Folgerung: Sind A und B stochastisch unabhängig, so gelten folgende Beziehungen:

P( A / B) = P( A)

P( A / B ) = P ( A)

P( B / A) = P( B)

P( B / A ) = P( B)

k Ereignisse A1, A2, ..., Ak heißen gegenseitig stochastisch unabhängig, falls für jede

Teilmenge {Ai1, ..., Aim}, i1,...,im∈{1,...,k} dieser Ereignisse gilt:

P(Ai1 ∩... ∩Aim) = P(Ai1)⋅P(Ai2)⋅...⋅P(Aim)

Folgerung: Sind B, A1, A2, ..., Ak gegenseitig stochastisch unabhängig, so gilt

für alle Teilmengen {Ai1, ..., Aim}⊆{ A1, A2, ..., Ak}:

P( B / Ai1 ∩... ∩Aim) = P(B)

Eigenschaften der Wahrscheinlichkeit P: (folgen aus den 3 Axiomen A1, A2, A3)

1) P( A ) = 1 - P(A)

2) P(A ∪ B) = P(A) + P(B) – P(A ∩ B)

3) P( A1 ∪ A2 ∪ ... ∪ Ak ) = P( A1 ) + P( A2 ) + ... + P( Ak ) , falls Ai ∩ A j = Φ für i≠j.

4) Multiplikationssatz:

P( A1 ∩ A2 ∩ ... ∩ Ak ) = P( A1 ) ⋅ P( A2 / A1 ) ⋅ P( A3 /( A1 ∩ A2 ) ⋅ ... ⋅ P( Ak /( A1 ∩ A2 ∩ ... ∩ Ak −1 ))

5) P( A1 ∩ A2 ∩ ... ∩ Ak ) = P( A1 ) ⋅ P( A2 ) ⋅ P( A3 ) ⋅ ... ⋅ P( Ak ) , falls A1, A2, ..., Ak gegenseitig

stochastisch unabhängig sind.

6) Bedingte Wahrscheinlichkeit von A unter B:

P(A / B): =

P( A ∩ B)

P( B)

7) P( A /B) = 1-P(A/B)

8) Formel der Totalen Wahrscheinlichkeit:

Seien A1, A2, ..., Ak ein vollständiges Ereignissystem in Ω, d.h. es gelte Ai ∩ A j = Φ für

alle i≠j und Ω = A1 ∪A2 ∪ ... ∪Ak . Dann gilt für jedes Ereignis B⊆Ω:

k

P(B) =

∑ P( B / A ) P( A )

i =1

i

i

9) Satz von Bayes:

Seien A1, A2, ..., Ak und B wie unter 8) definiert. Dann gilt:

P ( Ai / B ) =

P ( B / Ai ) P ( Ai )

P( B)

3

Formelsammlung 2005 Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Die klassische Wahrscheinlichkeit

(Berechnung von Wahrscheinlichkeiten in Laplace-Versuchen (Glücksspielen))

Def: V heißt Laplace-Versuch, falls gilt:

1) die Menge Ω = {ω 1 ,..., ω m } der zu V gehörenden Elementarereignisse ist endlich (m < ∞) .

1

2) die Elementarereignisse sind gleichwahrscheinlich, d.h. P ({ω i }) =

für i=1,...,m.

m

Satz: Ist V Laplace-Versuch, so gilt P(A) =

A

Ω

(|M|:=Anzahl der Elemente in der Menge M)

Laplace-Versuche sind bei Glücksspielen typisch, P(A) ist als Chance des Eintretens von A

interpretierbar. (P(A) = Anzahl aller für A günstigen Versuchsausgänge im Verhältnis zur

Anzahl aller möglichen Versuchsausgänge)

Nützliche kombinatorische Formeln zur Berechnung klassischer Wahrscheinlichkeiten:

n

1) = Anzahl aller k-elementigen Teilmengen, die man aus einer n-elementigen Menge

k

auswählen kann.

2) n! = Anzahl aller Vertauschungen von n Elementen auf n Plätze.

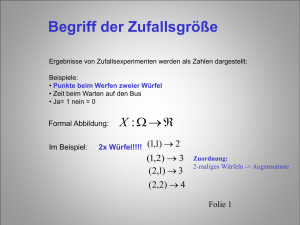

Wahrscheinlichkeitsverteilungen diskreter und stetiger Zufallsgrößen

Def.

Eine Zufallsgröße X ist ein in einem zufälligen Versuch beobachtetes Merkmal, dessen

Wertebereich (direkt oder nach Skalierung) in der Menge der reellen Zahlen liegt.

Bezeichnungen:

X,Y,Z,..

- Zufallsgröße

x,y,z ,...

- Beobachtungen (Stichprobenwerte) der Zufallsgröße

, ...

- Wertebereich

a1,a2,.. bzw. b1,b2,...- mögliche Werte aus dem Wertebereich der Zufallsgröße

Eine Zufallsgröße X heißt diskret, falls ihr Wertebereich χ endlich oder abzählbar ist, d.h.,

falls χ={a1,...,ak}; k ≤ ∞. Andernfalls heißt X stetig. D.h., X ist stetig, falls der Wertebereich

χ ein Intervall (a,b) ⊆ R, a < b, enthält.

4

Formelsammlung 2005 Statistik Prof.Dr.B.Grabowski

Diskrete Zufallsgröße

Wertebereich χ

Wahrscheinlichkeitsverteilung P

II Wahrscheinlichkeitsrechnung

Stetige Zufallsgröße

χ={a1,...,ak } endlich oder abzählbar viel Werte

Wahrscheinlichkeitsverteilung von X:

Gesamtheit aller Einzelwahrscheinlichkeiten

pi = P(X = ai) , i =1,...,k

∃(a,b) ⊆ R, a < b, mit (a,b) ⊆ χ ∞ viele Werte

Wahrscheinlichkeitsverteilung wird durch eine

Dichtefunktion f : χ ⊆ R R definiert:

Dichtefunktion f

Eigenschaften:

Verteilungsfunktion

(Summenhäufigkeitsfunktion) F

0 ≤ p i ≤ 1,

F (a) := P( X < a) =

Eigenschaften:

k

∑p

i =1

=1

i

∑ P( X = ai )

i:ai < a

f ( x) ≥ 0∀x ∈ χ ,

∞

∫ f ( x)dx = 1

−∞

a

F (a ) := P ( X < a ) =

∫ f ( x)dx

−∞

(F: Stammfunktion von f)

Eigenschaften:

1) 0 ≤ F(x) ≤1, 2) F(x) monoton nicht fallend

3) lim F ( x) = 0, lim F ( x) = 1

x → −∞

Berechnung von

Wahrscheinlichkeiten

P( X ∈ A) =

∑ P( X = a )

z.B.:

P( X ≤ a) =

P( X ∈ A) = ∫ f ( x)dx

i

i : ai ∈ A

x →∞

A

∑ P ( X = ai )

z.B.:

i:ai ≤ a

P ( a ≤ X ≤ b) =

P( a ≤ X ≤ b) = P( a < X < b)

b

= ∫ f ( x)dx = F (b) − F (a )

∑ P( X = a )

i :a ≤ ai ≤ b

i

a

Modalwert xM

x M : P( X = x M ) = max P( X = ai )

x M : f ( x M ) = max f ( x)

α-Quantil xα

xα : F ( xα ) ≤ α < F ( xα + ε )

xα : F ( xα ) = α

Erwartungswert EX

EX = ∑ a i P ( X = a i )

ai ∈χ

k

EX =

i =1

Varianz Var(X)

x∈χ

∞

∫ xf ( x)dx

−∞

∞

k

Var(X) = ( x − EX ) 2 f ( x)dx

∫

Var ( X ) = ∑ ( ai − EX ) 2 P ( X = ai )

i =1

−∞

Beispielverteilungen 2-Punkt-Verteilung, Binomialverteilung

Poissonverteilung,

Diskrete Gleichverteilung

5

Normalverteilung, Log-Normalverteilung

Exponentialverteilung, Stetige Gleichverteilung

Formelsammlung 2005 Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Berechnung diskreter Verteilungen:

V-zufälliger Versuch mit der Menge Ω der Elementarereignisse, X wird in V beobachtet.

Jedem Elementarereignis ω∈Ω wird ein Wert a für X zugeordnet: X(ω) = a∈χ

Dann gilt folgende Äquivalenz: X = a ⇔ A={ω / X(ω) = a} und P(X = a) = P(A).

Unabhängigkeit zweier Zufallsgrößen

Def: Seien X∈χ und Y∈ zwei Zufallsgrößen. Dann heißen X und Y stochastisch

unabhängig falls gilt:

P(X∈A und Y∈B) = P(X∈A) P(Y∈B) ∀ A⊆χ und ∀B⊆

Folgerung für den Spezialfall:

Sind X und Y diskret, also χ={a1,...,ak} und ={b1,...,bl}, dann sind X und Y stochastisch

unabhängig, falls gilt:

P( X = a i ∧ Y = b j ) = P( X = a i ) P(Y = b j ) für alle i=1,...,k und j=1,...,l.

Eigenschaften von Erwartungswerten und Varianz von Zufallsgrößen

X – diskret oder stetig (beliebig)

Satz: 1.) E (aX ) = aEX

2.) E (a ) = a

3.) E ( X + Y ) = EX + EY

4.) E ( X ⋅ Y ) = (EX ) ⋅ (EY )

falls X und Y stochastisch unabhängig

[ ]

Satz: 1.) Var ( X ) = E X 2 − E [X ] = E ( X − EX )

2.) Var (a ) = 0

2

2

3.) Var (aX + b ) = a 2 ⋅ Var ( X )

4.) Var (aX + bY ) = a 2 ⋅ Var ( X ) + b 2 ⋅ Var (Y ) , falls X und Y stochastisch unabhängig

Def.: Eine Zufallsgröße X mit EX = 0 und Var (X)=1 heißt Standardisierte Zufallsgröße

X→

Def.:

Var ( X )

X − EX

Var ( X )

–

Standardisierung einer Zufallsgröße

– Standardabweichung von X.

Die Tschebyscheff-Ungleichung

Satz: Es gilt ∀ε>0:

a ) P(( X − EX ) > ε ) ≤

Var ( X )

ε

2

b) P (( X − EX ) ≤ ε ) ≥ 1 −

bzw.

6

Var ( X )

ε2

Formelsammlung 2005 Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Zusammenhang zwischen I (Deskr. Stat.) und II (WR):

Begründung der Formeln für EX, Var(X) usw.

Sei X – diskret, X = {a 1 , a 2 ,..., a k }

deskriptive Statistik

ai

a1

a2

hn(ai)

hn(a1)

hn(a2)

ak

hn(ak)

Wahrscheinlichkeitsrechnung

n

→

→∞

hn (ai ) → pi

n →∞

ai

a1

pi = P(X = ai)

p1

ak

pk

rel.

Häufigkeitsverteilung

Wahrscheinlichkeitsverteilung

Aus der Konvergenz der relativen Häufigkeit gegen die Wahrscheinlichkeit ergibt sich:

arithm. Mittel:

=

k

1

n

x=

∑x

i

n

→

→∞

i =1

k

∑ a h (a )

i

n

EX =

k

∑a p

i

– Erwartungswert von X

i

i =1

i

i =1

Streuung:

s2 =

=

=

1

n

n

∑ (x

i

i =1

1

n −1

n

n −1

− x)

k

∑ (a

i =1

k

∑

i =1

2

− x ) ⋅ H n (a i )

2

i

( a i − x ) ⋅ h n (a i )

2

n

→

→∞

Var ( X) =

k

∑ (a

i =1

− EX) ⋅ p i - Varianz von X

2

i

Empirische Verteilungsfunktion:

Fn ( x) =

n

→ F( x) =

→∞

∑ h (a )

n

i

1:a i ≤ x

∑p

i:a i ≤ x

i

= P( X ≤ x)

– Verteilungsfunktion von X

– Anteil aller Beobachtungen

x j , j = 1,..., n mit

xj ≤ x

Hauptsatz der Statistik (Formuliert die stochastische Konvergenz für n→∞)

Satz: (Hauptsatz der Statistik)

Unter bestimmten Voraussetzungen gilt:

1) P (lim hn ( A) − P ( A) = 0) = 1 und 2) P lim sup Fn ( x) − F( x) = 0 = 1

n →∞

n→∞ x∈ℵ

D.h., die Wahrscheinlichkeit eines Ereignisses A entspricht der relativen Häufigkeit des Ereignisses nach ∞

vielen Versuchswiederholungen und die empirische Verteilungsfunktion der Beobachtungen einer Zufallsgröße

konvergiert mit Sicherheit gegen die (theoretische) Verteilungsfunktion der Zufallsgröße.

7

Formelsammlung Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

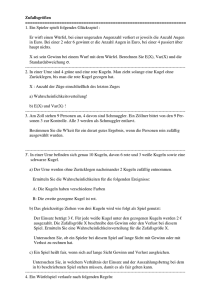

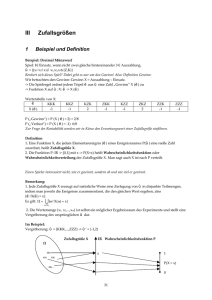

Spezielle diskrete Wahrscheinlichkeitsverteilungen

Verteilung der Parameter

Zufallsgröße X

n, p

Binomialn=1,2,...

verteilung

0<p<1

Siehe auch *3)

unten

Poissonverteilung

Hypergeometrische

Verteilung

Geometrische

Verteilung

Diskrete

Gleichverteilung auf

einer Menge

ℵ={a1,...,ak}

Bezeichnung

Einzelwahrscheinlichkeiten EX

X~B(n,p)

n=1:

n k

n−k

Bernoulli- bzw. P(X = k) = k p (1 − p )

Zweipunktfür k = 0,1,...,n

verteilung

λ>0

X~P(λ)

N=1,2,...

M=1,2,...,N

n=1,2,...,N

X~H(N,M,n)

P(X = k) =

λk

e −λ

np

Var(X)

np(1-p)

Wahrscheinlichkeit dafür, daß bei n-maliger Wiederholung eines zweipunktverteilten Versuches mit der

Erfolgswahrscheinlichkeit p die Anzahl

der Erfolge X gleich k ist.

Wie bei der Binomialverteilung; aber p

und /oder n unbekannt und EX=np= λ

bekannt. Beschreibt Ankunftsströme.

Bsp: Anzahl X eintreffender Signale in

Einer Empfängerstation pro Zeiteinheit.

λ

λ

M

n

N

n

1

p

1− p

p2

k!

für k = 0,1,2.....

M N − M

k n − k

P(X = k) =

N

n

für k=0,1,..., min{M,n}

0<p<1

X~Geo(p)

P(X = k) = p(1 − p)

k = 1,2,3,...

{a1,...,ak}⊆R

X~G({a1,...,ak})

P( X = ai ) =

k −1

Versuchsschema

(Anwendungsgebiet)

M

M N −n

(1 − )

N

N N −1

Wahrscheinlichkeit dafür, aus einer

Menge, die N Kugeln und davon M

Schwarze enthält, bei n-maligem

Ziehen ohne Zurücklegen X=k

Schwarze Kugeln zu ziehen.

Wahrscheinlichkeit dafür, bei n-maliger

Wiederholung eines 2-Punktverteilten

Versuchs mit Erfolgswahrscheinlichkeit

P erst beim k.ten Mal Erfolg zu haben.

2 Wahrscheinlichkeit dafür, daß bei einma1 k

1 k 2 1 k liger Durchführung eines Versuches

a

∑ i ∑ ai − ∑ ai

k i =1

k i =1

k i =1 eines von k gleichberechtigten

1

k

i = 1,2,...,k

Ereignissen eintritt. Wird bei Glücksspielen verwendet. Bsp.: X – zufällige

Augenzahl beim Würfeln.

8

Formelsammlung Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

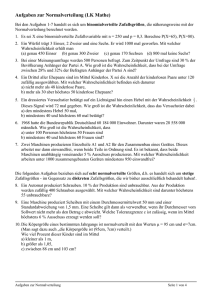

Spezielle stetige Wahrscheinlichkeitsverteilungen

Verteilung der

Zufallsgröße X

Stetige Gleichverteilung auf

Exponentialverteilung

einem Intervall zwischen a und b

Normalverteilung

Logarithmische NormalVerteilung

Parameter

a,b ∈R, a<b

λ>0

µ, σ2

µ, σ2

Bezeichnung

X~R(a,b)

X~E(λ)

X~N(µ, σ2)

Dichtefunktion

EX

Var(X)

Anwendungsgebiete

1

f (t ) = b − a

0

falls a ≤ t ≤ b

sonst

a+b

2

(b − a) 2

12

Man weiß: Beobachtungen von X

liegen zwischen a und b und es gibt

keine Häufung.

Wird deshalb auch als

nichtinformative Verteilung

bezeichnet.

λe − λt

f (t ) =

0

µ∈R, σ>0

X~logN(µ, σ2)

(t − µ )

−

falls t ≥ 0

1

2

f (t ) =

e 2σ ,

sonst

σ 2π

2

(ln t − µ )

1

−

2σ 2

für t > 0

f (t ) = σt 2π e

0

sonst

2

∀t ∈ R

µ

1

e

λ

1

-zuf. Abbauzeit einer Droge

-zuf. Tel.gesprächsdauern

-zuf. Zeit zwischen 2 eintreffenden Nachrichten *2)

9

µ+

σ2

2

σ2

e 2 µ +σ (eσ − 1)

Beschreibung von symmetrischen

Häufigkeitsverteilungen.

Besonderheiten: siehe *1)

Beschreibung von schiefsymmetrischen Häufigkeitsverteilungen.

(Häufung auf der linken Seite)

nichtnegativer Zufallsgrößen .

λ2

Beschreibung von Wachstums- oder Abklingvorgängen, Bediendauern und

Zwischenankunftszeiten.

µ∈R, σ>0

-zufällige Körpergröße

-zufälliges Gewicht

-zufälliger IQ

-Meßfehler

-zuf. Rauschen

2

2

X unterliegt einer logarithmischen

Normalverteilung, wenn ln(X) eine

Normalverteilung besitzt.

Formelsammlung Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Besonderheiten der Verteilungen

*1) Besonderheiten der Normalverteilung:

1,2,3-σ Bereiche: Sei X~N(µ ,σ 2 ) . Dann gilt:

1) P( X − µ ≤ σ ) =0,682

2) P( X − µ ≤ 2σ ) = 0,954 3) P( X − µ ≤ 3σ ) = 0,998

Standardnormalverteilung : N(0,1)

Bezeichnung der Dichtefunktion : ϕ (t)

Bezeichnung der Verteilungsfunktion: φ(t)

Bezeichnung des α -Quantils: u α

Die Standardnormalverteilung (Φ (t)) ist tabelliert. Die Berechnung von beliebigen

Normalverteilungswahrscheinlichkeiten erfolgt über die Transformation in die

Standardnormalverteilung!

Umrechnung von N( µ , σ2 ) (F) zu N(0,1) (Φ ):

t −µ

F(t) = Φ

σ

*2) Zusammenhang zwischen der Poisson- und der Exponentialverteilung

Satz: Sei X die zuf. Anzahl von eintreffenden Forderungen pro Zeiteinheit und T die zuf.

Zeit zwischen 2 eintreffenden Forderungen. Dann gilt:

X~P(λ) ⇔ T∼E(λ)

Bsp: Die Anzahl eintreffender Nachrichten sei poissonverteilt. Im Schnitt kommen 6

Nachrichten pro Stunde an. Dann ist die Zeit zwischen dem Eintreffen zweier Nachrichten

1

1

1

exponentialverteilt. Diese Zeit beträgt im Mittel ET= = −1 = h = 10 min

λ 6h

6

*3) Approximationen der Binomialverteilung

a) Approximation durch die Poisssonverteilung:

n k

λk −λ

n−k

=

Satz: Es gilt: lim p (1 − p )

e

n→∞ k

k!

p →0

np = λ

B(n,p) ≈ P(λ=np) für große n und kleine p (Empfehlung: n ≥ 20, p ≤ 0,01 )

b) Approximation durch die Normalverteilung

Aus dem Satz von Moivre – Laplace (siehe unten) folgt :

B(n,p) ≈ N(np, np(1-p)) für große n (Empfehlung: n ≥ 120 )

10

Formelsammlung Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Reproduktionssatz

Satz: (Reproduktionssatz)

Seien X und Y zwei stochastisch unabhängige Zufallsgrößen. Dann gelten folgende Aussagen:

(

(

)

1.) X ~ N µ , σ 2 ⇒ aX + b ~ N aµ + b, a 2 σ 2

)

(Typ der Normalverteilung bleibt bei linearen Transformationen erhalten.)

(

(

)

)

2

2.) X ~ N µ 1 , σ 1

2

2

⇒ X + Y ~ N µ 1 + µ 2 , σ1 + σ 2

2

Y ~ N µ2 ,σ2

(

)

3.) X ~ B(n1 , p )

⇒ X + Y ~ B(n1 + n2 , p )

Y ~ B(n2 , p )

4.) X ~ P(λ1 )

⇒ X + Y ~ P(λ1 + λ 2 )

Y ~ P(λ 2 )

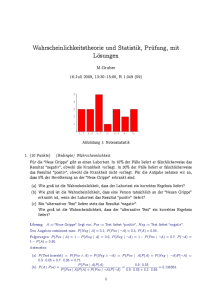

Verteilung des arithmetischen Mittels einer Stichprobe normalverteilten ZG

σ2

1 n

)

X = ∑ X i ~ N(µ,

n

n i =1

Grenzwertsätze

Satz: (Zentraler Grenzwertsatz (ZGWS))

Seien X1,...,Xn n stochastisch unabhängige Zufallsgrößen mit EX i = µ i und = 1,...,n. Dann gilt:

n

∑ (X

i

i =1

− µi )

ist für große n standardnormalverteilt.

n

∑σ

2

i

i =1

n

∑ (X

Es gilt also:

i

i =1

− µi )

n

∑σ

≈ N(0, 1) bzw. äquivalent dazu :

2

n

n

2

X i ≈ N µ i , σ i ,

i =1

i =1

i =1

n

∑

∑ ∑

i

i =1

falls n groß genug ist.

Empfehlung: n ≥ 120

(falls keine weiteren Informationen über die

Verteilung der Xi vorliegen)

D.h., wenn man n stochastisch unabhängige Zufallsgrößen additiv überlagert, so ist die entstehende

Summe approximativ für große n normalverteilt.

11

Formelsammlung Statistik Prof.Dr.B.Grabowski

II Wahrscheinlichkeitsrechnung

Spezialfälle des ZGWS

1) Approximation des arihmetischen Mittels einer Stichprobe:

Satz:

Sei X eine Zufallsgröße mit dem Erwartungswert EX = µ und der Varianz Var(X)=σ2. Seien

Xi für i=1,...,n eine Stichprobe von X. Dann gilt für das arithmetische Mittel der Stichprobe:

n(X − µ)

σ

→ N (0,1)

n→ ∞

Approximation:

X =

σ2

1 n

)

≈

N(

µ,

X

∑ i

n

n i =1

2) Approximation der Binomialverteilung durch eine Normalverteilung

(im ZGWS einsetzen: Xi Bernoulliverteilt mit Erfolgswahrscheinlichkeit p,

n

X := ∑ X i ~ B(np, np(1-p))

i =1

Satz: (Grenzwertsatz von Moivre – Laplace)

Sei X ~ B( n, p) . Dann gilt:

X − EX

Var ( X)

X − n⋅p

=

n ⋅ p(1 − p)

→ N (0,1)

n →∞

Approximation:

B(n , p) ≈ N(np, np(1-p) )

Approximative Verteilung der relativen Häufigkeit hn(A) eines Ereignisses A:

hn ( A) ≈ N ( p,

p (1 − p )

)

n

12