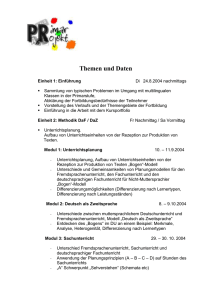

Vorlesung 5 - ASV, Uni Leipzig

Werbung

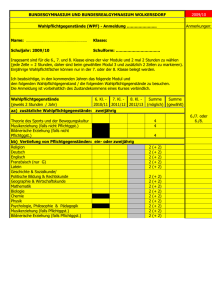

Dokumentenmodelle Gerhard Heyer, Patrick Jähnichen Universität Leipzig [email protected] [email protected] Institut für Informatik Ziel • Retrieval von Information – – – – • Clustering von Wörtern anhand Bedeutung(Semantik) Identifizierung von Synonymien und Polysemien Themenzuordnung von Dokumenten ...? Dimensionsreduktion – Trivial ist nur das Auszählen von Wörtern – Dimension hierbei: V (V aber oft sehr groß, oft >> 1000000) – Wie reduzierbar? Gerhard Heyer, Patrick Jähnichen Modul Textmining Grundlagen Institut für Informatik Aufbau von Textkorpora • • • • Korpus C enthält Menge von D Dokumenten Jedes Dokument enthält Menge von Nd Wörtern Gesamter Korpus enthält Vokabular von V voneinander verschiedenen Wörtern Länge des Korpus ist N Gerhard Heyer, Patrick Jähnichen Modul Textmining Vektorraummodell • Dokumente werden als Vektoren dargestellt – Jede Komponente im Vektor entspricht einem separaten Term – wenn dieser im Dokument vorkommt, ist der Vektor an dieser Stelle von 0 verschieden – Die Dimension des Vektors ist V (Größe des Vokabulars) – Möglichkeit der Nutzung von Vektoroperationen zum Vergleich von Dokumenten, z.B. Kosinusmaß – Häufig werden statt reinen Termfrequenzen tf-idf Gewichte als Vektorkomponenten genutzt Gerhard Heyer, Patrick Jähnichen Modul Textmining Tf-idf • • • • • Zähle Auftreten von Termen in Dokument Vergleiche Auftreten von Term in Dokument mit Logarithmus von inversem Auftreten des Terms in anderen Dokumenten des Korpus Ergebnis: Term-Dokumentmatrix (∈ RVxD) mit tf-idf Werten der Terme des Vokabular Reduktion von Dokumenten(unbestimmter Größe) auf Liste von Werten fixer Länge Berechnung: Gerhard Heyer, Patrick Jähnichen Modul Textmining Statistik • Multinomiale Verteilung – Generalisierung der Binomialverteilung – Binomialverteilung ist Wahrscheinlichkeitsverteilung der Anzahl Erfolge von n unbhänigen Bernoulli-Experimenten – Analogon der Bernoulli-Verteilung in mult. Verteilung ist die Kategoriale Verteilung, hier resultiert jeder der n Versuche in genau einem von K Ausgängen mit Wahrscheinlichkeiten p1, ..., pK und – Zeigt ein Zufallsvariable Xi die Anzahl der Ausgänge mit Ergebnis i an, so folgt der Vektor X = (X1, ..., XK) einer Multinomialverteilung mit Parameter n und p = (p1, ..., pK) – Im Bereich der automatischen Sprachverarbeitung sprechen wir meist von multinomialer Verteilung wenn wir eigentlich die Kategoriale Verteilung meinen Gerhard Heyer, Patrick Jähnichen Modul Textmining Statistik • Bedingte Wahrscheinlichkeit – Wahrscheinlichkeit für eine Beobachtung x unter der Voraussetzung dass Beobachtung y zuvor eingetreten ist heißt bedinge Wahrscheinlichkeit Sind x und y voneinander unabhängig, so gilt Und damit Gerhard Heyer, Patrick Jähnichen Modul Textmining Statistik • Bayestheorem • In Worten Gerhard Heyer, Patrick Jähnichen Modul Textmining Bag-of-words assumption • • • • Reihenfolge der Wörter wird nicht berücksichtigt Ein Dokument entspricht einem „Sack“ voller Wörter Für jedes Wort wird Frequenz gespeichert Annahme: – Informationen über Art und Anzahl von Wörtern reicht aus um Rückschlüsse auf die Struktur von Text zu ziehen – Grundlage: Satz von de Finetti • Annahme der Austauschbarkeit: • Austauschbare Zufallsvariablen folgen einer vermischten Verteilung (mixture distribution), meist unendlich Gerhard Heyer, Patrick Jähnichen Modul Textmining Singulärwertzerlegung • • • Ist die Darstellung einer Matrix als Produkt von drei speziellen Matrizen Singulärwerte sind spezifische Eigenschaft einer Matrix, vergleichbar mit Eigenwerten Singulärwertzerlegungen existieren für jede Art von Matrix Gerhard Heyer, Patrick Jähnichen Modul Textmining Singulärwertzerlegung - Anwendungen • Statistik – Hauptkomponentenanalyse (engl. Principal Component Analysis, PCA) • Strukturierung von Datensätzen durch Näherung von vielen statistischen Variabeln durch geringe Zahl von Linearkombinationen (den Hauptkomponenten) – Heißt auch Karhunen-Loève-Transformation • Bildkompression – – – – Bild (Matrix aus Farbwerten) wird zerlegt Nur stark von Null verschieden Singulärwerte werden berücksichtigt Rekonstruktion des Bildes möglich Weglassen kleiner Singulärwerte ist verlustbehaftete Modellreduktion Gerhard Heyer, Patrick Jähnichen Modul Textmining Latent Semantic Analysis - LSA Latent Semantic Indexing - LSI Institut für Informatik LSA (Deerwester et. al.) • • • • • Form der linearen Faktorisierung Grundlage bildet eine Wort-Dokument Kookkurrenzmatrix Diese wird per Singulärwertzerlegung in drei Matrizen zerlegt Alle bis auf n höchste Singulärwerte werden 0 gesetzt Ursprüngliche Matrix wird rekonstruiert (hat nun geringeren Rang n) Gerhard Heyer, Patrick Jähnichen Modul Textmining LSA Beispiel Gerhard Heyer, Patrick Jähnichen Modul Textmining LSA Beispiel - Termfrequenzmatrix Gerhard Heyer, Patrick Jähnichen Modul Textmining LSA Beispiel - Singulärwertzerlegung Gerhard Heyer, Patrick Jähnichen Modul Textmining LSA Beispiel - rekonstruierte Matrix mit geringerem Rang Gerhard Heyer, Patrick Jähnichen Modul Textmining LSA • Vorteil: – Keine Eins/Null Entscheidungen mehr – Dimensionsreduktion auf n Dimensionen („semantische Kategorien“) • Nachteil: – Verlustbehaftete Methode – Schlechtes zugrundeliegendes statistisches Model --> schlechte Begründbarkeit • Gemeinsame Verteilung von Wörtern und Dokumenten folgt nicht Gauss sondern Poissonverteilung – Kein Vorwissen über n – Polysemie • Jedes Wort wird genau einer semantischen Bedeutung zugeordnet (gleicher Datenpunkt im semantischen Raum) • D.h. Ergebnis ist Durchschnitt aller verschiedenen Bedeutungen einer Wortes (als Vektor) Gerhard Heyer, Patrick Jähnichen Modul Textmining LSA • Geometrische Interpretation – Reduzierte Dimensionen spannen „semantischen Raum“ – In Wortmatrix U • Winkel zwischen Wortvektoren (Cosinus-Maß) entspricht ihrer semantischen Ähnlichkeit • Möglichkeit semantisches Clustern – Ähnlich für Dokumentmatrix V • Clustering von ähnlichen Dokumenten Gerhard Heyer, Patrick Jähnichen Modul Textmining Latente Variablen • • • • Theoretische Konstrukte, abhängig von Modell Sind nicht direkt messbar Können ausgehend von messbaren Variablen (Observablen) bestimmt werden (auch: Operationalisierung) Beispiel: Intelligenzquotient – Kann nicht direkt gemessen werden – Wird anhand von vielen Testergebniss (Fragen) bestimmt – Da latente Variablen nur theoretische Konstrukte sind, ist der IQ nur so aussagekräftig, wie die Theorie plausibel (daher teils massive Kritik an IQ Messung) Gerhard Heyer, Patrick Jähnichen Modul Textmining probabilistic Latent Semantic Indexing - pLSI Institut für Informatik pLSI (Hofmann) • • • Stammt nicht aus linearer Algebra (wie LSI) Geht von vermischten Verteilungen und einem Modell der latenten Klassen aus Basiert auf Aspect-Modell – Ordnet jeder Beobachtung (Term) eine latenten Variable (Klasse) zu – Gemeinsame Wahrscheinlichkeit über Dokument und Terme wird definiert Gerhard Heyer, Patrick Jähnichen Modul Textmining pLSI • Generiert Dokumente: – Auswählen eines Dokuments d mit Wkt. P(d) – Auswählen einer latenten Klasse z mit Wkt. P(z|d) – Generieren von Wort w mit Wkt. P(w|z) • Übersetzung in Multivariates Modell • Modell basiert auf zwei Annahmen von Unabhängigkeit – Beispieltupel (d,w) werden unabhängig generiert (Bag-of-words) – Bedingte Unabhängigkeit zwischen w und d, sind nur über latente Klasse z gekoppelt Gerhard Heyer, Patrick Jähnichen Modul Textmining pLSI • Umstellen mit Hilfe des Bayestheorem Gerhard Heyer, Patrick Jähnichen Modul Textmining pLSI • Ähnlichkeit zu LSA – Definiere 3 Matrizen: – Gemeinsames Wahrscheinlichkeitsmodell gegeben durch: • Beobachtung – Äußere Produkte zwischen Zeilen von Û und V zeigen bedingte Unabhängigkeit – K Faktoren entsprechen Mischkomponenten aus Aspect-Model – Mischanteile ersetzen Singulärwerte Gerhard Heyer, Patrick Jähnichen Modul Textmining pLSI • Unterschied zu LSA – Funktion zum Bestimmen der optimalen Annäherung bei LSA: L2- oder Frobenius-Norm – Entspricht der Annahme eines Gauss-Rauschens auf den Termanzahlen – pLSI nutzt Likelihood-Funktion zur expliziten Maximierung der Vorhersagequalität des Modells • Dies entspricht der Minimierung der Kullback-Leibler Divergenz zwischen tatsächlicher und approximierter Wahrscheinlichkeitsverteilung Gerhard Heyer, Patrick Jähnichen Modul Textmining pLSI • Geometrische Deutung – K klassenspezifische Multinomialverteilungen werden im M-1 dimensionalen Simplex über alle möglichen Multinomialverteilungen dargestellt – Bilden K-1 dimensionalen Subsimplex – P(w|d) gegeben durch konvexkombinierte P(w|z) Gerhard Heyer, Patrick Jähnichen Modul Textmining pLSI • Würdigung – Approximation in P ist für jedes Wort eine wohldefinierte Wahrscheinlichkeitsverteilung – Faktoren haben klare probabilistische Bedeutung – LSA arbeitet nicht mit Wahrscheinlichkeiten, sogar negative Werte sind möglich – Keine offensichtliche Interpretation der Richtung im semantischen Raum von LSA, in pLSI ist Richtung interpretierbar als multinomiale Wortverteilung – Da probabilistisches Modell: Möglichkeiten der Modellselektion, Herausfinden von optimalem K (Anzahl der latenten Klassen) Gerhard Heyer, Patrick Jähnichen Modul Textmining Bildquellen • • • Wikipedia, Singulärwertzerlegung Deerwester, Dumais, Furnas, Landauer, Harshman: Indexing by Latent Semantic Analysis, Journal of the American Society for Information Science, 1990 Hofmann: Probabilistic Latent Semantic Indexing, Proceedings of the Twenty-Second SIGIR, 1999 Gerhard Heyer, Patrick Jähnichen Modul Textmining