Diplomarbeit: Effiziente Überprüfung von

Werbung

Technische Universität Ilmenau

Fakultät für Informatik und Automatisierung

Institut für Praktische Informatik und

Medieninformatik

FG Datenbanken und Informationssysteme

Effiziente Überprüfung von

Ausgabebedingungen in einem

Multimedia - Datenbanksystem

Diplomarbeit zur Erlangung des

akademischen Grades Diplominformatiker

Thomas Schröder

Betreuer:

Dipl.-Inf. Thomas Heimrich

Verantwortlicher Hochschullehrer: Prof. Dr.-Ing. Kai-Uwe Sattler

Die Diplomarbeit wurde am 20.05.2005 bei der Fakultät für Informatik

und Automatisierung der Technischen Universität Ilmenau eingereicht.

Inventarisierungsnummer: 2005-05-23/052/IN98/2254

Zusammenfassung

Der äußere Aufbau und die zeitliche Abfolge eines Medienprojektes können über

Ausgabebedingungen definiert werden. Es existieren Beschreibungsmöglichkeiten,

die auf Konsistenz geprüft werden können und eine Berechnung des Ausgabeschedule aufgrund relativer Zeitabstände ermöglichen. Bei großen Projekten ist kein

effizienter Algorithmus für die Überprüfung bekannt. Des Weiteren sind die in Datenbanksystemen vorhandenen herkömmlichen Mechanismen zur Integritätssicherung der Bedingungen unzureichend. Eine Verwaltung der Objekte und Bedingungen an einer zentralen Stelle ist aber wünschenswert, um anwendungsunabhängig

die Konsistenz zu gewährleisten.

Die vorliegende Arbeit stellt Algorithmen zur effizienten Überprüfung der Ausgabebedingungen und zur Berechnung des Ausgabeschedule vor. Die in einem Datenbankmanagementsystem realisierten vorgestellten Methoden werden anschließend hinsichtlich des praktischen Gebrauchswertes bewertet. Die Messergebnisse

zeigen, dass mit den Algorithmen auch große Projekte effizient verwaltet werden

können.

Inv.-Nr.: 2005-05-23/052/IN98/2254

Inhaltsverzeichnis

1 Einführung und Motivation

9

2 Grundlagen und Related Work

2.1 Multimedia-Datenbanksysteme . . . . . . . . . . . . . . . .

2.2 Integritätsbedingungen . . . . . . . . . . . . . . . . . . . . .

2.3 Architekturen zur Integritätssicherung . . . . . . . . . . . .

2.3.1 Integritätssicherung durch Anwendung . . . . . . . .

2.3.2 Integritätssicherung durch DBMS . . . . . . . . . . .

2.3.3 Integritätssicherung durch Kapselung . . . . . . . .

2.4 Aktive Datenbanksysteme und Trigger . . . . . . . . . . . .

2.5 Modellierung von Ausgabebedingungen . . . . . . . . . . .

2.5.1 Allen-Relationen . . . . . . . . . . . . . . . . . . . .

2.5.2 Difference Constraints . . . . . . . . . . . . . . . . .

2.5.3 Bellman und Ford . . . . . . . . . . . . . . . . . . .

2.5.4 Eingabe der Bedingungen - Der Constraint Manager

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

13

13

14

14

15

15

16

17

19

20

21

21

23

3 Überprüfung mit Bellman - Ford

3.1 Beschränkungen und Beispiele . . . .

3.2 Klassifizierung der Allen-Relationen

3.3 Optimierungen . . . . . . . . . . . .

3.4 Änderung der Objektdauer . . . . .

3.5 Reduzierung der Kantenanzahl . . .

3.6 Weitere Laufzeitoptimierungen . . .

3.7 Realisierung im DBMS . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

27

27

30

34

38

41

41

42

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4 Numerische Konsistenzprüfung

43

4.1 Erzeugen der Ungleichungen . . . . . . . . . . . . . . . . . . . . . . . 43

4.2 Änderung einer Relation . . . . . . . . . . . . . . . . . . . . . . . . . 47

4.3 Umsetzung durch Trigger/Constraints . . . . . . . . . . . . . . . . . 48

5 Berechnung des Ausgabeschedule

5.1 Ausgabeschedule . . . . . . . . . . . . . . . . . . . . . . . . .

5.2 Berechnung am Beispiel . . . . . . . . . . . . . . . . . . . . .

5.3 Optimierungen . . . . . . . . . . . . . . . . . . . . . . . . . .

5.3.1 Änderung einer Bedingung am Ende eines Stranges . .

5.3.2 Änderung einer Bedingung am Anfang eines Stranges

5.3.3 Änderung einer Bedingung in der Mitte eines Stranges

5.4 Änderung der Objektdauer . . . . . . . . . . . . . . . . . . .

5.5 Graphen mit mehreren Strängen . . . . . . . . . . . . . . . .

Inv.-Nr.: 2005-05-23/052/IN98/2254

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

51

51

52

54

55

57

62

64

66

6

INHALTSVERZEICHNIS

5.6

Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

6 Evaluierung

6.1 Testprojekte und Messmethode . . . . . . . . . . .

6.2 Optimierung des graphischen Konsistenzcheck . . .

6.2.1 Überprüfung von Änderungen als Teilgraph

6.2.2 Reduzierung der Kantenanzahl . . . . . . .

6.3 Numerische Konsistenzprüfung . . . . . . . . . . .

6.4 Scheduleberechnung . . . . . . . . . . . . . . . . .

6.5 Zwischenstand . . . . . . . . . . . . . . . . . . . .

6.6 Umsetzung im DBMS . . . . . . . . . . . . . . . .

6.6.1 Speichern des Graphen in der Datenbank .

6.6.2 Manipulation von Bedingungen . . . . . . .

6.6.3 Zusammenfassung . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

81

81

84

84

86

87

88

91

92

92

95

99

7 Zusammenfassung und Ausblick

101

7.1 Zusammenfassung . . . . . . . . . . . . . . . . . . . . . . . . . . . . 101

7.2 Ausblick . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 102

A Erweiterte Allen-Relationen

103

A.1 Übersicht der Relationen . . . . . . . . . . . . . . . . . . . . . . . . . 103

A.2 Numerische Bedingungen der Relationen . . . . . . . . . . . . . . . . 103

Literaturverzeichnis

107

Thesen

109

Eidesstattliche Erklärung

111

Inv.-Nr.: 2005-05-23/052/IN98/2254

Abkürzungsverzeichnis

AR . . . . . . . . . . . . . . . Allen-Relationen

DBMS . . . . . . . . . . . . Datenbankmanagementsystem

DBS . . . . . . . . . . . . . . Datenbanksystem

DDL . . . . . . . . . . . . . Datendefinitionssprache

DML . . . . . . . . . . . . . Datenmanipulationssprache

ECA . . . . . . . . . . . . . Event Condition Action

MMDBS . . . . . . . . . . Multimedia-Datenbanksystem

SMIL . . . . . . . . . . . . . Synchronized Multimedia Integration Language

WFS . . . . . . . . . . . . . Wellenfeldsynthese

ZE . . . . . . . . . . . . . . . Zeiteinheit

Inv.-Nr.: 2005-05-23/052/IN98/2254

Kapitel 1

Einführung und Motivation

Multimediadaten spielen in der heutigen Zeit eine zunehmend größere Rolle in vielen Bereichen des alltäglichen Lebens. Es gibt kaum einen Computer, der nicht auf

irgendeine Art und Weise Multimediadaten verarbeiten kann. Der Begriff Multimedia entsteht durch Komposition der beiden Teile Multi (viel, vielfach) und

media (Medium). Medien definieren sich laut Brockhaus Enzyklopädie als: Ver”

mittlungssysteme für Informationen aller Art, ihre Funktion ist der Transport von

Inhalten“ [Lex91]. Sie speichern bzw. stellen Informationen in Form von Texten, Bildern, Graphiken, Sprache oder Musik dar. Im Allgemeinen spricht man von Multimedia, wenn viele Medien“ gemeinsam verwendet werden, sie aber ein bestimmtes

”

Ziel verfolgen [Lex89]. In dieser Arbeit werden ausschließlich digitale Medien betrachtet, also Videos, Audiosamples, Bilder oder Texte, die in elektronischer Form

für den Computer lesbar vorliegen.

Multimediadaten alleine stellen noch keinen großen Informationswert dar. Durch

die Komposition verschiedener Medien entsteht (meistens) für den Nutzer ein Mehrwert gegenüber einzelnen Medien. Eine einfache Form ist z. B. der Hypertext. Neben der Darstellung von verknüpften Text lassen sich auch Bilder, Videos oder

Sprachmitteilungen einbinden. In diesem Zusammenhang spricht man auch von

Hypermedia [Lex92]. Des Weiteren existiert inzwischen eine Vielzahl von multimedialen Präsentationen, die es dem Anwender erlauben, den Ablauf interaktiv zu

gestalten. Sie werden häufig bei Vorträgen oder Schulungen eingesetzt.

Eine große Rolle spielen Multimediadaten in der Filmproduktion: angefangen

vom Home-User, der seine privaten Filmaufnahmen digital nachbearbeitet oder neu

zusammenstellt, bis hin zu Kinofilmen, die komplett digital erstellt werden und sich

letztendlich nur aus einzelnen Medienobjekten zusammensetzen.

Mit den Fortschritten in der PC-Technik steigen sowohl die Möglichkeiten als

auch die Anforderungen an Multimediaprojekte. Das bedeutet, dass die Qualität

und auch die Quantität der Multimediadaten zunehmen. Mit steigender Komplexität von Multimediaprojekten wächst auch die Zahl der zu verwaltenden Einzel(medien)objekte. Um die Verwaltung der Datenmassen möglichst effizient zu

gestalten, ist es sinnvoll, sie an einer zentralen Stelle zu speichern: vorzugsweise

in einer Datenbank. Das gilt sowohl für Daten im herkömmlichen Sinne (Zahlen,

Wörter, Text, Flags) als auch für Multimediadaten. Da es sich hierbei nicht um

einfache“ Daten im Sinne von alphanumerischen Zeichenfolgen handelt, werden sie

”

in Multimedia-Datenbanksystemen (MMDBS) gespeichert.

Neben der Speicherung der Objekte ist auch der Zeitpunkt ihrer Ausgabe von

Inv.-Nr.: 2005-05-23/052/IN98/2254

10

KAPITEL 1. EINFÜHRUNG UND MOTIVATION

o3

o1

0

o2

15 17

27

42 47

Zeit

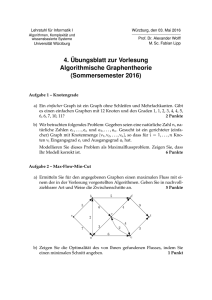

Abbildung 1.1: Absolute Ausgabezeiten von Medienbjekten

t3

t2

o3

t1

o1

0

o2

Zeit

Abbildung 1.2: Verknüpfung von Medienobjekten über relative Zeitabstände

Bedeutung. Eine lose Ansammlung von Medienobjekten in einer Datenbank ergibt noch keinen Film oder Musikstück. Möchte man einen Kuchen backen und

alle Zutaten liegen schon bereit, fehlt noch die Beschreibung, wie welche Zutaten

verarbeitet werden müssen: das Rezept. Ähnlich verhält es sich mit Medienobjekten. In der Regel wir für jedes Medienobjekt ein definiertes absolutes Intervall, die

Ausgabezeit, angegeben (Abbildung 1.1). Ändert sich die Dauer eines Objektes,

muss auch das Intervall entsprechend der Änderung angepasst werden. Aus diesem

Grund ist es wichtig, Bedingungen für die Ausgabe zu formulieren, auf deren Basis

die Ausgabezeiten automatisch berechnet werden können.

Eine Besonderheit der Ausgabebedingungen ist, dass man nicht die konkreten

absoluten Zeiten angibt, zu denen die Objekte ausgegeben werden sollen, sondern

relative Zeitabstände. Die Zeiten t1 , t2 und t3 in Abbildung 1.2 bedeuten, dass

Objekt o1 genau t1 Zeiteinheiten (ZE) nach Objekt o2 kommen soll, Objekt o3

eine Dauer von genau t3 ZE haben muss und erst t2 ZE nach dem Start von o2

ausgegeben werden soll. Ändert man die Dauer eines Objektes, z. B. von o1 , ergeben

sich die Ausgabezeiten aufgrund der Bedingungen bzw. der Dauer der Objekte und

können automatisch berechnet werden. Es existiert jedoch noch keine effiziente

Methode, eine größere Anzahl von Ausgabebedingungen auf Konsistent zu prüfen

und anschließend den Ausgabeschedule zu bestimmen. Ein praktischer Gebraucht

ist momentan nur für kleine Projekte gegeben.

Das Ändern von Bedingungen kann zu Inkonsistenzen führen, wenn zwei oder

mehr Bedingungen im Widerspruch zueinander stehen. Für einfache Daten (Text,

Zahlen usw.) lassen sich beim Erstellen einer Tabelle Bedingungen definieren, so

genannte Constraints. Beim Speichern prüft das DBMS, ob die Daten mit diesen

Bedingungen konform gehen, also konsistent sind. Da es sich bei Ausgabebeding-

Inv.-Nr.: 2005-05-23/052/IN98/2254

11

ungen um komplexe Zusammenhänge handelt, sind die in Datenbanken vorhandenen herkömmlichen Mechanismen der Überprüfung nicht ausreichend. Aus diesem

Grund müssen andere Wege gefunden werden, um die Bedingungen effizient zu

überprüfen und konsistent zu halten.

Fasst man beide Ziele zusammen, die zentrale Speicherung von Medienobjekten

in einem Multimedia-Datenbanksystem und die effiziente, automatische Überprüfung der Bedingungen, stellt sich die Aufgabe, beides in einem DBMS zu zentralisieren. Das ist das Ziel dieser Diplomarbeit. Es müssen Wege gefunden werden,

die Problemstellung auf bekannte Strukturen und Methoden in einem DBMS abzubilden. Des Weiteren stellt sich die Frage nach der Kosten-Nutzen-Rechnung.

Die Abbildung der Aufgabenstellung auf bekannte Probleme, also der Weg von der

Erstellung der Ausgabebedingungen bis zur internen Darstellung in der Datenbank

und der Überprüfung verursacht Kosten. Es muss bewertet werden, ob der Nutzwert die zusätzlichen Kosten rechtfertigen. Im Idealfall soll die Speicherung der

Daten und der Bedingungen unabhängig von einem Anwendungsprogramm über

SQL-Befehle erfolgen. Der anschließende Konsistenzcheck muss sehr effizient sein,

damit ein praktischer Gebrauchswert für den Nutzer gegeben ist.

Ein konkretes Anwendungsbeispiel ist die Modulation von Audiosignalen mittels Wellenfeldsynthese (WFS) [BV94]. Sie beruht auf dem Huygen‘schen Prinzip

[GS26] und ermöglicht mit Hilfe eines Lautsprecherarrys eine exakte Erzeugung eines beliebigen Schallfeldes, das hinsichtlich Ort, Ausrichtung, Bewegung und räumlicher Umgebung physikalisch korrekt dargestellt wird [TWR02]. Als Ergebnis erhält man ein natürliches und räumliches Klangfeld an jeder Stelle des Wiedergaberaumes. Dem Hörer wird der Eindruck vermittelt, dass die Tonquellen nicht die

Lautsprecher sind, sondern sich z. B. mitten im Raum oder auch hinter der Kinoleinwand befinden. Im Gegensatz zum 5.1-Sourroundsoundsystem befindet sich der

sogenannte Sweet-Point“ (Punkt der optimalen Klangwahrnehmung) nicht an einer

”

bestimmten Stelle im Raum, sondern erstreckt sich über den gesamten Hörbereich.

Auf diese Weise ist es möglich, in einem kleinen Raum die Akkustik jedes einzelnen

Instrumentes eines in einem Konzertsaal spielenden Orchesters exakt nachzubilden.

Um diese Effekte zu erzeugen, müssen mehrere Samples in zeitlicher Abhängigkeit moduliert und im Präsentationsraum ausgegeben werden. Solche Szenen können in einer Datenbank abgespeichert und anschließend ausgegeben werden. Angewendet wird diese Methode bereits im IOSONO-System, welches am FraunhoferInstitut entwickelt [FG04] und kommerziell genutzt werden soll [FI04a]. In [HSRG04]

wird gezeigt, wie Ausgabebedingungen für die Datenmodellierung und korrekte

Ausgabe der Medienobjekte zur Wellenfeldsynthese genutzt werden können. Aufbauend auf dieser Quelle beschäftigt sich diese Arbeit hauptsächlich mit der effizienten Überprüfung der Bedingungen und anschließend mit der Integration in ein

Multimedia-Datenbanksystem.

Aufbau der Diplomarbeit

In Kapitel 2 wird auf alle erforderlichen Grundlagen und bisherige Arbeiten und

Artikel zu diesem Thema eingegangen und der Weg von der Modellierung der Bedingungen bis zur Speicherung in der Datenbank besprochen. Anschließend werden

in den Kapiteln 3 und 4 zwei Methoden zur effizienten Überprüfung der Bedingungen vorgestellt. Neben der Konsistenz der Daten ist letztendlich auch deren

korrekte zeitliche Ausgabe wichtig. Kapitel 5 beschäftigt sich mit der effizienten

Berechnung des Ausgabeschedule. Kapitel 6 bewertet anschließend die vorgestell-

Inv.-Nr.: 2005-05-23/052/IN98/2254

12

KAPITEL 1. EINFÜHRUNG UND MOTIVATION

ten Algorithmen und Methoden.

Inv.-Nr.: 2005-05-23/052/IN98/2254

Kapitel 2

Grundlagen und Related

Work

Dieses Kapitel geht auf alle nötigen Begriffe und Methoden ein, die sich mit dem

Thema der Definition von Ausgabebedingungen, Konsistenzüberprüfung und Ausgabeschedule beschäftigen. Ebenso werden Mechanismen und Architekturen zur

Konsistenz- bzw. Integritätsüberprüfung in einem DBMS vorgestellt. Aufbauend

auf den Grundlagen, wird der Weg von der Formulierung der Bedingungen bis zum

Konsistenzcheck und Speicherung in der Daten in einer Datenbank erläutert.

2.1

Multimedia-Datenbanksysteme

Für Multimedia-Datenbanksysteme oder kurz MMDBS existiert bisher keine feste Definition. Im Allgemeinen werden Datenbankmanagementsysteme

(DBMS) als Multimedia-Datenbank bezeichnet, die eine Speicherung von Multimedia-Daten ermöglichen. Multimedia-Daten setzen sich aus zwei Komponenten zusammen. Zum einen aus Medienobjekten (Videos, Audiosamples, Bilder oder

Texte) und zum anderen aus Multimedia-Objekten, die eine Komposition aus Medien-Objekten verschiedener Medien darstellen, wie zum Beispiel ein Bild kombiniert mit einem Audio-Sample.

Da das Datenaufkommen von Multimediadaten im Allgemeinen größer ist als

das normaler“ alphanumerischer Daten, müssen MMDBS zusätzlichen Anforde”

rungen gegenüber DBMS gerecht werden. Khoshafian und Baker [KB95] formulieren folgende notwendige Funktionalitäten (vgl. [HSS03]):

• Unterstützung für Bild- und Mediendatentypen,

• Fähigkeiten, zur Verwaltung einer großen Anzahl von Medien-Objekten,

• effiziente Speicherverwaltung,

• Datenbankfunktionalität,

• Information-Retrieval-Funktionalität.

Die Speicherung von Multimedia-Daten erfolgt entweder über allgemeine Datenbanktypen oder spezielle Medien-Objekttypen. Heutige relationale oder objektrelationale Datenbankmanagementsysteme bieten die Datentypen BLOB (Binary

Inv.-Nr.: 2005-05-23/052/IN98/2254

14

KAPITEL 2. GRUNDLAGEN UND RELATED WORK

Large Objekt) oder CLOB (Character Large Objekt) zur Speicherung der Medieninhalte an. Das objekt-relationale DBMS Oracle der gleichnamigen Firma stellt

darüber hinaus spezielle Medien-Datentypen zur Verfügung. Zum Speichern eines

Bildes nutzt man den Typ Image, welcher neben den eigentlichen Bilddaten zusätzliche Attribute, wie zum Beispiel Größe oder Auflösung des Bildes zur Verfügung

stellt.

Solche Medien-Datentypen wurden als Erweiterungen von SQL:1999 definiert.

Da die Speicherung der Multimedia-Daten in dieser Diplomarbeit keine direkte

Rolle spielt, wird auf diese speziellen Datentypen nicht näher eingegangen. Die implementierten Algorithmen gehen stets von Multimedia-Objekten aus, die intern

aber nur über einen Bezeichner angesprochen werden. Die eigentlichen Daten sind

für die Definition, Überprüfung der Bedingungen und Berechnung der Ausgabezeiten nebensächlich.

In dieser Arbeit werden Datenbanksysteme als MMDBS bzw. DBMS verstanden, die eine Speicherung von Multimediadaten ermöglichen [ABH97] und aktiv

auf definierbare Ereignisse reagieren können (siehe Abschnitt 2.4).

2.2

Integritätsbedingungen

Neben der Speicherung von Daten, gehört zu den Aufgaben eines DBMS auch die

Gewährleistung der Integrität und Konsistenz der Daten. Dazu zählen neben dem

Schutz der Daten bei Mehrbenutzerzugriff auch die so genannten semantischen

Integritätsbedingungen. Diese ergeben sich aus dem Modell, mit dem das abzubildende Problem beschrieben wird (vgl. [KE01]). Wenn zum Beispiel ein Name

in einer Tabellenspalte nicht mehrfach vorkommen darf, kann man diese Bedingung (Primärschlüssel) in Form eines SQL-Befehls bei der Erzeugung der Tabelle

angeben.

Datenbanksysteme bieten standardmäßig diverse Möglichkeiten, die Integrität

der Daten durch sogenannte Constraints zu gewährleisten. So ist es zum Beispiel

möglich, für eine Spalte einen bestimmten Datentyp und Wertebereich anzugeben.

Versucht man einen Wert außerhalb dieses Bereiches einzutragen, wird die Insertoder Update-Operation abgebrochen. Auf diese Art wird die Konsistenz der Daten

in den Tabellen gewährleistet.

Die Integrität der Daten in der Datenbank muss nicht zwingend zu jedem Zeitpunkt gegeben sein. In diesem Zusammenhang spielt der Begriff der Transaktion

eine große Rolle. Eine Transaktion ist eine Folge von Anweisungen zur Manipulation

von Daten, die als Einheit betrachtet wird. Das Ende einer Transaktion wird durch

den commit-Befehl signalisiert. Nach erfolgreicher Abarbeitung der Befehlsfolge

auf einem konsistenten Datenbestand ist die Datenbank wieder in einem zulässigen

Zustand (vgl. [HS00]). Jede Transaktion muss die so genannten ACID - Eigenschaften erfüllen. ACID steht für: Atomicity (Atomarität), Consistency (Konsistenz),

Isolation und Durabiltity (Dauerhaftigkeit).

2.3

Architekturen zur Integritätssicherung

Die Integritäts- oder Konsistenzprüfung von Grunddatentypen ist gut erforscht und

in allen heutigen Datenbankmanagementsystemen implementiert. Zur Überprüfung

von Ausgabebedingungen im Sinne der Aufgabenstellung reichen diese Möglichkeiten aber nicht aus. Durch die im Vergleich zu einfachen Datentypen kompliziertere

Inv.-Nr.: 2005-05-23/052/IN98/2254

2.3. ARCHITEKTUREN ZUR INTEGRITÄTSSICHERUNG

Anwendung 1

Routinen

15

Anwendung n

Routinen

DBMS

Datenbank

Abbildung 2.1: Integritätssicherung durch Routinen in den Anwendungen

Datenstruktur und größeren funktionellen Zusammenhänge, ist auch die Konsistenzprüfung bzw. -sicherung aufwendiger.

Für die Integrität der Daten spielt es keine Rolle, an welcher Stelle der Datenbank-Anwendungsstruktur die Überprüfung erfolgt. Nachfolgend werden drei

Architekturvarianten vorgestellt, die an unterschiedlichen Punkten die Integritätsbedingungen verwirklichen (vgl. [HS00]).

2.3.1

Integritätssicherung durch Anwendung

Die Integritätssicherung ist eine von vielen Forderungen an ein Datenbankmanagementsystem. Sie muss bzw. kann aber nicht immer zwingend in vollem Umfang

durch das DBMS erfolgen. Stellt es unzureichende Integritätsbedingungen zur Verfügung, wird die Überprüfung durch die Applikation, welche auf die Datenbank

zugreift, selbst vorgenommen (Abbildung 2.1). Die Bedingungen können flexibel

in der von der Anwendung verwendeten Programmiersprache implementiert und

auf diesem Wege Unzulänglichkeiten der Integritätssicherung des DBMS beseitigt

werden. Man spricht hier von operativen Bedingungen, im Gegensatz zu deklarativen, die Bestandteil der Datendefinitions- (DDL) bzw. Datenmanipulationssprache

(DML) des DBMS sind.

Der Nachteil dieser Methode besteht in der dezentralen Überprüfung und der

daraus resultierenden Mehrfachimplementierung der Bedingungen. Dadurch können vermehrt Fehler auftauchen, bzw. die Korrektheit muss mehrfach nachgewiesen

werden. Außerdem kann es zu Inkonsistenzen nach partiellen Änderungen kommen

(Problem der verteilten Systeme).

2.3.2

Integritätssicherung durch DBMS

Eine übliche Form der Integritätssicherung für einfache Datentypen ist die Überprüfung durch einen Integritätsmonitor (Abbildung 2.2). Er ist Teil des DBMS und

Inv.-Nr.: 2005-05-23/052/IN98/2254

16

KAPITEL 2. GRUNDLAGEN UND RELATED WORK

Anwendung 1

Anwendung n

DBMS

Monitor

Datenbank

Abbildung 2.2: Integritätssicherung durch Integritätsmonitor

somit unabhängig von der jeweiligen Applikation. Die Integritätsbedingungen sind

Teil der Datendefinitions- bzw. Datenmanipulationssprache und werden über diese

deklariert. Durch die Integration der Überprüfung in das DBMS werden Redundanz

und Fehlerquellen vermieden, da die Integritätsüberwachung nur an einer zentralen

Stelle implementiert ist. Der Nachteil dieser Methode ist, dass bis heute nur sehr

einfache Bedingungen definiert werden können bzw. vom DBMS zur Verfügung

gestellt werden.

Die Integritätsbedingungen von SQL lassen sich grob unterteilen in modellinherente und tabellenübergreifende Bedingungen, welche explizit angegeben werden.

Erstere ergeben sich implizit aus der Struktur des Datenbankmodells, wie zum

Beispiel definierte Datentypen, Wertebereiche von Attributen oder Primär- und

Fremdschlüssel. Für die Überprüfung von Ausgabebedingungen von Medienobjekten sind die heute vorhandenen Möglichkeiten der modellinherenten Bedingungen

nicht geeignet.

Das Konzept der tabellenübergreifenden Integritätsregeln hat sich nicht vollständig in Datenbanksprachen durchsetzen können. Heutige Systeme unterstützen

eine simplere Version solcher Regeln: sogenannte Trigger. Sie bieten zusätzlich zu

den deklarativen Bedingungen auch die Möglichkeit zur Beschreibung von operativen Bedingungen. Durch Verwendung einer Programmiersprache, im Allgemeinen

PL/SQL oder Java, können nahezu beliebige Integritätsbedingungen definiert und

direkt durch das DBMS überprüft werden. Trigger und aktive Datenbanksysteme

werden in Abschnitt 2.4 ausführlicher besprochen.

2.3.3

Integritätssicherung durch Kapselung

Die Nachteile der bisher vorgestellen Methoden, Redundanz bei Integritätssicherung durch die Anwendung und unzureichende Bedingungen von Integritätsmonitoren, sollen durch eine dritte Architektur vermieden werden: Integritätssicherung

durch Einkapselung (Abbildung 2.3). Die Integritätsüberprüfung wird durch ei-

Inv.-Nr.: 2005-05-23/052/IN98/2254

2.4. AKTIVE DATENBANKSYSTEME UND TRIGGER

Anwendung 1

17

Anwendung n

Kapselung

DBMS

Datenbank

Abbildung 2.3: Integritätssicherung durch Kapselung

ne Zwischenschicht ausgeführt. Die Anwendungen greifen ausschließlich über diese

Schicht auf die Daten zu, ein direkter Zugriff auf die Datenbank per SQL-DDL ist

grundsätzlich nicht erlaubt. Durch die zwar vorgelagerte, aber zentrale Überprüfung wird Redundanz vermieden und das volle Spektrum der Integritätssicherung

durch operative Bedingungen in einer beliebigen Programmiersprache zur Verfügung gestellt.

2.4

Aktive Datenbanksysteme und Trigger

DBMS legen in Allgemeinen ein passives Verhalten an den Tag. Das heisst, Operationen auf den Daten werden expizit vom Nutzer ausgelöst. Wird ein reaktives

Verhalten gewünscht, also eine der Situation angepasste Reaktion auf ein Ereignis,

muss dies bisher oft aufwendig im Anwendungsprogramm implementiert werden.

Mit herkömmlichen DBMS kann solch ein reaktives Verhalten auf zwei Wege realisiert werden. Zum einen durch Polling, also regelmäßiges Abfragen der Datenbank.

Da man nicht immer abschätzen kann, wann das gewünschte Ereignis eintritt, kann

das Polling zu oft erfolgen und damit wertvolle Ressourcen belegen, oder zu selten,

und das Ereignis könnte verpasst werden. Zum anderen lässt sich diese Aufgabe in

das Anwendungsprogramm verlegen. Hier treffen aber wieder die gleichen Nachteile

wie bei der Integritätssicherung durch die Anwendung auf (vgl. Abschnitt 2.3.1).

Analog zur Integritätssicherung liegt es auch hier nahe, das Erkennen solcher

Situationen, die ein reaktives Verhalten erfordern, in das DBMS selbst zu verlegen.

Man spricht von so genannten aktiven Datenbanksystemen (aktive DBS). Eine

Definition solcher Systeme findet sich in [DG00]:

Ein Datenbanksystem heisst aktiv, wenn es zusätzlich zu den üblichen DBS-Fähigkeiten in der Lage ist, definierbare Situationen in der

Inv.-Nr.: 2005-05-23/052/IN98/2254

18

KAPITEL 2. GRUNDLAGEN UND RELATED WORK

Datenbank (und wenn möglich darüber hinaus) zu erkennen und in der

Folge davon bestimmte (ebenfalls definierbare) Reaktionen auszulösen.

Im Gegensatz zu konventionellen DBMS bieten aktive DBS zusätzliche Funktionalitäten. Zum einen muss die interessierende Situation definierbar sein und erkannt

werden können, und zum anderen muss sich eine Reaktion definieren lassen und

diese beim Erkennen der Situation automatisch ausgeführt werden. Die Aufgaben

herkömmlicher DBS sollen unabhängig von diesen neuen Funktionen in aktiven

Systemen nebenbei weiter laufen. Durch die Erweiterung um einen aktiven Teil

eines DBS basierend auf einem konventionellen System, spricht man zum Beispiel

von aktiven relationalen oder aktiven objekt-relationalen DBS.

ECA-Regel

Die interessierende Situation, auf die eine Reaktion erfolgen soll, muss in geeigneter Weise im DBMS beschrieben und auch erkannt werden. Alle Vorgänge in einem DBMS werden durch Operationen ausgelöst. Soll zum Beispiel der Wert eines

Integer-Tabellenfeldes eine bestimmte Grenze nicht überschreiten, wird überprüft,

ob dieses Feld geändert wurde (Operation) und danach mit der Grenze verglichen.

Die interessierende Situation setzt sich also allgemein aus einem Ereignis und einer

Bedingung zusammen.

Ein Ereignis ist ein Vorgang, der zu einem festen Zeitpunkt auftritt. Es wird

durch ein WAS und WANN charakterisiert. Die Bedingung gibt an, welche Voraussetzungen erfüllt sein müssen, damit zusätzlich zum Ereignis eine interessierende

Situation vorherrscht. Dazu können die Daten und der aktuelle Zustand des DBMS

genutzt werden. Eine Aktion gibt an, wie das DBMS auf eine bestimmte Situation

reagieren soll. Tritt ein Ereignis ein und ist die Auswertung der Bedingung positiv,

kann anschließend die gewünschte Aktion erfolgen. Fasst man die drei Teile (Ereignis, Bedingung, Aktion) zu einem Tripel zusammen, spricht man von Regeln, bzw.

von ECA-Regeln (event/condition/action).

Über solche Regeln wird der Zusammenhang zwischen der interessierenden Situation und der Reaktion hergestellt. Trigger sind eine eingeschränkte Version von

ECA-Regeln, werden aber häufig als Synonym für diese verwendet. Wird ein Trigger im DBMS definiert, wird das Eintreten relevanter Ereignisse überprüft. Ist dies

der Fall, wird der Trigger ausgelöst. Man sagt auch: er wird gefeuert. Anschließend wird die Bedingung auf Richtigkeit überprüft und im positiven Fall die Aktion

ausgeführt.

ECA-Regeln sind wie folgt aufgebaut:

DEFINE RULE rule name

ON event clause

IF cond clause

DO action clause

execution constraints

Das Ereignis (event clause) legt fest, WAS zum Zeitpunkt WANN geschehen

muss, um den Trigger zu feuern“. Es müssen nicht zwingend immer beide Teile

”

(WANN und WAS) angegeben werden. Spezifiziert man nur einen Zeitpunkt, stellt

der gleichzeitig auch das WAS dar. Ereignisse lassen sich in Klassen zusammenfassen, wenn sie einen ähnlichen Kontext aufweisen. Des Weiteren ist es möglich,

Inv.-Nr.: 2005-05-23/052/IN98/2254

2.5. MODELLIERUNG VON AUSGABEBEDINGUNGEN

19

unterschiedliche Ereignisse zu verknüpfen. Man spricht hier von zusammengesetzten Ereignissen.

Registriert das DBMS ein spezifiziertes Ereignis, wird der Trigger gefeuert. Anschließend wird die Bedingungsregel (cond clause) ausgewertet. Gibt sie ein true

zurück, wird die eigentliche Aktion action clause ausgeführt. Als Operationen sind

beliebige DDL-/DML-Konstrukte oder auch der Aufruf einer in der Datenbank

gespeicherten Prozedur (stored procedures) möglich.

Stored Procedures

Stored Procedures sind Programme, die direkt im Kernel des DBMS aufgeführt

werden. Man spricht hierbei von serverseitiger Programmierung. Das DBMS der

Firma Oracle unterstützt seit Version 8i neben PL/SQL auch Java-Programme als

gespeicherte Prozeduren [BS02]. Dazu wird der Bytecode in die Datenbank geladen

und kann anschließend durch die im Kernel der Datenbank integrierte Java Virtual

Machine (JVM) ausgeführt werden. Die Klassen des Java Development Kit (JDK)

liegen in einer nativ kompilierten Version vor, was eine Geschwindigkeitssteigerung

in der Ausführung der gespeicherten Prozeduren zur Folge hat.

Durch die Verwendung von Java ist es möglich, komplexere Vorgänge, im speziellen Fall Integritätsbedingungen, im DBMS abzubilden und zu integrieren. Wurden

Integritätsregeln in einem externen Java-Programm implementiert, können diese

mit wenigen Anpassungen in die Datenbank verlagert werden. Die Ausführung von

Programmen in der serverseitigen JVM bringt aber auch Nachteile. Zunächst muss

der Einstiegspunkt der gespeicherten Java-Prozedur eine statische Methode sein.

Nur statische Attribute und Methoden von Klassen können im Data Dictionary

von Oracle publiziert werden. Des Weiteren ist es nicht möglich, Instanzen von

GUI-Objekten zu erzeugen, was aber angesichts der fehlenden graphischen Ausgabemöglichkeiten des Datenbank-Kern nicht notwendig ist.

Die größte Einschränkung ist die fehlende Unterstützung für Multithreading.

Es ist prinzipiell möglich, Programme mit mehreren Threads zu implementieren.

Vorhandener Quellcode muss nicht verändert werden. Die Threads laufen im Kernel des DBMS nacheinander ab, im Gegensatz zum gleichzeitigen Ablauf in einer

normalen JVM. Man sagt dazu auch präemptives Multithreading. Benötigt ein

Thread den Prozessor für sich alleine, werden alle anderen Threads für diese Zeit

blockiert. Es ist sinnvoll auf Threads zu verzichten, da kein Performancegewinn

durch Multithreading zu erwarten ist.

Nachdem alle nötigen Mechanismen des DBMS vorgestellt wurden, beschäftigt

sich der nächste Abschnitt mit der Modellierung, Speicherung und Überprüfung

der eigentlichen Ausgabebedingungen.

2.5

Modellierung von Ausgabebedingungen

Um Ausgabebedingungen auf ihre Konsistenz zu prüfen, muss als erstes eine geeignete Form zur Beschreibung der funktionalen Zusammenhänge gefunden werden.

Es existieren bereits diverse Möglichkeiten, zeitliche oder räumliche Abfolgen von

Medienobjekten zu definieren. Die Synchronized Multimedia Integration Language,

kurz SMIL ([Roi98], [HL01], [Mi05]), ermöglicht eine allgemeine Definition die Dokumentenstruktur für Mediendaten. Es kann für die Positionierung, Synchronisation und Präsentation von Medoenobjekten genutzt werden. Der RealPlayer der

Inv.-Nr.: 2005-05-23/052/IN98/2254

20

KAPITEL 2. GRUNDLAGEN UND RELATED WORK

Firma RealNetworks oder Quicktime von Apple unterstützen zum Beispiel dieses

Format.

In [Ra04] werden bestehende Beschreibungsmöglichkeiten bewertet und eine

neue Form zur Beschreibung von Ausgabebedingungen in einer Multimedia-Datenbank konzipiert. Als Ergebnis wird eine Kombination von Allen-Relationen und

Difference Constraints vorgeschlagen, um auf einfache und verständliche Art

räumliche und zeitliche Bedingungen zu definieren. In den Abschnitten 2.5.1 und

2.5.2 werden die Grundlagen der Allen-Relationen und Difference Constraints vorgestellt. Durch die Transformation der Allen - Relationen in Difference Constraints

ist ein Konsistenzcheck auf gund eines Constraint Graphen mittels des Algorithmus von Bellman und Ford (Abschnitt 2.5.3) möglich, also die Überprüfung

der Ausgabebedingungen.

[He04] nutzt die Ergebnisse von [Ra04] und definiert eine Schnittstelle, die es

dem Nutzer ermöglicht, aus einer Auswahl von Allen Relationen räumliche und

zeitliche Bedingungen zu definieren.

Aufbauend auf diesem Artikel ist im Rahmen einer Studienarbeit das Programm ConstraintManager entstanden [Ha04], welches Ausgabebedingungen aus

einer XML-Datei ausliest, auf Konsistenz prüft und in der Datenbank speichert.

Die in diesem Programm definierten Tabellenstrukturen und Klassen werden in der

vorliegenden Arbeit verwendet und erweitert.

Die folgenden Abschnitte beschreiben die Transformation der Bedingungen, von

der Formulierung bis zur Speicherung in der Datenbank. Der eigentliche Konistenzcheck erfolgt zunächst durch ein externes Programm. Die Integritätsicherung

entspricht der in Abschnitt 2.3.1 vorgestellten Architektur. Anschließend wird der

Konsistenzcheck in das DBMS in Form eines Integritätsmonitors (vgl. Abschnitt

2.3.2) implementiert und hinsichtlich der Effizienz und praktischem Nutzen bewertet (Kapitel 6).

2.5.1

Allen-Relationen

Allen-Relationen [Al83] sind Konstrukte, mit denen feste Zeitintervalle (Objekte

mit einer definierten Dauer) zeitlich angeordnet werden können. Der große Vorteil

gegenüber anderen Beschreibungsmöglichkeiten (siehe nächster Abschnitt) liegt in

der einfachen Verständlichkeit für den Nutzer. Viele andere Modelle bauen auf

den Allen-Relationen auf, um eine zeitliche Strukturierung zu realisieren [DK95].

Nachteilig ist, dass keine funktionalen Zusammenhänge definiert werden können.

Eine Allen-Relation kann zum Beispiel lauten: A before B. Es kann nicht definiert werden, wie viele Zeiteinheiten A vor B kommen soll. Durch Veränderung der

Intervalle von A und B kann die Relation in ein meets, overlaps oder finishes-invers

verwandelt werden. Das ist hinsichtlich der Verständlichkeit beim Nutzer ein weiterer Nachteil. Welche Allen-Relationen es gibt und was sie im einzelnen bedeuten,

ist in [Ra04] ausführlich beschrieben.

Die Überprüfung der Konsistenz von Allen-Relationen erweist sich ebenfalls

als schwierig. Sie ist nur mit erheblichen Aufwand durchzuführen, da es sich um

ein NP-vollständiges Problem handelt. Durch diese Einschränkung sind die AllenRelationen zunächst nicht für die Beschreibung von Ausgabebedingungen brauchbar.

Inv.-Nr.: 2005-05-23/052/IN98/2254

2.5. MODELLIERUNG VON AUSGABEBEDINGUNGEN

2.5.2

21

Difference Constraints

Die Nachteile der Allen-Relationen sind bei Difference Constraints nicht vorhanden

([CLS00],[CPS96]). Mit ihnen ist es möglich, sowohl zeitliche als auch räumliche Zusammenhänge zwischen Objekten zu definieren. Dieser Vorteil lässt sich nutzen, da

Allen-Relationen in Difference Constraints transformiert werden können. Folgender

Difference Constraint entspricht der Allen-Relation A before B:

end(A) − st(B) ≤ c1 ,

c1 < 0.

Die Konstante c1 beschreibt den zeitlichen Mindestabstand zwischen den Endzeitpunkt von Objekt A und dem Startzeitpunkt von Objekt B. Es ist auch möglich,

außer Mindestabständen variable oder feste Intervalle zwischen zwei Objekten zu

definieren.

Neben den zeitlichen Bedingungen gibt es zusätzlich noch einen Duration-Constraint, welcher die Dauer eines Medienobjektes definiert:

end(O) − st(O) ≤ cDauer ,

st(O) − end(O) ≤ −cDauer , cDauer > 0

und diverse Constraints zur räumlichen Anordnung von Objekten. Eine Übersicht ist [Ra04] zu entnehmen.

Die Menge aller Bedingungen wird als ein System von Difference Constraints <

V,C > bezeichnet. Die Konsistenzprüfung dieses Systems mit Hilfe des Algorithmus

von Bellman und Ford wird im folgenden Abschnitt beschrieben.

Difference Constraints stellen eine Möglichkeit dar, alle gewünschten Informationen und Forderungen als Ausgabebedingungen abzubilden. Sie sind aber für

den Nutzer schwer verständlich. Das Manko der fehlenden funktionalen Zusammenhänge von Allen-Relationen wird in [He04] durch Erweiterung der Relationen

mit Parametern gelöst. Bei der Umwandlung der Allen - Relationen in Difference

Constraints bilden diese Parameter die Konstanten der einzelnen Ungleichungen.

Auf diese Art und Weise wird dem Nutzer eine Lösung zur Verfügung gestellt, die

sowohl leicht verständlich ist, als auch alle gewünschten Anforderungen zur Definition von Ausgabebedingungen erfüllt. Eine Übersicht der zur Verfügung stehenden

erweiteretn Allen-Relationen befindet sich im Anhang A.1.

2.5.3

Bellman und Ford

Die effiziente Überprüfung der Bedingungen (Konsistenzcheck) stellt das Hauptproblem der Thematik dar. Zunächst müssen die Difference Constraints, welche

die Ausgabebedingungen repräsentieren, in eine geeignete Form transformiert werden. Aus der Menge der Difference Constraints wird ein gerichteter und gewichteter

Graph gebildet, der die Bedingungen repräsentiert und auf Konsistenz geprüft werden kann.

Der Vorgang der Konsistenzprüfung lässt sich auf die Suche nach kürzesten

Wegen in gerichteten Graphen von einem Knoten aus reduzieren. Kann von einem

definierten (Start-) Knoten aus zu jedem anderen Knoten im Graphen ein kürzester

Weg gefunden werden, ist der Graph konsistent. Lässt sich kein kürzester Weg zu

diesem Knoten bestimmen, existiert ein negativer Zyklus auf dem Weg zu diesem

Knoten. Dieser Zyklus wird bei der Suche nach demm kürzesten Pfad immer wieder

durchlaufen, so dass es einen immer noch kürzeren Weg gibt. Das bedeutet eine

Inv.-Nr.: 2005-05-23/052/IN98/2254

22

KAPITEL 2. GRUNDLAGEN UND RELATED WORK

Inkonsistenz. Die Konsistenz des Graphen ist also direkt davon abhängig, ob ein

negativer Zyklus von einem Startknoten existiert, bzw. ob sich die kürzesten Wege

bestimmen lassen. Die Weglängen sind gleichzeitig Grundlage zur Berechnung der

Ausgabezeiten.

Zur Berechnung von kürzesten Pfaden in gerichteten Graphen von einem Knoten aus existieren diverse Algorithmen. Einer der bekanntesten

Algorithmen ist von

2

Dijkstra [Di59]. Er hat eine Zeitschranke von O |V | und ist für Graphen mit positiven Kantengewichten definiert (vgl. [Br94]). Die aus den Difference Constraints

erstellten Graphen besitzen aber auch negative Kantengewichte, für die der Algorithmus von Dijkstra nicht verwendet werden kann. Aus diesem Grund muss auf

den Algorithmus von Bellman und Ford [Be59] zurückgegriffen werden. Er ist für

gerichtete Graphen mit negativen Kantengewichten definiert, hat aber im Vergleich

zu Dijkstra die schlechtere Zeitschranke O (|V | · |E|).

Die Vorgehensweise der Umwandlung der Difference Constraints wurde schon

in [Ra04] beschrieben, wird hier aber noch einmal erwähnt, da sie eine zentrale

Rolle beim Konsistenzcheck einnimmt.

Die Menge der Difference Constraints wird als System von Difference Constraints < V,C > bezeichnet. Es besteht aus einer Menge V von Variablen und einer

Menge C von linearen Ungleichungen der Form:

xi − xj ≤ ck , 1 ≤ i, j ≤ n, 1 ≤ k ≤ m,

xi , xj ∈ V, ck = const.

(2.1)

Zur Überprüfung der Bedingungen mittels Bellman und Ford wird ein Constraint Graph erstellt. Jede Ungleichung wird durch je 2 Knoten (die Unbekannten)

repräsentiert, welche durch eine gerichtete und gewichtete Kante verbunden sind.

Das Gewicht der Kante entspricht dem Wert der Konstante ck . Der entsprechende

Constraint Graph ist ein gerichteter und gewichteter Graph G =< V, E >:

V = {v0 , v1 , v2 , ..., vn } ,

E = {(vj , vi ) : xi − xj ≤ ck } ∪ {(v0 , v1 ), (v0 , v2 ), ..., (v0 , vn )} ,

Kantengewichte : w(vj , vi ) = ck , i, j 6= 0, w(v0 , vi ) = 0, n < 0.

(2.2)

Der Graph kann je nach Zusammensetzung der Bedingungen ein zusammenhängender Graph sein oder aus Teilgraphen bestehen. Durch das Hinzufügen des

Startknotens v0 und den von ihm ausgehenden Kanten zu jedem anderen Knoten

wird sichergestellt, dass alle Knoten erreichbar sind und somit ein zusammenhängender Graph existiert.

Der Algorithmus von Bellman und Ford berechnet die kürzesten Pfade von einem definierten Startknoten zu jedem anderen Knoten im Graphen, falls dieser

erreichbar ist. Im Falle eines negativen Zyklus würde es immer einen noch kürzeren

Weg geben. In diesem Fall bricht der Algorithmus ab und liefert ein f alse zurück.

Die Bedingungen hätten somit den Konsistenzcheck nicht bestanden. Gibt der Algorithmus ein true aus, ist das System von Difference Constraints konsistent und

der Schedule kann anhand der kürzesten Pfade berechnet werden. Die Berechnung

der Ausgabezeiten wird in Kapitel 5 erläutert.

Die Zeitschranke O (|V | · |E|) des Algorithmus von Bellman und Ford ist abhängig von der Komplexität des Graphen. Je mehr Kanten und Knoten der Graph

besitzt, um so aufwendiger und kostenintensiver ist der Konsistenzcheck. Durch die

Inv.-Nr.: 2005-05-23/052/IN98/2254

2.5. MODELLIERUNG VON AUSGABEBEDINGUNGEN

23

expotentielle Laufzeit kann man sich sehr leicht beim Aufwand verschätzen. Um

ein Beispiel zu nennen: Ein PC mit 3 GHz benötigt für einen kompletten Check

eines Graphen mit 2000 Knoten und ca. 6000 Kanten ca. 19 Minuten. Für diesen Test wird die Testschleife des Algorithmus etwa 12 Millionen mal durchlaufen.

Der selbe PC braucht für einen Graphen mit 10.000 Knoten und 30000 Kanten

(Faktor 5) jedoch 101 Stunden (Faktor 300). Dies entspricht ca. 300 Milliarden

Schleifendurchläufe. Ein Konsistenzcheck muss bei jeder einzelnen Änderung einer

Bedingung durchgeführt werden. Dies ist bei großen Graphen nicht praktikabel.

Mit der Optimierung des Konsistenzcheck mittels Bellman und Ford beschäftigt sich das nächste Kapitel. Dort werden auch Beispiele für Constraint Graphen

aufgeführt.

2.5.4

Eingabe der Bedingungen - Der Constraint Manager

Nachdem gezeigt wurde, dass sich Difference Constraints zur Beschreibung von

räumlichen und zeitlichen Bedingungen eignen, müssen diese in eine Datenbank

eingegeben werden. Da sie nicht so leicht verständlich sind wie Allen-Relationen

ist es sinnvoll, dem Nutzer eine einfachere Möglichkeit zur Verfügung zu stellen.

Wie schon erwähnt, wurden in [He04] Vorschläge gemacht und eine Auswahl an

erweiterten Allen-Relationen für die Definition von Bedingungen zur Verfügung

gestellt.

Hauptsächlich auf diese Quelle aufbauend ist im Rahmen einer Studienarbeit

([Ha04]) das Programm ConstraintManager entstanden. Die Bedingungen werden

als Datei im XML-Format zur Verfügung gestellt. Sie beinhaltet alle zu einem

Projekt gehörenden erweiterten Allen Relationen und Duration Constraints.

Diese Form der Dateneingabe ist nicht sehr benutzerfreundlich. Wünschenswert

wäre ein Programm, in dem der Nutzer die Ausgabebedingungen über eine graphische Benutzeroberfläche erstellen kann und anschließend die XML-Datei automatisch generiert wird. Für Testzwecke ist der ConstraintManager aber ausreichend,

da nicht jeder einzelne Difference Constraint mühsam erstellt und von Hand“ in

”

die Datenbank eingegeben werden muss. Die XML-Dateien der in im Kapitel 6

vorgestellten Beispielprojekte wurden automatisch generiert.

Der ConstraintManager liest die Daten aus einer XML - Datei ein, konvertiert

sie in Difference Constraints und erstellt daraus einen Constraint Graph. Nach

erfolgreichem Konsistenzcheck mittels Bellman und Ford werden der Graph und

Informationen über die verwendeten Difference Constraints in einer Datenbank

gespeichert.

Die Speicherung erfolgt in zwei Tabellen (Tabellen 2.1 und 2.2). In Constraint Graphs wird der Constraint Graph gespeichert. Dazu werden alle Kanten

des Graphen mit Start-, Endknoten und Kantengewicht abgelegt. Eine Zeile entspricht einer Kante bzw. einem Difference Constraints. Aus den drei Einzeldaten

einer Kante (Start-, Endknoten und Kantengewicht) kann man durch Vertauschen

der Werte für Start- und Endknoten den entsprechenden Difference Constraint generieren und umgekehrt.

Definiert man die Relation A before(2) B, ergibt sich daraus folgender Difference

Constraint:

end(A) − st(B) ≤ −2

(2.3)

Jede Ungleichung entspricht einer Kante im Graphen. Die Knoten ergeben sich

Inv.-Nr.: 2005-05-23/052/IN98/2254

24

KAPITEL 2. GRUNDLAGEN UND RELATED WORK

Spaltenname

ID

Projekt

Startknoten

Endknoten

Gewicht

C ID

Bedeutung

Lfd. Nummer aller Kanten des Projektgraphen

Projektname

Startknoten der Kante

Endknoten der Kante

Gewicht der Kante

Nummer der Constraints

Tabelle 2.1: Tabelle Constraint Graphs

Spaltenname

ID

Projekt

C ID

Vorgaenger

Nachfolger

R ID

Bedeutung

Lfd. Nummer aller Constraints des Projektes

Projektname

Nummer der Constraints

Endknoten der Kante

Gewicht der Kante

Typ des Constraints

Tabelle 2.2: Tabelle Constraint Orders

implizit daraus. Die beim Parsen der XML-Datei enstandenen Difference Constraints (Ungleichungen) werden in SQL-Befehle konvertiert und somit in der Datenbank gespeichert. Die aus der Ungleichung 2.3 entstandene resultierende Kante

ist in Tabelle 2.3 zu sehen.

Für den klassischen Konsistenzcheck und die Berechnung des Ausgabeschedule reichen die gespeicherten Daten in der Tabelle Constraint Graphs aus. Für die

Optimierungen, welche in den folgenden Kapiteln beschrieben werden, sind aber zusätzliche Informationen notwendig. Die Tabelle Constraint Orders beinhaltet den

Typ und die beiden in Beziehung stehenden Objekte jedes Constraints. Der entsprechende Eintrag in der Tabelle zur before - Relation ist in Tabelle 2.4 dargestellt.

Inv.-Nr.: 2005-05-23/052/IN98/2254

2.5. MODELLIERUNG VON AUSGABEBEDINGUNGEN

ID

1

Projekt

Bsp1

Startknoten

st(B)

Endknoten

end(A)

Gewicht

-2

25

C ID

1

Tabelle 2.3: Beispiel Tabelleneintrag Constraint Graphs

ID

1

Projekt

Bsp1

C ID

1

Vorgaenger

A

Nachfolger

B

R ID

5

Tabelle 2.4: Beispiel Tabelleneintrag Constraint Orders

Inv.-Nr.: 2005-05-23/052/IN98/2254

26

KAPITEL 2. GRUNDLAGEN UND RELATED WORK

Inv.-Nr.: 2005-05-23/052/IN98/2254

Kapitel 3

Überprüfung mit Bellman Ford

Dieses Kapitel beschäftigt sich mit der Überprüfung von Ausgabebedingungen anhand eines Constraint Graphen durch den Algorithmus von Bellman-Ford. Ziel ist

es, den Konsistenzcheck anhand des Constraint Graphen so effektiv wie möglich

zu gestalten. Eine Optimierung ist erforderlich, da der Algorithmus von Bellman Ford eine Laufzeit von O(n ∗ m) besitzt. Die Testzeiten betragen bei sehr großen

Projekten mehrere Minuten bis Tage und sind somit nicht für den praktischen Gebrauch geeignet. Mit Hilfe von Optimierungen soll es möglich sein, auch größere

Projekte in einer vertretbaren Zeit auf Konsistenz zu überprüfen.

3.1

Beschränkungen und Beispiele

Der Konsistenzcheck ist gleichbedeutend mit der Suche nach negativen Zyklen.

Zur effizienteren Überprüfung sind einige Einschränkungen in der Graphstruktur

notwendig.

Negative Zyklen können auf zwei Arten entstehen. Zum einen gibt es lokale

negative Zyklen, die zwischen den Knoten zweier benachbarter Medienobjekten

existieren, falls die verknüpfende Bedingung nicht erfüllt ist. Zum anderen sind

auch globale negative Zyklen möglich. Sie können entstehen, wenn mehrere Objekte

transitiv miteinander in Beziehung stehen, zum Beispiel das erste und letzte Objekt

eines Projektes.

Die Problematik soll anhand eines Beispielprojektes verdeutlicht werden. Es

besteht aus vier Medienobjekten mit einer definierten Dauer (Tabelle 3.1) und drei

Allen-Relationen (Tabelle 3.2). Zum besseren Verständnis und Überblick über das

Beispielprojekt wird der Beziehungsgraph eingeführt.

Der Beziehungsgraph basiert auf den Allen-Relationen. Jedes Medienobjekt

wird durch einen Knoten repräsentiert und jede Allen-Relation durch eine gerichtete

Kante zwischen den betreffenden Objekten bzw. Knoten. Die Duration-Constraints

spielen im Beziehungsgraph keine Rolle, da sie keine Beziehungen zwischen Objekten abbilden. Der Startknoten v0 1 ist notwendig, ähnlich wie beim Constraint

1 Ein Startobjekt bzw. -knoten v existiert sowohl im Beziehungs- als auch im Constraint Gra0

phen und hat durch die ausgehenden Kanten die Aufgabe, einen zusammenhängenden Graphen

zu bilden.

Inv.-Nr.: 2005-05-23/052/IN98/2254

28

KAPITEL 3. ÜBERPRÜFUNG MIT BELLMAN - FORD

Objekt

o1

o2

o3

o4

Dauer

15

25

20

10

Bedingung

o1 duration(15)

o2 duration(25)

o3 duration(20)

o3 duration(10)

Tabelle 3.1: Beispielprojekt: Objektdauer

Bezeichnung

AR1

AR2

AR3

Allen - Relation

o1 before(2) o2

o2 overlaps(3,5) o3

o3 before(5) o4

Tabelle 3.2: Beispielprojekt: Allen-Relationen mit Parametern

Graphen, um einen zusammenhängenden Graphen zu bilden.

Die Abbildungen 3.1 und 3.2 zeigen den Beziehungsgraph bzw. den zugehörigen

Constraint Graph, die aus den Bedingungen des Beispielprojektes erzeugt wurden.

In diesem Beispiel sind nur lokale negative Zyklen möglich, denn es existieren

nur Beziehungen zwischen direkt benachbarten Objekten (siehe Beziehungsgraph).

Fügt man eine vierte Allen-Relation AR4 hinzu, zum Beispiel o1 before(20) o3 ,

wäre eine Kante zwischen den Objekten o1 und o3 (Abbildung 3.3, gestrichelte

Kante) und ein globaler negativer Zyklus grundsätzlich denkbar.

Beschränkt man die Erstellung von Bedingungen, können globale Zyklen von

Anfang an verhindert werden. Dies ist ein wichtiger Punkt zur Optimierung des

Konsistenzchecks. Folgende Regeln für den Beziehungsgraphen bzw. die Projektdefinition sind notwendig:

• es existiert genau ein Startobjekt v0 mit der Dauer t = 0 ohne Vorgänger

• alle Medienobjekte haben genau einen Vorgänger und beliebig viele Nachfolger

• alle Medienobjekte haben eine definierte Dauer t ≥ 0

Bei einem Blick auf diese Einschränkungen wird klar, dass es sich beim Beziehungsgraphen um einen Baum mit v0 als Wurzel handeln muss. Dank dieser Vorgabe können keine globale Zyklen entstehen und der Konsistenzcheck kann auf das

Suchen von lokalen negativen Zyklen beschränkt werden. Die nächsten Abschnitte

beziehen sich ausschließlich auf lokale negative Zyklen.

Die Forderung nach einer fest definierten Intervalldauer der Medienobjekte ist

nicht zwingend notwendig. Grundsätzlich lassen sich, analog zu Allen-Relationen,

auch variable Intervalle definieren. Aus Sicht der Optimierungen würde dies den

Konsistenzcheck aber erschweren und keinen zusätzlichen Erkenntnisgewinn bringen.

v0

o1

AR1

o2

AR2

o3

AR3

o4

Abbildung 3.1: Beziehungsgraph

Inv.-Nr.: 2005-05-23/052/IN98/2254

3.1. BESCHRÄNKUNGEN UND BEISPIELE

0

0

end(o1)

29

0

end(o2)

end(o4)

end(o3)

-5

0

v0

15

-15

25

-2

-1

-25

20

-20

-5

10

-10

0

-3

st(o1)

0

st(o2)

0

st(o4)

st(o3)

0

Abbildung 3.2: Constraint Graph

v0

o1

AR1

o2

AR2

o3

AR3

AR4

Abbildung 3.3: Beziehungsgraph mit globalem Zyklus

Inv.-Nr.: 2005-05-23/052/IN98/2254

o4

30

KAPITEL 3. ÜBERPRÜFUNG MIT BELLMAN - FORD

ID

1

2

3

4

5

6

7

8

9

10

11

12

13

Projekt

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Startknoten

st(o1 )

end(o1 )

st(o2 )

end(o2 )

st(o3 )

end(o3 )

st(o4 )

end(o4 )

st(o2 )

end(o3 )

st(o3 )

end(o2 )

st(o4 )

Endknoten

end(o1 )

st(o1 )

end(o2 )

st(o2 )

end(o3 )

st(o3 )

end(o4 )

st(o4 )

end(o1 )

end(o2 )

st(o2 )

st(o3 )

end(o3 )

Gewicht

15

-15

25

-25

20

-20

10

-10

-2

-5

-3

-1

-5

C ID

1

1

2

2

3

3

4

4

5

6

6

6

7

Tabelle 3.3: Komplette Constraint Graphs - Tabelle für Beispielprojekt

ID

1

2

3

4

5

6

7

Projekt

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

Bsp1

C ID

1

2

3

4

5

6

7

Vorgaenger

o1

o2

o3

o4

o1

o2

o3

Nachfolger

o2

o3

o4

R ID

1

1

1

1

5

7

5

Tabelle 3.4: Komplette Constraint Orders - Tabelle für Beispielprojekt

Die Einschränkungen zur Definition von Projekten bzw. des Beziehungsgraphen

erscheinen zunächst gravierend. Die Möglichkeit jedes Objekt mit einem beliebig

anderen in Beziehung zu setzen und somit keine Beschränkungen vorzugeben, ist

aus Sicht des Nutzers zunächst sinnvoll und erwünscht. Für den logischen Aufbau ist aber es besser, nur direkt nachfolgende Objekte zu verknüpfen. Andernfalls

können in größeren Projekten unübersichtliche Strukturen entstehen, die bei Änderungen negative Zyklen wahrscheinlicher machen. Die Problematik der Szenenbeschreibung zur Wellenfeldsynthese können mit diesen Einschränkungen problemlos

erfüllt werden.

Das Beispielprojekt wird als XML-Datei erzeugt und mit Hilfe des ConstraintManager in der Datenbank gespeichert. Die entsprechenden Tabellen Constraint

Graphs und Constraint Orders sind in 3.3 und 3.4 zu sehen. Die Tabelle Constraint Orders dient hauptsächlich zur Erstellung des Beziehungsgraphen, bzw. um

Zusammenhänge zwischen den Relationen zu extrahieren und um den Typ einer

Relation festzustellen.

3.2

Klassifizierung der Allen-Relationen

Eine Klassifizierung der Allen-Relationen ist sinnvoll, da nicht aus jeder Relation

ein negativer Zyklus hervorgehen kann. Alle Allen-Relationen haben als Graph das

selbe Grundgerüst (Abbildung 3.4). Zu einem Medienobjekt (v1 bzw. v2 ) im Bezie-

Inv.-Nr.: 2005-05-23/052/IN98/2254

3.2. KLASSIFIZIERUNG DER ALLEN-RELATIONEN

31

hungsgraph existieren je zwei Knoten im Constraint Graph: der Start- (v11 bzw.

v21 ) und Endknoten (v12 bzw. v22 ). In allen Abbildungen sind sie jeweils untereinander dargestellt, um die Zugehörigkeit zu verdeutlichen. Wird im Folgenden

von den Knoten eines Objektes (v1 ) im (Constraint) Graphen gesprochen, sind die

zugehörigen Start- und Endknoten (v11 und v12 ) gemeint.

Es wird stets davon ausgegangen, dass die Allen-Relationen sowohl korrekt erzeugt als auch korrekt in Difference Constraints transformiert wurden. Insbesonders bei erweiterten Allen-Relationen sind nur nichtnegative Werte als Parameter

erlaubt. Mit Hilfe der Parameter wird ein festes oder variables Intervall [a,b] mit

a ≤ b zwischen zwei Zeitpunkten definiert. Verwendet man negative Werte, würde

ein Intervall [a,b] mit a > b generiert und hätte eine Inkonsistenz bzw. negativen Zyklus zur Folge. Werden die Bedingungen falsch modelliert oder fehlerhaft

in Difference Constraints umgewandelt, können theoretisch an vielen Stellen negative Zyklen entstehen, z. B. durch die beiden Kanten zwischen v11 und v21 . Am

Ende dieses Abschnittes wird ein Beispiel eines negativen Zyklus durch eine unerlaubte Definition einer Relation gezeigt. Durch Ausschließen solcher Fehlerquellen

lässt sich die Anzahl potentieller negativer Zyklen stark reduzieren. Im Folgenden

werden nur solche negative Zyklen betrachtet, die allein durch Inkonsistenzen der

Bedingungen entstehen, also potentiell negative Zyklen.

Zwischen den Start- und Endknoten eines Objektes existieren je zwei Kanten,

welche die Dauer t der Objekte repräsentieren (Abbildung 3.4, durchgezogene Kanten). Diese Kanten können bei korrekter Modellierung der Allen-Relationen und

Transformation in Difference Constraints alleine keinen negativen Zyklus bilden.

Sie heben sich gegenseitig auf, da eine fest definierte Dauer der Objekte gefordert

ist. Im Falle eines negativen Zyklus sind sie aber zwingend an diesem beteiligt.

Die Kanten zwischen den Knoten der jeweiligen Objekte (Abbildung 3.4, gestrichelte Kanten), resultierend aus den Difference Constraints, sind essentiell für eine

Inkonsistenz. Abhängig von der Relation können eine oder mehrere dieser Kanten in

Teilgraphen vorkommen. Der Startknoten v0 muss in diesem Zusammenhang nicht

betrachtet werden. Da seine ausgehenden Kanten jeweils das Gewicht Null haben,

spielen sie bei der Suche nach negativen Zyklen innerhalb einer Allen-Relation keine

Rolle.

Der Graph G =< V, E > einer Allen-Relation (vgl. Gleichung 2.1) mit den zwei

verknüpften Objekten lässt sich allgemein wie folgt beschreiben:

V = V1 ∪ V2 , V1 = {v11 , v12 } , V2 = {v21 , v22 } ,

E = E1 ∪ E2 ,

E1 = {(v11 , v12 ), (v12 , v11 ), (v21 , v22 ), (v22 , v21 )} ,

E2 = {(vkl , vij ) : xij − xkl ≤ ck } ∩ E1 ,

Kantengewichte : w(vkl , vij ) = ck , i, j, k, l 6= 0.

(3.1)

Die Menge der Knoten setzt sich aus den beiden Untermengen der jeweils zwei

Objektknoten zusammen. Die Menge E1 repräsentiert die Kanten zwischen den

jeweiligen Knoten der Mengen V1 und V2 , welche die Objektdauer angeben (Abbildung 3.4, durchgezogene Kanten). Die restlichen Kanten der Menge E2 verlaufen

zwischen den Objektknoten (Abbildung 3.4, gestrichelte Kanten). Wie bereits erwähnt, sind die Knoten der Menge E1 zunächst neutral hinsichtlich der Entstehung

eines Kreises. Die notwendige Bedingung für einen potentiellen negativen Zyklus

Inv.-Nr.: 2005-05-23/052/IN98/2254

32

KAPITEL 3. ÜBERPRÜFUNG MIT BELLMAN - FORD

v12

t1

-t1

v11

v22

t2

-t2

v21

Abbildung 3.4: Vollvermaschter Graph mit vier Knoten

lautet:

∃k1 ∈ V1 :∃k2 ∈ V2 : (k1 , k2 ) ∩ E2 6= ∅ ∧ (k2 , k1 ) ∩ E2 6= ∅

(3.2)

Ein zu überprüfender Zyklus entsteht immer zwischen den Knoten der Mengen

V1 und V2 , zwischen den Knotenmengen beider Objekte. Also muss die Menge

E2 mindestens zwei Kanten enthalten, die entgegen gerichtet sind ((k1 , k2 ) und

(k2 , k1 )). Sind diese Bedingungen erfüllt, ist ein negativer Zyklus grundsätzlich

möglich. Durch Summierung der Kantengewichte kann numerisch bestimmt werden,

ob ein Kreis negativ ist oder nicht.

Die theoretisch vorkommenden Kanten sind im vollvermaschten Graphen sind

in Abbildung 3.4 zu sehen. Da die Menge der zugrunde liegenden Allen-Relationen

aber begrenzt ist, werden nicht alle Kanten in der Praxis vorkommen. Die Kanten

zwischen v11 und v22 sind daher theoretischer Natur. Abbildung 3.5 zeigt die Kanten, die aus den zugrunde liegenden Relationen resultieren. Anhand dieser Kanten

lassen sich alle Zyklen identifizieren, die durch Inkonsistenzen der Bedingungen

negativ werden können:

z1

z2

z3

z4

z5

z6

: (v11 , v21 ), (v21 , v22 ), (v22 , v12 ), (v12 , v11 ),

: (v11 , v12 ), (v12 , v22 ), (v22 , v21 ), (v21 , v11 ),

: (v21 , v22 ), (v22 , v12 ), (v12 , v21 ),

: (v21 , v11 ), (v11 , v12 ), (v12 , v21 ),

: (v21 , v12 ), (v12 , v22 ), (v22 , v21 ),

: (v21 , v12 ),(v12 , v11 ), (v11 , v21 ).

(3.3)

Inv.-Nr.: 2005-05-23/052/IN98/2254

3.2. KLASSIFIZIERUNG DER ALLEN-RELATIONEN

v12

t1

-t1

v11

33

v22

t2

-t2

v21

Abbildung 3.5: Grundgerüst aller verwendeten Allen - Relationen

Sichere Allen - Relationen

A before B

A meets B

Unsichere Allen - Relationen

A overlaps B

A finishes B

A starts B

A during B

A equals B

Tabelle 3.5: Klassifizierung: Sichere und unsichere Allen - Relationen

Durch Summierung der Kantengewichte eines Zyklus lässt sich feststellen, ob er

negativ ist, also eine Inkonsistenz darstellt. Bellman-Ford tut dies über die Suche

nach den kürzesten Pfaden. Hier ist es nicht erforderlich, die potentiellen Zyklen

einer Allen-Relation vorher zu identifizieren.

Anhand der Kriterien für potentielle Zyklen lassen sich alle verwendeten AllenRelationen in zwei Kategorien einteilen: Erstens die sicheren Allen-Relationen ohne

potentiellen negativen Zyklus und zweitens die Unsicheren. Diese enthalten einen

Kreis zwischen Knoten unterschiedlicher Objekte, der durch die Kombination der

Bedingungen und der Dauer der Medienobjekte negativ werden kann. Tabelle 3.5

zeigt die Klassifizierung.

Im Beispielprojekt sind sowohl sichere als auch unsichere Relationen vorhanden.

Betrachtet man die before-Relation (AR1) als Teilgraph, existiert nur eine Kante

zwischen beiden Objekten (Abbildung 3.6). Ist man einmal bei Objekt o1 angelangt,

führt kein Pfad zurück zu Objekt o2 . Die Kanten der Objektdauer bilden zwar einen

Kreis, heben sich aber bei korrekter Modellierung gegenseitig auf.

Im Gegensatz dazu ist die overlaps-Relation (AR2) unsicher. Es besteht u. a.

ein potentieller Zyklus zwischen end(o3 ), end(o2 ) und st(o3 ) (Abbildung 3.7, gestrichelte Kanten), der abhängig von den Kantengewichten, negativ werden kann.

Die im Beispiel gewählten Werte führen nicht zu einem negativen Zyklus: -5 -1 +

Inv.-Nr.: 2005-05-23/052/IN98/2254

34

KAPITEL 3. ÜBERPRÜFUNG MIT BELLMAN - FORD

end(o1)

15

-15

st(o1)

end(o2)

-2

25

-25

st(o2)

Abbildung 3.6: Sichere Relation: before

20 = 16 und somit größer als 0.

Wie bereits erwähnt, kann es durch inkorrekte Erzeugung der Difference Constraints zu Inkonsistenzen kommen. Des Dadurch sind auch negative Zyklen ohne

Beteiligung der Kanten der Menge E1 möglich, was anhand der bef orev (c1 , l)Relation verdeutlicht werden sollen. Es existiert ein Zyklus zwischen den Knoten

end(o1 ) und st(o2 ) (Abbildung 3.8, gestrichelten Kanten).

Die Kantengewichte werden durch die Parameter c1 und l der Relation bestimmt. Im Normalfall sind beide Werte nichtnegativ und somit auch der Kreis:

− c1 + c1 + l = l, l ≥ 0.

Die Paramenter repräsentieren ein Intervall von [c1 ,c1 +l] mit c1 < c1 +l. Wählt

man einen negativen Wert für l, resultiert daraus ein negativer Zyklus:

− c1 + c1 + l = l, l < 0.

Das Intervall [c1 ,c1 + l] wäre mit c1 < c1 + l nicht erlaubt und stellt somit eine

Inkonsistenz dar. Da aber stets davon ausgegangen wird, dass die Erzeugung der

Constraints und die Definitionen der Intervalle korrekt sind, können solche negative

Kreise ausgeschlossen werden. Nur die Zyklen der Auflistung 3.3 sind relevant für

die Konsistenzprüfung.

3.3

Optimierungen

Ein Konsistenzcheck ist generell nur notwendig, wenn Relationen verändert oder

neu hinzugefügt werden. Existiert ein konsistenter Graph und werden Bedingungen (Kanten, Knoten) gelöscht, ist kein Check nötig. Die Bedingungen werden in

diesem Fall weicher gemacht: durch das Löschen einer Kante oder Knoten kann

kein neuer Zyklus entstehen. Im Gegensatz dazu ist aber ein Konsistenzcheck erforderlich, wenn Bedingungen hinzugefügt werden oder sich Kantengewichte ändern

Inv.-Nr.: 2005-05-23/052/IN98/2254

3.3. OPTIMIERUNGEN

35

end(o2)

end(o3)

-5

25

-1

-25

20

-20

-3

st(o2)

st(o3)

Abbildung 3.7: Unsichere Relation: overlaps

end(o1)

15

-15

end(o2)

-c1

st(o1)

c1+l

25

-25

st(o2)

Abbildung 3.8: Mögliche Inkonsistenz bei beforev

Inv.-Nr.: 2005-05-23/052/IN98/2254

36

KAPITEL 3. ÜBERPRÜFUNG MIT BELLMAN - FORD

Sichere Operationen

Löschen einer Kante oder eines

Knoten

Hinzufügen einer ungefährlichen

Relation

Vergrößern eines Kantengewichtes

Unsichere Operationen

Hinzufügen einer gefährlichen

Relation

Verkleinern eines Kantengewichtes

Tabelle 3.6: Sichere und unsichere Operationen

(Änderung einer Bedingung). Im letzteren Fall spielt es aber auch eine Rolle, ob

die Gewichte vergrößert oder verkleinert werden (vgl. [Ra04]).

Analog zur der Klassifizierung der Allen-Relationen, kann man zwischen sicheren und unsicheren Operationen unterscheiden (Tabelle 3.6).

Nach der Löschung von Kanten oder Knoten bzw. einer Bedingung ist es notwendig, den Ausgabeschedule wegen möglicher veränderter Zeiten neu zu bestimmen.

In Kapitel 5 werden Berechnung und mögliche Optimierungen erläutert.

Die Änderung eines Kantengewichtes betrifft auch Änderungen der Objektdauer. Dieser Fall wird im nächsten Abschnitt betrachtet. Zunächst wird von Änderungen einzelner Allen-Relationen ausgegangen.

Der Konsistenzcheck erfolgt mit Hilfe des Algorithmus von Bellman und Ford.

Die Laufzeit dieses Tests ist, wie erwähnt, abhängig von der Anzahl der Kanten

und Knoten des zu prüfenden Constraint Graph. Zur Reduzierung der Kosten muss

der zu testende Graph verkleinert werden.

Hier erweist sich die Beschränkung des Beziehungsgraphen auf eine Baumstruktur als sehr vorteilhaft. Durch die besondere Struktur des Graphen schliesst man

das Entstehen von globalen Zyklen im Constraint Graph aus. Demzufolge sind nur

noch lokale negative Zyklen möglich. Und zwar nur an den Stellen, die seit dem

letzten Konsistenzcheck verändert wurden.

Wird eine Allen-Relation verändert, müssen nur diese Relation und die beteiligten Objekte überprüft werden. Aus diesem Grund wird ein Teilgraph auf Basis

des Constraint Graph erstellt. Der Algorithmus zur Erzeugung dieses Graphen aufgrund der Änderung einer einzelnen Bedingung ist in Abbildung 3.9 dargestellt. Der

Input des Algorithmus ist eine condition. Der Begriff ist weit gefasst. Es kann sich

um eine komplette Allen-Relation handeln, um einen einzelnen Difference Constraint als Teil einer Relation (im Falle einer Änderung) oder um einen Duration

Constraint, welcher letztendlich wieder aus zwei Difference Constraints besteht.

Zuerst wird geprüft, ob die veränderte Bedingung eine Allen-Relation (1) oder

eine Objektdauer (11) betrifft. Der Teilalgorithmus für die Änderung der Dauer

wird im Abschnitt 3.4 erläutert.

Handelt es sich um eine unsichere Allen-Relation (2) muss festgestellt werden,

ob die betreffende Relation schon im Constraint Graph vorhanden ist (3). Ist dies

der Fall und wurde ein Kantengewicht verkleinert(5), wird die komplette Relation mit den Knoten der beteiligten Objekte zum Teilgraph hinzugefügt (6). Beim

Hinzufügen der Bedingung wird ebenfalls der Teilgraph um die komplette Relation

ergänzt (8). Zum Schluss wird der Startknoten v0 hinzugefügt (19), um anschließend den Konsistenzcheck mittels Bellman und Ford zu starten.

Im Beispiel sieht das folgendermaßen aus: die Relation AR2 (o2 overlaps(3,5)

o3 ) wird geändert in o2 overlaps(5,5) o3 . Die Relation bzw. Bedingung ist schon

im Graph vorhanden, das Kantengewicht von st(o3 ) nach st(o2 ) wurde von −3 auf

−5 verkleinert. Der Teilgraph besteht demzufolge zunächst aus den vier betref-

Inv.-Nr.: 2005-05-23/052/IN98/2254

3.3. OPTIMIERUNGEN

Algorithm:

buildP artialGraph(INPUT condition, OUTPUT partialGraph)

Input:

Condition condition

Output:

Graph partialGraph

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

if condition is AllenRelation {

if condition is UnsafeRelation {

if condition is PartOfConstraintGraph {

oldCondition = getConditionFromGraph(condition.id)

if condition.value < oldCondition.value

addToPartialGraph(condition)

}

else addToPartialGraph(condition)

}

}

else if condition is Duration{

for all relations do{

if condition is related to relations {

allenRelation = relations.id

addToPartialGraph(allenRelation)

}

}

}

addToPartialGraph(startN ode)

return partialGraph

Abbildung 3.9: Algorithmus zur Teilgrapherzeugung

Inv.-Nr.: 2005-05-23/052/IN98/2254

37

38

KAPITEL 3. ÜBERPRÜFUNG MIT BELLMAN - FORD

end(o2)

0

end(o3)

-5

0

V0

25

-1

-25

20

-20

0

-5

st(o2)

st(o3)

0

Abbildung 3.10: Teilgraph nach Änderung einer Allen - Relation

fenden Knoten und Kanten. Danach wird der Startknoten v0 mit seinen Kanten

erzeugt und der Algorithmus von Bellman und Ford ausgeführt, welcher true zurück gibt. Der erzeugte Teilgraph ist in Abbildung 3.10 dargestellt. Die Kosten

für den Konsistenzcheck des Teilgraph gegenüber den gesamten Constraint Graph

sind geringer, da die Anzahl der Knoten und Kanten verkleinert wurde.

3.4

Änderung der Objektdauer

Bei der Konsistenzprüfung muss zwischen Änderungen von normalen“ Bedingun”

gen und Änderungen der Dauer unterschieden werden. Die Überprüfung lässt sich

zwar auch hier auf einen lokalen Test beschränken, aber es können in diesem Fall

mehr als zwei Medienobjekte beteiligt sein.

Allen-Relationen verknüpfen immer nur zwei Medienobjekte. Im Gegensatz dazu kann aber ein Medienobjekt in beliebig vielen Beziehungen vorkommen. Bei

Änderung der Dauer müssen alle Beziehungen, die dieses Medienobjekt betreffen,

und alle Medienobjekte, welche zu diesen Relationen gehören, getestet werden.

Erkennt der Algorithmus aus Abbildung 3.9, dass es sich bei einer geänderten

Bedingung um ein Duration Constraint handelt (11), werden alle im Constraint

Graph vorhandenen Relationen (12) überprüft, ob das geänderte Objekt beteiligt

ist (13). In diesem Fall werden alle beteiligten Relationen (14) und zugehörige

Objekte zum Teilgraphen hinzugefügt (15), ebenso der Startknoten. Der fertige

Teilgraph ist nun bereit für den Konsistenzcheck.

Erhöht man zum Beispiel die Dauer von Objekt o3 von 20 auf 30 Zeiteinheiten

(ZE), wird damit ein Kantengewicht verkleinert. Gleichzeitig muss natürlich die

positive Kante um den entsprechenden Wert erhöht werden, damit die Forderung

einer fest definierten Dauer erfüllt ist. Im Beziehungsgraphen des Beispiels (Abbildung 3.1) kann man gut erkennen, dass das Objekt o3 an den Relationen AR2 und

AR3 beteiligt ist. Also müssen die Relationen AR2 und AR3 und die involvierten

Objekte o2 , o3 und o4 für den Konsistenzcheck berücksichtigt werden. Der erzeugte

Teilgraph ist in Abbildung 3.11 zu sehen.

Inv.-Nr.: 2005-05-23/052/IN98/2254

3.4. ÄNDERUNG DER OBJEKTDAUER

39

0

end(o2)

0

end(o3)

end(o4)

-5

0

V0

25

-1

-25

30

-30

-5

10

-10

0

-3

st(o2)

st(o3)

0

st(o4)

0

Abbildung 3.11: Teilgraph nach Änderung eines Duration Constraint

v0

Abbildung 3.12: Idealer Beziehungsgraph

Auch hier ist der zu testende Graph kleiner als der ursprüngliche Constraint

Graph. Allerdings sind jetzt mehr Objekte beteiligt sind als bei einer Änderung einer Allen-Relation. Die Anzahl ist abhängig von der Art und Weise, wie die Objekte

untereinander verknüpft wurden und ist gut an der Struktur des Beziehungsgraphen erkennbar.

Für die Laufzeit des Konsistenzcheck ist es vorteilhaft, wenn alle Medienobjekte

der Reihe nach miteinander verknüpft sind. Jeder Knoten im Beziehungsgraphen