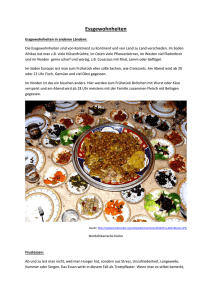

Kapitel 1: Einleitung - Professur Mediengestaltung

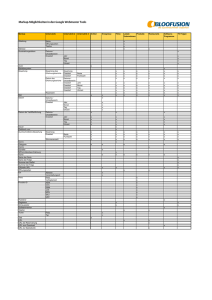

Werbung