3. Grenzwertsätze 3.1. Schwaches Gesetz der grossen Zahl

Werbung

74

3.

3. GRENZWERTSÄTZE

Grenzwertsätze

Sei nun {X1 , X2 , . . .} eine Folge von Zufallsvariablen auf einem Wahrscheinlichkeitsraum (Ω, F, IIP). Wir interessieren uns nun für die Summe Sn = X1 + · · · + Xn ,

und vor allem für die Asymptotik n → ∞. Zum einen wollen wir n−1 Sn betrachten

(Gesetz der grossen Zahl) und die Form der Verteilung von Sn bestimmen (zentraler

Grenzwertsatz).

3.1. Schwaches Gesetz der grossen Zahl

Satz 3.1. Seien IIE[Xi ] = µ unabhängig von i und die Varianzen im Schnitt beP

schränkt, supn n−1 ni=1 Var[Xi ] < ∞. Sind die Zufallsvariablen {Xi } unkorreliert,

so gilt

i

h S

n

lim IIP − µ≥ ε = 0

n→∞

n

für jedes ε > 0.

P

Beweis. Wir haben IIE[n−1 Sn ] = n−1 nk=1 IIE[Xk ] = µ, und, wegen der UnkorP

reliertheit, Var[n−1 Sn ] = n−2 nk=1 Var[Xk ] → 0. Somit folgt das Resultat aus der

Chebychev Ungleichung (2.1).

Sind die Zufallsvariablen {Xk } unabhängig und identisch verteilt, dann sind die

Bedingungen des Satzes erfüllt. Machen wir Zufallsexperimente unabhängig voneinander, haben wir nun die Intuition, mit der wir Wahrscheinlichkeiten eingeführt

haben, auch formal bewiesen.

Beispiele

• Für unabhängige {0, 1} Experimente mit Erfolgsparameter p hat Jacob Bernoulli

1713 durch kombinatorische Argumente bewiesen, dass IIP[|n−1 Sn − p| ≥ ε] → 0.

Ist n gross, hat man also ungefähr np Erfolge und n(1 − p) Misserfolge.

Sei f (x) : [0, 1] → IR eine stetige Funktion. Wir definieren die BernsteinPolynome

n

X

n k

Bn (x) :=

f (k/n)

x (1 − x)n−k .

k

k=0

Wir erhalten dann die Abschätzung

Jensen

|Bn (p) − f (p)| = |IIE[f (Sn /n)] − f (p)| ≤ IIE[|f (Sn /n) − f (p)|] .

3. GRENZWERTSÄTZE

75

Setzen wir kf k = supx |f (x)|, erhalten wir

|Bn (p) − f (p)| ≤ 2kf kIIP[|Sn /n − p| ≥ ε] + sup |f (x) − f (y)|IIP[|Sn /n − p| < ε] .

|x−y|≤ε

Aus dem schwachen Gesetz der grossen Zahl folgt, dass der erste Term gegen

Null konvergiert. Aus der Chebychev Ungleichung kann man schliessen, dass

die Konvergenz gleichmässig in p ist. Der zweite Term konvergiert gleichmässig

gegen Null, da jede stetige Funktion gleichmässig stetig ist. Somit konvergieren

die Bernstein Polynome gleichmässig gegen die Funktion f (x).

• Seien {Xi } unabhängige Experimente mit verschiedenen Erfolgsparameter pi .

Setzen wir X̃i = Xi − pi , dann haben die {X̃i } den gemeinsamen Mittelwert 0

und die Varianz Var[X̃i ] = Var[Xi ] = pi (1 − pi ) ≤ 41 . Also gilt

Pn

i

h Pn X̃ i

h S

n

k

k=1 pk IIP −

≥ ε = IIP k=1

≥ε →0.

n

n

n

Auch bei verschiedenen Erfolgsparameter nähert sich der Durchschnitt immer

mehr dem Mittelwert an.

• In den Anwendungen braucht man oft einen Ausdruck der Form IIE[f (X)], wobei

f (x) eine stetige Funktion ist, und X eine Zufallsvariable (z.B. Optionspreis). Oft

ist es schwer IIE[f (X)] auszurechnen, aber relativ einfach, X auf einem Computer

zu simulieren. Man erzeugt sich dann n unabhängige Zufallsvariablen {Xk } mit

P

der gleichen Verteilung wie X. Da n−1 nk=1 f (Xk ) sich immer mehr IIE[f (X)]

annähert, gibt dieses Verfahren mit hoher Wahrscheinlichkeit eine gute Approximation von IIE[f (X)]. Dieses Verfahren heisst Monte–Carlo Simulation.

R1

Will man ein Integral 0 f (x) dx numerisch berechnen, hat man manchmal Probleme, falls f (x) nicht eine schöne Funktion ist. Man bemerkt, dass für unabhängige und auf [0, 1] gleichverteilte Zufallsvariablen {Xk } der Mittelwert

R1

IIE[f (Xk )] = 0 f (x) dx gleich dem gesuchten Integral ist. Daher lässt sich das

P

Integral mit der Monte–Carlo Simulation n−1 nk=1 f (Xk ) approximieren. Der

Vorteil dieser Methode ist, dass die Integrationsdiskretisierung nicht regelmässig

P

ist, das heisst, nicht n−1 nk=1 f (k/n).

3.2. Konvergenzbegriffe

Seien nun {Xi } und X Zufallsvariablen auf (Ω, F, IIP). Wir definieren nun verschiedene Arten von Konvergenz von Xn nach X.

76

3. GRENZWERTSÄTZE

• Stochastische Konvergenz Wir sagen Xn konvergiert stochastisch gegen X,

IIP

Xn → X, falls

lim IIP[|Xn − X| ≥ ε] = 0

n→∞

für alle ε > 0.

• Fast sichere Konvergenz Wir sagen Xn konvergiert fast sicher gegen X,

Xn → X, falls

IIP[{ω : lim Xn (ω) = X(ω)}] = 1 .

n→∞

• Lp -Konvergenz, p ≥ 1

Wir sagen, Xn konvergiert in Lp gegen X, falls

lim IIE[|Xn − X|p ] = 0 .

n→∞

• Konvergenz in Verteilung Wir sagen Xn konvergiert in Verteilung gegen X,

d

Xn → X, falls

lim IIP[Xn ≤ x] = IIP[X ≤ x]

n→∞

für alle x ∈ IR, an denen FX (x) stetig ist. Dieser Konvergenzbegriff betrachtet

nur die Verteilungen. Zum Beispiel sind {Xk } unabhängig und identisch verteilt, dann konvergiert Xn in Verteilung gegen X1 . Dieser Konvergenzbegriff kann

daher nur verwendet werden, wenn wir uns nicht für limn→∞ Xn interessieren,

sondern für die Verteilungen.

Wir wollen die Konvergenzbegriffe nun vergleichen. Wir konzentrieren uns dabei auf

die ersten drei Begriffe, da der letzte Konvergenzbegriff von einer anderen Art ist.

Proposition 3.2.

i) “Fast sichere Konvergenz” impliziert “stochastische Konvergenz.”

ii) “Lp -Konvergenz” impliziert “stochastische Konvergenz.”

iii) Für q > p impliziert “Lq -Konvergenz” die “Lp -Konvergenz.”

iv) Ist IIE[(supn |Xn |)p ] < ∞, so folgt die “Lp -Konvergenz” aus der “fast sicheren

Konvergenz.”

v) Sei für jedes ε > 0

∞

X

n=1

IIP[|Xn − X| ≥ ε] < ∞ .

3. GRENZWERTSÄTZE

77

Dann konvergiert Xn sowohl stochastisch als auch fast sicher gegen X. Insbesondere hat jede stochastisch konvergierende Folge eine fast sicher konvergierende

Teilfolge.

Beweis.

i) Die fast sichere Konvergenz ist gleichbedeutend mit

IIP[∩k ∪m ∩n≥m {|Xn − X| ≤ k −1 }] = 1

(Für alle k gibt es ein m, so dass für alle n ≥ m, |Xn − X| ≤ k −1 gilt). Also gilt

IIP[∪m ∩n≥m {|Xn − X| ≤ `−1 }] ≥ IIP[∩k ∪m ∩n≥m {|Xn − X| ≤ k −1 }] = 1 .

Wegen der Monotonie in m haben wir weiter

1 = IIP[∪m ∩n≥m {|Xn − X| ≤ k −1 }] = lim IIP[∩n≥m {|Xn − X| ≤ k −1 }]

m→∞

für alle k. Wir können k −1 durch ε ersetzen. Also haben wir

lim IIP[|Xm − X| ≤ ε] ≥ lim IIP[∩n≥m {|Xn − X| ≤ ε}] = 1 .

m→∞

m→∞

Dies ist die stochastische Konvergenz.

ii) Dies folgt sofort mittels Hilfssatz 2.16 aus

IIE[|Xn − X|p ]

.

εp

iii) Dies folgt sofort mittels Korollar 2.15 aus

IIP[|Xn − X| ≥ ε] ≤

IIE[|Xn − X|p ]1/p ≤ IIE[|Xn − X|q ]1/q .

iv) Dies folgt aus der Eigenschaft der beschränkten Konvergenz.

v) Aus dem Borel–Cantelli-Lemma folgt, dass

IIP[{|Xn − X| ≥ ε unendlich oft}] = 0 .

Sei nun {εm } eine Folge von echt positiven Zahlen, die monoton gegen Null konvergiert. Dann ist

X

IIP[∪m {|Xn − X| ≥ εm unendlich oft}] ≤

IIP[{|Xn − X| ≥ εm unendlich oft}]

m

=0.

Also konvergiert Xn fast sicher gegen X.

Konvergiert Xn stochastisch gegen X, so wählen wir eine steigende Folge nk , so

dass IIP[|Xnk − X| ≥ k −1 ] < k −2 . Dann erfüllt {Xnk : k ∈ IIN} die Bedingung, und

konvergiert somit fast sicher gegen X.

78

3. GRENZWERTSÄTZE

Beispiele

• Sei IIP die Gleichverteilung auf [0, 1]. Für n ≥ 1 und k ∈ {0, 1, . . . , 2n − 1}

definieren wir Zn,k = 1I(k2−n ,(k+1)2−n ] . Wir lassen nun X1 = Z1,0 , X2 = Z1,1 ,

X3 = Z2,0 , etc., das heisst, wir zählen lexikographisch ab. Da immer wieder eine

1 auftritt, haben wir lim Xn = 0 und lim Xn = 1. Also kann Xn nicht fast sicher

konvergieren. Aber für ε ∈ (0, 1) haben wir

p

] = 2−n .

IIP[|Zn,k | ≥ ε] = IIP[Zn,k = 1] = IIE[Zn,k

Somit konvergiert Xn stochastisch und in Lp gegen 0.

• Sei IIP die Gleichverteilung auf [0, 1]. Wir definieren Xn = 2n 1I[0,2−n ] . Da IIP[ω >

0] = 1, erhalten wir, dass Xn fast sicher gegen 0 konvergiert. Aber

IIE[Xn ] = 2n IIP[[0, 2−n ]] = 2n 2−n = 1 .

Somit konvergiert Xn nicht in L1 gegen 0, und damit auch nicht in Lp .

Hilfssatz 3.3. Seien {Xn } und X Zufallsvariablen. Folgende Aussagen sind äquivalent:

i) Xn konvergiert in Verteilung gegen X.

ii) Für jede stetige beschränkte Funktion f (x) gilt

lim IIE[f (Xn )] = IIE[f (X)] .

n→∞

iii) Für jede dreimal stetig differenzierbare und beschränkte Funktion f (x) mit beschränkten ersten drei Ableitungen gilt

lim IIE[f (Xn )] = IIE[f (X)] .

n→∞

Beweis. “i) ⇒ ii)” Es gibt nur abzählbar viele Punkte, an denen F (x) nicht

stetig ist. Somit gilt für alle Intervalle der Form (y, z], wobei y < z und F (x) ist

stetig in y und z, dass die Aussage für Funktionen der Form f (x) = c1I(y,z] (x) gilt.

Wir können nun so Ober- und Untersummen wie beim Riemann-Integral bilden, und

die Aussage mit Hilfe der Monotonieeigenschaft des Erwartungswertes beweisen.

“ii) ⇒ iii)” trivial.

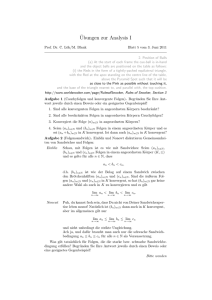

“iii) ⇒ i)” Betrachten wir die Funktion

3. GRENZWERTSÄTZE

79

1.0

0.8

0.6

0.4

0.2

0.2

-0.2

0.4

0.6

0.8

1.0

1.2

Abbildung 3.1: Die Funktion P (x)

1,

falls x ≤ 0,

P (x) = 0 ,

falls x ≥ 1,

20x7 − 70x6 + 84x5 − 35x4 + 1 , sonst,

dargestellt in Abbildung 3.1. Wir haben P (0) = 1 und P (1) = 0, die ersten drei

Ableitungen in 0 sind Null, und die ersten drei Ableitungen in 1 sind 0. Somit ist

P (x) dreimal stetig differenzierbar. Aus P 0 (x) = 140x3 (x − 1)3 folgt, dass P (x) im

Intervall [0, 1] fallend ist. Sei y ein Punkt, an dem F (x) stetig ist. Dann gilt

1I(−∞,y] (x) ≤ P ((x − y)/δ) ≤ 1I(−∞,y+δ] (x) .

Also erhalten wir

lim Fn (y) ≤ lim IIE[P ((Xn − y)/δ)] = IIE[P ((X − y)/δ)] ≤ F (y + δ) .

n→∞

n→∞

Da δ beliebig war, gilt limn→∞ Fn (y) ≤ F (y). Weiter gilt

lim Fn (y) ≥ lim IIE[P ((Xn − y + δ)/δ)] = IIE[P ((X − y + δ)/δ)] ≥ F (y − δ) .

n→∞

n→∞

Da δ beliebig war, gilt limn→∞ Fn (y) ≥ F (y).

80

3. GRENZWERTSÄTZE

0.60

0.55

50

100

150

200

0.45

0.40

0.35

Abbildung 3.2: Typisches Sn /n für uniform auf [0, 1] verteilte {Xk }

3.3. Starkes Gesetz der grossen Zahl

Wir haben gesehen, dass unter dem schwachen Gesetz der grossen Zahl der Durchschnitt von n Zufallsvariablen mit hoher Wahrscheinlichkeit nahe bei ihrem Mittelwert liegt. Wir wollen dieses Gesetz nun verschärfen und betrachten daher Sn /n für

ein ω. Ein möglicher Pfad ist in Abbildung 3.2 illustriert.

Satz 3.4. Seien {Xk } unabhängig mit festem Erwartungswert IIE[Xk ] = µ. Weiter

gelte eine der folgenden Bedingungen:

i) {Xk } seien identisch verteilt.

ii) Es gelte supk IIE[Xk4 ] < ∞.

Dann konvergiert Sn /n fast sicher gegen µ.

Beweis. i) Teilen wir Xk = Xk+ − Xk− in positiven und negativen Teil auf, dann

genügt es, den Satz für positive Zufallsvariablen zu beweisen. Lassen wir X̃n =

P

Xn 1IXn ≤n und S̃n = nk=1 X̃k . Wir zeigen zuerst, dass

S̃n − IIE[S̃n ]

=0.

n→∞

n

lim

Sei α > 1 und kn = bαn c. Wir wählen nun ε > 0. Es folgt aus der Chebychev-

3. GRENZWERTSÄTZE

81

Ungleichung

∞

X

n=1

IIP

h |S̃

kn

∞

∞

kn

i X

Var[S̃kn ] X 1 X

− IIE[S̃kn ]|

≥ε ≤

=

Var[X̃m ]

kn

ε2 kn2

ε2 kn2 m=1

n=1

n=1

∞

X 1

1 X

Var[X̃m ]

= 2

.

ε m=1

k2

n:k ≥m n

n

P∞

P

Da n=` (αn )−2 = α−2` /(1 − α−2 ), gibt es eine Konstante cα , so dass n:kn ≥m kn−2 ≤

cα m−2 . Damit erhalten wir

∞

m−1 Z

∞

∞

h |S̃ − IIE[S̃ ]|

i c X

2

X

IIE[X̃m

]

cα X −2 X `+1 2

kn

kn

α

IIP

≥ε ≤ 2

m

x dF (x)

= 2

2

k

ε

m

ε

n

`

n=1

m=1

m=1

`=0

Z `+1

∞

∞ X

X

cα

m−2

x2 dF (x)

= 2

ε `=0 m=`+1

`

Z

∞

cα X −1 `+1 2

≤A+ 2

`

x dF (x)

ε `=1

`

∞ Z

2cα X `+1

≤A+ 2

x dF (x) < ∞ ,

ε `=1 `

wobei A den Term für ` = 0 bezeichnet. Somit schliessen wir aus dem Borel–CantelliLemma, dass kn−1 (S̃kn − IIE[S̃kn ]) fast sicher gegen 0 konvergiert. Da

Z ∞

n Z

IIE[S̃n ]

1X k

=

x dF (x) →

x dF (x) = µ ,

n

n k=1 0

0

konvergiert also kn−1 S̃kn fast sicher gegen µ. Sei nun n ∈ [km , km+1 ). Dann gilt

S̃k

km S̃km

S̃km

S̃n

km+1 S̃km+1

≤ m+1 =

=

≤

.

km+1 km

km+1

n

km

km km+1

Lassen wir n gegen Unendlich streben, erhalten wir

1

S̃n

S̃n

µ ≤ lim

≤ lim

≤ αµ .

n→∞ n

α

n→∞ n

Da α > 1 beliebig war, folgt dass n−1 S̃n → µ.

Betrachten wir nun, wie oft das Ereignis {X̃n 6= Xn } eintritt. Wir haben

∞

X

IIP[X̃n 6= Xn ] =

n=1

=

∞

X

IIP[Xn > n] =

n=1

∞ X

m

X

∞ X

∞

X

IIP[Xn ∈ (m, m + 1]]

n=1 m=n

IIP[Xn ∈ (m, m + 1]] =

m=1 n=1

≤ IIE[X1 ] < ∞ .

∞

X

m=1

mIIP[X1 ∈ (m, m + 1]]

82

3. GRENZWERTSÄTZE

50

500

1000

1500

2000

-50

Abbildung 3.3: Irrfahrt und die Grenzen des iterierten Logarithmus

Somit folgt aus dem Borel–Cantelli Lemma, dass {X̃n 6= Xn } nur endlich oft eintritt.

Insbesondere gilt, dass n−1 Sn und n−1 S̃n den gleichen Grenzwert µ haben.

ii) Wir können ohne Beschränkung der Allgemeinheit annehmen, dass µ = 0. Wir

erhalten

IIE[Xi2 ]2 ≤ IIE[Xi4 ] ≤ M = sup IIE[Xk4 ] .

k

Für Sn ergibt sich die Abschätzung

IIE[Sn4 ] =

n

X

i,j,k,`=1

IIE[Xi Xj Xk X` ] ≤ nM + 6

n(n − 1)

M + 0 ≤ 3n2 M .

2

Also haben wir mit Hilfe von Hilfssatz 2.16

h S i IIE[(n−1 S )4 ]

3n2 M

3M

n

n

IIP ≥ ε ≤

≤ 4 4 = 4 2 .

4

n

ε

εn

εn

Letzterer Ausdruck ist summierbar, also können wir folgern aus dem Borel–Cantelli

Lemma folgern, dass n−1 Sn fast sicher gegen Null konvergiert.

Für viele Situationen ist die Bedingung IIE[Xk4 ] ≤ M erfüllt. Zum Beispiel bei

unabhängigen {0, 1} Experimenten mit Erfolgsparameter pi . Somit erhält man, dass

n−1 Sn − n−1 IIE[Sn ] fast sicher gegen Null konvergiert.

Das starke Gesetz der grossen Zahl gibt uns damit eine Schranke, wie schnell die

Summe Sn wachsen kann. Ist µ = 0, finden wir dass |Sn | ≤ εn, falls n gross genug

ist. Genauere Grenzen für Sn hat Alexander Jakowlewitsch Khintchine gefunden.

3. GRENZWERTSÄTZE

83

Satz 3.5. (Gesetz vom iterierten Logarithmus) Seien {Xk } unabhängig und

identisch verteilt mit Mittelwert IIE[Xk ] = 0 und Varianz σ 2 = Var[Xk ] < ∞. Dann

gilt

lim p

n→∞

Sn

2σ 2 n log log n

und

lim p

n→∞

Sn

2σ 2 n log log n

=1

= −1 .

3.4. Zentraler Grenzwertsatz

Aus dem Gesetz der grossen Zahl wissen wir, dass n−1 Sn gegen den Mittelwert

n−1 IIE[Sn ] konvergiert. Zur Verwendung in der Statistik brauchen wir aber genauere

Informationen über Sn . Wir wollen daher wissen, wie die Verteilung von Sn für grosse

n aussieht. Nehmen wir an, dass {Xk } unabhängig sind, Mittelwert µk und endliche

Varianz σk2 haben. Um die Verteilung studieren zu können, standardisieren wir nun

die Zufallsvariable

Sn − IIE[Sn ]

Sn∗ = p

.

Var[Sn ]

Dann ist IIE[Sn∗ ] = 0 und Var[Sn∗ ] = 1. Wir beweisen nun zwei Varianten des zentralen

Grenzwertsatzes.

Satz 3.6. Seien {Xn } unabhängige Zufallsvariablen und es gelte eine der beiden

folgenden Bedingungen:

i) supn IIE[|Xn3 ] < ∞ und limn

1

n

Pn

i=1

Var[Xi ] > 0.

ii) {Xn } sind identisch verteilt mit Varianz σ 2 < ∞.

Dann konvergiert Sn∗ in Verteilung gegen die standard Normalverteilung

Z x

1

2

∗

lim IIP[Sn ≤ x] = √

e−y /2 dy

n→∞

2π −∞

für alle x ∈ IR.

84

3. GRENZWERTSÄTZE

Beweis. Wir dürfen IIE[Xn ] = 0 annehmen. Wir verwenden Hilfssatz 3.3. Sei f (x)

eine dreimal stetig differenzierbare beschränkte Funktion mit beschränkten Ableitungen. Der Restterm in der Taylor-Formel

f (z + y) = f (z) + f 0 (z)y + 21 f 00 (z)y 2 + R(z, y)

lässt sich abschätzen durch

|R(z, y)| ≤ 61 |f 000 (z̃)| |y 3 | ≤ C|y 3 | ,

oder durch

|R(z, y)| ≤ 21 |f 00 (z̃) − f 00 (z)| |y 2 | ≤ δ(y)|y 2 | ,

wobei z̃ zwischen z und z + y liegt, δ(y) beschränkt ist und limy→0 δ(y) = 0.

Definieren wir Yi,n = Xi /σ(Sn ) und sei Ỹi,n eine normalverteilte Zufallsvariable

mit Mittelwert 0 und Varianz σ 2 (Yi,n ) unabhängig von den anderen Variablen. Dann

ist Sn∗ = Y1,n + · · · + Yn,n , und S̃n = Ỹ1,n + · · · + Ỹn,n ist standard normalverteilt. Wir

schreiben nun

f (Sn∗ )

− f (S̃n ) =

=

n

X

k=1

n

X

f (Zk,n + Yk,n ) − f (Zk,n + Ỹk,n )

2

2

− Ỹk,n

)

f 0 (Zk,n )(Yk,n − Ỹk,n ) + 21 f 00 (Zk,n )(Yk,n

k=1

+ R(Zk,n , Yk,n ) − R(Zk,n , Ỹk,n ) ,

wobei Zk,n = Ỹ1,n + · · · + Ỹk−1,n + Yk+1,n + · · · + Yn,n . Die Variablen Zk,n , Yk,n und

Ỹk,n sind unabhängig. Daher ist

IIE[f 0 (Zk,n )(Yk,n − Ỹk,n ) | Zk,n ] = f 0 (Zk,n )IIE[Yk,n − Ỹk,n ] = 0 ,

2

2

und damit IIE[f 0 (Zk,n )(Yk,n − Ỹk,n )] = 0. Analog folgt, dass IIE[f 00 (Zk,n )(Yk,n

− Ỹk,n

)] =

0. Für den Mittelwert ergibt sich somit

n

X

|IIE[f (Sn∗ )] − IIE[f (S̃n )]| = IIE[R(Zk,n , Yk,n )] − IIE[R(Zk,n , Ỹk,n )]

k=1

≤

n

X

k=1

IIE[|R(Zk,n , Yk,n )|] + IIE[|R(Zk,n , Ỹk,n )|] .

3. GRENZWERTSÄTZE

85

Wir müssen nun die letzte Summe abschätzen.

i) Für das dritte Moment der Normalverteilung haben wir die Abschätzung

r

8

2 3/2

2 3/2

3

IIE[|Ỹk,n |3 ] =

IIE[Ỹk,n

] ≤ 2IIE[Yk,n

] ≤ 2IIE[Yk,n

].

π

Damit erhalten wir

|IIE[f (Sn∗ )]

− IIE[f (S̃n )]| ≤

n

X

3

]

3CIIE[Yk,n

k=1

≤

≤ 3C

n

X

IIE[|Xk |3 ]

k=1

σ 3 (Sn )

3Cn supk IIE[|Xk |3 ]

1 3C supk IIE[|Xk |3 ]

√

=

.

σ 3 (Sn )

n (n−1 σ 2 (Sn ))3/2

Somit konvergiert der Ausdruck gegen Null.

ii) Wir erhalten wir die Abschätzung

|IIE[f (Sn∗ )]

− IIE[f (S̃n )]| ≤

n

X

2

2

IIE[δ(Yk,n )Yk,n

] + IIE[δ(Ỹk,n )Ỹk,n

]

k=1

h X̃ X̃ 2 i

h X X2 i

1

1

1

1

+

II

E

δ √

= n IIE δ √

σ n σ2n

σ n σ2n

h X̃ X̃ 2 i

h X X2 i

1

1

1

1

+ IIE δ √

.

= IIE δ √

2

2

σ n σ

σ n σ

Das Resultat folgt nun mit beschränkter Konvergenz, da δ(y) beschränkt ist.

Da die Normalverteilung als Grenzwert auftritt, nimmt diese Verteilung eine

besondere Rolle ein. Man findet daher die Normalverteilung in Tabellenbüchern.

Der klassische Spezialfall sind unabhängige 0-1 Experimente mit Erfolgsparameter 0 < p < 1

Z x

h S − np

i

1

2

n

lim IIP p

e−y /2 dy .

≤x = √

n→∞

2π −∞

np(1 − p)

Für p = 12 wurde dies 1730 von Abraham de Moivre und für beliebiges p von PierreSimon Laplace 1812 gezeigt. Hier wurde direkt die exakte Wahrscheinlichkeit mit

Hilfe der Sterlingschen Formel ausgewertet. De Moivre kannte aber die Integraldarstellung der Normalverteilung noch nicht.

Eine Anwendung könnte die folgende sein. Jemand will im Kasino Roulette spielen. Hier ist p = 18/37. Er hat vor, an einem Abend 100 Mal zu spielen. Wieviel

Geld muss der Spieler mitnehmen, um am Ende des Abends mit Wahrscheinlichkeit

86

3. GRENZWERTSÄTZE

99% keine Schulden zu haben? Wir formulieren das Problem mit 0-1 Experimenten,

das heisst, der gewonnene Betrag ist 2Sn − n. Wir suchen daher zuerst x, so dass

i

h S − np

n

≤ x = 0.01 .

IIP p

np(1 − p)

Aus einer Tabelle finden wir x = −2.3263 für die Normalverteilung. Also ist das

gesuchte Kapital

100 − 2

p

1800

+ 2 · 2.3263 34200/1369 = 25.9572 .

37

Der Spieler braucht also 26 Geldeinheiten. Dies ist auch das Resultat, das man bei

exakter Berechnung erhält.