Dissertation

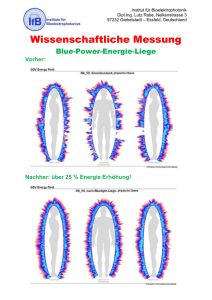

Werbung