Sch tzen und Testen

Werbung

Kapitel 5

Schätzen und Testen

Die Schätzung von Verteilungsparametern und das Testen von Hypothesen gehören

zum Gebiet der induktiven Statistik oder, wie man heute mehr und mehr sagt, der

Inferenzstatistik. Die empirische Grundlage für jede statistische Arbeit bilden Daten, die meist Zufallsstichproben aus definierten Zielpopulationen sind. Methoden

zur Beschreibung der Verteilung von Stichprobenwerten und des Zusammenhangs

zwischen den Werten verschiedener Stichproben wurden bereits in den vorangehenden Kapiteln besprochen und werden im ersten Abschnitt dieses Kapitels weiter

ergänzt. Die Datenbeschreibung ist meist nur der erste Schritt einer statistischen

Auswertung, bei der es primär um Aussagen über die Zielpopulation geht. Diese

gewinnt man, in dem man versucht, die in Stichproben festgestellten Ergebnisse

und Sachverhalte auf die Zielpopulation zu übertragen oder Vermutungen über die

Zielpopulation mit den Beobachtungsdaten zu bestätigen. Das zuerst genannte Ziel

wird methodisch in der Parameterschätzung umgesetzt, das zweite im Rahmen von

Testverfahren. Die Parameterschätzung (in den Abschnitten 2 und 5) befasst sich

mit der Schätzung des Mittelwerts und der Varianz einer normalverteilten Zufallsvariablen, mit der Schätzung des Anstiegs einer Regressionsgeraden sowie mit der

Schätzung einer Wahrscheinlichkeit. Bei den Testverfahren (in den Abschnitten 4

und 5) geht es um Vergleiche mit Mittelwerten und Wahrscheinlichkeiten. Wie man

die Annahme einer normalverteilten Zielpopulation überprüft, wird im dritten Abschnitt ausgeführt.

5.1 Datenbeschreibung

5.1.1 Grundgesamtheit und Stichprobe

Es sei X ein quantitatives Merkmal, z.B. ein Messmerkmal oder ein Zählmerkmal.

Aussagen über die Verteilung des Merkmals in einer Zielpopulation (man bezeichnet diese auch als Grundgesamtheit) erhält man mit Hilfe von Zufallsstichproben.

301

302

5 Schätzen und Testen

Zur Veranschaulichung der Begriffe „Grundgesamtheit“ und „Zufallsstichprobe“

betrachten wir zwei typische Beispiele aus der Praxis.

Das erste Beispiel ist der Qualitätssicherung entnommen. Aus einem Produktionslos mit sehr großem Umfang N werden durch zufällige Ziehungen n N Produkte ausgewählt und die Qualität X eines jeden ausgewählten Produkts überprüft.

Ist das Produkt ohne Fehler, erhält X den Wert null, andernfalls den Wert eins. Die

Beobachtung der Qualität der ausgewählten Produkte führt auf eine aus den Zahlen

null und eins bestehende Folge, die eine Zufallsstichprobe bildet. Die Grundgesamtheit besteht aus allen Produkten des Loses. Wenn man sich auf das Merkmal

X beschränkt, kann jedes Produkt durch seinen Merkmalswert erfasst und folglich

die Grundgesamtheit auch als Gesamtheit aller Merkmalswerte angesehen werden.

Die Zufallsstichprobe ergibt sich dann durch Zufallsauswahl (Ziehen mit Zurücklegen oder Ziehen ohne Zurücklegen) von n Elementen aus dieser Gesamtheit. Bei

großem N lassen sich die Werte der Zufallsstichprobe als Realisierungen einer B1,p verteilten Zufallsvariablen mit einer gewissen Wahrscheinlichkeit p = P(X = 1) erzeugen und man spricht in diesem Fall von einer B1,p -verteilten Grundgesamtheit.

Im zweiten Beispiel geht es um die Messung einer Größe, von der wir annehmen,

dass sie den wahren Wert µ besitze. Bei der Messung überlagert sich dem wahren

Wert ein Messfehler E, den wir uns als eine mit dem Mittelwert null und der Fehlervarianz σE2 normalverteilte Zufallsvariable vorstellen. Somit setzt sich das Ergebnis

X der Messung aus dem wahren Wert µ und dem Messfehler E zusammen. Bezeichnen e1 , e2 , . . . en die Realisierungen von E bei n Messwiederholungen, so können die erhaltenen Messwerte durch xi = µ + ei (i = 1, 2, . . . , n) dargestellt werden.

Die Messwerte bilden eine Zufallsstichprobe aus der N(µ, σE2 )-verteilten Grundgesamtheit X. Diese kann man als Gesamtheit der Messergebnisse ansehen, die mit

der Modellgleichung X = µ + E generiert werden können.

In beiden Beispielen wird die Grundgesamtheit abstrakt durch eine Variable X

mit einer bestimmten Verteilungsfunktion dargestellt. Kennt man die Parameter der

Verteilungsfunktion, so lässt sich eine Zufallsstichprobe (d.h. eine Folge von Realisierungen) von X mit entsprechenden Zufallszahlengeneratoren erzeugen. Für die

Praxis bedeutsamer ist die Umkehraufgabe: Gegeben ist eine Zufallsstichprobe von

X und es soll mit den Stichprobewerten auf die unbekannten Parameter der Verteilungsfunktion zurück geschlossen werden. Informationen über die Stichprobe gewinnt man im Rahmen einer Datenbeschreibung. Speziell handelt es sich um eine 1-dimensionale oder unvariate Datenbeschreibung, wenn man Stichprobenwerte

von nur einer Variablen betrachtet bzw. bei mehreren Variablen jede Stichprobe für

sich alleine betrachtet. Die Stichprobenwerte einer Variablen X nennt man auch eine

Beobachtungs- oder Messreihe und schreibt sie allgemein in der Form x1 , x2 , . . . , xn

an.

5.1 Datenbeschreibung

303

5.1.2 Lage- und Streuungsmaße

Die Verteilung der Werte x1 , x2 , . . . , xn einer Stichprobe vom Umfang n wird in kompakter Form mit Hilfe von Kennzahlen beschrieben. Dabei ist es nützlich, sich die

Stichprobenwerte als Datenpunkte auf der Zahlengeraden vorzustellen. Das klassische Maß zur Kennzeichnung

des Zentrums der Punkte ist das arithmetische Mit

tel x̄ = ∑ni=1 xi /n. Die Streuung der Datenpunkte um ihr Zentrum, also um x̄, wird

meist durch die Standardabweichung

s

1 n

s=

∑ (xi − x̄)2

n − 1 i=1

bzw. durch die Varianz s2 ausgedrückt. Das arithmetische Mittel und die Standardabweichung – beide Kennzahlen wurden bereits in Abschnitt 1.1 eingeführt – sind

gut interpretierbare Maße für die mittlere Lage bzw. die Streuung der Stichprobenwerte, wenn die Grundgesamtheit annähernd normalverteilt ist und es keine extremen Stichprobenwerte gibt, die durch nicht kontrollierte Störeinflüsse zustande gekommen sind. Sind diese Voraussetzungen nicht erfüllt, verwendet man besser den

Median Q2 als mittleres Lagemaß und den Quartilabstand IQR als Streuungsmaß.

Wie in Abschnitt 1.1 ausgeführt wurde, kann der Median für rangskalierte Daten

(und damit im Besonderen auch für Messdaten) bestimmt werden. Für die Interpretation des Medians ist folgende Eigenschaft nützlich: Mindestens 50% der Stichprobenwerte sind kleiner oder gleich Q2 und mindestens 50% größer oder gleich

Q2 . Wegen dieser Eigenschaft nennt man den Median auch 50%-Quantil. Betrachtet man nur die Stichprobenwerte kleiner oder gleich Q2 und bestimmt für diese

Stichprobenwerte den Median, so erhält man das untere Quartil Q1 der Stichprobe.

Analog kann das obere Quartil Q3 als Median der Stichprobenwerte größer oder

gleich Q2 berechnet werden.1 Für das untere Quartil gilt, dass mindestens 25% der

Stichprobenwerte kleiner oder gleich Q1 und mindestens 75% größer oder gleich

Q1 sind. Für die Quartile sind auch die Bezeichnungen 25%- bzw. 75%-Quantil

gebräuchlich. Zwischen den Quartilen liegen also rund 50% der Stichprobenwerte. Der entsprechende Streubereich wird durch den Quartilabstand IQR = Q3 − Q1

(engl. inter quartile range) erfasst. Zusammen mit dem kleinsten Stichprobenwert

xmin und dem größten Stichprobenwert xmax bilden der Median und die beiden Quartile die sogenannte Fünf-Punkte-Zusammenfassung der Stichprobe. Besonders illustrativ ist, wenn man die Fünf-Punkte-Zusammenfassung in grafischer Form als

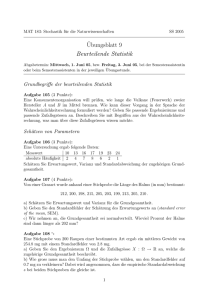

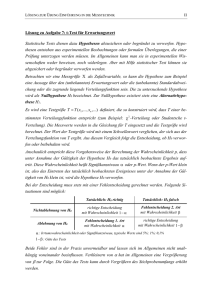

Boxplot wiedergibt. In Abb. 5.1 sind drei Boxplots in vertikaler Lage dargestellt.

Die rechteckige „Box“ wird jeweils unten und oben durch das untere bzw. obere

Quartil begrenzt. Die Strecken innerhalb der Rechtecke geben die Mediane wieder. Die Ausläufer nach unten und oben reichen bis zum Maximum von xmin und

Q1 − 1.5IQR bzw. bis zum Minimum von xmax und Q3 + 1.5IQR. Stichprobenwerte

1

Die so definierten Quartile werden als Angelpunkte (engl. hinges) der Stichprobe bezeichnet.

Man beachte, dass es auch andere Definitionen für die Quartile gibt, die zu geringfügig abweichenden Ergebnissen führen können.

304

5 Schätzen und Testen

0

−1

−3

−2

Variable X

1

2

jenseits der Ausläuferenden werden als isolierte Punkte dargestellt und dadurch als

extreme Stichprobenwerte ausgewiesen.2

Stichprobe 1

Stichprobe 2

Stichprobe 3

Abb. 5.1 Boxplots von drei Stichproben, jede mit dem Umfang 10. Die Zufallsstichproben wurden aus der N(0, 1)-verteilten Grundgesamtheit X mit der R-Funktion rnorm() generiert. Die

Ausläufer der zweiten und dritten Stichprobe gehen jeweils bis zu den kleinsten bzw. größten

Stichprobenwerten. In Stichprobe 1 ist der größte Wert mehr als 1.5 IQR vom oberen Quartil Q3

entfernt und als „ausreißerverdächtiger“ Punkt dem Boxplot hinzugefügt.

Beispiel 5.1.

Von einer normalverteilten Grundgesamtheit X liegt die Zufallsstichprobe

0.449, −0.846, −0.466, 0.084, 0.248, 0.222, 2.315, −0.884, 1.622, 0.058

vor. Wir beschreiben die Stichprobe mit den Kennzahlen xmin (kleinster Stichprobenwert), Q1 (unteres Quartil), Q2 (Median), Q3 (oberes Quartil) und xmax

(größter Stichprobenwert). Ferner bestimmen wir den Quartilabstand und stellen die Stichprobe grafisch durch ein Boxplot dar. Der nach aufsteigender Größe

geordneten Stichprobe

−0.884, −0.846, −0.466, 0.058, 0.084, 0.222, 0.248, 0.449, 1.622, 2.315

2

Die Wahrscheinlichkeit, dass eine normalverteilte Zufallsvariable X einen Wert annimmt, der das

obere Quartil um mehr als das 1.5-fache des Quartilabstandes übertrifft oder das untere Quartil um

den gleichen Betrag unterschreitet, ist klein; sie beträgt ca. 0.7% (vgl. Beispiel 2.23b). Wenn ein

derartiger Wert auftritt, besteht daher der Verdacht, dass er durch einen unerwünschten Störfaktor

verursacht wurde und es sich dabei um einen sogenannten „Ausreißer“ handelt.

5.1 Datenbeschreibung

305

entnimmt man unmittelbar xmin = −0.884, xmax = 2.315, Q2 = 12 (0.084 +

0.222) = 0.153. Das untere Quartil Q = −0.466 ist der Median der Stichprobenwerte, die kleiner oder gleich Q2 sind; das obere Quartil Q3 = 0.449 findet

man als Median der Stichprobenwerte größer oder gleich Q2 . Schließlich ist der

Quartilabstand IQR = Q3 − Q1 = 0.915. Wegen xmax > Q3 + 1.5IQR = 1.5255,

ist xmax als ein extremer Stichprobenwert anzusehen.

>

>

+

>

>

>

>

# Lö s u n g m i t R :

x1 <− c ( 0 . 4 4 9 , − 0 . 8 4 6 , − 0 . 4 6 6 , 0 . 0 8 4 , 0 . 2 4 8 ,

0.222 , 2.315 , −0.884 , 1.622 , 0.058)

xx <− f i v e n u m ( x1 ) # 5−P u n k t e −Zusammenfassung

min <− xx [ 1 ] ; Q1 <− xx [ 2 ] ; Q2 <− xx [ 3 ] ; Q3 <− xx [ 4 ]

max <− xx [ 5 ] ; i q r <− Q3−Q1

p r i n t ( c b i n d ( min , Q1 , Q2 , Q3 , max , i q r ) , d i g i t s = 4 )

min

Q1

Q2

Q3

max

iqr

[ 1 , ] −0.884 −0.466 0 . 1 5 3 0 . 4 4 9 2 . 3 1 5 0 . 9 1 5

> # B o x p l o t s d e r Abb . 5 . 1

> x2 <− c ( − 0 . 4 3 2 , − 0 . 1 2 5 , − 1 . 0 8 8 , − 1 . 3 7 0 , − 0 . 6 1 7 ,

+

0.172 , −0.402 , −1.757 , −0.058 , −1.734)

> x3 <− c ( − 2 . 0 8 9 , − 0 . 2 0 5 , 1 . 3 3 5 , 0 . 5 4 0 , − 1 . 4 5 6 ,

+

−0.162 , −3.533 , 0 . 2 1 0 , 0 . 0 2 0 , − 1 . 2 3 3 )

> x <− d a t a . f r a m e ( x1 , x2 , x3 )

> par ( cex . a x i s = 1. 3 , cex . l a b = 1 . 3 )

> b o x p l o t ( x , names=c ( " S t i c h p r o b e 1 " , " S t i c h p r o b e 2 " ,

+

" S t i c h p r o b e 3 " ) , y l a b =" V a r i a b l e X" , pch = 18 )

5.1.3 Histogrammschätzer

Wenn der Stichprobenumfang n klein ist, beschränkt sich die Datenbeschreibung im

Wesentlichen auf die Angabe der im vorangehenden Punkt behandelten Kennzahlen.

Bei größerem n (etwa ab n = 15) ist eine detailliertere Beschreibung der Variation

der Stichprobenwerte durch Häufigkeitstabellen und Histogramme angebracht.

Die Grundgesamtheit X sei stetig verteilt (z.B. normalverteilt) mit der Dichtefunktion f . Um eine Vorstellung über f zu erhalten, gehen wir von einer Zufallsstichprobe x1 , x2 , . . . , xn aus und zerlegen die X-Achse in k gleich lange, aneinandergrenzende Intervalle (Klassen) I1 , I2 , . . . , Ik . Zur Festlegung der Klassen bestimmen

wir eine passende Klassenbreite b; dies kann z.B. mit der auf Freedman & Diaconis

(1980) zurückgehenden Formel

IQR

b≈2 √

3

n

(5.1)

erfolgen. Als untere Grenze der ersten Klasse I1 wählen wir eine Zahl c0 derart,

dass c0 kleiner als alle Stichprobenwerte ist und in I1 wenigstens ein Stichprobenwert liegt. Die erste Klasse ist das links offene und rechts abgeschlossene Intervall (c0 , c1 ] mit c1 = c0 + b. Daran schließt die zweite Klasse I2 = (c1 , c2 ] mit

c2 = c1 + b an, daran die dritte Klasse I3 = (c2 , c3 ) mit c3 = c2 + b usw. So fort-

306

5 Schätzen und Testen

0.3

0.2

0.1

0.0

Klassenhäufigkeitsdichte

0.4

fahrend gelangt man schließlich zur letzte Klasse Ik = (ck−1 , ck ], die zumindest den

größten Stichprobenwert enthalten muss. Die Anzahl der Untersuchungseinheiten

in der Klasse Ii ist die absolute Klassenhäufigkeit Hi von Ii . Dividiert man Hi

durch den Stichprobenumfang n und die Klassenbreite b, folgt die KlassenhäuHi

der Klasse Ii . Ordnet man nun jedem Wert x der Klasse Ii

figkeitsdichte gi = nb

die Klassenhäufigkeitsdichte gi als Funktionswert zu, so erhält man den sogenannten Histogramm-Schätzer fˆ der Dichtefunktion f von X. Für x-Werte kleiner oder

gleich c0 oder x-Werte größer als ck verlangen wir zusätzlich fˆ(x) = 0. Man beachte,

dass der Inhalt der Fläche, die der Graph von fˆ und die X-Achse einschließen, durch

∑ki=1 gi b = ∑ki=1 Hi /n = 1 gegeben ist. Der Graph von fˆ wird meist als Histogramm

gezeichnet, d.h. als eine Folge von über den Intervallen Ii errichteten Rechtecken mit

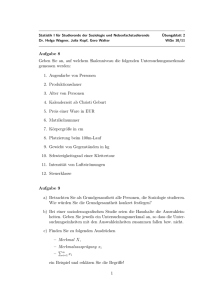

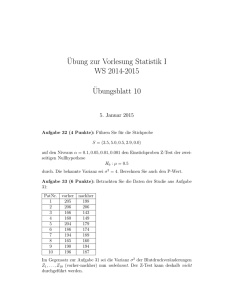

den Höhen gi (i = 1, 2, . . . , k) (vgl. Abb. 5.2). Da die Summe der Rechteckflächen

gleich eins ist, spricht man auch von einem flächennormierten Histogramm.

−3

−2

−1

0

1

2

3

X

Abb. 5.2 Flächennormiertes Histogramm einer Stichprobe mit dem Umfang n = 25 aus einer standardnormalverteilten Grundgesamtheit X. Die Realisierungen von X wurden mit der R-Funktion

rnorm(25) erzeugt. Die Dichtekurve der N(0, 1)-Verteilung ist punktiert eingezeichnet.

Beispiel 5.2.

Mit einem Zufallszahlengenerator wurden n = 25 Realisierungen einer N(0, 1)verteilten Zufallsvariablen X erzeugt. Die nach aufsteigender Größe sortierte

Stichprobe ist:

−2.16, −1.50, −1.17, −1.03, −0.98, −0.91, −0.84, −0.51, −0.43, −0.42,

−0.39, −0.31, −0.24, −0.17, 0.13, 0.18, 0.37, 0.37, 0.50, 0.66,

0.87, 1.17, 1.25, 1.26, 2.88

5.1 Datenbeschreibung

307

Wir stellen die Variation der Stichprobenwerte durch ein Histogramm dar.

Dazu nehmen wir eine Klasseneinteilung vor und bestimmen zuerst die Klassenbreite b. Der sortierten Stichprobe entnimmt man den kleinsten Wert xmin =

−2.6, das 25%-Quantil (Median der ersten 13 Stichprobenwerte) Q2 = −0.84

und das 75%-Quantil Q4 =√

0.5. Daher ist der Quartilabstand IQR = 1.34 und die

Klassenbreite b = 2·1.34/ 3 25 = 0.92 ≈ 1. Mit der unteren Grenze c0 = −3 der

ersten Klasse ergeben sich die Klassen I1 = (−3, −2], I2 = (−2, −1], . . . , I6 =

(2, 3]. Die absoluten Klassenhäufigkeiten sind H1 = 1, H2 = 3, H3 = 10, H4 =

7, H5 = 3, H6 = 1. Die Klassenhäufigkeitsdichten sind g1 = 1/25 = 0.04, g2 =

3/25 = 0.12, g3 = 10/25 = 0.40, g4 = 7/25 = 0.28, g5 = 3/25 = 0.12, g6 =

1/25 = 0.04. Das damit erstellte Histogramm ist in Abb. 5.2 wiedergegeben.

> # Lö s u n g m i t R :

> x <− c ( − 2 . 1 6 , − 1 . 5 0 , − 1 . 1 7 , − 1 . 0 3 , − 0 . 9 8 ,

+

−0 . 9 1 , −0 . 8 4 , −0. 51 , −0. 43 , −0. 42 ,

+

−0 .3 9 , −0 . 31 , −0.24 , −0.17 , 0 . 1 3 ,

+

0.18 , 0.37 , 0.37 , 0.50 , 0.66 ,

+

0.87 , 1.17 , 1.25 , 1.26 , 2.88)

> n <− l e n g t h ( x ) ; i q r <− f i v e n u m ( x ) [ 4 ] − f i v e n u m ( x ) [ 2 ]

> b <− r o u n d ( 2 ∗ i q r / n ^ ( 1 / 3 ) ) ; b # K l a s s e n b r e i t e ( g e r u n d e t )

[1] 1

> r e s <− h i s t ( x , b r e a k s ="FD " , p l o t =F )

> c <− r e s $ b r e a k s ; p r i n t ( c ) # K l a s s e n g r e n z e n

[ 1 ] −3 −2 −1 0 1 2 3

> H <− r e s $ c o u n t s # a b s o l u t e K l a s s e n h ä u f i g k e i t e n

> g <− H / b / n

# Klassenh ä u f i g h k e i t s d i c h t e n

> p r i n t ( r b i n d (H, g ) )

[ ,1] [ ,2] [ ,3] [ ,4] [ ,5] [ ,6]

H 1.00 3.00 10.0 7.00 3.00 1.00

g 0.04 0.12 0.4 0.28 0.12 0.04

Aufgaben

1. Die wiederholte Messungen der Konzentration eines Wirkstoffes ergab im Rahmen eines Ringversuches für zwei Labors die folgenden Werte (Angaben in

mg/l):

Labor A : 2.51 2.36 3.09 2.82 2.42 2.65 2.77 2.34

Labor B : 3.05 2.86 3.41 3.13 3.59 2.83 2.53 3.04

Man vergleiche die Stichproben numerisch mit den Kennzahlen der 5-PunkteZusammenfassung und grafisch durch Boxplots.

2. Die Messgröße Y sei N(µ, σ 2 )-verteilt. Von Y liegt die folgende Messreihe vor

(Angaben in mg):

4.99, 5.40, 6.91, 5.49, 3.91, 4.55, 4.97, 5.11, 5.57, 6.19,

4.15, 4.84, 4.57, 5.20, 3.55, 4.48, 5.13, 4.52, 5.33, 5.65.

308

5 Schätzen und Testen

a) Man berechne auf der Grundlage einer geeigneten Klasseneinteilung die absoluten Klassenhäufigkeiten sowie die Klassenhäufigkeitsdichten und stelle

die Variation der Stichprobenwerte grafisch durch ein flächennormiertes Histogramm dar.

b) Man zeichne die Dichtekurve einer an die Stichprobenwerte angepassten

N(µ, σ 2 )-Verteilung in die Grafik mit dem Histogramm ein; die Anpassung

nehme man so vor, dass die Parameter µ und σ näherungsweise durch das

arithmetische Mittel x̄ bzw. die Standardabweichung s der Stichprobenwerte

ersetzt wird.

5.2 Parameterschätzung bei normalverteilter Grundgesamtheit

5.2.1 Stichprobenmittel und Stichprobenvarianz

Es sei X eine N(µ, σ 2 )-verteilte Grundgesamtheit. Schon die übereinstimmende

Benennung des Mittelwerts µ der Grundgesamtheit X und des Mittelwerts x̄n =

∑ni=1 xi /n einer Zufallsstichprobe x1 , x2 , . . . , xn aus X legt nahe, x̄n als einen Schätzwert für µ zu betrachten. Tatsächlich ist es vorteilhaft, µ durch x̄n zu schätzen.

Bevor wir uns mit der Frage befassen, wie man die Güte eines Schätzverfahrens beurteilen kann, ist es wichtig, x̄n als Realisierung einer Zufallsvariablen zu begreifen;

für diese Zufallsvariable schreiben wir X̄n und bezeichnen sie als Stichprobenmittel. Durch das Stichprobenmittel X̄n wird also jeder n-elementigen Zufallsstichprobe

aus X das arithmetische Mittel x̄n dieser Stichprobe zugeordnet. Um die Abhängigkeit von einer Stichprobe auszudrücken, nennt man das Stichprobenmittel daher

auch eine Stichprobenfunktion oder Schätzfunktion. Wir stellen uns nun sehr viele Zufallsstichproben x1 , x2 , . . . , xn aus der Grundgesamtheit X vor und berechnen

zu jeder Stichprobe das arithmetische Mittel. Dann kann man die Variation dieser

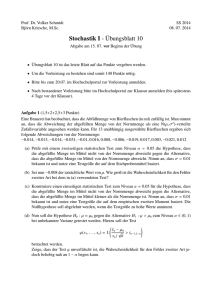

arithmetischen Mittelwerte durch ein Histogramm darstellen und damit die Dichtefunktion von X̄n schätzen. In Abb. 5.3 wurde diese Idee umgesetzt. Das Beispiel

lässt vermuten, dass das Stichprobenmittel wie die Grundgesamtheit mit demselben Mittelwert normalverteilt ist, die Standardabweichung des Stichprobenmittels

jedoch unter der Standardabweichung der Grundgesamtheit liegt.

Diese Vermutung gilt allgemein für jedes n > 1 und kann wie folgt präzisiert

werden:

• Bei einer mit dem Mittelwert µX und der Standardabweichung σX normalverteilter Grundgesamtheit X ist für jedes n > 1 auch das Stichprobenmittel X̄n

normalverteilt.3

• Für den Mittelwert und die Standardabweichung des Stichprobenmittels gilt:

3

Ist X nicht normalverteilt, so „nähert“ sich nach dem zentralen Grenzwertsatz die Verteilung von

X̄n mit wachsendem n einer Normalverteilung mit den durch (5.2) gegebenen Parametern.

0.0 0.5 1.0 1.5 2.0

Dichte

5.2 Parameterschätzung bei normalverteilter Grundgesamtheit

309

X9

X

0

1

2

3

4

X, X9

Abb. 5.3 Darstellung der Verteilung der arithmetischen Mittel von 10000 Zufallstichproben, jede

mit dem Umfang n = 9, aus der Grundgesamtheit X ∼ N(µ, σ 2 ) mit µ = 2 und σ = 0.7 durch ein

Histogramm. Die Grundgesamtheit X ist punktiert und die exakte Dichte des Stichprobenmittels

X̄9 strichliert eingezeichnet.

σX

µX̄n = µX und σX̄n = √ (n = 2, 3, . . .)

n

(5.2)

Das Ergebnis (5.2) ist von großer praktischer Bedeutung. Die erste Gleichung bringt

zum Ausdruck, das der Mittelwert µX̄n des Stichprobenmittels X̄n gleich dem Mittelwert µX der Grundgesamtheit X ist. Man bezeichnet diese Eigenschaft des Stichprobenmittels als erwartungstreu.4 Es ist üblich, die Güte der Schätzung des Mittelwertes µX mit dem Stichprobenmittel durch den mittleren quadratischen Fehler

MSE(X̄n ) (mean squared error) zu bewerten. Dieser ist gleich dem Mittelwert aus

dem Quadrat der Abweichung X̄n − µX des Stichprobenmittels vom Mittelwert µX

der Grundgesamtheit. Wenn MSE(X̄n ) klein ist, hat man eine hohe Wahrscheinlichkeit, dass das Stichprobenmittel einen Wert in einer kleinen Umgebung um µX

annimmt. Wegen (5.2) ist der mittlere quadratische Fehler des Stichprobenmittels

durch

σ2

MSE(X̄n ) = µ(X̄n −µX )2 = X

(5.3)

n

gegeben und geht mit wachsendem n gegen null. Eine Schätzfunktion, für die der

mittlere quadratische Fehler für n → ∞ verschwindet, wird konsistent im quadratischen Mittel genannt. Das Stichprobenmittel ist eine im quadratischen Mittel konsistente Schätzfunktion für µX . Die Wurzel aus dem mittleren

√ quadratischen Fehler

des Stichprobenmittels wird als Standardfehler σX̄ = σX / n des Mittelwerts bezeichnet.

4

Die Eigenschaft „erwartungstreu“ kann man anschaulich so umschreiben: Wählt man wiederholt Zufallsstichproben desselben Umfangs aus X aus und berechnet mit dem Stichprobenmittel

Schätzwerte für µX , so stimmt das arithmetische Mittel dieser Schätzwerte umso besser mit µX

überein, je größer die Zahl der Wiederholungen ist.

310

5 Schätzen und Testen

0.00

Dichte

0.04

0.08

0.12

Die (empirische) Varianz einer Zufallsstichprobe x1 , x2 , . . . , xn aus der Grund1

gesamtheit X wurde in Abschnitt 1.1 durch die Formel s2n = n−1

∑ni=1 (xi − x̄n )2

2

definiert. Analog zum arithmetischen Mittel x̄n ist auch sn als Realisierung einer

Zufallsvariablen zu sehen, die man als Stichprobenvarianz Sn2 bezeichnet. Durch

die Stichprobenvarianz wird jeder n-elementigen Zufallsstichprobe aus X die empirische Varianz s2n zugeordnet. Um eine Vorstellung von der Verteilung der Stichprobenvarianz zu erhalten, denken wir uns wieder eine große Anzahl von n-elementigen

Zufallsstichproben aus der Grundgesamtheit X und berechnen für jede dieser Stichproben die Varianz. Stellt man die Variation der erhaltenen Varianzen mit Hilfe eines

Histogramms dar, so erhält man eine Grafik von der Art der Abb. 5.4. In dieser Abbildung ist die Grundgesamtheit X als normalverteilt mit den Parametern µX = 2 und

σX2 = 0.7 angenommen und der Umfang der Zufallsstichproben mit n = 9 festgelegt.

Horizontal ist die mit (n−1)/σ 2 multiplizierte Stichprobenvarianz aufgetragen. Die

Verteilung der Größe (n − 1)Sn2 /σX2 kann exakt angegeben werden: Es handelt sich

dabei um die Chiquadrat-Verteilung mit n − 1 Freiheitsgraden.

0

5

10

(n − 1)S2 σ2

15

20

Abb. 5.4 Histogramm der mit dem Faktor (n − 1)/σX2 multiplizierten Varianzen von 10000 Zufallsstichproben (jede mit dem Umfang n = 9) aus der Grundgesamtheit X ∼ N(µX , σX2 ) mit µX = 2

und σX = 0.7. Die Dichtekurve der exakten χ82 -Verteilung ist strichliert eingezeichnet.

Die Chiquadrat-Verteilung gehört zu den grundlegenden theoretischen Verteilungen der Statistik. Sie besitzt einen Parameter, den man als Freiheitsgrad f bezeichnet. Der Mittelwert und die Varianz der Verteilung sind durch f bzw. 2 f gegeben.

Die Dichtefunktion ist nur für nichtnegative Argumente definiert. Die ChiquadratVerteilung mit f Freiheitsgraden wird kurz durch das Symbol χ 2f dargestellt. Für die

Anwendungen sind vor allem die Quantile die Verteilung wichtig. Das p-Quantil

einer χ 2f -verteilten Zufallsvariablen ist jene reelle Zahl χ 2f ,p , die von einer χ 2f verteilten Zufallsvariablen mit der Wahrscheinlichkeit p unterschritten wird.

Man kann zeigen, dass mit der Stichprobenvarianz S2 die Varianz σX2 der Grundgesamtheit erwartungstreu geschätzt wird, d.h. der Mittelwert von Sn2 stimmt mit

5.2 Parameterschätzung bei normalverteilter Grundgesamtheit

311

σX2 überein.5 Die Varianz der Stichprobenvarianz ist σS22 = 2σX4 /(n − 1). Damit erhält man als mittleren quadratischen Fehler der Stichprobenvarianz:

MSE(Sn2 ) = µ(Sn2 −σ 2 )2 =

X

2σX4

n−1

(5.4)

Dieser geht mit wachsendem n gegen null. Die Stichprobenvarianz ist eine im quadratischen Mittel konsistente Schätzfunktion für σX2 . Dies bedeutet, dass die Varianz

σX2 der Grundgesamtheit vor allem bei größerem n recht genau durch die empirische

Varianz s2n geschätzt werden kann. Als Schätzwert für die Standardabweichung σX

nimmt man meist die empirische Standardabweichung sn . Setzt man diese für σX√in

die Formeln 5.3 und 5.4 ein, ergibt sich der empirische Standardfehler

p σ̂X̄ = sn / n

des Stichprobenmittels bzw. der empirische Standardfehler σ̂S2 = s2n 2/(n − 1) der

Stichprobenvarianz.

Beispiel 5.3.

Im Zuge der Überwachung der Herstellung von Injektionsnadeln wurde aus der

laufenden Produktion eine Prüfstichprobe von n = 10 Nadeln entnommen und

die Außendurchmesser (in mm) 0.54, 0.53, 0.33, 0.52, 0.60, 0.50, 0.52, 0.40,

0.56, 0.45 gemessen. Wir bestimmen das arithmetische Mittel, die empirische

Varianz sowie den empirischen Standardfehler des arithmetischen Mittels und

der Varianz.

>

>

+

>

>

>

>

>

>

# Lö s u n g m i t R :

x <− c ( 0 . 5 4 , 0 . 5 3 , 0 . 3 3 , 0 . 5 2 , 0 . 6 0 ,

0.50 , 0.52 , 0.40 , 0.56 , 0.45)

n <− l e n g t h ( x ) # S t i c h p r o b e n u m f a n g

x q u e r <− mean ( x ) # a r i t h m e t i s c h e s M i t t e l

s 2 <− v a r ( x ) # emp . V a r i a n z

SE . x q u e r <− s q r t ( s 2 / n ) # emp . S t a n d a r d f e h l e r d . M i t t e l s

SE . s 2 <− s 2 ∗ s q r t ( 2 / ( n −1)) # emp . S t a n d a r d f e h l e r d . V a r i a n z

p r i n t ( c b i n d ( x q u e r , SE . x q u e r , s2 , SE . s 2 ) , d i g i t s = 3 )

x q u e r SE . x q u e r

s2

SE . s 2

[ 1 , ] 0.495

0.0254 0.00645 0.00304

5.2.2 Konfidenzintervalle für den Mittelwert und die Varianz

√

Die empirische Standardabweichung σ̂X̄ = sn / n ist ein einfaches Maß, mit dem

man die Genauigkeit des arithmetischen Mittels bei der Schätzung des Mittelwerts

µX der Grundgesamtheit X beurteilen kann. Ein kleiner Standardfehler bedeutet eine

höhere Genauigkeit als ein großer. Durch Erhöhung des Umfangs einer Stichprobe

wird der Standardfehler im Allgemeinen kleiner und folglich die Genauigkeit der

p

Dagegen stimmt der Mittelwert µSn der Stichproben-Standardabweichung Sn = Sn2 nicht mit

der Standardabweichung σX der Grundgesamtheit überein. Vielmehr ist µSn = kn σX mit kn < 1.

Z.B. ist k2 = 0.7979, k5 = 0.9400, k10 = 0.9727. Mit wachsendem n strebt kn gegen 1.

5

312

5 Schätzen und Testen

Schätzung größer. Eine präzisere Aussage über die Genauigkeit eines Schätzwertes

ist mit einem Konfidenzintervall möglich.

Zu einem (zweiseitigen) Konfidenzintervall für den Mittelwert µX der (als normalverteilt angenommenen) Grundgesamtheit X kommt man auf folgende Weise: Man gibt eine kleine Wahrscheinlichkeit α vor (z.B. α = 5%) und bestimmt

zwei Zufallsvariable U und O so, dass P(U > µX ) = P(O < µX ) = α/2 gilt. Die

Wahrscheinlichkeit, dass das Intervall [U, O] den Mittelwert µX überdeckt, d.h.

U ≤ µX ≤ O gilt, soll also 1 − α betragen. Die Größen U und O bilden die Grenzen des Konfidenzintervalls. Die Überdeckungswahrscheinlichkeit 1 − α wird auch

Konfidenzniveau genannt und zumeist mit 95% angenommen.

a) Konfidenzintervall für den Mittelwert bei bekannter Varianz. Die Bestimmung der Grenzen U und O nehmen wir zuerst für den Fall vor, das die Standard√X standardnormalverteilt und es gilt

abweichung σX bekannt ist. Dann ist X̄σn −µ

/ n

n

X̄n − µX

√ ≤ z1−α/2 = Φ(z1−α/2 ) − Φ(zα/2 ) = 1 − α.

P zα/2 ≤

σn / n

Hier sind z1−α/2 und zα/2 = −z1−α/2 das (1 − α/2)-Quantil bzw. das α/2-Quantil

der N(0, 1)-Verteilung. Nach einer einfachen Umformung der Ungleichungskette

auf der linken Seite erhält man daraus

P (X̄n + d ≥ µX ≥ X̄n − d) = 1 − α

σn

mit d = z1−α/2 √

. Somit ist die Wahrscheinlichkeit, dass µX von den Zufallsvan

riablen X̄n − d und X̄n + d eingeschlossen ist, gleich dem Konfidenzniveau 1 − α.

Genau das wird aber von den Grenzen U und O eines (1 − α)-Konfidenzintervalls

für µX verlangt, so dass wir

σX

U = X̄n − d, O = X̄n + d mit d = z1−α/2 √

n

(5.5a)

schreiben können. Hat man eine konkrete Zufallsstichprobe, kann man in (5.5a) für

das Stichprobenmittel das arithmetische Mittel x̄n einsetzen und erhält damit konkrete Realisierungen u und o der Grenzen U bzw. O. Man bezeichnet das mit diesen

Realisierungen gebildete Intervall [u, o] als ein empirisches Konfidenzintervall.

Der (unbekannte) Mittelwert µX wird von diesem Intervall entweder eingeschlossen oder nicht. Berechnet man mit einer großen Anzahl von Zufallsstichproben die

entsprechenden empirischen Konfidenzintervalle, so kann man erwarten, dass von

diesen der Anteil 1 − α den Mittelwert µX einschließt. Man kann den Sachverhalt

auch so ausdrücken: Die Wahrscheinlichkeit, mit einer Zufallsstichprobe ein empirisches Konfidenzintervall zu erhalten, das den Mittelwert µX einschließt, ist angenähert 1 − α.

Die halbe Breite d des Konfidenzintervalls wird oft zur Kennzeichnung der Genauigkeit der Schätzung herangezogen. Man beachte, dass d abnimmt, wenn n oder

5.2 Parameterschätzung bei normalverteilter Grundgesamtheit

313

α vergrößert wird.6 In der Regel gibt man bei einer Schätzung die Genauigkeit d

und die Sicherheit 1 − α vor und ermittelt den zur Einhaltung der Vorgaben erforderlichen Mindeststichprobenumfang. Dieser ist die kleinste ganze Zahl n∗ mit

der Eigenschaft

z1−α/2 σX 2

∗

.

(5.5b)

n ≥n=

d

Beispiel 5.4.

In einer Anlage soll ein Desinfektionsmittel in Flaschen mit 500ml abgefüllt

werden. Nach einer Störung und Neustellung der Anlage werden probeweise

20 Flachen abgefüllt. Dabei ergaben sich folgende Abfüllmengen (in ml):

501, 516, 498, 503, 518, 498, 479, 499, 502, 475,

505, 504, 491, 495, 505, 486, 494, 479, 502, 506.

Die Abfüllmenge X sei N(µX , σX2 )-verteilt mit dem (unbekannten) Mittelwert

µX . Als Standardabweichung wurde vom Anlagenbauer σX = 10 angegeben.

Um die Neueinstellung zu kontrollieren, schätzen wir mit der Stichprobe aus

dem Probebetrieb den Mittelwert µX und geben für µX ein 95%iges Konfidenzintervall an.

Der Stichprobe ist n = 10 und x̄ = 497.8 als Schätzwert für µX zu entnehmen. Mit α√= 1 − 0.95 = 0.05 und z1−α/2 = z0.975 = 1.96 ergibt sich

d = z1−α/2 σX / n = 1.96 · 10/4.47 = 4.38. Damit findet man die Grenzen

u = x̄ − d = 493.4 und o = x̄ + d = 502.2. Strebt man einer genauere Schätzung des Mittelwerts µX an, etwa eine Intervallschätzung mit d = 3, folgt bei

gleicher Sicherheit 1 − α = 0.95 aus Formel (5.5b) n = (1.96 · 10/3)2 = 42.7;

der erforderliche Mindeststichprobenumfang beträgt daher n∗ = 43.

>

>

+

>

>

>

>

>

>

>

>

>

# Lö s u n g m i t R :

x <− c ( 5 0 1 , 5 1 6 , 4 9 8 , 5 0 3 , 5 1 8 , 4 9 8 , 4 7 9 , 4 9 9 , 5 0 2 , 4 7 5 ,

505 , 504 , 491 , 495 , 505 , 486 , 494 , 479 , 502 , 506)

s i g m a <− 10 # S t a n d a r d a b w e i c h u n g

n <− l e n g t h ( x ) # S t i c h p r o b e n u m f a n g

# a ) Sch ä t z w e r t und 95%− K o n f i d e n z i n t e r v a l l

x q u e r <− mean ( x ) # a r i t h m e t i s c h e s M i t t e l

a l p h a <− 0 . 0 5 # G e g e n w a h r s c h e i n l i c h k e i t zum K o n f i d e n z n i v e a u

zq <− qnorm (1− a l p h a / 2 ) # (1− a l p h a /2) − Q u a n t i l d . N( 0 , 1 ) − V e r t .

d <− zq ∗ s i g m a / s q r t ( n ) # h a l b e I n t e r v a l l b r e i t e

u <− x q u e r −d ; o <− x q u e r +d # I n t e r v a l l g r e n z e n

p r i n t ( cbind ( xquer , d , u , o ) , d i g i t s =4)

xquer

d

u

o

[ 1 , ] 497.8 4.383 493.4 502.2

> # b ) e r f o r d e r l i c h e s M i n d e s t −n

> d <− 3 # G e n a u i g k e i t s v o r g a b e

> n s <− c e i l i n g ( ( zq ∗ s i g m a / d ) ^ 2 ) ; n s # M i n d e s t −n

[ 1 ] 43

6 Wenn α zunimmt, wird 1 − α/2 kleiner und damit auch das Quantil z

1−α/2 . Ein größeres α

bedeutet ein kleineres Konfidenzniveau 1 − α, das in diesem Zusammenhang auch als Sicherheit

der Schätzung bezeichnet wird.

314

5 Schätzen und Testen

b) Konfidenzintervall für den Mittelwert bei unbekannter Varianz. Im Allgemeinen ist die Varianz der Grundgesamtheit nicht bekannt. Um ein Konfidenzintervall für den Mittelwert µX bei unbekannter Varianz zu erhalten, müssen die Grenzen

(5.5a) auf

Sn

(5.6)

U = X̄n − D, O = X̄n + D mit D = tn−1,1−α/2 √

n

abgeändert werden. In dieser Formel ist Sn die Quadratwurzel der Stichprobenvarianz Sn2 . Mit dem Großbuchstaben D wird zum Ausdruck gebracht, dass die halbe Intervallbreite über Sn von der Zufallsstichprobe abhängt und folglich eine Zufallsvariable ist. Die Größe tn−1,1−α/2 bezeichnet das (1 − α/2)-Quantil der tn−1 Verteilung, die wie die Chiquadrat-Verteilung eine wichtige theoretische Verteilung

der Statistik darstellt.

Nach Abschnitt 5.2.1 ist das Stichprobenmittel X̄n bei N(µX , σX2 )-verteilter Grundgesamtheit

X normalverteilt mit dem Mittelwert

µX̄n = µX und der Varianz σX̄n =

√

√

man

σX / n. Es folgt, dass (X̄n − µX )/(σX / n) standardnormalverteilt ist. Schätzt√

σX im Nenner durch Sn , erhält man die Zufallsvariable X̄n∗ = (X̄n − µX )/(Sn / n),

deren Verteilung bei großem n praktisch mit der N(0, 1)-Verteilung zusammenfällt,

bei kleinem n aber deutlich abweicht. Die Verteilung von X̄n∗ ist eine t-Verteilung

mit f = n − 1 Freiheitsgraden (n = 2, 3, . . .), wofür man auch kurz X̄n∗ ∼ tn−1

schreibt. Abb. 5.5 zeigt beispielhaft die Verteilung von X̄n∗ für n = 3, die näherungsweise durch einen auf 10000 Zufallsstichproben basierenden Histogrammschätzer

und exakt durch die t2 -Verteilung dargestellt ist. Man erkennt, dass die Dichtekurve

symmetrisch um die Nullstelle verläuft. Dies gilt auch für jedes n > 2; mit wachsendem n nähert sich die Verteilung von X̄n∗ der N(0, 1)-Dichte.7 Die Varianz der

t f -Verteilung ist für f = 3, 4, · · · durch f /( f − 2) gegeben.

Beispiel 5.5.

Wir demonstrieren die Anwendung der Formel (5.6) an Hand der Zufallsstichprobe 10.07, 10.02, 9.99, 10.01, 9.98 aus einer N(µ, σ 2 )-verteilten Grundgesamtheit X und bestimmen damit eine Realisierung des 95%igen Konfidenzintervall für µ. Es ist n = 5, x̄ = 10.01 und s = 0.03507. Mit α = 1 − 0.95 =

0.05 und dem t-Quantil tn−1,1−α/2 = t4,0.975 = 2.776

√ erhält man als Realisierung der halben Intervallbreite d = tn−1,1−α/2 s/ n = 0.04355 und damit

die Grenzen u = x̄ − d = 9.97 und o = x̄ + d = 10.06 des empirischen 95%Konfidenzintervalls für µ.

>

>

>

>

# Lö s u n g m i t R :

x <− c ( 1 0 . 0 7 , 1 0 . 0 2 , 9 . 9 9 , 1 0 . 0 1 , 9 . 9 8 )

n <− l e n g t h ( x ) ; x q u e r <− mean ( x ) ; s <− s d ( x )

p r i n t ( cbind ( n , xquer , s ) , d i g i t s =4)

n xquer

s

[ 1 , ] 5 10.01 0.03507

> a l p h a <− 0 . 0 5

Die Verteilung von X̄n∗ wurde vom englischen Statistiker W. S. Gosset (1876-1937) untersucht,

der seine Ergebnisse unter dem Pseudonym „Student“ veröffentlichte. Die t-Verteilung wird daher

auch als Student-Verteilung und die Größe X̄n∗ wird als studentisiertes Stichprobenmittel bezeichnet.

7

315

0.0

0.1

Dichte

0.2 0.3

0.4

5.2 Parameterschätzung bei normalverteilter Grundgesamtheit

−3

−2

−1

0

X*

1

2

3

√

Abb. 5.5 Verteilung des studentisierten Stichprobenmittels X̄n∗ = (X̄n − µX )/(Sn / n): Aus der

Grundgesamtheit X ∼ N(µX , σX2 ) mit µX = 2 und σX = 0.7 wurden 10000 Zufallsstichproben

(jede mit dem Umfang n = 3) ausgewählt und die Variation der Realisierungen von X̄n∗ durch ein

flächennormiertes Histogramm dargestellt. Die Dichtekurve der exakten t2 -Verteilung ist strichliert

und die Standardnormalverteilungsdichte punktiert eingezeichnet.

q <− q t (1− a l p h a / 2 , n −1) # Q u a n t i l d . t −V e r t e i l u n g

s e <− s / s q r t ( n ) # S t a n d a r d f e h l e r d . S t i c h p r o b e n m i t t e l s

d <− q∗ s e # h a l b e Lä nge d e s K o n f i d e n z i n t e r v a l l s

u <− x q u e r −d ; o <− x q u e r +d # G r e n z e n d . K o n f i d e n z i n t e r v a l l s

p r i n t ( c b i n d ( a l p h a , q , se , d , u , o ) , d i g i t s = 4 )

alpha

q

se

d

u

o

[ 1 , ] 0.05 2.776 0.01568 0.04355 9.97 10.06

>

>

>

>

>

c) Konfidenzintervall für die Varianz. Wie bei der Mittelwertschätzung sei X normalverteilt mit dem Mittelwert µX und der Varianz σX2 . Bei der Bestimmung eines

(1 − α)-Konfidenzintervalles für die Varianz σX2 gehen wir davon aus, dass die mit

(n − 1)/σX2 multiplizierte Stichprobenvarianz Sn2 chiquadratverteilt ist mit dem Frei2

heitsgrad n − 1. Es folgt, dass die Größe (n − 1)Sn2 /σX2 die Quantile χn−1,α/2

und

2

χn−1,1−α/2 mit der Wahrscheinlichkeit α/2 unter- bzw. überschreitet. Dies bedeutet, dass (n − 1)Sn2 /σX2 mit der Wahrscheinlichkeit 1 − α einen Wert zwischen den

genannten Quantilen annimmt. Somit gilt:

(n − 1)Sn2

2

2

≤ χn−1,1−α/2

1 − α = P χn−1,α/2 ≤

σX2

!

1

σX2

1

=P

≥

≥ 2

2

(n − 1)Sn2

χn−1,α/2

χn−1,1−α/2

!

(n − 1)Sn2

(n − 1)Sn2

2

≥ σX ≥ 2

=P

2

χn−1,α/2

χn−1,1−α/2

Aus der zuletzt erhaltenen Beziehung lassen sich unmittelbar die Grenzen

316

5 Schätzen und Testen

Uσ 2 =

(n − 1)Sn2

(n − 1)Sn2

und Oσ 2 = 2

2

χn−1,1−α/2

χn−1,α/2

(5.7)

des gesuchten Konfidenzintervalls für die Varianz σX2 ablesen.8 Indem man für die

Stichprobenvarianz die aus einer Zufallsstichprobe des Umfangs n berechnete Realisierung s2n einsetzt, erhält man für σX2 ein empirisches (1 − α)-Konfidenzintervall.9 .

Beispiel 5.6.

Es sei 2.01, 2.15, 1.98, 1.95, 2.22, 1.98, 1.96, 1.88, 2.09, 1.92 eine Zufallsstichprobe aus einer normalverteilten Grundgesamtheit X. Die Stichprobe hat

den Umfang n = 10, das arithmetische Mittel x̄ = 2.014, die Standardabweichung s = 0.1069 und die Varianz s2 = 0.01143. Wir berechnen mit den Formeln (5.10) die Grenzen eines 95%igen Konfidenzintervalls für σX2 . Aus dem

vorgegebenen Konfidenzniveau 1 − α folgt α = 0.05. Für die untere Grenze

2

2

wird das Quantil χn−1,1−α/2

= χ9,0.975

= 19.02 benötigt, für die obere Gren2

2

ze das Quantil χn−1,α/2 = χ9,0.025 = 2.700. Indem man s2n = 0.01143 für Sn2 ,

n = 10 und die Werte für die Quantile in (5.7) einsetzt, ergeben sich die mit

unserer Stichprobe realisierten Grenzen uσ 2 = 0.0054 und oσ 2 = 0.038. Die

X

X

entsprechenden Grenzen eines 95%igen Konfidenzintervalls für die Standard√

√

abweichung σX sind uσ = uσ 2 = 0.0735 bzw. oσ = oσ 2 = 0.195.

Die im Beispiel verwendete Stichprobe mit dem Umfang n = 10 wurde mit

der R-Funktion rnorm(10, 2, 0.1) aus der normalverteilten Grundgesamtheit X (µX = 2, σX = 0.1) generiert. Der mit dieser Stichprobe berechnete

Schätzwert s2n = 0.01143 sowie die Grenzen des 95%igen Konfidenzintervalls

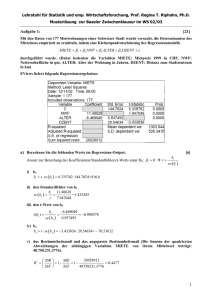

für σX2 sind im ersten Intervall von Abb. 5.6 dargestellt. Die anderen Intervalle der Abbildung wurden auf die gleiche Weise ermittelt. Wie man sieht, kann

ein empirisches Konfidenzintervall den wahren Parameter (hier σX2 ) einschließen oder nicht. Die Wahrscheinlichkeit, dass durch eine Zufallsstichprobe ein

Intervall realisiert wird, das den wahren Parameter einschließt, ist gleich dem

Konfidenzniveau 1 − α (hier 95%).

5.2.3 Konfidenzintervall für den Anstieg einer Regressionsgeraden

Im Abschnitt 2.1.3 wurden lineare Regressionsaufgaben betrachtet. Dabei ging es

um folgendes Problem: Von zwei Variablen x und Y ist eine Wertetabelle aus n

p

p

p

8 Wegen 1 − α = P U

2

Uσ 2 ≤ σX ≤ Oσ 2 sind Uσ = Uσ 2 und Oσ =

σ 2 ≤ σX ≤ Oσ 2 = P

p

Oσ 2 die Grenzen des entsprechenden Konfidenzintervalls für die Standardabweichung σX .

9 Beim Konfidenzintervall für den Mittelwert liegen die Grenzen symmetrisch um den Schätzwert

x̄n für µX . Im Gegensatz dazu liegt beim Konfidenzintervall für die Varianz der Schätzwert s2n für

σX2 nicht in der Mitte des Intervalls, sondern näher bei der unteren Grenze.

10

15

20

25

317

5

95%−Konfidenzintervalle für σ2X

5.2 Parameterschätzung bei normalverteilter Grundgesamtheit

0.00

0.02

0.04

Varianz

0.06

0.08

Abb. 5.6 Realisierungen des Konfidenzintervalls [Uσ 2 , Oσ 2 ] für die Varianz. Mit der R-Funktion

rnorm() wurden 25 Zufallsstichproben, jede mit dem Umfang n = 10, aus der mit µX = 2 und

σX2 = 0.01 normalverteilten Grundgesamtheit X erzeugt. Für jede Stichprobe sind die empirische

Varianz s2n (als Punkt) sowie das mit den Formeln (5.7) berechnete 95%ige Konfidenzintervall für

σX2 dargestellt. Die strichpunktierte Linie zeigt die Lage der wahren Varianz σX2 = 0.01 an. Man

beachte, dass 2 Intervalle die wahre Varianz nicht überdecken.

Wertepaaren (xi , yi ) (i = 1, 2, . . . , n) gegeben.10 Zur Erfassung der Abhängigkeit der

Variablen Y von x durch eine lineare Funktion denken wir uns die beobachteten

Y -Werte durch die Modellgleichung Y = f (x) + R mit f (x) = kx + d erzeugt. Der

lineare Term f (x) = kx + d mit den unbestimmten Konstanten k und d bildet den

Anteil von Y , der durch die Variable x erklärt werden kann. Diesem Anteil ist die

Zufallskomponente R überlagert, die wir als normalverteilt mit dem Mittelwert null

und einer gewissen Varianz σR2 annehmen wollen. Folglich ist auch Y für jedes feste x eine normalverteilte Zufallsvariable mit dem Mittelwert µY = f (x) = kx + d

und der Varianz σR2 . Die Regressionsfunktion f ordnet also jedem x den Mittelwert µY = f (x) = kx + d von Y zu. Man bezeichnet Y als abhängige Variable oder

Zielvariable, x als unabhängige Variable oder Einflussvariable und f als lineare Regressionsfunktion. Der Graph von f heißt Regressionsgerade mit dem Anstieg k und

dem y-Achsenabschnitt d.

Um mit der Modellgleichung Y = kx + d + R arbeiten zu können, müssen die

Konstanten k, d und σR2 mit Hilfe der gemessenen Variablenwerte geschätzt werden. Zur Bestimmung von Schätzwerten für die Geradenparameter werden zu jedem xi die Residuen ri = yi − f (xi ) = yi − kxi − d gebildet. Durch Minimierung der

von k und d abhängigen Summe der quadrierten Residuen erhält man die bereits in

Abschnitt 2.3.1 (Formel 2.4) angegebenen Kleinsten Quadrate-Schätzwerte

10

Mit dem Großbuchstaben Y wird nun deutlich gemacht, dass Y eine Zufallsvariable ist. Dagegen unterliegt x keiner Zufallsvariation. Vielmehr hat man sich unter x eine vom Beobachter

kontrollierte Variable (d.h. eine Variable mit vorgegebenen Werten) vorzustellen.

318

5 Schätzen und Testen

k̂ =

sxy

und dˆ = ȳ − k̂x̄

s2x

(5.8a)

für k bzw. d. Hier sind x̄ und ȳ die arithmetischen Mittel der xi - bzw. yi -Werte, s2x

ist die empirische Varianz der xi -Werte und sxy die empirische Kovarianz der beiden

Messreihen. Mit k̂ und dˆ kann man das Zielvariablenmittel µY durch ŷ = k̂x + dˆ in

Abhängigkeit von x schätzen.

Die dritte Modellkonstante σR2 wird durch die mit dem Nenner n − 2 gemittelte

Summe der Quadrate der Residuen ri = yi − k̂xi − dˆ geschätzt, also durch:11

σ̂R2 =

1

n−2

n

∑ ri2 =

i=1

s2y − k̂2 s2x

n−1

n−2

(5.8b)

Die Größe s2y ist die Varianz der yi -Werte. Für eine konkrete Stichprobe mit den

Wertepaaren (xi , yi ) (i = 1, 2, . . . , n) erhält man aus (5.8b) einen Schätzwert für σR2 .

Mit diesem Schätzwert lassen sich die Grenzen eines (1 − α)-Konfidenzintervalls

für den Anstieg k in der Form

uk = k̂ − tn−2,1−α/2 σ̂k̂ , ok = k̂ + tn−2,a−α/2 σ̂k̂ mit σ̂k̂ =

σ̂

√R

sx n − 1

(5.9)

anschreiben. Die Größe tn−2,1−α/2 ist das (1 − α/2)-Quantil der tn−2 -Verteilung.

Die Grenzen uk und ok sind als Realisierungen von zwei Zufallsvariablen Uk bzw.

Ok zu verstehen, die den (unbekannten) Anstieg k der Regressionsgeraden mit der

vorgegebenen Wahrscheinlichkeit 1 − α einschließen.

Mit dem Konfidenzintervalls [uk , ok ] kann man prüfen, ob die Variable Y im Rahmen des betrachteten linearen Modells Y = kx + d + R überhaupt von x abhängt.

Dies ist genau dann der Fall, wenn der Anstieg k der Regressionsgeraden von null

abweicht. Wir entscheiden uns für k 6= 0, wenn das Konfidenzintervall [uk , ok ] die

null nicht einschließt. Wendet man dieses Prüfkriterium an, hat man das Risiko α,

eine falsche Entscheidung zu treffen. Denn das Konfidenzintervall [uk , ok ] kann mit

der Wahrscheinlichkeit α rechts oder links vom wahren Anstieg k liegen.12 Die Abhängigkeitsprüfung sollte ein zentraler Bestandteil einer jeden Regressionsanalyse

sein. Kann man einen Anstieg k = 0 nicht ausschließen, macht es keinen Sinn, die

(nicht vorhandene) Abhängigkeit des Zielvariablenmittels von x durch Angabe der

11

Wegen ∑ ri = ∑ (yi − k̂xi − d) = ∑ yi − k̂ ∑ xi − nd = 0 ist das arithmetische Mittel r̄ = ∑ ri /n

der Residuen null (die Summation erstreckt sich jeweils von 1 bis n). Zur Schätzung von σR2 wird

also die Varianz der Residuen herangezogen. Die Division durch n − 2 sichert eine erwartungstreue

Schätzung der Varianz σR2 .

12 Die Abhängigkeitsprüfung kann auch mit einer Variante des t-Tests durchgeführt werden, die

äquivalent zur Entscheidungsfindung mit dem Konfidenzintervall für den Anstieg k ist. Vergleiche

mit dem t-Test werden in den kommenden Abschnitten behandelt. Man entscheidet

√ sich (mit dem

Irrtumsrisiko α) für k 6= 0, wenn die Testgröße tgn = k̂/σ̂k̂ mit σ̂k̂ = σ̂R /[sx n − 1] größer als

das (1 − α/2)-Quantil tn−2,1−α/2 der tn−2 -Verteilung ist. In der R-Funktion lm() ist dieser Test

standardmäßig lineare Regressionsaufgaben vorgesehen.

5.2 Parameterschätzung bei normalverteilter Grundgesamtheit

319

Geradengleichung ŷ = k̂x + dˆ zu dokumentieren, auch dann nicht, wenn der Schätzwert k̂ von null abweicht.

Beispiel 5.7.

Im Blutplasma wurde die Konzentrationen c (in ng/ml) eines Wirkstoffes in

Abhängigkeit von der Zeit t (in h) bestimmt. Für die Eliminationsphase ergaben

sich die folgenden Messwerte (der Index i läuft von 1 bis 10):

5

6

7

8

9 10 11 12 13 14

ti

ci 8.64 7.47 5.88 5.61 3.90 3.23 2.42 2.64 1.87 2.08

In der rechten Grafik von Abb. 5.7 sind die Datenpunkte (ti , ci ) dargestellt. Die

Grafik legt eine exponentielle Abnahme nach dem Zeitgesetz c = c0 e−βt nahe,

in dem c0 und β zwei positive Konstanten sind. Wir stellen uns die Aufgabe,

für die Konstante β einen Schätzwert und ein 95%iges Konfidenzintervall zu

bestimmen.

Durch Logarithmieren der Funktionsgleichung erhält man die lineare Beziehung y = kt + d mit y = ln c, k = −β und d = ln c0 . Diese stellt in der (t, y)Ebene eine Gerade dar. Wir schätzen den Anstieg dieser Geraden, in dem wir

die Gerade nach der Methode der kleinsten Quadrate an die Datenpunkte (ti , yi )

mit yi = ln ci anpassen. Die rechte Grafik in Abb. 5.7 zeigt das Streudiagramm

der Datenpunkte (ti , yi ) und die angepasste Regressionsgerade. Der Anstieg dieser Geraden kann mit (5.8a) berechnet werden. Die Varianz der Zeitwerte ist

st2 = 9.167, für die Kovarianz der y- und t-Werte erhalten wir syt = −1.624.

Damit ergibt sich der Schätzwert k̂ = syt /st2 = −0.1771 für k.

Das Konfidenzintervall wird mit (5.9) berechnet. Es ist α = 0.05, n = 10 und

tn−2,1−α/2 = t9,0.975 = 2.306. Für die Varianz der Reststreuung ergibt sich aus

(5.8b) der Schätzwert σ̂R2 = 0.01431. Mit σ̂k = 0.01317 folgen schließlich die

Grenzen uk = −0.2075 und ok = −0.1468. Offensichtlich liegt der Wert null

nicht im Intervall [uk , ok ]. Mit dem vorgegebenen Irrtumsrisiko α = 5% kann

daher geschlossen werden, dass der wahre Anstieg der Regressionsgeraden von

null verschieden ist. Wegen β = −k ist β̂ = 0.1771 ein Schätzwert für β und

[uβ , oβ ] mit uβ = 0.1468, oβ = 0.2075 ein 95%iges Konfidenzintervall für β .

>

>

>

+

>

>

>

>

>

>

>

>

# Lö s u n g m i t R :

t <− 5 : 1 4 # Z e i t ( i n h )

c <− c ( 8 . 6 4 , 7 . 4 7 , 5 . 8 8 , 5 . 6 1 , 3 . 9 0 ,

3 . 2 3 , 2 . 4 2 , 2 . 6 4 , 1 . 8 7 , 2 . 0 8 ) # K o n z e n t r a t i o n ( ng / ml )

y <− l o g ( c ) ; l i n r e g <− lm ( y ~ t )

# Sch ä t z w e r t kd u . 95%− K o n f i d e n z i n t e r v a l l [ uk , ok ] f ü r k

kd <− c o e f f i c i e n t s ( l i n r e g ) [ [ 2 ] ]

uk <− c o n f i n t ( l i n r e g ) [ [ 2 , 1 ] ]

ok <− c o n f i n t ( l i n r e g ) [ [ 2 , 2 ] ]

# Sch ä t z w e r t bd u . 95%− K o n f i d e n z i n t . [ ubd , obd ] f ü r b e t a

bd <− −kd ; ubd <− −ok ; obd <− −uk

p r i n t ( c b i n d ( kd , uk , ok , bd , ubd , obd ) , d i g i t s = 4 )

kd

uk

ok

bd

ubd

obd

[ 1 , ] −0.1771 −0.2075 −0.1468 0 . 1 7 7 1 0 . 1 4 6 8 0 . 2 0 7 5

5 Schätzen und Testen

y^ = − 0.1771t + 2.315

1.5

y = ln c

0.0

2

0.5

4

1.0

6

8

2.0

c^ = 10.13e−0.1771t

0

Konzentration c (in ng/ml)

10

2.5

320

6

8

10

Zeit t (in h)

12

14

6

8

10

12

14

Zeit t (in h)

Abb. 5.7 Exponentielle Abnahme der Konzentration eines Pharmakons im Blutplasma nach dem

Zeitgesetz c = c0 e−βt . Die Eliminationskonstante β kann nach logarithmischer Transformation der

Konzentrationswerte im Rahmen einer linearen Regressionanalyse geschätzt werden.

Aufgaben

1. Es sei X eine χ 2f -verteilte Zufallsvariable. Die Dichtekurve der ChiquadratVerteilung zeigt für alle Freiheitsgrade f eine rechtsschiefe Asymmetrie; die

Dichtekurve steigt für f = 3, 4, . . . links steiler an und fällt nach rechts flacher

ab. Eine Folge ist, dass das 75%-Quantil x0.75 vom Median x0.50 weiter entfernt

ist als das 25%-Quantil x0.25 . Man bestätige diese Behauptung für f = 10. Zur

Berechnung des p-Quantils der χ 2f -Verteilung verwende man die R-Funktion

qchisq(p, f).

2. Die Dichtekurve der t-Verteilung besitzt für jeden Freiheitsgrad f = 1, 2, . . .

einen um den Nullpunkt symmetrischen Verlauf. Im Vergleich zur N(0, 1)Dichtekurve ist die Dichtekurve der t-Verteilung „breiter“, so dass der Quartilabstand IQR f = x0.75 − x0.25 (also die Differenz des 75%- und 25%-Quantils)

größer ist als der entsprechende Quartilabstand IQR = z0.75 − z0.25 für eine

N(0, 1)-verteilte Zufallsvariable Z. Man bestätige die Behauptung für den Freiheitsgrad f = 5. Zur Berechnung des p-Quantils der t f -Verteilung verwende

man die R-Funktion qt(p, f) und zur Berechnung des p-Quantils der Standardnormalverteilung die R-Funktion qnorm(p).

3. Zur Sicherung der Produktqualität werden aus einer Fertigung laufend Stichproben entnommen und die zu überwachende Größe X gemessen. In einem Erhebungszeitpunkt ergaben sich die folgenden Werte der als normalverteilt vorausgesetzten Größe X (in mg/l): 2.00, 2.10, 2.02, 1.99, 2.16.

a) Man bestimme ein 95%iges Konfidenzintervall für den Mittelwert µ von X.

Wie groß müsste der Stichprobenumfang sein, damit man eine Schätzung

mit Konfidenzintervall erwarten kann, das nur 1/4 der Länge des ursprünglichen Intervalls aufweist?

5.3 Vergleich eines Mittelwerts mit einem Sollwert

321

b) Welche konkreten Grenzen ergeben sich mit den Stichprobenwerten für ein

95%iges Konfidenzintervalls für die Standardabweichung σ von X. Um wie

viel Prozent ist das 99%ige Konfidenzintervall für σ größer als das 95%ige

Intervall?

4. Nach dem statistischen Jahrbuch 2015 für Österreich ist der Prozentsatz der

täglich rauchenden Personen in der männlichen Bevölkerung (ab 16 Jahren) von

1972 bis 2006 wie folgt gesunken (in Klammern ist jeweils das Erhebungsjahr

angeführt): 38.7 (1972), 35.3 (1979), 34.6 (1986), 30.0 (1997), 27.5 (2006).

Man stelle die Abhängigkeit des Prozentsatzes von der Zeit durch ein lineares

Regressionsmodell dar und bestimme ein 95%iges Konfidenzintervall für den

Anstieg der Regressionsgeraden. (Der Anstieg kann als mittlere Änderung des

Prozentsatzes pro Jahr interpretiert werden.)

5.3 Vergleich eines Mittelwerts mit einem Sollwert

5.3.1 Der 1-Stichproben t-Test für 2-seitige Hypothesen

Von einer als N(µ, σ 2 )-verteilt angenommenen Variablen X liegen n Messwerte

x1 , x2 , . . . , xn mit dem arithmetischen Mittel x̄n und der empirischen Varianz s2n vor.

In diesem Abschnitt wird gezeigt, wie man mit Hilfe der Stichprobe entscheiden

kann, ob der Mittelwert µ von einem vorgegebenen Sollwert µ0 abweicht, also

µ 6= µ0 gilt. Die Aussage, die man nachweisen will, wird als Alternativhypothese in der Form H1 : µ 6= µ0 angeschrieben. Durch logische Verneinung der Alternativhypothese kommt man zur Nullhypothese H0 : µ = µ0 . Eine allfällige Entscheidung für die Alternativhypothese (und damit gegen die Nullhypothese) wird

mit einem statistischen Test herbeigeführt. Der klassische Test für den betrachteten

Mittelwertvergleich mit den Entscheidungsalternativen

H0 : µ = µ0 gegen H1 : µ 6= µ0

(5.10)

ist der 1-Stichproben t-Test. Bei diesem Test wird zur Entscheidung die von der

Zufallsstichprobe abhängige Variable

X̄n − µ0

T Gn = p

Sn2 /n

(5.11)

verwendet, in der X̄n und Sn2 das Stichprobenmittel bzw. die Stichprobenvarianz bedeuten. Die Größe (5.11) wird als Testgröße des 1-Stichproben t-Tests bezeichnet.

Die Testgröße nimmt für die durch die beobachtete Stichprobe realisierten Werte

322

5 Schätzen und Testen

p

x̄n und s2n von X̄n bzw. Sn2 den Wert tgn = (x̄n − µ0 )/ s2n /n an. Wenn H0 : µ = µ0

zutrifft, ist die Testgröße (5.11) tn−1 -verteilt.13

Wir nehmen nun an, dass H0 : µ = µ0 gilt. Dann wird das Stichprobenmittel X̄n

mit hoher Wahrscheinlichkeit einen Wert x̄n nahe bei µ0 annehmen und folglich

T Gn mit hoher Wahrscheinlichkeit nahe bei null liegen; stark von null abweichende

Testgrößenwerte sind dagegen nur mit geringer Wahrscheinlichkeit zu erwarten. Hat

man eine Realisierung tgn der Testgröße, so kann man die Wahrscheinlichkeit P des

Ereignisses berechnen, dass die Testgröße einen Wert annimmt, der zumindest so

stark von null abweicht wie die erhaltene Realisierung tgn . Diese Wahrscheinlichkeit – man bezeichnet sie kurz als P-Wert – ist durch

P = P(T Gn ≤ −|tgn |) + P(T Gn ≥ |tgn |) = 2[1 − Fn−1 (|tgn |)]

(5.12)

gegeben (vgl. Abb. 5.7); hier bezeichnet Fn−1 die Verteilungsfunktion der t-Verteilung mit n − 1 Freiheitsgraden.14 Der P-Wert ist also ein Maß für die Wahrscheinlichkeit, mit einer Zufallsstichprobe vom Umfang n eine Testgröße T Gn mit

|T Gn | ≥ |tgn | zu erhalten. Der P-Wert spielt bei der Testentscheidung eine zentrale

Rolle. Die Vorgangsweise ist dabei dem indirekten Beweis15 der Mathematik nachgebildet: Wir wollen wissen, ob H1 : µ 6= µ0 gilt, und nehmen an, dies ist nicht der

Fall. Wenn also H0 : µ = µ0 gilt, ist es unwahrscheinlich, dass eine der Grundgesamtheit entnommene Zufallsstichprobe zu einem von null „stark“ abweichenden

Testgrößenwert tgn führt. Tritt dieses (unwahrscheinliche) Ereignis aber ein, so interpretieren wir dies als ein Indiz gegen die angenommene Nullhypothese und entscheiden uns für H1 . Zu präzisieren ist noch, was eine von null “stark“ abweichende

Realisierung tgn ist. Es ist naheliegend, dafür den P-Wert (5.12) zu verwenden und

die Abweichung tgn der Testgröße von null dann als stark zu bezeichnen, wenn

der P-Wert eine vereinbarte kleine Schranke α unterschreitet. Wir entscheiden uns

demnach für H1 , wenn P < α ist. Wenn wir nach diesem Kriterium entscheiden, besteht natürlich ein Risiko, H0 irrtümlich abzulehnen. Man bezeichnet die irrtümliche

Ablehnung der Nullhypothese als Fehler erster Art oder α-Fehler. Die Wahrscheinlichkeit, H0 irrtümlich abzulehnen, ist aber nach oben durch α begrenzt. Man nennt

α das Signifikanzniveau oder Testniveau. Meist wird α = 5% angenommen.

Ein zu P < α äquivalentes Kriterium für die Ablehnung von H0 kann man auch

mit der Realisierung tgn der Testgröße formulieren. Wir bestimmen dazu jenen Testgrößenwert cα > 0, der die Forderung P = 2[1 − Fn−1 (cα )] = α erfüllt. Wegen

Fn−1 (cα ) = 1 − α/2 ist cα gleich dem (1 − α/2)-Quantil der tn−1 -Verteilung, d.h.

cα = tn−1,1−α/2 . Die Nullhypothese wird auf dem Signifikanzniveau α abgelehnt,

wenn |tgn | > cα = tn−1,1−α/2 gilt.

13

In diesem Fall stimmt nämlich T Gn mit dem im vorangehenden Abschnitt betrachteten studentisierten Stichprobenmittel X̄n∗ überein.

14 Man beachte, das die t

n−1 -Verteilung eine symmetrisch um null verlaufende Dichtekurve besitzt

und daher P(T Gn ≤ −|tgn |) = P(T Gn ≥ |tgn |) = 1 − Fn−1 (|tgn |) ist. Der Wert der Verteilungsfunktion Fn−1 an der Stelle x = |tgn | kann z.B. mit der R-Funktion pt(x, n-1) bestimmt werden.

15 Beim indirekten Beweis geht man von der Verneinung ¬A der zu beweisenden Aussage A aus.

Kommt man von ¬A durch eine logische Schlusskette zu einer offensichtlich falschen Aussage, so

muss ¬A falsch und die Verneinung von ¬A, also die Aussage A, richtig sein.

5.3 Vergleich eines Mittelwerts mit einem Sollwert

323

Dichte

tn−1

0.2

P(TGn <= −|tgn|)

P(TGn >= |tgn|)

−|tgn|

−3

−2

|tgn|

0.1

−1

0

1

2

TGn

Abb. 5.8 Berechnung des P-Werts beim 2-seitigen 1-Stichproben t-Test. Die Grafik verwendet die

Zufallsstichprobe mit dem Umfang n = 10 aus Beispiel 5.8. Die Größe tgn = 2.45 ist der mit diesen Daten realisierte Wert der Testgröße (5.11). Der P-Wert ist gleich der Wahrscheinlichkeit, dass

T Gn ≥ |tgn | oder T Gn ≤ −|tgn | gilt. Diese Wahrscheinlichkeiten entsprechen der „Überschreitungsfläche“ der Stelle |tgn | bzw. der „Unterschreitungsfläche“ der Stelle −|tgn |. Aus Symmetriegründen sind beide Flächen gleich groß, so dass der P-Wert aus P = 2P(T Gn ≤ −|tgn |) bestimmt

werden kann.

Der Mittelwertvergleich mit den Hypothesen (5.10) heißt 2-seitig, weil die Alternativhypothese H1 : µ = µ0 Abweichungen von dem in der Nullhypothese H0 : µ =

µ0 spezifizierten Sollwert nach beiden Seiten (d.h. Über- oder Unterschreitungen)

vorsieht.

Beispiel 5.8.

Es sei X ein N(µ, σ 2 )-verteiltes Qualitätsmerkmal, z.B. der Außendurchmesser

einer Kanüle in mm. Für µ ist ein Sollwert von µ0 = 1.2 vorgegeben. Zur Überprüfung der Vorgabe wurde aus einem Produktionslos die Zufallsstichprobe16

1.22, 1.41, 1.40, 1.30, 1.11, 1.35, 1.30, 1.22, 1.24, 1.19

entnommen. Wir prüfen mit dem 1-Stichproben t-Test, ob auf 5%igem Signifikanzniveau der Mittelwert µ vom Sollwert µ0 abweicht. Dem entsprechend

formulieren wir die Alternativhypothese H1 : µ 6= µ0 und die Nullhypothese

H0 : µ = µ0 .

Der Stichprobe entnimmt man n = 10, x̄ = 1.274 und s = 0.09571. Damit ergibt sich der Wert tgn = 2.445 der unter der Nullhypothese t9 -verteilten

Testgröße T Gn . Diese Verteilung ist in Abb. 5.7 gemeinsam mit der Realisierung |tgn | = 2.445 und dem am Nullpunkt gespiegelten Wert −|tgn | =

−2.445 dargestellt. Für den P-Wert benötigen wir den Wert der Verteilungsfunktion Fn−1 der tn−1 -Verteilung an der Stelle x = |tgn |. Diesen berechnen

16 Für das Beispiel wurde µ = 1.3 und σ = 0.1 angenommen und die Zufallsstichprobe mit der

R-Funktion rnorm(10, 1.3, 0.1) generiert.

324

5 Schätzen und Testen

wir mit Hilfe der R-Funktion pt(x, n-1) = 0.9815. Daher ist der P-Wert

P = 2[1 − Fn−1 (|tgn |)] = 0.03706. Wegen P ≈ 3.7% < 5% entscheiden wir uns

für H1 , d.h. die Abweichung des beobachteten arithmetischen Mittels x̄ = 1.274

vom Sollwert µ0 = 1.2 ist auf Testniveau α = 5% signifikant.

Einfacher ist es, wenn man die in einschlägigen statistischen Softwareprodukten bereit gestellten Funktionen nutzt. Die folgende Problemlösung zeigt

die Anwendung der R-Funktion t.test(). Die Ergebnisse enthalten nicht

nur den P-Wert (p-value), sondern darüber hinaus auch ein 95%iges Konfidenzintervall für µ, mit dem die Abweichung vom Sollwert beurteilt werden kann.

> # Lö s u n g m i t R :

> x <− c ( 1 . 2 2 , 1 . 4 1 , 1 . 4 0 , 1 . 3 0 , 1 . 1 1 ,

+

1.35 , 1.30 , 1.22 , 1.24 , 1.19)

> t . t e s t ( x , mu = 1 . 2 , c o n f . l e v e l = 0 . 9 5 )

One Sample t − t e s t

data : x

t = 2 . 4 4 5 , d f = 9 , p−v a l u e = 0 . 0 3 7 0 6

a l t e r n a t i v e h y p o t h e s i s : t r u e mean i s n o t e q u a l t o 1 . 2

95 p e r c e n t c o n f i d e n c e i n t e r v a l :

1.205535 1.342465

sample e s t i m a t e s :

mean o f x

1.274

5.3.2 Gütefunktion des 2-seitigen t-Tests

Nach dem vorangehenden Abschnitt wird die Nullhypothese H0 : µ = µ0 abgelehnt,

wenn P = 2P(T Gn < −|tgn |) < α bzw. |tgn | > tn−1,1−α/2 gilt. Wenn man mit einem

dieser Kriterien entscheidet, ist die Wahrscheinlichkeit, H0 irrtümlich abzulehnen,

durch

P(Ablehnung von H0 |µ = µ0 ) = P(T Gn < −tn−1,1−α/2 ) + P(T Gn > tn−1,1−α/2 )

= P(T Gn < tn−1,α/2 ) + 1 − P(T Gn ≤ tn−1,1−α/2 )

= α/2 + 1 − (1 − α/2) = α

(5.13a)

gegeben; dabei wurde verwendet, dass die Testgröße T Gn unter der Nullhypothese tn−1 -verteilt ist. Wenn H0 gilt, führt die Testentscheidung mit der geringen Irrtumswahrscheinlichkeit α zu einer (irrtümlichen) Ablehnung von H0 . Ist dagegen

µ 6= µ0 , so sollte die Testentscheidung mit hoher Wahrscheinlichkeit zu einer Ablehnung von H0 führen. Diese Wahrscheinlichkeit hängt wesentlich davon ab, wie

weit der Mittelwert µ vom Sollwert µ0 abweicht. Die Abhängigkeit von µ wird

durch die Gütefunktion G erfasst. Die Gütefunktion ordnet jedem reellen µ die

Wahrscheinlichkeit

5.3 Vergleich eines Mittelwerts mit einem Sollwert

325

G(µ) = P(Ablehnung von H0 |µ) = P(|T Gn | > tn−1,1−α/2 |µ)

= P(T Gn < −tn−1,1−α/2 |µ) + 1 − P(T Gn < tn−1,1−α/2 |µ)

(5.13b)

zu, mit der eine Zufallsstichprobe vom Umfang n aus der Grundgesamtheit X zu einer Ablehnung von H0 führt. Zur Berechnung der Wahrscheinlichkeiten in (5.13b)

benötigen wird die nichtzentrale t-Verteilung. Im Falle µ 6= µ0 ist nämlich die

Testgröße T G√

n nicht mehr t-verteilt, sondern mit den Parametern f = n − 1 und

λ = (µ − µ0 ) n/σ nichtzentral t-verteilt; f heißt wie bei der t-Verteilung Freiheitsgrad, λ ist der sogenannte Nichtzentralitätsparameter. Die Verteilungsfunktion

der Testgröße T Gn – wir bezeichnen sie mit Ff ,λ – ist in der oberen Grafik von Abb.

5.9 beispielhaft dargestellt; dabei wurde als Freiheitsgrad f = 9 und als Nichtzentralitätsparameter λ = 3.162 angenommen.17 Im Sonderfall λ = 0 fällt die Verteilungsfunktion Ff ,λ der nichtzentralen t-Verteilung mit der Verteilungsfunktion Ff

der t-Verteilung zusammen.

P(TG10 <= x)

1

λ=0

λ = 3.162

0.5

0

−2

−1

0

G*(ε)

1

1

2

x

3

4

5

6

G*(ε0)=0.96

0.5

n=10

n=30

G*(ε0)=0.51

G*(0) = α

0

−2

−1

ε0 = 0.7

0

Effektstärke ε

2

Abb. 5.9 Die obere Grafik zeigt die Verteilungsfunktion der Testgröße T Gn zum 1-Stichproben

t-Test in Beispiel 5.8. Die Testgröße ist nichtzentral t-verteilt mit den Parametern f = 9 und

λ = 3.162. Die strichlierte Linie ist die Verteilungsfunktion der t-Verteilung. In der unteren Grafik

ist die Gütefunktion (5.13d) für die Stichprobenumfänge n = 10 und n = 30 dargestellt. Bei gleichbleibendem n strebt die Gütefunktion vom Wert α an der Stelle ε = 0 mit wachsendem Betrag |ε|

gegen eins. Hält man ε fest, so kann man den Gütefunktionswert vergrößern, wenn man n erhöht.

17

Die Funktionswerte Ff ,λ (x) können mit der R-Funktion pt(x, df, ncp) bestimmt werden,

in der für df und ncp der Freiheitsgrad f bzw. der Nichzentralitätsparameter λ einzusetzen ist.

326

5 Schätzen und Testen

Mit Hilfe der Verteilungsfunktion Ff ,λ der nichtzentralen t-Verteilung kann man

die Wahrscheinlichkeiten P(T Gn < −tn−1,1−α/2 |µ) und P(T Gn < tn−1,1−α/2 |µ) in

(5.13b) durch Fn−1,λ (−tn−1,1−α/2 ) bzw. Fn−1,λ (tn−1,1−α/2 ) ausdrücken. Damit geht

(5.13b) in die Gleichung

G(µ) = Fn−1,λ (−tn−1,1−α/2 ) + 1 − Fn−1,λ (tn−1,1−α/2 ) mit λ =

µ − µ0

√ (5.13c)

σ/ n

über. Setzt man hier µ = µ0 , ergibt sich wegen λ = 0 und Fn−1,0 = Fn−1 die

schon in (5.13a) bestimmte Wahrscheinlichkeit G(µ0 ) = α. Bei der Diskussion

der Gütefunktion wird an Stelle von µ oft die dimensionslose Effektstärke ε verwendet. Diese ist als die auf die Standardabweichung σ bezogenen Abweichung

ε = (µ − µ0 )/σ des Mittelwerts µ vom Sollwert µ0 definiert. Offensichtlich ist

ε = 0, wenn H0 : µ = µ0 gilt, und ε 6= 0, wenn H1 : µ 6= µ0 gilt. Drückt man in

(5.13c) µ durch ε aus, folgt

G∗ (ε) = G(εσ + µ0 )

√

= Fn−1,λ (−tn−1,1−α/2 ) + 1 − Fn−1,λ (tn−1,1−α/2 ) mit λ = ε n

(5.13d)

Die untere Grafik von Abb. 5.9 zeigt, wie die Gütefunktion G∗ von der Effektstärke

ε abhängt. Dabei wurde α = 0.05 angenommen und als Stichprobenumfänge n =

10 bzw. n = 30 gewählt. Man erkennt, dass die Gütefunktion in der Umgebung

des Nullpunktes nur kleine Funktionswerte annimmt und vom Nullpunkt weg mit

wachsendem Abstand monoton gegen eins strebt.

Beispiel 5.9.

Um Werte der Gütefunktion G des 1-Stichproben t-Tests (Hypothesen H0 : µ =

µ0 gegen H1 : µ 6= µ0 , Signifikanzniveau α) mit Formel (5.13d) berechnen zu

können, müssen der Umfang n der Zufallsstichprobe sowie die Standardabweichung σ der als N(µ, σ 2 )-verteilt angenommenen Grundgesamtheit X bekannt

sein. Meist will man den Wert der Gütefunktion an einer Stelle µ = µ0 + δ wissen, die vom Sollwert um eine als relevant angesehene Differenz δ = µ − µ0

abweicht. Dividiert man diese Differenz durch σ , erhält man die Effektstärke

ε = δ /σ .

Z.B. erhält man mit den Daten α = 0.05, µ0 = 1.2, n = 10 aus Beispiel

5.8 und der bekannten Standardabweichung σ = 0.1 zur vorgegebenen relevanten Differenz δ√= 0.07 die Effektstärke ε = 0.7 und den Nichtzentralitätparameter λ = ε n = 2.214. Das (1 − α/2)-Quantil der tn−1 -Verteilung ist

tn−1,1−α/2 = t9,0.975 = 2.262. Setzt man in (5.13d) ein, ergibt sich der in Abb.

5.9 hervorgehobene Gütefunktionswert G(µ0 + δ ) = G∗ (0.7) = 0.5064 ≈ 51%.

Die numerische Berechnung ist der folgenden Lösung mit R zu entnehmen.

Im Allg. ist σ unbekannt und aus der Stichprobe zu schätzen. Mit den Daten

von Beispiel

5.8 erhält man σ ≈ s = 0.09571 und weiter ε ≈ δ /s = 0.7314,

√

λ = ε n = 2.313, G(µ0 + δ ) = G∗ (0.7314) = 0.5414 = 0.54%.

> # Lö s u n g m i t R :

> o p t i o n s ( d i g i t s =4)

5.3 Vergleich eines Mittelwerts mit einem Sollwert

327

>

>

>

>

>

>

>

mu0 <− 1 . 2 ; n <− 1 0 ; a l p h a <− 0 . 0 5 ; d e l t a <− 0 . 0 7

t q <− q t (1− a l p h a / 2 , n −1) # t −Q u a n t i l

# Bestimmung von G( mu0+ d e l t a ) m i t e x a k t e m s i g m a

s i g m a <− 0 . 1

e p s i l o n <− d e l t a / s i g m a ; lambda <− e p s i l o n ∗ s q r t ( n )

G <− p t (− t q , n −1 , lambda )+1− p t ( t q , n −1 , lambda )

p r i n t ( c b i n d ( sigma , e p s i l o n , lambda , G ) )

s i g m a e p s i l o n lambda

G

[1 ,]

0.1

0.7 2.214 0.5064

> # H i n w e i s : G( mu+ d e l t a ) ( = power ) kann d i r e k t m i t

> # power . t . t e s t ( ) b e r e c h n e t werden :

> power . t . t e s t ( n =10 , d e l t a = d e l t a , s d = sigma , s i g . l e v e l = 0 . 0 5 ,

+

t y p e =" one . s a m p l e " , s t r i c t =T )

One−s a m p l e

n

delta

sd

sig . level

power

alternative

t

=

=

=

=

=

=

t e s t power c a l c u l a t i o n

10

0.07

0.1

0.05

0.5064

two . s i d e d

> # Bestimmung von G( mu0+ d e l t a ) m i t g e s c h ä t z t e m s i g m a

> x <− c ( 1 . 2 2 , 1 . 4 1 , 1 . 4 0 , 1 . 3 0 , 1 . 1 1 ,

+

1.35 , 1.30 , 1.22 , 1.24 , 1.19)

> power . t . t e s t ( n =10 , d e l t a = d e l t a , s d = s d ( x ) , s i g . l e v e l = 0 . 0 5 ,

+

t y p e =" one . s a m p l e " , s t r i c t =T )

One−s a m p l e

n

delta

sd

sig . level

power

alternative

t

=

=

=

=

=

=

t e s t power c a l c u l a t i o n

10

0.07

0.09571

0.05

0.5414

two . s i d e d

Bei einer wenig von null abweichenden Effektstärke ε hat man nur eine geringe Wahrscheinlichkeit G∗ (ε) – oder wie man auch sagt, eine geringe Power, die

Nullhypothese H0 : µ = µ0 (d.h. ε = 0) abzulehnen. Kann bei einer von null verschiedenen Effektstärke (also bei einem Mittelwert µ 6= µ0 ) die Nullhypothese nicht

abgelehnt werden, so begeht man einen Fehler. Dieser Fehler wird als Fehler 2. Art

oder β -Fehler bezeichnet.18 Die Wahrscheinlichkeit, beim 2-seitigen Vergleich eines Mittelwerts mit einem Sollwert einen β -Fehler zu begehen, ist 1 − G∗ (ε). Um

die Wahrscheinlichkeit eines β -Fehlers klein zu halten, gibt man für 1 − G∗ (ε) eine

Fehlerschranke vor, die mit β bezeichnet wird. Häufig wird β = 10% verwendet,

β -Werte über 20% sind unüblich.

Die Forderung 1 − G∗ (ε) ≤ β erlaubt es, den Umfang der Zufallsstichprobe in

Verbindung mit dem 1-Stichproben t-Test planen. Das Planungsziel ist: Wenn µ

18 Der β -Fehler besteht darin, dass die Testentscheidung nicht zur Ablehnung von H führt, obwohl

0

H1 gilt. Davon zu unterscheiden ist der α-Fehler, bei dem H0 irrtümlich abgelehnt wird.

328

5 Schätzen und Testen

von µ0 um δ = σ ε > 0 oder mehr abweicht, soll die Wahrscheinlichkeit (Power)

mindestens 1−β betragen, dass der 1-Stichproben t-Test auf dem Niveau α zu einer

Ablehnung der Nullhypothese H0 : µ = µ0 führt. Der zur Erreichung dieses Ziels

erforderliche Mindeststichprobenumfang ergibt sich als Lösung n∗ der Gleichung

1 − G∗ (ε) = β oder ausführlicher

−Fn−1,ε √n (−tn−1,1−α/2 ) + Fn−1,ε √n (tn−1,1−α/2 ) = β

(5.14a)

Die Planung des Mindeststichprobenumfangs n∗ setzt also voraus, das man eine Abweichung δ = µ − µ0 = σ ε > 0 vorgibt, die man als relevant betrachtet und mit der

(hohen) Sicherheit 1 − β erkennen will.19 Die Bestimmung von n∗ aus (5.14a) ist

nur auf numerischen Wege möglich.20 Eine grobe Planung des Mindeststichprobenumfangs kann mit der Näherungsformel

n∗ ≈

σ2

(z

+ z )2

δ 2 1−α/2 1−β

(5.14b)

vorgenommen werden, so ferne n∗ groß genug (jedenfalls nicht kleiner als 10) ist

und ein Schätzwert für σ zur Verfügung steht; δ = µ − µ0 ist die relevante Abweichung des Mittelwerts vom Sollwert, z1−α/2 und z1−β sind Quantile der N(0, 1)Verteilung. Eine Begründung der Näherung (5.14b) findet sich in den Ergänzungen

(Abschnitt 5.7.1).

Beispiel 5.10.

Der erforderliche Mindestumfang n∗ einer Zufallsstichprobe soll so geplant

werden, dass wir eine Sicherheit von 1−β = 90% haben, mit dem 1-Stichproben

t-Test auf 5%igem Signifikanzniveau für H1 : µ 6= µ0 zu entscheiden, wenn µ

von µ0 um mindestens δ > 0 abweicht. Unter dem Untersuchungsmerkmal stelle man sich z.B. die Wirkstoffmenge X (in mg) in einer Filmtablette vor. Für den

Herstellungsprozess ist ein Sollwert von µ0 = 500 vorgegeben. Aus einer Voruntersuchung sei der Schätzwert s = 31.5 für die Standardabweichung der als

normalverteilt angenommenen Grundgesamtheit bekannt. Eine Sollwertabweichung größer oder gleich δ = 25 wird als relevant angesehen.

Wir bestimmen zuerst den Mindeststichprobenumfang mit der Näherungsformel (5.14b). Mit den Quantilen z1−α/2 = z0.975 = 1.96 und z1−β = z0.9 = 1.28

der Standardnormalverteilung erhält man:

n∗ ≈

2

31.52

1.96 + 1.28 = 16.68 ≈ 17

2

25

Die Lösung mit R liefert den exakten Wert n∗ = 18.71 ≈ 19.

19 In der Praxis ist es oft schwierig, Informationen über die relevante Abweichung ε zu finden bzw.

zu erhalten.

20 Z.B. mit der R-Funktion power.t.test(delta, sd, sig.level, power,

type=“one.sample", strict=T), in der für delta die als relevant betrachtete Abweichung δ = µ − µ0 , für sd ein Schätzwert für σ , für sig.level das Signifikanzniveau α und für

power die Sicherheit 1 − β einzusetzen ist.

5.3 Vergleich eines Mittelwerts mit einem Sollwert

329

> # Lö s u n g m i t R :

> o p t i o n s ( d i g i t s =4)

> power . t . t e s t ( d e l t a =25 , s d = 3 1 . 5 , s i g . l e v e l = 0 . 0 5 ,

+

power = 0 . 9 , t y p e =" one . s a m p l e " , s t r i c t =T )

One−s a m p l e

n

delta

sd

sig . level

power

alternative

t

=

=

=

=

=

=

t e s t power c a l c u l a t i o n

18.71

25

31.5

0.05

0.9

two . s i d e d

5.3.3 Der 1-Stichproben t-Test für 1-seitige Hypothesen

Neben den bisher betrachteten Testaufgaben mit 2-seitigen Hypothesen treten in

der Praxis auch 1-seitige Hypothesen auf. Will man wissen, ob der Mittelwert µ

einen vorgegebenen Sollwert µ0 (z.B. einen Grenzwert) überschreitet, setzt man als

Alternativhypothese H1 : µ > µ0 und als Nullhypothese H0 : µ ≤ µ0 an. Man spricht

nun von einem 1-seitigen Testproblem, weil bei Gültigkeit von H1 jedes µ auf der

Zahlengeraden „auf einer Seite“ (der rechten) von µ0 liegt. Wie beim 2-seitigen

Testproblem entscheiden wir uns auf dem Signifikanzniveau α für H1 , wenn der PWert kleiner als α ist. Der P-Wert des 1-seitigen t-Tests auf Überschreitung ist –

wie in den Ergänzungen (Abschnitt 5.7.1) gezeigt wird – durch

P = 1 − Fn−1 (tgn ) mit tgn =

x̄n − µ0

√

sn / n

(5.15a)

gegeben. Die Größen x̄n und sn sind das arithmetische Mittel bzw. die Standardabweichung der dem Test zugrunde liegenden Zufallsstichprobe mit dem Umfang n.

Fn−1 ist die Verteilungsfunktion der tn−1 -Verteilung. Den Wert der Gütefunktion an

der Stelle µ berechnet man wieder mit Hilfe der Verteilungsfunktion der nichtzentralen t-Verteilung analog zu (5.13c) aus:

G(µ) = 1 − Fn−1,λ (tn−1,1−α ) mit λ =

µ − µ0

√

σ/ n

(5.15b)

Gibt man in (5.15b) G(µ) = 1 − β vor, kann man den Mindeststichprobenumfang

n∗ in Abhängigkeit von δ = µ − µ0 > 0, σ und α ausrechnen. Durch n∗ wird sicher

gestellt, dass man bei einer Überschreitung des Sollwertes um δ eine Sicherheit

von 1 − β hat, mit dem auf dem Niveau α geführten Test H0 abzulehnen. Einen

Richtwert für n∗ erhält man mit der zu (5.14b) analoge Näherungsformel

n∗ ≈

σ2

(z1−α + z1−β )2

δ2

(5.15c)

330

5 Schätzen und Testen

Liegt ein 1-seitiges Testproblem mit der Alternativhypothese H1 : µ < µ0 und der

Nullhypothese H0 : µ ≥ µ0 vor, wendet man zur Entscheidungsfindung den 1Stichproben t-Test auf Unterschreitung an. Der P-Wert und die Gütefunktion sind

in diesem Fall:

x̄n − µ0

√ bzw.

sn / n

µ − µ0

√

G(µ) = Fn−1,λ (−tn−1,1−α ) mit λ =

σ/ n

P = Fn−1 (−tgn ) mit tgn =

(5.16a)

(5.16b)

Für eine Abschätzung des Mindeststichprobenumfangs kann wieder (5.15c) verwendet werden.