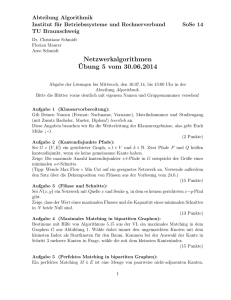

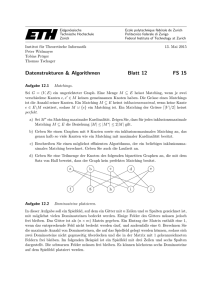

- Lehrstuhl für Effiziente Algorithmen

Werbung