Dynamic Causal Modelling - Fachbereich Mathematik und Informatik

Werbung

Dynamic Causal Modelling

Laura Bücker

7. Juni 2013

Prof. Dr. Mario Ohlberger

Bachelorseminar „Biomedizinische Modellierung und Modellreduktion“

SoSe 2013

Fachbereich Mathematik und Informatik

Institut für Numerische und Angewandte Mathematik

Universität Münster

1

Inhaltsverzeichnis

1 Einleitung

1.1 Medizinische Grundlagen . . . . . . . . . . . . . . . . . . . . . .

1.2 Statistische Grundlagen: Die Bayes’sche Invertierung . . . . . . .

1.2.1 Einführendes Beispiel: Münzwurf . . . . . . . . . . . . . .

3

3

3

4

2 Theorie

2.1 Dynamic causal models . . . . . . . . . . . . . . . . .

2.1.1 Neuronale Zustandsgleichungen . . . . . . . . .

2.1.2 Hämodynamische Zustandsgleichungen . . . . .

2.2 Schätzung der Parameter . . . . . . . . . . . . . . . .

2.2.1 Erwartungswert . . . . . . . . . . . . . . . . . .

2.2.2 Varianz . . . . . . . . . . . . . . . . . . . . . .

2.2.3 EM-Algorithmus . . . . . . . . . . . . . . . . .

2.3 A-priori-Verteilungen . . . . . . . . . . . . . . . . . . .

2.3.1 A-priori-Verteilung der Verschaltungsparameter

2.3.2 Hämodynamische A-priori-Verteilung . . . . . .

2.4 Schätzung . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

5

6

6

7

7

11

12

13

14

15

17

20

3 Validierung des EM-Algorithmus

3.1 Künstliche EEG-Daten . . . . . . . . . . . .

3.1.1 Vorwärts-laterale Vernetzung . . . .

3.1.2 Verkettete Vernetzung . . . . . . . .

3.1.3 Volle Konnektivität . . . . . . . . .

3.2 Reale EEG-Daten . . . . . . . . . . . . . .

3.2.1 Hypothese . . . . . . . . . . . . . . .

3.2.2 Vollständige CS + Block-Analyse . .

3.2.3 Ausschnittweise CS + Block-Analyse

3.2.4 Experimentelle Diskussion . . . . . .

3.2.5 Mathematische Diskussion . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

20

20

21

22

23

23

24

24

27

27

29

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Anhang

30

Tabellenverzeichnis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

Abbildungsverzeichnis . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

Literatur . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

2

1

Einleitung

Dynamic causal modelling, kurz DCM, ist ein Versuch, die Interaktionen zwischen mehreren Regionen des Gehirns mathematisch zu modellieren. Ziel ist das

Aufstellen eines realistischen neuronalen Modells der interagierenden Gehirnregionen. Es wird versucht, Rückschlüsse auf die Verschaltung zwischen Hirnarealen zu ziehen und zu verstehen, wie diese Verschaltung durch Veränderungen

der neuronalen Aktivität beeinflusst wird.

Grundlage dieser Modellierung sind Experimente, in denen man künstlich Störungen der neuronalen Dynamik erzeugt. Aus den gesammelten Daten über die

Neuronenaktivität in einzelnen Gehirnregionen entspringt ein inverses Problem,

das man mit Hilfe der Bayes’schen Invertierung zu lösen versucht. Hierzu wird

zunächst ein unterstützendes Modell benötigt, das die neuronale Aktivität in

messbare Ergebnisse umwandelt. Anschließend schätzt man mittels eines Algorithmus, der auf Erwartungsmaximierung basiert, die Parameterverteilung.

Das Ziel dieser Arbeit ist eine zusammenfassende Darstellung der Funktionsweise und des mathematischen Grundgerüsts von DCM.

Die Ausarbeitung beruht hauptsächlich auf [5], sowie auf [6] und [4].

1.1

Medizinische Grundlagen

In den Experimenten, die dem DCM zugrunde liegen, benutzt man zur Datenakquise die funktionelle Magnetresonanztomographie, abgekürzt fMRT.

Dieses Verfahren stellt Veränderungen des Blutflusses im Gehirn bildlich dar,

indem es sich die verschiedenen magnetischen Eigenschaften von Blut mit hohem und niedrigem Sauerstoffgehalt zunutze macht.

Dieses von Seiji Ogawa entdeckte Phänomen nennt man BOLD-Effekt (Blood

Oxygen Level Dependency). Hier nutzt man aus, dass sauerstoffreiches Blut

weniger starke magnetische Eigenschaften hat als sauerstoffarmes. Grund dafür

ist das an das Hämoglobin gebundene Eisen, welches für den Sauerstofftransport oxygenisiert wird. So entsteht das Molekül Oxyhämoglobin, in welchem

die magnetische Eigenschaft des Eisens weitgehend unterdrückt wird. Wird der

Sauerstoff abgegeben, so entsteht aus dem Oxyhämoglobin Desoxyhämoglobin,

dessen Eisenatome ihre volle magnetische Eigenschaft besitzen.

Neuronale Aktivität in einer Region des Gehirns regt den Blutfluss an, es wird

mehr Sauerstoff angeliefert als durch die neuronale Aktivität abgebaut werden

kann. Der Anteil von oxygenisiertem, sauerstoffreichem Hämoglobin steigt also

gegenüber dem desoxygenisierten, sauerstoffarmen Hämoglobin und das Magnetfeld wird verändert. Indem man dieses sogenannte BOLD-Signal von zwei

unterschiedlichen Zeitpunkten vergleicht, ist es möglich, Rückschlüsse auf den

Ort einer neuronalen Aktivität zu ziehen.

Eine detailliertere Beschreibung der physikalischen Hintergründe liefert [15].

1.2

Statistische Grundlagen: Die Bayes’sche Invertierung

Um die Vernetzung der einzelnen Gehirnregionen besser verstehen zu können,

wird auf das Konzept der Bayes’schen Invertierung zurückgegriffen. Die

Grundidee dahinter ist, dass bereits vor der Analyse der vorliegenden Daten

Informationen über diese vorliegen, die so genannten A-priori-Informationen.

Kombiniert man diese A-priori-Informationen mit den Daten, so erlangt man ein

3

verbessertes Verständnis der Zusammenhänge. Dies wird auch als A-posterioriInformation bezeichnet.

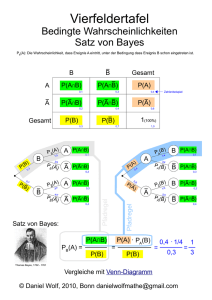

Die Grundlage der Bayes’schen Invertierung ist

Satz 1 (Die Formel von Bayes (aus [1])). Sei A ⊂ Ω ein Ereignis und B1 , B2 , . . . , Bk

eine Zerlegung der Ergebnismenge Ω mit P (Bi ) > 0 für i = 1, . . . , k. Dann gilt

P (A|Bj )P (Bj )

.

P (Bj |A) = Pk

i=1 P (A|Bi )P (Bi )

(1)

Eine analoge Formel gibt es für stetige Zufallsvariablen, ebenfalls aus [1].

Satz 2. Die gemeinsame Dichtefunktion der Zufallsvariablen X und Y sei

f (x, y). Dann gilt

f (x|y)f (y)

.

(2)

f (y|x) = R ∞

f (x|y)f (y)dy

−∞

Dieses Theorem lässt sich auch in dem Fall benutzen, dass eine Zufallsvariable stetig und die andere diskret ist. Dann lautet die Formel wie folgt

P ({X = x}|yf (y)

.

P ({X = x}|y)f (y)dy

−∞

f (y|X = x) = R ∞

(3)

Zum besseren Verständnis dieser Formeln und ihrer Anwendung in der Bayes’schen

Invertierung sein nun ein einfaches Beispiel aus [1] gegeben.

1.2.1

Einführendes Beispiel: Münzwurf

Problemstellung: Wie schätzt man für eine Münze die Wahrscheinlichkeit, mit

der nach einem Wurf Kopf zu sehen ist?

Dazu betrachtet man das folgende Experiment: Eine Münze wird dreimal geworfen. Hierbei bezeichnet die Zufallsvariable X die Anzahl der Würfe, bei denen

Kopf zu sehen ist. Da die drei Würfe unabhängig voneinander sind, ist die Wahrscheinlichkeitsfunktion von X bei gegebenem π = P ({„Kopf “})

( 3

x

3−x

für x = 0, 1, 2, 3

x π (1 − π)

P (x|π) =

(4)

0

sonst.

Man nehme nun an, dass das Ergebnis X = 2 beobachtet wurde. Im Bayes’schen

Verfahren fasst man π als eine Konstante auf, die aber nicht bekannt ist. Vor der

Durchführung des Experiments hat man eine subjektive Vorstellung davon, wie

der Wert von π aussehen könnte. Dies lässt sich als A-priori-Dichtefunktion

darstellen (siehe Abbildung 1, links).

Hier wird π als Zufallsvariable betrachtet. Zusätzlich ist bekannt, dass X für

ein gegebenes π binomialverteilt ist, d.h.

P ({X = 2}|π) = 32 π 2 (1 − π)3−2 .

(5)

Nun wendet man die Formel von Bayes an, um die A-priori-Vorstellung von der

Verteilung von π zu verbessern. In diesem Fall ist die Zufallsvariable X diskret,

während π stetig ist. Sei nun f (π) die Dichtefunktion der A-priori-Verteilung von

4

Abbildung 1: A-priori-Verteilung und A-posteriori-Verteilung von π aus [1].

π. Aus Formel (3) folgt nun, dass die bedingte Dichtefunktion von π, gegeben

X = 2, so aussieht

f (π|X = 2) = R 1

0

P ({X = 2}|π)f (π)

.

(6)

P ({X = 2}|π)f (π)dπ

Diese Funktion wird als A-posteriori-Verteilung von π bezeichnet. Sie enthält

also das korrigierte Wissen über die Verteilung von π nach der Durchführung

des Experiments. In Abbildung 1 ist der Zusammenhang zwischen A-priori- und

A-posteriori-Verteilung aufgeführt. Es wird deutlich, wie die anfängliche Vorstellung über die Parameterverteilung mit Hilfe des Modells (Binomialverteilung)

und der Beobachtungen zu einer genaueren A-posteriori-Vorstellung präzisiert

wird.

Aus diesem einfachen Beispiel lassen sich sofort zwei Ausgangsfragen für die

Bayes’sche Invertierung ableiten:

1. Wie kann die A-priori-Verteilung bestimmt werden?

2. Wie lässt sich die A-posteriori-Verteilung berechnen?

Diese beiden Fragen sollen im folgenden Abschnitt für das komplexere Modell

der Verschaltung des Gehirns beantwortet werden.

2

Theorie

DCM ist ein Verfahren zur Bestimmung eines nichtlinearen Systems, das mit

Hilfe von Bayes’scher Invertierung die Parameter von deterministischen dynamischen Systemen bestimmt. Bei diesen Systemen handelt es sich um InputState-Output-Systeme. Hier betrachten wir lediglich eine bilineare Approximation dieses analytischen Systems. Die Grundidee von DCM ist jedoch nicht auf

bilineare Ansätze beschränkt.

5

2.1

Dynamic causal models

Das DCM, das hier beschrieben wird, ist ein System, das durch m Inputs und

l Outputs mit je einem Output pro Gehirnregion beschrieben wird.

Die Inputs beschreiben Reize, die durch Experimente hervorgerufenen werden.

Dabei unterscheidet man zwei Arten von Inputs: Den direkten Input, der den

neuronalen Zustand selbst verändert, und den latenten Input, der die Vernetzung zwischen Gehirnregionen beeinflusst. Theoretisch hat jeder Input Auswirkungen auf sämtliche Regionen. In der Praxis beschränken sich die von außen

wirkenden Einflüsse jedoch meist auf eine einzige Region.

In jeder der l Regionen wird ein Output gemessen, der dem beobachteten

BOLD-Signal entspricht. Normalerweise werden diese l Zeitreihen als durchschnittliche oder typische Werte in der betrachteten Region gewählt.

Jede Gehirnregion wird durch fünf Zustandsvariablen beschrieben. Vier dieser Variablen entsprechen denen des hämodynamischen Modells, also des Modells, welches den Blutfluss beschreibt. Mit seiner Hilfe wird das BOLD-Signal

erzeugt. Sie sind nicht abhängig vom Zustand anderer Gehirnregionen. Hierbei

handelt es sich um ein Signal, das die Erweiterung der Blutgefäße beschreibt, sowie den normierten Blutfluss, das normierte Venenvolumen und den normierten

Desoxyhämoglobingehalt des Blutes. Die fünfte Zustandsgröße ist die neuronale

oder synaptische Aktivität in der betrachteten Gehirnregion. Sie wird auch von

den neuronalen Zuständen in anderen Regionen beeinflusst.

2.1.1

Neuronale Zustandsgleichungen

Seinen z = (z1 , . . . , zl )t ∈ Rl die neuronalen Zustände in den l betrachteten

Gehirnregionen. Die effektive Konnektivität der Regionen sei beschrieben durch

ż = F (z, u, θ)

(7)

Hierbei ist F eine beliebige nichtlineare Funktion, die die neurophysiologischen

Auswirkungen der neuronalen Aktivität z und der Inputs u = (u1 , . . . , um )t ∈

Rm auf die anderen Regionen beschreibt. θ enthält die Parameter des Modells.

Die Gleichung F muss nicht näher bestimmt werden, da sie wie in [5] durch ihre

Taylorentwicklung bilinear approximiert werden kann.

ż ≈ Az+

m

X

uj B j z + Cu = (A +

j=1

m

X

uj B j )z + Cu

j=1

∂ ż

∂F

=

∈ Rl×l

mit A =

∂z

∂z

∂2F

∂ ∂ ż

Bj =

=

∈ Rl×l , j = 1, . . . , m

∂z∂uj

∂uj ∂z

∂F

C=

∈ Rl×m

∂u

(8)

Die Matrix A, auch Konnektivitätsmatrix genannt, beschreibt die Verschaltung

erster Ordnung zwischen den Gehirnregionen, also ihren Zustand, bevor die

Konnektivität gegebenenfalls durch einen Input verändert wird. Die effektive

Konnektivität ist der Einfluss, den ein neuronales System auf ein anderes ausübt,

∂ ż

indem es Reaktionen ∂z

hervorruft. Diese Reaktion beschreibt die Änderung der

6

neuronalen Aktivität mit der Zeit ż.

Die Matrizen B j beschreiben die Veränderung der Konnektivität durch den jten Input uj , anschaulich formuliert also die Anpassung der Konnektivität durch

die experimentelle Manipulation des Gehirns.

Die Matrix C beschreibt die direkten Einflüsse der Inputs auf die neuronale

Aktivität.

Um die Interaktionen zwischen den Gehirnarealen zu verstehen, müssen also

diese Konnektivitätsmatrizen θc = {A, B j , C} bestimmt werden. Ein Beispiel

hierzu befindet sich in Abbildung 2 auf Seite 8.

2.1.2

Hämodynamische Zustandsgleichungen

Die verbleibenden vier Zustandsvariablen jeder Region sind biophysikalische

Größen, durch die die neuronale Aktivität in hämodynamische Reaktionen übersetzt und das BOLD-Signal erzeugt wird. Die hämodynamischen Gleichungen

hängen nur vom neuronalen Zustand der betrachteten Region ab. Sie erzeugen

ein Modell des Blutflusses, welches auf dem Balloon-Windkesselmodell basiert

(siehe [2], [7] und [11]).

s˙i = zi − κi si − γi (fi − 1)

f˙i = si

1

(9)

τi ν˙i = fi − νiα

1

α

τi q˙i =

fi E(fi , ρi ) νi qi

−

ρi

νi

Die neuronale Aktivität zi verändert das Signal si , welches die Gefäßerweiterung beschreibt. Der Zufluss fi ändert sich proportional zu diesem Signal si ,

damit einhergehend sind Veränderungen des Blutvolumens νi und des Desoxyhämoglobingehalts qi . Der Abfluss des Blutes steht in direktem Zusammen1

hang mit seinem Volumen: fout (ν) = ν α , wobei α den Grubbs-Exponenten

bezeichnet. Die Sauerstoffgewinnung ist eine vom Blutfluss abhängige Funktion

1

E(f, ρ) = 1 − (1 − ρ) f . Die biophysikalischen Parameter θh = {κ, γ, τ, α, ρ} sind

in Tabelle 1 aus [5] aufgeführt.

Das BOLD-Signal yi der i-ten Region wird in [5] beschrieben durch eine nichtlineare Funktion g, die abhängig ist vom Volumen νi und dem Desoxyhämoglobingehalt qi .

qi

yi = g(qi , νi ) = V0 k1 (1 − qi ) + k2 (1 − ) + k3 (1 − νi )

νi

(10)

mit k1 = 7ρi , k2 = 2, k3 = 2ρi − 0.2

Die Konstante V0 = 0, 02 bezeichnet hier den Anteil des verbleibenden Blutvolumens. Das hämodynamische Modell ist schematisch in Abbildung 3 auf Seite

9 dargestellt.

2.2

Schätzung der Parameter

Im DCM benutzt man einen statistischen Ansatz, um die Parameter des Modells zu bestimmen. Ziel ist es, die Verteilung der Parameter möglichst gut zu

7

Abbildung 2: Das obere Schema verdeutlicht die Architektur einer Verschaltung

von fünf Gehirnregionen mit Hilfe der bilinearen Approximation. Die gewöhnlichen Differentialgleichungen in den Regionen beschreiben die Änderungen der

neuronalen Aktivität zi durch Einflüsse aus anderen Gehirnregionen. Der direkte

Input u1 beeinflusst Region 1 unmittelbar. Input u2 dagegen verändert die intrinsischen Verschaltungsparameter aij proportional zu den bilinearen Verschaltungsparametern bij . In diesem Diagramm veranschaulicht die hämodynamische

Komponente des DCMs wie die neuronalen Zustände das region-spezifische hämodynamische Modell durchlaufen und letztlich die Outputs yi erzeugen. Diese

werden durch eine Funktion beschrieben, die von den biophysikalischen Zuständen einer Region (νi Venenvolumen und qi dHb-Gehalt) abhängt. Der untere

Teil der Grafik bringt die Differentialgleichungen des oberen Schemas in Matrixform. Die Grafik stammt aus [5].

8

Abbildung 3: Dieses Schema zeigt die Architektur des hämodynamischen Modells für eine einzelne Region. Die neuronale Aktivität ruft ein gefäßerweiterndes

und aktivitätsabhängiges Signal s hervor, welches dann wiederum den Blutfluss

f erhöht. Dieser verändert das Venenvolumen ν und den Desoxyhämoglobingehalt q. Diese beiden hämodynamischen Zustände erzeugen dann das BOLDSignal y. Siehe dazu [5].

9

Parameter

κ

γ

τ

α

ρ

Beschreibung

Signalzerfallsrate

Flussabhängige Eliminationsrate

Durchflusszeit des Blutes

Grubbs-Exponent

Residuale Sauerstoffkonzentration

EW ηθ

0,65 pro s

0,41 pro s

0,98 s

0,32

0,34

Varianz Cθ

0,015

0,002

0,0568

0,0015

0,0024

Tabelle 1: Biophysikalische Parameter des hämodynamischen Systems

berechnen. Sei dazu x = {z, s, f, ν, q} die Menge der neuronalen und hämodynamischen Zustandsvariablen. Durch die neuronalen Zustandsgleichungen (8)

und die hämodynamischen Gleichungen (9) und (10) erhält man das folgende

Gesamtmodell

ẋ = f (x, u, θ)

y = H(x)

(11)

mit den Parametern θ = {θc , θh }. H ist eine Funktion, die für den Input x den

Output y generiert. Für jede beliebige Parametermenge und beliebige Inputs

kann diese Zustandsgleichung (11) in die nichtlineare Gleichung (10) integriert

werden, die den Output y generiert. So erhält man eine prognostizierte Reaktion

h(u, θ).

Um die neuronale Aktivität in einer Region i zu bestimmen, müssen lediglich

die Aktivitäten aller mit ihr vernetzten Regionen in einer kurzen Zeitspanne

zuvor bekannt sein. Dazu parametrisiert man das System mit Hilfe der Volterraentwicklung um: Der prognostizierte Output hi (u, θ) in Region i = 1, ..., l

lässt sich wie in [5] durch eine Volterrareihe als nichtlineare Faltung der Inputs

ui (t) ausdrücken.

hi (u, θ)

Z t

∞ Z t

X

κki (σ1 , ..., σk )u(t − σ1 ) · · · u(t − σk )dσ1 · · · dσk

=

···

0

0

k=1 |

{z }

(12)

k−mal

mit κki (σ1 , ..., σk ) =

∂ k yi (t)

∂u(t − σ1 ) · · · ∂u(t − σk )

u(t − σ) beschreibt hier die Inputs in der jüngsten Vergangenheit. Die sogenannten Volterrakerne κki können entweder durch numerische Differentation oder

analytisch durch bilineare Approximation bestimmt werden.

Dieses Modell kann in ein auf Beobachtungen basierendes Modell umgewandelt

werden, indem man Fehler- und Störeffekte X(t) hinzufügt. Dadurch erhält man

die Gleichung

y = h(u, θ) + Xβ + ε.

(13)

Hier bezeichnet β die unbekannten Koeffizienten der Störung und ε den Fehler.

Durch eine Taylorentwicklung erster Ordnung von h (siehe [5]) erhält man eine

10

lineare Approximation des Fehlers y − h(u, ηθ|y ).

y − h u, ηθ|y ≈ J∆θ + Xβ + ε = J

∂h u, ηθ|y

mit ∆θ = θ − ηθ|y , J =

∂θ

∆θ

X

+ε

β

(14)

Nimmt man an, dass p(θ|y) annähernd normalverteilt ist, so reduziert sich das

Problem auf das Finden des bedingten Erwartungswerts ηθ|y und der bedingten

Kovarianz Cθ|y , da durch sie die Verteilung der Parameter eindeutig festgelegt

wird.

2.2.1

Erwartungswert

Dieser Abschnitt lehnt sich an die Herleitung aus [4] an.

Definition 3. p(θ) heißt A-priori-Wahrscheinlichkeitsverteilung. Sie beschreibt die Verteilung der Parameter θ, ohne dass weitere Informationen über

den Output y gegeben sind.

p(θ|y) heißt bedingte oder A-posteriori-Wahrscheinlichkeitsverteilung. Sie

bezeichnet die Verteilung der Parameter θ bei gegebenem bekanntem Output y.

Die Datenanalyse stützt sich auf die Formel von Bayes

p(θ|y) =

p(θ)p(y|θ)

.

p(y)

(15)

Die A-posteriori-Wahrscheinlichkeitsverteilung kann durch die Formel von Bayes

wie in [4] vereinfacht dargestellt werden, indem man berücksichtigt, dass p(y)

lediglich normiert.

p(θ|y) ∼ p(y|θ)p(θ)

(16)

Die Wahrscheinlichkeitsverteilungen p(y|θ) und p(θ) können approximativ bestimmt werden, wenn

der Output

y wie in Gleichung (14) ausgedrückt wird,

d.h. y ≈ h u, ηθ|y + J θ − ηθ|y .

(i)

(i)

Seien dazu ηθ|y und Cθ|y die approximierten Werte des A-posteriori-Erwartungswerts

(i)

und der A-posteriori-Kovarianz nach dem i-ten Iterationsschritt. Sei y −h ηθ|y

(i)

so, dass der Fehler Xβ + ε ≈ y − h ηθ|y − J θ − ηθ|y ist. Bezeichne r =

(i)

y − h ηθ|y den Fehler und Cε die Fehlerkovarianz. Wenn p(y|θ) und p(θ) normalverteilt sind, so gilt wie in [4]

t

1

(i)

(i)

−1

p(y|θ) ∼ exp −

r − J(θ − ηθ|y ) Cε r − J(θ − ηθ|y )

2

1

t −1

p(θ) ∼ exp − (θ − ηθ ) Cθ (θ − ηθ ) .

2

(17)

Unter der Annahme, dass auch die A-posteriori-Wahrscheinlichkeitsverteilung

näherungsweise normalverteilt ist, kann Gleichung (16) durch Gleichung (17)

11

ausgedrückt werden (siehe [4]).

t

1

(i+1)

(i+1)

−1

p(θ|y) ∼ exp −

θ − ηθ|y

Cθ|y

θ − ηθ|y

2

−1

mit Cθ|y = J t Cε−1 J + Cθ−1

,

(i+1)

(i)

(i)

ηθ|y = ηθ|y + Cθ|y J t Cε−1 r + Cθ−1 ηθ − ηθ|y

(18)

Um die spätere Implementierung in einem Algorithmus zu vereinfachen, schreibt

man Gleichung (18) in einer kompakteren Form (siehe [4]):

¯ −1

Cθ|y = (J¯t C̄ε−1 J)

!

(i)

∆ηθ|y

= Cθ|y (J¯t C̄ε−1 ȳ)

ηβ|y

!

(i)

y − h(ηθ|y )

¯= J

mit ȳ =

,

J

(i)

I

ηθ − ηθ|y

(19)

X

, C̄ε =

0

Cε

0

0

Cθ

Als Anfangswert für diesen A-posteriori-Erwartungswert wählt man typischerweise den A-priori-Erwartungswert ηθ und es wird angenommen, dass die Kovarianz gleichverteilt ist. Die Gültigkeit dieser Aussage hängt von der Konvergenzgeschwindigkeit der Taylorentwicklung von h in Gleichung (14) ab. Da h nichtlinear ist, wird die Wahrscheinlichkeitsverteilung nur näherungsweise gleichverteilt sein. Allerdings wird die A-posteriori-Wahrscheinlichkeitsverteilung für ausreichend viele Iterationsschritte weitestgehend gleichverteilt sein.

2.2.2

Varianz

Dieser Abschnitt lehnt sich an [6] an. Bisher wurde angenommen, dass die Fehlerkovarianz Cε bekannt ist. In der Praxis ist dies allerdings häufig nicht der

Fall. Wenn die Fehlerkovarianz unbekannt ist, kann sie mittels Taylorentwicklung durch Hyperparameter λj ∈ R näherungsweise bestimmt werden. Diese

Hyperparameter λ sind Parameter, die wiederum die Parameter θ kontrollieren.

Cε ≈

X

λj Qj

mit Qj =

j

∂Cε

∂λj

(20)

Die Hyperparameter λj kann man zusammenfassen zu einem Hyperparametervektor λ ∈ Rl . Die Kovarianzmatrix wird entsprechend daran angepasst.

P

0

Cε 0

j λj Qj

C̄ε =

=

(21)

0 Cθ

0

Cθ

Nun müssen die Hyperparameter bestimmt werden. Die Maximierung der Wahrscheinlickeit p(y|λ) ist äquivalent zur Maximierung der Log-Likelihood-Funktion

Z

ln p(y|λ) = ln p(θ, y|λ)dθ

Z

Z

(22)

≥ q(θ) ln p(θ, y|λ)dθ − q(θ) ln q(θ)dθ =: F (q, λ)

12

Hier bezeichnet q(θ) eine beliebige Verteilung der Parameter. F entspricht der

negativen freien Energie in der statistischen Thermodynamik und umfasst zwei

Terme, die sich auf die Energie (erster Term) und die Entropie (zweiter Term)

beziehen. Gleichung (22) basiert auf der Jensen’schen Ungleichung, die aus der

Konkavität der Log-Funktion folgert, dass der Logarithmus eines Integrals größer als das Integral über den Logarithmus ist.

Nun werden die Parameter benötigt, die den ersten Term von F in Gleichung

(22) maximieren. Dazu benutzt man einen Fischer-Scoring-Algorithmus, ein

numerisches Verfahren zur Lösung von Maximum-Likelihood-Gleichungen.

λ(i+1) =λ(i) − H −1 g

1

1

∂F

= − tr (P Qk ) + rT P T Qk P r,

mit gk =

(i)

2

2

∂λk

Hkj = h

P =

2.2.3

∂2F

∂ λ(i)

Cε−1

2 ikj =

1

tr (P Qk P Qj ) ,

2

(23)

−1 T −1

− Cε−1 JCθ|y

J Cε

EM-Algorithmus

Die lokale lineare Approximation aus Gleichung (14) durchläuft nun ein iteratives Verfahren, den sogenannten EM-Algorithmus (EM=expectation maximization). Ziel ist es, die Parameter zu finden, die die Log-Likelihood-Funktion in

(22) maximieren.

Im ersten Schritt des Algorithmus, dem E-Schritt (Expectation) wird die bedingte Erwartung ηθ|y der Parameter geschätzt, während der Hyperparametervektor

λ fix bleibt. Im M-Schritt (Maximization) werden dann die Hyperparameter λ

optimiert, während ηθ|y unverändert bleibt.

E − Schritt : q(θ) ← max F q(θ), λ

q

M − Schritt : λ ← max F q(θ), λ

λ

Das Maximum im E-Schritt wird genau dann angenommen, wenn q(θ) = p(θ|y, λ)

gilt, also dann, wenn aus der Ungleichung (22) eine Gleichung wird. Der MSchritt bestimmt den Maximum-Likelihood-Schätzer der Hyperparameter λ für

die Fehlerkovarianz.

Insgesamt erhält man durch eine Kombination aus E- und M-Schritt den fol-

13

genden Algorithmus (siehe [5]).

E-Schritt

∂h(ηθ|y )

∂θ

y − h(ηθ|y )

J X

¯

ȳ =

,J =

ηθ − ηθ|y

1 0

P

0

i λi Qi

C̄ε =

0

Cθ

∆ηθ|y

t −1 ¯ −1

¯

Cθ|y = (J C̄ε J) ,

= Cθ|y (J¯t C̄ε−1 ȳ)

ηβ|y

J=

ηθ|y ← ηθ|y + ∆ηθ|y

(24)

M-Schritt

¯ θ|y J¯t C̄ −1

P = C̄ε−1 − C̄ε−1 JC

ε

1 t t

1

∂F

= tr(P Qi ) + ȳ P Qi P ȳ

∂λi

2

2

∂2F

1

h 2 i = − tr(P Qi P Qj )

∂λij

2

λ←λ−h

∂ 2 F −1 ∂F

i

∂λ2

∂λ

Der Anfangswert der Parameter θ ist der A-priori-Erwartungswert, die Hyperparameter λ werden so klein gewählt, dass es wahrscheinlich ist, dass J¯T C̄ε−1 J¯

positiv ist.

(0)

ηθ|y = ηθ

λ(0) = λ0

(25)

Als Konvergenzkriterium schlägt [4] vor, dass die Summe der quadrierten Änderungen von ηθ|y kleiner als 10−6 werden soll.

2.3

A-priori-Verteilungen

Um die A-posteriori-Verteilung zu bestimmen, muss zunächst eine A-prioriVerteilung der Parameter aufgestellt werden. Dazu muss der A-priori-Erwartungswert ηθ und die A-priori-Kovarianz Cθ näher spezifiziert werden.

14

2.3.1

A-priori-Verteilung der Verschaltungsparameter

1. Zeitliche Skalierung Zur Bestimmung der A-priori-Werte der Verschaltungen parametrisiert man die Konnektivitätsmatrizen A und B j äquivalent zu [5]

um.

−1 a12 · · ·

A → σA = σ a21 −1

..

..

.

.

j

(26)

b11 bj12 · · ·

j

..

.

B j → σB j = σ

b21

..

.

Dieses Aufspalten in einen Skalar σ und eine normierte Matrix entdimensionalisiert die Verschaltung, so dass die Ausprägung der Konnektivität zwischen

Regionen relativ zur Selbst-Konnektivität dargestellt wird. Dadurch erzwingt

man die gleiche Selbst-Konnektivität bzw. Zeitskalierung σ in sämtlichen Regionen.

2. Stabiltät des Systems Es ist offensichtlich, dass die neuronale Aktivität keine unendlichen Werte annehmen kann. Daher muss in Abwesenheit

eines Inputs der neuronale Zustand zu einem stabilen Wert zurückkehren. Mathematisch betrachtet heißt das, dass der größte reelle Eigenwert der inneren

Verschaltungsmatrix negativ sein muss (siehe [8]). Dieser Eigenwert ist auch

bekannt als oberer Ljapunow-Exponent. Um eine A-priori-Verteilung der Verschaltungsparameter aij zu bestimmen, kann diese Beschränkung ausgenutzt

werden.

Definition 4. Sei ein bilineares Kontrollsystem in Rd gegeben, also ein System

der Form

m

X

ẋ(t) = A0 +

ui (t)Ai x(t),

x(0) = x0 ∈ Rd \{0}

i=1

mit Aj ∈ Rd×d , j = 0, . . . , m, u(·) ∈ U := {u : R → U, u messbar} mit

einer kompakten und konvexen Menge von Kontrollwerten U ⊂ Rm , U 6= ∅. Als

Ljapunow-Exponenten zum Anfangswert x0 ∈ Rd und einer Kontrollfunktion

u(·) ∈ U bezeichnet man

λ(x0 , u(·)) := lim sup

t→∞

1

ln k x(t, x0 , u(·)) k .

t

Der obere Ljapunow-Exponent λ charakterisiert die Geschwindigkeit, mit der

sich zwei Trajektorien voneinander entfernen. Für zwei gegebene Trajektorien

mit einer anfänglichen Entfernung von ∆Z0 lässt sich die Entfernung voneinander mit der Zeit t mit einer Rate von |∆Z(t)| ≈ exp(λt)|∆Z0 | darstellen. Ist

λ < 0, so wird das System konvergieren. Daher ist es ausreichend, die Konnektivitätsstärke so zu beschränken, dass sicher gestellt ist, dass der Hauptexponent

negativ ist.

Allerdings können verschiedene, aber gleich wahrscheinliche Anordnungen der

15

aij ’s verschiedene obere Exponenten zur Folge haben. Um dieses Problem zu

lösen, bestimmt man die Wahrscheinlichkeit, dass der größtmögliche obere Exponent die Null überschreitet. Anschließend wählt man A-priori-Werte, die diese

Wahrscheinlichkeit genügend klein werden lassen.

3. A-priori-Verteilung von A Betrachte hierzu eine beliebige

Menge von

P

2

l(l − 1) interregionalen Vernetzungen aij , i 6= j mit ζ =

a

als

Summe

i,j ij

über die quadrierten Werte. Für jeden gegebenen Wert von ζ und gleiche Kräfte

a = aij zwischen allen Regionen ergibt sich wie in [5] der obere LjapunowExponent λa als

λa = (l − 1)a − 1

ζ = l(l − 1)a2 .

(27)

1

l

annimmt, d.h. wenn a = l−1

gilt, wird der größtmögWenn ζ den Wert l−1

l

a

liche Exponent λ = 0. Solange ζ < l−1 ist, ist die Wahrscheinlichkeit, dass

der oberste Exponent größer als Null wird, durch eine obere Schranke beschränkt. Falls jede Verbindung eine normalverteilte A-priori-Verteilung mit

Erwartungswert ηa = 0 und Varianz νa hat, so weist ζ eine skalierte χ2 Verteilung auf: ζ/νa ∼ χ2l(l−1) mit l(l − 1) Freiheitsgraden. νa wird so gewählt,

l

dass pa := p(ζ > l−1

) genügend klein wird (siehe [5]).

ηa = 0,

νa =

l(l − 1)

φ−1

χ (1 − pa )

(28)

2

Hier ist φ−1

χ die inverse kumulative χl(l−1) -Verteilungsfunktion. Mit steigender

Anzahl von Regionen verringert sich diese A-priori-Varianz.

Zusätzlich zu der Beschränkung auf normierte Vernetzungen benötigt die Faktorisierung in Gleichung (26) einen Zeitskalar σ > 0. Dazu wählt man eine Apriori-Verteilung, die durch ihre Momente so bestimmt ist, dass σ ∼ N (ησ , νσ )

gilt. Der Erwartungswert ησ bestimmt die charakteristische Zeitkonstante des

Systems und wird hier als ησ = 1s gewählt. Die Varianz νσ wird wie in [5] so

gewählt, dass die Wahrscheinlichkeit, dass der obere Ljapunow-Exponent größer

als Null wird, gering ist, hier p(λ > 0) ≤ 10−3 .

2 2

ησ

1

ησ = 1, νσ =

=

(29)

φ−1

φ−1

N (1 − pσ )

N (1 − pσ )

Hier bezeichnet φ−1

N die inverse kumulative Normalverteilungsfunktion und pσ

die Wahrscheinlichkeit, dass λ positiv bleibt.

Die so erhaltene A-priori-Wahrscheinlichkeitsdichte für den zeitlichen Skalierungsparameter σ hat eine Gauß’sche Form (siehe Abb. 4, links). Diese wird

nun bezüglich der charakteristischen Halbwertszeit der neuronalen Transienten

τz (σ) = ln 2/σ ausgedrückt. Diese beträgt etwa 500ms. Dazu transformiert man

p(σ) um (siehe Abb. 4, rechts).

p(τz ) = p(σ)

∂σ

∂τz

(30)

Es werden also Transienten im Bereich von wenigen 100 Millisekunden bis einigen Sekunden erwartet.

16

Abbildung 4: Die A-priori-Wahrscheinlichkeitsdichtefunktion des zeitlichen Skalierungsparameters σ hat die Form einer Gauß’schen Glockenkurve (links). Diese

wird verzerrt, indem sie durch die charakteristische Halbwertszeit der neuronalen Transienten τz dargestellt wird (rechts). Diese A-priori-Verteilung verdeutlicht den erwarteten Abfall neuronaler Aktivität. Die Grafik stammt aus [5].

4. A-priori-Verteilungen von B und C Die Berechnung der A-prioriWerte der bilinearen Verschaltungsparameter bkij erfolgt analog zur Bestimmung

der A-priori-Werte der inneren Verschaltungsparameter aij .

ηb = 0,

νb =

l(l − 1)

− pb )

φ−1

χ (1

(31)

2

φ−1

χ bezeichnet wieder die inverse kumulative χl(l−1) -Verteilungsfunktion und

P

l

pb := p( ij,i6=j b2ij < l−1

). Da die bij ’s die Input-abhängige Komponente der

aij ’s beschreiben, werden auch diese Parameter mit σ normiert und damit entdimensionalisiert.

Die A-priori-Werte der cik ’s lauten

ηc = 0,

νc = 1

(32)

und sind damit relativ uninteressant.

Wichtig ist hierbei, dass diese Beschreibung der aij ’s, bij ’s und cik ’s immer in

Relation zur Skalierung der Inputs stattfindet. Denn die Parameter sind nicht

invariant gegenüber einer Transformation der Inputs. Die Erwartungswerte und

Kovarianzen der Parameter der neuronalen Zustandsgleichungen sind in Tabelle

2 und 3 auf Seite 18 aufgeführt (siehe [9]).

2.3.2

Hämodynamische A-priori-Verteilung

Für die hämodynamischen Parameter θh = {κ, γ, τ, α, ρ} können die A-posterioriErwartungswerte und -Kovarianzen experimentell bestimmt. Daraus werden dann

17

Parameter

aij

bij

cik

σ

Beschreibung

Konnektivität

Induzierte Konnektivität

Input

Skalierung

EW η

0

0

0

0

Varianz ν

siehe (28)

siehe (31)

1

siehe (29)

Tabelle 2: Parameter der neuronalen Zustandsgleichungen aus [9]

Konstante

aii

Beschreibung

Selbst-Konnektivität

Wert

-1

Tabelle 3: Konstanten der neuronalen Zustandsgleichungen aus [9]

normalverteilte A-priori-Werte berechnet.

Generell ist ein solches Vorgehen ausreichend. Allerdings kann man den Rechenaufwand, der dafür benötigt wird, deutlich verringern, indem man den Rang der

A-priori-Kovarianz der hämodynamischen Parameter θh verringert. Sei dazu wie

in [5]:

∂κ1 h ∂(κ1 )T

C

= εh λh εhT

∂θh θ ∂θh

+

+T

∂κ1 h h hT ∂κ1

mit Cθh =

ε

λ

ε

.

∂θh

∂θh

Cov{κ1 } =

(33)

Hier bezeichnet Cθh die Kovarianz von θh und κ1 den ersten Volterra-Kern. Das

Symbol + markiert die Pseudoinverse, εh sind die Eigenvektoren und λh die

Eigenwerte der hämodynamischen Parameter. Jetzt schränkt man den Wertebereich der Parameter auf einen 2-dimensionalen Unterraum ein. Dadurch wird

die Schätzung effizienter und der Rechenaufwand geringer.

Das Eigenwert-Spektrum der Hauptdiagonale von λh impliziert, dass nur zwei

Eigenwerte von Bedeutung sind (siehe Abb. 5, links). Setzt man nun die anderen

Eigenwerte auf Null, so beschreibt Cθh die A-priori-Kovarianz eines verringerten

Parameter-Raums.

Kombiniert man nun die A-priori-Verteilungen der neuronalen Parameter θc und

der hämodynamischen Parameter θh , so kann man die A-priori-Wahrscheinlichkeitsdichte der Parameter wie in [5] in Abhängigkeit von deren A-prioriErwartungswert ηθ und Kovarianz Cθ ausdrücken.

σ

1

νσ

aij

0

CA

k

b

0

C

θ=

,

η

=

,

C

=

(34)

B

ij θ θ

cik

0

1

Ch

ηθh

θh

Die A-priori-Kovarianzen CA und CB enthalten auf der Hauptdiagonalen Elemente νa und νb für alle Verbindungen, die sich verändern können. Da nun alle

A-priori-Werte bestimmt wurden, können nun die A-posteriori-Werte bestimmt

und mit der Schätzung fortgefahren werden, indem der EM-Algorithmus in Gleichung (24) angewandt wird.

18

Abbildung 5: Analyse der A-priori-Wahrscheinlichkeitsverteilungen der hämodynamischen Parameter, induziert durch die neuronale Aktivität in einer einzelnen

Region. Diese Verteilung wird beschrieben durch die Kovarianz der Volterrakerne erster Ordnung κ1 und die Eigenwerte und Eigenvektoren. So kann man zeigen, dass nur zwei wichtige Formen der hämodynamischen Reaktion existieren,

welche durch die A-priori-Werte der biophysikalischen Parameter hervorgerufen werden. Die Eigenwerte λhi spiegeln die durch diese Formen ausgedrückte

Varianz wider. Die beiden rechts abgebildeten Formen entsprechen den Eigenvektoren εhi , die eine Funktion der Peri-Stimulus-Zeit (PST) σ1 sind. Die Grafik

stammt aus [5].

19

2.4

Schätzung

Das Prognoseverfahren ist eine Analyse der normalverteilten A-posteriori-Verteilung. Die A-posteriori-Wahrscheinlichkeiten werden verwendet, um Rückschlüsse darauf zu ziehen, ob ein einzelner Parameter oder ein Wert der Parameter

cT ηθ|y (z.B. der Durchschnitt) eine bestimmte Schranke γ überschreitet (siehe

[5]).

cT ηθ|y − γ

p = φN q

T

c Cθ|y c

(35)

Hier bezeichnet φN die kumulative Normalverteilungsfunktion.

Ein besonderes Augenmerk legt man hier auf die Verschaltungsparameter θc

und unter diesen besonders auf die bilinearen Terme. Diese Parameter werden

in Hertz oder pro Sekunde gemessen oder sind dimensionslos, falls sie normiert

wurden. Die Schranken sind entsprechend definiert. In der dynamischen Modellierung bedeutet ein hoher Wert eine schnelle Reaktion mit einer kurzen

Zeitkonstante.

3

Validierung des EM-Algorithmus

Eine mathematische Validierung des EM-Algorithmus ist in [9] zu finden. Hier

werden statt fMRT-Experimenten EEG-Experimente betrachtet. Der EM-Algorithmus lässt sich jedoch in beiden Fällen analog anwenden.

Bei der Elektroenzephalografie (EEG) wird wie beim fMRT die elektrische

Aktivität gemessen. Hier wird jedoch die vom Gehirn ausgehende elektrische

Aktivität direkt an der Kopfhaut bestimmt. Dazu werden Elektroden mittels

Hauben oder Bändern am Kopf befestigt oder direkt auf die Kopfhaut geklebt.

In den Experimenten, die dieser Validierung zugrunde liegen, werden die Elektroden direkt im Mäusegehirn befestigt. Die so gemessenen Stromkurven werden

dann aufgezeichnet. Weitere Informationen zu diesem Thema liefert zum Beispiel [12] oder [3].

Um die Validität der Parameterschätzung zu testen, wurden numerische Experimente durchgeführt, die auf zwei verschiedenen Testreihen beruhen. Zum einen

auf den geschätzten EEG-Daten, die mit einem implementierten Programm simuliert wurden. Und zum anderen auf den Daten, die bei realen Experimenten

beobachtet wurden. Diese Daten sowie die dazugehörige Hypothese und die Hintergrundinformationen stammen von Prof. Dr. Hans-Christian Pape, Dr. Thomas Seidenbecher und Dr. Jörg Lesting von Institut für Physiologie I der Universität Münster. Sie wurden in Angst-Experimenten an konditionierten Mäusen

unter der Leitung von Rajeevan Narayanan gesammelt.

3.1

Künstliche EEG-Daten

Die simulierten Daten-Experimente betrachten drei Gehirnregionen, die auf drei

verschiedene Arten vernetzt sein können. Der Input wirkt ausschließlich auf die

erste Region. Die Tests umfassen jeweils 800ms mit zwei Inputs mit einer Dauer

von je 300ms.

20

Abbildung 6: Schema des vorwärts-lateralen Verschaltungstests aus [9]

Abbildung 7: Oben aufgeführt sind die EEG-Kurven der Simulation der

vorwärts-lateralen Verschaltung für die erste (rote), zweite (grüne) und dritte (blaue) Gehirnregion. Unten wird der Unterschied zwischen den simulierten

und den gemessenen Kurven gezeigt. Siehe [9].

3.1.1

Vorwärts-laterale Vernetzung

In diesem Test leitet Region 1 den Input durch vorwärts gerichtete Verschaltung

an die anderen beiden Regionen weiter. Diese sind einseitig lateral miteinander

verbunden (siehe Abbildung 6).

In Abbildung 7 aufgeführt sind die Graphen der simulierten EEG-Kurve und des

Unterschieds zwischen der simulierten und der gemessenen Kurve. Der maximale

Fehler der geschätzten Kurve beträgt 10%, der durchschnittliche Fehler liegt bei

2, 7%.

21

Abbildung 8: Schema des verketteten vorwärts gerichteten Verschaltungstests

aus [9]

Abbildung 9: Oben aufgeführt sind die EEG-Kurven der Simulation der verketteten vorwärts gerichteten Verschaltung für die erste (rote), zweite (grüne) und

dritte (blaue) Gehirnregion. Unten wird der Unterschied zwischen den simulierten und den gemessenen Kurven gezeigt. Siehe [9].

3.1.2

Verkettete Vernetzung

In diesem Test leitet Region 1 den Input durch eine vorwärts gerichtete Verschaltung an Region 2 weiter, welche ihn dann an Region 3 weitergibt (siehe

Abbildung 8).

In Abbildung 9 aufgeführt sind die Graphen der simulierten EEG-Kurven und

der Unterschiede zwischen den simulierten und den gemessenen Kurven. Der maximale Fehler der geschätzten Kurve beträgt 18%, der durchschnittliche Fehler

liegt bei 4, 4%.

22

Abbildung 10: Schema des Verschaltungstests mit voller Konnektivität aus [9]

Abbildung 11: Oben aufgeführt sind die EEG-Kurven der Simulation der Verschaltung mit voller Konnektivität für die erste (rote), zweite (grüne) und dritte

(blaue) Gehirnregion. Unten wird der Unterschied zwischen den simulierten und

den gemessenen Kurven gezeigt. Siehe [9].

3.1.3

Volle Konnektivität

In diesem Test leitet Region 1 den Input weiter an die beiden anderen Regionen, die ihn dann wieder zurück an die erste Region geben. Die zweite Region

ist mit der dritten lateral vernetzt, außerdem besteht eine vorwärts gerichtete

Verbindung von Region 3 zur Region 2 (siehe Abbildung 10).

In Abbildung 11 aufgeführt sind die Graphen der simulierten EEG-Kurven und

der Unterschiede zwischen den simulierten und den gemessenen Kurven. Der maximale Fehler der geschätzten Kurve beträgt 11%, der durchschnittliche Fehler

liegt bei 1, 8%.

3.2

Reale EEG-Daten

Die realen EEG-Daten wurden während Angst-Experimenten gesammelt, die

in [13], [14] und [10] beschrieben werden. Die Mäuse wurden darauf konditioniert, Angst zu verspüren, sobald sie mit einem auditorischen Reiz konfrontiert

werden. Das gesamte Experiment besteht aus elf Sitzungen je Maus. Die ersten drei Sitzungen wurden genutzt, um das Tier an den Reiz zu gewöhnen

23

(erster Tag) und mit einem sensorischen Stimulus (Elektroschock) zu konditionieren (zweiter Tag). Die Tests mit auditorischem und sensorischen Reiz sind

mit CS + gekennzeichnet, ohne sensorischen Reiz mit CS − . Einen Tag nach

der Konditionierung wurden sechs Tests (R1 bis R6) mit je 30 Minuten Pause

durchgeführt. Diese dauerten 360s mit acht Reiz-Anwendungen (vier mal CS −

und vier mal CS + ) von 10s mit je 20s Pause. Am folgenden Tag fanden zwei

weitere Tests (E1 und E2) statt, die aufgebaut waren wie die Sitzungen R1 bis

R6. Einen Überblick über dieses Experiment liefert [10]. Analysiert wurden die

ersten CS + -Stimulusböcke der Sitzungen R1 und R6.

3.2.1

Hypothese

In den Experimenten werden drei Gehirnregionen beobachtet: Der laterale Amygdala (AMY) ist wesentlich an der Entstehung von Angst und der Analyse möglicher Gefahren beteiligt. Die erste Cornu-Ammonis-Region (CA1) des Hippocampus ist eine Gehirnwindung im Großhirn und spielt eine Rolle in der Verarbeitung von sensorischen Informationen. Der präfrontale Cortex (PFC) empfängt

sensorische Signale. Volle Konnektivität zwischen allen Regionen ist möglich,

ebenso kann der Input auf alle Regionen wirken.

Die Hypothese ist, dass der laterale Amygdala die Quelle der Hirnaktivität ist

und diese an CA1 weitergibt, welche diese in Sitzung R1 an PFC weitergibt. Außerdem wird eine ähnliche, geringere Konnektivität zwischen den drei Regionen

in Sitzung R6 erwartet.

3.2.2

Vollständige CS + Block-Analyse

Zunächst wird der erste 10-sekündige CS + Block analysiert. Es werden die

Durchschnittswerte der Sitzungen R1 und R6 betrachtet (siehe Abbildung 12

auf Seite 25, Abbildung 13 auf Seite 26).

24

Abbildung 12: Gemessene (grün) und simulierte (rot) EEG-Kurven des gesamten

ersten CS + Blocks aller R1-Sitzungen. Siehe [9].

25

Abbildung 13: Gemessene (grün) und simulierte (rot) EEG-Kurven des gesamten

ersten CS + Blocks aller R6-Sitzungen. Siehe [9].

26

Abbildung 14: Gemessene (grün) und geschätzte (rot) EEG-Kurven der zweiten

Sekunde des ersten CS + Blocks der R1-Sitzungen. Siehe [9].

Abbildung 15: Verschaltungsschema der geschätzten Daten, das die dominanten

Verbindungen aus den R1-Sitzungen zeigt. Siehe [9].

3.2.3

Ausschnittweise CS + Block-Analyse

Um eine akkuratere Schätzung der Verschaltung zu erhalten, betrachtet man

ein Zeitfenster von einer einzigen Sekunde. Für diese Schätzung des ersten CS +

Blocks wird nur die zweite Sekunde des gesamten 10-sekündigen Blocks der R1und R6-Sitzungen betrachtet. Für die durchschnittliche R1-Sitzung erhält man

die Kurven in Abbildung 14. Die dominierenden Verbindungen sind schematisch

in Abbildung 15 aufgeführt.

Für die durchschnittliche R6-Sitzung liefert die Schätzung die Kurve in Abbildung 16. Die dominierenden Verbindungen sind schematisch in Abbildung 17

aufgeführt.

3.2.4

Experimentelle Diskussion

Die gemessene Verschaltung verifiziert die Hypothese über die Konnektivität der

betrachteten Gehirnregionen. Zusätzlich wird eine Verbindung vom präfrontalen

27

Abbildung 16: Gemessene (grün) und geschätzte (rot) EEG-Kurven der zweiten

Sekunde des ersten CS + Blocks der R6-Sitzungen. Siehe [9].

Abbildung 17: Verschaltungsschema der gemessenen Daten, das die dominanten

Verbindungen aus den R6-Sitzungen zeigt. Siehe [9].

28

Cortex zum Amygdala in Sitzung R1 deutlich, ebenso wie eine Verbindung

vom präfrontalen Cortex zur ersten Cornu-Ammonis-Region in Sitzung R6. Die

dominierenden Verbindungen von Sitzung R6 sind im Vergleich zur Sitzung R1

9

etwa 20

so stark.

3.2.5

Mathematische Diskussion

In einem eingeschränkten Zeitfenster lassen sich die Daten akkurater schätzen

als in dem gesamten Zeitraum des Experiments. Hier stimmen die EEG-Kurven

weitestgehend mit den simulierten Daten überein. Das Modell scheint unfähig

zu sein, die EEG-Kurve in einem lange andauernden Experiment zu prognostizieren, besonders wenn das Experiment einen einzelnen Reiz umfasst, der das

gesamte Experiment über andauert.

Eine Anpassung des Konzepts, die eventuell nötig ist, um die Daten von Experimenten dieser Zeitdauer zu schätzen, ist in diesem Modell nicht möglich. Vor

allem die starke Approximation durch ein bilineares Modell scheint dafür nicht

geeignet zu sein. Das Modell approximiert zwar grob die gemessene EEG-Kurve,

ist allerdings nicht in der Lage, die Konnektivität zwischen den Gehirnregionen

widerzuspiegeln.

29

Tabellenverzeichnis

1

2

3

Biophysikalische Parameter des hämodynamischen Systems . . .

Parameter der neuronalen Zustandsgleichungen . . . . . . . . . .

Konstanten der neuronalen Zustandsgleichungen . . . . . . . . .

10

18

18

Abbildungsverzeichnis

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

A-priori-Verteilung und A-posteriori-Verteilung von π . . . . . .

Das bilineare System . . . . . . . . . . . . . . . . . . . . . . . . .

Das hämodynamische Modell . . . . . . . . . . . . . . . . . . . .

Zeitliche Skalierung . . . . . . . . . . . . . . . . . . . . . . . . . .

Einschränkung des Wertebereichs . . . . . . . . . . . . . . . . . .

Schema des vorwärts-lateralen Verschaltungstests . . . . . . . . .

EEG-Kurven der vorwärts-lateralen Simulation . . . . . . . . . .

Schema des verketteten vorwärts gerichteten Verschaltungstests .

EEG-Kurven der verketteten vorwärts gerichteten Simulation . .

Schema des Verschaltungstests mit voller Konnektivität . . . . .

EEG-Kurven der Simulation mit voller Konnektivität . . . . . .

Gemessene und simulierte EEG-Kurven des gesamten ersten CS +

Blocks aller R1-Sitzungen . . . . . . . . . . . . . . . . . . . . . .

Gemessene und simulierte EEG-Kurven des gesamten ersten CS +

Blocks aller R6-Sitzungen . . . . . . . . . . . . . . . . . . . . . .

Gemessene und geschätzte EEG-Kurven der zweiten Sekunde des

ersten CS + Blocks der R1-Sitzungen . . . . . . . . . . . . . . . .

Verschaltungsschema der gemessenen Daten, das die dominanten

Verbindungen aus den R1-Sitzungen zeigt. . . . . . . . . . . . . .

Gemessene und geschätzte EEG-Kurven der zweiten Sekunde des

ersten CS + Blocks der R6-Sitzungen . . . . . . . . . . . . . . . .

Verschaltungsschema der gemessenen Daten, das die dominanten

Verbindungen aus den R6-Sitzungen zeigt. . . . . . . . . . . . . .

5

8

9

17

19

21

21

22

22

23

23

25

26

27

27

28

28

Literatur

[1] F. Böker. Statistik III. Universität Göttingen, 2004. http://www.statoek.wiso.uni-goettingen.de/veranstaltungen/statistik3alt/daten/sec10.pdf.

[2] R. Buxton, E. Wong, and L. Frank. Dynamics of blood flow and oxygenation changes during brain activation: the balloon model. MRM, 39:855–864,

1998.

[3] M. Ebe and I. Homma. Leitfaden für die EEG-Praxis: Ein Bildkompendium.

Urban & Fischer, 2002.

[4] K. Friston, L. Harrison, and W. Penny. Bayesian estimation of dynamical

systems: an application to fmri. NeuroImage, 16:513–530, 2002.

[5] K. Friston, L. Harrison, and W. Penny. Dynamic causal modelling. NeuroImage, 19:1273–1302, 2003.

30

[6] K. Friston, W. Penny, C. Phillips, S. Kiebel, G. Hinton, and J. Ashburner.

Classical and bayesian inference in neuroimaging: Theory. NeuroImage,

16:465–483, 2002.

[7] K. J. Friston, A. Mechelli, R. Turner, and C. Price. Nonlinear responses

in fmri: The balloon model, volterra kernels, and other hemodynamics.

NeuroImage, 12:466–477, 2000.

[8] L. Grüne. Numerical stabilization of bilinear control systems. SIAM Journal on Control and Optimization, 34, 1996.

[9] C. Himpe. Implementation and analysis of dynamic causal modeling for

eeg/meg data.

[10] K. Jüngling and et al. Neuropeptide s-mediated control of fear expression

and extinction: Role of intercalated gabaergic neurons in the amygdala.

Neuron, 59:298–310, 2008.

[11] J. Mandeville, J. Marota, C. Ayata, G. Zararchuk, M. Moskowitz, B. Rosen,

and R. Weisskoff. Evidence of cerebrovascular postarteriole windkessel with

delayed compliance. Journal of Cerebral Blood Flow & Metabolism, 19:679–

689, 1999.

[12] W. Paulus.

Klinische Neuropsychologie, Universität Göttingen, 2013.

http://www.neurologie.uni-goettingen.de/index.php/elektroenzephalographie-eeg.html.

[13] S. Sangha, R. Narayanan, J. Bergado-Acosta, O. Stork, T. Seidenbecher,

and H. Pape. Deficiency of the 65 kda isoform of glutamic acid decarboxylase impairs extinction of cued but not contextual fear memory. Journal of

Neuroscience, 29:15714–15720, 2009.

[14] T. Seidenbecher, T. Laxmi, O. Stork, and H. Pape. Amygdalar and

hippocampal theta rhythm synchronization during fear memory retrieval.

Science, 301:846–850, 2003.

[15] C. Siedentopf. fMRI easy. 2005. http://www.fmri-easy.de/start1.htm.

31