D-SPIN Webservices

Werbung

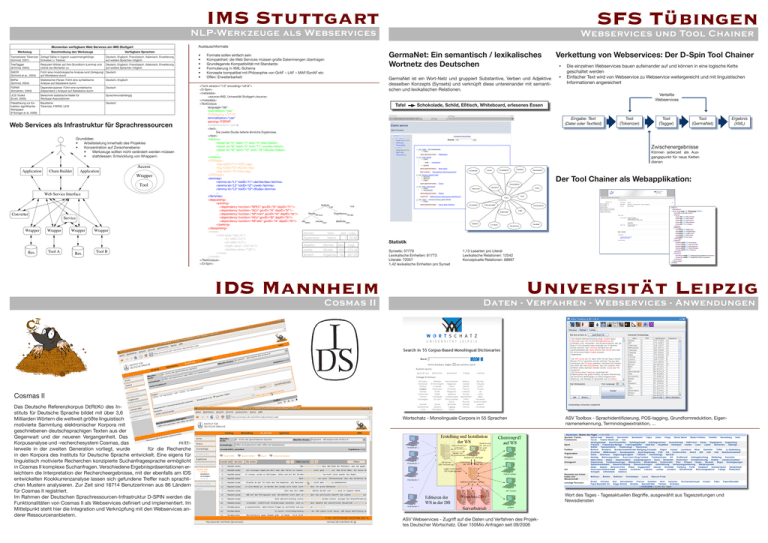

IMS Stuttgart SFS Tübingen NLP-Werkzeuge als Webservices Austauschformate Momentan verfügbare Web Services am IMS Stuttgart Werkzeug Beschreibung des Werkzeugs Verfügbare Sprachen Trainierbarer Tokenizer Zerlegt Sätze in logisch zusammengehörige (Schmid, 2001) Einheiten (= Tokens) Deutsch, Englisch, Französisch, Italienisch, Erweiterung auf weitere Sprachen möglich TreeTagger (Schmid, 2004) Reduziert Wörter auf ihre Grundform (Lemma) und ordnet sie Wortarten zu Deutsch, Englisch, Französisch, Italienisch, Erweiterung auf weitere Sprachen möglich SMOR (Schmid et al., 2004) Führt eine morphologische Analyse (und Zerlegung) Deutsch auf Wortebene durch BitPar (Schmid, 2004) Statistischer Parser. Führt eine syntaktische Analyse auf Satzebene durch Deutsch, Englisch FSPAR (Schiehlen, 2003) Dependenzparser. Führt eine syntaktische (Dependenz-) Analyse auf Satzebene durch Deutsch UCS Toolkit (Evert, 2005) Berechnet statistische Maße für Wortpaar-Assoziationen Sprachenunabhängig Paketlösung zur Extraktion signifikanter Wortpaare (Fritzinger et al. 2009) Bausteine: Tokenizer, FSPAR, UCS Deutsch Web Services als Infrastruktur für Sprachressourcen Grundidee: • Arbeitsteilung innerhalb des Projektes • Konzentration auf Zwischenebene: • Werkzeuge sollten nicht verändert werden müssen • stattdessen: Entwicklung von Wrappern Application Chain Builder Application Access Wrapper Tool Web Service Interface Converter Service Wrapper Res. Wrapper Tool A Wrapper Res. Webservices und Tool Chainer Wrapper Tool B • • • • • • GermaNet: Ein semantisch / lexikalisches Wortnetz des Deutschen Formate sollen einfach sein Kompaktheit: die Web Services müssen große Datenmengen übertragen Grundlegende Kompatibilität mit Standards: Formulierung in XML-Schema Konzepte kompatibel mit Philosophie von GrAF – LAF – MAF/SznAF etc Offen: Erweiterbarkeit <?xml version=“1.0“ encoding=“utf-8“> <D-Spin> <metadata> <source>IMS, Universität Stuttgart</source> </metadata> <TextCorpus language=“de“ tokenisation=“yes“ POStagging =“STTS“ lemmatisation=“yes“ parsing=“FSPAR“ mweExtraction=“yes“> <text> Die zweite Studie lieferte ähnliche Ergebnisse. </text> <tokens> <token id=“t1“ start=“1“ end=“3“>Die</token> <token id=“t2“ start=“5“ end=“11“>zweite</token> <token id=“t3“ start=“13“ end=“18“>Studie</token> ... </tokens> <POStags> <tag tokID=“t1“>ART</tag> <tag tokID=“t2“>ADJA</tag> <tag tokID=“t3“>NN</tag> </POStags> <lemmas> <lemma id=“L1“ tokID=“t1“>der/die/das</lemma> <lemma id=“L2“ tokID=“t2“>zweit</lemma> <lemma id=“L3“ tokID=“t3“>Studie</lemma> ... </lemmas> <depparsing> <parsing> <dependency function=“SPEC“ govID=“t3“ depID=“t1“/> <dependency function=“ADJ“ govID=“t3“ depID=“t2“/> <dependency function=“NP:nom“ govID=“t4“ depID=“t3“/> <dependency function=“ADJ“ govID=“t6“ depID=“t5“/> <dependency function=“NP:akk“ govID=“t4“ depID=“t6“/> </parsing> </depparsing> <mwes> <mwe type=“adj_nn“> <k1 refid=“L2“/> <k2 refid=“L3“/> <loglik value =“237.44“/> <absfreq value=“183“/> </mwe> </mwes> </TextCorpus> </D-Spin> GermaNet ist ein Wort-Netz und gruppiert Substantive, Verben und Adjektive desselben Konzepts (Synsets) und verknüpft diese untereinander mit semantischen und lexikalischen Relationen. Verkettung von Webservices: Der D-Spin Tool Chainer • • Die einzelnen Webservices bauen aufeinander auf und können in eine logische Kette geschaltet werden Einfacher Text wird von Webservice zu Webservice weitergereicht und mit linguistischen Informationen angereichert Verteilte Webservices Tafel Schokolade, Schild, Eßtisch, Whiteboard, erlesenes Essen Eingabe: Text (Datei oder Textfeld) Tool (Tokenizer) Tool (Tagger) Tool (GermaNet) Zwischenergebnisse Können jederzeit als Ausgangspunkt für neue Ketten dienen Der Tool Chainer als Webapplikation: lieferte . TOP TOP StudieNP:nom dieSPEC Ergebnisse NP:akk zweiteADJ ähnlicheADJ Nomen Verb Ergebnisse liefern abs LogL 7 22.82 Adjektiv Nomen abs LogL zweite Studie 183 273.44 ähnlich Ergebnis 64 357.20 IDS Mannheim Cosmas II Statistik Synsets: 57776 Lexikalische Einheiten: 81773 Literale: 72057 1,42 lexikalische Einheiten pro Synset 1,13 Lesarten pro Literal Lexikalische Relationen: 12042 Konzeptuelle Relationen: 68997 Universität Leipzig Daten - Verfahren - Webservices - Anwendungen Cosmas II Das Deutsche Referenzkorpus DEREKO des Instituts für Deutsche Sprache bildet mit über 3,6 Milliarden Wörtern die weltweit größte linguistisch motivierte Sammlung elektronischer Korpora mit geschriebenen deutschsprachigen Texten aus der Gegenwart und der neueren Vergangenheit. Das Korpusanalyse und -recherchesystem Cosmas, das mittlerweile in der zweiten Generation vorliegt, wurde für die Recherche in den Korpora des Instituts für Deutsche Sprache entwickelt. Eine eigens für linguistisch motivierte Recherchen konzipierte Suchanfragesprache ermöglicht in Cosmas II komplexe Suchanfragen. Verschiedene Ergebnispräsentationen erleichtern die Interpretation der Rechercheergebnisse, mit der ebenfalls am IDS entwickelten Kookkurrenzanalyse lassen sich gefundene Treffer nach sprachlichen Mustern analysieren. Zur Zeit sind 16714 BenutzerInnen aus 86 Ländern für Cosmas II registriert. Im Rahmen der Deutschen Sprachressourcen-Infrastruktur D-SPIN werden die Funktionalitäten von Cosmas II als Webservices definiert und implementiert. Im Mittelpunkt steht hier die Integration und Verknüpfung mit den Webservices anderer Ressourcenanbietern. Ergebnis (XML) Wortschatz - Monolinguale Corpora in 55 Sprachen ASV Toolbox - Sprachidentifizierung, POS-tagging, Grundformreduktion, Eigennamenerkennung, Terminologieextraktion, ... Wort des Tages - Tagesaktuellen Begriffe, ausgewählt aus Tageszeitungen und Newsdiensten ASV Webservices - Zugriff auf die Daten und Verfahren des Projektes Deutscher Wortschatz. Über 150Mio Anfragen seit 09/2006