Künstliche Neuronale Netze Überblick 2

Werbung

Arbeitstitel

Neuronen, Modelle,

Künstliche Neuronale Netze

Version 08.08.01

Jürgen Weiprecht

21. Dezember 2004

Inhaltsverzeichnis

1 Einführung

1

1.1

Frühe Vorstellungen und Automaten . . . . . . . . . . . . . .

1

1.2

Neuronen, Informationen und KNN . . . . . . . . . . . . . .

5

1.3

Motivation und Kapitelübersicht . . . . . . . . . . . . . . . . .

9

2 Das Gehirn

13

2.1

Die Anatomie des Nervensystems . . . . . . . . . . . . . . . . 13

2.2

Das Gehirn als System . . . . . . . . . . . . . . . . . . . . . . 18

2.3

2.2.1

Gehirn und Körper . . . . . . . . . . . . . . . . . . . . 18

2.2.2

Arten der Erfassung von Informationen durch das Gehirn 21

Wichtige Verfahren zur Untersuchung des Gehirns . . . . . . . 23

3 Die Neuronen

27

3.1

Der allgemeine äussere Aufbau einer Neurone . . . . . . . . . 27

3.2

Neuronentypen . . . . . . . . . . . . . . . . . . . . . . . . . . 29

3.3

Die Wirkungsweise einer Neurone . . . . . . . . . . . . . . . . 32

3.4

3.3.1

Der prinzipielle innere Aufbau einer Neurone . . . . . . 32

3.3.2

Potentiale von Neuronen . . . . . . . . . . . . . . . . . 35

Synaptischer Übergang und Informationsfluss . . . . . . . . . 38

4 Beschreibungen, Modelle und Systeme

4.1

41

Modellbildung und Betrachtung . . . . . . . . . . . . . . . . . 41

4.1.1

Betrachtungsebenen . . . . . . . . . . . . . . . . . . . 41

i

ii

INHALTSVERZEICHNIS

4.1.2

Berechnungsmodelle . . . . . . . . . . . . . . . . . . . 47

4.2 Vom biologischen zum abstrakten Modell . . . . . . . . . . . . 51

4.3 Das Neuron als abstraktes Modell . . . . . . . . . . . . . . . . 60

4.3.1

Die Neurone als Verabeitungelement . . . . . . . . . . 60

4.3.2

Aktivierung und die Funktion der VE . . . . . . . . . 65

4.3.3

Verbindungen von VE . . . . . . . . . . . . . . . . . . 69

5 Grundlagen von KNN

5.1

75

Eigenschaften von KNN . . . . . . . . . . . . . . . . . . . . . 75

5.1.1

Von der VE zum KNN . . . . . . . . . . . . . . . . . 75

5.1.2

Das Schichtenmodell der KNN . . . . . . . . . . . . . 78

5.2 Dynamik und Netzwerkstrukturen . . . . . . . . . . . . . . . . 85

5.2.1

Strukturen und Abbildung der Dynamik . . . . . . . . 85

5.2.2

Zustände eines KNN . . . . . . . . . . . . . . . . . . . 87

5.3 Lernen als Dynamik in einem KNN

. . . . . . . . . . . . . . 89

5.3.1

Lernen in biologischen neuronalen Netzen

. . . . . . . 89

5.3.2

Lernen in einem KNN als DS . . . . . . . . . . . . . . 91

5.3.3

Arten des Lernens

. . . . . . . . . . . . . . . . . . . . 94

5.3.3.1

Beobachtetes Lernen . . . . . . . . . . . . . . 94

5.3.3.2

Unbeobachtetes Lernen . . . . . . . . . . . . 95

5.3.3.3

Andere Arten des Lernens . . . . . . . . . . . 95

6 Einfache und historische Neuronen- und KNN-Modelle

6.1

97

Das Modell nach McCulloch und Pitts . . . . . . . . . . . . 97

6.2 Das Perzeptron . . . . . . . . . . . . . . . . . . . . . . . . . . 97

6.2.1

Das Prinzip des Perzeptron . . . . . . . . . . . . . . . 97

6.2.2

Lernen mit dem Perzeptron . . . . . . . . . . . . . . . 103

6.3 Das Adaline . . . . . . . . . . . . . . . . . . . . . . . . . . . . 105

7 Weitere Bausteine aus der KNN-Theorie

107

8 Simulationssysteme

109

INHALTSVERZEICHNIS

iii

8.1

PDP++-Software . . . . . . . . . . . . . . . . . . . . . . . . 109

8.2

Andere Systeme . . . . . . . . . . . . . . . . . . . . . . . . . . 110

8.2.1

GENESIS . . . . . . . . . . . . . . . . . . . . . . . . 110

9 Programmierung von Neuronenmodellen und KNN

111

9.1

Objekt-Orientierte Programmierung von KNN . . . . . . . . 111

9.2

Neuronenmodelle in C++ . . . . . . . . . . . . . . . . . . . . 114

9.2.1

McCulloch-Pitt Neuron . . . . . . . . . . . . . . . . . . 114

A Ergebnisse der Programmierung von Neuronenmodellen und

KNN

117

A.1 Ergebnisse von Neuronenmodellen . . . . . . . . . . . . . . . . 117

A.1.1 McCulloch-Pitt-Neuron . . . . . . . . . . . . . . . . . . 117

A.1.2 Adaline . . . . . . . . . . . . . . . . . . . . . . . . . . 120

B Begriffserläuterungen

123

C Mathematische Symbole

127

D Abkürzungen

129

iv

INHALTSVERZEICHNIS

Abbildungsverzeichnis

1.1

Beispiele für historische Maschinen sind a) die Ente von Vaucanson oder b) die Pascalin, eine Rechenmaschine von Blaise

Pascal. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

Modellvorstellung des Aktionspotentials einer Neurone, mehr

im Kapitel 3, ab Seite 35. . . . . . . . . . . . . . . . . . . . .

6

1.3

Historische Vorstellungen zu den KNN in einer Übersicht. . .

8

1.4

Motivation Künstliche Neuronale Netze und Computer. . . . . 10

2.1

Eine schematische Darstellung eines menschlichen Gehirns,

mit der Bezeichnung einiger wichtiger Bereiche. Abbildung

ähnlich der Darstellung in [THOMPSON94] auf S. 23 . . . . . 14

2.2

Skizze einer einfachen Neurone mit den wichtigsten Bezeichnungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

2.3

Erstes Modell einer Informationsverarbeitung in einem Gehirn. 18

2.4

Die beiden Abbildungen zeigen die Segmente und Bereiche in

einem Gehirn bei verschiedenen Funktionen. a) Deutet den

Verlauf und die Bereiche für die Funktion Schmecken, Sehen

usw. an und b) kennzeichnet schematisch einige der Bereiche beim Sprechen und Farbverstehen. Abbildungen modifizert nach [Spektrum92/1]. . . . . . . . . . . . . . . . . . . . . 19

3.1

Schematischer Aufbau einer Neurone, hier in einem Verbund

dargestellt. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

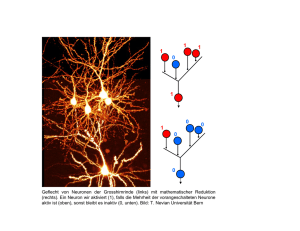

3.2

Neuronentypen: a) Strukturbilder von Neuronentypen, b) Eingefärbtes Nervengewebe. . . . . . . . . . . . . . . . . . . . . . 30

3.3

Der innere Aufbau einer Neurone . . . . . . . . . . . . . . . . 33

3.4

Das Prinzip einer Synapse . . . . . . . . . . . . . . . . . . . . 34

1.2

v

vi

ABBILDUNGSVERZEICHNIS

3.5 Das Ruhe- und Aktionspotentiale einer einzelnen Neurone . . 37

3.6 Bewegungrichtung des Aktionspotential und synaptischer Übergang . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

4.1

Modell des Sehsystems. Blaue Bezeichnungen kennzeichnen

die anatomische und die roten Bezeichnungen verdeutlichen

die Anwendung-Ebene. . . . . . . . . . . . . . . . . . . . . . . 42

4.2

Vektorkodierung mit Hilfe des Modells vom Sehsystem, Betrachtung erfolgt jetzt auf der Anwendungsebene. . . . . . . . 43

4.3

Zusammenhang zwischen Struktur und Funktion bei der Betrachtung des Gehirns und der Ableitung von Modellen. . . . . 44

4.4

Anwendung des Modells aus Abbildung 2.3. Oben: Prinzip des

menschlichen Sehsystems Unten: Modell eines einfachen mehrschichtigen KNN. . . . . . . . . . . . . . . . . . . . . . . . . 46

4.5

c

Robotermodell (aus dem LEGO°

-Mindstormbausatz ) . . . . 49

4.6 Berechnungsmodell: Es existiert ein möglicher Regelkreis, welcher sich durch Systemfunktionen oder konkrete Objekte (Roboter, Mensch) darstellen lässt. . . . . . . . . . . . . . . . . . 50

4.7

Der schematische Übergang von einem realen Neuronenmodell zum

einem künstlichen und abstrakten Neuronenmodell. Die Darstellung zeigt ein resultierendes System mit einer symbolischen Übertragungsfunktion, abgeleitet aus einem Neuronenverbund. . . . . . 52

4.8 Eine schematische Darstellung des Übergang vom biologischen

Vorbild über ein einzelnes Neuronenmodell hin zu einem, hier

mehrschichtigen (vgl. Kapitel 5.1.2), KNN. . . . . . . . . . . 53

4.9 Die mögliche Struktur eines Eingangsvektors. . . . . . . . . . 56

4.10 Ein allgemeines dynamisches System für Modellneuron oder

KNN. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58

4.11 Eine Neurone als dynamisches System und der Übergang von

einer Modellneurone zum KNN. . . . . . . . . . . . . . . . . 58

4.12 Modellbildung nach Gleichung 4.9 und 4.15: Die Modellneurone ist auch ein Dynamisches System, vgl. auch Abbildung 4.10. 61

4.13 Prinzipielle Aufbau einer VE, ähnlich wie in Abbildung 4.10

auf Seite 58. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 66

ABBILDUNGSVERZEICHNIS

vii

4.14 Die wichtigsten Aktivierungsfunktionen in einer qualitativen

Übersicht. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

4.15 Möglichen Parametereinstellungen für eine Aktivierungsfunktion. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69

4.16 Modellbildung ausgehend von einer Neuronenverbindung.

. . 70

4.17 Beispiel für FAN-IN und FAN-OUT. . . . . . . . . . . . . . . 72

5.1

Wichtige Eigenschaften in einem KNN. Die Schichten sind

farblich markiert, die VEs sind als Kreis gekennzeichnet und

die Verbindungen sind als Pfeile realisiert. . . . . . . . . . . . 76

5.2

Ein einfaches Schichtenmodell für ein KNN, Bild ist eine Vergrößerung des Modells aus Abbildung 4.8 auf Seite 53. . . . . 79

5.3

Dreischichtiges KNN mit einer willkürlich gewählten Verbindungsstruktur. Das Netz im Bild enthält 12 Eingänge und zwei

Ausgänge. Indizierungen im Bild weggelassen. . . . . . . . . . 80

5.4

Symbolische Erläuterung der Schichten und der Verbindungen

in einem einfachen dreischichtigen KNN. Weitere Erläuterungen zu dem Netz werden im Text gegeben. . . . . . . . . . . . 84

5.5

Weiterentwicklung des Ebenen-Modells nach der Abbildung 2.3 auf

Seite 18, bezogen auf die KNN und deren mögliche Struktur. 86

5.6

Mögliche Zustände in einem KNN, wobei diese auch für die

einzelnen VE zutriffen. Die Abbildung wurde durch das Zustandsdiagramm eines Prozesses nach [KALFA88] inspiriert. . 88

5.7

Schematische vereinfachte Darstellung des Lernen in einem

KNN, betrachtet als Dynamisches System. . . . . . . . . . . . 92

5.8

Signalausbreitung und Fehlerrückführung in einem einfachen

dreischichtigen KNN. Bild leicht verändert nach [DECO96] . 93

6.1

Das Perzeptron nach Rosenblatt . . . . . . . . . . . . . . . . 98

6.2

Der prinzipielle Aufbau eines Perzeptrons . . . . . . . . . . . . 100

6.3

Abhängigkeit des Ausgangs einer R-Einheit zu der Wichtung

der Eingangsinformation . . . . . . . . . . . . . . . . . . . . . 101

8.1

Simulation einer Neurone . . . . . . . . . . . . . . . . . . . . . 109

viii

ABBILDUNGSVERZEICHNIS

9.1 Betrachtet man die KNN als ein Objekt von allgemeiner Natur, so erkennt man im Sinne von OOP, dass die einzelnen

Netzarten in einer Beschreibung des Obkjets KNN enthalten

(instance of) sind. . . . . . . . . . . . . . . . . . . . . . . . . 111

9.2 Schematische Darstellung einer Klassenbildung für KNN in

C++. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 112

9.3

Schematische Darstellung von Objekten mittels zweier Basisklassen in C++. Bild ist den Darstellungen in [ROGERS97] auf Seite

41 nachempfunden. . . . . . . . . . . . . . . . . . . . . . . . . . . 113

9.4

Darstellung von von Basisklassen und abgeleiteten Klassen in

C++. Bild ist den Darstellungen in [ROGERS97] auf Seite 38 nachempfunden. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113

A.1 Adaline-Simulation . . . . . . . . . . . . . . . . . . . . . . . . 121

A.2 Adaline-Simulationsverteilung . . . . . . . . . . . . . . . . . . 121

A.3 Adaline-Simulationsverteilung . . . . . . . . . . . . . . . . . . 122

Tabellenverzeichnis

3.1

Die wichtigsten Typen von Neuronen . . . . . . . . . . . . . . 31

4.1

Arten Neuronaler Netze . . . . . . . . . . . . . . . . . . . . . 47

4.2

Programmtechnische Umsetzung von Eingabewerten am Beispiel der Sprache C++ . . . . . . . . . . . . . . . . . . . . . . 57

4.3

Schematische Ableitung eines Modellbildung für Neurone und

KNN mit der Andeutung der verwendeten mathematischen

Hilfsmittel. . . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

5.1

Sympolische Darstellung von Strukturelementen und zeitlichen Abhängingkeiten in KNN. . . . . . . . . . . . . . . . . . 85

C.1 Wichtige mathematische Symbole . . . . . . . . . . . . . . . . 127

D.1 Wichtige Abkürzungen . . . . . . . . . . . . . . . . . . . . . . 129

ix

Kapitel 1

Einführung

1.1

Frühe Vorstellungen und Automaten

Eines der faszinierendsten Organe von höheren Lebewesen und Menschen

bildet das Gehirn. Durch die Funktion dieses Organs ist der Mensch, im

Zusammenspiel mit seinen Sinnen und dem restlichen Körper, in der Lage,

die Welt zu erkennen und zu verändern.

Mit dem Gehirn ist die Betrachtung des Seele verbunden. Vermutete man

im Altertum die Seele des Menschen im Herzen, so weiß man heute, dass die

Seele eines Menschen als Ganzes maßgeblich vom Geschehen im Gehirn mitbestimmt wird. Die Suche nach dem Verständnis des Aufbaus, der Funktion

und der Wirkungsweise des Gehirns hat viele Forschergenerationen auf den

verschiedensten Gebieten beflügelt. Es hat und gibt viele Modelle von diesem

Objekt, die zum Teil auch wieder verworfen werden mussten. Die Vorstellungen über das Gehirn sind sehr komplex, in manchen Details existieren auch

gegensätzliche Ansichten. Viele der neusten Erkenntnisse sind erst durch den

Einsatz von modernen Technologien möglich geworden. Dabei tauchten auch

wieder neue Frage auf. Die neusten Erkenntnisse über das Gehirn - und das

menschliche Gehirn im Speziellen - resultieren aus Forschungsbereichen, welche augenscheinlich nicht unbedingt im Zusammenhang stehen.

Neben dem Gehirn, als einem Forschungsgegenstand, gab und gibt es Bemühungen dieses Gebilde nachzubilden oder dessen Fähigkeiten künstlich zu erzeugen. Schon immer sind die Menschen von den Vorstellungen über das Denken

und von der Realisierung künstlicher Wesen fasziniert. Die Methoden und

Verfahren von sogenannten Künstlichen Neuronalen Netze (KNN) sind den

allgemeinen Prinzipien der biologischen Intelligenz nachempfunden und man

1

2

KAPITEL 1. EINFÜHRUNG

nutzt diesen Sachverhalt auf einem Computer aus. Dabei bilden die Neuronen, als die Grundzellen der biologischen Informationsverarbeitung, und

deren hochgradige Vernetzung in den Hirnbereichen die Grundlage für solche

Modelle. Dabei ergibt sich eine Synthese, denn es werden durch diese Modelle

die Prinzipien der Intelligenz vestanden und andererseits angewendet.

Einen ersten Einstieg in das Gebiet der KNN, welches im Laufe der Zeit

sehr umfangreich geworden ist, sollte mit einer kurzen Darstellung der Entwicklungen über die Vorstellungen zu dieser Thema beginnen. Aus und über

die Geschichte der KNN ist die Anwendung, das Zusammenspiel und die

Beeinflussung von verschiedenen Wissenschaften (vgl. auch Abbildung 1.3)

deutlich zu erkennen. Natürlich können in dieser kurzen historischen Übersicht nur einige Konzepte benannt werden, wobei einige in den nachfolgenden Kapiteln weiter vertieft werden. Außerdem unterliegen die KNN einer

ständigen und rasanten Entwicklung, auch gerade weil sie stark interdisziplinär arbeiten. Übersichten, welche das Thema besser verdeutlichen findet

man in der Fachliteratur, einen kleiner Querschnitt ist im Literaturverzeichnis ab der S.131 zu finden.

Die Erforschung der Fakten der Umwelt und die Phantasie von Vorstellungen

legten letztlich den Grundstein zur Entwicklung der Wissenschaften. Schon

seit den fühen Tagen der Meschheit wurde nach dem Verständnis des Denkens und des Begreifen gesucht. Die Erkenntnisse der griechischen Philosophie (s.a. [KROENER91]), welche zum Kern und dem Ursprung der heutigen

modernen westlichen Denkvorstellungen zählen, sind der Ausgangspunkt für

viele dieser Ideen. Sokrates, Plato, Aristoteles u.a., sie sprachen natürlich

nicht von KNN, sondern eher von Automaten. Mit diesen Automaten sollten Leistungen des Menschen verstanden, verbessert oder verstärkt werden.

Letztlich sind KNN nichts anderes als abstrakte Automaten, welche Denkbzw. Lernvorgänge auf einem Computer nachbilden. In der Antike baute zum

Beispiel Heron hydraulische Automaten in der Form von sich selbstständig,

bewegenden Tempelanlagen oder Archimedes nutzte seine Kenntnisse über

mathematische Zusammenhänge nicht nur zum Bau von Kriegsmaschinen

bei der Verteidigung seinen Heimatstadt Syrakrus. Natürlich waren diese

Ansätze noch nicht unmittelbar mit Vorgängen im menschlichen Gehirn1

verknüpft und diese Maschinen hatten keine Fähigkeit sich veränderten Bedingungen anzupassen.

Neben diesen ersten wissenschaftlichen Ansätzen gibt es in vielen Völkern

Erzählungen, Sagen oder Märchen von künstlichen Wesen oder Kreaturen,

im Guten und im Bösen, die eine Sehnsucht ausdrücken, den Menschen als

1

Sondern gingen z.T. von diesem aus.

1.1. FRÜHE VORSTELLUNGEN UND AUTOMATEN

3

einen Schöpfer (Demirugen) zu sehen. Exemplarisch seien hier nur an die

Geschichten über den Golem und den Homunkulus erinnert. Im 19. Jahrhundert erregten die Geschichten von mechanischen Puppen2 viel Aufsehen.

Der Roman über Dr. Frankenstein3 oder über Roboter4 haben auch in der

Gegenwart viele Entwickler und Forscher und andere Menschen motiviert.

Im 18. Jahrhundert kam es zu einer Blüte von mechanischen Automaten. Es

wurden Maschinen zum automatischen Abspielen von Musik und und zum

Schachspielen entwickelt und gebaut. Die Abbildung 1.1a zeigt die mechanische Ente von Vaucanson. Diese Maschine geht auch auf den mechanistischen Ansatz von La Mettrie ([LaMetterie88]) zurück. Dieser meinte die

a)

b)

Abbildung 1.1: Beispiele für historische Maschinen sind a) die Ente von Vaucanson oder b) die Pascalin, eine Rechenmaschine von Blaise Pascal.

Automaten müssten nur verfeinert werden müssten, um die Fähigkeiten von

Menschen zu erreichen. Das Verständnis des Automaten als das mechanische Bild (besser Modell ) galt als der Schlüssel, dass ein Mensch eines Tages

nachgebaut werden könne. Neben dem Ansatz eines Menschen als Automaten gab5 es die Verwendung von Maschinen und Automaten zum Ersatz

oder der Verbesserung von bestimmten Fähigkeiten und Fertigkeiten. Blaise Pascal und Carl Friedrich Gauß bauten erste Rechenmaschinen, vgl.

Abbildung 1.1b, die die Kompliziertheit von Rechnungen vereinfachen sollten. Automaten oder Maschinen sollten intellektuelle Leistungen vollbringen.

Dieses zunächst mechanistische Denken hatte ihre Ursache in den damaligen

2

Hugo v. Hoffmansthal oder E.T.A Hoffmann

Mary Shelly,FRANKENSTEIN or The Modern Prometheus, Könemann Verlagsgesellschaft, Köln, 1995

4

Karel Capek, R.U.R. oder Isaac Asimov’s Roboter-Erzählungen

5

und gibt

3

4

KAPITEL 1. EINFÜHRUNG

Stand der Erkenntnisse der Wissenschaft, basierend auf deren Erkenntnissen,

z.B. von Isaac Newton über die Schwerkraft und von Galileo Galilei zur

Schiefen Ebene usw. Auch in der Mathematik unterstützte diesen Ansatz

ducrh die Enwicklung der Aussagelogik von George Boole, welcher sie als

“Denkgesetze” verstand. Charles Babbage legte dann die ersten Grundlagen für die Entwicklung von Automaten, welche wir heute als Computer

kennen6 . Aber auch diese Ansätze kamen nicht zur irgendeiner Form der Anpassung und Komplexität, welche dem Menschen und den Tieren eigen ist.

Sie blieben letztlich Spielereien.

Die ersten Ansätze zum Verständnis des Gehirns ergaben sich aus den Erkenntnissen zur Anpassung und Rückkopplung. Bei den Maschinen war dies

der Regler von J. Watt an den Dampfmaschinen und die damit verbundene Verbesserung der dazu gehörigen Technologie. Sie wurde damit zu einem

der Ausgangspunkte für die Grundlage der heutigen industriellen Massenproduktion7 . Mit den zunehmenden und neuen Erkenntnissen aus der Wissenschaften vertiefte und festigte sich die Vorstellung, dass der Mensch nach

Naturgesetzen funktioniere. Mit dem Zuwachs an Wissen, z.B. in der Medizin und in den sich bildenden Vertiefungsfachrichtungen - wie Anatomie,

Neurologie usw. -, wurde der Mensch als ein komplexes Gebilde begriffen,

man erkannte Prozesse von Ursache und Wirkung im Körper8 .

Das 19. Jahrhundert brachte ebenfalls auf vielen Gebieten große Fortschritte.

Man fand heraus, dass das Gehirn eine Steuerzentrale für die Vorgänge in einem lebendigen biologischen System ist. Weiterhin erkannte man das die Entwicklung dieses Organs von dem Informationsverarbeitungsprozess abhängig

ist. Man determinierte das Gehirn als Objekt9 zur Informationsverarbeitung,

indem man gewisse mentale Fähigkeiten bestimmten Regionen10 zuordnete.

Man erkannte ebenfalls, das diese Signale von einer gewissen Stärke sein

mussten. Mit den Erkenntnissen zu Reflexen und Elektrizität wurde das Interesse am Gehirn immer stärker. Die Fakten wurden in Modellen interpretiert und nachvollzogen, aber KNN nach heutigen Maßstäben waren es noch

nicht. Eine gute Übersicht zu den verschiedenen Ideen und die Entwicklungen

der Hirnforschung kann man in einem Beitrag von [SpdWGuG/I/II] nachlesen. Der Zusammenhang zwischen philosohischen Gedanken und der Idee

von künstlichen Wesen kann man auch in [DIETZ03] nachlesen.

6

Vgl. [GEB88]

Erste industrielle Revolution: Dampfmaschine und Eisenbahn

8

z.B. Blut, Körpertemperatur

9

und Subjekt

10

Schädellehre von Gall

7

1.2. NEURONEN, INFORMATIONEN UND KNN

1.2

5

Neuronen, Informationen und KNN

In den ersten Jahren des 20. Jahrhunderts wurden die Neuronen bzw. die

Nervenzellen von Ramón y Cajal und Camillo Golgi (vgl. Kapitel 2)

als die Grundzellen eines Gehirns bestimmt. Man erkannte, das sich diese

Zellen auf die Informationsverarbeitung spezialisiert hatten. Durch die Erkenntnisse über die Aktionspotentiale um das Jahr 1914, sowie die ständige

Analyse durch den Einsatz immer modernerer Verfahren (z.B. bildgebende

Verfahren ab den siebziger Jahren des 20. Jahrhunderts, vgl. Kapitel 2.3 auf

Seite 23) erhilt man eine immer bessere Vorstellung über diese Zellen. Das

Verhalten von Neuronen konnte und kann mit dem Wissen aus der Physik

zum Ladungstransport von Teilchen oder aus der Chemie über Ionenkonzentrationen, basierend auf den Erkenntnissen zur physikalischen Chemie von

Walther Nernst, beschrieben werden. Über die Ionenbewegung in und aus

den Nervenzellen und das Verhalten bei unterschiedlichen Leitfähigkeit basieren die Arbeiten von Hodgkin und Huxley, für die sie letztlich 1963 auch

mit dem Nobelpreis gewürdigt wurde.

Die Aktionspotentiale bilden sich, wenn ein Ladungsaustausch zwischen der

Nervenzelle und der Umgebung stattfindet. Überschreitet der Ladungstransfer einen Schwellenwert, so bildet sich ein Potential und es wird in der Neurone weitergeleitet. Neuronen besitzen häufig einen gleichförmigen Aufbau.

An eigentlichen Zellkörper befinden sich die Dendriten und ein Axon. An den

Dendriten übernimmt eine Neurone mittels der Synapsen die Signale einer

anderen Neurone von deren Axonende. Die Potentiale sind die Träger von

Informatioen in dem System der Neurone. Details zu dem Aufbau und der

Funktion von Neuronen werden im Kapitel 3 auf Seite 27 behandelt. Die Erkenntnisse zu den Neuronen führten zu der Einsicht, dass diese Zellen über

ihre vielfachen Verbindungen wie hochgradige parallele Systeme arbeiten.

Die Zusammenfassung von Neuronen zu Gruppen11 determiniert bestimmte

Bereiche, die wichtig für die Verhaltensweise von Lebewesen sind, fördern die

Betrachtung dieser Bereiche im Rahmen der Modellbildung als dynamische

Systeme12 .

Eccles13 untersuchte die Informationsverarbeitung, d.h. der Signalaustausch,

an den Synapsen. Er beschreibt diese Systeme mit Hilfe von elektronischen

Schaltungen, vgl. Abbildung 1.2, als Übertragungssysteme. Damit hatte man

die Funktion der Neuronen zwar erkannt, aber man konnte noch nicht im

Detail deren Zusammenwirken erklären. Mit Hilfe von Physik und Chemie

11

Nuclei, Ganglien

Vgl. nachfolgende Kapitel

13

Vgl. [ECCLES00] und [ECCLES99]

12

6

KAPITEL 1. EINFÜHRUNG

+

R ~1,2M Ω

−

U ~70mV

C ~ 3pF

RC−Modell eines Neurons

Abbildung 1.2: Modellvorstellung des Aktionspotentials einer Neurone, mehr

im Kapitel 3, ab Seite 35.

konnte das physikalische Verständnis des Wirkens vertieft werden, aber der

Zusammenhang zwischen dem Verstehen durch das Gehirn und der Aktion

am Neuron war und ist z.T. noch offen. Diese Erkenntnisse sollten auch durch

geeignete Computersimulationen gewonnen werden.

Mit der zunehmenden Erforschung von Gehirn und Neuronen, sowie den Fortschritten auf anderen Gebieten der Wissenschaften hat die Modellbildung zur

Beschreibung und dem Verstehen des Gehirns zugenommen. Jetzt kommt es

an diesem Punkt zu einem interessanten Aspekt, einerseits entwickelt man

KNN-Modelle um die Funktion und das Verhalten besser zu verstehen und

andererseits eignen sich diese Modelle in einer abstrakten Form für Anwendungen zur Lösung von Problemen14 . In der Gegenwart kommen neben den

anderen Wissenschaften auch noch die Mathematik und die Computerwissenschaften immer mehr zur Anwendung. Grundlage sind die Vorstellungen,

dass die internen Vorgänge und Funktionen in einem Gehirn oder einem realen Neuronenensemble ein internes Bild der äußeren Welt ergeben. Dies gilt

auch für die KNN.

Mit der Berücksichtigung der Rückkopplungen, die man durch entsprechende dynamische Systeme beschreiben kann, kann man ein Gehirn zu einem

Rechner abstrahieren. Ausgehend von der Vorstellung einer Turing-Maschine

entwickelten McCulloch und Pitt 1943 ein Modell einer Neurone, mehr im

Kapitel 6.1 auf Seite 97, als ein Verarbeitungselement. Die Grundidee ist,

14

Vgl. auch Kapitel 8 und ??

1.2. KNN

7

dass die Vorstellungen über die Außenwelt über die Sensoren zu den Neuronen gelangen und dort entsprechende Wahrheitswerte generieren. Mit diesem

Modell konnten sich die logischen Verknüpfungen, wie ODER, NICHT oder

UND, realisieren lassen. Dieses Modell der Vorstellungen der Informationsverarbeitung über die Außenwelt in den Neuronen bildete eine der wichtigsten

Grundlagen bzw. gab Ansätze zu den Beschreibungen in der Neurophysiologie15 . Jetzt konnte man die Vorstellungen in einem Gehirn determinieren,

aber für die Anpassung an Veränderungen blieben noch Fragen offen.

Die Erkenntnis von Donald Hebb, 1949, das sich in einem Neuronenverbund die Verbindungen verstärkten, welche besonders häufig aktiviert wurden, führte zu einer ersten Erklärung von Lernfähigkeit und Anpassung im

Gehirn, bzw. in bestimmten Hirnregionen. Die Stärke bzw. die Veränderung

einer Verbindung ist als eine Basis in vielen Lernstrategien enthalten16 . Durch

die Übernahme der Lernfähigkeit konnten jetzt auch Veränderungen berücksichtigt werden. Bevor man diese Systeme auf einem Rechner implementierte17 , wurden die Erkenntnisse in Algorithmen (z.B. Filter) oder Analogrechnern18 realisiert. Im Jahr 1958 stellte Rosenblatt ein neues Modell für Neuronen, das Perzeptron (s. Kapitel 6.2 auf Seite 97), vor. Das Lernverfahren

des Perzeptrons basierte auf der Korrektur von Fehlern bzw. Differenzen

zwischen Soll und Ist. Die Formulierung der Ansätze durch McCulloch und

Pitt, Rosenblatt und Hebb kennzeichnen einen wichtigen Ausgangspunkt

für die Betrachtung und die Erforschung der KNN.

Mit der Annahme von linearen Funktionen glaubte man, dass die einfachen

Neuron- und KNN-Modelle viele Probleme lösen könnten. Mit der Adaline

von Widrow und Hoff wurde um 1960 ein ähnliches Modell, wie das Perzeptron, vorgestellt. Hatte das Perzeptron noch seinen Ausgangspunkt in der

Biologie, als ein Modell der Verarbeitung von Informationen auf der Retina

eines Auges, so basierte das Modell des Adline auf der adaptiven Veränderung

von Parametern seiner Regelkreise. Das Lernen in einem einfachen KNN erfolgte unter definierten Bedingungen. Komplexeres Lernverhalten scheiterte,

dies konnten Minsky und Papert in ihrem Werk über das Perzeptron 1969

nachweisen. Dies führte nach einer frühen Euphorie des KNN-Ansatzes zu

einer Ernüchterung. In der Erforschung der Künstlichen Intelligenz wurde der

Top-Down-Ansatz für Jahre dominierend. Man glaubte, dass sich die Intelligenz über Regeln definieren19 und darstellen konnte. Die KNN traten in den

15

Arbeiten von Hubel und Wiesel

Vergleiche Lernen mit Neuronen in den Kapitel 5 und 7

17

In den 50-er Jahren des 20. Jahrhunderts waren Computer noch nicht allgegenwärtig.

18

Rechner, die z.T. nicht mit dem Binärsystem laufen.

19

Expertensysteme

16

8

KAPITEL 1. EINFÜHRUNG

60-er und frühen 70-er Jahren des letzten Jahrhunderts in den Hintergrund.

Andere Naturwissenschaften

Vorstellungen

MATHEMATIK

Golem, Homunkulus, Frankenstein

Gehirn/Neuron

Gehirn als Steuerzentrale

Neuron als Grundzelle/Schaltelement

Ramon y Cajal/Camillo Golgi

Neuronen im Verbund

Neurologie

Automaten/Roboter

Ionenaustausch, Aktivierung,

Neurotransmitter

Dynamische Systeme

Funktionen in Gehirnbereichen

als

Erklärung

Neuronale Netze und

Modell

Neuronale Netze als Modell

KNN−Lernverfahren

Neuronenmodelle Neuronale Netze als Künstliche Neuronale Netze (KNN)

McCulloch−Pitt

Perzeptron

Adaline

Komplexität

Einschichtige Netze

Mehrschichtige Netze

Gehirn als Computer

PHYSIK BIOLOGIE CHEMIE INFORMATIK

Zeit

Wissen

Abbildung 1.3: Historische Vorstellungen zu den KNN in einer Übersicht.

Eine neue Blüte der KNN begann in den letzten 25 Jahren des 20. Jahrhunderts. So wurden 1976 von Grossberg und 1982 von Kohonen Modelle der

Selbstorganisation bei einem Lernen ohne Lehrer eingeführt. Einfluss hatte

auch die Übertragung des Spinmodells von Magneten auf die KNN durch

Kohonen, ebenfalls 1982. Mit der Übernahme von nichtlinearen Funktionen

bei der Systembeschreibung und die zunehmende hohe Verfügbarkeit von

Rechentechnik halfen mit die Probleme bei den einfachen Netzen zu überwinden.

Die Betrachtung des Gehirns als Dynamisches System und die Dynamik

durch eine neuronale Selektion durch Gerald M. Edelmann20 , der dies auch

mit Hilfe von entsprechenden Computermodellen untermauerte, befruchtete

die KNN. Mit der PDP-Initiative (Parallel Distributed Processing)

von Rumelhart und McClelland wurden die KNN auch als Anwendungen interessant. Man hatte Modelle um die Vorgänge im Gehirn besser zu

20

vgl. [EDEL93] und [EDEL95]

1.3. MOTIVATION UND KAPITELÜBERSICHT

9

verstehen und man konnte die gleichen Modelle weiter abstrahieren, um aus

ihnen Anwendungen zu gewinnen, die auf einem Computer laufen. Klassifizierung oder Bilderkennung seien hier nur als Beispiel angeführt. Die Erkenntnis, dass die Neuronen in einem Gehirn nicht als einzelne Baugruppe

auftreten, sondern durch ihre hochgradig parallelen Verbindungen die Wirkung der Steuerung realisieren, determinierten eine dezentrale und verteilte

Informationsverarbeitung. Entsprechend musste die Adaption auf einem sequentiellen Rechner sein, man nutzt letztlich den Speicherplatz und die zunehmenden Rechengeschwindigkeiten. Verteilte Darstellung von Information

und nicht explizite Adressierung bilden eine Mikrostruktur für Prozesse wie

Lernen und Anpassung.

Mit den PDP-Modellen, auf welche auch hier ab dem Kapitel 5 Bezug genommen wird, hat sich die Entwicklung der KNN massiv beschleunigt. Eine

Generalogie würde Bände füllen, deshalb sollen jetzt in den nachfolgenden

Kapiteln einige der Grundprinzipien näher erläutert werden. Ausgangspunkt

ist das Gehirn, vor allem die Funktion der Neuronen, gekoppelt mit der entsprechenden Modellbildung.

1.3

Motivation und Kapitelübersicht

In diesem Buch geht es nicht um die Hirnforschung in seinen Aspekten, hierzu gibt es weiterführende und vertiefende Literatur21 (vgl. auch Literaturhinweise auf S. 131). Mit der Erforschung des Gehirns – als einem Ort oder

als einer Struktur –, wo Verstehen und Begreifen stattfindet, sind auch die

Versuche einer automatischen bzw. künstlichen Nachbildung dieses Objekts

verbunden.

Mit den Methoden und Verfahren der Nachbildung von Neuronalen Netzen,

besser Künstliche Neuronale Netze (KNN), möchte man die allgemeinen

Prinzipien der biologischen Intelligenz auf einem Computer nutzen. Dabei

sind die Abstraktionen von Neuronen als den Basiszellen und deren hochgradige Vernetzung in den Hirnbereichen die Grundlage für diese Modelle. Dabei

ergibt sich eine Synthese, denn es werden durch die Modelle die Prinzipien

der Intelligenz vestanden und andererseits angewendet. Doch erst ein hohes

Technologieniveau und die universelle Verfügbarkeit von Rechentechnik machen Simulationen solcher KNNs möglich, deren Resultate letztlich auch in

einer separaten Anwendung sinnvoll sein können. Abbildung 1.4 zeigt eine

nicht ganz ernst gemeinte Karikatur zu diesem Thema

21

speziell [EDEL93], [THOMPSON94], [SINAUER92] oder [EDEL02]

10

KAPITEL 1. EINFÜHRUNG

Abbildung 1.4: Motivation Künstliche Neuronale Netze und Computer.

Zu Beginn werden einige der biologischen Grundlagen, die für die Beschäftigung mit den KNN nötig sind, behandelt. Im Kapitel 2 wird das menschliche

Nervensystem und dessen Anatomie erläutert. Dabei werden einige Zusammenhänge zwischen den verschiedenen Betrachtungsweisen des Gehirns als

System und den KNN hergestellt. Anschließend werden kurz die biologischen

Grundlagen angedeutet und einige der Verfahren vorgestellt, welche bei der

Erforschung des Gehirns verwendet derden. Das Kapitel 3 behandelt in einer

kurzen Übersicht den Aufbau und die Wirkungsweise von biologischen Neuronen. Im Mittelpunkt steht der Informationsfluss, denn dieses Vorbild der

biologischen Informationsverarbeitung ist eine der Grundlagen für die Konzeption von KNN. Die Umsetzung von neuronalen, d.h. letztlich künstlichen

neuronalen, Strukturen wird bei Bilderkennugssystemen oder Roboterrealisierungen anders sein als bei den biologischen Vorbildern.

Der Übergang von den biologischen Modellen der Gehirnstrukturen und Neuronen zu denen, welche auf einen Rechner implementierbare KNN ergeben,

sind der Inhalt des des Kapitel 4. Im diesem werden einige Vorstellungen zur

Modellbildung und zu den benötigten Hilfsmitteln erklärt.

Im Kapitel 5 werden die allgemeinen Grundlagen von KNN eingeführt. Neben der Schichtenbetrachtung, der Zustandsbeschreibung und dem Lernen

werden das Modell von McCulloch und Pitts, das Perzeptron sowie das

Adaline beschrieben. An diesen historischen Modellen werden die allgmeinen

Grundlagen, wie z.B. die Möglichkeiten der Verbindung von Neuronen, eingegangen. Ebenfalls wird eines der wichtigsten Merkmale, die Lernfähigkeit,

der KNN eingeführt.

Lft. Stand. 13. September 2004, Änderungen möglich

1.3. ÜBERSICHT

11

⇓

Weitere Merkmale und prinzipielle Strukturen von KNN werden im Kapitel 7 behandelt. Anschließend wird die Wirkungsweise der KNN und deren

Dynamik von KNN erläutert. Dabei wird die mathematische Grundlage auf

der Basis der zu verarbeiteten Informationen kurz beschrieben. Auf dieser

Basis werden auch die Kriterien für eine objekt-orientierte Programmierung

abgeleitet.

Robotik und Künstliche Neuronale Netze sind Modelle der menschlichen Informationsverarbeitung, aber auch der Versuch einer technologischen Weiterentwicklung. Konkretisiert werden die KNN hier bei Anwendungen in der

Bildverarbeitung und Klassifizierung.

Ab dem Kapitel ?? beginnt der Anhang. Im Abschitt B sind wichtige vBegiffe diese Buches noch mal in Kurzform erläutert. In den Abschnitten C

und D sind die hier am häufigsten verwendeten mathematischen Symbole und

Abkürzungen zusammengefaßt. Im Kapitel D findet man ab der Seite 131 das

Literaturverzeichnis zur Vertiefung der hier angerissenen Themen.

12

KAPITEL 1. EINFÜHRUNG

Kapitel 2

Das Gehirn

2.1

Die Anatomie des Nervensystems

Der Begriff Gehirn ist für dieses Organ eigentlich ein Oberbegriff, welcher

ein vielseitiges Ensemble aus mehreren komplexen Strukturen aus sehr vielen

einzelnen Zellen, genannt Neuronen (vgl. Kapitel 3), bezeichnet. In diesem

Abschnitt sollen einige der wichtigsten Bereiche eines menschlichen Gehirns

benannt werden.

Das Gehirn, vgl. Abbildung 2.1, bildet zusammen mit dem Rückenmark,

welches im Bild nur als Ansatz zu sehen ist, das Zentralnervensystem (ZNS)

des Menschen. Das ZNS hat die Aufgabe der Informationsverarbeitung. Die

Informatioen entstehen durch oder über die Sensoren (z.B. die Haut oder die

Zunge), bei der Bildung von Stoffen in den exokrinen und endokrinen1 Drüsen

(z.B. Schweißdrüsen, Hypophyse) oder bei der Kommunikation von einzelnen

Hirnabschnitte. Der Emfang, die Sendung und Speicherung der Information

ist natürlich nicht direkt mit der Informationsverarbeitung in einem Rechner

vergleichbar. Dort kann lediglich eine Abstraktion dieser Prozesse stattfinden.

Das Groß- oder Endhirn (Cerebrum, Telencephalon) und das Kleinhirn (Cerebellum) überlagern den Hirnstamm (Medulla oblongata und Pons). Am Ende

des Hirnstammes findet man das Mittelhirn (Mesencephalon). Der Thalamus, sowie der Hypothalamus und die Großhirnrinde (Cortex cerebri) liegen

über dem Hirnstamm. Die Großhirnrinde ist in zwei Hälften geteilt, diese

werden Hemisphären genannt. Das Mittelhirn (Mesencephalon) schließt sich

dem Rückenmark als Fortsetzung an. Das Rückenmark ist Nervengewebe

in Längsform, welches durch die Wirbelsäule gestützt und geschützt wird.

1

vgl. Erklärung von Begriffen ab Seite 123.

13

14

KAPITEL 2. DAS GEHIRN

Cortex cerebri

(rechte und linke Großhirnrinde)

Zentralfurche

Gyrus

(Windung in der Hirnrinde)

Mesencephalon

(Mittelhirn)

Amygdala

Thalamus

Hippocampus

Cerebellum

Hypothalamus

Hypophyse

(Kleinhirn)

Pons und Medulla oblongata

(Hirnstamm)

Rückenmark

Abbildung 2.1: Eine schematische Darstellung eines menschlichen Gehirns,

mit der Bezeichnung einiger wichtiger Bereiche. Abbildung ähnlich der Darstellung in [THOMPSON94] auf S. 23

2.1. ANATOMIE

15

Gebündelte Fasern außerhalb des ZNS nennt man Nerven, im Unterschied

zu den Nervenbahnen, die sich im Inneren des ZNS befinden.

Im Rückenmark erfolgen Reflexe auf die Funktionen von Muskeln und auf

autonome Reaktionen bei körperlichen Reizen (spinale Reflexe). Aktivitäten,

welche über das Rückenmark laufen und die das Gehirn mit einbeziehen nennt

man supraspinale Aktivitäten. Die Informationen, die die Körperbewegungen

koordinieren, werden über das Rückenmark zu den Neuronen2 , die dann mit

den Muskeln verbunden sind, geleitet. In der Gegenrichtung werden viele

Wahrnehmungen der Sinne (hauptsächlich Tastreize) durch das Rückenmark

zum Gehirn gesendet. Im Bereich des Kopfes erfolgt die sensorische und motorische Anbindung (vgl. Gehör und Auge) direkt.

Der Hirnstamm (Medulla oblongata und Pons) enthält auf- und absteigenden

Nervenfasern und bildet somit eine Fortsetzung des Rückenmarks. In diesem

Bereich werden wichtige Funktionen, wie die Atmung, der Herzschlag und

andere unbewusste Aktionen, gesteuert. Es handelt sich um Nervenbahnen,

deren Struktur in Zusammenhang mit den autonomen Nerven steht. Diese

Art der Nervenbahnen hat Verbindung zu den autonomen Funktionen (Prozesse, die im Körper als Folge von Wechselwirkungen ablaufen, wie z.B. bei

Emotionen) und den bestimmenden Funktionen (z.B. Verdauung, Herztätigkeit oder Atmung). Man nennt es auch das vegetative Nervensystem.

Das Mittelhirn (Mesencephalon) geht von einer kabelbaumartigen Struktur

des Rückenmarks in die kompaktere Schichtenstruktur des Thalamus sowie

des Hypothalamus über. Im oberen Bereich des Mittelhirns findet man Zellenansammlungen für das Hör- und Sehsystem. Im unteren Teil werden die

Augenbewegungen gesteuert und auch die Kontrolle der tiefer gelegenen Hirnabschnitte erfolgt hier. Außerdem findet man hier Strukturen (der Rote Kern

(Nucleus ruber) und stark pigmentierte Zellen (Substantia nigra)), welche für

die Bewegungskontrolle mit verantwortlich sind.

Das Rückenmark, der Hirnstamm und das Mittelhirn bilden aus der Sicht der

Evolution die ältesten Teile des ZNS. Sie sind hintereinander angeordnet. Da

sie wichtige Vitalfunktionen kontrollieren und steuern, ist dies verständlich.

Im Laufe der Entwicklung waren und sind diese Funktionen zum Überleben

notwendig. Dies ist auch der Grund, dass die Organisation und die Struktur

dieser Hirnbereiche sich bei vielen Lebewesen, vor allem Säugetiere, ähnlich gestaltet ist. Das Kleinhirn (Cerebellum) ist ebenfalls eines der älteren

Resultate der Evolution. Es ist verantwortlich für die sensomotorische Koordination. Ähnlich der Großhirnrinde bilden die Neuronen hier eine wenige

2

Die Kommunikation zwischen Rückenmark, Hirn und Muskel ist natürlich komplexer,

als hier angedeutet.

16

KAPITEL 2. DAS GEHIRN

Millimeter dicke Oberflächenschicht. Die Eingaben zum Kleinhirn kommen

vom Gleichgewichtssystem der Ohren (Vestibularsystem), den sensorischen

Fasern des Rückenmarks, vom Sehsystem und von verschiedenen Bereichen

der Großhirnrinde und des Hirnstamms.

Den Thalamus findet man über und vor dem Mittelhirn. Er besteht aus je

zwei ovalen Strukturen, eine innerhalb der jeweiligen Großhirnhälfte. Der

Thalamus bildet einen Relaisknoten für das Seh-, Hör- und sensomotorische

System. Er umfasst auch Strukturen, welche wieder auf andere Bereiche (z.B.

den Cortex) projizieren und diese können dann Eingaben des Großhirns verarbeiten. Der Hypothalamus liegt in der unteren Hälfte des Gehirns im Bereich

des Zusammentreffens von Mittelhirn und Thalamus. Nachbar des Hypothalamus ist die Hirnanhangdrüse (Hypophyse). Diese wird von dem Thalamus

gesteuert. Es werden damit Körperfunktionen, die z.B. bei den Emotionen

auftreten, geregelt. Die Steuerung der Hormone im Körper wird von dem System Hypothalamus und Hypophyse koordiniert. Die chemische Zusammensetzung der Hormone bilden einen Regelkreis, mit dem auch andere Hirnbereiche

beeinflusst werden.

Die Großhirnrinde (Cortex cerebri) ist die jüngste Struktur, der sich beim

Menschen im Laufe der Evolution herausgebildet hat. Sie besitzt eine relativ

große Ausdehnung und ist bei Säugetieren, besonders beim Menschen, ein

äußerlich sehr dominierenter Bereich. Er fällt durch seine Faltung und Windungen (Gyrus) auf, es befinden sich die Kontrollzentren für die Sprache,

das Erkennen der Umwelt und das Denk- und Vorstellungsvermögen. Die

Großhirnrinde bildet sich über die jeweiligen Hirnhälften aus und ist mittels

Balken (Corpus callosum) miteinander verbunden. Der Cortex ist die oberste Neuronenschicht im Gehirn. Sie bildet eine rund drei Millimeter starke

Schicht über das ganze Gehirn. Bei einem Schnitt durch den Cortex zeigt

sich eine schichtenähnliche Struktur der Anordnung der Neuronenzellen.

Die Oberfläche der Großhirnrinde und diese Neuronenbereiche lassen sich in

bestimmte Regionen unterteilen. Die Darstellung solcher Regionen ist in dieser Abhandlung in den Abbildungen 2.4 auf Seite 19 und 2.4 auf Seite 19 zu

erkennen. In der Fachliteratur3 werden weitere Details und Zusammenhänge

für das ZNS und die einzelnen Bereiche genauer erläutert. Das vollständigen

Verstehen des Cortex cerebri, überhaupt des Gehirns, steht für die Wissenschaften trotz großer Erfolge erst am Anfang.

Grundlage der Funktion des Gehirns sind die bereits mehrfach erwähnten

Neuronen als eine Art elementare Bausteine. Abbildung 2.2 auf der nächsten

3

z.B.in [EDEL93], [EDEL95], [THOMPSON94], [CHURCHLAND97] oder [ROTH03]

u. v. a. m.

2.1. ANATOMIE

17

Seite zeigt ein Modell einer einfachen Neurone. Die Information empfängt

eine Neurone über die Dendriten und den Zellkörper (Soma). Weitergeleitet

wird die Information über das Axon. Das Ende des Axon verzweigt sich und

endet in den Synapsen. Eine Synapse ist die Verbindung zu anderen Neuronen oder zu den entsprechenden Muskel- oder Drüsenzellen. Eine genauere

Beschreibung der Funktion einer Neurone, die Behandlung des Informationsflusses, sowie die Abbleitung von Modellen bilden den Inhalt des folgenden

Kapitels.

Dendriten

Soma

(Zellkörper)

Axone

Synapsen eine Folgeneurone

Zellkern

Myelin

Abbildung 2.2: Skizze einer einfachen Neurone mit den wichtigsten Bezeichnungen

Über die Simulation von Neuronen und mit den Mitteln der KNN lassen sich

einige Funktionen des Gehirns nachgebilden, also sollte man einiges über den

Aufbau des Gehirns verstehen. Dieser ist aber nicht immer offensichtlich und

es treten auch widersprüchliche Theorien auf. Manche Funktionsbeschreibungen des menschlichen Gehirns ähneln manchmal denen von Computern. Die

Beschreibung der Funktionen des Gehirns auf der Grundlage der Informationstechnik ist ein Ausdruck des Verstehens des Hirns als eine Analogie zu

einem informationsverarbeitenden System.

18

KAPITEL 2. DAS GEHIRN

2.2

Das Gehirn als System

2.2.1

Gehirn und Körper

Um das Gehirn als System zu verstehen, betrachtet man die Wechselwirkungen zwischem dem Gehirn und dem Körper. Das Gehirn bildet eine Art

Steuerzentrale des Körpers und tritt mit den anderen Organen und Bereichen, z.B. über die Sensoren und die Motorik, in Wechselwirkung. Dieses,

natürlich extrem vereinfachte, Bild hat Bezüge zu einer Darstellung eines

Gehirns als eine Computer, der den Körper steuert. Analog gilt dies auch für

Robotermodelle, dort übernimmt die Software des Computers die Steuerung

der sensorischen Einheiten und des Roboterkörpers.

Reale Welt, Umwelt, Natur, ...

Körper

Sensorik/Motorik

(Transduktorzellen, Muskeln)

Gehirn/Neuronale Netze

Abbild der Realen Welt,

Umwelt, Natur, ...

Informationsfluß

Abbildung 2.3: Erstes Modell einer Informationsverarbeitung in einem Gehirn.

Ein Körper nimmt Informationen wahr, reagiert auf diese Informationen mit

der Verarbeitung im Gehirn, und der Körper reagiert mit der Motorik (vgl.

Abbildung 2.3). Diese Gesamtsystem enthält die, noch zu besprechenden,

Einheiten für eine Informationsverarbeitung. Die Interaktion mit der umgebenden Welt erfasst immer bestimmte Bereiche des Gehirns. Ein Nervensystem bzw. Gehirn empfängt Informationen durch eine Vielzahl von Sensoren,

wie Licht (Auge), Schall (Ohr) oder Druck (Tastsinn der Haut). Die Funktionen eines neuronalen Netzes oder Gehirnbereiches sind abhängig von diesen

Informationen ([EDEL93]).

Man nennt diese Umwandler von Informationen auch Transduktoren. Nach

der Signalwandlung werden über ein Bündel von Nerven, die Nervenfasern,

2.2. DAS GEHIRN ALS SYSTEM

19

a)

b)

Abbildung 2.4: Die beiden Abbildungen zeigen die Segmente und Bereiche in

einem Gehirn bei verschiedenen Funktionen. a) Deutet den Verlauf und die

Bereiche für die Funktion Schmecken, Sehen usw. an und b) kennzeichnet

schematisch einige der Bereiche beim Sprechen und Farbverstehen. Abbildungen modifizert nach [Spektrum92/1].

20

KAPITEL 2. DAS GEHIRN

Informationen zum bzw. vom Gehirn (vgl. auch S. 13) transportiert. Diese

Nerven im Körper werden häufig auch als periphere Nerven bezeichnet. Die

Informationen der Sinne werden auf bestimmte Teile des Gehirns abgebildet.

Die Rindenbereiche (manchmal auch Lappen4 genannt) sind für die Verarbeitung der jeweiligen Sinne verantwortlich.

Die Aufnahme der Informationen der Sinne in den Bereichen des Gehirns erfolgt über die Rezeptorenfelder. Ein Rezeptorfeld ist ein Bereich des Gehirns,

in dem eine Sinnesinformation eine entsprechendende Reaktion bewirkt. Die

Größe und der Umfang ist vom Körper abhängig, so ist z.B. das Rezeptorfeld der Fingerspitzen kleiner als das der Arme. Auch im visuellen Bereich

variieren die Größe der Felder. Die Abbildung 2.4 b zeigt einige der Bereiche

im Gehirn die z.B. bei Sprach- und Farbverstehen aktiv sind.

Die Entwicklung von höheren Lebewesen und die des Menschen hat im Gehirn zu einer Spezialisierung geführt. Beim Stoffwechsel und dem Kreislauf,

den sogenannten vegetaiven Funktionen, sind der Hirnstamm, der Hypothalamus und der Mandelkern (Amygdala) beteiligt. Die Wahrnehmungen unterteilen sich nach dem Sehen, dem Körperempfinden (Haut, Muskeln oder

Gelenke), das Sehsystem, das Gehör, der Geruch und der Geschmack. So sind

die Sinnesorgane für das Gleichgewicht (vestibuläres System) mit dem Organ

des Hörens verknüpft. Vom Innenohr führen Nervenbahnen zum verlängerten

Mark und von dort zu Bereichen im Thalamus und von dort in die vorden

Bereiche der Scheitellappen. Beim visuellen System (dem Sehen) gelangen

Informatione über Felder, zusammengesetzt aus lichtempfindlichen Stäbchen

und Zapfen, auf der Retina (vgl. [CHURCHLAND97]) des Auges. Diese Signale werden man diesen Stäbchen und Zapfen in Potentiale von Neuronen

verwandelt. Diese werden an die Sehkreuzung und von dort in den Thalamus weitergeleitet. Dort aktivieren sie im hinteren Bereich Neuronenfelder, oder neuronale Netzwerke, welche ein Mensch bewusst als Bilder wahrnimmt. Diese bewirken dann über den Hypothalamus oder die Amygdala die

Ausschüttung von Hormonen (z.B. sexuelle Erregung), die ihrerseits wieder

Reaktionen des Körpers (z.B. Schwitzen, Muskelkontraktionen o.ä) bewirken.

In der Abbildung 2.4 a sind einige der beteiligten Bereiche in ihren Abfolge

schematisch dargestellt.

An der Steuerung von Bewegungen, dem motorischen System, sind Kerne

beteiligt, die im Mittelhirn und im verlängerten Mark und dem Rückenmark lokalisiert sind. Sie betreffen die unbewusste Steuerung, wie z.B. die

Lidbewegungen der Augen. Die bewusste Steuerung kommt aus Bereichen

der Großhirnrinde, den hinteren Stirnlappen vor der Zentralfurche. Emo4

lat. Lupus

2.2. DAS GEHIRN ALS SYSTEM

21

tionales Verhalten wird meist mit dem limbischen System verbunden, da die

Drüsen, wie Hypothalamus und Amygdala, als das vegetative System die Produktion von entsprechenden Stoffen veranlassen. Die bisherigen Bereiche des

Gehirn beschäftigten sich mit den lebensnotwendiken Funktionen, die bei

vielen Lebewesen, besonders Säugetieren, anzutreffen sind. In den entwicklungsgeschichtlichen jüngsten Bereichen eines menschlichen Gehirn werden

die komplexeren Funktionen, wie Vorstellungen, Gedächtnis oder das Planen

von Aktionen, realisiert. Assoziationen findet man in der Großhirnrinde, man

nennt sie auch assoziativer Cortex. An Erinnerungen und dem Gedächtnis

ist der Hippocampus beteiligt. Modellbildungen, als Vorstellungem erfolgen

über die Stirnlappen, die in Verbindung zu anderen Bereichen sind, z.b. dem

Hinterhauptlappen. Ausführlichere Details der Funktionen des Gehirns findet man in der Literatur, so in [EDEL93], [ECCLES00], [CHURCHLAND97]

oder in [ROTH03] .

Neben der Eingrenzung der Funktionen eines Gehirn unterscheiden sich auch

die zellularen Bausteine des Gehirns. Die wichtigsen Zellen sind die Neuronen und die Gliazellen5 als Stützzellen der Neuronen. Eine genauere Betrachtung der Neurone wird im Kapitel 3 auf Seite 27 erfolgen. Man unterscheidet bei den Neuronen, im Zusammenhang mit der Sinneswahrnehmung

zwischen sensorischen Neuronen oder Rezeptoren (Sensorneuron) als den Detektoren der Sinne, den motorischen Sensoren (Motoneuron) als den Reaktoren oder Effektoren für die Reaktionen auf Sinneswahrnehmungen. Ferner

gibt es noch die Hauptneuronen und die Zwischenneuronen (Interneuronen).

Die Hauptneuronen sind große Nervenzellen innerhalb der bereits mehrfach

erwähnten Gehirnbereiche, welche mit anderen Bereichen in Verbindung stehen (z.B. Thalamus mit der Sehrinde), wohingegen die Interneuronen den

jeweiligen Bereich nicht überschreiten und als neuronale Netze zwischen den

Sensor- und Moto- oder Haupt-Neuronen vermitteln (vgl. Tabelle 3.1 im Abschnitt 3.2 des Kapitel 3).

2.2.2

Arten der Erfassung von Informationen durch

das Gehirn

Im letzten Abschnitt wurde schon erwähnt, dass die Informationen der Sinne

über eine Vielzahl von Rezeptoren zum Gehirn gelangen und dieses letztlich

agiert. Ähnlich wie bei einem Regelkreis6 übermitteln die Sinne Signale, die

5

Neuere Erkenntnisse messen diesen Gliazellen eine größere Bedeutung bei den

Abläufen zu.

6

Diese Betrachtung ist natürlich sehr vereinfacht!

22

KAPITEL 2. DAS GEHIRN

das Gehirn, also die Neuronen, verarbeiten und letztlich eine Reaktion bewirken. Es hat jeder wahrnehmbare Sinn seine zugehörigen Sensorneuronen

und diese funktionieren auf unterschiedliche Art und Weise. Die Anzahl der

Rezeptoren ist dabei sehr unterschiedlich verteilt.

Obwohl die Haut durch ihre Fläche das größte Sinnesorgan ist, mit der Informationen empfangen werden können, besitzt es nur ca. 3×105 Sensoren

für die Erfassung von Druck, Temperatur oder Schmerz. Die Empfindlichkeit

für taktile Reize ist über die Körperoberfläche unterschiedlich verteilt. Sehr

empfindlich reagieren die Fingerspitzen und die Lippen. Die erfassten Signale

(Reize) werden vom vegetativen und vom motorischen System verarbeitet.

Die meisten Sinnesorgane besitzt der Mensch im visuellen System. Dort befinden sich ca. 2. . . 3×108 Rezeptoren. Diese Sensoren unterteilen sich z.T.

meist in die bereits erwähneten Stäbchen und Zäpfchen auf der Retina. Damit ist ein Mensch in der Lage aus dem Spektrum der elektromagnetischen

Strahlung den Bereich des sichtbaren Lichts von 380. . .760 nm zu erfassen.

Dieser, zugegeben sehr kleine, Abschnitt aus diesem Spektrum bildet aber

einen der wichtigsten Informationsquellen für die Verarbeitung im Sehsystem und beim Zusammenwirken mit den anderen Bereichen. Dieser Bereich

ist auch bereits gut erforscht und die Erkenntnisse werden bei der Modellbildung für die KNN verwendet.

Wesentlich weniger Rezeptoren, nur 3×104 Haarzellen im Cortischen Organ,

steht dem Hörsystem zur Verfügung. Hören kann ein Mensch im Idealfall

Töne bzw. Frequenzen in einem Bereich von 20 Hz. . .20 kHz. Das Schlusslicht bildet das Geschmackssystem mit ca. 3000 Sensoren auf der Zunge. Dies

ist der Grund, warum ein Mensch nur Geschmäcker aus vier Grundarten,

Süß, Sauer, Salzig oder Bitter, identifizieren kann. Bei den Nervenbahnen der

Peripherie unterscheidet man zwischen zuleitenden (afferente) Fasern (auch

sensorische Fasern), welche die Informationen der Rezeptoren der Sensorik

ans Gehirn leiten und ableitenden (efferente) Fasern, sogenannte Motoneuronen (vgl. auch Tabelle 3.1), die Informationen vom Gehirn zum Rezeptor

bzw. die Motorik übertragen, der letztlich eine Reaktion des Körpers bewirkt

(z.B. Muskelkontraktion).

Die Verarbeitung der Sensordaten mittels der Rezeptoren repräsentieren eine Schnittstelle zwischen der Außenwelt und dem Gehirn. Ihre unterschiedliche Anzahl bewirkt eine Wichtung der ankommenden Signale. So ist klar,

dass der Mensch ein Lebewesen ist, welches sehr stark auf optische Reize

reagiert. ¿Ein Bild sagt mehr als tausend WorteÀ ist nicht nur ein geflügeltes Wort, sondern unterstreicht die Wichtigkeit von visuellen Signalen.

Diese Abhandlung ist keine Darstellung von neurologischen und neuroanato-

2.3. WICHTIGE VERFAHREN ZUR UNTERSUCHUNG DES GEHIRNS23

mischen Sachverhalten, für vertiefende Informationen sei auf das Literaturverzeichnis (ab S. 131) verwiesen. In den Literaturübersicht werden Quellen

aufgeführt, die die Details der sensorischen Erfassung, z.B. das Sehsystem

in [CHURCHLAND97] oder die Motorik in [EDEL93], genauer beschreiben.

2.3

Wichtige Verfahren zur Untersuchung des

Gehirns

Mit der Erforschung des Gehirns sind auch Untersuchungsverfahren für und

in diese Richtung verbunden. Auf den Erkenntnissen und Methoden dieser

Untersuchungsverfahren basieren vielen Modelle in der Hirnforschung und

Neurobiologie bzw. haben sich gegenseitig beinflußt. Viele dieser Verfahren

werden ebenfalls in der Medizin verwendet. Nach und mit diesen Modellen

wird und kann die Informationsverarbeitung im Gehirn oder deren Bereichen

beschrieben werden. Viele der Erkenntnisse, die in diesem Text angedeutet

wurden oder noch verarbeitet werden, beziehen sich auf diese Ergebnisse

solcher Untersuchungen.

Eines der ältesten Verfahren ist die Untersuchung von Hirnschäden (Läsionen). Man unterscheidet zwischen irreversiblen und reversiblen Schäden. Die

Betrachtung von Hirnschäden besteht natürlich aus dem Zusammenwirken

von mehreren eigenständigen Handhabungen und Praktiken. Irreversible Hirnschäden haben häufig ihre Ursache in Unfällen oder sind Folge von Krankheiten, z.B. einem Schlaganfall. Die Erkenntnisse von Beobachtungen sind das

Resultat von Einzelfällen. Ausserdem ist bei reversiblen Schäden eine Beobachtung nur während der Krankheit oder Läsionen möglich. Hier liegt aber

auch eine Schwäche dieser Methode. Stand in der Vergangenheit nur die ausschließliche Beobachtung über einen längeren Zeitraum bei Einzelfällen zur

Verfügung, so können gegenwärtig diese Ergebnisse durch zusätzliche moderne Verfahren verifiziert bzw. diagnostiziert werden. Die Menge der Einzelfälle und die zunehmende Möglichkeit der Verifizierung gleicht einen Teil

der Schwäche dieser Beobachtungsmethoden jedoch aus.

Moderne Methoden sind elektrische Aufzeichnungsverfahren und in letzter

Zeit immer mehr Abbildungsverfahren. Zum Teil kommen auch chemische

Methoden zur Anwendung. Kennt man die Stelle der Hirnschädigung, so

kann man aus der Beobachtung des Verhaltens Rückschlüsse auf die örtliche Struktur und deren Funktion gewinnen. Die Unterteilung des Gehirns in

verschiedene Bereiche und die Zuordnung der Funktionen sind zum Teil ein

Ergebnis solcher Beobachtungen. Neben der Untersuchung von permanenten

24

KAPITEL 2. DAS GEHIRN

Hirnschädigungen gibt es auch die Untersuchung der reversible Schädigungen (z.B. Blockieren von Neuronenfunktionen durch Medikamente). Diese

kurzzeitigen Störungen lassen Modelle zu, welche die Wechselwirkungen der

Hirnbereiche erklären können.

Chemische Verfahren werden verwendet, wenn man den Injektionsbereich

für solche Stellen genau lokalisieren kann. Man kann reversible Hirnschäden

durch Blockade von chemischen Vorgängen (z.B. Glutamat-Rezeptoren) bzw.

deren Verstärkung bewirken (z.B. Rauschgifte). Die Überreaktionen oder

Ausfallerscheinungen können den Hirnbereich determinieren. Es sind auch

gezielte Tierversuche möglich, welche Analogien zum Menschen erlauben.

Mit Hilfe von Tierexperimenten wurden die Grundlagen von Schlaf und

Traum herausgefunden. Mit diesen Verfahren konnten qualitative Modelle

des Gehirns erstellt werden. Man erkennt mit diesen Methoden die molekulare Struktur und deren Abläufe in einem Hirn. Durch die moderne Biotechnologie werden diese Verfahren zunehmend verfeinert (z.B. Klonierung von

Rezeptoren für Neurotransmitter) werden. Die Entwicklungen in der Molekularbiologie und Gentechnik werden hier sicherlich noch tiefere Erkenntnisse

liefern ([THOMPSON94]).

Eines der bekanntesten elektrischen Verfahren der Aufzeichnung von Gehirnaktivitäten ist das Elektroenzephalogramm (EEG). Hier werden auf der

Oberfläche (Kopf oder Hirn) die zusammengesetzten elektrischen Signale der

Hirnbereiche erfasst. Man kann die Aktivitäten von Gehirnregionen erfassen,

aber nichts über das Verhalten der Elemente innerhalb der Region aussagen. Im Tierversuch sind zwar Methoden möglich, die dass Einführen von

Tiefenelektroden in den Bereich erlauben, aber dies hat dann häufig nichts

mit dem menschlichen Verhalten zu tun. Hier helfen Analogiemodelle. Beim

ERP (engl. event-related potential) werden Signale erfasst, die zeitgleich auf

einen sensomotorischen Reiz oder ein motorisches Ereignis (z.B. Stromstoß)

auftreten. Zusammen mit dem EEG wird hier das Zeitverhalten von Reizen

auf bestimmte Bereiche oder Strukturelemente in Gehirn erkennbar. Man

nennt diese Techniken auch elektropsychologische Verfahren. Da der Aktivierungsimpuls eines Neurons meistens elektrischer Natur ist, entstehen somit

erfassbare elektrische und magnetische Felder. Diese können dann mittels

dem Magnetoenzephalogramm (MEG) registriert werden.

Mit der Nutzung der Röntgentechnik wurden die bildgebenden Techniken eingeführt. Mit einer Röngtenaufnahme, unter der Verwendung von Kontrastmittel, konnten so bestimmte Hirnbereiche lokalisiert worden. Trotzdem war

die Genauigkeit dieses Verfahrens nicht sehr hoch. Mit den Möglichkeiten der

Computertechnologie und der Verwendung von tomographischen Techniken

2.3. UNTERSUCHUNGSVERFAHREN

25

stehen heute wesentlich genauere Methoden der Analyse zur Verfügung. So

können mit diesen Techniken Querschnitte des Gehirns gewonnen werden,

die anschließend auch in eine entsprechende 3D-Ansicht überführt werden

können

Mit der Computertomographie (CT) auf Röntgenbasis erreicht man eine

Auflösung von 1mm. Dies ist gut für die Modellentwicklung von Strukturbereichen. Mit der MRI-Technik (engl. Magnetic Resonance Imaging) kann

man Auflösungen von ≈100µm erreichen. Bei der MRI-Technik wird das

Gehirn einem Magnetfeld ausgesetzt. Durch die Aufnahme der Veränderung der magnetischen Orientierung der Atome des entsprechenden Hirnbereiches kann man Strukturelemente oder Schädigungen bestimmen. Die

funktionelle Magnetresonanztomografie (fMRT) wird verwendet um Aktivitäten im Gehirn festzustellen bzw. aufzuzeichnen (vgl. [SpdWGuG02/II]).

Hier wird das sauerstoffreiche Blut sichtbar gemacht, da aktivierte Hirnbereiche einen sehr hohen Verbrauch an Sauerstoff haben. Da die MRI auf

Wasserstoff basiert, kann es zu Problemen mit anderen Elementen kommen.

Die Kombination von chemischen Methoden und Abbildungsverfahren erlaubt eine Lösung solcher Schwierigkeiten. Hier wird der Zusammenhang

zwischen elektrischer Aktivität und dem Stoffwechsel ausgenutzt. Dabei wird

ein schwach radioaktiver und dem Zucker ähnlicher Stoff ins Blut gegeben.

Dieser bewirkt dann bei Neuronen7 einen erhöhten Stoffwechsel. Man nennt

diese Methode 2-Desoxyglucose-Technik (2-DG). Eine Abbildung erhält man

mittels der Positronenemissionstomographie (PET, vgl. [THOMPSON94]

und [ECCLES99]).

Weitere Einzelheiten zu den Methoden, die in der Hirnforschung bzw. Neuroanatomie sowie Neurobiologie verwendet werden, findet man in der Fachliteratur und im Anhang von [CHURCHLAND97]. Für die weitere Abhandlung

werden die Resultate dieser Verfahren mit der Informationsverarbeitung in

Zusammenhang gebracht, um hieraus entsprechende Modelle zu simulieren

und zu entwerfen. Für das Verständnis des Gehirns als System sind sowohl

die Neuronen8 und das Zusammenwirken von Struktur und Funktion von Bedeutung. Das Gehirn wird als ein dynamisches System (vgl. [EDEL93] und

[EDEL95]) betrachtet, dessen kleinste Einheit ein Neuron darstellt.

7

8

vgl. Kapitel 3

die “Verarbeitungselemente”, vgl. S. 60

26

KAPITEL 2. DAS GEHIRN

Kapitel 3

Die Neuronen

3.1

Der allgemeine äussere Aufbau einer Neurone

Ist einer der Grundbausteine eines Organismus die Zelle, so ist dies für das

Gehirn oder ein biologisches neuronales Netz die Neurone. Im Kapitel 2 wurde bereits auf der Seite 17 in der Abbildung 2.2 ein einfaches Neuronenmodell

vorgestellt. Abbildung 3.1 zeigt eine ähnliche Struktur. Neuronen sind eigentlich normale Zellen, welche sich im Laufe der Evolution auf die Verarbeitung

von Informationen spezialisiert haben. Sie übertragen Informationen auf andere Neuronen oder senden und empfangen Informationen aus den Muskeloder Drüsenzellen. Neben den Neuronen gibt es im Gehirn noch die Gliazellen.

Neuere Forschungen1 ergaben, dass diese Art der Zellen nicht bloss das Stützgewebe für die Neuronen ist, sodern sich ebenfalls an der Informationsverbeitung im Gehirn beteiligt. Ein anderer Unterschied zu anderen biologischen

Zellen ist, dass sie sich nach ihrer Bildung nicht mehr zu vermehren scheinen. Dies bedeutet, dass sich in einem ausgewachsenen Gehirn keine neuen

Neuronen mehr bilden. Neuere Forschungen scheinen jedoch z.T. das Gegenteil zu bestätigen, d.h. es scheinen sich in bestimmten Hirnregionen (siehe

auch [SpdWGuG02/IV]) Neuronen wieder zu regenerieren. Die Ursache für

diese Verhalten wird gegenwärtig mit den modernen Methoden der Bio- und

Gentechnik weiter untersucht und zunehmend verstanden. In diesem Kapitel kann es daher nur einem sehr kurzen Abriss über den Aufbau und die

Funktion der Neuronen geben.

1

Vgl. [SpdW09/04]

27

28

KAPITEL 3. DIE NEURONEN

Zellkörper

(Soma)

Neuronen

Axone

Richtung des

Aktionspotential

(Erregung oder Hemmung)

Dendriten

präsynaptisch

Synapsen

prostsynaptisch

Zellkerne

Abbildung 3.1: Schematischer Aufbau einer Neurone, hier in einem Verbund

dargestellt.

Eine Neurone ist eine Struktur, von dessen Zellkörper (Soma)2 viele Fortsätze

ausgehen. Die meisten Fortsätze heißen Dendriten. Einer der wichtigsten

Fortsätze, aus der Sicht der Informationsverarbeitung, ist das Axon. Es hat

meist ein zylinderförmiges Aussehen. Am Ende eines Axon bilden sich, in

Richtung der mit dem Neuron verbundenen Zellen (Sensor- oder Muskelgewebe oder andere Neuronen), bestimmte Verdickungen. Diese Verdickungen

werden Synapsen genannt. Auf den Dendriten und dem Zellkörper befinden

sich viele dieser Synapsen. An diesen Synapsen werden die Informationen

zwischen den Neuronen (Hirnbereiche) oder den Transduktoren, den Verbindungen zwischen Nervengewebe und sensorischen Gewebe, ausgetauscht. Der

Informationsaustausch ist ein typisches Merkmal, besonders im Großhirnbereich (vgl. S.13), für die Neuronen.

Der Zellkörper einer Neurone enthält, wie viele andere organische Zellen,

einen Zellkern (Nucleus) und verschiedene Organellen, von denen die Mitochondrien die Wichtigsten sind. Sie stellen die Energie für die Neurone zur

Verfügung. Hierzu benötigen sie Sauerstoff und Glukose. Das Axon hat die

Funktion, ein entstehendes Aktionspotential (letztlich eine Erregung oder

2

Manchmal auch Perikaryon genannt

3.2. NEURONENTYPEN

29

Hemmung) vom Zellkörper zu den synapischen Verbindungsenden3 zu leiten

und chemische Substanzen vom oder zum Zellkörper zu transportieren. Die

Synapse als Form der Verbindung von Zellen kommt in dieser Art und Weise

nur in Nervengewebe vor. Es ist der Ort des Kontakts zwischen zwei Neuronen. Die Dendriten sind Auswüchse des Zellkörpers zur Informationsaufnahme, hier bilden sich die Synapsen heraus. Ihre Anzahl vergrößert letztlich die

Oberfläche des Zellkörpers für die Reizaufnahme. Genauere Einzelheiten zu

dem Aufbau von Neuronen und ihren Wechselwirkungen findet man in der

Literatur bei [CHURCHLAND97], [ECCLES00] und [Spektrum92/2].

3.2

Neuronentypen

Trotz des relativ gleichartigen funktionellen Aufbaus von Neuronen lassen

sich diese auf Grundlage ihrer Funktion in unterschiedliche Typen einteilen. Am Beispiel der menschlichen Großhirnrinde, wo Hirngewebe eingefärbt

wurde, kann man in Abbildung 3.2b verschiedene Arten von Neuronen erkennen. Das Einfärben von Nervengewebe geht auf die Methode des Histologen Ramón y Cajal und des Zytologen Camillo Golgi zurück. Diese beiden Wissenschaftler waren die Ersten, welche mittels der Einfärbung

Nervengewebe sichtbar machten und haben dafür 1906 den Nobelpreis erhalten ([CAJAL1889]). Mit der Imprägnierung mittels Silber-, Quecksilberoder Goldverbindungen können die Strukturen von Neuronen sichtbar gemacht werden ([BILEX88]). Verschiedene Arten von Neuronen zeigt die Abbildung 3.2a. Sie stellen eine Verallgemeinerung, die sich aus den komplexen

Bildern des eingefärbten Hirngewebe ergibt, dar.

Der obere Teil von Abbildung 3.2b zeigt pyramidenartige Motoneuronen.

Das Motoneuron ist der am leichtesten identifizierbare Typ von Neuronen.

Motoneuronen bilden sehr häufig auch die Grundlage für die Modelle zur Simulation oder für die Anwendung. Die Abbildung 2.2 auf Seite 17 war bereits

ein Modell einer solchen Motoneurone. Merkmal dieser Zellen sind ein großer

Zellkörper, ein umfangreicher Dendriten-Baum und ein langes ausgeprägtes

Axon.

Im Rückenmark befinden sich die Zellkörper der Motoneuronen, die mit der

Körpermuskulatur im Zusammenhang stehen. Bei der Versorgung der Gesichtsmuskeln und des Kopfes sind diese Somata im Hirnstamm zu finden.

Motoneuronen sind mit ihren Synapsen am Ende mit den Fasern von Muskeln verbunden. Deshalb leiten sie die neuronale Informationen zu den Mus3

Die im Text erwähnten Verdickungen, siehe Abbildung 3.1.

30

KAPITEL 3. DIE NEURONEN

a

b

Sensorneuron

Interneuron

Hauptneuron

Motoneuron

Abbildung 3.2: Neuronentypen: a) Strukturbilder von Neuronentypen, b)

Eingefärbtes Nervengewebe.

keln, sie beeinflussen (erregen oder hemmen) die Motorik des Körpers. Das

Axon der Motoneuronen ist von Myelin umgeben. Diese fetthaltige und isolierende Umhüllung des Axons, eine Art Hilfsgewebe, verbessert die Übertagungsfähigkeiten der Aktionspotentiale (vgl. auch Abbildung 2.2).

Ein weiterer Typ sind die Sensorneuronen, auch sensorische Nervenzellen genannt. Der untere Teil in Abbildung 3.2 b zeigt solche sternförmigen Zellen.

Sie empfangen die Reaktionen aus dem Körper. Im Gegensatz zu den Motoneuronen sind hier die Dendriten besonders ausgebildet. Analog zu den

Motoneuronen sind die Dendriten-Fasern ebenfalls mit Myelin umgeben. Die

Zellkörper der Sensorneuronen ist in Gruppen außerhalb des Rückenmarks zu

finden. Man nennt sie auch Spiralganglien. Innerhalb des Gehirns ist die Unterscheidung schwierig. Die Aktivierung von Sensorneuronen erfolgt über die

jeweiligen Rezeptoren. Die Umformung von physikalischen und chemischen

Zuständen erfolgt über die Synapsen in elektrische Potentiale (Aktionspotential, vgl. S. 37). Es findet die Transduktion, die Reiz-Erregungsübertragung,

statt.

Innerhalb des Gehirns gibt es eine große Menge von Nervenzellen oder Neuronen, die Anzahl wird auf ≈1011 Neuronen geschätzt. Man unterscheidet hier

im wesentlichen zwischen zwei Arten. Die Hauptneuronen, als die eine Art,

3.2. NEURONENTYPEN

31

sind große Zellen innerhalb eines Gehirnbereiches. Ihre Verbindungen kommunizieren mit den Neuronen in anderen Regionen. Um die Leitfähigkeit

zu erhöhen besitzen diese Neuronen ebenfalls eine Umhüllung aus Myelin,

d.h. ihr Axon ist myelinisiert. Damit kann man Hauptneuronen nach Modellvorstellungen praktisch als die Ausgabeneuronen der jeweiligen Hirnregion

betrachten.

Das Axon von Interneuronen, der zweiten Art, reicht nicht in andere Bereiche

des Gehirns hinein. Deshalb werden Informationen nur an die nächsten umliegenden Nervenzellen übertragen. Manche Interneuronen haben auch kein

Axon (vgl. Abb.3.2a) ausgebildet. Meistens sind Interneuronen zwischen Nervenzellen in Regionen mit zulaufenden bzw. weglaufenden Informationen zu

finden. Man bezeichnet sie auch als Zwischenneuronen. Sie bestimmen durch

ihre Verarbeitung die Struktur der Information, welche dann an die Hauptneuronen weitergeleitet wird, damit letztlich Hirnbereiche entsprechend reagieren. Die Tabelle 3.1 fasst die Neuronentypen nochmals zusammen. Die in

Neuronentypen

Hauptneuron

Interneuron

Sensorneuron

Motoneuron

Eigenschaft

Verbindungselement

Strukturelement

Reizempfänger/Filter

Reizsender/Filter

Anwendung

Kommunikation

Strukturfilter

Signalaufnahme

Signalabgabe

Tabelle 3.1: Die wichtigsten Typen von Neuronen

diesem Abschnitt verwendete Unterteilung ist nur eine von mehreren möglichen Kategorien der Unterteilung. So werden Neuronen z.T. auch nach ihrer

Geometrie unterteilt oder nach ihrer Lage in den Hirnbereichen. Hier wurde sie gewählt, um eine besseres Verständnis für die Modelle von KNN in

nachfolgenden Kapiteln, ab Seite 41, zu erreichen. Mehr zur angeführten Unterteilung kann man in [THOMPSON94] oder [SpdW01] nachlesen. Neuere

Ergebnisse aus der Hirnforschung haben Spiegelneuronen belegt, welche sowohl an den sensorischen bzw. motorischen Funktionen beteiligt sind, aber

auch solche Vorgänge nur simulieren. Dies bedeutet, dass diese Art der Neuronen Vorgänge simuliert, die auf Grund der Wechselwirkung mit der Umwelt

auftreten könnten. Sie spiegeln somit das Verhalten von Neuronenvorgängen,

nachzulesen mit Literaturangabe in [SpdWGuG02/I].

32

KAPITEL 3. DIE NEURONEN

3.3

3.3.1

Die Wirkungsweise einer Neurone

Der prinzipielle innere Aufbau einer Neurone

Der Schwerpunkt dieser Abhandlung liegt zwar auf den Künstlichen Neuronalen Netzen, dennoch ist die Beschreibung der Funktion einer Neurone

sinnvoll für das Verständnis von der Dynamik von realen neuronalen Netzen

(vgl. [EDEL93]). Die Neuronen sind als Zellen spezialisiert um Informationen zu leiten und auf andere Zellen bzw. Neuronen zu übertragen. Die verschiedenen Typen von Neuronen wurden im letzten Abschnitt erwähnt. Jetzt

sollen die grundsätzlichen Wechselwirkungen, die Funktionen der Informationsübertragung und der innere Aufbau einer Neurone erläutert werden. Man

unterscheidet bei dem Aufbau und der Funktion der Neurone zwischen dem

Verhalten als Zelle und der Funktion, die diesem Neuron im System oder

Schaltwerk ausführt (vgl. [CALVIN2000]).

Neben dem Grundaufbau von Neuronen (vgl. Abschnitt 3.1 auf Seite 27) ist

die Struktur einer Neuronenzelle auf einen Informationsaustausch ausgelegt,

d.h. auf die Träger der Information. Die Zellwand bzw. Plasma-Membran

trennt das Neuron als Zelle von ihrer Umgebung. Die Dicke dieser Membran beträgt ca. 5. . .10 nm und besteht zum großen Teil aus Fettsäuren.

In diesen Fettsäuren sind Phospholipide und andere Lipide, Cholesterin und

weitere Proteinmoleküle enthalten. Weitere Details zum Aufbau einer Neurone findet man Buch von [THOMPSON94]4 und auch in [ECCLES00]

und [ECCLES99]. Einige der Proteinmoleküle in einer Nervenzelle haben

die Funktion von chemischen Rezeptoren. Damit werden chemische Botenstoffe identifiziert, deren Erkennung abhängig von der elektrischen Ladung

und der Molekülform ist.

In der Membranen sind selektiv durchlässigen Poren enthalten, die auch Ionenkanäle genannt werden. Diese bilden Kanäle für Ionen, wie Natrium, Kalium oder Chlorid. Für jede der Ionen gibt es eigene Kanäle. Über diese Kanäle

erfolgt ein Ladungsaustausch, was letztlich die Fortpflanzung der Potentiale

erlaubt (siehe auch Abschnitt 3.3.2). Die Aufrechterhaltung der unterschiedlichen Ionenkonzentrationen an der Zellmembran und im Zellinneren wird

durch einen molekularen Mechanismus umgesetzt, welcher ähnlich wie eine

Pumpe, Ionen gegen das natürliche Konzentrationsgefälle durch die Membran

transportiert. Die Funktion der Zellmembran einer Neurone zur Trennung der

jeweiligen Ionenkonzentration ist eine typische Zelleigenschaft.

Die Abbildung 3.3 zeigt in vereinfachter Darstellung die innere Struktur

4

Speziell im dortigenKapitel 3

3.3. INNERER AUFBAU

33

und verdeutlicht auch einige Wechselwirkungen in der Neurone. In der Nähe

des Zellkerns findet man das endoplasmatische Reticulum und den GolgiApparat. Mit Hilfe dieser Objekte ist das Neuron in der Lage chemische

Substanzen wie Proteine, Peptite oder Transmitter zu bilden und zu reproduzieren. Im Golgi-Apparat werden diese Substanzen in Vesikel untergebracht und innerhalb der Neurone als Botenstoff bereitgestellt (s.a [BILEX88]

und [ROBERT95]).

Zellkörper

Dendrit der

Folgeneurone

Golgi−Apparat

Mitochondrium

plurivesikuläres

Körperchen Mikrotubulus

Vesikel

Zellmembrane

Details der Zellmembrane