Die Janson-Ungleichungen und Anwendungen

Werbung

Markus Huber

Do, 29.11.2007

Die Janson-Ungleichungen und

Anwendungen

Die Chromatische Zahl in G(n, 1/2)

Wir betrachten einen zufälligen Graphen G(n, 1/2) im Erdős-Rényi Modell. Die chromatische

Zahl eines Graphen G ist die kleinste Anzahl Farben, die ausreicht, den Graphen zu färben

und wird mit χ(G) bezeichnet. Ein Ergebnis des vorherigen Vortrags ist, dass wir χ(G) bereits

folgendermaßen eingrenzen können:

n

n

< χ(G) <

ω(G)

log2 n

wobei ω(G) die Cliquezahl von G ist und wir festgestellt haben, dass ω(G(n, 1/2)) mit hoher Wahrscheinlichkeit asymptotisch 2 log2 n ist. Die Cliquezahl beschreibt die Größe des

größten kompletten Teilgraphen von G, beziehungsweise die größte unabhängige Menge im

Komplementärgraph. Wie man leicht sieht, ist G(n, 1/2) und sein komplementärer Graph verteilungsgleich, und folglich können wir mit hoher Wahrscheinlichkeit nur höchstens 2 log2 n

Punkte mit einer Farbe versehen. Die Abschätzung nach oben ist Resultat eines Algorithmus,

der unabhängige Mengen der Größe log2 n in einem Graphen findet. Wir wollen nun folgenden

Satz beweisen:

Satz. Für die chromatische Zahl von G(n, 1/2) gilt mit hoher Wahrscheinlichkeit

n

2 log2 n

χ(G) ∼

Beweis. Wir setzen zunächst m = b (lnnn)2 c. Sei weiterhin S eine beliebige Menge von Ecken

aus G mit |S| = m und sei G|S die Einschränkung von G auf S. An dieser Stelle ist zu

bemerken, dass G|S in Verteilung gleich ist mit G(m, 1/2).

Weiterhin sei mit k0 (n) die Größe der kleinsten Clique bezeichnet, deren erwartete Anzahl

in einem zufälligen Graphen der Größe n unter 1 liegt, oder formal

¾

½ ¯µ ¶

¯ n

l

2−(2) < 1

k0 (n) := min l ¯¯

l

l

Wir setzen nun k = k(m) = k0 (m) − 4 und bemerken, dass k ∼ 2 log2 m ∼ 2 log2 n.

Die erste Abschätzung stimmt, da wie oben erwähnt ω(G(m, 1/2)) ≤ 2 log2 m. Die zweite

folgt aus

2 log2 m ≈ 2 log2

n

(ln n)2

= 2 log2 n − 2 log2 2 ln n

= 2 log2 n + o(log2 n)

= 2 log2 n (1 + o(1))

1

Unser Ziel ist es nun zu zeigen, dass es in jedem Teilgraphen der Größe m mindestens

eine Menge von k unabhängigen Punkten gibt, da wir dann immer wieder k Punkte ziehen

können und sie färben, obwohl der restliche Graph nach jedem Schritt nicht mehr zufällig ist.

Folglich suchen wir eine Abschätzung dieser Form:

2−o(1)

P[ω(G|S ) < k] < e−m

.

Diese bekommen wir durch die erweiterte Janson Ungleichung :

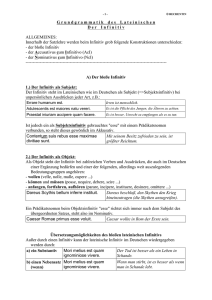

Janson-Ungleichungen

Betrachte Ereignisse A1 , . . . , Am und einen Abhängigkeitsgraphen V = {A1 , . . . , Am }, wobei

für alle i die Familie {Aj : i 6∼ j} unabhängig von Ai ist.

Janson-Ungleichungen. Unter den Voraussetzungen

V

i: Für alle i, S mit i ∈

/ S gilt P[Ai | j∈S Acj ] ≤ P[Ai ]

V

ii: Für alle i, k, S mit i, k ∈

/ S gilt P[Ai ∧ Ak | j∈S Acj ] ≤ P[Ai ∧ Ak ]

und mit P[Ai ] ≤ ε gilt die

a) Janson-Ungleichung

^

M ≤ P[ Aci ] ≤ M e∆/[2(1−ε)]

und die

b) Erweiterte Janson-Ungleichung, falls ∆ ≥ µ(1 − ε)

^

2

P[ Aci ] ≤ e−µ (1−ε)/2∆

mit M =

Qm

c

i=1 P(Ai )

; ∆=

P

i∼j

P(Ai ∧ Aj ) ; µ =

P

P[Ai ].

Beweis später.

Wir betrachten

auch hier wieder k = k0 (n) − 4.

¡ nun

¢ den ganzen Graphen G(n, 1/2) und

¡nsetzen

¢

Die Ai , 1 ≤ i ≤ nk , sind hier die

Ereignisse,

dass

die

verschiedenen

k-Cliquen existiek

V

ren, also ist {ω(G) < k} = { Aci }. Um die erweiterte Janson Ungleichung anzuwenden

benötigen wir:

• Die Vorrausetzungen sind erfüllt, denn

V

– P[Ai | j∈S Acj ] = P[Ai ], falls Ai und alle Aj kantendisjunkt sind und

V

– P[Ai | j∈S Acj ] ≤ P[Ai ] sonst, denn es vergrößert sich die Wahrscheinlichkeit, dass

Kanten fehlen.

– P[Ai ] = 2−k = ε.

¡ ¢ k

P

• µ =

P[Ai ] = nk 2−(2) =: f (k) > n3+o(1) , da

wie im vorhergehenden Vortrag gezeigt wurde.

2

f (k)

f (k+1)

= n1+o(1) in diesem Bereich,

• ∆ ist der Erwartungswert der k-Cliquen, die sich an mindestens einer Ecke überschneiden. Wir betrachten zuerst die Cliquen, die sich nur eine Kante teilen, also |S ∩ T | = 2.

µ ¶

µ ¶

µ

¶

n −(k)

k

n − k −(k)

P[AS ∩ AT ] =

2 2 ·

·

2 2 2

k

2

k−2

S∼T

| {z }

| {z }

{z

}

|

(erste Clique) (eine Kante aus 1.) (k − 2 Punkte aus dem Rest)

X

≈

k 4 µ2

n2

³

Dieser Term bestimmt die Größenordnung von ∆, also ∆ = Θ

µ2 k 4

n2

´

.

Nun können wir die erweiterte Janson-Ungleichung anwenden:

^

2

2

P[ω(G) < k] = P[ Aci ] < e−µ (1−ε)/2∆ = e−Ω(µ /∆)

= e−Ω(n

= e−n

2 /k 4 )

2−o(1)

Für G|S gilt also

2−o(1)

2−o(1)

P[ω(G|S ) < k] < e−m

= e−n

.

¡n¢

1+o(1)

Da es allerdings nur m

< 2n = en

m-große Mengen S gibt, gilt:

©

ª

1+o(1) −n2−o(1)

P[ ω(G|S ) < k für ein S ] < en

e

= o(1).

Man bemerke nun, dass G(n, 1/2) und sein komplementärer Graph G(n, 1/2) die gleiche

Verteilung besitzen, also lässt sich das Resultat direkt auf unabhängige Mengen - eine Punktmenge, in der keine zwei Punkte durch eine Kante verbunden sind - übertragen. Das heißt,

wir können in jeder Menge von mindestens m Punkten mit hoher Wahrscheinlichkeit eine

unabhängige Menge der Größe k finden.

Wir suchen also im Graphen unabhängige Mengen der Größe k, färben sie mit einer

Farbe und streichen sie aus dem Graphen. Diesen Schritt wiederholen wir solange, bis unser

Restgraph nur noch weniger als m Punkte besitzt. Man bemerke, dass es keine Rolle spielt,

dass der Restgraph nach jedem Schritt nicht mehr zufällig ist, da die Behauptung für jede

mindestens m-große Teilmenge gilt. Sind weniger als m Punkte übrig, geben wir diesen jeweils

eine Farbe. Die auf diese Weise verwendete Anzahl an Farben ist mit hoher Wahrscheinlichkeit

µ

¶

n

n

n

n−m

+m≤ +m =

(1 + o(1)) + o

χ(G) ≤

k

k

2 log2 n

2 log2 n

n

=

(1 + o(1))

2 log2 n

Beweis der Janson-Ungleichungen. a) Die untere Abschätzung folgt direkt aus der Voraussetzung i)

m

m

i) Y

^

Y

P[ Aci ] =

P[Aci |Ac1 , . . . , Aci−1 ] ≥

P[Aci ] = M

i=1

i=1

3

Für die obere Abschätzung benennen wir zunächst die Ai um, sodass im Abhängigkeitsgraphen i mit 1, . . . , d verbunden ist und nicht mit d, . . . , i−1. Sei C := {Acd+1 , . . . , Aci−1 }.

Dann ist

P[Ai , Ac1 , . . . , Aci−1 ]P[C]

P[Ac1 , . . . , Aci−1 ]P[C]

P[Ai , Ac1 , . . . , Aci−1 |C]

=

P[Ac1 , . . . , Aci−1 |C]

≥ P[Ai , Ac1 , . . . , Aci−1 |C]

P[Ai |Ac1 , . . . , Aci−1 ] =

≥ P[Ai |C] −

d

X

P[Ai ∧ Aj |C]

j=1

(wegen Unabhängigkeit und ii)) ≥ P[Ai ] −

d

X

P[Ai ∧ Aj ].

j=1

Nun addieren wir −1 zu jeder Seite und kehren das Vorzeichen um.

1 − P[Ai |Ac1 , . . . , Aci−i ] ≤ 1 − P[Ai ] +

d

X

P[Ai ∧ Aj ]

j=1

P[Aci |Ac1 , . . . , Aci−i ] ≤ P[Aci ] +

d

X

P[Ai ∧ Aj ]

j=1

Da P[Aci ] ≥ 1 − ε und 1 + x ≤ ex ∀x ≥ 0 gilt:

d

X

1 Pd

1

P[Ai ∧ Aj ] ≤ P[Aci ] e 1−ε j=1 P[Ai ∧Aj ]

P[Aci |Ac1 , . . . , Aci−i ] ≤ P[Aci ] 1 +

1−ε

j=1

Multiplikation über alle i ergibt

P[Ac1 , . . . , Acm ] ≤

m

Y

∆

(P[Aci ]) e 2(1−ε)

i=1

und damit

^

∆

P[ Aci ] ≤ M e 2(1−ε)

b) In diesem Teil verwenden wir die Probabilistische Methode. Wir formen zunächst die

Janson-Ungleichung um. Wieder 1 − x ≤ e−x ∀x ≥ 0 benutzend ist

M=

m

Y

i=1

P(Aci )

=

m

Y

1 − P(Ai ) ≤

i=1

m

Y

e−P(Ai ) = e−

Pm

i=1

P(Ai )

= e−µ

i=1

V

und damit P[ Aci ] ≤ e−µ e∆/[2(1−ε)] . Wir logarithmieren und kehren die Vorzeichen um

m

³ ^

´

X

c

− ln P[ Ai ] ≥

(P(Ai )) −

i=1

X

1

P(Ai ∧ Aj )

2(1 − ε)

i∼j

4

Das Gleiche muss aber für jede Teilmenge I ⊆ {1, . . . , m} gelten:

Ã

− ln P[

^

!

Aci ]

≥

i∈I

X

(P(Ai )) −

i∈I

X

1

P(Ai ∧ Aj )

2(1 − ε) i∈I

i∼j

Wir wollen nun I zufällig wählen. Sei P(i ∈ I) = p die Wahrscheinlichkeit, dass i-te

Ereignis unabhängig von allen übrigen in die Teilmenge I aufzunehmen. Wir werden

p gleich festlegen. Jetzt sind I und alle auftretenden Größen Zufallsvariable und wir

können den Erwartungswert bilden:

"

Ã

E − ln P[

^

!#

Aci ]

≥ pµ −

i∈I

1

p2 ∆.

2(1 − ε)

Um den Ausdruck zu maximieren, setzen wir nun p = µ(1−ε)

∆ . Damit ist p < 1, da nach

Voraussetzung ∆ ≥ µ(1 − ε) und

"

Ã

!#

^

µ2 (1 − ε)

c

E − ln P[ Ai ]

≥

.

2∆

i∈I

Also gibt es inbesondere eine bestimmte Menge I 0 , die die Gleichung erfüllt und daher

^

^

µ2 (1−ε)

P[ Aci ] ≤ P[

Aci ] ≤ e− 2∆ .

i∈I 0

Dreiecksfreiheit in G(n, p)

Wir betrachten einen zufälligen Graphen G(n, p) im Erdős-Rényi Modell. Wir wollen nun

mithilfe der Janson-Ungleichungen untersuchen, wie sich die Eigenschaft der Dreiecksfreiheit

(TF) in Abhängigkeit des Paramters p verhält. Der Abhängigkeitsgraph sei folgendermaßen

festgelegt, wobei Di , Dj Dreiecke in G darstellen:

i ∼ j ⇔ Di ∩ Dj 6= ∅

• Sei zunächst¡ p¢= c/n und Aijk das Ereignis, dass {i, j, k} in G ein Dreieck bilden. Dann

ist mit µ = n3 p3 ∼ c3 /6

n

3

M = (1 − p3 )( 3 ) ≈ e−µ ≈ e−c /6 .

¡ ¢

Für ∆ müssen wir nur Terme der Form Aijk ∩Ajkl betrachten. Es gibt n4 solche Punktkombinationen und mit Wahrscheinlichkeit p5 sind alle fünf Kanten zwischen diesen

Punkten vorhanden, also

∆ = Θ(n4 p5 ) = Θ(n4 c5 n−5 ) = o(1).

5

und ε = p3 = c3 /n3 = O(n−3 ) = o(1) liefert dann mit der Janson-Ungleichung:

3 /6)

P(TF) ∼ M ∼ e(−c

.

Dieses Resultat war bereits mit Hilfe einer Poissonapproximation aus dem ersten Vortrag

bekannt.

4

• Falls p = o(n− 5 ), ist immernoch ∆ = o(1) und damit

P(TF) ∼ M

³

Zum Beispiel wenn p = Θ

(ln n)1/3

n

´

¡

ist M ≈ 1 −

¢ 3

ln n n

n3

≈ e− ln n = n1 .

4

• Falls n− 5 ≤ p = o( √1n ) wird ∆ zu groß, aber man hat immernoch ∆ = O(n4 p5 ) =

o(n3 p3 ) = o(µ), was einem die folgende logarithmisch asymptotische Gleichung liefert:

P(TF) ∼ e−µ eo(µ) = e−µ(1+o(1)) = e−

n3 p3

(1+o(1))

6

.

• Liegt p nun auch jenseits dieser Grenze, also 1 À p À √1n müssen wir von der erweiterten

Janson-Ungleichung Gebrauch machen. Mit µ = Θ(n3 p3 ) und ∆ = Θ(n4 p5 ) ergibt sich

als obere Grenze

2 −1

2

P(TF) < e−Ω(µ ∆ ) = e−Ω(n p) .

Betrachtet man als untere Grenze zum Beispiel die Wahrscheinlichkeit, dass G überhaupt keine Kanten enthält, ergibt sich:

n

P(TF) > (1 − p)( 2 ) ≈

6

µ

¶n2

n2 p

2

1− 2

= e−Ω(n p) .

n

![Der AcI (Accusativus cum Infinitivo) Servus [Plinium quiescere] scit](http://s1.studylibde.com/store/data/002838425_1-e0e5b43c5547dc60b1cd628299d231d6-300x300.png)