Entwicklung und Evaluation eines Controllers zur Tonh

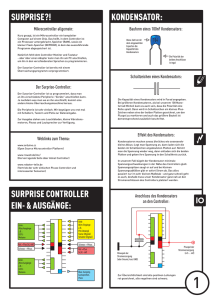

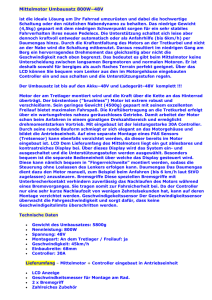

Werbung