Über die Konvergenz eines gewissen Iterationsverfahrens für

Werbung

Aplikace matematiky

Miroslav Šisler

Über die Konvergenz eines gewissen Iterationsverfahrens für zyklische Matrizen

Aplikace matematiky, Vol. 18 (1973), No. 2, 89--98

Persistent URL: http://dml.cz/dmlcz/103455

Terms of use:

© Institute of Mathematics AS CR, 1973

Institute of Mathematics of the Academy of Sciences of the Czech Republic provides access to

digitized documents strictly for personal use. Each copy of any part of this document must contain

these Terms of use.

This paper has been digitized, optimized for electronic delivery and stamped

with digital signature within the project DML-CZ: The Czech Digital Mathematics

Library http://project.dml.cz

SVAZEK 18 (1973)

APLIKACE MATEMATIKY

ČÍSLO 2

ÜBER DIE KONVERGENZ EINES GEWISSEN ITERATIONSVERFAHRENS

FÜR ZYKLISCHE MATRIZEN

M I R O S L A V SISLER

(Eingegangen a m 8. April 1972)

Die Arbeit befasst sich mit einigen Eigenschaften eines in der Arbeit [3] unter­

suchten Iterationsverfahrens für die Lösung eines linearen Gleichungssystems Ax = b.

Das Iterationsverfahren wird folgenderweise definiert:

Es sei A = D — P — R eine gewisse Zerlegung der Matrix A, wo D eine verall­

gemeinerte Diagonalmatrix ist und P, R die zugehörigen verallgemeinerten Dreiecks­

matrizen sind. Die Matrix A drückt man ferner in der Form A = M — N aus, wo

Ni = D — coP, N = (1 — co) P + R ist und co ein reeller Parameter ist. Die Iterations­

vorschrift für die betrachtete Methode ist von der Form

(1)

(D - coP) x v + 1 = [(1 - co) P + R] x v + b .

Falls man L = D~lP, U = D~XR setzt, geht die Formel (1) in die Form

(£ - coL) x v + 1 = [(1 -co)L+

U] x v + D~xb ,

über, d. h. in die F'orm

(2)

wo b' = D~ib

(3)

x v + 1 = T(co)xv + b' ,

und

T(co) = (E - coL)~l [(1 - co)L+

ü]

ist.

Für co = 1 geht offensichtlich das durch die Beziehungen (2) und (3) definierte

Verfahren in das übliche Gauss-Seidelsche Verfahren über; für co = 0 in das JacobiVerfahren über.

Ähnlicherweise wie in der Arbeit [3] setzt man voraus, dass die Matrix ß = T(0) =

= L + U einen linearen Operator darstellt, welcher den Vektorraum R in R abbildet,

und dass dieser Vektorraum durch die direkte Summe der Unterräume v l 5 . . . , vm

89

gebildet wird. Ferner setzt man wieder voraus, dass die Matrizen L, U die Bedingungen

(4)

Lv, c v l V , ,

Uv

* <= V£- k?

i = 1, ..., m

erfüllen, wo h, k positive ganze Zahlen sind, h + k = T, (P ^ m) und wo /?, k, p

teilerfremd sind (dabei ist v£ = 0 für i < 1 und i > m).

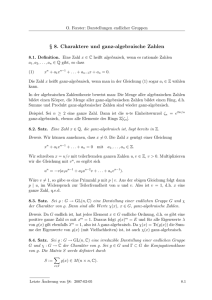

B e m e r k u n g 1. Wir geben jetzt ein eifaches Beispiel an, in dem die höher angeführten Bedingungen (4) erfüllt sind. Die n x n Matrix ß soll die Form

Ч,k

l

2,k+í

л

n-k+

1 ,n

*n,n-h+\

haben (mit zwei Nebendiagonalen). Es ist also ß = L + U, wo

•1,*

a

l

2,k+ 1

U

h + 1,2

l

o

0

n-k+

1 ,л

Den Vektorraum R„ zerlegt man in die direkte Summe der Unterräume v 3 , ..., v,,,

wo V; aus Vektoren von der Form vj = (0, ..., 0, xh 0, ..., 0) besteht. Dann gelten

offensichtlich die Bedingungen (4). Die Zahlen h, k bedeuten hier die „Entfernungen"

der beiden Nebendiagonalen von der Hauptdiagonale.

In der Arbeit [3] wurde ein Satz bewiesen (Satz 1 der Arbeit [3]), welcher unter

den höher angeführten Voraussetzungen über die Matrizen ß, JL, U den Zusammenhang der Eigenwerte X der Matrix T(co) mit den Eigenwerten \i der Matrix ß ausdrückt.

Es handelt sich um die folgende Behauptung:

Falls p ein Eigenwert der Matrix

(5)

ß ist, dann ist jede der

Я" = ^"(1 -co

Gleichunj

+ Åtûf

genügende X Zahl ein Eigenwert der Matrix 7"(cd)', falls im Gegensatz co 4= 1 oder

gleichzeitig co = 1 und X + 0 ist und X der Eigenwert der Matrix T(co) ist, dann

ist jede der Gleichung (5) genügende Zahl \i der Eigenwert der Matrix ß .

In der Arbeit [3] wurde ausführlich der wichtige Fall untersucht, wenn p = 2

und h = k = 1 ist und wenn die Matrix ß 2 nur reelle nichtnegative Eigenwerte hat.

90

Satz 4 in der Arbeit [3] gibt das Intervall für die Werte des Parameters co an, für die

der Spektralradius Q(T(CO)) der Matrix T(co) kleiner als 1 ist (d. h. die Werte co, für

die das untersuchte Verfahren konvergiert) und es wurde hier auch der Optimalparameter cob angegeben, für den der Wert Q(T(CO)) minimal ist.

Diese Arbeit befasst sich mit einem allgemeineren Fall, wenn p ^ 2 ist. Man befasst

sich mit der Frage, für welche Parameterwerte co unseres Iterationsverfahren konvergiert, d. h. wann Q(T(OJ)) < 1 ist. Im ganzen Artikel wird vorausgesetzt, dass

Q(B) < 1 ist (d. h. dass das Verfahren für co = 0 konvergiert).

1. Fs sei Q(B) der Spektralradius der Matrix ß. Dann ist O(T(0)) = Q(B) und

O(T(1)) = Qp/ip-k\B),

sodass Q(T(1)) < O(ß) < 1 gilt.

B e m e r k u n g 2. Satz 1 vergleicht also die Konvergenzgeschwindigkeit des GaussSeidelschen und des Jacobi-Verfahrens im Falle einer zyklischen Matrix ß. Das

Gauss-Seidelsche Verfahren konvergiert in diesem Falle schneller als das JacobiVerfahren.

Beweis. Da T(0) = ß ist, ist auch O(T(0)) = O(ß). Falls man in (5) co = 1 legt,

bekommt man die Beziehung

Xp =

(6)

fipXk.

Nach Satz 1 der Arbeit [3] und aus (6) folgt sofort, dass im Falle, wenn \i ein

Eigenwert der Matrix ß ist, die Nullstellen der Gleichung (6) die Eigenwerte der

Matrix T(l) darstellen. Die Gleichung (6) besitzt aber die k-fache Nullstelle X = 0

und ferner sind ihre Nullstellen die (p — k)-ten Wurzeln der Zahl pP. Es ist offensichtlich O(T(1)) = QpKp~k)(B) < O(ß) = e(T(0)), wodurch der Satz 1 bewiesen ist.

2. Es sei

o

'(>-ü<»<;(>

+ C'"(B)

«"'(»V

2\

2\

Dann gilt Q(T(CO)) < 1.

Beweis. Die Gleichung (5) schreibt man in der Form

(8)

Xp - pp £ (k\ Xk-Jtok-J(\

- co); = 0

(jip bezeichnet irgendeinen Eigenwert der Matrix ß P ). Nach der bekannten Gerschgoring-Abschätzung liegen alle Nullstellen der Gleichung (8) in dem Einheitskreise,

wenn

(9)

|ii,^i Qn'-qi-co^i

gilt.

91

a) Es sei cO > 1. Dann kann man (9) folgenderweise schreiben:

H"io (k) °>k~\°> - i)y < i .

Hp (°> + "> - i)* < i

oder

(ű < -i л i + i

2V

\ßi\"kJ

b) Es sei 0 < co < 1. Dann kann man (9) folgenderweise schreiben:

Hp t (k) ojk~\l - <°y < { >

N * (<*> + 1 - o>y < i ,

was für jedes CO mit 0 < co < 1 gilt.

c) Es sei cO < 0. Dann bekommt man aus (9) schrittweise die Ungleichungen

k

N p I ( - o > ) * - j ( i - ©y < i ,

H p (-cO + i - LOy < 1,

«,>-Yi

P/

2 V

|/>.] ".

d) Mit dem Fall cO = 0 und cO = 1 befasst sich der Satz 1.

Aus den Fällen a), b), c) und d) bekommt man insgesamt, dass bei gegebenem

Eigenwert /it der Matrix ß alle Nullstellen der Gleichung (5) in dem Einheitskreise

liegen, wenn co dem Intervalle

w

i - ^ - ) <

2\

zugehört. Da O(ß) =

max

,,k

H )

( a

<

1

- ( i

2V

]

+

Hplk.

\ßt\ ist, gilt für alle cO aus dem Intervalle (7) O(T(cO)) < \,

i=l,.,.,n

was wir beweisen sollten.

3. Es sei cO ^ 0. Dann gilt immer Q(T(CO)) g: O(ß).

Beweis. Man beweist, dass für gegebene fit die Gleichung (5) wenigstens eine

solche Nullstelle X besitzt, dass \X\ §: \fit\ ist, sodass Q(T(CO)) >. O(ß) ist.

Es gelte im Gegenteil für alle Nullstellen Xs der Gleichung (5) die Ungleichung

\XS\ < |/i;|. Die Gleichung (5) schreibt man in der Form

X" - |i~ £ (k\ ti (aj{\ - co)k~J = 0 .

92

Das Absolutglied dieser Gleichung ist der Ausdruck — /xp(l — cof. Da

1-/4(1 - cof\ = Fl |A,| < H P

s=l

gilt, bekommen wir schrittweise (co < 0)

\ßi\"(l

-a>Y£\iit\>

(1 - < » ) ' < . 1 ,

was ein Widerspruch ist, da 1 — co _ 1 ist. Dadurch ist der Satz 3 bewiesen.

Aus den Sätzen 3 und 1 ist klar, dass der Minimalspektralradius Q(T(CO)) immer

kleiner als die Zahl Q(B) ist (er ist sogar kleiner oder gleich der Zahl QpKp~k)(B))

und dass der Optimalparameter (d.h. der Parameterwert, für den Q(T(CO)) minimal ist)

also nicht im Intervalle co ^ 0 liegen kann. Deshalb ist auch der negative Teil des

Intervalles (7) aus Satz 2 vom Gesichtspunkte der Optimierung der Methode uninteressant. Weiter beschränken wir uns daher auf die obere Grenze des Intervalles der

Werte co, für die Q(T(CO)) < 1 ist.

Es gilt der folgende Satz:

4. Es sei co = 1 + l/(e p/fc (ß)). Dann gilt o(T(co)) = 1.

Beweis. Man beweist, dass für co ^ 1 4- l/|//f|p/*. i = 1, ..., n die Gleichung (5)

(wo \i = ixi ist) wenigstens eine solche Nullstelle X besitzt, dass |/l| — 1 gilt. Man

setze im Gegenteil voraus, dass für alle Nullstellen Xs der Gleichung (5) \XS\ < 1

gilt. Die Gleichung (5) schreibt man in der Form

k

*•" - /<; E (k)

x>

^ O - o)f-J = 0 .

Das Absolutglied dieser Gleichung ist der Ausdruck — /xf(l — cof und es gilt dabei,

dass

i-tfo -»)f-nw<i

s= 0

ist, da |/is| < 1 für alle s gilt. Man bekommt nun schrittweise (mit Rücksicht auf

die Ungleichung co > 1)

HP(rD-1)fc<1,

„ < ! + - ] _

was aber einen Widerspruch bedeutet. Für |^ f | = O(ß) dann bekommt man die

Behauptung des Satzes 4.

Aus den Sätzen 2 und 4 folgt, dass für die obere Grenze Q des Intervalles der

Parameterwerte co, für die Q(T(CO)) < 1 gilt, die Ungleichungen

1 /

2V

i

+

- ^ - ^ ß < i

ßp/k(B)J ~

~

+

Q"'k(B)

gelten.

93

Im folgenden Satze 5 werden wir uns mit dem Fall befassen, wenn Q =

= ^(1 + lJQp/k(B) ist, d. h. wenn die obere Grenze des Intervalles (7) scharf ist

(der Vollständigkeithalber geben wir auch die Fälle an, für die auch die untere Grenze

scharf ist). Wir werden dabei voraussetzen, dass alle Eigenwerte JXP der Matrix Bp

reell sind. Dann gilt der Folgende Satz:

max pFt = QP(B) (d. h. falls

5. a) Es seien p und k ungerade Zahlen. Falls 0 <

i=l,...,n

der im Absolutbetrag maximale Eigenwert der Matrix Bp positiv ist), hat die

Matrix T(co) für co2 = i(l + l/(Op//c(ß)) den Eigenwert X = — 1 und es ist also

Q(T(CO2)) ^ 1. Falls 0 > min pP = —QP(B) ist (d. h. falls der im Absolutbetrag

t=l,...,n

maximale Eigenwert der Matrix Bp negativ ist), hat die Matrix T(co) für co1 =

= {-(l - ll(Qp/k(B)) den Eigenwert X = ~1 und es ist also Q(T(COI)) ^ 1.

min pp =

b) Es sei p eine ungerade und k eine gerade Zahl. Falls 0 >

~QP(B)

i=l,...,n

ist, hat die Matrix T(co) für co± = | ( l — lj(Qp/k(B)) und auch für co2 =

= \(i + l/(Op/fc(ß)) den Eigenwert X = — 1 und es ist also O(T(cox)) ^ 1,

Q(T(CO2)) ^

1.

c) Es sei p eine gerade und k eine ungerade Zahl. Falls 0 <

max jip = QP(B)

i= 1 ,...,n

ist, hat die Matrix T(co) für co^ = ^(1 — lj(Qp/k(B)) den Eigenwert X = — 1 und es

ist also Q^cOi)) ^ 1. Falls 0 > min \i\ = — QP(B) ist, hat die Matrix T(co) für

i=l,...,n

<£2 = 1(1 + ll(@P/k(fy) den Eigenwert X = — 1 und es ist also Q(J(CO2)) ^ 1.

Beweis.

Es seien

p,

k ungerade

Zahlen,

0 <

max

\i\ = QP(B),

CO2 =

i

= i ( l + \j(Qp/k(B)). Wenn man in der Gleichung

Xp - QP(B) (1 - co2 + Xco2)k = 0

X = — 1 setzt, bekommt man schrittweise

W

-1 - Q"(B) (

\2

2Q'lk(B)

—) = 0,

2

2Q"\B))

- 1 + oHB) - X -

= 0,

was eine gültige Beziehung ist. Ganz analogisch verläuft der Beweis auch in den

übrigen Fällen.

B e m e r k u n g 3. Der Fall, wenn beide Zahlen p und k gerade sind, kommt nicht

in Betracht, da die Zahlen p, k, h nach Vorraussetzung teilerfremd sind.

94

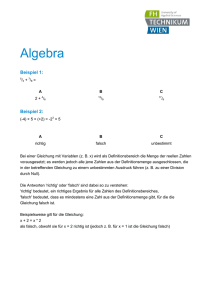

B e m e r k u n g 4. Eine anschauliche Vorstellung über die reellen Nullstellen der

Gleichung (5) im Falle, wenn der Eigenwert fiP der Matrix Bp reell und von Null

verschrieden ist, bekommt man, wenn man die Gleichung (5) in der Form

= (1 ~ CO + AC0f

schreibt. Die graphische Darstellung der Funktion mt(X) = Xp\[iv ist eine Parabel

p-ten Grades mit dem Scheitelpunkt im Koordinatenursprung und die graphische

Darstellung der Funktion gto(A) = (1 — co + Xcof ist eine Parabel k-ten Grades,

die durch den Punkt [1, 1] geht und den Scheitelpunkt im Punkte [(co — l)/co, 0]

Abb. 2.

Abb. 1.

hat (es ist dabei (co — l)/co > 1 für co < 0, (co — l)/co < 0 für 0 < co < 1 und

0 < (co — l)/co < 1 für co > 1). Der Anstieg der Tangente der Funktion gJ(A)

im Punkte [1, 1] ist dem Exponenten k gleich. Die Schnittpunkte beider Graphen

der Funktionen m{ und g^ entsprechen dann den reellen Nullstellen der Gleichung (5).

In Abb. 1 ist die Situation darstellt, wenn p ungerade und k gerade ist, JIP < 0 und

1 < co ist. In Abb. 2 sehen wir den Fall, wenn p gerade und k ungerade ist, \xv > 0

und 0 < co < 1 ist.

Zum Schluss führen wir noch den folgenden Satz an:

6. Es sei p gerade,

k = 1, 0 <

max fit = O(ß) und es gelte co — 1 +

P

+ (p — l)/O (ß). Dann liegt keiner von den Eigenwerten der Matrix T(co) im Einheitskreise.

Beweis. Mit Rücksicht auf die kleinere praktische Bedeutung dieses Satzes

deuten wir seinen Beweis nur kurz an. Man setze voraus, dass im Einheitskreise

95

eine Nullstelle X = x + iy existiert, wo x2 + y2 = r 2 < 1 ist. Aus (5) folgt, dass x

und y die Gleichungen

(8)

(o) xP ~ fyxP~2y2 + (l) x P _ V " - + (" 1 ) W2 (^ P - iiptox + IIP(CO -

1) = 0 ,

(9) (jV-'y - ( j W v + ( j W v - ... + (--T2-1 ( ^ W"1 -

jt£POJy =

0

erfüllen. Da man leicht zeigen kann, dass die Gleichung (5) im Einheitskreise keine

reelle Nullstelle besitzen kann, ist y + 0 und angesichts der Beziehung y2 = r2 — x2

bekommt man nach einer Umformung und Addition der Gleichungen (8) und (9)

die Gleichung

-HO)—v-*•)((;)-(;)) +

(10)

+ x"-4{r2

- x2)2(fP\

- (P\\

- ... + {-\)<>l2(r2 - x2)"'2 (P\

+ n'(o> - l) = 0

und nach einer weiteren Umformung die Gleichung

^^—OTX'J-CX/.JF

+ /ip(co - 1) = 0 .

Es ist also

(12)

P

f(-iyxp-2ir2i2p-2ifP

~y

+

V\ + fip(co - 1) = 0

in Hinsicht auf die kombinatorische Beziehungen

JT/^j-cm

p/2-i

j)J

\

c-:r)

2P_2i/P-(i

("hier setzt man für i = 0 ^

96

" _ |

+ i)\

1}

j J\2(i+j)

í =

) = ( ' j

+1

0 ) 1 ) 2 ) 3 ;

*) = 0.)

_

Man setze in (12) x = ur. Es genügt dann zu beweisen, dass die Gleichung

(13)

f ( - 1 ) - - u — 2 — ( ' - ('

;= i

\

+

^

i —1

- - - f e ~ -) = 0

rp

/

für — 1 < u < 1 und co ^ 1 + (p — l)jjip keine reellen Nullstellen besitzt. Dazu

genügt zu beweisen, dass für — 1 < u < 1 die linke Seite der Gleichung (13) negativ

ist. Da aber iip(w — i)jrp > p — 1 gilt, genügt es zu beweisen, dass die linke Seite

der Gleichung

E(-l) 1 '- 1 up-2i 2p~2i (P ~ (* + ]A - (p - 1) = 0

(14)

für — 1 < u < 1 negativ ist.

In Hinsicht auf die Gültigkeit der kombinatorischen Beziehung

Z(-l) 1 " 1 2"~2' (P ~ ^ + ^ = p - 1

(15)

ist nun klar, dass die Gleichung (14) reelle Nullstellen u = 1 und u = — 1 hat.

Wenn man die Gleichung (14) mit den Wurzelfaktor u2 — 1 < 0 dividiert, bekommt

man angesichts (15) nach der Substitution z = 2u die Gleichung

2

(.«> «„- .-(- )+ ,-(2= (-*) -(-'))+ 0

.

/

3

\

l

/ \

2

/ /

- 2 - ( - ) + ... + (-.r-» ( ( /

/2

V

V o

4)/2 ))-.

Die linke Seite dieser Gleichung ist aber positiv für alle reellen Zahlen z. Das kann

man folgenderweise beweisen:

Es gilt vor allem, dass f4(z) = l

fp+2(z)

) = 1 > 0 ist. Ferner stellt man fest, dass

^ fp(z) ist, da man den Ausdruck fp+2(z)

fp+2(z)-/p(z)

=

~ fP(z) angesichts (16) in der Form

- [ K P - 2 ) ]]

y

( _ I ) U P - 2 - 4 0 fi(p

-

2 ~

2l)\

2

> 0

schreiben kann (hier bezeichnet [{-(p — 2)] den ganzen Teil der Zahl {-(p — 2).

Man bekommt endlich einen Widerspruch mit der Voraussetzung, dass die Gleichungen (8) und (9) im Einheitskreise eine Nullstelle besitzen. Dadurch ist der

Satz 6 bewisen.

97

Literaturverzeichnis

[1] Kjellberg, G.: On the successive over-relaxation method for cyclic Operators. Numerische

Math., 3, 1961, 8 7 - 9 1 .

[2] Varga, R. S.: Matrix Iterative Analysis. Prentice-Hall, INC, 1962.

[3] Šisler, M.: Über ein Iterationsverfahren für zyklische Matrizen. Aplikace matematiky, 17,

225-233, 1972.

Souhrn

O KONVERGENCI JEDNÉ ITERAČNÍ METODY PRO CYKLICKÉ MATICE

MIROSLAV ŠISLER

V práci je zkoumána konvergence jisté iterační metody pro řešení soustavy lineár­

ních rovnic Ax = b. Iterační metoda je definována vzorcem

* v + i = T(co)xv +

y.

Zde T(co) = (£ — OJL)'1 [(1 — OJ) L + U], b' = D~lí>, kde co značí reálný parametr,

matice L, U jsou definovány vztahy L = D~lP, U = D^R a 4 = D - P - R

je jistý rozklad matice A (přitom je D blokově diagonální matice, P a R jsou odpoví­

dající blokově trojúhelníkové matice). Je zřejmé, že metoda přechází pro co = 0

v Jacobiho metodu a pro co = 1 v Gauss-Seidelovu metodu. Předpokládá se, že

matice B = 7(0) = L + U je lineárním operátorem zobrazujícím vektorový prostor

R do R, že R je direktním součtem podprostorů v l 5 ..., vm a že matice L, U splňují

podmínky Lv£ <= v i + h , Uvt a v ř _ k , i = 1, ...,m, kde //, k jsou celá kladná čísla,

h + k = p, přičemž čísla h, k, p nemají netriviálního dělitele.

V práci je zkoumána otázka, pro které hodnoty parametru co metoda konverguje

jak v obecném případě, kdy vlastní čísla matice Bp jsou komplexní, tak i ve speciálním

případě reálných vlastních čísel matice Bp,

Anschrift des Verfassers: Dr. Miroslav Šisler, CSc, Matematický

Žitná 25, 115 67 Praha 1.

98

ústav ČSAV v Praze,