np p pY YTG /) 1( )( − − =

Werbung

1

REPETITORIUM DER ANGEWANDTE STATISTIK II

4 EINFÜHRUNG IN DAS TESTEN VON UNTERSCHIEDSHYPOTHESEN I:

1-STICHPROBENVERGLEICHE

4.1 Binomialtest (Binomial Test)

Problemstellung:

Von der Wahrscheinlichkeit p eines Ereignisses E liegt eine Vermutung

H1 (Alternativhypothese, alternative hypothesis) vor, z.B. in der Form H1: p ≠ p0 (p0 ist

ein fester, vorgegebener Wert); die Menge der p, für die H1 nicht zutrifft, bildet die

Nullhypothese (null hypothesis) H0: p = p0; mit dem Test wird eine Entscheidung

zwischen H0 und H1 angestrebt.

Schema der Problemlösung:

• Beobachten

Testentscheidung baut auf Beobachtungsdaten auf. Das Zufallsexperiment, bei dem

entweder E oder Ec eintritt, wird n-mal durchgeführt; y sei der Anteil der Wiederholungen

mit dem Ereignis E.

•

Modellieren:

Beobachtungsdaten werden durch ein Bernoulli-Experiment mit n Wiederholungen

simuliert; jede Wiederholung liefert mit der Wahrscheinlichkeit p das Ereignis E. Es sei Y

die relative Häufigkeit von E bei n Wiederholungen. Die Anzahl nY der Wiederholungen

mit dem Ausgang E ist Bn,p –verteilt. Für n > 20 und 10 ≤ np ≤ n -10 gilt die

Approximation: Bn,p ≈ N(np, np(1-p)).

•

Präzisieren:

Entscheidungsalternativen: H0 : p = p0 versus H1: p ≠ p0 (Test auf Abweichung mit 2seitigen Hypothesen, two-sided alternative)

Signifikanzniveau (significance level): α-Fehler (meist α=5% angenommen)

Wahrer

Sachverhalt

H0 ist richtig

(p = p0=1/2)

Entscheidung für H0 (gegen

H1)

richtige Entscheidung!

Entscheidung für H1 (gegen H0)

H1 ist richtig

(p ≠ p0=1/2)

Fehler! (2. Art, β-Fehler)

Forderung:

P(Entscheid. gegen H1| |pp0|>∆) ≤ β !

richtige Entscheidung!

Fehler! (1. Art, α-Fehler)

Forderung:

P(Entscheid. für H1|p=p0) ≤ α !

Anmerkung:

Kontrolle des b-Fehlers erfolgt meist im Nachhinein, in dem die relevante Abweichung

∆=|y-p0| gesetzt wird und die Testschärfe (Power)= P(Entscheidung für H1| |p-p0|>∆)

berechnet wird. Besser ist eine Planung des Stichprobenumfangs n im Vorhinein zu

vorgegebener Power=1-β und ∆.

•

Entscheiden:

Hilfsgröße (Testgröße, test statistic) TG(Y) =

Y − p0

p0 (1 − p0 ) / n

bilden (ist unter H0

angenähert standardnormalverteilt); Einsetzen von y (aus der Zufallsstichprobe)

Realisation TGs=TG(y) der Testgröße.

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

2

Entscheidungsregel:

a) mit Quantilen: H0 ablehnen, wenn |TGs| > z1-α/2.

b) mit P-Wert= P(TG < - |TGs| oder TG > |TGs|): H0 ablehnen, wenn P < α.

Ergänzungen:

•

•

Einseitige Hypothesen (one-sided alternatives):

Test auf Überschreitung mit den Hypothesen: H0 : p ≤ p0 versus H1 : p > p0

Entscheidungsregel: H0 ablehnen, wenn TGs > z1-α (mit Quantilen) bzw. H0

ablehnen, wenn P= P(TG > TGs) = < α. (mit P-Wert)

Test auf Unterschreitung mit den Hypothesen: H0 : p ≥ p0 versus H1 : p < p0

Entscheidungsregel: H0 ablehnen, wenn TGs < zα (mit Quantilen) bzw. H0

ablehnen, wenn P= P(TG < TGs) = < α. (mit P-Wert)

Gütefunktion (power function):

Die Fehlerrisken (α-Fehler, β-Fehler) werden in der sog. Gütefunktion (Power) G

zusammengefasst:

G(p) = P(Ablehnung von H0 | p) = Wahrscheinlichkeit, auf Grund einer Zufallsstichprobe

gegen H0 zu entscheiden

Es gilt: G(p) ≤ α, wenn H0 zutrifft; wenn H1 zutrifft ist die Güte umso besser, je näher G(p)

bei 1 liegt (d.h. je kleiner das β-Risiko β(p) = 1-G(p) ist).

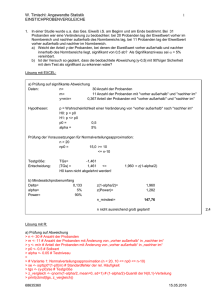

1.0

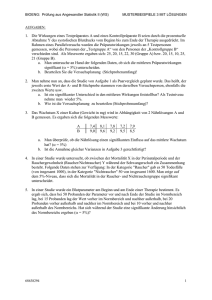

Gütefunktionen des Binomialtests mit H1: p>0.5

Testniveau=5%, Stichprobenumfang n= 50, 100 bzw. 1000

n=100

n=50

0.6

0.4

0.2

G(p)=P(Ablehnung von H0|p)

0.8

n=1000

0.0

(0.5, 0.05)

0.4

0.5

0.6

0.7

0.8

p

•

Mindeststichprobenumfang:

Die Fehlerrisken α und β, die relevante Abweichung ∆ =|p - p0| und der

Stichprobenumfang n sind voneinander abhängig. Dies ermöglicht es, bei vorgegebenen

Werten von α, ß und ∆ den Stichprobenumfang zu bestimmen, d.h. eine Planung des

Stichprobenumfangsvorzunehmen.

Näherungsformeln für den notwendigen Stichprobenumfang n, um auf Niveau α mit der

Sicherheit 1-ß eine Entscheidung für H1 herbeizuführen, wenn p von p0 um ∆ ≠ 0 im

Sinne der Alternativhypothese abweicht:

1

2

n ≈ 2 (z1−α / 2 + z1−β ) (für 2 - seitige Hypothesen),

4∆

1

2

n ≈ 2 (z1−α + z1−β )

4∆

W. Timischl: Angewandte_Statistik_II_Repetitorium

(für 1 - seitige Hypothesen)

21.05.12

3

•

Nicht-signifikante Testergebnisse:

Wenn eine Entscheidung für H1 auf dem vorgegebenen Signifikanzniveau a nicht

möglich ist, spricht man von einem nicht-signifikantem Ergebnis. Ein nicht-signifikantes

Ergebnis erlaubt nur dann eine Entscheidung für H0, wenn die Power ausreichend groß

ist (zumindest 80%).

R-Funktionen: binom.test(), prop.test()

4.2 Einstichproben t-Test (One-Sample t Test)

Problemstellung:

Es soll entschieden werden, ob der Mittelwert µ einer normalverteilten Zufallsvariablen

von einem vorgegebenen Sollwert µ0 abweicht (oder µ0 überschreitet bzw.

unterschreitet).

Ablaufschema:

• Beobachtungsdaten:

Beobachtungswerte x1, x2, ... , xn

Mittelwert, Varianz s2.

•

Modell:

xi ist Realisation von Xi ∝ N(µ, σ2), (i =1,2, ... ,n).

•

Hypothesen:

2-seitige Hypothesen:

1-seitige Hypothesen:

Signifikanzniveau: α

•

H0 : µ = µ0 vs. H1 : µ ≠ µ0 (Fall I)

H0 : µ ≤ µ0 vs. H1 : µ > µ0 (Fall IIa)

H0 : µ ≥ µ0 vs. H1 : µ < µ0 (Fall IIb)

Testgröße:

X − µ0

≅ tn −1 unter µ = µ0

S

/

n

• Entscheidung mit Quantilen:

TG =

H0 auf Testniveau α ablehnen, wenn |TGs| > tn-1,1-α/2 (Fall I),

TGs > tn-1,1-α (Fall IIa) bzw. TGs < tn-1,α (Fall IIb)

•

Entscheidung mit P-Wert:

H0 auf Signifikanzniveau α ablehnen, wenn P < α, wobei

P=P(TG ≤ -|TGs| oder TG ≥ |TGs|) (Fall I) bzw.

P=P(TG ≥ |TGs|) (Fall IIa) bzw. P=P(TG ≤ -|TGs|) (Fall IIb).

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

4

•

Planung des Stichprobenumfanges:

Um auf dem Niveau α mit der Sicherheit 1-β eine Entscheidung für H1 herbeizuführen,

wenn µ von µ0 um ∆ ≠ 0 im Sinne der Alternativhypothese abweicht, ist das dafür

notwendige n näherungsweise (etwa ab n=20)

n≈

n≈

•

σ2

∆

2

σ2

∆

2

(z

1−α / 2

(z

1−α

+ z1− β )

2

+ z1− β )

2

(für 2 - seitige Hypothesen )

(für 1 - seitige Hypothesen )

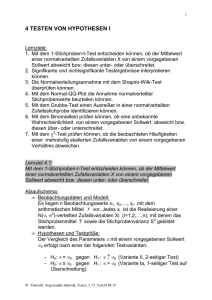

Gütefunktion:

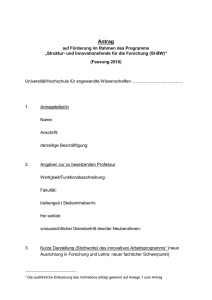

Gütefunktion des t-Tests H0 : µ = µ0 versus H1: µ ≠ µ0 für n =6 und

n = 20 (horizontal ist die Effektgröße δ =(µ - µ0)/σ aufgetragen)

1,0

n=20

0,9

0,8

n=6

Power

0,7

0,6

0,5

0,4

0,3

0,2

0,1

0,0

-2,0

-1,0

0,0

1,0

2,0

Effektgröße

R-Funktion: t.test()

4.3 χ2 – Anpassungstest und Shapiro-Wilk Test

(χ2 goodness-of-fit test, Shapiro-Wilk test)

Problemstellung 1:

Es soll entschieden werden, ob die beobachteten Häufigkeiten einer mehrstufig

skalierten Zufallsvariablen von einem vorgegebenen Verhältnis abweichen.

Ablaufschema:

• Beobachtungsdaten:

Es liegen n Beobachtungen einer k-stufig skalierten Variablen vor, zur Stufe (Klasse) ai

gehören oi Beobachtungen.

•

Modell:

pi = Wahrscheinlichkeit, dass ein Beobachtungsergebnis zur Klasse ai gehört;

Ei = npi = zu erwartende Häufigkeit von Beobachtungswerten in der Klasse ai,

Oi = beobachtete Häufigkeit von Variablenwerten in der Klasse ai.

•

Hypothesen und Testgröße:

H0: pi = p0i (i=1,2, ..., k) vs. H1: pi ≠ p0i für wenigstens ein i

Testgröße (Chiquadratsumme, Goodness-of-fit-Statistik):

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

5

k

TG= GF =

∑

i =1

(Oi − E i )2

Ei

≅ χ k2−1 bei Gültigkeit von H 0

Hinweis:

2

Die Testgröße ist unter H0 asymptotisch χ − verteilt mit k-1 Freiheitsgraden; die

Approximation ist ausreichend genau, wenn nicht mehr als 20% der erwarteten

Häufigkeiten kleiner als 5 sind und keine kleiner als 1 ist.

•

Entscheidung mit Quantilen:

H0 auf Testniveau α ablehnen, wenn TGs > χ2k-1,1-α

•

Entscheidung mit P-Wert:

H0 auf Signifikanzniveau α ablehnen, wenn P < α wobei P=P(TG ≥ |TGs|).

Problemstellung 2:

Es soll entschieden werden, ob eine mehrstufig skalierte Zufallsvariable von einer

vorgegebenen Verteilung mit unbekannten Parametern abweicht.

Ablaufschema:

• Wie bei Problemstellung 1 mit der Ergänzung, dass zu Bestimmung der erwarteten

Häufigkeiten die/der Verteilungsparameter zu schätzen sind und für jeden geschätzten

2

Parameter sich die Anzahl der Freiheitsgrade der χ − Verteilung um 1 vermindert. Die

Nullhypothese lautet: Die Zufallsvariable folgt der vorgegebenen Verteilung.

Problemstellung 3:

Es soll entschieden werden, ob die Verteilung einer metrischen Zufallsvariablen von

einer Normalverteilung abweicht?

Ablaufschema:

• Chiquadrat-Anpassungstest:

Grundsätzlich kann die Prüfung, ob die Variation einer Messgröße von der

Normalverteilung abweicht, wie die Prüfung auf ein vorgegebenes Verhältnis mit der

Ergänzung durchgeführt werden, dass zuerst der Mittelwert und die Standardabweichung

der Normalverteilung – aus den Messdaten - zu schätzen sind, eine Klasseneinteilung

der Merkmalsachse vorzunehmen ist und die erwarteten Häufigkeiten als

Klassenhäufigkeiten zu bestimmen sind. Die Anzahl der Freiheitsgrade der

χ 2 − Verteilung ist k–3, wobei k wieder die Anzahl der Klassen bezeichnet. Die

Nullhypothese lautet: Die Zufallsvariable ist normalverteilt. Die Nullhypothese wird auf

dem Testniveau α abgelehnt, wenn die mit den beobachteten und erwarteten

Klassenhäufigkeiten gebildete Chiquadratsumme GF größer als das (1-α)-Quantil der

χ 2 -Verteilung mit k-3 Freiheitsgraden ist. Die Anwendung des ChiquadratAnpassungstests zur Überprüfung der Normalverteilungsannahme setzt entsprechend

große Stichproben (n≥60, k≥7) voraus.

•

Shapiro-Wilk Test:

Hat man eine entsprechende Statistik-Software zur Verfügung, wird an Stelle des

Chiquadrat-Anpassungstests ein auch bei kleinen Stichproben anwendbarer exakter Test

empfohlen, z.B. der im Basis-Package von R vorgesehene Shapiro-Wilk Test. Die

Nullhypothese (die Stichprobenwerte stammen aus einer normalverteilten

Grundgesamtheit) wird beibehalten, wenn der P-Wert gleich oder größer als das

angenommene Testniveau α bleibt.

R-Funktionen: chisq.test(), shapiro.test()

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

6

4.4 Grundlagen der Qualitätssicherung

Statistische Prozesslenkung

Qualitätsregelkarten (control chart)

Wir betrachten den Einsatz von Qualitätsregelkarten zur Klärung der Frage, ob ein

Prozess „beherrscht“ ist. Für einen beherrschten Prozess bleibt die Verteilung des

Qualitätsmerkmals X im Laufe des Prozesses unverändert. Wenn X – wie wir annehmen

wollen - normalverteilt ist, bedeutet dies, dass die Werte von X mit einer festen

Fehlervarianz σ2 zufällig um einen festen Mittelwert (dem Fertigungsmittelwert) µ

streuen. Große oder systematische in eine Richtung gehende Abweichungen vom

Mittelwert deuten eine (unerwünschte) Änderung des Mittelwertes und/oder der

Standardabweichung an, die z.B. durch Störungen in der Fertigungsanlage bedingt sein

können.

Mittelwertkarte (control chart for the mean)

Die Eingriffsgrenzen (action limits) der Mittelwertkarte ( x -Karte) werden aus der

Forderung P( X < UEG) = P( X > OEG) = 0,5% bestimmt; daraus ergibt sich:

UEG = µˆ − z0 ,995σˆ / n , OEG = µˆ + z 0, 995σˆ / n ;

analog werden die Warngrenzen (warning limits) aus der Forderung P( X < UWG) =

P( X > OWG) = 2,5%, d.h.

UWG = µˆ − z 0,975σˆ / n , OWG = µˆ + z 0,975σˆ / n .

In diesen Formeln sind

µ̂

und

σˆ

Schätzwerte für den Fertigungsmittelwert µ und die

Fertigungsstreuung σ. Den Schätzwert µ̂ gewinnt man durch Mittelung der

Stichprobenmittelwerte über die Erhebungszeitpunkte; analog wird σ2 durch den

Mittelwert der Stichprobenvarianzen geschätzt, die Quadratwurzel dieses Mittelwerts ist

schließlich der gesuchte Schätzwert σˆ für σ. Neben den Eingriffs- und Warngrenzen ist

in der x -Karte auch der Schätzwert µ̂ für den Fertigungsmittelwert (als Mittellinie MLµ =

µ̂

parallel zur Zeitachse) eingezeichnet.

s-Karte (contrtol chart for the standard deviation)

Die Eingriffsgrenzen der s-Karte werden aus der Forderung P(S2 < UEG2) = P(S2 >

OEG2) = 0,5% bestimmt; daraus ergibt sich:

UEG = σˆ

χ n2−1, 0.005

n −1

, OEG = σˆ

χ n2−1, 0.995

n −1

.

analog werden die Warngrenzen aus der Forderung P(S2 < UWG2) = P(S2 > OWG2) =

2,5% bestimmt, d.h.

UWG = σˆ

χ n2−1, 0.025

n −1

, OWG = σˆ

χ n2−1, 0.975

n −1

.

Für die Mittellinie der s-Karte ergibt sich die Lage:

MLs = E[ S ] = k nσˆ mit k n =

n

Γ

2

2 .

n − 1 n − 1

Γ

2

R-package: qcc

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

7

Annahmestichprobenprüfung

Problemstellung:

Die Annahmestichprobenprüfung (acceptance sampling) wird zur Eingangsprüfung oder

Endkontrolle von Prüflosen (=Zusammenfassung von unter vergleichbaren Bedingungen

hergestellten Einheiten) verwendet. Die Überprüfung erfolgt mit einer so genannten

Stichprobenanweisung, die über den Umfang der Prüfstichprobe sowie über die

Entscheidung für die Annahme oder die Zurückweisung des Prüfloses Auskunft gibt.

Prüfung auf fehlerhafte Einheiten (Attributprüfung, acceptance sampling for attributes):

•

Verteilungsmodell:

Es sei N der Umfang des Prüfloses, a die Anzahl der schlechten Einheiten im Prüflos

(Ausschusszahl), p = a/N der Fehleranteil (bzw. Ausschussanteil) und n der Umfang der

Prüfstichprobe. Die Stichprobennahme aus dem Prüflos möge dem Modell der

„Zufallsziehung ohne Zurücklegen“ folgen; dann ist die Anzahl X der schlechten Einheiten

in der Prüfstichprobe hypergeometrisch verteilt.

•

Annahmewahrscheinlichkeit:

Es sei vereinbart, dass das Prüflos mit dem Umfang n im Falle X ≤ c angenommen und

im Falle X > c abgelehnt wird (c ist die maximal zulässige Anzahl von

Ausschusseinheiten, acceptance number). Die Wahrscheinlichkeit Pa, dass nach dieser

kurz als (n,c)-Plan bezeichneten Stichprobenanweisung (sampling plan) das Prüflos

angenommen wird, ist in Abhängigkeit vom Ausschussanteil p=a/N (a=0, 1, 2, …, N)

gegeben durch:

c

Pa ( p | n, c) =

∑H

c

N ,n , p

( x) =

x =0

∑

x =0

a N − a

x n − x mit a = Np

N

n

Unter der Voraussetzung n/N < 0,1 und N > 60 können die Verteilungsfunktionswerte

HN,n,p(x) mit ausreichender Genauigkeit durch die entsprechenden Werte der

Binomialverteilung Bn,p approximiert werden; die Formel für die

Annahmewahrscheinlichkeit vereinfacht sich damit auf:

c

Pa ( p | n, c) =

∑

x=0

c

n x

p (1 − p)n−x

x

∑

Bn, p ( x) =

x=0

Auf der Grundlage dieser Approximation kann zu einem vorgegebenen Wert γ der

Annahmewahrscheinlichkeit Pa(p|n,c) der entsprechende Ausschussanteil pγ berechnet

werden:

pγ =

•

(c + 1) F2( c +1), 2( n −c ),1−γ

n − c + (c + 1) F2( c +1), 2 ( n −c ),1−γ

=

c +1

c + 1 + ( n − c ) F2 ( n −c ), 2( c +1),γ

OC- Kurven (operating characteristic curves):

Bezeichnet D={p|p=a/N und a=0, 1, …, N} die Menge der möglichen Ausschussanteile,

so heißt die auf D definierte Funktion f: D [0,1] mit der Gleichung f(p)=Pa(p|n, c) die

Operationscharakteristik der Stichprobenanweisung (n, c). Der Graph der Operationscharakteristik heißt Annahmekennlinie oder OC-Kurve.

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

8

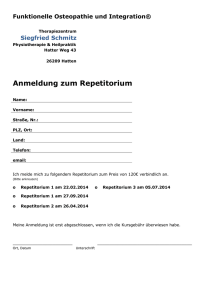

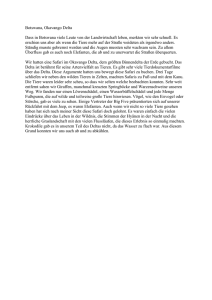

1

OC-Kurven zu (n,c)-Prüf plänen mit

n=20 bzw. n=30 und c=1

PRP

10,8

ti

e

k

h 0,6

icl

in

e

h

c

sr 0,4

h

a

w

e

m0,2

h

a

n

n

A

n=20, c=1

n=30, c=1

CRP

0

0,0

p1-

0,1

p

0,2

0,3

Fehleranteil p

Man erkennt:

Die OC-Kurven verlaufen monoton fallend vom Wert 1 bei p=0 auf den Wert 0 bei

p=1; mit wachsendem n wird der Kurvenverlauf steiler.

Sehr gute Lose (p ≤ p1-α) sollen mit einer (hohen) Wahrscheinlichkeit Pa(p|n,c) ≥ 1α angenommen und mit einer kleinen Wahrscheinlichkeit 1- Pa(p|n,c) < α

(irrtümlich) zurückgewiesen werden; α ist z.B. 10% oder 5% und heißt das

Lieferantenrisiko; p1-α wird Annahmegrenze (kurz AQL, acceptable quality level)

genannt. Der Punkt (p1-α, 1-α) auf der OC-Kurve heißt auch Producer Risk Point

(PRP).

Sehr schlechte Lose (p ≥ pβ) sollen mit einer (kleinen) Wahrscheinlichkeit

Pa(p|n,c) ≤ β (irrtümlich) angenommen und mit einer großen Wahrscheinlichkeit 1Pa(p|n,c) > 1-β zurückgewiesen werden; β ist wie α z.B. 10% oder 5% und heißt

das Abnehmerrisiko; pβ wird Ablehngrenze (kurz LQL, limiting quality level)

genannt. Der Punkt (pβ, β) auf der OC-Kurve wird auch Consumer Risk Point

(CRP) genannt.

-

•

Auswahl einer geeigneten Stichprobenanweisung:

Zur Bestimmung der Parameter n und c werden die Gleichungen

Pa(p1-α|n,c) = 1-α und Pa(pβ|n,c) = β herangezogen, die in geometrischer Deutung

verlangen, dass die Punkte (p1-α,1-α) und (pβ,β) auf der OC liegen. Diese Vorgaben

entsprechen den Forderungen, dass das Prüflos bis zum (kleinen) Fehleranteil p1-α,

zumindest mit der (hohen) Wahrscheinlichkeit 1-α und ab dem (hohen) Fehleranteil pβ

höchstens mit der (kleinen) Wahrscheinlichkeit β angenommen wird. Eine Auflösung des

Gleichungssystems Pa(p1-α|n,c) = 1-α, Pa(pβ|n,c) = β ist nur auf numerischem Wege

möglich. Um ganzzahlige Lösungswerte für n und c zu finden, müssen die Gleichungen i.

Allg. als Ungleichungen Pa(p1-α|n,c) ≥ 1-α, Pa(pβ|n,c) ≤ β betrachtet werden.

Annahmeprüfung bei einem quantitativen Merkmal (acceptance sampling by variables):

•

Annahmewahrscheinlichkeit und OC-Kurve:

Wir setzen das Merkmal X als normalverteilt mit den Parametern µ und σ2 voraus und

nehmen an, dass der Fertigungsmittelwert µ unbekannt, die Fertigungsstreuung σ2 der

Einfachheit halber aber bekannt ist. Ferner beschränken wir uns auf den Fall, dass X

nur mit einer kleinen Wahrscheinlichkeit p eine vorgegebene obere Toleranzgrenze To

überschreiten soll (einseitiges Kriterium „nach oben“).

Wegen P(X ≤ To) = 1 – P(X > To) = 1- p, ist To das (1-p)-Quantil der Verteilung von X. Es

folgt, dass die standardisierte Größe (To -µ)/σ gleich dem (1-p)-Quantil z1-p der

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

9

Standardnormalverteilung ist, d.h. der Fertigungsmittel-wert kann in der Form µ = To -σz1p dargestellt werden. Die Wahrscheinlichkeit p ist der zu erwartende Anteil von

schlechten Einheiten (mit X> To).

Zur Schätzung des Fertigungsmittelwerts µ wird dem Prüflos (vom Umfang N) eine

Zufallsstichprobe vom Umfang n<N entnommen und daraus der Stichprobenmittelwert

X bestimmt. Damit wird nun die folgende Prüfvorschrift formuliert: Das Los wird

angenommen, wenn X ≤ To - kσ gilt. Die Konstante k ist der sogenannte Annahmefaktor

und neben der Größe n der Prüfstichprobe die zweite Kennzahl des Prüfplans für ein

metrisches Merkmal.

Für die Annahmewahrscheinlichkeit ergibt sich in Abhängigkeit vom Fertigungsmittelwert

µ die Formel

T − µ

X − µ To − kσ − µ

= = Φ o

Paµ (µ | n, k ) = P (X ≤ To − kσ ) = P

≤

− k n

σ/ n

σ / n

σ

bzw. in Abhängigkeit vom Fehleranteil p, wenn µ = To -σz1-p substituiert wird, die

Formel:

(

Pa ( p | n, k ) = Φ [z1− p − k ] n

)

Den Graphen der Funktion Paµ: µ

Paµ (µ |n,k) bzw. Pa: p

Pa(p |n,k) bezeichnet man

wieder als Annahmekennlinie oder Operationscharakteristik (OC-Kurve) des

verwendeten Prüfplans. Aus der Monotonie von Φ folgt, dass die

Annahmewahrscheinlichkeit mit wachsendem µ bzw. p streng monoton abnimmt.

•

Bestimmung der Kennzahlen k und n:

Die Kennzahlen n und k können durch Vorgabe von 2 Punkten der

Operationscharakteristik bestimmt werden. Wir verlangen, dass

sehr gute Lose (p≤ p1−α) mindestens mit der an der Annahmegrenze AQL=p1−α

vorgegebenen hohen Wahrscheinlichkeit 1-α und

sehr schlechte Lose (p≥ pβ) höchstens mit der an der Ablehngrenze LQL=pβ

vorgegebenen kleinen Wahrscheinlichkeit β angenommen werden.

Für die Annahmewahrscheinlichkeit folgen daraus die Bedingungen

(

P ( LQL | n, k ) = Φ ([z

)

− k ] n ) = β ⇔ [z

Pa ( AQL | n, k ) = Φ [z1− AQL − k ] n = 1 − α ⇔ [z1− AQL − k ] n = z 1−α ,

a

1− LQL

1− LQL

− k ] n = z β = − z 1− β ,

aus denen die Kennzahlenwerte

2

z + z1−β

z z

+ z1−β z1− AQL

, k = 1−α 1−LQL

n = 1−α

z1−α + z1−β

z1− AQL − z1− LQL

bestimmt werden können. Dabei ist n i. Allg. nicht ganzzahlig und durch die nächst

größere ganze Zahl zu ersetzen; wir bezeichnen diese Zahl mit nσ.

-

Annmerkungen:

In der Regel ist die Fertigungsstreuung σ nicht bekannt und ebenso wie der

Fertigungsmittelwert aus der Prüfstichprobe zu schätzen. Es sei s der Schätzwert für

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

10

σ. Der Umfang ns der Prüfstichprobe ergibt sich nun näherungsweise aus ns = (1+

-

k2/2)nσ; diese Formel liefert für ns ≥ 10 brauchbare Näherungswerte.

Entsprechende Überlegungen gelten für den Fall der einseitigen Abgrenzung des

Toleranzbereichs durch einen unteren Grenzwert Tu.

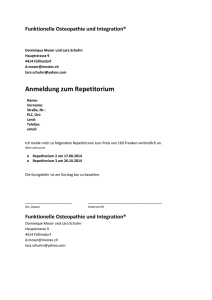

1.0

OC-Kurve für Messmerkmal X mit STD=2

(obere Toleranzgrenze=100, n=73, k=1.452)

0.8

0.6

0.4

0.2

Annahmewahrscheinlichkeit Pa(p_X)

PRP

0.0

CRP

0.00

0.05

0.10

0.15

0.20

Ausschussanteil p_X

R-Funktionen: library(AcceptanceSampling), OC2c(), find.plan(), OCvar()

4.5 Musterbeispiele

1. In einer Studie wurde ein Blutparameter am Beginn und am Ende einer Therapie

bestimmt. Es ergab sich, dass bei 35 Probanden eine Veränderung des Parameters

eintrat, und zwar lag der Wert bei 15 Probanden vorher im Normbereich und nachher

außerhalb und bei 20 Probanden vorher außerhalb und nachher im Normbereich.

a. Weicht der Anteil der Veränderungen von „vorher außerhalb“ in „nachher innerhalb“

signifikant von 0.5 ab (alpha = 5%)?

b. Welcher Anzahl von Probanden mit einer Veränderung müsste man haben, um mit

dem Test die beobachtete Abweichung des Anteils von 0.5 mit einer Sicherheit von

90% als signifikant zu erkennen?

Präzisierung der Aufgabe:

Wir bezeichnen die Zufallsvariable „Veränderung des Blutparameters auf Grund der Therapie“

mit X. X ist eine zweistufige Zufallsvariable mit den Werten „vorher außerhalb nachher

innerhalb“ bzw. „vorher innerhalb nachher außerhalb“. Die Anzahl der Veränderungen von

„vorher außerhalb nachher innerhalb“ ist binomialverteilt mit den Parametern p =

P(Veränderung von „vorher außerhalb nachher innerhalb“) und n = 35.

Teilaufgabe 1a (zweiseitiger Binomialtest):

Lösungsansatz und numerische Lösung:

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

11

In der Teilaufgabe a) ist gefragt, ob p von 0,5 abweicht, d.h. es geht um einen Vergleich einer

Wahrscheinlichkeit mit einem Sollwert. Die Alternativhypothese lautet H1: p <> 0,5, die

Nullhypothese ist H0: p=0,5. Die Testentscheidung wird mit dem Binomialtest auf dem

Testniveau alpha=5% durchgeführt. Aus der Stichprobe entnimmt man den Stichprobenumfang

n=35 sowie die Anzahl m = 20 der Probanden mit einer Veränderung von „vorher außerhalb

nachher innerhalb“.

Lösung mit R:

>

>

>

>

>

>

>

# 1a

n <- 35

m <- 20

alpha <- 0.05

soll=0.5

# H0: p=0.5 versus H1: p<>0.5

binom.test(m, n, p=soll, alternative="two.sided", conf.level=0.95)

Exact binomial test

data: m and n

number of successes = 20, number of trials = 35, p-value = 0.4996

alternative hypothesis: true probability of success is not equal to 0.5

95 percent confidence interval:

0.3935309 0.7367728

sample estimates:

probability of success

0.5714286

Ergebnis:

Wegen p-value = 0.4996 >= 0.05 kann H0: p=0.5 nicht abgelehnt werden!

Teilaufgabe 1b (Mindeststichprobenumfang):

Lösungsansatz und numerische Lösung:

In der Teilaufgabe b) wird nach dem erforderlichen Mindeststichprobenumfang n_mindest

(Anzahl der Probanden mit einer Veränderung) gefragt, um mit dem in 1a) durchgeführten

Binomialtest die beobachtete Abweichung delta=|20/35-0,5| mit der Sicherheit 1-ß= 0,9 als

signifikant zu erkennen.

Approximative Bestimmung des Mindeststichprobenumfangs mit der Formel ((Die Formel liefert

vertretbare Näherungswerte, wenn n >20 und 10<= np0 < n-10 ist.):

nmin dest ≈

1

(z1−α / 2 + z1−β )2

2

4∆

Lösung mit R:

>

>

>

>

>

>

>

# 1b (Approximation)

delta <- abs(m/n-0.5)

power <- 0.9

alpha <- 0.05

n_mindest <- 1/4/delta^2*(qnorm(1-alpha/2)+qnorm(power))^2

options(digits=4)

print(cbind(delta, alpha, power, n_mindest))

delta alpha power n_mindest

[1,] 0.07143 0.05

0.9

514.9

Ergebnis:

Es ist ein Mindeststichprobenumfang von n_mindest=515 erforderlich, um mit dem auf 5%igen

Signifikanzniveau geführten Test die Abweichung delta=0.07143 vom Sollwert 0.5 mit einer

Sicherheit von 90% als signifikant zu erkennen.

2. Im Rahmen einer Untersuchung des Ernährungsstatus von Schulkindern aus den

Regionen A und B wurde u.a. das Gesamtcholesterin (in mg/dl) stichprobenartig erfasst.

a. Man prüfe für die Region A auf 5%igem Niveau, ob der Anteil von Schulkindern in der

optimalen Kategorie signifikant über p0 = 0,5 liegt.

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

12

b. Welcher Stichprobenumfang müsste geplant werden, um mit dem Binomialtest auf

dem Niveau alpha = 5% eine Überschreitung des Referenzwertes p0 = 0.5 um 0.1 mit

90%iger Sicherheit erkennen zu können?

Gesamtcholesterin

<170 (optimal)

>=170 (Risiko)

Region A

95

60

Region B

80

50

Präzisierung der Aufgabe:

Wir bezeichnen die Zufallsvariable „Gesamtcholesterin“ mit X. X ist auf einer zweistufigen Skala

mit den Werten „<170 (optimal)“ bzw. „>=170 (Risiko)“ dargestellt. Die Anzahl der Schulkinder

mit einem optimalen X-Wert ist binomialverteilt mit den Parametern p = P(ein Schulkind in

Region A hat einen optimalen X-Wert) und n = 95+60 = 155 (Region A).

Teilaufgabe 2a (einseitiger Binomialtest):

Lösungsansatz und numerische Lösung:

In der Teilaufgabe a) ist gefragt, ob p größer als 0,5 ist; die Alternativhypothese lautet also H1:

p>0,5; die Nullhypothese ist H0: p<=0,5. Die Testentscheidung wird mit dem Binomialtest auf

dem Testniveau alpha=5% durchgeführt. Aus der Stichprobe entnimmt man den

Stichprobenumfang n=155 (Region A) sowie die Anzahl m = 95 der Schulkinder mit einem

optimalen Cholesterinwert.

Lösung mit R:

>

>

>

>

>

>

>

# Aufgabe 2a

m <- 95

n <- 95+60

alpha <- 0.05

soll=0.5

# H0: p<=0.5 versus H1: p>0.5

binom.test(m, n, p=soll, alternative="greater", conf.level=0.95)

Exact binomial test

data: m and n

number of successes = 95, number of trials = 155, p-value = 0.003066

alternative hypothesis: true probability of success is greater than 0.5

95 percent confidence interval:

0.5440993 1.0000000

sample estimates:

probability of success

0.6129032

Ergebnis:

Wegen p-value = 0.003066 <0.05 wird H0: p<=0.5 abgelehnt, d.h. der Anteil der Schulkinder mit

einem optimalen Cholesterinwert liegt auf 5%igem Testniveau signifikant über 0,5.

Teilaufgabe 2b (Mindeststichprobenumfang):

Lösungsansatz und numerische Lösung:

In der Teilaufgabe b) wird nach dem erforderlichen Mindeststichprobenumfang n_mindest

(Anzahl der Schulkinder) gefragt, um mit dem in 2a) durchgeführten Binomialtest die

Überschreitung delta=0,1 des Sollwertes p0=0,5 mit der Sicherheit 1-ß= 0.9 als signifikant zu

erkennen. Die Bestimmung des Mindeststichprobenumfangs erfolgt näherungsweise mit der

Formel (Die Formel liefert vertretbare Näherungswerte, wenn n >20 und 10<= np0 < n-10 ist.):

nmin dest ≈

1

(z1−α + z1−β )2

2

4∆

Lösung mit R:

>

>

>

>

# Aufgabe 2b (Approximation)

delta <- 0.1

power <- 0.9

alpha <- 0.05

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

13

> n_mindest <- 1/4/delta^2*(qnorm(1-alpha)+qnorm(power))^2

> options(digits=4)

> print(cbind(delta, alpha, power, n_mindest))

delta alpha power n_mindest

[1,]

0.1 0.05

0.9

214.1

Ergebnis:

Es ist ein Mindeststichprobenumfang von n_mindest=215 erforderlich, um mit dem auf 5%igen

Signifikanzniveau geführten Binomialtest die Überschreitung delta=0.1 des Sollwertes p0=0.5

mit einer Sicherheit von 90% als signifikant zu erkennen.

3. Von einer Messstelle wurden die folgenden Werte der Variablen X (SO2-Konzentration

der Luft in mg/m3) gemeldet: 32, 41, 33, 35, 34.

a. Weicht die mittlere SO2-Konzentration signifikant vom Wert µo=30 ab? (alpha=5%)

b. Welcher Mindeststichprobenumfang müsste geplant werden, um mit dem Test eine

Abweichung vom Referenzwert µo um 5% (des Referenzwertes) mit einer Sicherheit

von 95% erkennen zu können?

Präzisierung der Aufgabe:

Wir nehmen an, dass X normalverteilt ist mit dem Mittelwert µ und der Varianz σ2.

Teilaufgabe 3a (1-Stichproben t-Test):

Lösungsansatz und numerische Lösung:

In der Teilaufgabe a) ist gefragt, ob µ von µ0=30 abweicht, d.h. es geht um den Vergleich eines

Mittelwerts mit einem Sollwert. Die Alternativhypothese lautet H1: µ <> 30, die Nullhypothese

ist H0: µ =30. Die Testentscheidung wird mit dem 1-Stichproben-t -Test auf dem Testniveau

alpha=5% durchgeführt. Aus der Stichprobe entnimmt man den Stichprobenumfang n sowie die

Schätzwerte für µ und σ.

Lösung mit R:

>

>

>

>

>

>

>

# Aufgabe 3a

so2 <- c(32, 41, 33, 35, 34)

n <- length(so2)

xquer <- mean(so2)

s <- sd(so2)

options(digits=4)

print(cbind(n, xquer, s))

n xquer

s

[1,] 5

35 3.536

> t.test(so2, alternative="two.sided", mu=30, conf.level=0.95)

One Sample t-test

data: so2

t = 3.162, df = 4, p-value = 0.03411

alternative hypothesis: true mean is not equal to 30

95 percent confidence interval:

30.61 39.39

sample estimates:

mean of x

35

Ergebnis:

Wegen p-value = 0.03411 <0.05 wird H0: µ<>30 abgelehnt, d.h. die mittlere SO2-Konzentration

weicht auf 5%igem Testniveau signifikant vom Sollwert 30 ab.

Teilaufgabe 3b (Mindeststichprobenumfang):

Lösungsansatz und numerische Lösung:

In der Teilaufgabe b) wird nach dem erforderlichen Mindeststichprobenumfang n_mindest

(Anzahl der Messwiederholungen) gefragt, um mit dem in 3a) durchgeführten t-Test die

Abweichung delta=1,5 (5% von µ0) vom Sollwert µ0 mit der Sicherheit 1-ß= 0,95 als signifikant

zu erkennen. Die Bestimmung des Mindeststichprobenumfangs erfolgt (näherungsweise) mit der

Formel

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

14

nmin dest ≈

σ2

∆

2

(z

1−α / 2

+ z1−β )

2

oder einfacher mit der R-Prozedur power.t.test().

Lösung mit R:

>

>

>

>

>

>

# Aufgabe 3b

so2=c(32, 41, 33, 35, 34)

s <- sd(so2)

soll <- 30

delta <- 0.05*soll

print(cbind(soll, delta, s))

soll delta

s

[1,]

30

1.5 3.536

> power.t.test(delta=delta, sd=s, sig.level=0.05, power=0.95,

+ type ="one.sample", alternative="two.sided")

One-sample t test power calculation

n

delta

sd

sig.level

power

alternative

=

=

=

=

=

=

74.14

1.5

3.536

0.05

0.95

two.sided

Ergebnis:

Es ist ein Mindeststichprobenumfang von n_mindest=75 erforderlich, um mit dem auf 5%igen

Signifikanzniveau geführten t-Test die Abweichung delta=1,5 vom Sollwert 30 mit einer

Sicherheit von 95% als signifikant zu erkennen.

4. In einer Studie mit 5 Probanden wurde eine bestimmte Zielgröße X am Studienbeginn

(Xb) und – nach erfolgter Behandlung - am Studienende (Xe) gemessen.

a. Man erfasse die Wirkung der Behandlung durch die Differenz Y= Xe - Xb und prüfe,

ob der Mittelwert von Y signifikant von Null abweicht (alpha=5%).

b. Welcher Stichprobenumfang müsste geplant werden, um die halbe beobachte

Differenz der mittleren Wirkungen mit einer Sicherheit von 90% als signifikant zu

erkennen?

Proband

1

2

3

4

5

Xb

67

63

44

27

32

Xe

69

71

46

26

35

Präzisierung der Aufgabe:

Wir nehmen an, dass die Wirkung Y=Xe – Xb normalverteilt ist mit dem Mittelwert µ und der

Varianz σ2.

Teilaufgabe 4a (1-Stichproben t-Test):

Lösungsansatz und numerische Lösung:

In der Teilaufgabe a) ist gefragt, ob µ von µ0=0 abweicht, d.h. es geht um den Vergleich eines

Mittelwerts mit einem Sollwert. Die Alternativhypothese lautet H1: µ<>0, die Nullhypothese ist

H0: µ=0. Die Testentscheidung wird mit dem 1-Stichproben-t -Test auf dem Testniveau

alpha=5% durchgeführt. Aus der Stichprobe entnimmt man den Stichprobenumfang n sowie die

Schätzwerte yquer und s für µ bzw σ.

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

15

Lösung mit R:

>

>

>

>

>

# Aufgabe 4a

xb <- c(67, 63, 44, 27, 32)

xe <- c(69, 71, 46, 26, 35)

y <- xe - xb

print(cbind(xb, xe, y))

xb xe y

[1,] 67 69 2

[2,] 63 71 8

[3,] 44 46 2

[4,] 27 26 -1

[5,] 32 35 3

> n <- length(y)

> yquer <- mean(y)

> s <- sd(y)

> options(digits=4)

> print(cbind(n, yquer, s))

n yquer

s

[1,] 5

2.8 3.271

> t.test(y, alternative="two.sided", mu=0, conf.level=0.95)

One Sample t-test

data: y

t = 1.914, df = 4, p-value = 0.1281

alternative hypothesis: true mean is not equal to 0

95 percent confidence interval:

-1.262 6.862

sample estimates:

mean of x

2.8

Ergebnis:

Wegen p-value = 0.1281>=0.05 kann H0: µ<>0 nicht abgelehnt werden, d.h. die mittlere

Wirkung weicht auf 5%igem Testniveau nicht signifikant vom Sollwert 0 ab.

Teilaufgabe 4b (Mindeststichprobenumfang):

Lösungsansatz und numerische Lösung:

In der Teilaufgabe b) wird nach dem erforderlichen Mindeststichprobenumfang n_mindest

(Anzahl der Messwiederholungen) gefragt, um mit dem in 3a) durchgeführten t-Test die halbe

beobachtete Abweichung des Stichprobenmittelwerts yqer vom Sollwert 0 mit der Sicherheit 1ß= 0,90 als signifikant zu erkennen. Die Bestimmung des Mindeststichprobenumfangs erfolgt mit

der R-Prozedur power.t.test().

Lösung mit R:

>

>

>

>

>

>

>

>

# Aufgabe 4b

xb <- c(67, 63, 44, 27, 32)

xe <- c(69, 71, 46, 26, 35)

y <- xe - xb

soll <- 0

s <- sd(y)

delta <- abs(mean(y)/2- soll)

print(cbind(soll, delta))

soll delta

[1,]

0

1.4

> options(digits=4)

> power.t.test(delta=delta, sd=s, sig.level=0.05, power=0.90,

+ type ="one.sample", alternative="two.sided")

One-sample t test power calculation

n

delta

sd

sig.level

power

alternative

=

=

=

=

=

=

59.32

1.4

3.271

0.05

0.9

two.sided

Ergebnis:

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

16

Es ist ein Mindeststichprobenumfang von n_mindest=60 erforderlich, um mit dem auf 5%igen

Signifikanzniveau geführten t-Test die halbe beobachtete Abweichung delta=1,4 der mittleren

Wirkung vom Sollwert 0 mit einer Sicherheit von 90% als signifikant zu erkennen.

5. Bei einen Fertigungsprozess werden Lose vom Umfang N=10000 Stück auf fehlerhafte

Einheiten geprüft (Gut/Schlecht-Prüfung). Der Prüfplan sieht Stichproben vom Umfang

n=89 und die Annahmezahl c=2 vor. Kann damit ein Lieferantenrisiko von höchstens 5%

an der Gutgrenze AQL=1% sowie ein Konsumentenrisiko von höchstens 10% an der

Schlechtgrenze LQL=6% sicher gestellt werden?

Präzisierung der Aufgabe:

Wegen n/N<0.1 und N>60 kann die Annahmewahrscheinlichkeit in Abhängigkeit vom

Ausschussanteil p mit guter Näherung durch die Binomialverteilung dargestellt werden.

Lösungsansatz und numerische Lösung:

Zur Lösung der Aufgabe sind die Annahmewahrscheinlichkeiten Pa(AQL| 89, 2) und Pa(LQL| 89,

2) an der Gut- bzw. Schlechtgrenze zu bestimmen. Es ist:

2

Pa ( 0 .01 | 89 , 2 ) =

89

x

89

x

∑ x 0.01 (1 − 0.01)

89 − x

= 93 .97 %,

x=0

2

Pa ( 0 .06 | 89 , 2 ) =

∑ x 0.06

(1 − 0 .06 ) 89 − x = 9 .19 %.

x=0

Wegen Pa(AQL|89,2)=93,97% ≥ 90% ist die erforderliche Mindestannahmewahrscheinlichkeit im

Punkt PRP erfüllt. Auch im Punkt CRP wird wegen Pa(LQL|89,2)=9.19% ≤ 10% die

vorgegebene Maximalwahrscheinlichkeit nicht überschritten.

Lösung mit R:

> library(AcceptanceSampling)

> PPbinom <- OC2c(89, 2, type="binom")

> assess(PPbinom, PRP=c(0.01, 0.9), CRP=c(0.06, 0.1))

Acceptance Sampling Plan (binomial)

Sample size(s)

Acc. Number(s)

Rej. Number(s)

Sample 1

89

2

3

Plan CAN meet desired risk point(s):

PRP

CRP

Quality

0.01

0.06

RP P(accept) Plan P(accept)

0.9

0.93968992

0.1

0.09186935

Ergebnis:

Für den Prüfplan n=89 und c=2 sind die Forderungen an die Operationscharakteristik

(Mindestannahmewahercheinlichkeiten von 90% für p ≤ 0.01 sowie eine maximale

Annahmewahrscheinlichkeit von 10% für p ≥ 0.06) erfüllt.

6. Es gelte die Annahme, dass das in einem Produktionsprozess an Werkstücken zu

überprüfende Merkmal X angenähert normalverteilt sei. Ein Werkstück gelte als

fehlerhaft, wenn ein bestimmter Grenzwert To überschritten wird. Zur Festlegung der

Operationscharakteristik wird ein Lieferantenrisiko von 5% an der Gutgrenze AQL=1.5%

und ein Abnehmerrisiko von 5% an der Schlechtgrenze LQL = 10% vereinbart. Man

bestimme die Kennwerte n und k eines geeigneten Prüfplans. Dabei nehme man die

Varianz von X als bekannt an.

Präzisierung der Aufgabe:

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

17

Man beachte, dass ein Los angenommen wird, wenn der Mittelwert der Prüfstichprobe um die kfache Standardabweichung unter dem Grenzwert To liegt. Die Wahrscheinlichkeit dafür ist in

Abhängigkeit vom Ausschussanteil p durch Pa ( p | n, k ) = Φ z1− p − k n gegeben. Der

([

] )

Ausschussanteil p ist gleich der Überschreitungswahrscheinlichkeit des Grenzwert To.

Lösungsansatz und numerische Lösung:

Aus den an der Gut- und Schlechtgrenze vorgegebenen Annahmewahrscheinlichkeiten sind die

Kenngrößen n (Umfang der Prüfstichprobe) und k (Annahmezahl) zu bestimmen.

An der Gutgrenze p=0.015 soll Pa (0.01 | n, k ) = 0.95, d.h., ( z 0.985 − k ) n = z 0.95 gelten, für

und für die Schlechtgrenze p=0.1 wird Pa (0.1 | n, k ) = 0.05, d.h., ( z 0.9 − k ) n = − z 0.95

verlangt. Drückt man z.B. k aus der ersten Gleichung durch n aus und setzt in die zweite

Gleichung ein, folgt schließlich n=13.7 ≈ 14. Einsetzen des gerundeten Wertes von n in die erste

Gleichung führt auf k = 1.73.

Lösung mit R:

> library(AcceptanceSampling)

> xx <- find.plan(PRP=c(0.015, 0.95), CRP=c(0.1, 0.05), type="normal",

s.type="known")

> xx

$n

[1] 14

$k

[1] 1.730485

$s.type

[1] "known"

Ergebnis:

Die vorgegebenen Forderungen werden mit Prüfplankenngrößen n=14 und k=1.73 erfüllt. Nach

diesem Prüfplan wird das Los angenommen, wenn der Mittelwert der Prüfstichprobe vom

Umfang n=14 den vorgegebenen Grenzwert um mindestens k=1,73 Standardabweichungen

unterschreitet.

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

18

5 EINFÜHRUNG IN DAS TESTEN VON UNTERSCHIEDSHYPOTHESEN II:

2-STICHPROBENVERGLEICHE UND 1-FAKTORIELLE VARIANZANALYSE

5.1. Zwei grundlegende Versuchsanlagen

•

Parallelversuch (parallel groups, unabhängige Stichproben):

Der Parallelversuch ist eine einfache Versuchsanlage, um unter kontrollierten

Bedingungen zwei Gruppen hinsichtlich eines interessierenden Untersuchungsmerkmals

X (z.B. Präparatwirkung) zu vergleichen. Bei einem metrischen Untersuchungsmerkmal

geht es dabei meist um einen Vergleich der Mittelwerte von X unter zwei

Versuchsbedingungen, bei einem alternativ skalierten Untersuchungsmerkmal erfolgt der

Vergleich der Gruppen in der Regel an Hand der relativen Häufigkeiten einer

Merkmalsausprägung. Aus einer "Zielpopulation" wird eine bestimmte Anzahl von

Untersuchungseinheiten (z.B. Probanden) ausgewählt und in zwei (möglichst gleich

große) sogenannte "Parallelgruppen" geteilt. Die eine Gruppe ist die Testgruppe (z.B. zur

Erprobung eines neuen Präparates), die andere Gruppe in der Regel eine Kontrollgruppe

(z.B. eine Placebogruppe oder eine mit einem herkömmlichen Präparat behandelte

Gruppe). Von jeder Untersuchungseinheit wird ein Wert des Untersuchungsmerkmals X

(auch abhängige Variable genannt) gewonnen. Die Werte von X können in zwei

Stichproben angeordnet werden:

Testgruppe T (Gruppe 1)

Untersuchungseinheiten

T1

T2

...

Tn1

Untersuchungsmerkmal X

Wert von T1

Wert von T2

...

Wert von Tn1

Kontrollgruppe K (Gruppe 2)

Untersuchungseinheiten

K1

K2

...

Kn2

Untersuchungsmerkmal X

Wert von K1

Wert von K2

...

Wert von Kn2

Man beachte, dass zwischen den Untersuchungseinheiten der Parallelgruppen keinerlei

Beziehung besteht, die eine Anordnung in Paaren rechtfertigen würde. Vielmehr können

die Untersuchungseinheiten (und entsprechend die Stichprobenwerte) der Testgruppe

unabhängig von jenen der Kontrollgruppe angeordnet werden. Es ist daher üblich, den

Parallelversuch auch als einen Versuch mit unabhängigen Stichproben zu bezeichnen.

Die Unabhängigkeit der Stichproben kommt auch darin zum Ausdruck, dass die

Stichprobenumfänge n1 und n2 der Parallelgruppen grundsätzlich verschieden sein

können (wenngleich der symmetrische Fall n1 = n2 aus verschiedenen Gründen

angestrebt werden sollte).

•

Paarvergleich (matched-pair design, abhängige Stichproben):

Man spricht von einem 2-Stichprobenproblem mit abhängigen (oder verbundenen)

Stichproben, wenn es einen sachlogischen Zusammenhang gibt, nach dem jeder Wert

der einen Stichprobe mit einem Wert der anderen Stichprobe zu einem Wertepaar

zusammengefasst werden kann. Ein solcher Zusammenhang ist z.B. gegeben, wenn die

Stichprobenwerte durch zweimaliges Beobachten an ein und derselben

Untersuchungseinheit gewonnen wurden; in dieser Weise geplante Versuche werden

auch Paarvergleiche genannt. Ein häufiger Anwendungsfall sind die sogenannten

selbstkontrollierten Versuche zur Prüfung eines allfälligen Behandlungseffektes: Um die

Auswirkung einer Behandlung auf eine Zielvariable zu prüfen, werden aus einer

Zielpopulation n Probanden ausgewählt und an jedem Probanden die Zielvariable vor der

Behandlung (Variable X1) sowie nach erfolgter Behandlung (Variable X2) beobachtet. Von

jedem Probanden liegt also ein Paar von Beobachtungswerten vor. Die aus einem

Paarvergleich resultierenden Stichproben sind daher als Spalten einer Datenmatrix zu

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

19

sehen, in der jede Zeile einem „Block“ (z.B. einem Probanden) entspricht, über den die

Stichprobenwerte zu Wertepaaren verbunden werden:

Untersuchungseinheiten

U1

U2

...

Un

X1

Stichprobe 1

1. Wert von U1

1. Wert von U2

...

1. Wert von Un

X2

Stichprobe 2

2. Wert von U1

2. Wert von U2

...

2. Wert von Un

5.2 Zweistichprobenvergleiche bei metrischen Variablen im Rahmen von Parallelversuchen

2-Stichproben t-Test (two-sample t-test):

Problemstellung:

Es soll im Rahmen eines Parallelversuchs festgestellt werden, ob sich die Mittelwerte µ1

und µ2 einer Variablen X unter zwei Versuchsbedingungen unterscheiden. Dabei wird X

unter jeder Versuchsbedingung als normalverteilt und mit gleichen Varianzen

vorausgesetzt.

Ablaufschema:

• Beobachtungsdaten:

zwei (voneinander unabhängige) Stichproben x11, x21, ..., xn1,1 bzw.

x12, x22, ..., xn2,2

Mittelwerte x1 und x 2 , Varianzen s21 und s22

•

Modell:

xi1 ist eine Realisation von Xi1 ~ N(µ1, σ21) (i=1,2,...,n1)

Stichprobenfunktionen X 1 , S21

xi2 ist eine Realisation von Xi2 ~ N(µ2, σ22) (i=1,2,...,n1)

Stichprobenfunktionen X 2 , S22

Es gelte: σ21 = σ22 (Varianzhomogenität)

•

Hypothesen:

2-seitige Hypothesen:

1-seitige Hypothesen:

Signifikanzniveau: α

•

H0: µ1 = µ2 vs. H1: µ1 ≠ µ2 (Fall I)

H0: µ1 ≤ µ2 vs. H1: µ1 > µ2 (Fall IIa)

H0: µ1 ≥ µ2 vs. H1: µ1 < µ2 (Fall IIb)

Testgröße:

TG =

X1 − X 2

Sp

1 1

+

n1 n 2

≅ t n1 + n2 − 2

(n1 − 1) S12 + (n 2 − 1) S 22

(für µ 1 = µ 2 ) mit S p =

n1 + n 2 − 2

•

Entscheidung mit Quantilen:

H0 auf Signifikanzniveau α ablehnen, wenn |TGs| > tn1+ n2 - 2,1-α/2 (Fall I) bzw. TGs > tn1 + n2 2,1- α (Fall IIa) bzw. TGs < tn1 + n2 - 2, α (Fall IIb)

•

Entscheidung mit P-Wert:

H0 auf Signifikanzniveau α ablehnen, wenn P < α wobei

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

20

P=P(TG ≤ -|TGs| oder TG ≥ |TGs|) (Fall I) bzw. P=P(TG ≥ |TGs|) (Fall IIa) bzw. P=P(TG

≤ -|TGs|) (Fall IIb).

•

Planung des Stichprobenumfanges:

Um auf Niveau α mit Sicherheit 1-β eine Entscheidung für H1 herbeizuführen, wenn µ1

von µ2 um ∆ ≠ 0 im Sinne der Alternativhypothese abweicht, ist der dafür notwendige

Stichprobenumfang (Voraussetzung für Abschätzung: symmetrische Versuchsanlage mit

n=n1=n2 und n ≥ 20):

2σ 2

(z1−α / 2 + z1− β )2 (2 - seitige Hypothesen) bzw.

2

∆

2σ 2

2

n ≈ 2 (z1−α + z1− β ) (1 - seitige Hypothesen)

∆

n≈

F-Test:

Problemstellung:

Es soll im Rahmen eines Parallelversuchs festgestellt werden, ob sich die Varianzen σ12

und σ22 einer Variablen X unter zwei Versuchsbedingungen unterscheiden. X wird unter

jeder Versuchsbedingung als normalverteilt vorausgesetzt.

Ablaufschema:

• Beobachtungsdaten:

zwei (voneinander unabhängige) Stichproben

x11, x21, ..., xn1,1 und x12, x22, ..., xn2,2

Varianzen s21 bzw. s22

•

Modell:

xi1 ist eine Realisation von Xi1 ~ N(µ1, σ21) (i=1,2,...,n1)

xi2 ist eine Realisation von Xi2 ~ N(µ2, σ22) (i=1,2,...,n1)

Stichprobenvarianzen S21,S22

•

Hypothesen:

2-seitige Hypothesen:

1-seitige Hypothesen:

Signifikanzniveau: α

•

H0: σ12 = σ22 vs. H1: σ12 ≠ σ22 (Fall I)

H0: σ12 ≤ σ22 vs. H1: σ12 > σ22 (Fall IIa)

H0: σ12 ≥ σ22 vs. H1: σ12 < σ22 (Fall IIb)

Testgröße:

TG =

S12

≅ Fn1 −1, n2 −1 für σ 12 = σ 22

S22

•

Entscheidung mit Quantilen:

H0 auf Testniveau α ablehnen, wenn TGs < Fn1-1, n2-1, α/2 oder

TGs >Fn1-1, n2-1,1-α/2 (Fall I) bzw. TGs > Fn1-1, n2-1,1-α (Fall IIa) bzw.

TGs < Fn1-1, n2-1, α (Fall IIb).

Hinweis:

Bildet man die Testgröße so, dass die größere Varianz im Zähler steht, reduziert sich im

Fall I die Bedingung auf TGs > Fn1-1, n2-1,1-α/2.

•

Entscheidung mit P-Wert:

H0 auf Signifikanzniveau α ablehnen, wenn P < α, wobei P=P(1/TG≤1/TGs oder

TG≥TGs) (Fall I) bzw. P=P(TG≥TGs) (Fall IIa) bzw. P=P(1/TG≤ 1/TGs) (Fall IIb).

Hinweis:

TGs so ansetzen, dass die größere Varianz im Zähler steht; die Variablen TG und 1/TG

haben unterschiedliche Zähler- bzw. Nennerfreiheitsgrade!

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

21

Anmerkung:

Wird der F-Test in Verbindung mit dem 2-Stichproben t-Test als „Vortest“ zum Nachweis der

Varianzhomogenität eingesetzt, kann das Gesamtirrtumsrisiko αg für beide

Testentscheidungen bis knapp 2α ansteigen. Diesen nicht erwünschten Nebeneffekt

vermeidet man, wenn als Alternative zum Mittelwertvergleich mit dem 2-Stichproben t-Test

und dem F-Test als Vortest der nicht ganz so „scharfe“ Welch-Test eingesetzt wird (siehe

weiter unten).

U – Test (Wilcoxon-Rangsummentest, Mann-Whitney rank-sum test):

Problemstellung:

Es soll im Rahmen eines Parallelversuchs festgestellt werden, ob sich die Mittelwerte µ1

und µ2 einer Variablen X unter zwei Versuchsbedingungen unterscheiden, wobei von X

unter jeder Versuchsbedingung die gleiche Verteilung (nicht notwendigerweise eine

Normalverteilung) vorausgesetzt wird.

Ablaufschema:

• Beobachtungsdaten:

Stichproben x11, x21, ..., xn1,1 und x12, x22, ..., xn2,2

rangskalierte Stichroben:

beide Stichproben kombinieren und nach aufsteigender Größe anordnen;

Stichprobenwerte von 1 bis n1+n2 durchnummerieren und Ordnungsnummern den

Stichprobenwerten xi1 und xi2 als Rangzahlen ri1 bzw. ri2 zuordnen; bei gleichen

Stichprobenwerten erfolgt Bindungskorrektur. Aufsummieren der Rangzahlen ergibt die

Rangsummen r1 und r2.

•

Modell:

Jedes xi1 (xi2) ist Realisation einer Zufallsvariablen Xi1 (Xi2) mit Verteilungsfunktion F1 (F2).

F1 und F2 unterscheiden sich nur in der Lage, d.h., Graph von F2 geht durch

Verschiebung um ein bestimmtes θ in Richtung der positiven horizontalen Achse in

Graphen von F1 über. Die Rangsummenwerte r1 und r2 sind Realisationen der

Zufallsvariablen R1 bzw. R2.

•

Hypothesen:

2-seitige Hypothesen:

1-seitige Hypothesen:

Signifikanzniveau: α

•

H0: θ = 0 vs. H1: θ ≠ 0 (Fall I)

H0: θ ≤ 0 vs. H1: θ > 0 (Fall IIa)

H0: θ ≥ 0 vs. H1: θ < 0 (Fall IIb)

Testgröße:

TG = U = n1n2 + n1(n1+1)/2 - R1;

für θ = 0 gilt: E[U]=n1n2/2, Var[U]= n1n2(n1+n2+1)/12;

Approximation bei großen Stichproben (n1>20 oder n2>20):

TG ' =

U − E[U ]

≅ N (0,1)

Var[U ]

•

Entscheidung mit Quantilen (große Stichproben):

H0 auf Testniveau α ablehnen, wenn |TGs| > z1-α/2 (Fall I) bzw. TGs > z1-α (Fall IIa) bzw.

TGs < zα (Fall IIb).

•

Entscheidung mit P-Wert (große Stichproben):

H0 auf Signifikanzniveau α ablehnen, wenn P < α wobei

P=P(TG ≤ -|TGs| oder TG ≥ |TGs|) (Fall I) bzw. P=P(TG ≥ |TGs|) (Fall IIa) bzw. P=P(TG

≤ -|TGs|) (Fall IIb).

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

22

Welch – Test (two sample t-test with unequal variances):

Problemstellung:

Es soll im Rahmen eines Parallelversuchs festgestellt werden, ob sich die Mittelwerte µ1

und µ2 einer Variablen X unter zwei Versuchsbedingungen unterscheiden, wobei X unter

jeder Versuchsbedingung als normalverteilt vorausgesetzt wird.

Ablaufschema:

• Beobachtungsdaten, Modell, Hypothesen:

wie beim 2-Stichproben t-Test bis auf die Voraussetzung der Varianzhomogenität.

•

Testgröße:

TG =

•

X1 − X 2

S12

/ n1 + S 22 / n2

Entscheidung:

H0 auf Testniveau α ablehnen, wenn |TGs| > tf,1-α/2 (Fall I),

TGs > tf,1-α (Fall IIa), TGs > tf, α (Fall IIb) mit:

(s

/ n1 + s22 / n2 )

f ≈ 2

(gerundet auf ganze Zahl)

(s1 / n1 )2 /( n1 − 1) + (s22 / n2 )2 /(n2 − 1)

2

1

2

5.3 Unterschiedshypothesen bei metrischen Variablen im Rahmen von Paarvergleichen

Differenzen- t-Test (paired t-test, t-Test für abhängige Stichproben):

Problemstellung:

Es soll im Rahmen eines Paarvergleichs (mit abhängigen Stichproben) festgestellt

werden, ob sich die Mittelwerte µ1 und µ2 der Variablen X1 bzw. X2 (zB zu zwei

aufeinanderfolgenden Zeitpunkten beobachtete Merkmale) unterscheiden. Dabei werden

X1 und X2 als normalverteilt vorausgesetzt.

Ablaufschema:

• Beobachtungsdaten:

n Wertepaare (x11, x12), (x21, x22), ..., (xn,1, xn,2) durch Messung der Variablen X1

(Mittelwert µ1) und X2 (Mittelwert µ2) an n Untersuchungseinheiten

Differenzenstichprobe d1=x12 - x11, d2=x22 - x21, ..., dn=xn2 - xn1

mit Mittelwert md und die Varianz sd2

•

Modell:

Jedes di ist Realisation von Di ∝ N(µd, σd2) mit µd=µ2-µ1

Stichprobenmittel MD ∝ N(µd, σd2/n), Stichprobenvarianz SD2

•

Hypothesen:

2-seitige Hypothesen:

1-seitige Hypothesen:

Signifikanzniveau: α

•

H0: µd = 0 vs. H1: µd ≠ 0 (Fall I)

H0: µd ≤ 0 vs. H1: µd > 0 (Fall IIa)

H0: µd ≥ 0 vs. H1: µd < 0 (Fall IIb)

Testgröße:

TG =

MD

≅ tn−1 für µd = 0

SD / n

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

23

•

Entscheidung mit Quantilen:

H0 auf Testniveau α ablehnen, wenn |TGs| > tn-1,1-α/2 (Fall I) bzw. TGs > tn-1,1-α (Fall IIa)

bzw. TGs < tn-1,α (Fall IIb).

•

Entscheidung mit P-Wert:

H0 auf Signifikanzniveau α ablehnen, wenn P < α wobei

P=P(TG ≤ -|TGs| oder TG ≥ |TGs|) (Fall I) bzw. P=P(TG ≥ |TGs|) (Fall IIa) bzw. P=P(TG

≤ -|TGs|) (Fall IIb).

•

Planung des Stichprobenumfangs:

Um auf Niveau α mit der Sicherheit 1-β eine Entscheidung für H1 herbeizuführen,

wenn µd von 0 um ∆ ≠ 0 im Sinne der Alternativhypothese abweicht, ist das dafür

notwendige n näherungsweise (etwa ab n = 20)

im Fall I:

2

n≈

σd

∆

2

(z1−α / 2 + z1−β )2

in den Fällen IIa und IIb ist z1-α/2 durch z1-α zu ersetzen.

Wilcoxon-Test (Wilcoxon signed-rank test):

Problemstellung:

Es soll im Rahmen eines Paarvergleichs (mit abhängigen Stichproben) festgestellt

werden, ob sich die Mittelwerte µ1 und µ2 der Variablen X1 bzw. X2 (zB zu zwei

aufeinanderfolgenden Zeitpunkten beobachtete Merkmale) unterscheiden. Dabei wird

D= X2 - X1 als nicht normalverteilt vorausgesetzt.

Ablaufschema:

• Beobachtungsdaten:

Differenzenstichprobe d1=x12 - x11,

n Wertepaare (x11, x12), (x21, x22), ..., (xn,1, xn,2)

d2=x22 - x21, ..., dn=xn2 - xn1 (Paare mit übereinstimmenden Werten bleiben

unberücksichtigt); Paardifferenzen hinsichtlich Absolutbeträgen nach aufsteigender

Größe anordnen und durchnummerieren, Ordnungsnummern den Paardifferenzen als

Rangzahlen zuordnen (Bindungskorrektur bei gleichen Absolutbeträgen). t+ = Summe der

zu den positiven Paardifferenzen gehörenden Rangzahlen.

•

Modell:

Jedes di ist die Realisation einer Zufallsvariablen Di mit einer stetigen und symmetrisch

um den Median ζ liegenden Verteilungsfunktion;

t+ =Realisation von T+.

•

Hypothesen und Testgröße:

2-seitige Hypothesen:

1-seitige Hypothesen:

H0: ζ = 0 vs. H1: ζ ≠ 0 (Fall I)

H0: ζ ≤ 0 vs. H1: ζ > 0 (Fall IIa)

H0: ζ ≥ 0 vs. H1: ζ < 0 (Fall IIb)

Signifikanzniveau: α

Testgröße: TG = T+

Für ζ = 0 (H0) gilt: E[T+]=n(n+1)/4, Var[T+]= n(n+1)(2n+1)/24)

Approximation bei großen Stichproben (n >20):

TG' =

•

T + − E[T + ]

Var[T + ]

≅ N (0,1)

Entscheidung mit Quantilen (große Stichproben):

H0 auf Testniveau α ablehnen, wenn |TGs| > z1-α/2 (Fall I) bzw. TGs > z1-α (Fall IIa) bzw.

TGs < zα (Fall IIb).

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

24

•

Entscheidung mit P-Wert (große Stichproben):

H0 auf Signifikanzniveau α ablehnen, wenn P < α wobei

P=P(TG ≤ -|TGs| oder TG ≥ |TGs|) (Fall I) bzw. P=P(TG ≥ |TGs|) (Fall IIa) bzw. P=P(TG

≤ -|TGs|) (Fall IIb).

5.4 Zweistichprobenvergleiche bei dichotomen Variablen

Häufigkeitsvergleich (comparison of two observed frequencies):

Problemstellung:

Es soll im Rahmen eines Parallelversuchs festgestellt werden, ob sich die

Wahrscheinlichkeiten eines unter zwei Versuchsbedingungen betrachteten Ereignisses

unterscheiden. Dabei wird ein Parallelversuch mit großen Stichproben vorausgesetzt.

Ablaufschema:

• Beobachtungsdaten:

X = zweistufiges Merkmal mit den Werten a1, a2; Beobachtung von X unter zwei

Bedingungen

2 unabhängige Stichproben (Gruppen)

Zusammenfassung in

Vierfeldertafel:

Untersuchungsmerkmal X

Wert a1

Wert a2

(Spalten-)

Summen

Gruppe 1

Gruppe 2

n11

n21

n.1=n1

vorgegeben

n12

n22

n.2=n2

vorgegeben

(Zeilen-)

Summen

n1.

n2.

n.. =n1+n2

• Modell:

X ist in jeder Gruppe zweipunktverteilt mit den Parametern p1=P(X=a1|Gruppe 1) bzw.

p2=P(X=a1|Gruppe 2)

•

Hypothesen:

2-seitige Hypothesen:

1-seitige Hypothesen:

Signifikanzniveau: α

•

H0: p1 = p2 vs. H1: p1 ≠ p2 (Fall I)

H0: p1 ≤ p2 vs. H1: p1 > p2 (Fall IIa)

H0: p1 ≥ p2 vs. H1: p1 < p2 (Fall IIb)

Testgröße:

TG =

n.. (n11n22 − n12n21 )

n.1n.2 n1.n2.

≅ N (0,1) für p1 = p2 (approx.)

Faustformel: n..>60, n1.n.1/n..>5, n1.n.2/n..>5, n2.n.1/n..>5, n2.n.2/n..>5

• Entscheidung mit Quantilen:

H0 auf Testniveau α ablehnen, wenn |TGs| > z1-α/2 (Fall I) bzw.

TGs > z1-α (Fall IIa) bzw. TGs < zα (Fall IIb).

• Entscheidung mit P-Wert:

H0 auf Signifikanzniveau α ablehnen, wenn P<α, wobei

P=P(TG ≤ -|TGs| oder TG ≥ |TGs|) (Fall I) bzw. P=P(TG ≥ |TGs|) (Fall IIa) bzw. P=P(TG ≤

-|TGs|) (Fall IIb).

•

Planung des Stichprobenumfanges:

Notwendiger Mindeststichprobenumfang n (=n1=n2), um auf dem Niveau α mit der

Sicherheit 1-β eine Entscheidung für H1 herbeizuführen, wenn p1 von p2 um ∆ ≠ 0 im

Sinne der Alternativhypothese abweicht:

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

25

n≈

n≈

2∆

1

2

(z1−α / 2 + z1− β )2

2∆

2

(z1−α + z1− β )2

1

(Fall I) bzw.

(Fall IIa, IIb)

McNemar – Test (McNemar test):

Problemstellung:

Es soll für ein zweistufiges Merkmal (Werte + bzw. - ) im Rahmen eines Paarvergleichs

festgestellt werden, ob sich von einer Versuchsbedingung zu einer anderen (zB

zwischen zwei Zeitpunkten) die Wahrscheinlichkeiten für Änderungen von + nach – bzw.

umgekehrt unterscheiden.

Ablaufschema:

• Beobachtungsdaten:

X = zweistufiges Merkmal mit Werten + und − , Beobachtung von X zu zwei Zeitpunkten

2 abhängige Stichproben

Zusammenfassung in Vierfeldertafel (die absoluten

Häufigkeitswerte b und c drücken die Veränderungen von der ersten zur zweiten

Beobachtung aus):

Zeitpunkt 1

+

−

Zeitpunkt 2

+

−

a

c

b

d

•

Modell:

Die Veränderungen von + nach − oder umgekehrt werden durch ein Bernoulli-Experiment

mit n = b + c Wiederholungen simuliert. Jede Wiederholung führt mit der

Wahrscheinlichkeit p+− zu einer Veränderung von + nach −.

•

Hypothesen und Testgröße:

H0: p+− =1/2 vs. H1: p+− ≠ 1/2

Signifikanzniveau: α

2

(

| b − c | −1)

TG =

≅ χ12

b+c

unter H0 (approx. für b + c ≥ 20)

Anmerkung: Mit dem Binomialtest ist eine exakte Entscheidung zwischen den

Alternativen möglich

•

Entscheidung mit Quantilen:

H0 auf Testniveau α ablehnen, wenn TGs > χ21,1-α.

•

Entscheidung mit P-Wert:

H0 auf Signifikanzniveau α ablehnen, wenn P<α, wobei P=P(TG≥|TGs|).

•

Planung des Stichprobenumfangs:

Notwendiger Mindeststichprobenumfang n =b+c, um auf dem Niveau α mit der Sicherheit

1-β eine Entscheidung für H1 herbeizuführen, wenn p+− von 1/2 um ∆ ≠ 0 abweicht:

n≈

1

4∆

2

(z1−α / 2 + z1− β )2

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

26

5.5 Zweistichprobenvergleiche bei mehrstufig skalierten Variablen

Homogenitätsprüfung mit dem Chiquadrat-Tes t

(comparison of two frequency distributions):

Problemstellung:

Es soll für ein mehrstufiges Merkmal mit m>2 Werten im Rahmen eines Parallelversuchs

festgestellt werden, ob sich die unter zwei Bedingungen beobachteten

Häufigkeitsverteilungen unterscheiden. Vorausgesetzt werden „große“ Stichproben“.

Ablaufschema:

• Beobachtungsdaten:

X = m -stufiges Merkmal mit Werten a1, a2, ..., am , Beobachtung von X unter zwei

Bedingungen

2 unabhängige Stichproben (Gruppen)

Zusammenfassung in m×2Tafel:

Untersuchungs-merkmal Gruppe 1

X

Gruppe 2

(Zeilen-)

Summen

Wert a1

Wert a2

...

Wert am

n12

n22

...

nm2

n.2=n2

n1.

n2.

...

nm.

n =n1+n2

n11

n21

...

nm1

(Spalten-) n.1=n1

•

Modell:

X ist in jeder Gruppe m-punktverteilt mit den Parametern pi1=P(X=ai|Gruppe 1) bzw.

pi2=P(X=a1|Gruppe 2) (i=1,2,...,m)

•

Hypothesen:

H0: pi1 = pi2 vs. H1: nicht alle pi1 = pi2 (i=1,2,...,m)

Signifikanzniveau: α

•

Testgröße (Faustformel: alle eij ≥ 1 und max. 20% der eij < 5):

m

2

TG = GF = ∑ ∑

i =1 j =1

mit eij =

(n

ij

− eij )

2

eij

≅ χ m2 −1 unter H 0 (approx.)

ni.n. j

n

•

Entscheidung mit Quantilen:

H0 auf Testniveau α ablehnen, wenn TGs > χ2m-1,1-α.

•

Entscheidung mit P-Wert:

H0 auf Signifikanzniveau α ablehnen, wenn P= P(TG ≥ |TGs|)<α.

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

27

5.6 Einfaktorielle Varianzanalyse

Problemstellung - Globaltest:

Die 1-faktorielle Varianzanalyse ermöglicht es unter gewissen Voraussetzungen, die

Mittelwerte aus k >2 unabhängigen Stichproben im Rahmen der Globalhypothesen

H0: „Alle k Mittelwerte sind gleich“ vs. H1: „Wenigstens 2 Mittelwerte sind verschieden“

vergleichen zu können.

Ablaufschema:

• Beobachtungsdaten:

Variable Y unter k Versuchsbedingungen (= Faktorstufen) wiederholt (an nj

Untersuchungseinheiten auf der Faktorstufe j) gemessen

k unabhängige Stichproben

Anordnung in Datentabelle (yij = Messwert von der i-ten Untersuchungseinheit unter

der j -Versuchsbedingung):

Versuchsbedingung (Faktorstufe)

j

k

1

2

...

...

y12 ... y1j ... y1k

Wiederholungen y11

y21

y22 ... y2j ... y2k

...

...

... ... ...

...

yi1

yi2

... yij ...

yik

...

...

... ... ...

...

yn1,1 yn2,2 ... ynj,j ... ynk,k

n1

n2

... nj ...

nk

Anzahl

m1

m2 ... mj ... mk

Mittelwert

2

2

2

2

s1

s2

... sj

... sk

Varianz

•

Modell:

Jedes yij ist eine Realisation einer N(µj,σ2)-verteilten Zufallsvariablen Yij mit der

Darstellung:

Yij = µ j + E ij = µ + τ j + E ij

Es bedeuten:

− µj das Mittelwert auf der j-ten Faktorstufe

(geschätzt durch mj);

− µ eine Konstante (geschätzt durch das aus allen Stichprobenwerten berechnete

Gesamtmittel m);

− τj eine den Behandlungseffekt auf der j-ten Stufe zum Ausdruck bringende Konstante

(geschätzt durch mj -m und mit der Normierung τ1+ τ2+ ... + τk=0);

− Eij den Versuchsfehler (für alle Wiederholungen und Faktorstufen unabhängig N(0,

σ2)-verteilt); Schätzung der Fehlervarianz σ2 durch:

MQE =

SQE

mit

N −k

k

k

j =1

j =1

N = ∑ n j und SQE = ∑ (n j − 1) s 2j

•

Hypothesen und Testgröße:

Globaltest:

H0: µ1 = µ2 = ... = µk vs.

H1: wenigstens zwei der µj unterscheiden sich

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

28

TG =

MQF

≅ Fk −1, N − k mit

MQE

SQF

MQF =

, SQF =

k −1

k

∑ n (m − m)

2

j

j

j =1

Zusammenfassung der relevanten Rechengrößen in der ANOVA-Tafel:

Variationsursache

Quadrat- Freiheits- Mittlere

summe grad

Quadratsumme

Faktor F

SQF

k -1

MQF=

(Bedingung)

SQF/(k-1)

VersuchsSQE

N-k

MQE=

fehler

SQE/(N-k)

Summe

SQT

n-1

Testgröße

TG=

MQF/MQE

SQT = (n1-1)s12+(n2-1)s22+...+(n2-1)s22

•

Entscheidung:

H0 auf Testniveau α ablehnen, wenn TGs > Fk-1,N-k,1-α.

Überprüfung der Varianzhomogenität (Levene-Test):

Ablaufschema:

• Daten:

Variable Y unter k Versuchsbedingungen (= Faktorstufen) wiederholt (an nj

Untersuchungseinheiten auf der Faktorstufe j) gemessen

k unabhängige Stichproben

Anordnung in Datentabelle (yij = Messwert von der i-ten Untersuchungseinheit unter

der j -Versuchsbedingung:

Versuchsbedingung (Faktorstufe)

j

k

1

2

...

...

y12 ... y1j ... y1k

Wiederholungen y11

y21

y22 ... y2j ... y2k

...

...

... ... ...

...

yn1,1 yn2,2 ... ynj,j ... ynk,k

n1

n2

... nj ...

nk

Anzahl

m1

m2 ... mj ... mk

Mittelwert

N = n1 + n2 +... + nk

•

Modell:

Jedes yij ist eine Realisation Zufallsvariablen Yij, die auf der

j-ten Faktorstufe N(µj,σj2)-verteilt ist.

•

Hypothesen:

H0: σ12 = σ22 = ... = σk2 vs.

H1: wenigstens zwei der σj2 unterscheiden sich

•

Testgröße:

Beobachtungen Yij auf der j-ten Faktorstufe werden durch Abstände Zij=|Yij - mj| vom

jeweiligen Stichprobenmittel mj ersetzt

modifizierte Datentabelle

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

29

Versuchsbedingung (Faktorstufe)

1

2

...

j

...

k

Wiederholungen z11

z12 ... z1j ... z1k

z21

z22 ... z2j ... z2k

...

... ... ... ... ...

zn1,1 zn2,2 ... znj,j ... znk,k

Anzahl

n1

n2 ... nj ... nk

z-Mittelwerte

m1(z) m2(z) ... mj(z) ... mk(z)

z-Varianzen

s12(z) s22(z) ... sj2(z) ... sk2(z)

Idee:

Wenn Varianzhomogenität vorliegt, stimmen die Mittelwerte mj(z) bis auf zufallsbedingte

Abweichungen überein.

Prüfung der Abweichungen im Rahmen einer einfaktoriellen ANOVA mit der Testgröße:

MQF ( z )

mit

MQE ( z )

1 k

(n j − 1)s 2j ( z) und

MQE ( z ) =

∑

N − k j =1

1 k

2

MQF =

n j [m j ( z ) − m( z )]

∑

k − 1 j =1

TG ( z ) =

(m(z) ist das aus allen z-Werten berechnete Gesamtmittel).

•

Entscheidung:

H0 auf Testniveau α ablehnen, wenn TG(z)s > Fk-1,N-k,1-α.

5.7 Musterbeispiele

1. Die Wirkungen eines Testpräparates A und eines Kontrollpräparate B seien durch die

prozentuelle Abnahme Y des systolischen Blutdrucks vom Beginn bis zum Ende der

Therapie ausgedrückt. Im Rahmen eines Parallelversuchs wurden die Präparatwirkungen

jeweils an 5 Testpersonen gemessen, wobei die Personen der „Testgruppe A“ von den

Personen der „Kontrollgruppe B“ verschieden sind. Als Messwerte ergaben sich: 23, 18,

13, 19, 27 (Gruppe A) bzw. 20, 15, 10, 25, 21 (Gruppe B).

a. Man untersuche an Hand der folgenden Daten, ob sich die mittleren

Präparatwirkungen signifikant (α = 5%) unterscheiden.

b. Beurteilen Sie die Versuchsplanung (Stichprobenumfang)!

Präzisierung der Aufgabe:

Wir bezeichnen mit YA die Wirkung des Testpräparates A und mit YB die Wirkung des

Kontrollpräparates B. Beide Variablen werden als normalverteilt vorausgesetzt mit den

Mittelwerten µA bzw. µB.

Teilaufgabe 1a (t-Test)

Lösungsansatz und rechnerische Lösung:

In der Teilaufgabe a) ist gefragt, ob der Mittelwert µA von µB verschieden ist. Es geht also um

einen Vergleich zweier Mittelwerte von als normalverteilt angenommenen Merkmalen. Die

Alternativhypothese lautet H1: µA ≠ µB, die Nullhypothese ist H0: µA = µB. Die Testentscheidung

wird mit dem t-Test für unabhängige Stichproben (Parallelversuch) auf dem Testniveau

alpha=5% durchgeführt. Wir wenden die Variante des Welch-Tests an, der keine

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

30

Varianzhomogenität voraussetzt. Dem Test geht eine kurze Datenbeschreibung voran, die die

Stichprobenumfänge nA und nB, die Mittelwerte mA und mB sowie die Standardabweichungen sA

und sB der beiden Stichproben enthält.

Lösung mit R:

>

>

>

>

>

>

>

>

>

>

>

ya <- c(23, 18, 13, 19, 27)

yb <- c(20, 15, 10, 25, 21)

# Deskriptive Statistiken

n_A <- length(ya)

n_B <- length(yb)

m_A <- mean(ya)

m_B <- mean(yb)

s_A <- sd(ya)

s_B <- sd(yb)

options(digits=4)

print(cbind(n_A, m_A, s_A))

n_A m_A

s_A

[1,]

5 20 5.292

> print(cbind(n_B, m_B, s_B))

n_B m_B s_B

[1,] 5 18.2 5.805

> # Parallelversuch: t-Test für unabhängige Stichproben (Variante WELCH-Test)

> # H0: kein Unterschied, H1: Unterschied in der mittleren Wirkung

> t.test(ya, yb, alternative="two.sided", paired=FALSE, mu=0)

Welch Two Sample t-test

data: ya and yb

t = 0.5124, df = 7.932, p-value = 0.6223

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

-6.313 9.913

sample estimates:

mean of x mean of y

20.0

18.2

Ergebnis:

Wegen p-value = 0.623 >= 0.05 kann H0: µA = µB nicht abgelehnt werden (nichtsignifikantes

Ergebnis)!

Teilaufgabe 1b (Mindeststichprobenumfang)

Lösungsansatz und rechnerische Lösung:

In der Teilaufgabe b) ist die Versuchsplanung zu beurteilen. Der Versuch ist ausreichend gut

geplant, wenn der erforderliche Mindeststichprobenumfang n_mindest (d.h. jener

Stichprobenumfang, der geplant werden muss, um mit einer hohen Sicherheit (Power) – wir

wählen diese 90% - einen signifikanten Testausgang zu erhalten) kleiner oder gleich den

(übereinstimmenden) Stichprobenumfängen in 1a) ist. Die Formel

σ 2

2

n ≈ 2 2 (z1−α / 2 + z1− β )

∆

liefert einen brauchbaren Näherungswert für n_mindest, soferne dieser größer oder gleich 20 ist.

In der Formel bedeutet s die „gepoolte“ Standardabweichung sp der beiden Stichproben, d.h.

sp =

( n A − 1) s A2 + (n B − 1) s B2

n A + nB − 2

Ferner ist ∆ der Betrag |mA – mB| der Differenz der Stichprobenmittelwerte sowie z1-α/2 und z1-ß die

Quantile der Standardnormalverteilung zu den Unterschreitungswahrscheinlichkeiten 1-α/2 bzw.

1-ß (hier ist α=5% das Testniveau und 1-ß=0.9 die Power).

Lösung mit R:

> ya <- c(23, 18, 13, 19, 27)

> yb <- c(20, 15, 10, 25, 21)

> # Deskriptive Statistiken

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

31

>

>

>

>

>

>

>

>

>

>

n_A <- length(ya)

n_B <- length(yb)

m_A <- mean(ya)

m_B <- mean(yb)

s_A <- sd(ya)

s_B <- sd(yb)

options(digits=4)

s_p <- sqrt(((n_A-1)*s_A^2+(n_B-1)*s_B^2)/(n_A+n_B-2))

delta <- abs(m_A - m_B)

print(cbind(delta, s_p))

delta

s_p

[1,]

1.8 5.554

> # Bestimmung des erforderlichen Mindeststichprobenumfangs, um mit dem WelchTest

> # den beobachteten Mittelwertunterschied mit einer Sicherheit von 90% als

> # signifikant ungleich null zu erkennen.

> power.t.test(delta=abs(m_A-m_B), sd=s_p, sig.level=0.05, power=0.9,

+

alternative="two.sided", type="two.sample")

Two-sample t test power calculation

n

delta

sd

sig.level

power

alternative

=

=

=

=

=

=

201.1

1.8

5.554

0.05

0.9

two.sided

NOTE: n is number in *each* group

Ergebnis:

Es ist ein Mindeststichprobenumfang von n_mindest=202 erforderlich, um im Rahmen eines

Parallelversuchsmit dem auf 5%igen Signifikanzniveau geführten Test die Differenz delta = 1.8

der Stichprobenmittelwerte mit einer Sicherheit von 90% als signifikant zu erkennen.

2. Man nehme nun an, dass die Studie von Aufgabe 1 als Paarvergleich geplant wurde. Das

heißt, der jeweils erste Wert der A- und B-Stichprobe stammen von derselben

Versuchsperson, ebenfalls die zweiten Werte usw.

a. Ist ein signifikanter Unterschied in den mittleren Wirkungen feststellbar? Als

Testniveau nehme man wieder 5%.

b. Wie ist die Versuchsplanung zu beurteilen (Stichprobenumfang)?

Präzisierung der Aufgabe:

Wie in Aufgabe 1 bezeichnen wir mit YA die Präparatwirkung in der Diagnosegruppe A und mit

YB die entsprechende Wirkung in der Gruppe B. Beide Variablen werden als normalverteilt

vorausgesetzt mit den Mittelwerten µA bzw. µB. Im Gegensatz zu Aufgabe 1 werden nun die

Merkmalswerte an ein und denselben Personen gemessen, d.h. jede Person bekommt zuerst das

Präparat A und dann – nachdem die Wirkung abgeklungen ist – das Präparat B.

Teilaufgabe 2a (Differenzen t-Test )

Lösungsansatz und numerische Lösung:

In der Teilaufgabe a) ist gefragt, ob die mittlere Wirkungen µA und µB voneinander verschieden

sind. Bildet man die Differenz µ= µA - µB kann man die Frage auch so formulieren, ob die

Mittelwertdifferenz µ von Null verschieden ist. Es geht also um einen Vergleich des Mittelwerts

von YA-YB mit dem Sollwert 0. Die Alternativhypothese lautet H1:µ≠0, die Nullhypothese ist

H0:µ=0. Die Testentscheidung wird mit dem t-Test für abhängige Stichproben (Paarvergleich)

auf dem Testniveau alpha=5% durchgeführt.

Lösung mit R:

>

>

>

>

>

>

ya <- c(23, 18, 13, 19, 27)

yb <- c(20, 15, 10, 25, 21)

# Paarvergleich: t-Test für abhängige Stichproben

# H0: Mittelwertdifferenz=0, H1: Mittelwertdifferenz <> 0

yab <- ya-yb # Differenzstichprobe

print(yab)

W. Timischl: Angewandte_Statistik_II_Repetitorium

21.05.12

32

[1] 3 3 3 -6 6

> # Deskriptive Statistiken (Differenzstichprobe)

> n_AB <- length(yab)

> m_AB <- mean(yab)

> s_AB <- sd(yab)

> options(digits=4)

> print(cbind(n_AB, m_AB, s_AB))

n_AB m_AB s_AB